云计算核心技术MapReduce介绍

第4章大数据技术教程-MapReduce

第四章分布式计算框架MapReduce4.1初识MapReduceMapReduce是一种面向大规模数据并行处理的编程模型,也一种并行分布式计算框架。

在Hadoop流行之前,分布式框架虽然也有,但是实现比较复杂,基本都是大公司的专利,小公司没有能力和人力来实现分布式系统的开发。

Hadoop的出现,使用MapReduce框架让分布式编程变得简单。

如名称所示,MapReduce主要由两个处理阶段:Map阶段和Reduce 阶段,每个阶段都以键值对作为输入和输出,键值对类型可由用户定义。

程序员只需要实现Map和Reduce两个函数,便可实现分布式计算,而其余的部分,如分布式实现、资源协调、内部通信等,都是由平台底层实现,无需开发者关心。

基于Hadoop开发项目相对简单,小公司也可以轻松的开发分布式处理软件。

4.1.1 MapReduce基本过程MapReduce是一种编程模型,用户在这个模型框架下编写自己的Map函数和Reduce函数来实现分布式数据处理。

MapReduce程序的执行过程主要就是调用Map函数和Reduce函数,Hadoop把MapReduce程序的执行过程分为Map和Reduce两个大的阶段,如果细分可以为Map、Shuffle(洗牌)、Reduce三个阶段。

Map含义是映射,将要操作的每个元素映射成一对键和值,Reduce含义是归约,将要操作的元素按键做合并计算,Shuffle在第三节详细介绍。

下面以一个比较简单的示例,形象直观介绍一下Map、Reduce阶段是如何执行的。

有一组图形,包含三角形、圆形、正方形三种形状图形,要计算每种形状图形的个数,见下图4-1。

图:4-1 map/reduce计算不同形状的过程在Map阶段,将每个图形映射成形状(键Key)和数量(值Value),每个形状图形的数量值是“1”;Shuffle阶段的Combine(合并),相同的形状做归类;在Reduce阶段,对相同形状的值做求和计算。

云计算核心技术剖析(节选)

2 IT,身为一个新兴行业,在其发展历程中向其他行业借鉴了一些先进的思想和理念,比如除了前面提到的从电力行业借鉴了公用事业这种商业模式和从丰田汽车流水线生产中总结出精益这套编程模式之外,还在软件设计方面引入了架构这个在建筑行业非常核心的概念。

架构,对软件系统而言是极为重要的。

因为它不仅定义了系统内部各个模块之间是如何整合和协调的,同时也对其整体表现起着非常关键的作用。

而云,作为一个非常复杂的大型软件系统,其中包含着许许多多的模块和组件,所以如果能够理出其架构的话,将会非常有益。

为了让大家对云计算有更深入的理解,本章将会对云的架构进行深入剖析。

除了云的架构之外,本章还将会对云计算最主要和最常见的4种模式进行深入介绍。

2.1云的架构在对云计算进行了三年多的研究之后,觉得云计算虽然涉及了很多产品与技术,表面上看起来的确有点纷繁复杂,但是云计算本身还是有迹可循和有理可依的,所以在个人理解的基础上,我总结出了一套云计算的架构,具体请看图2-1。

2.1 云的架构 17 2 6这个云架构共分为服务和管理这两大部分。

在服务方面,主要以提供用户基于云的各种服务为主,共包含3个层次。

其一是Software as a Service (软件即服务),简称SaaS ,这层的作用是将应用主要以基于Web 的方式提供给客户。

其二是Platform as a Service (平台即服务),简称PaaS ,这层的作用是将一个应用的开发和部署平台作为服务提供给用户。

其三是Infrastructure as a Service (基础设施即服务),简称IaaS ,这层的作用是将各种底层的计算(比如虚拟机)和存储等资源作为服务提供给用户。

从用户角度而言,这3层服务是独立的,因为它们提供的服务是完全不同的,而且面对的用户也不尽相同。

但从技术角度而言,云服务这三层是有一定依赖关系的。

比如一个SaaS 层的产品和服务不仅需要用到SaaS 层本身的技术,而且还依赖PaaS 层所提供的开发和部署平台或者直接部署于IaaS 层所提供的计算资源上,而PaaS 层的产品和服务也很有可能构建于IaaS 层服务之上。

云计算Mapreduce简介PPT课件

google云计算的构成要素

• 谷歌文件系统GFS(海量的数据访问存储) • Chubby分布式锁服务(分布式环境下并发操作的同步) • MapReduce分布式编程模型的结构(并行数据处理) • BigTable结构化数据存储系统(管理组织海量的数据)

google云计算的构成要素

Google云计算应用

惊人,能容纳不计其数的网络数据拷贝,因此搜索速度能够更快,在眨眼之

间便能为数十亿的搜索提交答案。

• 向"云"规模的数据处理迈进标志着我们在信息处理方面发生了翻天覆地的转 变。从最基本的层面讲,"云"的发展就如同100年前人类用电的进程演变,当 时的农场和公司逐渐关闭了自己的发电机,转而从高效的发电厂购买电力。 Google的高管们很早前就开始展望这一转变并为之进行筹划准备。

强大的分布式处理能力

• 云计算:其概念是由Google提出的,这是一个美 丽的网络应用模式。

• 主要目的:它旨在通过网络把多个成本相对较低 的计算实体整合成一个具有强大计算能力的完美 系统。

强大的分布式处理能力

•

由几十万甚至大约100万台廉价的服务器所组成的网络。这些机器单个

而论的话,其性能并不比家用台式机强大多少。但是这个网络存储的数据量

过程5master通知分配了reduce作业的worker它负责的分区在什么位置当reduceworker把所有它负责的中间键值对都读过来后先对它们进行排序使得相同键的键值对聚集在一起

Google云计算的强 大处理能力

目录

• 1.为何云计算有强大的处理能力 • 2.云计算的构成要素 • 3.MapReduce分布式编程模型的结构 • 4.MapReduce对数据处理的流程 • 5.容错机制

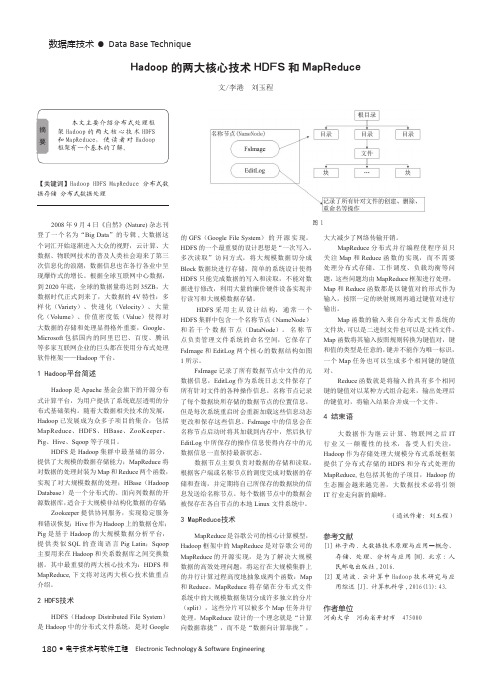

Hadoop的两大核心技术HDFS和MapReduce

Hadoop的两大核心技术HDFS和MapReduce作者:李港刘玉程来源:《电子技术与软件工程》2018年第07期摘要本文主要介绍分布式处理框架Hadoop的两大核心技术HDFS和MapReduce,使读者对Hadoop框架有一个基本的了解。

【关键词】Hadoop HDFS MapReduce 分布式数据存储分布式数据处理2008年9月4日《自然》(Nature)杂志刊登了一个名为“Big Data”的专辑,大数据这个词汇开始逐渐进入大众的视野,云计算、大数据、物联网技术的普及人类社会迎来了第三次信息化的浪潮,数据信息也在各行各业中呈现爆炸式的增长。

根据全球互联网中心数据,到2020年底,全球的数据量将达到35ZB,大数据时代正式到来了,大数据的4V特性:多样化( Variety)、快速化(Velocity)、大量化( Volume)、价值密度低(Value)使得对大数据的存储和处理显得格外重要,Google、Microsoft包括国内的阿里巴巴、百度、腾讯等多家互联网企业的巨头都在使用分布式处理软件框架--Hadoop平台。

1 Hadoop平台简述Hadoop是Apache基金会旗下的开源分布式计算平台,为用户提供了系统底层透明的分布式基础架构。

随着大数据相关技术的发展,Hadoop已发展成为众多子项目的集合,包括MapReduce. HDFS. HBase. ZooKeeper.Pig、Hive、Sqoop等子项目。

HDFS是Hadoop集群中最基础的部分,提供了大规模的数据存储能力;MapReduce将对数据的处理封装为Map和Reduce两个函数,实现了对大规模数据的处理;HBase (HadoopDatabase)是一个分布式的、面向列数据的开源数据库,适合于大规模非结构化数据的存储Zookeeper提供协同服务,实现稳定服务和错误恢复;Hive作为Hadoop上的数据仓库;Pig 是基于Hadoop的大规模数据分析平台,提供类似SQL的查询语言Pig Latin; Sqoop主要用来在Hadoop和关系数据库之间交换数据。

MapReduce简介

7.3.2

MapReduce各个执行阶段

节点1 节点2

从分布式文件系统中加载文件

从分布式文件系统中加载文件

InputFormat 文件 文件 Split Split Split Split

InputFormat 文件 Split Split 文件

输入 <key,value>

RR Map

RR Map

7.3.3

Shuffle过程详解

其他Reduce任务

3. Reduce端的Shuffle过程

Map任务 磁盘

1 “领取”数据

Reduce任务 缓存

2 归并数据

分区

分区

磁盘 文件归并

3

把数据输入给 Reduce任务

其他Map任务

其他Reduce任务

图7-5 Reduce端的Shuffle过程

7.3.4

合并(Combine)和归并(Merge)的区别: 两个键值对<“a”,1>和<“a”,1>,如果合并,会得到<“a”,2>,如果归并,会得到<“a”,<1,1>>

7.3.3

Shuffle过程详解

3. Reduce端的Shuffle过程

•Reduce任务通过RPC向JobTracker询问Map任务是 否已经完成,若完成,则领取数据 •Reduce领取数据先放入缓存,来自不同Map机器, 先归并,再合并,写入磁盘 •多个溢写文件归并成一个或多个大文件,文件中的键 值对是排序的 •当数据很少时,不需要溢写到磁盘,直接在缓存中归 并,然后输出给Reduce

RR Map

RR Map

RR Map

RR Map

mapreduce总结

mapreduce总结MapReduce一个由Google出的分布式编程模型,它将大数据处理转化为分布式程序模型,提供了一种简单却强大的方法来处理海量的数据。

MapReduce优点在于提供了一种既可以低成本、高效率地处理大规模数据的数据处理框架,在大数据的处理和管理方面发挥了重要作用。

本文将对MapReduce的相关概念及其实现原理、特点和应用进行综述。

一、MapReduce的概念MapReduceGoogle发明的一种解决海量数据处理的分布式编程模型,它是一种计算框架,可以将一个大型数据集分割成多个小任务,并把任务分发到多台机器上执行,并最终将小任务的结果合并成最终结果。

MapReduce模型由Google在2004年提出,并于2005年在著名论文“MapReduce:A Flexible Data Processing Tool”中被正式发表,其主要贡献者为Google公司的三位研究人员:Jeff Dean、Sanjay Ghemawat Andrew Tomkins。

二、MapReduce的实现原理MapReduce实现原理主要分2个阶段。

1. Map:Map是利用已有的数据,进行数据归类和分块的过程,将大规模的数据量分割成多个中等规模的数据块,每个数据块用一个子任务来处理;2. Reduce阶段:Reduce是从 Map的多个子任务的结果中汇总出最终的结果;MapReduce框架建立在分布式环境之上,将一个大规模的计算任务拆分成小任务,分发到各个节点运行,最后把小任务的结果合并成一个总结果。

三、MapReduce的特点MapReduce模型提供了一种机制,可以实现以下处理大规模数据的特点:1.发处理大数据:MapReduce过将大数据集分成多个小数据集,并由多个节点并行处理,从而提供了大规模数据处理的并发能力,可以提升处理效率;2.错性:MapReduce型支持容错性处理,也即当某台机器出现故障或是宕机,MapReduce架会将任务重新分发到其它机器上执行,从而保证了数据的正确性;3.可伸缩性:MapReduce型具有较高的可伸缩性,即可以根据需求随时增加或减少计算任务的数量,从而改变计算的规模;4.持低延迟的数据处理:MapReduce数据处理过程中,可以有效避免数据倾斜现象,从而减少任务处理的时间。

MapReduce的工作机制演示课件

统计词频的例子

4

1.2MapReduce 的用途

在Google,MapReduce用在非常广泛的应用程 序中,如分布grep,分布排序,web访问日志 分析,反向索引构建,文档聚类,机器学习, 基于统计的机器翻译。 值得注意的是,MapReduce实现以后,它被 用来重新生成Google的整个索引。 总来的说MapReduce是用于大规模数据的并 行处理。

12

2.2 作业运行机制

任务的分配:

7.TaskTracker定期发送 “心跳”给JobTracker.

“心跳”告知 JobTracker它是否存活, 同时也充当两者之间 的消息通道。

Jobtracker为tasktracker 选择任务之前,必须 先选定任务所在的作 业。

选择map任务时, jobtracker会考虑 tasktracker的网络位置, 选在一个距离其输入 分片最近的tasktracker

4.调用Jobtracker的 submitjob()方法来通 知Jobtracker作业准备

11

2.2 作业运行机制

作业的初始化:

5.创建一个表示正在 运行作业的对象—— 封装任务和记录信息, 以便跟踪任务的状态 和进程 6.获取已经计算好的 输入分片信息,为每 一个分片创建一个 map任务(reduce任务 的个数由用户配置), 将任务放入任务列表

5

1.3 MapReduce 作业和任务

MapReduce 作业( Job )是指客户端需要执 行的一个工作单元(它包括输入数据、 MapReduce程序和配置信息)。 Hadoop将作业分成若干个小任务(Task)来 执行,其中包括两类任务:map任务和reduce 任务。

6

Hadoop的两大核心技术HDFS和MapReduce

180 •电子技术与软件工程 Electronic Technology & Software Engineering数据库技术• Data Base Technique【关键词】Hadoop HDFS MapReduce 分布式数据存储 分布式数据处理2008年9月4日《自然》(Nature)杂志刊登了一个名为“Big Data ”的专辑,大数据这个词汇开始逐渐进入大众的视野,云计算、大数据、物联网技术的普及人类社会迎来了第三次信息化的浪潮,数据信息也在各行各业中呈现爆炸式的增长。

根据全球互联网中心数据,到2020年底,全球的数据量将达到35ZB ,大数据时代正式到来了,大数据的4V 特性:多样化(Variety )、快速化(Velocity )、大量化(V olume )、价值密度低(Value )使得对大数据的存储和处理显得格外重要,Google 、Microsoft 包括国内的阿里巴巴、百度、腾讯等多家互联网企业的巨头都在使用分布式处理软件框架——Hadoop 平台。

1 Hadoop平台简述Hadoop 是Apache 基金会旗下的开源分布式计算平台,为用户提供了系统底层透明的分布式基础架构。

随着大数据相关技术的发展,Hadoop 已发展成为众多子项目的集合,包括MapReduce 、HDFS 、HBase 、ZooKeeper 、Pig 、Hive 、Sqoop 等子项目。

HDFS 是Hadoop 集群中最基础的部分,提供了大规模的数据存储能力;MapReduce 将对数据的处理封装为Map 和Reduce 两个函数,实现了对大规模数据的处理;HBase (Hadoop Database )是一个分布式的、面向列数据的开源数据库,适合于大规模非结构化数据的存储;Zookeeper 提供协同服务,实现稳定服务和错误恢复;Hive 作为Hadoop 上的数据仓库;Pig 是基于Hadoop 的大规模数据分析平台,提供类似SQL 的查询语言Pig Latin ;Sqoop 主要用来在Hadoop 和关系数据库之间交换数据。

3-MapReduce编程详解

MapReduce编程一、实验目的1、理解MapReduce编程模型基本知识2、掌握MapReduce开发环境的搭建3、掌握MapReduce基本知识,能够运用MapReduce进行基本的开发二、实验原理MapReduce 是Hadoop两个最基础最重要的核心成员之一。

它是大规模数据(TB 级)计算的利器,Map 和Reduce 是它的主要思想,来源于函数式编程语言。

从编程的角度来说MapReduce分为Map函数和Reduce函数,Map负责将数据打散,Reduce负责对数据进行聚集,用户只需要实现map 和reduce 两个接口,即可完成TB级数据的计算。

Hadoop Map Reduce的实现采用了Master/Slave 结构。

Master 叫做JobTracker,而Slave 叫做TaskTracker。

用户提交的计算叫做Job,每一个Job会被划分成若干个Tasks。

JobTracker负责Job 和Tasks 的调度,而TaskTracker负责执行Tasks。

常见的应用包括:日志分析和数据挖掘等数据分析应用,另外,还可用于科学数据计算,如圆周率PI 的计算等。

MapReduce 框架的核心步骤主要分两部分:Map 和Reduce。

当你向MapReduce 框架提交一个计算作业时,它会首先把计算作业拆分成若干个Map 任务,然后分配到不同的节点上去执行,每一个Map 任务处理输入数据中的一部分,当Map 任务完成后,它会生成一些中间文件,这些中间文件将会作为Reduce 任务的输入数据。

Reduce 任务的主要目标就是把前面若干个Map 的输出汇总到一起并输出。

按照以上基本的描述,其工作图如下。

从工作流程来讲,MapReduce对应的作业Job首先把输入的数据集切分为若干独立的数据块,并由Map组件以Task的方式并行处理。

处理结果经过排序后,依次输入给Reduce 组件,并且以Task的形式并行处理。

云计算与大数据技术概论-实验1-3 MapReduce编程:单词计数

MapReduce编程:单词计数1、实验描述•使用mapreduce编程,完成单词计数•实验时长:90分钟•主要步骤:o启动Hadoop集群o编写代码o打包程序,并提交至HDFS运行o查看实验结果文件•虚拟机数量:3•系统版本:Centos 7.5•Hadoop版本:Apache Hadoop 2.7.3•Eclipse版本:Neon.3 4.6.3•JavaSE基础•MapReduce编程•配置开发环境•编写Mapper类•编写Reducer类•编写main函数•程序打jar包•将jar包运行在hadoop集群上•效果图:展示结果为成功对文件中的单词进行了单词计数图16.1进入虚拟机并启动Hadoop集群6.1.1在master启动Hadoop集群1.[zkpk@master ~]$ start-all.sh图26.1.2在master上运行jps,确认NameNode, SecondaryNameNode, ResourceManager进程启动图36.1.3在slave01上运行jps,确认DataNode, NodeManager进程启动图46.1.4在slave02上运行jps,确认DataNode, NodeManager进程启动图56.2启动Eclipse客户端1.[zkpk@master ~]$ cd eclipse/2.[zkpk@master eclipse]$ ./eclipse6.3在Eclipse客户端主界面中左侧空白处右击,依次选择New->Project,选择Java Project点击Next图6图76.3.1在弹出的对话框中定义工程名为hadoop,然后点击Finish完成创建,弹出询问是否将Java Project设置为常用工程项目时,点击Yes即可图86.3.2在工程名上单击鼠标右键点击依次选择Build Path ->Configure Build Path图96.3.3在弹出窗口中,进入Libraries模块,再点击Add External Jars导入实验相关jar包图10图66.3.4将hadoop主目录中的share/hadoop/common中的jar包导入,然后再次点击Add External JARs将share/hadoop/common/lib文件夹中的所有jar包导入图11图126.3.5将hadoop主目录中的share/hadoop/hdfs中的jar包导入,然后再次点击Add External JARs将share/hadoop/hdfs/lib文件夹中的所有jar包导入图13图146.3.6将hadoop主目录中的share/hadoop/mapreduce中的jar包导入,然后再次点击Add External JARs将share/hadoop/mapreduce/lib文件夹中的所有jar包导入图15图166.3.7将hadoop主目录中的share/hadoop/yarn中的jar包导入,然后再次点击Add External JARs将share/hadoop/yarn/lib文件夹中的所有jar包导入图17图186.3.8所有jar包导入完成,在Build Path点击OK按钮完成环境配置图196.4创建Wordcount的Mapper类6.4.1首先在工程目录中的src文件夹上右击,依次选择New->Package,创建名字是org.zkpk.hadoop.wordcount的package图20图216.4.2右键点击Package包名,依次选择New->Class,在此package中创建mr编程中的mapper类图22 6.4.2.1弹出对话框,定义类名为WordMap图236.4.2.2WordMap类继承Mapper类,Mapper类的输入键值对中键是Object类型,值是Text类型;输出键值对中键是Text类型,值是IntWritable类型图246.4.3覆写Mapper类中的map方法图256.4.3.1map方法第一个参数key表示当前所读的这一行数据行首的文本偏移量6.4.3.2第二个参数value表示当前所读的这一行文本6.4.3.3在map方法中编写代码读取数据的每一行,将value转换成string类型,再按照字段之间的分隔符进行切分,得到一个字符串数组图266.4.3.4使用for循环对单词数组进行遍历,将每次遍历得到的单词包装成Text类型,1包装成Intwritable类型,分别作为输出的key和value图276.5创建Wordcount中的Reduce类6.5.1右键点击包名,依次选择New->Class,在名为org.zkpk.hadoop.wordcount的package中创建reducer类图286.5.1.1弹出对话框,定义类名为WordReduce,点击Finish完成创建图296.5.1.2WordReduce类继承Reducer类,Reducer类的输入键值对中键是Text类型,值是IntWritable 类型(与Mapper输出的键值对类型分别一致);输出键值对中键是Text类型,值是IntWritable类型图306.5.2覆写Reducer类中的reduce方法图316.5.2.1reduce会将相同key的键值对汇聚到一个reduce task中6.5.2.2第一个参数key表示单词,类型对应Mapper的输出key类型6.5.2.3第二个参数Values表示当前key对应的所有value集合,集合元素类型对应于Mapper的输出value类型6.5.2.4对values进行遍历,将每次遍历的数值进行累加到一个变量,例如:sum图326.5.2.5结束遍历,将参数key作为输出的键值对中的键,将sum包装成IntWritable类型作为输出键值对中的值,使用context的write方法写出图336.6创建Wordcount中包含main方法的类6.6.1右键点击包名依次选择New->Class,在名为org.zkpk.hadoop.wordcount的package中创建包含MapReduce的main方法的类图34 6.6.1.1定义类名为WordMain图356.6.1.2在类WordMain中创建main方法,在main方法中使用if语句判断传入的参数格式是否正确,如果不正确则退出程序(这里我们的代码需要接受两个参数作为输入和输出路径)图366.6.1.3生成Configuration类型对象图376.6.1.3利用Configuration对象生成job对象图386.6.1.4调用job的setJarByClass方法设置job运行主类图396.6.1.5通过setInputFormatClass方法设置job输入格式,setOutputFormatClass方法设置job输出格式图406.6.1.6通过setInputPaths、setOutputPath方法设置job的输入、输出路径图416.6.1.7通过setMapperClass、setReducerClass方法设置Map/Reduce阶段的类图426.6.1.8通过setOutputKeyClass、setOutputValueClass方法设置最终输出key/value的类型图436.6.1.9通过waitForCompletion方法提交job图446.7程序打jar包6.7.1右击工程名,点击export,在弹出窗口中,选择java的JAR file点击Next,如图:图45图466.7.2指定导出的jar包的位置及名字然后点击Finish,如图:图476.7.3导出完成后,关闭eclipse然后返回指定目录查看,如图所示图486.8运行jar包6.8.1上传输入数据6.8.1.1从Hadoop的公共目录下拷贝数据文件test.txt到/home/zkpk1.[zkpk@master ~]$ cp ~/experiment/test.txt ~/6.8.1.2将上一步拷贝的数据文件test.txt上传到HDFS的根目录1.[zkpk@master ~]$ hadoop fs -put /home/zkpk/test.txt /6.8.2查看是否上传成功1.[zkpk@master ~]$ hadoop fs -ls /图496.8.3运行jar包,指定包名及主类名,然后指定输入路径参数和输出路径参数(该参数都是在HDFS上,且输出路径即word文件夹不能够已存在)1.[zkpk@master ~]$ hadoop jar /home/zkpk/wordcount.jarorg.zkpk.hadoop.wordcount.WordMain/test.txt /word 6.8.4查看输出目录1.[zkpk@master ~]$ hadoop fs -ls /word/图506.8.5查看输出结果1.[zkpk@master ~]$ hadoop fs -cat /word/part-r-00000图51•代码清单org.zkpk.hadoop.wordcount.WordMain图52•代码清单org.zkpk.hadoop.wordcount.WordMap图53•代码清单org.zkpk.hadoop.wordcount.WordReduce图54完成本实验可掌握用mapreduce计算框架对数据做基本分布式处理。

Google云计算三大核心技术

Google三大核心技术之一:MapReduceMapReduce:超大机群上的简单数据处理摘要MapReduce是一个编程模型,和处理,产生大数据集的相关实现.用户指定一个map函数处理一个key/value对,从而产生中间的key/value对集.然后再指定一个reduce函数合并所有的具有相同中间key的中间 value.下面将列举许多可以用这个模型来表示的现实世界的工作.以这种方式写的程序能自动的在大规模的普通机器上实现并行化.这个运行时系统关心这些细节:分割输入数据,在机群上的调度,机器的错误处理,管理机器之间必要的通信.这样就可以让那些没有并行分布式处理系统经验的程序员利用大量分布式系统的资源.我们的MapReduce实现运行在规模可以灵活调整的由普通机器组成的机群上,一个典型的MapReduce计算处理几千台机器上的以TB计算的数据.程序员发现这个系统非常好用:已经实现了数以百计的MapReduce程序,每天在Google的机群上都有1000多个MapReduce程序在执行.1.介绍在过去的5年里,作者和Google的许多人已经实现了数以百计的为专门目的而写的计算来处理大量的原始数据,比如,爬行的文档,Web请求日志,等等.为了计算各种类型的派生数据,比如,倒排索引,Web文档的图结构的各种表示,每个主机上爬行的页面数量的概要,每天被请求数量最多的集合,等等.很多这样的计算在概念上很容易理解.然而,输入的数据量很大,并且只有计算被分布在成百上千的机器上才能在可以接受的时间内完成.怎样并行计算,分发数据,处理错误,所有这些问题综合在一起,使得原本很简介的计算,因为要大量的复杂代码来处理这些问题,而变得让人难以处理.作为对这个复杂性的回应,我们设计一个新的抽象模型,它让我们表示我们将要执行的简单计算,而隐藏并行化,容错,数据分布,负载均衡的那些杂乱的细节,在一个库里.我们的抽象模型的灵感来自Lisp和许多其他函数语言的map和reduce的原始表示.我们认识到我们的许多计算都包含这样的操作:在我们输入数据的逻辑记录上应用map操作,来计算出一个中间key/value对集,在所有具有相同key的value上应用reduce操作,来适当的合并派生的数据.功能模型的使用,再结合用户指定的map和reduce操作,让我们可以非常容易的实现大规模并行化计算,和使用再次执行作为初级机制来实现容错.这个工作的主要贡献是通过简单有力的接口来实现自动的并行化和大规模分布式计算,结合这个接口的实现来在大量普通的PC机上实现高性能计算.第二部分描述基本的编程模型,并且给一些例子.第三部分描述符合我们的基于集群的计算环境的MapReduce的接口的实现.第四部分描述我们觉得编程模型中一些有用的技巧.第五部分对于各种不同的任务,测量我们实现的性能.第六部分探究在Google内部使用MapReduce作为基础来重写我们的索引系统产品.第七部分讨论相关的,和未来的工作.2.编程模型计算利用一个输入key/value对集,来产生一个输出key/value对集.MapReduce库的用户用两个函数表达这个计算:map和reduce.用户自定义的map函数,接受一个输入对,然后产生一个中间key/value对集.MapReduce库把所有具有相同中间key I的中间value聚合在一起,然后把它们传递给reduce函数.用户自定义的reduce函数,接受一个中间key I和相关的一个value集.它合并这些value,形成一个比较小的value集.一般的,每次reduce调用只产生0或1个输出value.通过一个迭代器把中间value提供给用户自定义的reduce函数.这样可以使我们根据内存来控制value列表的大小.2.1 实例考虑这个问题:计算在一个大的文档集合中每个词出现的次数.用户将写和下面类似的伪代码:map(St ring key,String value)://key:文档的名字//value:文档的内容for each word w in value:Emit Intermediate(w,"1");reduce(String key,Iterator values)://key:一个词//values:一个计数列表int result=0;for each v in values:result+=ParseInt(v);Emit(AsString(resut));map函数产生每个词和这个词的出现次数(在这个简单的例子里就是1).reduce函数把产生的每一个特定的词的计数加在一起.另外,用户用输入输出文件的名字和可选的调节参数来填充一个mapreduce规范对象.用户然后调用MapReduce函数,并把规范对象传递给它.用户的代码和MapReduce库链接在一起(用C++实现).附录A包含这个实例的全部文本.2.2类型即使前面的伪代码写成了字符串输入和输出的t erm格式,但是概念上用户写的map和reduce函数有关联的类型:map(k1,v1) ->list(k2,v2)reduce(k2,list(v2)) ->list(v2)例如,输入的key,value和输出的key,value的域不同.此外,中间key,value和输出key,values的域相同.我们的C++实现传递字符串来和用户自定义的函数交互,并把它留给用户的代码,来在字符串和适当的类型间进行转换.2.3更多实例这里有一些让人感兴趣的简单程序,可以容易的用MapReduce计算来表示.分布式的Grep(UNIX工具程序, 可做文件内的字符串查找):如果输入行匹配给定的样式,map函数就输出这一行.reduce函数就是把中间数据复制到输出.计算URL访问频率:map函数处理web页面请求的记录,输出(URL,1).reduce函数把相同URL的value都加起来,产生一个(URL,记录总数)的对.倒转网络链接图:map函数为每个链接输出(目标,源)对,一个URL叫做目标,包含这个URL的页面叫做源.reduce 函数根据给定的相关目标URLs连接所有的源URLs形成一个列表,产生(目标,源列表)对.每个主机的术语向量:一个术语向量用一个(词,频率)列表来概述出现在一个文档或一个文档集中的最重要的一些词.map函数为每一个输入文档产生一个(主机名,术语向量)对(主机名来自文档的URL).reduce函数接收给定主机的所有文档的术语向量.它把这些术语向量加在一起,丢弃低频的术语,然后产生一个最终的(主机名,术语向量)对.倒排索引:map函数分析每个文档,然后产生一个(词,文档号)对的序列.reduce函数接受一个给定词的所有对,排序相应的文档IDs,并且产生一个(词,文档ID列表)对.所有的输出对集形成一个简单的倒排索引.它可以简单的增加跟踪词位置的计算.分布式排序:map函数从每个记录提取key,并且产生一个(key,record)对.reduce函数不改变任何的对.这个计算依赖分割工具(在4.1描述)和排序属性(在4.2描述).3实现MapReduce接口可能有许多不同的实现.根据环境进行正确的选择.例如,一个实现对一个共享内存较小的机器是合适的,另外的适合一个大NUMA的多处理器的机器,而有的适合一个更大的网络机器的集合.这部分描述一个在Google广泛使用的计算环境的实现:用交换机连接的普通PC机的大机群.我们的环境是:1.Linux操作系统,双处理器,2-4GB内存的机器.2.普通的网络硬件,每个机器的带宽或者是百兆或者千兆,但是平均小于全部带宽的一半.3.因为一个机群包含成百上千的机器,所有机器会经常出现问题.4.存储用直接连到每个机器上的廉价IDE硬盘.一个从内部文件系统发展起来的分布式文件系统被用来管理存储在这些磁盘上的数据.文件系统用复制的方式在不可靠的硬件上来保证可靠性和有效性.5.用户提交工作给调度系统.每个工作包含一个任务集,每个工作被调度者映射到机群中一个可用的机器集上.3.1执行预览通过自动分割输入数据成一个有M个split的集,map调用被分布到多台机器上.输入的split能够在不同的机器上被并行处理.通过用分割函数分割中间key,来形成R个片(例如,hash(key) mod R),reduce调用被分布到多台机器上.分割数量(R)和分割函数由用户来指定.图1显示了我们实现的MapReduce操作的全部流程.当用户的程序调用MapReduce的函数的时候,将发生下面的一系列动作(下面的数字和图1中的数字标签相对应):1.在用户程序里的MapReduce库首先分割输入文件成M个片,每个片的大小一般从16到64MB(用户可以通过可选的参数来控制).然后在机群中开始大量的拷贝程序.2.这些程序拷贝中的一个是mast er,其他的都是由mast er分配任务的worker.有M 个map任务和R个reduce任务将被分配.管理者分配一个map任务或reduce任务给一个空闲的worker.3.一个被分配了map任务的worker读取相关输入split的内容.它从输入数据中分析出key/value对,然后把key/value对传递给用户自定义的map函数.由map函数产生的中间key/value对被缓存在内存中.4.缓存在内存中的key/value对被周期性的写入到本地磁盘上,通过分割函数把它们写入R个区域.在本地磁盘上的缓存对的位置被传送给master,master负责把这些位置传送给reduce worker.5.当一个reduce worker得到mast er的位置通知的时候,它使用远程过程调用来从map worker的磁盘上读取缓存的数据.当reduce worker读取了所有的中间数据后,它通过排序使具有相同key的内容聚合在一起.因为许多不同的key映射到相同的reduce任务,所以排序是必须的.如果中间数据比内存还大,那么还需要一个外部排序.6.reduce worker迭代排过序的中间数据,对于遇到的每一个唯一的中间key,它把key和相关的中间value集传递给用户自定义的reduce函数.reduce函数的输出被添加到这个reduce分割的最终的输出文件中.7.当所有的map和reduce任务都完成了,管理者唤醒用户程序.在这个时候,在用户程序里的MapReduce调用返回到用户代码.在成功完成之后,mapreduce执行的输出存放在R个输出文件中(每一个 reduce任务产生一个由用户指定名字的文件).一般,用户不需要合并这R个输出文件成一个文件--他们经常把这些文件当作一个输入传递给其他的MapReduce调用,或者在可以处理多个分割文件的分布式应用中使用他们.3.2master数据结构master保持一些数据结构.它为每一个map和reduce任务存储它们的状态(空闲,工作中,完成),和worker机器(非空闲任务的机器)的标识.master就像一个管道,通过它,中间文件区域的位置从map任务传递到reduce任务.因此,对于每个完成的map 任务,mast er存储由map任务产生的R个中间文件区域的大小和位置.当map任务完成的时候,位置和大小的更新信息被接受.这些信息被逐步增加的传递给那些正在工作的reduce任务.3.3容错因为MapReduce库被设计用来使用成百上千的机器来帮助处理非常大规模的数据,所以这个库必须要能很好的处理机器故障.worker故障master周期性的ping每个worker.如果mast er在一个确定的时间段内没有收到worker返回的信息,那么它将把这个worker标记成失效.因为每一个由这个失效的worker完成的map任务被重新设置成它初始的空闲状态,所以它可以被安排给其他的worker.同样的,每一个在失败的worker上正在运行的map或reduce任务,也被重新设置成空闲状态,并且将被重新调度.在一个失败机器上已经完成的map任务将被再次执行,因为它的输出存储在它的磁盘上,所以不可访问.已经完成的reduce任务将不会再次执行,因为它的输出存储在全局文件系统中.当一个map任务首先被worker A执行之后,又被B执行了(因为A失效了),重新执行这个情况被通知给所有执行reduce任务的worker.任何还没有从A读数据的reduce任务将从worker B读取数据.MapReduce可以处理大规模worker失败的情况.例如,在一个MapReduce操作期间,在正在运行的机群上进行网络维护引起80台机器在几分钟内不可访问了,MapReduce mast er只是简单的再次执行已经被不可访问的worker完成的工作,继续执行,最终完成这个MapReduce操作.master失败可以很容易的让管理者周期的写入上面描述的数据结构的checkpoints.如果这个mast er任务失效了,可以从上次最后一个checkpoint开始启动另一个mast er进程.然而,因为只有一个mast er,所以它的失败是比较麻烦的,因此我们现在的实现是,如果mast er失败,就中止MapReduce计算.客户可以检查这个状态,并且可以根据需要重新执行MapReduce操作.在错误面前的处理机制当用户提供的map和reduce操作对它的输出值是确定的函数时,我们的分布式实现产生,和全部程序没有错误的顺序执行一样,相同的输出.我们依赖对map和reduce任务的输出进行原子提交来完成这个性质.每个工作中的任务把它的输出写到私有临时文件中.一个reduce任务产生一个这样的文件,而一个map任务产生R个这样的文件(一个reduce任务对应一个文件).当一个map任务完成的时候,worker发送一个消息给master,在这个消息中包含这R个临时文件的名字.如果master从一个已经完成的map任务再次收到一个完成的消息,它将忽略这个消息.否则,它在master的数据结构里记录这R个文件的名字.当一个reduce任务完成的时候,这个reduce worker原子的把临时文件重命名成最终的输出文件.如果相同的reduce任务在多个机器上执行,多个重命名调用将被执行,并产生相同的输出文件.我们依赖由底层文件系统提供的原子重命名操作来保证,最终的文件系统状态仅仅包含一个reduce任务产生的数据.我们的map和reduce操作大部分都是确定的,并且我们的处理机制等价于一个顺序的执行的这个事实,使得程序员可以很容易的理解程序的行为.当map或/和reduce操作是不确定的时候,我们提供虽然比较弱但是合理的处理机制.当在一个非确定操作的前面,一个reduce任务R1的输出等价于一个非确定顺序程序执行产生的输出.然而,一个不同的reduce任务R2的输出也许符合一个不同的非确定顺序程序执行产生的输出.考虑map任务M和reduce任务R1,R2的情况.我们设定e(Ri)为已经提交的Ri的执行(有且仅有一个这样的执行).这个比较弱的语义出现,因为e(R1)也许已经读取了由M的执行产生的输出,而e(R2)也许已经读取了由M的不同执行产生的输出.3.4存储位置在我们的计算机环境里,网络带宽是一个相当缺乏的资源.我们利用把输入数据(由GFS 管理)存储在机器的本地磁盘上来保存网络带宽.GF S把每个文件分成64MB的一些块,然后每个块的几个拷贝存储在不同的机器上(一般是3个拷贝).MapReduce的mast er考虑输入文件的位置信息,并且努力在一个包含相关输入数据的机器上安排一个map任务.如果这样做失败了,它尝试在那个任务的输入数据的附近安排一个map任务(例如,分配到一个和包含输入数据块在一个swit ch里的worker机器上执行).当运行巨大的MapReduce操作在一个机群中的一部分机器上的时候,大部分输入数据在本地被读取,从而不消耗网络带宽.3.5任务粒度象上面描述的那样,我们细分map阶段成M个片,reduce阶段成R个片.M和R应当比worker机器的数量大许多.每个worker执行许多不同的工作来提高动态负载均衡,也可以加速从一个worker失效中的恢复,这个机器上的许多已经完成的map任务可以被分配到所有其他的worker机器上.在我们的实现里,M和R的范围是有大小限制的,因为mast er必须做O(M+R)次调度,并且保存O(M*R)个状态在内存中.(这个因素使用的内存是很少的,在O(M*R)个状态片里,大约每个map任务/reduce任务对使用一个字节的数据).此外,R经常被用户限制,因为每一个reduce任务最终都是一个独立的输出文件.实际上,我们倾向于选择M,以便每一个单独的任务大概都是16到64MB的输入数据(以便上面描述的位置优化是最有效的),我们把R设置成我们希望使用的worker机器数量的小倍数.我们经常执行MapReduce计算,在M=200000,R=5000,使用2000台工作者机器的情况下.3.6备用任务一个落后者是延长MapReduce操作时间的原因之一:一个机器花费一个异乎寻常地的长时间来完成最后的一些map或reduce任务中的一个.有很多原因可能产生落后者.例如,一个有坏磁盘的机器经常发生可以纠正的错误,这样就使读性能从30MB/s降低到3MB/s.机群调度系统也许已经安排其他的任务在这个机器上,由于计算要使用CPU,内存,本地磁盘,网络带宽的原因,引起它执行MapReduce代码很慢.我们最近遇到的一个问题是,一个在机器初始化时的Bug引起处理器缓存的失效:在一个被影响的机器上的计算性能有上百倍的影响.我们有一个一般的机制来减轻这个落后者的问题.当一个MapReduce操作将要完成的时候,mast er调度备用进程来执行那些剩下的还在执行的任务.无论是原来的还是备用的执行完成了,工作都被标记成完成.我们已经调整了这个机制,通常只会占用多几个百分点的机器资源.我们发现这可以显著的减少完成大规模MapReduce操作的时间.作为一个例子,将要在5.3描述的排序程序,在关闭掉备用任务的情况下,要比有备用任务的情况下多花44%的时间.4技巧尽管简单的map和reduce函数的功能对于大多数需求是足够的了,但是我们开发了一些有用的扩充.这些将在这个部分描述.4.1分割函数MapReduce用户指定reduce任务和reduce任务需要的输出文件的数量.在中间key上使用分割函数,使数据分割后通过这些任务.一个缺省的分割函数使用hash方法(例如,hash(key) mod R).这个导致非常平衡的分割.然后,有的时候,使用其他的key分割函数来分割数据有非常有用的.例如,有时候,输出的key是URLs,并且我们希望每个主机的所有条目保持在同一个输出文件中.为了支持像这样的情况,MapReduce库的用户可以提供专门的分割函数.例如,使用"hash(Hostname(urlkey)) mod R"作为分割函数,使所有来自同一个主机的URLs保存在同一个输出文件中.4.2顺序保证我们保证在一个给定的分割里面,中间key/value对以key递增的顺序处理.这个顺序保证可以使每个分割产出一个有序的输出文件,当输出文件的格式需要支持有效率的随机访问key的时候,或者对输出数据集再作排序的时候,就很容易.4.3combiner函数在某些情况下,允许中间结果key重复会占据相当的比重,并且用户定义的reduce函数满足结合律和交换律.一个很好的例子就是在2.1部分的词统计程序.因为词频率倾向于一个zipf分布(齐夫分布),每个map任务将产生成百上千个这样的记录<the,1>.所有的这些计数将通过网络被传输到一个单独的reduce任务,然后由reduce函数加在一起产生一个数字.我们允许用户指定一个可选的combiner函数,先在本地进行合并一下,然后再通过网络发送.在每一个执行map任务的机器上combiner函数被执行.一般的,相同的代码被用在combiner和reduce函数.在combiner和reduce函数之间唯一的区别是MapReduce库怎样控制函数的输出.reduce函数的输出被保存最终输出文件里.combiner函数的输出被写到中间文件里,然后被发送给reduce任务.部分使用combiner可以显著的提高一些MapReduce操作的速度.附录A包含一个使用combiner函数的例子.4.4输入输出类型MapReduce库支持以几种不同的格式读取输入数据.例如,文本模式输入把每一行看作是一个key/value 对.key是文件的偏移量,value是那一行的内容.其他普通的支持格式以key的顺序存储key/value对序列.每一个输入类型的实现知道怎样把输入分割成对每个单独的map任务来说是有意义的(例如,文本模式的范围分割确保仅仅在每行的边界进行范围分割).虽然许多用户仅仅使用很少的预定意输入类型的一个,但是用户可以通过提供一个简单的reader接口来支持一个新的输入类型.一个reader不必要从文件里读数据.例如,我们可以很容易的定义它从数据库里读记录,或从内存中的数据结构读取.4.5副作用有的时候,MapReduce的用户发现在map操作或/和reduce操作时产生辅助文件作为一个附加的输出是很方便的.我们依靠应用程序写来使这个副作用成为原子的.一般的,应用程序写一个临时文件,然后一旦这个文件全部产生完,就自动的被重命名.对于单个任务产生的多个输出文件来说,我们没有提供其上的两阶段提交的原子操作支持.因此,一个产生需要交叉文件连接的多个输出文件的任务,应该使确定性的任务.不过这个限制在实际的工作中并不是一个问题.4.6跳过错误记录有的时候因为用户的代码里有bug,导致在某一个记录上map或reduce函数突然crash掉.这样的bug使得MapReduce操作不能完成.虽然一般是修复这个bug,但是有时候这是不现实的;也许这个bug是在源代码不可得到的第三方库里.有的时候也可以忽略一些记录,例如,当在一个大的数据集上进行统计分析.我们提供一个可选的执行模式,在这个模式下,MapReduce库检测那些记录引起的crash,然后跳过那些记录,来继续执行程序.每个worker程序安装一个信号处理器来获取内存段异常和总线错误.在调用一个用户自定义的map或reduce 操作之前,MapReduce库把记录的序列号存储在一个全局变量里.如果用户代码产生一个信号,那个信号处理器就会发送一个包含序号的"last gasp"UDP包给MapReduce的mast er.当mast er不止一次看到同一个记录的时候,它就会指出,当相关的map或reduce任务再次执行的时候,这个记录应当被跳过.4.7本地执行调试在map或reduce函数中问题是很困难的,因为实际的计算发生在一个分布式的系统中,经常是有一个master动态的分配工作给几千台机器.为了简化调试和测试,我们开发了一个可替换的实现,这个实现在本地执行所有的MapReduce操作.用户可以控制执行,这样计算可以限制到特定的map任务上.用户以一个标志调用他们的程序,然后可以容易的使用他们认为好用的任何调试和测试工具(例如,gdb).4.8状态信息master运行一个HTTP服务器,并且可以输出一组状况页来供人们使用.状态页显示计算进度,象多少个任务已经完成,多少个还在运行,输入的字节数,中间数据字节数,输出字节数,处理百分比,等等.这个页也包含到标准错误的链接,和由每个任务产生的标准输出的链接.用户可以根据这些数据预测计算需要花费的时间,和是否需要更多的资源.当计算比预期的要慢很多的时候,这些页面也可以被用来判断是不是这样.此外,最上面的状态页显示已经有多少个工作者失败了,和当它们失败的时候,那个map和reduce任务正在运行.当试图诊断在用户代码里的bug时,这个信息也是有用的.4.9计数器MapReduce库提供一个计数器工具,来计算各种事件的发生次数.例如,用户代码想要计算所有处理的词的个数,或者被索引的德文文档的数量.为了使用这个工具,用户代码创建一个命名的计数器对象,然后在map或/和reduce函数里适当的增加计数器.例如:Counter * uppercase;uppercase=Get Count er("uppercase");map(St ring name,String contents):for each word w in contents:if(IsCapit alized(w)):uppercase->Increment();Emit Intermediate(w,"1");来自不同worker机器上的计数器值被周期性的传送给master(在ping回应里).master把来自成功的map和reduce任务的计数器值加起来,在MapReduce操作完成的时候,把它返回给用户代码.当前计数器的值也被显示在master状态页里,以便人们可以查看实际的计算进度.当计算计数器值的时候消除重复执行的影响,避免数据的累加.(在备用任务的使用,和由于出错的重新执行,可以产生重复执行)有些计数器值被MapReduce库自动的维护,比如,被处理的输入key/value对的数量,和被产生的输出key/value 对的数量.用户发现计数器工具对于检查MapReduce操作的完整性很有用.例如,在一些MapReduce操作中,用户代码也许想要确保输出对的数量完全等于输入对的数量,或者处理过的德文文档的数量是在全部被处理的文档数量中属于合理的范围.5性能在本节,我们用在一个大型集群上运行的两个计算来衡量MapReduce的性能.一个计算用来在一个大概1TB的数据中查找特定的匹配串.另一个计算排序大概1TB的数据.这两个程序代表了MapReduce的用户实现的真实的程序的一个大子集.一类是,把数据从一种表示转化到另一种表示.另一类是,从一个大的数据集中提取少量的关心的数据.5.1机群配置所有的程序在包含大概1800台机器的机群上执行.机器的配置是:2个2G的 Int el Xeon超线程处理器,4GB内存,两个160GB IDE磁盘,一个千兆网卡.这些机器部署在一个由两层的,树形交换网络中,在根节点上大概有100到2000G的带宽.所有这些机器都有相同的部署(对等部署),因此任意两点之间的来回时间小于1毫秒.。

mapreduce 统计首字母次数 案例

一、背景介绍近年来,随着互联网和大数据技术的迅速发展,大数据分析已经成为各行各业不可或缺的一部分。

而在大数据处理中,MapReduce作为一种经典的并行计算框架,被广泛应用于数据处理和分析任务中。

在实际应用中,经常会遇到需要对大规模数据进行统计分析的需求,比如统计单词、字母出现的频次等。

本文将以统计中文文章中每个词的首字母的出现次数为例,介绍MapReduce在统计任务中的应用。

二、MapReduce介绍MapReduce是一种用于处理大规模数据的编程模型,由Google在2004年提出,并在2006年发表了论文。

它的核心思想是将数据处理任务分解成Map和Reduce两个阶段,使得分布式计算变得简单和高效。

在MapReduce模型中,Map阶段负责对输入数据进行处理和过滤,并生成中间的键值对数据;Reduce阶段则负责对中间数据进行汇总和统计,生成最终的输出数据。

三、统计首字母次数的MapReduce实现在统计中文文章中每个词的首字母的出现次数的案例中,我们可以利用MapReduce模型来实现。

对于输入的中文文章,我们需要对每个词进行分词处理,并提取每个词的首字母;在Map阶段,我们将每个首字母作为键,将出现的频次作为值,生成中间的键值对;在Reduce 阶段,我们对相同首字母的频次进行累加,得到最终的统计结果。

接下来,我们将详细介绍Map和Reduce两个阶段的具体实现。

四、Map阶段:1. 数据输入:将中文文章作为输入数据,以行为单位读取并进行分词处理,得到每个词和其对应的首字母。

2. Map函数:对于每个词,提取其首字母作为键,将出现的频次设为1,生成中间的键值对数据。

3. 数据输出:将生成的中间数据按照键值对的形式输出。

五、Reduce阶段:1. 数据输入:接收Map阶段输出的中间数据,以键为单位进行分组。

2. Reduce函数:对于每个键值对数据,将相同键的频次进行累加,得到每个首字母的总频次。

云计算的核心技术

云计算的核心技术云计算系统运用了许多技术,其中以编程模型、数据管理技术、数据存储技术、虚拟化技术、云计算平台管理技术最为关键。

(1)编程模型MapReduce是Google开发的java,Python,C++编程模型,它是一种简化的分布式编程模型和高效的任务调度模型,用于大规模数据集(大于1T8)的并行运算。

严格的编程模型使云计算环境下的编程十分简单。

MapAeduce模式的思想是将要执行的问题分解成}P(映射)和Reduce(化简)的方式,先通过Map程序将数据切割成不相关的区块,分配(调度)给大量计算机处理,达到分布式运算的效果,再通过Reduce程序将结果汇整输出。

(2)海量数据分布存储技术云计算系统由大量服务器组成,同时为大量用户服务,因此云计算系统采用分布式存储的方式存储数据,用冗余存储的方式保证数据的可靠性。

云计算系统中广泛使用的数据存储系统是Google的GFS和Hadoop团队开发的GFS的开源实现HDFS。

GFS即Google文件系统(Google File System),是一个可扩展的分布式文件系统,用于大型的、分布式的、对大量数据进行访问的应用。

GFS的设计思想不同于传统的文件系统,是针对大规模数据处理和Google应用特性而设计的。

它运行于廉价的普通硬件上,但可以提供容错功能。

它可以给大量的用户提供总体性能较高的服务。

一个GFS集群由一个主服务器(~)和大量的块服务器(chunksecvcr)构成,并被许多客户(Client)访问。

主服务器存储文件系统所有的元数据,包括名字空间、访问控制信息、从文件到块的映射以及块的当前位置。

它也控制系统范围的活动,如块租约(lease)管理,孤儿块的垃圾收集,块服务器间的块迁移。

主服务器定期通过HeartBeat消息与每一个块服务器通信。

给块服务器传递指令并收集它的状态。

GFS中的文件被切分为64MB的块并以冗余存储,每份数据在系统中保存3个以上备份。

Hadoop Mapreduce云计算 技术手册

Hadoop云计算技术手册作者:zbwd中国云计算论坛Email:xjtuzb@GTCRC@XJTU序言Hadoop是一个开源的分布式并行计算平台,它主要由MapReduce的算法执行和一个分布式的文件系统等两部分组成。

Hadoop起源于Doug Cutting大牛领导开发的Nutch搜索引擎项目的子项目。

现在是Apache软件基金会管理的开源项目。

本文主要介绍Hadoop及相关技术,从Hadoop的起源开始讲述,主要涵盖了MapReduce算法思想,基本框架,运行流程和编程粒度等内容,以期给入门者提供一个关于Hadoop的技术简介和研究参考。

关于Hadoop的安装指南和编程范例并不在本文叙述范围内,有需要者请参考其它资料。

因笔者水平实在太有限了,文中如有疏漏错误请不吝指出,万分感谢。

本人资料多数来源于互联网的技术文档,附录列出引文列表,特此致谢原文作者。

最后,发自内心、无与伦比地感谢Google、Apache软件基金会和Doug Cutting 带给我们如此简约、优雅的技术。

OK,让我们开始吧!去寻找那神奇的小飞象。

目录�引言——Hadoop从何而来�算法思想——Hadoop是怎么思考的�基本架构——Hadoop是如何构成的�运行流程——Hadoop是如何工作的�任务粒度——Hadoop是如何并行的�参考文献1.引言——Hadoop从何而来自从Google工程师Jeffrey Dean提出MapReduce编程思想,MapReduce便在Google的各种Web应用中释放着魔力。

然而,也许出于技术保密的目的,Google 公司并没有透露其MapReduce的实现细节。

幸运的是,Doug Cutting开发的Hadoop作为MapReduce开源实现,让MapReduce这么平易近人地走到了我们面前。

2006年1月,Doug Cutting因其在开源项目Nutch和Lucene的卓越表现受邀加入Yahoo公司,专职在Hadoop项目上进行开发。

mapreduce的原理

MapReduce的原理介绍MapReduce是一种用于大规模数据处理的编程模型,最初由Google提出并应用于分布式计算系统。

它的设计目标是简化并发处理大规模数据集的过程,通过将数据分割成多个块,然后在多个计算节点上进行并行处理,最后将结果合并返回。

在本文中,我们将深入探讨MapReduce的原理及其工作机制。

MapReduce的基本原理MapReduce模型包含两个主要步骤:Map和Reduce。

Map任务将输入数据拆分成一系列独立的片段,并为每个片段生成键值对。

Reduce任务则将Map任务生成的键值对进行合并和聚合,生成最终的结果。

Map任务Map任务是并行处理的第一步,它的输入是原始数据集,输出是一系列键值对。

Map任务通常由多个计算节点并行执行,每个节点处理输入数据的一个片段。

Map 任务的执行过程可以分为以下几个步骤:1.输入数据划分:原始数据集被划分成多个片段,每个片段被分配给一个Map任务。

2.记录解析:Map任务对输入数据进行解析,并将其转换成键值对的形式。

键值对的格式由具体的应用决定。

3.中间结果存储:Map任务将生成的键值对存储在本地磁盘上或内存中的缓冲区中。

这些中间结果将在Reduce任务中使用。

4.分区:Map任务根据键的哈希值将键值对分配到不同的Reduce任务上。

这样可以确保具有相同键的键值对被发送到同一个Reduce任务进行处理。

Reduce任务Reduce任务是并行处理的第二步,它的输入是Map任务生成的键值对,输出是最终的结果。

Reduce任务的执行过程可以分为以下几个步骤:1.分组:Reduce任务根据键对键值对进行分组,将具有相同键的键值对放在一起。

2.排序:Reduce任务对每个组内的键值对进行排序,以便更方便地进行后续的聚合操作。

3.聚合:Reduce任务对每个组内的键值对进行聚合操作,生成最终的结果。

聚合操作可以是求和、求平均值、计数等。

4.结果输出:Reduce任务将最终的结果写入输出文件或存储系统中。

mapreduce技术特点及适用场景

MapReduce是一种用于处理大规模数据的并行计算程序设计模式。

它由Google公司提出并用于其大规模数据处理系统中,后来被Hadoop等开源项目广泛采用。

MapReduce技术具有很多特点,同时也具有很多适用场景。

一、MapReduce技术特点1. 分布式处理:MapReduce将问题分解成独立的任务,并且在多台计算机上并行处理。

这样可以提高计算速度,适应大规模数据处理。

2. 容错性:MapReduce框架在处理数据时会自动检测错误并进行重新计算,确保计算结果的准确性。

3. 可伸缩性:MapReduce框架可以方便地进行横向扩展,即通过增加计算节点来提高处理能力。

4. 简单易用:MapReduce编程模型相对简单,使用Map和Reduce 两种基本操作就可以完成大部分数据处理任务。

5. 适合非交互式计算:MapReduce适用于一次性大规模数据处理,不适合需要即时交互的应用场景。

6. 适合数据并行计算:MapReduce适用于数据集的并行计算,而不适用于计算量很大但是没有明显的数据并行结构的任务。

7. 适用于高延迟环境:MapReduce框架可以有效地利用网络传输数据,适合在高延迟的环境下进行数据处理。

二、MapReduce适用场景1. 数据挖掘和分析:MapReduce技术适用于大规模的数据挖掘和分析任务,可以方便地处理海量的结构化和非结构化数据。

2. 分布式搜索引擎:MapReduce可以用于构建分布式的搜索引擎,通过并行计算来提高搜索效率。

3. 日志处理和分析:许多互联网公司使用MapReduce来处理大规模的日志数据,以便进行性能监控、用户行为分析等工作。

4. 数据清洗和预处理:大规模数据处理中,往往需要清洗和预处理数据,MapReduce技术可以很好地完成这类任务。

5. 图像处理和识别:MapReduce可以并行处理大规模的图像数据,用于图像特征提取、目标检测等应用。

6. 自然语言处理:对文本数据进行分析和处理时,MapReduce技术可以提高处理速度和效率。

MapReduce技术详解

MapReduce技术详解1.什么是MapReduce?MapReduce 是由Google公司的Jeffrey Dean 和 Sanjay Ghemawat 开发的一个针对大规模群组中的海量数据处理的分布式编程模型。

MapReduce实现了两个功能。

Map把一个函数应用于集合中的所有成员,然后返回一个基于这个处理的结果集。

而Reduce是把从两个或更多个Map中,通过多个线程,进程或者独立系统并行执行处理的结果集进行分类和归纳。

Map() 和 Reduce() 两个函数可能会并行运行,即使不是在同一的系统的同一时刻。

Google 用MapReduce来索引每个抓取过来的Web页面。

它取代了2004开始试探的最初索引算法,它已经证明在处理大量和非结构化数据集时更有效。

用不同程序设计语言实现了多个MapReduce,包括 Java, C++, Python, Perl, Ruby和C, 其它语言。

在某些范例里,如Lisp或者Python, Map() 和Reduce()已经集成到语言自身的结构里面。

通常,这些函数可能会如下定义:List2 map(Functor1, List1);Object reduce(Functor2, List2);Map()函数把大数据集进行分解操作到两个或更多的小“桶”。

而一个“桶”则是包含松散定义的逻辑记录或者文本行的集合。

每个线程,处理器或者系统在独立的“桶”上执行Map()函数,去计算基于每个逻辑记录处理的一系列中间值。

合并的结果值就会如同是单个Map()函数在单个“桶”上完全一致。

Map()函数的通常形式是:map(function, list) {foreach element in list {v = function(element)intermediateResult.add(v)}} // mapReduce()函数把从内存,磁盘或者网络介质提取过来的一个或多个中间结果列表,对列表中的每个元素逐一执行一个函数。

Google云计算技术架构

精品文档Google 云计算技术架构:Google 云计算技术架构应用均依赖于四个基本组件1.分布式文件存储(GFS),2,并行数据处理模型(MapReduce).3分布式锁(Chubby).4,结构化数据表(BigTable).Chubby的作用:1.为GFS提供锁服务,选择Master节点:记录Master的相关描述信息;2:通过独占锁记录Chunk Server 的活跃情况;3:为BigTable提供锁服务,记录子表信息(如子表文件信息,子表分类信息,子表服务信息);4:记录MapReduce的任务信息;5:为第三方提供锁服务与文件存储.GFS的作用:1.存储Bigtable的子表文件,2:为第三方应用提供大尺寸文件存储功能;3:文件读操作流程(API与Mater 通信,获取文件元信息,根据指定的读取位置与读取长度,API发动兵发起操作,分别从若干ChunkServer上读取数据,API组装所得数据,返回结果.BigTable的作用:1.为Google云计算应用(或第三方应用)提供数据结构化存储功能;2:类似于数据库;3:为应用提供简单数据查询功能(不支持联合查询);4:为MapReduce提供数据源或者数据结果存储.BigTable的存储于服务请求的响应:1.换分为子表存储,每一个子表对应一个子表文件,子表文件存储于GFS 上;2:bigTable通过元数据组织子集;3:每个子集都被分配给一个子表服务器;4:一个子表服务器可同时分配多个子表;4:子表服务器负责对外提供服务,响应查询请求.MapReduce的作用:对BigTable中的数据进行并行计算处理;2使用BigTable或者GFS存储计算结果Google Analytics:免费的企业级网络分析解决方案;2:帮助企业了解网站流量和营销效果;3:能以灵活的反噬(各类报表)查看并分析流量数据Google网站流量分析的基本功能:统计网站的基本数据,包括会话,综合浏览量,点击量和字节流量;2:分析网站页面关注度,帮助企业调整或者增删页面;3:分析用户浏览路径,优化页面布局;4:分析用户访问来源连接,提供广告投资回报;5:分析用户访问环境,帮助美化页面EC2:Eastic Compute Cloud)简言之,EC2就是一部具有无限采集能力的虚拟计算机,用户能够用来执行一些处理任务EC2的主要特征:1:灵活性,可以自行配置的实例类型,数量,还可以选择实例运行的地理位置,可以根据影虎的需求随时改变实例的使用数量;2:低成本:SSH,可配置的防火墙机制,监控等;3:易用性:用户可以根据亚马逊提供的模块自由构建自己的应用程序,同时EC2还会对用户的服务请求自动进行负载均衡;3:容错性,弹性IP简单队列服务SQS:目标:解决低耦合系统间的通信问题,支持分布式计算机系统之间的工作流,简单队列服务SQS:特点:简单,无处不在简单队列服务SQS:的机制:冗余存储,给予加权随机分布的消息取样,并发管理和故障排除,消息的可见性超时值与生命周期SDB与S3的区别:S3是专为大型,费结构化的数据块设计的;SimpleDB是为复杂的,结构化数据建立的,支持数据的查找,删除,插入等操作.。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MapReduce:超大机群上的简单数据处理摘要MapReduce是一个编程模型,和处理,产生大数据集的相关实现.用户指定一个map函数处理一个key/value对,从而产生中间的key/value对集.然后再指定一个reduce函数合并所有的具有相同中间key的中间value.下面将列举许多可以用这个模型来表示的现实世界的工作.以这种方式写的程序能自动的在大规模的普通机器上实现并行化.这个运行时系统关心这些细节:分割输入数据,在机群上的调度,机器的错误处理,管理机器之间必要的通信.这样就可以让那些没有并行分布式处理系统经验的程序员利用大量分布式系统的资源.我们的MapReduce实现运行在规模可以灵活调整的由普通机器组成的机群上,一个典型的MapReduce计算处理几千台机器上的以TB计算的数据.程序员发现这个系统非常好用:已经实现了数以百计的MapReduce程序,每天在Google的机群上都有1000多个MapReduce程序在执行.1.介绍在过去的5年里,作者和Google的许多人已经实现了数以百计的为专门目的而写的计算来处理大量的原始数据,比如,爬行的文档,Web请求日志,等等.为了计算各种类型的派生数据,比如,倒排索引,Web文档的图结构的各种表示,每个主机上爬行的页面数量的概要,每天被请求数量最多的集合,等等.很多这样的计算在概念上很容易理解.然而,输入的数据量很大,并且只有计算被分布在成百上千的机器上才能在可以接受的时间内完成.怎样并行计算,分发数据,处理错误,所有这些问题综合在一起,使得原本很简介的计算,因为要大量的复杂代码来处理这些问题,而变得让人难以处理.作为对这个复杂性的回应,我们设计一个新的抽象模型,它让我们表示我们将要执行的简单计算,而隐藏并行化,容错,数据分布,负载均衡的那些杂乱的细节,在一个库里.我们的抽象模型的灵感来自Lisp和许多其他函数语言的map和reduce的原始表示.我们认识到我们的许多计算都包含这样的操作:在我们输入数据的逻辑记录上应用map操作,来计算出一个中间key/value对集,在所有具有相同key的value上应用reduce操作,来适当的合并派生的数据.功能模型的使用,再结合用户指定的map和reduce操作,让我们可以非常容易的实现大规模并行化计算,和使用再次执行作为初级机制来实现容错.这个工作的主要贡献是通过简单有力的接口来实现自动的并行化和大规模分布式计算,结合这个接口的实现来在大量普通的PC机上实现高性能计算.第二部分描述基本的编程模型,并且给一些例子.第三部分描述符合我们的基于集群的计算环境的MapReduce的接口的实现.第四部分描述我们觉得编程模型中一些有用的技巧.第五部分对于各种不同的任务,测量我们实现的性能.第六部分探究在Google内部使用MapReduce作为基础来重写我们的索引系统产品.第七部分讨论相关的,和未来的工作.2.编程模型计算利用一个输入key/value对集,来产生一个输出key/value对集.MapReduce库的用户用两个函数表达这个计算:map和reduce.用户自定义的map函数,接受一个输入对,然后产生一个中间key/value对集.MapReduce库把所有具有相同中间key I的中间value聚合在一起,然后把它们传递给reduce函数.用户自定义的reduce函数,接受一个中间key I和相关的一个value集.它合并这些value,形成一个比较小的value集.一般的,每次reduce调用只产生0或1个输出value.通过一个迭代器把中间value提供给用户自定义的reduce函数.这样可以使我们根据内存来控制value列表的大小.2.1 实例考虑这个问题:计算在一个大的文档集合中每个词出现的次数.用户将写和下面类似的伪代码:map(String key,String value)://key:文档的名字//value:文档的内容for each word w in value:EmitIntermediate(w,"1");reduce(String key,Iterator values)://key:一个词//values:一个计数列表int result=0;for each v in values:result+=ParseInt(v);Emit(AsString(resut));map函数产生每个词和这个词的出现次数(在这个简单的例子里就是1).reduce函数把产生的每一个特定的词的计数加在一起.另外,用户用输入输出文件的名字和可选的调节参数来填充一个mapreduce规范对象.用户然后调用MapReduce函数,并把规范对象传递给它.用户的代码和MapReduce库链接在一起(用C++实现).附录A包含这个实例的全部文本.2.2类型即使前面的伪代码写成了字符串输入和输出的term格式,但是概念上用户写的map和reduce函数有关联的类型:map(k1,v1) ->list(k2,v2)reduce(k2,list(v2)) ->list(v2)例如,输入的key,value和输出的key,value的域不同.此外,中间key,value和输出key,values的域相同.我们的C++实现传递字符串来和用户自定义的函数交互,并把它留给用户的代码,来在字符串和适当的类型间进行转换.2.3更多实例这里有一些让人感兴趣的简单程序,可以容易的用MapReduce计算来表示.分布式的Grep(UNIX工具程序, 可做文件内的字符串查找):如果输入行匹配给定的样式,map函数就输出这一行.reduce函数就是把中间数据复制到输出.计算URL访问频率:map函数处理web页面请求的记录,输出(URL,1).reduce函数把相同URL的value都加起来,产生一个(URL,记录总数)的对.倒转网络链接图:map函数为每个链接输出(目标,源)对,一个URL叫做目标,包含这个URL的页面叫做源.reduce 函数根据给定的相关目标URLs连接所有的源URLs形成一个列表,产生(目标,源列表)对.每个主机的术语向量:一个术语向量用一个(词,频率)列表来概述出现在一个文档或一个文档集中的最重要的一些词.map函数为每一个输入文档产生一个(主机名,术语向量)对(主机名来自文档的URL).reduce函数接收给定主机的所有文档的术语向量.它把这些术语向量加在一起,丢弃低频的术语,然后产生一个最终的(主机名,术语向量)对.倒排索引:map函数分析每个文档,然后产生一个(词,文档号)对的序列.reduce函数接受一个给定词的所有对,排序相应的文档IDs,并且产生一个(词,文档ID列表)对.所有的输出对集形成一个简单的倒排索引.它可以简单的增加跟踪词位置的计算.分布式排序:map函数从每个记录提取key,并且产生一个(key,record)对.reduce函数不改变任何的对.这个计算依赖分割工具(在4.1描述)和排序属性(在4.2描述).3实现MapReduce接口可能有许多不同的实现.根据环境进行正确的选择.例如,一个实现对一个共享内存较小的机器是合适的,另外的适合一个大NUMA的多处理器的机器,而有的适合一个更大的网络机器的集合.这部分描述一个在Google广泛使用的计算环境的实现:用交换机连接的普通PC机的大机群.我们的环境是:1.Linux操作系统,双处理器,2-4GB内存的机器.2.普通的网络硬件,每个机器的带宽或者是百兆或者千兆,但是平均小于全部带宽的一半.3.因为一个机群包含成百上千的机器,所有机器会经常出现问题.4.存储用直接连到每个机器上的廉价IDE硬盘.一个从内部文件系统发展起来的分布式文件系统被用来管理存储在这些磁盘上的数据.文件系统用复制的方式在不可靠的硬件上来保证可靠性和有效性.5.用户提交工作给调度系统.每个工作包含一个任务集,每个工作被调度者映射到机群中一个可用的机器集上.3.1执行预览通过自动分割输入数据成一个有M个split的集,map调用被分布到多台机器上.输入的split能够在不同的机器上被并行处理.通过用分割函数分割中间key,来形成R个片(例如,hash(key) mod R),reduce调用被分布到多台机器上.分割数量(R)和分割函数由用户来指定.图1显示了我们实现的MapReduce操作的全部流程.当用户的程序调用MapReduce的函数的时候,将发生下面的一系列动作(下面的数字和图1中的数字标签相对应):1.在用户程序里的MapReduce库首先分割输入文件成M个片,每个片的大小一般从16到64MB(用户可以通过可选的参数来控制).然后在机群中开始大量的拷贝程序.2.这些程序拷贝中的一个是master,其他的都是由master分配任务的worker.有M 个map任务和R个reduce 任务将被分配.管理者分配一个map任务或reduce任务给一个空闲的worker.3.一个被分配了map任务的worker读取相关输入split的内容.它从输入数据中分析出key/value对,然后把key/value对传递给用户自定义的map函数.由map函数产生的中间key/value对被缓存在内存中.4.缓存在内存中的key/value对被周期性的写入到本地磁盘上,通过分割函数把它们写入R个区域.在本地磁盘上的缓存对的位置被传送给master,master负责把这些位置传送给reduce worker.5.当一个reduce worker得到master的位置通知的时候,它使用远程过程调用来从map worker的磁盘上读取缓存的数据.当reduce worker读取了所有的中间数据后,它通过排序使具有相同key的内容聚合在一起.因为许多不同的key映射到相同的reduce任务,所以排序是必须的.如果中间数据比内存还大,那么还需要一个外部排序.6.reduce worker迭代排过序的中间数据,对于遇到的每一个唯一的中间key,它把key和相关的中间value集传递给用户自定义的reduce函数.reduce函数的输出被添加到这个reduce分割的最终的输出文件中.7.当所有的map和reduce任务都完成了,管理者唤醒用户程序.在这个时候,在用户程序里的MapReduce调用返回到用户代码.在成功完成之后,mapreduce执行的输出存放在R个输出文件中(每一个reduce任务产生一个由用户指定名字的文件).一般,用户不需要合并这R个输出文件成一个文件--他们经常把这些文件当作一个输入传递给其他的MapReduce调用,或者在可以处理多个分割文件的分布式应用中使用他们.3.2master数据结构master保持一些数据结构.它为每一个map和reduce任务存储它们的状态(空闲,工作中,完成),和worker机器(非空闲任务的机器)的标识.master就像一个管道,通过它,中间文件区域的位置从map任务传递到reduce任务.因此,对于每个完成的map 任务,master存储由map任务产生的R个中间文件区域的大小和位置.当map任务完成的时候,位置和大小的更新信息被接受.这些信息被逐步增加的传递给那些正在工作的reduce任务.3.3容错因为MapReduce库被设计用来使用成百上千的机器来帮助处理非常大规模的数据,所以这个库必须要能很好的处理机器故障.worker故障master周期性的ping每个worker.如果master在一个确定的时间段内没有收到worker返回的信息,那么它将把这个worker标记成失效.因为每一个由这个失效的worker完成的map任务被重新设置成它初始的空闲状态,所以它可以被安排给其他的worker.同样的,每一个在失败的worker上正在运行的map或reduce任务,也被重新设置成空闲状态,并且将被重新调度.在一个失败机器上已经完成的map任务将被再次执行,因为它的输出存储在它的磁盘上,所以不可访问.已经完成的reduce任务将不会再次执行,因为它的输出存储在全局文件系统中.当一个map任务首先被worker A执行之后,又被B执行了(因为A失效了),重新执行这个情况被通知给所有执行reduce任务的worker.任何还没有从A读数据的reduce任务将从worker B读取数据.MapReduce可以处理大规模worker失败的情况.例如,在一个MapReduce操作期间,在正在运行的机群上进行网络维护引起80台机器在几分钟内不可访问了,MapReduce master只是简单的再次执行已经被不可访问的worker 完成的工作,继续执行,最终完成这个MapReduce操作.master失败可以很容易的让管理者周期的写入上面描述的数据结构的checkpoints.如果这个master任务失效了,可以从上次最后一个checkpoint开始启动另一个master进程.然而,因为只有一个master,所以它的失败是比较麻烦的,因此我们现在的实现是,如果master失败,就中止MapReduce计算.客户可以检查这个状态,并且可以根据需要重新执行MapReduce操作.在错误面前的处理机制当用户提供的map和reduce操作对它的输出值是确定的函数时,我们的分布式实现产生,和全部程序没有错误的顺序执行一样,相同的输出.我们依赖对map和reduce任务的输出进行原子提交来完成这个性质.每个工作中的任务把它的输出写到私有临时文件中.一个reduce任务产生一个这样的文件,而一个map任务产生R个这样的文件(一个reduce任务对应一个文件).当一个map任务完成的时候,worker发送一个消息给master,在这个消息中包含这R个临时文件的名字.如果master从一个已经完成的map任务再次收到一个完成的消息,它将忽略这个消息.否则,它在master的数据结构里记录这R个文件的名字.当一个reduce任务完成的时候,这个reduce worker原子的把临时文件重命名成最终的输出文件.如果相同的reduce任务在多个机器上执行,多个重命名调用将被执行,并产生相同的输出文件.我们依赖由底层文件系统提供的原子重命名操作来保证,最终的文件系统状态仅仅包含一个reduce任务产生的数据.我们的map和reduce操作大部分都是确定的,并且我们的处理机制等价于一个顺序的执行的这个事实,使得程序员可以很容易的理解程序的行为.当map或/和reduce操作是不确定的时候,我们提供虽然比较弱但是合理的处理机制.当在一个非确定操作的前面,一个reduce任务R1的输出等价于一个非确定顺序程序执行产生的输出.然而,一个不同的reduce任务R2的输出也许符合一个不同的非确定顺序程序执行产生的输出.考虑map任务M和reduce任务R1,R2的情况.我们设定e(Ri)为已经提交的Ri的执行(有且仅有一个这样的执行).这个比较弱的语义出现,因为e(R1)也许已经读取了由M的执行产生的输出,而e(R2)也许已经读取了由M的不同执行产生的输出.3.4存储位置在我们的计算机环境里,网络带宽是一个相当缺乏的资源.我们利用把输入数据(由GFS 管理)存储在机器的本地磁盘上来保存网络带宽.GFS把每个文件分成64MB的一些块,然后每个块的几个拷贝存储在不同的机器上(一般是3个拷贝).MapReduce的master考虑输入文件的位置信息,并且努力在一个包含相关输入数据的机器上安排一个map任务.如果这样做失败了,它尝试在那个任务的输入数据的附近安排一个map任务(例如,分配到一个和包含输入数据块在一个switch里的worker机器上执行).当运行巨大的MapReduce操作在一个机群中的一部分机器上的时候,大部分输入数据在本地被读取,从而不消耗网络带宽.3.5任务粒度象上面描述的那样,我们细分map阶段成M个片,reduce阶段成R个片.M和R应当比worker机器的数量大许多.每个worker执行许多不同的工作来提高动态负载均衡,也可以加速从一个worker失效中的恢复,这个机器上的许多已经完成的map任务可以被分配到所有其他的worker机器上.在我们的实现里,M和R的范围是有大小限制的,因为master必须做O(M+R)次调度,并且保存O(M*R)个状态在内存中.(这个因素使用的内存是很少的,在O(M*R)个状态片里,大约每个map任务/reduce任务对使用一个字节的数据).此外,R经常被用户限制,因为每一个reduce任务最终都是一个独立的输出文件.实际上,我们倾向于选择M,以便每一个单独的任务大概都是16到64MB的输入数据(以便上面描述的位置优化是最有效的),我们把R设置成我们希望使用的worker机器数量的小倍数.我们经常执行MapReduce计算,在M=200000,R=5000,使用2000台工作者机器的情况下.3.6备用任务一个落后者是延长MapReduce操作时间的原因之一:一个机器花费一个异乎寻常地的长时间来完成最后的一些map或reduce任务中的一个.有很多原因可能产生落后者.例如,一个有坏磁盘的机器经常发生可以纠正的错误,这样就使读性能从30MB/s降低到3MB/s.机群调度系统也许已经安排其他的任务在这个机器上,由于计算要使用CPU,内存,本地磁盘,网络带宽的原因,引起它执行MapReduce代码很慢.我们最近遇到的一个问题是,一个在机器初始化时的Bug引起处理器缓存的失效:在一个被影响的机器上的计算性能有上百倍的影响.我们有一个一般的机制来减轻这个落后者的问题.当一个MapReduce操作将要完成的时候,master调度备用进程来执行那些剩下的还在执行的任务.无论是原来的还是备用的执行完成了,工作都被标记成完成.我们已经调整了这个机制,通常只会占用多几个百分点的机器资源.我们发现这可以显著的减少完成大规模MapReduce操作的时间.作为一个例子,将要在5.3描述的排序程序,在关闭掉备用任务的情况下,要比有备用任务的情况下多花44%的时间.4技巧尽管简单的map和reduce函数的功能对于大多数需求是足够的了,但是我们开发了一些有用的扩充.这些将在这个部分描述.4.1分割函数MapReduce用户指定reduce任务和reduce任务需要的输出文件的数量.在中间key上使用分割函数,使数据分割后通过这些任务.一个缺省的分割函数使用hash方法(例如,hash(key) mod R).这个导致非常平衡的分割.然后,有的时候,使用其他的key分割函数来分割数据有非常有用的.例如,有时候,输出的key是URLs,并且我们希望每个主机的所有条目保持在同一个输出文件中.为了支持像这样的情况,MapReduce库的用户可以提供专门的分割函数.例如,使用"hash(Hostname(urlkey)) mod R"作为分割函数,使所有来自同一个主机的URLs保存在同一个输出文件中.4.2顺序保证我们保证在一个给定的分割里面,中间key/value对以key递增的顺序处理.这个顺序保证可以使每个分割产出一个有序的输出文件,当输出文件的格式需要支持有效率的随机访问key的时候,或者对输出数据集再作排序的时候,就很容易.4.3combiner函数在某些情况下,允许中间结果key重复会占据相当的比重,并且用户定义的reduce函数满足结合律和交换律.一个很好的例子就是在2.1部分的词统计程序.因为词频率倾向于一个zipf分布(齐夫分布),每个map任务将产生成百上千个这样的记录<the,1>.所有的这些计数将通过网络被传输到一个单独的reduce任务,然后由reduce函数加在一起产生一个数字.我们允许用户指定一个可选的combiner函数,先在本地进行合并一下,然后再通过网络发送.在每一个执行map任务的机器上combiner函数被执行.一般的,相同的代码被用在combiner和reduce函数.在combiner和reduce函数之间唯一的区别是MapReduce库怎样控制函数的输出.reduce函数的输出被保存最终输出文件里.combiner函数的输出被写到中间文件里,然后被发送给reduce任务.部分使用combiner可以显著的提高一些MapReduce操作的速度.附录A包含一个使用combiner函数的例子.4.4输入输出类型MapReduce库支持以几种不同的格式读取输入数据.例如,文本模式输入把每一行看作是一个key/value 对.key是文件的偏移量,value是那一行的内容.其他普通的支持格式以key的顺序存储key/value对序列.每一个输入类型的实现知道怎样把输入分割成对每个单独的map任务来说是有意义的(例如,文本模式的范围分割确保仅仅在每行的边界进行范围分割).虽然许多用户仅仅使用很少的预定意输入类型的一个,但是用户可以通过提供一个简单的reader接口来支持一个新的输入类型.一个reader不必要从文件里读数据.例如,我们可以很容易的定义它从数据库里读记录,或从内存中的数据结构读取.4.5副作用有的时候,MapReduce的用户发现在map操作或/和reduce操作时产生辅助文件作为一个附加的输出是很方便的.我们依靠应用程序写来使这个副作用成为原子的.一般的,应用程序写一个临时文件,然后一旦这个文件全部产生完,就自动的被重命名.对于单个任务产生的多个输出文件来说,我们没有提供其上的两阶段提交的原子操作支持.因此,一个产生需要交叉文件连接的多个输出文件的任务,应该使确定性的任务.不过这个限制在实际的工作中并不是一个问题.4.6跳过错误记录有的时候因为用户的代码里有bug,导致在某一个记录上map或reduce函数突然crash掉.这样的bug使得MapReduce操作不能完成.虽然一般是修复这个bug,但是有时候这是不现实的;也许这个bug是在源代码不可得到的第三方库里.有的时候也可以忽略一些记录,例如,当在一个大的数据集上进行统计分析.我们提供一个可选的执行模式,在这个模式下,MapReduce库检测那些记录引起的crash,然后跳过那些记录,来继续执行程序.每个worker程序安装一个信号处理器来获取内存段异常和总线错误.在调用一个用户自定义的map或reduce 操作之前,MapReduce库把记录的序列号存储在一个全局变量里.如果用户代码产生一个信号,那个信号处理器就会发送一个包含序号的"last gasp"UDP包给MapReduce的master.当master不止一次看到同一个记录的时候,它就会指出,当相关的map或reduce任务再次执行的时候,这个记录应当被跳过.4.7本地执行调试在map或reduce函数中问题是很困难的,因为实际的计算发生在一个分布式的系统中,经常是有一个master动态的分配工作给几千台机器.为了简化调试和测试,我们开发了一个可替换的实现,这个实现在本地执行所有的MapReduce操作.用户可以控制执行,这样计算可以限制到特定的map任务上.用户以一个标志调用他们的程序,然后可以容易的使用他们认为好用的任何调试和测试工具(例如,gdb).4.8状态信息master运行一个HTTP服务器,并且可以输出一组状况页来供人们使用.状态页显示计算进度,象多少个任务已经完成,多少个还在运行,输入的字节数,中间数据字节数,输出字节数,处理百分比,等等.这个页也包含到标准错误的链接,和由每个任务产生的标准输出的链接.用户可以根据这些数据预测计算需要花费的时间,和是否需要更多的资源.当计算比预期的要慢很多的时候,这些页面也可以被用来判断是不是这样.此外,最上面的状态页显示已经有多少个工作者失败了,和当它们失败的时候,那个map和reduce任务正在运行.当试图诊断在用户代码里的bug时,这个信息也是有用的.4.9计数器MapReduce库提供一个计数器工具,来计算各种事件的发生次数.例如,用户代码想要计算所有处理的词的个数,或者被索引的德文文档的数量.为了使用这个工具,用户代码创建一个命名的计数器对象,然后在map或/和reduce函数里适当的增加计数器.例如:Counter * uppercase;uppercase=GetCounter("uppercase");map(String name,String contents):for each word w in contents:if(IsCapitalized(w)):uppercase->Increment();EmitIntermediate(w,"1");来自不同worker机器上的计数器值被周期性的传送给master(在ping回应里).master把来自成功的map和reduce任务的计数器值加起来,在MapReduce操作完成的时候,把它返回给用户代码.当前计数器的值也被显示在master状态页里,以便人们可以查看实际的计算进度.当计算计数器值的时候消除重复执行的影响,避免数据的累加.(在备用任务的使用,和由于出错的重新执行,可以产生重复执行)有些计数器值被MapReduce库自动的维护,比如,被处理的输入key/value对的数量,和被产生的输出key/value 对的数量.用户发现计数器工具对于检查MapReduce操作的完整性很有用.例如,在一些MapReduce操作中,用户代码也许想要确保输出对的数量完全等于输入对的数量,或者处理过的德文文档的数量是在全部被处理的文档数量中属于合理的范围.5性能在本节,我们用在一个大型集群上运行的两个计算来衡量MapReduce的性能.一个计算用来在一个大概1TB的数据中查找特定的匹配串.另一个计算排序大概1TB的数据.这两个程序代表了MapReduce的用户实现的真实的程序的一个大子集.一类是,把数据从一种表示转化到另一种表示.另一类是,从一个大的数据集中提取少量的关心的数据.5.1机群配置所有的程序在包含大概1800台机器的机群上执行.机器的配置是:2个2G的Intel Xeon超线程处理器,4GB内存,两个160GB IDE磁盘,一个千兆网卡.这些机器部署在一个由两层的,树形交换网络中,在根节点上大概有100到2000G的带宽.所有这些机器都有相同的部署(对等部署),因此任意两点之间的来回时间小于1毫秒.在4GB的内存里,大概有1-1.5GB被用来运行在机群中其他的任务.这个程序是在周末的下午开始执行的,这个时。