儿童对于机器人的情感识别——基于Nao机器人的研究案例

nao机器人实验报告

nao机器人实验报告

Nao机器人实验报告

近年来,随着人工智能技术的迅速发展,机器人在各个领域的应用越来越广泛。

其中,Nao机器人作为一种可以模拟人类情感和行为的机器人,备受关注。

为

了更好地了解Nao机器人的性能和潜力,我们进行了一系列实验,并在此报告

中分享我们的研究成果。

首先,我们对Nao机器人进行了基本的功能测试。

我们发现,Nao机器人在语

音识别和交互方面表现出色,能够准确地理解和回应人类的指令。

此外,Nao

机器人还具有良好的运动控制能力,可以完成各种动作和姿态。

其次,我们对Nao机器人的情感表达能力进行了测试。

我们发现,Nao机器人

能够通过面部表情、语调和姿势来传达情感,使人与机器人之间的交流更加自

然和愉快。

这种情感表达能力为Nao机器人在陪伴、教育和娱乐领域的应用提

供了广阔的前景。

最后,我们还对Nao机器人的学习和适应能力进行了测试。

我们发现,Nao机

器人能够通过不断的学习和训练来适应不同的环境和任务,具有一定的智能化

和自适应能力。

这为Nao机器人在教育、医疗和服务领域的应用提供了更多可

能性。

总的来说,我们的实验结果表明,Nao机器人具有出色的交互能力、情感表达

能力和学习适应能力,为其在各个领域的应用提供了广阔的前景。

然而,我们

也意识到Nao机器人在一些复杂任务和环境下仍然存在一定的局限性,需要进

一步的研究和改进。

我们相信,在不久的将来,Nao机器人将会成为人类生活

中不可或缺的一部分,为我们的生活带来更多的便利和乐趣。

《仿人机器人NAO的路径规划研究》范文

《仿人机器人NAO的路径规划研究》篇一一、引言近年来,随着科技的发展和社会的进步,仿人机器人的应用日益广泛,尤其在智能化和自主性方面取得了很多重要突破。

在众多领域中,机器人技术已经被用于自动化执行、救援工作、生活助手、服务业等多个领域。

而在这一领域的关键技术之一就是路径规划。

本文以NAO仿人机器人为研究对象,探讨其路径规划的原理、方法和应用。

二、NAO仿人机器人概述NAO是一款由Aldebaran Robotics公司开发的仿人机器人,具有高度自主性和互动性。

其设计灵感来源于人类,能够完成复杂的动作和任务。

NAO拥有多个传感器和执行器,可以感知环境并做出相应的反应。

其独特的外观和强大的功能使其在科研、教育、娱乐等多个领域得到广泛应用。

三、路径规划原理及方法路径规划是机器人自主导航和运动控制的核心技术之一。

在NAO仿人机器人的路径规划中,主要涉及到以下几个方面的原理和方法:1. 环境感知:NAO通过激光雷达、摄像头等传感器获取周围环境的信息,包括障碍物的位置、大小、形状等。

这些信息是路径规划的基础。

2. 路径规划算法:根据环境感知信息,采用合适的路径规划算法来计算从起点到终点的最优路径。

常用的算法包括基于图论的算法、基于采样的算法等。

3. 运动控制:根据计算出的最优路径,通过运动控制算法来控制NAO的运动,使其按照预定的轨迹行驶。

四、NAO仿人机器人的路径规划方法针对NAO仿人机器人的特点,可以采用以下几种路径规划方法:1. 基于全局路径规划:根据环境地图信息,采用全局路径规划算法计算从起点到终点的最优路径。

这种方法适用于已知环境的情况。

2. 基于局部路径规划:当NAO在未知或动态变化的环境中行驶时,可以采用基于局部路径规划的方法。

这种方法通过实时感知环境信息,根据当前位置和目标位置计算局部最优路径。

3. 融合全局和局部的混合路径规划:结合全局和局部路径规划的优点,根据实际情况选择合适的方法进行路径规划。

幼儿园智能机器人教学案例分析与实践

幼儿园智能机器人教学案例分析与实践一、前言在当今数字化时代,人工智能已经逐渐渗透到各个领域,并且在教育领域也得到了广泛的应用。

幼儿园作为孩子们学前教育的第一站,如何引入人工智能元素,让孩子们在玩中学,融合科技与教育,成为了教育界的关注焦点。

本文将以幼儿园智能机器人教学为例,深入分析其实践案例,探讨其对幼儿教育的意义与影响。

二、案例分析1.案例介绍某幼儿园引入了一款名为“小智益”的智能机器人,在幼儿园教学中进行示范和实践。

这款智能机器人具有语音识别、情感交流等功能,可根据幼儿的芳龄和知识水平,提供个性化的互动教学服务。

它还可以与幼儿进行启发式互动,激发幼儿学习的兴趣,培养他们的逻辑思维能力和创造力。

2.教学实践在实际教学中,智能机器人被运用到了幼儿园的各个科目中。

在语言环节,机器人可以通过播放儿歌、故事的方式,帮助幼儿学习汉语拼音、词汇等;在数学环节,机器人可以进行简单的数学题目教学,如加减法、数字认知等。

在启蒙教育环节,机器人还可以和老师一起引导幼儿进行手工、游戏等活动,促进他们的动手能力和社交能力。

三、教育意义与影响1.个性化教学智能机器人可以根据幼儿的兴趣、水平,提供个性化的教学服务。

它能够主动调整教学内容和方式,给予每个幼儿更贴心的教育辅助,让他们在自主学习的过程中更容易地获取知识。

2.激发学习兴趣智能机器人的互动方式,更易引发幼儿的好奇心和求知欲。

它不仅可以像老师那样进行教学,还可以作为一个陪伴者,与幼儿进行情感上的交流,从而使学习变得更加轻松愉快。

3.动手能力培养在实践中,智能机器人的引入也为幼儿园的动手能力培养提供了更广阔的空间。

机器人可以通过各种形式的互动游戏,对幼儿的动手能力进行锻炼,提高他们的操作技能和创造力。

四、总结与展望在幼儿园教育中引入智能机器人的实践,为幼儿的学前教育带来全新的体验和启发。

通过个性化教学、激发学习兴趣以及动手能力培养,智能机器人为幼儿提供了更多元、更有趣的学习方式。

幼儿园睿智机器人教育案例分析 幼儿园教育

幼儿园睿智机器人教育案例分析一、引言近年来,随着人工智能技术的飞速发展,越来越多的智能机器人被应用到教育领域中。

幼儿园作为儿童教育的重要阶段,也开始引入智能机器人教育,以提高教学效果和培养学生的综合能力。

本文通过分析一所幼儿园引入的睿智机器人教育案例,探讨智能机器人在幼儿园教育中的应用及效果。

二、案例背景某幼儿园为了提高教学质量,引进了一款名为“睿智”的教育机器人。

这款机器人拥有语音识别、情感识别和智能对话等功能,能够与幼儿进行互动交流,教授语言、数学、科学等知识,并培养幼儿的思维逻辑和表达能力。

幼儿园希望通过引入这款智能机器人,改善教学效果,提高幼儿对学习的兴趣和积极性。

三、智能机器人在幼儿园教育中的应用1. 语言启蒙教育睿智机器人可以通过语音识别和智能对话功能,与幼儿进行简单的对话交流,教授基础的汉语拼音、词汇和语法知识。

与传统的语言启蒙教育相比,机器人能够更好地调动幼儿的学习兴趣,让他们在轻松愉快的氛围中学习语言知识。

2. 交互式学习睿智机器人还可以通过互动教学模式,让幼儿参与到各种语言、数学、科学等教学活动中。

机器人既可以向幼儿提出问题,引导他们思考和回答,也可以向幼儿讲解知识,展示动画和视频等教学资源,提供更加生动直观的学习体验。

3. 情感教育机器人不仅能够教授知识,还能够通过情感识别功能,观察幼儿的情感状态,并进行情感倾诉和安慰。

在幼儿情感教育中,机器人能够作为一位温和可靠的伙伴,增强幼儿的情感体验和情商培养。

四、案例效果分析1. 提高学习积极性引入睿智机器人后,幼儿园的学生们在学习过程中表现出更高的积极性和主动性。

他们对机器人教学充满好奇和兴趣,乐于参与到机器人教学中来,愿意接受新的知识和挑战。

2. 提升学习成绩通过睿智机器人的互动教学和个性化辅导,幼儿园的学生们在语言、数学等学科的成绩有了显著提升。

许多学生在与机器人的对话和更加直观的学习方式下,掌握了更多的知识,提高了学习效率。

幼儿园智能机器人教育案例

幼儿园智能机器人教育案例幼儿园智能机器人教育案例随着科技的不断发展,智能机器人教育正在成为幼儿园教育的一种新趋势。

机器人作为一种先进的教学工具,具有强大的功能和丰富的教育资源,正在为教育行业带来革命性的变化。

本文将介绍一家幼儿园如何引入智能机器人教育,有效地促进幼儿智力、运动、情感、社交以及语言能力方面的发展。

一、引入智能机器人教育的背景幼儿园作为未成年人教育的重要场所,其教学方式一直处于不断的探索中。

传统的教学方式主要依赖于老师和幼儿之间的面对面教学,往往存在效率低下、教学资源有限、难以满足个性需求等诸多问题。

而智能机器人教育则可以有效地解决这些问题,为幼儿提供全新的教学方式和教育资源,促进幼儿全面发展。

二、幼儿园智能机器人教育案例1.引入具有情感交互和语音识别功能的小猫机器人针对幼儿园幼儿智力和情感领域的发展,学校引入了具有情感交互和语音识别功能的小猫机器人。

这款机器人可以根据幼儿声音的不同做出不同的反应,例如幼儿哭泣时会发出安慰的喵喵声,幼儿说话时会听懂并回答相应的问题。

通过与小猫机器人的互动,幼儿可以感受到机器人的喜怒哀乐,提高幼儿的情感认知和表达能力。

2.引入具有动作识别和语音提醒功能的大熊机器人针对幼儿园幼儿运动和语言领域的发展,学校引入了具有动作识别和语音提醒功能的大熊机器人。

这款机器人可以根据幼儿动作的不同做出不同的反应,例如幼儿跳跳床时会发出欢快的音乐,幼儿站立不稳时会发出提醒声。

通过与大熊机器人的互动,幼儿可以提高运动技能和语言理解能力。

3.引入具有社交交互和语音发送功能的智能机器人小友针对幼儿园幼儿社交和语言领域的发展,学校引入了具有社交交互和语音发送功能的智能机器人小友。

这款机器人可以与幼儿进行聊天、游戏等多种互动,例如幼儿可以与机器人一起进行儿歌唱、表情游戏等,还可以通过机器人发送语音信息与家长沟通。

通过与小友机器人的互动,幼儿可以提高社交能力和语言表达能力。

三、智能机器人教育的优势1.多元化的教学资源:智能机器人教育可以提供多种教学资源,包括视频、音乐、影视、游戏等多种形式,丰富了幼儿的学习内容和方式。

幼儿园智能机器人教育案例及教学经验分享

幼儿园智能机器人教育案例及教学经验共享随着科技的不断发展,智能机器人在教育领域的应用也越来越广泛。

在幼儿园教育中,智能机器人作为一种新型的教学工具,为幼儿的学习和成长带来了许多新的可能性。

本文将通过一个实际案例,共享幼儿园智能机器人教育的经验,并探讨这种教学方式的优势和挑战。

一、案例介绍某幼儿园引入了智能机器人作为教学辅助工具,用于幼儿的启蒙教育和智力开发。

这些智能机器人能够与幼儿进行互动,通过语音识别和人脸识别等技术,能够回答幼儿的问题并与他们进行简单的对话。

在教学过程中,教师们将智能机器人引入到各个学科的教学中,例如语言、数学、科学等,以丰富教学内容,激发幼儿的学习兴趣,提高他们的学习效果。

二、教学经验共享1. 激发学习兴趣通过智能机器人的引入,幼儿在学习过程中能够体验到科技带来的乐趣,从而激发他们对学习的兴趣。

智能机器人具有很强的趣味性,能够吸引幼儿的注意力,让他们在愉快的氛围中进行学习。

2. 个性化教学智能机器人可以根据幼儿的个性和兴趣进行个性化的教学。

通过对幼儿的语音识别和情感识别,智能机器人能够了解每个幼儿的学习特点,从而为他们提供个性化的学习内容和方式。

3. 提高学习效果在实际教学中,智能机器人能够帮助幼儿更好地理解和掌握知识,提高他们的学习效果。

通过与智能机器人进行互动,幼儿可以加深对某一知识点的理解,从而提高学习成绩。

4. 培养综合能力智能机器人教育不仅能够帮助幼儿学习知识,还能够培养他们的思维能力、创造力和解决问题的能力。

通过与智能机器人进行对话和交流,幼儿能够锻炼自己的语言表达能力和逻辑思维能力,提高综合素质。

三、观点和理解智能机器人教育在幼儿园教育中具有重要的意义。

它可以丰富教学内容,激发幼儿的学习兴趣,提高学习效果,培养综合能力。

然而,智能机器人教育也面临着一些挑战,例如技术成本高、故障率较高、师资配备等。

在推广智能机器人教育时,需要充分考虑其优势和挑战,做好教学准备。

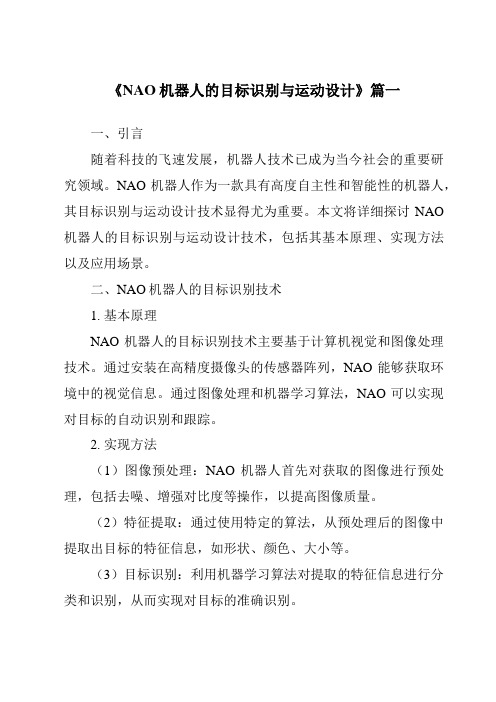

《NAO机器人的目标识别与运动设计》范文

《NAO机器人的目标识别与运动设计》篇一一、引言随着科技的飞速发展,机器人技术已成为当今社会的重要研究领域。

NAO机器人作为一款具有高度自主性和智能性的机器人,其目标识别与运动设计技术显得尤为重要。

本文将详细探讨NAO 机器人的目标识别与运动设计技术,包括其基本原理、实现方法以及应用场景。

二、NAO机器人的目标识别技术1. 基本原理NAO机器人的目标识别技术主要基于计算机视觉和图像处理技术。

通过安装在高精度摄像头的传感器阵列,NAO能够获取环境中的视觉信息。

通过图像处理和机器学习算法,NAO可以实现对目标的自动识别和跟踪。

2. 实现方法(1)图像预处理:NAO机器人首先对获取的图像进行预处理,包括去噪、增强对比度等操作,以提高图像质量。

(2)特征提取:通过使用特定的算法,从预处理后的图像中提取出目标的特征信息,如形状、颜色、大小等。

(3)目标识别:利用机器学习算法对提取的特征信息进行分类和识别,从而实现对目标的准确识别。

(4)跟踪与交互:一旦目标被识别,NAO机器人将通过摄像头和传感器阵列进行实时跟踪,并根据需要进行交互操作。

3. 应用场景NAO机器人的目标识别技术广泛应用于各种场景,如智能家居、安防监控、无人驾驶等。

在智能家居中,NAO机器人可以通过识别家庭成员的行为和需求,提供个性化的服务。

在安防监控中,NAO机器人可以实现对目标的实时跟踪和监控,提高安全性能。

在无人驾驶领域,NAO机器人的目标识别技术可以帮助车辆更准确地识别道路上的障碍物和行人,提高行驶安全性。

三、NAO机器人的运动设计技术1. 基本原理NAO机器人的运动设计技术主要基于动力学和运动学原理。

通过分析机器人的结构、质量和力等参数,以及环境因素对机器人运动的影响,设计出合理的运动轨迹和策略。

2. 实现方法(1)运动规划:根据任务需求和环境因素,为NAO机器人规划出合理的运动轨迹和姿态。

(2)运动控制:通过控制算法和执行器,实现对NAO机器人运动的精确控制。

幼儿园STEM教育实践案例:让孩子与机器人亲密接触

幼儿园STEM教育实践案例:让孩子与机器人亲密接触STEM教育是当前教育领域中热门的话题,幼儿园阶段应该如何实施STEM教育也成为了教育者思考的问题之一。

本文将介绍一种幼儿园STEM教育实践案例,即通过让孩子与机器人亲密接触来激发他们的兴趣和探索精神。

一、背景介绍该实践案例发生在一家私立幼儿园,幼儿园坐落于城市中心区域,拥有120名幼儿和15名教师。

在这个幼儿园中,STEM教育被视为一个非常重要的教育领域。

二、实践过程1. 选择适当的机器人教育者为幼儿们选择了一些适合他们年龄阶段的机器人,这些机器人不仅可以满足幼儿们的好奇心和探索欲望,还兼具趣味性和可操作性。

例如,“小胖子”机器人是一款充气的、能够唱歌跳舞的机器人,孩子们非常喜欢该机器人的表演和互动形式;“童趣机器人”可以模拟多种动物叫声和运动,孩子们可以模仿和学习这些动物的特征和行为。

2. 让孩子们学习机器人相关知识在让孩子们与机器人亲密接触之前,教育者为他们讲解了一些机器人的相关知识,包括机器人的组成部分、工作原理、用途等。

这样可以帮助孩子们更好地理解机器人,并增加他们的科学素养。

3. 让孩子们操作机器人在学习了相关知识之后,教育者让孩子们分组操作机器人。

教育者提供简单的指导,例如如何启动机器人、如何调整音量、如何操作机器人的手臂和舞蹈等。

这一过程中,孩子们不仅可以了解机器人的操作方法,还可以感受到用自己的手操作机器人的乐趣和成就感。

4. 让孩子们设计自己的机器人在孩子们逐渐熟悉机器人之后,教育者组织了一项有趣的活动,即让孩子们设计自己的机器人。

教育者为他们提供了足够的材料和工具,例如纸板、剪刀、胶水、电线等,让孩子们自主选择并组合这些材料,制作出自己的机器人作品。

在这个过程中,孩子们不仅可以创造自己的机器人,还可以锻炼自己的动手能力和想象力。

三、实践效果1. 提高了孩子们的STEM意识通过与机器人亲密接触,孩子们对STEM教育的理解和认识得到了提高。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Child’s Recognition of Emotions in Robot’s Face and BodyIris CohenTNO/University Utrecht i.cohen1@Rosemarijn LooijeTNO Human Factorsrosemarijn.looije@tno.nlMark A. NeerincxTNO/Delft University of Technologymark.neerincx@tno.nlABSTRACTSocial robots can comfort and support children who have to cope with chronic diseases. In previous studies, a “facial robot”, the iCat, proved to show well-recognized emotional expressions that are important in social interactions. The question is if a mobile robot without a face, the Nao, can express emotions with its body. First, dynamic body postures were created and validated that express fear, happiness, anger, sadness and surprise. Then, fourteen children had to recognize emotions, expressed by both robots. Recognition rates were relatively high (between 68% and 99% accuracy). Only for the emotion “sad”, the recognition was better for the iCat (95%) compared to the Nao (68%). Providing context increased the number of correct recognitions. In a second session, the emotions were significantly better recognized than during the first session for both robots. In sum, we succeeded to design Nao emotions, which were well recognized and learned, and can be important ingredients of the social dialogs with children.ACM Classification Keywords:I.2.9 [Artificial Intelligence]: Robotics, H.1.2 [Models and Principals]: User/Machine Systems - Software psychology General Terms:Human Factors, ExperimentationAuthors Keywords:Social robots, persuasive technology, emotions, children, affective body posture, facial expression.1. INTRODUCTIONWith computers and robots stepping out of their industrial environment and into the human society, they can be of surprising help in the healthcare. “Non-interactive” robots can provide support for surgical, rehabilitation and medication delivery purposes, whereas “highly interactive” robots can provide more cognitive, affective and social support [6]. Our research focuses on the latter, social robots, and their potential to comfort or support children who have to cope with a chronic disease.The iCat is a robotic research platform with movable eyes, eyelids, eyebrows and lips. It has the ability to show facial expressions and thus show emotions. The six basic emotions were programmed into the iCat and validated by Kessens et al.[5]. The Nao robot is a humanoid robot that doesn’t have moveable facial features like the iCat does, but has the ability to alter its body posture and thus show affective postures. The Nao also has the ability to show different colors in its eyes and this Copyright is held by the author/owner(s).HRI’11, March 6–9, 2011, Lausanne, Switzerland.ACM 978-1-4503-0561-7/11/03.can help to strengthen the emotions being expressed. The colors that will be used are those investigated by Kaya and Epps [4]. This article describes two experiments. In the first one, a set of dynamic emotional postures for the Nao will be created and validated. In the second the question is if the emotions are recognized more accurate with the iCat (facial expression) or with the Nao (body posture). An additional question is if the emotion recognition is better when the emotional expression is presented in a corresponding context for both robots. A third question concerns repeated exposures. Does it get easier to recognize emotions in a second time contact, than after the first session for both robots?2. EXPERIMENT 1First, emotional postures for the Nao needed to be created. Four emotional postures, anger, fear, happiness and sadness were based on research by Bianchi-Berthouze and Kleinsmith [2] and one posture, surprise was based on research by Coulsen [3]. For anger, fear and happiness, two postures were created for the Nao, for sad, three postures were created and for surprise one posture was created.2.1 MethodsA signal-detection task was used to validate the postures. Every emotion had a trial, where the participants had to indicate whether they saw a certain emotion (signal), or a different emotion (noise).2.2 ResultsThe hit-rates and false-alarm rates were then calculated (see table 1). D’ was calculated by the Z-score of the hit-rate minus the Z-score of the false alarm-rate and shows the discriminability between the trial emotion (signal) and different emotions (noise).Table 1Hits, false alarms, hit rate, false alarm rate and d’.Angry1 12 1 3 0.75 0.01 2.92 Angry2 14 1 2 0.87 0.01 3.39Fear1 14 3 2 0.87 0.04 2.93Fear2 11 3 4 0.69 0.04 2.27 Happy1 14 0 2 0.87 0 0.97 Happy2 12 0 4 0.72 0 0.94 Sad1 11 1 5 0.69 0.01 2.73Sad2 7 1 1 0.88 0.01 3.46Sad3 3 1 4 0.38 0.01 1.99 Surprise 22 3 10 0.69 0.05 2.16A higher d’, means a higher discriminability between the trial emotion and a noise emotion. The posture with the highest d’ was chosen as the posture for that emotion. For anger andsadness, the second posture was chosen and for fear and happiness the first posture was chosen. The surprise posture was altered to make a better recognizable emotion with the help of vocal feedback from the participants.2.3 ConclusionWith these results the final postures were chosen and for surprised the final posture was altered. The postures are shown in figure 2 and can be seen at the following link:http://mmi.tudelft.nl/SocioCognitiveRobotics/index.php/SocioC ognitiveRobotics3. EXPERIMENT 2With the robots both having validated emotional expressions (see figure 1 and 2), the actual experiment was conducted.Figure 1. A scared, happy, angry, sad and surprised iCatFigure 2. A scared, happy, angry, sad and surprised Nao3.1 MethodsParticipantsFourteen children between 8 and 9 years, were recruited from anelementary school in the Netherlands.ProcedureThe children came to the experiment room and interacted twicewith both robots. A ‘context’ interaction and a ‘no-context’interaction. The orders of the interactions were counterbalancedto reduce order effects. In the context interactions, a story wastold by the computer. The robots showed emotions appropriateto the story. In the ‘no-context’ interaction, the robots showedthe emotions without a story. On a questionnaire the childrencould fill in what emotion they thought the robot had shown.3.2 RESULTSCorrect recognition rates for the emotions are calculated. For theiCat, fear had a recognition of 88.39%, happy had a rate of73.21%, angry had 99.11%, sad 94.64% and for surprised,69.64% was correctly recognized. For the Nao, the percentagesof correct recognitions for fear, happy, angry, sad and surprisedwere 87.5%, 89.28%, 96.43%, 67.86% and 68.75% respectively.Then, an ANOVA (figure 3) showed that there was no overallsignificant difference of recognition accuracy between the iCatand Nao emotions F(1, 1118)=1.24, p=0.27. Emotions expressedin context were significantly better recognized than emotionsexpressed without a context F(1, 1118) = 29.79, p = .00.And last, in the second session, emotions were better recognizedthan in the first session (F(1, 1118) = 18.76, p = .00).Figure 3. Factorial ANOVA with three variables: robot,session and context.3.3 ConclusionThe main research questions focused on the difference inemotion recognition for the two robots, the effects of contextand learning effects.Only for the sad emotion, the iCat’s expression was significantlybetter recognized than the Nao’s posture, but when looking atthe entire set of emotions, no difference was found betweenfacial and body posture expression.It was expected that the emotions will be better recognized whenthey are being expressed in the context condition [1]. Theconducted ANOVA shows that this is indeed the case.The last and final hypothesis stated that in the second session thecorrect recognition rates would be higher than in the firstsession. This was based on Nelson’s review [7] which concludethat the skill for emotion recognition increases with multipleexperiences. This hypotheses was supported by the results.4. REFERENCES[1] Barrett, L.F., Lindquist, K. A., & Gendron, M. 2008.Language as context for the perception of emotion. Trendscognitive science. 11 (8).[2] Bianchi-Berthouze, N., & Kleinsmith, A. (2003). Acategorical approach to affective gesture recognition.Connection science. 15 (4).[3] Coulsen, M. (2004). Attributing emotion to static bodypostures: recognition accuracy, confusion, and viewpointdependence. Journal of Nonverbal Behavior, 28(2).[4] Kaya, N., & Epps, H. (2004). Relationship between colorand emotion: a study of college students. College studentjournal. 38. 3[5] Kessens, J.M., Neerincx, M.A., Looije, R., Kroes, M., &Bloothooft, G. (2009). Facial and vocal emotion expressionof a personal computer assistant to engage, educate andmotivate children. IEEE 2009.[6] Nejat, G., Sun, Y., & Nies, M., (2009). Assistive robots inhealth care settings. Home health care management &practice. 21(3).[7] Nelson, C.A. (2001). The development and neural bases offace recognition. Infant and child development. 10, 3-8.。