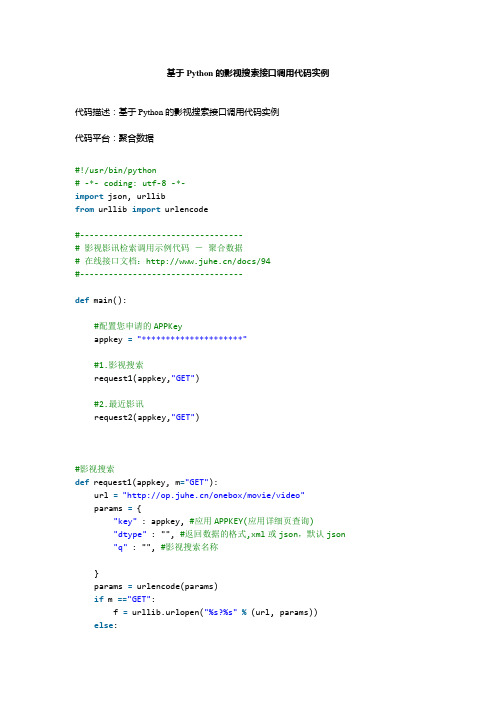

基于Python的影视搜索接口调用代码实例

python爬电影 代码 -回复

python爬电影代码-回复Python爬电影代码在编写Python爬电影的代码之前,我们需要先了解爬虫的基本工作原理以及所需的库。

爬虫是一种自动化程序,通过网络请求获取页面上的数据,并将其解析和提取。

Python是一门功能强大且易于学习的编程语言,适合用于编写爬虫。

以下是一步一步回答如何使用Python爬取电影数据的整个过程。

第一步:安装所需的库在开始之前,我们需要安装一些Python库。

这些库将帮助我们进行网络请求、HTML解析和数据处理。

使用以下命令安装所需的库:pip install requestspip install BeautifulSoup4第二步:发送网络请求并获取网页内容要爬取电影数据,我们首先需要找到电影网站。

我们可以选择像IMDb、豆瓣电影或猫眼电影这样的网站。

在这篇文章中,我们将以IMDb电影网站为例。

使用以下代码发送网络请求并获取网页内容:pythonimport requestsurl = "response = requests.get(url)content = response.text在上面的代码中,我们使用requests库发送一个GET请求,获取IMDb 电影排行榜的网页内容。

我们将网页内容存储在变量`content`中,我们将在后面的步骤中使用它。

第三步:解析HTML并提取电影数据通过以下代码解析HTML并提取电影数据:pythonfrom bs4 import BeautifulSoupsoup = BeautifulSoup(content, "html.parser")table = soup.find("table", class_="chart")rows = table.find_all("tr")movies = []for row in rows[1:]:cells = row.find_all("td")title = cells[1].find("a").string.strip()year = cells[1].find("span",class_="secondaryInfo").string.strip("()")rating = cells[2].find("strong").string.strip()movies.append({"title": title, "year": year, "rating": rating})在上面的代码中,我们使用BeautifulSoup库解析网页内容。

python爬电影 代码

python爬电影代码摘要:1.Python 爬虫电影资源的概述2.Python 爬虫电影资源的实现方法3.Python 爬虫电影资源的应用案例4.Python 爬虫电影资源的发展前景正文:随着互联网的发展,电影资源的获取变得越来越便捷。

Python 爬虫作为一种网络数据抓取技术,在电影资源的获取上具有很大的优势。

本文将从Python 爬虫电影资源的概述、实现方法、应用案例和发展前景四个方面进行阐述。

一、Python 爬虫电影资源的概述Python 爬虫,即Web 爬虫,是一种自动获取网页信息的程序。

利用Python 爬虫技术,可以快速获取网站上的电影资源,包括电影名称、演员、导演、上映时间等信息。

这对于电影爱好者来说,无疑是一个很好的工具。

二、Python 爬虫电影资源的实现方法要实现Python 爬虫电影资源,需要以下几个步骤:1.导入所需库:在Python 中,有很多库可以用于实现爬虫,如requests、BeautifulSoup、Scrapy 等。

首先需要导入这些库。

2.发送请求:利用requests 库发送HTTP 请求,获取目标网页的数据。

3.解析网页:通过BeautifulSoup 库解析网页,提取所需的电影信息。

4.存储数据:将提取到的电影信息存储到本地文件或数据库中,方便后续使用。

三、Python 爬虫电影资源的应用案例一个典型的Python 爬虫电影资源应用案例是制作一个电影资源搜索引擎。

用户可以在搜索引擎中输入关键词,如电影名称、演员等,系统会自动从网络上抓取相关电影资源,并展示给用户。

这样,用户可以快速找到自己感兴趣的电影。

四、Python 爬虫电影资源的发展前景随着我国电影市场的快速发展,电影资源的需求越来越大。

Python 爬虫作为一种有效的数据抓取工具,其在电影资源获取方面的应用前景非常广阔。

未来,Python 爬虫电影资源应用将在数据抓取速度、数据处理能力、用户体验等方面不断优化,为用户提供更好的服务。

《2024年基于Python影评数据挖掘与分析——以《你好,李焕英》为例》范文

《基于Python影评数据挖掘与分析——以《你好,李焕英》为例》篇一一、引言随着互联网的普及和大数据技术的不断发展,影评数据作为一种重要的文化资源,越来越受到研究者的关注。

影评数据中蕴含着大量的用户情感、观点、评价等信息,通过数据挖掘与分析,可以揭示电影的受众喜好、电影口碑等重要信息。

本文以《你好,李焕英》为例,通过Python语言进行影评数据的挖掘与分析,旨在深入了解观众对该电影的评价及反馈。

二、数据采集与预处理1. 数据采集首先,我们通过爬虫技术从各大电影评论网站、社交媒体等平台收集《你好,李焕英》的影评数据。

在采集过程中,我们主要关注影评的标题、内容、评分、发布时间、用户信息等关键数据。

2. 数据预处理收集到的原始数据需要进行预处理,包括去除重复数据、清洗无效数据、进行文本分词、去除停用词等。

此外,我们还需要对数据进行情感分析,将文本数据转化为情感得分,以便后续分析。

三、基于Python的数据分析1. 情感分析我们使用Python中的情感分析库对影评数据进行情感分析。

通过计算每条影评的情感得分,我们可以了解观众对《你好,李焕英》的整体情感倾向。

分析结果表明,该电影的情感得分为正,说明观众对该电影的评价较为积极。

2. 主题模型分析我们使用Python中的主题模型算法对影评数据进行主题分析。

通过构建主题模型,我们可以发现观众对《你好,李焕英》的评价主要集中在哪些方面。

分析结果表明,该电影的主题包括剧情、演员表现、导演功力、情感表达等方面。

3. 用户画像分析我们通过分析用户的性别、年龄、地域等信息,构建用户画像。

通过对不同用户群体的影评数据进行分析,我们可以了解不同用户群体对《你好,李焕英》的评价差异。

例如,我们发现年轻观众对该电影的评价更为积极,而中老年观众则更关注电影的剧情和演员表现。

四、结果与讨论1. 结果展示通过上述分析,我们可以得到以下结果:(1)观众对《你好,李焕英》的情感倾向较为积极;(2)该电影的主题包括剧情、演员表现、导演功力、情感表达等方面;(3)不同用户群体对电影的评价存在差异。

基于 python 的电影爬虫设计与实现

基于 python 的电影爬虫设计与实现基于 Python 的电影爬虫设计与实现引言:电影作为一种重要的文化艺术形式,能够给人们带来欢乐、思考和感悟。

随着互联网的普及和发展,越来越多的人选择在网上观看电影。

然而,如何找到自己感兴趣的电影,成为了一个让人头疼的问题。

本文将介绍如何使用基于 Python 的电影爬虫来解决这个问题。

一、爬虫的原理和作用爬虫是一种自动化程序,通过模拟人的行为,从网页中提取有用的信息。

在电影爬虫中,我们可以利用爬虫技术从电影网站上获取电影的相关信息,如电影名称、演员、导演、评分等。

这些信息可以帮助我们了解电影的基本情况,从而方便我们进行选择和观看。

二、电影爬虫的设计思路1. 确定目标网站:首先,我们需要确定一个电影网站作为爬取的目标。

常见的电影网站有豆瓣电影、IMDb等。

本文以豆瓣电影为例进行说明。

2. 分析网站结构:接下来,我们需要分析目标网站的结构,找到存储电影信息的位置。

在豆瓣电影中,电影信息通常存储在网页的特定标签中,如<div class="info">等。

3. 编写爬虫代码:根据网站结构的分析结果,我们可以编写相应的爬虫代码。

在Python 中,可以使用第三方库,如BeautifulSoup、Requests等来实现网页的解析和数据的抓取。

4. 数据存储和展示:爬取到的电影信息可以存储到数据库中,也可以生成一个电影列表网页来展示。

在这里,我们可以使用Python的数据库模块,如SQLite3来进行数据存储,也可以使用Django等框架来搭建电影列表网页。

三、电影爬虫的实现步骤1. 导入所需库:在开始编写代码之前,需要导入所需的库,如BeautifulSoup、Requests等。

2. 发送请求获取网页内容:使用Requests库发送HTTP请求,获取目标网页的内容。

3. 解析网页内容:使用BeautifulSoup库将网页内容进行解析,提取出有用的电影信息。

python爬电影 代码

python爬电影代码如何使用Python爬取电影信息并保存到CSV文件中?Python是一种功能强大的编程语言,广泛用于Web 开发、数据分析和爬虫等领域。

在本文中,我们将探讨如何使用Python编写一个简单的网络爬虫来获取电影信息,并将其保存在一个CSV文件中。

1. 第一步,我们需要安装所需的库。

在Python中,有很多实用的库可用于网络爬虫任务。

在这个例子中,我们将使用`requests`库来发送HTTP 请求,并使用`BeautifulSoup`库来解析HTML页面。

可以通过运行以下命令来安装这两个库:`pip install requests beautifulsoup4`2. 在正式开始爬取之前,我们首先需要确定我们要从哪个网站获取电影信息。

在这个例子中,我们将使用IMDb(互联网电影数据库)作为我们的数据源。

IMDb是一个包含大量电影信息的网站,包括电影标题、演员、导演、评分等。

3. 打开你喜欢的集成开发环境(IDE)或文本编辑器,并创建一个新的Python文件。

我们将在文件的顶部导入所需的库:pythonimport requestsfrom bs4 import BeautifulSoupimport csv4. 在这个例子中,我们将获取IMDb网站上的电影信息。

为了演示方便,我们只爬取首页上的电影信息。

我们首先需要定义一个函数来获取HTML 页面的内容:pythondef get_html(url):response = requests.get(url)return response.text在这个函数中,我们使用`requests.get()`方法向指定的URL发送HTTP GET请求,并使用`return`语句返回响应的文本内容。

5. 接下来,我们将解析HTML页面以提取电影信息。

我们可以使用`BeautifulSoup`库来解析页面。

创建一个新函数来解析页面并提取电影信息:pythondef parse_html(html):soup = BeautifulSoup(html, 'html.parser')movies = []for movie_container in soup.find_all('div',class_='lister-item-content'):title = movie_container.h3.a.textrating = movie_container.find('div',class_='ratings-bar').strong.textdirector = movie_container.find('p',class_='').find_all('a')[0].textactors = [a.text for a in movie_container.find('p', class_='').find_all('a')[1:]]movies.append({'Title': title, 'Rating': rating, 'Director': director, 'Actors': actors})return movies在这个函数中,我们首先创建一个BeautifulSoup对象,使用`html.parser`作为解析器。

7个经典python爬虫案例代码分享

Python作为一种简单易学的编程语言,广受程序员和数据科学家的喜爱。

其中,用Python进行网络爬虫的应用也越来越广泛。

本文将共享7个经典的Python爬虫案例代码,希望能够给大家带来启发和帮助。

1. 爬取豆瓣电影排行榜数据在本例中,我们将使用Python的requests库和BeautifulSoup库来爬取豆瓣电影排行榜的数据。

我们需要发送HTTP请求获取网页内容,然后使用BeautifulSoup库解析HTML文档,提取出我们需要的电影名称、评分等信息。

我们可以将这些数据保存到本地或者进行进一步的分析。

```pythonimport requestsfrom bs4 import BeautifulSoupurl = 'response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')for movie in soup.find_all('div', class_='item'):title = movie.find('span', class_='title').textrating = movie.find('span', class_='rating_num').textprint(title, rating)```2. 爬取博博用户信息在这个案例中,我们将利用Python的requests库和正则表达式来爬取博博用户的基本信息。

我们需要登录博博并获取用户主页的URL,然后发送HTTP请求获取用户主页的HTML文档。

我们可以使用正则表达式来提取用户的昵称、性别、位置区域等信息。

我们可以将这些信息保存到数据库或者进行其他处理。

```pythonimport requestsimport reurl = 'response = requests.get(url)pattern = repile(r'<title>(.*?)</title>.*?昵称:(.*?)<.*?性别:(.*?)<.*?地区:(.*?)<', re.S)result = re.search(pattern, response.text)if result:username = result.group(2)gender = result.group(3)location = result.group(4)print(username, gender, location)```3. 爬取新浪新闻在这个案例中,我们将使用Python的requests库和XPath来爬取新浪新闻的标题和信息。

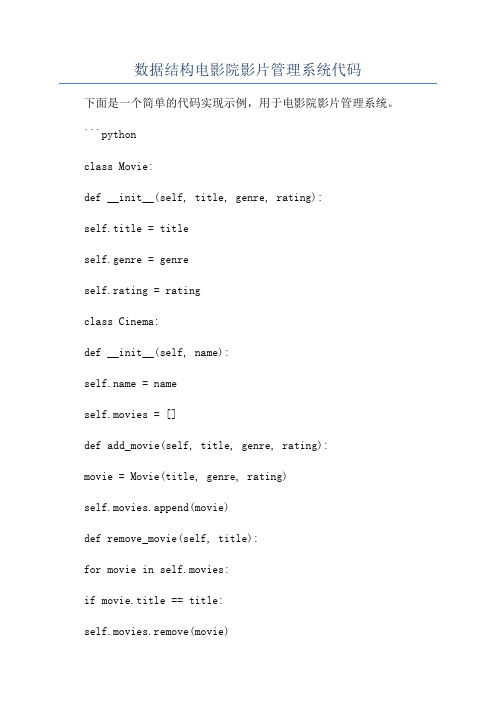

数据结构电影院影片管理系统代码

数据结构电影院影片管理系统代码下面是一个简单的代码实现示例,用于电影院影片管理系统。

```pythonclass Movie:def __init__(self, title, genre, rating):self.title = titleself.genre = genreself.rating = ratingclass Cinema:def __init__(self, name): = nameself.movies = []def add_movie(self, title, genre, rating):movie = Movie(title, genre, rating)self.movies.append(movie)def remove_movie(self, title):for movie in self.movies:if movie.title == title:self.movies.remove(movie)breakdef get_movies(self):return self.moviesdef search_by_genre(self, genre):result = []for movie in self.movies:if movie.genre == genre:result.append(movie)return resultdef search_by_rating(self, rating):result = []for movie in self.movies:if movie.rating == rating:result.append(movie)return resultdef main(:cinema = Cinema("My Cinema")cinema.add_movie("Avengers: Endgame", "Action", 9.5) cinema.add_movie("Joker", "Drama", 8.8)cinema.add_movie("Frozen 2", "Animation", 7.6)print("All movies:")for movie in cinema.get_movies(:print(f"{movie.title} ({movie.genre}) - {movie.rating}") genre = "Action"print(f"\nMovies in genre '{genre}':")for movie in cinema.search_by_genre(genre):print(f"{movie.title} ({movie.genre}) - {movie.rating}") rating = 8.8print(f"\nMovies with rating {rating}:")for movie in cinema.search_by_rating(rating):print(f"{movie.title} ({movie.genre}) - {movie.rating}") title = "Joker"cinema.remove_movie(title)print(f"\nMovie '{title}' removed.")print("\nUpdated movie list:")for movie in cinema.get_movies(:print(f"{movie.title} ({movie.genre}) - {movie.rating}") if __name__ == "__main__":main```这个代码实现了电影和电影院两个类。

《2024年基于Python爬虫和聚类的热映电影数据抓取与可视化设计》范文

《基于Python爬虫和聚类的热映电影数据抓取与可视化设计》篇一一、引言随着互联网的飞速发展,网络资源日趋丰富,数据获取变得越来越容易。

而Python语言因其简洁的语法和强大的功能,被广泛运用于网络爬虫的编写中。

本文旨在通过Python爬虫技术,从各大电影网站抓取热映电影数据,并结合聚类算法进行数据处理与分析,最后以可视化设计的方式呈现结果。

旨在通过这种方法,为用户提供更为直观、高效的电影选择建议。

二、热映电影数据的爬取首先,我们利用Python中的爬虫框架(如requests库、BeautifulSoup等)对各大电影网站进行数据的抓取。

我们针对网站的特定URL,利用爬虫模拟浏览器行为,对网页进行解析,提取出我们所需的数据。

这些数据包括电影名称、导演、演员、上映时间、票房等关键信息。

在爬取过程中,我们要遵循网站的规定和robots协议,保证数据抓取的合法性。

三、数据的预处理与聚类分析抓取到数据后,我们需要对数据进行预处理。

这包括去除重复数据、清洗无效数据、对数据进行格式化等操作。

接着,我们利用聚类算法对电影数据进行分类。

聚类算法是一种无监督学习方法,能够将数据集按照其相似性进行分组。

在电影数据的聚类中,我们可以根据电影的票房、评价、导演等特征进行聚类分析,得到不同类型的电影。

四、聚类结果的可视化设计聚类分析的结果需要以可视化的方式呈现出来,以便用户更好地理解和使用。

我们可以利用Python中的数据可视化库(如matplotlib、seaborn等)进行设计。

例如,我们可以将不同类型的电影以树状图或散点图的形式呈现出来,通过颜色、大小等视觉元素来区分不同类型的电影。

此外,我们还可以利用热力图等工具展示电影的票房、评价等关键指标的变化趋势。

五、结论与展望通过Python爬虫和聚类算法的结合,我们能够有效地从各大电影网站抓取热映电影数据并进行处理分析。

通过可视化设计的方式,我们可以将复杂的电影数据以直观、易懂的方式呈现给用户。

调用bangumi api示例

调用bangumi api示例全文共四篇示例,供读者参考第一篇示例:调用bangumi api是一种获取番剧信息的常用方法,通过这种方式可以快捷地获取到各种番剧的信息,包括名称、播放时间、简介、评分等等。

在进行番剧推荐、数据分析等工作时,调用bangumi api 是非常方便的选择。

本文将介绍如何使用bangumi api以及展示一些示例代码。

我们需要了解一下bangumi api的基本信息。

bangumi api是一种RESTful API,可以通过发送HTTP请求来获取番剧信息。

具体的url 为:https://。

通过该api,我们可以获取到各种番剧的信息,包括正在热播的番剧、新番、排行榜等等。

接下来,我们将展示一些调用bangumi api的示例代码。

首先是使用Python进行调用的示例代码:```pythonimport requestsurl = "https:///calendar"response = requests.get(url)在这段代码中,我们首先发送了一个GET请求到https:///calendar这个url,然后判断返回的状态码是否为200,如果是的话将返回的json数据遍历输出番剧的名称、播放时间、周几播放。

这是一个简单的示例,通过这段代码可以获取到最近将要播放的番剧信息。

接下来,我们再看一个使用JavaScript进行调用的示例代码:fetch(url).then(response => response.json()).then(data => console.log(data)).catch(error => console.error('Error:', error));```第二篇示例:Bangumi API(番组API)是一个提供关于动漫、番剧等相关信息的API 接口,能够让开发者快速获取各种番组数据,比如动画、漫画、音乐等。

python爬电影 代码 -回复

python爬电影代码-回复Python爬取电影的代码在这篇文章中,我们将学习如何使用Python语言编写一个简单的网络爬虫程序,以爬取电影网站上的电影信息。

我们将从设置环境开始,一步一步地讲解每个代码片段的作用和实现过程。

1. 环境设置:首先,我们需要安装Python解释器和一些必要的库来执行爬虫程序。

我们可以从Python官方网站下载和安装Python。

同时,我们需要安装requests和BeautifulSoup库。

可以使用以下命令来安装这些库:pip install requestspip install beautifulsoup42. 导入库:在编写任何代码之前,我们需要导入所需的库。

这些库包括requests、BeautifulSoup和csv。

pythonimport requestsfrom bs4 import BeautifulSoupimport csv3. 获取HTML内容:接下来,我们需要使用requests库来获取电影网站的HTML内容。

我们可以使用以下代码来获取内容并存储在一个变量中:pythonurl = 'response = requests.get(url)content = response.text在这段代码中,我们将电影网站的URL存储在一个变量中,并使用requests库发送一个GET请求。

然后,我们将响应的内容保存在一个变量中。

4. 解析HTML内容:接下来,我们需要使用BeautifulSoup库来解析HTML内容。

这样,我们就可以提取所需的电影信息。

在下面的代码片段中,我们使用BeautifulSoup来解析内容,并使用所需的HTML标签和类名来定位电影信息。

pythonsoup = BeautifulSoup(content, 'html.parser')movies = soup.find_all('div', class_='movie')在上面的代码中,我们创建一个BeautifulSoup对象,并传入之前获取的HTML内容以及指定的解析器。

14个python爬虫案例

14个Python爬虫案例1. 案例背景在信息时代,互联网上的数据量巨大且丰富。

为了从中获取特定的数据,人们常常需要编写爬虫程序来实现自动化数据采集。

Python作为一种简洁而又强大的编程语言,在爬虫开发中得到了广泛应用。

本文将介绍14个Python爬虫案例,并对其背景、过程和结果进行详细描述,以展示Python爬虫的强大功能。

2. 案例1: 爬取豆瓣电影信息2.1 背景豆瓣是一个电影资讯网站,用户可以在网站上查找电影信息、评论电影等。

我们希望通过爬虫程序获取豆瓣电影的名称、评分和简介等信息,以便进行数据分析或制作推荐系统。

2.2 过程•使用Python的Requests库发送HTTP请求获取豆瓣电影网页的HTML源码。

•使用BeautifulSoup库解析HTML源码,提取电影名称、评分和简介等信息。

•使用数据库或文件存储提取的电影信息,以便后续使用或分析。

2.3 结果通过该爬虫程序,我们可以获取豆瓣电影的详细信息,并存储在数据库或文件中,方便后续分析和使用。

3. 案例2: 爬取新浪新闻标题3.1 背景新浪是中国最大的综合门户网站之一,提供丰富的新闻内容。

我们希望通过爬虫程序获取新浪新闻的标题,以便进行新闻数据分析或制作新闻推荐系统。

3.2 过程•使用Python的Requests库发送HTTP请求获取新浪新闻网页的HTML源码。

•使用正则表达式或BeautifulSoup库解析HTML源码,提取新闻标题。

•使用数据库或文件存储提取的新闻标题,以便后续使用或分析。

3.3 结果通过该爬虫程序,我们可以获取新浪新闻的标题,并存储在数据库或文件中,方便后续分析和使用。

4. 案例3: 爬取京东商品信息4.1 背景京东是中国最大的综合性电商平台之一,拥有庞大的商品库存和丰富的商品种类。

我们希望通过爬虫程序获取京东的商品信息,以便进行商品数据分析或制作商品推荐系统。

4.2 过程•使用Python的Requests库发送HTTP请求获取京东商品网页的HTML源码。

《2024年基于Python爬虫的电影数据可视化分析》范文

《基于Python爬虫的电影数据可视化分析》篇一一、引言随着互联网的飞速发展,网络信息日益丰富。

电影作为人们休闲娱乐的重要方式之一,其相关数据具有极高的研究价值。

本文旨在通过Python爬虫技术获取电影数据,并利用数据可视化技术对电影数据进行深入分析,以期为电影产业及相关从业者提供有价值的参考。

二、电影数据爬取1. 确定数据源首先,我们需要确定电影数据的数据源。

本例中,我们选择知名的电影数据库IMDb作为数据源。

IMDb拥有丰富的电影数据,包括电影名称、导演、演员、上映时间、票房等。

2. Python爬虫技术利用Python的爬虫技术,我们可以从IMDb网站爬取所需的数据。

具体步骤包括:发送HTTP请求、获取HTML页面、解析HTML页面、提取所需数据等。

在爬取过程中,需要注意遵守网站的robots协议,避免对网站造成不良影响。

三、数据清洗与整理1. 数据清洗从网站上爬取的数据可能存在一些噪声数据或缺失值,需要进行数据清洗。

数据清洗包括去除重复数据、处理缺失值、纠正错误数据等。

2. 数据整理将清洗后的数据整理成适合分析的格式,如CSV、Excel等。

同时,还需要对数据进行分类、编码等处理,以便于后续的分析。

四、数据可视化分析1. 选用的可视化工具本例中,我们选用Python的matplotlib、seaborn和pyecharts 等工具进行数据可视化分析。

这些工具具有丰富的图表类型和强大的数据处理能力,能够满足我们的分析需求。

2. 电影票房分析以电影票房为例,我们可以将不同年份的电影票房数据进行可视化分析。

通过绘制折线图或柱状图,可以直观地展示电影票房的变化趋势。

同时,还可以通过比较不同类型电影的票房数据,分析电影类型对票房的影响。

3. 导演与演员分析通过分析导演和演员的电影作品数量、票房等信息,可以评估他们的市场影响力。

我们可以绘制饼图或散点图,展示导演和演员的分布情况以及他们之间的合作关系。

Python网络爬虫的电影与影视信息抓取与分析实例

Python网络爬虫的电影与影视信息抓取与分析实例随着互联网的发展和智能设备的普及,人们对电影和影视剧的需求也日益增加。

而获取电影和影视剧的相关信息对于观众和行业从业者来说十分重要。

本文将介绍使用Python编写网络爬虫来抓取电影和影视剧的相关信息,并使用数据分析的方法对这些信息进行分析。

一、爬取电影和影视剧信息为了抓取电影和影视剧的相关信息,我们可以利用Python的一些库,如requests库和BeautifulSoup库。

具体步骤如下:1. 寻找合适的网站:首先我们需要找到一个提供电影和影视剧信息的合适网站。

通常,一些电影数据库和影视剧资源网站会提供电影和影视剧的详细信息,包括片名、导演、主演、剧情介绍等。

2. 发送请求并获取网页内容:使用requests库向选定的网站发送HTTP请求,并获取网页的HTML内容。

3. 解析网页内容:使用BeautifulSoup库对获取的网页内容进行解析,提取出电影和影视剧的相关信息。

4. 存储数据:将抓取到的电影和影视剧信息存储到文件或数据库中,以供后续分析使用。

二、分析电影和影视剧信息在抓取了足够的电影和影视剧信息后,我们可以对这些数据进行分析。

这些数据可以包括电影和影视剧的评分、上映时间、类型等。

1. 统计不同类型电影的数量:我们可以从抓取到的电影信息中提取电影的类型,并统计各类型电影的数量。

这样可以帮助我们了解不同类型电影在市场上的分布情况。

2. 分析电影评分:将电影的评分进行统计和分布分析,可以帮助我们了解观众对于不同电影的评价和喜好。

3. 探索电影上映时间:通过对电影的上映时间进行分析,我们可以了解电影的发展趋势和市场变化。

4. 比较不同导演和演员的作品评分:将电影和影视剧的导演和演员进行统计和比较,可以了解他们的作品在观众中的口碑和认可程度。

三、实例应用——订阅推荐系统除了对电影和影视剧信息进行抓取和分析,我们还可以利用这些信息构建一个订阅推荐系统。

python抓取电影天堂案例笔记

python抓取电影天堂案例笔记1.导入模块。

首先需要导入一些必要的模块,例如requests、beautifulsoup4等,具体代码如下:```python。

import requests。

from bs4 import BeautifulSoup。

```。

2.获取页面。

使用requests.get()方法获取页面内容,可以通过修改url来获取不同的页面,具体代码如下:```python。

res = requests.get(url)。

res.encoding = 'gb2312'。

```。

在获取页面时需要注意页面的编码方式,通过res.encoding来指定编码方式。

3.解析页面。

使用BeautifulSoup解析页面,可以通过CSS选择器和正则表达式来获取需要的信息。

通过查看HTML源代码可以确定需要获取的标签和属性,具体代码如下:```python。

soup = BeautifulSoup(res.text, 'html.parser')。

new_movies = soup.select('.co_content8 .ulink')。

```。

其中,.co_content8和.ulink是CSS选择器,表示获取class为co_content8的标签及其下属class为ulink的标签。

获取到的结果是一个列表,可以遍历列表获取电影名称及其详情页链接。

```python。

for movie in new_movies:。

print('片名:'+ movie.get_text())。

print('详情页链接:'+ url + movie['href'])。

```。

4.获取详细信息。

根据详情页链接获取详细信息,可以通过requests.get()方法获取页面内容,再使用BeautifulSoup解析页面。

Python爬虫项目实战源码案例分析

Python爬虫项目实战源码案例分析Python爬虫是一种自动化提取互联网信息的技术,可以用于抓取网页、解析数据、爬取图片、视频等,在各种领域都有广泛的应用。

本文将分析几个Python爬虫项目的实战源码案例,以展示其实际应用价值和技术特点。

1. 网页抓取项目:豆瓣电影Top250豆瓣电影Top250网页包含了250部高评分电影的信息,我们可以通过Python爬虫将其抓取下来并进行数据分析。

首先,我们需要使用相关库(如requests、BeautifulSoup)发送HTTP请求获取网页内容,然后利用正则表达式或BeautifulSoup解析页面数据,最后将获取的数据存储到本地文件或数据库中。

通过分析数据,我们可以得出电影评分排行榜、评分分布情况等有价值的信息。

2. 数据解析项目:天气数据抓取与分析天气数据是人们关心的重要信息之一,我们可以使用Python爬虫抓取各地区的天气数据并进行分析。

首先,我们需要选择一个天气数据网站,然后通过Python发送HTTP请求获取网页内容。

接下来,使用相关技术(如XPath、正则表达式或BeautifulSoup)解析页面数据,提取出我们需要的天气信息(如温度、风力等)。

最后,我们可以将数据可视化,如制作天气趋势图、比较各地区温度差异等。

3. 图片爬取项目:壁纸图片批量下载壁纸图片是人们常用的个性化装饰素材,我们可以利用Python爬虫批量下载高清壁纸图片。

首先,我们需要找到壁纸图片网站,并通过Python发送HTTP请求获取网页内容。

然后,使用相关技术(如正则表达式或BeautifulSoup)解析页面数据,提取出图片的URL地址。

最后,通过Python的文件操作功能,将图片下载到本地指定目录。

这样,我们就可以方便地获取大量壁纸图片,满足个性化的需求。

4. 动态网页抓取项目:微博热搜榜实时爬取微博热搜榜是人们了解热门话题的重要渠道,我们可以使用Python爬虫实时抓取微博热搜榜数据。

调用bangumi api示例

调用bangumi api示例"Bangumi" 是指中国大陆的 bilibili 网站上的一个动画、漫画、游戏及相关作品索引平台。

它提供了一个 API 来获取各种内容,如番剧信息、角色信息等。

为了使用 bangumi 的 API,你需要首先在 bilibili 官网上注册一个开发者账号,然后创建一个应用来获取 API 密钥。

之后,你可以使用该密钥来调用API。

以下是一个简单的 Python 示例,使用 `requests` 库来调用 bangumi 的API 并获取番剧信息:1. 首先,确保已经安装了 `requests` 库:```bashpip install requests```2. 使用以下代码调用 API:```pythonimport requestsimport jsondef get_bangumi_info(api_key, bangumi_id):url = f"response = (url)if _code == 200:return ()else:return None替换以下内容为你的 API 密钥和番剧IDapi_key = "YOUR_API_KEY"bangumi_id = "YOUR_BANGUMI_ID" 例如: '100001' for 'Re:从零开始的异世界生活'info = get_bangumi_info(api_key, bangumi_id)if info:print((info, indent=4))else:print("Error fetching bangumi info.")```注意:确保替换`YOUR_API_KEY` 为你在bilibili 开发者平台上获得的API 密钥。

替换 `YOUR_BANGUMI_ID` 为你想查询的番剧的 ID。

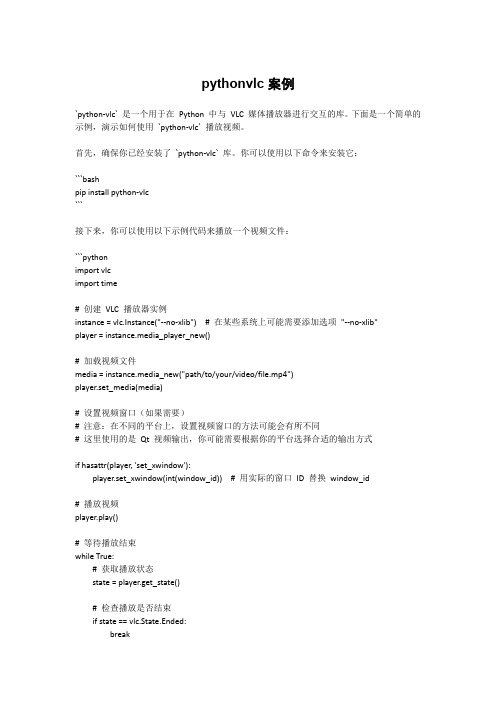

pythonvlc案例

pythonvlc案例`python-vlc` 是一个用于在Python 中与VLC 媒体播放器进行交互的库。

下面是一个简单的示例,演示如何使用`python-vlc` 播放视频。

首先,确保你已经安装了`python-vlc` 库。

你可以使用以下命令来安装它:```bashpip install python-vlc```接下来,你可以使用以下示例代码来播放一个视频文件:```pythonimport vlcimport time# 创建VLC 播放器实例instance = vlc.Instance("--no-xlib") # 在某些系统上可能需要添加选项"--no-xlib"player = instance.media_player_new()# 加载视频文件media = instance.media_new("path/to/your/video/file.mp4")player.set_media(media)# 设置视频窗口(如果需要)# 注意:在不同的平台上,设置视频窗口的方法可能会有所不同# 这里使用的是Qt 视频输出,你可能需要根据你的平台选择合适的输出方式if hasattr(player, 'set_xwindow'):player.set_xwindow(int(window_id)) # 用实际的窗口ID 替换window_id# 播放视频player.play()# 等待播放结束while True:# 获取播放状态state = player.get_state()# 检查播放是否结束if state == vlc.State.Ended:break# 等待一段时间,然后继续检查播放状态time.sleep(1)# 释放播放器资源player.release()```请注意,上述代码中的`path/to/your/video/file.mp4` 需要替换为实际的视频文件路径。

基于Python的影视搜索接口调用代码实例

基于Python的影视搜索接口调用代码实例代码描述:基于Python的影视搜索接口调用代码实例代码平台:聚合数据#!/usr/bin/python# -*- coding: utf-8 -*-import json, urllibfrom urllib import urlencode#----------------------------------# 影视影讯检索调用示例代码-聚合数据# 在线接口文档:/docs/94#----------------------------------def main():#配置您申请的APPKeyappkey ="*********************"#1.影视搜索request1(appkey,"GET")#2.最近影讯request2(appkey,"GET")#影视搜索def request1(appkey, m="GET"):url ="/onebox/movie/video"params ={"key": appkey, #应用APPKEY(应用详细页查询)"dtype": "", #返回数据的格式,xml或json,默认json"q": "", #影视搜索名称}params =urlencode(params)if m =="GET":f =urllib.urlopen("%s?%s"%(url, params))else:f =urllib.urlopen(url, params)content =f.read()res =json.loads(content)if res:error_code =res["error_code"]if error_code ==0:#成功请求print res["result"]else:print"%s:%s"%(res["error_code"],res["reason"]) else:print"request api error"#最近影讯def request2(appkey, m="GET"):url ="/onebox/movie/pmovie"params ={"key": appkey, #应用APPKEY(应用详细页查询)"dtype": "", #返回数据的格式,xml或json,默认json"city": "", #城市名称}params =urlencode(params)if m =="GET":f =urllib.urlopen("%s?%s"%(url, params))else:f =urllib.urlopen(url, params)content =f.read()res =json.loads(content)if res:error_code =res["error_code"]if error_code ==0:#成功请求print res["result"]else:print"%s:%s"%(res["error_code"],res["reason"]) else:print"request api error"if__name__ =='__main__':main()。

用python实现一个抓取腾讯电影的爬虫

用python实现一个抓取腾讯电影的爬虫实现思路:抓取一个电影网站中的所有电影的思路如下:1.根据一个URL得到电影网站的所有分类2.得到每个分类中的电影的页数3.根据其电影分类的URL规律构造每个分类中每个页面的URL4.分析每个页面中的html,并用正则把电影信息过滤出来准备工作:1.安装python(我用的是mac系统,默认的版本是Python2.7.1 )2.安装mongodb,从官网下载最新版本,然后启动即可,注意如放在外网的话,要设定验证密码或绑定地址为127.0.0.1,否则黑客轻易就进去了3.安装BeautifulSoup和pymongo模块4.安装一个python编辑器,我个人喜欢用sublime text2编写部分:这次以腾讯视频为例,其他视频网站只是换一下正则表达式。

1.根据视频所有分类的URL获取网站中所有视频分类腾讯的所有视频的URL为:/list/1_-1_-1_-1_1_0_0_20_0_-1_0.html首先我们import urllib2包,封装一个读取url中html的方法,详细代码如下:导入需要的模块并定义全局变量:01 # -*- coding: utf-8 -*-02 import re03 import urllib204 from bs4 import BeautifulSoup05 import string, time06 import pymongo0708 NUM = 0 #全局变量,电影数量09 m_type = u'' #全局变量,电影类型10 m_site = u'qq' #全局变量,电影网站gethtml方法,传入一个url,返回这个url的html内容:1 #根据指定的URL获取网页内容2 def gethtml(url):3 req = urllib2.Request(url)4 response = urllib2.urlopen(req)5 html = response.read()6 return html然后查看这个URL的源码文件,得知其电影分类的信息在<ul class="clearfix _group" gname="mi_type" gtype="1">标签内部,每条电信分类的格式为:<a _hot="tag.sub" class="_gtag _hotkey" href="/list/1_0_-1_-1_1_0_0_20_0_-1_0.html" title="动作" tvalue="0">动作</a>ok,我们再写一个gettags方法,将所有的电影分类及url存放于一个字典中,代码如下:01 #从电影分类列表页面获取电影分类02 def gettags(html):03 global m_type04 soup = BeautifulSoup(html) #过滤出分类内容05 #print soup06 #<ul class="clearfix _group" gname="mi_type" gtype="1">07 tags_all = soup.find_all('ul', {'class' : 'clearfix_group' , 'gname' : 'mi_type'})08 #print len(tags_all), tags_all09 #print str(tags_all[1]).replace('\n', '')1011 #<a _hot="tag.sub" class="_gtag _hotkey"href="/list/1_0_-1_-1_1_0_0_20_0_-1_0.html" title="动作" tvalue="0">动作</a>12 re_tags = r'<a _hot=\"tag\.sub\" class=\"_gtag _hotkey\"href=\"(.+?)\" title=\"(.+?)\" tvalue=\"(.+?)\">.+?</a>'13 p = pile(re_tags, re.DOTALL)1415 tags = p.findall(str(tags_all[0]))16 if tags:17 tags_url = {}18 #print tags19 for tag in tags:20 tag_url = tag[0].decode('utf-8')21 #print tag_url22 m_type = tag[1].decode('utf-8')23 tags_url[m_type] = tag_url2425 else:26 print "Not Find"27 return tags_url接下来用一个循环分类获取每个分类下电影的页数,代码如下:1 for url in tag_urls.items():2 print str(url[1]).encode('utf-8') #,url[0]3 maxpage = int(get_pages(str(url[1]).encode('utf-8')))4 print maxpage获取每个分类中有多少页电影的代码如下:01 #获取每个分类的页数02 def get_pages(tag_url):03 tag_html = gethtml(tag_url)04 #div class="paginator05 soup = BeautifulSoup(tag_html) #过滤出标记页面的html06 #print soup07 #<div class="mod_pagenav" id="pager">08 div_page = soup.find_all('div', {'class' : 'mod_pagenav','id' : 'pager'})09 #print div_page #len(div_page), div_page[0]1011 #<a class="c_txt6" href="/list/1_2_-1_-1_1_0_24_20_0_-1_0.html" title="25"><span>25</span></a>12 re_pages = r'<a class=.+?><span>(.+?)</span></a>'13 p = pile(re_pages, re.DOTALL)14 pages = p.findall(str(div_page[0]))15 #print pages16 if len(pages) > 1:17 return pages[-2]18 else:19 return 1然后在每个分类中,根据其URL的规律生成具体的每页的URL,详细代码如下:1 for x in range(0, maxpage):2 #/list/1_0_-1_-1_1_0_0_20_0_-1_0.html3 m_url = str(url[1]).replace('0_20_0_-1_0.html', '')4 movie_url = "%s%d_20_0_-1_0.html" % (m_url,x)5 print movie_url6 movie_html = gethtml(movie_url.encode('utf-8'))7 #print movie_html8 getmovielist(movie_html)getmovielist函数的作用是将每页地址返回的html传入,然后从中过滤出电影信息所在的html块,详细代码如下:01 def getmovielist(html):02 soup = BeautifulSoup(html)0304 #<ul class="mod_list_pic_130">05 divs = soup.find_all('ul', {'class' : 'mod_list_pic_130'})06 #print divs07 for div_html in divs:08 div_html = str(div_html).replace('\n', '')09 #print div_html10 getmovie(div_html)将过滤出来的包含电影信息的html代码块传入getmovie函数来分离出具体的电影信息并入库,详细代码如下:01 def getmovie(html):02 global NUM03 global m_type04 global m_site0506 #<h6 class="caption"> <ahref="/albumcover/Z7eF_40EL4I.html"target="_blank" title="徒步旅行队">徒步旅行队</a> </h6> <ul class="info"> <li class="desc">法国卖座喜剧片</li> <li class="cast"> </li> </ul> </div> <div class="ext ext_last"> <div class="ext_txt"> <h3 class="ext_title">徒步旅行队</h3> <div class="ext_info"> <span class="ext_area">地区: 法国</span> <span class="ext_cast">导演: </span> <span class="ext_date">年代: 2009</span> <span class="ext_type">类型: 喜剧</span> </div> <p class="ext_intro">理查德·达奇拥有一家小的旅游公司,主要经营法国游客到非洲大草原的旅游服务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于Python的影视搜索接口调用代码实例

代码描述:基于Python的影视搜索接口调用代码实例

代码平台:聚合数据

#!/usr/bin/python

# -*- coding: utf-8 -*-

import json, urllib

from urllib import urlencode

#----------------------------------

# 影视影讯检索调用示例代码-聚合数据

# 在线接口文档:/docs/94

#----------------------------------

def main():

#配置您申请的APPKey

appkey ="*********************"

#1.影视搜索

request1(appkey,"GET")

#2.最近影讯

request2(appkey,"GET")

#影视搜索

def request1(appkey, m="GET"):

url ="/onebox/movie/video"

params ={

"key": appkey, #应用APPKEY(应用详细页查询)

"dtype": "", #返回数据的格式,xml或json,默认json

"q": "", #影视搜索名称

}

params =urlencode(params)

if m =="GET":

f =urllib.urlopen("%s?%s"%(url, params))

else:

f =urllib.urlopen(url, params)

content =f.read()

res =json.loads(content)

if res:

error_code =res["error_code"]

if error_code ==0:

#成功请求

print res["result"]

else:

print"%s:%s"%(res["error_code"],res["reason"]) else:

print"request api error"

#最近影讯

def request2(appkey, m="GET"):

url ="/onebox/movie/pmovie"

params ={

"key": appkey, #应用APPKEY(应用详细页查询)

"dtype": "", #返回数据的格式,xml或json,默认json

"city": "", #城市名称

}

params =urlencode(params)

if m =="GET":

f =urllib.urlopen("%s?%s"%(url, params))

else:

f =urllib.urlopen(url, params)

content =f.read()

res =json.loads(content)

if res:

error_code =res["error_code"]

if error_code ==0:

#成功请求

print res["result"]

else:

print"%s:%s"%(res["error_code"],res["reason"]) else:

print"request api error"

if__name__ =='__main__':

main()。