IBM中间件虚拟化介绍

中间件技术

中间件技术定义:中间件是一种独立的系统软件或服务程序,分布式应用软件借助这种软件在不同的技术之间共享资源。

中间件位于客户机/ 服务器的操作系统之上,管理计算机资源和网络通讯,是连接两个独立应用程序或独立系统的软件。

相连接的系统,即使它们具有不同的接口,但通过中间件相互之间仍能交换信息。

执行中间件的一个关键途径是信息传递。

通过中间件,应用程序可以工作于多平台或 OS 环境。

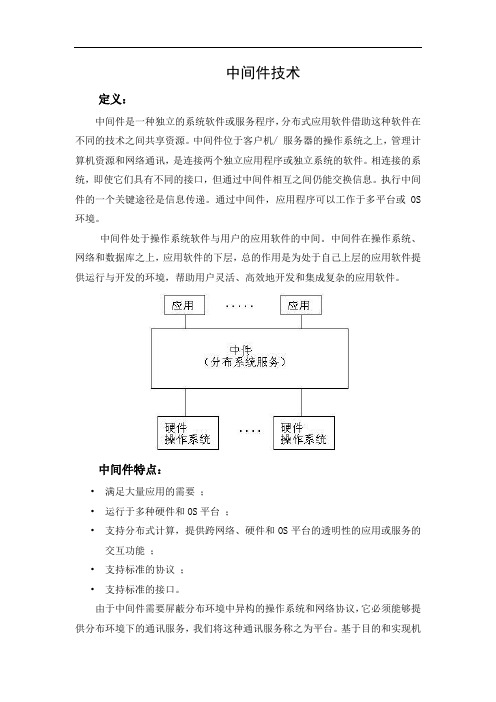

中间件处于操作系统软件与用户的应用软件的中间。

中间件在操作系统、网络和数据库之上,应用软件的下层,总的作用是为处于自己上层的应用软件提供运行与开发的环境,帮助用户灵活、高效地开发和集成复杂的应用软件。

中间件特点:•满足大量应用的需要;•运行于多种硬件和OS平台;•支持分布式计算,提供跨网络、硬件和OS平台的透明性的应用或服务的交互功能;•支持标准的协议;•支持标准的接口。

由于中间件需要屏蔽分布环境中异构的操作系统和网络协议,它必须能够提供分布环境下的通讯服务,我们将这种通讯服务称之为平台。

基于目的和实现机制的不同,我们将平台分为以下主要几类:•远程过程调用中间件(Remote Procedure Call)•面向消息的中间件(MesSAge-Oriented Middleware)•对象请求代理中间件(object RequeST Brokers)•事务处理监控(Transaction processing monitors)1、远程过程调用远程过程调用是一种广泛使用的分布式应用程序处理方法。

一个应用程序使用RPC来“远程”执行一个位于不同地址空间里的过程,并且从效果上看和执行本地调用相同。

事实上,一个RPC应用分为两个部分:server和client。

server 提供一个或多个远程过程;client向server发出远程调用。

server和client 可以位于同一台计算机,也可以位于不同的计算机,甚至运行在不同的操作系统之上。

ibm mq原理

ibm mq原理

IBM MQ是一种消息传递中间件,用于在分布式系统中传递消息。

它提供可靠的、高性能的消息传递机制,确保消息能够按照指定的顺序和时效性被发送和接收。

IBM MQ的工作原理基于消息队列的概念。

在这个概念中,消息发送者将消息发送到一个中央队列中,然后消息接收者从队列中获取消息进行处理。

这种解耦的方式使得发送者和接收者能够独立地进行开发和维护,提高了系统的可扩展性和灵活性。

IBM MQ通过使用消息队列管理器(MQM)来实现消息的存

储和处理。

MQM负责接收发送者的消息,并将其保存到队列中。

接收者会连接到MQM,从队列中获取消息并进行处理。

这种模式确保了消息不会丢失,并且发送者和接收者之间不需要直接通信。

除了消息队列,IBM MQ还提供了一些其他的特性,如消息的持久化和事务支持。

持久化意味着即使在消息发送或接收过程中发生故障,消息也不会丢失。

事务支持则可以确保消息的一致性和完整性,即发送者要么完全发送消息,要么不发送。

在实际的应用中,IBM MQ可以用于各种不同的场景,如企业应用集成、分布式系统之间的通信、异步消息处理等。

它具有高可用性、可靠性和性能优势,被广泛应用于金融、制造、电信等行业。

总之,IBM MQ通过使用消息队列和消息队列管理器,实现了

可靠的、高性能的消息传递机制。

它的工作原理简单而有效,可以满足各种不同场景下的需求。

ibmsvc实施方案

ibmsvc实施方案ibmsvc(IBM Service Virtualization for Cloud)是一种基于云计算的服务虚拟化解决方案,旨在帮助企业加速应用程序的开发和测试过程,降低成本,提高效率。

本文将介绍ibmsvc的实施方案,包括实施前的准备工作、实施过程中的注意事项以及实施后的优化和管理。

一、实施前的准备工作在进行ibmsvc的实施前,首先需要进行详细的需求分析,了解业务流程和系统架构,明确实施的目标和范围。

同时,需要评估现有的IT基础设施和资源,确定是否满足ibmsvc的部署要求。

另外,还需要制定详细的实施计划,包括人员安排、时间节点、风险评估等内容。

二、实施过程中的注意事项在实施过程中,需要注意以下几个方面:1. 系统集成:ibmsvc需要与现有的系统进行集成,因此需要确保各个系统之间的兼容性和稳定性,避免出现数据不一致或者系统故障的情况。

2. 安全性保障:在实施过程中,需要严格控制访问权限,确保敏感数据不被泄露,同时需要加强系统的安全防护措施,防范潜在的安全威胁。

3. 性能优化:实施过程中需要对系统进行性能测试和优化,确保ibmsvc能够满足业务需求,并且在高负载情况下保持稳定运行。

4. 人员培训:在实施完成后,需要对相关人员进行培训,使其熟悉ibmsvc的操作和管理,提高系统的可用性和稳定性。

三、实施后的优化和管理实施完成后,需要进行系统的优化和管理,包括以下几个方面:1. 运维管理:建立完善的运维管理体系,确保系统能够持续稳定运行,及时处理各类故障和问题。

2. 性能监控:建立性能监控体系,对系统的各项指标进行实时监测,及时发现并解决性能问题。

3. 安全管理:加强系统的安全管理,定期进行安全漏洞扫描和修复,防范潜在的安全威胁。

4. 系统优化:定期对系统进行优化,包括数据库清理、系统调优等工作,提高系统的性能和稳定性。

总结ibmsvc的实施是一个复杂的过程,需要充分的准备和周密的计划,同时需要注重系统的安全性和稳定性。

ibm服务器配置

IBM服务器配置1. 服务器概述在企业中,服务器作为网络基础设施的重要组成部分,扮演着存储和处理数据的关键角色。

IBM服务器以其高性能、稳定性和可靠性而闻名,是许多企业选择的首选。

2. 服务器硬件配置IBM服务器提供了多种硬件配置选项,根据用户的需求和预算可定制以下硬件配置:2.1 CPUIBM服务器配备了强大的中央处理器(CPU),以提供高性能的计算能力。

可以选择不同的CPU型号和核心数量,以满足不同工作负载的要求。

2.2 内存内存是服务器基本的工作空间,用于存储运行时数据和程序。

IBM服务器支持多种内存配置,可以根据需要选择适当的内存容量和类型(例如DDR4)。

2.3 存储存储是服务器中存储数据的重要组件。

IBM服务器支持多种存储选项,包括固态硬盘(SSD)和机械硬盘(HDD)。

用户可以选择不同的存储容量和速度,以满足数据存储和访问的需求。

2.4 网络接口IBM服务器可配置多个网络接口,以支持高速网络连接和数据传输。

用户可以根据需要选择不同类型的网络接口(例如千兆以太网、万兆以太网),以满足服务器对外部网络的连接要求。

3. 服务器操作系统IBM服务器可以安装多种操作系统,如Linux、Windows Server等。

根据用户的需求和应用程序兼容性,可以选择适合的操作系统进行安装和配置。

4. 服务器管理IBM服务器配备了强大的服务器管理工具,以便用户轻松监控和管理服务器。

其中包括以下功能:4.1 远程管理IBM服务器支持远程管理功能,可以通过远程控制台访问服务器和进行管理操作。

这允许管理员远程监控服务器的状态、配置和性能,并进行必要的管理操作。

4.2 健康监控IBM服务器提供健康监控功能,可以实时监测服务器的硬件状态和运行状况。

这包括CPU温度、内存使用率、硬盘健康等信息,以帮助管理员及时发现和解决潜在问题。

4.3 资源管理IBM服务器提供资源管理功能,可以帮助管理员有效地管理服务器资源。

这包括对CPU、内存和存储资源的分配和优化,以确保服务器的性能和效率。

IBM_SVC_介绍

SSDs

Mirrored SSD Capacity

1

146GB (two SSDs)

32

2.4TB

SVC 概念及术语——物理映射

VDisk

IOgroup

IOgroup

IOgroup

IOgroup

EMC EMC

IBM IBM

IBM IBM

HDS HDS

HP HP

MDisk

SVC 概念及术语——逻辑视图

• • 需要中断应用进行数据迁移 数据复制只能在同构平台进 行

引入SVC后

• • • 数据迁移时不需要中断应用 数据复制可以在任意磁盘阵列间进 行 合理迁移数据到适ume Controller

DS4000 DS8000

EMC

DS8000

DS 4000

TimeFinder

Metro Mirror with Business

Continuity

备份主机 – 集群架构 存储的整合简化 网络冗余

单中心数据整合

AIX Server AIX Server

SM & TPC Console

Mirror or LVM

IBM SDD

IBM SDD

FC IP LAN-Free

Switch

EMC

Metro Mirror FlashCopy

Migration

更灵活的数据复制技术——异构存储平台的业务连续性

传统 SAN

• • • • 不同厂商提供不同的复制API 复制目的地与复制源必须为同构平台 不同系统使用不同的多路径驱动软件 低端磁盘系统没有远程复制功能或者只 有很初级的功能

引入SVC后

异构环境,虚拟先行

跟小编一起认识IBM虚拟发展历史

跟小编一起认识IBM虚拟发展历史1964年L.W. Comeau和R.J. Creasy创造性地设计了一种名为CP-40的新型操作系统,该操作系统实现了虚拟内存和虚拟机。

1965年1965年8月,IBM推出System/360 Model 67和TSS分时共享系统(Time Sharing System),允许很多远程用户共享同一高性能计算设备的使用时间。

在IBM内部,Model 67与另一个被称为CP-67的系统配合使用,以保证使用一台360/67模仿多台不同型号的计算机。

1972年IBM发布用于创建灵活大型主机的虚拟机(VM)技术,该技术可根据动态的需求快速而有效地使用各种资源。

1978年IBM获得了RAID(冗余独立磁盘阵列)概念的专利。

作为一种存储虚拟形式,RAID首先将物理设备组合为池,然后从这一池中“切割”出一组虚拟逻辑单元(LUN)并将其提供给主机。

通过使用镜像和奇偶性,这些逻辑单元第一次拥有了比底层物理磁盘驱动器更高的可用性。

虽然直到1988年IBM与加利福尼亚州立大学伯克利分校的研究人员携手之后才开发出一个实用的版本,但这一专利技术却是第一次将虚拟引入存储之中。

1991年IBM为z/OS平台推出分级文件系统(HFS)和网络文件系统(NFS)。

1997年IBM推出虚拟磁带服务器(VTS)。

该磁带库使用磁盘作为转储磁带数据的高速缓存。

较小容量(800MB)的虚拟磁带数据首先存储在磁盘上,然后将数据写入到存储容量大得多的磁带盒(超过10GB)。

很少有程序能够写满大容量的本地磁带,但VTS能够在磁带上写满小型虚拟磁带映像。

1999年2月,IBM在AS/400(现在被称为System i)上第一次推出新的“逻辑分区(LPAR)”技术和新的高可用性集群解决方案。

在POWER管理程序上运行的AS/400 LPAR令单台服务器工作起来如同12个独立的服务器,这样就为客户进行服务器整合、业务部门整合以及实现混合工作和测试环境及集成集群提供了一个理想的解决方案。

WAS中间件服务器介绍

WAS中间件服务器介绍WAS中间件服务器介绍1. 介绍WAS(WebSphere Application Server)是一种中间件服务器,用于构建、部署和管理企业级应用程序。

它提供了一个可靠、安全和可扩展的平台,用于在分布式环境中运行大型应用程序。

本文将详细介绍WAS中间件服务器的各个方面和功能。

2. 架构2.1 组件架构WAS中间件服务器由多个组件构成,包括应用服务器、管理工具、数据源、线程池等。

每个组件都有特定的功能,并相互协作以提供完整的应用程序环境。

2.2 集群架构WAS支持集群架构,可以将多个服务器组成一个集群,提供负载均衡和高可用性功能。

集群架构可以提高应用程序的性能和可靠性。

3. 安全性WAS提供了多种安全功能,包括身份验证、授权、数据加密等。

它还支持各种安全协议和标准,如SSL、TLS、Kerberos等,以保护应用程序和用户数据的安全性。

4. 部署和管理4.1 应用程序部署WAS支持多种方式的应用程序部署,包括本地部署、远程部署、自动部署等。

它还提供了灵活的部署工具和界面,方便开发人员和管理员进行应用程序的部署和管理。

4.2 配置管理WAS提供了丰富的配置管理功能,包括服务器配置、数据源配置、JNDI配置等。

管理员可以通过配置管理工具进行配置的修改和管理。

5. 监控和故障排查WAS提供了强大的监控和故障排查功能,包括性能监控、错误日志分析、线程跟踪等。

管理员可以实时监控应用程序的运行情况,并及时发现和解决问题。

6. 扩展性和性能优化WAS具有良好的扩展性和性能优化能力。

它支持多种插件和扩展模块,可以根据应用程序的需求和规模进行灵活的扩展和优化。

附件:本文档不涉及附件。

法律名词及注释:1. 中间件:指在计算机系统中,处于操作系统和应用程序之间的软件组件,它们用于支持应用程序的运行和通信。

2. WAS(WebSphere Application Server):是由IBM开发的一种中间件服务器,用于构建、部署和管理企业级应用程序。

IBMPowerVM虚拟化介绍

硬件虚拟化

总结词

将物理硬件资源虚拟化为多个虚拟资源,实现资源共享和动态分配。

详细描述

通过硬件虚拟化技术,IBM PowerVM可以将物理服务器的CPU、内存、存储和网络等硬件资源虚拟化为多个独 立的虚拟资源,实现资源的共享和动态分配,提高硬件利用率和灵活性。

操作系统虚拟化

总结词

在单个物理服务器上运行多个操作系统实例,实现操作系统级别的隔离。

ibmpowervm虚拟化介绍

目 录

• 引言 • IBM PowerVM虚拟化技术 • IBM PowerVM虚拟化优势 • IBM PowerVM虚拟化应用场景 • IBM PowerVM虚拟化实施步骤 • 结论

01 引言

什么是虚拟化

虚拟化是一种将物理硬件资源虚拟化成多个独立、可管理的 资源的技术,使得多个操作系统可以同时运行在一个物理服 务器上,提高了服务器的利用率和灵活性。

系统部署与测试

部署虚拟化环境

根据设计,部署虚拟化环境,包括安装虚拟化软件、配置网络和存 储等方面的工作。

测试虚拟化环境

对部署好的虚拟化环境进行测试,包括性能测试、功能测试、兼容 性测试等方面,确保环境稳定可靠。

优化虚拟化环境

根据测试结果,对虚拟化环境进行优化,包括资源分配、网络配置、 存储配置等方面的优化。

02

IBM PowerVM支持多种操作系统和应用程序,包括AIX、 Linux、IBM i等,并且可以与其他虚拟化技术如VMware和

Hyper-V进行集成。

03

IBM PowerVM提供了丰富的管理工具和功能,如虚拟机迁移 、高可用性、负载均衡等,可以帮助企业实现高效、可靠的虚

拟化解决方案。

02 IBM PowerVM虚拟化技 术

WAS中间件服务器介绍

WAS中间件服务器介绍WAS中间件服务器介绍1、概述WAS(WebSphere Application Server)是IBM公司开发的一种中间件服务器,用于提供企业级应用程序的运行环境和基础设施。

它可以在多种操作系统上运行,并支持多种编程语言和开发框架。

本文将详细介绍WAS中间件服务器的各个方面。

2、功能特性2·1 应用程序部署WAS提供了强大的应用程序部署功能,支持将应用程序打包成可部署的文件,然后在服务器上进行安装和配置。

它还提供了自动化的部署工具,可以简化应用程序的发布和更新过程。

2·2 事务管理WAS支持分布式事务处理,可以保证多个相关操作的一致性和原子性。

它提供了事务管理器和事务日志功能,确保在发生故障或异常情况下数据的完整性。

2·3 高可用性和负载均衡WAS具备高可用性和负载均衡的能力,可以通过多台服务器实现应用程序的冗余部署和负载分担。

它提供了故障恢复和故障转移的功能,保证应用程序的持续可用性。

2·4 安全性和认证授权WAS提供了丰富的安全功能,包括身份认证、访问控制和数据加密等。

它支持多种身份认证方式,如基于用户名密码的认证、证书认证和单点登录。

同时,它还提供了细粒度的授权机制,可以对用户进行精确的权限控制。

2·5 监控和性能调优WAS内置了监控和性能调优工具,可以实时监测应用程序的运行状态和性能指标。

通过这些工具,可以及时发现并解决潜在的性能瓶颈,提升应用程序的性能和响应速度。

3、部署架构3·1 单节点部署单节点部署是将WAS安装在单台服务器上,适用于小型应用程序或开发测试环境。

在此架构下,WAS担任应用程序的运行和管理角色。

3·2 多节点部署多节点部署是将WAS安装在多台服务器上,通过集群技术实现应用程序的冗余和负载均衡。

在此架构下,WAS集群中的各个节点相互协作,共同提供应用程序的服务。

4、集成与扩展WAS支持与其他中间件和系统的集成,可以与数据库、消息队列、企业服务总线等进行无缝连接。

IBM System x 服务器实现虚拟化的解决方案

IBM System x 服务器实现虚拟化的解决方案“分布式资源调度和高可用性虚拟化”利用IBM System x 服务器实现虚拟化的解决方案•使用和管理几十甚至上百台一路、两路服务器,且利用率不高的客户。

•使用JAVA 或 .NET 环境自行开发应用的客户。

•正在运行和准备使用Microsoft SQL Server 数据库的客户。

•使用多种操作系统,如Windows、Linux 或Netware 的客户。

返回页首随着企业业务的不断发展,企业的I/T 环境也在不断进行演变。

经过多年的积累,在很多大型企业的IT 机房中逐渐形成了大量的服务器系统,运行企业的各种业务应用,其中有很多运行在Linux、Windows 2000、Windows 2003、Netware 系统平台上,属于企业的核心业务应用,包括数据库系统和核心的应用程序。

这些系统包括:•中小规模数据库系统•服务器系统(Exchange server, Domino Server…)•企业资源规划(ERP)•各种通讯服务器•企业门户系统及其周边应用•大量的开发,测试用服务器•已及其它各种类型的企业应用这种IT 模式决定了管理员必须要同时管理大量的服务器系统,有时会达到几十台甚至上百台。

企业的IT 经理门往往面临着巨大的成本压力,管理压力和业务连续性要求的压力。

作为企业IT 部门或业务部门的经理,您是否还面临一下这些问题的困扰?•成本考虑o对贵公司而言降低总体拥有成本是否是最先考虑的问题?•管理考虑o您是否在管理30台以上的Intel 平台服务器?但有很大一部分的服务器利用率其实很低。

o贵公司的业务部门是否正在由于快速业务扩X,要求您运行数量庞大的服务器?o为了满足业务部门的新业务需求,您是否一直在购买新服务器硬件?而且部署缓慢?•故障/灾难恢复考虑o您能否始终保证达到您所制定的故障或者灾难恢复时间的目标?o由于成本原因,是否您处于不得已,而将某些重要应用排除在了灾难恢复的X围之外?o对贵公司而言减少恢复所需时间是否非常重要?•可用性考虑o您能始终达到您所制定的应用可用性目标吗?o您是否因为缺少设备和电力资源从而不能实施群集或高可用方案?o当您从旧的服务器升级到新的服务器的时候,服务器需要停机维护的时候,您的业务仍然能保持24小时在线吗?•软件开发、测试环境考虑o您想在单台系统上同时建立多个不同的开发测试环境?o您的应用开发人员及QA 工程师是否花费了大量时间在新的测试服务器的安装上?o你能测试到所有期望的服务器平台上的选件、中间件、数据库及操作环境吗?o从QA 工程师到开发人员,从支持人员到QA,从QA 到生产服务器管理,软件分发、部署是否消耗大量时间和资源?o您是否为开发人员所要求建立新的测试服务器及分发服务并且重建环境所苦恼?o您是否有大量应用由于服务器资源缺少在上线前未进行过足够的测试?•服务器资源的共同管理、分配和使用的考虑o在大量零散服务器的系统中,管理员很难实现系统资源的共享。

IBMPowerVM虚拟化架构大局观与绿色IT

IBM PowerVM 虚拟化架构大局观与绿色IT当今世界,“绿色”已成共识;绿色食品、绿色建筑、绿色设计、绿色经济,人类社会吹起了阵阵“绿色”旋风;IT 界自然不甘落后,绿色计算应运而生;它致力于实现高效的 IT 架构,降低能耗,促进信息技术的可持续性发展;在企业的 IT 支出中,能源消耗所占的比重日益增大,制约着投资回报率,节约成本成为绿色计算的首要驱动因素;Gartner 预测,绿色计算在未来数年内将成为最热门的技术发展趋势之一;IDC 认为,中国企业在未来 3-5 年的时间里将迎来绿色计算和节能建设的新高潮;IBM 是绿色计算的倡导者和先行者,拥有悠久的环境保护传统,于 2007 年启动的绿色创新工程Project Big Green,并提出了改善数据中心能效的五个步骤:诊断评估现有的能力、构建计划和构建高能效的数据中心、虚拟化虚拟化 IT 基础架构、管理进行能效控制和冷却使用液体冷却资源;虚拟化在资源的整合、共享和灵活性方面具有独特的优势,是实现绿色计算的重要途径;它包括服务器虚拟化、网络虚拟化、存储虚拟化和软件虚拟化等方面;IBM 在 POWER 平台上实现了一种企业级的虚拟化架构—PowerVM,它是 IBM UNIX 服务器取得成功的重要因素,在绿色计算的浪潮中也必将发挥重要的作用;本文将介绍 IBM PowerVM 的总体架构及其完善的虚拟化特性,并讨论 PowerVM 如何助力绿色计算;PowerVM 的总体架构逻辑分区LPAR: Logical Partition是 PowerVM 最基本的概念;Power Hypervisor 直接管理硬件,根据需求将系统划分成若干逻辑分区;每个逻辑分区相当于一台独立的机器,不同分区独立运行,互不干扰;PowerVM 实现了如下完善的虚拟化特性,为各种资源提供了专用和共享模式,实现了性能、资源共享和灵活性的统一;这些特性可以用于 Power 服务器的各种机型,降低了学习和管理的成本;PowerVM 可以通过硬件管理控制台HMC: Hardware Management Console、集成虚拟化管理器IVM: Integrated Virtualization Manager或者更加高级的VMControl 进行管理;VMControl 是 IBM Systems Director 中的插件,可以帮助用户方便地创建需要部署的安装映像,同时便捷地进行部署、调整以及管理,从而极大地降低了相应的工作量和需要的时间;处理器虚拟化特性:专用处理器、微分区Micro-partitioning、共享处理器池和同时多线程SMT: Simultaneous Multi-threading内存虚拟化特性:专用内存和动态内存共享AMS: Active Memory Sharing网络设备虚拟化特性:专用网卡、虚拟以太网和主机以太网适配器HEA: Host Ethernet Adapter存储设备虚拟化特性:专用 SCSI 适配器、虚拟 SCSI 适配器和虚拟光纤通道适配器NPIV: N_Port ID Virtualization动态虚拟化特性:动态逻辑分区DLPAR: Dynamic Logical Partitioning 和动态分区迁移LPM: Live Partition MobilityAIX 专有的特性:工作负载分区WPAR: Workload Partition和动态应用迁移Live Application MobilityLinux专有的特性:Lx86,实现了 POWER 架构对 x86 体系下的 Linux 应用程序的二进制兼容处理器虚拟化专用模式下,处理器必须以个为单位进行分配;即使工作负载只需要个处理器的计算能力,也必须分配 2 个处理器,造成了资源的浪费;微分区,即共享模式允许将 POWER 处理器的时间片最多分成 100 份来使用,从而可以用最少的处理器资源满足上述要求;共享处理器池和微分区配合使用,允许使用微分区在负载增大时暂时借用其它分区过剩的计算能力;这种特性对于负载峰值不重叠的业务非常有效,分区只需要分配正常负载而不是峰值所需要的计算能力;微分区提高了资源的利用率,却带来的一定的开销,在一定程度上影响了业务的性能;对于需要保证稳定性能的应用,建议使用专用处理器模式;两种不同类型的处理器模式可以同时在一台服务器上的不同分区上使用,用户可以根据业务负载的特点选择最佳的组合;处理器的流水线由于 Cache 不命中等原因一般处于不饱和的状态,当某个指令流的执行停滞时,可以调度执行另外一个指令流,从而增强整个处理器的处理能力;POWER 芯片实现了同时多线程 SMT,每个线程都是操作系统可用于进程调度的独立单位,即逻辑处理器;内存虚拟化动态内存共享允许多个逻辑分区共享相同的内存,这使得它们所能看到分区内存总和大于物理内存;由于一段时间内分区的活跃内存仅占总量的一部分,不活跃的内存被 Hypervisor 交换到外部存储,从而实现了内存的动态共享;由于增加了交换的开销,动态内存共享比较适用于峰值错开,内存争抢不太频繁的情况;对于要求稳定性能的应用, 建议使用专用内存;然而,动态内存共享并非性能差的代名词,当不活跃内存增多且持续较长时间时,某些分区可以获得更多的内存来提高性能;因此,性能和节能并非鱼和熊掌不可兼得,微分区技术也是如此;网络设备虚拟化PowerVM 的虚拟网络特性包括虚拟以太网、虚拟以太网适配器和共享以太网适配器;虚拟以太网基于 IEEE 标准,是由 Hypervisor 实现的;逻辑分区通过虚拟以太网适配器连接到虚拟网络,同一机器的不同分区之间可以通过虚拟网络进行高速安全的通信;如果要跟外部网络进行通信,还需要共享以太网适配器;共享以太网适配器是虚拟 I/O 服务器VIOS: Virtual I/O Server上的链路层网桥,将该分区的虚拟以太网适配器 ent1 和物理网卡 ent0 桥接在一起,把虚拟以太网和外部以太网连接成一个更大的网络;VIOS 是 Power 服务器上的一种特殊的逻辑分区,运行定制的 AIX,用于为其它分区提供虚拟的 I/O 资源,是 PowerVM 的一个重要组成部分;虚拟网络允许用少量的物理网卡满足分区的网络通信需求,节约硬件成本,但是不适用于需要跟外部网络进行大量通信的应用;在这种情况下可以使用专用网卡或者主机以太网适配器,也称为集成虚拟以太网 IVE: Integrated Virtual Ethernet;HEA 是一种高速度和易共享的网络设备,被虚拟成若干逻辑设备,每个逻辑设备有各自的 MAC 地址,可以分配给任意分区;分区直接通过 HEA 进行网络通信,从而减少了跟 VIOS 交互所带来的开销;逻辑设备共享网络带宽,当某些逻辑设备网络吞吐量较小时,剩余的带宽可供其他逻辑设备使用;和虚拟网络一样,HEA 也支持逻辑分区之间的直接通信,无需通过外部网络;存储设备虚拟化在专用 SCSI 模式下,适配器和所连接的所有磁盘必须同时分配给同一个分区;虚拟 SCSI 技术允许重新分割磁盘资源,以更小的粒度进行存储分配,用少量的存储资源满足分区的需求,或者用相同存储资源划分出更多的分区;虚拟 SCSI 采用 client/server 模式,包含服务器端和客户端虚拟 SCSI 适配器;服务器端虚拟 SCSI 适配器由 VIOS 提供,VIOS 上的存储资源被映射到该适配器,可以是整个物理磁盘、逻辑卷或者文件等等;Power 服务器使用 LRDMALogical Remote Direct Memory Access协议在客户端虚拟 SCSI 适配器缓冲区和 VIOS 的物理适配器之间直接传输数据,提高数据传送的速度;由于需要通过 VIOS 进行存储映射,因此虚拟 SCSI 存在性能损耗;为了提高I/O 吞吐量,除了专用的物理 SCSI 适配器外,还可以使用虚拟光纤通道适配器NPIV;它是 PowerVM 对ANSI T11 光纤信道协议的一种实现,基本架构主要包括:NPIV 物理光纤通道适配器、VIOS pass-through 模块、服务器端虚拟光纤通道适配器和客户端虚拟光纤通道适配器;和 HEA 类似,NPIV 也是一种硬件实现,可以虚拟成多个逻辑设备,每个设备有各自的 WWPNWorld Wide Port Name,逻辑分区通过逻辑设备跟 SAN 进行通信;与虚拟 SCSI 相比,VIOS 只转发 I/O 读写,不需要复杂的磁盘映射,因此 NPIV 能够提供更高的 I/O 吞吐量;在企业级应用中,存储局域网络是一种典型的存储系统,NPIV 为这种高端的存储系统提供了良好的虚拟化;动态虚拟化动态逻辑分区可以在同一台 Power 服务器内部以对物理处理器、虚拟处理器、内存、物理/虚拟以太网适配器/SCSI 适配器进行动态添加、删除和分区之间的移动等操作;这种动态调整在分区运行的时候进行,无需重启系统即可生效;用户可以根据分区的需求对资源的分配进行动态调节,使得系统资源得到更加充分的利用,并且不影响应用或者服务的正常运行,从而更加有效的利用硬件资源来满足不断变化的业务需求;动态分区迁移是 Power 服务器之间的动态资源调整操作,能够在短短的几秒钟内把运行中的逻辑分区从一台服务器迁移到另外一台,同时保证操作系统和各种应用程序的连续运行,不影响用户的正常使用;它使得管理员能够把更多数量的服务器作为流动的资源来考虑,而不是将每一台服务器看作是完成某一项具体任务的单一实体,能够提高系统的可用性,并起到整合和节能的效果;目前该特性是其它 UNIX 服务器厂商所没有提供的,是 IBM 针对 UNIX 服务器市场的一项重要举措;工作负载分区和动态应用迁移工作负载分区 WPAR 是 AIX 的新特性,允许在单个 AIX 映像中创建多个分区,运行各自的应用程序;与上述固件级别的虚拟化特性不同,它是在操作系统级别实现的纯软件形式的虚拟化特性,填补了 PowerVM 在操作系统级别虚拟化技术的空白;既然有了逻辑分区,为何还需要工作负载分区呢首先,它是一种粒度更细的资源控制方式,能够更加充分的划分和利用逻辑分区的资源;其次,它需要更少的操作系统映像,降低了资源的占用和维护的成本;还有,它的建立更加便捷,管理更为简单;最后,它不依赖于硬件,而前述特性则需要特定硬件和固件的支持,在老的机器上不能使用,使用 WPAR 有利于保障客户的硬件投资;当然,工作负载分区也有自身的局限;首先,它所在的机器或者逻辑分区以及 AIX 都是单一故障点,而逻辑分区提供了更好的故障隔离能力;其次,它对资源分配的控制精度不如逻辑分区;最后,它的安全性和性能也存在缺陷;因此它不会替代逻辑分区,而是一种有益的补充;WPAR 适合为特定的工作负载,特别是临时工作负载,比如测试和开发环境,提供一个快速有效的整合环境;动态应用迁移是 WPAR 的一项重要特性,可以将 WPAR 及其应用程序从一个系统在线地迁移到另一个系统,无需停止该 WPAR;与动态分区迁移类似,动态应用迁移可以提高应用的不间断服务水平和系统的灵活性,实现负载均衡;动态应用迁移和动态分区迁移有各自的局限性和应用场景,在实际应用中,可以结合在一起使用,取长补短;Lx86 虚拟 x86 Linux 环境PowerVM Lx86 支持在 Power 平台上直接运行 x86 环境下的大部分 Linux 应用程序,而不需要重新编译或者移植;Lx86 利用动态二进制翻译技术,在 x86 Linux 应用程序运行的时候将 x86 指令翻译成 POWER 指令,从而实现对 x86 Linux 程序的二进制兼容;Lx86 可用于整合大量的 x86 应用,充分利用 Power 平台的 RAS、性能和可靠性;IBM 提供了一个 Power 服务器上 Linux 安装和维护的工具包 PowerPack,帮助用户简化 x86 Linux 应用程序到 Power 平台的迁移;基于 PowerVM 的绿色计算基于 x86 的 Windows 或者Linux 服务器处理器的利用率通常在 15% 以下,很多 UNIX 服务器则是在 15% - 25% 左右;机器大部分时间处于空闲状态,但是仍然要大量消耗能源用于维持机器的运转和冷却;虚拟化和系统的整合能力允许用户可以将多台服务器上的业务整合到同一台机器,使得资源利用率达到 50% - 70% 甚至更高POWER7 系统支持超过 90% 的利用率,减少硬件资源和能源的浪费;数据表明,利用率的提高能显著的降低能耗在 IBM 刀片服务器中,资源利用率提高到 3 倍,能耗仅增加 50%;由此可见,虚拟化和整合对于绿色计算不可或缺的作用;IBM Power 服务器尤其是高端机型如 Power 595 等具有强大的硬件基础,提供了高度的整合能力;不断优化的每瓦特性能和水冷技术也在持续的降低能耗;PowerVM 更是将这种整合能力和绿色计算推到另一个高度;PG&E 和 IBM 在2007 年宣布的一项合作计划中,将大约 300 台 UNIX 服务器整合成仅有的 6 台 System p5 服务器,把资源利用率从 10% 提升到 80%,减少了 80% 的能耗那么 PowerVM 虚拟化架构是如何助力绿色计算的呢这得益于 PowerVM 所支持的强大的整合能力、广泛的资源共享功能和灵活的动态资源管理等;强大的整合能力在最新的 POWER7 上,每个处理器核最多支持 4 个 SMT,每个处理器芯片最多支持 32 个 SMT,每台服务器最多支持 1024 个 SMT;每个处理器最多分配给 10 个分区进行共享,每台服务器最多支持 1000 个逻辑分区是 POWER6 系统的 4 倍;强大的芯片提供更高的计算能力和逻辑分区数量,允许把更多的应用整合到同一台服务器;PowerVM 支持 AIX、IBM i 和 Linux,能够支持这些类型的 Power 系统以及系统中超过 15,000 个应用软件的整合;Lx86 使得 Power 服务器还可以整合基于x86 的大量 Linux 应用;工作负载分区能够进一步整合 AIX 上的各种应用,使用更少的 AIX 操作系统映像,减少资源浪费,从而提供更多的资源供其它应用的整合来使用;广泛的资源共享功能PowerVM 的资源共享涵盖了处理器微分区和处理器池、内存AMS 和内存池、网络设备虚拟网络和 HEA和存储设备虚拟 SCSI 和 NPIV,使用了软件实现或者硬件实现的方式,资源共享的调度由 PowerVM 自动完成;资源的共享使得用户无需为每个分区分配峰值负载所需的处理器和内存资源,以及专用的物理设备,从而节省昂贵的硬件开销,以及维持硬件运转和冷却所需的能源;当峰值到来时,所需的额外资源从负载较轻的分区暂时借用;假设某台 Power 服务器上有 10 个逻辑分区,分区之间需要大量的通信协作,分区与外部网络仅有少量的网络通信;如果使用专用网络,那么至少需要 10 块物理网卡才能满足要求;如果使用虚拟网络,只需要装配 1 块物理网卡并分配给VIOS 并做成共享以太网适配器,满足外部通信需求,分区直接的通信通过虚拟以太网就可以满足了;由此可见,资源共享的确可以节省不少硬件投资;广泛资源共享从另外一个侧面反映了强大的整合功能;对于一台服务器,由于资源共享而剩余出来的系统资源可以用于整合更多的应用,降低能耗,实现绿色计算;灵活的动态资源管理动态逻辑分区 DLPAR 是一种动态资源管理方式,也是一种资源共享的方式,因此也是一种绿色计算的方式;当某些分区的资源尤其是专用的处理器、内存和I/O 设备不足时,可以通过 DLPAR 从空闲资源池或者资源过剩的分区中获取;当不需要使用的时候,仍然可以通过 DLPAR 从分区中删除;动态分区迁移和动态应用迁移可用于不当机的服务器整合,使得业务在整合过程中仍然处于服务状态,实现不间断的绿色计算;当服务器负载较低的时候,还可以使用这些特性把应用迁移到少量的服务器中,然后关闭空闲的服务器,从而达到节能减排的目的,实现动态的绿色计算;整合案例整合发生在一个基于 POWER4 的数据中心,包括 11 个各种类型的 POWER4 机器,每台服务器的资源利用率是 30%,最大的耗电量约为 52KW;整合后,整个数据中心只有两台 POWER6 机器,占地空间大大减少,利用率提高到 50%,性能也得到了很大的提高,最重要的是,耗电量节省了 79%虽然该案例没有具体说明 PowerVM 各种特性的使用情况,但是 Power 服务器和PowerVM 强大的整合能力还是得到了很好的体现;总结随着人类日益关注自身的生存环境,节能减排、绿色计算已是大势所趋;虚拟化和整合是实现绿色计算的基础和必由之路;IBM 在虚拟化和绿色计算方面的研究具有很深的历史积淀,PowerVM 虚拟化架构提供了完善的虚拟化特性、强大的整合能力、广泛的资源共享和灵活的动态资源管理,能够对资源进行有效的控制和管理,是实现绿色计算的一把利器;作者简介沈林峰,软件工程师,有丰富的 PowerVM 虚拟化技术经验,目前在 IBM 中国系统和科技研发中心从事 GPFS 研发工作;曹羽中,软件工程师,在虚拟化和系统管理方面有丰富的经验,目前在 IBM 中国系统和科技研发中心从事 Director 研发工作 ;声明:本文仅代表作者个人之观点,不代表 IBM 公司之观点;。

中间件的工作原理及应用

中间件的工作原理及应用介绍中间件是指位于应用程序和操作系统之间的软件。

它扮演着连接和协调不同组件之间的重要角色。

中间件的工作原理及应用广泛,本文将深入探讨中间件的工作原理以及在不同领域的应用。

工作原理中间件的工作原理可以概括为以下几个关键步骤:1.接收请求:中间件作为应用和操作系统之间的层,能够接收来自应用程序的请求。

2.处理请求:中间件将接收到的请求进行处理,可以执行一系列的操作,如身份验证、请求分发、路由等。

3.转发请求:一旦请求被处理完毕,中间件会将请求转发给目标组件或服务。

4.接收响应:中间件接收到目标组件或服务的响应后,可以对响应进行处理。

5.发送响应:最后,中间件将处理后的响应发送回应用程序。

中间件可以通过这一系列的步骤实现各种功能,例如安全性、负载均衡、缓存、日志记录等。

应用领域中间件在各个应用领域都有广泛的应用。

以下是一些常见的中间件应用实例:1. Web开发•Web服务器中间件:如Apache、Nginx等,用于处理HTTP请求、静态文件服务、反向代理等。

•Web框架中间件:例如Express.js、Django等,用于处理路由、请求响应、数据验证等。

2. 分布式系统•消息队列中间件:如Kafka、RabbitMQ等,用于解耦不同组件之间的通信。

•缓存中间件:例如Redis、Memcached等,用于加速数据访问速度。

•分布式数据库中间件:如MySQL Proxy、PostgreSQL Citus等,用于在多个数据库节点之间实现数据分片和负载均衡。

3. 云计算和容器化•虚拟化中间件:如VMware、VirtualBox等,用于虚拟机的创建和管理。

•容器编排中间件:例如Kubernetes、Docker Swarm等,用于管理容器化应用的生命周期和资源调度。

4. 数据库•数据库连接池中间件:如HikariCP、C3P0等,用于管理数据库连接的池化和复用。

•数据库代理中间件:例如MySQL Proxy、PgBouncer等,用于在数据库和应用程序之间进行请求分发和连接管理。

ibm数据中心解决方案

ibm数据中心解决方案随着数字化时代的到来,数据中心成为了企业不可或缺的重要组成部分。

然而,随着数据量的不断增长和技术的不断进步,企业对于数据中心的需求也在不断发展和变化。

为了满足企业在数据存储、处理和安全方面的需求,IBM提供了一系列的数据中心解决方案,以帮助企业更好地管理和利用其数据资产。

一、IBM数据中心解决方案的概述IBM数据中心解决方案基于其强大的技术实力和丰富的经验,在数据中心基础设施、存储方案、云计算和安全等方面提供全面的解决方案。

通过采用IBM数据中心解决方案,企业能够提高数据中心的效率和可靠性,减少成本和风险,并实现更好的业务运营。

二、数据中心基础设施解决方案IBM的数据中心基础设施解决方案旨在提供可靠、高效、可扩展的基础设施环境。

这包括服务器、网络设备、存储设备等基础设施组件的选择和部署。

IBM提供了各种类型的服务器和存储设备,以满足不同企业的需求。

同时,IBM还提供了强大的网络设备,以保障数据中心的高效和稳定运行。

三、数据存储解决方案数据存储是数据中心最重要的组成部分之一。

IBM提供了多种类型的存储解决方案,包括存储系统、存储软件和存储管理。

IBM的存储解决方案具有高可靠性、高性能和高可扩展性的特点,能够满足企业对于数据存储容量和性能的需求,并提供方便的管理和监控功能。

四、云计算解决方案随着企业对于云计算的需求不断增加,IBM提供了灵活和可靠的云计算解决方案。

IBM的云计算解决方案包括基础设施即服务(IaaS)、平台即服务(PaaS)和软件即服务(SaaS)等多种服务模式,以满足不同企业的需求。

通过采用IBM的云计算解决方案,企业能够实现资源的高效利用和灵活的部署,提高业务的敏捷性和竞争力。

五、安全解决方案数据中心的安全是企业最关注的问题之一。

IBM提供了一系列的安全解决方案,以保障数据中心的安全性和可靠性。

这包括网络安全、身份认证、数据加密和安全管理等多方面的安全措施。

IBM的安全解决方案能够有效地保护企业的数据资源,预防各类安全威胁和攻击。

云中间件与虚拟化平台的集成指南

云中间件与虚拟化平台的集成指南随着云计算技术的发展,云中间件和虚拟化平台成为了企业信息化建设中的重要组成部分。

云中间件有助于提供可靠、可扩展和灵活的云服务,而虚拟化平台则提供了资源优化的能力。

本文将介绍云中间件与虚拟化平台的集成指南,以帮助企业更好地利用云计算技术。

一、了解云中间件和虚拟化平台的基本概念云中间件是指一类软件工具,它们用于支持云服务和应用的开发、运行和管理。

常见的云中间件包括容器技术、消息队列、负载均衡等。

虚拟化平台则是一种技术,通过将物理资源虚拟化为多个虚拟资源,使得多个操作系统和应用程序能够共享这些虚拟资源。

常见的虚拟化平台有VMware、KVM等。

二、选择适合的云中间件和虚拟化平台在集成云中间件和虚拟化平台之前,首先需要根据实际需求和企业规模选择适合的云中间件和虚拟化平台。

不同的云中间件和虚拟化平台有不同的特点和适用场景。

例如,如果企业对高可用性要求较高,可以选择基于容器的云中间件,如Docker;如果企业规模较大,可以选择具有良好扩展性的虚拟化平台,如VMware。

三、配置云中间件和虚拟化平台在集成云中间件和虚拟化平台之前,需要对它们进行适当的配置。

首先,需要根据实际需求配置云中间件。

例如,配置容器集群的节点数、容器的网络设置、资源的分配策略等。

然后,还需要对虚拟化平台进行配置。

例如,配置虚拟机的CPU和内存资源、虚拟网络的设置等。

四、实施云中间件和虚拟化平台的集成实施云中间件和虚拟化平台的集成可以分为以下几个步骤。

首先,需要创建虚拟机来托管云中间件。

虚拟机的配置应根据云中间件的要求进行设置。

然后,需要将云中间件安装和配置到虚拟机中。

例如,将Docker引擎安装到虚拟机的操作系统中。

接下来,需要配置云中间件和虚拟化平台之间的网络连接和通信。

最后,还需要进行测试和调优,以确保云中间件和虚拟化平台的集成正常运行。

五、管理和监控云中间件和虚拟化平台的集成在云中间件和虚拟化平台集成完成后,需要进行管理和监控,以确保其正常运行和性能优化。

VAS Cloud 资源池 IBM小型机虚拟化组网方案 V1.0 (20140108)

虚拟FC网口

HUAWEI TECHNOLOGIES CO., LTD.

Huawei Confidential

基本概念

WWPN Word wide port name存储网络中对存储端口的唯一标识。

HUAWEI TECHNOLOGIES CO., LTD.

Huawei Confidential

IBM小型机虚拟化

Client

Virt Enet

VIOS 2 VIOS 1 VIOS 2

NIB

SEA Enet PCI

SEA Enet PCI

SEA Enet PCI

SEA Enet PCI

Primary

Huawei Confidential

Backup

HUAWEI TECHNOLOGIES CO., LTD.

可靠性-Shared Ethernet Adapter Failover

APP OS

Micropartitions 分区2

APP OS

分区(虚拟机)通过设置 PVID来确定分区(虚拟机) 所在VLAN,并且确定那个

分区3

APP OS

Virtual I/O Server

VID200 ……

VIOS上的虚拟网口进行数据 转发。 一个VIOS上可以有多个虚拟 接口Virtual Ethernet entX(vir)。 一台物理服务器默认情况下有

Virtual Ethernet Hypervis Switch or

SEA,每个SEA最多支持18个 VLAN。 部署建议:

建议使用独享处理器 若使用微分区,使用比原来 规划的更多的处理器授权数 量。

Switch

Switch

中间件(WAS、WMQ)运维9个常见难点解析

中间件(WAS、WMQ)运维9个常见难点解析包括WAS、WMQ在安装、巡检、监控、优化过程中的常见难点。

安装1、was 负载均衡的机制的粘连性,was负载均衡异常?有⼀个case系统,部署在was集群环境,应⽤是集群环境,有的时候当⼀个节点异常的时,客户端访问该系统就会抛出异常,按正常情况,该会话应该不会断或者断了再连接⼀次就会到另⼀个节点,但是好多时候不管客户端如何连接,都不⾏,该正常的客户端⼀直是正常的,不正常重启机器也不正常。

当然其他新连接的节点也没啥问题,直到重启了故障节点的应⽤,原先不能正常访问的客户端才正常,就算当时清除浏览器缓存也不好使,哪位有这⽅⾯的经验可以多谈谈。

答:1,这是故障转移,was有内部机制可以做到1)内存到内存复制技术可以,缺点,因每台服务器共享session,所以占⽤内存⽐较⼤(如果server很少,可以考虑使⽤)。

2)存储到数据苦或者其他地⽅也可以实现。

推荐使⽤,但是实现较复杂2、如何⼤批量的完成WAS的安装和部署?有哪些⼯具和⽅法?如:⼏百台或上千台WAS服务器的安装和部署答:1,wsadmin 去写脚本是个好办法,配合虚拟化去做。

2,还有上千台的已经不适合去⽤商业软件了,建议去考虑下开源的软件,或者云平台了。

3、was安装低版本升级需要注意哪些⽅⾯?需要重新缴费吗?答:1,was 6 官⽅已经不再提供⽀持,除⾮额外买服务。

2,从2018年4⽉开始,将不再⽀持Java SE 6 与 WebSphere Application Server 配合使⽤,建议更新为 Java SE 7 或 83,WAS V7.0.x 和 V8.0.x 和 Portal Server V8.0.x 于 April 30, 2018 End Of Service低版本注意事项:1,规划好磁盘空间,内存和CPU2,规划好安装⽬录,尽量做到安装⽬录统⼀,规范。

3,了解好业务量⼤⼩,并发等等,⽅便你设计你的was部署⽅案。

虚拟机 中间件 数据库 前置库基本知识

一、虚拟机的基本知识1.1 虚拟机的概念和分类1.2 虚拟机的作用和优势1.3 虚拟机的常见应用场景二、中间件的基本知识2.1 中间件的定义和功能2.2 中间件的分类和特点2.3 中间件在企业应用中的应用三、数据库的基本知识3.1 数据库的概念和分类3.2 数据库的设计原则和范式3.3 数据库的管理和维护四、前置库的基本知识4.1 前置库的定义和作用4.2 前置库的特点和优势4.3 前置库的应用场景和发展趋势一、虚拟机的基本知识1.1 虚拟机的概念和分类虚拟机是一种能够模拟运行在其上的操作系统和应用程序的软件计算机。

根据其运行方式和原理,虚拟机可分为全虚拟化和半虚拟化两种。

全虚拟化是指将整个物理计算机都虚拟成多个虚拟计算机,每个虚拟计算机都拥有完整的硬件系统和运行环境;半虚拟化则是指通过修改操作系统内核,使得多个操作系统共享一个主机的内核和硬件资源。

1.2 虚拟机的作用和优势虚拟机的作用主要是实现资源的高效利用和隔离,可以将一台物理服务器虚拟成多台逻辑服务器,从而提高服务器的利用率和灵活性,并能够更好地隔离不同应用之间的资源和安全性。

虚拟机的优势包括资源隔离、快速部署、灵活性高、成本低等。

1.3 虚拟机的常见应用场景虚拟机的常见应用场景包括服务器虚拟化、开发环境隔离、测试环境模拟等。

在服务器虚拟化中,虚拟机可以将一台物理服务器虚拟成多台逻辑服务器,从而提高服务器的利用率和降低成本;在开发环境隔离中,虚拟机可以提供不同的开发环境,使得开发者可以在同一台物理机上进行不同的开发工作,提高开发效率;在测试环境模拟中,虚拟机可以模拟不同的测试环境,从而提高测试的覆盖率和可靠性。

二、中间件的基本知识2.1 中间件的定义和功能中间件是一种在客户端和服务器端之间的软件系统,它的作用是协调和管理各种不同的软件系统,使它们能够协同工作,实现客户端和服务器端之间的通信和交互。

2.2 中间件的分类和特点中间件根据其作用和功能可以分为消息中间件、数据库中间件、应用服务器等。

IBM虚拟化概念(1)--CPU

IBM虚拟化概念(1)--CPU微分区(micro-partition):可以使用最少0.1个物理CPU。

分配精度可以到0.01,如可是给一个微分区0.11个CPU,但是不能是0.09。

当通过HMC或IVM创建分区时就要指定是创建微分区还是创建专用CPU分区。

这里的0.1、0.11实际上是指的0.1或0.11个物理CPU 的处理能力。

专用CPU分区(dedicated-processor LPAR):只能使用整个物理CPU。

微分区CPU有两种模式:uncapped 和capped不封顶模式(uncapped):当CPU池(Shared Processor Pool)中有多余可用资源时,uncapped 模式的LPAR可以根据设定的权重获得超额的CPU处理能力封顶模式(capped):即使Shared Processor Pool中有空闲的CPU处理能力,使用capped模式的微分区也不能获取超出设定的CPU处理能力。

uncapped模式下,还要设置一个权重值。

当有多个uncapped的LPAR去竞争空闲的CPU 池资源时,各个LPAR按照各自预先设定的权重的比例对可用的CPU资源进行分配。

这个权重值是一个0-255的整数,默认值是128,如果这个权重值设置为0,则系统将此微分区按capped模对待,分区将不能分配超额的CPU资源。

标称处理能力(entitled capacity)如果一个LPAR 没有充分使用它的标称处理能力,余下的CPU 周期会返回给这个LPAR 所属的共享处理器池。

如果一个LPAR 占用它的所有标称CPU 处理能力,就报告利用率为100%。

现在,LPAR 的使用率不一定限于100%。

根据LPAR 的虚拟处理器配置,它能够从共享处理器池借用未使用的CPU周期,系统CPU的使用率就会超过100%。

在这种情况下,一定要注意,在使用的处理能力中超过LPAR 标称处理能力的部分得不到保证(因为它们可能是其他LPAR 的标称处理能力)。