远方梦想-数据分析课堂笔记

第一天课堂笔记

数据分析笔记第1次课–第1章计算机开发Python Java > .net大数据方向数据分析:采集数据-》清洗-》-》分类-》隐含的数据中挖掘有用的数据-》应用于实际生产第一章数据分析概述1 数据分析基本概念从2方面来描述2 数据分析流程(重要)来源于部门需求-》。

-》需求的部门➢需求分析:数据分析中的需求分析也是数据分析环节的第一步和最重要的步骤之一,决定了后续的分析的方向、方法。

➢数据获取:数据是数据分析工作的基础,是指根据需求分析的结果提取,收集数据。

➢数据预处理:数据预处理是指对数据进行数据合并,数据清洗,数据变换和数据标准化,数据变换后使得整体数据变为干净整齐,可以直接用于分析建模这一过程的总称。

➢分析与建模:分析与建模是指通过对比分析、分组分析、交叉分析、回归分析等分析方法和聚类、分类、关联规则、智能推荐等模型与算法发现数据中的有价值信息,并得出结论的过程。

➢模型评价与优化:模型评价是指对已经建立的一个或多个模型,根据其模型的类别,使用不同的指标评价其性能优劣的过程。

部署:部署是指将通过了正式应用数据分析结果与结论应用至实际生产系统的过程3 应用场景介绍(不重要)…4 分析工具-3个5 常用类库Ipython 是python增强工具NumPy 用于科学计算SciPy 标准问题域模块集合Pandas python数据分析的核心库Matplotlib 根据数据绘制表|图Scikit-learn 数据挖掘和分析的工具Spyder(pydee)是交互式开发环境Conda 包|环境管理anaconda:一个集合,包括conda、某版本Python、一批第三方库等6 anaconda安装课后作业:1 复习PPT2 完成课后习题3 预习任务2.1 (第2次课内容)。

2021年北师大版数学小学一年级上册复习课堂笔记

2021年北师大版数学小学一年级上册复习课堂笔记一、数的概念1. 认识数字0-10,理解数字的意义,会进行简单的数的比较。

2. 学习数的组成,理解相邻数字之间的进位关系。

3. 掌握数的排列顺序,会进行简单的数数活动。

4. 学习数的分解,理解乘法口诀的意义。

二、基本的加减法运算1. 学习加法运算,理解加法的意义,会进行简单的加法计算。

2. 学习减法运算,理解减法的意义,会进行简单的减法计算。

3. 学习加减法的运算规律,理解加减法之间的关系。

4. 掌握10以内的加减法计算,能够熟练地进行计算。

三、几何图形1. 认识基本的几何图形,如圆形、正方形、长方形、三角形等。

2. 学习几何图形的特征,理解几何图形之间的关系。

3. 学习几何图形的分类,能够正确地辨别各种几何图形。

4. 掌握几何图形的画法,能够熟练地画出各种几何图形。

四、量的认识1. 认识长度、面积、体积等基本量。

2. 学习量的单位,如米、厘米、千克、克等。

3. 掌握量的测量方法,能够正确地进行量的测量。

4. 学习量的比较,能够进行简单的量的估算。

五、数据的处理1. 学习收集数据的方法,能够用图表的形式展示数据。

2. 学习整理数据的方法,能够对数据进行分类、排序等操作。

3. 学习数据分析的方法,能够从数据中得出结论。

4. 学习运用数据解决问题的方法,能够运用数据解决实际问题。

六、数学思维1. 培养学生的逻辑思维能力,能够进行简单的逻辑推理。

2. 培养学生的抽象思维能力,能够进行简单的抽象概括。

3. 培养学生的创新思维能力,能够进行简单的创新设计。

4. 培养学生的解决问题的能力,能够运用数学知识解决实际问题。

以上就是2021年北师大版数学小学一年级上册的复习课堂笔记,希望同学们能够通过复习,巩固所学知识,提高数学素养。

粉笔资料分析听课笔记(整理版)

粉笔资料分析听课笔记(整理版)一、常用分数、百分数、平方1 3=33.3%14=25%15=20%16=16.7%17=14.3%18=12.5% 19=11.1%110=10%111=9.1%112=8.3%113=7.7%114=7.1%115=6.7%116=6.3%1 1.5=66.7%12.25=44%12.5=40%13.5=28.6%14.5=22%15.5=18.2%16.5=15.4%17.5=13.3%18.5=11.8%1 9.5=10.5%110.5=9.5%111.5=8.7%112.5=7.8%113.5=7.4%114.5=6.9%115.5=6.5%116.5=6.1%22=2 32=942=1652=2562=3672=4982=64 92=81 102=100112= 121122=144132=169 142=196152=225 162=256172=289182=324192=361202=400212=441 222=484232=529242=576252=625 262=676272=729 282=784292=841二、截位直除速算法三、其他速算技巧1、一个数×1.5,等于这个数本身加上这个数的一半。

2、一个数×1.1等于这个数错位相加.3、一个数×0.9等于这个数错位相减.4、一个数÷5,等于这个数乘以2,乘积小数点向前移1位。

5、一个数÷25,等于这个数乘以4,乘积小数点向前移2位。

6、一个数÷125,等于这个数乘以8,乘积小数点向前移3位。

7、比较类:①分母相同,分子大的大;分子相同,分母小的大。

②分子大分母小>分子小分母大。

③当分母大分子大,分母小分子小时,看分母与分母的倍数,分子与分子的倍数,谁倍数大听谁的,谁小统统看为1,再比较。

四、统计术语1、基期:相对于今年来说,去年的就是基期。

《4.3 分析数据》教学设计教学反思-2023-2024学年中职信息技术高教版基础模块下册

《分析数据》教学设计方案(第一课时)一、教学目标1. 理解数据分析和数据处理的基本概念。

2. 掌握Excel软件的基本操作,能够进行简单的数据整理和表格制作。

3. 学会使用Excel中的函数和公式进行数据分析和可视化展示。

二、教学重难点1. 教学重点:掌握Excel软件的基本操作,能够进行简单的数据整理和表格制作。

2. 教学难点:学会使用Excel中的函数和公式进行数据分析和可视化展示,理解数据分析的过程和方法。

三、教学准备1. 准备教学用具:黑板、白板、投影仪、计算机等。

2. 准备教学材料:数据分析案例、Excel软件安装包、Excel 教程视频等。

3. 安排教学时间:本课时为1小时,共2课时。

4. 设计本次课程主要涉及Excel的常见操作,包括数据输入、格式化、公式应用、函数使用等。

我们将通过实际操作和讲解,帮助您掌握Excel的基本技能,从而更好地完成日常工作。

以下为具体的教学安排:1. 导入:介绍Excel的基本界面和功能,以及安装包的使用方法。

2. 任务一:数据输入和格式化(30分钟)* 演示正确的输入方法,如文本、数字、日期等* 讲解如何设置单元格格式,如字体、大小、颜色等* 实际操作,解决学员遇到的问题3. 任务二:公式的应用和函数的了解(30分钟)* 介绍公式的构成和常见元素* 讲解常用函数的使用方法,如SUM、AVERAGE等* 学员实际操作,老师解答疑问4. 任务三:数据透视表的应用(15分钟)* 讲解数据透视表的基本概念和使用方法* 演示如何创建和使用数据透视表* 学员实际操作,老师指导改进5. 总结(5分钟)* 回顾本次课程的主要内容* 解答学员疑问,提供后续建议以下是两个课时的安排表,请参考:**课时一**:内容:数据输入和格式化、公式的应用和函数的了解时间:45分钟/课时**课时二**:内容:数据透视表的应用及总结时间:45分钟/课时如果您有任何问题,欢迎随时提问!请您准备好纸和笔,以便记录课堂中的重要信息。

数据分析咖哥十话读书札记

《数据分析咖哥十话》读书札记一、高级数据分析技能的培养与提升路径数据分析在当今社会已经成为一项至关重要的技能,尤其对于希望在这一领域取得卓越成就的人来说,掌握高级数据分析技能更是必不可少。

在《数据分析咖哥十话》中,作者详细阐述了如何培养与提升高级数据分析技能。

我们必须理解数据分析不仅仅是统计和数学的运用,更是对业务、行业和领域的深入理解。

我们在培养数据分析技能的过程中,需要将数学基础、统计学知识与实际业务场景相结合。

只有深入理解业务背后的逻辑和需求,我们才能做出真正有价值的数据分析。

技术的掌握是提升数据分析技能的关键,随着大数据、云计算和人工智能等技术的不断发展,数据分析的技术工具也在不断更新。

我们需要不断学习新的技术,如Python、R语言、SQL等,以便能高效地进行数据处理和分析。

掌握数据可视化工具,如Tableau、PowerBI 等,也是非常重要的,因为良好的数据可视化能够更直观地展示数据分析的结果。

持续学习是提升数据分析技能的必经之路,数据分析是一个不断学习和进步的过程。

我们需要关注最新的行业动态和技术发展,参加相关的培训课程和研讨会,与同行交流学习,不断提升自己的专业素养。

实践是检验学习成果的最好方式,我们可以通过参与实际的项目,将所学的理论知识运用到实践中,通过解决问题来提升自己的数据分析技能。

通过实践,我们也可以更好地理解数据的价值和影响力,从而更好地进行决策和分析。

良好的数据思维是提升数据分析技能的核心,我们需要培养一种以数据为中心的思考方式,用数据来驱动决策,用数据来解决问题。

我们才能真正成为优秀的数据分析师,为组织和机构带来真正的价值。

《数据分析咖哥十话》为我们提供了培养与提升高级数据分析技能的全面路径。

从理解业务、掌握技术、持续学习到实践项目,再到培养数据思维,每一步都是必不可少的。

只有沿着这条路径不断前进,我们才能在数据分析领域取得更高的成就。

二、数据可视化技术的应用与展示技巧在数据时代,数据分析工作离不开数据可视化这一关键环节。

23课的课堂笔记

23课的课堂笔记

23课堂笔记:

本次课程主要讲解了大数据处理中的一些基本概念和技术,以下是我所记录的一些重点内容:

1. 大数据指的是数据量过大、类型繁多、处理速度要求高的数

据集合。

其特点包括三个V:Volume(数据规模大)、Variety(数据类型多样)和Velocity(数据处理速度快)。

2. 大数据处理的技术包括分布式存储和计算、MapReduce编程

模型、Hadoop生态系统等。

其中,Hadoop是一个开源的大数据处理

框架,包含了HDFS分布式文件系统和MapReduce计算模型。

3. 在大数据处理中,常用的数据存储格式包括文本格式、序列

化格式和列式存储格式。

其中,列式存储格式在处理大规模数据时具有较好的性能表现。

4. 数据清洗和预处理在大数据处理中也非常重要。

常用的数据

清洗工具包括OpenRefine、DataWrangler等。

5. 大数据可视化是将大数据处理结果以图形化界面展现出来的

过程。

常用的大数据可视化工具包括Tableau、D3.js等。

总的来说,本次课程让我了解到了大数据处理的基本概念和技术,对我今后的工作和学习都有很大的启发作用。

DPS课堂笔记

3研究对象的稳定性分析农作物新品种登记推广前的品种区域比较试验包括AMMI模型4 效应曲线分析(定量分析),温度与昆虫发育速度,施肥与产量的关系用的最多的是完全随机设计,随机区组设计完全随机:先将各个处理编上号码先编号再随机分组随机区组设计在电子表格里面输入各个处理的名称,再进行区组设计完全随机设计随机区组设计实验室,实验条件完全相同(如培养皿),用完全随机设计田间实验,局部控制用随机区组设计先划分区组两种设计结果的统计分析。

数据格式;一行一个处理,一列一次重复对数正态分布:对数转换Poisson分布:平方根要不要转换,怎样转换?计算出来的p值最小方差分析是基于正态分布假设,数据在接近正太分布情况下统计效率最高,p值最小多重比较了、:看期刊习惯分析结果,先看p值不同处理之间,指标的高低存在极显著的差异F(2,57)=5.54,P=0.0063 自由度一般只有n-1个是可变的方差分析结果表明不同处理之间差异多重比较,只有在方差分析的p<0、05时才接着进行。

多重比较:有相同的字母,差异不显著所以进行多重比较前,一定要先报告F和P值区组之间差异不用管随机区组设计统计分析、结果解读:区组间差异不用管他和完全随机设计相同,分析处理之间的差异统计差异显著性数据时完整的(平衡数据),实际科研所有的实验设计方法的分析都可以用GLM解决统计方差分析:平方和分解GLM方法,回归分析,最小二乘法回归方程:实验结果的观察值作为因变量Y实验设计的各个处理因子作为自变量X处理因子各个水平进行0-1化虚拟变量处理回归分析第一步:0-1化处理处理高剂量低剂量对照处理1 1 0 0处理2 0 1 0处理3 0 0 1解方程,求回归系数根据回归系数计算各个处理的平方和根据平方和进行方差分析实验设计与回归方程关系:线性模型完全随机设计Y=μ(均值效应)+αi区组效应+e误差项i为处理,j为区组u为在回归方程里为常数项α各个处理水平0-1化求的GLM分析数据格式右边是观察值作为y左边是各个实验处理的组合,自变量x 平方和分解方式:一般是III型变量编码:效应编码参照两种都可以多重比较:5个处理,互相比较,要比较10次4 3 2 1、假设里面有5对是有差异的Tukey:保证不会吧没有差异的判为有差异,这里的判为只有4对……有差异。

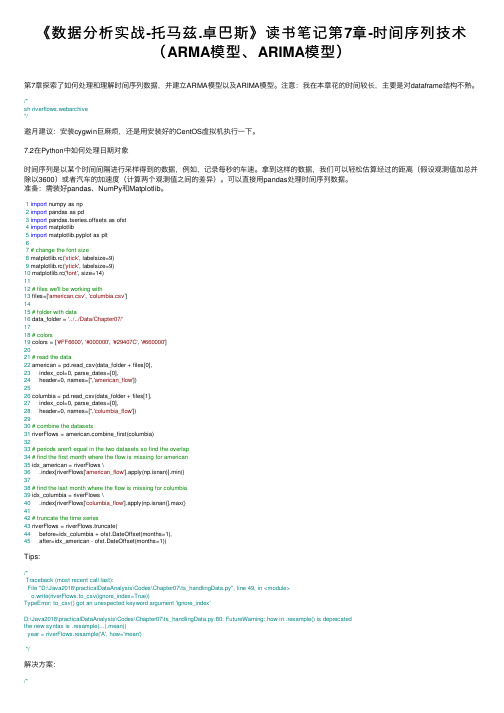

《数据分析实战-托马兹.卓巴斯》读书笔记第7章-时间序列技术(ARMA模型、ARIMA模型)

《数据分析实战-托马兹.卓巴斯》读书笔记第7章-时间序列技术(ARMA模型、ARIMA模型)第7章探索了如何处理和理解时间序列数据,并建⽴ARMA模型以及ARIMA模型。

注意:我在本章花的时间较长,主要是对dataframe结构不熟。

/*sh riverflows.webarchive*/邀⽉建议:安装cygwin巨⿇烦,还是⽤安装好的CentOS虚拟机执⾏⼀下。

7.2在Python中如何处理⽇期对象时间序列是以某个时间间隔进⾏采样得到的数据,例如,记录每秒的车速。

拿到这样的数据,我们可以轻松估算经过的距离(假设观测值加总并除以3600)或者汽车的加速度(计算两个观测值之间的差异)。

可以直接⽤pandas处理时间序列数据。

准备:需装好pandas、NumPy和Matplotlib。

1import numpy as np2import pandas as pd3import pandas.tseries.offsets as ofst4import matplotlib5import matplotlib.pyplot as plt67# change the font size8 matplotlib.rc('xtick', labelsize=9)9 matplotlib.rc('ytick', labelsize=9)10 matplotlib.rc('font', size=14)1112# files we'll be working with13 files=['american.csv', 'columbia.csv']1415# folder with data16 data_folder = '../../Data/Chapter07/'1718# colors19 colors = ['#FF6600', '#000000', '#29407C', '#660000']2021# read the data22 american = pd.read_csv(data_folder + files[0],23 index_col=0, parse_dates=[0],24 header=0, names=['','american_flow'])2526 columbia = pd.read_csv(data_folder + files[1],27 index_col=0, parse_dates=[0],28 header=0, names=['','columbia_flow'])2930# combine the datasets31 riverFlows = bine_first(columbia)3233# periods aren't equal in the two datasets so find the overlap34# find the first month where the flow is missing for american35 idx_american = riverFlows \36 .index[riverFlows['american_flow'].apply(np.isnan)].min()3738# find the last month where the flow is missing for columbia39 idx_columbia = riverFlows \40 .index[riverFlows['columbia_flow'].apply(np.isnan)].max()4142# truncate the time series43 riverFlows = riverFlows.truncate(44 before=idx_columbia + ofst.DateOffset(months=1),45 after=idx_american - ofst.DateOffset(months=1))Tips:/*Traceback (most recent call last):File "D:\Java2018\practicalDataAnalysis\Codes\Chapter07\ts_handlingData.py", line 49, in <module>o.write(riverFlows.to_csv(ignore_index=True))TypeError: to_csv() got an unexpected keyword argument 'ignore_index'D:\Java2018\practicalDataAnalysis\Codes\Chapter07\ts_handlingData.py:80: FutureWarning: how in .resample() is deprecatedthe new syntax is .resample(...).mean()year = riverFlows.resample('A', how='mean')*/解决⽅案:/*# year = riverFlows.resample('A', how='mean')year = riverFlows.resample('A').mean()# o.write(riverFlows.to_csv(ignore_index=True))o.write(riverFlows.to_csv(index=True))*/原理:⾸先,我们引⼊所有必需的模块:pandas和NumPy。

管理系统中计算机应用课堂笔记第四章(5)

管理系统中计算机应用课堂笔记第四章(5)5.2.3功能分析功能分析是对数据流程图中处理过程的功能作详细的说明。

从逻辑上进行分析,处理功能可归纳为三类,即数据的输入和输出处理、算术运算、逻辑判断。

常采用决策树、决策表及结构化语言等作为描述功能分析的工具。

1.决策树决策树又称判定树,是一种呈树状的图形工具,适合于描述处理中具有多种策略,要按照若干条件的判定,确定所采用策略的情况。

左端圆圈为树根表示决策结点;由决策结点引出的直线,形似树枝,称为条件技,每条树枝代表一个条件;中间的圆圈称为条件结点;右端的实心圆表示决策结果。

决策树中条件结点以及每个结点所引出条件技的数量依具体问题而定。

决策树的优点是清晰、直不雅;缺点是当条件多,并且互相组合时,不容易清楚地表达判断过程。

2.决策表决策表又称判断表,是一种呈表格状的图形工具,适用于描述处理判断条件较多、各条件又彼此组合、有多种决策方案的情况。

决策表由四部分组成,3.结构化语言在自然语言的基础上发展了一种规范化的语言表达方式,它使用的词汇主要有三种:即祈使语句中明确的动词;数据字典和数据流程图中的名词;表示处理逻辑结构的保留字。

用结构化语言任何处理逻辑都可以表达为挨次、选择判断、循环三种结构。

(1)挨次结构中的祈使语句应包含一个动词及一个宾语,表示要进行的处理(包罗输入、输出及运算等)。

(2)判断结构有两种表示形式,可与判定树、判定表的表达方式相对应。

(3)循环结构是指在条件成立时,重复执行某处理,直到条件不成立时为止。

5.2.4数据/功能分析U/C矩阵是一张表格。

它可以表数据/功能系统化分析的结果。

它的左边第一列列出系统中各功能的名称,上面第一行列出系统中各数据类的名称。

表中在各功能与数据类的交叉处,填写功能与数据类的关系。

U/C矩阵的正确性,可由三方面来检验:(1)完备性检验。

这是指每一个数据类必需有一个产生者(即“C”)和至少有一个使用者(即“U”);每个功能必需产生或者使用数据类。

语文质量分析报告格式

语文质量分析报告格式标题: 语文质量分析报告一、引言在当今社会,语文素养是一个人综合能力的重要体现。

为了更好地了解学生的语文水平和提升教学质量,本次报告旨在对某教育机构学生的语文质量进行分析和评估。

二、数据收集1. 数据来源本次报告的数据来源主要有以下几方面:- 学生的作文、阅读理解、语法、词汇等写作、阅读和语言知识测试成绩;- 学生的课堂表现和参与度;- 学生的学习笔记和作业完成情况。

2. 数据收集方法为了收集到可靠的数据,我们采取了以下方法:- 定期进行写作、阅读理解、语法、词汇等测试,记录学生的成绩;- 观察和记录学生的课堂表现和参与程度;- 检查学生的学习笔记和作业完成情况。

三、数据分析1. 成绩分析通过对学生的测试成绩进行分析,我们可以得出以下结论:- 学生的写作能力普遍较弱,存在表达不清晰、逻辑混乱等问题;- 阅读理解能力相对较好,但仍有部分学生存在理解不准确、答案选择错误的情况;- 语法和词汇掌握程度良好,大部分学生能正确使用语法规则和词汇。

2. 课堂表现和参与度分析通过观察和记录学生的课堂表现和参与度,我们可以得出以下结论:- 学生的注意力不集中,容易分心;- 学生的积极性较低,缺乏主动参与和思考;- 学生的合作意识和互动能力弱,不善于与同学合作和交流。

3. 学习笔记和作业完成情况分析通过检查学生的学习笔记和作业完成情况,我们可以得出以下结论:- 学生对于笔记的整理能力较弱,缺乏条理性;- 学生对于作业的完成度和质量参差不齐,存在草率和马虎的情况;- 学生对于反思和改进的意识较低,缺乏主动反思和自我检视的习惯。

四、问题分析与建议1. 问题分析根据数据分析的结果,我们可以看出学生存在以下问题:- 写作能力较差,需要加强表达和逻辑思维训练;- 学习积极性和自主学习能力较低,需要培养学生的学习兴趣和主动性;- 合作意识和交流能力较弱,需要提供更多合作学习机会;- 学习态度和习惯有待改善,需要加强学生的自我反思和自我管理能力。

千锋教育python课堂笔记

1. Python基础知识- Python是一种面向对象的编程语言,由Guido van Rossum在1989年发明。

它具有简单易学、功能强大、可扩展性强等特点,适合初学者学习。

2. 变量和数据类型- 在Python中,变量是用来存储数据的名称,可以是数字、字符串、列表等不同类型的数据。

常见的数据类型包括整型、浮点型、字符串等。

3. 控制流语句- Python提供了丰富的控制流语句,如if语句、for循环和while循环,用来控制程序的执行流程。

掌握这些语句可以让程序更灵活、更高效。

4. 函数和模块- 函数是一段可重复使用的代码块,通过定义和调用函数可以提高代码的重用性和可维护性。

模块是一组相关的函数和变量的集合,可以使用import关键字引入模块。

5. 文件操作- Python支持对文件的读写操作,通过open函数可以打开文件并进行读写操作。

掌握文件操作可以让程序与外部文件进行数据交互,提高程序的实用性。

6. 异常处理- 在程序运行过程中可能会出现各种错误,Python提供了try-except 语句用来处理异常。

掌握异常处理可以让程序更健壮、更可靠。

7. 面向对象编程- Python是一种面向对象的编程语言,支持类、对象、继承、多态等面向对象编程的特性。

掌握面向对象编程可以让程序更结构化、更易扩展。

8. 实战项目- 通过实战项目可以巩固所学知识,提高编程能力。

可以选择一些简单的项目,如编写一个简单的小游戏、爬取全球信息站数据等。

9. 学习资源- 除了课堂教学,还可以通过阅读书籍、参加线上课程、搜索网络资源等方式来提高Python编程技能。

建议可以关注一些Python技术交流社区,如GitHub、知识等。

10. 总结- Python是一种简单易学、功能丰富的编程语言,适合初学者学习。

通过系统的课堂学习和实战项目练习,可以提高编程能力,为将来的学习和工作打下良好的基础。

11. 应用领域Python不仅仅是一种流行的教学语言,同时也是各种领域中的实际应用编程语言。

数据分析师数据科学家学习笔记

数据分析师数据科学家学习笔记涉及内容统计学,机器学习,数据可视化数据分析师数据科学家统计学,机器学习,预测建模,可视化专业领域商业智慧甚⾄编程能⼒。

统计学概念通过搜索、整理、分析⽅法达到推断所研究对象的本质,为做决策做辅助。

获取数据 =》数据仓库准备 =》挖掘分析 =》形成辅助决策数据思维体系采集、建模、决策、预测数据分析报告:1.明确分析报告。

2.深⼊学习业务流程。

3.理解业务领域模型。

4.收集报告及相关数据5.分析提炼数据信息,挖掘,洞察数据价值6.准备的语⾔概括特征,可视化展⽰。

7.并给出科学合理的总结性建议,为企业的战略规划提供数据⽀撑。

题型分析:了解常⽤假设检验⽅法。

卡⽅、t、z、分散分析。

两范畴的独⽴性检验选择卡⽅检验。

基本任务:数据挖掘识别出未知的,有⽤的,最终可理解的模式。

定义挖掘⽬标:原⽣数据数据挖掘隐藏的数据信息机器学习求的是参数 R-square 准确率母体(总体) 参数和统计量总体: 所有数据个体:每⼀个样本:⼀组数据全量:可以收集到的数据⼤量性、同质性、差异性、相对性母体的特征/变量/观测是⼀个意思随机样本和⾮随机样本,样本是否能真是正确的代表母体是⾮常重要的。

数据收集:普查、抽样调查。

母体参数:描述母体的特征的某些特征值。

均值⽅程,样本统计量:是由样本中所计算出来的量,⽤来推断母体变量/观测:指研究对象特征或者属性的名称统计学变量可区分连续性离散变量连续变量按照性质确定性变量和随机变量。

参数:统计学总体特征变量的总称参数和统计量:参数是总体的变量,总体平均数防擦好,统计量指的是样本。

估计误差:当样本参数估计母体参数,估计量与母体参数总会有差距估计误差 = 样本统计量与母体参数差异 = 抽样误差+⾮抽样误差抽样误差:因为抽样⽅法和推论⽅法不同造成的样本统计量和母体参数间的差异。

⾮抽烟误差:⼈为误差造成。

统计学种类:统计学:收集处理分析解释并从数据得到结论的科学。

描述统计:研究数据收集、处理和描述的统计学⽅法。

四年级上册第10课课堂笔记

四年级上册第10课课堂笔记一、引言在本课中,我们将学习如何进行统计和数据分析,这是四年级学生必须掌握的一项重要技能。

统计数据在我们的日常生活中随处可见,而数据分析则是理解和利用这些数据的关键。

通过本课的学习,学生们将了解如何收集、整理和展示统计数据,以及如何利用数据得出有意义的结论。

二、课程内容1. 认识统计图表教学目标:学生能够识别不同类型的统计图表(如条形图、折线图、饼图等),并了解它们的特点和用途。

教学内容:(1)条形图:用于比较两个或多个事物的数量差异。

(2)折线图:用于表示时间序列数据的趋势。

(3)饼图:用于显示部分与整体的比例。

教学步骤:(1)展示各种类型的统计图表,并解释其含义。

(2)让学生观察图表,并尝试解释其反映的信息。

(3)讨论不同图表的特点和适用场景。

2. 数据收集与整理教学目标:学生能够掌握如何收集和整理数据,以及如何确保数据的准确性和可靠性。

教学内容:(1)如何从日常生活中收集数据。

(2)如何筛选、分类和整理数据。

(3)如何识别无效数据并排除干扰。

教学步骤:(1)引导学生讨论他们感兴趣的某个主题,并思考如何收集相关数据。

(2)教授学生使用适当的工具和方法整理数据,例如列表、画图等。

(3)讨论如何确保数据的准确性和可靠性,以及如何处理异常值。

3. 数据分析教学目标:学生能够理解数据分析的基本步骤,包括选择分析指标、进行描述性统计和推断性统计等。

教学内容:(1)数据分析的基本步骤。

(2)常见分析指标及其用途(如平均数、中位数、众数、标准差等)。

(3)推断性统计的基本概念和方法。

教学步骤:(1)介绍数据分析的基本步骤,包括选择分析指标、进行描述性统计和推断性统计等。

(2)通过实例讲解如何选择合适的分析指标,并进行描述性统计,如求平均数、中位数等。

(3)讲解如何利用样本数据推断总体分布和特征,如使用正态分布表进行推断。

(4)讨论如何根据数据分析结果得出有意义的结论。

三、课堂笔记总结通过本课的学习,学生们了解了统计图表的特点和用途,学会了如何收集和整理数据,并掌握了数据分析的基本步骤和方法。

六年级上册园地三课堂笔记

六年级上册园地三课堂笔记

一、学习目标

1. 了解中国的传统文化,增强文化自信。

2. 学习如何进行简单的调查,收集、整理数据。

3. 学习使用学习工具,提升自主学习能力。

二、重点与难点

1. 重点:了解中国的传统文化,学习如何进行简单的调查。

2. 难点:学习使用学习工具,进行数据的收集和整理。

三、学习内容

1. 中国的传统文化

- 中国传统节日:春节、清明节、端午节、中秋节。

- 中国传统艺术:书法、绘画、音乐、舞蹈。

- 中国传统习俗:拜年、放鞭炮、贴春联、赏月。

2. 调查的方法与步骤

- 确定调查主题:选择一个感兴趣的主题,如“小学生最喜欢的节日”。

- 设计调查问卷:问卷应包括问题和答案,问题应简洁明了,答案易于统计。

- 发放问卷:将问卷发放给目标人群,确保样本的代表性和广泛性。

- 整理数据:对收集到的数据进行整理,统计出各项答案的百分比。

- 分析数据:根据统计结果,分析出调查主题的情况和趋势。

3. 学习工具的使用

- 学习资料:推荐使用《辞海》等权威工具书。

- 学习软件:可以使用Microsoft Excel等电子表格软件进行数据处理。

四、练习与思考

1. 思考题:在中国的传统文化中,你认为哪些习俗或艺术最具代表性?为什么?

2. 练习题:设计一份关于“小学生最喜欢的学科”的调查问卷,并进行调查,最后写出调查报告。

基于高质量教学在线教育课堂活跃度数据分析

基于高质量教学在线教育课堂活跃度数据分析在线教育课堂的学习效果一直是教育界研究人员关注的话题,课堂活跃度是影响学习效果的重要因素。

为了客观地认识课堂活跃度对学习效果的影响,本次调查以数字媒体学院2019级数字媒体系学生1班和2班为研究对象,通过课堂活跃数据统计的方法,收集一个教学周的课堂互动数据,分析网课学生课堂活跃度对学生学习效果的影响,指出积极的心理因素能促进学习效果的提高和改善。

关键词:在线教育;数字媒体;数据一、在线教育课堂活跃度调查方法(一)调查对象选取的研究对象为数字媒体学院2019级数字媒体技术专业1班和2班,人数均为40人,学习的课程为《图形创意》。

数字媒体技术专业两个班级的文化底蕴、所学课程内容难易度、授课教师个人风格和教学设计完全对等。

(二)测试工具(1)课堂活跃度;收集了在线直播工具“腾讯课堂”中2020-2021学年第二学期3月-6月第一教学周中,每次直播课程的师生互动情况数据,从个体、班级、专业多个维度统计学生的课堂互动数量、课堂加分情况,保证统计数据的获取条件相同,确保统计数据科学可信。

(2)教学效果;借助“腾讯课堂”数据统计平台,以过程性学生参与度为基本指标,收取学生互动的频率。

(3)数字媒体技术专业1班互动60次、签到3次、互动一次1分,其中最高分为56分占1人,15-20分的人数最多占15人,最低分0分占1人;数字媒体技术2班互动60次、签到3次,、互动一次1分,其中最高分为16分占2人,5-10分的人数最多占36人,最低分0分占5人。

课堂活跃度对个人成绩没有决定性作用,课堂发言的积极性程度并不能预示其学习效果的好坏,但是对整体的平均分和及格率会有一定的影响,这就说明课堂活跃度可以提高课堂教学的氛围,一定程度上提高学生的学习兴趣,因此教师在教学活动中引导学生积极课堂互动有一定的正面意义。

(三)分析方法(1)个案研究法:针对教学资源不同,学习设置不同对不同班级的班干部进行调查,挖掘其对学习效果的影响。

cda考试二级笔记

cda考试二级笔记CDA(Certified Data Analyst)考试是中国数据分析师协会认证的数据分析师考试。

下面是CDA考试二级的笔记,供您参考:一、数据挖掘与机器学习基础1. 数据挖掘定义:从大量数据中提取有价值的信息的过程。

2. 机器学习定义:利用计算机算法从数据中自动学习并改进模型的过程。

3. 数据挖掘与机器学习的关系:数据挖掘是应用,机器学习是方法。

4. 常用数据挖掘算法:决策树、聚类、关联规则、分类、回归等。

5. 常用机器学习算法:线性回归、逻辑回归、支持向量机、神经网络等。

二、数据预处理1. 数据清洗:处理缺失值、异常值、重复值等。

2. 数据集成:将多个数据源的数据整合到一起。

3. 数据归约:降低数据集的大小,如主成分分析、特征选择等。

4. 数据变换:将数据转换成适合分析的格式或形式,如特征编码、数据标准化等。

三、数据分析与可视化1. 描述性统计:均值、中位数、方差等统计量。

2. 探索性分析:发现数据的分布、趋势和异常。

3. 可视化工具:Tableau、Excel、PowerBI等。

4. 常用图表类型:柱状图、折线图、饼图、散点图等。

四、预测与决策分析1. 时间序列预测:ARIMA模型、指数平滑等。

2. 回归分析:线性回归、逻辑回归等。

3. 分类分析:决策树、支持向量机等。

4. 决策树分析:构建决策树模型,进行分类或预测。

5. 关联规则分析:发现数据之间的关联规则,如购物篮分析。

五、高级主题1. 大数据处理技术:Hadoop、Spark等。

2. 数据挖掘中的隐私保护技术:差分隐私、k-匿名等。

3. 数据可视化中的高级技术:热力图、气泡图等。

4. 机器学习中的集成学习、深度学习等技术。

数据分析习题集

5

成都信息工程学院>>精品课程>>数据分析

第四章 主成分分析与典型相关分析

1、设总体 X = ( X 1 X 2 X 3 )T 的协方差矩阵为

179.41

13

福建

19.46

250.16

14

江西

10.93

122.06

15

山东

40.26

552.74

16

河南

19.82

268.20

17

湖北

19.49

221.43

18

湖南

16.01

197.68

19

广东

99.32

1080.26

20

广西

14.77

160.6021海南3.9639.51

22

重庆

10.49

111.76

(2) 求出方差分析表,解释线性回归关系显著性检验结果,求复相关系数的

平方 R 2 的值并解释其意义。

(3) 分别求 b1 和 b 2 的置信度为 0.95 的置信区间。 (4) 该 公 司 欲 在 一 个 适 宜 使 用 该 化 妆 品 的 人 数 x01 = 220 , 人 均 月 收 入

x02 = 2500 的城市销售该化妆品,求其销量的预测值及其置信度为 0.95 的置信区 间。

表 1.5 血液中 4 种成分的含量数据

x1 18.8 17.4 16.0 19.3 17.4 15.3 16.7 17.4 16.2 16.7 18.2 16.7 x2 28.1 25.6 27.4 29.5 27.4 25.3 25.8 26.7 25.7 26.7 28.0 26.7 x3 5.1 4.9 5.0 1.7 4.5 3.6 4.4 4.4 2.3 6.4 3.2 2.1 x4 35.1 33.9 32.2 29.1 35.6 32.2 33.0 33.0 33.9 35.0 29.7 34.9

面板数据笔记

5,面板的R2不重要,可不汇报。

固定效应模型(Fixed Effects Model,FE):

种类:单向固定效应和双向固定效应模型

单向固定效应:只考虑个体固定效应 双向固定效应:考虑个体固定效应和时间固定效应 (个体)固定效应模型:组内估计量——模型的修正方法是对方程做离差变 换,消去个体效应νi (个体)固定效应模型:LSDV法(最小二乘虚拟变量法)——模型的修正方 法是为n个个体引入(n-1)个“个体虚拟变量”(因为要保存常数,避免虚拟 变量陷阱) (个体)固定效应模型:一阶差分法——模型的修正方法是对方程做一阶差 分变换 (时间)固定效应模型(如宏观经济环境)——模型的修正方法是引入时间 固定效应,引入(T-1)时间虚拟变量

4,面板数据视作截面数据,即要求样本中的每 个个体i拥有完全相同的回归方程,不存在个体效应。

缺点:强调同质性,忽视异质性。异质性可能与解释变量相关,导致估计不一 致。

方法:使用OLS估计,但使用的是聚类稳健的标注误。(使用聚类稳健标准误的 前提是短面板,n趋向于无穷) (2)分别回归:为每个个体估计单独的回归方程。 缺点:强调异质性,忽视同质性。可能没有足够大的样本容量。 (3)个体效应模型(折中策略):假定个体的回归方程拥有不同的截距,相同的斜 率。

面板数据

参考: 2,一元时序 3,多元时序

1,定义 同时具有横截面维度和时间维度的数据

2,种类 (1)短面板和长面板: 短面板:T较小,n较大 (2)动态面板和静态面板: 动态面板:解释变量中包含着被解释变量的滞后值 (3)平衡面板和非平衡面板: 平衡面板:在每个时期个体完全相同

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

远方的梦想数据分析

这是第一次听远方老师的课程,以前也没接触过淘宝类似的课程。

所以从某种角度,远方老师的理论在我内心根深蒂固了。

这次分享,主要是告诉卖家们如何建立一套自己可控的运营体系。

熟知运营当中的一些漂亮的玩法。

活学活用,运用到自己的类目当中去。

我很赞同远方老师的方法,指引道路,抛砖引玉。

一套基本的运营体系的建立,要依靠

1、原始数据的精准

2、产品方向的准确把握能力

3、敏锐的洞察力

4、详尽的逻辑分析

本次学习的关键是从三张表格引申出来的

一、商品运营推广计划表

二、人气商品工作表

三、店铺健康监测表

【一】运营表的建立,思路是一整套缜密的流程。

对应着流程结合自己的类目,一个该类目的运营流程就出来了。

这里面包含了有:

1、选品分析

这里需要问自己几个问题:

1)、该子类目有哪些商家在做,并且要把他们全部分析一遍

(这里要知道他们的销量是怎么来的)

2)、这些商家的推广方式是什么

3)、这些商家投入的广告费用是多少

4)、这个商品的转化率是多少

2、新产品推广计划

这个环节是开展也是基于前面对类目的分析来进行,类目选择好以后,产品也就出来了,产品确定以后,就要对新产品进行从头到脚的塑造。

这里远方老师的一句话很经典:每一个店铺每一个行业都是不可复制的。

新产品计划,就是创造自己的人气商品(爆款是运作起来的)。

产品的确定之前需要考虑一个重要问题就是分析买家的购买,要问自己买家为什么购买,也学学羊群效应。

这里重点是在一个周期下进行分类运作。

远方来时是以30天为案例,来打造自己的人气商品。

这个周期分为1、2、3、4、5-15、15-25、25-30

第一天:文案策划

这里有3个数字和3个指标要确定好

3个数字:3——3个卖点;4——买家的4个问题;5——商品描述的5个步骤(在一家企业中这步骤有运营总监于客服主管进行)

3个指标:高——商城推荐位置;中——人气宝贝页第一页;低——人气宝贝页第三页

这里的运算公式是最后6个商品的销量相加除以六,得出的结果即是自己需要达到的目标销量。

第二天:拍照环节

根据第一天得出的3个数字,来从拍照过程体现出来。

第三、四天:美工作图上传

这里需要加入一个审核机制(运营总监与客服主管,远方老师公司的做法是,给客服前十吗

比订单30%的奖励)从而将客服培训内容包含了进去。

第五-十五天

这个周期是测款的开始。

而且这十天是需要完成前面3个指标中的低指标的。

如何完成,首先是不花一分钱就要把这个目标做到。

而且要做到,对待老顾客只送不卖。

这里的实现过程就是要做到全淘宝自然搜索第一,销量的话从熟人,熟人的团队,自己CRM 的客户数据来获得。

这十天也是搞定竞争对手的关键。

关于推广手段,这里提到了官方工具搭配套餐。

即:A+B=销售价。

数据显示这么操作以后A 产品得到了高转化率,B产品获得了销量、评价、转化、流量。

而且最后B产品的转化率会高于A产品。

这里有个核心概念就是:“转化率比销售笔数更重要”。

在这个低指标要求完成70%左右,可以开始我们的直通车付费式推广的试运行。

范围是本省,关注两个点:一直通车图片(点击量、转化率);二是关键字,这里说到每个产品的关键词不超过20个。

这十天整个的过程都是一个测试测款的过程。

通过这些免费手段推出的产品如果连最低的指标都达不到,那么这款商品就根本没有推广的必要。

如果整个指标在2-3天完成,那么说明这个产品成为爆款的潜力非常之大。

第十五-二十五天

首先,通过前十天的指标完成情况得到的结论无非是此次爆款已经成型,那么要将这个爆款更加深入人心,那么就要在接下来的十天内完成中级目标。

如何完成:

首先前期的免费推广手段幅度降低,开始着手付费推广环节。

因为前面也做了相应的试推广,那么这里的实施开展就会非常的方便与有针对性。

讲到付费推广,那么就要明白一个参考值的来历。

首先问自己为什么付费推广,付费推广是为了更高的利润回报,那么一个客户的价值利润是怎么的出来的呢?一个公式:客单价*转化率*毛利率=访客价值。

的出来的值就是这件商品推广时的重要参考指标,如果高于这个值,那么所做的一切都是亏本的,而这里还仅仅是对毛利率。

这里的转化率,目标是起码达到行业的平均转化率。

推广手段:直通车(要做到夜夜做新娘)、钻石展位(店铺定向)、淘客;关于这三个手段的使用,只需详细阅读相应的说明文档即可。

起决定性因素的其实是对产品动向的把握能力也就是思路方向。

付费推广所做的产品必须是有销售记录的产品

同样的在这十天内也要考虑到出现差错时的应对预案。

假如1-2天就达到了此次中级目标,那么这个时候要第一时间考量供应链是否能承受得住接下来的大爆发。

常见的是遇到这种情况,运营与供应链就出现了脱节,一旦脱节。

前面所做的工作就都白费了,而且被竞争对手超过是分分钟的事情。

第二十五天-第三十天

这里通过前面十天的精心打造,已经可以说是一个甩开竞争对手一大截的关键冲刺阶段,决定着你是否能做真正的第一的时刻。

到了这步骤,就需要不惜一切代价,来达到高级目标了,甚至可以加大免费推广实施的力度。

在这里要遵循的规则有,一个类目:

1个人气商品(直通车永远推广的)

2-3个次爆款

4-6个利润款(利润款只做关联销售)

1-2个形象款

1个打击款(这个玩法很有用)

这个环节最重要的就是监测和反应速度了。

能否做到第一,就在此一举了,有了前面周期的铺垫,要做到第一其实已经不是很难的事情了。

【二】人气商品工作表

这个表格的建立主要是监测人气商品的几个重要指标和竞争对手的同类商品的指标做对比。

A商品排名;最近30天销量,7天销量,昨日销量

通过这些指标与竞争对手进行对比,就会发现,如果连续三天排名下降,如果连续三天竞争对手销售笔数超过我了,我们这边就要做出相应的对策。

同样的是要快速。

这里远方来时提到过人气飙升榜,这里我很模糊。

【三】店铺健康检测表

这个表格是由6个基础表综合的出来的。

他们分别是

1、 DSR表:流量转化率毛利润三个基础数据加上DSR的评分数据:描述、服务、快递

同样对比,连续三天某项降低都需要作出相应的对策。

2、自然搜索比例表:人气商品的上升与下降,三个基本点,一自然搜索量;二自然搜索量占比;三是包含有关键词、类目、商城、收费等元素在内的指标监测。

3、跳失率表:包括有全站跳失率,人气1、人气2、新品1、新品2的跳失率等等。

这里的关键在于评价。

4、询单转化率表:这个可以通过赤兔来获得数据。

同样包含了全站的询单转化,客服

A、客服B的转化等等。

5、 ROI投入产出比表:主要三大付费推广手段直通车,钻石展位,淘客的投入与销售情况。

6、访问深度表:即PV/UV 这里大于等于4属于正常,小于2的就是在做无谓的推广。

同样对人气商品、关联1、关联2、关联3等字段进行监测。

以上每张表格后面都会附带着解决对策。

总结一下:这次学习,我对淘宝店铺运营有了一个最基础的了解。

也深知一次完整并且有效的推广在整个店铺运营中起到的中流砥柱的作用。

更加让我对这个领域的兴趣大大增加。