Coupled Information-Theoretic Encoding for Face Ph

山西省朔州市怀仁市第一中学2024-2025学年高三上学期摸底考试英语试题

2024~2025学年怀仁一中高三年级摸底考试英语全卷满分150分,考试时间120分钟。

注意事项:1.答题前,先将自己的姓名、准考证号填写在试卷和答题卡上,并将条形码粘贴在答题卡上的指定位置。

2.请按题号顺序在答题卡上各题目的答题区域内作答,写在试卷、草稿纸和答题卡上的非答题区域均无效。

3.选择题用2B铅笔在答题卡上把所选答案的标号涂黑;非选择题用黑色签字笔在答题卡上作答;字体工整,笔迹清楚。

4.考试结束后,请将试卷和答题卡一并上交。

5.本卷主要考查内容:高考范围。

第一部分听力(共两节,满分30分)第一节(共5小题;每小题1.5分,满分7.5分)听下面5段对话。

每段对话后有一个小题,从题中所给的A、B、C三个选项中选出最佳选项。

听完每段对话后,你都有10秒钟的时间来回答有关小题和阅读下一小题。

每段对话仅读一遍。

例:How much is the shirt?A. £19.15.B. £9.18.C. £9.15.答案是C。

1. Whose birthday is it today?A. Cassie’s.B. John’s.C. Ashley’s.2. What does the man think of Allan’s paintings?A. Funny.B. Terrible.C. So- so.3. What does the woman mean?A. David often eats his words.B. Her party was a success.C. Dr. Andrew put off his lecture.4. How do the speakers sound?A. Fine.B. Relaxed.C. Worried.5. What happened to Josh’s sister yesterday?A. She served the wrong dish.B. She got lost with her brother.C. She failed to behave herself in public.第二节(共15小题;每小题1.5分,满分22.5分)听下面5段对话或独白。

信息检索关键词部分

信息检索关键词部分Key word第1章信息检索(Information Retrieval, IR)数据检索(data retrieval)相关性(relevance)推送(Push)超空间(hyperspace)拉出(pulling)⽂献逻辑表⽰(视图)(logical view of the document)检索任务(retrieval task 检索(retrieval )过滤(filtering)全⽂本(full text)词⼲提取(stemming)⽂本操作(text operation)标引词(indexing term)信息检索策略(retrieval strategy)光学字符识别(Optical Character Recognition, OCR)跨语⾔(cross-language)倒排⽂档(inverted file)检出⽂献(retrieved document)相关度(likelihood)信息检索的⼈机交互界⾯(human-computer interaction, HCI)检索模型与评价(Retrieval Model & Evaluation)⽂本图像(textual images)界⾯与可视化(Interface & Visualization)书⽬系统(bibliographic system)多媒体建模与检索(Multimedia Modeling & Searching)数字图书馆(Digital Library)检索评价(retrieval evaluation)标准通⽤标记语⾔(Standard Generalized Markup Language, SGML)标引和检索(indexing and searching)导航(Navigation)并⾏和分布式信息检索(parallel and distribution IR)模型与查询语⾔(model and query language)导航(Navigation)有效标引与检索(efficient indexing and searching)第2章特别检索(ad hoc retrieval)过滤(filtering)集合论(set theoretic)代数(algebraic)概率(probabilistic 路由选择(routing)⽤户需求档(user profile)阙值(threshold)权值(weight)语词加权(term-weighting)相似度(similarity)相异度(dissimilarity)域建模(domain modeling)叙词表(thesaurus)扁平(flat)⼴义向量空间模型(generalized vector space model)神经元(neuron)潜语义标引模型(latent semantic indexing model)邻近结点(proximal node)贝叶斯信任度⽹络(Bayesian belief network)结构导向(structure guided)结构化⽂本检索(structured text retrieval, STR)推理⽹络(inference network)扩展布尔模型(extended Boolean model)⾮重叠链表(non-overlapping list)第3章检索性能评价(retrieval performance evaluation)会话(interactive session)查全率(R, Recall Ratio) 信息性(Informativeness)查准率(P, Precision Ratio) ⾯向⽤户(user-oriented)漏检率(O, Omission Ratio) 新颖率(novelty ratio)误检率(M, Miss Ratio) ⽤户负担(user effort)相对查全率(relative recall)覆盖率(coverage ratio)参考测试集(reference test collection)优劣程度(goodness)查全率负担(recall effort)主观性(subjectiveness)信息性测度(informativeness measure)第4章检索单元(retrieval unit)字母表(alphabet)分隔符(separator)复合性(compositional)模糊布尔(fuzzy Boolean)模式(pattern)SQL(Structured Query Language, 结构化查询语⾔) 布尔查询(Boolean query)参照(reference)半结合(semijoin)标签(tag)有序包含(ordered inclusion)⽆序包含(unordered inclusion)CCL(Common Command Language, 通⽤命令语⾔) 树包含(tree inclusion)布尔运算符(Boolean operator) searching allowing errors容错查询Structured Full-text relevance feedback 相关反馈Query Language (SFQL) (结构化全⽂查询语⾔) extended patterns扩展模式CD-RDx Compact Disk Read only Data exchange (CD-RDx)(只读磁盘数据交换)WAIS (⼴域信息服务系统Wide Area Information Service)visual query languages. 查询语⾔的可视化查询语法树(query syntax tree)第5章query reformulation 查询重构 query expansion 查询扩展 term reweighting 语词重新加权相似性叙词表(similarity thesaurus)User Relevance Feedback⽤户相关反馈 the graphical interfaces 图形化界⾯簇(cluster)检索同义词(searchonym) local context analysis局部上下⽂分析第6章⽂献(document)样式(style)元数据(metadata)Descriptive Metadata 描述性元数据 Semantic Metadata 语义元数据intellectual property rights 知识产权 content rating 内容等级digital signatures数字签名 privacy levels 权限electronic commerce电⼦商务都柏林核⼼元数据集(Dublin Core Metadata Element Set)通⽤标记语⾔(SGML,standard general markup language)机读⽬录记录(Machine Readable Cataloging Record, MARC)资源描述框架(Resource Document Framework, RDF) XML(eXtensible Markup Language, 可扩展标记语⾔) HTML(HyperText Markup Language, 超⽂本标记语⾔)Tagged Image File Format (TIFF标签图像⽂件格式)Joint Photographic Experts Group (JPEG) Portable Network Graphics (PNG新型位图图像格式)第7章分隔符(separator)连字符(hyphen)排除表(list of stopwords)词⼲提取(stemming)波特(porter)词库(treasury of words)受控词汇表(controlled vocabulary)索引单元(indexing component)⽂本压缩text compression 压缩算法compression algorithm注释(explanation)统计⽅法(statistical method)赫夫曼(Huffman)压缩⽐(compression ratio)数据加密Encryption 半静态的(semi-static)词汇分析lexical analysis 排除停⽤词elimination of stopwords第8章半静态(semi-static)191 词汇表(vocabulary)192事件表(occurrence)192 inverted files倒排⽂档suffix arrays后缀数组 signature files签名档块寻址(block addressing)193 索引点(index point)199起始位置(beginning)199 Vocabulary search词汇表检索Retrieval of occurrences 事件表检索 Manipulation of occurrences事件表操作散列变换(hashing)205 误检(false drop)205查询语法树(query syntax tree)207 布鲁特-福斯算法简称BF(Brute-Force)故障(failure)210 移位-或(shift-or)位并⾏处理(bit-parallelism)212顺序检索(sequential search)220 原位(in-place)227第9章并⾏计算(parallel computing) SISD (单指令流单数据流)SIMD (单指令流多数据流) MISD (多指令流单数据流)MIMD (多指令流多数据流)分布计算(distributed computing)颗粒度(granularity)231 多任务(multitasking)I/O(input/output)233 标引器(indexer)映射(map)233 命中列表(hit-list)全局语词统计值(global term statistics)线程(thread)算术逻辑单元(arithmetic logic unit, ALU 中介器(broker)虚拟处理器(virtual processor)240分布式信息检索(distributed information retrieval)249⽂献收集器(gatherer)主中介器(central broker)254第10章信息可视化(information visualization)图标(icon)260颜⾊凸出显⽰(color highlighting)焦点+背景(focus-plus-context)画笔和链接(brushing and linking)魔术透镜(magic lenses)移动镜头和调焦(panning and zooming)弹性窗⼝(elastic window)概述及细节信息(overview plus details)⾼亮⾊显⽰(highlight)信息存取任务(information access tasks)⽂献替代(document surrogate)常见问题(FAQ, Frequently Asked Question) 群体性推荐(social recommendation)上下⽂关键词(keyword-in-context, KWIC)伪相关反馈(pseudo-relevance feedback)重叠式窗⼝(overlapping window)⼯作集(working set)第11/12章多媒体信息检索(Multimedia Information Retrieval, MIR)超类(superclass)半结构化数据(semi-structured data)数据⽚(data blade)可扩充型系统(extensible type system)相交(intersect)动态服务器(dynamic server)叠加(overlaps)档案库服务器(archive server)聚集(center)逻辑结构(logical structure)词包含(contain word)例⼦中的查询(query by example)路径名(path-name)通过图像内容查询(Query by Image Content, QBIC)图像标题(image header)主要成分分析(Principal Component Analysis, PCA)精确匹配(exact match)潜语义标引(Latent Semantic Indexing, LSI)基于内容(content-based)范围查寻(Range Query)第13章exponential growth指数增长 Distributed data 数据的分布性volatile data 不稳定数据 redundant data 冗余数据Heterogeneous data异构数据分界点(cut point)373Centralized Architecture集中式结构收集器-标引器(crawler-indexer)373 Wanderers 漫步者 Walkers 步⾏者 Knowbots 知识机器⼈Distributed Architecture分布式结构 gatherers 收集器brokers 中介器 the query interface 查询界⾯the answer interface响应界⾯ PageRank ⽹页级别Crawling the Web漫游Web breadth-first ⼴度优先depth-first fashion 深度优先 Indices(index pl.)索引Web Directories ⽹络⽬录 Metasearchers元搜索引擎Teaching the User⽤户培训颗粒度(granularity)384超⽂本推导主题检索(Hypertext Included Topic Search, HITS)380 Specific queries专指性查询 Broad queries 泛指性查询Vague queries模糊查询 Searching using Hyperlinks使⽤超链接搜索Web Query Languages查询语⾔ Dynamic Search 动态搜索Software Agents 软件代理鱼式搜索(fish search)鲨鱼搜索(shark search)拉出/推送(pull/push)393门户(portal)395 Duplicated data 重复数据第14章联机公共检索⽬录(online public access catalog, OPAC)397化学⽂摘(Chemical Abstract, CA)399 ⽣物学⽂摘(Biological Abstract, BA)⼯程索引(Engineering Index,EI)国会图书馆分类法(Library of Congress Classification)408杜威⼗进分类法(Dewey Decimal Classification)408联机计算机图书馆中⼼(Online Computer Library Center, OCLC)409机读⽬录记录(Machine Readable Cataloging Record, MARC)409第15章NSF (National Science Foundation, 美国国家科学基⾦会)NSNA(National Aeronautics and Space Administration,美国航空航天局)数字图书馆创新项⽬(Digital Libraries Initiative, DLI)4155S(stream,信息流structure,结构space, 空间scenario, 场景society社会)416基于数字化对象标识符(Digital Object Identifier, DOI)420都柏林核⼼(Dublin Core, DC)430 数字图书馆(Digital Library, DL)资源描述框架(Resource Document Framework, RDF)431text encoding initiative (TEI) (⽂本编码创新项⽬)431v。

稠密表示下语义相似段落检索技术

稠密表示下语义相似段落检索技术语义相似段落检索技术是一种用于在大规模文本数据中快速检索语义相似段落的技术。

在信息爆炸的时代,海量的文本数据对于人们来说是一种巨大的挑战,如何有效地检索和获取所需信息成为了重要的问题。

稠密表示是一种将文本转换成稠密向量的方法,它可以将文本的语义信息编码到一个固定长度的向量中,从而方便后续的相似度计算和检索。

传统的文本表示方法如词袋模型和TF-IDF方法存在着维度高、稀疏性和数据冗余等问题,而稠密表示则可以通过学习语义信息来减小向量的维度,提高表示的效果。

语义相似段落检索技术的核心思想是通过计算文本之间的相似度来实现检索。

在稠密表示下,我们可以使用余弦相似度来度量两个向量之间的相似程度。

具体而言,我们可以使用预训练的语义模型,如BERT或GPT,将输入的文本转换为对应的向量表示,然后计算查询文本与数据库中所有文本的相似度,最后根据相似度值进行排序,选取相似度最高的几个文本作为检索结果。

除了基于预训练模型的方法,还有一些基于词向量的方法可以用于语义相似段落检索。

例如,我们可以使用Word2Vec或GloVe等技术将文本转换为词向量表示,然后通过计算词向量的平均值或加权平均值来得到段落的向量表示。

接下来,我们可以使用余弦相似度或其他相似度度量方法来计算段落之间的相似度,从而实现检索。

语义相似段落检索技术在实际应用中有着广泛的应用。

例如,它可以用于搜索引擎中的相关性排序,帮助用户快速找到所需的文本信息。

此外,它还可以应用于自然语言处理任务中,如问答系统、文本摘要和机器翻译等,提高系统的性能和效果。

然而,语义相似段落检索技术也存在一些挑战和限制。

首先,语义表示模型的训练需要大量的数据和计算资源,对于小规模数据集或资源有限的环境可能不适用。

其次,模型的性能和效果往往依赖于训练数据的质量和多样性,不同领域或任务的数据差异可能导致模型的泛化能力不足。

此外,模型的可解释性也是一个重要的问题,如何理解模型学到的语义信息和进行错误分析是一个有待研究的方向。

《2024年应用语言学研究的多模态分析方法》范文

《应用语言学研究的多模态分析方法》篇一一、引言应用语言学作为一门跨学科的研究领域,旨在探讨语言在不同社会、文化、科技背景下的应用与变化。

随着信息技术的飞速发展,多模态交流逐渐成为人们日常生活和工作中不可或缺的一部分。

因此,应用语言学研究需要引入多模态分析方法,以更好地理解和解释语言在不同媒介中的运用和影响。

本文旨在探讨应用语言学研究中的多模态分析方法,并分析其在实际研究中的应用。

二、多模态分析方法的概述多模态分析方法是一种综合运用多种符号和媒介来分析和解释语言现象的方法。

它包括文本、图像、声音、动作等多种符号系统,以及社交媒体、网络平台等不同的媒介形式。

在应用语言学研究中,多模态分析方法可以更好地揭示语言在不同媒介中的运用和变化,从而为语言教学、语言规划、语言政策等提供有力支持。

三、多模态分析方法在应用语言学研究中的应用1. 语言教学多模态分析方法可以用于研究多媒体教学资源在语言教学中的作用。

例如,通过分析视频、音频、图片等多媒体资源在英语教学中的应用,可以探讨多媒体资源对学生语言学习的影响。

此外,多模态分析方法还可以用于研究不同文化背景下的语言教学策略,以帮助教师更好地适应不同学生的需求。

2. 语言规划与语言政策多模态分析方法可以用于研究语言规划与语言政策在不同社会、文化、科技背景下的实施效果。

例如,通过分析政府宣传片、广告等多媒体内容中的语言使用,可以了解政府在推广某种语言或方言时的策略和效果。

此外,多模态分析方法还可以用于研究不同社会群体对语言政策的态度和反应,以帮助政策制定者更好地制定和实施语言政策。

3. 跨文化交际多模态分析方法可以用于研究跨文化交际中的语言和非语言符号的运用。

例如,通过分析不同国家人们在社交媒体上的交流方式,可以探讨文化差异如何影响语言使用和非语言符号的解读。

此外,多模态分析方法还可以用于研究国际会议、商务谈判等跨文化交际活动中的语言和非语言符号的运用,以帮助人们更好地理解和适应不同文化背景下的交际需求。

多级网络编码方案

多级网络编码方案宋雪;周异辉;师军;吴振强【摘要】目前安全网络编码的研究有信息论安全和密码学安全两种方法。

信息论安全的编码方案中,中继节点编码主要是使用随机线性网络编码(RLNC)生成编码矩阵,但是此方法并不能保证生成的矩阵一定满秩,从而影响方案的解码率。

提出了一个多级网络编码(MLNC)方案,该方案通过在源端使用对角矩阵对消息进行编码,以降低编码复杂度;在中继节点,让入度大于等于2的节点作为编码节点,使用多级的网络编码使混淆效果更好,编码节点随机生成满秩的下三角矩阵和上三角矩阵,用它们的乘积作为编码矩阵,这样能保证编码矩阵满秩,接收节点可以成功解码。

Matlab仿真结果表明,MLNC编码矩阵达到k-安全概率优于RLNC 编码矩阵,并证明MLNC方案满足信息论安全。

%The current secure network coding has two methods.They are information-theoretic security and cryptography security. Among the encoding methods of information-theoretic security, the encoding scheme of the relay node uses the Random Linear Network Coding(RLNC)to generate the encoding matrix. But this method does not guarantee that the resulting matrix must be full rank and affects the decoding rate. This paper proposes a Multi-Level Network Coding(MLNC) scheme. The scheme uses the triangle matrix to encode source message. On the relay node, the node whose degree is greater than or equal to 2 is used as coding node, using multi-level network coding can make the message encode mix better. The encoding nodes generate the full rank lower triangular matrix and the full rank upper triangular matrix randomly. It uses their product as an encoding matrix.This scheme will ensure encoding matrix must be full rank. The receiving node can successfully decode the data. The result of the Matlab simulation shows that the probability of the coding matrix of MLNC satisfying k-secure can be better than RLNC. And the scheme of MLNC satisfies the theoretic security.【期刊名称】《计算机工程与应用》【年(卷),期】2015(000)018【总页数】5页(P94-98)【关键词】网络编码;对角矩阵;多级网络编码;k-安全【作者】宋雪;周异辉;师军;吴振强【作者单位】陕西师范大学计算机科学学院,西安 710062;陕西师范大学计算机科学学院,西安 710062;陕西师范大学计算机科学学院,西安 710062;陕西师范大学计算机科学学院,西安 710062【正文语种】中文【中图分类】TP3931 概述网络编码理论是2000 年由香港中文大学Rudolf Ahlswede[1]等基于网络信息流的概念首次提出的。

如何处理稀疏编码算法中的多模态数据

如何处理稀疏编码算法中的多模态数据多模态数据是指包含多种类型的数据,如图像、文本、语音等。

稀疏编码算法是一种用于处理多模态数据的方法,它可以通过学习数据的稀疏表示来提取数据中的有用信息。

本文将探讨如何处理稀疏编码算法中的多模态数据。

一、多模态数据的特点多模态数据具有以下几个特点:1.不同模态之间存在相关性:多模态数据中的不同模态之间通常存在一定的相关性,如图像中的物体和文本描述之间存在对应关系。

2.不同模态的数据维度不同:不同模态的数据可能具有不同的维度,如图像是二维的,而文本是一维的。

3.不同模态的数据表示方式不同:不同模态的数据可能采用不同的表示方式,如图像可以用像素值表示,而文本可以用词向量表示。

二、多模态稀疏编码算法多模态稀疏编码算法是一种将多模态数据映射到稀疏表示的方法,它可以通过学习数据的稀疏表示来提取数据中的有用信息。

多模态稀疏编码算法的主要步骤包括:1.数据预处理:对多模态数据进行预处理,如图像可以进行降维处理,文本可以进行分词处理。

2.模态特征提取:对每个模态的数据进行特征提取,如图像可以使用卷积神经网络提取特征,文本可以使用词袋模型提取特征。

3.模态融合:将不同模态的特征进行融合,可以使用加权求和的方式,也可以使用多模态融合网络进行融合。

4.稀疏编码:对融合后的特征进行稀疏编码,可以使用L1范数正则化来促使稀疏性。

5.重构:通过稀疏编码得到的稀疏表示,可以重构原始的多模态数据。

三、处理多模态数据的挑战在处理多模态数据时,会面临一些挑战:1.模态不平衡:不同模态的数据可能存在不平衡问题,如图像数据较多,而文本数据较少。

这会导致模态融合和稀疏编码过程中的不平衡问题。

2.模态相关性建模:多模态数据中的不同模态之间存在相关性,如何准确地建模这种相关性是一个挑战。

3.数据噪声:多模态数据中可能存在噪声,如图像中的遮挡、文本中的拼写错误等。

如何处理这些噪声对稀疏编码算法的性能有很大影响。

涌现的定义及其辨析

涌现的定义及其辨析涌现是复杂系统的根本特征,通常认为,它是指复杂系统在自组织过程中新结构、新属性的出现。

[13]按照目前公认的看法,“复杂性科学本质上是关于涌现的一门学科,同时研究如何确认涌现现象的基本法则。

”[12]遗憾的是,目前对涌现还没有一个明确的定义。

目前关于涌现的研究,多数基于实验观察或者数值模拟的描述性工作,缺乏真正具有可操作性的观点和方法[14],这就使得人们在判断某个现象是否为涌现现象时难以界定;另外一个方面,由于缺乏真正的理论深度,也难以获得更深刻的理解。

涌现的思想可以追溯到亚里士多德,那句著名的“整体不同于其部分之和”已经触及“涌现”的核心。

目前,将涌现理解为“因局部组分之间的交互而产生系统全局行为”[31]或“缘起于微观的宏观效应”[37],而这些宏观全局行为或特征是微观组分所不具有的,只能通过整体体现出来[38]。

对于涌现概念,这种描述还是比较模糊的。

对涌现的更具体的认识主要有两种思路,其中,第一种思路基于层级和可预测性的思路。

基于层级的思路是指,从高层特征与低层特征之间的关系来界定涌现性;基于可预测性的思路是指,站在系统演化的时间轴上,从系统特征的可预测性角度,来理解涌现。

Fromm [39]就是从层次之间不同的反馈类型和因果关系,将涌现分为4类,并解释了它们的可预测性:简单或有名无实的涌现(simple/nominal emergence)、弱涌现(weak emergence)、多重涌现(multiple emergence)、强涌现(strong emergence),如图3。

类型I 只包含前馈,而无反馈;类型II只包含简单的正反馈或负反馈;类型III中存在多个反馈循环,同时还包含了学习和适应;类型IV 则表现为,在高层组织中出现了涌现结构或产生了体现不可还原性新性质的复杂性。

这里的前馈和反馈主要指的是因果关系。

同时,Fromm还指出,“如果用可预测性取代反馈作为主要分类标准,会得到相同的分类结果。

多模态语言处理技术的研究与应用

多模态语言处理技术的研究与应用多模态语言处理技术是一种综合利用视觉、听觉和语言等多种信息模态的技术,旨在实现对复杂信息的全面理解和处理。

随着人工智能和机器学习等技术的不断发展,多模态语言处理技术在自然语言理解、情感分析、机器翻译等领域展现出了巨大的潜力。

本文将探讨多模态语言处理技术的研究进展、应用场景以及面临的挑战,并对未来发展进行展望。

一、多模态语言处理技术概述多模态语言处理是一种将视觉和听觉等非文本信息与文本信息进行融合分析和理解的方法。

通过综合利用不同信息来源,可以更全面地理解人类交流行为,并且能够有效地应对复杂场景下存在的歧义性和不确定性。

常见的多模态数据包括图像、视频、音频以及与之相关联的文本数据。

二、多模态语言处理技术研究进展1. 多模态情感分析情感分析是指通过对文本或其他媒体内容进行分析,识别出其中所包含的情感信息。

多模态情感分析通过结合文本、图像、音频等多种信息模态,可以更准确地识别出情感倾向。

例如,通过分析用户在社交媒体上发布的文本和照片,可以更准确地了解用户的情感状态和心理健康状况。

2. 多模态机器翻译机器翻译是指利用计算机技术将一种语言自动转化为另一种语言。

多模态机器翻译将图像、视频等非文本信息与文本信息进行融合,可以更准确地理解源语言的含义,并生成更自然流畅的目标语言。

例如,在图像描述生成任务中,通过结合图像和文本信息进行训练,可以生成与图像内容相关的自然语言描述。

3. 多模态问答系统多模态问答系统是指通过综合利用视觉和听觉等非文本信息,并结合自然语言处理技术,实现对用户提问进行回答的系统。

这种系统可以处理复杂问题,并根据问题所涉及到的不同媒体内容提供相关答案。

例如,在视频问答任务中,系统能够根据视频内容回答用户提出的问题。

三、多模态语言处理技术应用场景1. 智能助理多模态语言处理技术可以应用于智能助理中,实现对用户语音和图像输入的理解和处理。

通过综合利用多种信息模态,智能助理可以更好地理解用户的需求,并提供更准确和个性化的服务。

混合词汇特征和lda的语义相关度计算方法

混合词汇特征和LDA的语义相关度计算方法一、背景简介在自然语言处理和文本挖掘领域,语义相关度计算是一个重要而复杂的问题。

传统的基于词袋模型的相似度计算往往无法很好地捕捉词语之间的语义关联,因此引入了深度学习和主题模型等方法来提高语义相关度的计算精度。

混合词汇特征和LDA的语义相关度计算方法就是其中之一,它结合了词汇特征和主题模型的优势,能够更准确地评估文本之间的语义相关性。

二、混合词汇特征和LDA的基本原理混合词汇特征和LDA的语义相关度计算方法的基本原理是将词汇特征和LDA主题模型结合起来,利用它们各自的优势来计算文本之间的语义相关度。

通过词袋模型和词嵌入模型等方法提取文本的词汇特征,将文本表示为向量;利用LDA主题模型来挖掘文本的主题分布,将文本表示为主题分布的向量;将词汇特征向量和主题分布向量进行融合,通过一定的计算方法得到文本之间的语义相关度。

三、混合词汇特征和LDA的计算方法1. 词汇特征提取词汇特征提取是语义相关度计算的基础,包括词袋模型、TF-IDF、词嵌入等方法。

在混合词汇特征和LDA的计算方法中,可以使用词袋模型将文本表示为词频向量,也可以利用词嵌入模型将词语转换为稠密的向量表示。

这些词汇特征能够捕捉文本中词语的语义信息,为后续的语义相关度计算奠定了基础。

2. LDA主题模型LDA主题模型是一种用于挖掘文本主题分布的概率生成模型,能够将文本表示为主题分布的向量。

在混合词汇特征和LDA的计算方法中,利用LDA主题模型可以发现文本隐含的语义主题,从而更好地表征文本的语义信息。

3. 混合计算方法混合词汇特征和LDA的计算方法采用了词汇特征向量和主题分布向量的融合策略,常见的计算方法包括余弦相似度、欧氏距离等。

这些方法能够将词汇特征和主题信息进行有效地整合,得到文本之间的语义相关度。

四、实际应用与案例分析混合词汇特征和LDA的语义相关度计算方法在文本相似度计算、信息检索、推荐系统等领域有着广泛的应用。

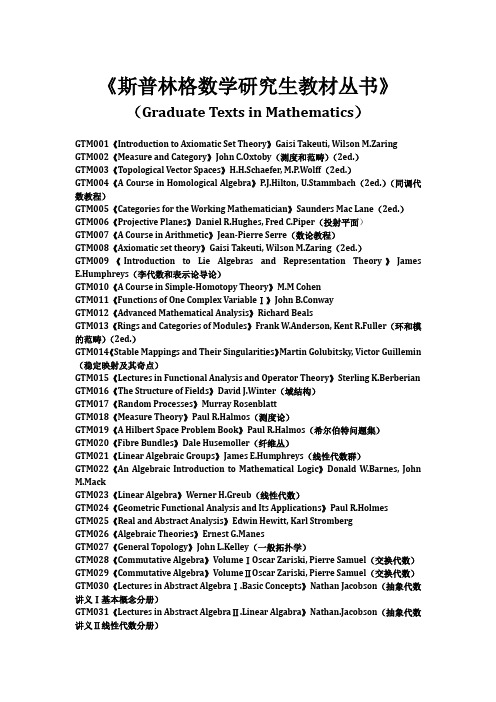

斯普林格数学研究生教材丛书

《斯普林格数学研究生教材丛书》(Graduate Texts in Mathematics)GTM001《Introduction to Axiomatic Set Theory》Gaisi Takeuti, Wilson M.Zaring GTM002《Measure and Category》John C.Oxtoby(测度和范畴)(2ed.)GTM003《Topological Vector Spaces》H.H.Schaefer, M.P.Wolff(2ed.)GTM004《A Course in Homological Algebra》P.J.Hilton, U.Stammbach(2ed.)(同调代数教程)GTM005《Categories for the Working Mathematician》Saunders Mac Lane(2ed.)GTM006《Projective Planes》Daniel R.Hughes, Fred C.Piper(投射平面)GTM007《A Course in Arithmetic》Jean-Pierre Serre(数论教程)GTM008《Axiomatic set theory》Gaisi Takeuti, Wilson M.Zaring(2ed.)GTM009《Introduction to Lie Algebras and Representation Theory》James E.Humphreys(李代数和表示论导论)GTM010《A Course in Simple-Homotopy Theory》M.M CohenGTM011《Functions of One Complex VariableⅠ》John B.ConwayGTM012《Advanced Mathematical Analysis》Richard BealsGTM013《Rings and Categories of Modules》Frank W.Anderson, Kent R.Fuller(环和模的范畴)(2ed.)GTM014《Stable Mappings and Their Singularities》Martin Golubitsky, Victor Guillemin (稳定映射及其奇点)GTM015《Lectures in Functional Analysis and Operator Theory》Sterling K.Berberian GTM016《The Structure of Fields》David J.Winter(域结构)GTM017《Random Processes》Murray RosenblattGTM018《Measure Theory》Paul R.Halmos(测度论)GTM019《A Hilbert Space Problem Book》Paul R.Halmos(希尔伯特问题集)GTM020《Fibre Bundles》Dale Husemoller(纤维丛)GTM021《Linear Algebraic Groups》James E.Humphreys(线性代数群)GTM022《An Algebraic Introduction to Mathematical Logic》Donald W.Barnes, John M.MackGTM023《Linear Algebra》Werner H.Greub(线性代数)GTM024《Geometric Functional Analysis and Its Applications》Paul R.HolmesGTM025《Real and Abstract Analysis》Edwin Hewitt, Karl StrombergGTM026《Algebraic Theories》Ernest G.ManesGTM027《General Topology》John L.Kelley(一般拓扑学)GTM028《Commutative Algebra》VolumeⅠOscar Zariski, Pierre Samuel(交换代数)GTM029《Commutative Algebra》VolumeⅡOscar Zariski, Pierre Samuel(交换代数)GTM030《Lectures in Abstract AlgebraⅠ.Basic Concepts》Nathan Jacobson(抽象代数讲义Ⅰ基本概念分册)GTM031《Lectures in Abstract AlgebraⅡ.Linear Algabra》Nathan.Jacobson(抽象代数讲义Ⅱ线性代数分册)GTM032《Lectures in Abstract AlgebraⅢ.Theory of Fields and Galois Theory》Nathan.Jacobson(抽象代数讲义Ⅲ域和伽罗瓦理论)GTM033《Differential Topology》Morris W.Hirsch(微分拓扑)GTM034《Principles of Random Walk》Frank Spitzer(2ed.)(随机游动原理)GTM035《Several Complex Variables and Banach Algebras》Herbert Alexander, John Wermer(多复变和Banach代数)GTM036《Linear Topological Spaces》John L.Kelley, Isaac Namioka(线性拓扑空间)GTM037《Mathematical Logic》J.Donald Monk(数理逻辑)GTM038《Several Complex Variables》H.Grauert, K.FritzsheGTM039《An Invitation to C*-Algebras》William Arveson(C*-代数引论)GTM040《Denumerable Markov Chains》John G.Kemeny, urie Snell, Anthony W.KnappGTM041《Modular Functions and Dirichlet Series in Number Theory》Tom M.Apostol (数论中的模函数和Dirichlet序列)GTM042《Linear Representations of Finite Groups》Jean-Pierre Serre(有限群的线性表示)GTM043《Rings of Continuous Functions》Leonard Gillman, Meyer JerisonGTM044《Elementary Algebraic Geometry》Keith KendigGTM045《Probability TheoryⅠ》M.Loève(概率论Ⅰ)(4ed.)GTM046《Probability TheoryⅡ》M.Loève(概率论Ⅱ)(4ed.)GTM047《Geometric Topology in Dimensions 2 and 3》Edwin E.MoiseGTM048《General Relativity for Mathematicians》Rainer.K.Sachs, H.Wu伍鸿熙(为数学家写的广义相对论)GTM049《Linear Geometry》K.W.Gruenberg, A.J.Weir(2ed.)GTM050《Fermat's Last Theorem》Harold M.EdwardsGTM051《A Course in Differential Geometry》Wilhelm Klingenberg(微分几何教程)GTM052《Algebraic Geometry》Robin Hartshorne(代数几何)GTM053《A Course in Mathematical Logic for Mathematicians》Yu.I.Manin(2ed.)GTM054《Combinatorics with Emphasis on the Theory of Graphs》Jack E.Graver, Mark E.WatkinsGTM055《Introduction to Operator TheoryⅠ》Arlen Brown, Carl PearcyGTM056《Algebraic Topology:An Introduction》W.S.MasseyGTM057《Introduction to Knot Theory》Richard.H.Crowell, Ralph.H.FoxGTM058《p-adic Numbers, p-adic Analysis, and Zeta-Functions》Neal Koblitz(p-adic 数、p-adic分析和Z函数)GTM059《Cyclotomic Fields》Serge LangGTM060《Mathematical Methods of Classical Mechanics》V.I.Arnold(经典力学的数学方法)(2ed.)GTM061《Elements of Homotopy Theory》George W.Whitehead(同论论基础)GTM062《Fundamentals of the Theory of Groups》M.I.Kargapolov, Ju.I.Merzljakov GTM063《Modern Graph Theory》Béla BollobásGTM064《Fourier Series:A Modern Introduction》VolumeⅠ(2ed.)R.E.Edwards(傅里叶级数)GTM065《Differential Analysis on Complex Manifolds》Raymond O.Wells, Jr.(3ed.)GTM066《Introduction to Affine Group Schemes》William C.Waterhouse(仿射群概型引论)GTM067《Local Fields》Jean-Pierre Serre(局部域)GTM069《Cyclotomic FieldsⅠandⅡ》Serge LangGTM070《Singular Homology Theory》William S.MasseyGTM071《Riemann Surfaces》Herschel M.Farkas, Irwin Kra(黎曼曲面)GTM072《Classical Topology and Combinatorial Group Theory》John Stillwell(经典拓扑和组合群论)GTM073《Algebra》Thomas W.Hungerford(代数)GTM074《Multiplicative Number Theory》Harold Davenport(乘法数论)(3ed.)GTM075《Basic Theory of Algebraic Groups and Lie Algebras》G.P.HochschildGTM076《Algebraic Geometry:An Introduction to Birational Geometry of Algebraic Varieties》Shigeru IitakaGTM077《Lectures on the Theory of Algebraic Numbers》Erich HeckeGTM078《A Course in Universal Algebra》Stanley Burris, H.P.Sankappanavar(泛代数教程)GTM079《An Introduction to Ergodic Theory》Peter Walters(遍历性理论引论)GTM080《A Course in_the Theory of Groups》Derek J.S.RobinsonGTM081《Lectures on Riemann Surfaces》Otto ForsterGTM082《Differential Forms in Algebraic Topology》Raoul Bott, Loring W.Tu(代数拓扑中的微分形式)GTM083《Introduction to Cyclotomic Fields》Lawrence C.Washington(割圆域引论)GTM084《A Classical Introduction to Modern Number Theory》Kenneth Ireland, Michael Rosen(现代数论经典引论)GTM085《Fourier Series A Modern Introduction》Volume 1(2ed.)R.E.Edwards GTM086《Introduction to Coding Theory》J.H.van Lint(3ed .)GTM087《Cohomology of Groups》Kenneth S.Brown(上同调群)GTM088《Associative Algebras》Richard S.PierceGTM089《Introduction to Algebraic and Abelian Functions》Serge Lang(代数和交换函数引论)GTM090《An Introduction to Convex Polytopes》Ame BrondstedGTM091《The Geometry of Discrete Groups》Alan F.BeardonGTM092《Sequences and Series in BanachSpaces》Joseph DiestelGTM093《Modern Geometry-Methods and Applications》(PartⅠ.The of geometry Surfaces Transformation Groups and Fields)B.A.Dubrovin, A.T.Fomenko, S.P.Novikov (现代几何学方法和应用)GTM094《Foundations of Differentiable Manifolds and Lie Groups》Frank W.Warner(可微流形和李群基础)GTM095《Probability》A.N.Shiryaev(2ed.)GTM096《A Course in Functional Analysis》John B.Conway(泛函分析教程)GTM097《Introduction to Elliptic Curves and Modular Forms》Neal Koblitz(椭圆曲线和模形式引论)GTM098《Representations of Compact Lie Groups》Theodor Breöcker, Tammo tom DieckGTM099《Finite Reflection Groups》L.C.Grove, C.T.Benson(2ed.)GTM100《Harmonic Analysis on Semigroups》Christensen Berg, Jens Peter Reus Christensen, Paul ResselGTM101《Galois Theory》Harold M.Edwards(伽罗瓦理论)GTM102《Lie Groups, Lie Algebras, and Their Representation》V.S.Varadarajan(李群、李代数及其表示)GTM103《Complex Analysis》Serge LangGTM104《Modern Geometry-Methods and Applications》(PartⅡ.Geometry and Topology of Manifolds)B.A.Dubrovin, A.T.Fomenko, S.P.Novikov(现代几何学方法和应用)GTM105《SL₂ (R)》Serge Lang(SL₂ (R)群)GTM106《The Arithmetic of Elliptic Curves》Joseph H.Silverman(椭圆曲线的算术理论)GTM107《Applications of Lie Groups to Differential Equations》Peter J.Olver(李群在微分方程中的应用)GTM108《Holomorphic Functions and Integral Representations in Several Complex Variables》R.Michael RangeGTM109《Univalent Functions and Teichmueller Spaces》Lehto OlliGTM110《Algebraic Number Theory》Serge Lang(代数数论)GTM111《Elliptic Curves》Dale Husemoeller(椭圆曲线)GTM112《Elliptic Functions》Serge Lang(椭圆函数)GTM113《Brownian Motion and Stochastic Calculus》Ioannis Karatzas, Steven E.Shreve (布朗运动和随机计算)GTM114《A Course in Number Theory and Cryptography》Neal Koblitz(数论和密码学教程)GTM115《Differential Geometry:Manifolds, Curves, and Surfaces》M.Berger, B.Gostiaux GTM116《Measure and Integral》Volume1 John L.Kelley, T.P.SrinivasanGTM117《Algebraic Groups and Class Fields》Jean-Pierre Serre(代数群和类域)GTM118《Analysis Now》Gert K.Pedersen(现代分析)GTM119《An introduction to Algebraic Topology》Jossph J.Rotman(代数拓扑导论)GTM120《Weakly Differentiable Functions》William P.Ziemer(弱可微函数)GTM121《Cyclotomic Fields》Serge LangGTM122《Theory of Complex Functions》Reinhold RemmertGTM123《Numbers》H.-D.Ebbinghaus, H.Hermes, F.Hirzebruch, M.Koecher, K.Mainzer, J.Neukirch, A.Prestel, R.Remmert(2ed.)GTM124《Modern Geometry-Methods and Applications》(PartⅢ.Introduction to Homology Theory)B.A.Dubrovin, A.T.Fomenko, S.P.Novikov(现代几何学方法和应用)GTM125《Complex Variables:An introduction》Garlos A.Berenstein, Roger Gay GTM126《Linear Algebraic Groups》Armand Borel(线性代数群)GTM127《A Basic Course in Algebraic Topology》William S.Massey(代数拓扑基础教程)GTM128《Partial Differential Equations》Jeffrey RauchGTM129《Representation Theory:A First Course》William Fulton, Joe HarrisGTM130《Tensor Geometry》C.T.J.Dodson, T.Poston(张量几何)GTM131《A First Course in Noncommutative Rings》m(非交换环初级教程)GTM132《Iteration of Rational Functions:Complex Analytic Dynamical Systems》AlanF.Beardon(有理函数的迭代:复解析动力系统)GTM133《Algebraic Geometry:A First Course》Joe Harris(代数几何)GTM134《Coding and Information Theory》Steven RomanGTM135《Advanced Linear Algebra》Steven RomanGTM136《Algebra:An Approach via Module Theory》William A.Adkins, Steven H.WeintraubGTM137《Harmonic Function Theory》Sheldon Axler, Paul Bourdon, Wade Ramey(调和函数理论)GTM138《A Course in Computational Algebraic Number Theory》Henri Cohen(计算代数数论教程)GTM139《Topology and Geometry》Glen E.BredonGTM140《Optima and Equilibria:An Introduction to Nonlinear Analysis》Jean-Pierre AubinGTM141《A Computational Approach to Commutative Algebra》Gröbner Bases, Thomas Becker, Volker Weispfenning, Heinz KredelGTM142《Real and Functional Analysis》Serge Lang(3ed.)GTM143《Measure Theory》J.L.DoobGTM144《Noncommutative Algebra》Benson Farb, R.Keith DennisGTM145《Homology Theory:An Introduction to Algebraic Topology》James W.Vick(同调论:代数拓扑简介)GTM146《Computability:A Mathematical Sketchbook》Douglas S.BridgesGTM147《Algebraic K-Theory and Its Applications》Jonathan Rosenberg(代数K理论及其应用)GTM148《An Introduction to the Theory of Groups》Joseph J.Rotman(群论入门)GTM149《Foundations of Hyperbolic Manifolds》John G.Ratcliffe(双曲流形基础)GTM150《Commutative Algebra with a view toward Algebraic Geometry》David EisenbudGTM151《Advanced Topics in the Arithmetic of Elliptic Curves》Joseph H.Silverman(椭圆曲线的算术高级选题)GTM152《Lectures on Polytopes》Günter M.ZieglerGTM153《Algebraic Topology:A First Course》William Fulton(代数拓扑)GTM154《An introduction to Analysis》Arlen Brown, Carl PearcyGTM155《Quantum Groups》Christian Kassel(量子群)GTM156《Classical Descriptive Set Theory》Alexander S.KechrisGTM157《Integration and Probability》Paul MalliavinGTM158《Field theory》Steven Roman(2ed.)GTM159《Functions of One Complex Variable VolⅡ》John B.ConwayGTM160《Differential and Riemannian Manifolds》Serge Lang(微分流形和黎曼流形)GTM161《Polynomials and Polynomial Inequalities》Peter Borwein, Tamás Erdélyi(多项式和多项式不等式)GTM162《Groups and Representations》J.L.Alperin, Rowen B.Bell(群及其表示)GTM163《Permutation Groups》John D.Dixon, Brian Mortime rGTM164《Additive Number Theory:The Classical Bases》Melvyn B.NathansonGTM165《Additive Number Theory:Inverse Problems and the Geometry of Sumsets》Melvyn B.NathansonGTM166《Differential Geometry:Cartan's Generalization of Klein's Erlangen Program》R.W.SharpeGTM167《Field and Galois Theory》Patrick MorandiGTM168《Combinatorial Convexity and Algebraic Geometry》Günter Ewald(组合凸面体和代数几何)GTM169《Matrix Analysis》Rajendra BhatiaGTM170《Sheaf Theory》Glen E.Bredon(2ed.)GTM171《Riemannian Geometry》Peter Petersen(黎曼几何)GTM172《Classical Topics in Complex Function Theory》Reinhold RemmertGTM173《Graph Theory》Reinhard Diestel(图论)(3ed.)GTM174《Foundations of Real and Abstract Analysis》Douglas S.Bridges(实分析和抽象分析基础)GTM175《An Introduction to Knot Theory》W.B.Raymond LickorishGTM176《Riemannian Manifolds:An Introduction to Curvature》John M.LeeGTM177《Analytic Number Theory》Donald J.Newman(解析数论)GTM178《Nonsmooth Analysis and Control Theory》F.H.clarke, Yu.S.Ledyaev, R.J.Stern, P.R.Wolenski(非光滑分析和控制论)GTM179《Banach Algebra Techniques in Operator Theory》Ronald G.Douglas(2ed.)GTM180《A Course on Borel Sets》S.M.Srivastava(Borel 集教程)GTM181《Numerical Analysis》Rainer KressGTM182《Ordinary Differential Equations》Wolfgang WalterGTM183《An introduction to Banach Spaces》Robert E.MegginsonGTM184《Modern Graph Theory》Béla Bollobás(现代图论)GTM185《Using Algebraic Geomety》David A.Cox, John Little, Donal O’Shea(应用代数几何)GTM186《Fourier Analysis on Number Fields》Dinakar Ramakrishnan, Robert J.Valenza GTM187《Moduli of Curves》Joe Harris, Ian Morrison(曲线模)GTM188《Lectures on the Hyperreals:An Introduction to Nonstandard Analysis》Robert GoldblattGTM189《Lectures on Modules and Rings》m(模和环讲义)GTM190《Problems in Algebraic Number Theory》M.Ram Murty, Jody Esmonde(代数数论中的问题)GTM191《Fundamentals of Differential Geometry》Serge Lang(微分几何基础)GTM192《Elements of Functional Analysis》Francis Hirsch, Gilles LacombeGTM193《Advanced Topics in Computational Number Theory》Henri CohenGTM194《One-Parameter Semigroups for Linear Evolution Equations》Klaus-Jochen Engel, Rainer Nagel(线性发展方程的单参数半群)GTM195《Elementary Methods in Number Theory》Melvyn B.Nathanson(数论中的基本方法)GTM196《Basic Homological Algebra》M.Scott OsborneGTM197《The Geometry of Schemes》David Eisenbud, Joe HarrisGTM198《A Course in p-adic Analysis》Alain M.RobertGTM199《Theory of Bergman Spaces》Hakan Hedenmalm, Boris Korenblum, Kehe Zhu(Bergman空间理论)GTM200《An Introduction to Riemann-Finsler Geometry》D.Bao, S.-S.Chern, Z.Shen GTM201《Diophantine Geometry An Introduction》Marc Hindry, Joseph H.Silverman GTM202《Introduction to Topological Manifolds》John M.LeeGTM203《The Symmetric Group》Bruce E.SaganGTM204《Galois Theory》Jean-Pierre EscofierGTM205《Rational Homotopy Theory》Yves Félix, Stephen Halperin, Jean-Claude Thomas(有理同伦论)GTM206《Problems in Analytic Number Theory》M.Ram MurtyGTM207《Algebraic Graph Theory》Chris Godsil, Gordon Royle(代数图论)GTM208《Analysis for Applied Mathematics》Ward CheneyGTM209《A Short Course on Spectral Theory》William Arveson(谱理论简明教程)GTM210《Number Theory in Function Fields》Michael RosenGTM211《Algebra》Serge Lang(代数)GTM212《Lectures on Discrete Geometry》Jiri Matousek(离散几何讲义)GTM213《From Holomorphic Functions to Complex Manifolds》Klaus Fritzsche, Hans Grauert(从正则函数到复流形)GTM214《Partial Differential Equations》Jüergen Jost(偏微分方程)GTM215《Algebraic Functions and Projective Curves》David M.Goldschmidt(代数函数和投影曲线)GTM216《Matrices:Theory and Applications》Denis Serre(矩阵:理论及应用)GTM217《Model Theory An Introduction》David Marker(模型论引论)GTM218《Introduction to Smooth Manifolds》John M.Lee(光滑流形引论)GTM219《The Arithmetic of Hyperbolic 3-Manifolds》Colin Maclachlan, Alan W.Reid GTM220《Smooth Manifolds and Observables》Jet Nestruev(光滑流形和直观)GTM221《Convex Polytopes》Branko GrüenbaumGTM222《Lie Groups, Lie Algebras, and Representations》Brian C.Hall(李群、李代数和表示)GTM223《Fourier Analysis and its Applications》Anders Vretblad(傅立叶分析及其应用)GTM224《Metric Structures in Differential Geometry》Gerard Walschap(微分几何中的度量结构)GTM225《Lie Groups》Daniel Bump(李群)GTM226《Spaces of Holomorphic Functions in the Unit Ball》Kehe Zhu(单位球内的全纯函数空间)GTM227《Combinatorial Commutative Algebra》Ezra Miller, Bernd Sturmfels(组合交换代数)GTM228《A First Course in Modular Forms》Fred Diamond, Jerry Shurman(模形式初级教程)GTM229《The Geometry of Syzygies》David Eisenbud(合冲几何)GTM230《An Introduction to Markov Processes》Daniel W.Stroock(马尔可夫过程引论)GTM231《Combinatorics of Coxeter Groups》Anders Bjröner, Francesco Brenti(Coxeter 群的组合学)GTM232《An Introduction to Number Theory》Graham Everest, Thomas Ward(数论入门)GTM233《Topics in Banach Space Theory》Fenando Albiac, Nigel J.Kalton(Banach空间理论选题)GTM234《Analysis and Probability:Wavelets, Signals, Fractals》Palle E.T.Jorgensen(分析与概率)GTM235《Compact Lie Groups》Mark R.Sepanski(紧致李群)GTM236《Bounded Analytic Functions》John B.Garnett(有界解析函数)GTM237《An Introduction to Operators on the Hardy-Hilbert Space》Rubén A.Martínez-Avendano, Peter Rosenthal(哈代-希尔伯特空间算子引论)GTM238《A Course in Enumeration》Martin Aigner(枚举教程)GTM239《Number Theory:VolumeⅠTools and Diophantine Equations》Henri Cohen GTM240《Number Theory:VolumeⅡAnalytic and Modern Tools》Henri Cohen GTM241《The Arithmetic of Dynamical Systems》Joseph H.SilvermanGTM242《Abstract Algebra》Pierre Antoine Grillet(抽象代数)GTM243《Topological Methods in Group Theory》Ross GeogheganGTM244《Graph Theory》J.A.Bondy, U.S.R.MurtyGTM245《Complex Analysis:In the Spirit of Lipman Bers》Jane P.Gilman, Irwin Kra, Rubi E.RodriguezGTM246《A Course in Commutative Banach Algebras》Eberhard KaniuthGTM247《Braid Groups》Christian Kassel, Vladimir TuraevGTM248《Buildings Theory and Applications》Peter Abramenko, Kenneth S.Brown GTM249《Classical Fourier Analysis》Loukas Grafakos(经典傅里叶分析)GTM250《Modern Fourier Analysis》Loukas Grafakos(现代傅里叶分析)GTM251《The Finite Simple Groups》Robert A.WilsonGTM252《Distributions and Operators》Gerd GrubbGTM253《Elementary Functional Analysis》Barbara D.MacCluerGTM254《Algebraic Function Fields and Codes》Henning StichtenothGTM255《Symmetry Representations and Invariants》Roe Goodman, Nolan R.Wallach GTM256《A Course in Commutative Algebra》Kemper GregorGTM257《Deformation Theory》Robin HartshorneGTM258《Foundation of Optimization》Osman GülerGTM259《Ergodic Theory:with a view towards Number Theory》Manfred Einsiedler, Thomas WardGTM260《Monomial Ideals》Jurgen Herzog, Takayuki HibiGTM261《Probability and Stochastics》Erhan CinlarGTM262《Essentials of Integration Theory for Analysis》Daniel W.StroockGTM263《Analysis on Fock Spaces》Kehe ZhuGTM264《Functional Analysis, Calculus of Variations and Optimal Control》Francis ClarkeGTM265《Unbounded Self-adjoint Operatorson Hilbert Space》Konrad Schmüdgen GTM266《Calculus Without Derivatives》Jean-Paul PenotGTM267《Quantum Theory for Mathematicians》Brian C.HallGTM268《Geometric Analysis of the Bergman Kernel and Metric》Steven G.Krantz GTM269《Locally Convex Spaces》M.Scott Osborne。

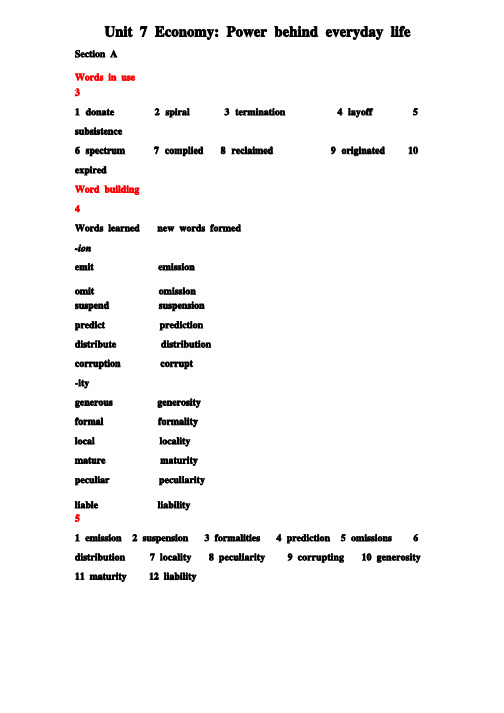

新视野大学英语(第三版)读写教程第三册Unit7课后练习答案

Unit 7 Economy: Power behind everyday life Section AWords in use31 donate2 spiral3 termination4 layoff5 subsistence6 spectrum7 complied8 reclaimed9 originated 10 expiredWord building4Words learned new words formed-ionemit emissionomit omissionsuspend suspensionpredict predictiondistribute distributioncorruption corrupt-itygenerous generosityformal formalitylocal localitymature maturitypeculiar peculiarityliable liability51 emission2 suspension3 formalities4 prediction5 omissions6 distribution7 locality8 peculiarity9 corrupting 10 generosity 11 maturity 12 liabilityBanked cloze61 E2 J3 B4 H5 A6 K7 G8 I9 C 10 NExpressions in use71 put down2 wind up3 scrape together4 on the verge of5 in all likelihood6 deteriorate into7 are in a position8 gave way to Translation9世界贸易组织成立于1995年1月1日,旨在监督和促进国际贸易自由化。

该组织负责对成员国之间的贸易进行调控,为贸易协定的谈判和形成制定框架,并提供争端解决机制以敦促成员国遵守世贸协定,而这些协定皆为各成员国政府的代表所签署并获得其立法机构的批准。

一种改进的基于区域增长的稠密立体匹配算法

i ma g e s a r e u s e d t o r e d u c e t h e i mp a c t o f v a r y i n g i l l u mi n a t i o n i n l o c a l a r e a i n d i f f e r e n t p e r s p e c t i v e s v i e w s , t h e n t h e

陈友庆 , 袁 建 英 r,李柏 林 ,王 琼

( 1 . 西南交通大学 机械 工程 学院 , 四川 成都 6 1 0 0 3 1 ;

2 . 昆 明学 院 自动 控 制 与 机 械 工 程 学 院 , 云 南 昆明 6 5 0 2 1 4 )

摘

要 :针对传统 区域增 长稠密匹配算法存在 匹配效率低 、 误 差大的问题 , 提出一种 改进的区域增 长稠密

匹配算法 。首先 以 B R I S K特征 点作 为区域增长的种子点 , 采用纹理图像降低 不同视角下 图像局部 光照不 均对 匹配的影响 , 再通过方 向性 约束与极线距离约束准则减小 自适应搜索窗 范围。实 验表 明 : 所提 出的算 法较 传统算法有更高的 匹配精度 、 更大的匹配范 围。 关键词 :区域增长 ; 纹 理图像 ; B R I S K特征 ; 极线; 立体 匹配 中图分类号 :T P 3 9 1 . 4 1 文献标识码 :A 文章编 号 :1 0 0 0 - 9 7 8 7 ( 2 0 1 3 ) 1 O 01 - 1 8 - 0 3

A ▲ n I ● m pr o v e d ' I c 1 I e ns e s t ・ e r e o m a t ・ l c hl ● ng a l g or i ● t ・ hm l

基于“松弛尺度”的短语翻译对抽取方法

Be ig 1 0 8 i n 0 0 0,Chn ;2 No i Re e rh Ce tr ej g 1 0 1 j ia . ka s ac n e ,B in 0 0 3,Chn ) i ia

Ab t a t s r c :T he p a et a s a i i xta i nsi e o heke e hni e n t hr s r n l ton pare r cto son ft y t c qu si he Phr e b s d St ts ia a hi as — a e a i tc lM c ne T r nsa i . Oc S hr s xta ton m e h a iy de e a l ton h’ p a e e r c i t od he v l p nds n w or lg o d a inm e s。 S l he phr s p is w hih nt O on y t a e a r c a e f ly c s s e ih t r u l on it ntw t he wor l d ai gnm e sar xta t d. Thi p pe op e et nt e e r c e s a rpr os sa m hod ofp as i xta ton hr e pa re r c i wih a fe bl c l. Thi e ho a x r c ho e phr s lg t lxi e s ae sm t d c n e t a tt s a e ai nm e s whih O c S m e h a nt c h’ t od c n noto ane bt i d. T h e fe bl c l s b s d on t wo f a ur s: P0 S a c i ar nf m a i lxi es a ei a e he t e t e nd diton y i or ton. 0 ur e e i e s ha e hown ha ur xp rm nt v s t t o meh t od out e f r sO c S m e ho i iia l p r o m h’ t d sgn fc nty. Ke ywor s:ariii li elge e;m a hi r s a i d tfca nt li nc c ne tan l ton;phr s a re r to a e p i xtac in; sats ia a hi r t itc lm c ne tansa in; fe i l to l x— b】 e 】 es a e

语言学量化研究案例

语言学量化研究案例一、研究目的和背景语言学量化研究旨在通过利用数据分析和统计方法来研究语言现象,揭示语言规律和变异。

下面列举一些语言学量化研究的案例来说明这一点。

二、词频研究词频研究是语言学量化研究中的一个重要方向。

通过统计大量文本中各个词汇的出现频率,可以揭示不同词汇的使用偏好和语义变化。

例如,研究发现现代英语中“you”一词的使用频率远高于“thou”,反映了人们使用“you”来表示第二人称的偏好。

三、语言变体研究语言变体研究是研究不同语言使用者之间的语言差异的一种方法。

通过收集和分析不同地区、社会群体或年龄组别的语言数据,可以发现他们在发音、词汇和语法等方面的差异。

例如,研究表明美国南方口音中的元音发音与其他地区有所不同。

四、语言演化研究语言演化研究关注语言的历史变迁和发展。

通过比较不同时期的语言数据,可以追踪语言的演化轨迹。

例如,研究发现古英语中的词缀“-eth”在现代英语中已经消失,反映了语法变化和语言演化的过程。

五、情感分析研究情感分析研究旨在通过分析语言表达来揭示情感状态和情绪变化。

通过对大量文本数据进行情感标注和分类,可以了解不同话题、时间和地点下人们的情感倾向。

例如,研究发现社交媒体上人们在自然灾害发生时的情感表达更加负面。

六、语义关系研究语义关系研究通过分析语言中词汇之间的关联性来揭示语义结构和语义变化。

通过构建词汇网络或语义模型,可以发现不同词汇之间的关系,并研究它们在不同语境下的语义变化。

例如,研究发现“苹果”一词在不同语境下既可以表示水果,也可以表示科技公司。

七、语言障碍研究语言障碍研究旨在通过分析患者的语言表达和语言处理能力来揭示语言障碍的原因和机制。

通过对不同语言障碍患者的语言数据进行分析,可以了解他们在语音、词汇和语法等方面的问题。

例如,研究发现阅读障碍患者在词汇处理和语法理解方面存在困难。

八、语言教育研究语言教育研究旨在通过分析学习者的语言学习过程和成果来改进语言教育方法和教材。

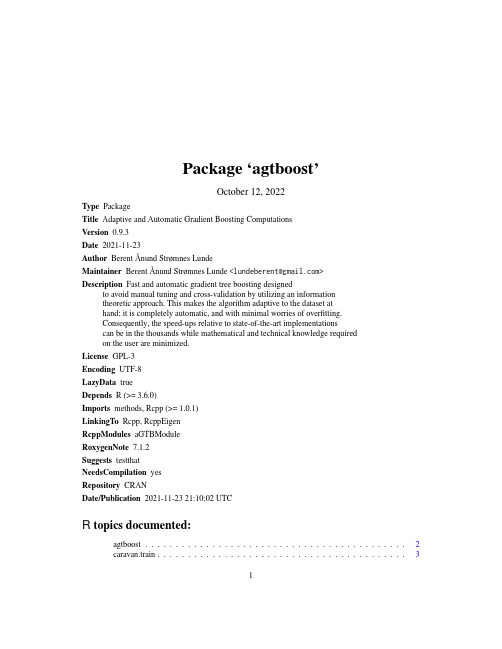

agtboost软件包说明说明书

Package‘agtboost’October12,2022Type PackageTitle Adaptive and Automatic Gradient Boosting ComputationsVersion0.9.3Date2021-11-23Author BerentÅnund Strømnes LundeMaintainer BerentÅnund Strømnes Lunde<*********************>Description Fast and automatic gradient tree boosting designedto avoid manual tuning and cross-validation by utilizing an informationtheoretic approach.This makes the algorithm adaptive to the dataset athand;it is completely automatic,and with minimal worries of overfitting.Consequently,the speed-ups relative to state-of-the-art implementationscan be in the thousands while mathematical and technical knowledge requiredon the user are minimized.License GPL-3Encoding UTF-8LazyData trueDepends R(>=3.6.0)Imports methods,Rcpp(>=1.0.1)LinkingTo Rcpp,RcppEigenRcppModules aGTBModuleRoxygenNote7.1.2Suggests testthatNeedsCompilation yesRepository CRANDate/Publication2021-11-2321:10:02UTCR topics documented:agtboost (2)caravan.train (3)12agtboostplexity (4)gbt.convergence (5)gbt.importance (6)gbt.ksval (7)gbt.load (8)gbt.save (8)gbt.train (9)predict.Rcpp_ENSEMBLE (11)predict.Rcpp_GBT_COUNT_AUTO (13)Index14 agtboost Adaptive and automatic gradient boosting computations.DescriptionAdaptive and Automatic Gradient Boosting ComputationsDetailsagtboost is a lightning fast gradient boosting library designed to avoid manual tuning and cross-validation by utilizing an information theoretic approach.This makes the algorithm adaptive to the dataset at hand;it is completely automatic,and with minimal worries of overfitting.Consequently, the speed-ups relative to state-of-the-art implementations are in the thousands while mathematical and technical knowledge required on the user are minimized.Important functions:•gbt.train:function for training an agtboost ensemble•predict.Rcpp_ENSEMBLE:function for predicting from an agtboost ensemble See individual function documentation for usage.Author(s)BerentÅnund Strømnes Lundecaravan.train3 caravan.train The Insurance Company(TIC)BenchmarkDescriptioncaravan.train and caravan.test both contain a design matrix with85columns and a response vector.The train set consists of70%of the data,with4075rows.The test set consists of the remaining30%with1747rows.The following references the documentation within the ISLR package:The original data contains5822real customer records.Each record consists of86vari-ables,containing sociodemographic data(variables1-43)and product ownership(variables44-86).The sociodemographic data is derived from zip codes.All customers living in areas with the same zip code have the same sociodemographic attributes.Variable86(Purchase)indicates whether the customer purchased a caravan insurance policy.Further information on the individual variables can be obtained at http://www.liacs.nl/~putten/library/cc2000/data.htmlUsagecaravan.train;caravan.testFormatLists with a design matrix x and response ySourceThe data was originally supplied by Sentient Machine Research and was used in the CoIL Challenge 2000.ReferencesP.van der Putten and M.van Someren(eds).CoIL Challenge2000:The Insurance Company Case.Published by Sentient Machine Research,Amsterdam.Also a Leiden Institute of Advanced Com-puter Science Technical Report2000-09.June22,2000.See http://www.liacs.nl/~putten/library/cc2000/ P.van der Putten and M.van Someren.A Bias-Variance Analysis of a Real World Learning Prob-lem:The CoIL Challenge2000.Machine Learning,October2004,vol.57,iss.1-2,pp.177-195, Kluwer Academic PublishersJames,G.,Witten,D.,Hastie,T.,and Tibshirani,R.(2013)An Introduction to Statistical Learning with applications in R,https://trevorhastie.github.io/ISLR/,Springer-Verlag,New YorkExamplessummary(caravan.train)summary(caravan.test)plexity plexity Return complexity of model in terms of hyperparameters.Descriptionplexity creates a list of hyperparameters from a modelUsageplexity(model,type)Argumentsmodel object or pointer to object of class ENSEMBLEtype currently supports"xgboost"or"lightgbm"DetailsReturns the complexity of model in terms of hyperparameters associated to model type.Valuelist with type hyperparameters.Examplesset.seed(123)library(agtboost)n<-10000xtr<-as.matrix(runif(n,0,4))ytr<-rnorm(n,xtr,1)xte<-as.matrix(runif(n,0,4))yte<-rnorm(n,xte,1)model<-gbt.train(ytr,xtr,learning_rate=0.1)plexity(model,type="xgboost")plexity(model,type="lightgbm")##See demo(topic="gbt-complexity",package="agtboost")gbt.convergence5 gbt.convergence Convergence of agtboost model.Descriptiongbt.convergence calculates loss of data over iterations in the modelUsagegbt.convergence(object,y,x)Argumentsobject Object or pointer to object of class ENSEMBLEy response vectorx design matrix for training.Must be of type matrix.DetailsComputes the loss on supplied data at each boosting iterations of the model passed as object.This may be used to visually test for overfitting on test data,or the converce,to check for underfitting or non-convergence.Valuevector with$K+1$elements with loss at each boosting iteration and at thefirst constant predictionExamples##Gaussian regression:x_tr<-as.matrix(runif(500,0,4))y_tr<-rnorm(500,x_tr,1)x_te<-as.matrix(runif(500,0,4))y_te<-rnorm(500,x_te,1)mod<-gbt.train(y_tr,x_tr)convergence<-gbt.convergence(mod,y_te,x_te)which.min(convergence)#Should be fairly similar to boosting iterations+1mod$get_num_trees()+1#num_trees does not include initial prediction6gbt.importance gbt.importance Importance of features in a model.Descriptiongbt.importance creates a data.frame of feature importance in a modelUsagegbt.importance(feature_names,object)Argumentsfeature_names character vector of feature namesobject object or pointer to object of class ENSEMBLEDetailsSums up"expected reduction"in generalization loss(scaled using learning_rate)at each node for each tree in the model,and attributes it to the feature the node is split on.Returns result in terms of percents.Valuedata.frame with percentwise reduction in loss of total attributed to each feature.Examples##Load datadata(caravan.train,package="agtboost")train<-caravan.trainmod<-gbt.train(train$y,train$x,loss_function="logloss",verbose=10)feature_names<-colnames(train$x)imp<-gbt.importance(feature_names,mod)impgbt.ksval7 gbt.ksval Kolmogorov-Smirnov validation of modelDescriptiongbt.ksval transforms observations to U(0,1)if the model is correct and performs a Kolmogorov-Smirnov test for uniformity.Usagegbt.ksval(object,y,x)Argumentsobject Object or pointer to object of class ENSEMBLEy Observations to be testedx design matrix for training.Must be of type matrix.DetailsModel validation of model passed as object using observations y.Assuming the loss is a negative log-likelihood and thus a probabilistic model,the transformationu=F Y(y;x,θ)∼U(0,1),is usually valid.One parameter,µ=g−1(f(x)),is given by the model.Remaining parameters are estimated globally over feature space,assuming they are constant.This then allow the above trans-formation to be exploited,so that the Kolmogorov-Smirnov test for uniformity can be performed.If the response is a count model(poisson or negbinom),the transformationu i=F Y(y i−1;x,θ)+Uf Y(y i,x,θ),U∼U(0,1)is used to obtain a continuous transformation to the unit interval,which,if the model is correct,will give standard uniform random variables.ValueKolmogorov-Smirnov test of modelExamples##Gaussian regression:x_tr<-as.matrix(runif(500,0,4))y_tr<-rnorm(500,x_tr,1)x_te<-as.matrix(runif(500,0,4))y_te<-rnorm(500,x_te,1)mod<-gbt.train(y_tr,x_tr)gbt.ksval(mod,y_te,x_te)8gbt.save gbt.load Load an aGTBoost ModelDescriptiongbt.load is an interface for loading a agtboost model.Usagegbt.load(file)Argumentsfile Validfile-path to a stored aGTBoost modelDetailsThe load function for agtboost.Loades a GTB model from a txtfile.ValueTrained aGTBoost model.See Alsogbt.savegbt.save Save an aGTBoost ModelDescriptiongbt.save is an interface for storing a agtboost model.Usagegbt.save(gbt_model,file)Argumentsgbt_model Model object or pointer to object of class ENSEMBLEfile Validfile-pathDetailsThe model-storage function for agtboost.Saves a GTB model as a txtfile.Might be retrieved using gbt.loadValueTxtfile that can be loaded using gbt.load.See Alsogbt.loadgbt.train aGTBoost Training.Descriptiongbt.train is an interface for training an agtboost model.Usagegbt.train(y,x,learning_rate=0.01,loss_function="mse",nrounds=50000,verbose=0,gsub_compare,algorithm="global_subset",previous_pred=NULL,weights=NULL,force_continued_learning=FALSE,offset=NULL,...)Argumentsy response vector for training.Must correspond to the design matrix x.x design matrix for training.Must be of type matrix.learning_rate control the learning rate:scale the contribution of each tree by a factor of0< learning_rate<1when it is added to the current approximation.Lower valuefor learning_rate implies an increase in the number of boosting iterations:low learning_rate value means model more robust to overfitting but slower tocompute.Default:0.01loss_function specify the learning objective(loss function).Only pre-specified loss functions are currently supported.•mse regression with squared error loss(Default).•logloss logistic regression for binary classification,output score beforelogistic transformation.•poisson Poisson regression for count data using a log-link,output scorebefore natural transformation.•gamma::neginv gamma regression using the canonical negative inverselink.Scaling independent of y.•gamma::log gamma regression using the log-link.Constant informationparametrisation.•negbinom Negative binomial regression for count data with overdispersion.Log-link.•count::auto Chooses automatically between Poisson or negative binomialregression.nrounds a just-in-case max number of boosting iterations.Default:50000verbose Enable boosting tracing information at i-th iteration?Default:0.gsub_compare Deprecated.Boolean:Global-subset comparisons.FALSE means standard GTB, TRUE compare subset-splits with global splits(next root split).Default:TRUE.algorithm specify the algorithm used for gradient tree boosting.•vanilla ordinary gradient tree boosting.Trees are optimized as if theywere the last tree.•global_subset function-change to target maximized reduction in general-ization loss for individual datapointsprevious_pred prediction vector for training.Boosted training given predictions from another model.weights weights vector for scaling contributions of individual observations.Default NULL (the unit vector).force_continued_learningBoolean:FALSE(default)stops at information stopping criterion,TRUE stops atnround iterations.offset add offset to the model g(mu)=offset+F(x)....additional parameters passed.•if loss_function is’negbinom’,dispersion must be provided in...DetailsThese are the training functions for an agtboost.Explain the philosophy and the algorithm and a little mathgbt.train learn trees with adaptive complexity given by an information criterion,until the same (but scaled)information criterion tells the algorithm to stop.The data used for training at each boosting iteration stems from a second order Taylor expansion to the loss function,evaluated at predictions given by ensemble at the previous boosting iteration.ValueAn object of class ENSEMBLE with some or all of the following elements:•handle a handle(pointer)to the agtboost model in memory.•initialPred afield containing the initial prediction of the ensemble.•set_param function for changing the parameters of the ensemble.•train function for re-training(or from scratch)the ensemble directly on vector y and design matrix x.•predict function for predicting observations given a design matrix•predict2function as above,but takes a parameter max number of boosting ensemble itera-tions.•estimate_generalization_loss function for calculating the(approximate)optimism of the ensemble.•get_num_trees function returning the number of trees in the ensemble.ReferencesBerentÅnund Strømnes Lunde,Tore Selland Kleppe and Hans Julius Skaug,"An Information Criterion for Automatic Gradient Tree Boosting",2020,https:///abs/2008.05926 See Alsopredict.Rcpp_ENSEMBLEExamples##A simple gtb.train example with linear regression:x<-runif(500,0,4)y<-rnorm(500,x,1)x.test<-runif(500,0,4)y.test<-rnorm(500,x.test,1)mod<-gbt.train(y,as.matrix(x))y.pred<-predict(mod,as.matrix(x.test))plot(x.test,y.test)points(x.test,y.pred,col="red")predict.Rcpp_ENSEMBLE aGTBoost PredictionDescriptionpredict is an interface for predicting from a agtboost model.Usage##S3method for class Rcpp_ENSEMBLEpredict(object,newdata,...)Argumentsobject Object or pointer to object of class ENSEMBLEnewdata Design matrix of data to be predicted.Type matrix...additional parameters passed.Currently not in use.DetailsThe prediction function for ing the generic predict function in R is also possible, using the same arguments.ValueFor regression or binary classification,it returns a vector of length nrows(newdata).ReferencesBerentÅnund Strømnes Lunde,Tore Selland Kleppe and Hans Julius Skaug,"An Information Criterion for Automatic Gradient Tree Boosting",2020,https:///abs/2008.05926 See Alsogbt.trainExamples##A simple gtb.train example with linear regression:x<-runif(500,0,4)y<-rnorm(500,x,1)x.test<-runif(500,0,4)y.test<-rnorm(500,x.test,1)mod<-gbt.train(y,as.matrix(x))##predict is overloadedy.pred<-predict(mod,as.matrix(x.test))plot(x.test,y.test)points(x.test,y.pred,col="red")predict.Rcpp_GBT_COUNT_AUTO13 predict.Rcpp_GBT_COUNT_AUTOaGTBoost Count-Regression Auto PredictionDescriptionpredict is an interface for predicting from a agtboost model.Usage##S3method for class Rcpp_GBT_COUNT_AUTOpredict(object,newdata,...)Argumentsobject Object or pointer to object of class GBT_ZI_MIXnewdata Design matrix of data to be predicted.Type matrix...additional parameters passed.Currently not in use.DetailsThe prediction function for ing the generic predict function in R is also possible, using the same arguments.ValueFor regression or binary classification,it returns a vector of length nrows(newdata).ReferencesBerentÅnund Strømnes Lunde,Tore Selland Kleppe and Hans Julius Skaug,"An Information Criterion for Automatic Gradient Tree Boosting",2020,https:///abs/2008.05926See Alsogbt.trainExamples##A simple gtb.train example with linear regression:##Random generation of zero-inflated poisson2+2Index∗datasetscaravan.train,3agtboost,2caravan.test(caravan.train),3caravan.train,3plexity,4gbt.convergence,5gbt.importance,6gbt.ksval,7gbt.load,8,9gbt.save,8,8gbt.train,2,9,12,13predict.Rcpp_ENSEMBLE,2,11,11predict.Rcpp_GBT_COUNT_AUTO,1314。

利用词汇分布相似度的中文词汇语义倾向性计算

利用词汇分布相似度的中文词汇语义倾向性计算赵煜;蔡皖东;樊娜;李慧贤【期刊名称】《西安交通大学学报》【年(卷),期】2009(043)006【摘要】针对现有中文词汇语义倾向性计算方法存在较少考虑深层语义影响因素的问题,提出了一种利用词汇分布相似度的中文语义倾向性计算方法.该方法分2个步骤完成:①利用依存句法分析和统计工具获取词汇在语料库中的分布相似度,并综合知网(HowNet)和汉语连词特征信息优化语料库统计结果,计算中文词汇间的语义相似度;②采用无向带权图划分的聚类方法来实现中文词汇语义倾向推断.由于获取最优聚类结果是一个NP难问题,所以采用贪心算法求解近似最优值.通过在自建的语料库上进行测试,并与利用语料库统计信息、利用HowNet等2个词汇语义倾向性计算系统进行比较,结果是所提方法的准确率达到了80%,表明在提高中文词汇语义倾向性计算的准确性方面是可行、有效的.【总页数】5页(P33-37)【作者】赵煜;蔡皖东;樊娜;李慧贤【作者单位】西北工业大学计算机学院,710072,西安;西北工业大学计算机学院,710072,西安;西北工业大学计算机学院,710072,西安;西北工业大学计算机学院,710072,西安【正文语种】中文【中图分类】TP39【相关文献】1.基于语义相似度计算的词汇语义自动分类系统 [J], 李杰;曹谢东;余飞2.改进的基于知网词汇语义褒贬倾向性计算 [J], 杨昱昺;吴贤伟3.中文网络评论观点词汇语义褒贬倾向性判断 [J], 李华;储荷兰;高旻4.一种基于搭配的中文词汇语义相似度计算方法 [J], 王石;曹存根;裴亚军;夏飞5.极性相似度计算在词汇倾向性识别中的应用 [J], 宋乐;何婷婷;王倩;闻彬因版权原因,仅展示原文概要,查看原文内容请购买。

基于完全偏好序信息的严格双边匹配方法

0 引 言

在实际生活中, 众多问题都涉及到某群体 中 的主体需要 与另一个群体 中的主体相 匹配的情 形, 例如婚 姻 匹配 问题 _ l J 、 电子 中介 中商 品买卖 问题 。 J 、 人力 资 源管 理 中员 工 与 岗位 匹配 问 题_ 4 J 、 大学招生录取问题 一 ’ 等. 随着社会经济

匹配 问题 的研 究 受 到 了学 者 们 的广 泛 关 注 . T e o 等从 最优 欺骗 策 略的角 度研究 了男女 婚姻 匹配 问

有利于提高主体对其匹配主体的满意度. 因此 , 针

对 双边 匹 配 问题 的研 究具 有 重要 的理 论意 义和 实

视角出发 , 试 图采用经济博弈论 、 实验经济学等相 关 理论 与方 法获得 匹 配结果 ¨ 卜 .

通常, 在 双边 匹配 过程 中 , 需 要考 虑 双边 主体

际价值 .

第1 7卷第 1期

2 0 1 4年 1月

管

理

科

学

学

报

V0 1 . 1 7 No . 1

J OUR NAL OF MANAG EME NT S CI ENC E S I N C HI NA

J a n . 2 01 4

基 于 完全 偏 好序 信 息 的严格 双 边 匹配 方 法①

确提出了双边匹配的概念 。 。 . 双边匹配是指如何 匹配两个不同有 限集合 中的主体 , 尽量使每个主 体匹配到满意的另一边主体. 双边匹配一般是通 过中介来进行¨ , 这里中介通常是指撮合双边主

体 进行 匹配 的 个人 、 机构 或 决 策 系统 . 此后 , 许 多 学 者将 双边 匹 配 问题 进 行 扩 展 , 针对 不 同 的实 际

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Thanks for listening

Xin Liu

Relative Attributes

Author: Devi Parikh, Kristen Grauman Speaker:刘昕

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Methods—Overview

Methods-Assumption

This approach stems from the observation that ranked Doppelganger lists are similar for similar people(Even under different imaging conditions)

Conclusion(2/2)

We expect that a great deal of improvement can be achieved by using this powerful comparison method as an additional feature in a complete verification or recognition pipeline where it can add the robustness that is required for face recognition across large pose ranges. Furthermore, we are currently exploring the use of ranked lists of identities in other classification domains.

Authors(4/4)

Serge J. Belongie:

Background: Professor Computer Science and Engineering University of California, San Diego

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Speaker:刘昕

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

To the best of our knowledge, we have shown the first verification results for face-similarity measures under truly unconstrained expression, illumination and pose, including full profile, on both Multi-PIE and FacePix.

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Methods-Set up Face database

Using MultiPIE as a Face Library:

Methods-Finding Alike

Calculating the list:

Methods-Compare List

Calculating similarity:

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Motivation

Learn a new distance metric D’

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

The advantages of the ranked Doppelganger lists become apparent when the two probe images depict faces in very different poses. Our method does not require explicit training and is able to cope with large pose ranges.

Outline

Authors Paper பைடு நூலகம்nformation Abstract Motivation Methods Experiment Conclusion

Abstract(1/2)

Face recognition approaches have traditionally focused on direct comparisons between aligned images, e.g. using pixel values or local image features. Such comparisons become prohibitively difficult when comparing faces across extreme differences in pose, illumination and expression.

To this end we describe an image of a face by an ordered list of identities from a Library. The order of the list is determined by the similarity of the Library images to the probe image. The lists act as a signature for each face image: similarity between face images is determined via the similarity of the signatures.

We show improved performance over state of the art face-similarity measures based on local features, such as FPLBP, especially across large pose variations on FacePix and Multi-PIE. On LFW we show improved performance in comparison with measures like SIFT (on fiducials), LBP, FPLBP and Gabor (C1).

Experiment on LFW(1/2)

LFW实验结果

Experiment on LFW(2/2)

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Conclusion(1/2)

Pose, Illumination and Expression Invariant Pairwise Face-Similarity Measure via Doppelganger List Comparison

Author: Florian Schroff, Tali Treibitz, David Kriegman, Serge Belongie

Outline

Authors Paper Information Abstract Motivation Methods Experiment Conclusion

Experiment on FacePix(across pose)

Experiment- Verification Across Large Variations of Pose

Authors(1/4)

Florian Schroff:

Authors(2/4)

Tali Treibitz:

Background: Ph.D. student in the Dept. of Electrical Engineering, Technion

Publication: 三篇CVPR,一篇PAMI

Experiment- on Multi-PIE

The classification performance using ten fold cross-validation is 76:6% ± 2.0(both FPLBP and SSIM on direct image comparison perform near chance). To the best of our knowledge these are the first results reported across all pose, illumination and expression conditions on Multi-PIE.