并行程序设计导论第三节PPT

并行计算概述PPT课件

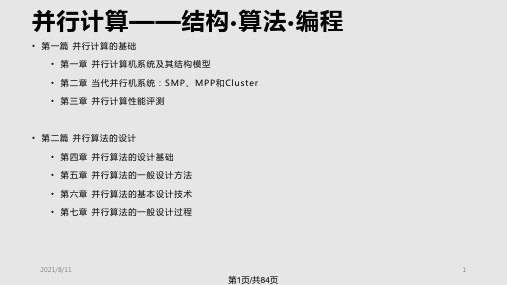

• 第一篇 并行计算的基础 • 第一章 并行计算机系统及其结构模型 • 第二章 当代并行机系统:SMP、MPP和Cluster • 第三章 并行计算性能评测

• 第二篇 并行算法的设计 • 第四章 并行算法的设计基础 • 第五章 并行算法的一般设计方法 • 第六章 并行算法的基本设计技术 • 第七章 并行算法的一盘

桥

系统 I

节点 2

节点 N

SAN(e.g.Myrinet)

I/O总 线 ,系 统 总 线

接口

LAN(e.g.以 太 网 ,FDDI)

系统 II

2021/8/11

15

第15页/共84页

网络性能指标

• 节点度(Node Degree):射入或射出一个节点的边数。在单向网络中, 入射和出射边之和称为节点度。

2

N / 2向)

4

2( N 1)

N

4

N 1

2N

4

2 N/2

2N

3 2loN g 1

1

非

N 1

是

N

非

2(N N)

非

2N

是

2N

非

N 1

星形

2

N N 1

超立方

N 2n

n

n

非 N / 2

是

N/2

N 1 nN/ 2

立方环

Nk2k

3

2k1k/2 N/(2k)

是

3N/ 2

2021/8/11

24

第24页/共84页

动态互连网络 (1)

1100

1110 1101

1111

0010

0011

1010

2024年度并行程序设计导论PPT课件

根据实际需求,选择其他 适合并行计算的实验项目 。

30

并行程序设计实验指导与注意事项

理解并行计算原理

在进行实验前,需要充分了解并行计算的原理和 基本概念。

调试与性能分析

学会使用调试器和性能分析工具,对并行程序进 行调试和性能分析。

ABCD

2024/2/2

熟悉并行编程模型

掌握常见的并行编程模型,如OpenMP、MPI 等,并根据实验需求选择合适的模型。

访问延迟和带宽瓶颈。

通信优化

减少不必要的通信开销,采用高效的 通信协议和算法,优化消息传递和数 据传输过程。

算法并行化优化

针对特定算法进行并行化优化,如矩 阵运算、排序算法等,提高算法的并 行执行效率。

21

并行程序调试与优化案例

案例一

案例二

案例三

案例四

MPI并行程序调试与优 化,通过TotalView工 具对MPI程序进行调试 ,发现并解决死锁、消 息不同步等问题,结合 性能分析工具找到性能 瓶颈并进行优化。

19

并行程序性能分析工具

Gprof

GNU的性能分析工具,可以分析 程序的函数调用关系、执行时间

、CPU占用率等性能指标。

NVIDIA Nsight

一款开源的内存管理和线程错误 检测工具,也可用于性能分析,

如Cachegrind可以模拟CPU缓 存进行性能分析。

2024/2/2

Valgrind

Intel推出的性能分析工具,可以 对并行程序进行深度性能分析, 包括热点分析、内存访问模式分 析等。

软件环境

安装并行程序设计所需的操作系统、 编译器、调试器和性能分析工具。

2024/2/2

29

并行计算机体系结构PPT课件

17

二、Amdahl定律

*基本思想:优化某部件所获得的系统性能的改善程度,取 决于该部件被使用的频率,或所占总执行时间的比例

S T0

p

Te

1

(1

fe

)

fe re

*举例:某功能处理时间占系统时间的40%,将其处理速度加

快10倍后,整个系统性能提高多少? Sp

10

解—已知fe=0.4,re=10,利

23

*特点:吞吐率与I/O软硬件组织方式及OS有很大关系; 能够反映软硬件系统对多任务的响应能力

*提高吞吐率方法: 流水化--使多个作业流水处理; 并行处理--给每个PE分配多个作业,各PE相互协调

3、利用率 *定义:利用率=持续性能÷峰值性能 *特点:不直接表示系统性能,与前两种指标有密切关系; 对系统性能优化及结构改进起着至关重要的作用!

A系统 B系统

得到性能可扩放性曲线 1

n

影响因素—结构、处理器数、问题规模、存储系统等

25

二、性能评价与比较

1、评价技术

(1)分析技术 *思路:在一定假设条件下,计算机系统参数与性能指标间

存在着某种函数关系,按其工作负载的驱动条件列出方程,用 数学方法求解后评价

*发展:从脱离实际的假设发展到近似求解 近似求解算法—聚合法、均值分析法、扩散法等

2

二、参考教材

1、并行计算机体系结构,陈国良等著,高等教育出版社, ISBN 7-04—11558-1,2002.9

2、并行计算机体系结构,David E.Culler等著,李晓明等译, 机械工业出版社,ISBN 7-111-07888-8,2002.10

3、可扩展并行计算—技术、结构与编程,黄铠、徐志伟著,陆 鑫达等译,机械工业出版社,2000.5

并行程序设计导论(2024)

编译时通过任务划分和调度实现负载平衡。

3

动态负载均衡

运行时监测负载并根据需要迁移任务。

2024/1/29

18

负载均衡与性能评估指标

01

性能评估指标

用于衡量并行算法和程序性能的标 准。

效率

加速比与处理器数量的比值,衡量 并行化的效果。

03

2024/1/29

02

加速比

并行执行相对于串行执行的速度提 升。

并行程序设计导论

2024/1/29

1

目录

2024/1/29

• 并行计算概述 • 并行计算硬件基础 • 并行程序设计语言与模型 • 并行算法设计策略与优化方法 • 典型并行算法案例剖析 • 并行程序设计实践与挑战

2

01

并行计算概述

2024/1/29

3

并行计算定义与特点

定义

并行计算是指同时使用多种计算资源解决 计算问题的过程,其主要目的是快速解决 大型且复杂的计算问题。

可扩展性

随着处理器数量的增加,性能提升 的能力。

04

19

05

典型并行算法案例剖析

2024/1/29

20

矩阵运算并行化方法

2024/1/29

分块矩阵并行计算

01

将大型矩阵分割成若干个小块,分配给不同的处理单元进行并

行计算,最后再将结果合并。

矩阵向量乘法并行化

02

利用矩阵和向量的乘法运算可以并行化的特点,将矩阵按行或

20世纪90年代至今,随着计算机网络 、分布式系统、GPU等技术的飞速发 展,并行计算进入了一个全新的时代 。

中期阶段

20世纪60年代至80年代,随着计算机

硬件技术的进步,如多处理器系统、

并行程序设计导论.ppt

SPMD类型的MPI程序 myprog.c

#include “mpi.h” int foo int i; {…} main(argc,argv) int argc; char *argv[ ]; { int i, tmp, sum=0, group_size,my_rank,N; MPI_Init(&argc,&argv); 消息标志 MPI_Comm_size(MPI_COMM_WORLD,&group_size); MPI_Comm_rank(MPI_COMM_WORLD,&my_rank); if (my_rank==0) { printf(“Enter N:”); scanf(“%d”,&N); for (i=1;i<group_size;i++) MPI_send(&N,1,MPI_INT,i,i,MPI_COMM_WORLD); 目的进程 for (i=my_rank;i<N;i=i+group_size ) sum=sum+foo(i); for (i=1;i<group_size;i++) { MPI_Recv(&tmp,1,MPI_INT,i,i,MPI_COMM_WORLD,&status); sum=sum+tmp; } 源进程 结构指针 printf(“\n The result=%d”,sum); } else { MPI_Recv(&N,1,MPI_INT,0,i,MPI_COMM_WORLD,&status); for (i=my_rank;i<N;i=i+group_size ) sum=sum+foo(i); MPI_Send(&sum,1,MPI_INT,0,i,MPI_COMM_WORLD); } MPI_Finalize(); }

(2024年)并行程序设计导论课件

03

并行策略调整

04

根据程序特点和性能瓶颈,选择 合适的并行策略,如任务并行、 数据并行或混合并行等。

案例分析

结合具体案例,分析性能瓶颈的 来源,并给出相应的优化策略和 实现方法。例如,针对矩阵乘法 运算的性能优化,可以采用分块 矩阵乘法算法,并结合OpenMP 并行框架实现并行计算。

2024/3/26

GPU拥有成千上万的核心,能够实现大规模并行处理 ,加速计算密集型任务。

高带宽内存访问

GPU采用高速显存,提供高带宽内存访问,使得数据 传输更加高效。

优化的浮点运算

GPU针对单精度和双精度浮点运算进行优化,适用于 科学计算、图形渲染等领域。

2024/3/26

25

CUDA编程模型简介

CUDA编程模型概述

并行矩阵运算

03

如矩阵乘法、矩阵转置等,通过并行处理矩阵中的元素来实现

高性能计算。

10

03

并行编程模型与语言

2024/3/26

11

共享内存编程模型

原理

多个线程或进程共享同一块内存空间,通过 读写共享变量实现通信和同步。

缺点

存在数据一致性和同步问题,需要采用锁等 机制进行控制。

2024/3/26

优点

日志分析

记录程序运行过程中的关键事件和时间戳,通过分析日志找出性 能瓶颈。

可视化工具

利用可视化工具,如性能图表、火焰图等,直观地展示程序性能 瓶颈。

30

优化策略与案例分析

01 算法优化

针对程序中计算密集型的部分 ,采用更高效的算法或并行算 法进行优化。

02 数据结构优化

调整数据结构以适应并行计算 的需求,减少数据访问冲突和 通信开销。

程序设计导论(讲解如何画算法流程图)ppt课件

一个判断框有两个出口 一个选择结构只有一个出口

(3) 结构内的每一部分都有机会被执行到。也就 是说,对每一个框来说,都应当有一条从入口 到出口的路径通过它

(4) 结构内不存在“死循环”

精选课件

40

由三种基本结构派生出来的结构:

B

A

根据表达式p 的值进行选择

end

(算法开始) (算法结束)

精选课件

24

(5)用计算机语言表示算法

要完成一项工作,包括设计算法和实现算 法两个部分。

设计算法的目的是为了实现算法。 不仅要考虑如何设计一个算法,也要考虑

如何实现一个算法。

精选课件

25

例:(求5!)用C语言表示。

#include <stdio.h> int main( ) { int i,t;

2 3 …1

2 1 ..1

0

高位

精选课件

15

3.算法的特性

一个有效算法应该具有以下特点:

(1) 有穷性。一个算法应包含有限的操作 步骤,而不能是无限的。

(2) 确定性。算法中的每一个步骤都应当 是确定的,而不应当是含糊的、模棱两 可的。

精选课件

16

一个有效算法应该具有以下特点:

(3) 有零个或多个输入。所谓输入是指在执 行算法时需要从外界取得必要的信息。

精选课件

30

开始 输入n 2i

n%ir

r=0 Y N

i+1i

N

i> n

Y 输出n是素数

输出n是素数

结束

精选课件

31

通过以上例子可以看出流程图是表示算法 的较好的工具

2024版并行程序设计精品公开课件

ABCD

读者写者问题

通过读写锁、信号量等机制实现读者和写者之间 的同步与通信,并避免读写冲突。

进程池管理

通过信号量、进程间通信等机制实现进程池的管 理,包括进程的创建、销毁、调度等。

04 并行编程模型与框架介绍

OpenMP编程模型

加速比

同一任务在单处理器系统和并行 处理器系统上执行消耗的时间的 比率。

效率

加速比与处理器个数的比值,反 映了并行系统的利用率。

可扩展性

并行程序在不同规模的并行系统 上执行时,能否保持相近的加速

比和效率。

02 并行算法设计原则与策略

设计原则

分治原则

将大问题分解为小问题,独立求解后合并结 果。

减少通信

05 并行程序性能优化技术探 讨

性能优化策略概述

识别并行性

将可并行执行的任务划分出来,提高程序执行效率。

减少通信开销

合理设计并行算法和数据结构,降低进程间通信开销。

利用局部性原理

优化数据访问模式,提高数据访问的局部性,减少缓存失效。

迭代优化

通过反复测试、分析和调整,找到性能瓶颈并进行优化。

负载均衡技术实现方法

开启编译器优化选项

使用编译器提供的优化选项,如 O2、O3等,自动进行代码优化。

矢量化优化

利用编译器提供的矢量化优化功能, 将循环中的标量操作转换为矢量操 作。

考虑目标平台特性

针对目标平台的特性选择合适的编 译器和优化选项。

谨慎使用编译器自动并行化

编译器自动并行化可能引入额外的 开销和复杂性,需谨慎使用。

THANKS FOR WATCHING

MPI基础PPT课件

2020/9/28

10

4.2 6个基本函数组成的MPI子集

▪ 消息发送:MPI_Send函数用于发送一个消息到目标进 程。

▪ int MPI_Send(void *buf, int count, MPI_Datatype dataytpe, int dest, int tag, MPI_Comm comm)

现代密码学理论与实践之五

2020/9/28

13

4.3 MPI消息(数据类型)

▪ MPI的消息类型分为两种:预定义类型和派生数据类型 (Derived Data Type)

▪ 预定义数据类型:MPI支持异构计算(Heterogeneous Computing),它指在不同计算机系统上运行程序,每 台计算可能有不同生产厂商,不同操作系统。

现代密码学理论与实践之五

2020/9/28

6

4.2 6个基本函数组成的MPI子集

#include "mpi.h" /*MPI头函数,提供了MPI函数和数据类型定义*/ int main( int argc, char** argv ) { int rank, size, tag=1; int senddata,recvdata; MPI_Status status; MPI_Init(&argc, &argv); /*MPI的初始化函数*/ MPI_Comm_rank(MPI_COMM_WORLD, &rank); /*该进程编号*/ MPI_Comm_size(MPI_COMM_WORLD, &size); /*总进程数目*/

现代密码学理论与实践之五

2020/9/28

7

4.2 6个基本函数组成的MPI子集

《并行程序设计导论》第一章PPT

Copyright © 2010, Elsevier Inc. All rights Reserved

15

Approaches to the serial problem

Rewrite serial programs so that they’re parallel.

Write translation programs that automatically convert serial programs into parallel programs.

Share it among the other cores.

Pair the cores so that core 0 adds its result with core 1’s result.

Core 2 adds its result with core 3’s result, etc.

18

Example (cont.)

We have p cores, p much smaller than n. Each core performs a partial sum of

approximately n/p values.

Each core uses it’s own private variables

20

Example (cont.)

Once all the cores are done computing their private my_sum, they form a global sum by sending results to a designated “master” core which adds the final result.

and executes this block of code independently of the other cores.

并行程序设计导论(精品)

并行程序设计导论(精品)一、教学内容本节课的教学内容来自于并行程序设计导论教材的第三章,主要内容包括:并行计算机的基本概念、并行计算模型、并行算法的基本概念及其分类、并行算法的性能评价以及并行算法的设计方法。

二、教学目标1. 让学生了解并行计算机的基本概念,理解并行计算的原理和优势。

2. 掌握并行计算模型,了解不同类型的并行计算机体系结构。

3. 理解并行算法的基本概念,学会分析并评价并行算法的性能。

三、教学难点与重点重点:并行计算机的基本概念、并行计算模型、并行算法的基本概念及其分类、并行算法的性能评价。

难点:并行算法的设计方法。

四、教具与学具准备教具:多媒体教学设备、黑板、粉笔。

学具:教材、笔记本电脑、编程环境。

五、教学过程1. 实践情景引入:通过介绍一些并行计算机的应用场景,如高性能计算、大数据处理等,让学生了解并行计算机的重要性。

2. 讲解并行计算机的基本概念:解释并行计算机的定义、特点和优势,引导学生理解并行计算的原理。

3. 介绍并行计算模型:讲解不同类型的并行计算模型,如SIMD、MIMD等,并分析它们的优缺点。

4. 讲解并行算法的基本概念:介绍并行算法的定义、分类及其特点,让学生了解并行算法的基本知识。

5. 分析并评价并行算法的性能:讲解并行算法的性能评价指标,如加速比、效率等,并引导学生学会分析并行算法的性能。

6. 讲解并行算法的设计方法:介绍并行算法的设计方法,如流水线算法、分治算法等,让学生掌握并行算法的设计技巧。

7. 例题讲解:通过分析一些典型的并行算法实例,让学生更好地理解并行算法的原理和设计方法。

8. 随堂练习:让学生根据所学的并行算法设计方法,尝试解决一些实际的并行计算问题。

六、板书设计板书内容主要包括并行计算机的基本概念、并行计算模型、并行算法的基本概念及其分类、并行算法的性能评价以及并行算法的设计方法。

七、作业设计1. 请简述并行计算机的基本概念及其优势。

2. 解释并行计算模型的概念,并比较不同类型的并行计算模型的优缺点。

并行算法的设计与分析》ppt课件

1

m n1

1mD a O M (x E m /2,n/2)D ,O M (E m /2,n/2) 其他

普通地有 D O M ( m E ,n ) 1 D O M ( m E /2 , n /2 )

当m=n=2t时,不D 难O M推(E n,得n)long1

Parallel Algorithms 9 / Ch3

假设一个n输入的网络能排序一切2n种0,1序列, 那么它也能排序n个数的恣意序列。

Parallel Algorithms 5 / Ch3

3.1.2 奇偶归并网络

1. 网络构造 有序序列A:a1,a2,…,an

B: b1,b2,…,bm 归并思想: A, B中奇数号元素进入奇

归并器; A, B中偶数号元素进入偶

MIN MAX

Parallel Algorithms 11 / Ch3

3.1.3 双调归并网络

3. 例:双调序列(8,6,4,2,0,1,3,5)的(4,4)双调归并网络

8

80

6

08

MIN归并

0

1

4

61

2

16

0

43

1

34

2 3

MAX归并

4

5

3 5

22 55

6 8

两两比较 2个(2,2)双调归并网络

Knuth ==>

CO M(E n,n)O (nlon)g

当mCO M =En(n=,2n)t时2,CO 不ME(难n/推2,n得/2)n122CO ME(n/2,n/2)(n1)12

2CO ME(n/2,n/2)(n1)2(2CO ME(n/4,n/4)n/21)(n1)

22CO ME(n/22,n/22)(n2)(n1)...

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

8

Execution

mpiexec -n <number of processes> <executable>

mpiexec -n 1 ./mpi_hello

run with 1 process

mpiexec -n 4 ./mpi_hello

run with 4 processes

Copyright © 2010, Elsevier Inc. All rights Reserved

MPI_Init defines a communicator that consists of all the processes created when the program is started.

Called MPI_COMM_WORLD.

Copyright © 2010, Elsevier Inc. All rights Reserved

Copyright © 2010, Elsevier Inc. All rights Reserved

10

MPI Programs

Written in C.

Has main. Uses stdio.h, string.h, etc.

Need to add mpi.h header file. Identifiers defined by MPI start with

Copyright © 2010, Elsevier Inc. All rights Reserved

4

Hello World!

(a classic)

Copyright © 2010, Elsevier Inc. All rights Reserved

5

Identifying MPI processes

26

The Trapezoidal Rule

Copyright © 2010, Elsevier Inc. All rights Reserved

27

One trapezoid

Copyright © 2010, Elsevier Inc. All rights Reserved

28

Pseudo-code for a serial program

Common practice to identify processes by nonnegative integer ranks.

p processes are numbered 0, 1, 2, .. p-1

Copyright © 2010, Elsevier Inc. All rights Reserved

17

Data types

Copyright © 2010, Elsevier Inc. All rights Reserved

18

Communication

Copyright © 2010, Elsevier Inc. All rights Reserved

19

Message matching

6

Our first MPI program

Copyright © 2010, Elsevier Inc. All rights Reserved

7

Compilation

wrapper script to compile

source file

mpicc -g -Wall -o mpi_hello mpi_hello.c

MPI_Status*

MPI_Status* status;

status.MPI_SOURCE status.MPI_TAG

MPI_SOURCE MPI_TAG MPI_ERROR

Copyright © 2010, Elsevier Inc. All rights Reserved

22

How much data am I receiving?

Copyright © 2010, Elsevier Inc. All rights Reserved

31

Tasks and communications for Trapezoidal Rule

Copyright © 2010, Elsevier Inc. All rights Reserved

the amount of data in the message, the sender of the message, or the tag of the message.

Copyright © 2010, Elsevier Inc. All rights Reserved

21

status_p argument

MPI_Recv always blocks until a matching message is received.

Know your implementation; don’t make assumptions!

Copyright © 2010, Elsevier Inc. All rights Reserved

“MPI_”. First letter following underscore is

uppercase.

For function names and MPI-defined types. Helps to avoid confusion.

Copyright © 2010, Elsevier Inc. All rights Reserved

Copyright © 2010, Elsevier Inc. All rights Reserved

2

A distributed memory system

Copyright © 2010, Elsevier Inc. All rights Reserved

3

A shared memory system

The if-else construct makes our program SPMD.

Copyright © 2010, Elsevier Inc. All rights Reserved

16

Communication

Copyright © 2010, Elsevier Inc. All rights Reserved

Copyright © 2010, Elsevier Inc. All rights Reserved

12

Basic Outline

Copyright © 2010, Elsevier Inc. All rights Reserved

13

Communicators

A collection of processes that can send messages to each other.

11

MPI Components

MPI_Init

Tells MPI to do all the necessary setup.

MPI_Finalize

Tells MPI we’re done, so clean up anything allocated for this program.

Copyright © 2010, Elsevier Inc. All rights Reserved

29

Parallelizing the Trapezoidal Rule

1. Partition problem solution into tasks. 2. Identify communication channels between

14

Communicators

number of processes in the communicator

my rank (the process making this call)

Copyright © 2010, Elsevier Inc. All rights Reserved

15

SPMD

32

First version (1)

Copyright © 2010, Elsevier Inc. All rights Reserved

33

First version (2)

Copyright © 2010, Elsevier Inc. All rights Reserved

34

First version (3)

tasks. 3. Aggregate tasks into composite tasks. 4. Map composite tasks to cores.

Copyright © 2010, Elsevier Inc. All rights Reserved

30

Parallel pseudo-code

1

# Chapter Subtitle

Roadmap

Writing your first MPI program. Using the common MPI functions. The Trapezoidal Rule in MPI. Collective communication. MPI derived datatypes. Performance evaluation of MPI programs. Parallel sorting. Safety in MPI programs.

Copyright © 2010, Elsevier Inc. All rights Reserved

MPI_Send src = q

r

MPI_Recv dest = r

q

Copyright © 2010, Elsevier Inc. All rights Reserved

20

Receiving messages