词向量、word2vec、sense2vec与相关应用

自然语言处理技术的使用教程

自然语言处理技术的使用教程自然语言处理(Natural Language Processing,简称NLP)是人工智能领域中的一个重要分支,旨在实现和提升机器对人类语言的理解和处理能力。

随着大数据和机器学习算法的发展,NLP技术被广泛运用于机器翻译、文本分类、情感分析、语义理解等领域。

本文将为您介绍自然语言处理技术的基本概念和使用方法。

1. 文本预处理在进行自然语言处理之前,首先需要对文本进行预处理。

常见的预处理操作包括去除标点符号、分词、去除停用词、词干化等。

去除标点符号可以使用正则表达式进行简单的替换操作。

分词是将文本划分成独立的词语。

常用的中文分词工具有结巴分词、HanLP等;英文分词则可以使用NLTK库。

停用词是指在文本中频繁出现但无实际意义的常见词语,如“的”、“是”等。

可以根据实际需求,使用现成的停用词表进行去除。

词干化则是将词语还原为其原始形式,例如将“running”还原为“run”。

2. 词向量表示词向量是将词语转换为向量形式的表示方法,它能够捕捉到词语之间的语义关系。

常用的词向量模型有Word2Vec和GloVe。

Word2Vec是一种基于神经网络的模型,通过训练预料库中的词语来学习词向量。

GloVe则是一种基于全局词汇统计信息的模型。

使用这些模型可以将词语转换为向量形式,并计算词语之间的相似度。

比如,“男人”和“女人”的向量表示之间的相似度会比“男人”和“桌子”之间的相似度更高。

3. 文本分类文本分类是指将文本划分到事先定义好的不同类别中。

常见的文本分类任务包括情感分析、垃圾邮件过滤、新闻分类等。

常用的机器学习算法包括朴素贝叶斯、支持向量机和深度学习模型(如卷积神经网络和循环神经网络)。

在使用这些算法进行文本分类之前,需要先将文本转换为词向量表示。

然后,根据训练集的标注信息,使用监督学习算法进行模型训练。

最后,使用训练好的模型对新的文本进行分类预测。

4. 机器翻译机器翻译是将一种语言的文本自动转换为另一种语言的过程。

基于word2vec模型的文本特征抽取方法详解

基于word2vec模型的文本特征抽取方法详解在自然语言处理领域,文本特征抽取是一个重要的任务。

它的目标是将文本数据转换为机器学习算法可以处理的数值特征。

近年来,基于word2vec模型的文本特征抽取方法在该领域取得了显著的进展。

本文将详细介绍这一方法的原理和应用。

一、word2vec模型简介word2vec是一种用于将词语表示为向量的技术。

它基于分布假设,即上下文相似的词语往往具有相似的含义。

word2vec模型通过学习大量的文本数据,将每个词语表示为一个固定长度的向量,使得具有相似含义的词语在向量空间中距离较近。

二、word2vec模型的训练过程word2vec模型有两种训练方法:Skip-gram和CBOW。

Skip-gram模型通过给定中心词语,预测其周围的上下文词语;CBOW模型则相反,通过给定上下文词语,预测中心词语。

这两种方法都使用神经网络进行训练,通过最大化预测准确率来学习词语的向量表示。

三、基于word2vec模型的文本特征抽取方法基于word2vec模型的文本特征抽取方法主要有两种:词袋模型和平均词向量模型。

1. 词袋模型词袋模型是一种简单而常用的文本特征抽取方法。

它将文本表示为一个词语频率的向量,其中每个维度对应一个词语。

基于word2vec模型的词袋模型将每个词语的向量表示相加,并除以文本长度得到平均向量。

这种方法可以捕捉到文本中词语的语义信息,但忽略了词语的顺序。

2. 平均词向量模型平均词向量模型是一种更加复杂的文本特征抽取方法。

它将文本表示为所有词语向量的平均值。

通过这种方式,平均词向量模型可以保留词语的顺序信息。

与词袋模型相比,平均词向量模型可以更好地捕捉到文本的语义信息。

四、基于word2vec模型的文本特征抽取方法的应用基于word2vec模型的文本特征抽取方法在许多自然语言处理任务中得到了广泛应用。

例如,情感分析任务可以通过将文本表示为词袋模型或平均词向量模型的特征向量,然后使用机器学习算法进行分类。

word2vec和doc2vec词向量表示

word2vec和doc2vec词向量表⽰Word2Vec 词向量的稠密表达形式(⽆标签语料库训练)Word2vec中要到两个重要的模型,CBOW连续词袋模型和Skip-gram模型。

两个模型都包含三层:输⼊层,投影层,输出层。

1.Skip-Gram神经⽹络模型(跳过⼀些词)skip-gram模型的输⼊是⼀个单词wI,它的输出是wI的上下⽂wO,1,...,wO,C,上下⽂的窗⼝⼤⼩为C。

举个例⼦,这⾥有个句⼦“I drive my car to the store”。

我们如果把”car”作为训练输⼊数据,单词组{“I”, “drive”, “my”, “to”, “the”, “store”}就是输出。

所有这些单词,我们会进⾏one-hot编码2.连续词袋模型(Continuos Bag-of-words model)CBOW模型是在已知当前词w(t)的上下⽂w(t-2),w(t-1),w(t+1),w(t+2)的前提下预测当前词w(t)Hierarchical Softmax 实现加速。

3.传统的神经⽹络词向量语⾔模型DNN,⾥⾯⼀般有三层,输⼊层(词向量),隐藏层和输出层(softmax层:要计算词汇表中所有词softmax概率)。

⾥⾯最⼤的问题在于从隐藏层到输出的softmax层的计算量很⼤,因为要计算所有词的softmax概率,再去找概率最⼤的值。

word2vec也使⽤了CBOW与Skip-Gram来训练模型与得到词向量,但是并没有使⽤传统的DNN模型。

最先优化使⽤的数据结构是⽤霍夫曼树来代替隐藏层和输出层的神经元,霍夫曼树的叶⼦节点起到输出层神经元的作⽤,叶⼦节点的个数即为词汇表的⼩⼤。

⽽内部节点则起到隐藏层神经元的作⽤体如何⽤霍夫曼树来进⾏CBOW和Skip-Gram的训练我们在下⼀节讲,这⾥我们先复习下霍夫曼树。

霍夫曼树的建⽴其实并不难,过程如下:(节点权重可看作词频) 输⼊:权值为(w1,w2,...wn)的n个节点 输出:对应的霍夫曼树1)将(w1,w2,...wn)看做是有n棵树的森林,每个树仅有⼀个节点。

NLP之word2vec:word2vec简介、安装、使用方法之详细攻略

NLP之word2vec:word2vec简介、安装、使用方法之详细攻略NLP之word2vec:word2vec简介、安装、使用方法之详细攻略word2vec简介word distributed embedding最早是Bengio 03年的论文"A Neural Probabilistic Language Model"提出来,rnn lm 在10年被mikolov提出。

word2vec 是 Google 于 2013 年开源推出的一个用于获取词向量(word vector)的工具包,它简单、高效。

word2vec也叫word embeddings,中文名“词向量”,作用就是将自然语言中的字词转为计算机可以理解的稠密向量Dense Vector。

所谓的word vector,就是指将单词向量化,将某个单词用特定的向量来表示。

将单词转化成对应的向量以后,就可以将其应用于各种机器学习的算法中去。

一般来讲,词向量主要有两种形式,分别是稀疏向量和密集向量。

word2vec的思想类似于antodecoder,但是并不是将自身作为训练目标,也不是用RBM来训练。

word2vec将 context和word5:别作为训练目标,Wskip-gram和CBOW。

word2vec其实就是two layer shallow neural network,减少了深度神经网络的复杂性,快速的生成word embedding.Skip-gram: works well with small amount of the training data, represents well even rare words or phrases.CBOW: several times faster to train than the skip-gram, slightly better accuracy for the frequent wordsThis can get even a bit more complicated if you consider that there are two different ways how to train the models: the normalized hierarchical softmax, and the un-normalized negative sampling. Both work quite differently.1、稀疏向量One-Hot Encoder在word2vec出现之前,自然语言处理经常把字词转为离散的单独的符号,也就是One-Hot Encoder。

自然语言处理中的词嵌入技术

自然语言处理中的词嵌入技术自然语言处理(Natural Language Processing,NLP)是人工智能领域中的一个重要研究方向,旨在使计算机能够理解和处理人类语言。

在NLP中,词嵌入技术是一种广泛应用的关键技术,它可以将语言中的单词转化为向量表示,从而使计算机能够对文本内容进行处理和理解。

词嵌入是一种将离散的符号化表示(如单词)转化为连续向量的技术。

在传统的文本处理中,单词通常被表示为独热向量,即只有一个元素为1,其余元素为0。

这种表示方法存在两个问题:首先,它无法捕捉到词之间的关系和语义信息;其次,由于每个单词的表示都是相互独立的,导致向量空间极大,计算成本高。

词嵌入技术通过学习将单词映射到低维向量空间中,解决了传统文本处理的问题。

其中,Word2Vec是最具代表性的方法之一。

Word2Vec基于两种核心模型:Skip-Gram和CBOW(Continuous Bag-of-Words)。

Skip-Gram模型通过给定一个单词预测其周围的上下文单词,而CBOW则相反,它根据上下文单词预测目标单词。

这样的模型能够通过训练建立起单词之间的语义关系,使得具有相似语义的单词在向量空间中距离更近。

除了Word2Vec,还有其他一些常用的词嵌入模型,如GloVe(Global Vectors for Word Representation)。

GloVe通过统计单词在语料库中的共现概率来构建词向量,能够同时捕捉到全局和局部的语义信息。

这种方法相比于Word2Vec在一些任务上表现更好。

词嵌入技术的应用非常广泛。

一方面,它可以应用于文本分类、情感分析和命名实体识别等任务中,通过对单词的语义信息进行建模,提高模型的性能。

另一方面,词嵌入还可以用于单词的相似度计算和文本推荐系统等场景,从而改进信息检索和推荐的效果。

在实际应用中,为了训练好的词向量模型,需要大量的文本数据。

一般情况下,可以使用维基百科、大规模的新闻语料库或者互联网上的大量文本进行训练。

bm-marker animation类型-概述说明以及解释

结论

Word2vec是一种非常强大的词向量生成模型,它的工作原理基于Skip-gram模 型和神经网络。通过学习词的上下文关系,Word2vec能够生成具有丰富语义 信息的词向量,从而在文本处理、信息抽取和自然语言处理等领域得到广泛应 用。

然而,Word2vec也存在一些局限性。例如,它对训练语料库的规模和质量要 求较高,且训练时间较长。此外,虽然Word2vec能够捕捉到词之间的语义关 系,但它无法理解句子的语法结构和语序信息。为了解决这些问题,未来的研 究方向可以包括改进Word2vec的训练算法、结合其他语言学特征、以及探索 基于深度学习的词向量表示方法等。

Word2vec核心架构

Word2vec是一种基于神经网络的词向量表示方法,其主要由两部分组成: Skip-gram模型和Continuous Bag of Words(CBOW)模型。Skip-gram模型 通过预测上下文来学习词向量表示,而CBOW模型则通过预测当前词来学习上下 文向量表示。这两种模型都采用了负采样(negative sampling)技术,以高 效地训练大规模语料库。

Word2vபைடு நூலகம்c的核心架构及其应 用

目录

01 引言

03

Word2vec的应用场 景

02 Word2vec核心架构 04 参考内容

引言

随着人工智能和自然语言处理技术的快速发展,词向量表示作为其中的关键部 分,越来越受到研究者的。Word2vec是一种广泛使用的词向量表示方法,它 通过训练神经网络学习词表中的词向量表示,从而捕捉词义和语法信息。本次 演示将深入探讨Word2vec的核心架构及其应用场景,以期为相关领域的研究 和实践提供有益的参考。

2、在推荐系统中,Word2vec可以通过分析用户历史行为和项目属性,将它们 转换为向量表示,从而预测用户的兴趣和推荐相关项目。这种方法可以有效提 高推荐系统的准确性和用户满意度。

word2vec原理

word2vec原理Word2vec原理。

Word2vec是一种用于自然语言处理的词嵌入技术,它能够将单词映射到一个高维向量空间中,从而实现对单词语义的表示。

本文将介绍word2vec的原理及其在自然语言处理中的应用。

Word2vec的原理基于神经网络模型,它通过学习大规模文本语料库中的单词上下文关系来生成单词的向量表示。

在word2vec模型中,有两种常用的架构,分别是CBOW(Continuous Bag of Words)和Skip-gram。

CBOW模型试图根据上下文单词的信息来预测目标单词,而Skip-gram模型则是根据目标单词来预测上下文单词。

这两种模型在实际应用中都有着各自的优势,选择合适的模型取决于具体的任务需求。

在word2vec模型中,每个单词都被表示为一个固定长度的向量,这些向量可以被用来计算单词之间的相似度。

通过在向量空间中计算单词之间的距离,我们可以得到单词之间的语义关系。

例如,对于两个相似的单词,它们在向量空间中的距离应该较小;而对于两个不相似的单词,它们的距离则应该较大。

这种基于向量空间的语义表示方法为自然语言处理任务提供了更加丰富和有效的特征表示。

除了用于计算单词之间的相似度外,word2vec的向量表示还可以应用于其他自然语言处理任务,如命名实体识别、情感分析、文本分类等。

通过将单词映射到向量空间中,我们可以更好地捕捉单词的语义信息,从而提升模型在各种任务上的性能。

在实际应用中,为了得到高质量的词向量表示,我们通常需要大规模的文本语料库来进行训练。

通过训练word2vec模型,我们可以得到一个包含丰富语义信息的词向量空间,这对于提升自然语言处理任务的性能具有重要意义。

总的来说,word2vec是一种强大的词嵌入技术,它通过将单词映射到向量空间中来实现对单词语义的表示。

通过学习大规模文本语料库中的单词上下文关系,word2vec能够生成丰富的词向量表示,这对于提升自然语言处理任务的性能具有重要意义。

word2vec详解与实战

word2vec详解与实战有那么⼀句话不懂word2vec,就别说⾃⼰是研究⼈⼯智能->机器学习->⾃然语⾔处理(NLP)->⽂本挖掘的所以接下来我就从头⾄尾的详细讲解⼀下word2vec这个东西。

简要介绍先直接给出维基百科上最权威的解释(⼤家英语⽔平够格的话⼀定要充分理解这个最权威的解释,⽐国内的某些长篇啰嗦解释简直不知道简洁清楚多少倍!):Word2vec is a group of related models that are used to produce word embeddings. These models are shallow, two-layer neural networks that are trained to reconstruct linguistic contexts of words. Word2vec takes as its input a large corpus of text andproduces a vector space, typically of several hundred dimensions, with each unique word in the corpus being assigned acorresponding vector in the space. Word vectors are positioned in the vector space such that words that share common contexts in the corpus are located in close proximity to one another in the space.下⾯说⼀说我对word2vec的简要概括:它是Google在2013年开源的⼀款⽤于词向量计算的⼯具word2vec可以在百万数量级的词典和上亿的数据集上进⾏⾼效地训练该⼯具得到的训练结果——词向量(word embedding),可以很好地度量词与词之间的相似性另外简要列出⼈们容易对word2vec产⽣的两⼤误区:很多⼈误以为word2vec是⼀种深度学习算法,其实word2vec算法的背后是⼀个浅层神经⽹络(正如维基百科所述:These models are shallow, two-layer neural networks)word2vec是⼀个计算word vector的开源⼯具,当我们在说word2vec算法或模型的时候,其实指的是其背后⽤于计算word vector的CBoW模型和Skip-gram模型。

数学与语言学数学在语音识别和自然语言处理中的应用

数学与语言学数学在语音识别和自然语言处理中的应用数学与语言学:数学在语音识别和自然语言处理中的应用概述:在当今信息技术迅速发展的背景下,语音识别和自然语言处理作为人机交互的重要领域,正不断吸引着研究者的关注。

而数学作为一种强大的工具,也在这两个领域中发挥着重要作用。

本文将分析数学在语音识别和自然语言处理中的应用,并探讨它们背后的原理和算法。

一、语音识别中的数学应用1. 数字信号处理在语音识别中,首先需要将语音信号转化为数学模型,以便进行进一步的分析和处理。

在这一过程中,数字信号处理的数学方法被广泛应用。

其中,傅里叶变换、小波变换等数学工具能够将语音信号从时域转换为频域,以便提取语音的频谱特征。

2. 统计模型统计模型在语音识别中扮演着重要角色。

隐马尔可夫模型(Hidden Markov Model,HMM)被广泛用于语音识别中的声学建模,它利用数学中的概率理论,建立了声学特征和文本之间的映射关系。

通过训练大量的语音数据,利用统计学习方法,可以得到准确的语音识别模型。

3. 语音识别算法数学在语音识别算法中发挥着关键作用。

动态时间规整算法(Dynamic Time Warping,DTW)是一种基于动态规划的算法,它通过计算语音之间的时间距离,寻找最佳匹配路径,从而实现语音识别。

此外,支持向量机、深度学习等数学方法也被用于语音识别中,不断提高系统的识别准确率。

二、自然语言处理中的数学应用1. 统计语言模型统计语言模型是自然语言处理的重要组成部分,它通过统计语料库中的频率和概率分布,为自然语言的建模提供数学支持。

n-gram模型是一种常用的统计语言模型,它基于历史上的n个词来预测下一个词的出现概率。

2. 词向量表示词向量是将单词映射到实数向量空间的表示方法,在自然语言处理中得到广泛应用。

基于词向量的方法能够很好地捕捉词语之间的语义和语法信息。

著名的Word2Vec算法就是一种基于神经网络的词向量训练算法,它将单词的分布式表示通过神经网络进行学习。

使用word2vec训练中文词向量

使⽤word2vec训练中⽂词向量https:///p/87798bccee48⼀、⽂本处理流程通常我们⽂本处理流程如下:1 对⽂本数据进⾏预处理:数据预处理,包括简繁体转换,去除xml符号,将单词条内容处理成单⾏数据,word2vec训练原理是基于词共现来训练词之间的语义联系的。

不同词条内容需分开训练2 中⽂分词:中⽂NLP很重要的⼀步就是分词了,分词的好坏很⼤程度影响到后续的模型训练效果3 特征处理:也叫词向量编码,将⽂本数据转换成计算机能识别的数据,便于计算,通常是转换成数值型数据,常⽤的编码⽅式有onehot编码(BOW词袋模型离散表⽰⽅式,另外⽂章我们讲解TF-IDF模型时候会介绍)和基于word2vec等深度学习模型训练得到的低维稠密向量,通常称为word embedding的Distributed representation4 机器学习:词向量进⾏编码之后,便可以将⽂本数据转换成数值数据,输⼊到我们的机器学习模型进⾏计算训练了⽂本处理流程图如下:⽂本处理流程⼆、训练过程模型:gensim⼯具包word2vec模型,安装使⽤简单,训练速度快语料:百度百科500万词条+维基百科30万词条+1.1万条领域数据分词:jieba分词,⾃定义词典加⼊⾏业词,去除停⽤词硬件:8核16g虚拟机数据预处理维基百科数据量不够⼤,百度百科数据量较全⾯,内容上⾯百度百科⼤陆相关的信息⽐较全⾯,港澳台和国外相关信息维基百科的内容⽐较详细,因此训练时将两个语料⼀起投⼊训练,形成互补,另外还加⼊了1.1万公司⾏业数据分词1 准备⼀个停⽤词词典,训练时要去除停⽤词的⼲扰2 分词⼯具有中科院分词,哈⼯⼤的LTP分词,jieba分词,分词效果中科院的分词效果不错,我们直接使⽤jieba进⾏分词,使⽤简单⽅便,分词速度快3 ⾃定义词典:由于百科数据有很多专属名词,很多⽐较长,如果直接分词,很⼤情况下会被切开,这不是我们想要的结果,⽐如:中国⼈民解放军,可能会被分成:中国⼈民解放军,jieba虽然有新词发现功能,为保证分词准确度,jieba的作者建议我们还是使⽤⾃定义词典。

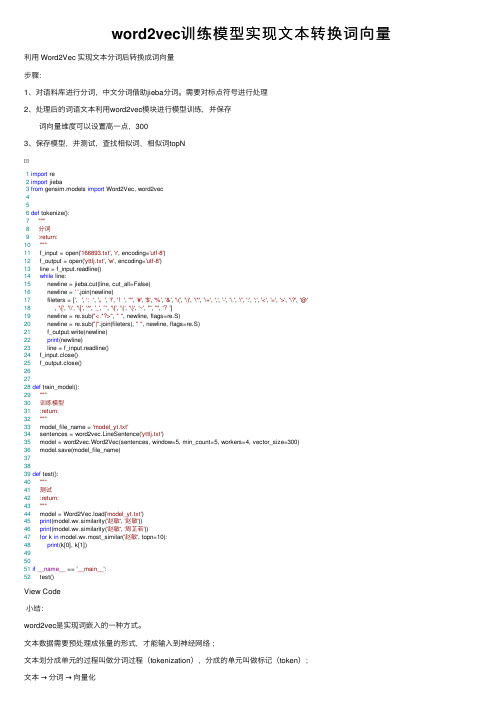

word2vec训练模型实现文本转换词向量

word2vec训练模型实现⽂本转换词向量利⽤ Word2Vec 实现⽂本分词后转换成词向量步骤:1、对语料库进⾏分词,中⽂分词借助jieba分词。

需要对标点符号进⾏处理2、处理后的词语⽂本利⽤word2vec模块进⾏模型训练,并保存 词向量维度可以设置⾼⼀点,3003、保存模型,并测试,查找相似词,相似词topN1import re2import jieba3from gensim.models import Word2Vec, word2vec456def tokenize():7"""8分词9 :return:10"""11 f_input = open('166893.txt', 'r', encoding='utf-8')12 f_output = open('yttlj.txt', 'w', encoding='utf-8')13 line = f_input.readline()14while line:15 newline = jieba.cut(line, cut_all=False)16 newline = ''.join(newline)17 fileters = [',', ':', '。

', '!', '!', '"', '#', '$', '%', '&', '\(', '\)', '\*', '\+', ',', '-', '\.', '/', ':', ';', '<', '=', '>', '\?', '@'18 , '\[', '\\', '\]', '^', '_', '`', '\{', '\|', '\}', '~', '”', '“', '?']19 newline = re.sub("<.*?>", "", newline, flags=re.S)20 newline = re.sub("|".join(fileters), "", newline, flags=re.S)21 f_output.write(newline)22print(newline)23 line = f_input.readline()24 f_input.close()25 f_output.close()262728def train_model():29"""30训练模型31 :return:32"""33 model_file_name = 'model_yt.txt'34 sentences = word2vec.LineSentence('yttlj.txt')35 model = word2vec.Word2Vec(sentences, window=5, min_count=5, workers=4, vector_size=300)36 model.save(model_file_name)373839def test():40"""41测试42 :return:43"""44 model = Word2Vec.load('model_yt.txt')45print(model.wv.similarity('赵敏', '赵敏'))46print(model.wv.similarity('赵敏', '周芷若'))47for k in model.wv.most_similar('赵敏', topn=10):48print(k[0], k[1])495051if__name__ == '__main__':52 test()View Code⼩结:word2vec是实现词嵌⼊的⼀种⽅式。

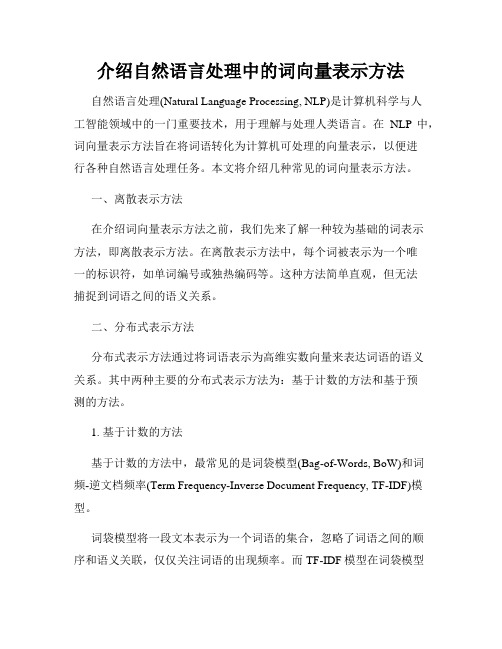

介绍自然语言处理中的词向量表示方法

介绍自然语言处理中的词向量表示方法自然语言处理(Natural Language Processing, NLP)是计算机科学与人工智能领域中的一门重要技术,用于理解与处理人类语言。

在NLP中,词向量表示方法旨在将词语转化为计算机可处理的向量表示,以便进行各种自然语言处理任务。

本文将介绍几种常见的词向量表示方法。

一、离散表示方法在介绍词向量表示方法之前,我们先来了解一种较为基础的词表示方法,即离散表示方法。

在离散表示方法中,每个词被表示为一个唯一的标识符,如单词编号或独热编码等。

这种方法简单直观,但无法捕捉到词语之间的语义关系。

二、分布式表示方法分布式表示方法通过将词语表示为高维实数向量来表达词语的语义关系。

其中两种主要的分布式表示方法为:基于计数的方法和基于预测的方法。

1. 基于计数的方法基于计数的方法中,最常见的是词袋模型(Bag-of-Words, BoW)和词频-逆文档频率(Term Frequency-Inverse Document Frequency, TF-IDF)模型。

词袋模型将一段文本表示为一个词语的集合,忽略了词语之间的顺序和语义关联,仅仅关注词语的出现频率。

而TF-IDF模型在词袋模型的基础上引入了词频-逆文档频率的概念,用于衡量词语在整个语料库中的重要程度。

2. 基于预测的方法基于预测的方法尝试通过预测上下文或目标词来学习词向量。

其中最著名的是Word2Vec模型。

Word2Vec模型通过两种主要的训练方法来学习词向量:连续词袋模型(Continuous Bag-of-Words, CBOW)和跳字模型(Skip-Gram)。

CBOW模型通过上下文预测目标词,而跳字模型则相反,通过目标词预测上下文。

三、预训练词向量表示方法预训练词向量表示方法是指在大规模数据上预先训练好的词向量模型。

这些模型将词语映射到高维向量空间,并捕捉了词语之间的语义关系。

1. Word2Vec已经提到的Word2Vec模型,通过训练大规模语料库得到词向量表示。

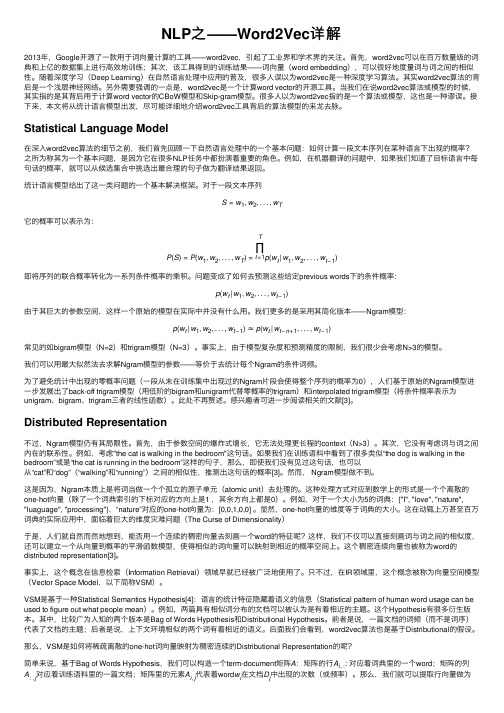

NLP之——Word2Vec详解

NLP之——Word2Vec详解2013年,Google开源了⼀款⽤于词向量计算的⼯具——word2vec,引起了⼯业界和学术界的关注。

⾸先,word2vec可以在百万数量级的词典和上亿的数据集上进⾏⾼效地训练;其次,该⼯具得到的训练结果——词向量(word embedding),可以很好地度量词与词之间的相似性。

随着深度学习(Deep Learning)在⾃然语⾔处理中应⽤的普及,很多⼈误以为word2vec是⼀种深度学习算法。

其实word2vec算法的背后是⼀个浅层神经⽹络。

另外需要强调的⼀点是,word2vec是⼀个计算word vector的开源⼯具。

当我们在说word2vec算法或模型的时候,其实指的是其背后⽤于计算word vector的CBoW模型和Skip-gram模型。

很多⼈以为word2vec指的是⼀个算法或模型,这也是⼀种谬误。

接下来,本⽂将从统计语⾔模型出发,尽可能详细地介绍word2vec⼯具背后的算法模型的来龙去脉。

Statistical Language Model在深⼊word2vec算法的细节之前,我们⾸先回顾⼀下⾃然语⾔处理中的⼀个基本问题:如何计算⼀段⽂本序列在某种语⾔下出现的概率?之所为称其为⼀个基本问题,是因为它在很多NLP任务中都扮演着重要的⾓⾊。

例如,在机器翻译的问题中,如果我们知道了⽬标语⾔中每句话的概率,就可以从候选集合中挑选出最合理的句⼦做为翻译结果返回。

统计语⾔模型给出了这⼀类问题的⼀个基本解决框架。

对于⼀段⽂本序列S=w1,w2,...,w T它的概率可以表⽰为:P(S)=P(w1,w2,...,w T)=T∏t=1p(w t|w1,w2,...,w t−1)即将序列的联合概率转化为⼀系列条件概率的乘积。

问题变成了如何去预测这些给定previous words下的条件概率:p(w t|w1,w2,...,w t−1)由于其巨⼤的参数空间,这样⼀个原始的模型在实际中并没有什么⽤。

NLP-文本分类之词向量-word2vec概念和公式理解

NLP-⽂本分类之词向量-word2vec概念和公式理解不积跬步⽆以⾄千⾥,不积⼩流⽆以成江海!每天⼀点点,以达到积少成多之效!word2vec----概念,数学原理理解1.数据集 Kaggle上的电影影评数据,包括unlabeledTrainData.tsv,labeledTrainData.tsv,testData.tsv三个⽂件 Strange things: kaggle,主要为开发商和数据科学家提供举办机器学习⽐赛、托管数据库、编写和分享代码的平台。

tsv,即tab separated values(制表符分隔值),就是数据集按照⼀个tab键的空格⼤⼩分开的,如下, csv,即comma separated values(逗号分隔值),csv数据集常见些,就是⽤逗号分隔的数据集,如下 2.pandas等包的函数理解 Strange things: pandas.DataFrame类似于excel,是⼀种⼆维表,DataFrame的单元格可以放数值、字符串等。

pandas.DataFrame(data,index,columns,dtype,copy),data:接受的数据的形式,如ndarry,series,map,lists,dict,constant和另⼀个DataFrame。

参考博客(超好理解):index:⾏标签。

columns:列标签。

dtype:每列的数据类型。

copy:若默认值为False,则此命令⽤于复制数据 BeautifulSoup:和lxml⼀样,是⼀个HTML/XML的解析器,主要就是如何解析和提取HTML/XML数据。

它⾃动把输⼊⽂档转换为Unicode编码,输出⽂档转换为utf-8编码 BeautifulSoup.get_text():get_text()⽅法返回BeautifulSoup对象或标签对象中的⽂本内容,其为⼀个Unicode字符串,如中所⽰如下 DataFrame.apply(function,axis):对DataFrame⾥⼀⾏或⼀列做出⼀些操作(axis=1则为对某⼀列进⾏操作,此时,apply函数每次将dataframe的⼀⾏传给function,然后获取返回值,将返回值放⼊⼀个series),返回⼀个新的⾏(列)。

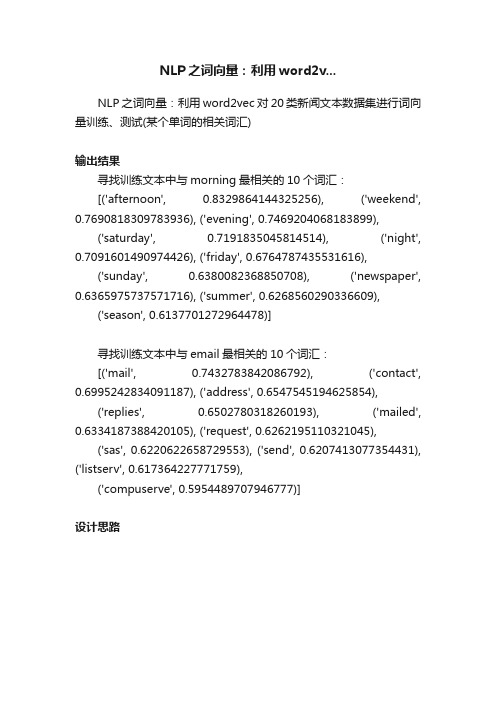

NLP之词向量:利用word2v...

NLP之词向量:利用word2v...NLP之词向量:利用word2vec对20类新闻文本数据集进行词向量训练、测试(某个单词的相关词汇)输出结果寻找训练文本中与morning最相关的10个词汇:[('afternoon', 0.8329864144325256), ('weekend', 0.7690818309783936), ('evening', 0.7469204068183899),('saturday', 0.7191835045814514), ('night', 0.7091601490974426), ('friday', 0.6764787435531616),('sunday', 0.6380082368850708), ('newspaper', 0.6365975737571716), ('summer', 0.6268560290336609),('season', 0.6137701272964478)]寻找训练文本中与email最相关的10个词汇:[('mail', 0.7432783842086792), ('contact', 0.6995242834091187), ('address', 0.6547545194625854),('replies', 0.6502780318260193), ('mailed', 0.6334187388420105), ('request', 0.6262195110321045),('sas', 0.6220622658729553), ('send', 0.6207413077354431), ('listserv', 0.617364227771759),('compuserve', 0.5954489707946777)]设计思路核心代码class Word2Vec(BaseWordEmbeddingsModel):"""Train, use and evaluate neural networks described in https://code.google.com/p/word2vec/.Once you're finished training a model (=no more updates, only querying)store and use only the :class:`~gensim.models.keyedvectors.KeyedVectors` instance in `self.wv` to reduce memory.The model can be stored/loaded via its :meth:`~gensim.models.word2vec.Word2Vec.save` and:meth:`~gensim.models.word2vec.Word2Vec.load` methods.The trained word vectors can also be stored/loaded from a format compatible with theoriginal word2vec implementation via `self.wv.save_word2vec_format`and :meth:`gensim.models.keyedvectors.KeyedVectors.load_word2vec_format`.Some important attributes are the following:Attributes----------wv : :class:`~gensim.models.keyedvectors.Word2VecKeyedV ectors`This object essentially contains the mapping between words and embeddings. Aftertraining, it can be useddirectly to query those embeddings in various ways. See the module level docstring forexamples.vocabulary : :class:'~gensim.models.word2vec.Word2VecVoc ab'This object represents the vocabulary (sometimes called Dictionary in gensim) of themodel.Besides keeping track of all unique words, this object provides extra functionality, such asconstructing a huffman tree (frequent words are closer to the root), or discardingextremely rare words.trainables : :class:`~gensim.models.word2vec.Word2VecTrain ables`This object represents the inner shallow neural network used to train the embeddings. Thesemantics of thenetwork differ slightly in the two available training modes (CBOW or SG) but you can thinkof it as a NN witha single projection and hidden layer which we train on the corpus. The weights are thenused as our embeddings(which means that the size of the hidden layer is equal to the number of features `self.size`)."""def __init__(self, sentences=None, size=100, alpha=0.025, window=5, min_count=5,max_vocab_size=None, sample=1e-3, seed=1, workers=3, min_alpha=0.0001,sg=0, hs=0, negative=5, ns_exponent=0.75, cbow_mean=1, hashfxn=hash, iter=5,null_word=0,trim_rule=None, sorted_vocab=1, batch_words=MAX_WORDS_IN_BATCH,compute_loss=False, callbacks=(),max_final_vocab=None):"""Parameters----------sentences : iterable of iterables, optionalThe `sentences` iterable can be simply a list of lists of tokens, but for larger corpora,consider an iterable that streams the sentences directly fromdisk/network.See :class:`~gensim.models.word2vec.BrownCorpus`, :class:` ~gensim.models.word2vec.Text8Corpus`or :class:`~gensim.models.word2vec.LineSentence` in :mod:`~gensim.models.word2vec` module for such examples.See also the `tutorial on data streaming in Python</data-streaming-in-python-generators-iterators-iterables/>`_.If you don't supply `sentences`, the model is left uninitialized -- use if you plan toinitialize itin some other way.size : int, optionalDimensionality of the word vectors.window : int, optionalMaximum distance between the current and predicted word within a sentence.min_count : int, optionalIgnores all words with total frequency lower than this.workers : int, optionalUse these many worker threads to train the model (=faster training with multicoremachines).sg : {0, 1}, optionalTraining algorithm: 1 for skip-gram; otherwise CBOW.hs : {0, 1}, optionalIf 1, hierarchical softmax will be used for model training.If 0, and `negative` is non-zero, negative sampling will beused.negative : int, optionalIf > 0, negative sampling will be used, the int for negative specifies how many "noisewords"should be drawn (usually between 5-20).If set to 0, no negative sampling is used.ns_exponent : float, optionalThe exponent used to shape the negative sampling distribution. A value of 1.0samples exactly in proportionto the frequencies, 0.0 samples all words equally, while a negative value samples low-frequency words morethan high-frequency words. The popular default value of 0.75 was chosen by theoriginal Word2Vec paper.More recently, in /abs/1804.04212, Caselles-Dupré, Lesaint, & Royo-Letelier suggest thatother values may perform better for recommendation applications.cbow_mean : {0, 1}, optionalIf 0, use the sum of the context word vectors. If 1, use the mean, only applies whencbow is used.alpha : float, optionalThe initial learning rate.min_alpha : float, optionalLearning rate will linearly drop to `min_alpha` as trainingprogresses.seed : int, optionalSeed for the random number generator. Initial vectors for each word are seeded witha hash ofthe concatenation of word + `str(seed)`. Note that for a fully deterministically-reproducible run,you must also limit the model to a single worker thread (`workers=1`), to eliminateordering jitterfrom OS thread scheduling. (In Python 3, reproducibility between interpreter launchesalso requiresuse of the `PYTHONHASHSEED` environment variable to control hash randomization).max_vocab_size : int, optionalLimits the RAM during vocabulary building; if there are more uniquewords than this, then prune the infrequent ones. Every 10 million word types needabout 1GB of RAM.Set to `None` for no limit.max_final_vocab : int, optionalLimits the vocab to a target vocab size by automatically picking a matching min_count.If the specifiedmin_count is more than the calculated min_count, the specified min_count will beused.Set to `None` if not required.sample : float, optionalThe threshold for configuring which higher-frequency words are randomlydownsampled,useful range is (0, 1e-5).hashfxn : function, optionalHash function to use to randomly initialize weights, for increased trainingreproducibility.iter : int, optionalNumber of iterations (epochs) over the corpus.trim_rule : function, optionalVocabulary trimming rule, specifies whether certain words should remain in thevocabulary,be trimmed away, or handled using the default (discard if word count < min_count).Can be None (min_count will be used, look to :func:`~gensim.utils.keep_vocab_item`),or a callable that accepts parameters (word, count, min_count) and returns either:attr:`gensim.utils.RULE_DISCARD`, :attr:`gensim.utils.RULE_K EEP` or :attr:`gensim.utils.RULE_DEFAULT`.The rule, if given, is only used to prune vocabulary during build_vocab() and is notstored as part of themodel.The input parameters are of the following types:* `word` (str) - the word we are examining* `count` (int) - the word's frequency count in the corpus* `min_count` (int) - the minimum count threshold.sorted_vocab : {0, 1}, optionalIf 1, sort the vocabulary by descending frequency before assigning word indexes.See :meth:`~gensim.models.word2vec.Word2VecVocab.sort_ vocab()`.batch_words : int, optionalTarget size (in words) for batches of examples passed to worker threads (andthus cython routines).(Larger batches will be passed if individualtexts are longer than 10000 words, but the standard cython code truncates to thatmaximum.)compute_loss: bool, optionalIf True, computes and stores loss value which can be retrieved using:meth:`~gensim.models.word2vec.Word2Vec.get_latest_train ing_loss`.callbacks : iterable of :class:`~gensim.models.callbacks.CallbackAny2Vec`, optional Sequence of callbacks to be executed at specific stages during training.Examples--------Initialize and train a :class:`~gensim.models.word2vec.Word2Vec` model>>> from gensim.models import Word2Vec>>> sentences = [["cat", "say", "meow"], ["dog", "say", "woof"]]>>> model = Word2Vec(sentences, min_count=1)"""self.max_final_vocab = max_final_vocabself.callbacks = callbacksself.load = call_on_class_onlyself.wv = Word2VecKeyedVectors(size)self.vocabulary = Word2VecVocab(max_vocab_size=max_vocab_size, min_count=min_count, sample=sample,sorted_vocab=bool(sorted_vocab),null_word=null_word, max_final_vocab=max_final_vocab, ns_exponent=ns_exponent)self.trainables = Word2VecTrainables(seed=seed, vector_size=size, hashfxn=hashfxn)super(Word2Vec, self).__init__(sentences=sentences, workers=workers,vector_size=size, epochs=iter, callbacks=callbacks, batch_words=batch_words,trim_rule=trim_rule, sg=sg, alpha=alpha, window=window, seed=seed, hs=hs,negative=negative, cbow_mean=cbow_mean, min_alpha=min_alpha,compute_loss=compute_loss, fast_version=FAST_VERSION)def _do_train_job(self, sentences, alpha, inits):"""Train the model on a single batch of sentences.Parameters----------sentences : iterable of list of strCorpus chunk to be used in this training batch.alpha : floatThe learning rate used in this batch.inits : (np.ndarray, np.ndarray)Each worker threads private work memory.Returns-------(int, int)2-tuple (effective word count after ignoring unknown words and sentence lengthtrimming, total word count)."""work, neu1 = initstally = 0if self.sg:tally += train_batch_sg(self, sentences, alpha, work, pute_loss)else:tally += train_batch_cbow(self, sentences, alpha, work, neu1, pute_loss)return tally, self._raw_word_count(sentences)def _clear_post_train(self):"""Remove all L2-normalized word vectors from the model."""self.wv.vectors_norm = Nonedef _set_train_params(self, **kwargs):if 'compute_loss' in kwargs:pute_loss = kwargs['compute_loss']self.running_training_loss = 0def train(self, sentences, total_examples=None, total_words=None,epochs=None, start_alpha=None, end_alpha=None, word_count=0,queue_factor=2, report_delay=1.0, compute_loss=False, callbacks=()):"""Update the model's neural weights from a sequence of sentences.Notes-----To support linear learning-rate decay from (initial) `alpha` to `min_alpha`, and accurateprogress-percentage logging, either `total_examples` (count of sentences) or`total_words` (count ofraw words in sentences) **MUST** be provided. If `sentences` is the same corpusthat was providedto :meth:`~gensim.models.word2vec.Word2Vec.build_vocab` earlier,you can simply use `total_examples=self.corpus_count`.Warnings--------To avoid common mistakes around the model's ability to do multiple training passesitself, anexplicit `epochs` argument **MUST** be provided. In the common and recommendedcasewhere :meth:`~gensim.models.word2vec.Word2Vec.train` is only called once, you canset `epochs=self.iter`.Parameters----------sentences : iterable of list of strThe `sentences` iterable can be simply a list of lists of tokens, but for larger corpora,consider an iterable that streams the sentences directly from disk/network.See :class:`~gensim.models.word2vec.BrownCorpus`, :class:` ~gensim.models.word2vec.Text8Corpus`or :class:`~gensim.models.word2vec.LineSentence` in :mod:`~gensim.models.word2vec` module for such examples.See also the `tutorial on data streaming in Python</data-streaming-in-python-generators-iterators-iterables/>`_.total_examples : int, optionalCount of sentences. Used to decay the `alpha` learning rate.total_words : int, optionalCount of raw words in sentences. Used to decay the `alpha` learning rate.epochs : int, optionalNumber of iterations (epochs) over the corpus.start_alpha : float, optionalInitial learning rate. If supplied, replaces the starting `alpha` from the constructor,for this one call to`train()`.Use only if making multiple calls to `train()`, when you want to manage the alphalearning-rate yourself(not recommended).end_alpha : float, optionalFinal learning rate. Drops linearly from `start_alpha`.If supplied, this replaces the final `min_alpha` from the constructor, for this one call to`train()`.Use only if making multiple calls to `train()`, when you want to manage the alphalearning-rate yourself(not recommended).word_count : int, optionalCount of words already trained. Set this to 0 for the usualcase of training on all words in sentences.queue_factor : int, optionalMultiplier for size of queue (number of workers * queue_factor).report_delay : float, optionalSeconds to wait before reporting progress.compute_loss: bool, optionalIf True, computes and stores loss value which can be retrieved using:meth:`~gensim.models.word2vec.Word2Vec.get_latest_train ing_loss`.callbacks : iterable of :class:`~gensim.models.callbacks.CallbackAny2Vec`, optional Sequence of callbacks to be executed at specific stages during training.Examples-------->>> from gensim.models import Word2Vec>>> sentences = [["cat", "say", "meow"], ["dog", "say", "woof"]]>>>>>> model = Word2Vec(min_count=1)>>> model.build_vocab(sentences) # prepare the model vocabulary>>> model.train(sentences, total_examples=model.corpus_count, epochs=model.iter) # train word vectors(1, 30)"""return super(Word2Vec, self).train(sentences, total_examples=total_examples, total_words=total_words,epochs=epochs, start_alpha=start_alpha, end_alpha=end_alpha,word_count=word_count,queue_factor=queue_factor, report_delay=report_delay,compute_loss=compute_loss, callbacks=callbacks)def score(self, sentences, total_sentences=int(1e6), chunksize=100, queue_factor=2,report_delay=1):"""Score the log probability for a sequence of sentences.This does not change the fitted model in any way (see :meth:`~gensim.models.word2vec.Word2Vec.train` for that).Gensim has currently only implemented score for the hierarchical softmax scheme,so you need to have run word2vec with `hs=1` and `negative=0` for this to work.Note that you should specify `total_sentences`; you'll run into problems if you ask toscore more than this number of sentences but it is inefficient to set the value too high.See the `article by Matt Taddy: "Document Classification by Inversion of DistributedLanguage Representations"</pdf/1504.07295.pdf>`_ and the`gensim demo <https://github.com/piskvorky/gensim/blob/develop/docs/notebooks/dee pir.ipynb>`_ for examples ofhow to use such scores in document classification.Parameters----------sentences : iterable of list of strThe `sentences` iterable can be simply a list of lists of tokens, but for larger corpora,consider an iterable that streams the sentences directly from disk/network.See :class:`~gensim.models.word2vec.BrownCorpus`, :class:` ~gensim.models.word2vec.Text8Corpus`or :class:`~gensim.models.word2vec.LineSentence` in :mod:`~gensim.models.word2vec` module for such examples.total_sentences : int, optionalCount of sentences.chunksize : int, optionalChunksize of jobsqueue_factor : int, optionalMultiplier for size of queue (number of workers * queue_factor).report_delay : float, optionalSeconds to wait before reporting progress."""if FAST_VERSION < 0:warnings.warn("C extension compilation failed, scoring will be slow. ""Install a C compiler and reinstall gensim for fastness.")("scoring sentences with %i workers on %i vocabulary and %i features, ""using sg=%s hs=%s sample=%s and negative=%s",self.workers, len(self.wv.vocab), yer1_size, self.sg, self.hs, self.vocabulary.sample, self.negative)if not self.wv.vocab:raise RuntimeError("you must first build vocabulary before scoring new data")if not self.hs:raise RuntimeError("We have currently only implemented score for the hierarchical softmax scheme, ""so you need to have run word2vec with hs=1 and negative=0 for this to work.")def worker_loop():"""Compute log probability for each sentence, lifting lists of sentences from the jobsqueue."""work = zeros(1, dtype=REAL) # for sg hs, we actually only need one memory loc(running sum)neu1 = matutils.zeros_aligned(yer1_size, dtype=REAL)while True:job = job_queue.get()if job is None: # signal to finishbreakns = 0for sentence_id, sentence in job:if sentence_id >= total_sentences:breakif self.sg:score = score_sentence_sg(self, sentence, work)else:score = score_sentence_cbow(self, sentence, work, neu1)sentence_scores[sentence_id] = scorens += 1progress_queue.put(ns) # report progressstart, next_report = default_timer(), 1.0 # buffer ahead only a limited number of jobs..this is the reason we can't simply use ThreadPool :(job_queue = Queue(maxsize=queue_factor * self.workers)progress_queue = Queue(maxsize=(queue_factor + 1) * self.workers)workers = [threading.Thread(target=worker_loop) for _ in xrange(self.workers)]for thread in workers:thread.daemon = True # make interrupting the process with ctrl+c easierthread.start()sentence_count = 0sentence_scores = matutils.zeros_aligned(total_sentences, dtype=REAL)push_done = Falsedone_jobs = 0jobs_source = enumerate(utils.grouper(enumerate(sentences), chunksize)) # fill jobs queue with (id, sentence) job itemswhile True:try:job_no, items = next(jobs_source)if (job_no - 1) * chunksize > total_sentences:logger.warning("terminating after %i sentences (set higher total_sentences if youwant more).", total_sentences)job_no -= 1raise StopIteration()logger.debug("putting job #%i in the queue", job_no)job_queue.put(items)except StopIteration:("reached end of input; waiting to finish %i outstanding jobs", job_no -done_jobs + 1)for _ in xrange(self.workers):job_queue.put(None) # give the workers heads up that they can finish -- no morework!push_done = Truetry:while done_jobs < (job_no + 1) or not push_done:ns = progress_queue.get(push_done) # only block after all jobs pushedsentence_count += nsdone_jobs += 1elapsed = default_timer() - startif elapsed >= next_report:("PROGRESS: at %.2f%% sentences, %.0f sentences/s", 100.0 *sentence_count, sentence_count / elapsed)next_report = elapsed + report_delay # don't flood log, wait report_delaysecondselse:break # loop ended by job count; really doneexcept Empty:pass # already out of loop; continue to next pushelapsed = default_timer() - startself.clear_sims()("scoring %i sentences took %.1fs, %.0f sentences/s", sentence_count,elapsed, sentence_count / elapsed)return sentence_scores[:sentence_count]def clear_sims(self):"""Remove all L2-normalized word vectors from the model, to free up memory.You can recompute them later again using the :meth:`~gensim.models.word2vec.Word2Vec.init_sims` method."""self.wv.vectors_norm = Nonedef intersect_word2vec_format(self, fname, lockf=0.0, binary=False, encoding='utf8',unicode_errors='strict'):"""Merge in an input-hidden weight matrix loaded from the original C word2vec-toolformat,where it intersects with the current vocabulary.No words are added to the existing vocabulary, but intersecting words adopt the file'sweights, andnon-intersecting words are left alone.Parameters----------fname : strThe file path to load the vectors from.lockf : float, optionalLock-factor value to be set for any imported word-vectors; thedefault value of 0.0 prevents further updating of the vector during subsequenttraining. Use 1.0 to allow further training updates of merged vectors.binary : bool, optionalIf True, `fname` is in the binary word2vec C format.encoding : str, optionalEncoding of `text` for `unicode` function (python2 only).unicode_errors : str, optionalError handling behaviour, used as parameter for `unicode` function (python2 only)."""overlap_count = 0("loading projection weights from %s", fname)with utils.smart_open(fname) as fin:header = utils.to_unicode(fin.readline(), encoding=encoding) vocab_size, vector_size = (int(x) for x in header.split()) # throws for invalid file formatif not vector_size == self.wv.vector_size:raise ValueError("incompatible vector size %d in file %s" % (vector_size, fname)) #TOCONSIDER: maybe mismatched vectors still useful enough to merge (truncating/padding)?if binary:binary_len = dtype(REAL).itemsize * vector_sizefor _ in xrange(vocab_size): # mixed text and binary: read text first, then binaryword = []while True:ch = fin.read(1)if ch == b' ':breakif ch != b'\n': # ignore newlines in front of words (some binary files have)word.append(ch)word = utils.to_unicode(b''.join(word), encoding=encoding, errors=unicode_errors)weights = fromstring(fin.read(binary_len), dtype=REAL)if word in self.wv.vocab:overlap_count += 1self.wv.vectors[self.wv.vocab[word].index] = weightsself.trainables.vectors_lockf[self.wv.vocab[word].index] = lockf # lock-factor: 0.0=no changeselse:for line_no, line in enumerate(fin):parts = utils.to_unicode(line.rstrip(), encoding=encoding, errors=unicode_errors).split(" ")if len(parts) != vector_size + 1:raise ValueError("invalid vector on line %s (is this really the text format?)" %line_no)word, weights = parts[0], [REAL(x) for x in parts[1:]]if word in self.wv.vocab:overlap_count += 1self.wv.vectors[self.wv.vocab[word].index] = weightsself.trainables.vectors_lockf[self.wv.vocab[word].index] = lockf # lock-factor: 0.0=no changes("merged %d vectors into %s matrix from %s", overlap_count, self.wv.vectors.shape, fname)@deprecated("Method will be removed in 4.0.0, use self.wv.__getitem__() instead")def __getitem__(self, words):"""Deprecated. Use `self.wv.__getitem__` instead.Refer to the documentation for :meth:`~gensim.models.keyedvectors.Word2VecKeyedVectors.__getitem__`."""return self.wv.__getitem__(words)@deprecated("Method will be removed in 4.0.0, use self.wv.__contains__() instead")def __contains__(self, word):"""Deprecated. Use `self.wv.__contains__` instead.Refer to the documentation for :meth:`~gensim.models.keyedvectors.Word2VecKeyedVectors.__contains__`."""return self.wv.__contains__(word)def predict_output_word(self, context_words_list, topn=10): """Get the probability distribution of the center word given context words.Parameters----------context_words_list : list of strList of context words.topn : int, optionalReturn `topn` words and their probabilities.Returns-------list of (str, float)`topn` length list of tuples of (word, probability)."""if not self.negative:raise RuntimeError("We have currently only implemented predict_output_word for the negativesampling scheme, ""so you need to have run word2vec with negative > 0 for this to work.")if not hasattr(self.wv, 'vectors') or not hasattr(self.trainables, 'syn1neg'):raise RuntimeError("Parameters required for predicting the output words not found.")word_vocabs = [self.wv.vocab[w] for w in context_words_list if w in self.wv.vocab]if not word_vocabs:warnings.warn("All the input context words are out-of-vocabulary for the currentmodel.")return Noneword2_indices = [word.index for word in word_vocabs]l1 = np_sum(self.wv.vectors[word2_indices], axis=0)if word2_indices and self.cbow_mean:l1 /= len(word2_indices)# propagate hidden -> output and take softmax to get probabilitiesprob_values = exp(dot(l1, self.trainables.syn1neg.T))prob_values /= sum(prob_values)top_indices = matutils.argsort(prob_values, topn=topn, reverse=True) # returning themost probable output words with their probabilitiesreturn [(self.wv.index2word[index1], prob_values[index1]) for index1 in top_indices]def init_sims(self, replace=False):"""Deprecated. Use `self.wv.init_sims` instead.See :meth:`~gensim.models.keyedvectors.Word2VecKeyedV ectors.init_sims`."""if replace and hasattr(self.trainables, 'syn1'):del self.trainables.syn1return self.wv.init_sims(replace)def reset_from(self, other_model):"""Borrow shareable pre-built structures from `other_model` and reset hidden layerweights.Structures copied are:* Vocabulary* Index to word mapping* Cumulative frequency table (used for negative sampling) * Cached corpus lengthUseful when testing multiple models on the same corpus in parallel.Parameters----------other_model : :class:`~gensim.models.word2vec.Word2Vec` Another model to copy the internal structures from."""self.wv.vocab = other_model.wv.vocabself.wv.index2word = other_model.wv.index2wordself.vocabulary.cum_table = other_model.vocabulary.cum_tableself.corpus_count = other_model.corpus_countself.trainables.reset_weights(self.hs, self.negative, self.wv)@staticmethoddef log_accuracy(section):"""Deprecated. Use `self.wv.log_accuracy` instead.See :meth:`~gensim.models.word2vec.Word2VecKeyedVect ors.log_accuracy`."""return Word2VecKeyedVectors.log_accuracy(section)@deprecated("Method will be removed in 4.0.0, useself.wv.evaluate_word_analogies()instead")def accuracy(self, questions, restrict_vocab=30000, most_similar=None,case_insensitive=True):"""Deprecated. Use `self.wv.accuracy` instead.See :meth:`~gensim.models.word2vec.Word2VecKeyedVect ors.accuracy`."""most_similar = most_similar or Word2VecKeyedVectors.most_similarreturn self.wv.accuracy(questions, restrict_vocab, most_similar, case_insensitive)def __str__(self):"""Human readable representation of the model's state.Returns-------strHuman readable representation of the model's state, including the vocabulary size,vector sizeand learning rate."""return "%s(vocab=%s, size=%s, alpha=%s)" % (self.__class__.__name__, len(self.wv.index2word), self.wv.vector_size, self.alpha)。

词向量概念

词向量概念定义词向量(word vector)是将词语表示为实数向量的一种方法。

它通过将每个词映射到一个高维空间中的向量,使得具有相似语义的词在空间中距离较近。

这种表示方式可以捕捉到词语之间的关联性和语义信息,为自然语言处理任务提供了基础。

重要性1.解决稀疏性问题:传统的文本表示方法,如one-hot编码,会将每个词表示为一个独立的向量,导致维度过高且稀疏。

而词向量可以将高维稀疏的表示转换为低维稠密的表示,更好地捕捉了词语之间的关系。

2.提供了语义信息:通过训练模型得到的词向量,可以反映出词汇之间的相似性和关联性。

例如,在训练好的模型中,“king”和”queen”、“man”和”woman”之间的距离应该是相近的。

这样一来,在进行自然语言处理任务时,可以利用这些语义信息来提升模型性能。

3.降低计算复杂度:使用词向量能够减少计算的复杂度。

在传统的文本表示方法中,计算两个向量之间的相似度需要进行高维向量的点积运算,而使用词向量后,可以通过计算两个低维向量之间的距离来评估其相似性,大大降低了计算复杂度。

应用词向量在自然语言处理领域有着广泛的应用。

1. 文本分类在文本分类任务中,词向量可以作为输入特征,帮助模型捕捉文本中的语义信息。

通过将文本中每个词映射为对应的词向量,并将这些词向量进行平均或拼接操作,可以得到一个固定长度的特征表示。

这样一来,就可以使用传统机器学习算法或深度学习模型对文本进行分类。

2. 语义相似度计算词向量能够衡量两个词之间的语义相似度。

通过计算两个词向量之间的距离(如欧氏距离、余弦相似度等),可以评估出它们之间的相似程度。

这在机器翻译、问答系统等任务中非常有用。

3. 命名实体识别命名实体识别是指从文本中识别出具有特定意义的实体,如人名、地名、组织机构等。

利用词向量可以提取出实体的上下文信息,并通过训练模型来进行命名实体识别。

4. 情感分析情感分析是指对文本进行情感倾向性分类,如判断一段评论是正面还是负面的。

doc2vec原理

Doc2Vec原理解析1. 引言Doc2Vec是一种用于将文本转换为向量表示的算法,它是Word2Vec的扩展。

Word2Vec算法将单词映射为固定长度的向量,而Doc2Vec则将整个文档映射为向量。

Doc2Vec广泛应用于文本分类、信息检索、推荐系统等领域。

2. Word2Vec回顾在介绍Doc2Vec之前,我们先回顾一下Word2Vec的基本原理。

Word2Vec是一种用于学习单词向量表示的算法,它有两个变体:CBOW(Continuous Bag of Words)和Skip-gram。

2.1 CBOW模型CBOW模型通过上下文预测中心词。

假设我们有一个句子”the cat sat on the mat”,我们希望通过上下文”the”, “sat”, “on”, “mat”来预测中心词”cat”。

CBOW模型的目标是最大化给定上下文条件下中心词的概率。

具体来说,CBOW模型将上下文中的单词向量进行平均,并通过一个全连接层将其转换为中心词的预测向量。

然后使用softmax函数计算预测向量对应每个单词的概率分布,并最大化实际中心词的概率。

2.2 Skip-gram模型Skip-gram模型与CBOW相反,它通过中心词预测上下文。

假设我们有一个句子”the cat sat on the mat”,我们希望通过中心词”cat”来预测上下文”the”, “sat”, “on”, “mat”。

Skip-gram模型的目标是最大化给定中心词条件下上下文单词的概率。

具体来说,Skip-gram模型将中心词向量通过一个全连接层转换为预测向量,并使用softmax函数计算预测向量对应每个上下文单词的概率分布。

然后最大化实际上下文单词的概率。

3. Doc2Vec原理Doc2Vec是Word2Vec的扩展,它不仅可以学习单词向量表示,还可以学习整个文档(或段落)的向量表示。

Doc2Vec有两个变体:PV-DM(Paragraph Vector - Distributed Memory)和PV-DBOW(Paragraph Vector - Distributed Bag of Words)。

英文词向量模型

英文词向量模型

英文词向量模型是一种基于机器学习的自然语言处理技术,用于

将英文单词转化为数学向量。

它可以帮助计算机理解单词之间的语义

关系,从而优化文本分类、推荐系统、信息检索以及其他相关领域的

应用。

英文词向量模型常用的算法有Word2Vec和GloVe。

这些算法都是

基于分布式假设,即单词的含义与其上下文密切相关。

因此,词向量

模型可以通过学习单词在上下文中的分布来构建单词的向量表示。

在

这些向量空间中,具有相似含义的单词之间的距离更接近,从而提高

了机器学习模型的性能。

例如,使用词向量模型可以将“king”和“queen”之间的关系表

示为“man”和“woman”之间的关系,因为它们在语义上是相似的。

这种模型还可以挖掘出单词之间的隐含关系,例如将“cat”和“dog”之间的关系表示为“pet”和“animal”之间的关系。

总之,英文词向量模型是一个强大的自然语言处理技术,可以帮

助计算机更好地理解单词之间的关系,并提高机器学习模型的性能。