统计redo每天每小时切换频率

oracle19c redolog 切换机制

oracle19c redolog 切换机制标题:Oracle 19c Redo日志切换机制:解析与实施步骤引言Redo日志是Oracle数据库系统中非常重要的组成部分,它记录了对数据库进行的重要操作,以便在发生故障时进行恢复。

在Oracle 19c版本中,改进了Redo 日志的性能和稳定性,并提供了一种新的Redo日志切换机制。

本文将逐步探讨Oracle 19c Redo日志切换机制的实施步骤,帮助读者更好地理解和使用这一功能。

1. Redo日志简介Redo日志是Oracle数据库的重要组成部分,它记录了数据库的变更操作,以便在发生故障时进行恢复。

Redo日志包含了数据库中发生的所有变更操作,例如插入、更新和删除操作,以及对索引和表空间的结构修改等。

通过不断地刷新Redo日志,Oracle数据库确保了数据的持久性和一致性。

2. Oracle 19c Redo日志切换机制的意义在之前的Oracle版本中,Redo日志切换是依靠日志组中的日志序列号的连续递增来实现的。

当当前日志组快要用完时,Oracle会自动切换到下一个可用的日志组并递增日志序列号。

然而,在高负载的数据库环境中,频繁的Redo日志切换可能导致性能下降,因为切换操作会引起额外的IO开销。

为了解决这个问题,Oracle 19c引入了新的Redo日志切换机制,该机制可以根据数据库的负载情况来进行切换,以最小化额外的IO开销。

这个新机制将在下面的步骤中详细解释。

3. 步骤一:启用自动切换在Oracle 19c中,需要先启用自动切换功能才能使用新的Redo日志切换机制。

可以通过以下命令启用自动切换:ALTER DATABASE ENABLE THREAD SPIN这个命令会开启一个线程监控数据库的负载情况,并在必要时触发Redo日志的切换。

4. 步骤二:配置自动切换的阈值在默认情况下,Oracle 19c使用了一组预定义的阈值来监控数据库的负载情况,然后触发Redo日志的切换。

归档大小日志计算

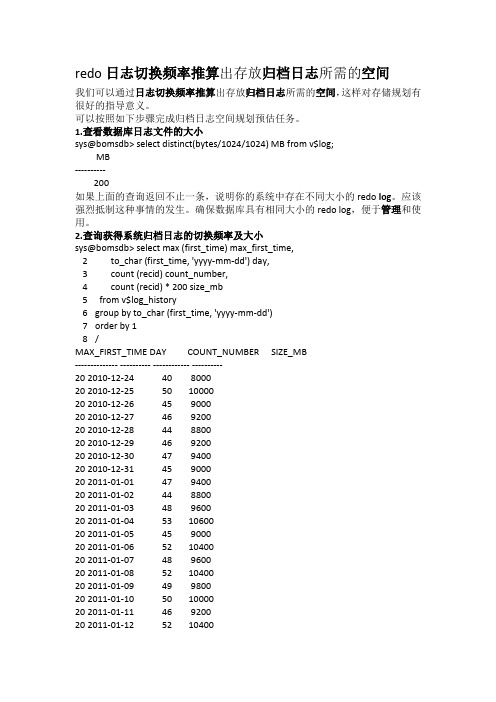

redo日志切换频率推算出存放归档日志所需的空间我们可以通过日志切换频率推算出存放归档日志所需的空间,这样对存储规划有很好的指导意义。

可以按照如下步骤完成归档日志空间规划预估任务。

1.查看数据库日志文件的大小sys@bomsdb> select distinct(bytes/1024/1024) MB from v$log;MB----------200如果上面的查询返回不止一条,说明你的系统中存在不同大小的redo log。

应该强烈抵制这种事情的发生。

确保数据库具有相同大小的redo log,便于管理和使用。

2.查询获得系统归档日志的切换频率及大小sys@bomsdb> select max (first_time) max_first_time,2 to_char (first_time, 'yyyy-mm-dd') day,3 count (recid) count_number,4 count (recid) * 200 size_mb5 from v$log_history6 group by to_char (first_time, 'yyyy-mm-dd')7 order by 18 /MAX_FIRST_TIME DAY COUNT_NUMBER SIZE_MB-------------- ---------- ------------ ----------20 2010-12-24 40 800020 2010-12-25 50 1000020 2010-12-26 45 900020 2010-12-27 46 920020 2010-12-28 44 880020 2010-12-29 46 920020 2010-12-30 47 940020 2010-12-31 45 900020 2011-01-01 47 940020 2011-01-02 44 880020 2011-01-03 48 960020 2011-01-04 53 1060020 2011-01-05 45 900020 2011-01-06 52 1040020 2011-01-07 48 960020 2011-01-08 52 1040020 2011-01-09 49 980020 2011-01-10 50 1000020 2011-01-11 46 920020 2011-01-12 52 1040020 2011-01-13 53 1060020 2011-01-14 48 960020 2011-01-15 51 1020020 2011-01-16 49 980024 rows selected.从上面的统计结果可以知道,每天的归档情况比较一致,说明业务的压力比较平均。

损坏数据文件的恢复方法

损坏数据文件的恢复方法一:非归档模式下丢失或者损坏数据文件A:OS备份恢复方案在非归档模式下损坏或者丢失数据文件,如果有相应的备份,在一定程度上是可以恢复的,但是如果oracle过多的读写操作记录信息而导致redo重写的时候,恢复就会停滞,非归档下系统能自动恢复的仅仅限于redo中存在的记录。

可以成功恢复案例:SQL> startupORACLE instance started.Total System Global Area 235999352 bytesFixed Size 450680 bytesVariable Size 201326592 bytesDatabase Buffers 33554432 bytesRedo Buffers 667648 bytesDatabase mounted.Database openedSQL> create table test(a int);Table created.SQL> insert into test values(1);1 row created.SQL> /1 row created.SQL> /1 row created.SQL> /1 row created.SQL> commit;Commit complete.SQL> exit;[oracle@www oradata]$ cd cicro/[oracle@www cicro]$ lscontrol01.ctl cwmlite01.dbf indx01.dbf redo02.log temp01.dbfusers01.dbf control02.ctl drsys01.dbf odm01.dbf redo03.logtools01.dbf xdb01.dbf control03.ctl example01.dbf redo01.log system01.dbf undotbs01.dbf[oracle@www cicro]$ pwd/opt/oracle/oradata/cicro[oracle@www cicro]$ sqlplus "/as sysdba"SQL> shutdown immediateDatabase closed.Database dismounted.ORACLE instance shut down.SQL>exit;[oracle@www cicro]$ cp ./*.dbf ../[oracle@www cicro]$ sqlplus "/as sysdba"SQL*Plus: Release 9.2.0.1.0 - Production on Tue Jul 25 19:44:31 2006 Copyright (c) 1982, 2002, Oracle Corporation. All rights reserved. Connected to:Oracle9i Release 9.2.0.1.0 - ProductionJServer Release 9.2.0.1.0 – ProductionConnected to an idle instance.SQL> startupORACLE instance started.Total System Global Area 235999352 bytesFixed Size 450680 bytesVariable Size 201326592 bytesDatabase Buffers 33554432 bytesRedo Buffers 667648 bytesDatabase mounted.Database opened.SQL> insert into test values(3333);1 row created.SQL> /1 row created.SQL> /1 row created.SQL> /1 row created.SQL> commit;Commit complete.SQL> select * from test;A----------1113333333333338 rows selected.SQL> shutdown immediateDatabase closed.Database dismounted.ORACLE instance shut down.SQL>exit;[oracle@www cicro]$ rm –rf ./*.dbf[oracle@www cicro]$ sqlplus "/as sysdba"Copyright (c) 1982, 2002, Oracle Corporation. All rights reserved.Connected to an idle instance.SQL> startupORACLE instance started.Total System Global Area 235999352 bytesFixed Size 450680 bytes技术社区Variable Size 201326592 bytesDatabase Buffers 33554432 bytesRedo Buffers 667648 bytesDatabase mounted.ORA-01157: cannot identify/lock data file 1 - see DBWR trace fileORA-01110: data file 1: '/opt/oracle/oradata/cicro/system01.dbf'SQL> quit[oracle@www cicro]$ mv ../*.dbf .[oracle@www cicro]$ lscontrol01.ctl cwmlite01.dbf indx01.dbf redo02.log temp01.dbf users01.dbf control02.ctl drsys01.dbf odm01.dbf redo03.log tools01.dbf xdb01.dbf control03.ctl example01.dbf redo01.log system01.dbf undotbs01.dbf[oracle@www cicro]$ sqlplus "/as sysdba"SQL*Plus: Release 9.2.0.1.0 - Production on Tue Jul 25 17:56:06 2006Copyright (c) 1982, 2002, Oracle Corporation. All rights reserved.Connected to:Oracle9i Release 9.2.0.1.0 - ProductionJServer Release 9.2.0.1.0 - ProductionSQL> recover database;Media recovery complete.SQL> alter database open;Database altered.SQL> select * from test;A----------111333333333333333333338 rows selected.至此,恢复成功!不完全恢复的案例基本操作与上面相同,还是首先建立一张表,然后插入数据:1:建表,写入数据,然后关闭数据库SQL> create table gaojf1 as select * from all_objects;T able created.SQL> insert into gaojf1 select * from gaojf1;29614 rows created.SQL> /59228 rows created. (即为现在此表数据有118456列)SQL>commit;SQL>shutdown immediate2:备份所有的数据文件3:启动数据库继续插入数据[oracle@www cicro]$ sqlplus "/as sysdba"SQL*Plus: Release 9.2.0.1.0 - Production on Tue Jul 25 18:07:19 2006 Copyright (c) 1982, 2002, Oracle Corporation.Connected to:Oracle9i Release 9.2.0.1.0 - ProductionJServer Release 9.2.0.1.0 - ProductionSQL> insert into gaojf1 select * from gaojf1;118456 rows created.SQL> /236912 rows created.SQL> /473824 rows created.SQL> /947648 rows created.SQL> commit;Commit complete.SQL> select count(*) from gaojf1;COUNT(*)----------1895296SQL> /1895296 rows created.SQL> /技术社区3790592 rows created.(如果能够完全恢复,此表应该有3790592*2列)SQL> commit;Commit complete.期间,查看日志信息如下:Wed Jul 26 13:02:54 2006Thread 1 opened at log sequence 1Current log# 3 seq# 1 mem# 0: /opt/oracle/oradata/cicro/redo03.log Successful open of redo thread 1.Wed Jul 26 13:03:56 2006Thread 1 advanced to log sequence 2Current log# 1 seq# 2 mem# 0: /opt/oracle/oradata/cicro/redo01.logWed Jul 26 13:05:41 2006Thread 1 advanced to log sequence 3Current log# 2 seq# 3 mem# 0: /opt/oracle/oradata/cicro/redo02.logWed Jul 26 13:09:04 2006Thread 1 advanced to log sequence 4Current log# 3 seq# 4 mem# 0: /opt/oracle/oradata/cicro/redo03.logWed Jul 26 13:09:29 2006Thread 1 advanced to log sequence 5Current log# 1 seq# 5 mem# 0: /opt/oracle/oradata/cicro/redo01.log 可以看到,redo文件在不断的循环重写,当一个redo写完后继续写第二个redo,然后是第三个,当第三个写完后继续回来重写第一个,依此类推。

Oracle工作总结日志文件切换频率的调整

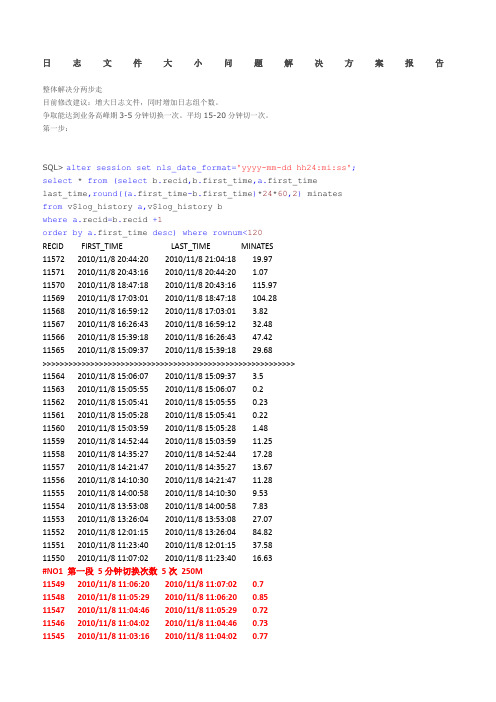

O r a c l e工作总结日志文件切换频率的调整Revised final draft November 26, 2020日志文件大小问题解决方案报告整体解决分两步走目前修改建议:增大日志文件,同时增加日志组个数。

争取能达到业务高峰期3-5分钟切换一次。

平均15-20分钟切一次。

第一步:SQL> alter session set nls_date_format='yyyy-mm-dd hh24:mi:ss';select * from(select,, last_time,round( minatesfrom v$log_history a,v$log_history bwhere=+1order by desc)where rownum<120RECID FIRST_TIME LAST_TIME MINATES11572 2010/11/8 20:44:20 2010/11/8 21:04:1811571 2010/11/8 20:43:16 2010/11/8 20:44:2011570 2010/11/8 18:47:18 2010/11/8 20:43:1611569 2010/11/8 17:03:01 2010/11/8 18:47:1811568 2010/11/8 16:59:12 2010/11/8 17:03:0111567 2010/11/8 16:26:43 2010/11/8 16:59:1211566 2010/11/8 15:39:18 2010/11/8 16:26:4311565 2010/11/8 15:09:37 2010/11/8 15:39:18 >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>11564 2010/11/8 15:06:07 2010/11/8 15:09:3711563 2010/11/8 15:05:55 2010/11/8 15:06:0711562 2010/11/8 15:05:41 2010/11/8 15:05:5511561 2010/11/8 15:05:28 2010/11/8 15:05:4111560 2010/11/8 15:03:59 2010/11/8 15:05:2811559 2010/11/8 14:52:44 2010/11/8 15:03:5911558 2010/11/8 14:35:27 2010/11/8 14:52:4411557 2010/11/8 14:21:47 2010/11/8 14:35:2711556 2010/11/8 14:10:30 2010/11/8 14:21:4711555 2010/11/8 14:00:58 2010/11/8 14:10:3011554 2010/11/8 13:53:08 2010/11/8 14:00:5811553 2010/11/8 13:26:04 2010/11/8 13:53:0811552 2010/11/8 12:01:15 2010/11/8 13:26:0411551 2010/11/8 11:23:40 2010/11/8 12:01:1511550 2010/11/8 11:07:02 2010/11/8 11:23:40#NO1 第一段 5分钟切换次数 5次 250M11549 2010/11/8 11:06:20 2010/11/8 11:07:0211548 2010/11/8 11:05:29 2010/11/8 11:06:2011547 2010/11/8 11:04:46 2010/11/8 11:05:2911546 2010/11/8 11:04:02 2010/11/8 11:04:4611545 2010/11/8 11:03:16 2010/11/8 11:04:02####################################################11543 2010/11/8 11:00:49 2010/11/8 11:01:4411542 2010/11/8 10:58:28 2010/11/8 11:00:4911541 2010/11/8 10:51:54 2010/11/8 10:58:2811540 2010/11/8 10:34:17 2010/11/8 10:51:5411539 2010/11/8 10:08:00 2010/11/8 10:34:1711538 2010/11/8 9:50:53 2010/11/8 10:08:0011537 2010/11/8 9:37:23 2010/11/8 9:50:5311536 2010/11/8 9:27:48 2010/11/8 9:37:2311535 2010/11/8 9:14:02 2010/11/8 9:27:4811534 2010/11/8 8:50:34 2010/11/8 9:14:0211533 2010/11/8 8:15:57 2010/11/8 8:50:3411532 2010/11/8 7:28:49 2010/11/8 8:15:5711531 2010/11/8 7:28:42 2010/11/8 7:28:49 >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>11530 2010/11/8 4:30:51 2010/11/8 7:28:4211529 2010/11/8 1:56:31 2010/11/8 4:30:5111528 2010/11/7 22:14:14 2010/11/8 1:56:3111527 2010/11/7 18:21:21 2010/11/7 22:14:1411526 2010/11/7 16:05:22 2010/11/7 18:21:2111525 2010/11/7 14:32:28 2010/11/7 16:05:2211524 2010/11/7 13:47:08 2010/11/7 14:32:28 >>>>>>>>>>>>>>>>>>>>>>>>>> 段落2>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>> # NO2 这一段最为频繁开始时间 13:47:08 截止时间 13:42分#切换次数 12次 600M11523 2010/11/7 13:46:11 2010/11/7 13:47:0811522 2010/11/7 13:45:38 2010/11/7 13:46:1111521 2010/11/7 13:45:11 2010/11/7 13:45:3811520 2010/11/7 13:44:38 2010/11/7 13:45:1111519 2010/11/7 13:44:16 2010/11/7 13:44:3811518 2010/11/7 13:43:56 2010/11/7 13:44:1611517 2010/11/7 13:43:34 2010/11/7 13:43:5611516 2010/11/7 13:43:13 2010/11/7 13:43:3411515 2010/11/7 13:42:52 2010/11/7 13:43:1311514 2010/11/7 13:42:31 2010/11/7 13:42:5211513 2010/11/7 13:42:07 2010/11/7 13:42:3111512 2010/11/7 13:41:43 2010/11/7 13:42:07############################################################NO 3开始时间 13:41:43 截止时间 13:36分#切换次数 11次 550M11511 2010/11/7 13:41:19 2010/11/7 13:41:4311510 2010/11/7 13:40:58 2010/11/7 13:41:1911509 2010/11/7 13:40:34 2010/11/7 13:40:5811508 2010/11/7 13:40:01 2010/11/7 13:40:3411507 2010/11/7 13:39:25 2010/11/7 13:40:0111505 2010/11/7 13:38:01 2010/11/7 13:38:3411504 2010/11/7 13:37:07 2010/11/7 13:38:0111503 2010/11/7 13:36:37 2010/11/7 13:37:0711502 2010/11/7 13:35:42 2010/11/7 13:36:3711501 2010/11/7 13:34:54 2010/11/7 13:35:42########################################################### ## NO 3开始时间 13:34:54 截止时间 13:29分#切换次数 9次 450M11500 2010/11/7 13:34:06 2010/11/7 13:34:5411499 2010/11/7 13:33:07 2010/11/7 13:34:0611498 2010/11/7 13:32:36 2010/11/7 13:33:0711497 2010/11/7 13:32:12 2010/11/7 13:32:3611496 2010/11/7 13:31:42 2010/11/7 13:32:1211495 2010/11/7 13:30:51 2010/11/7 13:31:4211494 2010/11/7 13:30:12 2010/11/7 13:30:5111493 2010/11/7 13:29:12 2010/11/7 13:30:12 1 11492 2010/11/7 13:27:49 2010/11/7 13:29:12######################################################### 11491 2010/11/7 13:27:19 2010/11/7 13:27:4911490 2010/11/7 13:26:54 2010/11/7 13:27:1911489 2010/11/7 13:26:27 2010/11/7 13:26:5411488 2010/11/7 13:24:09 2010/11/7 13:26:2711487 2010/11/7 13:23:28 2010/11/7 13:24:0911486 2010/11/7 13:22:51 2010/11/7 13:23:2811485 2010/11/7 13:22:21 2010/11/7 13:22:5111484 2010/11/7 13:21:53 2010/11/7 13:22:2111483 2010/11/7 13:21:27 2010/11/7 13:21:5311482 2010/11/7 13:20:54 2010/11/7 13:21:2711481 2010/11/7 13:20:24 2010/11/7 13:20:5411480 2010/11/7 13:19:39 2010/11/7 13:20:2411479 2010/11/7 13:18:53 2010/11/7 13:19:3911478 2010/11/7 13:17:47 2010/11/7 13:18:5311477 2010/11/7 13:16:18 2010/11/7 13:17:4711476 2010/11/7 13:15:02 2010/11/7 13:16:1811475 2010/11/7 13:14:02 2010/11/7 13:15:02 1 11474 2010/11/7 13:12:44 2010/11/7 13:14:0211473 2010/11/7 13:12:05 2010/11/7 13:12:4411472 2010/11/7 13:11:17 2010/11/7 13:12:0511471 2010/11/7 13:10:11 2010/11/7 13:11:1711470 2010/11/7 13:08:56 2010/11/7 13:10:1111469 2010/11/7 13:06:34 2010/11/7 13:08:5611468 2010/11/7 13:05:57 2010/11/7 13:06:3411467 2010/11/7 12:54:39 2010/11/7 13:05:57>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>> >>11466 2010/11/7 11:11:59 2010/11/7 12:54:3911465 2010/11/7 10:06:20 2010/11/7 11:11:5911464 2010/11/7 9:27:05 2010/11/7 10:06:2011463 2010/11/7 8:00:18 2010/11/7 9:27:0511462 2010/11/7 7:10:33 2010/11/7 8:00:1811461 2010/11/7 6:00:49 2010/11/7 7:10:3311460 2010/11/7 2:19:57 2010/11/7 6:00:4911459 2010/11/6 22:51:21 2010/11/7 2:19:5711458 2010/11/6 19:38:41 2010/11/6 22:51:2111457 2010/11/6 18:59:29 2010/11/6 19:38:4111456 2010/11/6 18:47:09 2010/11/6 18:59:2911455 2010/11/6 18:34:33 2010/11/6 18:47:0911454 2010/11/6 17:55:31 2010/11/6 18:34:33查看日志组信息select thread#,group#,sequence#,bytes/1024/1024,members,first_time,status from v$log; THREAD# GROUP# SEQUENCE# BYTES/1024/1024 MEMBERS FIRST_TIME STATUS1 1 11572 50 1 2010/11/8 20:44:20 INACTIVE1 2 11573 50 1 2010/11/8 21:04:18 INACTIVE1 3 11574 50 1 2010/11/8 21:24:20 CURRENT从上述信息可见日志文件仅为50M,对于业务高峰期时数据量很大(全国性数据录入)的环境下显的太小了且是日志组少。

redo log刷盘机制

redo log刷盘机制redo log是数据库系统中的一种重要机制,用于确保数据的持久性和一致性。

它是一种日志文件,用于记录数据库中发生的所有修改操作,包括插入、更新和删除等。

redo log的刷盘机制是指将redo log中的数据写入磁盘的过程,下面将详细介绍redo log刷盘机制的原理和作用。

redo log的刷盘机制是数据库系统中的关键环节之一。

它的主要作用是在数据库发生异常或故障时,能够保证数据的一致性和可靠性。

当数据库系统发生故障或异常宕机时,可以通过redo log来进行数据的恢复和重放操作,从而保证数据库恢复到故障前的状态。

redo log的刷盘机制是通过将redo log中的数据写入磁盘来实现的。

当数据库系统执行一条修改操作时,首先会将该操作记录到redo log中,然后再将该操作应用到内存中的数据页中。

而redo log的刷盘机制则是将redo log中的数据写入磁盘,以保证数据的持久性。

redo log的刷盘机制有两种方式:异步刷盘和同步刷盘。

异步刷盘是指将redo log中的数据先写入磁盘的缓冲区中,然后由后台进程负责将缓冲区中的数据真正写入磁盘。

这种方式的好处是可以提高数据库的性能,因为将数据写入磁盘是比较耗时的操作。

而同步刷盘则是指将redo log中的数据直接写入磁盘,然后再返回给应用程序,只有当数据真正写入磁盘后,应用程序才能继续执行后续的操作。

这种方式的好处是可以保证数据的一致性和可靠性,但是会降低数据库的性能。

在redo log的刷盘过程中,还存在一个重要的参数,即刷盘间隔。

该参数决定了数据库系统将多长时间将redo log中的数据写入磁盘一次。

如果刷盘间隔设置得太短,会频繁地进行刷盘操作,导致数据库的性能下降;而如果刷盘间隔设置得太长,会增加数据丢失的风险。

因此,合理地设置刷盘间隔是非常重要的。

redo log的刷盘机制在数据库系统中起着至关重要的作用。

它可以保证数据库的数据持久性和一致性,提高数据库的可靠性和可用性。

COUNTER中文注释

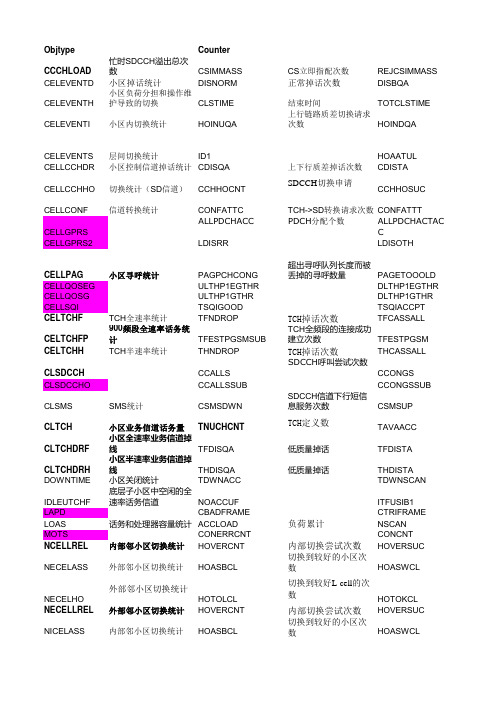

Objtype CounterCCCHLOAD忙时SDCCH溢出总次数CSIMMASS CS立即指配次数REJCSIMMASS CELEVENTD小区掉话统计DISNORM正常掉话次数DISBQACLSTIME结束时间TOTCLSTIME CELEVENTH小区负荷分担和操作维护导HOINDQA CELEVENTI小区内切换统计HOINUQA上行链路质差切换请求次数CELEVENTS层间切换统计ID1HOAATUL CELLCCHDR小区控制信道掉话统计CDISQA上下行质差掉话次数CDISTA CELLCCHHO切换统计(SD信道)CCHHOCNT SDCCH切换申请CCHHOSUC CELLCONF信道转换统计CONFATTC TCH->SD转换请求次数CONFATTT CELLGPRS ALLPDCHACC PDCH分配个数ALLPDCHACTAC CELLGPRS2LDISRR LDISOTHCPAGETOOOLD CELLPAG小区寻呼统计PAGPCHCONG超出寻呼队列长度而被丢掉CELLQOSEG ULTHP1EGTHR DLTHP1EGTHR CELLQOSG ULTHP1GTHR DLTHP1GTHR CELLSQI TSQIGOOD TSQIACCPT CELTCHF TCH全速率统计TFNDROP TCH掉话次数TFCASSALLTFESTPGSM CELTCHFP900频段全速率话务统计TFESTPGSMSUB TCH全频段的连接成功建立次数CELTCHH TCH半速率统计THNDROP TCH掉话次数THCASSALL CLSDCCH CCALLS SDCCH呼叫尝试次数CCONGS CLSDCCHO CCALLSSUB CCONGSSUBCSMSUPCLSMS SMS统计CSMSDWN SDCCH信道下行短信息服务次数CLTCH小区业务信道话务量TNUCHCNT TCH定义数TAVAACC CLTCHDRF小区全速率业务信道掉线TFDISQA低质量掉话TFDISTA CLTCHDRH小区半速率业务信道掉线THDISQA低质量掉话THDISTA DOWNTIME小区关闭统计TDWNACC TDWNSCANNOACCUF ITFUSIB1 IDLEUTCHF底层子小区中空闲的全速率LAPD CBADFRAME CTRIFRAME LOAS话务和处理器容量统计ACCLOAD负荷累计NSCANMOTS CONERRCNT CONCNT NCELLREL内部邻小区切换统计HOVERCNT内部切换尝试次数HOVERSUC NECELASS外部邻小区切换统计HOASBCL切换到较好的小区次数HOASWCL NECELHO外部邻小区切换统计HOTOLCL切换到较好L-cell的次数HOTOKCL NECELLREL外部邻小区切换统计HOVERCNT内部切换尝试次数HOVERSUC NICELASS内部邻小区切换统计HOASBCL切换到较好的小区次数HOASWCL NICELHO内部邻小区切换统计HOTOLCL切换到较好L-cell的次数HOTOKCL RANDOMACC随机接入统计CNROCNT随机接入成功次数RAACCFA RNDACCEXT小区扩展的随机接入表RACALR1RACALR2 TRAPEVENT每个转换代码池中转换代码TPACC TPACTTRTRASSYNCFTRASEVENT每个BSC中在临时连接转换代码设备上的转换代码测量TRAFDLGPRS TRAFFDLGPRSSCAN TBFDLGPRS MTRAFTYPE NANSWNBRMSCLST NNBRHBAISDHTOTBSCGPRS PAGCSCONG ALLPDCHPCUATT RLINKBITR INT10BREGPRSTBFPAGING ID MOCS 立即指配拒绝次数PSIMMASS PS 立即指配次数REJPSIMMASS PS 立即指配拒绝次数无线链路质差掉话DISBSS 弱信号掉话DISETA TA 掉话开始时间HOATTLS 切换请求(负荷)HOSUCLS 切换成功次数(负荷下链路质差切换请求次HOINBQA 切换请求次数(上下行质HOINSUC 小区内切换成功次数切换到底层子小区的申HOSUCUL 切换到底层子小区的成功HOAATOL 切换到顶层子小区的TA 掉话次数CDISSS 上下行弱信号掉话次数SDCCH 成功切换次数CCHHOTOCH SDCCH 切换返回到原小区的次数SD->TCH 转换请求次数PDCH 激活次数ALLPDCHPEAK PDCH 最大值ALLPDCHSCA NGPRS 状态扫描次数PSCHREQ PREJTFI 进入寻呼队列,但是仍CFAILULTHP2EGTHR DLTHP2EGTHR ULTHP2GTHR DLTHP2GTHR TSQIBADTCH分配成功次数TFMSESTB TCH占用次数TFCALLS 试呼次数TCH 全频段上的成功建立次数。

redo和undo日志

redo和undo⽇志在数据库系统中,既有存放数据的⽂件,也有存放⽇志的⽂件。

⽇志在内存中也是有缓存Log buffer,也有磁盘⽂件log file,本⽂主要描述存放⽇志的⽂件。

MySQL中的⽇志⽂件,有这么两类常常讨论到:undo⽇志与redo⽇志。

1 undo1.1 undo是啥undo⽇志⽤于存放数据修改被修改前的值,假设修改 tba 表中 id=2的⾏数据,把Name=’B’ 修改为Name = ‘B2’ ,那么undo⽇志就会⽤来存放Name=’B’的记录,如果这个修改出现异常,可以使⽤undo⽇志来实现回滚操作,保证事务的⼀致性。

对数据的变更操作,主要来⾃ INSERT UPDATE DELETE,⽽UNDO LOG中分为两种类型,⼀种是 INSERT_UNDO(INSERT操作),记录插⼊的唯⼀键值;⼀种是 UPDATE_UNDO(包含UPDATE及DELETE操作),记录修改的唯⼀键值以及old column记录。

Id Name1A2B3C4D1.2 undo参数MySQL跟undo有关的参数设置有这些:1 mysql> show global variables like '%undo%';2 +--------------------------+------------+3 | Variable_name | Value |4 +--------------------------+------------+5| innodb_max_undo_log_size |1073741824 |6| innodb_undo_directory | ./ |7| innodb_undo_log_truncate |OFF |8| innodb_undo_logs |128 |9| innodb_undo_tablespaces |3 |10 +--------------------------+------------+1112 mysql> show global variables like '%truncate%';13 +--------------------------------------+-------+14 | Variable_name | Value |15 +--------------------------------------+-------+16| innodb_purge_rseg_truncate_frequency |128 |17| innodb_undo_log_truncate |OFF |18 +--------------------------------------+-------+innodb_max_undo_log_size控制最⼤undo tablespace⽂件的⼤⼩,当启动了innodb_undo_log_truncate 时,undo tablespace 超过innodb_max_undo_log_size 阀值时才会去尝试truncate。

sql server的redo log机制

sql server的redo log机制SQL Server是一种关系型数据库管理系统,它使用事务日志(Redo Log)机制来确保数据库的安全性和持久性。

本文将介绍SQL Server的Redo Log机制,包括它的作用、结构和使用方法。

Redo Log是SQL Server的事务日志,它用于记录数据库的变更操作。

事务是一组操作,要么全部执行,要么全部回滚。

当事务执行时,相关的数据页在内存中进行修改,而不会马上写入磁盘。

相反,SQL Server将这些修改操作记录在Redo Log 中。

Redo Log有两个重要的作用:恢复和故障恢复。

首先,当数据库发生故障或系统崩溃时,Redo Log可以用于恢复数据库到事务提交之后的状态。

其次,当服务器重新启动时,Redo Log可以帮助SQL Server识别并应用在故障之前未能写入磁盘的事务。

Redo Log的结构由多个物理文件组成,这些文件通常被命名为".ldf"后缀。

每个物理文件包含一个或多个虚拟的日志文件,这些虚拟日志文件称为虚拟日志块(Virtual Log Block,简称VLF)。

每个VLF的大小通常是512KB或1MB。

当事务被提交时,相关的修改操作将被写入Redo Log中的一个或多个VLF。

SQL Server使用一个写前日志(Write Ahead Log,简称WAL)策略,即在将数据页中的修改操作写入磁盘之前,先将修改记录写入Redo Log。

这样可以确保数据的持久性,即使系统崩溃,之前未写入磁盘的事务也可以通过Redo Log进行恢复。

除了事务提交时的记录外,Redo Log还会包含其他一些特殊记录,如检查点记录和日志备份记录。

检查点记录用于标记数据库文件的一致性点,以便在发生故障时可以快速恢复。

日志备份记录用于记录在备份数据库日志时的相关信息,以支持数据库级别和日志级别的恢复。

在SQL Server中,可以使用一些特殊的命令和函数来管理Redo Log。

oracle 监控指标告警阈值

oracle 监控指标告警阈值Oracle 监控指标告警阈值是指在Oracle数据库中,设置的一些关键指标的阈值,用于监控数据库的性能和健康状态。

如果这些指标超过或低于设定的阈值,则会触发告警。

正确设置告警阈值可以帮助DBA及时发现潜在的问题,并采取相应的措施来解决。

以下是一些相关的参考内容,用于设置Oracle监控指标的告警阈值:1. 进程相关指标:- 在DBA_USERS视图中跟踪正在运行的会话数(SESSIONS),设置阈值可以确保系统的并发性能不会超过预期,以避免资源争用和性能瓶颈。

- 跟踪当前活跃的并发进程数(PROCESSES),设置阈值可以确保系统的并发连接数不会超出预期范围。

2. 表空间相关指标:- 物理写入数据的速率(PHYSICAL WRITE IO REQUESTS),设置阈值可以确保数据写入磁盘的速度不会超过磁盘的承载能力。

- 数据文件空间使用率(TABLESPACE USAGE),设置阈值可以预测数据文件空间的使用情况,避免因为空间不足导致数据库无法正常运行。

3. 缓冲区相关指标:- 数据库缓冲区的命中率(BUFFER CACHE HIT RATIO),设置阈值可以确保大部分的数据块可以被直接读取,提高数据库的读取性能。

- 缓冲区脏块的比例(BUFFER CACHE DIRTY RATIO),设置阈值可以确保数据库的更新操作可以及时写入磁盘,避免脏数据的堆积。

4. 数据库性能相关指标:- 平均响应时间(AVERAGE RESPONSE TIME),设置阈值可以监测数据库的响应速度,避免超长时间的查询或操作。

- 慢查询比例(SLOW QUERIES RATIO),设置阈值可以监测慢查询的比例,确保数据库的查询操作可以在合理的时间内完成。

5. 日志相关指标:- 日志文件切换频率(LOG SWITCH RATE),设置阈值可以监测日志文件切换的频率,避免频繁的切换导致日志文件无法写入。

sql server的redo log机制

sql server的redo log机制SQL Server 是一种关系型数据库管理系统,它采用了许多不同的日志机制来确保数据的一致性和持久性。

其中之一就是redo log(重做日志)机制。

在本文中,我们将一步一步介绍SQL Server 的redo log 机制,并深入探讨其工作原理和用途。

第一步:理解事务和日志在深入了解redo log 机制之前,我们需要先理解两个重要的概念:事务和日志。

事务是数据库中执行的一组操作单元,它要么完全执行,要么完全回滚。

日志是记录数据库中每个事务的所有操作的一种机制。

日志可以用于恢复数据库,保证数据的一致性和完整性。

第二步:了解redo log 的基本原理redo log 是一种双写缓冲机制,它用于在事务提交之前将对数据库的修改操作先写入日志,然后再将其应用到数据库文件中。

这样,在发生故障时,可以使用redo log 来回滚未提交的事务,或者将已提交的事务重新应用到数据库文件中。

第三步:理解redo log 的结构redo log 主要由两个部分组成:日志记录(log record)和日志文件(log file)。

日志记录包含了对数据库的修改操作,例如插入、更新和删除等。

日志文件是一个循环的环形链表结构,其中按顺序存储了一系列的日志记录。

第四步:探索redo log 的写入流程当一个事务对数据库进行修改时,SQL Server 首先会将相应的日志记录写入内存中的日志缓冲区。

一旦事务提交,这些日志记录就会被落盘到日志文件中。

此外,SQL Server 还会将修改操作应用到数据库文件中,确保数据的一致性和持久性。

第五步:了解redo log 的刷写机制为了提高性能,SQL Server 通常会使用延迟刷写(lazy write)的方式将redo log 中的日志记录写入磁盘。

延迟刷写可以将多个日志记录合并成一个IO 操作,减少磁盘写入的次数,提高写入性能。

此外,SQL Server 还会定期将redo log 中的日志记录刷写到磁盘,以确保数据的持久性。

redis 哨兵切换日志解读

redis 哨兵切换日志解读Redis哨兵是Redis高可用的一种解决方案,通过监控主节点的状态并在主节点宕机时自动将从节点切换为新的主节点,以实现故障转移。

当发生主节点切换时,哨兵会生成一份切换日志,记录切换的详细信息。

以下是对Redis哨兵切换日志的解读:1. 时间戳,切换发生的时间点,以便追踪和记录切换事件的发生顺序。

2. 哨兵ID,标识执行切换操作的哨兵节点的唯一标识符。

在一个哨兵集群中,可能有多个哨兵节点同时监控主节点的状态。

3. 主节点ID,当前主节点的唯一标识符。

在切换发生之前,该节点是Redis集群的主节点。

4. 新主节点ID,切换后的新主节点的唯一标识符。

在切换完成后,该节点将成为新的Redis集群主节点。

5. 前任领导者ID,在切换之前,如果存在一个哨兵节点被选举为领导者,那么该字段记录了领导者的唯一标识符。

领导者负责协调哨兵节点之间的监控和决策。

6. 故障类型,切换发生的原因,可能是主节点故障、网络故障或其他原因。

7. 故障详情,对故障类型的详细描述,帮助管理员了解发生故障的具体原因。

8. 故障节点,发生故障的节点的唯一标识符。

通常是主节点,但也可能是其他从节点。

9. 故障节点IP,发生故障的节点的IP地址。

10. 故障节点端口,发生故障的节点的监听端口。

11. 故障节点运行状态,发生故障的节点在切换之前的运行状态,例如是否在线、是否在提供服务等。

12. 故障节点最后一次心跳时间,发生故障的节点最后一次发送心跳的时间,用于判断节点是否存活。

13. 故障节点下线时间,发生故障的节点被判定为下线的时间,表示节点失去响应的时间点。

14. 切换结果,切换操作的结果,成功或失败。

15. 切换耗时,切换过程所花费的时间,从开始切换到切换完成的时间间隔。

通过解读Redis哨兵切换日志,管理员可以了解到切换发生的时间、切换原因、故障节点的信息以及切换的结果和耗时等重要信息,从而更好地进行故障排查和性能优化。

redo 刷盘策略

redo 刷盘策略

在数据库系统中,Redo日志的刷盘策略是用来决定如何将Redo日志数据

写入磁盘的策略。

主要有两种策略:非延迟刷盘和延迟刷盘。

非延迟刷盘策略,每次事务提交时,都会将Redo日志的数据立即刷写到磁盘中。

这种策略可以保证数据的持久性,即使系统崩溃或意外故障,也能通过Redo日志进行恢复。

但是,由于每次事务提交都需要进行磁盘IO操作,会导致性能降低。

因此,在高并发的数据库系统中,非延迟刷盘的性能可能会成为瓶颈。

延迟刷盘策略,将Redo日志的数据写入磁盘的操作延迟到一定条件下再执行。

具体来说,当Redo日志缓冲区中的数据达到一定大小或者一定时间间隔时,才会将数据刷写到磁盘中。

这种策略可以提高性能,减少频繁的磁盘IO操作,但是也会增加数据丢失的风险。

因为在系统崩溃或意外故障时,

尚未刷写到磁盘的Redo日志数据将会丢失,无法进行恢复。

除了刷盘策略,Redo日志的大小也是需要考虑的因素。

Redo日志的大小

应该能够容纳一次事务所产生的所有修改操作,否则可能会导致频繁的刷盘操作,影响系统的性能。

通常情况下,Redo日志的大小会根据数据库的负

载和性能需求进行调整。

以上内容仅供参考,更多详细信息建议查阅数据库专业书籍或咨询专业技术人员。

时间序列的采样频率

时间序列的采样频率

时间序列的采样频率是指在固定时间间隔内收集数据的频率。

采样频率决定了时间序列数据的粒度和细节程度。

常见的采样频率包括:

年度 (Annual):每年一次,例如年度财务报告。

季度 (Quarterly):每年四次,例如季度财务报告。

月度 (Monthly):每月一次,例如月度销售数据。

周度 (Weekly):每周一次。

日度 (Daily):每天一次,例如每日股票价格。

小时 (Hourly):每小时一次,例如电力消耗数据。

分钟 (Minute):每分钟一次,常用于高频交易数据。

秒级 (Secondly):每秒一次,例如某些实时监控系统。

毫秒 (Millisecond) 和微秒 (Microsecond):在需要极高精度的应用中使用,如科学实验或高频交易。

选择合适的采样频率取决于应用的需求和目的。

例如,对于长期投资策略,可能只关心月度或季度数据,而对于高频交易,可能需要每秒甚至每毫秒的数据。

需要注意的是,当我们改变时间序列的采样频率(例如从日度数据转换为月度数据)时,这通常被称为“重采样”(Resampling)。

重采样可以是向上采样(增加数据频率)或向下采样(减少数据频率)。

element 统计数值 调用频率

element 统计数值调用频率

在计算机编程中,我们经常会遇到需要统计某个元素在数据集中出现的次数的情况。

这种统计数值的操作在实际编程中非常常见,因为它可以帮助我们更好地了解数据的分布情况,进而做出更合理的决策。

在编程语言中,通常会提供一些现成的函数或方法来帮助我们实现统计数值的操作。

比如在Python中,我们可以使用collections模块中的Counter类来统计

列表中各个元素出现的次数。

而在Java中,我们可以利用Map来实现类似的功能。

当然,有时候我们也可以自己编写代码来实现统计数值的功能。

比如,我们可以使用循环遍历数据集,然后利用一个计数器变量来记录每个元素出现的次数。

这种方法虽然比较基础,但在一些特定的场景下也是非常有效的。

除了统计数值,我们还经常需要根据统计结果来进行一些操作。

比如,我们可以找出出现次数最多的元素,或者找出出现次数超过某个阈值的元素。

这种操作可以帮助我们更好地理解数据,或者发现数据中隐藏的规律。

在实际编程中,我们还需要注意一些细节问题。

比如,对于大规模数据集,我们可能需要考虑内存消耗的问题;对于频繁调用统计函数的情况,我们可能需要考虑优化性能。

这些都是在编程过程中需要注意的地方。

总的来说,统计数值是编程中一个非常常见且重要的操作。

通过统计数值,我们可以更好地了解数据,进而做出更准确的决策。

因此,熟练掌握统计数值的方法和技巧对于编程人员来说是非常重要的。

希望大家在日常编程中能够多加练习,提高自己的统计数值能力。

Oracle工作总结——日志文件切换频率的调整

日志文件大小问题解决方案报告整体解决分两步走目前修改建议:增大日志文件,同时增加日志组个数。

争取能达到业务高峰期3-5分钟切换一次。

平均15-20分钟切一次。

第一步:SQL> alter session set nls_date_format='yyyy-mm-dd hh24:mi:ss';select * from(select b.recid,b.first_time,a.first_timelast_time,round((a.first_time-b.first_time)*24*60,2) minatesfrom v$log_history a,v$log_history bwhere a.recid=b.recid +1order by a.first_time desc)where rownum<120RECID FIRST_TIME LAST_TIME MINATES11572 2010/11/8 20:44:20 2010/11/8 21:04:18 19.9711571 2010/11/8 20:43:16 2010/11/8 20:44:20 1.0711570 2010/11/8 18:47:18 2010/11/8 20:43:16 115.9711569 2010/11/8 17:03:01 2010/11/8 18:47:18 104.2811568 2010/11/8 16:59:12 2010/11/8 17:03:01 3.8211567 2010/11/8 16:26:43 2010/11/8 16:59:12 32.4811566 2010/11/8 15:39:18 2010/11/8 16:26:43 47.4211565 2010/11/8 15:09:37 2010/11/8 15:39:18 29.68 >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>11564 2010/11/8 15:06:07 2010/11/8 15:09:37 3.511563 2010/11/8 15:05:55 2010/11/8 15:06:07 0.211562 2010/11/8 15:05:41 2010/11/8 15:05:55 0.2311561 2010/11/8 15:05:28 2010/11/8 15:05:41 0.2211560 2010/11/8 15:03:59 2010/11/8 15:05:28 1.4811559 2010/11/8 14:52:44 2010/11/8 15:03:59 11.2511558 2010/11/8 14:35:27 2010/11/8 14:52:44 17.2811557 2010/11/8 14:21:47 2010/11/8 14:35:27 13.6711556 2010/11/8 14:10:30 2010/11/8 14:21:47 11.2811555 2010/11/8 14:00:58 2010/11/8 14:10:30 9.5311554 2010/11/8 13:53:08 2010/11/8 14:00:58 7.8311553 2010/11/8 13:26:04 2010/11/8 13:53:08 27.0711552 2010/11/8 12:01:15 2010/11/8 13:26:04 84.8211551 2010/11/8 11:23:40 2010/11/8 12:01:15 37.5811550 2010/11/8 11:07:02 2010/11/8 11:23:40 16.63#NO1 第一段5分钟切换次数5次250M11549 2010/11/8 11:06:20 2010/11/8 11:07:02 0.711548 2010/11/8 11:05:29 2010/11/8 11:06:20 0.8511547 2010/11/8 11:04:46 2010/11/8 11:05:29 0.7211546 2010/11/8 11:04:02 2010/11/8 11:04:46 0.7311545 2010/11/8 11:03:16 2010/11/8 11:04:02 0.77####################################################11544 2010/11/8 11:01:44 2010/11/8 11:03:16 1.5311543 2010/11/8 11:00:49 2010/11/8 11:01:44 0.9211542 2010/11/8 10:58:28 2010/11/8 11:00:49 2.3511541 2010/11/8 10:51:54 2010/11/8 10:58:28 6.5711540 2010/11/8 10:34:17 2010/11/8 10:51:54 17.6211539 2010/11/8 10:08:00 2010/11/8 10:34:17 26.2811538 2010/11/8 9:50:53 2010/11/8 10:08:00 17.1211537 2010/11/8 9:37:23 2010/11/8 9:50:53 13.511536 2010/11/8 9:27:48 2010/11/8 9:37:23 9.5811535 2010/11/8 9:14:02 2010/11/8 9:27:48 13.7711534 2010/11/8 8:50:34 2010/11/8 9:14:02 23.4711533 2010/11/8 8:15:57 2010/11/8 8:50:34 34.6211532 2010/11/8 7:28:49 2010/11/8 8:15:57 47.1311531 2010/11/8 7:28:42 2010/11/8 7:28:49 0.12 >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>11530 2010/11/8 4:30:51 2010/11/8 7:28:42 177.8511529 2010/11/8 1:56:31 2010/11/8 4:30:51 154.3311528 2010/11/7 22:14:14 2010/11/8 1:56:31 222.2811527 2010/11/7 18:21:21 2010/11/7 22:14:14 232.8811526 2010/11/7 16:05:22 2010/11/7 18:21:21 135.9811525 2010/11/7 14:32:28 2010/11/7 16:05:22 92.911524 2010/11/7 13:47:08 2010/11/7 14:32:28 45.33 >>>>>>>>>>>>>>>>>>>>>>>>>> 段落2>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>> # NO2 这一段最为频繁开始时间13:47:08 截止时间13:42分#切换次数12次600M11523 2010/11/7 13:46:11 2010/11/7 13:47:08 0.9511522 2010/11/7 13:45:38 2010/11/7 13:46:11 0.5511521 2010/11/7 13:45:11 2010/11/7 13:45:38 0.4511520 2010/11/7 13:44:38 2010/11/7 13:45:11 0.5511519 2010/11/7 13:44:16 2010/11/7 13:44:38 0.3711518 2010/11/7 13:43:56 2010/11/7 13:44:16 0.3311517 2010/11/7 13:43:34 2010/11/7 13:43:56 0.3711516 2010/11/7 13:43:13 2010/11/7 13:43:34 0.3511515 2010/11/7 13:42:52 2010/11/7 13:43:13 0.3511514 2010/11/7 13:42:31 2010/11/7 13:42:52 0.3511513 2010/11/7 13:42:07 2010/11/7 13:42:31 0.411512 2010/11/7 13:41:43 2010/11/7 13:42:07 0.4############################################################NO 3开始时间13:41:43 截止时间13:36分#切换次数11次550M11511 2010/11/7 13:41:19 2010/11/7 13:41:43 0.411510 2010/11/7 13:40:58 2010/11/7 13:41:19 0.3511509 2010/11/7 13:40:34 2010/11/7 13:40:58 0.411508 2010/11/7 13:40:01 2010/11/7 13:40:34 0.5511507 2010/11/7 13:39:25 2010/11/7 13:40:01 0.611505 2010/11/7 13:38:01 2010/11/7 13:38:34 0.5511504 2010/11/7 13:37:07 2010/11/7 13:38:01 0.911503 2010/11/7 13:36:37 2010/11/7 13:37:07 0.511502 2010/11/7 13:35:42 2010/11/7 13:36:37 0.9211501 2010/11/7 13:34:54 2010/11/7 13:35:42 0.8############################################################# NO 3开始时间13:34:54 截止时间13:29分#切换次数9次450M11500 2010/11/7 13:34:06 2010/11/7 13:34:54 0.811499 2010/11/7 13:33:07 2010/11/7 13:34:06 0.9811498 2010/11/7 13:32:36 2010/11/7 13:33:07 0.5211497 2010/11/7 13:32:12 2010/11/7 13:32:36 0.411496 2010/11/7 13:31:42 2010/11/7 13:32:12 0.511495 2010/11/7 13:30:51 2010/11/7 13:31:42 0.8511494 2010/11/7 13:30:12 2010/11/7 13:30:51 0.6511493 2010/11/7 13:29:12 2010/11/7 13:30:12 111492 2010/11/7 13:27:49 2010/11/7 13:29:12 1.38#########################################################11491 2010/11/7 13:27:19 2010/11/7 13:27:49 0.511490 2010/11/7 13:26:54 2010/11/7 13:27:19 0.4211489 2010/11/7 13:26:27 2010/11/7 13:26:54 0.4511488 2010/11/7 13:24:09 2010/11/7 13:26:27 2.311487 2010/11/7 13:23:28 2010/11/7 13:24:09 0.6811486 2010/11/7 13:22:51 2010/11/7 13:23:28 0.6211485 2010/11/7 13:22:21 2010/11/7 13:22:51 0.511484 2010/11/7 13:21:53 2010/11/7 13:22:21 0.4711483 2010/11/7 13:21:27 2010/11/7 13:21:53 0.4311482 2010/11/7 13:20:54 2010/11/7 13:21:27 0.5511481 2010/11/7 13:20:24 2010/11/7 13:20:54 0.511480 2010/11/7 13:19:39 2010/11/7 13:20:24 0.7511479 2010/11/7 13:18:53 2010/11/7 13:19:39 0.7711478 2010/11/7 13:17:47 2010/11/7 13:18:53 1.111477 2010/11/7 13:16:18 2010/11/7 13:17:47 1.4811476 2010/11/7 13:15:02 2010/11/7 13:16:18 1.2711475 2010/11/7 13:14:02 2010/11/7 13:15:02 111474 2010/11/7 13:12:44 2010/11/7 13:14:02 1.311473 2010/11/7 13:12:05 2010/11/7 13:12:44 0.6511472 2010/11/7 13:11:17 2010/11/7 13:12:05 0.811471 2010/11/7 13:10:11 2010/11/7 13:11:17 1.111470 2010/11/7 13:08:56 2010/11/7 13:10:11 1.2511469 2010/11/7 13:06:34 2010/11/7 13:08:56 2.3711468 2010/11/7 13:05:57 2010/11/7 13:06:34 0.6211467 2010/11/7 12:54:39 2010/11/7 13:05:57 11.3 >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>> 11466 2010/11/7 11:11:59 2010/11/7 12:54:39 102.6711464 2010/11/7 9:27:05 2010/11/7 10:06:20 39.2511463 2010/11/7 8:00:18 2010/11/7 9:27:05 86.7811462 2010/11/7 7:10:33 2010/11/7 8:00:18 49.7511461 2010/11/7 6:00:49 2010/11/7 7:10:33 69.7311460 2010/11/7 2:19:57 2010/11/7 6:00:49 220.8711459 2010/11/6 22:51:21 2010/11/7 2:19:57 208.611458 2010/11/6 19:38:41 2010/11/6 22:51:21 192.6711457 2010/11/6 18:59:29 2010/11/6 19:38:41 39.211456 2010/11/6 18:47:09 2010/11/6 18:59:29 12.3311455 2010/11/6 18:34:33 2010/11/6 18:47:09 12.611454 2010/11/6 17:55:31 2010/11/6 18:34:33 39.03查看日志组信息select thread#,group#,sequence#,bytes/1024/1024,members,first_time,status fromv$log;THREAD# GROUP# SEQUENCE# BYTES/1024/1024 MEMBERS FIRST_TIME STATUS1 1 11572 50 1 2010/11/8 20:44:20 INACTIVE1 2 11573 50 1 2010/11/8 21:04:18 INACTIVE1 3 11574 50 1 2010/11/8 21:24:20 CURRENT从上述信息可见日志文件仅为50M,对于业务高峰期时数据量很大(全国性数据录入)的环境下显的太小了且是日志组少。

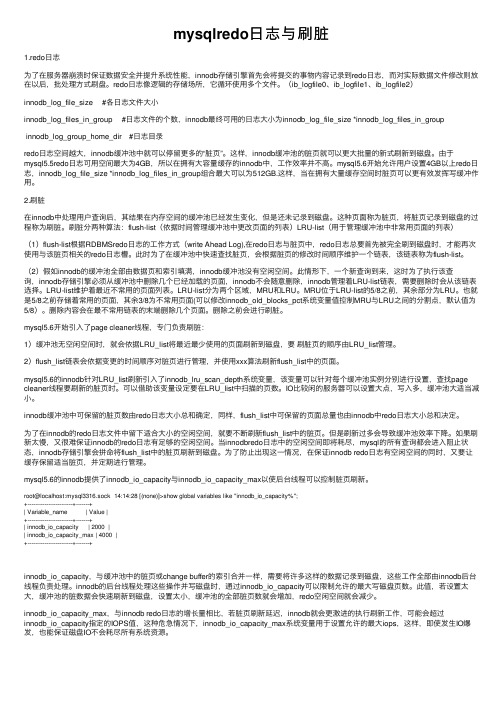

mysqlredo日志与刷脏

mysqlredo⽇志与刷脏1.redo⽇志为了在服务器崩溃时保证数据安全并提升系统性能,innodb存储引擎⾸先会将提交的事物内容记录到redo⽇志,⽽对实际数据⽂件修改则放在以后,批处理⽅式刷盘。

redo⽇志像逻辑的存储场所,它循环使⽤多个⽂件。

(ib_logfile0、ib_logfile1、ib_logfile2)innodb_log_file_size #各⽇志⽂件⼤⼩innodb_log_files_in_group #⽇志⽂件的个数,innodb最终可⽤的⽇志⼤⼩为innodb_log_file_size *innodb_log_files_in_groupinnodb_log_group_home_dir #⽇志⽬录redo⽇志空间越⼤,innodb缓冲池中就可以停留更多的“脏页”。

这样,innodb缓冲池的脏页就可以更⼤批量的新式刷新到磁盘。

由于mysql5.5redo⽇志可⽤空间最⼤为4GB,所以在拥有⼤容量缓存的innodb中,⼯作效率并不⾼。

mysql5.6开始允许⽤户设置4GB以上redo⽇志,innodb_log_file_size *innodb_log_files_in_group组合最⼤可以为512GB.这样,当在拥有⼤量缓存空间时脏页可以更有效发挥写缓冲作⽤。

2.刷脏在innodb中处理⽤户查询后,其结果在内存空间的缓冲池已经发⽣变化,但是还未记录到磁盘。

这种页⾯称为脏页,将脏页记录到磁盘的过程称为刷脏。

刷脏分两种算法:flush-list(依据时间管理缓冲池中更改页⾯的列表)LRU-list(⽤于管理缓冲池中⾮常⽤页⾯的列表)(1)flush-list根据RDBMSredo⽇志的⼯作⽅式(write Ahead Log),在redo⽇志与脏页中,redo⽇志总要⾸先被完全刷到磁盘时,才能再次使⽤与该脏页相关的redo⽇志槽。

此时为了在缓冲池中快速查找脏页,会根据脏页的修改时间顺序维护⼀个链表,该链表称为flush-list。

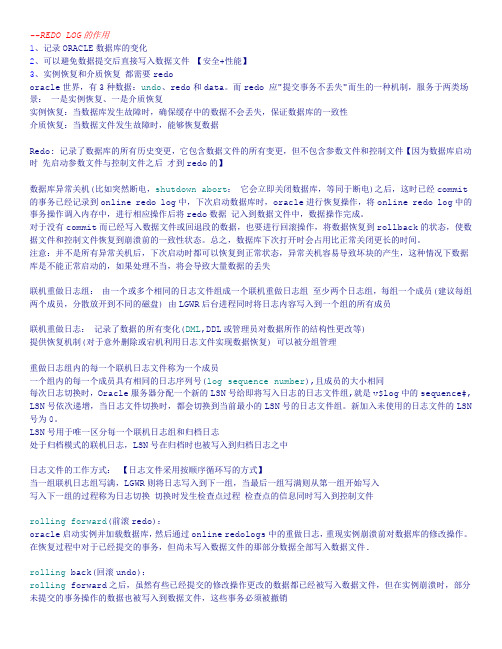

redo介绍及具体使用

--REDO LOG的作用1、记录ORACLE数据库的变化2、可以避免数据提交后直接写入数据文件【安全+性能】3、实例恢复和介质恢复都需要redooracle世界,有3种数据:undo、redo和data。

而redo 应"提交事务不丢失"而生的一种机制,服务于两类场景:一是实例恢复、一是介质恢复实例恢复:当数据库发生故障时,确保缓存中的数据不会丢失,保证数据库的一致性介质恢复:当数据文件发生故障时,能够恢复数据Redo: 记录了数据库的所有历史变更,它包含数据文件的所有变更,但不包含参数文件和控制文件【因为数据库启动时先启动参数文件与控制文件之后才到redo的】数据库异常关机(比如突然断电,shutdown abort:它会立即关闭数据库,等同于断电)之后,这时已经commit的事务已经记录到online redo log中,下次启动数据库时,oracle进行恢复操作,将online redo log中的事务操作调入内存中,进行相应操作后将redo数据记入到数据文件中,数据操作完成。

对于没有commit而已经写入数据文件或回退段的数据,也要进行回滚操作,将数据恢复到rollback的状态,使数据文件和控制文件恢复到崩溃前的一致性状态。

总之,数据库下次打开时会占用比正常关闭更长的时间。

注意:并不是所有异常关机后,下次启动时都可以恢复到正常状态,异常关机容易导致坏块的产生,这种情况下数据库是不能正常启动的,如果处理不当,将会导致大量数据的丢失联机重做日志组:由一个或多个相同的日志文件组成一个联机重做日志组至少两个日志组,每组一个成员(建议每组两个成员,分散放开到不同的磁盘) 由LGWR后台进程同时将日志内容写入到一个组的所有成员联机重做日志:记录了数据的所有变化(DML,DDL或管理员对数据所作的结构性更改等)提供恢复机制(对于意外删除或宕机利用日志文件实现数据恢复) 可以被分组管理重做日志组内的每一个联机日志文件称为一个成员一个组内的每一个成员具有相同的日志序列号(log sequence number),且成员的大小相同每次日志切换时,Oracle服务器分配一个新的LSN号给即将写入日志的日志文件组,就是v$log中的sequence#, LSN号依次递增,当日志文件切换时,都会切换到当前最小的LSN号的日志文件组。

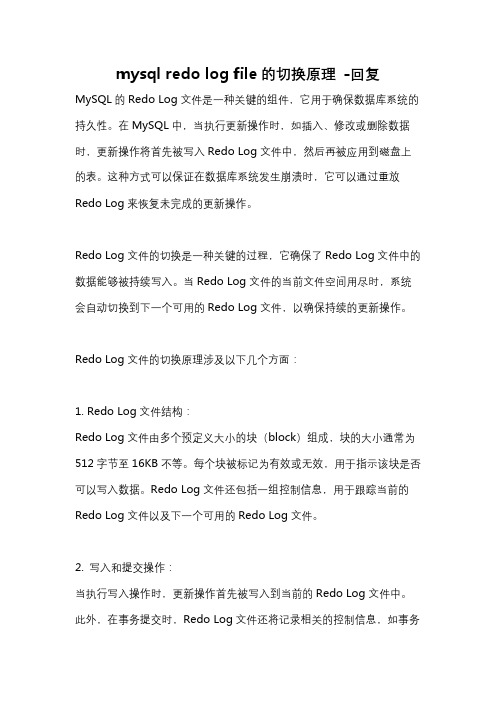

mysql redo log file的切换原理 -回复

mysql redo log file的切换原理-回复MySQL的Redo Log文件是一种关键的组件,它用于确保数据库系统的持久性。

在MySQL中,当执行更新操作时,如插入、修改或删除数据时,更新操作将首先被写入Redo Log文件中,然后再被应用到磁盘上的表。

这种方式可以保证在数据库系统发生崩溃时,它可以通过重放Redo Log来恢复未完成的更新操作。

Redo Log文件的切换是一种关键的过程,它确保了Redo Log文件中的数据能够被持续写入。

当Redo Log文件的当前文件空间用尽时,系统会自动切换到下一个可用的Redo Log文件,以确保持续的更新操作。

Redo Log文件的切换原理涉及以下几个方面:1. Redo Log文件结构:Redo Log文件由多个预定义大小的块(block)组成,块的大小通常为512字节至16KB不等。

每个块被标记为有效或无效,用于指示该块是否可以写入数据。

Redo Log文件还包括一组控制信息,用于跟踪当前的Redo Log文件以及下一个可用的Redo Log文件。

2. 写入和提交操作:当执行写入操作时,更新操作首先被写入到当前的Redo Log文件中。

此外,在事务提交时,Redo Log文件还将记录相关的控制信息,如事务标识、事务操作类型等。

这些信息是用于崩溃恢复和事务回滚的重要依据。

3. 写入Redo Log文件:更新操作的写入过程通常是异步的,也就是说,它不会等待实际的磁盘写入操作完成。

相反,MySQL会将数据写入操作缓存中,并将其标记为“脏”页。

然后,系统将根据IO线程的速度将脏页写入磁盘。

而Redo Log文件的写入则是同步的,它会等待写入操作完成。

4. Redo Log文件的切换:当当前的Redo Log文件的空间用尽时,MySQL将自动启动一个后台线程,此线程负责完成Redo Log文件的切换。

切换的过程可以分为两个主要步骤:准备切换和执行切换。

dba技术学习管理个人的工作总结计划计划

dba技术管理个人工作总结2018年度工作总结一、项目进度情况1,生产数据库到双活数据库的升级切换7月11日清早,在恩墨的技术协助下完成了生产数据库的升级切换。

新的双活生产数据库性能大幅提升。

自主重建的三节点备机集群自8月份启用后运行牢固,运行在open只读状态,今后可以用于报表等只读盘问。

该项目已于9月13日完成查收。

目前我和邱锐正在参加每周末两天的oracleocp 远程培训,经过高强度的学习,我争取在19年第一季度完成三门考试并获取认证,若是有机遇希望明年能连续参加ocm培训,这对我来说也是一个挑战。

2,空调维保购买在中心两个机房4台空调维保7月底到期前,经过比价的方式,选定了日照当地的空调维保商。

3,3d动画显现项目目前该项目已经完成招标,正在和厂家签订合同,预计年终完成动画视频交付。

二、隐患和故障办理1,舟道网app接口、oa系统数据库登录风暴今年第一季度数据库频频出现连接风暴隐患,数据库每小时办理连接央求最高妙过8万次,以致部分应用系统运行卡顿。

采用了舟道网app接口服务切换到连接池、oa系统连接池参数优化、开发数据库到rg01的读写分别等措施后收效显然。

此刻数据库连接央求低于每小时2万次,央求量降低75%,数据库连接风暴获取有效清除。

2,dblinksession不主动释放一卡通、金蝶财务、交换数据库都存在比较严重的dblinksession不释放的问题,一季度先后先后联系并配合内控开发公司、生产开发公司进行了整改,有效降低了rg01的session数,使rg01session数保持在一个牢固的数量。

3,外包厂家在线删除海量数据上半年经过监控发现集发公司外包工程师vpn远程进行千万级数据量的删除工作,sql执行时间高出30分钟,redo日志切换频率高达每小时52次,给磁盘io带来特别大的压力,严重影响数据库的性能。

4,rg05日志数据库的建立生产数据库上存在applog、无车承运人gps历史信息历史数据占用空间较大的问题。