回归Chap7

chatglm 评估指标

chatglm 评估指标ChatGLM(Chat Language Generation Metric)是一种用于评估对话生成模型质量的指标。

在对话生成任务中,评估模型的质量是非常重要的,因为一个好的对话生成模型应该能够产生流畅、准确、有逻辑性的对话内容。

ChatGLM作为一种自动化评估指标,可以帮助我们更好地衡量对话生成模型的表现。

ChatGLM的计算方法基于语言模型,通过对模型生成的对话进行概率计算来评估其质量。

具体而言,ChatGLM首先使用一个预训练的语言模型来计算对话中每个句子的概率,然后将这些概率相乘得到整个对话的概率。

通过与人工标注的参考对话进行比较,可以得到模型生成对话的ChatGLM分数。

ChatGLM的评估指标可以用于对话生成模型的训练和调优。

在训练中,可以根据ChatGLM分数来调整模型的参数,提高对话质量。

在模型选择和比较中,可以使用ChatGLM来评估不同模型的性能,选择最佳的对话生成模型。

除了ChatGLM,还有其他一些常用的评估指标,比如BLEU、ROUGE和METEOR等。

与这些指标相比,ChatGLM更加专注于对话生成任务,并且更加符合对话的语言特点。

然而,ChatGLM也存在一些局限性。

首先,由于ChatGLM是基于语言模型的,它可能无法捕捉到一些对话质量的细微差别。

其次,ChatGLM只能评估对话的语法和语义准确性,而对于对话的一致性、逻辑性和可读性等方面的评估可能不够全面。

另外,由于ChatGLM是自动化评估指标,它可能无法完全代替人工评估,人工评估仍然是评估对话生成模型的重要手段。

ChatGLM作为一种用于评估对话生成模型质量的指标,在对话生成任务中具有一定的应用价值。

它可以帮助我们更好地了解和改进对话生成模型的质量,提高对话生成的效果。

然而,我们也需要注意其局限性,并结合其他评估指标和人工评估来综合评估对话生成模型的质量。

这样才能更加准确地评估对话生成模型的性能,推动对话生成技术的发展。

chatglm训练题目

题目:使用ChatGLM进行文本生成背景:ChatGLM是一种基于预训练的序列到序列模型,适用于自然语言对话系统的生成任务。

在训练过程中,你需要准备一组已标注的数据集,其中包含一些预先定义的对话和回复。

现在,你被要求使用ChatGLM模型训练文本生成任务。

问题:请描述你如何使用ChatGLM进行文本生成训练?步骤:1. 数据准备:首先,你需要准备一个标注的数据集,其中包含对话和回复的文本。

这些文本应该被标记为输入和输出,以便模型能够学习到正确的回复模式。

2. 模型选择:选择ChatGLM模型,并确保已经下载并安装了相应的模型权重和配置文件。

3. 配置模型:在训练过程中,你需要设置一些参数,如批处理大小、优化器、学习率等。

同时,你需要选择合适的预处理和后处理步骤,以便将数据集转换为模型所需的格式。

4. 训练模型:将数据集加载到模型中,并开始训练。

在训练过程中,你需要监视模型的性能指标,如准确率、BLEU分数等,并适当地调整超参数以优化性能。

5. 保存模型:在训练完成后,将模型保存到本地磁盘上,以便将来使用。

6. 文本生成:加载保存的模型,并使用相应的输入文本生成回复。

模型的输出应该是回复的文本。

解答要点:* 在数据准备阶段,需要确保数据集的标注准确无误,以便模型能够学习正确的回复模式。

* 在配置模型时,需要选择合适的预处理和后处理步骤,以便将数据集转换为模型所需的格式。

这可能包括分词、编码、填充等步骤。

* 在训练过程中,需要监视模型的性能指标,并根据需要调整超参数。

这可能包括学习率、优化器类型、批次大小等。

* 在保存模型时,需要选择合适的存储方式,如本地磁盘或云存储,以便将来使用。

* 在文本生成阶段,需要加载保存的模型,并使用相应的输入文本生成回复。

这可以通过调用模型的预测方法来完成。

总结:使用ChatGLM进行文本生成训练需要一定的技术知识和实践经验。

通过正确的数据准备、模型配置、训练和保存过程,可以获得性能良好的模型,用于生成正确的回复文本。

chatglm 原理

ChatGPT的基本原理解析概述ChatGPT是一种基于预训练和微调的transformer模型,它使用大量的对话数据进行训练,以生成语义一致的对话回复。

它的核心思想是以语言模型为基础,通过自回归的方式逐词生成对话回复。

自回归语言模型自回归语言模型(Autoregressive Language Model)是一种用来预测序列中下一个词的概率分布的模型。

它假设当前的词依赖于前面已经生成的词。

形式化地说,给定一个输入序列X={x1,x2,...,x t},自回归语言模型的目标是估计条件概率P(x t|x<t),其中x<t={x1,x2,...,x t−1}。

例如,在对话生成任务中,给定用户的输入“你好,还有什么菜推荐吗?”,模型需要生成一个合理的回复,比如“我们推荐的特色菜是红烧肉和麻婆豆腐”。

Transformer模型Transformer是一种基于自注意力机制(Self-Attention)的深度神经网络模型,它在许多自然语言处理任务中取得了令人印象深刻的效果。

与传统的循环神经网络(RNN)相比,Transformer更容易并行计算,使得训练速度更快。

Transformer模型包括编码器和解码器两部分,其中编码器负责将输入序列映射到一组连续的向量表示,解码器在此基础上生成输出序列。

自注意力机制自注意力机制能够在不同位置之间建立关联并为每个位置分配注意力权重。

在自注意力机制中,查询(query)、键(key)和值(value)是通过对输入序列的线性变换得到的,通过计算查询与键的相似度来分配注意力权重,并使用注意力权重对值进行加权求和以得到表示序列的上下文。

具体地,给定输入序列X={x1,x2,...,x n},通过线性变换将其映射为查询Q、键K 和值V。

则自注意力得分矩阵A可以通过计算查询和键之间的相似度得到,每个元素a ij表示x i对x j的注意力权重。

通过将矩阵A与值V相乘,并对结果进行归一化,可以得到上下文表示C。

ChatGPT如何避免陷入无限循环和回避问题

ChatGPT如何避免陷入无限循环和回避问题ChatGPT是OpenAI开发的一种人工智能语言模型,它可以根据输入的提示和上下文生成相应的文本回复。

然而,由于其开放性和自由度高,有时会面临一些挑战,比如陷入无限循环和回避问题。

本文将探讨ChatGPT如何避免这些问题,并提供一些解决方案。

首先,ChatGPT陷入无限循环是指在与用户的对话中,模型不断重复相同或类似的回答,无法进行有意义的对话。

这通常是因为模型倾向于选择最高概率的回答,而在某些情况下,最常见的回答可能是重复的。

为了解决这个问题,一种方法是引入多样性机制,使得模型能够生成多样的回答。

OpenAI研究人员通过在生成回答时引入随机性,从而提高了回答的多样性。

他们还尝试了一种称为“惩罚机制”的方法,通过让模型对相似性较高的回答进行惩罚,来促使其生成不同的回答。

另一个问题是ChatGPT可能会回避问题,即选择回答与问题不相关或模糊的内容。

这可能是因为在训练过程中,模型接触到了大量与问题无关的数据,导致其在生成回答时选择不相关的内容。

为了解决这个问题,OpenAI采取了一种称为“微调”的方法,即在训练过程中使用人类进行常识修正。

研究人员通过使用基于规则的模型对生成的回答进行筛选和修正,从而提高了回答的质量。

此外,在发布了研究原型后,OpenAI还收集了大量用户反馈,并不断改进模型以提高其问答准确性。

除了技术手段外,ChatGPT的使用方式也可以帮助避免陷入无限循环和回避问题。

用户可以通过明确的问题、限制回答长度或者要求给出多个回答选项来引导模型生成更有意义的回答。

此外,对于重要的或敏感的问题,用户也可以选择人工审核或人工干预的方式来保证回答的准确性。

尽管ChatGPT在避免陷入无限循环和回避问题上已经取得了一定的进展,但仍然存在一些挑战。

比如,生成回答可能涉及到虚假信息、歧视性语言或其他不当内容。

OpenAI意识到这一点,并坚持将合规性和安全性作为开发的重要目标。

chatglm3 工具调用原理

chatglm3 工具调用原理引言:在机器学习和数据科学领域中,chatglm3是一个常用的工具,它被用于构建和训练聊天机器人模型。

chatglm3的调用原理是基于一种称为广义线性模型(Generalized Linear Model,简称GLM)的统计学方法。

本文将详细介绍chatglm3工具的调用原理,包括其背后的数学原理和具体的应用过程。

正文:1. 背景介绍1.1 广义线性模型广义线性模型是一种统计学方法,它通过将线性模型与非线性函数相结合,从而能够适应更复杂的数据分布。

在chatglm3中,广义线性模型被用于建模用户的输入和聊天机器人的输出之间的关系。

通过对输入和输出之间的关系进行建模,chatglm3可以预测用户输入的内容,并生成相应的聊天机器人回应。

1.2 chatglm3工具chatglm3是一个用于构建和训练聊天机器人模型的工具。

它基于R语言开发,提供了一系列的函数和算法,用于处理文本数据、构建模型和进行预测。

chatglm3的核心思想是通过广义线性模型来建模聊天机器人的回应,从而实现智能的对话交互。

2. chatglm3工具的调用原理2.1 数据预处理在使用chatglm3工具进行模型训练之前,首先需要对原始的文本数据进行预处理。

这包括文本清洗、分词、词向量化等步骤。

chatglm3提供了一系列的函数和工具,用于实现这些预处理步骤。

通过预处理,可以将原始的文本数据转化为机器学习算法可以处理的格式。

2.2 模型构建在数据预处理完成后,可以开始构建聊天机器人模型。

chatglm3提供了一系列的模型构建函数,包括线性模型、逻辑回归模型等。

根据具体的应用需求,可以选择合适的模型进行构建。

在模型构建过程中,需要选择合适的特征变量和目标变量,并进行模型训练。

2.3 模型训练和预测模型构建完成后,可以进行模型训练和预测。

chatglm3提供了一系列的函数和算法,用于实现模型训练和预测的过程。

chatglm的损失函数

ChatGPT的损失函数ChatGPT是一种基于生成式对话模型,用于自动回答用户提出的问题或参与对话。

为了训练ChatGPT模型,需要定义一个损失函数来衡量生成的回答与真实回答之间的差异。

ChatGPT的损失函数使用了特定的函数来实现这一目标。

本文将详细解释ChatGPT的损失函数中的特定函数,包括函数的定义、用途和工作方式等。

损失函数的定义ChatGPT的损失函数是基于最大似然估计(Maximum Likelihood Estimation, MLE)的。

最大似然估计是一种常用的参数估计方法,用于选择最能解释观测数据的模型参数。

在ChatGPT中,损失函数的目标是最大化生成回答的概率,使得生成的回答与真实回答的概率差异最小化。

ChatGPT中使用的损失函数可以表示为:)其中,L表示损失函数,t表示时间步,y_t表示生成的回答的第t个标记,x_{<t}表示输入的上下文,y_{<t}表示真实回答的前t个标记。

损失函数衡量了生成的回答与真实回答之间的差异。

通过最大化生成回答的概率,可以使得生成的回答尽可能接近真实回答,从而提高模型的生成能力。

损失函数的用途ChatGPT的损失函数在训练过程中起到了关键的作用。

通过最大化生成回答的概率,损失函数能够引导模型学习生成与真实回答相符的回答。

这样,模型在训练过程中逐渐学会生成合理、准确的回答,提高了模型的生成能力和语义理解能力。

具体来说,损失函数的用途包括:1.参数估计:损失函数通过最大似然估计方法对模型的参数进行估计。

通过最大化生成回答的概率,可以找到最能解释观测数据的模型参数。

2.模型训练:损失函数是模型训练的关键指标。

通过最小化损失函数,可以引导模型学习生成与真实回答相符的回答。

模型通过不断地调整参数,使得生成的回答逐渐接近真实回答。

3.生成能力提升:损失函数的最大化目标是使生成的回答的概率尽可能接近真实回答。

通过训练过程中的反馈,模型能够逐渐提高生成能力,生成更准确、合理的回答。

chatglm的损失函数

chatglm的损失函数ChatGPT是一种基于生成式语言模型的自然语言处理技术,广泛应用于对话系统和聊天机器人的开发中。

为了训练ChatGPT模型,需要定义一个损失函数来度量模型生成的回复与人类生成的回复之间的差异。

ChatGPT模型的目标就是最小化这个损失函数,从而使其能够生成更加准确、连贯和有意义的回复。

ChatGPT的损失函数通常采用一种称为ChatGLM(Chat-based Generative Language Model)的方法。

ChatGLM的基本思想是将对话看作是一个序列生成问题,模型的任务是根据上下文生成下一个单词或一段话。

在训练过程中,模型通过最大化生成正确回复的概率来调整参数,使得生成的回复尽可能接近人类回复。

ChatGLM的损失函数可以分为两个部分:语言模型损失和对话一致性损失。

语言模型损失用于衡量模型生成回复的语言质量,而对话一致性损失则用于确保模型的回复与上下文保持一致。

语言模型损失通常使用交叉熵损失函数来度量模型生成的回复与人类回复之间的差异。

交叉熵是一种常用的分类损失函数,它通过计算模型生成的回复与真实回复之间的差异来评估模型的性能。

通过最小化交叉熵损失,模型可以学习到生成更加准确和合理的回复。

对话一致性损失是为了保证模型生成的回复与上下文保持一致。

在对话系统中,上下文是指前面的对话历史,模型需要根据上下文来生成回复。

对话一致性损失可以通过引入对话历史的表示来实现。

一种常用的表示方法是使用循环神经网络(RNN)或者是Transformer模型来编码对话历史,然后将其与生成的回复进行比较,通过最小化两者之间的差异来更新模型。

除了语言模型损失和对话一致性损失,还可以引入其他的损失函数来进一步提升模型的性能。

例如,可以使用强化学习的方法来引入奖励信号,鼓励模型生成更加满意和有用的回复。

总结来说,ChatGPT的损失函数是通过最小化语言模型损失和对话一致性损失来训练模型。

使用ChatGPT进行多轮对话的实现指南

使用ChatGPT进行多轮对话的实现指南引言:ChatGPT是一种基于深度学习的自然语言处理模型,能够进行多轮对话。

它通过对大量对话数据的学习,能够生成连贯、流畅的回答,并根据上下文进行语义理解。

本文将介绍如何使用ChatGPT进行多轮对话,并提供一些实用的指南。

一、理解ChatGPT的工作原理ChatGPT是一个基于Transformer模型的语言模型。

它通过预训练获取语言的表示能力,然后在特定任务上进行微调以提高性能。

ChatGPT使用了自回归生成的方法,在每个时间步生成一个词,并将生成的词作为输入继续生成下一个词,直到达到最大长度或遇到特殊的结束符号。

二、准备数据集在开始使用ChatGPT进行多轮对话之前,需要准备一个适合的对话数据集。

这个数据集应该包含多个对话样本,并且每个对话都包含多个回合。

对话样本可以从网络上收集,或者自己构建。

确保对话样本的质量和多样性,以提高ChatGPT对多轮对话的理解能力。

三、微调ChatGPT模型在准备好数据集之后,可以开始微调ChatGPT模型。

首先,将数据集分成训练集和验证集。

然后,使用训练集对ChatGPT进行一定轮数的训练,并使用验证集进行模型选择和调优。

微调的目标是让ChatGPT在多轮对话任务上表现出较好的性能,所以需要根据实际情况设计合适的微调策略。

四、构建对话系统当ChatGPT模型微调完成后,可以将其用于构建实际的对话系统。

对话系统可以使用人机交互的方式,也可以通过接口与其他系统对接。

在构建对话系统时,需要考虑以下几个方面:1. 输入预处理:根据ChatGPT的输入格式要求,对用户的输入进行预处理,包括分词、转换为模型可接受的向量表示等。

2. 上下文管理:对于多轮对话,需要正确地管理上下文信息。

在每轮对话开始时,将上一轮对话的输出作为输入的一部分提供给ChatGPT,以便它能够理解对话的上下文。

3. 输出后处理:ChatGPT生成的回答可能包含不明确或错误的部分,所以需要进行适当的后处理。

ChatGPT技术简介与实际应用案例

ChatGPT技术简介与实际应用案例引言:近年来,人工智能的发展引起了广泛的关注与研究。

ChatGPT作为一种新兴的自然语言处理模型,以其强大的对话生成能力,被广泛应用于各个领域,取得了令人瞩目的成果。

本文将介绍ChatGPT的基本原理与技术,同时探讨其在实际应用中所取得的成功案例。

1. ChatGPT基本原理:ChatGPT是一种端到端的神经语言模型,基于Transformer架构和预训练技术。

首先,在大规模的对话数据集上进行预训练,通过无监督学习方式使模型掌握自然语言结构和对话逻辑。

然后,在特定任务的有监督数据上进行微调,使模型适应具体的应用场景。

ChatGPT通过编码器-解码器结构,将对话历史和生成的回复作为输入,输出生成的响应。

2. ChatGPT的技术特点:(1)多轮对话处理能力:与传统的单轮问答模型相比,ChatGPT能够处理更复杂的多轮对话场景。

它能够理解上下文信息,生成连贯、一致的回复,提供更好的对话体验。

(2)开放式生成:ChatGPT是一种生成式模型,可以根据输入的提示生成自然语言的回复。

它不仅能回答用户提出的问题,还可以主动参与到对话中,产生灵活多样的响应。

(3)可控的输出:为了避免生成不当或无意义的回复,ChatGPT引入了对输出的控制机制。

用户可以通过引导语言、温度参数等方式,灵活地控制回复的风格和内容。

(4)个性化推理:ChatGPT通过捕捉语义和上下文信息,具备一定的推理能力。

它可以推断用户的意图,根据已有知识进行推理和判断,提供个性化的回答和建议。

3. ChatGPT的实际应用案例:(1)智能客服:ChatGPT可应用于在线客服系统,为用户提供实时、个性化的服务。

通过对用户问题进行理解和响应,可以减少人工客服的工作量,提高客户满意度。

(2)语言学习:ChatGPT可以作为一种交互式的语言学习工具,提供实时的语法纠错、词汇解释等功能。

学习者可以通过与ChatGPT对话,练习口语表达和语言理解能力。

chatglm文本总结

chatglm文本总结ChatGPT是一种基于大规模预训练的语言模型,它可以进行对话式交互。

这个模型被训练得足够强大,能够回答各种类型的问题,提供信息和建议,并进行有趣的对话。

在本文中,我们将探讨ChatGPT的特点、应用领域以及对社交交互和人工智能发展的潜在影响。

ChatGPT的特点之一是其语言处理能力。

它可以理解和生成自然语言,能够处理复杂的句子结构和上下文信息。

这使得ChatGPT在回答问题和提供信息时非常准确和有逻辑。

它可以根据上下文进行推理,并产生连贯的回答,使得对话更加流畅。

ChatGPT的应用领域非常广泛。

它可以被用作个人助手,回答用户的各种问题,例如天气查询、翻译、时间和地点等。

此外,ChatGPT 还可以用于客户服务,在网站或应用程序中提供快速和高效的帮助。

它还可以应用于教育领域,为学生提供答疑解惑,解释复杂概念,并提供学习建议。

由于ChatGPT可以进行对话式交互,它也可以用于社交娱乐。

用户可以与ChatGPT进行有趣的聊天,讨论电影、音乐、体育等话题。

ChatGPT还可以模拟名人或虚构角色的对话,为用户带来娱乐和惊喜。

然而,尽管ChatGPT具有强大的语言处理能力和广泛的应用前景,但也存在一些潜在的问题。

首先,ChatGPT在处理敏感信息时可能会存在隐私问题。

它需要访问大量的数据来进行训练,这意味着用户的对话可能会被记录和存储。

其次,ChatGPT可能会受到滥用,例如用于传播虚假信息、进行网络钓鱼等。

这需要对其使用进行严格的监管和限制。

另一个问题是ChatGPT可能会产生不准确或有偏见的回答。

由于其训练数据是从互联网上收集的,其中可能包含错误、不准确或有偏见的信息。

因此,ChatGPT在回答问题时可能会受到这些影响,产生不准确或有偏见的答案。

这需要用户在使用ChatGPT时保持警惕,并对其回答进行验证和评估。

尽管存在这些问题,ChatGPT作为一种新兴的技术,对人工智能和社交交互领域具有重要的影响。

chatgpt的48个实例

chatgpt的48个实例ChatGPT是一种基于大规模预训练的语言生成模型,它可以用于多种不同的应用场景。

以下是ChatGPT的48个实例:1. 对话生成,ChatGPT可以用于生成对话,与用户进行自然对话交流,回答问题,提供建议等。

2. 个性化助手,ChatGPT可以作为个性化助手,根据用户的需求提供定制化的服务和建议。

3. 问答系统,ChatGPT可以用于构建问答系统,回答用户提出的问题,提供相关信息和解决方案。

4. 智能客服,ChatGPT可以用于构建智能客服系统,与用户进行在线交流,解决问题和提供帮助。

5. 情感分析,ChatGPT可以分析用户输入的文本情感,了解用户的情绪和态度。

6. 内容生成,ChatGPT可以生成各种类型的文本内容,如新闻报道、故事、诗歌等。

7. 语音识别,ChatGPT可以将语音转换为文本,实现语音识别功能。

8. 文本摘要,ChatGPT可以生成文本摘要,将长篇文章或文档压缩成精炼的摘要信息。

9. 语言翻译,ChatGPT可以进行实时语言翻译,将一种语言的文本翻译成另一种语言。

10. 信息检索,ChatGPT可以用于信息检索,根据用户的需求从大量文本中检索相关信息。

11. 文本纠错,ChatGPT可以对用户输入的文本进行纠错,修正拼写错误和语法错误。

12. 智能写作助手,ChatGPT可以辅助用户进行写作,提供创意和灵感,改善文笔和表达。

13. 情景模拟,ChatGPT可以模拟不同情景下的对话交流,帮助用户进行情景演练和模拟对话。

14. 个性化推荐,ChatGPT可以根据用户的偏好和历史数据进行个性化推荐,提供个性化的服务和建议。

15. 情感生成,ChatGPT可以根据用户输入的情感生成相应的文本内容,如笑话、安慰话语等。

16. 文本分类,ChatGPT可以对文本进行分类,将文本归类到不同的类别中。

17. 舆情监控,ChatGPT可以监控网络舆情,分析用户评论和文章内容,了解公众对某一话题的看法和态度。

ChatGPT中的常用参数与配置项介绍

ChatGPT中的常用参数与配置项介绍近年来,人工智能领域发展迅猛,自然语言处理技术也取得了重大突破。

ChatGPT作为OpenAI最新推出的聊天机器人模型,被广泛应用于自动回复、智能客服等场景。

在使用ChatGPT进行开发和配置时,我们需要了解一些常用参数和配置项,以便更好地定制化我们的聊天机器人。

1. 温度(Temperature)参数:温度参数控制生成回复时的随机性。

较高的温度值(例如1.0)会导致模型生成更多的随机回复,而较低的温度值(例如0.2)会使其更加确定和保守。

适度调整温度值可以平衡生成回复的创新性和准确性。

2. 最大回复长度(Max tokens)参数:该参数限制生成回复的最大长度,以防止输出超出预期范围。

通过设置合理的最大回复长度,可以控制回复的精确程度。

一般来说,较小的值会得到更短的回复,而较大的值可能会导致冗长的输出。

3. 强制回复(Forced replies):在多轮对话中,我们可以提供一些强制回复,以确保机器人在对话的早期进行某种回应。

通过在输入中加入"User: ..."或"Assistant: ..."的标记,我们可以指示ChatGPT生成特定方向的回复。

这对于控制对话的流程非常有用。

4. top-k(Top K)和top-p(Top p)抽样:这两个参数用于控制生成回复时的词汇选择范围。

top-k抽样从概率最高的k个词中进行选择,而top-p抽样则从累积概率达到给定阈值(通常介于0.8到1.0之间)的词中进行选择。

通过调整这些抽样参数,我们可以控制生成回复的多样性和可读性。

5. 学习率(Learning rate):学习率是指在训练ChatGPT时用来更新模型参数的步长。

较大的学习率可以加快模型的收敛速度,但可能会导致不稳定和震荡。

而较小的学习率则可以提高模型的稳定性,但学习速度则较慢。

在训练ChatGPT时,我们需要权衡学习率的大小。

期中复习词汇运用专项练习 牛津译林版英语七年级上册(含答案)

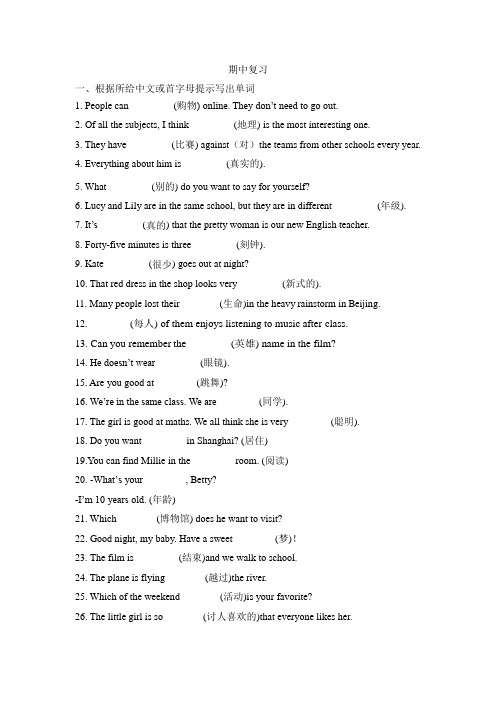

期中复习一、根据所给中文或首字母提示写出单词1. People can ________ (购物) online. They don’t need to go out.2. Of all the subjects, I think ________ (地理) is the most interesting one.3. They have ________ (比赛) against(对)the teams from other schools every year.4. Everything about him is ________ (真实的).5. What ________ (别的) do you want to say for yourself?6. Lucy and Lily are in the same school, but they are in different ________ (年级).7. It’s ________ (真的) that the pretty woman is our new English teacher.8. Forty-five minutes is three ________ (刻钟).9. Kate ________ (很少) goes out at night?10. That red dress in the shop looks very ________ (新式的).11. Many people lost their________(生命) i n the heavy rainstorm in Beijing.12. ________(每人) of them enjoys listening to music after class.13. Can you remember the_________(英雄) name in the film?14. He doesn’t wear ________ (眼镜).15. Are you good at ________(跳舞)?16. We’re in the same class. We are ________(同学).17. The girl is good at maths. We all think she is very ________(聪明).18. Do you want ________ in Shanghai? (居住)19.You can find Millie in the ________ room. (阅读)20. -What’s your ________, Betty?-I’m 10 years old. (年龄)21. Which________(博物馆) does he want to visit?22. Good night, my baby. Have a sweet________ (梦)!23. The film is ________ (结束)and we walk to school.24. The plane is flying________(越过)the river.25. Which of the weekend________(活动)is your favorite?26. The little girl is so________(讨人喜欢的)that everyone likes her.27. Jack is a new member of the________(网球)club.28. Sam is not good at running, so he________(练习)a lot after school29. These fish ________(需要)some more water, or they'll die.30. Eddie often________(享受……的乐趣) watching TV at weekends.31. The supermarket________(开门) at 9 a.m. every day.32. Keeping________(日记) is a good way to help us with our writing.33. Thank you for________(领) me around the wonderful park.34. Susan has________(少数的) friends at school, so she isn’t happy.二、用所给词的适当形式填空1. He usually ________ (practise) his English with me in English classes.2. My brother and I often go to ________ (swim) lessons in Summer.3. Kawhi Leonard is my cousin’s favourite basketball ________ (play) in NBA.4. Ms. Zhu is a new teacher. She teaches ________ (we) Chinese this term(学期).5. I clean my bedroom ________ (one) a week.6. It takes her about ten minutes ________(chat) with her cousin on the phone.7. ________ (read) helps us a lot in our study.8. My father with my mother and I usually ________ (enjoy) our Sundays in parks.9. Li Hua ________ (not be) in any club. He just likes staying in the classroom.10. Listening to light music can make you ________ (feel) peaceful(平静的).11. Look! One of the boys ________ (have) a piece of chocolate in his hand.He wants to give it to his mother.12. ________ (not look) out of the window, Joseph. We’re having the Art lesson.13. Thanks for ________ (help) me with my study, Sandy.14. ________ (be) Steven and his sister nice to their new classmates?15. It’s time for me ________ (go) to bed. It’s too late.16. The boys ________ ( not be) careful. They often make mistakes(错误).17. The funny jokes make all of us ________ (laugh) happily.18. My grandpa is old, but he wants to learn how ________ (use) a computer.19. My brother with his classmates often ________ (fly) kites in the park on Sundays.20. Thank you for ________ (let) me visit your new house. It is so wonderful.21. Will you please ________ (get) ready for the coming sports meeting?22. We each ________ (hope) that we can have a good time in the school tip.23. My mom sometimes ________ (shop) online to buy different kinds of things for the family because she has no time to buy things in stores or supermarkets.24. Look,my shoes are under the desk. ________(They) are behind the boxes25. -Helen, what’s yo ur dream?-________(be) a famous basketball player.26. The little girl has fun ________(read) history books.27. Lucy with her friends usually ________(help) the old man do some cleaning at weekends.28. Some students are glad ________(watch) videos in English class.29. Students need ________(have) rich breakfast. But many students go to school without breakfast.30. He has fun(in)________(swim) in the summer holiday.31. I don't know when________ (have) supper.32. He usually watches TV when ________(have) supper.答案一、1. shop 2.geography/Geograghy 3. matches 4. true 5.else6. grades7. true8. quarters9. seldom 10. modern11. lives 12. Each 13. heroes’14. glasses 15. dancing16. classmates 17. clever 18. to live 19. reading 20. age21. museum 22. dream 23. end 24. over 25. activities26. cute 27. tennis 28. practices 29. need 30. enjoys31. opens 32. diaries 33. showing 34. few二、1. practises 2.swimming 3. player 4. us 5.once6. to chat7. Reading8. enjoys9. isn’t 10. feel11. has 12. Don’t look 13. helping 14.Are 15. to go16. aren’t 17. laugh 18. to use 19. flies 20. letting21. get 22. hope 23. shops 24. Theirs 25. To be26. reading 27. helps 28. to watch 29. to have 30. swimming31. to have 32. having。

chat gpt的逻辑原理

chat gpt的逻辑原理Chat GPT是一种基于深度学习的自然语言处理模型,它的逻辑原理可以分为数据预处理、模型训练和推理三个阶段。

在数据预处理阶段,Chat GPT使用大量的文本数据来训练模型。

这些数据可以是来自互联网上的各种文本资源,如维基百科、新闻文章、小说等。

在预处理阶段,需要对这些文本数据进行清洗和标记,以便模型能够更好地理解和处理这些数据。

清洗的过程包括去除特殊字符、标点符号和数字,还可以进行词汇的分割和词性标注等操作。

接下来,在模型训练阶段,Chat GPT使用深度学习技术来构建一个生成式对话模型。

模型的核心是一个称为Transformer的神经网络架构,它能够有效地处理长文本序列,并且具有较好的并行计算能力。

在训练过程中,模型通过不断地对输入序列进行预测和调整参数来提高模型的性能。

为了减少训练时间和提高模型的泛化能力,还可以使用预训练的技术,即利用大规模文本数据预训练一个模型,然后在特定任务上进行微调。

在推理阶段,Chat GPT利用训练好的模型来生成对话回复。

当用户输入一个问题或者对话时,模型会将输入转化为一个向量表示,并通过网络的前向传播来预测下一个词或者一段话。

模型会根据之前的对话上下文和当前的输入来生成回复,这个过程是一个逐步生成的过程,模型会根据之前的生成结果来决定下一个生成的内容。

为了增加生成结果的多样性,可以使用一些技术手段,如温度参数控制和顶级采样等。

总结一下,Chat GPT的逻辑原理包括数据预处理、模型训练和推理三个阶段。

通过清洗和标记文本数据,构建生成式对话模型,并利用训练好的模型来生成回复,Chat GPT能够实现智能的对话交互。

未来,随着深度学习技术的不断发展和模型的优化,我们可以期待Chat GPT在各个领域的应用得到进一步的拓展和提升。

第五讲线性回归分析

naˆ bˆ xi yi

aˆ

xi bˆ

x

2 i

yi xi

一、回归分析的来源

回归分析现在已应用于多个领域,比如气温与旅游、 产品价格与销量、房地产投资与地方经济等。

思考:你身边有哪些现象可以用回归分析解释?

案例1:女大学生的身高与体重

例1 从某大学中随机选取8名女大学生,其身高和体重数据如表1-1所示。

Karl Gauss的最小化图

y

(xn , yn)

(x2 , y2)

ei = yi-^yi

(x1 , y1)

(xi , yi)

yˆ βˆ 0 βˆ1x

x

一、回归分析的来源

最小二乘法 • 设已知n组数据(x1,y1),( x2,y2)… (xn,yn), • 模型: yˆi aˆ bˆxi • 误差ui= yi yˆi • 误差的平方和

皮尔逊相关 pearson correlation

定距

Cross-tabulate

Multinominal Logistic Regression

Ordinal Regression

皮尔逊相关 pearson correlation

回归 regression

复习

双变量关系强度测量的主要指标

定类

定序

计算并保存自变量的一个观测值与所有观测值的均值偏差其中mahalanobis马氏距离是一种测量自变量观测值与所有观测值均值差异的测度将马氏距离数值大的观测值视为异常值cooks库克距离用于测量一个特殊观测值被排除在回归系数的计算之外时所有观测值残差有多大变化leveragevalues用于测量回归拟合中一个数据点对回归方程拟合程度的影响其值介于0和n1n之间如果该值为0说明该点对回归拟合无影响其值越大对方程拟合影响越大

ChatGPT技术的训练数据准备与标注技巧

ChatGPT技术的训练数据准备与标注技巧ChatGPT是由OpenAI开发的一种基于神经网络的语言模型,它可以进行对话生成和回复。

而ChatGPT的性能和质量,很大程度上取决于训练数据的准备和标注技巧。

本文将详细探讨ChatGPT技术的训练数据准备与标注技巧。

首先,训练数据的准备是确保ChatGPT能够生成高质量对话的关键。

为了准备训练数据,需要收集大量的对话文本。

这可以包括聊天记录、社交媒体上的对话、论坛帖子或其他在线对话。

收集的对话文本应该涵盖多样化的主题和语境,以确保模型具备广泛的知识和应对能力。

收集到的对话文本需要进行预处理,包括数据清理和格式转换。

数据清理步骤包括去除无关信息,如广告、噪声或非对话文本。

此外,还需要移除个人信息和敏感信息,以保护用户隐私。

对话文本应当具有一定的准确性和可读性,不应包含太多的拼写错误、语法错误或不规范的缩写。

在训练数据准备过程中,应注意保持数据的多样性和平衡性。

多样性是指对话文本中包含了各种主题和语言风格的对话,这有助于ChatGPT模型在不同领域和语境中进行适应和生成。

平衡性是指对话文本中各类对话的比例应该合理,避免某一类对话过多或过少,以免模型在某些领域上表现得不够准确。

接下来,准备好的对话文本需要进行标注,以使ChatGPT模型能够理解并生成有意义的回复。

标注过程可以分为两个方面:对话生成的上下文和生成回复的分类。

对于对话生成的上下文,需要标注的是模型需要了解的历史对话信息。

通常,将历史对话限制在一个固定长度范围内,以避免模型过度关注过去对话的细节。

此外,还可以在标注上下文时指定一个特殊的分隔符,以便ChatGPT模型能够清晰地区分上下文和回复。

对于生成回复的分类,需要标注的是回复应该属于哪个类别或语言风格。

这有助于模型根据用户的需求,并选择适当的回复方式。

例如,可以标注回复为肯定、否定、建议等不同的类别,或者标注回复的语言风格为正式、礼貌、幽默等。

Getting+Along+with+Others+回归课本复习讲义 高三英语一轮复习牛津译林版

高考英语总复习之回归课本必修一Unit 3Getting along with others一.单元重点单词背记1.sight n.视野;视力;看见2.horrible adj.令人震惊的;可恶的,极坏的3.chat v i.& n.聊天,闲聊4.café n.咖啡馆,小餐馆5.loss n.失去,丧失;亏损;去世;损失6.case n.具体情况,事例;案件;容器7.frank adj.坦率的,直率的8.trick v t.欺骗,欺诈n.诡计,花招;戏法9.ignore v t.忽视,对……不予理会10.misunderstand v t.& v i.(misunderstood,misunderstood)误解,误会11.contact v t.& n.联系,联络12.generous adj.宽宏大量的,仁慈的;慷慨的13.shallow adj.肤浅的,浅薄的;浅的14.theme n.主题;主旋律15.opinion n.意见,看法;(群体的)观点,信仰16.quality n.品德,素质;质量;特征adj.优质的,高质量的17.extra adj.额外的,分外的,附加的ad v.额外,另外;特别,格外18.measure v t.估量,判定;测量n.措施;衡量19.seek(sought,sought) v i.试图;寻找;争取v t.寻求;寻找20.escape v i.& v t.逃脱,躲避;逃跑;避开,避免;被遗忘n.逃离,逃脱21.joy n.高兴,愉快;令人高兴的人(或事),乐趣22.moment n.时光,时机;瞬间;某个时刻23.indeed ad v.其实,实际上;的确;真正地24.thorough adj.彻底的,全面的;仔细的25.company n.陪伴,作伴;公司26.crowd n.一伙人,一帮人;人群v t.挤满,使拥挤v i.聚集;挤,涌27.poet n.诗人二.词形变换1.origin n.起源→original adj.起初的;独创的;原作的→originally ad v.最初,原先2.recover v i.恢复健康;恢复常态v t.全额收回;重新获得→recovery n.恢复健康;恢复3.respond v i. & v t.回答,回应;作出反应,响应→response n.回复;反应,响应→responsible adj.有责任,负责;可靠的4.lose v t.丢失,失去→loss n.失去,丧失;亏损;去世;损失5.apology n.道歉,致歉→apologize v i.道歉,谢罪6.behave v i.行为,举止→behaviour n.行为,举止,态度7.frank adj.坦率的,直率的→frankly ad v.坦率地8.ignore v t.忽视,对……不予理会→ignorant adj.无知的→ignorance n.无知9.suffer v i.受苦,受折磨;变差v t.遭受,蒙受→suffering n.(肉体或精神上的)痛苦;苦难10.explode v i.(愤怒等感情)爆发,迸发;爆炸v t.使爆炸→explosion n.爆炸;爆炸声11.reflect v.反映→reflection n.沉思;反射;映像;反映12.benefit n.优势,益处,成效v t.使受益v i.得益于→beneficial adj.有益的,有用的13.fail v.失败→failure n.失败;失败的人(或事);未履行;故障14.recognize v t.承认,意识到;认出,辨别出→recognition n.认出,识别15.admire v t.钦佩;欣赏→admiration n.钦佩;欣赏→admirable adj.令人羡慕的,值得称赞的三.重点短语1.on the rocks(关系)陷于困境,濒临崩溃2.at a loss不知所措,困惑3.social media社交媒体4.make it能够出席;成功到达;准时赶上5.in the wrong有错,应承担责任6.let go of放弃,摒弃;松手,放开7.eat away at腐蚀,侵蚀,逐渐破坏8.high point最有意思(或最令人愉快、最好)的部分9.through thick and thin不顾艰难险阻,同甘共苦10.in one’s opinion在某人看来11.smooth out消除(问题),克服(困难)12.in full measure最大程度地,最大限度地13.maintain/value friendships保持/珍视友谊14.primary school student 小学生15.put our thoughts into words 把我们的想法用语言表达出来16.more often than not通常;往往17.set/achieve a goal设定/实现一个目标18.have a double advantage有双重优势19.recognize other people’s weaknesses认识到别人的弱点20.shared interests共同的利益四.知识点回顾1.sight n.视野;视力;看见out of one’s sight脱离某人的视线in/within sight在视野内,看得见at the sight of一看见……come into sight 开始看见,进入眼帘catch sight of看见lose sight of看不见例句(2020·浙江1月卷读后续写)Poppy jumped with joy at the sight of the little dog.波比一看到小狗就高兴地跳了起来2.respond v i. & v t.回答(reply),回应;作出反应(react),响应respond to...对……作出回应respond that...回答说……response n.回复;反应,响应make a/no response to对……作出/未作回应in response to对……作出回应3.loss n.失去,丧失;亏损;去世;损失at a loss不知所措,困惑lose weight减肥be lost in陷入……4.judge v t. & v i.评价(evaluate),(尤指)批评;判断,认为n.法官;裁判员(referee) judging from/by...根据……判断judgment n.判断,判决书make a judgment作判断as far as I can judge据我判断;我认为例句:Judging(judge) from the look on her face,the twins knew their mother was satisfied with what they did.(2021·新高考全国Ⅰ,读后续写)5.apologize v i.道歉,谢罪apologize to sb for (doing)sth因(做)某事向某人道歉apology n.道歉;谢罪make an apology to sb for sth因某事向某人道歉owe sb an apology=owe an apology to sb.应向某人道歉6.case n.事例;事件;具体情况;病例;案件in case以防(万一)in case of万一……,如果发生……in any case无论如何;总之in no case决不(置于句首时,引起部分倒装)as is often the case这是常有的事【注意】(1)当case作先行词且在定语从句中作状语时,要用where引导定语从句。

chatglm训练方式

chatglm训练方式

摘要:

1.ChatGLM 的训练方式概述

2.ChatGLM 的训练过程

3.ChatGLM 的训练结果

正文:

ChatGLM 是一种基于自然语言处理技术的人工智能助手,其主要任务是针对用户的问题和要求提供适当的答复和支持。

ChatGLM 的训练方式主要包括以下几个方面:

1.概述

ChatGLM 的训练方式采用了深度学习技术和大量的数据集,以实现高精度和有效的自然语言处理。

其训练过程采用了预处理、模型构建、优化和评估等步骤,以确保模型的准确性和可靠性。

2.训练过程

ChatGLM 的训练过程可以分为以下几个步骤:

(1) 数据预处理:首先,对数据集进行清洗和预处理,以去除无关紧要的信息和噪音,提高数据质量。

(2) 模型构建:根据预处理后的数据集,构建一个基于深度学习技术的自然语言处理模型,以实现对用户提问的准确理解和回答。

(3) 优化:通过反向传播算法和其他优化技术,不断更新模型参数,以提高模型的准确性和效率。

(4) 评估:使用交叉验证和测试集等方法,对模型的准确性和可靠性进行评估,以确保其能够满足实际应用场景的需求。

3.训练结果

ChatGLM 的训练结果表明,其具有较高的准确性和可靠性,能够针对用户的问题和要求提供适当的答复和支持。

同时,ChatGLM 还具有较好的泛化能力和鲁棒性,能够适应不同的应用场景和环境。

总之,ChatGLM 的训练方式采用了深度学习技术和大量的数据集,以实现高精度和有效的自然语言处理。

其训练过程包括预处理、模型构建、优化和评估等步骤,以确保模型的准确性和可靠性。

chatgpt 工作原理

chatgpt 工作原理1. 简介1.1 概述ChatGPT 是一种基于深度学习的对话生成模型,它使用了大规模的预训练数据和自回归生成的方法来产生连贯的对话回复。

ChatGPT 的工作原理可以分为两个主要步骤:预训练和微调。

在预训练阶段,ChatGPT 使用大规模的无监督数据集进行训练,其中包含了来自互联网的大量对话数据。

模型通过自监督学习的方式来学习对话的结构和语言的规律。

具体来说,ChatGPT 使用了一种称为 Transformer 的神经网络架构来处理对话数据。

Transformer 模型具有多层的编码器和解码器,它们可以将输入的对话信息编码成一个中间表示,并将其解码成连贯的回复。

在微调阶段,ChatGPT 使用有监督的对话数据进行进一步的训练。

这些对话数据包含了人类生成的对话样本,其中包括了用户的对话历史和正确的回复。

通过在这些对话数据上进行训练,ChatGPT 可以学习到更加准确和合理的回复策略。

总的来说,ChatGPT 的工作原理是通过预训练和微调两个阶段来生成连贯的对话回复。

预训练阶段通过大规模的无监督数据进行模型的初始化,微调阶段则通过有监督的对话数据进行模型的优化。

这种两阶段的训练方式使得ChatGPT 能够生成更加准确、流畅和合理的对话回复。

1.2 chatgpt 的定义ChatGPT 是一种基于人工智能的对话生成模型,它是由 OpenAI 开发的一种强大的语言模型。

ChatGPT 使用了大量的训练数据和深度学习算法,可以生成具有上下文感知能力的自然语言回复。

它能够理解输入的问题或对话,并生成与之相关的回答。

ChatGPT 的工作原理是通过预训练和微调两个阶段来实现的。

在预训练阶段,模型使用大规模的无监督数据集进行训练,学习了大量的语言知识和语言模式。

这使得模型能够理解语言的结构和语义,并具备一定的常识和推理能力。

在微调阶段,模型使用特定的有监督数据集进行训练,以使其能够更好地适应特定的任务和应用场景。