linux网卡绑定及网卡顺序变更测试

Lniux网络配置与管理实验报告

实验六网络配置与管理

一、实验目的

1.掌握Linux系统下网络的管理方法。

2.掌握Linux系统下常用的网络命令。

二、实验内容

某公司新购一台服务器,服务器上已安装Linux操作系统,并且服务器上配置两块网卡,现需对这两块网卡进行网络配置,配置内容如下表所示:

令重启Linux系统的网络服务功能,并ifconfig命令查看网卡的IP 地址是否为更改的IP地址。

(1)查看网卡信息和配置IP地址和子网掩码和网关

(2)配置网关

(3)重启Linux系统的网络服务功能,用ifconfig查看网卡的IP 地址

三、实验总结

通过本次实验,让我知道了用ifconfig命令配置的网卡信息,在机器重启后,修改的配置就不存在了。

要想保存修改的配置,就需要

修改网卡的配置文件。

Linux双网卡绑定和解除

Linux双⽹卡绑定和解除⼀、传统的bond模式⽹卡绑定⼀定要在服务管理中关闭NetworkManager服务并禁⽤⾃动启动,因为centos中NetworkManager服务与network服务冲突,默认是由NetworkManager接管⽹络服务,所以传统⽅式重启会出现启动失败,错误⽇志⼀般如下所⽰,管理员就得回到机房接显⽰器配置⽹络连接。

以绑定eth0和eth1为例1.通过vim设置eth0的IP地址和eth1的IP地址。

[root@x101 network-scripts]# vim ifcfg-eth0DEVICE=eth0ONBOOT=yesBOOTPROTO=noneTYPE=EthernetMASTER=bond0 //将⽹卡指向bond0SLAVE=yesUSERCTL=[yes|no](⾮root⽤户是否可以控制该设备)[root@x101 network-scripts]# vim ifcfg-eth1DEVICE=eth1ONBOOT=yesNETBOOT=yesBOOTPROTO=noneTYPE=EthernetMASTER=bond0 //将⽹卡指向bond0SLAVE=yesUSERCTL=[yes|no](⾮root⽤户是否可以控制该设备)2.新建 /etc/sysconfig/network-scripts/ifcfg-bond0绑定配置⽂件[root@x101 network-scripts]# cat ifcfg-bond0DEVICE=bond0ONBOOT=yesNETBOOT=yesBOOTPROTO=noneTYPE=EthernetIPADDR=192.168.0.106PREFIX=24DNS=192.168.0.1NM_CONTROLLED=no[root@x101 network-scripts]#5.创建⽹卡绑定的驱动⽂件/etc/modprobe.d/⾃定义.conf,使得绑定后的⽹卡bond0能够⽀持绑定技术(bonding),同时定义⽹卡以mode6模式进⾏绑定,且出故障时⾃动切换时间为100毫秒ms,添加alias bond0 bondingoptions bond0 mode=6 miimon=100 max_bonds=2miimon是指多久时间要检查⽹路⼀次,单位是ms(毫秒)。

Linux网卡Bonding配置

Linux⽹卡Bonding配置⼀、bonding技术简介 bonding(绑定)是⼀种将n个物理⽹卡在系统内部抽象(绑定)成⼀个逻辑⽹卡的技术,能够提升⽹络吞吐量、实现⽹络冗余、负载等功能,有很多优势。

Linux 系统下⽀持⽹络 Bonding,也叫 channel Bonding,它允许你将 2 个或者更多的⽹卡绑定到⼀起,成为⼀个新的逻辑⽹卡,从⽽实现故障切换或者负载均衡的功能,具体情况要取决于 mode 参数的具体配置。

Linux系统bonding技术是内核层⾯实现的,它是⼀个内核模块(驱动)。

使⽤它需要系统有这个模块, 我们可以modinfo命令查看下这个模块的信息, ⼀般来说都⽀持.modinfo bondingbonding的七种⼯作模式bonding技术提供了七种⼯作模式,在使⽤的时候需要指定⼀种,每种有各⾃的优缺点.balance-rr (mode=0) 默认, 有⾼可⽤ (容错) 和负载均衡的功能, 需要交换机的配置,每块⽹卡轮询发包 (流量分发⽐较均衡).active-backup (mode=1) 只有⾼可⽤ (容错) 功能, 不需要交换机配置, 这种模式只有⼀块⽹卡⼯作, 对外只有⼀个mac地址。

缺点是端⼝利⽤率⽐较低balance-xor (mode=2) 不常⽤broadcast (mode=3) 不常⽤802.3ad (mode=4) IEEE 802.3ad 动态链路聚合,需要交换机配置,没⽤过balance-tlb (mode=5) 不常⽤balance-alb (mode=6) 有⾼可⽤ ( 容错 )和负载均衡的功能,不需要交换机配置 (流量分发到每个接⼝不是特别均衡)详细说明请参考⽹络上其他资料,了解每种模式的特点根据⾃⼰的选择就⾏, ⼀般会⽤到0、1、4、6这⼏种模式。

⼆、RHEL6 下的 Boding 配置: 在所有的 RHEL 版本下,⽬前都不⽀持在 NetworkManager 服务协作下实现 Bonding 配置.所以要么直接关闭 NetworkManager 服务,并取消其开机启动,要么在所有涉及 Bonding 的⽹卡配置⽂件中(包含ethx 或者 bondY),显式地添加⼀⾏:NM_CONTROLLED=no 要配置⽹卡 Bonding,你必须在/etc/sysconfig/network-scripts/⽬录下建⽴逻辑⽹卡的配置⽂件 ifcfg-bondX,⼀般 X 从 0 开始,依次增加.具体的⽂件内容根据参与 Bonding 的⽹卡类型的不同⼜有所差别,以最最常见的 Ethernet 为例,配置⽂件⼤致是这样的:DEVICE=bond0IPADDR=192.168.0.1NETMASK=255.255.255.0ONBOOT=yesBOOTPROTO=noneUSERCTL=noBONDING_OPTS="bonding parameters separated by spaces"NM_CONTROLLED=no BONDING_OPTS 这⼀⾏填写你需要的 Bonding 模式,⽐如 BONDING_OPTS="miimon=100 mode=1" ,下⾯也会介绍⼏种常见的配置⽅式和它代表的意义,这⾥暂时不展开说明.为了⽅便称呼,我们把Bongding 后的逻辑⽹卡 bondX 称为主⽹卡(Master),参与 Bonding 的物理⽹卡 ethY 称为⼦⽹卡(Slave). 主⽹卡配置⽂件创建完毕以后,⼦⽹卡的配置⽂件也需要做相应的改变,主要是添加 MASTER=和SLAVE=这两项参数,我们假设 2 张⼦⽹卡为 eth0 和 eth1,那么他们的配置⽂件⼤致的样⼦会是这样⼦:DEVICE=ethXBOOTPROTO=noneONBOOT=yesMASTER=bond0SLAVE=yesUSERCTL=noNM_CONTROLLED=no 像这样,分别修改 ifcfg-eth0 和 ifcfg-eth1 配置⽂件,DEVICE=ethX 中的 X ⽤相应的值代替.然后我们重启⽹络服务.service network restart这样⼦,⼦⽹卡为 eth0 和 eth1,主⽹卡为 bond0,模式为 mode 1 的⽹络 Bonding 就完成了rhel6 bonding 实例展⽰系统: rhel6⽹卡: eth2、eth3bond0:10.200.100.90负载模式: mode1(active-backup) # 这⾥的负载模式为1,也就是主备模式.1、关闭和停⽌NetworkManager服务service NetworkManager stopchkconfig NetworkManager offps: 如果有装的话关闭它,如果报错说明没有装这个,那就不⽤管2、加载bonding模块modprobe --first-time bonding3、创建基于bond0接⼝的配置⽂件[root@rhel6.6 network-scripts]# cat ifcfg-bond0DEVICE=bond0BOOTPROTO=noneIPADDR=10.200.100.90NETMASK=255.255.255.0ONBOOT=yesNM_CONTROLLED=noUSERCTL=noBONDING_OPTS="mode=1 miimon=200"4、SLAVE⽹卡的配置⽂件两种⼦⽹卡的配置⽂件如下[root@rhel6.6 network-scripts]# cat ifcfg-eth2DEVICE=eth2#HWADDR=14:58:D0:5A:0F:76NM_CONTROLLED=no#UUID=3b718bed-e8d4-4b64-afdb-455c8c3ccf91ONBOOT=yes#NM_CONTROLLED=yesBOOTPROTO=noneMASTER=bond0SLAVE=yesUSERCTL=no[root@rhel6.6 network-scripts]# cat ifcfg-eth3DEVICE=eth3#HWADDR=14:58:D0:5A:0F:77NM_CONTROLLED=no#UUID=988835c2-8bfa-4788-9e8d-e898f68458f0ONBOOT=yes#NM_CONTROLLED=yesBOOTPROTO=noneMASTER=bond0SLAVE=yesUSERCTL=no5、bonding信息查看重启⽹络服务器后bonding⽣效[root@rhel6.6 network-scripts]# ip a4: eth2: <BROADCAST,MULTICAST,SLAVE,UP,LOWER_UP> mtu 1500 qdisc mq master bond0 state UP qlen 1000link/ether c4:34:6b:ac:5c:9e brd ff:ff:ff:ff:ff:ff5: eth3: <BROADCAST,MULTICAST,SLAVE,UP,LOWER_UP> mtu 1500 qdisc mq master bond0 state UP qlen 1000link/infiniband a0:00:03:00:fe:80:00:00:00:00:00:00:00:02:c9:03:00:0a:6f:ba brd 00:ff:ff:ff:ff:12:40:1b:ff:ff:00:00:00:00:00:00:ff:ff:ff:ff10: bond0: <BROADCAST,MULTICAST,MASTER,UP,LOWER_UP> mtu 1500 qdisc noqueue state UPlink/ether c4:34:6b:ac:5c:9e brd ff:ff:ff:ff:ff:ffinet 10.200.100.90/24 brd 10.212.225.255 scope global bond0inet6 fe80::c634:6bff:feac:5c9e/64 scope linkvalid_lft forever preferred_lft forever[root@rhel6.6 network-scripts]# cat /proc/net/bonding/bond0Ethernet Channel Bonding Driver: v3.6.0 (September 26, 2009)Bonding Mode: fault-tolerance (active-backup) # bond0接⼝采⽤mode1Primary Slave: NoneCurrently Active Slave: eth2MII Status: upMII Polling Interval (ms): 200Up Delay (ms): 0Down Delay (ms): 0Slave Interface: eth2MII Status: upSpeed: 1000 MbpsDuplex: fullLink Failure Count: 0Permanent HW addr: c4:34:6b:ac:5c:9eSlave queue ID: 0Slave Interface: eth3MII Status: upSpeed: 1000 MbpsDuplex: fullLink Failure Count: 0Permanent HW addr: c4:34:6b:ac:5c:9fSlave queue ID: 0进⾏⾼可⽤测试,拔掉其中的⼀条⽹线看丢包和延时情况, 然后在插回⽹线(模拟故障恢复),再看丢包和延时的情况.三、RedHat7配置bonding系统: Red Hat Enterprise Linux Server release 7.6 (Maipo)⽹卡: eno3、eno4bonding:bond0负载模式: mode1(active-backup)服务器上两张物理⽹卡eno3和eno4, 通过绑定成⼀个逻辑⽹卡bond0,bonding模式选择mode1注: ip地址配置在bond0上, 物理⽹卡不需要配置ip地址.1、关闭和停⽌NetworkManager服务RedHat7默认安装了NetworkManager,在配置前先关掉NetworkManager服务,否则可能会对bonding或造成问题。

linux(凝思) 网卡绑定方法

linux系统里面有一个内置的nameif的命令可以实现网卡绑定的功能

方法:可以写一个脚本,然后将脚本设置为开机启动即可。

参考如下:

(1) 首先写一个脚本,脚本路径为/etc/rc.d/init.d,脚本内容如下(针对两块网卡):

#cat /etc/rc.d/init.d/nameif.sh

#!/bin/sh

/sbin/nameif -s a0 00:E0:81:D3:30:74

/sbin/nameif -s a1 00:E0:81:D3:30:76

/sbin/nameif -s eth0 00:E0:81:D3:30:74

/sbin/nameif -s eth1 00:E0:81:D3:30:76

注释:此处的MAC为举例用的,应根据自己机器的实际情况来编写脚本。

(2) 写完脚本后,给脚本加权限

chmod 777 /etc/rc.d/init.d/nameif.sh

(3) 然后在对应的启动级别里做一个开机启动的连接,注意,nameif脚本需要执行在

network网络启动之前,否则无法生效

#cd /etc/rc.d/rc3.d

#ln -s /etc/rc.d/init.d/nameif.sh S016nameif

#cd /etc/rc.d/rc5.d

#ln -s /etc/rc.d/init.d/nameif.sh S016nameif

注释:由于内核里面事先记录了eth[0-1*]的网卡名字信息,若直接对eth*进行绑定的话,会存在网卡名字占用的问题,由此会造成设置无法生效。

所有上面所写的脚本里面首先将网卡的MAC地址赋给其他的名字,然后在重新指定给eth*,即可解决这个问题。

linux双网卡绑定

一、L inux bonding研究及实现Linux Bonding本文介绍Linux(具体发行版本是CentOS5.6)下的双卡绑定的原理及实现。

Linux双网卡绑定实现是使用两块网卡虚拟成为一块网卡设备,这简单来说,就是两块网卡具有相同的IP地址而并行链接聚合成一个逻辑链路工作。

这项技术在Sun和Cisco中分别被称为Trunking和Etherchannel技术,在Linux的2.4.x及其以后的内核则称为Bonding技术。

bonding的前提条件:网卡应该具备自己独立的BIOS芯片,并且各网卡芯片组型号相同。

同一台服务器上的网卡毫无疑问是是符合这个条件的。

Bonding原理bonding的原理:在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身MAC的以太网帧,过滤别的数据帧,以减轻驱动程序的负担;但是网卡也支持另外一种被称为混杂promisc的模式,可以接收网络上所有的帧,bonding就运行在这种模式下,而且修改了驱动程序中的mac地址,将两块网卡的MAC地址改成相同,可以接收特定MAC的数据帧。

然后把相应的数据帧传送给bond驱动程序处理。

为方便理解bonding的配置及实现,顺便阐述一下Linux的网络接口及其配置文件。

在Linux 中,所有的网络通讯都发生在软件接口与物理网络设备之间。

与网络接口配置相关的文件,以及控制网络接口状态的脚本文件,全都位于/etc/sysconfig/netwrok-scripts/ 目录下。

网络接口配置文件用于控制系统中的软件网络接口,并通过这些接口实现对网络设备的控制。

当系统启动时,系统通过这些接口配置文件决定启动哪些接口,以及如何对这些接口进行配置。

接口配置文件的名称通常类似于ifcfg-<name>,其中<name> 与配置文件所控制的设备的名称相关。

在所有的网络接口中,最常用的就是以太网接口ifcfg-eth0,它是系统中第一块网卡的配置文件。

Linux系统配置双网卡绑定bond0

Linux系统配置双⽹卡绑定bond01、bonding简述双⽹卡配置设置虚拟为⼀个⽹卡实现⽹卡的冗余,其中⼀个⽹卡坏掉后⽹络通信仍可正常使⽤,实现⽹卡层⾯的负载均衡和⾼可⽤性。

现在⼀般的企业都会使⽤双⽹卡接⼊,这样既能添加⽹络带宽,同时⼜能做相应的冗余,可以说是好处多多。

⽽⼀般企业都会使⽤linux操作系统下⾃带的⽹卡绑定模式,当然现在⽹卡产商也会出⼀些针对windows操作系统⽹卡管理软件来做⽹卡绑定(windows操作系统没有⽹卡绑定功能需要第三⽅⽀持)。

1.1 bonding原理⽹卡⼯作在混杂(promisc)模式,接收到达⽹卡的所有数据包,tcpdump⼯作⽤的也是混杂模式(promisc),将两块⽹卡的MAC地址修改为相同接收特定MAC的数据帧,然后把相应的数据帧传送给bond驱动程序进⾏处理。

1.2 Bonding模式(bonding mode)轮询策略(round robin),mode=0,按照设备顺序依次传输数据包,提供负载均衡和容错能⼒主备策略(active-backup),mode=1,只有主⽹卡处于⼯作状态,备⽹卡处于备⽤状态,主⽹卡坏掉后备⽹卡开始⼯作,提供容错能⼒异或策略(load balancing (xor)),mode=2,根据源MAC地址和⽬的MAC地址进⾏异或计算的结果来选择传输设备,提供负载均衡和容错能⼒⼴播策略(fault-tolerance (broadcast)),mode=3,将所有数据包传输给所有接⼝通过全部设备来传输所有数据,⼀个报⽂会复制两份通过bond下的两个⽹卡分别发送出去,提供⾼容错能⼒动态链接聚合(lacp),mode=4,按照802.3ad协议的聚合⾃动配置来共享相同的传输速度,⽹卡带宽最⾼可以翻倍,链路聚合控制协议(LACP)⾃动通知交换机聚合哪些端⼝,需要交换机⽀持 802.3ad协议,提供容错能⼒输出负载均衡模式(transmit load balancing),mode=5,输出负载均衡模式,只有输出实现负载均衡,输⼊数据时则只选定其中⼀块⽹卡接收,需要⽹卡和驱动⽀持ethtool命令输⼊/输出负载均衡模式(adaptive load balancing),mode=6,输⼊和输出都实现负载均衡,需要⽹卡和驱动⽀持ethtool命令2、⽹卡配置⽂件的配置2.1 配置环境 环境:系统CentOS 6.7 + 虚拟机 VMware 12 ⾄少两块物理⽹卡(VMware上添加eth0,eth1) 2.2 需要添加或修改的配置⽂件有5个(mode=1) 这5个配置⽂件是: /etc/sysconfig/network-scripts/ifcfg-eth{0,1} /etc/sysconfig/network-scripts/ifcfg-bond0 /etc/modprobe.d/dist.conf /etc/rc.local2.2.1 /etc/sysconfig/network-scripts/ifcfg-{eth0,eth1,bonding0}修改或添加提⽰:先备份好eth0和eth1,再修改这⼏个⽂件以下是修改好的三个⽹卡配置⽂件的参数[root@ant network-scripts]# vimdiff ifcfg-eth0 ifcfg-eth1 ifcfg-bond02.2.2 修改/etc/modprobe.d/dist.conf⽂件在此⽂件中添加以下内容:alias bond0 bonding,表⽰系统在启动时加载bonding模块,对外虚拟⽹络接⼝设备为 bond0miimon=100,表⽰系统每100ms监测⼀次链路连接状态,如果有⼀条线路不通就转⼊另⼀条线mode=1,表⽰绑定模式为1primary=eth0,系统⾸先eth0作为bond0接⼝与外界信息的传输接⼝2.2.3 修改配置⽂件/etc/rc.local在此⽂件中添加以下内容:modprobe bonding miimon=100 mode=12.2.4 重启⽹络(service network restart),并查看三个接⼝的mac地址使⽤ifconfig命令显⽰,bond0,eth1,eth2物理地址相同,提⽰三个⽹卡均通过⼀个ip主机端⼝与外界通信但是,我们可以看到,在mode=1的情况下,当前bond0采⽤eth0通信,实际的物理⽹卡地址见下图:3、验证⽹络的连通性没有丢包,⽹络连通性可。

linux下网卡bond配置

Linux 7.x OS bond配置一、bonding技术bonding(绑定)是一种linux系统下的网卡绑定技术,可以把服务器上n个物理网卡在系统内部抽象(绑定)成一个逻辑上的网卡,能够提升网络吞吐量、实现网络冗余、负载等功能,有很多优势。

bonding技术是linux系统内核层面实现的,它是一个内核模块(驱动)。

使用它需要系统有这个模块, 我们可以modinfo命令查看下这个模块的信息, 一般来说都支持.# modinfo bondingfilename:/lib/modules/2.6.32-642.1.1.el6.x86_64/kernel/drivers/net/bonding/bonding.koauthor: Thomas Davis, tadavis@ and many othersdescription: Ethernet Channel Bonding Driver, v3.7.1version: 3.7.1license: GPLalias: rtnl-link-bondsrcversion: F6C1815876DCB3094C27C71depends:vermagic: 2.6.32-642.1.1.el6.x86_64 SMP mod_unloadmodversionsparm: max_bonds:Max number of bonded devices (int)parm: tx_queues:Max number of transmit queues (default = 16) (int)parm: num_grat_arp:Number of peer notifications to send on failover event (alias of num_unsol_na) (int)parm: num_unsol_na:Number of peer notifications to send on failover event (alias of num_grat_arp) (int)parm: miimon:Link check interval in milliseconds (int)parm: updelay:Delay before considering link up, in milliseconds (int)parm: downdelay:Delay before considering link down, in milliseconds (int)parm: use_carrier:Usenetif_carrier_ok (vs MII ioctls) in miimon; 0 for off, 1 for on (default) (int)parm: mode:Mode of operation; 0 for balance-rr, 1 for active-backup, 2 for balance-xor, 3 for broadcast, 4 for 802.3ad, 5 for balance-tlb, 6 for balance-alb (charp)parm: primary:Primary network device to use (charp)parm: primary_reselect:Reselect primary slave once it comes up; 0 for always (default), 1 for only if speed of primary is better, 2 for only on active slave failure (charp) parm: lacp_rate:LACPDUtx rate to request from 802.3ad partner; 0 for slow, 1 for fast (charp)parm: ad_select:803.ad aggregation selection logic; 0 for stable (default), 1 for bandwidth, 2 for count (charp)parm: min_links:Minimum number of available links before turning on carrier (int)parm: xmit_hash_policy:balance-xor and 802.3ad hashing method; 0 for layer 2 (default), 1 for layer 3+4, 2 for layer 2+3 (charp)parm: arp_interval:arp interval in milliseconds (int)parm: arp_ip_target:arp targets in n.n.n.n form (array of charp)parm: arp_validate:validatesrc/dst of ARP probes; 0 for none (default), 1 for active, 2 for backup, 3 for all (charp)parm: arp_all_targets:fail on any/all arp targets timeout; 0 for any (default), 1 for all (charp)parm: fail_over_mac:For active-backup, do not set all slaves to the same MAC; 0 for none (default), 1 for active, 2 for follow (charp)parm: all_slaves_active:Keep all frames received on an interface by setting active flag for all slaves; 0 for never (default), 1 for always. (int)parm: resend_igmp:Number of IGMP membership reports to send on link failure (int)parm: packets_per_slave:Packets to send per slave in balance-rr mode; 0 for a random slave, 1 packet per slave (default), >1 packets per slave. (int)parm: lp_interval:The number of seconds between instances where the bonding driver sends learning packets to each slaves peer switch. The default is 1. (uint)modinfo bondingbonding的七种工作模式:bonding技术提供了七种工作模式,在使用的时候需要指定一种,每种有各自的优缺点. 1.balance-rr (mode=0) 默认, 有高可用(容错) 和负载均衡的功能, 需要交换机的配置,每块网卡轮询发包(流量分发比较均衡).2.active-backup (mode=1) 只有高可用(容错) 功能, 不需要交换机配置, 这种模式只有一块网卡工作, 对外只有一个mac地址。

SUSE Linux 网卡配置实例解析

Linux网卡绑定

修改完网卡配置文件后,执行下面两条命令: [root@sugon~]# echo "alias bond0 bonding" >> /etc/modprobe.conf [root@sugon~]# echo "options bond0 mode=6" >> /etc/modprobe.conf

#使用lspci不加参数可以查看当前系统的所有硬件设备

查看网卡当前的驱动程序版本

[root@sugon ~]# ethtool -i eth0 driver: e1000e #Intel 82574l对应驱动模块为e1000e version: 1.3.10-k2 firmware-version: 1.8-0 bus-info: 0000:03:00.0 [root@node1 ~]# ethtool -i eth2 driver: igb #Intel 82576对应驱动模块为igb version: 1.3.7-k2 firmware-version: 1.8-6 bus-info: 0000:01:00.0

关闭网卡自适应,强制百兆或千兆

[root@sugon~]# ethtool -s eth1 speed 100 duplex full autoneg off #本例是将eth1强制变更为100Mbps全双工模式 [root@sugon~]# ethtool -s eth1 autoneg on #恢复 网卡为自适应模式 上面的设置,服务器重启过之后即失效,如果需要重启后也 生效,有两种办法, 7.1、将ethtool -s eth1 speed 100 duplex full autoneg off写入/etc/rc.local 7.2、将ETHTOOL_OPTS="speed 100 duplex full autoneg off"添加到网卡配置文件中。

麒麟系统双网卡绑定配置

麒麟操作系统技术总结一、网卡绑定当系统中有多个网卡需要进行设置时,建议将网卡的MAC地址与ethX 文件种的HWADDR一一对应,否则系统重启后网卡的eth号很可能会发生改变,在设置了网卡绑定的生成系统中,这是非常危险的。

网卡绑定配置(如将网卡eth1和eth3绑定为bond0的操作步骤):(1)使用service NetworkManage stop命令关闭NetworkManage服务,使用chkconfig NetworkManage off命令使NetworkManage服务在系统开机时不自动启动;(2)修改被绑定网卡eth1的配置。

打开终端,使用cd /etc/sysconfig/network-scripts命令进入network-scripts目录,使用gedit ifcfg-eth1命令打开ifcfg-eth1文件,修改以下内容,修改完成后保存并关闭ifcfg-eth1文件。

DEVICE=eth1BOOTPROTO=noneHWADDR=”: ::::”ONBOOT=yesTYPE=EthernetUSERCTL=noIPV6INIT=noPEERDNS=yesSLA VE=yesMASTER=bond0备注:DEVICE=<name>:<name>表示物理设备的名称,对于动态寻址的PPP设备则是指它的逻辑名称。

BOOTPROTO=<protocol><protocol>的值有以下几种:none——不自定启用协议bootp——使用BOOTP协议dhcp——使用DHCP协议HWADDR:网卡的MAC地址ONBOOT=<yes | no>:yes表示系统启动时激活设备;no表示系统启动时不激活设备USERCTL=<yes | no>:yes表示允许非root用户控制这个设备;no表示不允许非root用户控制这个设备;PEERDNS=<yes | no>:yes表示使用DNS选项的值代替/etc/resolv.conf中的配置。

SUSE Linux 网卡配置实例解析

Linux双网卡绑定

Linux下双网卡绑定比较简单,总共有七种模式,七种 模式都有不同的功能,其中0、2、3、4需要交换机支持,1、 5、6不需要交换机配置支持

linux网卡绑定模式解释

mode=0 round-robin轮询策略(Round-robin policy),模式代号是0。该策略是按照设备顺序依次传 输数据包,直到最后一个设备。这种模式提供负载均衡和容错能力。 mode=1 active-backup活动备份策略(Active-backup policy),模式代号是1。该策略只有一个设备 处理数据,当它宕机的时候就会由备份代替,仅提供容错能力。 mode=2 load balancing (xor)异或策略(XOR policy),模式代号是2。该策略是根据MAC地址异或运 算的结果来选择传输设备,提供负载均衡和容错能力。 mode=3 fault-tolerance (broadcast)广播策略(Broadcast policy),模式代号是3。该策略通过全部 设备来传输所有数据,提供容错能力。 mode=4 lacp IEEE 802.3ad 动态链接聚合(IEEE 802.3ad Dynamic link aggregation),模式代号是 4。该策略通过创建聚合组来共享相同的传输速度,需要交换机也支持 802.3ad 模式,提供容错能力。 mode=5 transmit load balancing适配器传输负载均衡(Adaptive transmit load balancing),模式 代号是5。该策略是根据当前的负载把发出的数据分给每一个设备,由当前使用的设备处理收到的数据。 本策略的通道联合不需要专用的交换机支持,提供负载均衡和容错能力。 mode=6 adaptive load balancing适配器负载均衡(Adaptive load balancing),模式代号是6。该策 略在IPV4情况下包含适配器传输负载均衡策略,由ARP协商完成接收的负载,通道联合驱动程序截获 ARP在本地系统发送出的请求,用其中一个设备的硬件地址覆盖从属设备的原地址。

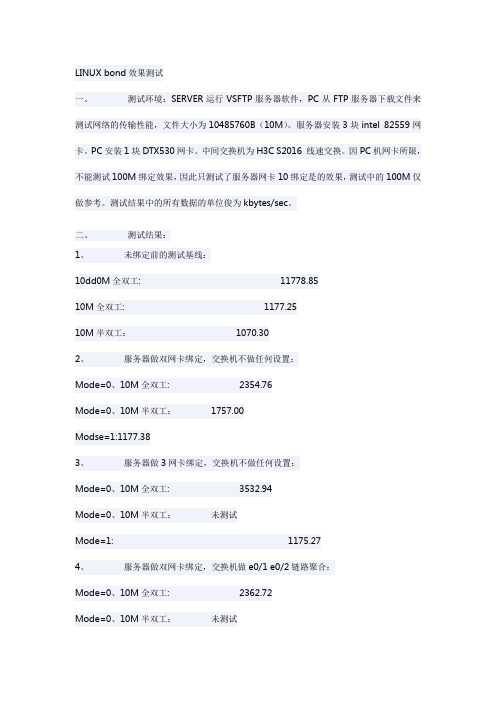

LINUX bond效果测试

LINUX bond效果测试一、测试环境:SERVER运行VSFTP服务器软件,PC从FTP服务器下载文件来测试网络的传输性能,文件大小为10485760B(10M)。

服务器安装3块intel 82559网卡。

PC安装1块DTX530网卡。

中间交换机为H3C S2016 线速交换。

因PC机网卡所限,不能测试100M绑定效果,因此只测试了服务器网卡10绑定是的效果,测试中的100M仅做参考。

测试结果中的所有数据的单位俊为kbytes/sec。

二、测试结果:1、未绑定前的测试基线:10dd0M全双工: 11778.8510M全双工: 1177.2510M半双工:1070.302、服务器做双网卡绑定,交换机不做任何设置:Mode=0、10M全双工: 2354.76Mode=0、10M半双工:1757.00Modse=1:1177.383、服务器做3网卡绑定,交换机不做任何设置:Mode=0、10M全双工: 3532.94Mode=0、10M半双工:未测试Mode=1: 1175.274、服务器做双网卡绑定,交换机做e0/1 e0/2链路聚合:Mode=0、10M全双工: 2362.72Mode=0、10M半双工:未测试Mode=1: 1175.255、服务器做3网卡绑定,交换机做e0/1 e0/2 e0/3链路聚合:Mode=0、103M全双工: 3531.75Mode=0、10M半双工:未测试Mode=1: 117744.38三、实验结论及注意事项:1、LINUX机器做BOND=0需交换机的支持,而BOND=6则无需。

2、MODE 0 即为负载均衡模式,1即为冗余备份模式。

3、在测试中建议将交换机端口和网卡的工作速率以及工作模式强制为一致,在测试中发现82559网卡不能正确的和H3C S2016交换机协商工作模式,导致速度巨慢,强制速率及工作模式后排除。

(LINUX用mii-tool -F 来强制,ethtool发现不能使用)。

linux网卡顺序变更

一、添加网卡1、将新网卡插入网卡插槽中。

并重启一次系统。

/etc/udev/rules.d/70-persistent-net.rules文件会多出一条记录重启前:重启后:2、复制eth1信息新建一个eth2#cd /etc/sysconfig/network-scripts/#cp ifcfg-eth1 ifcfg-eth2修改eth2配置文件信息,将信息修改成对应70-persistent-net.rules文件中eth2的信息。

3、重启网卡#service network restart二、调换网卡1、修改70-persistent-net.rules文件,修改参数NAME中的值,将eth1换成eth2,eth2换成eth1。

如图:修改前:修改后:2、先关闭eth1和eth2,再将网卡配置文件eth1和eth2的内容对调。

#cd /etc/sysconfig/network-scripts/# ifdown eth1# ifdown eth2#cp ifcfg-eth1 ifcfg-eth3#cp ifcfg-eth2ifcfg-eth1#cp ifcfg-eth3 ifcfg-eth2#rm–rfifcfg-eth33、修改eth1和eth2的配置文件中的DEVICE和NAME两参数的值。

4、激活配置文件,并重启网卡#udevadm trigger#service network restart5、验证通过ifconfig命令查看网卡状态。

如下图,置换前eth2为运行状态,置换后eth1为置换状态,且eth1和eth2的地址也都对调了。

linux系统主机双网卡环回测试

Linux下双网卡主机的回环测试一、设计任务及要求路由器测试早期采用“回绕测试法”(Loop-back Test Method,LTM),即测试器将测试数据的目的IP地址指定为测试系统(SUT)自身的IP地址,测试器发出的测试数据将被路由器的输入单元直接返回测试系统。

单台主机多网卡的测试系统也可以进行回绕测试,在RFC2544文档中有相关描述,本实验的任务就是在linux下的双网卡主机进行回绕测试,也可叫做环回测试,待测设备可以是路由器或者交换机,主机的双网卡分别和交换机或路由器的两个接口相连,数据由一个网卡出来经过待测设备之后再从另外一个网卡回来,这就是整个实验测试的任务。

实验要求:网卡之间能够进行ICMP报文和TCP或UDP报文的传输。

二、实验的解决思路Linux的内核对从一个网络地址发往另一个网络地址的数据包,如果这两个网络地址同属一个host,则这个数据包会直接在内部转发,根本不会放到网络设备上,本实验的解决思路是在主机上制定两个不属于任何主机的ip,再将网卡的IP地址进行绑定,增加两条相关的路由,用防火墙进行ip 地址转换。

三、实验操作实验场景如图所示:图1:双网卡主机测试环境如图所示其ip地址分别为192.168.1.108(有线网卡),另一个的IP地址为192.168.1.101(无线网卡),有线网卡通过一台路由器进行连接,路由器的网关是192.168.1.1,有线网卡和无线网卡通过路由器的Dhcp自动获得分配的IP,可以连接外网。

其配置如下图所示:图2:linux下主机的网络配置图在主机上增加两条路由,route add 192.168.1.11 dev eth0;route add 192.168.1.22 dev wlan0;上面的两个ip地址是不属于任何主机,目的地址为192.168.1.11的数据包由eth0转发,目的地址为192.168.1.22的数据包由wlan0转发。

Suse-linux网卡绑定bonding方法

Suse-linux网卡绑定bonding方法SueLinu某系统的网卡冗余bonding方法有两种:一种是在命令模式下直接配置,一种是用Sue系统里面的yat管理工具对网络配置里面直接绑定。

Yat管理工具进去之后可以看到已通电网卡,直接编辑设置为绑定网卡,再添加bond0网卡,直接进行绑定设置即可。

下面介绍命令模式绑定的步骤:首先确定有两块以上的网卡ifconfig–a1.在/etc/yconfig/network/建立一个ifcfg-bond0ifcfg-bond0文件名是启用网卡时,优先使用模式的配置文件BONDING_MASTER='ye' BONDING_MODULE_OPTS='mode=active-backupmiimon=100'##主备状态BONDING_SLAVE0='eth0'##根据环境而定BONDING_SLAVE1='eth1'##根据环境而定BOOTPROTO='tatic'BROADCAST=''ETHTOOL_OPTIONS='' IPADDR='192.168.217.128/24'##根据环境而定MTU=''NAME=''NETWORK=''REMOTE_IPADDR=''STARTMODE='auto'USERCONTROL='no'2.新建了ifcfg-bond0这个文件配置写好之后,重启网络服务:rcnetworkretartIfconfig会看到如下信息:Bond0,eth0,eth1的MAC地址都是一样的运行cat/proc/net/bonding/bond0会看到如下信息如果绑定不成功/proc/net/bonding/不会有bond0这个文件这里可以看到绑定信息,以及两块网卡的真实MAC地址,可以看出eth0是主卡,因为MAC地址用的是eth0的地址。

linux双网卡绑定

TYPE=Ethernet

这里要主意,不要指定单个网卡的IP 地址、子网掩码或网卡 ID。将上述信息指定到虚拟适配器(bonding)中即可。

[root@rhas-13 network-scripts]# cat ifcfg-eth0

DEVICE=eth0

ONBOOT=yes

在mode=0 负载均衡工作模式,他能提供两倍的带宽,下我们来看一下网卡的配置信息

[root@rhas-13 root]# ifconfig

bond0 Link encap:Ethernet HWaddr 00:0E:7F:25:D9:8B

inet addr:172.31.0.13 Bcast:172.31.3.255 Mask:255.255.252.0

alias bond0 bonding

options bond0 miimon=100 mode=0

6. 说明

如果是主备冗余模式,需将

options bond0 miimon=100 mode=0中

mode 改为1

其它改为

options bond0 miimon=100 mode=1 primary=eth0

UP BROADCAST RUNNING SLAVE MULTICAST MTU:1500 Metric:1

RX packets:9572 errors:0 dropped:0 overruns:0 frame:0

TX packets:480 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:753739 (736.0 Kb) TX bytes:0 (0.0 b)

Linux网卡bond配置详解

Linux⽹卡bond配置详解⽹卡bonding模式共有0、1、2、3、4、5、6共7种mode1、5、6不需要要交换机设置mode0、2、3、4需要交换机设置1、mode=0 (round-robin)轮询策略,数据包在每个slave⽹卡上都进⾏数据传输,以逐包形式在两个物理⽹卡上转发数据。

这种模式提供了数据的负载均衡和容错能⼒。

2、mode=1 (active-backup)主备策略,只有⼀个slave被激活,只有当active的slave的接⼝down时,才会激活其它slave接⼝。

主备模式下发⽣⼀次故障切换,在新激活的slave接⼝上会发送⼀个或者多个gratuitous ARP。

主salve接⼝上以及配置在接⼝上的所有VLAN接⼝都会发送gratuitous ARP,需要在这些接⼝上配置了⾄少⼀个IP地址。

VLAN接⼝上发送的的gratuitous ARP将会附上适当的VLAN id。

本模式提供容错能⼒。

3、mode=2(XOR)基于所选择的hash策略,本模式也提供负载均衡和容错能⼒4、mode=3(broadcast)⼴播策略,向所有的slave接⼝发送数据包,本模式提供容错能⼒5、mode=4(802.3ad)动态链路聚合,根据802.3ad标准利⽤所有的slave建⽴聚合链路。

slave接⼝的出⼝取决于传输的hash策略,默认策略是简单的XOR策略,⽽hash策略则可以通xmit_hash_policy选项配置。

前提:每个slave⽹卡⽀持ethtool获取速率和双⼯状态交换机⽀持IEEE 802.3ad标准(可能需要配置启⽤)IEEE 802.3ad 是执⾏的标准⽅法。

将多个适配器聚集到单独的虚拟适配器⽅⾯与“(EtherChannel)”的功能相同,能提供更⾼的防⽌发⽣故障。

例如,eth0 和 eth1 可以聚集到称作eth3 的 IEEE 802.3ad;然后⽤ IP 地址配置接⼝ eth3。

Linux下多网卡绑定bond及模式介绍

Linux下多⽹卡绑定bond及模式介绍【介绍】⽹卡bond⼀般主要⽤于⽹络吞吐量很⼤,以及对于⽹络稳定性要求较⾼的场景。

主要是通过将多个物理⽹卡绑定到⼀个逻辑⽹卡上,实现了本地⽹卡的冗余,带宽扩容以及负载均衡。

Linux下⼀共有七种⽹卡bond⽅式,实现以上某个或某⼏个具体功能。

最常见的三种模式是bond0,bond1,bond6.【bond0】平衡轮循环策略,有⾃动备援,不过需要"Switch"⽀援及设定。

balance-rr(Round-robin policy)⽅式:传输数据包的顺序是依次传输(即:第⼀个包⾛eth0,第⼆个包就⾛eth1……,⼀直到所有的数据包传输完成)。

优点:提供负载均衡和容错能⼒。

缺点:同⼀个链接或者会话的数据包从不同的接⼝发出的话,中间会经过不同的链路,在客户端可能会出现数据包⽆法有序到达的情况,⽽⽆序到达的数据包将会被要求重新发送,⽹络吞吐量反⽽会下降。

【bond1】主-备份策略active-backup(Active -backup policy)⽅式:只有⼀个设备处于活动状态,⼀个宕掉之后另⼀个马上切换为主设备。

mac地址为外部可见,从外⾯看,bond的mac地址是唯⼀的,switch不会发⽣混乱。

优点:提⾼了⽹络连接的可靠性。

缺点:此模式只提供容错能⼒,资源利⽤性较低,只有⼀个接⼝处于active状态,在有N个⽹络接⼝bond 的状态下,利⽤率只有1/N。

【bond2】平衡策略balance-xor(XOR policy)⽅式:基于特性的Hash算法传输数据包。

缺省的策略为:(源MAC地址 XOR ⽬标MAC地址) % slave数量。

# XRO为异或运算,值不同时结果为1,相同为0可以通过xmit_hash_policy选项设置传输策略。

特点:提供负载均衡和容错能⼒。

【bond3】⼴播策略broadcast⽅式:在每个slave接⼝上传输每⼀个数据包。

麒麟系统双网卡绑定配置

麒麟操作系统技术总结一、网卡绑定当系统中有多个网卡需要进行设置时,建议将网卡的MAC地址与ethX 文件种的HWADDR一一对应,否则系统重启后网卡的eth号很可能会发生改变,在设置了网卡绑定的生成系统中,这是非常危险的。

网卡绑定配置(如将网卡eth1和eth3绑定为bond0的操作步骤):(1)使用service NetworkManage stop命令关闭NetworkManage服务,使用chkconfig NetworkManage off命令使NetworkManage服务在系统开机时不自动启动;(2)修改被绑定网卡eth1的配置。

打开终端,使用cd /etc/sysconfig/network-scripts命令进入network-scripts目录,使用gedit ifcfg-eth1命令打开ifcfg-eth1文件,修改以下内容,修改完成后保存并关闭ifcfg-eth1文件。

DEVICE=eth1BOOTPROTO=noneHWADDR=”: ::::”ONBOOT=yesTYPE=EthernetUSERCTL=noIPV6INIT=noPEERDNS=yesSLA VE=yesMASTER=bond0备注:DEVICE=<name>:<name>表示物理设备的名称,对于动态寻址的PPP设备则是指它的逻辑名称。

BOOTPROTO=<protocol><protocol>的值有以下几种:none——不自定启用协议bootp——使用BOOTP协议dhcp——使用DHCP协议HWADDR:网卡的MAC地址ONBOOT=<yes | no>:yes表示系统启动时激活设备;no表示系统启动时不激活设备USERCTL=<yes | no>:yes表示允许非root用户控制这个设备;no表示不允许非root用户控制这个设备;PEERDNS=<yes | no>:yes表示使用DNS选项的值代替/etc/resolv.conf中的配置。

LINUX服务器改网卡

Linux下调整网卡的工作模式现在的网卡一般都是10/100M/1000M自适应工作模式,在配置网卡参数时我们很少考虑它的工作模式,但是在路由器、交换机、代理服务器等通信量比较大的关键设备上,我们应该为它指定正确的工作模式,这样可以提高通信效率。

在Linux环境下,我们可以使用系统自带的工具mii-tool(这是专门设置网卡工作模式的命令)来配置网卡工作模式。

下面我们具体来谈一下它的使用方法。

1. 查看网卡的工作模式,输入命令:一,用mii-tool来调整#mii-tool -veth0: negotiated 100baseTx-FD,link okproduct info:Vendor 00:05:be,model 8 rev 0basic status: autonegotiation complete,link okbasic mode:autonegotiation enabled.Capabilities: ..............从以上信息中可以看出,这块网卡工作在100M全双工自适应模式下,“100BaseTx-FD”意为100M Full Duplex。

2. 更改网卡的工作模式,输入命令:#mii-tool -F media [interface]media可选的模式有100baseTx-FD、100baseTx-HD、10baseT-FD、10baseT-HD等。

Interface代表所选择的网卡,如eth0、eth1等,默认为eth0。

例如,设置网卡工作在10M半双工模式下,输入命令:#mii-tool -F 1000baseTx-FD eth23. 恢复网卡的自适应工作模式,输入命令:#mii-tool -r eth2二,用ethtool来调整ethtool ethX //查询ethX网口基本设置ethtool –h //显示ethtool的命令帮助(help)ethtool –i ethX //查询ethX网口的相关信息ethtool –d ethX //查询ethX网口注册性信息ethtool –r ethX //重置ethX网口到自适应模式ethtool –S ethX //查询ethX网口收发包统计ethtool –s ethX [speed 10|100|1000]\ //设置网口速率10/100/1000M [duplex half|full]\ //设置网口半/全双工[autoneg on|off]\ //设置网口是否自协商[port tp|aui|bnc|mii]\ //设置网口类型例如:查询eth0网卡的工作模式:[root@freesky ~]# ethtool eth0Settings for eth0:Supported ports: [ TP ]Supported link modes: 10baseT/Half 10baseT/Full100baseT/Half 100baseT/Full1000baseT/FullSupports auto-negotiation: YesAdvertised link modes: 10baseT/Half 10baseT/Full100baseT/Half 100baseT/Full1000baseT/FullAdvertised auto-negotiation: YesSpeed: 1000Mb/sDuplex: FullPort: Twisted PairPHYAD: 0Transceiver: internalAuto-negotiation: onSupports Wake-on: umbgWake-on: gCurrent message level: 0x00000007 (7)Link detected: yes例如:将网卡eth1设置为100M全双工、自动协商关闭# ethtool -s eth1 autoneg off speed 100 duplex full网卡模式修改后如果系统重启好就恢复原样了,为了保存我们修改好的设置有两种方面:一,ethtool设置可通过/etc/sysconfig/network-scripts/ifcfg-ethX文件保存,从而在设备下次启动时激活选项。

交换机和Linux服务器网卡绑定模式(bond)对接经典配置

∙大数据∙案交换机和Linux服务器网卡绑定模式(bond)对接经典配置关键词:∙交换机∙bond∙∙0推荐,274浏览∙∙2收藏,我的收藏功能需求交换机与Linux服务器多网卡bond模式对接组网信息及描述无配置步骤交换机多端口和服务器对接时,需要确定是否需要配置聚合或者不配置聚合,并且配置聚合的时候还需要确认是静态聚合还是动态聚合,当然这和当前服务器网卡的bond模式有关。

下面我们了解下Linux服务器的7种bond模式,说明如下:第一种模式:mod=0 ,即:(balance-rr) Round-robin policy(平衡抡循环策略)特点:传输数据包顺序是依次传输(即:第1个包走eth0,下一个包就走eth1….一直循环下去,直到最后一个传输完毕),此模式提供负载平衡和容错能力;但是我们知道如果一个连接或者会话的数据包从不同的接口发出的话,中途再经过不同的链路,在客户端很有可能会出现数据包无序到达的问题,而无序到达的数据包需要重新要求被发送,这样网络的吞吐量就会下降。

这种模式需要接入交换机配置静态链路聚合配置。

V3平台交换机侧的静态典型配置[H3C] link-aggregation group 1 mode manual[H3C] interface ethernet2/1/1[H3C-Ethernet2/1/1] port link-aggregation group 1[H3C-Ethernet2/1/1] interface ethernet2/1/2[H3C-Ethernet2/1/2] port link-aggregation group 1[H3C-Ethernet2/1/2] interface ethernet2/1/3[H3C-Ethernet2/1/3] port link-aggregation group 1V5/V7交换机侧的静态典型配置[DeviceA] interface Bridge-Aggregation 1 //默认静态[DeviceA-Bridge-Aggregation1] quit[DeviceA] interface GigabitEthernet 4/0/1[DeviceA-GigabitEthernet4/0/1] port link-aggregation group 1[DeviceA] interface GigabitEthernet 4/0/2[DeviceA-GigabitEthernet4/0/2] port link-aggregation group 1第二种模式:mod=1,即:(active-backup) Active-backup policy(主-备份策略)特点:只有一个设备处于活动状态,当一个宕掉另一个马上由备份转换为主设备。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux网卡顺序变更导致网卡绑定出错及解决办法测试

2012/2/21

描述:linux中新安装网卡会导致原网卡识别顺序紊乱,影响网络及网卡绑定正常工作,此时可以更改/etc/sysconfig/network-scripts目录中各网卡配置,手工加入各网卡真实mac地址来解决。

测试环境:

Workstation7.1

虚拟机—Centos5

测试情况简介:

1、虚拟机关机,虚拟机原有1块网卡,再为虚拟机增加2块网卡,这3块网卡

均为虚拟的Intel e1000类型,均为bridge模式(物理机配置microsoft loop 网卡,将该网卡配置为虚拟机bridge连接的网卡);

2、此时,虚拟机vmx中可见该三张网卡的顺序及mac地址为:

eth0 00:0C:29:1A:22:7A

eth1 00:0C:29:1A:22:84

eth2 00:0C:29:1A:22:8E

3、启动虚拟机后,系统识别顺序正确,将eth1及eth2配置为bond0,在该虚

拟机setting中断开某一网卡,bond0仍正常工作,cat /proc/net/bonding/bond0可见一块网卡为down,bond0及另一张网卡为up;

4、再关闭虚拟机,为该虚拟机添加2张网卡,仍为bridge模式,假设测试目标

是需要将新加入的2块网卡用于bond0,释放bond0之前使用的2张网卡。

为区别于之前的3张网卡,编辑该虚拟机vmx文件,将新加的eth3及eth4类型修改为AMD网卡:

ethernet3.virtualDev = "vlance"

5、此时该虚拟机vmx中5张网卡顺序及mac地址为:

eth0 00:0C:29:1A:22:7A /INTEL网卡

eth1 00:0C:29:1A:22:84 /INTEL网卡

eth2 00:0C:29:1A:22:8E /INTEL网卡

eth3 00:0c:29:1a:22:98 /AMD网卡

eth4 00:0c:29:1a:22:a2 /AMD网卡

6、重新启动该虚拟机后,发现虚拟机系统中:

eth0、eth1为AMD网卡

eth2/eth3/eth4为Intel网卡

7、修改ifcfg-eth0、ifcfg-eth1,由于eth0及eth1为bond0使用,只需添加

bond配置,无需mac地址,而ifcfg-eth2/3/4需要改为实际的mac地址,:修改后结果如下:

[root@NBU70 sysconfig]# ifconfig -a |grep HW

bond0 Link encap:Ethernet HWaddr 00:0C:29:1A:22:98

eth0 Link encap:Ethernet HWaddr 00:0C:29:1A:22:98

eth1 Link encap:Ethernet HWaddr 00:0C:29:1A:22:98

eth2 Link encap:Ethernet HWaddr 00:0C:29:1A:22:7A

eth3 Link encap:Ethernet HWaddr 00:0C:29:1A:22:84

eth4 Link encap:Ethernet HWaddr 00:0C:29:1A:22:8E 其中eth1由于在bond0中,和eth0的mac地址一样。

通过查看bond0状态可验证eth1真实mac地址:

[root@NBU70 sysconfig]# cat /proc/net/bonding/bond0

Ethernet Channel Bonding Driver: v3.4.0 (October 7, 2008)

Bonding Mode: fault-tolerance (active-backup)

Primary Slave: None

Currently Active Slave: eth0

MII Status: up

MII Polling Interval (ms): 100

Up Delay (ms): 0

Down Delay (ms): 0

Slave Interface: eth0

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:0c:29:1a:22:98

Slave Interface: eth1

MII Status: down

Link Failure Count: 0

Permanent HW addr: 00:0c:29:1a:22:a2

同时,还需要修改/etc/modprobe.conf文件,使各网卡类型一致:alias eth0 vmxnet

alias eth1 vmxnet

alias eth2 e1000

alias eth3 e1000

alias eth4 e1000

alias bond0 bonding

options bond0 miimon=100 mode=1

8、重启虚拟机,bond及其他网卡工作正常。