06Spark 机器学习入门

带你入门使用Spark进行大数据分析

带你入门使用Spark进行大数据分析一、介绍Spark大数据分析Apache Spark是一个开源的、快速通用的集群计算系统,也是当前最流行的大数据处理框架之一。

Spark以其高效的内存计算和丰富的API支持,成为大数据处理和分析的首选工具之一。

本文将带你入门使用Spark进行大数据分析,介绍Spark的基本概念、结构和常用功能,帮助你开始使用Spark进行大数据分析。

二、Spark基本概念和架构1. Spark基本概念Spark由以下几个基本概念组成:- Resilient Distributed Dataset(RDD):Spark的核心数据结构,是一个分布式的、不可变的弹性数据集。

RDD可以并行计算,自动容错和恢复。

RDD可以从Hadoop、本地文件系统等数据源创建。

- DataFrame:Spark中的一种丰富的数据结构,类似于数据库中的表。

DataFrame支持结构化数据处理和SQL查询。

它是由多个RDD组成的分布式数据集合。

- Spark Core:Spark的核心模块,提供了RDD的实现和基本功能。

- Spark SQL:Spark的SQL和数据处理模块,提供了对结构化数据的处理和查询能力。

- Spark Streaming:Spark的流式处理模块,支持实时数据流处理。

- Machine Learning Library(MLlib):Spark的机器学习库,提供了丰富的机器学习算法和工具。

- Graph Processing System(GraphX):Spark的图处理模块,支持图数据的处理和分析。

2. Spark架构Spark的核心架构由以下几个组件组成:- Driver:Spark应用的驱动程序,负责定义Spark上的任务执行、创建RDD和提交Spark作业。

- Cluster Manager:集群管理器,用于在集群上启动和管理Spark应用程序。

常见的集群管理器包括Standalone、YARN和Mesos。

《Spark大数据编程基础(Scala版)》第九章 Spark机器学习原理

9.2.1 Pipeline概念

3.Estimator Estimator直译为评估器。其包括拟合和训练数据的所有

算法。通过执行以DataFrame为输入的fit()操作,生成一个模 型,该模型就是Transformer。例如:LogisticRegression是评 估器,通过执行fit()操作,训练产生LogisticRegressionModel, 即转换器。

9.1 Spark机器学习简介

spark.ml和spark.mllib都属于Spark的机器学习库,它们之 间的主要区别如下:

(1) spark.ml是升级版的spark.mllib,最新的Spark版本优 先支持spark.ml,2.0版本后,spark.mllib进入维护阶段,只进 行bug修复。

spark.ml.linalg 线性代数

spark.ml.recommendation 推荐

FPGrowth

Matrix Vector

ALS

spark.ml.regression 回归

AFTSurvivalRegression DecisionTreeRegressor RandomForestRegressor

9.1 Spark机器学习简介

目前(Spark2.3.0) spark.ml提供图9-1所示的API,在Spark 后续版本中,新的机器学习算法将加入spark.ml。

9.1 Spark机器学习简介

图 9-1 spark.ml库(Spark2.3.0)

9.1 Spark机器学习简介

spark.ml.fpm 关联规则

9.1 Spark机器学习简介 9.2 ML Pipeline 9.3 Spark机器学习数据准备 9.4 算法调优 9.5 本章小结

spark基础教程

spark基础教程Spark基础教程介绍了如何使用Spark进行数据处理和分析。

Spark是一个开源的分布式计算框架,旨在通过内存计算以及并行处理来加速大规模数据处理任务。

首先,我们需要安装Spark并配置环境。

Spark支持多种编程语言,包括Scala、Java、Python和R。

可以根据自己的需求选择合适的语言。

一旦环境配置完成,我们可以开始使用Spark的核心概念,如Resilient Distributed Datasets(RDDs)。

RDDs是Spark的灵魂,它代表了分布在集群中的不可变的分区数据集。

我们可以通过RDDs进行数据的转换和操作。

Spark提供了丰富的操作和转换函数,如map、filter、reduce 等,可以对RDDs进行各种运算。

此外,Spark还支持一些高级函数,如join、groupByKey等,用于更复杂的数据处理和分析。

在实际应用中,我们可能需要从外部数据源加载数据,如文本文件、HDFS、数据库等。

Spark提供了用于读取和存储数据的API,可以轻松处理不同格式的数据。

除了RDDs,Spark还引入了DataFrame和Dataset,用于进行结构化数据的处理。

DataFrame是具有命名列的分布式数据集,类似于关系型数据库中的表。

Dataset是DataFrame的扩展,提供了类型安全的API。

Spark还支持常见的机器学习和图计算算法,如分类、回归、聚类、图计算等。

可以使用MLlib进行机器学习任务,使用GraphX进行图计算。

最后,我们需要注意Spark的调优和性能优化。

Spark提供了多种机制来提高作业的性能,如广播变量、累加器、数据分区等。

理解这些机制并进行适当的优化可以显著提升Spark作业的效率。

总结一下,Spark基础教程介绍了Spark的安装和环境配置,RDDs的基本概念和操作,DataFrame和Dataset的使用,以及机器学习和图计算的应用。

【转载】Spark学习机器学习

【转载】Spark学习机器学习然后看的是机器学习这⼀块,因为偏理论,可以先看完。

其他的实践,再看。

“机器学习是⽤数据或以往的经验,以此优化计算机程序的性能标准。

” ⼀种经常引⽤的英⽂定义是:A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E。

可以看出机器学习强调三个关键词:算法、经验、效果,其处理过程如下图所⽰。

上图表明机器学习是数据通过算法构建出模型并对模型进⾏评估,评估的性能如果达到要求就拿这个模型来测试其他的数据,如果达不到要求就要调整算法来重新建⽴模型,再次进⾏评估,如此循环往复,最终获得满意的经验来处理其他的数据。

1.2 机器学习的分类1.2.1 监督学习监督是从给定的训练数据集中学习⼀个函数(模型),当新的数据到来时,可以根据这个函数(模型)预测结果。

监督学习的训练集要求包括输⼊和输出,也可以说是特征和⽬标。

训练集中的⽬标是由⼈标注(标量)的。

在监督式学习下,输⼊数据被称为“训练数据”,每组训练数据有⼀个明确的标识或结果,如对防垃圾邮件系统中“垃圾邮件”、“⾮垃圾邮件”,对⼿写数字识别中的“1”、“2”、“3”等。

在建⽴预测模型时,监督式学习建⽴⼀个学习过程,将预测结果与“训练数据”的实际结果进⾏⽐较,不断调整预测模型,直到模型的预测结果达到⼀个预期的准确率。

常见的监督学习算法包括回归分析和统计分类:l ⼆元分类是机器学习要解决的基本问题,将测试数据分成两个类,如垃圾邮件的判别、房贷是否允许等问题的判断。

l 多元分类是⼆元分类的逻辑延伸。

例如,在因特⽹的流分类的情况下,根据问题的分类,⽹页可以被归类为体育、新闻、技术等,依此类推。

机器学习初学者的入门教程

机器学习初学者的入门教程机器学习是一门能够让计算机学习和自主变得更加智能的领域。

随着技术的不断发展,机器学习被广泛应用于各个行业,包括医疗、金融、交通等。

对于初学者来说,入门机器学习可能有些困难,但只要掌握一些基本的概念和工具,你也可以从中受益。

下面将介绍一些机器学习的基本概念和入门教程,帮助你快速入门。

1. 了解基本概念在开始之前,先了解一些基本的机器学习术语是非常重要的。

首先,机器学习是一种通过计算机算法让机器从数据中学习,并根据学习结果做出决策的方法。

常见的机器学习任务有分类、回归、聚类和推荐等。

此外,还有一些重要的概念,如特征、模型、训练集和测试集等。

2. 学习Python编程语言Python是一种流行的编程语言,广泛应用于机器学习领域。

学习Python编程语言将使你能够使用各种机器学习工具和库,如NumPy、Pandas和Scikit-learn等。

你可以通过在线教程、视频课程和练习项目来学习Python编程语言。

3. 数据预处理在进行机器学习任务之前,首先需要对数据进行预处理。

数据预处理是指对原始数据进行清洗、转换和规范化的过程。

常见的数据预处理方法包括数据清洗、特征缩放、特征选择和缺失值处理等。

学习数据预处理是成为一名优秀机器学习工程师的重要一步。

4. 学习常见的机器学习算法学习常见的机器学习算法是入门的关键。

线性回归、逻辑回归、决策树和支持向量机是最基础的机器学习算法之一。

此外,还有一些更高级的算法,如随机森林、神经网络和深度学习等。

你可以通过阅读相关的教材、参加在线课程或者参与实践项目来学习这些算法。

5. 实践项目实践是学习机器学习的最佳方法之一。

找到一些适合初学者的机器学习项目并动手实践。

这些项目可以是分类任务,如手写数字识别;回归任务,如房价预测;或者聚类任务,如图像分割等。

通过实践项目,你可以更好地理解机器学习的原理和应用方法。

6. 参与机器学习社区加入机器学习社区,和其他学习者和专家进行交流和讨论,是一个快速学习的好方法。

机器学习入门教程

机器学习入门教程简介机器学习是一种人工智能(AI)领域的技术,它使计算机能够从数据中自动学习并改进性能,而不需要明确编程。

本教程旨在介绍机器学习的基础知识和常见的算法,以帮助初学者快速入门。

目录1.什么是机器学习2.机器学习的应用领域3.常见的机器学习算法•监督学习算法–线性回归–逻辑回归–决策树–支持向量机•无监督学习算法–K均值聚类–主成分分析(PCA)–关联规则挖掘(Apriori算法)4.数据预处理•数据清洗•特征选择和提取•数据转换和标准化5.模型评估与选择6.模型调优与参数优化7.实践案例展示什么是机器学习机器学习是一种通过对数据进行统计分析和模式识别来让计算机自动进行决策或预测的技术。

它基于数学和统计原理,利用算法和模型来让计算机从数据中学习,提取规律并应用于新的数据。

机器学习的应用领域机器学习已经广泛应用于各个领域,包括但不限于以下几个方面:•自然语言处理(NLP)•图像识别与处理•推荐系统•声音和语音识别•金融风控与欺诈检测•医疗诊断与预测•智能交通系统•智能物流和供应链管理常见的机器学习算法监督学习算法监督学习是一种通过已有的输入输出数据来训练模型,并利用该模型对未知数据进行预测或分类的方法。

线性回归线性回归是一种常见的监督学习算法,适用于对连续数值进行预测。

它建立了一个线性关系模型,通过最小化残差平方和来找到最优解。

逻辑回归逻辑回归是一种二分类问题的监督学习算法。

它通过将线性回归模型结合Sigmoid函数的输出进行转换,将连续值映射到概率范围内(0到1之间)。

决策树决策树是一种基于树状结构的分类算法,通过学习从特征到目标值的映射关系来进行预测。

它可以处理离散和连续型数据,并且易于解释和理解。

支持向量机支持向量机(SVM)是一种常用的监督学习算法,在二分类和多分类问题中都有良好的表现。

它通过在高维空间中找出最优分隔超平面来进行分类。

无监督学习算法无监督学习是一种通过对未标记数据的分析、挖掘和模式识别来进行模型训练的方法。

Spark学习总结 - 入门.

standalone 集群模式

On YARN 集群模式 On Mesos 集群模式 On cloud 集群模式

常用于本地开发测试,本地还分为local和local-

cluster 典型的Master/Slave模式,不过也能看出Master 是有单点故障的,Spark支持Zookeeper来实现

HA 运行在Yarn资源管理器框架之上,由Yarn负责资 源管理,Spark负责任务调度和计算 运行在mesos资源管理器框架之上,由mesos负 责资源管理,Spark负责任务调度和计算 比如Aws的EC2,使用这个模式能很方便地访问 Amazon的S3;Spark支持多种分布式存储系统 ,hdfs和S3、hbase等

五 运行模式

总之,这四种分布式部署方式各有利弊,通常需要根据公司情况 决定采用哪种方案。进行方案选择时,往往要考虑公司的技术路线( 采用Hadoop生态系统还是其他生态系统)、服务器资源(资源有限的 话就不要考虑standalone模式了)、相关技术人才储备等。

六 架构组成

六 架构组成

(1)Bagel(pregel on spark):Bagel是基于Spark的轻量级的 Pregel(Pregel是Google鼎鼎有名的图计算框架)的实现。

(7)Spark数据的存储:Spark支持多种数据底层存储,这点比Hadoop 支持的数据文件格式广泛的多。Spark可以兼容HDFS, Hbase,Amazon S3等多种数据集,将这些数据集封装成RDD进行操 作。

七 集群运行方式

八 核心RDD

RDD:是Spark的最基本抽象,是对分布式内存的抽象使用,实现了以 操作本地集合的方式来操作分布式数据集的抽象实现。RDD是Spark 最核心的东西,它表示已被分区,不可变的并能够被并行操作的数据 集合,不同的数据集格式对应不同的RDD实现。RDD必须是可序列化 的。RDD可以cache到内存中,每次对RDD数据集的操作之后的结果 ,都可以存放到内存中,下一个操作可以直接从内存中输入,省去了 MapReduce大量的磁盘IO操作。这对于迭代运算比较常见的机器学习 算法, 交互式数据挖掘来说,效率提升比较大。

机器学习入门ppt课件

朴素贝叶斯分类器:假定模型的的各个特征变量都是概率独立的,根据训练数据和分类标记的的联合分布概率来判定新数据的分类和回归值。优点:对于在小数据集上有显著特征的相关对象,朴素贝叶斯方法可对其进行快速分类场景举例:情感分析、消费者分类

机器学习应用的场景

1. 风控征信系统2. 客户关系与精准营销3. 推荐系统4. 自动驾驶5. 辅助医疗6. 人脸识别7. 语音识别8. 图像识别9. 机器翻译量化交易智能客服商业智能BI

机器学习的通用步骤

选择数据:将你的数据分成三组:训练数据、验证数据和测试数据 (训练效果,验证效果,泛化效果)

数据建模:使用训练数据来构建使用相关特征的模型 (特征:对分类或者回归结果有影响的数据属性,例如,表的字段) 特征工程。

训练模型:使用你的特征数据接入你的算法模型,来确定算法模型的类型,参数等。

测试模型:使用你的测试数据检查被训练并验证的模型的表现 (模型的评价标准 准确率,精确率,召回率等)

使用模型:使用完全训练好的模型在新数据上做预测

调优模型:使用更多数据、不同的特征或调整过的参数来提升算法的性能表现

机器学习的位置

传统编程:软件工程师编写程序来解决问题。首先存在一些数据→为了解决一个问题,软件工程师编写一个流程来告诉机器应该怎样做→计算机遵照这一流程执行,然后得出结果统计学:分析并比较变量之间的关系

机器学习:数据科学家使用训练数据集来教计算机应该怎么做,然后系统执行该任务。该计算可学习识别数据中的关系、趋势和模式

智能应用:智能应用使用人工智能所得到的结果,如图是一个精准农业的应用案例示意,该应用基于无人机所收集到的数据

机器学习的分类

1、 监督式学习工作机制:用有正确答案的数据来训练算法进行机器学习。代表算法:回归、决策树、随机森林、K – 近邻算法、逻辑回归,支持向量机等。2、非监督式学习工作机制:训练数据没有标签或者答案,目的是找出数据内部的关联和模式,趋势。代表算法:关联算法和 K – 均值算法。3、强化学习工作机制:给予算法一个不断试错,并具有奖励机制的场景,最终使算法找到最佳路径或者策略。代表算法:马尔可夫决策过程,AlphaGo+Zero, 蒙特卡洛算法4. 半监督学习 工作机制: 训练数据一部分数据为生成数据,一部分数据为监督数据,算法分为生成器和判定器两部分, 生成器的目标是使判定器接受自己的数据,判别器是为了最大可能的区分生成数据和监督数据。通过不断的训练使两者都达到最佳性能。代表算法: GANs(生成式对抗网络算法)

【Spark机器学习速成宝典】基础篇01Windows下spark开发环境搭建(Python版)

配置Spark

下载Spark

配置环境变量 变量名:SPARK_HOME 变量值:D:\spark (不能有空格)

添加到Path

安装pyspark包: 将spark/python中的pyspark和pyspark.egg-info拷贝到python的Anaconda2\Lib\site-packages目录下

根据下载的spark版本下载相应版本的hadoop271

【 Spark机器学习速成宝典】基础篇 01Windows下 spark开发环境搭jdk 安装 eclipse 安装 PyDev插件 配置 Spark 配置 Hadoop Python代码

x, y = random.random(), random.random() return x*x + y*y < 1 count = sc.parallelize(xrange(0, NUM_SAMPLES)) \

.filter(inside).count() print "Pi is roughly %f" % (4.0 * count / NUM_SAMPLES) '''运行结果: Pi is roughly 3.140160 '''

配置Hadoop

无需安装完整的Hadoop,但需要hadoop.dll,winutils.exe等。根据下载的Spark版本,下载相应版本的hadoop2.7.1。 链接: 密码:wdf9

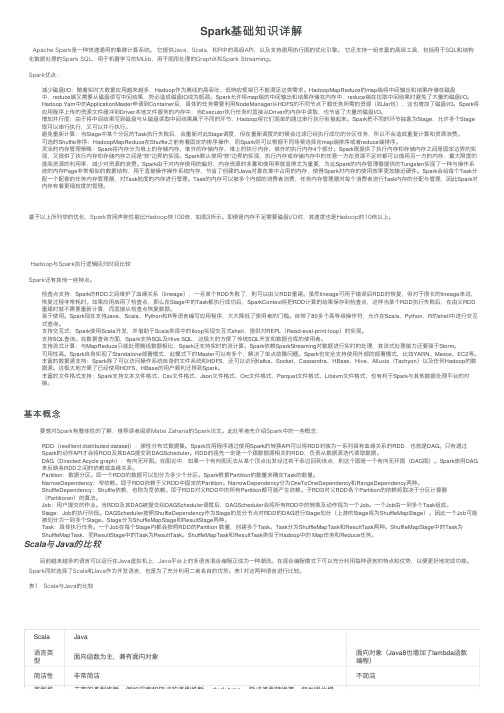

Spark基础知识详解

Spark基础知识详解Apache Spark是⼀种快速通⽤的集群计算系统。

它提供Java,Scala,和R中的⾼级API,以及⽀持通⽤执⾏图的优化引擎。

它还⽀持⼀组丰富的⾼级⼯具,包括⽤于SQL和结构化数据处理的Spark SQL,⽤于机器学习的MLlib,⽤于图形处理的GraphX和Spark Streaming。

Spark优点:减少磁盘I/O:随着实时⼤数据应⽤越来越多,Hadoop作为离线的⾼吞吐、低响应框架已不能满⾜这类需求。

HadoopMapReduce的map端将中间输出和结果存储在磁盘中,reduce端⼜需要从磁盘读写中间结果,势必造成磁盘IO成为瓶颈。

Spark允许将map端的中间输出和结果存储在内存中,reduce端在拉取中间结果时避免了⼤量的磁盘I/O。

Hadoop Yarn中的ApplicationMaster申请到Container后,具体的任务需要利⽤NodeManager从HDFS的不同节点下载任务所需的资源(如Jar包),这也增加了磁盘I/O。

Spark将应⽤程序上传的资源⽂件缓冲到Driver本地⽂件服务的内存中,当Executor执⾏任务时直接从Driver的内存中读取,也节省了⼤量的磁盘I/O。

增加并⾏度:由于将中间结果写到磁盘与从磁盘读取中间结果属于不同的环节,Hadoop将它们简单的通过串⾏执⾏衔接起来。

Spark把不同的环节抽象为Stage,允许多个Stage 既可以串⾏执⾏,⼜可以并⾏执⾏。

避免重新计算:当Stage中某个分区的Task执⾏失败后,会重新对此Stage调度,但在重新调度的时候会过滤已经执⾏成功的分区任务,所以不会造成重复计算和资源浪费。

可选的Shuffle排序:HadoopMapReduce在Shuffle之前有着固定的排序操作,⽽Spark则可以根据不同场景选择在map端排序或者reduce端排序。

灵活的内存管理策略:Spark将内存分为堆上的存储内存、堆外的存储内存、堆上的执⾏内存、堆外的执⾏内存4个部分。

spark入门及实践

2010’NJUPT

纲要

1 Spark综述 2 核心技术 3 Spark架构 4 BDAS简介

5 Spark安装部署 6 Spark应用实例 7 Scala简介

2010’NJUPT

三、Spark体系架构

1 架构组成 Master Worker

2010’NJUPT

三、Spark体系架构

2 架构图

2010’NJUPT

二、Spark关键技术

宽依赖和窄依赖的样例。每一个方框表示一个 RDD,其内的阴影矩 形表示 RDD 的分区。

2010’NJUPT

二、Spark关键技术

4 RDD算子

RDD操作算子,RDD中的操作算子可以分为两类: Transformation(变换)算子 与 Action(行动)算子。

Transformation

Transformation操作是延迟计算的,也就是说从一个 RDD转换生成另一个RDD的转换操作不是立即执行的,而是 需要等到Action操作是才真正出发运算。

Action

Action算子会触发Spark提交作业,并将数据输出到 Spark系统。

2010’NJUPT

二、Spark关键技术

6 spark的容错机制

2010’NJUPT

二、Spark关键技术

检查点支持: 虽然 lineage 可用于错误后 RDD 的恢复,但对于很长的 lineage 的 RDD 来说 ,这样的恢复耗时较长。由此,可以考虑将某些 RDD 进行检查点操作 (Checkpoint)保存到稳定存储上。 Spark 当前提供了为 RDD 设置检查点操作的 API , 让用户自行决定需要为哪些 数据设置检查点操作。 由于 RDD 的只读特性使得比常用的共享内存更容易做 checkpoint.由于不需要 关心一致性的问题,RDD 的写出可在后台进行,而不需要程序暂停或进行分布 式快照

Spark大数据处理系列之Machine Learning

Spark大数据处理系列之Machine Learning超人学院——机器学习和数据科学机器学习是从已经存在的数据进行学习来对将来进行数据预测,它是基于输入数据集创建模型做数据驱动决策。

数据科学是从海里数据集(结构化和非结构化数据)中抽取知识,为商业团队提供数据洞察以及影响商业决策和路线图。

数据科学家的地位比以前用传统数值方法解决问题的人要重要。

以下是几类机器学习模型:∙监督学习模型∙非监督学习模型∙半监督学习模型∙增强学习模型下面简单的了解下各机器学习模型,并进行比较:∙监督学习模型:监督学习模型对已标记的训练数据集训练出结果,然后对未标记的数据集进行预测;监督学习又包含两个子模型:回归模型和分类模型。

∙非监督学习模型:非监督学习模型是用来从原始数据(无训练数据)中找到隐藏的模式或者关系,因而非监督学习模型是基于未标记数据集的;∙半监督学习模型:半监督学习模型用在监督和非监督机器学习中做预测分析,其既有标记数据又有未标记数据。

典型的场景是混合少量标记数据和大量未标记数据。

半监督学习一般使用分类和回归的机器学习方法;∙增强学习模型:增强学习模型通过不同的行为来寻找目标回报函数最大化。

下面给各个机器学习模型举个列子:∙监督学习:异常监测;∙非监督学习:社交网络,语言预测;∙半监督学习:图像分类、语音识别;∙增强学习:人工智能(AI)。

机器学习项目步骤开发机器学习项目时,数据预处理、清洗和分析的工作是非常重要的,与解决业务问题的实际的学习模型和算法一样重要。

典型的机器学习解决方案的一般步骤:∙特征工程∙模型训练∙模型评估图1原始数据如果不能清洗或者预处理,则会造成最终的结果不准确或者不可用,甚至丢失重要的细节。

训练数据的质量对最终的预测结果非常重要,如果训练数据不够随机,得出的结果模型不精确;如果数据量太小,机器学习出的模型也不准确。

使用案例:业务使用案例分布于各个领域,包括个性化推荐引擎(食品推荐引擎),数据预测分析(股价预测或者预测航班延迟),广告,异常监测,图像和视频模型识别,以及其他各类人工智能。

0基础怎样入门Spark

0基础怎样入门Spark0基础怎样入门Spark,相信这是很多想学习大数据相关人员一直比较困惑的问题。

那么想要了解0基础怎样入门Spark,首先咱们需要了解什么是Spark。

下面随着科多老师一起来看看吧。

1.什么是SparkApache Spark是一个围绕速度、易用性和复杂分析构建的大数据处理框架。

最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apache 的开源项目之一。

与Hadoop和Storm等其他大数据和MapReduce技术相比,Spark有如下优势。

首先,Spark为我们提供了一个全面、统一的框架用于管理各种有着不同性质(文本数据、图表数据等)的数据集和数据源(批量数据或实时的流数据)的大数据处理的需求。

Spark可以将Hadoop集群中的应用在内存中的运行速度提升100倍,甚至能够将应用在磁盘上的运行速度提升10倍。

Spark让开发者可以快速的用Java、Scala或Python编写程序。

它本身自带了一个超过80个高阶操作符集合。

而且还可以用它在shell中以交互式地查询数据。

除了Map和Reduce操作之外,它还支持SQL查询,流数据,机器学习和图表数据处理。

开发者可以在一个数据管道用例中单独使用某一能力或者将这些能力结合在一起使用。

在这个Apache Spark文章系列的第一部分中,我们将了解到什么是Spark,它与典型的MapReduce解决方案的比较以及它如何为大数据处理提供了一套完整的工具。

2.Hadoop和SparkHadoop这项大数据处理技术大概已有十年历史,而且被看做是首选的大数据集合处理的解决方案。

MapReduce是一路计算的优秀解决方案,不过对于需要多路计算和算法的用例来说,并非十分高效。

数据处理流程中的每一步都需要一个Map阶段和一个Reduce阶段,而且如果要利用这一解决方案,需要将所有用例都转换成MapReduce模式。

在下一步开始之前,上一步的作业输出数据必须要存储到分布式文件系统中。

机器学习初学者必备知识点

机器学习初学者必备知识点机器学习是近年来备受瞩目的领域之一,它的应用非常广泛,如语言识别、图像识别、推荐系统、智能车辆等。

随着机器学习在各个领域的应用越来越广泛,机器学习初学者也越来越多。

本文将介绍机器学习初学者必备的知识点。

一、数学基础机器学习的基础是数学,因此初学者需要掌握一些基础的数学知识,如线性代数、概率论、统计学等。

其中,线性代数是机器学习中使用到最多的数学知识之一。

初学者需要掌握矩阵乘法、向量空间、行列式、特征值等基本的概念,并能够应用到实际的机器学习问题中。

概率论和统计学是机器学习中应用较多的知识点,如朴素贝叶斯、高斯混合模型等都是基于概率论和统计学建立的。

初学者需要掌握概率论中的基本概念和公式,如概率密度函数、条件概率、贝叶斯公式等,并且需要掌握统计学中的统计模型和参数估计方法等。

二、编程能力机器学习的实现需要编程能力,因此初学者需要掌握一门编程语言,如Python、Java、C++等。

其中,Python是机器学习领域应用最广泛的编程语言之一,因此初学者可以从学习Python开始。

初学者需要熟练掌握Python中的基本语法、数据类型、控制语句等,并需要了解Python中一些常用的机器学习库,如numpy、pandas、scikit-learn等。

三、机器学习算法机器学习是一个非常庞大的领域,其中包括了许多不同的算法。

初学者需要了解一些常用的机器学习算法,如线性回归、决策树、支持向量机、神经网络等,并能够应用到实际的机器学习问题中。

四、数据处理在机器学习中,数据处理是非常重要的一环。

数据处理的目的是将原始数据转化为可用于机器学习算法的数据格式。

初学者需要了解数据处理的基本概念和方法,如数据清洗、数据变换、特征工程等,并且需要掌握一些数据处理工具,如pandas、numpy 等。

五、实践能力机器学习是一门实践性很强的学科,理论知识需要通过实践才能够加深理解。

初学者需要通过实践来巩固所学知识,如通过一些开源的机器学习项目来练手、通过竞赛来提高自己的能力等。

机器学习的基础知识与入门教程(五)

机器学习的基础知识与入门教程机器学习是一门涉及人工智能领域的重要学科,通过训练模型使计算机可以通过数据学习,并且不需要明确地进行编程。

这种技术已经在各个行业得到广泛应用,包括医疗保健、金融、零售和交通。

本文将介绍机器学习的基础知识和入门教程,帮助初学者快速入门这一领域。

数据的重要性机器学习的核心在于数据。

数据是机器学习的“食物”,只有通过大量的数据来训练模型,才能使模型具有良好的预测能力。

因此,初学者需要理解数据的重要性,并且学会如何处理和准备数据。

这包括数据清洗、特征工程、数据标准化等步骤。

对于初学者来说,可以从一些公开的数据集开始,例如鸢尾花数据集、波士顿房价数据集等,这些数据集已经被广泛使用,可以帮助初学者更好地理解数据的结构和特征。

机器学习算法了解机器学习算法是入门的第一步。

常见的机器学习算法包括线性回归、逻辑回归、决策树、支持向量机、随机森林等。

每种算法都有自己的优缺点和适用场景,初学者需要理解这些算法的原理和应用。

此外,还需要学习如何评估算法的性能,常用的评估指标包括准确率、精确率、召回率、F1分数等。

编程工具和库机器学习需要使用编程工具和库来实现算法。

Python是目前机器学习最流行的编程语言,因为它有丰富的库和工具支持。

初学者可以通过学习Python来进行机器学习实践。

常用的机器学习库包括NumPy、Pandas、Scikit-learn、TensorFlow、Keras等。

这些库提供了丰富的函数和方法,可以帮助初学者更方便地实现机器学习算法。

实践项目理论知识固然重要,但实践项目同样不可或缺。

通过实践项目,初学者可以将所学的知识应用到实际问题中,加深对机器学习的理解。

建议初学者选择一些简单的项目开始,例如手写数字识别、垃圾邮件分类等。

随着实践的深入,可以逐渐挑战一些更复杂的项目,例如图像识别、自然语言处理等。

持续学习机器学习是一个不断发展的领域,新的算法和技术层出不穷。

因此,持续学习是非常重要的。

spark入门教程及经验总结

spark入门教程及经验总结问题导读1.cluster mode 模式运行包含哪些流程?2.yarn mode 运行模式有什么特点?3..在关闭http file server进程时,遇到什么错误?一、环境准备测试环境使用的cdh提供的quickstart vmhadoop版本:2.5.0-cdh5.2.0spark版本:1.1.0二、Hello Spark将/usr/lib/spark/examples/lib/spark-examples-1.1.0-cdh5.2.0-hado op2.5.0-cdh5.2.0.jar 移动到/usr/lib/spark/lib/spark-examples-1.1.0-cdh5.2.0-hadoop2.5.0-cd h5.2.0.jar执行程序./bin/run-example SparkPi 10日志分析:程序检查ip,host,SecurityManager启动sparkDriver。

通过akka工具启动一个tcp监听[akka.tcp://sparkDriver@192.168.128.131:42960]启动MapOutputTracker,BlockManagerMaster启动一个block manager,也就是ConnectionManagerId(192.168.128.131,41898),其中包含一个MemoryStore通过netty启动一个HTTP file server:SocketConnector@0.0.0.0:55161启动一个sparkUI:http://192.168.128.131:4040通过http上传本地程序运行Jar包连接HeartbeatReceiver:akka.tcp://sparkDriver@192.168.128.131:42960/user/Heartbeat ReceiverStarting job: reduce分析中job,有stage 0 (MappedRDD[1])添加并启动运行task Submitting 10 missing tasks from Stage 0通过http协议获取程序jar包,并添加到classloader完成task 后,将结果发送到driverscheduler.DAGScheduler完成Stage的所有task在localhost的scheduler.TaskSetManager收集完成的taskjob finishedStop Spark Web UIStop DAGSchedulerMapOutputTrackerActor stoppedstop ConnectionManagerMemoryStore clearedBlockManager stoppedShutting down remote daemon.Successfully stopped SparkContext三、cluster mode 运行模式运行流程::SparkContext 连接cluster Manager (either Spark’s own standalone cluster manager or Mesos/YARN),spark Application向Cluster Manager请求资源executors (运行计算和存储数据的线程)将程序Jar包或者python程序分发到executorsSparkContext发送tasks到executors上运行Cluster Manager 类型:Standalone Spark 内置的cluster manager,可以快速启动一个集群Apache Mesos 一个通用的Cluster manger,可以运行hadoop的Mapreduce和其他Service applicationsHadoop YARN Hadoop 2中的Clustger Manager主要概念TermMeaningApplicationUser program built on Spark. Consists of a driver program and executors on the cluster.Application jarA jar containing the user's Spark application. In some cases users will want to create an "uber jar" containing their application along with its dependencies. The user's jar should never include Hadoop or Spark libraries, however, these will be added at runtime.Driver programThe process running the main() function of the application and creating the SparkContextCluster managerAn external service for acquiring resources on the cluster (e.g. standalone manager, Mesos, YARN)Deploy modeDistinguishes where the driver process runs. In "cluster"mode, the framework launches the driver inside of the cluster. In "client" mode, the submitter launches the driver outside of the cluster.Worker nodeAny node that can run application code in the clusterExecutorA process launched for an application on a worker node, that runs tasks and keeps data in memory or disk storage across them. Each application has its own executors.TaskA unit of work that will be sent to one executorJobA parallel computation consisting of multiple tasks that gets spawned in response to a Spark action (e.g. save, collect); you'll see this term used in the driver's logs.StageEach job gets divided into smaller sets of tasks called stages that depend on each other (similar to the map and reduce stages in MapReduce); you'll see this term used in the driver's logs.。

机器学习入门指南(八)

机器学习入门指南随着科技的飞速发展,机器学习已经成为了科技领域的热门话题。

然而,对于大多数人来说,机器学习似乎是一个高深的领域,很难入门。

但实际上,只要有一定的学习方法和坚持,任何人都可以掌握机器学习的基础知识。

本文将从机器学习的基本概念、常见算法和实践方法等方面进行介绍,帮助初学者快速入门机器学习。

机器学习是一门涉及计算机科学、数学和统计学的跨学科领域,其目的是使计算机系统能够从数据中学习并改进性能。

在实际应用中,机器学习可以用于图像识别、语音识别、自然语言处理等多个领域。

要想入门机器学习,首先需要了解一些基本概念。

首先,了解机器学习的基本概念。

机器学习的核心思想是通过数据训练模型来实现预测或决策。

在这个过程中,我们需要关注几个重要概念。

首先是数据,数据是机器学习的基础,没有数据就没有机器学习。

其次是模型,模型是机器学习的核心,它是一个数学函数,将输入映射到输出。

最后是训练,训练是指通过数据来调整模型的参数,使其能够更好地拟合数据。

其次,了解机器学习的常见算法。

在机器学习领域,有许多不同的算法,每种算法都有自己的特点和适用场景。

常见的机器学习算法包括线性回归、逻辑回归、决策树、支持向量机、神经网络等。

这些算法可以用于不同的问题,比如分类、回归、聚类等。

初学者可以通过学习这些算法的原理和实现方式,来逐步掌握机器学习的基本方法。

最后,了解机器学习的实践方法。

要想真正掌握机器学习,理论知识远远不够,还需要通过实践来加深理解。

在实践过程中,可以选择一些开源的机器学习库,比如Scikit-learn、TensorFlow、PyTorch等,来实现机器学习模型。

此外,还可以参加一些相关的比赛或项目,比如Kaggle比赛、开源项目等,来锻炼自己的实战能力。

总的来说,机器学习是一个既有挑战性又有趣味性的领域,对于想要入门的初学者来说,需要耐心和恒心。

通过学习基本概念、常见算法和实践方法,相信任何人都可以成为一名合格的机器学习工程师。

机器学习的基础知识与入门教程(Ⅲ)

机器学习的基础知识与入门教程机器学习是一门兴起于近年的新兴科学领域,它涉及人工智能、统计学、数据挖掘等多个学科的知识。

机器学习通过建立数学模型,让计算机能够从数据中学习,并不断优化自身的表现,以完成特定任务。

在工业、医疗、金融等领域,机器学习已经得到了广泛的应用。

想要学习机器学习的人,可以按照以下步骤进行入门学习。

基础知识首先,了解机器学习的基础知识是入门的第一步。

机器学习的基础知识主要包括统计学、线性代数、概率论和编程语言等。

在统计学方面,了解基本的概念,比如平均值、方差、标准差等,对于理解机器学习模型的评估和优化是非常重要的。

而线性代数则是机器学习中常用到的数学工具,它涉及向量、矩阵、特征值等概念,是理解机器学习算法的基础。

此外,概率论也是机器学习中不可或缺的一部分,它涉及到概率分布、贝叶斯定理等内容,对于理解概率模型和贝叶斯网络非常重要。

最后,编程语言是机器学习实践中必不可少的一部分,Python是目前最流行的机器学习编程语言,掌握Python编程语言对于学习机器学习非常重要。

学习资源在掌握了机器学习的基础知识之后,就可以开始寻找合适的学习资源了。

有很多优秀的学习资源可以供选择,比如MOOC平台上的课程、机器学习领域的经典书籍、公开的数据集等。

《机器学习实战》、《统计学习方法》、《Python机器学习》等书籍都是非常不错的选择。

而在网上,Coursera、edX、Udacity等平台上也有很多优质的机器学习课程可以供选择。

另外,Kaggle等数据科学竞赛平台上也有很多公开的数据集和比赛,可以用来练习和实践。

实践项目除了学习理论知识,实践项目也是学习机器学习的重要一环。

选择一个合适的实践项目,通过动手实践,可以更好地巩固理论知识,同时也能够锻炼解决实际问题的能力。

比如,选择一个分类或者回归问题,使用机器学习算法对数据进行建模和预测。

在实践项目中,可以遇到各种问题,比如数据清洗、特征工程、模型选择、调参等,这些都是机器学习实践中非常重要的环节。

机器学习入门指南(十)

机器学习入门指南一、什么是机器学习?机器学习是一种人工智能的应用,它使计算机能够从数据中学习并逐渐改进性能。

与传统的编程方式不同,机器学习利用统计学和数学模型来训练计算机,使其能够从数据中发现规律和模式,并做出预测和决策。

二、为什么学习机器学习?随着大数据时代的到来,数据量呈现爆炸式增长,如何从海量数据中提取有价值的信息成为了一项重要的任务。

机器学习可以帮助我们挖掘数据中的潜在规律,进行预测和决策,为企业和个人带来巨大的商业和科研价值。

三、如何入门机器学习?1. 学习数学和统计学知识机器学习的理论基础主要是在数学和统计学上的,因此在学习机器学习之前,建议先打好数学和统计学的基础。

线性代数、微积分、概率论和统计学是机器学习所需的基本数学工具,掌握这些知识将对后续的学习大有裨益。

2. 学习编程机器学习的实现离不开编程,特别是Python语言在机器学习领域的应用非常广泛。

建议学习Python编程语言,并掌握一些常用的机器学习库,如Scikit-learn、TensorFlow等。

此外,熟悉一些数据处理和可视化工具也是必不可少的。

3. 学习机器学习算法了解并掌握一些常用的机器学习算法是入门的关键。

监督学习、无监督学习、强化学习等不同类型的算法都有着各自的特点和应用场景,掌握它们的原理和实现方式对于理解机器学习的内在逻辑非常重要。

4. 实践和项目最后,通过实际的项目练习来巩固所学的知识。

选择一些简单的数据集,尝试应用机器学习算法进行预测和决策,从中发现问题、解决问题,逐步提高自己的技能水平。

四、机器学习的发展趋势随着技术的不断进步和应用场景的不断扩展,机器学习领域也在不断发展和演进。

深度学习、自然语言处理、计算机视觉等新技术的涌现为机器学习带来了新的发展机遇,也给学习者提出了更高的要求。

总结机器学习是一门前沿的科学,它不仅让计算机能够更智能地处理数据,也为我们的生活和工作带来了巨大的变革。

学习机器学习需要全面的知识储备和实践能力,但只要坚持不懈,相信每个人都可以成为一名合格的机器学习从业者。

机器学习入门教程(Ⅲ)

机器学习入门教程机器学习是一门涉及数据分析、模式识别和人工智能的领域,它的应用范围非常广泛,包括自然语言处理、图像识别、医学诊断等。

随着数据量的急剧增加和计算能力的提升,机器学习的应用也越来越广泛。

本文将介绍机器学习的基本概念和入门教程,帮助读者快速了解并入门机器学习。

数据预处理在进行机器学习之前,我们首先需要对数据进行预处理。

数据预处理是机器学习的第一步,它包括数据清洗、数据转换和特征选择。

数据清洗是指处理数据中的缺失值、异常值和重复值,保证数据的质量。

数据转换是指将数据转换成适合机器学习算法的形式,例如将分类数据转换成数值型数据。

特征选择是指选择对于机器学习任务有用的特征,去除无用的特征。

模型选择选择合适的机器学习模型是机器学习的核心。

常见的机器学习模型包括线性回归、逻辑回归、决策树、支持向量机和神经网络等。

不同的模型适用于不同的问题,因此需要根据具体的问题选择合适的模型。

在选择模型的过程中,需要考虑模型的复杂度、准确性和运行时间等因素。

模型训练模型训练是指利用已有的数据来训练模型,使其能够对新数据进行预测。

在模型训练的过程中,我们需要将数据分为训练集和测试集,用训练集来训练模型,然后用测试集来评估模型的性能。

常见的评估指标包括准确率、精确度、召回率和F1值等。

根据评估指标来选择合适的模型和调整模型的参数。

模型评估模型评估是机器学习中非常重要的一步,它用于评估模型的性能。

常见的模型评估方法包括交叉验证、ROC曲线和混淆矩阵等。

交叉验证是一种常用的模型评估方法,它将数据分为多个子集,然后用其中的一个子集作为测试集,其余子集作为训练集,重复多次得到不同的测试集和训练集,最后对模型性能进行平均。

ROC 曲线是一种评估分类模型性能的方法,它可以用来选择合适的阈值来平衡模型的准确率和召回率。

模型部署模型部署是指将训练好的模型应用到实际问题中。

在模型部署的过程中,我们需要考虑模型的性能、可扩展性和实时性等因素。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

DATAGURU

专业数据分析社区

第六课:Spark

机器学习入门

法律声明

【声明】本视频和幻灯片为炼数成金网络课程的教学资料,所有资料只能在课程内使用,不得在课程以外范围散播,违者将可能被追究法律和经济责任。

课程详情访问炼数成金培训网站

上周回顾

SparkStreaming

–无状态操作

–状态操作

–windows操作

本周内容

机器学习

–定义

–分类

–常用算法

Mllib

–什么是MLlib

–MLlib构成

–MLlib的运行架构

实例演示

–K-Means算法介绍和实例

–协同过滤 算法介绍和实例

机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能。

机器学习是对能通过经验自动改进的计算机算法的研究。

机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。

A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E.算法T 模型E

评估

P

机器学习应用十分广泛

–数据挖掘

–计算机视觉

–自然语言处理–生物特征识别–搜索引擎

–医学诊断

–检测信用卡欺诈–证券市场分析–DNA序列测序–语音和手写识别–

战略游戏和机器人运用2012最佳科技图表:

http://shijue.me/show_idea/50d129c48ddf872e41000252

机器学习分类

监督学习从给定的训练数据集中学习出一个函数(模型),当新的数据到来时,可以根据这个函数(模型)预测结果。

监督学习的训练集要求是包括输入和输出,也可以说是特征和目标。

训练集中的目标是由人标注(标量)的。

常见的监督学习算法包括回归分析和统计分类。

–二元分类是ML要解决的基本问题,将测试数据分成两个类。

如垃圾邮件的判别、房贷是否允许等等问题的判断。

–多元分类是二元分类的逻辑延伸。

例如,在因特网的流分类的情况下,根据问题的网页可以被归类为体育,新闻,技术,或成人/色情,依此类推。

无监督学习与监督学习相比,训练集没有人为标注的结果。

常见的无监督学习算法有聚类。

半监督学习介于监督学习与无监督学习之间。

增强学习通过观察来学习做成如何的动作。

每个动作都会对环境有所影响,学习对象根据观察到的周围环境的反馈来做出判断。

机器学习常用算法

一个数据集可以采用多种算法来

进行机器学习

本周内容

机器学习

–定义

–分类

–常用算法

Mllib

–什么是MLlib

–MLlib构成

–MLlib的运行架构

实例演示

–K-Means算法介绍和实例

–协同过滤 算法介绍和实例

什么是MLlib

为什么MLlib

性能集成易用

Utilities

基础部分

–Local vector

●Dense V ector

●Sparse V ector

–Labeled point

–Local matrix

–Distributed matrix

●R owMatrix

–Multivariate summary statistics

●I ndexed R owMatrix

●C oordinateMatrix

V ector

Double

Local Matrix

Double

Distributed Matrix

Double

Long RDD1 RDD2

RDDN ...

R owMatrix

I ndexed R owMatrix

C oordinateMatrix

a tuple of (i: Long,

j: Long,

value: Double)

算法部分

更多详情请关注

MLlib课程

MLlib构成 实用程序部分

MLlib运行结构

本周内容

机器学习

–定义

–分类

–常用算法

Mllib

–什么是MLlib

–MLlib构成

–MLlib的运行架构

实例演示

–K-Means算法介绍和实例

–协同过滤 算法介绍和实例

实例演示

K-Means是聚类的一个算法,是一个无监督学习,目标是将一部分实体根据某种意义上的相似度和另一部分实体聚在一起。

聚类通常被用于探索性的分析。

算法:

–1选择K个点作为初始中心

–2将每个点指派到最近的中心,形成K个簇(聚类)

–3重新计算每个簇的中心

–4重复2-3直至中心不发生变化

距离

–绝对值距离

–欧氏距离

–闵可夫斯基距离

–切比雪夫距离

–马氏距离

MLlib K-Means的实现中包含一个 k-means++方法的并行化变体 kmeans||。

MLlib 里面的实现有如下的参数:

–k 是所需的类簇的个数。

–max I terations 是最大的迭代次数。

–initiali z ationMode 这个参数决定了是用随机初始化还是通过 k-means||进行初始化。

–runs 是跑k-means 算法的次数(k-mean 算法不能保证能找出最优解,如果在给定的数据集上运行多次,算法将会返回最佳的结果)。

–initiali z iationSteps 决定了k-means||算法的步数。

–epsilon 决定了判断 k-means 是否收敛的距离阀值。

协同过滤常被应用于推荐系统。

这些技术旨在补充用户-商品关联矩阵中所缺失的部分。

MLlib当前支持基于模型的协同过滤,其中用户和商品通过一小组隐性因子进行表达,并且这些因子也用于预测缺失的元素。

MLLib使用交替最小二乘法(ALS)来学习这些隐性因子。

在 MLlib 中的实现有如下的参数:

–num B locks 是用于并行化计算的分块个数 (设置为-1为自动配置)。

–rank 是模型中隐性因子的个数。

–iterations 是迭代的次数。

–lambda 是ALS的正则化参数。

–implicitPrefs 决定了是用显性反馈ALS的版本还是用适用隐性反馈数据集的版本。

–alpha 是一个针对于隐性反馈ALS 版本的参数,这个参数决定了偏好行为强度的基准

课程回顾

机器学习

MLlib

下周G raph X

–G raph X原理

–G ranp X实例

Thanks

FAQ时间。