带激活函数的梯度下降及线性回归算法和matlab代码_20170522

matlab 中gradient的计算

Matlab中的gradient函数是用于计算多变量函数的梯度。

梯度是一个向量,它由函数的偏导数组成。

在Matlab中,gradient函数可以接受标量函数或多元函数作为输入,并返回函数在每个维度上的梯度向量。

1. gradient函数的语法在Matlab中,gradient函数的基本语法如下所示:```matlab[gx,gy] = gradient(f)```其中,f是要计算梯度的函数, gx和gy分别是f在x和y方向上的梯度。

2. gradient函数的工作原理gradient函数通过计算函数在每个维度上的偏导数来计算梯度。

它使用中心差分法来近似计算偏导数。

假设我们要计算函数f(x, y)在点(x0, y0)处的梯度,那么可以通过以下公式来计算:```matlabgx = (f(x0+hx, y0) - f(x0-hx, y0)) / 2hxgy = (f(x0, y0+hy) - f(x0, y0-hy)) / 2hy```其中,hx和hy分别是x和y方向上的步长。

gradient函数会自动选择一个合适的步长来计算梯度,通常情况下我们不需要设置步长。

3. gradient函数的用法在Matlab中,gradient函数可以接受不同类型的输入,包括标量函数和多元函数。

下面分别介绍这两种情况下的用法。

(1)标量函数的梯度计算对于标量函数f(x, y),我们可以直接使用gradient函数来计算其梯度。

对于函数f(x, y) = x^2 + y^2,我们可以这样计算其梯度:```matlab[x, y] = meshgrid(-2:0.1:2, -2:0.1:2);f = x.^2 + y.^2;[gx, gy] = gradient(f);```在这个例子中,我们首先使用meshgrid函数生成一个网格,然后计算函数f在每个点上的值,并将其传递给gradient函数来计算梯度。

(2)多元函数的梯度计算对于多元函数f(x1, x2, ..., xn),我们也可以使用gradient函数来计算其梯度。

matlab梯度算法

matlab梯度算法Matlab梯度算法在数学和计算机科学中,梯度是指一个多元函数在某一点上的变化率或斜率。

梯度算法是一种优化算法,用于找到函数的最小值或最大值。

在Matlab中,有多种方法可以使用梯度算法来优化函数,包括梯度下降和共轭梯度法。

本文将详细介绍Matlab中的梯度算法,并逐步讲解其原理和应用。

I. 梯度下降法梯度下降法是一种基于迭代的优化算法,通过计算函数的梯度来更新参数的值,以逐步接近函数的最小值。

在Matlab中,可以使用"gradientDescent"函数来实现梯度下降法。

1. 实现梯度下降法首先,我们需要定义一个优化目标函数,例如:f(x) = x^2 + 2x + 1。

然后,定义其梯度函数为g(x) = 2x + 2。

接下来,我们可以使用以下代码来计算梯度下降:matlab定义优化目标函数f = (x) x^2 + 2*x + 1;定义梯度函数g = (x) 2*x + 2;初始化参数x0 = 0;设置学习率和迭代次数alpha = 0.01;iterations = 100;梯度下降法for i = 1:iterationsx0 = x0 - alpha * g(x0);end打印最优解disp(['Optimal solution: ', num2str(x0)]);在这个例子中,我们使用了学习率(alpha)为0.01,迭代次数(iterations)为100。

通过不断更新参数x0的值,最终得到了最优解。

2. 梯度下降法的原理梯度下降法的核心思想是利用函数在当前点的梯度信息来更新参数的值,以便能够向着函数的最小值前进。

具体来说,算法的步骤如下:a. 初始化参数的值:选择一个初始参数的值作为起始点。

b. 计算梯度:计算函数在当前点的梯度,即求解函数关于参数的偏导数。

c. 更新参数:根据当前点的梯度和学习率,通过减去梯度的乘积来更新参数的值。

梯度算法的Matlab实现

梯度算法的Matlab 实现⼀、通过⼀个例⼦来看梯度下降法是怎么算的函数,求解其最⼩值 1.求解梯度函数 2.给定初始点,计算出该点的梯度,开始迭代 3.计算初始点梯度模,判断是否满⾜终⽌条件,如果满⾜,得到终点。

如果不满⾜,求得当前最优的学习率,然后迭代。

function [k ender]=steepest(f,x,e)% 梯度下降法函数function [k ender]=steepest(f,x,e),需要三个参数f 、x 和e,其中% f 为⽬标函数,x 为初始点,e 为终⽌误差。

输出也为两个参数,k 表⽰迭代的次数,% ender 表⽰找到的最低点。

%梯度下降法,f 为⽬标函数(两变量x1和x2),x 为初始点,如[3;4]syms x1 x2 m; %m 为学习率d=-[diff(f,x1);diff(f,x2)]; %分别求x1和x2的偏导数,即下降的⽅向flag=1; %循环标志k=0; %迭代次数while(flag)d_temp=subs(d,x1,x(1)); %将起始点代⼊,求得当次下降x1梯度值d_temp=subs(d_temp,x2,x(2)); %将起始点代⼊,求得当次下降x2梯度值nor=norm(d_temp); %范数if(nor>=e)x_temp=x+m*d_temp; %改变初始点x 的值f_temp=subs(f,x1,x_temp(1)); %将改变后的x1和x2代⼊⽬标函数f_temp=subs(f_temp,x2,x_temp(2));h=diff(f_temp,m); %对m 求导,找出最佳学习率m_temp=solve(h); %求⽅程,得到当次mx=x+m_temp*d_temp; %更新起始点xk=k+1;elseflag=0;endendender=double(x); %终点end 其中的初始点设为[3;3],误差设为10^(-20);结果为迭代27次找到了[2;1]点为最值点。

matlab中的优化算法

MATLAB是一个广泛用于数值计算的编程环境,它提供了许多优化算法,用于解决各种优化问题。

以下是一些常见的MATLAB优化算法及其基本描述:1. 梯度下降法:梯度下降法是一种常用的优化算法,用于找到函数的最小值。

它通过迭代地更新参数,以减少目标函数(我们的优化目标)的梯度(即对目标函数的斜率)。

2. 牛顿法:牛顿法是一种更高级的优化算法,它利用泰勒级数的前几项来近似目标函数,从而找到其最小值。

这种方法对于在局部找到最优解非常有效,但在某些情况下可能无法收敛。

3. 拟牛顿法:拟牛顿法是一种改进的牛顿法,它使用更复杂的矩阵形式来近似Hessian矩阵,从而加速了搜索过程。

常见的拟牛顿算法包括BFGS、LBFGS等。

4. 共轭梯度法:共轭梯度法是一种使用共轭方向作为搜索方向的梯度下降方法。

这种方法可以找到具有非线性目标函数的局部最优解。

5. 坐标下降法:坐标下降法是一种在多维空间中同时优化多个变量的优化算法。

这种方法通过逐步优化每个变量,以同时减少目标函数的总和。

6. 模拟退火算法:模拟退火算法是一种概率优化算法,它通过随机选择和跳出局部最优解来寻找全局最优解。

这种方法在处理大规模问题时非常有效。

7. 遗传算法:遗传算法是一种基于生物进化理论的优化算法,它通过模拟自然选择和遗传过程来寻找最优解。

这种方法适用于解决具有复杂和不确定性的优化问题。

这些算法在MATLAB中都有相应的实现,用户可以根据问题的具体需求选择合适的算法。

此外,MATLAB还提供了许多其他工具箱和函数,如控制系统工具箱、信号处理工具箱等,这些工具箱也提供了许多优化算法的实现。

总的来说,MATLAB的优化算法非常丰富,用户可以根据问题的具体需求选择合适的算法,并利用MATLAB提供的强大功能进行数值计算和仿真分析。

三元函数梯度下降matlab代码

三元函数梯度下降 Matlab 代码一、引言在数学和计算机科学领域,梯度下降是一种常用的优化算法,用于最小化一个函数的值。

对于多元函数,我们可以使用梯度下降算法来求解函数的最小值点。

在本篇文章中,我将着重讨论三元函数的梯度下降,并共享针对该算法的 Matlab 代码实现。

二、梯度下降算法简介梯度下降是一种迭代优化算法,其基本思想是通过不断沿着函数梯度的相反方向更新参数,直到达到函数的最小值点。

对于三元函数,我们需要求解的是函数在三维空间中的最小值点,而梯度下降算法就能很好地实现这一目标。

三、三元函数的梯度下降 Matlab 代码实现我们首先定义一个三元函数,例如 f(x, y, z) = x^2 + y^2 + z^2,然后编写Matlab 代码来实现梯度下降算法。

以下是一个简单的示例:```matlab% 定义三元函数function f = three_variable_function(x, y, z)f = x^2 + y^2 + z^2;end% 梯度下降算法实现function [min_point, min_value] = gradient_descent() learning_rate = 0.1; % 学习率max_iterations = 1000; % 最大迭代次数precision = 0.0001; % 收敛精度x = 3; % 初值y = 4;z = 5;for i = 1:max_iterationsgrad_x = 2*x; % 计算梯度grad_y = 2*y;grad_z = 2*z;x = x - learning_rate * grad_x; % 参数更新y = y - learning_rate * grad_y;z = z - learning_rate * grad_z;f_val = three_variable_function(x, y, z); % 计算函数值 if abs(f_val) < precision % 判断收敛break;endendmin_point = [x, y, z]; % 最小值点min_value = f_val; % 最小值end```以上代码中,我们首先定义了一个简单的三元函数three_variable_function,并在 gradient_descent 函数中实现了梯度下降算法,最终得到了函数的最小值点和最小值。

三种梯度下降代码

三种梯度下降代码梯度下降是机器学习中常用的优化算法,用于最小化代价函数。

在实际应用中,有多种不同的梯度下降算法可以选择。

下面介绍三种常见的梯度下降算法的代码实现。

1. 批量梯度下降(Batch Gradient Descent)批量梯度下降是最基本的梯度下降算法。

它的特点是每次迭代计算所有样本的梯度,因此收敛速度较慢,但最终精度较高。

具体实现如下:```pythondef batch_gradient_descent(X, y, theta, alpha,num_iters):m = len(y)for i in range(num_iters):h = X.dot(theta)theta = theta - alpha * (1/m) * (X.T.dot(h-y))return theta```其中,X是特征矩阵,y是目标变量向量,theta是参数向量,alpha是学习率,num_iters是迭代次数。

2. 随机梯度下降(Stochastic Gradient Descent)随机梯度下降是每次只随机选择一个样本进行梯度计算和参数更新。

因此收敛速度较快,但最终精度不如批量梯度下降。

具体实现如下:```pythondef stochastic_gradient_descent(X, y, theta, alpha, num_iters):m = len(y)for i in range(num_iters):for j in range(m):h = X[j].dot(theta)theta = theta - alpha * (h - y[j]) * X[j]return theta```其中,X、y、theta、alpha和num_iters的含义与批量梯度下降相同。

3. 小批量梯度下降(Mini-batch Gradient Descent)小批量梯度下降是介于批量梯度下降和随机梯度下降之间的一种方法。

matlab实现梯度下降法(GradientDescent)的一个例子

matlab 实现梯度下降法(GradientDescent )的⼀个例⼦ 在此记录使⽤matlab 作梯度下降法(GD)求函数极值的⼀个例⼦: 问题设定: 1. 我们有⼀个n 个数据点,每个数据点是⼀个d 维的向量,向量组成⼀个data 矩阵X ∈R n ×d ,这是我们的输⼊特征矩阵。

2. 我们有⼀个响应的响应向量y ∈R n 。

3. 我们将使⽤线性模型来fit 上述数据。

因此我们将优化问题形式化成如下形式:arg min w f (w )=1n ‖y −¯X w ‖22 其中¯X =(1,X )∈R n ×(d +1) and w =(w 0,w 1,...,w d )⊤∈R d +1 显然这是⼀个回归问题,我们的⽬标从通俗意义上讲就是寻找合适的权重向量w ,使得线性模型能够拟合的更好。

预处理: 1. 按列对数据矩阵进⾏最⼤最⼩归⼀化,该操作能够加快梯度下降的速度,同时保证了输⼊的数值都在0和1之间。

x i 为X 的第i 列。

z ij ←x ij −min (x i )max (x i )−min (x i ) 这样我们的优化问题得到了转化:arg minu g (w )=1n ‖y −¯Z u ‖22 2. 考虑对⽬标函数的Lipschitz constants 进⾏估计。

因为我们使⽤线性回归模型,Lipschitz constants 可以⽅便求得,这样便于我们在梯度下降法是选择合适的步长。

假如⾮线性模型,可能要⽤其他⽅法进⾏估计(可选)。

问题解决: 使⽤梯度下降法进⾏问题解决,算法如下: 我们可以看到,这⾥涉及到求⽬标函数f 对x k 的梯度。

显然在这⾥,因为是线性模型,梯度的求解⼗分的简单:∇f (x k )=−2n ¯X ⊤(y −¯X u k ) 进⾏思考,还有没有其他办法可以把这个梯度给弄出来?假如使⽤Tensorflow ,Pytorch 这样可以⾃动保存计算图的东东,那么梯度是可以由机器⾃动求出来的。

最速下降法matlab代码

最速下降法matlab代码最速下降法(Steepest Descent Method)是一种用于数值优化问题的迭代算法。

下面是一个简单的最速下降法的MATLAB 代码示例:1.定义目标函数function f = objective(x)f = x(1)^2 + 4*x(2)^2 - 4*x(1) - 8*x(2); % 示例目标函数,可根据实际问题进行修改end2.定义目标函数的梯度function g = gradient(x)g = [2*x(1) - 4; 8*x(2) - 8]; % 示例目标函数的梯度,可根据实际问题进行修改end3.最速下降法function steepestDescent()x = [0; 0]; % 初始点epsilon = 1e-6; % 收敛准则,可根据实际问题调整maxIterations = 1000; % 最大迭代次数,可根据实际问题调整for k = 1:maxIterationsg = gradient(x); % 计算梯度if norm(g) < epsilon % 判断梯度范数是否小于收敛准则break;endalpha = 0.01; % 步长,可根据实际问题调整x = x - alpha * g; % 更新参数enddisp('Optimization Results:');disp('---------------------');disp(['Iterations: ', num2str(k)]);disp(['Minimum point: (', num2str(x(1)), ', ', num2str(x(2)), ')']);disp(['Objective function value: ', num2str(objective(x))]);end4.调用最速下降法函数steepestDescent();上述代码包含了以下几个关键部分:objective 函数:定义了目标函数,根据实际问题进行修改。

matlab 梯度下降法编程

梯度下降法是一种常用的优化算法,可用于求解最优化问题。

在MATLAB 中,我们可以通过编写梯度下降法的程序来解决各种复杂的优化问题。

本文将深入介绍 MATLAB 中梯度下降法的编程方法,并根据其深度和广度要求,逐步探讨梯度下降法的原理、实现步骤、优化调节和应用场景,帮助读者全面理解和掌握这一优化算法。

1. 梯度下降法的原理梯度下降法是一种迭代优化算法,其基本原理是不断沿着目标函数的负梯度方向更新参数,直至达到局部最小值或全局最小值。

在MATLAB 中,我们可以利用数值计算和矩阵运算来实现梯度下降法,通过不断迭代来更新参数并逐步逼近最优解。

2. 梯度下降法的实现步骤在 MATLAB 中实现梯度下降法主要包括以下步骤:定义目标函数、计算目标函数的梯度、选择学习率和迭代次数、初始化参数、通过循环迭代更新参数直至收敛。

通过编写 MATLAB 程序来实现这些步骤,我们可以轻松地对各种复杂的优化问题进行求解。

3. 优化调节和应用场景在实际应用中,梯度下降法的效果受到学习率和迭代次数的影响,因此需要进行适当的优化调节。

在 MATLAB 中,我们可以通过调节学习率和设置合理的停止准则来提高梯度下降法的收敛速度和稳定性。

梯度下降法在机器学习、神经网络训练、参数优化等领域有着广泛的应用场景,通过 MATLAB 编程可以快速应用于实际问题中。

总结回顾通过本文的介绍,我们全面了解了 MATLAB 中梯度下降法的编程方法。

从梯度下降法的原理到实现步骤,再到优化调节和应用场景,我们逐步深入地探讨了这一优化算法。

在实际编程中,我们需要注意学习率和迭代次数的选择,并结合具体问题进行调节优化。

梯度下降法在各种优化问题中具有广泛的应用,通过 MATLAB 编程可以轻松应用于实际场景中。

个人观点和理解我个人认为,掌握 MATLAB 中梯度下降法的编程方法对于解决各种复杂的优化问题非常重要。

通过编写梯度下降法的程序,我们可以深入理解优化算法的原理,并在实际问题中灵活应用。

梯度下降法及一元线性回归的python实现

梯度下降法及⼀元线性回归的python实现梯度下降法及⼀元线性回归的python实现⼀、梯度下降法形象解释 设想我们处在⼀座⼭的半⼭腰的位置,现在我们需要找到⼀条最快的下⼭路径,请问应该怎么⾛?根据⽣活经验,我们会⽤⼀种⼗分贪⼼的策略,即在现在所处的位置上找到⼀个能够保证我们下⼭最快的⽅向,然后向着该⽅向⾏⾛;每到⼀个新位置,重复地应⽤上述贪⼼策略,我们就可以顺利到达⼭底了。

其实梯度下降法的运⾏过程和上述下⼭的例⼦没有什么区别,不同的是我们⼈类可以凭借我们的感官直觉,根据所处的位置来选择最佳的⾏⾛⽅向,⽽梯度下降法所依据的是严格的数学法则来进⾏每⼀步的更新。

本⽂不再对该算法进⾏严格的数理讨论,只介绍梯度下降法进⾏数据拟合的流程和利⽤梯度下降法解决⼀元线性回归的python实现。

⼆、梯度下降法算法应⽤流程 假设有⼀组数据X=[x1,x2,x3,...],Y=[y1,y2,y3,...],现求由X到Y的函数关系: 1、为所需要拟合的数据,构造合适的假设函数:y=f(x;θ),以θ=[θ1,θ2,θ3,...]为参数; 2、选择合适的损失函数:cost(θ),⽤损失函数来衡量假设函数对数据的拟合程度; 3、设定梯度下降法的学习率α,参数的优化初始值及迭代终⽌条件; 4、迭代更新θ,直到满⾜迭代终⽌条件,更新公式为: θ1=θ1-α*dcost(θ)/dθ1, θ2=θ2-α*dcost(θ)/dθ2,...三、⼀元线性回归的python实现 下⾯以⼀个⼀元线性回归的例⼦来更进⼀步理解梯度下降法的过程。

笔者通过在函数y=3*x+2的基础之上添加⼀些服从均匀分布的随机数来构造如下的待拟合数据:X,Y,训练数据图像如下图1所⽰。

假设函数为⼀元线性函数: y=f(x;θ,k)=θ*x+k,损失函数为:cost(θ,k)=1/2*∑(f(x i;θ,k)-y i),x i属于X,y i属于Y,损失函数的图像如下图2所⽰。

梯度优化算法在matlab中的实现

梯度优化算法在Matlab中的实现梯度优化算法是一种常用的数值优化算法,它通过不断迭代来寻找函数的最小值或最大值。

在机器学习和深度学习领域,梯度优化算法被广泛应用于优化模型的参数,以使模型能够更好地拟合数据。

在本文中,我们将探讨梯度优化算法在Matlab中的实现,并深入了解这一算法的原理和应用。

一、梯度下降算法梯度下降算法是梯度优化算法的一种,它通过不断迭代来更新参数,使目标函数的值不断减小。

在梯度下降算法中,关键的步骤是计算目标函数对参数的梯度,然后沿着梯度的反方向更新参数。

这一过程持续进行,直到达到收敛条件为止。

在Matlab中实现梯度下降算法可以通过以下步骤进行:1. 定义目标函数在Matlab中,首先需要定义目标函数,即待优化的函数。

我们可以定义一个简单的目标函数如下:```matlabfunction y = target_function(x)y = x^2;end```2. 计算梯度接下来,需要计算目标函数对参数的梯度。

在Matlab中,可以使用内置的gradient函数来计算梯度。

对于上述的目标函数,可以这样计算梯度:```matlabx = 1;dx = gradient(@target_function, x);```3. 更新参数有了梯度之后,就可以沿着梯度的反方向更新参数。

在梯度下降算法中,参数的更新公式为:```matlablearning_rate = 0.1;x = x - learning_rate * dx;```通过以上步骤,就可以在Matlab中实现简单的梯度下降算法了。

二、常见的梯度优化算法除了简单的梯度下降算法之外,还有一些其他常见的梯度优化算法,如随机梯度下降(SGD)、动量法(Momentum)、Adam算法等。

这些算法在不同的场景下有不同的表现,需要根据具体问题来选择合适的算法。

在Matlab中,这些算法都有成熟的实现,可以方便地调用和使用。

三、个人观点和理解梯度优化算法在机器学习和深度学习领域扮演着至关重要的角色。

梯度下降法matlab代码

梯度下降法matlab代码梯度下降法matlab代码是一种基于梯度下降的机器学习算法,它的核心思想是:在每次迭代中,以当前参数值计算损失函数的梯度,根据梯度更新参数值,使得参数值不断趋向于使损失函数最小值。

它是目前最流行的机器学习优化方法之一,可用于解决回归、分类等问题。

梯度下降法matlab代码的具体实现步骤如下:1.加载数据:首先,根据实际情况,加载所需要的数据集,并将其分割成训练集和测试集。

2.初始化参数:接下来,需要初始化模型参数,可以采用随机初始化法,也可以采用其他方法(如高斯分布)。

3.计算损失函数:接下来,需要计算损失函数,可以采用常见的损失函数,如均方误差(MSE)、交叉熵(CE)等。

4.计算梯度:然后,需要计算损失函数的梯度,以便进行参数更新。

5.更新参数:根据上一步计算的梯度,计算各参数的更新值,并将其应用于模型参数中,以进行参数更新。

6.重复步骤3-5:重复步骤3-5,直到模型收敛或超过预定的迭代次数。

最后,通过上述步骤,即可得到梯度下降法matlab代码的实现步骤,从而解决机器学习中的优化问题。

以下是梯度下降法matlab代码的示例:% 加载数据 load('data.mat'); % 初始化参数w=rand(size(X,2),1); b=rand(); % 设定学习率alpha=0.01; % 设定迭代次数 epochs=1000; % 训练 fori=1:epochs % 计算损失函数 Y_hat=X*w+b; loss=mean((Y-Y_hat).^2); % 计算梯度grad_w=mean(-2*X.*(Y-Y_hat)); grad_b=mean(-2*(Y-Y_hat)); % 更新参数 w=w-alpha*grad_w; b=b-alpha*grad_b; end。

matlab 梯度下降算法 -回复

matlab 梯度下降算法-回复Matlab梯度下降算法(Gradient Descent Algorithm in Matlab)在机器学习和优化问题中,梯度下降算法是一种常用的优化算法。

它通过迭代地调整参数值,以最小化某个目标函数。

本文将详细介绍如何在Matlab中实现梯度下降算法,并提供一个简单的示例说明。

1. 梯度下降算法简介(Introduction to Gradient Descent Algorithm)梯度下降算法是一种通过迭代调整参数以最小化目标函数的优化算法。

其基本思想是在每一步迭代中,计算目标函数的梯度,并按照梯度的方向调整参数值。

通过迭代调整参数直至收敛,得到目标函数的最小值。

数学上,梯度是目标函数在某一点上的导数。

在梯度下降算法中,我们将目标函数的梯度视为移动方向。

通过不断迭代调整参数,算法会朝着梯度的相反方向移动,从而能够找到最小值点。

梯度下降算法具有广泛的应用,包括线性回归、逻辑回归、神经网络等。

2. 在Matlab中实现梯度下降算法(Implementing Gradient Descent Algorithm in Matlab)在Matlab中实现梯度下降算法非常简单。

我们首先定义目标函数以及其梯度函数,并初始化参数值。

然后,通过迭代地更新参数值,直到达到停止条件。

下面是一个简单的示例,说明如何在Matlab中实现梯度下降算法:matlab定义目标函数及其梯度函数function [f, grad] = target_func(x)f = (x(1)^2 + x(2)^2)/2; 目标函数grad = [x(1); x(2)]; 梯度函数end梯度下降算法function [x_opt, f_opt] = gradient_descent(learning_rate, tolerance) 参数初始化x = [0; 0];[f, grad] = target_func(x);f_opt = f;iter = 0;while norm(grad) > tolerance 迭代停止条件x = x - learning_rate * grad; 更新参数[f, grad] = target_func(x); 计算新的目标函数值及梯度f_opt = min(f_opt, f); 更新最优值iter = iter + 1;endfprintf('迭代次数:d\n', iter);x_opt = x;end运行梯度下降算法learning_rate = 0.1;tolerance = 1e-5;[x_opt, f_opt] = gradient_descent(learning_rate, tolerance);fprintf('最优参数:s\n', mat2str(x_opt));fprintf('最优值:f\n', f_opt);在上述示例中,我们定义了一个二维目标函数`f = (x(1)^2 + x(2)^2)/2` ,其梯度为`[x(1); x(2)]`。

matlab 梯度下降算法

matlab 梯度下降算法以下是一篇关于Matlab中梯度下降算法的1500-2000字的文章:梯度下降算法是一种在机器学习和优化问题中广泛使用的算法,它通过迭代的方式,利用目标函数的负梯度(方向导数最大的方向)来寻找函数的最小值点。

在本文中,我们将重点介绍如何在Matlab中实现梯度下降算法,并使用一个案例来说明。

首先,让我们来了解一下梯度下降算法的基本原理。

对于一个可微的目标函数J(θ),其中θ是参数向量,我们希望找到使得J(θ)最小的θ值。

梯度下降算法的思想是从一个初始的θ值开始,通过不断迭代,沿着负梯度的方向来更新θ的值,直到收敛到最小值。

在Matlab中实现梯度下降算法的关键步骤如下:Step 1: 初始化参数向量θ和学习率α。

在梯度下降算法中,学习率α决定了每次更新θ的步长,通常需要手动调整。

参数向量θ可以是随机初始化的数值或者根据先验知识进行初始化。

Step 2: 计算损失函数的梯度。

我们需要计算目标函数J(θ)关于参数向量θ的偏导数。

对于线性回归等简单问题,梯度的计算可以直接使用解析解。

对于复杂的深度学习模型等问题,梯度的计算可能较为困难,可以使用自动微分工具箱或者数值方法来近似计算梯度。

Step 3: 更新参数向量θ。

根据梯度的方向,更新参数向量θ的值。

更新的公式为θ = θ - α * ∇J(θ),其中α为学习率。

通过不断迭代该更新过程,可以使得θ逐渐接近函数的最小值。

Step 4: 重复步骤2和步骤3,直到满足收敛条件。

在实际的应用中,我们需要判断何时终止梯度下降的迭代过程。

一种常见的收敛条件是当参数向量θ的变化量小于一个预定义的阈值时,认为算法已经收敛。

接下来,我们将通过一个实际的案例来演示在Matlab中如何使用梯度下降算法。

假设我们有一个简单的线性回归问题,给定一个输入变量x和一个输出变量y,我们希望找到一条最佳拟合直线。

首先,我们需要定义一个损失函数J(θ)来衡量预测值与真实值之间的差异。

带激活函数的梯度下降及线性回归算法和matlab代码-0522

% initial values of parameters

theta0=1;

theta1=3;

theta2=8;

%learning rate

alpha=39;

% if alpha is too large, the final error will be much large.

% if alpha is too small, the convergence will be slow

% theta0=theta0-alpha*((h_theta_x(1)-y(1))*fz(1)+(h_theta_x(2)-y(2))*fz(2)+(h_theta_x(3)-y(3))*fz(3))/num_sample;

r0=sum((h_theta_x-y).*fz);

theta0=theta0-alpha*r0/num_sample;

%learning rate

alpha=;

% if alpha is too large, the final error will be much large.

% if alpha is too small, the convergence will be slow

!

epoch=100;

fork=1:epoch

x_min=min(x)

xn=(x-x_mean)/(x_max-x_min)

x=xn;

y=p0+p1*x

y=y+;

·

num_sample=size(y,2);

% gradient descending process

% initial values of parameters

matlab梯度下降法

matlab梯度下降法

Matlab中的梯度下降法是一种常用的有监督式机器学习算法,它可以估计输入空间中的函数值最小值的参数。

它可以有效地处理非线性的多元函数最小化问题,在优化技术的

应用领域非常重要。

梯度下降法的主要过程如下:由一个初始猜测,从头开始计算函数值对参数的梯度

(梯度是参数改变量导致函数值变化量最大程度);将计算出来的梯度反对参数进行更新;以步长为更新系数,将梯度乘以步长,从而获得更新后的参数值;再次计算函数值,如果

目标函数值变小,则继续更新,否则结束更新。

Matlab 中的梯度下降法首先使用fminunc函数来估算函数最小值的那个参数。

这个

函数的输入是一个匿名函数,并且有至少两个参数。

除此之外,还需要定义一个数组来表

示初始猜测点(也就是第一次梯度下降的参数值)。

然后,函数会遍历函数自变量空间,

查找最优值,最后输出最小值及最优参数。

fminunc函数返回最佳参数值,可以使用“ fminsearch” 函数处理多变量的梯度下降,它返回最大值和最优参数值,做这个可以用 Matlab中的“ fminsearch”算法。

此外,也可以使用Matlab中的“ fmincon”优化算法,这是一种以最小限度原则为

基础,应用于多自变量最小化问题的算法,它可以应用约束条件,比如多变量梯度下降时,每个变量的取值可以被上下限值限制。

总之,Matlab中包含了一系列用于梯度下降优化的函数,他们具有不同的功能,但基本过程都是更新自变量,使得函数值变小的梯度下降。

梯度下降的正确步骤

梯度下降的正确步骤梯度下降是一种优化算法,用于在机器学习和深度学习中最小化损失函数。

它通过迭代地调整模型的参数,以使损失函数最小化。

以下是梯度下降的正确步骤:1.确定问题:首先,我们需要确定需要优化的问题。

这可能是一个回归问题,需要最小化均方误差,或是一个分类问题,需要最小化交叉熵损失。

2.确定参数:确定需要优化的参数。

这些参数可以是线性回归中的权重和偏置,或是神经网络中的权重和偏置。

3.初始化参数:将参数初始化为随机数或零。

这个步骤是为了确保每个训练迭代的起始位置都是随机的。

4.计算损失函数的梯度:梯度下降的关键步骤是计算损失函数对参数的梯度。

梯度可以表示为损失函数在参数空间中的斜率,告诉我们在哪个方向上应该更新参数。

5.更新参数:根据计算得到的梯度,更新参数的值。

更新的方向是损失函数下降最快的方向,大小由学习率决定。

学习率指定了每次迭代更新参数的步长。

6.重复步骤4和步骤5:重复计算梯度和更新参数的过程,直到达到足够小的损失或达到预定的迭代次数。

7.收敛判断:在每次参数更新后,我们需要检查算法是否已经收敛,即损失函数是否已经足够小。

如果损失函数的改进不再显著,那么可以认为算法已经收敛,可以停止训练。

8.结果评估:对于回归问题,可以使用均方误差或平均绝对误差等指标评估预测结果的准确性。

对于分类问题,可以使用准确率、精确率和召回率等指标。

9.参数调优:如果模型的表现不佳,可以调整学习率、增加迭代次数或重新选择特征等步骤来改善模型。

10.验证集测试:在训练完成后,使用验证集进行最后的模型测试。

验证集是从训练集中独立选择的一部分数据,用于评估模型在未见过的数据上的表现。

11.模型部署:如果模型在验证集上表现良好,可以部署模型并在实际应用中使用。

总结起来,梯度下降的正确步骤包括确定问题、确定参数、初始化参数、计算损失函数的梯度、更新参数、重复计算和更新直到收敛、判断收敛情况、结果评估、参数调优、验证集测试和模型部署。

在matlab中实现线性回归和logistic回归

在matlab中实现线性回归和logistic回归本⽂主要讲解在matlab中实现Linear Regression和Logistic Regression的代码,并不涉及公式推导。

具体的计算公式和推导,相关的机器学习⽂章和视频⼀⼤堆,推荐看Andrew NG的公开课。

⼀、线性回归(Linear Regression)⽅法⼀、利⽤公式 :function [ theta ] = linearReg()%线性回归。

X=[1 1;1 2;1 3;1 4]; %注意第⼀列全为1,即x0=1,第⼆列才为x1Y=[1.1;2.2;2.7;3.8];A=inv(X'*X);theta=A*X'*Y; %根据公式theta=(X'*X)^(-1)*X'*Y;end这种⽅法最简单,但是公式推导过程很复杂。

⽅法⼆:使⽤梯度下降法迭代function theta=linearRegression()% 梯度下降法寻找最合适的theta,使得J最⼩options=optimset('GradObj','on','MaxIter',100);inittheta=[1 1]';theta=fminunc(@costFunc,inittheta,options);end%%function [J,gradient]= costFunc(theta)%J为代价函数。

%y=theta(0)*x0+theta(1)*x1; 找出最好的theta来拟合曲线。

%使得J最⼩的theta就是最好的thetax=[1;2;3;4];y=[1.1;2.2;2.7;3.8];m=size(x,1);hypothesis=theta(1)+theta(2)*x;delta=hypothesis-y;J=sum(delta.^2)/(2*m);gradient(1)=sum(delta.*1)/m; %x0=1;gradient(2)=sum(delta.*x)/m;end这两种⽅法,都采⽤数据:x=[1;2;3;4];y=[1.1;2.2;2.7;3.8];当然,⽤的时候可以换成其它数据,两种⽅法得出的结果都是theta =0.30000.8600即可以学习到线性函数:Y=0.3000+0.8600*X;⼆、Logistic回归(Logistic Regression)⽅法⼀、利⽤matlab⾃带的函数glmfit() :function theta=logisticRegression()% logistic regression的参数theta,可以⽤matlab⾃带函数glmfit求出x = [0.0 0.1 0.7 1.0 1.1 1.3 1.4 1.7 2.1 2.2]';y = [0 0 1 0 0 0 1 1 1 1]';theta = glmfit(x, [y ones(10,1)], 'binomial', 'link', 'logit')end⽅法⼆:使⽤梯度下降法迭代function theta =logisticReg()% 梯度下降法寻找最合适的theta,使得代价函数J最⼩options=optimset('GradObj','on','MaxIter',100);inittheta=[0 0]';theta=fminunc(@costFunc,inittheta,options);end%%function [J,gradient] = costFunc(theta)x = [0.0 0.1 0.7 1.0 1.1 1.3 1.4 1.7 2.1 2.2]';y = [0 0 1 0 0 0 1 1 1 1]';m=size(x,1);tmp=theta(1)+theta(2)*x; %theta'xhypothesis=1./(1+exp(-tmp)); %logistic functiondelta=log(hypothesis+0.01).*y+(1-y).*log(1-hypothesis+0.01); %加上0.01是为了防⽌x为0 J=-sum(delta)/m;gradient(1)=sum(hypothesis-y)/m; %x0=1;gradient(2)=sum((hypothesis-y).*x)/m; %theta=theta-a*gradient; gradient=-J'(theta)end两种⽅法都使⽤数据:x = [0.0 0.1 0.7 1.0 1.1 1.3 1.4 1.7 2.1 2.2]';y = [0 0 1 0 0 0 1 1 1 1]';注意,Y的值只能取0和1两种。

梯度下降算法代码

梯度下降算法代码梯度下降算法是一种常见的机器学习优化算法,用于最小化损失函数。

下面是一个使用梯度下降算法实现线性回归的代码示例:假设我们有一个二维数据集 X 和一个对应的标签集 Y,我们的目标是找到一条线性函数 y = wx + b,使得它能够最好地拟合数据集。

首先,我们将初始化权重 w 和偏置 b,然后计算损失函数。

然后我们将使用梯度下降算法来优化权重和偏置,不断重复直到满足停止条件。

以下是代码示例:```pythonimport numpy as np# 定义数据集和标签X = np.array([2, 4, 6, 8, 10, 12])Y = np.array([3, 5, 7, 9, 11, 13])# 初始化权重和偏置w = 0b = 0# 定义学习率和迭代次数learning_rate = 0.01num_iter = 1000# 定义损失函数def compute_loss(w, b, X, Y):total_loss = 0N = len(X)for i in range(N):total_loss += (Y[i] - (w*X[i] + b))**2return total_loss/N# 使用梯度下降算法来更新权重和偏置for i in range(num_iter):w_gradient = 0b_gradient = 0N = len(X)for j in range(N):w_gradient += -2*X[j]*(Y[j] - (w*X[j] + b))b_gradient += -2*(Y[j] - (w*X[j] + b))w -= (learning_rate * w_gradient/N)b -= (learning_rate * b_gradient/N)# 打印损失函数if i % 100 == 0:print("迭代次数: {0}, 损失函数值: {1}".format(i, compute_loss(w, b, X, Y)))# 打印最终的权重和偏置print("最终权重: {0}, 最终偏置: {1}".format(w, b))```在这个例子中,我们使用线性函数 y = wx + b 来拟合数据集。

最速下降法matlab代码

最速下降法matlab代码最速下降法(Steepest Descent Method)是一种优化算法,用于求解无约束最优化问题。

下面是一个使用MATLAB实现最速下降法的代码示例:```matlabfunction x = steepest_descent(f, grad_f, x0, tol, max_iter)% f: 目标函数% grad_f: 目标函数的梯度% x0: 初始点% tol: 迭代停止的容差% max_iter: 最大迭代次数x = x0; % 初始点iter = 0; % 迭代次数while norm(grad_f(x)) > tol && iter < max_iterp = -grad_f(x); % 计算搜索方向% 一维搜索,选择合适的步长alphaalpha = backtracking_line_search(f, grad_f, x, p);x = x + alpha * p; % 更新变量xiter = iter + 1;endendfunction alpha = backtracking_line_search(f, grad_f, x, p, alpha0, rho, c)% f: 目标函数% grad_f: 目标函数的梯度% x: 当前点% p: 搜索方向% alpha0: 初始步长% rho: 减小步长的比例因子% c: Armijo-Goldstein条件的常数因子if nargin < 6rho = 0.5; % 默认减小步长的比例因子endif nargin < 7c = 0.1; % 默认Armijo-Goldstein条件的常数因子endalpha = alpha0; % 初始步长while f(x + alpha * p) > f(x) + c * alpha * grad_f(x)' * palpha = rho * alpha; % 减小步长endend```在上述代码中,`steepest_descent`函数实现了最速下降法的主要逻辑。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

4

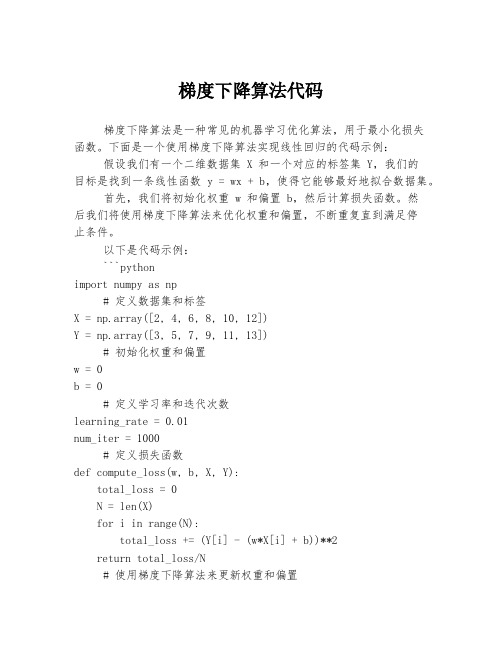

epoch=800; for k=1:epoch v_k=k zc=theta0+theta1*x; % h_theta_x=theta0+theta1*x; % hypothesis function h_theta_x=1./(1+exp(-zc)); fz=h_theta_x.*(1-h_theta_x); Jcost(k)=((h_theta_x(1)-y(1))^2+(h_theta_x(2)-y(2))^2+(h_theta_x(3)-y(3))^2)/num_sample; theta0=theta0-alpha*((h_theta_x(1)-y(1))*fz(1)+(h_theta_x(2)-y(2))*fz(2)+(h_theta_x(3)-y(3))*fz(3))/num_sample; theta1=theta1-alpha*((h_theta_x(1)-y(1))*x(1)*fz(1)+(h_theta_x(2)-y(2))*x(2)*fz(2)+(h_theta_x(3)-y(3))*x(3)*fz(3))/num_sample; end ynt=theta0+theta1*x; yn=1./(1+exp(-ynt)) plot(Jcost) 上述 matlab 代码的训练过程的误差见下图所示:

6

p0=2; p1=9; p2=3; x1=[1 6 12 8 7 31 112]; x2=[3 7 9 12 8 4 292]; x1_mean=mean(x1) x1_max=max(x1) x1_min=min(x1) x1n=(x1-x1_mean)/(x1_max-x1_min) x1=x1n; x2_mean=mean(x2) x2_max=max(x2) x2_min=min(x2) x2n=(x2-x2_mean)/(x2_max-x2_min) x2=x2n; y_temp=p0+p1*x1+p2*x2; y=1./(1+exp(-y_temp)); num_sample=size(y,2); % gradient descending process % initial values of parameters theta0=1; theta1=3; theta2=8; %learning rate alpha=39;

3

(3). 输出带 sigmoid 激活函数的线性回归算法 matlab 代码 clear all clc % training sample data; p0=2; p1=9; x=1:3; x_mean=mean(x) x_max=max(x) x_min=min(x) xn=(x-x_mean)/(x_max-x_min) x=xn; y_temp=p0+p1*x; y=1./(1+exp(-y_temp)); num_sample=size(y,2); % gradient descending process % initial values of parameters theta0=1; theta1=3; %learning rate alpha=69; % if alpha is too large, the final error will be much large. % if alpha is too small, the convergence will be slow

5

图1

训练过程中的误差示意图

(4). 输出带 sigmoid 激活函数的双输入线性回归算法 matlab 代码 % double variable input with activation function % normalization of input data clear all clc % training sample data;

1

%learning rate alpha=0.33; % if alpha is too large, the final error will be much large. % if alpha is too small, the convergence will be slow epoch=100; for k=1:epoch v_k=k h_theta_x=theta0+theta1*x; % hypothesis function Jcost(k)=((h_theta_x(1)-y(1))^2+(h_theta_x(2)-y(2))^2+(h_theta_x(3)-y(3))^2)/num_sample theta0=theta0-alpha*((h_theta_x(1)-y(1))+(h_theta_x(2)-y(2))+(h_theta_x(3)-y(3)))/num_sample; theta1=theta1-alpha*((h_theta_x(1)-y(1))*x(1)+(h_theta_x(2)-y(2))*x(2)+(h_theta_x(3)-y(3))*x(3))/num_sample; end plot(Jcost) yn=theta0+theta1*x 上述未进行输入数据归一化处理的代码最大的学习速率为 0.35,在迭代次数到达 60 次时,输出误差下降至 0.0000。 (2). 进行输入数据归一化处理的代码 clear all clc % training sample data; p0=3; p1=7; x=1:3; x_mean=mean(x) x_max=max(x) x_min=min(x)

2

xn=(x-x_mean)/(x_max-x_min) x=xn; y=p0+p1*x y=y+0.5; num_sample=size(y,2); % gradient descending process % initial values of parameters theta0=1; theta1=3; %learning rate alpha=0.9; % if alpha is too large, the final error will be much large. % if alpha is too small, the convergence will be slow epoch=100; for k=1:epoch v_k=k h_theta_x=theta0+theta1*x; % hypothesis function Jcost(k)=((h_theta_x(1)-y(1))^2+(h_theta_x(2)-y(2))^2+(h_theta_x(3)-y(3))^2)/num_sample theta0=theta0-alpha*((h_theta_x(1)-y(1))+(h_theta_x(2)-y(2))+(h_theta_x(3)-y(3)))/num_sample; theta1=theta1-alpha*((h_theta_x(1)-y(1))*x(1)+(h_theta_x(2)-y(2))*x(2)+(h_theta_x(3)-y(3))*x(3))/num_sample; end yn=theta0+theta1*x; plot(Jcost) 上述进行输入数据归一化处理的代码最大的学习速率为0.96,在迭代次数到达33次时,输出误差下降至0.0000。上述代码为了使 得输出值中不包含负数,对所有输出值都加了0.5。这个0.5被反映至theta0的值上。Theta0的值比p0的值多0.5。

8

(5). 输出带 sigmoid 激活函数的三输入双输出线性回归算法 matlab 代码 % triple variable inputs with activation function % double outputs % normalization of input data clear all clc % training sample data; pa0=2; pa1=9; pa2=3; pa3=11; pb0=3; pb1=1; pb2=2; pb3=6; x1=[1 6 12 8 7 31 11 3 18 27 31 17]; x2=[3 7 9 12 8 4 92 8 3 7 9 12]; x3=[9 17 92 2 68 41 22 3 92 2 68 41]; x1_mean=mean(x1) x1_max=max(x1) x1_min=min(x1) x1n=(x1-x1_mean)/(x1_max-x1_min) x1=x1n; x2_mean=mean(x2) x2_max=max(x2) x2_min=min(x2) x2n=(x2-x2_mean)/(x2_max-x2_min) x2=x2n; x3_mean=mean(x3) x3_max=max(x3) x3_min=min(x3)

7

% if alpha is too large, the final error will be much large. % if alpha is too small, the convergence will be slow % lamda=0.0001; lamda=0.000001; epoch=29600; for k=1:epoch v_k=k zc=theta0+theta1*x1+theta2*x2; % h_theta_x=theta0+theta1*x; % hypothesis function h_theta_x=1./(1+exp(-zc)); fz=h_theta_x.*(1-h_theta_x); % Jcost(k)=((h_theta_x(1)-y(1))^2+(h_theta_x(2)-y(2))^2+(h_theta_x(3)-y(3))^2)/num_sample; Jcost(k)=sum((h_theta_x-y).^2)/num_sample; % theta0=theta0-alpha*((h_theta_x(1)-y(1))*fz(1)+(h_theta_x(2)-y(2))*fz(2)+(h_theta_x(3)-y(3))*fz(3))/num_sample; r0=sum((h_theta_x-y).*fz); theta0=theta0-alpha*r0/num_sample; % theta1=theta1-alpha*((h_theta_x(1)-y(1))*x(1)*fz(1)+(h_theta_x(2)-y(2))*x(2)*fz(2)+(h_theta_x(3)-y(3))*x(3)*fz(3))/num_sample+lamda*thet a1; r1=sum(((h_theta_x-y).*x1).*fz); theta1=theta1-alpha*r1/num_sample+lamda*theta1; r2=sum(((h_theta_x-y).*x2).*fz); theta2=theta2-alpha*r2/num_sample+lamda*theta2; end ynt=theta0+theta1*x1+theta2*x2; yn=1./(1+exp(-ynt)) plot(Jcost)