数据降维方法LLE算法matlab代码

lle算法详解及matlab代码实现

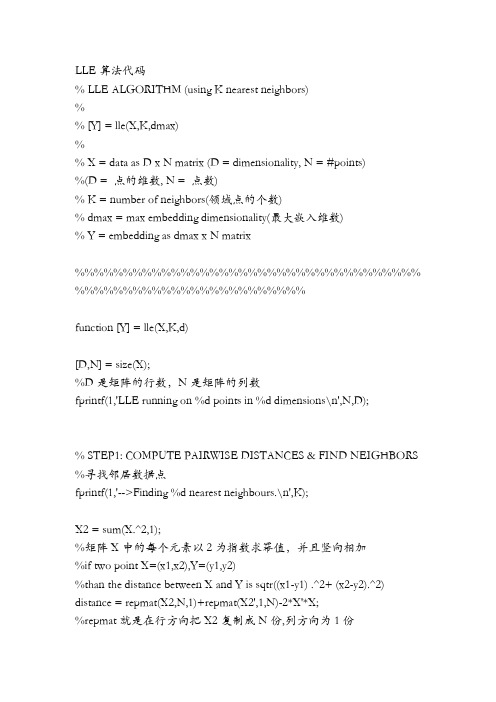

LLE相关知识详解网址:/p-196479604.htmlLLE在其它参考文献中讲解的实现方式,结合上述方法,更能理解lle 的本质LLE算法代码% LLE ALGORITHM (using K nearest neighbors)%% [Y] = lle(X,K,dmax)%% X = data as D x N matrix (D = dimensionality, N = #points)%(D = 点的维数, N = 点数)% K = number of neighbors(领域点的个数)% dmax = max embedding dimensionality(最大嵌入维数)% Y = embedding as dmax x N matrix%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%function [Y] = lle(X,K,d)[D,N] = size(X);%D是矩阵的行数,N是矩阵的列数fprintf(1,'LLE running on %d points in %d dimensions\n',N,D);% STEP1: COMPUTE PAIRWISE DISTANCES & FIND NEIGHBORS %寻找邻居数据点fprintf(1,'-->Finding %d nearest neighbours.\n',K);X2 = sum(X.^2,1);%矩阵X中的每个元素以2为指数求幂值,并且竖向相加%if two point X=(x1,x2),Y=(y1,y2)%than the distance between X and Y is sqtr((x1-y1) .^2+ (x2-y2).^2) distance = repmat(X2,N,1)+repmat(X2',1,N)-2*X'*X;%repmat就是在行方向把X2复制成N份,列方向为1份[sorted,index] = sort(distance);%sort是对矩阵排序,sorted是返回对每列排序的结果,index是返回排%序后矩阵中每个数在矩阵未排序前每列中的位置neighborhood = index(2:(1+K),:);%计算neighborhood(看distance定义理解)的时候,要记住X中N代表的是点数,D代%表每个点得维数,把neighborhood进行sort后会找出每个点(用X的每列表示)最近的%K 个列% STEP2: SOLVE FOR RECONSTRUCTION WEIGHTS%计算重构权fprintf(1,'-->Solving for reconstruction weights.\n');if(K>D)fprintf(1,' [note: K>D; regularization will be used]\n');tol=1e-3; % regularlizer in case constrained fits are ill conditionedelsetol=0;endW = zeros(K,N);for ii=1:Nz = X(:,neighborhood(:,ii))-repmat(X(:,ii),1,K); % shift ith pt to originC = z'*z; % local covarianceC = C + eye(K,K)*tol*trace(C); % regularlization (K>D)W(:,ii) = C\ones(K,1); % solve Cw=1W(:,ii) = W(:,ii)/sum(W(:,ii)); % enforce sum(w)=1end;% STEP 3: COMPUTE EMBEDDING FROM EIGENVECTS OFCOST MATRIX M=(I-W)'(I-W)%计算矩阵M=(I-W)'(I-W)的最小d个非零特征值对应的特征向量fprintf(1,'-->Computing embedding.\n');% M=eye(N,N); % use a sparse matrix with storage for 4KN nonzero elements M = sparse(1:N,1:N,ones(1,N),N,N,4*K*N);for ii=1:Nw = W(:,ii);jj = neighborhood(:,ii);M(ii,jj) = M(ii,jj) - w';M(jj,ii) = M(jj,ii) - w;M(jj,jj) = M(jj,jj) + w*w';end;% CALCULATION OF EMBEDDINGoptions.disp = 0; options.isreal = 1; options.issym = 1;[Y,eigenvals] = eigs(M,d+1,0,options);%[Y,eigenvals] = jdqr(M,d+1);%change in using JQDR funcY = Y(:,2:d+1)'*sqrt(N); % bottom evect is [1,1,1,1...] with eval 0fprintf(1,'Done.\n');%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%% other possible regularizers for K>D% C = C + tol*diag(diag(C)); % regularlization % C = C + eye(K,K)*tol*trace(C)*K; % regularlization。

matlab数据预处理 代码

数据预处理是数据分析的重要一环,在使用MATLAB进行数据处理时,合理的数据预处理能够提高数据的质量,减小数据处理的难度。

本文将介绍MATLAB数据预处理的一般流程以及常用的代码实现。

一、数据预处理的一般流程1. 数据清洗数据清洗是数据预处理的第一步,其目的是处理数据中的错误、缺失和异常值。

常用的数据清洗方法包括删除缺失值、填充缺失值、删除重复值和处理异常值。

在MATLAB中,可以使用以下代码进行数据清洗:```matlab删除缺失值data = data(~any(ismissing(data), 2), :);填充缺失值data = fillmissing(data, 'previous');删除重复值data = unique(data);处理异常值data(data > 100) = NaN;```2. 数据转换数据转换是将原始数据转换为更适合模型处理的形式。

常用的数据转换方法包括标准化、归一化和对数变换。

在MATLAB中,可以使用以下代码进行数据转换:```matlab标准化data_stand = (data - mean(data)) / std(data);归一化data_norm = (data - min(data)) / (max(data) - min(data));对数变换data_log = log(data);```3. 数据集成数据集成是将不同数据源的数据合并成一个数据集的过程。

在MATLAB中,可以使用以下代码进行数据集成:```matlabdata_integrated = [data1; data2];```4. 数据降维数据降维是通过保留主要信息的方式减少数据特征的过程。

常用的数据降维方法包括主成分分析(PCA)和线性判别分析(LDA)。

在MATLAB中,可以使用以下代码进行数据降维:```matlabcoeff = pca(data);data_pca = data * coeff(:, 1:2);```二、数据预处理常用函数介绍1. ismissingismissing函数用于判断数据中是否有缺失值,返回一个逻辑数组。

在Matlab中进行数据降维的技术实现

在Matlab中进行数据降维的技术实现随着科学技术和计算能力的快速发展,人们能够从各种来源获取到海量的数据。

然而,对于这些数据进行处理和分析的过程常常面临一个难题:高维问题。

高维数据不仅在存储空间上占用较大,而且难以进行可视化和分析。

因此,数据降维成为了解决高维问题的一种重要手段。

数据降维是指将高维数据映射到低维空间的过程,通过这个过程可以保留数据间的重要关系和结构信息。

在Matlab中,有多种方法可以实现数据降维,下面将介绍其中几种常用的技术。

一、主成分分析(Principal Component Analysis,PCA)主成分分析是一种常用的数据降维方法。

其基本思想是通过线性变换将原始特征映射到新的坐标系中,使得映射后的特征具有最大的方差。

Matlab中的pca函数可以直接应用主成分分析算法进行数据降维。

例如,我们有一组高维数据X,其中每一行表示一个样本,每一列表示一个特征。

我们可以使用以下代码将数据降至二维:```[coeff,score,latent] = pca(X);Y = X * coeff(:,1:2);```代码中,coeff表示主成分的系数矩阵,score表示映射后的特征矩阵,latent表示每个主成分的方差。

通过选择合适的主成分数,我们可以将数据降维到任意维度。

二、独立成分分析(Independent Component Analysis,ICA)独立成分分析是一种非线性的数据降维方法,它假设高维数据是由多个相互独立的信号混合而成的。

通过ICA算法,我们可以将这些信号分离出来,从而达到数据降维的目的。

在Matlab中,可以使用ica函数进行独立成分分析。

以下是一个简单的示例:```[A, S] = ica(X, 'approach', 'symm', 'g', 'tanh');Y = A * X;```代码中,A表示分离矩阵,S表示分离后的独立成分。

matlab 特征提取 降维

matlab 特征提取降维特征提取和降维是机器学习和模式识别中非常重要的一步,它们可以帮助我们从复杂的数据中提取出最具代表性的特征,并减少数据维度,提高算法的性能和效率。

在Matlab中,有许多功能强大的工具箱和函数可以用于特征提取和降维,本文将详细介绍其原理和应用。

1.特征提取特征提取是将原始数据转换为一组有意义且易于理解的特征的过程。

在机器学习和模式识别任务中,这些特征通常是数据中最有区分性和相关性的部分。

下面是一些常用的特征提取方法:1.1统计特征统计特征是从数据的统计分布中提取的。

例如,平均值、方差、标准差等都可以作为数据的统计特征。

在Matlab中,可以使用`mean`、`var`、`std`等函数来计算这些统计特征。

1.2傅里叶变换特征傅里叶变换是将信号从时域转换到频域的过程。

通过对信号进行傅里叶变换,可以提取出信号的频率特征。

在Matlab中,可以使用`fft`函数进行傅里叶变换,然后提取频域中的特征。

1.3小波变换特征小波变换是将信号从时域转换到时频域的过程。

它可以提供信号的时间和频率信息。

在Matlab中,可以使用`cwt`函数进行小波变换,然后提取时频域的特征。

1.4图像特征对于图像数据,可以使用各种图像处理算法来提取特征。

例如,边缘检测、角点检测、纹理分析等都可以作为图像的特征。

在Matlab 中,可以使用`edge`、`corner`、`texturefilt`等函数来提取这些图像特征。

1.5神经网络特征神经网络是一种强大的模式识别工具,可以通过学习数据的潜在规律来提取特征。

在Matlab中,可以使用`trainAutoencoder`和`encode`函数来训练和使用自编码器来提取数据的特征。

2.降维降维是将高维数据映射到低维空间的过程,可以减少数据的维度并保留最有代表性的特征。

常用的降维方法有以下几种:2.1主成分分析(PCA)PCA是一种经典的线性降维方法,通过找到原始数据中方差最大的方向来进行降维。

如何使用Matlab进行特征选择和降维技术实现

如何使用Matlab进行特征选择和降维技术实现使用Matlab进行特征选择和降维技术实现在机器学习和数据挖掘领域,特征选择和降维是一个重要的预处理步骤。

通过选择和提取最相关和最具有代表性的特征,可以大大简化问题的复杂度,并提高模型的性能和效率。

而Matlab作为一种强大的科学计算软件,提供了丰富的函数和工具箱来支持特征选择和降维的实现。

本文将介绍如何使用Matlab进行特征选择和降维技术的实现。

一、特征选择(Feature Selection)特征选择是从原始特征集合中选择一组最具有代表性的特征,以便于构建简化的模型。

特征选择可以帮助我们去除冗余和无关的特征,减少数据维度,并提高模型的泛化能力和解释性。

Matlab提供了各种特征选择的方法和函数,包括基于统计学指标、机器学习算法和启发式搜索等。

1. 统计学指标方法统计学指标方法是一种基于特征与目标变量之间统计关系的特征选择方法。

常见的统计学指标包括相关系数、互信息和卡方检验等。

在Matlab中,可以使用函数corrcoef、entropy和chi2等来计算相应的统计学指标,并根据其值选择相关或具有显著性的特征。

2. 机器学习算法方法机器学习算法方法是一种基于机器学习模型的特征选择方法。

通过训练和评估机器学习模型,可以得到特征的重要性或权重,进而进行特征选择。

在Matlab中,可以使用各种机器学习算法的函数和工具箱,如分类器、回归模型和集成学习等,来实现特征选择。

3. 启发式搜索方法启发式搜索方法是一种基于优化算法的特征选择方法。

常见的启发式搜索算法包括遗传算法、禁忌搜索和模拟退火等。

在Matlab中,可以使用函数ga、tabu和simulannealbnd等来实现相应的启发式搜索算法,并根据特征选择的优化目标进行搜索和选择。

二、降维(Dimensionality Reduction)降维是通过投影方法和矩阵分解等技术将高维数据映射到低维空间的过程。

lle算法详解及matlab代码实现

LLE算法代码% LLE ALGORITHM (using K nearest neighbors)%% [Y] = lle(X,K,dmax)%% X = data as D x N matrix (D = dimensionality, N = #points)%(D = 点的维数, N = 点数)% K = number of neighbors(领域点的个数)% dmax = max embedding dimensionality(最大嵌入维数)% Y = embedding as dmax x N matrix%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%function [Y] = lle(X,K,d)[D,N] = size(X);%D是矩阵的行数,N是矩阵的列数fprintf(1,'LLE running on %d points in %d dimensions\n',N,D);% STEP1: COMPUTE PAIRWISE DISTANCES & FIND NEIGHBORS %寻找邻居数据点fprintf(1,'-->Finding %d nearest neighbours.\n',K);X2 = sum(X.^2,1);%矩阵X中的每个元素以2为指数求幂值,并且竖向相加%if two point X=(x1,x2),Y=(y1,y2)%than the distance between X and Y is sqtr((x1-y1) .^2+ (x2-y2).^2) distance = repmat(X2,N,1)+repmat(X2',1,N)-2*X'*X;%repmat就是在行方向把X2复制成N份,列方向为1份[sorted,index] = sort(distance);%sort是对矩阵排序,sorted是返回对每列排序的结果,index是返回排%序后矩阵中每个数在矩阵未排序前每列中的位置neighborhood = index(2:(1+K),:);%计算neighborhood(看distance定义理解)的时候,要记住X中N代表的是点数,D代%表每个点得维数,把neighborhood进行sort后会找出每个点(用X的每列表示)最近的%K 个列% STEP2: SOLVE FOR RECONSTRUCTION WEIGHTS%计算重构权fprintf(1,'-->Solving for reconstruction weights.\n');if(K>D)fprintf(1,' [note: K>D; regularization will be used]\n');tol=1e-3; % regularlizer in case constrained fits are ill conditionedelsetol=0;endW = zeros(K,N);for ii=1:Nz = X(:,neighborhood(:,ii))-repmat(X(:,ii),1,K); % shift ith pt to originC = z'*z; % local covarianceC = C + eye(K,K)*tol*trace(C); % regularlization (K>D)W(:,ii) = C\ones(K,1); % solve Cw=1W(:,ii) = W(:,ii)/sum(W(:,ii)); % enforce sum(w)=1 end;% STEP 3: COMPUTE EMBEDDING FROM EIGENVECTS OF COST MATRIX M=(I-W)'(I-W)%计算矩阵M=(I-W)'(I-W)的最小d个非零特征值对应的特征向量fprintf(1,'-->Computing embedding.\n');% M=eye(N,N); % use a sparse matrix with storage for 4KN nonzero elements M = sparse(1:N,1:N,ones(1,N),N,N,4*K*N);for ii=1:Nw = W(:,ii);jj = neighborhood(:,ii);M(ii,jj) = M(ii,jj) - w';M(jj,ii) = M(jj,ii) - w;M(jj,jj) = M(jj,jj) + w*w';end;% CALCULATION OF EMBEDDINGoptions.disp = 0; options.isreal = 1; options.issym = 1;[Y,eigenvals] = eigs(M,d+1,0,options);%[Y,eigenvals] = jdqr(M,d+1);%change in using JQDR funcY = Y(:,2:d+1)'*sqrt(N); % bottom evect is [1,1,1,1...] with eval 0fprintf(1,'Done.\n');%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%% other possible regularizers for K>D% C = C + tol*diag(diag(C)); % regularlization% C = C + eye(K,K)*tol*trace(C)*K; % regularlization。

使用Matlab进行特征选择与降维的方法

使用Matlab进行特征选择与降维的方法引言在许多实际应用中,数据集往往具有大量特征,而这些特征之间可能存在冗余或很弱的相关性。

这不仅会导致计算负担增加,还可能导致模型过拟合,降低模型的泛化能力。

因此,特征选择与降维成为了解决这一问题的重要手段。

本文将介绍如何使用Matlab进行特征选择与降维的方法。

一、特征选择方法特征选择是从原始特征集中选择出最有用的特征,以降低维度,并去除冗余与噪声。

常用的特征选择方法有过滤式、包裹式和嵌入式。

过滤式方法通过对特征进行评估和排名,然后选择得分较高的特征。

常用的评估指标有信息增益、方差、互信息等。

在Matlab中,可以使用函数`rankfeatures`来实现特征排序和选择。

包裹式方法将特征选择问题转化为子集搜索问题,通过对每个特征子集进行验证来评估特征的质量。

常用的方法有递归特征消除、遗传算法等。

Matlab中提供了函数`sequentialfs`和`ga`用于实现包裹式特征选择。

嵌入式方法将特征选择融入到模型训练中,通过优化模型的目标函数来选择特征。

常用的方法有LASSO回归、岭回归等。

在Matlab中,可以使用`lasso`函数和`ridge`函数来实现嵌入式特征选择。

二、特征降维方法特征降维是将原始数据从高维空间映射到低维空间,以减少特征的数量和复杂性,并保留原始数据的主要结构和信息。

主要的特征降维方法有主成分分析(PCA)、线性判别分析(LDA)等。

PCA是一种无监督的线性降维方法,通过线性变换将数据投影到新的特征空间,使得投影后的特征具有最大的方差。

在Matlab中,可以使用`pca`函数来进行PCA降维。

LDA是一种有监督的线性降维方法,它考虑类别信息,并试图最大化类内距离和最小化类间距离。

在Matlab中,可以使用`classify`函数进行LDA降维。

除了PCA和LDA,还有很多其他的降维方法,如多维缩放(MDS)、局部线性嵌入(LLE)等。

matlab数据降维方法

matlab数据降维方法

在MATLAB中,降维方法主要用于处理高维数据,以便于数据可视化、特征提取和模式识别等应用。

常见的降维方法包括主成分分析(PCA)、线性判别分析(LDA)、t分布邻域嵌入(t-SNE)和自编码器等。

下面我将分别介绍这些降维方法在MATLAB中的应用。

首先是主成分分析(PCA),它通过线性变换将原始数据映射到新的坐标系中,以便找到数据中的主要特征。

在MATLAB中,可以使用`pca`函数来实现主成分分析,并通过`coeff = pca(data)`来获取主成分系数。

这些系数可以用于将数据投影到低维空间中。

其次是线性判别分析(LDA),它是一种监督学习的降维方法,它试图找到能够最好区分不同类别数据的投影方向。

在MATLAB中,可以使用`fitcdiscr`函数来拟合线性判别分析模型,并通过`coeff = lda.Coeffs(1,2).Linear`来获取投影系数。

另外,t分布邻域嵌入(t-SNE)是一种非线性降维方法,它可以在保持数据之间的局部关系的同时将高维数据映射到低维空间。

在MATLAB中,可以使用第三方工具箱(如t-SNE MATLAB)来实现

t-SNE算法。

最后,自编码器是一种基于神经网络的降维方法,它试图学习数据的紧凑表示。

在MATLAB中,可以使用神经网络工具箱来构建自编码器模型,并通过训练网络来实现数据的降维处理。

综上所述,MATLAB提供了丰富的工具和函数来实现不同的数据降维方法,用户可以根据自己的需求选择合适的方法进行数据降维处理。

希望以上信息能够帮助到你。

数据降维方法LLE算法matlab代码

LLE算法代码% L LE AL GORIT HM (u singK nea restneigh bors)%%[Y] = lle(X,K,d max)%% X = da ta as D xN mat rix (D = d imens ional ity,N = #point s)%K = n umber of n eighb ors(领域点的个数)% d max = maxembed dingdimen siona lity(最大嵌入维数)%Y = e mbedd ing a s dma x x N matr ix%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%func tion[Y] = lle(X,K,d)[D,N] = size(X);%D是矩阵的行数,N是矩阵的列数fpr intf(1,'LL E run ningon %d poin ts in %d d imens ions\n',N,D);% ST EP1:COMPU TE PA IRWIS E DIS TANCE S & F IND N EIGHB ORS %寻找邻居数据点f print f(1,'-->Fi nding %d n eares t nei ghbou rs.\n',K);X2= sum(X.^2,1);%矩阵X中的每个元素以2为指数求幂值,并且竖向相加%iftwo p ointX=(x1,x2),Y=(y1,y2)%than thedista nce b etwee n X a nd Yis sq tr(x1-y1)+sqtr(x2-y2)dis tance = re pmat(X2,N,1)+re pmat(X2',1,N)-2*X'*X;%r epmat就是在行方向把X2复制成N份,列方向为1份[so rted,index] = s ort(d istan ce);%sort是对矩阵排序,sor ted是返回对每列排序的结果,index是返回排序后矩阵中每个数在矩阵未排序前每列中的位置neig hborh ood = inde x(2:(1+K),:);%STEP2: SOL VE FO R REC ONSTR UCTIO N WEI GHTS%计算重构权fpr intf(1,'-->Solv ing f or re const ructi on we ights.\n');if(K>D)f print f(1,' [n ote:K>D;regul ariza tionwillbe us ed]\n'); tol=1e-3; % r egula rlize r incaseconst raine d fit s are illcondi tione dels et ol=0;endW =zeros(K,N);for ii=1:N z =X(:,n eighb orhoo d(:,i i))-r epmat(X(:,ii),1,K);% shi ft it h ptto or iginC= z'*z; % l ocalcovar ianceC = C+ eye(K,K)*tol*trace(C); %regul arliz ation (K>D) ey e()产生k*k的单位矩阵 W(:,ii)= C\o nes(K,1); % so lve C w=1 W(:,ii)= W(:,ii)/sum(W(:,ii)); % en force sum(w)=1end;% S TEP 3: COM PUTEEMBED DINGFROMEIGEN VECTS OF C OST M ATRIXM=(I-W)'(I-W)%计算矩阵M=(I-W)'(I-W)的最小d个非零特征值对应的特征向量fpri ntf(1,'-->Compu tingembed ding.\n');% M=eye(N,N); % us e a s parse matr ix wi th st orage for4KN n onzer o ele mentsM =spars e(1:N,1:N,ones(1,N),N,N,4*K*N);fo r ii=1:N w = W(:,ii);jj = ne ighbo rhood(:,ii); M(ii,jj)= M(i i,jj) - w';M(jj,ii) = M(jj,ii)- w;M(jj,jj) = M(jj,j j) +w*w';end;% C ALCUL ATION OF E MBEDD INGo ption s.dis p = 0; opt ions.isrea l = 1; opt ions.issym = 1;[Y,eigen vals] = ei gs(M,d+1,0,opti ons);%[Y,eigen vals] = jd qr(M,d+1);%chan ge in usin g JQD R fun cY = Y(:,2:d+1)'*sq rt(N); % b ottom evec t is[1,1,1,1...] wi th ev al 0fpr intf(1,'Do ne.\n');%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%other poss ibleregul arize rs fo r K>D% C = C + to l*dia g(dia g(C)); % regu larli zatio n% C =C + e ye(K,K)*to l*tra ce(C)*K; % reg ularl izati on。

matlab各种分类方法和降维方法

matlab各种分类方法和降维方法一、分类方法1.决策树分类:Matlab的决策树分类器可用于构建分类模型。

通过提供训练数据和目标标签,模型可以学习并生成分类规则,用于对新数据的分类。

2.支持向量机(SVM)分类:SVM是一种基于统计学习理论的分类方法,可以处理高维、复杂的数据。

Matlab的SVM工具箱提供了构建SVM模型的功能。

3.神经网络分类:神经网络是一种模拟人脑工作方式的算法,可用于分类、回归等任务。

Matlab的神经网络工具箱提供了多种神经网络模型,如多层感知器(MLP)等。

4.k-最近邻(k-NN)分类:k-NN是一种基于实例的学习算法,通过比较待分类项与已知类别的项,确定其所属类别。

Matlab的k-NN分类器可用于构建分类模型。

5.随机森林分类:随机森林是一种基于决策树的集成学习算法,通过组合多个决策树的预测结果,提高模型的性能和稳定性。

Matlab 的随机森林分类器可用于构建分类模型。

二、降维方法1.主成分分析(PCA):PCA是一种常用的降维方法,通过最大化数据方差的方式来选择新的坐标系,将原始数据投影到低维空间中。

Matlab的PCA工具箱提供了实现PCA的功能。

2.独立成分分析(ICA):ICA是一种用于分离混合信号的方法,通过最大化数据中非高斯性的方式,将数据降维并分离出各成分。

Matlab的独立成分分析工具箱提供了实现ICA的功能。

3.线性判别分析(LDA):LDA是一种用于二分类问题的降维方法,通过在样本间找到一个最优的超平面,将高维数据降维到二维空间中,提高分类的效率和准确性。

Matlab的线性判别分析工具箱提供了实现LDA的功能。

4.t-分布邻域嵌入(t-SNE):t-SNE是一种非线性降维方法,通过将高维数据映射到低维空间中,保留数据的分布和结构信息,用于可视化数据分析。

Matlab的t-SNE工具箱提供了实现t-SNE的功能。

在使用这些方法时,需要注意选择适合的数据和任务,并进行适当的参数调整和模型评估,以确保得到准确和可靠的分类或降维结果。

matlab中的降维方法

MATLAB中的降维方法1.引言降维是一种在数据分析和机器学习领域中常用的技术,它可以将高维数据映射到一个更低维的子空间中,从而提取出重要的特征信息。

在M A TL AB中,有多种降维方法可以选择,本文将介绍其中的几种常见方法,包括主成分分析(PC A)、线性判别分析(LD A)和t-分布随机邻近嵌入(t-S NE)。

2.主成分分析(P C A)主成分分析是一种无监督学习方法,用于将高维数据转换为低维数据。

它通过计算数据的协方差矩阵,并找到一组正交基来表示数据,使得基上的投影方差最大化。

在M AT LA B中,我们可以使用`p ca`函数来进行主成分分析。

首先,将原始数据矩阵传递给该函数,并指定所需的主成分数量,函数会返回主成分得分和主成分方差解释比例。

3.线性判别分析(LD A)线性判别分析是一种有监督学习方法,主要用于分类任务中的降维。

它试图找到一个低维投影空间,其中不同类别的数据点之间的距离最大化,同时同一类别内的数据点之间的距离最小化。

在M AT LA B中,使用`f it cd is cr`函数来进行线性判别分析。

该函数需要输入原始数据和对应的标签,可以返回投影后的数据以及类别之间的判别特征。

4. t分布随机邻近嵌入(t-SN E)t-SN E是一种非线性降维方法,广泛应用于可视化高维数据。

它使用t-分布来表示高维空间和低维空间之间的相似度,并通过最小化两个空间之间的KL散度,实现数据的降维。

在M AT LA B中,可以使用`t sn e`函数来进行t-SN E降维。

该函数接受原始数据矩阵作为输入,并返回降维后的数据矩阵。

5.总结M A TL AB提供了丰富的降维方法,包括主成分分析、线性判别分析和t-SN E等。

这些方法可以帮助我们处理高维数据,提取出重要的特征信息,并可视化数据。

根据具体任务的需求,我们可以选择合适的降维方法来进行数据处理和分析。

要注意的是,在使用这些方法时,需要根据实际情况进行参数调整和结果的解释,以确保得到可靠和有效的降维结果。

如何在MATLAB中进行数据压缩与降维

如何在MATLAB中进行数据压缩与降维数据压缩和降维是现代数据处理和分析中的重要技术,它们可以帮助我们有效地处理大规模数据,减少存储空间和计算复杂度。

在MATLAB中,有许多强大的工具和算法可供我们使用,本文将介绍如何利用MATLAB进行数据压缩和降维。

一、数据压缩的基本概念和方法数据压缩是指通过一系列算法和技术,将原始数据转换为更紧凑和可表示的形式,以减少存储空间或传输带宽。

常用的数据压缩方法包括有损和无损压缩。

无损压缩是指压缩后的数据可以完全还原为原始数据,而有损压缩则会有一定的信息损失。

在MATLAB中,我们可以使用许多压缩算法来处理数据。

其中一个常用的压缩算法是gzip,它采用DEFLATE算法将数据压缩成一个单一的gz文件。

使用gzip压缩数据非常简单,只需使用MATLAB的zlib库即可实现。

另一个常用的压缩算法是Lempel-Ziv-Welch(LZW)算法,它是一种无损压缩算法,常用于文本和图像数据的压缩。

这个算法的核心思想是利用字典来存储已经出现的字符序列,然后将新的字符序列转换为字典中的索引。

在MATLAB中,我们可以使用`lwcompress`函数来实现LZW压缩。

二、数据降维的基本概念和方法数据降维是指通过选择一组最重要的特征或主成分,将高维的数据映射到低维空间中,从而降低数据的维度。

降维可以帮助我们减少数据的存储空间和分析复杂度,同时保持数据的主要结构和特征。

在MATLAB中,有许多经典的降维算法可供使用。

其中最常见的算法是主成分分析(PCA)算法。

PCA可以将原始数据转换为一组无关的主成分,其中每个主成分都是原始数据的线性组合。

在MATLAB中,我们可以使用`pca`函数来进行PCA降维分析。

另一个常用的降维算法是线性判别分析(LDA)。

LDA通过选择最佳投影方向,将多类别数据映射到低维空间中,从而使不同类别之间具有最大的差异性。

在MATLAB中,我们可以使用`classificationlda`函数来进行LDA降维分析。

MATLAB中的数据降维与特征抽取方法

MATLAB中的数据降维与特征抽取方法导语:在现代科技高速发展的背景下,数据处理已经成为各行各业不可或缺的一环。

在海量数据面前,如何从中提取出有价值的信息,成为了一个重要的问题。

而数据降维与特征抽取方法,则是解决这一问题的关键技术之一。

本文将介绍MATLAB中的数据降维与特征抽取方法,帮助读者深入了解并掌握这一领域中的技术。

一、数据降维的概念与应用数据降维是指通过某种方式将高维度的数据转换为低维度的数据,而能够保留尽可能多的原始数据信息。

数据降维的应用非常广泛,比如在图像识别、文本挖掘、自然语言处理等领域中,高维数据的处理往往存在着维数灾难问题,使用降维方法可以有效降低计算成本并提高算法的效果。

在MATLAB中,常用的数据降维方法有主成分分析(PCA)、线性判别分析(LDA)等。

其中,PCA是一种无监督降维方法,通过线性变换将原始数据映射到新的空间中,使得新的变量之间无相关性,尽可能保留原始数据的信息。

LDA则是一种有监督降维方法,通过最大化类间散度和最小化类内散度的方式,将数据投影到新的低维空间中。

二、MATLAB中的主成分分析(PCA)主成分分析(PCA)是一种经典的数据降维方法,被广泛应用于数据处理和模式识别等领域。

在MATLAB中,可以通过调用"pca"函数来实现主成分分析。

首先,在MATLAB中导入数据集,并通过如下代码进行数据预处理:```matlabdata = [1 2 3; 4 5 6; 7 8 9; 10 11 12]; % 假设数据集为一个4x3的矩阵[m, n] = size(data); % 获取数据集的行数和列数mean_data = mean(data); % 计算数据集每列的均值data_centered = data - repmat(mean_data, m, 1); % 中心化数据集```接下来,调用"pca"函数进行主成分分析,代码如下:```matlab[coeff, score, latent] = pca(data_centered); % 执行主成分分析```其中,"coeff"为主成分的系数矩阵,"score"为新的数据集,"latent"为每个主成分的方差解释量。

MATLAB中的特征选择和降维技巧

MATLAB中的特征选择和降维技巧引言数据分析是如今科学研究和实际应用中不可或缺的一部分。

在处理各种数据时,我们常常会遇到高维数据的情况,这种数据会给我们的分析带来挑战。

高维数据的特点是特征数量多,但往往包含了大量冗余和噪声信息。

因此,为了提高分析效果和降低计算复杂度,特征选择和降维技巧应运而生。

一、特征选择的意义和方法1.1 特征选择的意义特征选择是指从原始数据中挑选出最具有代表性和区分性的特征,以达到简化数据和提高模型性能的目的。

通过特征选择,我们可以剔除冗余信息,降低计算和存储复杂性,减少过拟合的风险。

特征选择在现实生活中的应用广泛,如生物医学领域的基因选择、图像处理领域的特征提取等。

1.2 特征选择的方法特征选择方法可以分为三类:过滤方法、包装方法和嵌入方法。

过滤方法是一种一次性进行特征选择的方法。

其原理是通过计算特征与目标变量之间的相关性或类似度,选取相关性较高的特征。

常用的过滤方法包括相关系数法、卡方检验、信息增益等。

包装方法是一种先训练模型再进行特征选择的方法。

它通过先训练一个模型,然后根据模型的表现选择最佳特征。

包装方法通常采用递归特征消除(Recursive Feature Elimination,RFE)和遗传算法等。

嵌入方法是一种将特征选择嵌入到模型训练中的方法。

比如,决策树和支持向量机(Support Vector Machines,SVM)等模型在训练过程中自动进行特征选择。

二、降维技巧的意义和方法2.1 降维技巧的意义降维是指通过一定的变换方法将高维数据映射到低维空间中,从而实现简化数据和提高模型性能的目的。

降维的意义在于减少数据维度,使得数据更易于理解和分析,并可以减少计算和存储复杂性。

此外,降维还可以帮助我们发现数据内部的隐藏结构,从而为后续分析提供更有效的特征。

2.2 降维技巧的方法降维技巧可以分为线性降维和非线性降维两类。

线性降维是指通过线性变换将高维数据映射到低维空间。

使用MATLAB进行数据降维的最佳实践

使用MATLAB进行数据降维的最佳实践引言:数据降维是在现代数据分析和机器学习中非常重要的一项技术,主要用于减少特征维度、压缩数据和提高算法效率。

在大数据时代,如何在信息丰富的数据集中找到最具代表性的特征向量成为了一个挑战。

这篇文章将介绍如何使用MATLAB 进行数据降维的最佳实践。

一、数据降维概述数据降维是指将高维数据转化为低维数据的过程,同时保留原始数据的重要信息。

高维数据往往包含大量冗余特征,因此进行降维可以提高计算效率、减少存储空间和消除特征之间的相关性。

常用的降维方法包括主成分分析(PCA)和线性判别分析(LDA)等。

在使用这些方法时,MATLAB提供了丰富的函数和工具箱,方便我们进行高效的数据降维分析。

二、数据准备与预处理在进行数据降维之前,首先需要对原始数据进行准备和预处理。

对于数值型数据,可以进行缺失值处理、标准化和归一化等操作。

对于类别型数据,可以进行独热编码或者使用数值代替进行处理。

在使用MATLAB进行数据预处理时,可以使用函数如preprocess和normalize等进行相应操作,确保数据的一致性和准确性。

三、主成分分析(PCA)主成分分析(PCA)是常用的一种降维方法,通过线性变换将原始数据映射到新的坐标系上,使得降维后的数据保留了最大方差。

在MATLAB中,可以使用函数pca进行主成分分析。

通过设置参数,我们可以选择保留的主成分个数,从而实现数据降维。

同时,MATLAB还提供了绘制主成分分析结果的函数,如biplot和scatter等,便于我们直观地分析降维后的数据分布。

四、线性判别分析(LDA)与PCA不同,线性判别分析(LDA)是一种监督式的降维方法,主要用于分类问题。

LDA通过找到最佳投影方向,使得同一类样本的投影尽可能接近,不同类样本的投影尽可能远离。

这样可以使得样本之间的区分度最大化。

在MATLAB 中,可以使用函数classify进行LDA分类,同时也提供了lda函数用于进行降维分析。

MATLAB中的特征选择与降维方法介绍

MATLAB中的特征选择与降维方法介绍引言特征选择与降维是机器学习和模式识别领域中非常重要的一部分,它们可以帮助我们从高维数据中提取出最重要的信息,减少特征空间的维度,并提高学习算法的效率和准确性。

MATLAB作为一种功能强大的科学计算软件,提供了丰富的特征选择和降维的方法和工具,本文将对其中的一些方法进行介绍。

一、特征选择方法1.1 过滤方法过滤方法是一种简单而直观的特征选择方法,它通过对特征进行评估和排序,选择出与目标变量相关性较高的特征。

常用的过滤方法包括皮尔逊相关系数、互信息和卡方检验等。

在MATLAB中,可以使用函数corrcoef、mutualinfo和chi2来进行相关性计算。

1.2 包装方法包装方法是一种基于学习器的特征选择方法,它通过训练一个学习器,结合特征子集的评估指标来搜索最佳的特征子集。

常用的包装方法包括递归特征消除和遗传算法等。

在MATLAB中,可以使用函数rfe和ga来实现相应的包装方法。

1.3 嵌入方法嵌入方法是一种将特征选择和学习算法进行融合的方法,它通过学习算法自身的特性来选择特征。

常用的嵌入方法包括L1正则化和决策树等。

在MATLAB中,可以使用函数lasso和fitctree来实现相应的嵌入方法。

二、降维方法2.1 主成分分析(PCA)主成分分析是一种常用的降维方法,它通过线性变换将原始特征空间映射到一组新的正交特征空间,新特征空间的维度低于原始特征空间。

PCA可以最大程度地保留原始数据的方差,使得降维后的数据尽可能保留原始数据的信息。

在MATLAB中,可以使用函数pca来进行主成分分析。

2.2 线性判别分析(LDA)线性判别分析是一种常用的降维方法,它使用类别信息来寻找最佳投影方向,将原始特征空间映射到一组新的低维特征空间。

LDA可以最大程度地保持不同类别的距离,提高分类的性能。

在MATLAB中,可以使用函数classify来进行线性判别分析。

2.3 独立成分分析(ICA)独立成分分析是一种常用的降维方法,它假设原始数据是由多个独立的成分线性组合而成,通过寻找这些独立成分的投影方向,并使得投影数据之间的相关性最小化,实现对原始数据的降维。

MATLAB中的数据降维与主成分分析方法

MATLAB中的数据降维与主成分分析方法导言:数据降维是一种常见的数据预处理技术,通过减少数据特征的数量,将高维数据转化为低维数据,并保留原始数据的重要信息。

主成分分析(Principal Component Analysis, PCA)是一种常用的数据降维方法,它通过线性变换将高维数据映射到低维空间,使得数据在新的坐标系下具有最大的方差。

本文将介绍MATLAB中的数据降维与主成分分析方法,并探讨其应用领域和局限性。

一、MATLAB中的数据降维函数1.1 主成分分析函数pca在MATLAB中,数据降维与主成分分析可以通过内置函数pca实现。

pca函数的基本语法如下:```matlab[coeff,score,latent,tsquared,explained] = pca(X)```其中,X是一个m×n的矩阵,其中每一行表示一个样本,每一列表示一个特征。

函数返回值中,coeff是一个n×n的矩阵,表示原始特征与主成分之间的线性关系;score是一个m×n的矩阵,表示样本在主成分上的投影;latent是一个n×1的向量,表示每个主成分的方差贡献程度;explained是一个n×1的向量,表示每个主成分的方差解释程度。

1.2 主成分分析函数pcares除了pca函数外,MATLAB还提供了另一个主成分分析函数pcares,用于计算主成分分析的残差矩阵。

pcares函数的基本语法如下:```matlab[R,SSM,SSE] = pcares(X,m)```其中,X是一个m×n的矩阵,m表示样本数,n表示特征数。

R是一个m×n的矩阵,表示主成分分析的残差矩阵;SSM是一个n×1的向量,表示主成分模型的平方和;SSE是一个n×1的向量,表示残差模型的平方和。

二、主成分分析方法的应用主成分分析方法在数据降维领域有广泛的应用。

Matlab中的数据降维与特征选择技巧概述

Matlab中的数据降维与特征选择技巧概述引言:随着信息时代的到来,数据量呈现爆炸性增长的趋势。

对于大规模、高维度的数据集,通常会面临着许多挑战。

为了降低计算和存储成本,以及提高模型训练和预测的效率,人们开始借助数据降维和特征选择技巧来简化数据。

在本文中,我们将概述Matlab中常用的数据降维和特征选择的技术,以及它们在实际应用中的作用和优势。

一、数据降维技术概述数据降维是对高维度数据进行转换,将其映射到低维度空间的过程。

降维技术的目的是在保持数据信息丢失最小的前提下,减少数据集的维度。

常见的数据降维技术主要有主成分分析(Principal Component Analysis, PCA)和线性判别分析(Linear Discriminant Analysis, LDA)。

1. 主成分分析(PCA):PCA是一种无监督学习的降维技术,它通过线性变换将原始数据集映射为新的坐标系,在新的坐标系中,数据点之间的协方差最小化。

这样做的好处是可以保留原始数据的大部分信息,同时减少数据的维度。

在Matlab中,可以使用`pca`函数实现PCA。

2. 线性判别分析(LDA):与PCA不同,LDA是一种有监督学习的降维技术,它基于数据的类别标签,将原始数据映射为新的坐标系,使得不同类别之间的类内距离最小化,而不同类别之间的类间距离最大化。

这样做的目的是为了在降维的同时保留数据的判别能力。

在Matlab中,可以使用`fitcdiscr`函数实现LDA。

二、特征选择技术概述特征选择是从原始特征集中选择出最具有代表性和决策能力的特征子集的过程。

特征选择的目的是减少特征集的维度,提高模型的泛化能力,避免维度灾难。

常见的特征选择技术主要有过滤式选择、包裹式选择和嵌入式选择。

1. 过滤式选择:过滤式选择是一种独立于具体机器学习模型的特征选择方法,它通过对每个特征的评估来确定其重要性,然后根据重要性进行排序,最后选取排名最高的特征子集。

使用Matlab进行数据降维

使用Matlab进行数据降维数据降维是一种在数据分析和机器学习领域中广泛应用的技术。

它可以帮助我们从高维数据中提取出最为关键的特征,以便更好地进行数据分析和模型建立。

在这篇文章中,我们将探讨使用Matlab进行数据降维的方法和步骤,以及一些常用的降维算法。

首先,让我们引入一个简单的例子来说明数据降维的概念和应用。

假设我们有一个包含1000个样本和100个特征的数据集。

这个数据集可能来自于某个实验,记录了不同因素对结果的影响。

然而,由于每个样本具有过多的特征,我们很难直接观察和分析数据。

因此,我们希望通过数据降维的方式,找出最能代表原始数据的特征。

在Matlab中,我们可以使用主成分分析(Principal Component Analysis,PCA)算法来进行数据降维。

PCA是一种常用的线性降维方法,通过线性变换将高维数据映射到低维空间,保留大部分的信息。

在Matlab中,我们可以使用“pca”函数来实现PCA降维。

下面是一个简单的PCA降维示例代码:```matlabdata = load('data.mat'); % 加载数据[mapped_data, ~, latent] = pca(data); % 进行PCA降维explained_variance = cumsum(latent) / sum(latent); % 计算解释方差比例```在上面的代码中,我们首先使用“load”函数加载了一个名为"data.mat"的数据文件。

接下来,我们使用“pca”函数对数据进行降维。

函数返回了降维后的映射数据“mapped_data”,以及每个主成分的累计方差“latent”。

最后,我们通过计算累计方差的比例,来衡量每个主成分所解释的数据方差比例。

除了PCA之外,Matlab还提供了其他一些常用的降维算法,如多维尺度(Multidimensional Scaling,MDS)、线性判别分析(Linear Discriminant Analysis,LDA)等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

end;

% STEP 3: COMPUTE EMBEDDING FROM EIGENVECTS OF COST MATRIX M=(I-W)'(I-W)

distance = repmat(X2,N,1)+repmat(X2',1,N)-2*X'*X;

%repmat就是在行方向把X2复制成N份,列方向为1份

[sorted,index] = sort(distance);

%sort是对矩阵排序,sorted是返回对每列排序的结果,index是返回排序后矩阵中每个数在矩阵未排序前每列中的位置

%[Y,eigenvals] = jdqr(M,d+1);%change in using JQDR func

Y = Y(:,2:d+1)'*sqrt(N); % bottom evect is [1,1,1,1...] with eval 0

fprintf(1,'Done.\n');

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

[D,N] = size(X);

%D是矩阵的行数,N是矩阵的列数

fprintf(1,'LLE running on %d points in %d dimensions\n',N,D);

% STEP1: COMPUTE PAIRWISE DISTANCES & FIND NEIGHBORS

%计算矩阵M=(I-W)'(I-W)的最小d个非零特征值对应的特征向量

fprintf(1,'-->Computing embedding.\n');

% M=eye(N,N); % use a sparse matrix with storage for 4KN nonzero elements

neighborhood = index(2:(1+K),:);

% STEP2: SOLVE FOR RECONSTRUCTION WEIGHTS

%计算重构权

fprintf(1,'-->Solving for reconstruction weights.\n');

if(K>D)

fprintf(1,' [note: K>D; regularization will be used]\n');

tol=1e-3; % regularlizer in case constrained fits are ill conditioned

else

tol=0;

end

%寻找邻居数据点

fprintf(1,'-->Finding %d nearest neighbours.\n',K);

X2 = sum(X.^2,1);

%矩阵X中的每个元素以2为指数求幂值,并且竖向相加

%if two point X=(x1,x2),Y=(y1,y2)

%than the distanc1-y1)+sqtr(x2-y2)

M = sparse(1:N,1:N,ones(1,N),N,N,4*K*N);

for ii=1:N

w = W(:,ii);

jj = neighborhood(:,ii);

M(ii,jj) = M(ii,jj) - w';

M(jj,ii) = M(jj,ii) - w;

W = zeros(K,N);

for ii=1:N

z = X(:,neighborhood(:,ii))-repmat(X(:,ii),1,K); % shift ith pt to origin

C = z'*z; % local covariance

LLE算法代码

% LLE ALGORITHM (using K nearest neighbors)

%

% [Y] = lle(X,K,dmax)

%

% X = data as D x N matrix (D = dimensionality, N = #points)

% K = number of neighbors(领域点的个数)

% dmax = max embedding dimensionality(最大嵌入维数)

% Y = embedding as dmax x N matrix

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

function [Y] = lle(X,K,d)

C = C + eye(K,K)*tol*trace(C); % regularlization (K>D) eye()产生k*k的单位矩阵

W(:,ii) = C\ones(K,1); % solve Cw=1

% other possible regularizers for K>D

% C = C + tol*diag(diag(C)); % regularlization

% C = C + eye(K,K)*tol*trace(C)*K; % regularlization

M(jj,jj) = M(jj,jj) + w*w';

end;

% CALCULATION OF EMBEDDING

options.disp = 0; options.isreal = 1; options.issym = 1;

[Y,eigenvals] = eigs(M,d+1,0,options);