Unified-Memory-CUDA-6.0

cuda发展历程

cuda发展历程CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种并行计算架构,允许科学家和工程师利用GPU (Graphics Processing Unit)进行高性能计算和并行编程。

下面将介绍CUDA发展历程。

CUDA的发展可以追溯到2006年,当时NVIDIA发布了第一版的CUDA架构,并推出了第一代的CUDA编程工具包(CUDA Toolkit)。

这一版本的CUDA主要用于加速科学计算和图形渲染任务。

初期的CUDA架构由一个称为“流处理器”的多个执行单元组成,这些执行单元同步执行GPU上并行计算的指令流。

随着时间的推移,NVIDIA不断推出新的CUDA架构和工具包,以提供更好的性能和功能。

2008年,NVIDIA发布了第二代的CUDA架构,并推出了CUDA 2.0工具包,引入了一些重要的功能,如双精度浮点数和纹理内存。

这使得科学计算和数据处理等高性能计算任务在GPU上的加速效果更加显著。

在2010年,NVIDIA发布了第三代的CUDA架构和CUDA3.0工具包。

这一版本引入了动态并行性(Dynamic Parallelism)的概念,允许GPU上的线程能够生成其他线程,从而实现更复杂的并行计算任务。

此外,NVIDIA还增加了对并行数据传输的支持,提高了内存访问的效率。

随后几年中,NVIDIA继续推出新的CUDA架构和工具包。

例如,在2012年,NVIDIA发布了Kepler架构和CUDA 5.0工具包,引入了许多新的功能和改进。

其中一个重要的改进是支持动态并行性的进一步增强,使得GPU上的线程能够更好地调度和协同工作。

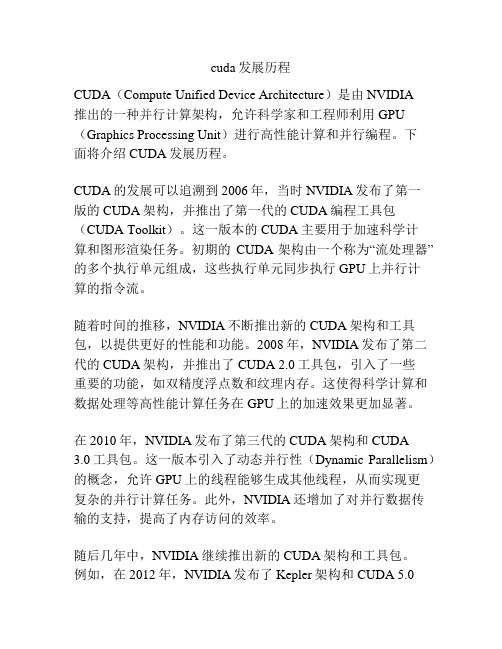

此外,NVIDIA还引入了一种新的内存模型,称为统一虚拟内存(Unified Virtual Memory),以简化GPU和CPU之间的数据传输。

在2014年,NVIDIA发布了Maxwell架构和CUDA 6.0工具包。

cuda 模板函数 -回复

cuda 模板函数-回复什么是CUDA模板函数?CUDA(Compute Unified Device Architecture)是一种由NVIDIA推出的并行计算平台和编程模型。

CUDA模板函数是利用CUDA平台进行并行计算的一种技术,它允许程序员使用模板元编程的方式进行GPU加速。

CUDA模板函数的特点和用途CUDA模板函数具有以下几个特点和用途:1. 可以实现泛型编程:CUDA模板函数能够实现泛型编程,以适应不同的数据类型和计算需求。

它能够根据不同的数据类型生成对应的GPU函数,从而实现更高效的计算。

2. 可以减少代码冗余:CUDA模板函数可以通过模板参数来减少代码冗余。

程序员可以使用模板元编程的方式将代码中的冗余部分提取出来,以减少代码量,并提高代码复用性。

3. 可以提高代码可维护性和可阅读性:CUDA模板函数能够提高代码的可维护性和可阅读性。

它们可以根据传入的模板参数自动生成对应的GPU函数,从而使得代码更加清晰和易于理解。

4. 可以加快开发速度:CUDA模板函数可以加快程序的开发速度。

程序员可以使用模板元编程的方式将一些通用的计算过程封装成为模板函数,从而避免重复性的工作,提高开发效率。

如何编写CUDA模板函数?下面将一步一步介绍如何编写CUDA模板函数:步骤一:定义函数模板首先,我们需要定义一个函数模板来实现并行计算。

函数模板使用template关键字进行定义,并在尖括号中指定模板参数。

例如,我们可以定义一个模板函数来实现向量加法运算:template <typename T>__global__ void vectorAdd(T* A, T* B, T* C, int size) {int tid = blockIdx.x * blockDim.x + threadIdx.x;if (tid < size) {C[tid] = A[tid] + B[tid];}}在上述代码中,模板参数T表示数据类型,函数名为vectorAdd,接受四个参数:输入向量A、B,输出向量C,以及向量的大小size。

unexpected error from cudagetdevicecount

unexpected error from cudagetdevicecount怎么解决"unexpected error from cuGetDeviceCount" 是与NVIDIA 的CUDA(Compute Unified Device Architecture)相关的错误信息。

这个错误通常表明在尝试获取可用的CUDA 设备数量时发生了意外的问题。

以下是一些建议,希望能帮助你解决这个问题:1. 检查CUDA驱动和Toolkit的安装:-确保已正确安装与你的GPU兼容的CUDA驱动和Toolkit版本。

你可以在NVIDIA的官方网站上找到相应的CUDA版本和GPU驱动版本兼容性表。

2. 更新GPU驱动:-尝试更新你的GPU驱动程序到最新版本。

最新版本的驱动程序通常修复了已知的问题并提供更好的兼容性。

3. 确认GPU支持CUDA:-确保你的GPU确实支持CUDA。

一些较老的或低端的GPU可能不支持最新版本的CUDA。

4. 检查CUDA环境变量:-确保设置了正确的CUDA环境变量。

在环境变量中,`CUDA_HOME` 应该指向你的CUDA Toolkit的安装路径。

5. 查看系统日志和错误信息:-在尝试运行CUDA程序时,查看系统日志和错误信息。

这些信息可能提供更多的线索,帮助你找到问题所在。

6. 检查系统兼容性:-确保你的操作系统和硬件符合CUDA Toolkit的系统要求。

7. 尝试重新安装CUDA Toolkit:-如果可能,尝试重新安装CUDA Toolkit。

确保按照官方文档的说明进行操作。

8. 检查其他程序的冲突:-有时,其他正在运行的程序可能会干扰CUDA的正常运行。

尝试关闭其他可能与CUDA 冲突的程序。

9. 查看CUDA示例程序:-尝试运行CUDA Toolkit自带的示例程序,以确保CUDA环境设置正确且没有其他问题。

如果你仍然无法解决问题,建议查阅相关CUDA文档、用户论坛或与NVIDIA支持团队联系,以获取更详细的帮助。

linux环境GPU版pytorch安装教程

linux环境GPU版pytorch安装教程在Linux环境下安装GPU版PyTorch需要进行以下步骤:1.确认显卡驱动:首先要确保系统中正确安装了适配自己显卡的驱动程序。

可以通过输入以下命令来检查显卡驱动版本:```nvidia-smi```如果出现显卡驱动的信息说明已经正确安装。

2. 安装CUDA:PyTorch使用CUDA进行GPU加速,所以需要安装对应的CUDA版本。

可以通过以下步骤安装CUDA:```chmod +x cuda_*.runsudo ./cuda_*.run```安装过程中会询问是否安装NVIDIA驱动,如果之前已经安装了驱动则无需再次安装。

c. 添加CUDA路径到系统环境变量。

找到cuda安装目录下的bin文件夹,打开终端,并执行以下命令:```export PATH=/usr/local/cuda-<version>/bin${PATH:+:${PATH}}export LD_LIBRARY_PATH=/usr/local/cuda-<version>/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}} ```其中`<version>`为CUDA的版本号,例如`11.0`。

3. 安装cuDNN:cuDNN是NVIDIA提供的用于深度学习框架的GPU加速库,PyTorch需要使用到它。

可以按照以下步骤安装cuDNN:4. 创建虚拟环境:为了避免与系统Python环境冲突,最好在安装PyTorch之前创建一个虚拟环境。

可以使用`virtualenv`或者`conda`来创建虚拟环境。

这里使用`conda`为例:a. 如果没有安装`conda`,可以先安装`conda`,并创建一个新的环境:```conda create -n pytorch_env python=3.7```在这个例子中,我们创建了一个名为`pytorch_env`的环境,并选择了Python 3.7版本。

cuda samples用法 -回复

cuda samples用法-回复CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种并行计算平台和编程模型,可为GPU(图形处理器)提供并行计算能力。

CUDA使开发人员能够利用GPU的强大性能来加速各种计算密集型应用程序。

在CUDA中,有许多示例代码可供开发人员使用。

这些示例代码可以帮助开发人员了解CUDA编程模型的基本概念和技术,并为他们提供一个快速入门的方式。

本文将详细介绍CUDA示例的使用方法和一些常见示例的功能。

首先,要使用CUDA示例,我们需要确保已安装了适当的CUDA开发环境。

这包括安装NVIDIA显卡驱动程序、CUDA Toolkit和在计算机上配置适当的编译环境。

一旦安装完CUDA开发环境,我们可以开始浏览和运行CUDA示例。

CUDA示例通常由一组源代码文件组成,每个文件都包含一个示例的实现。

示例的实现代码通常采用C或C++编写,并使用CUDA编程模型中的函数和语法扩展。

要编译和运行示例,我们可以使用CUDA Toolkit提供的命令行工具nvcc。

例如,假设我们下载并解压了CUDA示例源代码,现在我们可以使用终端或命令提示符打开示例目录。

从示例目录中,我们可以使用以下命令编译和运行示例:nvcc -o example example.cu./example上述命令将使用nvcc编译示例源文件example.cu,并生成可执行文件example。

然后,我们可以运行生成的可执行文件以查看示例的输出。

CUDA示例涵盖了许多不同的主题和技术,包括向量加法、矩阵乘法、并行排序、并行规约等等。

每个示例都具有相应的实现代码和文档说明,可以帮助开发人员理解示例背后的算法和实现细节。

以向量加法为例,CUDA示例提供了一个简单的矢量加法实现。

示例代码首先分配和初始化两个输入向量,然后将这两个向量作为参数传递给CUDA函数。

在CUDA函数中,每个线程负责处理一个元素,并将其与另一个向量的对应元素相加,然后将结果存储在输出向量中。

cuda .c后缀 -回复

cuda .c后缀-回复CUDA(Compute Unified Device Architecture)是一种并行计算平台和编程模型,由NVIDIA公司开发。

它允许开发人员利用GPU(图形处理器)的强大计算能力,加速并行计算任务的执行速度。

在本文中,我们将逐步回答关于CUDA的相关问题。

第一部分:什么是CUDA?CUDA是一种并行计算平台和编程模型,它利用GPU的并行计算能力来加速计算任务。

传统上,GPU主要用于图形渲染,而CUDA将其转变为通用计算设备。

CUDA利用GPU内部的大量并行计算单元,高效地执行大规模的并行计算任务。

第二部分:为什么使用CUDA?CUDA相比于传统的CPU计算具有很多优势。

首先,GPU具有数以千计的并行计算单元,远远超过CPU的数量,因此可以同时执行更多的计算任务。

其次,GPU具有高带宽的内存访问,可以更快地从内存中读取数据。

最重要的是,CUDA提供了一组强大的编程工具和库,使开发人员可以方便地利用GPU的计算能力。

第三部分:CUDA的工作原理是什么?CUDA的工作原理可以概括为以下几个步骤。

首先,开发人员使用CUDA 编程语言(通常是C)编写并行计算的代码,并使用CUDA工具链将其编译成机器代码。

然后,开发人员将数据从主机(CPU)内存复制到设备(GPU)内存中。

接下来,开发人员将并行计算的任务分解成多个线程块,每个线程块包含多个线程。

每个线程独立地执行计算任务,并访问设备内存中的数据。

最后,开发人员将计算结果从设备内存复制回主机内存,并进行后续处理。

第四部分:如何使用CUDA进行并行计算?要使用CUDA进行并行计算,首先需要安装NVIDIA的显卡驱动和CUDA 开发工具包。

然后,开发人员可以使用CUDA编程语言编写并行计算的代码。

在代码中,需要使用特定的语法和API来定义并行计算任务,并操作设备内存中的数据。

编写完代码后,使用CUDA工具链进行编译,并将生成的可执行文件在GPU上运行。

linux cuda cudnn 卸载

linux cuda cudnn 卸载在Linux操作系统中,CUDA和CUDNN是广泛使用的深度学习框架。

然而,有时候我们可能需要卸载它们,可能是由于升级、更换显卡或者其他原因。

本文将为您介绍如何在Linux系统中卸载CUDA和CUDNN,以及如何验证卸载是否成功。

**第一步:卸载CUDA和CUDNN的原因**在开始卸载之前,我们先来了解一下为什么需要卸载CUDA和CUDNN。

首先,CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种通用并行计算架构,用于加速深度学习和其他计算密集型任务。

CUDNN (CUDA Deep Neural Network library)则是专为深度学习而设计的库。

当我们不再需要这两个框架,或者需要升级到最新版本时,就可以考虑卸载旧版本。

**第二步:卸载CUDA和CUDNN的步骤**1.首先,打开终端。

2.卸载CUDA,运行以下命令:```sudo apt-get remove nvidia-cuda-toolkitsudo apt-get remove nvidia-cuda-dev```3.卸载CUDNN,运行以下命令:```sudo apt-get remove libcudnn*```4.删除CUDA和CUDNN的相关配置文件,运行以下命令:```rm -rf /usr/local/cuda```5.更新系统,运行以下命令:```sudo apt-get update```6.验证CUDA和CUDNN是否已成功卸载。

在终端中运行以下命令:```nvcc --versionpython -c "import ctypes; print(ctypes.CDLL("libcudnn.so"))"```如果卸载成功,这两个命令将无法找到相应的库文件。

**第三步:验证卸载是否成功**完成上述步骤后,我们可以通过以下方法验证CUDA和CUDNN是否已成功卸载:1.尝试运行使用CUDA和CUDNN的程序。

cuda best practice guide -回复

cuda best practice guide -回复关于CUDA最佳实践指南引言在当前的计算机科学和工程领域,图形处理单元(GPU)的应用越来越广泛。

CUDA(Compute Unified Device Architecture)是一种由NVIDIA 推出的并行计算平台和应用程序编程接口(API),用于利用GPU进行高性能的并行计算。

在使用CUDA开发应用程序时,遵循一些最佳实践指南可以帮助程序员提高代码的性能和可维护性。

本文将介绍一些重要的CUDA最佳实践,并使用具体的示例来说明每个实践的应用方法。

1. 设备选择和设备属性查询在CUDA编程中,首先需要选择一个适当的设备来执行计算任务。

可以使用CUDA Runtime API提供的函数cudaGetDeviceCount来查询系统中可用的GPU设备数量。

然后,可以通过调用cudaSetDevice函数来选择要使用的设备。

在选择设备之后,还可以使用cudaGetDeviceProperties 在代码中获取设备的属性信息,比如设备的全局内存大小和计算能力等。

示例代码:int deviceCount;cudaGetDeviceCount(&deviceCount);if (deviceCount == 0) {printf("Error: No CUDA capable devices found.\n");return;}cudaSetDevice(0);cudaDeviceProp deviceProp; cudaGetDeviceProperties(&deviceProp, 0);printf("Device Name: s\n", );printf("Total Global Memory: llu bytes\n", deviceProp.totalGlobalMem);printf("Compute Capability: d.d\n", deviceProp.major, deviceProp.minor);2. 内存管理在CUDA编程中,内存管理是一个非常重要的方面。

cuda发展历程

cuda发展历程CUDA(Compute Unified Device Architecture)是由NVIDIA 公司推出的一种并行计算模型和编程框架,可利用显卡的GPU(图形处理器)进行高性能并行计算。

CUDA的发展历程如下:- 2006年:NVIDIA推出了第一个支持CUDA的显卡Tesla。

- 2007年:NVIDIA发布了CUDA开发工具包(CUDA Toolkit),使开发者可以使用CUDA编程模型进行开发,利用GPU进行并行计算。

- 2008年:推出了第一个支持双精度浮点数运算的显卡Tesla C1060。

- 2009年:发布了CUDA 2.0版本,引入了动态并行调度(Dynamic Parallelism)的概念,开发者可以在GPU上启动更多的线程,并且线程可以递归地启动其他线程。

- 2010年:发布了CUDA 3.0版本,引入了统一虚拟地址空间(Unified Virtual Addressing)的概念,使得CPU和GPU可以共享同一块内存。

- 2011年:发布了CUDA 4.0版本,支持C++编程,并引入了C++11标准的一些特性。

- 2012年:发布了CUDA 5.0版本,引入了动态并行规约(Dynamic Parallelism Reduction)的概念,使得开发者可以在GPU上进行更加灵活的并行规约操作。

- 2013年:发布了CUDA 6.0版本,引入了支持GPU内存分配和管理的Unified Memory概念。

- 2014年:发布了CUDA 7.0版本,引入了CUDNN(CUDADeep Neural Network library),提供了一套高性能的深度学习库,用于加速神经网络的训练和推断。

- 2015年:发布了CUDA 7.5版本,引入了Dynamic Parallelism的改进和扩展,进一步提高了GPU的可编程性和灵活性。

- 2016年:发布了CUDA 8.0版本,引入了支持并行计算任务调度的异步处理流(Stream)机制,提供了更好的任务并行性和资源利用率。

cuda out of memory. 浮点数截断

cuda out of memory. 浮点数截断

当 CUDA 出现内存不足的情况时,通常会出现“CUDA out of memory”的错误。

这通常是由于要处理的数据量过大,超出了GPU的内存容量所致。

解决这个问题的方法有以下几种:

1. 减小输入数据规模:尝试减小输入数据的规模,可以通过降低图像分辨率、减少处理的帧数或者对输入数据进行降维等方式来减少内存占用。

2. 优化算法:优化算法以减少内存使用率。

有些算法可能存在内存占用较大的问题,可以尝试寻找更节省内存的算法或对现有算法进行优化。

3. 使用更大显存的GPU:如果条件允许,可以考虑使用具有更大显存的GPU来处理数据,以满足更高的内存需求。

至于提到的“浮点数截断”,这可能是指在数据处理过程中因为内存不足而导致浮点数运算时发生了精度丢失或截断,从而影响了计算结果的准确性。

避免这种情况的方法包括确保足够的内存供给、合理设计算法以减少对内存的需求、以及对数据进行适当的缩放和归一化处理等。

cuda error out of memory 中断训练 -回复

cuda error out of memory 中断训练-回复什么是CUDA错误之内存不足?当我们使用CUDA进行训练或运算时,可能会遇到错误信息“CUDA error: out of memory”。

这个错误提示意味着显存(GPU中的内存)不足以执行当前的操作。

显存通常是GPU中用于存储数据和计算的关键资源。

为什么会出现CUDA错误之内存不足?出现CUDA错误之内存不足可能有以下原因:1. 模型过大:训练一个非常复杂的深度学习模型时,模型参数和中间计算所需的显存会很大。

2. 数据集过大:处理大数据集时,需要将数据加载到显存中,如果数据量太大,显存可能会不够用。

3. 硬件限制:有些旧版GPU的显存容量较小,可能无法满足大规模计算的需求。

如何解决CUDA错误之内存不足问题?解决CUDA错误之内存不足问题的方法有以下几种:1. 减少显存使用:如果模型或数据集太大,可以试着减少显存使用。

可以尝试降低模型复杂度、减少输入数据的维度、减少批处理大小等。

2. 数据增强:通过数据增强技术可以扩充数据集,减少显存使用。

例如,通过对图像进行随机裁剪、缩放、翻转等操作,在不改变数据总体分布的情况下产生更多的训练样本。

3. 分布式训练:在有多个GPU的情况下,可以使用分布式训练框架,将模型和数据分配到多个GPU上进行并行计算,以减少单个GPU的显存压力。

4. 降低批处理大小:减小每次处理的数据量,以便将数据完全加载到显存中。

但要注意,过小的批处理大小可能会降低训练效果。

5. 使用更大的显存:如果使用的GPU显存容量较小,可以考虑升级为具有更大显存的GPU。

这将提供更多的显存可用于模型训练和计算。

总结CUDA错误之内存不足是在使用GPU进行深度学习训练或计算时常见的问题。

解决这个问题的方法包括减少显存使用、数据增强、分布式训练、降低批处理大小和使用更大的显存。

在实际应用中,我们可以根据具体情况选择合适的方法来解决CUDA错误之内存不足问题,以确保训练或计算的顺利进行。

cuda version is insufficient

cuda version is insufficient产生CUDA 版本不足的问题时,我们需要仔细分析问题的背景和可能的解决方案。

本文将逐步讨论如何解决CUDA 版本不足的问题。

第一步:了解CUDA 是什么?CUDA(Compute Unified Device Architecture)是由NVIDIA 推出的一种并行计算平台和编程模型,用于在NVIDIA 的GPU 上进行通用目的并行计算。

CUDA 提供了一系列的库和工具,可以帮助开发人员使用GPU 进行高性能计算、深度学习和科学计算等任务。

第二步:确定CUDA 版本不足的具体问题。

在使用CUDA 进行开发或运行CUDA 加速的应用程序时,可能会遇到CUDA 版本不足的问题。

这通常意味着系统中安装的CUDA 版本低于应用程序所需的最低要求。

第三步:了解CUDA 版本的区别。

NVIDIA 推出了许多不同版本的CUDA,每个版本都有其独特的特性和功能。

不同的CUDA 版本可能针对不同的GPU 架构、操作系统或其他硬件要求进行优化。

因此,确保使用正确的CUDA 版本是非常重要的。

第四步:查看应用程序的CUDA 版本要求。

在解决CUDA 版本不足的问题之前,我们应该查看应用程序的文档或开发人员指南,找到该应用程序所需的最低CUDA 版本要求。

这通常可以在文档中的系统要求部分或关于CUDA 版本的说明中找到。

第五步:检查系统中已安装的CUDA 版本。

为了确定当前系统中已安装的CUDA 版本,我们可以使用以下命令:nvcc version这将显示系统中安装的CUDA 版本。

如果系统中没有安装CUDA,我们可能需要手动安装适合应用程序要求的CUDA 版本。

第六步:升级或安装新的CUDA 版本。

如果系统中已安装的CUDA 版本低于应用程序所需的最低要求,我们需要升级到或安装新的CUDA 版本。

要升级CUDA,我们可以按照以下步骤进行操作:1. 访问NVIDIA 的官方网站,并下载适合系统要求的CUDA 版本安装程序。

linux cuda cudnn 卸载

linux cuda cudnn 卸载摘要:1.介绍CUDA 和cuDNN2.CUDA 和cuDNN 的安装3.CUDA 和cuDNN 的卸载4.总结正文:一、介绍CUDA 和cuDNNCUDA(Compute Unified Device Architecture)是NVIDIA 推出的一种通用并行计算架构,它允许开发人员使用NVIDIA 的GPU 来进行高性能计算。

而cuDNN(CUDA Deep Neural Network library)是专为深度神经网络计算而设计的GPU 加速库,它提供了许多深度学习所需的计算功能,如卷积、池化等。

二、CUDA 和cuDNN 的安装在安装CUDA 和cuDNN 之前,确保系统中已正确安装了NVIDIA 驱动。

以下是在Linux 系统中安装CUDA 和cuDNN 的步骤:1.首先,访问NVIDIA 官网,下载与系统相匹配的CUDA 版本。

2.解压缩下载的文件,进入解压后的文件夹。

3.在终端中执行如下命令安装CUDA:```sudo./install_cuda_linux.sh```4.安装cuDNN:```sudo cp /usr/local/cuda/include/cuDNN/.* /usr/local/cuda/include sudo cp /usr/local/cuda/lib64/tensore_core.* /usr/local/cuda/lib64 ```5.设置环境变量:```export PATH=/usr/local/cuda/bin:$PATHexport LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH ```三、CUDA 和cuDNN 的卸载卸载CUDA 和cuDNN 的步骤如下:1.卸载cuDNN:```cd /usr/local/cuda-11.5/bin./cuda-uninstaller```2.卸载CUDA:```sudo rm -rf /usr/local/cuda```3.删除解压文件:```sudo rm -rf /usr/local/cuda```四、总结本文介绍了CUDA 和cuDNN 在Linux 系统中的安装与卸载方法。

cuda out of memory,矩阵乘法

cuda out of memory,矩阵乘法

CUDA内存不足问题通常与矩阵乘法有关,特别是在处理大规模矩阵时。

以下是一些可能的解决方案:

1.调整CUDA内存分配:在调用cudaMalloc分配内存时,可以尝试

增加内存分配的大小。

这可以通过增加cudaMallocManaged的参数来实现。

2.使用更小的矩阵:如果可能的话,尝试减少矩阵的大小或使用更小

的数据结构来存储矩阵。

3.优化代码:检查是否有代码片段在执行过程中使用了过多的内存。

尝试优化算法或数据结构以减少内存使用。

4.使用GPU显存映射:如果可能,可以使用CUDA显存映射功能将

数据从主机内存复制到设备内存,这样可以避免频繁的数据传输。

5.使用分块算法:对于大规模矩阵乘法,可以使用分块算法来减少内

存使用。

这种方法将大矩阵分成小块,并在GPU上并行处理这些小块。

6.使用GPU内存优化工具:有些工具可以帮助识别和解决GPU内存

问题。

例如,NVIDIA的Nsight工具可以帮助你分析GPU内存使用情况。

如果上述方法都无法解决问题,可能需要考虑以下步骤:

•检查是否有其他程序或服务占用了大量GPU内存。

•尝试在不同的GPU设备上运行相同的代码,以确定问题是否与特定的设备有关。

•如果可能,考虑使用CPU进行计算,尤其是在内存限制不是主要问题的情况下。

以上内容仅供参考,具体的解决方案可能需要基于你的代码和环境进行详细的分析。

cudaerrorcontextisdestory

cudaerrorcontextisdestory(原创实用版)目录1.CUDA 错误背景介绍2.CUDA 错误代码含义详解3.错误解决方法及建议正文一、CUDA 错误背景介绍CUDA(Compute Unified Device Architecture)是 NVIDIA 推出的一种通用并行计算架构,它允许开发人员利用 NVIDIA 的 GPU 来进行高性能计算。

在使用 CUDA 进行编程时,可能会遇到各种各样的错误,其中之一就是 cudaErrorContextIsDestroyed。

二、CUDA 错误代码含义详解cudaErrorContextIsDestroyed(错误代码:cudaErrorMemoryAllocation)表示在 CUDA 程序运行过程中,GPU 上下文已经被销毁。

通常情况下,这个错误是由于在 GPU 内存分配过程中发生了问题,导致上下文被意外销毁。

三、错误解决方法及建议1.检查内存分配确保在程序中正确地分配了 GPU 内存。

使用 cudaMalloc() 和cudaFree() 函数来分配和释放内存。

注意,不要在没有正确释放内存的情况下重复分配内存,这可能会导致上下文被销毁。

2.避免重复创建上下文确保在程序中只创建一个 CUDA 上下文,并在整个计算过程中一直使用它。

不要在多个线程或函数中创建多个上下文,这可能会导致上下文被销毁。

3.使用 cudaGetLastError() 检查错误在 CUDA 程序中,使用 cudaGetLastError() 函数来检查是否发生了错误。

这个函数可以返回最近一次 CUDA 操作的错误代码。

通过检查错误代码,可以找到错误的原因并进行相应的修复。

4.确保 CUDA 驱动正确安装确保 NVIDIA CUDA 驱动正确安装并且与系统其他组件兼容。

如果不兼容,可能会导致 cudaErrorContextIsDestroyed 错误。

5.降低 GPU 负载如果在程序中同时执行多个 CUDA 计算,可能会导致 GPU 负载过高,从而使上下文被销毁。

cuda is out of memory cuda内存不足

cuda is out of memory cuda内存不足

“cuda is out of memory” 或“cuda内存不足” 是一个常见的错误信息,它表明你正在尝试使用的CUDA内存已经用完。

这可能是由于以下原因:

1. 程序中分配了太多的内存:如果你的程序在GPU上分配了太多的内存,比如大量的数组或矩阵,那么可能会耗尽CUDA内存。

2. 并行度太高:如果你在GPU上运行太多的线程或执行太多的任务,那么可能会耗尽CUDA内存。

3. 数据类型问题:有些数据类型在GPU上可能需要更多的内存。

例如,使用float32类型的数据可能会比使用float16类型的数据需要更多的内存。

为了解决这个问题,你可以尝试以下几种方法:

1. 减小数据集大小:如果你的程序需要处理大量的数据,那么可以尝试减小数据集的大小,或者只使用数据集的一部分进行计算。

2. 优化代码:优化你的代码,以减少内存使用。

例如,你可以尝试使用更小的数据类型,或者优化你的算法以减少内存需求。

3. 使用显存监视工具:你可以使用显存监视工具来查看你的程序在运行时使用了多少显存,这可以帮助你找出问题所在。

4. 使用显存清理工具:如果你的程序中使用了许多显存,那么可以使用显存清理工具来释放未使用的显存。

5. 增加GPU内存:如果可能的话,你可以考虑购买更大内存的GPU。

CUDA架构

第二章CUDA架构2.1 CUDA的编程模型CUDA(Compute Unified Device Architecture),是一种由NVIDIA推出的并行计算架构,非常适合大规模数据密集型计算。

CUDA使GPU的超高计算性能在数据处理和并行计算等通用计算领域发挥优势。

它包含了CUDA指令集架构(ISA)以及GPU内部的并行计算引擎。

随着显卡的发展,GPU越来越强大,在计算上已经超越了通用的CPU。

如此强大的芯片如果只是作为显卡会造成计算能力的浪费,因此NVIDIA推出CUDA,让显卡可以用于图像渲染以外的目的。

CUDA 的GPU编程语言基于标准的C语言,通过在标准C语言的基础上增加一小部分关键字,任何有C语言基础的用户都很容易地开发CUDA的应用程序。

CUDA3.0已经开始支持C++和FORTRAN。

2.1.1主机和设备CUDA编程模型在设计结构上采用了异构编程的模式,将CPU作为宿主(Host),GPU作为设备(Device),在同一个系统中可以有同时存在多个设备,但是只能有一个宿主。

在CUDA程序架构中,主程序由CPU来执行,而当遇到数据并行处理的部分,CUDA就会将程序编译成GPU能执行的程序,并传送到GPU。

CUDA使用被称为块(Block)的单元,每个块都由一些CUDA线程组成,线程是CUDA中最小的处理单元,将这些较小的子问题进一步划分为若干更小的细粒度的问题,我们便可以使用线程来解决这些问题了。

对于一个普通的NVIDIA GPU,其CUDA线程数目通常能达到数千个甚至更多,因此,这样的问题划分模型便可以成倍地提升计算机的运算性能。

GPU是由多个流水多处理器构成的,流水处理器以块(Block)为基本调度单元,因此,对于流水处理器较多的GPU,它一次可以处理的块(Block)更多,从而运算速度更快,时间更短。

而反之对于流水处理器较少的GPU,其运算速度便会较慢。

CUDA C是C语言的一个扩展,它允许程序员定义一种被称为内核函数(Kernel Functions)的C函数,内核函数运行在GPU上,一旦启动,CUDA中的每一个线程都将会同时并行地执行内核函数中的代码。

cuda out of memory的意思

CUDA Out of Memory的意思:在使用CUDA进行并行计算时,有时会遇到'Out of Memory'的错误提示。

这个错误提示表明GPU内存不足,无法继续执行任务。

本文将详细解释'CUDA Out of Memory'的意思以及可能导致该错误的原因。

1. CUDA和GPU内存CUDA是一种并行计算平台和编程模型,用于利用GPU的强大计算能力。

GPU是图形处理器,具有大量的并行计算单元,并且配备了专用的内存。

2. 'Out of Memory'的意思'Out of Memory'意味着GPU内存已经用尽,无法分配更多的内存来执行任务。

这可能是由于任务所需的内存超过了GPU的可用内存。

3. 导致'CUDA Out of Memory'的原因(1)数据量过大:当任务所需要的数据量超过了GPU可用内存的容量时,就会导致内存不足的错误。

这可能是由于输入数据的尺寸过大或者计算过程中产生了大量的临时数据。

(2)内存泄漏:程序中存在内存泄漏时,会导致内存的不断累积,最终耗尽所有可用的GPU内存。

(3)错误的内存管理:未正确使用CUDA的内存管理函数,如未释放已分配的内存,或者使用了无效的指针等,都可能导致内存不足的错误。

4. 解决'CUDA Out of Memory'的方法(1)减少数据量:如果数据量过大,可以考虑减小数据的尺寸或者采用分批处理的方式,将数据分成小块进行计算。

(2)优化内存使用:通过合理地管理内存,及时释放不再使用的内存,避免内存泄漏。

(3)降低模型复杂度:对于深度学习等模型,可以尝试减小模型的规模,减少参数量和计算量,以减少对GPU内存的需求。

(4)使用更高内存容量的GPU:如果经常遇到内存不足的问题,可以考虑使用内存容量更大的GPU来执行任务。

总之,'CUDA Out of Memory'错误提示意味着GPU内存不足,无法继续执行任务。

cuda error out of memory 中断训练

cuda error out of memory 中断训练当你在使用CUDA进行深度学习训练时遇到“out of memory”错误,这通常意味着你的GPU 内存不足以容纳当前的模型或数据。

以下是一些建议来解决这个问题:1.减小批量大小:减小批量大小可以减少每次迭代时GPU内存的使用量。

但请注意,这可能会增加训练时间,因为每次迭代都需要更多的迭代次数。

2.使用梯度累积:如果你不能进一步减小批量大小,或者减小批量大小导致训练效果不佳,你可以考虑使用梯度累积。

简单来说,就是在一个小批量上计算梯度,然后在几个小批量上累积梯度,最后用累积的梯度进行参数更新。

3.优化模型:简化模型或使用更小的卷积核可以减少GPU内存的使用。

但请注意,这可能会影响模型的性能。

4.使用混合精度训练:混合精度训练允许你在GPU上同时使用32位浮点数(float32)和16位浮点数(float16)。

这可以减少内存使用量,但可能需要额外的设置和技巧。

5.清理未使用的变量:在PyTorch中,你可以使用torch.cuda.empty_cache()来释放未使用的GPU内存。

这并不直接解决内存不足的问题,但可以帮助你为当前迭代释放更多空间。

6.数据加载优化:确保你的数据加载器(如torch.utils.data.DataLoader)高效地加载数据。

例如,你可以考虑使用pin_memory=True参数来将数据预先加载到GPU内存中。

7.使用显存更大的GPU:如果可能的话,考虑升级到具有更大显存的GPU。

8.检查其他程序:确保没有其他程序(如其他深度学习训练任务或大型游戏)正在使用你的GPU资源。

9.考虑使用梯度检查点:对于非常大的模型,可以考虑使用梯度检查点技术来进一步减少内存使用。

10.分批预处理:对于预处理步骤(如归一化),尝试将这些操作移到CPU上或分批处理,而不是在GPU上一次性完成。

在采取任何行动之前,最好先了解当前训练任务的内存需求和你的GPU的显存大小。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

kernel<<< >>>(data);

dataElem prop1 prop2 “Hello World”

// Ideal C++ version of class class dataElem { int prop1; int prop2; String text; };

Pass-by-value uses copy constructor

Only practical option is to use zero-copy (pinned system) memory GPU accesses at PCIe bandwidth GPU accesses at very high latency

key data next

CPU Memory

Overload new operator* to use C++ in unified memory region

class Managed { void *operator new(size_t len) { void *ptr; cudaMallocManaged(&ptr, len); return ptr; } void operator delete(void *ptr) { cudaFree(ptr); } };

Simpler Memory Model: Eliminate Deep Copies

CPU Memory

dataElem prop1

struct dataElem { int prop1; int prop2; char *text; };

prop2 *text “Hello World”

dataElem prop1 prop2 *text

Concise and explicit: let C++ handle deep copies Pass by-value or by-reference without memcpy shenanigans

CPU Program

dataElem *data = new dataElem;

CPU Mem) { kernel<<< ... >>>(elem); }

Unified Memory

dataElem prop1 prop2 *text “Hello World”

GPU Memory

Simpler Memory Model

Two Copies Required

“Hello World”

GPU Memory

Simpler Memory Model: Eliminate Deep Copies

void launch(dataElem *elem) { dataElem *g_elem; char *g_text; int textlen = strlen(elem->text); // Allocate storage for struct and text cudaMalloc(&g_elem, sizeof(dataElem)); cudaMalloc(&g_text, textlen); // Copy up each piece separately, including // new “text” pointer value cudaMemcpy(g_elem, elem, sizeof(dataElem)); cudaMemcpy(g_text, elem->text, textlen); cudaMemcpy(&(g_elem->text), &g_text, sizeof(g_text)); // Finally we can launch our kernel, but // CPU & GPU use different copies of “elem” kernel<<< ... >>>(g_elem); }

Example: GPU & CPU Shared Linked Lists

key data next

CPU Memory

key data next key data next key data next

GPU Memory

Simpler Memory Model

Example: GPU & CPU Shared Linked Lists

Local data access

GPU Memory

Unified Memory with C++

Host/Device C++ integration has been difficult in CUDA

Cannot construct GPU class from CPU References fail because of no deep copies

* (or use placement-new)

Unified Memory with C++

Pass-by-reference enabled with new overload

// Deriving from “Managed” allows pass-by-reference class String : public Managed { int length; char *data; };

NOTE: CPU/GPU class sharing is restricted to POD-classes only (i.e. no virtual functions)

Unified Memory with C++

Pass-by-value enabled by managed memory copy constructors

use_data(data); free(data);

}

}

Unified Memory Delivers

1. Simpler Programming & Memory Model

Single pointer to data, accessible anywhere

Tight language integration

void kernel(dataElem data) { }

GPU Memory

Unified Memory with C++

Host/Device C++ integration has been difficult in CUDA

Cannot construct GPU class from CPU References fail because of no deep copies

key data next All data access over PCIe key data next key data next

GPU Memory

Simpler Memory Model

Example: GPU & CPU Shared Linked Lists

Can pass list elements between Host & Device Can insert and delete elements from Host or Device* Single list - no complex synchronization

CPU Memory

dataElem prop1 prop2 *text “Hello World”

dataElem prop1 prop2 *text

Two Copies Required

“Hello World”

GPU Memory

Simpler Memory Model: Eliminate Deep Copies

CPU Memory

kernel<<< >>>(data);

dataElem prop1 prop2 text “Hello World”

// Ideal C++ version of class class dataElem { int prop1; int prop2; String text; };

CPU Memory

Local data access

Unified Memory

key data next key data next key data next key data next

*Program must still ensure no race conditions. *Data is coherent between CPU & GPU at kernel launch & sync only

Greatly simplifies code porting

2. Performance Through Data Locality

Migrate data to accessing processor Guarantee global coherency Still allows cudaMemcpyAsync() hand tuning

CUDA 6 Code with Unified Memory

void sortfile(FILE *fp, int N) { char *data; cudaMallocManaged(&data, N); fread(data, 1, N, fp); qsort<<<...>>>(data,N,1,compare); cudaDeviceSynchronize(); use_data(data); cudaFree(data);