《Hadoop大数据技术与应用》-HDFS常用方法和MapReduce程序

hadoop命令及使用方法

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

hadoop技术、方法以及原理的理解

hadoop技术、方法以及原理的理解Hadoop技术、方法以及原理的理解Hadoop是一个开源的分布式计算框架,它能够存储和处理海量的数据。

它由Apache基金会开发和维护,是目前最流行的大数据处理解决方案之一。

Hadoop的技术、方法以及原理是构成Hadoop 的核心部分,下面我们将对其进行详细的解析。

一、Hadoop的技术1. HDFSHadoop分布式文件系统(HDFS)是Hadoop的核心组件之一。

它是一种高度容错的分布式文件系统,具有高可靠性和高可用性。

该文件系统将海量数据分散存储在多个节点上,以实现快速访问和处理。

2. MapReduceMapReduce是Hadoop的另一个核心组件,它是一种编程模型和处理数据的方式。

MapReduce将数据分成小的块,然后在分布式计算机集群上处理这些块。

MapReduce将任务分为Map和Reduce两个阶段。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce阶段,计算的结果被合并起来并输出。

3. YARNHadoop资源管理器(YARN)是另一个重要的组件,它是一个分布式的集群管理系统,用于管理Hadoop集群中的资源。

YARN允许多个应用程序同时运行在同一个Hadoop集群上,通过动态管理资源来提高集群的使用效率。

二、Hadoop的方法1. 大数据存储Hadoop通过HDFS实现对海量数据的存储和管理。

HDFS的设计目标是支持大型数据集的分布式处理,它通过多个节点存储数据,提供高可靠性和高可用性。

2. 数据处理Hadoop通过MapReduce实现对海量数据的处理。

MapReduce 将数据分成小的块,然后在分布式计算机集群上处理这些块。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce 阶段,计算的结果被合并起来并输出。

3. 数据分析Hadoop通过Hive、Pig和Spark等工具实现数据分析。

这些工具提供了高级查询和数据分析功能,可以通过SQL和其他编程语言来处理海量数据。

林子雨大数据技术原理与应用第二章课后题答案

林子雨大数据技术原理与应用第二章课后题答案-标准化文件发布号:(9456-EUATWK-MWUB-WUNN-INNUL-DDQTY-KII大数据第二章课后题答案黎狸1.试述Hadoop和谷歌的MapReduce、GFS等技术之间的关系。

Hadoop是Apache软件基金会旗下的一-个开源分布式计算平台,为用户提供了系统底层细节透明的分布式基础架构。

①Hadoop 的核心是分布式文件系统( Hadoop Ditributed FileSystem,HDFS )和MapReduce。

②HDFS是对谷歌文件系统( Google File System, GFS )的开源实现,是面向普通硬件环境的分布式文件系统,具有较高的读写速度、很好的容错性和可伸缩性,支持大规模数据的分布式存储,其冗余数据存储的方式很好地保证了数据的安全性。

③MapReduce 是针对谷歌MapReduce的开源实现,允许用户在不了解分布式系统底层细节的情况下开发并行应用程序,采用MapReduce 来整合分布式文件系统上的数据,可保证分析和处理数据的高效性。

2.试述Hadoop具有哪些特性。

Hadoop是一个能够对大量数据进行分布式处理的软件框架,并且是以一种可靠、高效、可伸缩的方式进行处理的,它具有以下几个方面的特性。

①高可靠性。

采用冗余数据存储方式,即使一个副本发生故障,其他副本也可以保证正常对外提供服务。

②高效性。

作为并行分布式计算平台,Hadoop采用分布式存储和分布式处理两大核心技术,能够高效地处理PB级数据。

③高可扩展性。

Hadoop的设计目标是可以高效稳定地运行在廉价的计算机集群上,可以扩展到数以千计的计算机节点。

④高容错性。

采用冗余数据存储方式,自动保存数据的多个副本,并且能够自动将失败的任务进行重新分配。

⑤成本低。

Hadoop采用廉价的计算机集群,成本比较低,普通用户也很容易用自己的PC搭建Hadoop运行环境。

hadoop大数据原理与应用

hadoop大数据原理与应用Hadoop大数据原理与应用随着信息技术的飞速发展,大数据成为当今社会的热门话题之一。

而Hadoop作为大数据处理的重要工具,因其可靠性和高效性而备受关注。

本文将介绍Hadoop大数据的原理和应用。

一、Hadoop的原理Hadoop是一个开源的分布式计算框架,可以处理大规模数据集。

其核心组件包括Hadoop分布式文件系统(HDFS)和Hadoop分布式计算框架(MapReduce)。

HDFS是一个可靠的分布式文件系统,能够将大文件分成多个块并存储在不同的计算机节点上,以实现高容错性和高可用性。

而MapReduce是一种编程模型,将大规模数据集分成多个小的子集,然后在分布式计算集群上进行并行处理。

Hadoop的工作流程如下:首先,将大文件切分成多个块,并将这些块存储在不同的计算机节点上。

然后,在计算机节点上进行并行计算,每个节点都可以处理自己所存储的数据块。

最后,将每个节点的计算结果进行整合,得到最终的结果。

Hadoop的优势在于其可扩展性和容错性。

由于其分布式计算的特性,Hadoop可以轻松地处理大规模数据集。

同时,Hadoop还具有高容错性,即使某个计算机节点发生故障,整个计算任务也不会中断,系统会自动将任务分配给其他可用节点。

二、Hadoop的应用Hadoop广泛应用于大数据分析和处理领域。

以下是几个典型的应用场景:1.数据仓库:Hadoop可以存储和处理海量的结构化和非结构化数据,为企业提供全面的数据仓库解决方案。

通过使用Hadoop,企业可以轻松地将各种类型的数据整合到一个统一的平台上,从而更好地进行数据分析和挖掘。

2.日志分析:随着互联网的普及,各种网站和应用产生的日志数据越来越庞大。

Hadoop可以帮助企业对这些日志数据进行实时分析和处理,从而发现潜在的问题和机会。

3.推荐系统:在电子商务和社交媒体领域,推荐系统起着重要的作用。

Hadoop可以帮助企业分析用户的行为和偏好,从而提供个性化的推荐服务。

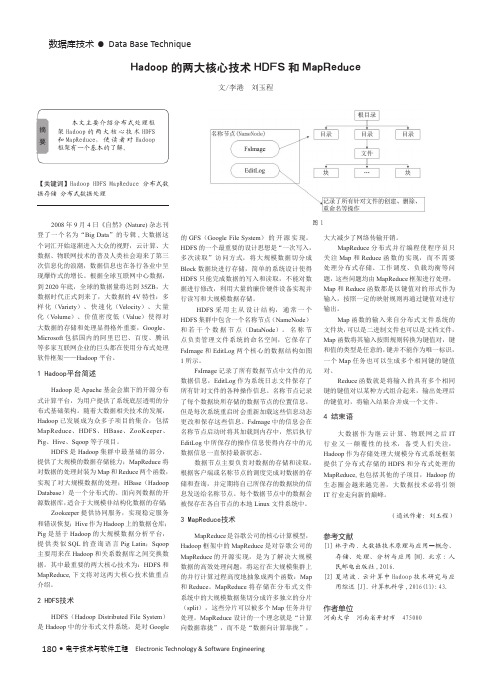

Hadoop的两大核心技术HDFS和MapReduce

180 •电子技术与软件工程 Electronic Technology & Software Engineering数据库技术• Data Base Technique【关键词】Hadoop HDFS MapReduce 分布式数据存储 分布式数据处理2008年9月4日《自然》(Nature)杂志刊登了一个名为“Big Data ”的专辑,大数据这个词汇开始逐渐进入大众的视野,云计算、大数据、物联网技术的普及人类社会迎来了第三次信息化的浪潮,数据信息也在各行各业中呈现爆炸式的增长。

根据全球互联网中心数据,到2020年底,全球的数据量将达到35ZB ,大数据时代正式到来了,大数据的4V 特性:多样化(Variety )、快速化(Velocity )、大量化(V olume )、价值密度低(Value )使得对大数据的存储和处理显得格外重要,Google 、Microsoft 包括国内的阿里巴巴、百度、腾讯等多家互联网企业的巨头都在使用分布式处理软件框架——Hadoop 平台。

1 Hadoop平台简述Hadoop 是Apache 基金会旗下的开源分布式计算平台,为用户提供了系统底层透明的分布式基础架构。

随着大数据相关技术的发展,Hadoop 已发展成为众多子项目的集合,包括MapReduce 、HDFS 、HBase 、ZooKeeper 、Pig 、Hive 、Sqoop 等子项目。

HDFS 是Hadoop 集群中最基础的部分,提供了大规模的数据存储能力;MapReduce 将对数据的处理封装为Map 和Reduce 两个函数,实现了对大规模数据的处理;HBase (Hadoop Database )是一个分布式的、面向列数据的开源数据库,适合于大规模非结构化数据的存储;Zookeeper 提供协同服务,实现稳定服务和错误恢复;Hive 作为Hadoop 上的数据仓库;Pig 是基于Hadoop 的大规模数据分析平台,提供类似SQL 的查询语言Pig Latin ;Sqoop 主要用来在Hadoop 和关系数据库之间交换数据。

大数据技术原理与应用第三版核心知识点

大数据技术原理与应用第三版核心知识点一、大数据概述1. 大数据定义大数据是指规模巨大、种类繁多的数据集合,这些数据量大到传统数据处理工具无法处理。

2. 大数据特点- 五V特点:大数据具有Volume(大量)、Velocity(高速)、Variety(多样)、Value(价值)、Veracity(真实性)五个特点。

- 非结构化数据:大部分大数据都是非结构化数据,需要通过特定的技术进行处理和分析。

二、大数据技术基础1. 分布式存储- Hadoop分布式文件系统HDFS:将大数据存储在多个节点上,提高了数据的可靠性和并行处理能力。

2. 分布式计算- MapReduce计算模型:将数据分片并行处理,提高了数据处理的速度和效率。

3. 数据清洗和预处理- 数据清洗:去除噪音数据、填补缺失值、处理异常值等。

- 数据预处理:将数据转换成可供分析的格式,如规范化、归一化等。

三、大数据存储技术1. NoSQL数据库- HBase:面向列的分布式数据库,适用于大规模结构化数据存储。

- MongoDB:面向文档的数据库,适用于存储半结构化数据。

2. 大数据文件格式- Parquet、ORC等列式存储格式:适用于大规模数据存储和分析,能够减少I/O操作。

四、大数据处理技术1. 数据挖掘- 聚类分析、分类分析、关联规则挖掘、异常检测等。

2. 机器学习- 逻辑回归、决策树、支持向量机、神经网络等机器学习算法在大数据中的应用。

3. 实时流式处理- Storm、Flink等实时流式处理框架,在大数据实时处理中的应用。

4. 图计算- 图数据库、图计算框架如Neo4j、GraphX等在大数据图计算中的应用。

五、大数据分析与应用1. 数据可视化- Tableau、Power BI等工具的应用,将大数据分析结果直观展现。

2. 业务智能- 利用大数据分析结果进行商业决策和趋势预测。

3. 个性化推荐系统- 利用用户行为数据进行个性化推荐,提升用户体验。

hadoop大数据技术与应用考试题

1、Hadoop生态系统中的分布式存储系统是什么?A. HDFSB. HBaseC. HiveD. Mahout(答案:A,HDFS是Hadoop Distributed File System的缩写,是Hadoop的分布式存储系统)2、Hadoop集群中的NameNode主要负责什么功能?A. 数据存储B. 数据处理C. 元数据管理D. 资源调度(答案:C,NameNode负责Hadoop集群中的元数据管理)3、以下哪个工具常用于Hadoop集群的资源管理和作业调度?A. YARNB. HDFSC. ZookeeperD. Sqoop(答案:A,YARN是Yet Another Resource Negotiator的缩写,用于Hadoop集群的资源管理和作业调度)4、Hadoop中的MapReduce编程模型主要包括哪两个阶段?A. Map和ShuffleB. Map和ReduceC. Reduce和SortD. Sort和Combine(答案:B,MapReduce包括Map和Reduce两个阶段)5、HBase是Hadoop生态系统中的哪个组件?A. 分布式文件系统B. 分布式数据库C. 数据仓库D. 机器学习库(答案:B,HBase是Hadoop生态系统中的分布式数据库)6、以下哪个组件通常用于在Hadoop中进行大规模数据处理和分析?A. PigB. SqoopC. FlumeD. Zookeeper(答案:A,Pig是一个高级平台,用于在Hadoop中进行大规模数据处理和分析)7、Hadoop集群中的DataNode主要负责什么?A. 存储和管理数据块B. 处理数据计算C. 管理集群元数据D. 监控集群状态(答案:A,DataNode主要负责存储和管理数据块)8、以下哪个是Hadoop生态系统中的数据挖掘和机器学习库?A. MahoutB. HiveC. PigD. Oozie(答案:A,Mahout是Hadoop生态系统中的数据挖掘和机器学习库)。

Hadoop大数据分析原理与应用

Hadoop大数据分析原理与应用随着互联网的不断发展,数据量越来越大,因此如何高效地处理这些数据成为了互联网公司不可或缺的一环。

而Hadoop作为分布式计算平台,被越来越多的公司所采用。

本文将从Hadoop的原理、应用以及优缺点三个方面进行探讨。

一、Hadoop的原理Hadoop作为一个分布式计算平台,主要运用了HDFS分布式文件系统和MapReduce计算模型。

其中HDFS将大文件分割成小块,分别保存在多个磁盘上,并且自动备份以实现容错。

而MapReduce计算模型则是将大数据分割成小数据块,分发给多个节点完成并行处理,最终将结果合并输出。

因此,Hadoop的核心思想在于将一个任务分解成多个小任务,再将这些小任务分配给多个计算节点进行并行计算。

二、Hadoop的应用1、网站日志分析一些大型的网站需要统计用户行为及网站流量数据,这就需要用到Hadoop进行大数据处理。

Hadoop可以通过分析网站流量数据,帮助网站拓展营销渠道,优化营销策略,提高网站的用户体验度和粘性,进而提高网站收益。

2、金融数据分析目前,许多公司更倾向于使用Hadoop分析金融数据。

Hadoop可以高效地处理非常庞大的金融数据,不仅能加快分析业务过程,同时还能降低操作成本。

此外,Hadoop也可以对贷款审批、投资决策等方面提供支持。

3、社交媒体分析在社交媒体环境下,海量的社交媒体数据需要进行处理。

而使用Hadoop可以进行快速的社交媒体分析,以得出针对特定人群的市场趋势、方法和意见等。

此外,利用Hadoop的技术,还可以对社交媒体数据生成精细化报告,以用于组织创造、推广营销、客户关系管理等方面的决策。

三、Hadoop的优缺点优点:1、分布式计算能力。

2、横向扩展能力。

3、容错能力强。

4、可以处理极大数据。

缺点:1、要求专业技能。

2、运行平台不太稳定。

3、运行效率不高,容易造成数据流不畅。

四、结语随着企业对效率和数据制造便利性不断的要求提高,Hadoop成为了企业处理大数据的绝佳选择。

如何在Hadoop中使用MapReduce进行数据分析

如何在Hadoop中使用MapReduce进行数据分析在当今信息爆炸的时代,数据分析已经成为了企业和组织决策的重要工具。

而Hadoop作为一个开源的分布式计算框架,提供了强大的数据处理和分析能力,其中的MapReduce就是其核心组件之一。

本文将介绍如何在Hadoop中使用MapReduce进行数据分析。

首先,我们需要了解MapReduce的基本原理。

MapReduce是一种分布式计算模型,它将大规模的数据集划分成若干个小的数据块,然后通过Map和Reduce两个阶段进行并行处理。

在Map阶段,数据集会被分割成若干个键值对,每个键值对由一个键和一个值组成。

然后,Map函数会对每个键值对进行处理,生成一个新的键值对。

在Reduce阶段,相同键的值会被分组在一起,然后Reduce函数会对每个键的值进行聚合和处理,最终生成最终的结果。

在Hadoop中使用MapReduce进行数据分析的第一步是编写Map和Reduce函数。

在编写Map函数时,我们需要根据具体的数据分析任务来定义键值对的格式和生成方式。

例如,如果我们要统计某个网站的访问量,那么键可以是网站的URL,值可以是1,表示一次访问。

在Reduce函数中,我们需要根据具体的需求来定义对键的值进行聚合和处理的方式。

例如,如果我们要统计每个网站的总访问量,那么Reduce函数可以将所有的值相加得到最终的结果。

编写好Map和Reduce函数后,我们需要将数据加载到Hadoop中进行分析。

在Hadoop中,数据通常以HDFS(Hadoop Distributed File System)的形式存储。

我们可以使用Hadoop提供的命令行工具或者编写Java程序来将数据加载到HDFS 中。

加载完成后,我们就可以使用Hadoop提供的MapReduce框架来进行数据分析了。

在运行MapReduce任务之前,我们需要编写一个驱动程序来配置和提交任务。

在驱动程序中,我们需要指定Map和Reduce函数的类名、输入数据的路径、输出数据的路径等信息。

《大数据技术原理与操作应用》第4章习题答案

第4章课后习题答案一、单选题1.在 MapReduce 程序中,map() 函数接收的数据格式是(A. 字符串B. 整型C. LongD. 键值对参考答案:D2.每个 Map 任务都有一个内存缓冲区,默认大小是( ) 。

A. 128 MBB. 64 MBC. 100 MBD. 32 MB参考答案:C3.在 MapTask 的 Combine 阶段,当处理完所有数据时,MapTask 会对所有的临时文件进行一次() 。

A. 分片操作B. 合并操作C. 格式化操作D. 溢写操作参考答案:B4.下列选项中,主要用于决定整个 MapReduce 程序性能高低的阶段是( ) 。

A. MapTaskB. ReduceTaskC. 分片、格式化数据源D. Shuffle参考答案:D二、判断题1. MapReduce 编程模型借鉴了面向过程的编程语言的设计思想。

( )参考答案:错2.在MapReduce 程序进行格式化数据源操作时, 是将划分好的分片格式化为键值对“ < key,value > ” 形式的数据。

( )参考答案:对3.带有倒排索引的文件称为“倒排索引文件”,简称“ 倒排文件” 。

( )参考答案:对4.reduce() 函数会将 map( ) 函数输出的键值对作为输入,将相同 key 值的 value 进行汇总,输出新的键值对。

( )参考答案:对5.MapReduce 通过 TextOutputFormat 组件输出到结果文件中。

( )参考答案:对biner 组件可以让 Map 对 key 进行分区,从而可以根据不同的 key 分发到不同的Reduce 中去处理。

( )参考答案:错7.对于 MapReduce 任务来说,一定需要 Reduce 过程。

( )参考答案:错8.在 MapReduce 程序中,只有 Map 阶段涉及 Shuffle 机制。

( )参考答案:错9.MapReduce 的数据流模型可能只有 Map 过程,由 Map 产生的数据直接被写入 HDFS中。

大数据技术原理与应用课程实验报告一

大数据技术原理与应用课程实验报告一随着科技的不断发展,“大数据技术原理与应用”课程在许多学校中受到了广泛的重视,并开设了相应的专业课程。

本文将简要介绍“大数据技术原理与应用”课程的实验内容、分析方法、实验要求,以及实验结果的讨论。

一、实验内容本次实验的主要内容是,用Hadoop环境来进行海量数据分析处理,结合大数据技术原理开展相应实验。

1.建Hadoop环境首先,我们要搭建一个Hadoop环境,并使用Hadoop平台上的HDFS文件系统来组织和管理大规模数据。

2.立数据仓库接下来,我们需要在HDFS文件系统中建立一个统一的数据仓库,便于我们进行有效的数据处理分析。

3.计MapReduce程序最后,应根据实验要求,设计MapReduce程序,用来处理海量数据,并提取出所需的有效信息。

二、分析方法本次实验主要采用MapReduce程序来进行分析处理,我们要对海量数据进行分组,然后分别进行分析处理,提取有用的数据,最后形成相应结果。

三、实验要求本次实验要求根据所给数据,设计一个MapReduce程序,对海量数据进行有效的分组处理,并从中提取出有用的结果。

四、实验结果在本次实验中,我们首先搭建Hadoop环境和HDFS文件系统,然后建立相应的数据仓库,再根据实验要求设计并实现MapReduce程序,用来处理海量数据,最后获得了有效的实验结果。

通过实验,我们可以了解到用Hadoop环境来进行海量数据处理,是一种有效的方式。

五、结论本文介绍了“大数据技术原理与应用”课程的实验内容、分析方法、实验要求,以及实验结果的讨论。

搭建Hadoop环境,利用MapReduce程序进行大规模数据的分析处理,是一种有效的大数据处理方法。

hadoop大数据技术原理与应用

hadoop大数据技术原理与应用

Hadoop是由Apache基金会在2006年提出的分布式处理系统。

它由一系列技术和系统所组成,包括Hadoop集群、Hadoop Distributed File System (HDFS)、MapReduce任务和JobTracker以及基于Apache HBase的非关系型数据库技术。

Hadoop集群是一群Hadoop包所组成的虚拟机,每个机器都具有它所需要和管理Hadoop系统所需要的功能。

HDFS是Hadoop的核心,它可以将数据存储在集群中的不同服务器上。

MapReduce是一种编程模型,可以用来在分布式集群上大规模的运行任务,开发和优化并行应用的表示方法。

JobTracker是Hadoop集群的集群管理器,负责管理任务。

HBase是基于Apache的非关系型数据库技术,可以支持大量的结构化数据以及查询和操纵它们。

Hadoop技术可以将海量数据存储在分布式系统中,然后再快速有效地处理这些数据。

它可以执行更复杂的计算,不受台式机和服务器硬件限制,同时可靠。

它也可以节省机器资源和购置费用,因为可以用更少的服务器来支撑更多的工作负载。

由于Hadoop的易用性,它被许多行业所采用,用来处理和分析数据,也可以

用来进行大规模的科学和工程类的计算。

它也可以在搜索引擎以及商业数据挖掘方面得到应用。

hdfs的文件操作命令以及mapreduce程序设计

hdfs的文件操作命令以及mapreduce程序设计Hadoop分布式文件系统(HDFS)是Hadoop框架的一部分,用于存储和处理大规模数据集。

以下是HDFS的一些常见文件操作命令:1. 查看文件和目录:- `hadoop fs -ls <path>`:列出指定路径下的文件和目录。

- `hadoop fs -du <path>`:查看指定路径下的文件和目录的大小。

2. 创建和删除目录:- `hadoop fs -mkdir <path>`:创建一个新目录。

- `hadoop fs -rmr <path>`:递归删除指定路径下的所有文件和目录。

3. 文件复制和移动:- `hadoop fs -cp <src> <dest>`:将源路径中的文件复制到目标路径。

- `hadoop fs -mv <src> <dest>`:将源路径中的文件移动到目标路径。

4. 文件上传和下载:- `hadoop fs -put <localSrc> <dest>`:将本地文件上传到HDFS中的指定路径。

- `hadoop fs -get <src> <localDest>`:将HDFS中的文件下载到本地目录。

5. 查看文件内容:- `hadoop fs -cat <path>`:显示指定路径下文件的内容。

- `hadoop fs -tail <path>`:显示指定文件的最后几行内容。

上述命令可以在命令行中使用。

此外,Hadoop还提供了Java 编程接口(API)和命令行工具(如`hadoop jar`)来编写和运行MapReduce程序。

以下是使用Java编写的简单MapReduce程序的示例:```javaimport org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.Mapper;import org.apache.hadoop.mapreduce.Reducer;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import java.io.IOException;public class WordCount {public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {private final IntWritable one = new IntWritable(1);private Text word = new Text();public void map(Object key, Text value, Context context) throws IOException, InterruptedException {String[] words = value.toString().split(" ");for (String w : words) {word.set(w);context.write(word, one);}}}public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {private IntWritable result = new IntWritable();public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}public static void main(String[] args) throws Exception {Job job = Job.getInstance();job.setJarByClass(WordCount.class);job.setMapperClass(TokenizerMapper.class);job.setCombinerClass(IntSumReducer.class);job.setReducerClass(IntSumReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}}```该示例是一个简单的词频统计程序。

Hadoop大数据处理技术与应用实践

Hadoop大数据处理技术与应用实践第一章简介Hadoop是一个由Apache开源组织开发的Java基础软件框架,用于可靠地存储和处理大规模数据集。

它可以处理来自不同来源的数据,这些数据可以是结构化或非结构化的形式。

Hadoop框架中核心的两个组件是Hadoop分布式文件系统(HDFS)和Hadoop MapReduce。

第二章 HDFSHDFS是一个分布式文件系统,它可以在多个物理机上存储文件。

在HDFS中,数据被分成块并在多台机器上复制以提高可靠性。

块的大小可以根据需要进行调整。

HDFS还提供了透明的数据访问和处理。

第三章 MapReduceHadoop MapReduce是一种计算模型,它可以将大规模数据集分解成小规模数据集。

每个小数据集可以在单独的计算节点上处理,并且可以在输出结果之前进行合并和整合。

MapReduce的目的是使数据处理并行化和可扩展化。

第四章 Hadoop应用实践Hadoop可以应用于许多不同的领域,例如:1.大数据分析:Hadoop可以对大数据集进行统计分析和数据挖掘,以提取有用的信息。

2.日志分析:Hadoop可以从大量日志文件中提取信息,以便分析应用程序的性能和排错。

3.推荐系统:Hadoop可以通过处理大量用户交互数据来构建个性化推荐系统。

4.大规模图像处理:Hadoop可以处理大型图像数据集,生成缩略图和其他有用的图像处理操作。

5.物联网:Hadoop可以处理来自传感器和其他IOT设备的数据,并提供实时反馈和控制。

第五章 Hadoop的未来Hadoop已经成为大数据处理和分析的事实标准,但是它也面临一些挑战。

随着数据集的增长,Hadoop的可扩展性成为关键问题。

虽然Hadoop可以横向扩展到成千上万台服务器,但它需要大量的管理和维护。

另外,Hadoop的安全性也需要进一步加强。

为了应对这些挑战,Hadoop社区已经开始研究一些新的技术,例如Apache Ignite、Apache Flink和Apache Spark。

hdfs和mapreduce综合实训hdfs文件读写

Hadoop分布式文件系统(HDFS)和MapReduce是Hadoop的核心组件,用于大规模数据的存储和处理。

以下是一个简单的HDFS和MapReduce的实训例子,涉及到HDFS文件的读写操作。

实训目标:1.了解HDFS的基本操作,如创建目录、上传文件、下载文件等。

2.了解MapReduce的基本概念和工作原理。

3.使用MapReduce对HDFS中的数据进行处理。

实训步骤:一、准备环境1.安装Hadoop,配置好环境变量。

2.启动Hadoop集群,包括NameNode、DataNode等。

二、HDFS操作打开终端,使用hdfs dfs -mkdir命令创建目录。

例如:shellhdfs dfs -mkdir /user/hadoop/data上传本地文件到HDFS目录中,使用hdfs dfs -put命令。

例如:shellhdfs dfs -put localfile.txt /user/hadoop/data/从HDFS下载文件到本地,使用hdfs dfs -get命令。

例如:shellhdfs dfs -get /user/hadoop/data/localfile.txt localfile_downloaded.txt列出HDFS目录中的文件,使用hdfs dfs -ls命令。

例如:shellhdfs dfs -ls /user/hadoop/data/删除HDFS中的文件或目录,使用hdfs dfs -rm命令。

例如:shellhdfs dfs -rm /user/hadoop/data/localfile.txt三、MapReduce操作1.编写MapReduce程序,可以使用Java或其他支持的语言。

以下是一个简单的MapReduce程序的示例:Mapper类:将输入的文本行分割成单词,并输出每个单词和其出现次数。

Reducer类:将相同单词的计数进行累加。

2. 将Mapper和Reducer类编译打包成JAR文件。

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案第一章:Hadoop概述1.1 Hadoop简介了解Hadoop的发展历程理解Hadoop的核心价值观:可靠性、可扩展性、容错性1.2 Hadoop生态系统掌握Hadoop的主要组件:HDFS、MapReduce、YARN理解Hadoop生态系统中的其他重要组件:HBase、Hive、Pig等1.3 Hadoop安装与配置掌握Hadoop单机模式安装与配置掌握Hadoop伪分布式模式安装与配置第二章:HDFS文件系统2.1 HDFS简介理解HDFS的设计理念:大数据存储、高可靠、高吞吐掌握HDFS的基本架构:NameNode、DataNode2.2 HDFS操作命令掌握HDFS的基本操作命令:mkdir、put、get、dfsadmin等2.3 HDFS客户端编程掌握HDFS客户端API:Configuration、FileSystem、Path等第三章:MapReduce编程模型3.1 MapReduce简介理解MapReduce的设计理念:将大数据处理分解为简单的任务进行分布式计算掌握MapReduce的基本概念:Map、Shuffle、Reduce3.2 MapReduce编程步骤掌握MapReduce编程的四大步骤:编写Map函数、编写Reduce函数、设置输入输出格式、设置其他参数3.3 典型MapReduce应用掌握WordCount案例的编写与运行掌握其他典型MapReduce应用:排序、求和、最大值等第四章:YARN资源管理器4.1 YARN简介理解YARN的设计理念:高效、灵活、可扩展的资源管理掌握YARN的基本概念:ResourceManager、NodeManager、ApplicationMaster等4.2 YARN运行流程掌握YARN的运行流程:ApplicationMaster申请资源、ResourceManager 分配资源、NodeManager执行任务4.3 YARN案例实战掌握使用YARN运行WordCount案例掌握YARN调优参数设置第五章:Hadoop生态系统扩展5.1 HBase数据库理解HBase的设计理念:分布式、可扩展、高可靠的大数据存储掌握HBase的基本概念:表结构、Region、Zookeeper等5.2 Hive数据仓库理解Hive的设计理念:将SQL查询转换为MapReduce任务进行分布式计算掌握Hive的基本操作:建表、查询、数据导入导出等5.3 Pig脚本语言理解Pig的设计理念:简化MapReduce编程的复杂度掌握Pig的基本语法:LOAD、FOREACH、STORE等第六章:Hadoop生态系统工具6.1 Hadoop命令行工具掌握Hadoop命令行工具的使用:hdfs dfs, yarn命令等理解命令行工具在Hadoop生态系统中的作用6.2 Hadoop Web界面熟悉Hadoop各个组件的Web界面:NameNode, JobTracker, ResourceManager等理解Web界面在Hadoop生态系统中的作用6.3 Hadoop生态系统其他工具掌握Hadoop生态系统中的其他工具:Azkaban, Sqoop, Flume等理解这些工具在Hadoop生态系统中的作用第七章:MapReduce高级编程7.1 二次排序理解二次排序的概念和应用场景掌握MapReduce实现二次排序的编程方法7.2 数据去重理解数据去重的重要性掌握MapReduce实现数据去重的编程方法7.3 自定义分区理解自定义分区的概念和应用场景掌握MapReduce实现自定义分区的编程方法第八章:Hadoop性能优化8.1 Hadoop性能调优概述理解Hadoop性能调优的重要性掌握Hadoop性能调优的基本方法8.2 HDFS性能优化掌握HDFS性能优化的方法:数据块大小,副本系数等8.3 MapReduce性能优化掌握MapReduce性能优化的方法:JVM设置,Shuffle优化等第九章:Hadoop实战案例9.1 数据分析案例掌握使用Hadoop进行数据分析的实战案例理解案例中涉及的技术和解决问题的方法9.2 数据处理案例掌握使用Hadoop进行数据处理的实战案例理解案例中涉及的技术和解决问题的方法9.3 数据挖掘案例掌握使用Hadoop进行数据挖掘的实战案例理解案例中涉及的技术和解决问题的方法第十章:Hadoop项目实战10.1 Hadoop项目实战概述理解Hadoop项目实战的意义掌握Hadoop项目实战的基本流程10.2 Hadoop项目实战案例掌握一个完整的Hadoop项目实战案例理解案例中涉及的技术和解决问题的方法展望Hadoop在未来的发展和应用前景重点和难点解析重点环节1:Hadoop的设计理念和核心价值观需要重点关注Hadoop的设计理念和核心价值观,因为这是理解Hadoop生态系统的基础。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

《Hadoop大数据技术与应用》

实验报告

实验2:HDFS常用方法和

MapReduce程序

一、实验目的

1. 理解HDFS在Hadoop体系结构中的角色;

2. 熟练使用HDFS操作常用的Shell命令;

二、实验环境

Linux操作系统、hadoop3.2.0、JDK1.8

三、实验内容与实验过程及分析(写出详细的实验步骤,并分析实验结果)

实验内容:

一、1、熟悉命令,执行并查看结果。

(1) 列出HDFS下的文件

hadoop fs -ls

(2) 列出HDFS文件下名为document的文件夹中的文件

Hadoop fs -ls document

(3) 上传文件

将hadoop目录下的file1文件上传到HDFS上并重命名为file2:

hadoop fs -put file1 file2

(4)下载文件

将HDFS中的file2文件复制到本地系统并命名为file1:

hadoop fs -get file2 file1

(5) 查看文件

查看HDFS下file1文件中的内容:

hadoop fs -cat file1

(6) 删除文档

删除HDFS下名为file1的文件(参数r为递归删除)

hadoop fs -rmr file1

(7) 在HDFS的/user/hadoop的路径下建立新目录,名为catalog hadoop fs -mkdir /user/hadoop/catalog

只能一级一级的建目录。

(8) 本地文件复制到HDFS(注意与put的区别)

hadoop fs -copyFromLocal src dst

(9)本地文件移动到HDFS

hadoop fs -moveFromLocal src dst

(10)文件或文件夹复制

hadoop fs -cp src dst

(11)文件或文件夹的移动

hadoop fs -mv src dst

(12)copyToLocal 复制文件到本地

hadoop fs -copyToLocal src dst

(13)moveToLocal 移动文件到本地

hadoop fs -moveToLocal src dst

(14) touchz 创建一个空文件file

Hadoop fs -touchz file

(15)追加到文件末尾的指令

hadoop fs -appendToFile local.txt text.txt

2、命令的综合运用

创建一个文件file1,查看file1是否创建成功,写内容。

在HDFS上创建一个文件夹folder1,把file1上传到folder1中。

查看是否上传成功,成功后查看file1的内容。

把file1下载到本地,查看file1的内容。

把folder1删除,并查看是否删除成功。

最后把本地的file1删除。

二、熟悉Hadoop执行MapReduce程序

计算圆周率示例

1、找到hadoop安装路径下的/share/hadoop/mapreduce/hadoop-mapreduce-examples-{version}.jar

2、在终端中输入

3、$hadoop jar {hadoop-install-dir}/share/hadoop/mapreduce/hadoop-mapreduce-examples-{version}.jar pi 10 10

四、实验总结(每项不少于20字)

存在问题:对MapReduce进行计算时容易出现错误,修改起来很难找到。

解决方法:先自己查找错误,自己能力无法达到时抓紧找同学询问,多进行尝试,网络搜索解决方案。

收获:了解了Hadoop的一些对本地文件及DataNode上的数据的基本操作,对代码操作更加熟练了一步,也对Hadoop了解更深入一些。

五、教师批语。