玩转“Log Parser”,轻松搞定网站日志安全分析

日志分析工具LogParser介绍

⽇志分析⼯具LogParser介绍摘要: 微软动态CRM专家罗勇,回复321或者20190322可⽅便获取本⽂,同时可以在第⼀间得到我发布的最新博⽂信息,follow me!下载完毕安装后,打开安装⽬录 C:\Program Files (x86)\Log Parser 2.2 ,将其中的⽂件 LogParser.exe 复制到 C:\Windows\System32 ⽂件夹中,这样在cmd或者PowerShell中就可以直接使⽤命令分析⽇志了,也可以⽅便的查看帮助。

打开界⾯输⼊ logparser 结果如下:如果IIS 没有启动Log功能(默认安装情况下不启⽤),建议先启⽤。

在服务器上输⼊ INETMGR 打开 Internet Infomation Services (IIS) Manager ,打开IIS上的LoggingIIS⽇志默认情况下是没有记录Bytes Sent和Bytes Received两个字段的,建议勾选。

从Directory: 就知道IIS⽇志存放的路径。

如果访问量很⼤,IIS Log⽂件会很⼤,打开⿇烦,可以考虑每个⽇志⽂件达到多⼤的时候⽣成⼀个新⽂件来记录IIS ⽇志。

将 IIS Log拿到后就可以⽤Log Parser对它进⾏分析了,我这⾥查看⼀个⽂件所有记录,以另外⼀种格式来看看。

⾸先截图原⽂是啥样的,不是很好阅读。

我是⽤下⾯语句来以另外⼀种格式化⼀下以另外⼀种形式展⽰:logparser "select * from D:\u_ex190322.log" -o:datagrid展⽰的样⼦如下:默认只展⽰10⾏,可以点击下⾯的【All rows 】按钮。

列太多,我选⼀些列来看看。

logparser "select date,time,c-ip,cs-method,cs-uri-stem,cs-uri-query,sc-status,sc-bytes,cs-bytes,time-taken from D:\u_ex190322.log" -o:datagrid效果如下图:我这⾥简单对⼏个列的含义做个说明(为本⼈理解,不对正确性做保证):当然也可以做⼀些统计,⽐如统计耗时超过10s 的请求数量:logparser "select count(*) from D:\u_ex190322.log where time-taken >=10000"当然还可以导出部分请求,⽰例如下:logparser "select date,time,c-ip,cs-method,cs-uri-stem,cs-uri-query,sc-status,sc-bytes,cs-bytes,time-taken from D:\u_ex190322.log where time-taken >=10000" -o:datagrid 在打开的新窗⼝中是可以显⽰所有符合条件记录(使⽤【All rows 】按钮),然后⽤ Ctrl + A 全选,Ctrl + C 复制,可以直接粘贴到Excel 中。

log parser lizard sql 语法

一、log parser lizard 介绍log parser lizard 是一款功能强大的日志解析工具,它支持多种日志格式和语法,能够帮助用户快速、准确地分析和提取日志数据。

在各种应用场景下,log parser lizard 都能发挥其优势,帮助用户提高工作效率,提供更好的数据分析和报告。

二、log parser lizard 的优势1. 多种日志格式支持:log parser lizard 支持多种常见的日志格式,包括但不限于文本日志、CSV、XML、JSON 等,用户可以根据实际需要选择合适的日志格式进行解析和分析。

2. 强大的 SQL 语法支持:log parser lizard 内置了强大的 SQL 语法解析引擎,用户可以使用 SQL 查询语句对日志数据进行灵活、高效的筛选和分析,大大提高了数据分析的效率和准确性。

3. 数据可视化展示:log parser lizard 可以将解析后的日志数据以图表、表格等形式进行可视化展示,帮助用户更直观地理解数据中的规律和趋势,为数据分析和报告提供了强有力的支持。

三、log parser lizard 的使用方法1. 下载和安装:用户可以从 log parser lizard 的冠方全球信息站或其他可靠渠道下载安装包,并按照安装向导进行安装。

2. 导入日志文件:用户可以在 log parser lizard 中导入需要解析的日志文件,根据实际情况选择合适的日志格式。

3. 编写 SQL 查询语句:用户可以在 log parser lizard 中使用 SQL 查询语句,对导入的日志数据进行灵活的筛选和分析,以获取所需的数据结果。

4. 数据可视化展示:用户可以将查询结果以图表、表格等形式进行可视化展示,直观地展现数据的分布和趋势,便于进一步分析和报告。

四、log parser lizard 的应用场景1. 系统日志分析:log parser lizard 可以帮助用户对系统产生的大量日志进行有效的筛选和分析,快速定位系统问题并进行故障排查。

Python在网络安全中的网络日志分析与异常检测

Python在网络安全中的网络日志分析与异常检测随着互联网的普及和发展,网络安全问题日益严重,攻击者利用各种漏洞和技术手段威胁着网络的安全。

网络日志分析与异常检测是一项重要的网络安全工作,它可以帮助我们快速识别和响应潜在的安全问题。

Python作为一种功能强大且易于使用的编程语言,被广泛应用于网络安全领域。

本文将介绍Python在网络日志分析与异常检测中的应用。

一、网络日志分析网络日志是记录网络设备和系统操作的重要信息,通过分析这些日志,可以发现网络攻击或异常行为。

Python提供了许多库和工具,可以帮助我们对网络日志进行有效的分析。

1. 数据收集在进行网络日志分析之前,我们首先需要收集网络设备和系统的日志数据。

Python中的socket库可以用于网络通信,我们可以编写程序定期从网络设备上获取日志数据,然后保存到本地文件中。

此外,还可以结合第三方工具,如Splunk和Elasticsearch,进行日志的集中管理和存储。

2. 数据清洗日志数据通常包含大量的冗余信息和无效字段,对于有效的日志分析来说,我们需要对数据进行清洗和预处理。

Python中的正则表达式库re可以帮助我们快速定位和提取需要的信息,比如IP地址、时间戳等。

同时,还可以利用Python的字符串处理函数对日志数据进行格式化和调整,使其符合我们的需求。

3. 数据分析清洗后的日志数据可以进行进一步的分析。

Python中的pandas库是一个非常强大的数据分析工具,它提供了丰富的数据结构和函数,可以方便地进行数据处理和统计。

我们可以使用pandas对日志数据进行聚合、过滤、排序等操作,以便更好地发现异常行为。

此外,还可以通过可视化库matplotlib和seaborn绘制图表,直观地展示分析结果。

二、异常检测网络日志分析的目标是发现异常行为,即与正常行为相比具有明显差异的活动。

Python提供了多种方法和技术,可以用于异常检测。

1. 统计分析统计分析是一种常用的异常检测方法,它基于数据的统计特性,通过计算和比较来判断是否存在异常。

apache log viewer使用方法-概述说明以及解释

apache log viewer使用方法-概述说明以及解释1.引言1.1 概述概述部分的内容:在现代世界中,计算机技术和互联网的迅猛发展使得网络日志(log)变得日益重要。

Apache是一个流行的开源Web服务器软件,其日志文件记录了访问服务器的详细信息,包括访问者的IP地址、访问时间、浏览器类型等等。

然而,阅读和分析这些日志文件是一项繁琐而耗时的任务。

为了帮助网络管理员和开发人员更好地理解和利用这些日志文件,出现了许多日志文件查看器工具,其中最为知名和实用的就是Apache Log Viewer。

Apache Log Viewer是一款简单易用且功能强大的工具,旨在帮助用户分析和解释Apache日志文件中的信息。

它提供了直观、交互式的界面,可以快速筛选和搜索日志文件的内容,并以可视化方式展示统计数据和图表。

使用Apache Log Viewer,用户可以轻松地监控网站访问情况、检测异常活动、识别潜在的安全威胁等。

本文将介绍如何使用Apache Log Viewer这个强大工具来分析和解读Apache日志文件。

接下来的章节将逐步介绍Apache Log Viewer的安装配置方法以及其主要功能和使用技巧。

通过本文的学习,读者将能够迅速上手并熟练使用Apache Log Viewer,从而提升对Apache日志的分析能力和效率。

继续阅读下一章节:2.正文- 2.1 Apache Log Viewer的介绍。

1.2文章结构文章结构是指文本的组织方式和内容安排。

在撰写一篇长文时,良好的文章结构可以帮助读者更好地理解和消化文章的内容。

文章结构应该合理有序,清晰明确,使读者能够迅速地找到所需的信息。

下面是关于Apache Log Viewer使用方法的文章结构部分的内容:1.2 文章结构文章将按照以下步骤和章节展开,以帮助读者全面了解Apache Log Viewer的使用方法:1.2.1 第一部分:Apache Log Viewer的概述本部分将对Apache Log Viewer进行简要介绍,包括其定义、功能和用途。

网络安全中入侵日志分析的使用方法

网络安全中入侵日志分析的使用方法随着科技的发展,网络安全问题日益严重。

为了保护网络的安全,企业和组织需要采取各种方法来预防和应对网络入侵。

其中一种重要的方法是利用入侵日志分析工具。

本文将介绍入侵日志分析的使用方法,包括入侵日志的收集、分析和应用。

入侵日志是指记录网络中的各种连接、事件和异常的日志文件。

它可以包含许多有用的信息,如网络连接的源和目标地址、访问的时间和日期、登录信息等。

通过分析入侵日志,网络管理员可以识别出潜在的网络威胁和攻击,及时采取相应的措施。

首先,收集入侵日志是入侵日志分析的第一步。

现代网络中的服务器和安全设备通常会自动记录入侵事件并生成日志文件。

管理员可以通过设置相关的日志配置来确保入侵日志的生成,并设置合适的日志保留期限,以便对日志进行后续分析。

此外,还可以利用一些第三方安全设备和软件来主动收集入侵事件的日志信息,以获取更全面和准确的数据。

其次,入侵日志的分析是实现网络安全的重要环节。

在进行入侵日志分析之前,管理员需要根据网络的特点和安全需求,制定相应的分析策略和规则。

分析日志时需要重点关注异常事件和潜在的网络入侵行为,如多次失败的登录尝试、恶意代码的传播等。

管理员还可以利用统计和数据分析的方法,识别和预测网络风险,并通过建立相关的报表和告警机制来实时监视网络安全。

入侵日志的分析可以采用多种方法和工具。

其中一种常用的方法是使用日志管理系统,如Splunk、ELK等,来集中管理和分析入侵日志。

这些系统提供了强大的搜索和查询功能,便于管理员根据需要检索和分析特定的日志数据。

此外,还可以使用各种网络入侵检测系统(IDS)和入侵防御系统(IPS)来实时监测和分析网络流量,并根据入侵日志生成相应的警报和报告。

最后,入侵日志的分析结果需要应用到实际的安全措施中。

通过对入侵日志的分析,管理员可以发现网络的漏洞和弱点,并及时采取措施加以修复和防止。

例如,禁止特定IP地址的访问、封锁恶意代码的传播路径等。

日志易parse语法

日志易parse语法日志易parse语法:如何轻松解析日志文件在软件开发和系统管理中,日志文件是非常重要的。

它们记录了系统的运行状态、错误和警告信息,以及用户的操作记录。

但是,日志文件往往非常庞大,难以直接阅读和理解。

因此,我们需要一种工具来解析日志文件,以便更好地理解和分析它们。

日志易parse 语法就是这样一种工具。

日志易parse语法是一种简单而强大的语法,用于解析日志文件。

它基于正则表达式,可以轻松地匹配和提取日志文件中的关键信息。

下面是一些常用的日志易parse语法:1. 字符串匹配字符串匹配是日志易parse语法中最基本的功能。

它可以用来匹配日志文件中的特定字符串,例如错误消息、警告消息等。

例如,以下语法可以匹配所有包含“error”的行:```match "error"```2. 正则表达式匹配正则表达式匹配是日志易parse语法中最强大的功能。

它可以用来匹配复杂的模式,例如IP地址、URL等。

例如,以下语法可以匹配所有包含IP地址的行:```match /(\d{1,3}\.){3}\d{1,3}/```3. 提取字段提取字段是日志易parse语法中非常有用的功能。

它可以用来提取日志文件中的特定字段,例如时间戳、请求URL等。

例如,以下语法可以提取所有包含时间戳的行,并将时间戳保存到名为“timestamp”的字段中:```match /(\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2})/set timestamp $1```4. 过滤行过滤行是日志易parse语法中非常实用的功能。

它可以用来过滤掉不需要的行,例如调试信息、无用的警告等。

例如,以下语法可以过滤掉所有包含“debug”的行:```filter "debug"```5. 统计信息统计信息是日志易parse语法中非常有用的功能。

它可以用来统计日志文件中的特定信息,例如错误数量、请求次数等。

使用LogParser分析日志

使⽤LogParser分析⽇志系统运维,少不了分析系统⽇志,微软有个⼯具Log Parser可以帮助你分析⽇志。

它功能强⼤,使⽤简单,可以分析基于⽂本的⽇志⽂件、XML ⽂件、CSV(逗号分隔符)⽂件,以及操作系统的事件⽇志、注册表、⽂件系统、Active Directory。

它可以像使⽤ SQL 语句⼀样查询分析这些数据,甚⾄可以把分析结果以各种图表的形式展现出来。

Log Parser可以到微软的⽹站,安装完后,就会有命令⾏的执⾏程序LogParser.exe,供API使⽤的LogParser.dll及说明⽂件LogParser.chm,⾥⾯还会有⼀些Sample Code可以供参考.Log Parser⽀持的格式很多,输⼊格式如下:输出格式如下:通过 .NET Framework 的 COM interop(COM 交互操作)特性,可以很⽅便地在 .NET 应⽤程序中使⽤ Log Parser,.NET Framework 的 COM interop是通过 Runtime Callable Wrappers (RCW) 来实现对 COM 的操作的,RCW 是 .NET 中的⼀个类。

现在要玩的是,怎么⽤LogParser.dll来开发更适合的API,其实命令⾏的做法就可以满⾜⼤部份的需求,但有时有时特殊的判断,在命令⾏模式下就有难度了,⽐如说,我们需要⽤程序⾃动去处理⼤批量的⽇志⽂件分析等,所以这时⽤API就⽅便很多.下⾯我们⽤.NET封装下LogParser的Com接⼝,从LogParser的操作流程来看,⽆⾮就是不同格式⽂件的⽇志⽂件的输⼊,通过类SQL的分析输出我们需要的结果,核⼼算法就是类似于// 初始化LogQuery 对象var logQuery = new LogQueryClass();// 缓存输⼊上下⽂if (myInputContext == null)myInputContext = GetInputContext();// 执⾏查询var oRecordSet = logQuery.Execute(query, myInputContext);// 浏览记录for (; !oRecordSet.atEnd(); oRecordSet.moveNext()){// 获取当前的记录ILogRecord logRecord = oRecordSet.getRecord();}oRecordSet.close();使⽤OOP⽅式封装接⼝,⼤家很容易的就会得出类似下⾯的设计,类图如下:每⼀种类型的⽇志的分析主要是格式的不同,通过⼀个配置类去记录每种类型的不同配置,根据配置去⽣成相应的输⼊、输出格式类。

Python网络安全日志分析与监控实时掌握系统状态

Python网络安全日志分析与监控实时掌握系统状态Python作为一种高级编程语言,具有强大的数据处理和分析能力,被广泛应用于网络安全领域。

本文将介绍如何使用Python实现网络安全日志的分析与监控,以实时掌握系统状态。

1. 简介网络安全日志是记录网络活动的重要数据来源,通过对日志数据进行分析,可以发现潜在的安全威胁和异常行为。

Python提供了丰富的库和工具,可以帮助我们解析、处理和分析网络安全日志。

2. 日志收集首先,我们需要配置系统以收集网络安全日志。

可以使用工具如syslog-ng或rsyslog来收集各种日志数据,包括防火墙、入侵检测系统(IDS)和网络设备的日志。

收集到的日志数据可以存储在本地或者远程服务器上。

3. 日志解析Python提供了多种库用于解析不同格式的日志数据。

例如,对于常见的格式如CSV或JSON,可以使用csv或json库进行解析。

对于自定义格式的日志数据,可以使用正则表达式来提取关键信息。

4. 日志分析通过对日志数据进行分析,我们可以发现系统中的异常活动或潜在的安全威胁。

Python的数据分析库如Pandas和NumPy可以帮助我们对大规模的日志数据进行处理和分析。

我们可以使用统计方法、可视化工具和机器学习算法来识别异常行为和模式。

5. 实时监控为了实时掌握系统状态,我们可以使用Python编写脚本来监控网络安全日志的变化。

可以使用inotify或watchdog库来监测日志文件的新增和修改。

一旦检测到新的日志数据,脚本就可以触发相应的分析和报警机制。

6. 报警机制当系统出现异常行为或安全威胁时,我们需要及时发出警报以采取相应的措施。

Python通过邮件、短信、即时通讯等方式可以实现报警机制。

我们可以使用smtplib库发送邮件,使用twilio库发送短信,或者使用第三方API集成即时通讯工具。

7. 系统状态监控除了分析网络安全日志,Python还可以实现系统状态的监控。

windows安全日志分析工具logparser用法详解

windows安全⽇志分析⼯具logparser⽤法详解logparser使⽤介绍⾸先,让我们来看⼀下Logparser架构图,熟悉这张图,对于我们理解和使⽤Logparser是⼤有裨益的简⽽⾔之就是我们的输⼊源(多种格式的⽇志源)经过 SQL语句(有SQL引擎处理)处理后,可以输出我们想要的格式。

1、输⼊源从这⾥可以看出它的基本处理逻辑,⾸先是输⼊源是某⼀种固定的格式,⽐如EVT(事件),Registry(注册表)等,对于每⼀种输⼊源,它所涵盖的字段值是固定的,可以使⽤logparser –h –i:EVT查出(这⾥以EVT为例):这⾥是⼀些可选参数,在进⾏查询的时候,可对查询结果进⾏控制,不过我们需要重点关注的是某⼀类⽇志结构⾥含有的字段值(在SQL查询中匹配特定的段):对于每⼀类字段值的详细意义,我们可以参照logparser的⾃带⽂档的参考部分,这⾥以EVT(事件)为例:2、输出源输出可以是多种格式,⽐如⽂本(CSV等)或者写⼊数据库,形成图表,根据⾃⼰的需求,形成⾃定的⽂件(使⽤TPL)等,⽐较⾃由基本查询结构了解了输⼊和输出源,我们来看⼀则基本的查询结构Logparser.exe –i:EVT –o:DATAGRID “SELECT * FROM E:\logparser x.evtx”这是⼀则基本的查询,输⼊格式是EVT(事件),输出格式是DATAGRID(⽹格),然后是SQL语句,查询E:\logparser x.evtx的所有字段,结果呈现为⽹格的形式:看到这⾥,想必你已经明⽩了,对于windows的安全⽇志分析,我们只需要取出关键进⾏判断或者⽐对,就可以从庞⼤的windows安全⽇志中提取出我们想要的信息。

windows安全⽇志分析对于windows安全⽇志分析,我们可以根据⾃⼰的分析需要,取出⾃⼰关⼼的值,然后进⾏统计、匹配、⽐对,以此有效获取信息,这⾥通过windows安全⽇志的EVENT ID迅速取出我们关⼼的信息,不同的EVENT ID代表了不同的意义,这些我们可以在⽹上很容易查到,这⾥列举⼀些我们平常会⽤到的。

log maskpattern 用法

log maskpattern 是一种用于数据处理的工具,它可以帮助用户对日志文件进行处理和分析。

在这篇文章中,我们将介绍 log maskpattern 的用法和功能,以及如何在实际项目中应用它。

1. log maskpattern 的功能和作用log maskpattern 是一种用于数据脱敏的工具,它可以帮助用户隐藏敏感信息,保护用户的隐私。

通过使用 log maskpattern,用户可以对日志文件中的特定内容进行模糊处理,如通信、唯一识别信息号码、银行卡号等敏感信息。

这样可以确保在日志文件中不会泄露用户的敏感信息,提高数据的安全性。

2. log maskpattern 的使用方法在使用 log maskpattern 时,我们可以通过配置文件来指定需要脱敏的字段和相应的脱敏规则。

我们可以指定将通信的中间四位数字替换为*号,将唯一识别信息号码的前六位和后四位替换为*号,将银行卡号的前十位和后四位替换为*号等。

通过这样的配置,我们可以对不同类型的敏感信息进行不同的处理,提高数据的安全性。

3. log maskpattern 的实际应用log maskpattern 在实际项目中有着广泛的应用。

在互联网行业中,各种应用程序产生大量的日志文件,其中可能包含大量的用户信息和敏感信息。

通过使用 log maskpattern,我们可以对这些日志文件进行处理,确保不会泄露用户的敏感信息,保护用户的隐私。

除了在互联网行业中的应用,log maskpattern 也可以应用于金融、医疗、教育等领域。

在这些领域中,用户的信息安全和隐私保护尤为重要,使用 log maskpattern 可以帮助这些行业保护用户的隐私,遵守相关法律法规。

4. log maskpattern 的优势和局限log maskpattern 作为一种数据处理工具,有着许多优势。

它可以帮助用户快速、灵活地对日志文件进行处理,节约了人力和时间成本。

log parser的用法

log parser的用法Log Parser的用法Log Parser是一款实用性较强的日志分析工具,主要用于处理生成的各类日志文件,在Windows平台下有广泛的应用,可以通过LogParser查询、分析和格式化各种日志文件,包括IIS日志、事件日志、XML日志、CSV等格式的数据。

以下是Log Parser的用法:1.安装Log Parser首先需要在Windows系统中安装Log Parser,可以从微软官网下载最新版本的Log Parser。

安装完成后,可以使用命令行界面或者运行Log Parser Studio来使用它的核心功能。

2.查询日志文件Log Parser支持查询各种格式的日志文件,比如IIS日志文件。

例如,查询IIS的日志文件。

以下是基本语法:```sqlLogParser.exe -i:iisw3c "SELECT TOP 10 date, time, c-ip, cs-method, cs-uri-stem, sc-status FROM ex*.log"```3.处理日志文件Log Parser提供了丰富的日志文件处理功能,可以非常方便地进行各种操作,比如对日志文件进行排序、筛选、统计、分组等。

例如,统计访问IP地址最多的前10个IP地址:```sqlLogParser "SELECT TOP 10 COUNT(c-ip),c-ip AS Address FROMex*.log GROUP BY c-ip Order By COUNT(*) DESC" -i:iisw3c -o:datagrid```4.格式化日志文件Log Parser还可以将日志文件导出成CSV、XML、HTML等格式,方便进行操作和分析。

例如,将IIS的日志文件导出为CSV格式:```sqlLogParser "SELECT TO_LOCALTIME(TO_TIMESTAMP(date, time)), s-ip, cs-method, cs-uri-stem, sc-status INTOC:\Logs\results.csv FROM ex*.log" -i:IISW3C -o:CSV```总结通过Log Parser的功能,可以轻松处理各种格式的日志文件,理解现有的日志中所包含的信息,并进行有效地查询和分析,这对于运维人员和开发人员来说是一种非常实用的工具。

玩转“Log Parser”,轻松搞定网站日志安全分析

玩转“Log Parser”,轻松搞定网站日志安全分析玩转“Log Parser”,轻松搞定网站日志安全分析web日志分析是安全从业人员必须掌握的技能之一。

本文将介绍一款免费且强大的日志分析工具——Log Parser,它具备通用的日志分析能力,可以帮助我们分析windows系统日志,iis、apache、tomcat、nginx等web日志。

本文将重点介绍web方面的安全分析和系统日志分析。

一、介绍在生产环境中,系统每天产生的日志数量惊人。

一旦系统被入侵,能够追溯到攻击者的最好途径也只能是查看网站日志。

因此,web日志分析往往是件令人非常头疼的事情。

为了解决这一难题,我们可以使用Log Parser。

二、Log Parser的介绍Log Parser是XXX免费且强大的日志分析工具。

学会使用此工具,就能够实现对windows系统日志,iis、apache、tomcat、nginx等web日志进行分析。

我们只需要下载并安装Log Parser,然后将工具的路径加入系统环境变量中,就可以在任何地方调用此工具。

我们可以从以下链接下载Log Parser:/en-XXX?id=安装完成后,我们可以简单运行一下,Log Parser会输出帮助信息,如下图所示:图1三、使用Log Parser进行web日志分析使用Log Parser进行web日志分析非常简单。

我们只需要在命令行中输入相应的命令,就可以得到分析结果。

例如,我们可以使用以下命令来分析iis日志:LogParser.exe -i:IISW3C "SELECT * FROM ex*.log WHERE cs-uri-stem LIKE '%config%'"该命令将查询iis日志中所有包含“config”关键字的记录。

我们还可以使用Log Parser来分析其他类型的web日志,例如apache、tomcat、nginx等。

Logparser的用法

Logparser的⽤法Logparser是⼀款⾮常强⼤的⽇志分析软件,可以帮助你详细的分析⽹站⽇志。

是所有数据分析和⽹站优化⼈员都应该会的⼀个软件。

Logparser是微软的⼀款软件完全免费的,⼤家可以在微软的官⽹上去下载,下载地址:下载后安装也⾮常简单,只要按照步骤去安装就可以了,虽然软件语⾔是英语但是都是⽐较容易的。

使⽤⽅法:打开logparser出现的是这个类似命令⾏的窗⼝,我们就是在这个窗⼝输⼊各种命令对⽇志进⾏分析。

那我们怎么去运⾏呢?最基本的格式:LogParser –i:输⼊⽂件的格式 –o:输出格式 “SQL语句”我们输⼊⼀个最简单的例⼦,把⼀个IIS⽇志转化成⼀个csv格式的表格,那么我们应该怎么做呢?C:\Program Files\Log Parser 2.2> logparser -i:iisw3c -o:csv “SELECT *FROM C:rizhi.log” >D:rizhi.scv这就是完成了最简单的转换,把C盘中rizhi.log这个⽇志转换成csv格式并保存到D盘。

我们要注意的是-i:iisw3c,-i代表的是输⼊,iisw3c代表的是⽇志格式,例⼦中分析的是iis⽇志,因此标准格式的iisw3c。

-o:scv,-o 代表的是输出,csv是输出⽂件的格式。

”SELECT*FROM”这个是分析⽇志的SQL命令语句,我们可以⽤不同的SQL语句来分析⽇志。

注意:logparser是区分⼤⼩写的,因此SQL语句⼀定要⽤⼤写,不然会出错的。

明⽩了logparser怎么去⽤,那么接下来给⼤家介绍⼀些我们经常⽤到的操作命令。

--对⽇志中的url进⾏归并统计LogParser -o:csv "SELECT cs-uri-stem, COUNT(*) into a.csv FROM iis.log GROUP BY cs-uri-stem"--取出所有的asp页⾯SELECT COUNT(*) FROM ex040528.log WHERE EXTRACT_EXTENSION(cs-uri-stem) LIKE 'asp'--求出各个路径的访问次数SELECT cs-uri-stem, COUNT(*) FROM ex040528.log GROUP BY cs-uri-stem--求出各个资源类型的访问次数SELECT EXTRACT_EXTENSION(cs-uri-stem) AS PageType, COUNT(*)FROM ex040528.logGROUP BY PageType--group by两个东东SELECT EXTRACT_EXTENSION(cs-uri-stem) AS PageType, sc-status, COUNT(*)FROM ex040528.logGROUP BY PageType, sc-status--求出各个资源类型的访问次数,并按访问次数降序排列SELECT EXTRACT_EXTENSION(cs-uri-stem) AS PageType, COUNT(*) AS PageTypeHitsFROM ex040528.logGROUP BY PageTypeORDER BY PageTypeHits DESC--求出各个页⾯类型,各种返回结果占总点击数的⽐重SELECT EXTRACT_EXTENSION(cs-uri-stem) AS PageType, sc-status, MUL(PROPCOUNT(*), 100.0) AS HitsFROM ex040528.logGROUP BY PageType, sc-statusORDER BY PageType, sc-status--求出各个页⾯类型、各种返回结果的点击数占各种页⾯类型点击数的百分⽐SELECT EXTRACT_EXTENSION(cs-uri-stem) AS PageType, sc-status, MUL(PROPCOUNT(*) ON (PageType), 100.0) AS HitsFROM ex040528.logGROUP BY PageType, sc-statusORDER BY PageType, sc-status--求解各种类型的客户端环境占总环境数的百分⽐SELECT DISTINCT cs(User-Agent) as IEType,count(*) as total,mul(propcount(*),100) as [percent(%)]FROM F:/挑战赛资料/ex081213.loggroup by IEType转义字符:/注意:order by后只能有⼀个desc或者ascorder by的项必须要在select⼦句中having⼦句必须紧跟group⼦句--查出哪个IP访问最频繁SELECT c-ip, COUNT(*) as c FROM 'F:\iislog\u_extend7237.log' GROUP BY c-iporder by c desc--查出哪个页⾯哪个IP访问最频繁SELECT c-ip, COUNT(*) as c FROM 'F:\iislog\u_extend2.log'Where TO_LOWERCASE(cs-uri-stem) ='/msearch/result/'GROUP BY c-iporder by c desc--查出指定页⾯200状态最多的ip,SELECT c-ip, COUNT(*) as c FROM 'F:\iislog\u_extend2.log'Where TO_LOWERCASE(cs-uri-stem) ='/msearch/result/'and sc-status=200GROUP BY c-iporder by c desc--统计哪个ip,哪个页⾯被访问得最多SELECT c-ip,cs-uri-stem,COUNT(*) as c FROM 'F:\iislog\u_extend9681.log' GROUP BY c-ip,cs-uri-stem order by c desc--统计指定IP,访问各个页⾯次数SELECT cs-uri-stem, COUNT(*) as c FROM 'F:\iislog\u_extend9681.log'where c-ip='112.47.159.76'GROUP BY cs-uri-stemorder by c desc。

Jenkins解析日志(log-parser-plugin)

Jenkins解析⽇志(log-parser-plugin)Jenkins打包机打包时产⽣了⼤量的⽇志,当报错时,不⽅便查看error⽇志因为⽇志量太⼤,查看全部log的时候整个web页⾯会卡死,所以引⽤log-parser-plugin可以增加过滤条件显⽰⽇志第1步:安装插件log-parser-plugingitlab地址:第2步:增加log解析的配置⽂件参考wiki说明⽂档:log可以分块展⽰(error、warning、info),级别后⾯是匹配的关键字,根据正则匹配出要分到当前块的内容例如:error /[Ee]rror/表⽰匹配⾏中包含Error或error的⾏到error分块中分块可以有多个匹配规则(匹配规则最好⾃定义,因为是从⽇志⾥过滤定义的规则关键词,如果定的不准,⽐如代码正常会打印error,则都会匹配成错误信息)参考例⼦内容如下:ok /not really/# match line starting with 'error ', case-insensitiveerror /[Ee]rror/error /ERROR/# list of warnings here...warning /[Ww]arning/warning /WARNING/# create a quick access link to lines in the report containing 'INFO'info /INFO/# each line containing 'BUILD' represents the start of a section for grouping errors and warnings found after the line.# also creates a quick access link.start /BUILD/第3步:Jenkins配置⽇志解析规则⽂件勾选使⽤全局还是当前⼯程的规则⽂件,后⾯写对应master或⼯程服务器上的绝对路径即可Use global rule:全局规则⽂件User project rule:这个⼯程服务器上的规则⽂件Mark build Failed on Error:当有error时,构建结果变为失败,红⾊Show log parser graphs:在⼯程⾯板上会以图表形式显⽰失败的情况,感觉⽆什么⼤⽤效果如下:1、当前构建结果中,点击Parsed Console Output,可查看各个分块的结果(error、warning、info)2、每个分块下显⽰具体匹配的条数(例如例⼦中Error是1条,Warning是1条)3、点击对应分块下的报错,会定位到⽇志中对应的位置参考⽂档:。

logparser及常用使用方法总结

logparser及常⽤使⽤⽅法总结Log Parser()是微软公司出品的⽇志分析⼯具,它功能强⼤,使⽤简单,可以分析基于⽂本的⽇志⽂件、XML ⽂件、CSV(逗号分隔符)⽂件,以及操作系统的事件⽇志、注册表、⽂件系统、Active Directory。

它可以像使⽤ SQL 语句⼀样查询分析这些数据,甚⾄可以把分析结果以各种图表的形式展现出来。

Log Parser 的安装很简单,没有什么特别的,安装之后,可以在安装⽬录下找到 LogParser.chm 这个⽂件,该⽂件是 LogParser 的帮助⽂件,为英语语⾔。

我们简单介绍⼀下在命令提⽰符中如何使⽤ Log Parser。

LogParser.exe 为可执⾏⽂件,后跟⼀个使⽤ SQL 结构的语句参数进⾏查询。

C:\Program Files\Log Parser 2.2>LogParser "SELECT TOP 10 * FROM System ORDER BY RecordNumber DESC"从系统⽇志(可以从事件查看器中找到)中,选出按 RecordNumber 逆序的前 10 条记录。

RecordNumber 是 System 中的⼀个字段。

我们也可以⽣成图表:C:\Program Files\Log Parser 2.2>LogParser "SELECT EventID, Count(*) as 出现次数 INTO Chart.gif FROM System GROUP BY EventID" -chartType:PieExploded3D -groupSize:500x350 -chartTitle:"事件分类"上述代码中还加了其它参数来确定图表的类型、⼤⼩等,得到类似如下图表:是不是⾮常的简单,⽽且很振奋⼈⼼,不过这些都不是我们介绍的重点,我们的重点是如何利⽤ C# 去执⾏ Log Parser。

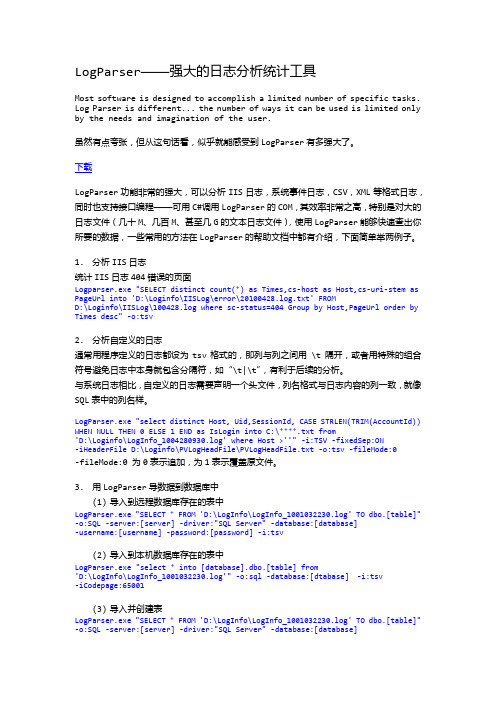

LogParser-强大的日志分析统计工具

下载

LogParser 功能非常的强大,可以分析 IIS 日志,系统事件日志,CSV,XML 等格式日志, 同时也支持接口编程——可用 C#调用 LogParser 的 COM,其效率非常之高,特别是对大的 日志文件(几十 M、几百 M、甚至几 G 的文本日志文件),使用 LogParser 能够快速查出你 所要的数据,一些常用的方法在 LogParser 的帮助文档中都有介绍,下面简单举两例子。

LogParser——强大的日志分析统计工具

Most software is designed to accomplish a limited number of specific tasks. Log Parser is different... the number of ways it can be used is limited only by the needs and imagination of the user.

-fileMode:0 为 0 表示追数据到数据库中

(1) 导入到远程数据库存在的表中

LogParser.exe "SELECT * FROM 'D:\LogInfo\LogInfo_1001032230.log' TO dbo.[table]" -o:SQL -server:[server] -driver:"SQL Server" -database:[database] -username:[username] -password:[password] -i:tsv

class LogParserUtil {

/// <summary> /// 计算失败率 /// </summary> public double GetFailureRate(string headerFile, string logPath) {

LogParser——快速发现重要的安全日志事件

LogParser——快速发现重要的安全日志事件RandyFranklinSmith;杨岩

【期刊名称】《Windows & Net Magazine:国际中文版》

【年(卷),期】2004(000)09M

【摘要】如果有一种工具可以像查询SQL一样读取和执行任何类型的日志。

那该多好!LogParser就可以让这个梦想变成现实。

你可以使用它来自动地处理网络每天产生的不同日志数据。

【总页数】7页(P48-54)

【作者】RandyFranklinSmith;杨岩

【作者单位】《Windows&.NETMagazine》资深编辑;不详

【正文语种】中文

【中图分类】TP316.86

【相关文献】

1.2013重要科技发现和热点事件预测 [J],

2.用环境磁学磁化率方法研究历史地震--抚仙湖地区重要历史地震事件的检验与发现 [J], 李杰森;宋学良;马成大;张子雄;李雁北

3.大庆油田的发现和大庆油田会战若干重要事件的回忆 [J], 张文昭

4.基于互联网的省级重要基础地理信息变化快速发现技术研究 [J], 张大骞; 刘善磊; 潘九宝; 王玮

5.监视重要的安全事件——在你的安全日志中查找有用的信息 [J], RandyFranklinSmith; 陈流浩

因版权原因,仅展示原文概要,查看原文内容请购买。

loguru 日志解析 -回复

loguru 日志解析-回复问题:什么是loguru日志解析?中括号内的内容:loguru 日志解析回答:Loguru是一个Python日志解析工具,它提供了简单且直观的接口,使日志处理变得更加简单和高效。

它是基于"garrota/loguru"项目开发的,旨在提供更强大和更易于使用的日志解析能力。

日志解析是在软件开发和系统管理领域中非常重要的一项任务。

通过解析日志文件,开发人员和系统管理员可以更好地了解系统的运行情况、故障和错误,从而更快地定位和解决问题。

在大规模的系统环境中,处理和分析庞大的日志文件可能会变得非常复杂和耗时。

因此,使用一个高效且易于使用的日志解析工具是至关重要的。

Loguru提供了丰富的功能和强大的性能,使开发人员和系统管理员能够更轻松地解析日志文件。

以下是使用Loguru进行日志解析的一些步骤:1. 安装Loguru:在Python环境中,可以通过pip来安装Loguru。

在命令行中运行以下命令即可安装Loguru:shellpip install loguru2. 导入Loguru模块:在Python代码中,我们需要导入Loguru模块以使用其功能。

可以使用以下代码来导入Loguru:pythonfrom loguru import logger3. 配置日志输出:使用Loguru,可以灵活地配置日志输出的格式、级别和目标。

以下是一个简单的配置示例,将日志输出到控制台和文件中,并将日志级别设置为DEBUG:pythonlogger.configure(handlers=[{"sink": sys.stdout, "level": "DEBUG"}, {"sink": "logs/file.log", "level": "DEBUG"}])4. 编写日志解析逻辑:根据需求和日志文件的格式,编写解析日志的逻辑代码。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335技术支持热线:400-888-6688 微博:@美亚柏科 网站:玩转“Log Parser ”,轻松搞定网站日志安全分析一、开篇2 厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科网站:二、介绍web日志分析往往是件令人非常头疼的事情,特别是一些生产环境中的系统,每天产生的日志数量惊人,一但系统被入侵,能够追溯到攻击者的最好途径也只能是查看网站日志了。

作为安全从业人员不得不面对的通过海量日志文件找到入侵者的难题,本期我们给大家分享一些应急响应中的web日志分析相关的经验工欲善其事必先利其器,下面引出我们本期的主角logparserLog Parser 是微软免费且强大的日志分析工具,具备通用的日志分析能力,学会使用此款工具,就能够实现对windows系统日志,iis、apache、tomcat、nginx等web日志进行分析,本期我们只关注web方面的安全分析、系统日志分析等,大家有兴趣可以自己研究下载地址https:///en-us/download/details.aspx?id=24659安装过程也特别简单,安装完成后我们可以将工具的路径加入系统环境变量中,这样方便我们在任何地方调用此工具3 厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科网站:4厦门市美亚柏科信息股份有限公司电话:(86-592)3929988传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:图1设置完成后,我们简单运行下,不出意外我们看到时logpaser 给我们输出的帮助信息图2logparser集成了微软自身的数据库引擎,我们可以直接把一个日志文件简单理解成一个表来进行我们的操作三、输入输出-i 定义输入的日志形式logparser所有支持的日志格式如下图3其中我们常见的web服务器默认产生的日志文件对应关系如下:iis产生的日志iisw3cnginx默认日志格式ncsaapache默认日志格式ncsa格式其中还有通用的文本格式处理为textline,在遇到一些自定义格式的日志时可以使用此格式,在通过自己分割成我们需要的格式常用的输出格式-o 定义输出的日志形式5 厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科网站:6厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:图4csv 即文本形式输出datagrid 为logparser 自带一款图形化界面显示输出 例:1:查看所有字段的iis 日志信息,并以自带的图形化ui显示结果通过cmd 进入到日志目录 cd E:\logss\web2logparser –i iisw3c –o datagrid "select * from u_ex160612.log"图5为了保证性能,默认它会显示前10条2:查看时间字段,客户ip ,访问的页面三个字段并且以图形化形式输出 logparser –i iisw3c –o datagrid "select time,c-ip,cs-uri-stem from u_ex160612.log"7厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:图6四、com 扩展logparser 提供com 接口来扩展,支持c#语言调用,在处理一些自定义格式分析的时候可以采用此方式来扩展,更多详情可以查看官方手册五、sql 语句的支持logparser 是集成了数据库引擎的,我们可以直接使用标准的sql 语句来对日志进行筛选查询操作即可,这是这款工具的最大的亮点之一。

六、多文件的支持一般的web 日志文件都是按天进行生成的,我们有时需要对整个目录的日志文件进行查找,我们只需要对from 语句后面添加*通配符 如以下日志目录:8厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:图7因此我们可以构造以下语句实现多日志文件的操作 logparser–i iisw3c –o datagrid "select * from u_ex*"六、实例模拟通过后门文件定位追溯攻击者1:首选获取到后门程序的文件名(可以通过webshell 查杀工具),如下图82:通过文件名获取所有操作后门的攻击者iplogparser -o:datagrid "select * from ex* where TO_LOWERCASE(cs-uri-stem) like '%dj888.aspx%'"图93:筛选下我们需要的字段logparser -o:datagrid "selectdate,time,c-ip,cs-method,cs-uri-stem,cs-uri-query,cs(User-Agent) from ex* whereTO_LOWERCASE(cs-uri-stem) like '%dj888.aspx%'"图104:获取得到所有访问者的ip,这里我们可能会出现很多记录,因此我们可以直接按照c-ip来进行分组logparser -o:datagrid "select c-ip from ex* where TO_LOWERCASE(cs-uri-stem) like'%dj888.aspx%' group by c-ip"这样我们就获取得到所有通过后门访问我们web系统的ip信息9 厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科网站:10厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:图11这里我们可能或获取得到很多个ip 地址,为了方便查询归属地,我们可以用纯真ip 库,也可以利用线上的批量查询,如站长之家ip 归属地批量查询等5:通过获取的ip 追溯整个攻击者的访问信息 logparser -o:datagrid "selectdate,time,c-ip,cs-method,cs-uri-stem,cs-uri-query,cs(User-Agent) from ex* where c-ip='10.xx.xx.100'"首选攻击者打开首页,没有发现任何异常图12紧接着出现了大量的head 请求,很明显开始了路径扫描图13head请求结束后,攻击者打开了上传页面图14两次post请求uploadfaceok.asp后就开始请求后门文件了,因此这个文件存在较大的安全隐患,需要重点排除,通过对脚本分析发现uploadfaceok.asp存在文件截断上传漏洞获取后门收攻击者对后门脚本提交了大量post,按照经验攻击者应该在尝试提权等操作图152:通过敏感文件分析日志一般攻击者或多或少的都会尝试下载一些资源文件,主要在扫描阶段,脱裤等行为留下的日志,通过常规后缀进行分析,.sql .zip .rar .mdb .baklogparser –i iisw3c -o:datagrid "select * from ex* where (TO_LOWERCASE(cs-uri-stem) like '%.mdb%') OR (TO_LOWERCASE(cs-uri-stem) like '%.zip%') OR11 厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科网站:12厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:(TO_LOWERCASE(cs-uri-stem) like '%.rar%') OR (TO_LOWERCASE(cs-uri-stem) like '%.bak%')"同上我们在根据这些ip去依次判断此人的访问轨迹,分析入侵者是否成功获取系统权限,和系统漏洞的入口七、通过注入语句同理我们也可以通过常见的sql 注入来找出攻击者,一般来说注入语句常见的关键字 ' and select or union 等logparser -o:datagrid "select * from ex* where (TO_LOWERCASE(cs-uri-query) like '%\%27%') OR (TO_LOWERCASE(cs-uri-query) like '%\%20and\%20%') OR (TO_LOWERCASE(cs-uri-query) like '%\%20or\%20%') OR (TO_LOWERCASE(cs-uri-query) like '%\%20union%') OR (TO_LOWERCASE(cs-uri-query) like '%\%20union')13厦门市美亚柏科信息股份有限公司电话:(86-592)3929988 传真:(86-592)2519335 技术支持热线:400-888-6688 微博:@美亚柏科 网站:工具最大的好处是解放我们操作日志,让我们的分析的思路更加灵活,因此我们也可以有很多种方式找到攻击者,如八、其他方式1:分析所有ip 成功登入后台的记录,通过ip 还原到地市,找到异常登入情况 2:分析特殊时间的一些管理操作,如凌晨1-5点的一些ip3:通过一些特殊扫描器的user-agent 信息找到攻击者,如sqlmap ,awvs 默认的user-agent 4:通过一些最新的payload 做关键字来分析系统是否有被尝试利用等等九、篇外logparser 是一款优秀的日志分析工具,我们可以在此基础上封装更多的易用的可视化的工具实现自动化分析等等,更多更高级的玩法等着你十、总结渗透测试哪家强,就到厦门找安胜。