中国面孔表情图片系统的修订

护理心理学 面部表情识别 实验报告

面部表情识别

一、实验目的

1、了解、体验情绪实验的基本特征,初步掌握情绪识别实验的方法。

2、初步掌握内容分析法。

3、考察情绪面孔识别的一致性、识别不同面部表情的难度差异以及识别面部表情的主要方法和线索。

二、实验材料

·24张情绪面孔

·这些情绪面孔是从罗跃嘉等人开发的中国面孔表

情图片系统中选取的愤怒、厌恶、恐惧、悲伤、惊讶和高兴面孔各4张,男女各半,表情者不同

7、每个小组对本组的实验结果进行统计分析

8、小组之间进行结果交流。同时课代表统计分析全班的实验结果,之后向全班同学报告。

四、实验结果

表1 自己和本小组正确识别每种情绪的次数和比率

自己 小组

情绪

次数 比率 次数 比率

愤怒 4 100% 13 67%

厌恶 3 75% 9 44%

恐惧 2 50% 13 67%

4、人们的情绪有共同的面部表情模式。

成绩:

指导老师:竺静

·这24张情绪面孔按事先规定好的顺序依次通过投影仪呈现,每张呈现40秒。

三、实验程序

1、安排学生进入实验室

2、对学生进行分组,每8人左右一个小组,每组同学围坐一张实验桌。

3、给学生讲解实验的基本情况

4、将“面部表情识别记录表和线索的的记录统计表”分发给学生。

5、确认学生开始实验

6、播放完24张情绪面孔后,公布正确答案,请学生自行统计自己的正确情况,并整理和统计自己填写的识别面部表情的主要方法与线索。

悲伤 3 75% 20 100%

惊讶 3 75% 16 80%

高兴 100% 20 100%

合计 19 79% 91 75.9%

表2 自己和本小组使用每种方法的次数和频率

基于VGG16架构的中国名人面孔识别

基于VGG16架构的中国名人面孔识别人工智能在计算机视觉领域的应用越来越广泛,其中人脸识别技术受到了广泛的关注和研究。

中国名人面孔识别是人脸识别技术的一个重要应用。

本文将基于VGG16架构介绍中国名人面孔识别的相关技术。

VGG16是一个十分流行的卷积神经网络的架构,由Karen Simonyan和Andrew Zisserman于2014年提出。

它的架构相对比较简单,但是它的性能异常强劲,因此得到了广泛的应用,也成为图像分类领域的经典网络之一。

中国名人面孔识别使用了VGG16网络的架构作为基础,对其进行了修改。

具体来说,我们将VGG16网络的输入从原先的224x224调整为128x128,这是由于我们的训练数据集的人脸图像比较小。

同时,我们将输出层的神经元数目从1000调整为人脸名人数量,即我们需要识别的名人数目。

我们使用了中国名人面孔识别数据集,该数据集由多个著名中国人物的照片组成,包括政治家、科学家、艺术家等。

该数据集中包含了很多的变形、表情、角度等因素的人脸图像。

我们将数据集分为训练集、验证集和测试集,其中训练集包含65%的数据,验证集和测试集各包含17.5%的数据。

数据集的预处理是十分重要的一步。

首先,我们需要对每张图片进行人脸检测,找到其中的人脸位置。

然后,我们需要将人脸图像进行归一化,即将每张图像的像素值减去均值并除以方差。

这样可以使得每个像素的值在[-1, 1]之间,并且可以提高模型的精度和收敛速度。

为了防止过拟合,我们使用了数据增强的技术,包括翻转、旋转、缩放等。

这样可以使得模型具有更好的泛化能力,同时增加了训练集的大小。

我们还使用了dropout技术,以提高网络的鲁棒性,并防止过拟合。

最后,我们使用softmax分类器来分类每个输入的人脸图像。

我们使用交叉熵来计算损失函数,并使用反向传播算法进行优化。

我们将学习率设定的相对较小,即使用了Adam 优化器来优化模型,最终达到了较好的识别效果。

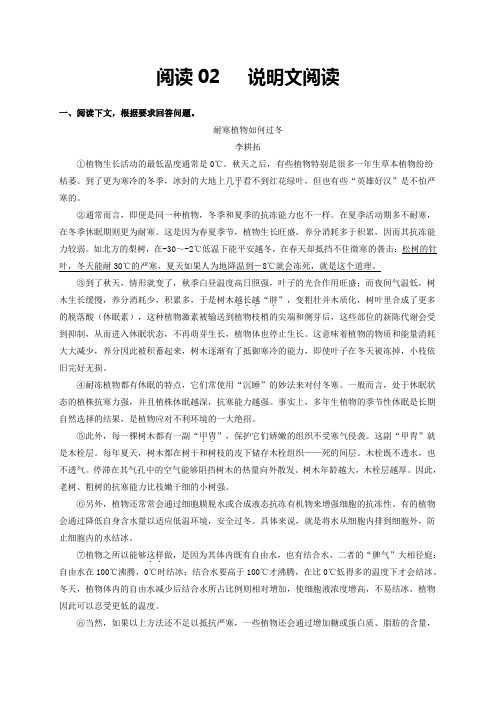

阅读02 说明文阅读(解析版)

阅读02 说明文阅读一、阅读下文,根据要求回答问题。

耐寒植物如何过冬李耕拓①植物生长活动的最低温度通常是0℃。

秋天之后,有些植物特别是很多一年生草本植物纷纷枯萎。

到了更为寒冷的冬季,冰封的大地上几乎..看不到红花绿叶,但也有些“英雄好汉”是不怕严寒的。

②通常而言,即便是同一种植物,冬季和夏季的抗冻能力也不一样。

在夏季活动期多不耐寒,在冬季休眠期则更为耐寒。

这是因为春夏季节,植物生长旺盛,养分消耗多于积累,因而其抗冻能力较弱。

如北方的梨树,在-30~-2℃低温下能平安越冬,在春天却抵挡不住微寒的袭击;松树的针叶,冬天能耐30℃的严寒,夏天如果人为地降温到-8℃就会冻死,就是这个道理。

③到了秋天,情形就变了,秋季白昼温度高日照强,叶子的光合作用旺盛;而夜间气温低,树木生长缓慢,养分消耗少,积累多,于是树木越长越...“胖.”,变粗壮并木质化,树叶里合成了更多的脱落酸(休眠素),这种植物激素被输送到植物枝梢的尖端和侧芽后,这些部位的新陈代谢会受到抑制,从而进入休眠状态,不再萌芽生长,植物体也停止生长。

这意味着植物的物质和能量消耗大大减少,养分因此被积蓄起来,树木逐渐有了抵御寒冷的能力,即使叶子在冬天被冻掉,小枝依旧完好无损。

④耐冻植物都有休眠的特点,它们常使用“沉睡”的妙法来对付冬寒。

一般而言,处于休眠状态的植株抗寒力强,并且植株休眠越深,抗寒能力越强。

事实上,多年生植物的季节性休眠是长期自然选择的结果,是植物应对不利环境的一大绝招。

⑤此外,每一棵树木都有一副“甲胄..”,保护它们娇嫩的组织不受寒气侵袭。

这副“甲胄”就是木栓层。

每年夏天,树木都在树干和树枝的皮下储存木栓组织——死的间层。

木栓既不透水,也不透气。

停滞在其气孔中的空气能够阻挡树木的热量向外散发。

树木年龄越大,木栓层越厚。

因此,老树、粗树的抗寒能力比枝嫩干细的小树强。

⑥另外,植物还常常会通过细胞膜脱水或合成液态抗冻有机物来增强细胞的抗冻性。

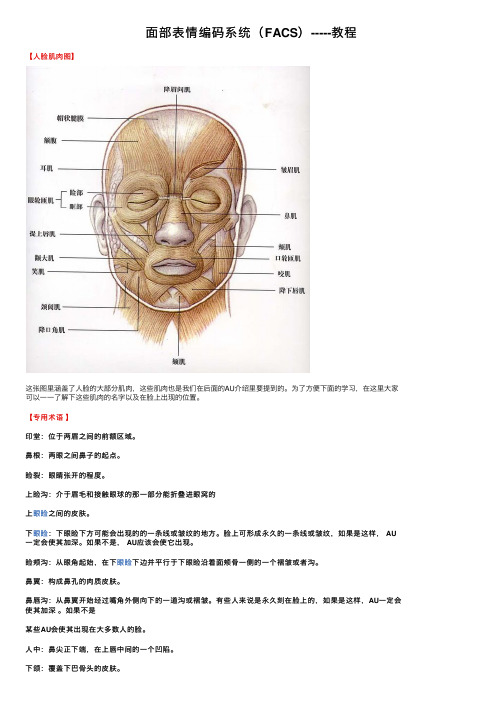

面部表情编码系统(FACS)-----教程

⾯部表情编码系统(FACS)-----教程【⼈脸肌⾁图】这张图⾥涵盖了⼈脸的⼤部分肌⾁,这些肌⾁也是我们在后⾯的AU介绍⾥要提到的。

为了⽅便下⾯的学习,在这⾥⼤家可以⼀⼀了解下这些肌⾁的名字以及在脸上出现的位置。

【专⽤术语】印堂:位于两眉之间的前额区域。

⿐根:两眼之间⿐⼦的起点。

睑裂:眼睛张开的程度。

上睑沟:介于眉⽑和接触眼球的那⼀部分能折叠进眼窝的上眼睑之间的⽪肤。

下眼睑:下眼睑下⽅可能会出现的的⼀条线或皱纹的地⽅。

脸上可形成永久的⼀条线或皱纹,如果是这样, AU ⼀定会使其加深。

如果不是, AU应该会使它出现。

睑颊沟:从眼⾓起始,在下眼睑下边并平⾏于下眼睑沿着⾯颊⾻⼀侧的⼀个褶皱或者沟。

⿐翼:构成⿐孔的⾁质⽪肤。

⿐唇沟:从⿐翼开始经过嘴⾓外侧向下的⼀道沟或褶皱。

有些⼈来说是永久刻在脸上的,如果是这样,AU⼀定会使其加深。

如果不是某些AU会使其出现在⼤多数⼈的脸。

⼈中:⿐尖正下端,在上唇中间的⼀个凹陷。

下颌:覆盖下巴⾻头的⽪肤。

巩膜:眼球⽩⾊的部分。

框下三⾓区:⿐唇沟、睑颊沟和脸部外侧曲线组成的三⾓区⽤于描述唇的⼀些术语常常也被⽤来描述⼈脸的其他部分,相同的基本含义都适⽤。

举例:·收窄常常被⽤来描述睑裂的变⼩.·放宽常常被⽤来描述睑裂的增加.·放宽经常被⽤在关于⿐孔扩⼤上⾯,甚⾄涉及到AUS 25,26,27中嘴部张开的程度。

·铺平常⽤来降低涉及到au20的脸颊区域的弯曲程度。

·紧缩常常被⽤来描述上下眼睑.注:以上的术语,就是你在学习这个教程时会经常⽤到的重要术语!请熟记这些术语以及它们的意思!AU1——抬起眉⽑内⾓AU1的外显变化1. 拉动中部的眉⽑向上2. ⼤多数⼈会产⽣⼀个⼋字形状的眉⽑3. 导致前额中部的⽪肤产⽣⽔平的褶皱。

这些褶皱通常不会贯穿全部的前额⽽是限制在中部。

褶皱可能是弧线,皱褶中部⽐尾端提升的⾼⼀些,⽽不是⽔平。

那些褶皱可能不会出现在⼉童或幼⼉的脸上。

无意识愤怒面孔加工的脑区激活似然估计(ALE)元分析

)

*+

)

!"# $%$"&’ (!(

"

$$ $%$!$"&"!

! "$ $ !& $%$(&’’(

左侧杏仁核对正性情绪起作用, 右侧杏仁核对负性 情绪起作用[24,25]。 两种假说从本研究看来均支持,首 先,右侧杏仁核的确在本研究结果中激活更明显,支

。。。。。。。。。。

。。。。。

。。。。。

。。。。。 。。。。。。

。 。 。 。。。。。 。。。 。。。 。 。 。 。

。。 。 。。 。 。Fra bibliotek 。 。 。 。

。。。。。

。。。。

。 。。。。。 。。。。。 。 。。。 。 。 。 。。

。。 。 。

。 。 。。 。 。 。 。

。。。。。

。。。。

。 。。。。。 。。。。。 。 。。。 。 。 。 。 。

·572·

Chinese Journal of Clinical Psychology Vol.19 No.5 2011

无意识愤怒面孔加工的脑区激活似然估计(ALE)元分析

姚树桥, 张江华, 石湖清 (中南大学湘雅二医院医学心理研究所,湖南 长沙 410011)

动态表情面孔再认的实验研究

大学生面孔表情材料的标准化及其评定

中国临床心理学杂志 1,,/ 年 第 *- 卷 第 .期

色!评价方法"要求评价者对所呈现的情绪面孔图片 进行分类# 评价者只需指出情绪面孔图片所表达的 情绪类型$不需要提供自己的情绪感受% 实验程序" 用 !"#$%&’ 软件编制程序呈现图片$显示器亮度&对 比度和色彩均为统一设置! 图片呈现时被试根据自 己的即时感受为图片划分类型$ 每种情绪类型对应 计算机大键盘数字键 (")! 分类时间由被试自己掌 握$每完成一幅图片的分类$程序会自动进入下一张 图片$要求被试不做长时间思考!每 *+, 幅图片休息 一次! 正式评价前对被试进行举例讲解$ 并安排练 习$练习图片共 -, 幅! !"# 结果

)-2)*

握%当同一幅图片再次出现时$被试需要仔细观察该 图片$ 判断该面部表情中是否还含有其他的情绪成 分$如果有$则继续为其划分类型$并为其强弱程度 打分%每完成一幅图片的分类和强弱程度判断后$程 序会自动进入下一张图片% 每 ), 幅图片休息一次% 正式评价前对被试进行举例讲解$并安排练习$练习 图片共 -, 幅% #"# 结果 !"!"$ 各类图片百分比分析 根据对图片选择的人 数百分比和图片类型将图片统计分类见表 *% 由统 计结果可以看出$ 评分者对高兴的表情有最高的认 同率$有 )06)5的高兴图片的认同率达到 2,5以上$ 而对带有厌恶和恐惧表情的面孔图片认同率很低%

对评分者的评价结果进行统计! 选出 . 名评分 者对其分类一致的图片$结果得到高兴 *)/ 张&愤怒 00 张 &恐 惧 11 张 &悲 伤 0/ 张 &厌 恶 *2 张 &惊 讶 21 张&平静 */+ 张$共 /32 张! 符合要求的图片分别占 原 始 图 片 数 量 的 百 分 比 为 " 高 兴 2*4.5 & 愤 怒 -26/5&恐 惧 *)605&悲 伤 -.635&厌 恶 1.6*5&惊 讶 0-6.5&平静 3.6-5!

中国面孔表情图片系统的修订

【 摘

要 】目的:扩展本土化 的中国面孔表情图片 系统 以提供情 绪研 究 的取材 。方法 :采用方 便取样 。

从北京 2所高等艺术 院校 的表演系 、导演系选取 10名学生 ,作为 面孔 表情表 演者 ;从北京 2所 普通高等 0

院校招募 10名学生 ,作为面孔表情评 分者。采集表演者 的愤怒 ,厌 恶 ,恐惧 ,悲 伤 ,惊讶 ,高 兴和平静 0 7种面孔表情 图片 ,再 由评分者对图片进 行情 绪类 别 的判 定和情绪 强烈 程度 的 9点量表 评分 ,扩展 各种情 绪类型 的图片数量 。然后 ,从北京 3 普通 高校 戏剧社社员 中选取 10名学生 ,从北京某社 区选取老 年人 、 所 0

at gaddrcn eat e t f w t ol e e i eesl t st x rs rA d10s dns ee c n n i t gdpr n oa l gsi B in w r e c da eepes . n t et w r i ei m o t rc e n jg ee h e 0 u

儿 童各 1 ,作为面孔表情表演者 ;另从北京 2所普通高 等院校招募 10名学生 ,作 为面孔 表情评分 者。 O名 0

进一步扩展负性 图片 的数 量 ( ,愤怒 ,厌恶 ,恐 惧 ,悲伤 ) 如 ,并补充 一些其他 年龄段 的 图片。结果 :得 到具有代表性 的 7种情绪类型的面孔表 情图片共 80张 ,每张 图片都有其 对应 的认 同率和 情绪 强度评 分 , 7 其 中 ,愤怒 7 ,厌恶 4 4张 7张 ,恐惧 6 4张 ,悲伤 9 5张 ,惊讶 10张 ,高兴 2 8张 ,平静 2 2张 。结论 :本 2 4 2 研究初步建立 了信度较高 的中国人面孔表情图片系统 ,可作为 以后情绪研究 的选取材料 ,本系统有 待进一

中国人面孔表情强度分级图片库的建立

·心理卫生评估·中国人面孔表情强度分级图片库的建立*刘静1,3任艳萍2屈威1陈楠1范宏振1宋丽丽1张蒙1田占宵1赵艳丽1谭淑平1(1北京回龙观医院,北京大学回龙观临床医学院,北京1000962首都医科大学附属北京安定医院,国家精神心理疾病临床医学研究中心,精神疾病诊断与治疗北京市重点实验室,北京1000883河南科技大学第五附属医院,河南洛阳471300通信作者:谭淑平shupingtan@)【摘要】目的:建立中国人面孔表情强度分级图片库,为情绪研究提供素材。

方法:22名话剧演员在专业导演指导下表演愤怒、厌恶、恐惧、悲伤、惊奇、高兴和平静7种面部表情,用高速摄像机录制,之后根据表演情绪的强度多次屏幕截图,所有图片去除非面孔特征后,制作成相同大小和灰度的的814张黑白照片。

每名表演者的每种情绪均包含6个强度等级。

招募112名健康志愿者,采用0 100等级对全部图片的情绪强度、愉悦度、唤醒度进行评价。

结果:建立的中国人面孔表情强度分级图片库,包含2个子库,图片库1为不同表演者的面孔表情强度分级图片库,共入选436张图片;图库2为同一表演者不同情绪强度图片库共入选640张图片;每个图片库都有相应的强度、愉悦度、唤醒度的评分结果,且在信度分析方面均呈现出较高的内部一致性(Cronbach a值均大于0.9)。

结论:本研究建立了具有良好认同度、符合心理学测量属性的中国人面孔表情强度分级图片库,可作为我国面孔表情的相关研究素材。

【关键词】情绪;面部表情;情绪刺激素材;评定中图分类号:B842.6文献标识码:A文章编号:1000-6729(2019)002-0120-06doi:10.3969/j.issn.1000-6729.2019.02.009(中国心理卫生杂志,2019,33(2):120-125.)Establishment of the Chinese facial emotion imagesdatabase with intensity classificationLIU Jing1,3,REN Yanping2,QU Wei1,CHEN Nan1,FAN Hongzhen1,SONG Lili1,ZHANG Meng1,TIAN Zhanxiao1,ZHAO Yanli1,TAN Shuping1 1Beijing Huilongguan Hospital,Huilongguan College of Clinical Medicine,Peking University,Beijing100096,China2Anding Hospital,Capital Medical University,Beijing100088,China3The Fifth Affiliated Hospital of Henan University of Science and Technology,Luoyang471300,Henan Province,ChinaCorresponding author:TAN Shuping,shupingtan@【Abstract】Objective:To establish an intensity-classified Chinese facial emotion image database and provide materials for emotional researches in China.Methods:Firstly,under the guidance of professional director,22pro-fessional dramatic actors put up seven kinds of emotion,including anger,disgust,fear,sadness,surprise,happy and calm.The process of facial emotional performance of actors were filmed by a high-speed camera.Then we made screen captures according to the intensity of emotion performed by the actors.A total of814black-and-white photo-graphs with same size and gray level were made after we removed the irrelevant parts to the facial features.Each kind of emotion contains six levels of intensity scoring from1to6.Totally,112healthy volunteers were recruited to evalu-ate the emotional intensity,pleasure and arousal of all images via a visual scale ranged from0to100.Results:A Chinese face emotional intensity hierarchical picture library was set up,which contained2sublibraries.The first li-brary was consisted of436images with hierarchical emotional intensity images collected from different performers.The*基金项目:首都临床特色应用研究重点项目(Z141107002514016),北京市自然科学基金项目(7162087)second one was built with640images,in which the hierarchical emotional intensity image was collected from same actor/actress.Both image libraries had corresponding scores for intensity,pleasure,and arousal.Furthermore,both exhibited a high degree of internal consistency in reliability analysis(with a Cronbach's alpha value larger than0.9).Conclusion:The present study has established an intensity-classified Chinese facial emotion image database with good recognition degree and psychological measurement attribution,which could provide materials for emotional re-searches in China.【Key words】emotion;facial expression;emotional stimulus material;assessment(Chin Ment Health J,2019,33(2):120-125.)情绪作为人类日常生活中时刻经历着的一种体验,与人们的生活、工作和学习都密切相关。

述情障碍大学生表情识别能力的研究

[5]Oh、rier LumiIIet,Ni∞l曲Vemeulen,Cathe血e D锄aret

~ex—

ithy曲蛐d leveIs of pIDcessirIg:Evidence

r哪哪be血g

[6]

0uvier

emodon诚【J].Jo岫_1al

fbr

aIl

overaⅡdeficit in

of Research in Personali.

2.1

将一定数量的被试分批进入实验室,每一批被试同 时进行实验。他们被告知实验的目的是进行表情识 别,具体程序如下:(1)所有被试进入实验室后,首先

所有进行问卷调查大学生的多伦多述情障碍

向被试介绍整个实验程序,并告知应注意事项,等被

试没有疑问后开始发放个人基本情况问卷和多伦多 述情障碍量表(TAS一20)。(2)完成个人基本情况 问卷和多伦多述情障碍量表(TAS一20)。(3)识别 面部基本表情图片。 本实验采用的是信号检测论的任务。面部表情 图片通过Eprime程序在电脑屏幕上呈现,同时实验 的指导语也呈现在电脑屏幕上。为了使表情图片的 呈现效果更佳,表情图片呈现时图片后的屏幕背景 设定为白屏。每次实验,首先呈现500 ms的蓝屏, 然后呈现2

wagrIera.Victoria L∞b.~e妇thy删a and individual缸fe卜

3讨论 本实验的研究结果与其他很多学者得到的结论

【2]

Hugh

enc皓iTl emotional

expr髂sion[J].Joumal

of Research in Personal.

一致。KeSsler(2006)的研究结果指出,述情障碍高 发生率的进食障碍病人中,述情障碍特质与情绪面 孔的识别不存在相关性【5|。Prkachin(1990)发现在 不限时的表情命名的任务中,述情障碍组与非述情 障碍组的表现没有差异,或者说两组的表现一样 好[4】。根据Martin等人的观点:述情障碍个体对情 绪刺激的评估以其不完整的、不一致的认知模式为 根据,这将导致个体对情绪信息的意义不明确、评估 不充分、不准确,而这又会进一步使个体回避情绪刺 激。之所以本研究与前人一部分的研究结果不一 致。也许是因为述情障碍个体并不是意识不到情绪

《中图法》标记符号系统 和复分表的修订和使用

如: B3 亚洲哲学 东方哲学、东方哲学史等入此。 B4 非洲哲学 非洲哲学史入此。 (在处理东方哲学史、非洲哲学史等著作 时,不应再加“-09历史”。) 如: H19 汉语教学

{ } 停用符号

置于{ }内的类号是前一版本中用于 标引的分类号,现在的版本已经停用, 类目下再用< >加以沿革注释。 如:{TU243.3} 会议厅 <停用;5版入TU243> {TS956.2+1} 手电筒 <停用;5版入TS956.2>

ⓧ禁用符号

第5版对“一般性问题”类目进行规范,在其 类名后用此标记加以提示,避免误标引并造成与 其上位类分类不一致。

为使号码适应类目设置需要,或给 重点类目留有较宽裕的号码,或为 缩短类号,又采用八分法、双位制、 借号法等措施,增强配号的灵活性 与扩充性。

342.3 马都拉人 342.4 班查尔人 即第一类至第八 类用一个数字1-8来表 342.5 米南卡保人 342.6 亚齐人 示,第九类至第十六 342.7 库布人 类用两位数字91-98来 342.8 巴塔克人 表示…,依此类推。 342.91 巴厘人 例: (P1005) 342.92 布吉人 342 印度尼西亚人 342.93 望加锡人 342.1 爪哇人 342.94 萨萨克人 342.98 达雅克人 342.2 巽他人

八分法

双位制

用11、12…19, 21、22…29,3l、32 …99…等双位数字 表示各个同位类… 例: (P171) I236 中国地方剧 I236.21天津市地方剧 I236.22 河北省地方剧 I236.25山西省地方剧

I236.26 内蒙古自治区 地方剧 I236.3 东北地区地方 剧 I236.41 陕西省地方剧 I236.42 甘肃省地方剧 I236.51 上海市地方剧 I236.58 台湾省地方剧 I236.61 河南省地方剧 I236.65 广东省地方剧 I236.71 四川省地方剧 I236.75 西藏自治区地 方剧

面部表情控制对情绪面孔识别的影响

面部表情控制对情绪面孔识别的影响

具身情绪观认为情绪是基于身体加工的,受到身体构造、身体活动、身体的感知觉及其经验的影响,而面部表情作为最常见的外显情绪表征,因此研究面部表情识别的影响因素,从而促进他人情绪的理解,对个体适应社会生活具有重要意义。

本研究在前人有关情绪具身性研究的基础上,探讨面部表情控制对情绪面孔图片识别的影响。

针对情绪面孔图片识别的情绪一致性效应、局部线索效应以及面部模仿效应,设计了实验一、实验二和实验三。

实验一和实验二的研究目的是探究具身行为下的情绪一致性效应。

所采用的实验材料为中国化面孔情绪图片系统,被试为60名重庆师范大学本科生和研究生,将被试分为积极具身行为组和消极具身行为组,通过积极与消极的面部肌肉控制方式引发相对应的具身情绪,并采用识别-判断范式让被试对情绪面孔图片进行识别和判断,研究面部表情控制下个体对情绪面孔图片识别的反应时和正确率。

实验三在实验一和实验二的基础上进行,继续探讨具身情绪下对面孔图片识别的干扰因素。

呈现材料来自中国化面孔情绪图片,将面孔图片分为上半部(眼部)以及下半部(嘴部),采用识别判断范式,考察具身情绪下,局部线索及面部模仿效应对情绪面孔识别的影响。

结论:(1)面部肌肉控制能够有效诱发被试情绪;(2)积极具身行为状态比消极具身行为状态,识别正性面孔图片更快,识别消极面孔图片更慢;(3)消极具身行为状态比积极具身行为状态,识别消极情绪更快,识别积极情绪更慢。

(4)识别正性面孔图片时,嘴部线索作用更大;识别负性图片时,眼部线索作用更大;(5)具身情绪下识别情绪面孔图片会受到面部模仿效应和局部线索的影

响。

基于VGG16架构的中国名人面孔识别

基于VGG16架构的中国名人面孔识别随着人工智能技术的不断发展,人脸识别技术已经成为了生活中的常见应用,包括安防监控、手机解锁等领域。

在中国,人脸识别技术也被广泛应用于公安、金融、旅游等行业。

而基于深度学习的人脸识别技术更是在近年来取得了长足的发展。

本文将要介绍的是基于VGG16架构的中国名人面孔识别技术,该技术可以应用于名人信息管理、知识产权保护等领域,具有很高的实用价值。

VGG16是由牛津大学计算机视觉组(Visual Geometry Group)开发的深度卷积神经网络模型。

该模型在2014年的ImageNet大规模视觉识别挑战赛上取得了优异的成绩,因此被广泛应用于图像识别领域。

VGG16模型具有16层深度的网络结构,包括13个卷积层和3个全连接层,可以有效地提取图像的特征信息。

在人脸识别领域,VGG16模型可以通过学习大量的人脸图像数据,从而识别出不同人脸之间的差异性,具有很强的识别能力。

中国名人面孔识别技术可以应用于多个领域。

在文化娱乐领域,可以利用该技术建立名人信息数据库,方便用户了解各种名人的生平事迹、作品信息等。

在知识产权保护领域,可以利用该技术对名人的形象进行管理和监控,防止他人利用名人形象进行侵权行为。

在旅游领域,可以利用该技术对名人雕像、名人故居等进行识别,提供更加便捷的导览服务。

基于VGG16架构的中国名人面孔识别技术具有广泛的应用前景和商业价值。

要实现基于VGG16架构的中国名人面孔识别技术,首先需要构建一个包含大量名人面孔图像数据的数据集。

这些人脸图像数据应该具有丰富的多样性,包括不同人的正面、侧面、不同角度等多种情况,以提高识别的准确性。

需要利用VGG16模型对数据集进行训练,从而学习人脸的特征信息。

在训练过程中,需要利用反向传播算法不断调整网络权重,提高网络的识别能力。

通过测试集的验证,评估模型的性能,进一步优化模型参数,提高识别的准确性和速度。

在实际应用中,基于VGG16架构的中国名人面孔识别技术可能会面临一些挑战。

人脸表情识别研究

人脸表情识别研究一、人脸表情识别技术的背景人脸表情识别技术是一项基于人工智能技术的重要研究领域。

随着现代社会中越来越多的图像和视频数据被数字化存储和处理,如何迅速、准确地分析这些数据成为许多应用领域的重要问题。

人脸表情作为人类社交交流的重要组成部分,具有广泛的应用前景,例如个性化推荐、智能客服、人机交互等。

因此,研究人脸表情识别技术对于提升智能化应用的质量和效率具有重要意义。

二、人脸表情识别技术的概述人脸表情识别技术是指通过计算机算法从人脸图像或视频中自动识别出人脸表情并进行情感分类。

其技术流程一般包括人脸检测、面部特征提取、特征选择和表情分类等步骤。

目前,人脸表情识别技术主要有基于特征提取和基于深度学习两种方法。

1、基于特征提取的方法基于特征提取的人脸表情识别方法是将面部特征向量提取出来,并利用分类器进行分类预测。

特征提取的方法包括主成分分析、独立分量分析等方法。

它的优点是计算速度快,但缺点是分类器性能受到特征提取质量和特征选择的影响。

2、基于深度学习的方法基于深度学习的人脸表情识别方法是利用卷积神经网络(CNN)等深度神经网络进行人脸属性及情感特征的学习和提取。

其优点是端到端学习,对特征的自动学习和分类器训练效果更好,但缺点是需要大量的标记样本和计算资源。

三、人脸表情识别技术的应用领域人脸表情识别技术具有广泛的应用领域,下面主要介绍以下几个方面:1、智能客服基于人脸表情识别技术的智能客服系统能够智能地识别用户情绪,更好地与用户交互、解决用户问题,提升用户体验。

2、个性化推荐利用人脸表情识别技术可以识别用户的情感状态,了解用户的偏好和需求,为用户提供个性化推荐服务。

3、人机交互通过人脸表情识别技术能够实现人机自然的交互体验,例如自适应控制、游戏、娱乐等领域。

4、医疗保健人脸表情识别技术可以用于疾病诊断、治疗、心理咨询等场景中,帮助医生更好地诊断病情、指导治疗、提高治疗效果。

四、人脸表情识别技术的面临的挑战和应对策略目前,人脸表情识别技术仍面临许多挑战。

中美两国6种基本面部表情识别的跨文化研究分析报告

中美两国6种基本面部表情识别的跨文化研究(汤艳清,欧凤荣,吴枫,孔令韬)1.问题的提出本研究采用美国宾夕法尼亚大学情绪识别测验(The Penn Emotion Recognition Test )系统中96 张情绪面部表情高低程度不同的三维彩色照片,分别对中美两国健康成年人对愉快、愤怒、恐惧、悲伤、厌恶和中性6 种情绪面部表情的识别率进行跨文化研究,以帮助我们修正对不同文化背景下人类情绪行为的理解,促使我们更进一步地探讨情绪面部表情产生的神经生物学基础。

2.实验设计受试者: 82名来自中国医科大学的健康志愿者,男40人,女42人,年龄21.2(17~43)岁,受教育年限13.2(8~25)年;61名来自美国宾夕法尼亚大学的健康志愿者,其中男29人,女32人,年龄19.5(17~27)岁,受教育年限12.8(9~22)年。

接受测试前告知实验的目的和方法。

入组标准: 所有受试者均采用DSM-Ⅳ-TR轴Ⅰ障碍定式临床检查(非患者版)(SCID-1/NP)进行评估。

排除精神分裂症、抑郁症、物质依赖等精神疾病患者,排除患有可能影响脑功能的躯体疾病患者,排除有精神分裂症和情感障碍家族史者。

所有受试者双眼裸视或矫正视力正常。

3.实验方法1).地点:安静、光线适宜的房间内进行。

2).实验准备:将3张A4情绪面孔识别测试答题纸发给受试者,告知受试者有6种情绪面孔图片,请受试者在相应图片序号对应的情绪面部表情空格内打“√”,正式测试开始前用10张图片进行练习。

根据随机数字表随机排列答题纸上的6种面部表情和96张三维彩色情绪面孔图片,以消除面部表情识别的前摄抑制和后摄抑制备注:宾夕法尼亚大学情绪识别测试系统有96张彩色照片,其中愉快、悲伤、愤怒、恐惧、厌恶和中性照片各16张,每种表情有8张高强度情绪面部表情和8张低强度情绪面部表情;96张照片中男、女各半,其中59张为高加索(白种人)面孔、24张为非裔美国人面孔、5张为亚洲人面孔、8张为西班牙人面孔。

动态高兴表情评价中的表征动量效应和参照依赖效应

心理学报 2024, Vol. 56, No. 1, 29 43 © 2024中国心理学会 Acta Psychologica Sinica https:///10.3724/SP.J.1041.2024.00029收稿日期: 2023-05-07通信作者: 蒋重清,E-mail:******************;崔倩,E-mail:******************动态高兴表情评价中的表征动量效应和参照依赖效应田杨阳 李 东 闫向博 李 曌 崔 倩 蒋重清(辽宁师范大学心理学院, 大连 116029)摘 要 已有的表情面孔研究大多使用静态面孔图片材料, 对动态表情研究相对不足。

然而, 在生活中人们的表情往往是动态的。

为了探究动态表情的情绪加工特点, 本研究通过3个包含了动态和静态高兴表情图片材料的实验, 考察了动态高兴表情的强度变化方向和总体平均表征对情绪三维度评价的影响。

结果发现:总体平均表征越高的动态表情面孔会得到更高的唤醒度评分。

以与动态表情最后一帧表情强度相同的静态表情为对比条件, 从强到弱变化的动态表情会获得更低的效价评分和更高的优势度评分, 而从弱到强变化的动态表情则获得更高的效价评分, 即出现了表征动量效应。

相对于从弱到强, 从强到弱变化的动态表情所产生的知觉表征动量效应更大。

此外, 知觉者会基于实验中所见过的表情图片形成内部参照标准, 进而影响当前表情图片的情绪评价, 内部参照标准越低, 目标表情图片所得情绪评分越高, 反之亦然, 表现出参照依赖效应。

这些加工特征提示今后研究者采用表情材料进行研究时, 需要注意动静差异以及材料间的影响。

关键词 动态表情, 情绪三维度, 表征动量, 参照依赖效应 分类号 B8421 引言在人际交往过程中, 当一个人没有明确地说出其真实的观点和意图时, 面孔表情是少数能让人洞察其内心世界的线索之一(Ekman et al., 1980)。

用于情绪障碍研究的面部表情系统的初步建立

摘 要: 目的: 建立一套情绪障碍研究用面部表情图片系统,为异常情绪的研究提供标准化刺

激材料,增加情绪障碍研究的取材范围。方法: 对 85 名被试拍摄喜悦、惊奇、轻蔑、厌恶、愤怒、恐

惧、悲伤、平静、兴趣、羞愧、痛苦 11 种面部表情图片,拍摄强度分为强、中、弱三个等级,经过两次

筛选,再由 40 名评定者对其进行类别、强度、愉悦度和优势度的判定。结果: 获得一系列具有代表

Ekman( 1971) 认为人类存在六种基本情绪表达 喜悦、愤 怒、恐 惧、悲 伤、厌 恶 和 惊 讶。 也 有 研 究 认 为,轻蔑、兴趣和羞愧也是不同文化背景下人类所共 同具有的情绪( Izard,1971) 。表情研究是心理学研 究的重点,许多研究者制作面部表情图片,以研究正 常儿童及行为障碍儿童情绪认知特点( Delphine et al. ,2008; Geraldine et al. ,2004) ,如儿童自闭症、阿 斯伯格综合征和情绪障碍等( Kevin et al. ,2002; Noah,2006) ,以及成人异常情绪的研究( 徐舒靖,尹慧 芳,吴大兴,2008) 。由于情绪刺激材料的标准化对 研究结果有着重要的影响,国际上一些标准化的情 绪刺激材料也应运而生,如国际情绪图片、面部行为 编码系统、面部表情图片系统、字词材料、系列电影

78 张( 男 35 张,女 43 张) 、轻蔑 67 张( 男 37 张,女

表情

张数 最小值 最大值 平均数 标准差

30 张) 、厌恶 7 张( 男 4 张,女 3 张) 、愤怒 46 张( 男 24 张,女 22 张) 、恐惧 2 张( 男 1 张,女 1 张) 、悲伤 65 张( 男 28 张,女 37 张) 、平静 49 张( 男 23 张,女 26 张) 。统计分析一致率在 70% 以上的图片表情 强烈程度见表 2。表 2 显示,除悲伤和平静外,其他

中国情绪图片系统的编制_在46名中国大学生中的试用

・心理测量与评估・中国情绪图片系统的编制———在46名中国大学生中的试用白露1马慧1黄宇霞1罗跃嘉2@【摘要】目的:建立本土化的中国情绪图片系统(CAPS)以适应情绪研究的需要。

方法:筛选出852幅图片组成CAPS,46名中国大学生对CAPS图片的愉悦度、唤醒度和优势度进行了自我报告的9点量表评分。

结果:在CAPS评分中,唤醒度评分结果的一致性最高,愉悦度和优势度评分结果的标准差大于唤醒度的标准差。

散点图显示,CAPS在愉悦度和唤醒度上评分分布较为广泛。

结论:国际情绪图片系统(IAPS)具有较好的国际通用性,但仍由于文化、个性等因素存在差异,因此编制本土化的中国情绪图片系统是有必要的。

【关键词】普通心理学;情绪;心理测量学研究;中国情绪图片系统;IAPS中图分类号:G449.9文献标识码:A文章编号:1000-6729(2005)11-719-04TheDevelopmentofNativeChineseAffectivePictureSystem—Apretestin46CollegeStudentsBAILu,MAHui,HUANGYu-Xia,etal.KeyLaboratoryofMentalHealth,InstituteofPsychology,ChineseAcademyofSciences,Beijing100101【Abstract】Objective:TodevelopthenativeChineseAffectivePictureSystem(CAPS)forfutureresearchonemotion.!Methods:852pictureswerescreenedouttomakeupofCAPS.46Chineseuniversitystudentswerecollectedtoratethevalence,arousalanddominancebyself-reportina9-pointratingscaleforCAPS.!Results:Thestandarddeviationsofscoresonvalenceanddominanceweregreaterthanthatonarousal.ScatterplotshowedthatthescoredistributiononthedimensionofvalenceandarousalwaswideinCAPS.!Conclusion:ThoughIAPS(InternationalAffectivePictureSystem)ishighlyinternationally-accessible,therearestillsignificantdifferencesbetweenthetwosources.ThenativeChineseAffectivePictureSystemisnecessary.【Keywords】psychology;emotion;psychometricstudies;affectivepicture;CAPS;IAPSCAPS(ChineseAffectivePictureSystem)是由中国科学院心理健康重点实验室编制的一套标准化的情绪刺激图片系统,是该实验室正在编制的一系列情绪刺激材料中的一个子系统。

CAS-PEAL大规模中国人脸图像数据库及其基本评测介绍

第17卷第1期2005年1月计算机辅助设计与图形学学报J OURNAL O F COM PUTER -A I DED DES I GN S COM PUTER GRA PH I CSV o l.17,N o.1Jan.,2005收稿日期:2004-05-10;修回日期:2004-09-06基金项目:国家“八六三”高技术研究发展计划项目(2001AA 114010);国家自然科学基金重点项目(60332010)CAS -PEAL 大规模中国人脸图像数据库及其基本评测介绍张晓华山世光曹波高文周德龙赵德斌(中国科学院计算技术研究所数字化研究室北京100080)(s g shan !ict.ac.c m )摘要人脸图像数据库是人脸识别算法研究、开发、评测的基础,具有重要的意义.介绍了自行创建并已经部分共享的CA S -PEAL 大规模中国人脸图像数据库及其基准测试结果.CA S -PEAL 人脸图像数据库中包含了1040名中国人共99450幅头肩部图像.所有图像在专门的采集环境中采集,涵盖了姿态、表情、饰物和光照4种主要变化条件,部分人脸图像具有背景、距离和时间跨度的变化.目前该人脸图像数据库的标准训练、测试子库已经公开发布.与其他已经公开发布的人脸图像数据库相比,CA S -PEAL 人脸图像数据库在人数、图像变化条件等方面具有综合优势,将对人脸识别算法的研究、评测产生积极的影响.同时,作为以东方人为主的人脸图像数据库,CA S -PEAL 人脸图像数据库也使人脸识别算法在不同人种之间的比较成为可能,利于人脸识别算法在国内的实用化.还给出了两种基准人脸识别算法(E i g enf ace 和C orre lation )和两个著名商业系统在该人脸图像数据库上的测试结果,定量分析了该人脸图像数据库对于人脸识别算法的难易程度和人脸识别算法的发展现状.关键词人脸识别;人脸图像数据库;性能评测中图法分类号T P391CAS -PEAL :A Lar g e-Scale Chi nese face database and Som e Pri m ar y Eval uationsZhan g X iaohuaS han S hi g uan gC ao B oG ao W enZhou D elon gZhao D ebi n(D i g it al l ab ,I nstit ute o f C o m P utin g T echnolo gy ,C hinese a cade m y o f S ciences ,B ei j in g100080)AbstractA s t he basis o f research ,develo p m ent and evaluation o f f ace reco g nition al g orit h m s ,f ace i m a g e database is o f g reat i m p ortance.I n t his p a p er ,w e i ntroduce t he construction and basic content o f t he CA S -PEAL ,lar g e-scale Chi nese f ace database and som e p ri m ar y eval uation results based on t he database.T he CA S -PEAL f ace database consists o f 99450f acial i m a g es o f 1040Chi nese i ndi vi duals.A ll t he i m a g es i n t he database w ere co llected i n s p eciall y desi g ned environ m ent w it h f our p ri nci p al variations o f p ose ,ex p ression ,accessor y and li g hti n g ,as w ell as t hree ot her variations i n ter m s o f back g round ,distance and a g i n g .C urrentl y ,t he standard trai ni n g set and p robe set o f CA S -PEAL f ace database have been m ade p ublicl y available f or research p ur p ose onl y on a case-b y -case basis.C om p ared w it h ot her p ublic f ace databases ,CA S -PEAL excels i n its lar g e-scale and variation m odes and is ex p ected to have p ositi ve i m p act on t he develo p m ent and eval uation o f f ace reco g nition al g orit h m s.I n addition ,as an oriental f ace i m a g e database ,CA S -PEAL m akes p ossi ble t he com p arison o f al g orit h m s ’p erf or m ance bet w een diff erent et hnic g rou p s and w ill benefit t he a pp lication o f f ace reco g nition techno lo gy i n Chi na.T his p a p er also g i ves t he evaluation results o f t w o basic f ace reco g nition al g orit h m s (E i g enf ace and C orrelation )and t w o comm ercial s y ste m s ,ex p lai ns t he difficult y o f t he database to t he f ace reco g nition al g orit h m s and anal y ses t he current develo p m ent stat us o f f ace reco g nition techno lo gy .K e y words f ace reco g nition ;f ace database ;p !!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!erf or m ance evaluation!引言人脸识别的研究工作自20世纪60年代开始以来,经历了近40年的发展,已成为图像分析和理解领域最热门的研究内容之一[1].目前,人脸识别技术已经从实验室中的原型系统逐渐走向了商用,出现大量的识别算法和若干商业系统[1-3].然而,人脸识别的研究仍旧面临着巨大的挑战,人脸图像中姿态、光照、表情、饰物、背景、时间跨度等因素的变化对人脸识别算法的鲁棒性有着负面的影响,一直是影响人脸识别技术进一步实用化的主要障碍[2-3].多数人脸识别算法的研究、开发和测试需要更多的人脸图像来克服上述障碍,主要包括两方面:人脸图像数据库(简称人脸库)所包含的人数以及人脸库中每个人所具有的、在不同条件下的人脸图像数.目前,人脸识别领域常用的人脸库主要有:(1)FERET人脸库[2].由FERET项目创建,包含14051幅多姿态、光照的灰度人脸图像,是人脸识别领域应用最广泛的数据库之一.其中的多数人脸图像是西方人的,每个人所包含的人脸图像的变化比较单一.(2)M I T人脸库[4].由麻省理工大学媒体实验室创建,包含16位志愿者的2592幅不同姿态、光照和大小的面部图像.(3)Y ale人脸库[5].由耶鲁大学计算视觉与控制中心创建,包含15位志愿者的165幅图像,包含光照、表情和姿态的变化.(4)Y ale人脸库B[6].包含了10个人的5850幅多姿态、多光照的图像.其中姿态和光照变化的图像都是在严格控制的条件下采集的,主要用于光照和姿态问题的建模与分析.由于采集人数较少,该数据库的进一步应用受到了比较大的限制.(5)P I E人脸库[7].由美国卡耐基梅隆大学创建,包含68位志愿者的41368幅多姿态、光照和表情的面部图像.其中的姿态和光照变化图像也是在严格控制的条件下采集的,目前已经逐渐成为人脸识别领域的一个重要的测试集合.(6)ORL人脸库[8].由剑桥大学AT&T实验室创建,包含40人共400幅面部图像,部分志愿者的图像包括了姿态、表情和面部饰物的变化.该人脸库在人脸识别研究的早期经常被人们采用,但由于其变化模式较少,多数系统的识别率均可以达到90%以上,因此进一步利用的价值已经不大.(7)PF01人脸库[9].由韩国浦项科技大学创建,包含103人的1751幅不同光照、姿态、表情的面部图像,志愿者以韩国人为主.(8)AR人脸库[10].由西班牙巴塞罗那计算机视觉中心建立,包含116人的3288幅图像.采集环境中的摄像机参数、光照环境、摄像机距离等都是经过严格控制的.(9)BANCA人脸库[11].它是欧洲BANCA计划的一部分,包含了208人、每人12幅不同时间段的面部图像.(10)KFDB人脸库[12].包含了1000人,共52000幅多姿态、多光照、多表情的面部图像,其中姿态和光照变化的图像是在严格控制的条件下采集的.其志愿者以韩国人为主.(11)M P I人脸库[13].包含了200人的头部3D结构数据和1400幅多姿态的人脸图像.(12)XM2VT S人脸库[14].包含了295人在4个不同时间段的图像和语音视频片断.在每个时间段,每人被记录了2个头部旋转的视频片断和6个语音视频片断.此外,其中的293人的3D模型也可得到.人脸库在提供标准的人脸图像训练、测试集合的同时,还应该能对影响人脸识别性能的不同情况进行模拟,以方便研究人员针对不同的关键问题进行重点研究.但是,现有的人脸库大多存在数据量较小或者图像变化情况比较单一的缺陷,而且提供面部图像的志愿者多为西方人;由于东西方人在面部特征上存在一定的差异,使用西方人的面部图像进行识别系统的研究可能会给我们所开发的技术在国内的应用带来不利因素.因此,建立一个大规模、多样化的东方人脸库对国内人脸识别技术的发展将会有极大的推动作用.CA S-PEAL人脸库正是基于上述考虑而创建的大规模、多变化的东方人脸库.该数据库的建立是国家“八六三”高技术研究发展计划项目课题———“中文平台总体技术研究与基础数据库建设”的一部分,同时得到国家自然科学基金和国家“八六三”高技术研究发展计划的资助,由中国科学院计算技术研究所-银晨科技面像识别联合实验室负责建立.建库工作开始于2002年8月,2003年4月最终完成,01计算机辅助设计与图形学学报2005年共采集并整理了1040位志愿者(其中595位男性,445位女性)的共99450幅人脸图像.CA S -PEAL 人脸库中的所有图像分为姿态变化、表情变化、饰物变化、光照变化、背景变化、距离变化和时间跨度变化等7种变化模式子库,其中又以姿态(p ose )、表情(ex p ression )、饰物(accessor y )和光照(li g hti n g )4种变化为主(故简称为PEAL ).各个变化模式子库均可以与姿态变化子库进行组合,以满足研究工作中的不同要求.本文将从采集环境、变化模式两个方面介绍CA S -PEAL 人脸库,并结合几种人脸识别算法和商业系统在该数据库已经发布的基准训练、测试子库上的测试结果,进一步说明CA S -PEAL 人脸库用于人脸识别系统性能评测的难易程度,并简要分析了目前最好的人脸识别算法的性能.2C A S -P E A L 人脸库采集环境采集环境是建立人脸库所需要的基本硬件条件,包括摄像头和控制设备的布局、光照环境的建立等.这些硬件的组织和应用将直接影响人脸库的特性和质量.在建立CA S -PEAL 人脸库之前,我们对采集环境进行了认真设计,以求在现有的硬件条件下达到最佳的采集效果.CA S -PEAL 人脸库的采集环境主要具有了以下几个特点.图1摄像头在水平面上的排列(1)多角度摄像头图像采集系统为获得多角度的人脸面部图像,我们采用了多摄像头的采集系统布局.编号从0! 的9个摄像头在半圆形框架上成等角度分布,摄像头分布示意图如图1所示.被采集对象位于半圆形摄影架的圆心位置,调整椅子高度以使被采集人正对!4摄像头.9个摄像头通过 S 连接线连接到PC 机,由程序统一控制9个摄像头进行拍摄.每次拍摄时,0! 号摄像头依次抓取图像(总耗时小于 s ),并按照统一的命名规则保存.多摄像头同时拍摄获取多角度图像的方法,与使用单个摄像头拍摄而由被采集者转动头部获取多角度图像的方法相比,很好地控制了图像之间的角度变化,能保持角度间隔的一致性,更有利于研究多视角人脸识别问题.()多光源分布环境为获得一致均匀的自然环境光,同时也为了便于控制,我们完全遮挡了室外光线,用太阳灯照射粗糙的白色墙壁,利用其反射光来模拟自然环境光照,模拟自然环境光的光源叫作环境光源.为了获取不同光照条件下的面部图像,我们在 个垂直方向(上、中、下)和每个垂直方向的5个水平方向上共布置了15个光源,并按照光源所处的垂直和水平位置分别对每个光源进行了编号.由于这15个光源对被拍摄者的面部来说都具有很强的方向性,因此我们称这15个光源为方向光源.方向光源的分布示意图如图 所示.图 光照设备布局在多光照模式的拍摄过程中,首先关闭所有光源,每次只打开1个方向光源进行拍摄.每次变换方向光,9个摄像头都同时工作,采集9幅不同角度的面部图像.多光源分布环境结合多角度的摄像头系统,使得我们的光照变化图像更加丰富,有利于研究者研究多光照条件下的人脸识别问题.( )多饰物选择我们预备了 种不同样式的眼镜和 种不同样式的帽子,要求被采集者依次佩戴这 种饰物进行拍摄.每次更换饰物,9个摄像头均同时工作拍摄不同视角的图像.111期张晓华等:CA S -PEAL 大规模中国人脸图像数据库及其基本评测介绍(4)背景变化很多情况下,进行人脸识别时所用的摄像头被打开了自动白平衡功能.在遇到背景颜色变化的情况时,由于摄像头的白平衡功能,所摄取的图像会有较大的色彩变化.因此,我们在采集环境中设置了5种不同颜色的背景,默认的拍摄背景为蓝色;此外,在红色、黑色、黄色、白色背景条件下各进行了一次环境光照模式的图像拍摄.在多光照模式的拍摄情况下,我们也采用了白色背景.同样地,每次变换背景,9个摄像头同时拍摄不同视角图像.3C A S-P E A L人脸库图像变化模式介绍CA S-PEAL人脸库中总共包括1040人,99450幅人脸图像,这些图像可以划分为姿态、表情、背景、饰物、光照、距离和时间等7个子库.(1)姿态子库在环境光照模式下,要求志愿者变换平视、抬头、低头3种姿态分别进行拍摄,每次变换俯仰姿态时,多角度摄像头系统一次拍摄,可同时获得同一俯仰姿态下的、9幅水平深度旋转姿态变化的图像.因此,姿态子库中的每个志愿者有27幅环境光照模式下的标准姿态变化图像.姿态变化图像示例如图3所示.(2)表情子库环境光照模式下,要求志愿者做出笑、皱眉、惊讶、闭眼、张嘴5种表情,这5种都是造成面部特征变化比较大的表情,有利于研究人脸识别算法对表情变化的鲁棒性.表情子库的示例如图4所示.(3)饰物子库环境光照模式下,志愿者佩戴3种不同的帽子和3种不同的眼镜,如图5所示.图3每人的27幅姿态变化图像图4表情子库中5种不同的表情图5饰物子库中的3种帽子、3种眼镜饰物(4)光照子库采集光照子库图像时,环境光源关闭,每次打开一个方向光源进行图像采集,如图6所示.(5)背景子库5种不同的背景颜色包括蓝色、红色、黑色、白色和黄色.环境光照模式下,由于摄像头的白平衡功能,面部图像的色彩分布在每种背景颜色条件下均有不同,如图7所示.(6)距离子库环境光照模式下,改变志愿者与摄像头的相对距离,获取到距离子库中每个志愿者的3种不同距离的面部图像,其示例如图8所示.(7)时间跨度子库随着时间的改变,人的面部特征会有一定的变21计算机辅助设计与图形学学报2005年化.在我们的人脸库中,引入了时间跨度子库,子库中的志愿者图像距离他们第一次被采集的图像有6个月的时间跨度,其图像示例如图9所示.图6光照子库中的15种方向光图7背景子库中的蓝、红、黑、白、黄色5种背景图8距离子库中3种不同的距离下的图像图9时间跨度子库,第二行的图像为第一次采集6个月后再次拍摄的图像4CAS-PEAL-rl共享人脸库为了方便国内外人脸识别领域的研究者使用CA S-PEAL人脸库,我们提供了CA S-PEAL人脸库的共享版本CA S-PEAL-r1[15].CA S-PEAL-r1共享库包含1040人的30900幅图像,分为两个子库:正面图像子库和姿态图像子库.正面图像子库中包含1040人的共9060幅图像,其中的所有图像均由编号为!4的摄像头拍摄.子库中涉及的变化条件如表1所示,其中,377人有6种表情变化的图像,438人有6种面部饰物变化的图像,233人有至少9种光照变化的图像,297人有2!4种背景变化的图像,296人有1!2种距离变化的图像;此外,还有66人有2幅时间跨度变化的图像.表l CA S-PEAL-r l的正面图像子库和姿态子库的图像情况变化种类人数图像数目正面子库标准110401040表情5!3771884光照"92332450饰物64382646背景2!4297650距离1!2296324时间1!6666正面子库图像总数9060姿态子库21(3>7)104021840姿态子库图像总数21840!中性表情的标准正面图像没有包括在内311期张晓华等:CA S-PEAL大规模中国人脸图像数据库及其基本评测介绍姿态图像子库中包含1040人的共21840幅图像,每人21幅姿态变化的图像.姿态变化包括了3种俯仰姿态变化(抬头、平视、低头)和每种俯仰姿态下的7种水平深度旋转姿态变化.CA S-PEAL人脸库中的原图像为640>480像素,24位RGB色彩的BM P位图图像.为了方便图像的发布和共享,CA S-PEAL-R1库中的图像全部在原图像的基础上进行了处理.图像大小被裁剪为360>480像素,并去除了颜色信息转换为灰度图像,图像格式为BM P位图格式.这样,整个CA S-PEAL-R1库的数据量为5GB左右,其图像示例如图10!11所示.图10CA S-PEAL-R1正面图像子库中的图像示例图11CA S-PEAL-R1姿态图像子库中的图像示例5CAS-PEAL-rl建议评测协议人脸识别系统的评测工作的目的是为了评价各个识别系统的性能差距,并指导人脸识别领域未来的研究方向.要达到这个目的,评测方法的设计尤为重要.科学的评测方法应该能够解决著名的“三熊问题”(T hree bears p rob lem)[2],即对所有待测算法或系统来说,评测不能太难,以致超出了现有系统的识别能力;也不能太简单,使得对所有系统的测试结果都非常好.要解决“三熊问题”,就需要仔细地选择数据库并合理地制定评测协议.本节主要介绍我们建议的基于CA S-PEA L-R1的评测协议,包括标准训练、测试集合划分和评测性能指标等方面的内容.5.l CAS-PEAL-rl标准训练、测试集合划分根据待测试算法的特性,我们从CA S-PEAL-R1库中整理出了三个大的集合,分别作为训练集合(trai ni n g set)、原型图像集合(g aller y)和测试集合(p robe set).训练集合.除了模板匹配等少数简单算法,多数人脸识别算法都是需要进行训练的.因此,我们从正面子库中随机选择300人,每人随机选择4幅正面图像,共1200幅图像构成训练集.原型图像集合.提供给算法为待识别人员建立识别原型的图像子集,包含1040人,每人1幅标准正面图像(正面平视,环境光照,中性表情,无饰物);测试集合.提供给算法进行识别测试的图像子集.对于正面子库,测试集包括除去训练集和原型集以外余下的6992幅图像,分为表情变化、光照变化、饰物变化、背景变化、距离变化和时间跨度变化6个子集;对于姿态子库,测试集包括除去原型集中图像外的、水平深度姿态旋转在 30 以内的共21840幅姿态变化图像,分为低头、平视、抬头3个子集.考虑到算法泛化能力(也称推广能力)的问题,严格地讲,训练集合中的图像与测试集合和原型集合中的图像乃至人物应该是不能有重叠的.考虑到降低问题的难度,参照FERET的做法,我们的原型集合与训练集合中的图像有部分重复.而测试集合中的图像则与训练集合和原型集合中的图像都是严格没有重复的.上述3个子集的图像示例如图12! 15所示.图14测试集中的正面图像示例图12训练集中的图像示例图13原型集中的图像示例41计算机辅助设计与图形学学报2005年图15测试集中的姿态图像示例5.2算法性能测试指标在FERET 和FRVT 测试中,对测试结果的表示有比较详细说明[2-3].常用的表示不同系统间测试结果的方法有CM C (C lm l lative M atch C haracteristic )曲线和ROC (R eciei ver O p eration Characteristic )曲线.在我们的测试中,为了更方便、直观地表现各个系统在不同测试集合上的识别性能,仅选择了各个系统在每个测试集合上的首选识别率进行比较,并将测试结果综合到一个首选识别率柱状图中进行直观的对比.6CAS -PEAL -rl 上的基本评测情况6.l特征脸(E i g enface )算法和模板匹配(C o rre la tion )算法的评测设计E i g enf ace 算法和C orrelation 算法是人脸识别领域的两个基准算法,通过对这两个算法的测试,有助于检验CA S -PEAL 人脸库的基本难易程度.为了有效地去除背景、头发等因素的影响,我们把测试集中的图像根据双眼中心坐标位置进行了几何归一化处理,每幅人脸图像被裁剪并缩放到32>32像素大小.此外,为了进一步去除背景信息,我们在人脸上覆盖了一个掩模,使得每幅图像只包含了人脸内部特征区域,其最终的效果如图16!19所示.本文实验中的E i g enf ace 算法和C orrelation 算法都是在这样的图像基础上进行测试的.图18测试集合中正面图像示例(32>32)图16训练集合中图像示例(32>32)图17原型集合中的图像示例(32>32)图19测试集合中姿态图像示例(32>32)对于C o rre lation 算法,我们采用归一化的相关量计算方法来计算图像之间的相似度.对于E i g en face算法,其PCA (P ri nci p al C om p one m ent A nal y sis )变换矩阵是对CA S -PEAL -R1训练集中所有的1200幅图像进行特征值分解得到的,综合考虑计算速度和识别效果,我们的测试中所保留的主成分特征维数为600.6.2对商业系统的测试我们还同时对两个国外最优秀的商业人脸识别系统在CA S -PEAL -R1上的性能进行了初步评测(由于种种原因,我们不能公开这两个商业系统的名字,仅用系统!和系统"来分别表示).这两个系统的性能在已有的人脸识别商业系统中被认为是最好的,通过对这两个系统的评测,可以知道CA S -PEAL 人脸库和本文的测试方法对现有商业系统的难易度,同时可以发现更多值得进一步研究的课题方向和关键问题.系统!和系统"对测试图像的大小并没有特别要求,因此我们在测试过程中直接使用CA S -PEAL -R1库中的360>480像素大小的图像.两个系统的工作过程如下:S te p 1.依次读入原型集中的人脸图像和每个人脸图像的双眼位置坐标,建立每个人的原型模板.S te p 2.读入待识别图像#$,自动地在#$中检测人脸的位置并建立待识别模板,将待识别模板与原型模板进行比较,输出#$与每个原型的相似度,并最终通过相似度的排序来完成整个识别过程.6.3测试结果及分析我们将E i g enf ace 算法、C orrelation 算法、系统!和系统"的测试结果综合到一起,取测试结果的首选识别率进行比较,结果如图20,21所示.从E i g enf ace 算法和C orrelation 算法的测试结果不难看出,在正面子库上,E i g enf ace 和C orrelation 两种算法除了在背景和距离两个子集上达到或接近了80%的识别率之外,在表情子集上,两种算法的识别率不到60%,时间跨度子集上识别率不到50%,饰物子集上识别率不到40%,而光照子集上识别率还不到10%;在姿态子库上,两个算法对平视姿态变化的识别率都不到40%,而对俯仰姿态变化的识别率都不到10%.测试结果说明,E i g enf ace 算法和C orrelation 两个基准算法均不能很好地解决饰物、511期张晓华等:CA S -PEAL 大规模中国人脸图像数据库及其基本评测介绍表情、光照、时间跨度和姿态变化情况下的识别问题;对于背景和距离变化的情况,即使对图像事先进行了几何归一化处理和添加掩模,E i g enf ace算法和C orrelation算法的识别效果依然不能让人满意.图20CA S-PEAL-R1正面子库上的测试结果图21CA S-PEAL-R1姿态子库上的测试结果对商业系统的测试结果显示,在我们的6个测试子集中,表现最佳的系统B对表情、背景、距离和时间跨度几种变化的识别率已经接近100%,对饰物变化的识别率也已经超过80%.系统A尽管在饰物子集上的表现比较差,但在背景、表情和距离子集上的性能与系统B也差别不大.我们也看到,对正面子库中光照变化图像的识别率,表现最佳的系统B仍然达不到40%,系统A只有10%多一点.在姿态子库中,平视状态下水平姿态变化识别率最高只有60%,俯仰状态下的姿态变化识别率最高也仅40%上下.这些结果表明,优秀的商业系统尽管对环境光照模式下的正面图像的饰物、表情、背景、距离等变化情况已经能够较好地解决识别问题,但是对复杂光照和较大范围的姿态变化,其识别性能依然差强人意.由测试结果可以看出,在CA S-PEAL人脸库中,人脸识别的商业系统对于正面图像的表情、饰物、背景和距离等变化已经表现出了较强的鲁棒性,综合性能已经远远超出了基准的识别算法.但是,商业系统在光照和姿态子集上较差的性能也表明,如何提高光照变化条件下的正面图像识别率和姿态变化条件下的识别率,以及如何进一步提高光照与姿态组合变化条件下的识别率,这些问题还没有得到很好的解决,这将是今后人脸识别研究需要重点关注的问题.!总结及未来工作本文介绍了我们建立的CA S-PEAL人脸库的采集平台、创建过程和覆盖的图像变化条件.它提供了一个大型的、多样化的人脸图像数据资源,在一定程度上弥补了国内在大规模人脸数据库方面的不足.我们测试了E i g enf ace和C orrelation两种基准算法,以及两种商业系统在已经共享的CA S-PEAL-R1人脸库上的性能.结果表明:(1)E i g en face和C o rre lation算法在CA S-PEA L-R1人脸库上的识别性能非常差,这说明该人脸库具备了一定的难度;(2)两个最著名商业系统的识别性能远远高于基准算法,尤其是对表情、背景、距离变化的情况,取得了接近100%的正确识别率,这说明目前的人脸识别方法对于这些变化已经具备了良好的适应能力,而对饰物变化的鲁棒性还需要进一步的加强;(3)两个最著名的商业系统对光照、姿态变化的识别性能很不理想,这说明光照和姿态变化问题是人脸识别领域需要进一步研究的关键性问题;(4)光照和姿态两个子集不仅对于基准算法,而且对于优秀的商业系统也表现出了较大的难度,提供了一个光照和姿态变化的人脸图像数据平台,有望在今后对这两个方面的研究中得到进一步的应用.参考文献[1]Che lla pp a R,W ilson C L,S irohe y S.H u m an and m ach i ne reco g n ition of f aces:A surve y[J].P roceed i n g s o f t he I EEE,1995,83(5):704!741[2]Ph illi p s P Johnat hon,M oon H,R iZvi S y ed A,G IO I.T he FERET evaluation m et hodo lo gy f or f ace-reco g n ition al g orit h m s[J].I EEE T ransactions on Pattern A nal y s is and M ach i neInte lli g ence,2000,22(10):1090!110461计算机辅助设计与图形学学报2005年。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中国面孔表情图片系统的修订

龚栩;黄宇霞;王妍;罗跃嘉

【期刊名称】《中国心理卫生杂志》

【年(卷),期】2011(025)001

【摘要】目的:扩展本土化的中国面孔表情图片系统以提供情绪研究的取材.方法:采用方便取样.从北京2所高等艺术院校的表演系、导演系选取100名学生,作为面孔表情表演者;从北京2所普通高等院校招募100名学生,作为面孔表情评分者.采集表演者的愤怒,厌恶,恐惧,悲伤,惊讶,高兴和平静7种面孔表情图片,再由评分者对图片进行情绪类别的判定和情绪强烈程度的9点量表评分,扩展各种情绪类型的图片数量.然后,从北京3所普通高校戏剧社社员中选取100名学生,从北京某社区选取老年人、儿童各10名,作为面孔表情表演者;另从北京2所普通高等院校招募100名学生,作为面孔表情评分者.进一步扩展负性图片的数量(如,愤怒,厌恶,恐惧,悲伤),并补充一些其他年龄段的图片.结果:得到具有代表性的7种情绪类型的面孔表情图片共870张,每张图片都有其对应的认同率和情绪强度评分,其中,愤怒74张,厌恶47张,恐惧64张,悲伤95张,惊讶120张,高兴248张,平静222张.结论:本研究初步建立了信度较高的中国人面孔表情图片系统,可作为以后情绪研究的选取材料,本系统有待进一步完善.

【总页数】7页(P40-46)

【作者】龚栩;黄宇霞;王妍;罗跃嘉

【作者单位】北京师范大学认知神经科学与学习国家重点实验室,北京,100875;北京师范大学认知神经科学与学习国家重点实验室,北京,100875;中国科学院心理研

究所心理健康重点实验室,北京,100101;北京师范大学认知神经科学与学习国家重点实验室,北京,100875;中国科学院心理研究所心理健康重点实验室,北京,100101【正文语种】中文

【中图分类】G449;B842.6

【相关文献】

1.场景情境与面孔表情图片诱发ERP的早中期成分差异性研究 [J], 王欣;靳静娜;李松;刘志朋;殷涛

2.制备中国人物静态面部表情图片及信度效度的初探 [J], 顾莉萍;静进;金宇;徐桂凤;梁华妮;黄赛君;杨文翰;五十岚一枝

3.来自第19届中国国际服装服饰博览会的报道老面孔国产大品牌“借壳”走出去新面孔陌生洋品牌“借势”涌进来 [J], 罗书宏

4.老标准新面孔——ISO 9001标准修订的主要看点 [J], 保罗·潘斯; 刘健

5.简笔画面孔正倒立表情图片识别N170的特征分析 [J], 陆雪松;何逸康;周曙;王红星;刘艳丽;洪忠贤;王锦玉

因版权原因,仅展示原文概要,查看原文内容请购买。