Boosting 自下而上和自上而下的视觉特征的显著性估计.

集成学习Boosting算法综述

集成学习Boosting算法综述一、本文概述本文旨在全面综述集成学习中的Boosting算法,探讨其发展历程、基本原理、主要特点以及在各个领域的应用现状。

Boosting算法作为集成学习中的一类重要方法,通过迭代地调整训练数据的权重或分布,将多个弱学习器集合成一个强学习器,从而提高预测精度和泛化能力。

本文将从Boosting算法的基本概念出发,详细介绍其发展历程中的代表性算法,如AdaBoost、GBDT、GBoost等,并探讨它们在分类、回归等任务中的性能表现。

本文还将对Boosting算法在各个领域的应用进行综述,以期为读者提供全面、深入的Boosting 算法理解和应用参考。

二、Boosting算法概述Boosting算法是一种集成学习技术,其核心思想是将多个弱学习器(weak learner)通过某种策略进行组合,从而形成一个强学习器(strong learner)。

Boosting算法的主要目标是提高学习算法的精度和鲁棒性。

在Boosting过程中,每个弱学习器都针对前一个学习器错误分类的样本进行重点关注,从而逐步改善分类效果。

Boosting算法的基本流程如下:对训练集进行初始化权重分配,使得每个样本的权重相等。

然后,使用带权重的训练集训练一个弱学习器,并根据其分类效果调整样本权重,使得错误分类的样本权重增加,正确分类的样本权重减少。

接下来,使用调整后的权重训练下一个弱学习器,并重复上述过程,直到达到预定的弱学习器数量或满足其他停止条件。

将所有弱学习器进行加权组合,形成一个强学习器,用于对新样本进行分类或预测。

Boosting算法有多种变体,其中最具代表性的是AdaBoost算法。

AdaBoost算法采用指数损失函数作为优化目标,通过迭代地训练弱学习器并更新样本权重,逐步提高分类精度。

还有GBDT(Gradient Boosting Decision Tree)、GBoost、LightGBM等基于决策树的Boosting算法,它们在处理大规模数据集和高维特征时表现出良好的性能。

Boosting 自下而上和自上而下的视觉特征的显著性估计

二、学习一个视觉显著性的模型

另一个重要特点是在前中心的基础上发现的:大多数的录 制品在中心附近发生的图像(即中心偏置[39])。与基线 的方法进行公平比较的分类(AWS和GBVS模型),我们 在这里单独对待中心功能。根据公式2,我们把每个模型 的显著性图与p(s|x)相乘,p(s|x)是每个像素打牌中 心的距离。 最终,所有的特点都变成34(30自底向上+4自上而下) 向量(不含中心),被送入分类器(在下一节中解释)。

www.themegallerLeabharlann

二、学习一个视觉显著性的模型

与手动设计显著性措施相比,我们按照训练分类的一种学 习方式,直接从人眼跟踪数据。其基本思路是的加权组合 的功能,其中权重学会从一个大的库对自然图像的眼球运 动,可以增强显著性检测比未经调整组合特征映射。学习 方法也有容易适用于通过提高要素权重目标对象的可视化 搜索的好处。 在下面,我们提出了一个朴素贝叶斯公式的显著性估计。 让我们是一个二元变量表示的显著位置的图像像素X =(X ,Y)与特征向量f,其中“s等于1”表示这个像素是突出 的(也就是说,它可以吸引人类的眼睛)和零。像素x的 概率是显著的可写为:

Boosting Bottom-up and Topdown Visual Features for Saliency Estimation

Boosting 自下而上和自上而下的视觉特征的显

著性估计

LOGO

主要内容

1 2 摘要 一、简介

3

4

二、学习一个视觉显著性的模型

三、实验程序

本节对分类和功能提出一个全面的评估。 在这里,我们不仅评估了我们的模型,也比较几款模型以 供日后参考。我们能够运行27个显著性模型。此外,我们 还实施了其他两个简单但功能强大的模型:Gaussian Blob和人类中间观察者模型。Gaussian Blob的是一个简 单的2D高斯形状的绘制图像的中心,它是预期预测人的 目光,以及如果这样的凝视强烈图像中心的周围聚集。对 于一个给定的刺激,当他们观看刺激时,中间观察员的模 型输出一个通过整合比其他物体测试的地图。模型地图可 以根据记录眼球运动来调整原始图像的大小。

基于Boosting算法的特征选择研究

基于Boosting算法的特征选择研究一、引言特征选择是机器学习和数据挖掘领域的重要问题之一。

在构建模型和分析数据时,通常会遇到大量的特征。

然而,不是所有的特征都对模型的性能有贡献。

因此,特征选择的目标是从大量的特征中筛选出最具有信息量的特征,提高模型性能和数据分析的效率。

Boosting算法作为一种常用的机器学习方法,近年来在特征选择问题中得到了广泛的应用。

本文将介绍基于Boosting算法的特征选择研究,探讨其原理、方法和应用。

二、Boosting算法的原理与方法Boosting算法是一种综合多个弱分类器的算法,通过串行训练弱分类器并加权组合它们的结果,不断提高整体模型的性能。

在特征选择问题中,Boosting算法可以通过优化特征的权重来选择最具有区分性的特征。

具体而言,Boosting算法的基本步骤包括初始化权重、训练弱分类器、计算错误率、更新样本权重以及组合弱分类器等。

三、基于Boosting算法的特征选择方法1. Adaboost算法Adaboost是最早提出的Boosting算法之一,也是应用最为广泛的特征选择方法之一。

Adaboost通过迭代训练多个弱分类器,并根据分类器的分类错误率来更新样本的权重。

在每轮迭代中,Adaboost会增加错误分类样本的权重,减少正确分类样本的权重,使得后续的弱分类器更加关注那些分类错误的样本。

通过加权组合多个弱分类器的结果,Adaboost能够得到更准确的分类结果,并选择出最重要的特征。

2. Gradient Boosting算法Gradient Boosting是一种更加强大和灵活的Boosting算法。

与Adaboost不同,Gradient Boosting在每轮迭代中不仅仅关注样本的分类结果,还考虑样本的梯度信息。

通过最小化损失函数的负梯度来训练下一个弱分类器,并通过加权组合多个弱分类器的结果来提高模型的性能。

Gradient Boosting在特征选择中具有很强的灵活性,可以适应不同的问题和数据集。

人工智能之模式识别_北京理工大学中国大学mooc课后章节答案期末考试题库2023年

人工智能之模式识别_北京理工大学中国大学mooc课后章节答案期末考试题库2023年1.采用非线性激活函数可以实现感知器解决非线性分类问题。

参考答案:错误2.下列关于最大池化的说法中错误的是?参考答案:LeNet采用的是最大池化方法3.填充树法由顶向底的方法和由底向顶填充相反。

参考答案:正确4.语言可以是无限的但是句子必须是有限的。

参考答案:正确5.文法是由下列哪些参数构成的?参考答案:起始符S_终止符V_T_非终止符V_N_产生式P6.感知器算法应用什么方法求解准则函数的最优值?参考答案:梯度下降法7.下列关于对比散度算法的说法中错误的是?参考答案:深度信念网中多层受限玻尔兹曼机同时通过对比散度算法完成预训练8.下列选项中,属于模式识别系统的环节是?参考答案:分类器训练_模式采集_分类决策_预处理与特征生成9.分类器函数的VC维h越大,将使下列选项中的哪些数据发生变化?参考答案:置信风险越大_结构风险越大_分类器泛化能力越差10.利用SVM将低维空间中的非线性问题映射到高维空间,存在哪些问题?参考答案:不确定需要映射到多少维的空间上,非线性问题才会转化为线性问题_如何找到合适的映射函数φ_增加计算量,可能会因为维数灾难无法解决11.本课程中介绍的与句法模式识别相关的基本概念有?参考答案:字母表_句子(链)_文法_语言12.下列选项中属于贝叶斯分类器的特点的是?参考答案:分类决策存在错误率_先验概率已知,以新获得的信息对先验概率进行修正13.贝叶斯分类器的训练,是从样本集数据中估计出____。

参考答案:类条件概率_先验概率14.下列选项中属于特征降维的优点的是?参考答案:降低模式识别任务的复杂度_提升分类决策的正确率_用更少的代价设计出更加优秀的模式识别系统15.下列说法中正确的是?参考答案:聚类结果受特征选取和聚类准则的影响_数据聚类没有预先分好类的样本集_聚类结果受各特征量纲标尺的影响_数据聚类没有已知的分类决策规则16.设计一个组合分类器需要满足什么要求?参考答案:每个基分类器的训练集和训练结果要有差异_组合分类器需要重点考虑方差和偏差_基分类器的分类正确率大于50%17.下列选项中属于决策树分类器的特点的是?参考答案:需选择分支后两个子节点纯度最高的特征作为一个节点的测试特征_速度快,分类决策规则明确_未考虑特征间的相关性_有监督学习方法18.下列选项中属于Adaboost算法的特点的是?参考答案:异常数据(离群点)影响大_不易实现并行化训练_只能解决二分类问题_算法的组合过程能减小偏差19.下列选项中属于反馈型神经网络的是?参考答案:Hopfield网络_受限玻尔兹曼机20.调节以下哪些部分可以对神经网络的性能造成影响?参考答案:权值_激活函数_隐层单元_阈值21.下列选项中关于前馈网络和反馈网络的说法中正确的是?参考答案:前馈网络输出不作用在网络的输入中_前馈网络为静态网络_反馈网络下一时刻的输出与上一时刻的输出有关_反馈网络为动态网络22.下列选项中属于BP网络的不足的是?参考答案:容易陷入局部极小值_全连接网络计算大_隐层神经元数量难以确定_无法做到深度很深,会产生梯度消失23.下列选项中属于深度学习的特点的是?参考答案:需要大量样本进行训练_逐层抽象,发现数据集的特征_是层数较多的大规模神经网络_需要大规模并行计算能力的支持24.利用链式求导法则需要哪些信息?参考答案:损失函数与网络输出向量之间的函数关系_激活函数输出对净激励的导数25.深度信念网不能用于图像识别的原因是?参考答案:深度信念网为一维向量输入,不能直接用于二位图像_需要进行认知-重构的双向计算,学习速度不够快_受限玻尔兹曼机的层间全连接,权值数量太多26.Jp作为类内、类间可分性的概率距离度量时应该满足下列选项中哪些条件?参考答案:当两类完全不可分时,Jp等于0_当两类完全可分时,Jp取得最大值27.特征选择的算法包括以下哪些?参考答案:分支定界法_顺序后退法_穷举法_顺序前进法28.特征降维的方法包括特征选择和特征提取。

Boosting原理及应用

Boosting原理及应用[object Object]Boosting是一种用于提升机器学习模型性能的集成学习方法,它通过训练一系列弱分类器,并将它们组合成一个强分类器。

Boosting的原理是通过迭代的方式,逐步改进弱分类器的性能,使得它们在错误分类的样本上有更高的权重,从而达到提升整体分类性能的目的。

Boosting的核心思想是将多个弱分类器进行加权组合,使得它们能够协同工作,并形成一个更强大的分类器。

在每一轮迭代中,Boosting会根据上一轮分类器的性能调整样本权重,使得对错误分类的样本施加更高的权重,从而在下一轮中更加关注这些难以分类的样本。

这种迭代的过程会一直进行,直到达到一定的迭代次数或者分类器的性能不再提升为止。

1. Adaboost(Adaptive Boosting):Adaboost是Boosting算法最经典的实现之一,它通过迭代的方式训练一系列弱分类器,并将它们加权组合成一个强分类器。

Adaboost的特点是能够适应不同的数据分布,对于难以分类的样本会给予更高的权重,从而提升整体的分类性能。

2. Gradient Boosting:Gradient Boosting是一种通过梯度下降的方式逐步优化模型性能的Boosting算法。

它的核心思想是在每一轮迭代中,计算损失函数的负梯度,并将其作为下一轮训练样本的权重调整。

通过迭代的方式,逐步改进弱分类器的性能,从而提升整体的分类准确率。

3. XGBoost(eXtreme Gradient Boosting):XGBoost是Gradient Boosting的一种优化实现,它在Gradient Boosting的基础上引入了一些创新的技术,如正则化、缺失值处理和并行计算等。

XGBoost在很多机器学习竞赛中取得了优秀的成绩,并被广泛应用于各种实际问题中。

4. LightGBM:LightGBM是一种基于梯度提升树的Boosting算法,它在XGBoost的基础上进行了一些改进,使得它能够更快地训练模型,并具有更低的内存消耗。

集成学习之Boosting——GradientBoosting原理

集成学习之Boosting——GradientBoosting原理集成学习之Boosting —— Gradient Boosting原理上⼀篇介绍了AdaBoost算法,AdaBoost每⼀轮基学习器训练过后都会更新样本权重,再训练下⼀个学习器,最后将所有的基学习器加权组合。

AdaBoost使⽤的是指数损失,这个损失函数的缺点是对于异常点⾮常敏感,(关于各种损失函数可见之前的⽂章:),因⽽通常在噪⾳⽐较多的数据集上表现不佳。

Gradient Boosting在这⽅⾯进⾏了改进,使得可以使⽤任何损失函数 (只要损失函数是连续可导的),这样⼀些⽐较robust的损失函数就能得以应⽤,使模型抗噪⾳能⼒更强。

Boosting的基本思想是通过某种⽅式使得每⼀轮基学习器在训练过程中更加关注上⼀轮学习错误的样本,区别在于是采⽤何种⽅式?AdaBoost采⽤的是增加上⼀轮学习错误样本的权重的策略,⽽在Gradient Boosting中则将负梯度作为上⼀轮基学习器犯错的衡量指标,在下⼀轮学习中通过拟合负梯度来纠正上⼀轮犯的错误。

这⾥的关键问题是:为什么通过拟合负梯度就能纠正上⼀轮的错误了?Gradient Boosting的发明者给出的答案是:函数空间的梯度下降。

函数空间的的梯度下降这⾥⾸先回顾⼀下梯度下降 (Gradient Descend)。

机器学习的⼀⼤主要步骤是通过优化⽅法最⼩化损失函数L(θ),进⽽求出对应的参数θ。

梯度下降是经典的数值优化⽅法,其参数更新公式:θ=θ−α⋅∂∂θL(θ)Gradient Boosting 采⽤和AdaBoost同样的加法模型,在第m次迭代中,前m-1个基学习器都是固定的,即f m(x)=f m−1(x)+ρm h m(x)因⽽在第m步我们的⽬标是最⼩化损失函数L(f)=N∑i=1L(y i,f m(x i)),进⽽求得相应的基学习器。

若将f(x)当成参数,则同样可以使⽤梯度下降法:f m(x)=f m−1(x)−ρm⋅∂∂f m−1(x)L(y,f m−1(x))对⽐式 (1.2)和 (1.3),可以发现若将h m(x)≈−∂L(y,f m−1(x))∂f m−1(x),即⽤基学习器h m(x)拟合前⼀轮模型损失函数的负梯度,就是通过梯度下降法最⼩化L(f) 。

掌握机器学习中的集成学习和深度强化学习算法

掌握机器学习中的集成学习和深度强化学习算法集成学习和深度强化学习是机器学习领域中的两个重要研究方向。

本文将介绍集成学习和深度强化学习的基本概念、算法原理和应用领域。

一、集成学习集成学习(Ensemble Learning)是一种通过结合多个基学习器来提高机器学习算法性能的方法。

集成学习的基本思想是“三个臭皮匠,赛过诸葛亮”,通过将多个弱学习器集合在一起,形成一个强学习器,从而提高预测性能。

常见的集成学习方法包括投票法、平均法和Bagging、Boosting 等。

投票法是指通过多个弱学习器进行投票来决定最终的预测结果。

平均法则是将多个弱学习器的预测结果进行平均,作为最终的预测结果。

而Bagging和Boosting是将多个基学习器进行整合,分别通过并行和串行的方式进行训练,从而提高模型的泛化能力。

集成学习的应用非常广泛,其中最著名的应用之一是随机森林(Random Forest)。

随机森林是一种基于决策树的集成学习算法,通过多个决策树的投票或平均来进行分类或回归任务。

随机森林具有较强的鲁棒性和泛化能力,在各种实际应用中取得了良好的效果。

二、深度强化学习深度强化学习(Deep Reinforcement Learning)是结合深度学习和强化学习的一种方法。

强化学习是一种通过智能体在环境中执行动作并得到奖励信号,以达到最大化累积奖励的学习方法。

深度学习则是一种模仿人脑神经网络的学习方法,利用多层神经网络对输入特征进行高层抽象和表示学习。

深度强化学习的核心是使用深度神经网络来近似值函数或者策略函数。

一种经典的深度强化学习算法是深度Q网络(Deep Q-Network,DQN)。

DQN通过深度神经网络来逼近动作值函数(Q函数),从而实现智能体在环境中选取最优动作。

DQN具有较强的逼近能力和泛化能力,在很多领域,特别是游戏领域取得了非常好的效果。

深度强化学习在很多领域都有着广泛的应用。

例如,在机器人领域,深度强化学习可以用于实现机器人的自主导航和控制;在自然语言处理和机器翻译领域,深度强化学习可以用于语言模型的训练和优化;在金融领域,深度强化学习可以通过学习交易模式来进行股票交易。

视觉显著性算法概述

• 其中 为使用者设定的延迟因子。

PQFT模型

• 四元组图像可以表示为下列形式

q(t ) M (t ) RG(t )1 BY (t )2 I (t )3

其中 i , i 1,2,3,满足 i2 1 ,2 3 , 1 3 , 3 12 1 2 , q(t ) 可以写成如下形式

• 其中 I 为图像特征的几何平均向量, I hc 为对原始 图像的高斯模糊,采用 5 的二项式核。 5 为 L2 范数, x, y为像素点坐标 。

SR模型

• SR(Spectral Residual)模型是由Hou等人提出 来的,基于空间频域分析的算法之一,显著 R( f ) 图通过对剩余谱 做傅里叶逆变换得到。 • 剩余谱 定义为

S (Ik )

• 其中D( I k , Ii )为像素在Lab空间的颜色距离度量。如果 忽略空间关系,使得具有相同颜色的像素归到一起 ,得到每一个颜色的显著性值

S ( I k ) S (cl ) f j D(cl , c j )

FTS模型

• FTS(Frequency-Tuned Saliency)模型是由Achanta 等人提出的一种自底向上的显著性检测方法,通 过局部颜色和亮度特征的对比多尺度方法求像素 点显著值。 • 将原始图像由SRGB颜色空间转化成CIE颜色空间, 然后显著性映射定义为

S ( x, y ) I I hc

I ( x ) log( p ( x )) 为特征的概率密度函数。

p( x)

GBVS模型

• GBVS(Graph-Based Visual Saliency)模型是 在Itti的模型基础之上运用马尔可夫随机场 的特点构建二维图像的马尔可夫链,通过 求其平衡分布而得到显著图 • 算法步骤:

Boosting算法

Boosting算法Boosting算法也是一种基于数据集重抽样的算法,与Bagging 算法主要区别在于,需要动态调整训练样本中各数据权重,每一次迭代增加不能被正确学习的样本权重,相对地降低了能被正确学习的样本权重,从而提升在整个训练样本数据集上的学习正确率。

一、Boosting算法流程与Bagging算法不同,Boosting算法第一次构建基学习器时给每一个训练数据样本赋予动态权重,增加分类错误样本权重。

在下一次,基学习器采用新的样本权重进行随机抽样构建新的基学习器并以此类推构建多个基学习器,直到递进生成的基学习器精度不再明显提升或满足精度需求,最后这多个基学习器形成一个精度较高的强学习器。

为了控制集成学习模型复杂度,通过动态权重降低了高精度分类样本的权重,有效控制了最终学习器的样本数量,从而控制了集成学习模型复杂度。

为了提升集成模型的差异化,Boosting算法是一种逐步递进的方法,每一个学习器都是前一个学习器通过调整样本权重的改进模型,不存在两个相同的基学习器。

Boosting算法问题在于,更多关注不能正确分类样本数据,对于边界样本会导致权重失衡,产生“退化问题”。

Boosting算法的原理示意图如图7-5所示。

图7-5 Boosting算法的原理示意图Boosting算法最典型的是Adaptive Boosting算法,简称AdaBoost算法,其基本流程描述如下。

从“偏差-方差分解”的角度看,Boosting算法主要提升基学习器的准确率,降低偏差,因此,Boosting算法能基于泛化性能相当弱的学习器构建出很强的集成。

二、Boosting系列算法Boosting算法包括以梯度提升为核心方法的系列算法,主要包括前面介绍的调整错分样本权重的AdaBoost算法、以决策树为基函数的Boosting Tree算法、利用损失函数的负梯度在当前模型的值作为回归问题提升树算法中残差的近似值的GBDT算法、大规模并行Boosting Tree的XGBoost算法。

boosting分类

boosting分类摘要:1.Boosting 分类简介2.Boosting 分类的核心思想3.Boosting 分类的方法4.Boosting 分类的优缺点5.Boosting 分类的应用实例正文:Boosting 分类是一种集成学习方法,其核心思想是通过组合多个基本分类器来提高分类准确率。

这种方法主要应用于二分类问题,例如文本分类、图像分类等。

Boosting 分类的核心思想是加权训练样本。

在每一轮训练中,Boosting 算法会根据样本的权重来调整训练样本,使得分类器更加关注那些容易被误分类的样本。

这样,当多个基本分类器组合起来时,它们可以相互补充,从而提高分类准确率。

Boosting 分类的方法主要包括三种:AdaBoost、Gradient Boosting Machine (GBM) 和XGBoost。

AdaBoost 是一种基于梯度的Boosting 方法,其主要思想是在每一轮训练中,根据样本的权重来调整基本分类器的权重。

GBM 是另一种基于梯度的Boosting 方法,它使用了树模型,可以处理更复杂的数据结构。

XGBoost 是GBM 的优化版本,它使用了更加高效的算法,可以更快地训练模型。

Boosting 分类的优点是它可以提高分类准确率,尤其是在处理大量数据时。

此外,Boosting 分类方法也相对简单,易于实现和理解。

然而,Boosting 分类也存在一些缺点,例如它可能会过拟合,导致在测试集上的表现不佳。

一个典型的Boosting 分类应用实例是文本分类。

例如,我们可以使用Boosting 分类来对新闻文章进行分类,根据它们的主题将它们分为不同的类别。

这样,我们就可以根据分类结果来推荐相关的新闻给读者。

另一个应用实例是图像分类,例如,我们可以使用Boosting 分类来对图片进行分类,根据它们的内容将它们分为不同的类别。

梯度boosting算法 原理及应用

梯度boosting算法原理及应用梯度提升算法(Gradient Boosting)是一种集成学习方法,它通过串行地训练一系列的弱学习器,并寻找下一个学习器的方向来最小化损失函数。

其原理主要通过梯度下降来进行模型训练。

梯度提升算法的步骤如下:1. 初始化模型,可以是一个简单的初始预测值,比如用训练集的均值来初始化。

2. 计算当前模型的损失函数的梯度和对应的残差。

损失函数可以根据具体任务选择,比如平方误差损失函数用于回归问题,对数损失函数用于二分类问题等。

3. 使用一个弱学习器来拟合当前模型的残差。

弱学习器可以选择决策树等简单的模型。

4. 更新模型,在当前模型的基础上添加一个新的弱学习器,通过寻找残差在新学习器上的梯度方向来更新模型。

5. 重复步骤2-4,直到达到预定的学习器个数或者达到某个停止条件。

6. 将所有弱学习器的预测结果叠加起来,得到最终的模型预测结果。

梯度提升算法的优点主要体现在以下几个方面:1. 高预测精度:梯度提升算法能够通过不断拟合残差来提高模型的预测精度,尤其是在数据集复杂、噪音较大的情况下表现出色。

2. 可解释性:梯度提升算法可以基于决策树等简单模型进行拟合,使得最终的模型具有较强的可解释性,可以帮助分析数据的特征重要性等问题。

3. 损失函数灵活性:梯度提升算法可以根据不同任务选择合适的损失函数,适用于回归、分类和排名等各种场景。

梯度提升算法有广泛的应用领域,包括但不限于以下几个方面:1. 预测建模:梯度提升算法在预测建模中广泛应用,比如房价预测、用户购买意向预测等任务。

它能够通过不断拟合残差来提高模型的预测精度。

2. 金融风控:在金融领域,梯度提升算法被广泛应用于风控模型的建设。

通过分析用户的历史行为数据,预测用户的信用违约风险,提高风控能力。

3. 推荐系统:在推荐系统中,梯度提升算法可以通过分析用户的历史行为记录,建立用户画像并预测用户的兴趣偏好,从而提供个性化的推荐服务。

集成学习Boosting算法综述

集成学习Boosting算法综述集成学习是当前机器学习领域的一个重要研究方向,而Boosting算法则是集成学习中一类重要的方法。

Boosting算法的主要思想是通过多个弱学习器的组合来提高预测精度和稳定性,从而更好地解决分类和回归问题。

在本篇文章中,我们将对Boosting算法进行综述,介绍其基本理论、应用领域、评价与展望,以及未来的发展趋势。

Boosting算法的基本理论可以追溯到1990年代,当时一些学者发现将多个弱学习器组合起来可以显著提高预测精度。

Boosting算法基于这一思想,通过迭代地训练弱学习器和调整其权重,使得整个集成学习器的性能优于单个学习器。

Boosting算法的优化思想主要是通过调整样本数据的权重分布,使得每个弱学习器都能够专注于之前学习器难以处理的样本,从而降低错误率。

在模型建立方面,Boosting 算法通常采用基于决策树的弱学习器,但也可以使用其他类型的弱学习器。

Boosting算法在机器学习、数据挖掘和自然语言处理等领域都有广泛的应用。

在机器学习领域,Boosting算法被广泛应用于图像分类、语音识别、自然语言处理等任务。

例如,AdaBoost算法被用于人脸检测和识别,以及文本分类任务中。

在数据挖掘领域,Boosting算法被应用于关联规则挖掘、聚类分析等任务,如Adaboost.M1算法被用于挖掘频繁项集。

在自然语言处理领域,Boosting算法被应用于词性标注、命名实体识别等任务,如朴素贝叶斯分类器被作为弱学习器,通过Boosting算法提高其性能。

对于Boosting算法的评价,我们可以看到其具有以下优点:提高预测精度:通过多个弱学习器的组合,Boosting算法能够降低错误率,提高预测精度。

稳定性高:Boosting算法对数据集的初始分布和噪声干扰不敏感,具有较好的稳定性。

容易实现:Boosting算法的实现比较简单,可以方便地与其他机器学习算法进行结合。

boosting方法

boosting方法[object Object]Boosting方法是一种集成学习方法,通过组合多个弱学习器来构建一个强学习器。

它通过迭代的方式逐步提升学习器的性能。

本文将详细介绍Boosting方法的原理、算法和应用。

一、原理Boosting方法的原理基于两个主要观点:一是通过组合多个弱学习器可以构建出一个强学习器;二是通过关注错误样本,不断调整学习器的权重,可以提高学习器的性能。

Boosting方法的基本思想是将多个弱学习器进行线性组合,每个弱学习器的权重由其在前一轮迭代中的错误率决定。

在每一轮迭代中,Boosting方法根据样本的权重进行训练,并根据分类错误的样本调整权重。

通过这种方式,Boosting方法能够逐步减少错误样本的权重,提高学习器的准确性。

二、算法Boosting方法的经典算法有AdaBoost和Gradient Boosting。

1. AdaBoost(Adaptive Boosting)AdaBoost是最早提出的Boosting方法之一、它的核心思想是通过迭代的方式,训练一系列弱学习器,并将它们进行线性组合。

在每一轮迭代中,AdaBoost会根据前一轮迭代中的错误率调整样本的权重,使得错误率高的样本得到更多的关注。

最终,AdaBoost将得到一个强学习器,它的性能优于单个弱学习器。

2. Gradient BoostingGradient Boosting是另一种常用的Boosting方法。

它通过迭代的方式训练一系列弱学习器,并将它们进行线性组合。

与AdaBoost不同的是,Gradient Boosting使用梯度下降的方法来调整学习器的权重。

在每一轮迭代中,Gradient Boosting会计算样本的残差,并将残差作为下一轮迭代的目标。

通过这种方式,Gradient Boosting能够逐步减少残差,提高学习器的准确性。

三、应用Boosting方法在机器学习领域有广泛的应用。

Boosting算法简介

Boosting算法简介分类:机器学习2012-01-06 10:48 1044人阅读评论(1) 收藏举报算法框架任务测试c网络一、Boosting算法的发展历史Boosting算法是一种把若干个分类器整合为一个分类器的方法,在boosting算法产生之前,还出现过两种比较重要的将多个分类器整合为一个分类器的方法,即boostrapping 方法和bagging方法。

我们先简要介绍一下bootstrapping方法和bagging方法。

1)bootstrapping方法的主要过程主要步骤:i)重复地从一个样本集合D中采样n个样本ii)针对每次采样的子样本集,进行统计学习,获得假设H iiii)将若干个假设进行组合,形成最终的假设H f inaliv)将最终的假设用于具体的分类任务2)bagging方法的主要过程主要思路:i)训练分类器从整体样本集合中,抽样n* < N个样本针对抽样的集合训练分类器C iii)分类器进行投票,最终的结果是分类器投票的优胜结果但是,上述这两种方法,都只是将分类器进行简单的组合,实际上,并没有发挥出分类器组合的威力来。

直到1989年,Yoav Freund与Robert Schapire提出了一种可行的将弱分类器组合为强分类器的方法。

并由此而获得了2003年的哥德尔奖(Godel price)。

Schapire还提出了一种早期的boosting算法,其主要过程如下:i)从样本整体集合D中,不放回的随机抽样n1 < n个样本,得到集合D1训练弱分类器C1ii)从样本整体集合D中,抽取n2 < n个样本,其中合并进一半被C1分类错误的样本。

得到样本集合D2训练弱分类器C2iii)抽取D样本集合中,C1和C2分类不一致样本,组成D3训练弱分类器C3iv)用三个分类器做投票,得到最后分类结果到了1995年,Freund and schapire提出了现在的adaboost算法,其主要框架可以描述为:i)循环迭代多次更新样本分布寻找当前分布下的最优弱分类器计算弱分类器误差率ii)聚合多次训练的弱分类器在下图中可以看到完整的adaboost算法:图1.1 adaboost算法过程现在,boost算法有了很大的发展,出现了很多的其他boost算法,例如:logitboost 算法,gentleboost算法等等。

Boosting算法

经被准确地分类,那么在构造下一个 训练集中,它的权重就降低;相反, 如果某个样本点没有被准确地分类, 那么它的权重就得到提高。 ❖ 权重更新过的样本集被用于训练下一 个分类器,整个训练过程如此迭代地 进行下去

Ut = (1,1,1) Ut = ( 2,1,0 )

A C

B

A A

B

MOST

© 2020 Companyname PowerPoint Business Theme. All Rights Reserved.

11

更新样本权值

Adaptive Boosting

❖ 使分类器之间的差别越大越好 ❖ Gt这个模型在使用U(t+1)n的时候得到的error很大,即预测效果非常不好,那就表示由U(t+1)n计算的Gt+1会与Gt

8

概述

Boosting方法思想

❖ 通过对样本集的操作获得样本子集,然后用弱分类算法在样本子集上训练生成一系列的基分类器。他可以用来提高其他弱分 类算法的识别率,也就是将其他的弱分类算法作为基分类算法放于Boosting 框架中,通过Boosting框架对训练样本集的操作, 得到不同的训练样本子集,用该样本子集去训练生成基分类器;每得到一个样本集就用该基分类算法在该样本集上产生一个基 分类器,这样在给定训练轮数 n 后,就可产生 n 个基分类器,然后Boosting框架算法将这 n个基分类器进行加权融合,产生一个 最后的结果分类器,在这 n个基分类器中,每个单个的分类器的识别率不一定很高,但他们联合后的结果有很高的识别率,这样 便提高了该弱分类算法的识别率。在产生单个的基分类器时可用相同的分类算法,也可用不同的分类算法,这些算法一般是不 稳定的弱分类算法,如神经网络(BP) ,决策树(C4.5)等。

bootstrap法

bootstrap法Bootstrap法,也称为自助法,是一种统计学方法,用于估计样本数据的统计量和置信区间。

它的主要思想是通过从样本中重复抽取数据来创建新的样本集,从而获得对总体的估计。

Bootstrap法最早由布莱曼(Bradley Efron)在1979年提出,是一种非参数统计方法。

它的优点是可以用于任何类型的数据,包括连续型、离散型、偏态分布等。

由于它的普适性和易于实现,Bootstrap 法已经成为了统计学中常用的方法之一。

Bootstrap法的基本思想是:根据已有的样本数据,进行有放回的抽样,得到与原始样本数据大小相等的新样本。

这个过程重复进行n次,得到n个新样本。

对于每个新样本,我们可以计算出所关心的统计量(如均值、方差、中位数等)的值,从而得到n个统计量。

这些统计量的分布就是原始样本数据中该统计量的抽样分布,可以用于估计总体的统计量。

Bootstrap法的具体步骤如下:1. 从原始样本中有放回地抽取n个样本,得到新样本集。

2. 对新样本集进行统计分析,得到所关心的统计量的值。

3. 重复步骤1和2,得到n个统计量的值。

4. 根据n个统计量的值,计算出该统计量的抽样分布,从而得到估计值和置信区间。

Bootstrap法的优点在于,它不需要假设数据服从特定的分布,也不需要对数据进行任何假设检验。

它可以处理大部分数据类型,包括缺失数据和异常值。

此外,Bootstrap法还可以用于估计参数的标准误差、评估模型的预测误差等。

但是,Bootstrap法也存在一些限制。

由于需要进行大量的重复抽样,计算量较大,需要较长的计算时间。

此外,当样本数据较少时,Bootstrap法可能会出现样本抽取中的偏差,导致估计结果不准确。

总之,Bootstrap法是一种简单、直观、普适性强的统计学方法,可以用于估计总体的各种统计量,并提供置信区间。

在实际应用中,Bootstrap法已经被广泛应用于生物统计、金融风险管理、质量控制等领域。

回归分析中的Boosting回归模型构建技巧

回归分析中的Boosting回归模型构建技巧回归分析是统计学中一种重要的方法,用于研究自变量和因变量之间的关系。

Boosting回归模型是一种优化的回归分析方法,其通过迭代的方式构建多个弱分类器,然后将它们组合成一个强分类器,从而提高模型的预测能力。

在本文中,我们将讨论回归分析中Boosting回归模型的构建技巧。

理解Boosting回归模型的基本原理首先,我们需要理解Boosting回归模型的基本原理。

Boosting回归模型是一种集成学习方法,它通过结合多个弱分类器来构建一个强分类器。

在每一轮迭代中,Boosting算法都会调整样本的权重,使得前一个分类器分错的样本在下一轮迭代中得到更多的关注。

通过不断迭代,Boosting回归模型可以不断提高模型的性能。

选择合适的弱分类器在构建Boosting回归模型时,选择合适的弱分类器是非常重要的。

通常来说,Boosting算法可以与各种回归模型结合,例如线性回归、决策树回归和支持向量机回归等。

在选择弱分类器时,需要考虑模型的复杂度、偏差和方差等因素,以及样本数据的特点和分布情况。

调整学习率和迭代次数另外,调整学习率和迭代次数也是构建Boosting回归模型时需要考虑的重要因素。

学习率决定了每个弱分类器对最终模型的影响程度,通常来说,较小的学习率可以使得模型更加稳定,但也会增加模型的收敛时间;而较大的学习率则可能导致模型不稳定。

迭代次数决定了模型的复杂度,通常来说,迭代次数越多,模型的性能也会越好,但同时也会增加模型的计算成本。

处理样本不平衡问题在构建Boosting回归模型时,还需要考虑样本不平衡的问题。

由于Boosting算法会不断调整样本的权重,使得前一个分类器分错的样本在下一轮迭代中得到更多的关注,因此样本不平衡可能会导致模型的性能下降。

在处理样本不平衡问题时,可以采用过采样、欠采样或者集成采样等方法,以平衡不同类别的样本权重,从而提高模型的性能。

Boosting算法进化史

Boosting算法进化史背景:当前的热门算法中,除了神经⽹络在图像和⽂字、⾳频等领域⼤放异彩之外,集成学习中的xgboost,lightGBM,CatBoost也在kaggle等机器学习平台上成为了炙⼿可热的⼯具。

明确概念:1、Boosting(提升)2、Adaptive Boosting(⾃适应增强)3、Gradient Boosting(梯度提升)4、Decision Tree(决策树)⼀、Boosting关于boosting(提升算法)的概念,上⽂有简单介绍过,提升算法(这是⼀类算法族的称呼,不是指某种具体算法)是通过改变训练样本的权重(如果基分类器不⽀持则通过调整采样的⽅式改变基分类器的训练样本分布),学习多个分类器,并将这些分类器进⾏线性组合,提⾼分类的性能。

下⾯要讲的集成算法都属于提升算法⼆、Adaboost(Adaptive Boosting⾃适应增强算法)针对分类任务,李航的《统计学习⽅法》中有详细介绍总结⼀下流程如下图所⽰经过上述学习,我们已经可以明确adaboost的核⼼是1)计算基分类器的误差2)计算基分类器的权重3)更新样本的权重4)最后的结合策略针对回归任务,adaboost有以下步骤三、GBDT(GBDT泛指所有梯度提升树算法,包括XGBoost,它也是GBDT的⼀种变种,为了区分它们,GBDT⼀般特指“Greedy Function Approximation:A Gradient Boosting Machine”⾥提出的算法,只⽤了⼀阶导数信息。

)参考⾃:GBDT是以CART树(回归树)作为基分类器的boosting算法。

与Adaboost通过每次调整样本的权值来训练不同的基分类器不同,GBDT是通过将残差作为拟合⽬标训练⼼得基分类器。

先看⼀下GBDT应⽤于回归任务的原理其实,我⼀直对GBDT中的“梯度提升”很不理解,因为最优化理论中,梯度下降优化算法已经很熟悉了,拿两者进⾏⽐较,我总是觉得GBDT 依然是“梯度下降”⽽⾮“梯度提升”,如下图是某个博客上的对⽐,这分明都是使⽤的“梯度下降”。

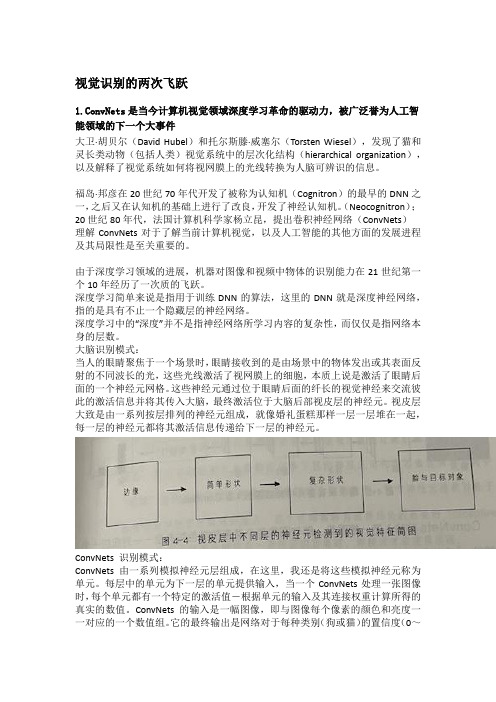

视觉识别的两次飞跃产品经理职场进产品运营用户分析操作指南

视觉识别的两次飞跃1.ConvNets是当今计算机视觉领域深度学习革命的驱动力,被广泛誉为人工智能领域的下一个大事件大卫·胡贝尔(David Hubel)和托尔斯滕·威塞尔(Torsten Wiesel),发现了猫和灵长类动物(包括人类)视觉系统中的层次化结构(hierarchical organization),以及解释了视觉系统如何将视网膜上的光线转换为人脑可辨识的信息。

福岛·邦彦在20世纪70年代开发了被称为认知机(Cognitron)的最早的DNN之一,之后又在认知机的基础上进行了改良,开发了神经认知机。

(Neocognitron);20世纪80年代,法国计算机科学家杨立昆,提出卷积神经网络(ConvNets)理解ConvNets对于了解当前计算机视觉,以及人工智能的其他方面的发展进程及其局限性是至关重要的。

由于深度学习领域的进展,机器对图像和视频中物体的识别能力在21世纪第一个10年经历了一次质的飞跃。

深度学习简单来说是指用于训练DNN的算法,这里的DNN就是深度神经网络,指的是具有不止一个隐藏层的神经网络。

深度学习中的“深度”并不是指神经网络所学习内容的复杂性,而仅仅是指网络本身的层数。

大脑识别模式:当人的眼睛聚焦于一个场景时,眼睛接收到的是由场景中的物体发出或其表面反射的不同波长的光,这些光线激活了视网膜上的细胞,本质上说是激活了眼睛后面的一个神经元网格。

这些神经元通过位于眼睛后面的纤长的视觉神经来交流彼此的激活信息并将其传入大脑,最终激活位于大脑后部视皮层的神经元。

视皮层大致是由一系列按层排列的神经元组成,就像婚礼蛋糕那样一层一层堆在一起,每一层的神经元都将其激活信息传递给下一层的神经元。

ConvNets 识别模式:ConvNets 由一系列模拟神经元层组成,在这里,我还是将这些模拟神经元称为单元。

每层中的单元为下一层的单元提供输入,当一个ConvNets处理一张图像时,每个单元都有一个特定的激活值-根据单元的输入及其连接权重计算所得的真实的数值。

视觉显著性算法概述课件

目前,多模态显著性检测主要涉 及不同模态之间的特征融合、模 态间的协同作用以及多模态数据

的联合处理等方面。

跨领域应用研究

WATCHING

比较不同算法在处理速 度上的表现,包括单张 图片处理时间和视频流

处理速度。

并行处理

评估算法是否支持并行 计算,以提高处理速度。

内存占用

优化技术

比较算法在运行过程中 占用的内存大小,以及 是否适合在资源有限的

环PU加速、算 法剪枝等,以提高实时性。

应用场景比较

视觉显著性算法概述 课件

目录

• 引言 • 视觉显著性算法基础 • 常见视觉显著性算法 • 视觉显著性算法比较 • 视觉显著性算法的未来发展

CHAPTER

引言

目的和背景

目的

背景

随着计算机视觉技术的不断发展,视 觉显著性检测在图像处理、目标检测、 图像识别等领域的应用越来越广泛, 成为当前研究的热点问题。

GBVS算法是一种结合颜色和纹理特征的显著性检测算法。该算法首先分别计算颜色和纹理的显著性,然后结合两者得到最 终的显著性图。该算法能够更好地捕捉图像中的细节信息。

SALICON 算法

CHAPTER

视觉显著性算法比较

准确性比 较

01

算法准确性

02

鲁棒性

03

细节捕捉

04

适应性

实时性比较

计算效率

显著性检测的应用领域

人机交互

在人机交互中,通过显著性检测技术, 可以快速准确地识别出用户关注的焦 点,提高人机交互的效率和用户体验。

安全监控

智能驾驶

在智能驾驶领域,显著性检测技术可 以用于车辆检测、行人检测和交通标 志识别等方面,提高驾驶的安全性和 可靠性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、介绍

由[1]的启发,我们提出了三个贡献显著性的学习。首先, 我们结合最好的两个方面:自下而上和自上而下的因素。 通过比较29个显著性模型,我们整合功能,最好的自下而 上的模式已经发现预测与自上而下的因素,如人脸,人, 车,等人的注视,培养几个线性和非线性分类从这些功能 中的录制品。第二,我们更强调内部零件更准确的显著性 检测瞩目的对象(例如,人类上部)。通过大量的实验, 我们证明了我们的相结合的方法,超过以前显著的学习方 法([1] [48]),以及其他最新的方法, 在3个数据集上, 使用3个评价得分。第三,我们证明了我们的模型能够在 一个场景中检测到最突出的对象,接近主流的显著区域检 测的表现。

其中,d(X,X0)是归一化的像素x从中心像素的X0的距离。

二、学习一个视觉显著性的模型

与手动设计显著性措施相比,我们按照训练分类的一种学 习方式,直接从人眼跟踪数据。其基本思路是的加权组合 的功能,其中权重学会从一个大的库对自然图像的眼球运 动,可以增强显著性检测比未经调整组合特征映射。学习 方法也有容易适用于通过提高要素权重目标对象的可视化 搜索的好处。 在下面,我们提出了一个朴素贝叶斯公式的显著性估计。 让我们是一个二元变量表示的显著位置的图像像素X =(X ,Y)与特征向量f,其中“s等于1”表示这个像素是突出 的(也就是说,它可以吸引人类的眼睛)和零。像素x的 一直是许多心理学,神经科学,计算机 视觉等研究的对象。相应地,一些计算模型已经在机器学 习,计算机视觉和机器人领域引起关注。几个应用程序也 已经被提出,并进一步提出了在这一领域的兴趣,包括:, 自动创建拼贴[5],视频压缩[6] [9],非真实渲染[8],广告 设计[10]。 自下而上的显著性的模型经常被评估,在自由观看任务中, 预测人的注视。今天,许多显著性模型基于各种各样令人 信服的技术,仍然每年都会有人引进新模型。然而,在预 测眼睛注视时,模型和人类间观察员(IO)有很大的差距。 IO模型“对于一个给定的刺激的输出,通过整合眼睛注视 建成地图,而不是观看那个刺激。该模型预计将提供预测 模型的准确度的程度,不同的人可能是对方的最好的预测 者。上面提到的模型和人类之间的差距主要是由于自顶向 下的因素的作用(参照图1)。

二、学习一个视觉显著性的模型

上面的公式是基于假设特点可以出现在所有的空间位置 (即,x和f是相互独立的,则p(f|x)=p(f))。我们进 一步假设,在S的先验概率(即,位置突出与否)都是平 等的。上式右边的第一项测量由于上面的图像的像素的特 征的显著性,而第二项措施显著性的基础上的像素的空间 位置。我们学习使用p(s|f)分类标注数据(倾向的位 置)。我们估计p(s|x):

三、实验程序 四、 模型比较和结果 五、讨论与小结 六、读者小结

5

6 7

摘要

自由观赏自然场景时,最好的视觉显著模型尽管有显著的 最新进展,在预测眼睛注视与人类的表现仍然落后。多数 模型是基于低层次的视觉特点,自顶向下的特点的重要性 尚未得到充分探讨或建模。在这里,我们结合了低级别的 功能,如方向,颜色,强度,以前最好的自下而上的模式, 采用自顶向下的视觉认知功能(例如,脸,人类,汽车等) 的显著图,使用回归、 SVM 和 AdaBoost 分类,从这些特 点里学习直接映射这些功能的的眼睛注视。通过广泛的试 验三个基准眼球跟踪数据集,使用三种流行的评价分数, 我们展示了:我们的Boosting模型优于27个最先进的模型, 是迄今为止在注视预测最准确的模型。此外,我们的模型 没有如区域分割这样复杂的图像处理,成功地检测到的最 显著的一个场景中的对象。

一、介绍

一、介绍

它被认为是自由观看的早期阶段(前几百毫秒),主要是 基于图像醒目性的注意,后来,高层次的因素(例如,行 动和事件)指导眼球运动[53][39]。这些高层次的因素可 能不一定转化为自下而上的显著性(例如,根据颜色,强 度或方向),应考虑分开。举例来说,一个人的头部可能 在其余的场景中不会特别突出,但可能会引起人们的注意。 因此,结合高层次概念和低层次的功能扩展现有模型,并 达到人类的表现似乎是不可避免的。

Boosting Bottom-up and Topdown Visual Features for Saliency Estimation

Boosting 自下而上和自上而下的视觉特征的显

著性估计

LOGO

主要内容

1 2 摘要 一、简介

3

4

二、学习一个视觉显著性的模型

一、介绍

相关工作 :显著性模型简介

显著性模型一般可以分为认知(生物)或计算(数学), 而有些发生在之间。几款根据Itti等人的自底向上的显著性 模型[4]。这种模型是先执行Koch和Ullman的计算架构基 于特征整合理论[15][16]。在这个理论中,图像被分解为 低一级的属性,如跨越几个空间尺度,然后归一化和线性 或非线性相结合,形成一个主显著图的颜色,强度和方向。 这一理论的一个重要组成部分是作为图像区域及其周围环 境的独特性,显著性定义中心环绕的想法。这个模型还提 出一个合适的架构适应视觉搜索理论和对象检测模型(例 如,[18])。基于去相关的神经反应,Diaz等人[29]提出 了一种有效的模型被称为自适应白化显著性(AWS)的 显著性。Le Meur等[33],Marat等[36],Kootstra等[17]提 出的模型是其他以认知的调查结果为导向的模型。 另有,基于概率模型、基于频率模型等,这里不一一介绍。