聊聊软件定义存储

软件定义存储技术与应用场景解析

软件定义存储技术与应用场景解析随着云计算、大数据、人工智能等领域的迅速发展,存储技术也不断被推陈出新。

其中,软件定义存储技术(Software Defined Storage,SDS)作为一种基于软件的存储方案,备受关注。

本文将详细介绍软件定义存储技术的基本原理和应用场景。

一、软件定义存储技术的基本原理软件定义存储技术是一种以软件为核心的存储解决方案,将传统的硬件存储和软件存储进行了融合,在控制层面实现存储资源的统一调度和管理。

具体来说,软件定义存储技术包括以下几大核心技术:1.虚拟化技术:通过虚拟化技术,可以将物理存储抽象为虚拟化的存储池,从而实现存储资源的动态调度和管理。

2.分布式存储技术:通过分布式存储技术,可以将不同的存储设备进行协同工作,实现集群化管理和可靠性提升。

3.自动化管理技术:通过自动化管理技术,可以对存储资源进行自动化的配置、监控和维护,提高存储系统的效率和可靠性。

4.软件定义接口技术:通过软件定义接口技术,可以将存储管理接口进行虚拟化,为上层应用提供标准、高效的接口。

二、软件定义存储技术的应用场景1.云计算领域随着云计算的快速发展,越来越多的企业将存储资源移到云端,以更好地满足业务需求。

而软件定义存储技术正是为这一需求而生,它能够为云计算平台提供更加便捷、灵活、高效的存储方案,提高云计算平台的性能和可靠性。

2.大数据领域在大数据领域中,存储需求和数据量呈指数级增长。

传统的硬件存储无法满足这一需求,而软件定义存储技术可以动态扩容、高效管理多种存储设备,满足大数据处理的存储需求。

3.容器化应用场景近年来,容器技术在应用场景中越来越受到关注。

而传统的存储方案往往不适合容器化应用场景,而软件定义存储技术则可以提供针对容器化应用的存储方案,为容器化应用的存储需求提供更加便捷的解决方案。

4.物联网应用在物联网应用中,嵌入式设备的存储容量有限,传统的存储方案无法满足物联网应用的存储需求。

软件定义存储技术的原理与应用

软件定义存储技术的原理与应用近年来,随着大数据、云计算、物联网等技术的快速发展,数据量也呈现出爆炸式增长的趋势。

因此,数据的存储和管理成为了企业和机构面临的一个重大问题。

传统存储技术对于海量数据的处理效率十分低下,面临着容量不足、性能差、维护困难等种种问题。

软件定义存储(Software-Defined Storage,SDS)技术的出现,为解决这些难题提供了有效的方案。

本文将介绍软件定义存储技术的原理与应用。

一、软件定义存储技术的原理软件定义存储技术是一种基于软件的存储解决方案,它将存储设备的控制功能从硬件层面抽象出来,通过软件来实现存储系统的管理和配置。

这种技术的核心理念是将存储设备的控制平面与数据平面分离,将控制平面作为一个中心挂载点,通过物理接口与底层存储系统进行交互。

这样的设计可以有效降低硬件的复杂性,同时提高存储系统的灵活性和可扩展性。

软件定义存储技术包括三个核心要素:软件定义存储控制平面、软件定义存储数据平面和去中心化存储设备。

1、软件定义存储控制平面软件定义存储控制平面是指使用软件来管理和控制存储系统的中心节点,它可以统一管理存储设备并向上层应用屏蔽硬件细节。

具体来说,软件定义控制平面主要实现以下功能:(1)为存储系统中的每个节点提供管理控制点。

(2)通过不同的协议与存储节点进行交互。

(3)收集并处理存储节点的各种数据,包括存储容量、存储性能等指标。

(4)将收集到的数据提供给上层应用,以便进行决策。

2、软件定义存储数据平面软件定义存储数据平面是指物理存储设备的数据读写通道。

存储设备的数据流会经过中介节点,由其中一台或多台节点完成数据读写操作并返回给访问者。

在此过程中,中介节点的角色是将计算、内存和网络资源组合在一起,提供数据平面的功能。

3、去中心化存储设备去中心化存储设备是指一种彼此连接的物理存储设备集群,它们通过互联网和专有网络建立联系。

去中心化存储设备通过软件定义存储技术进行统一管理,它们的存储空间被统一为一个虚拟池,分布在不同的节点上,并形成一个虚拟存储系统。

云计算中的软件定义存储与分布式存储

云计算中的软件定义存储与分布式存储随着信息技术的不断发展和进步,云计算已经成为现代企业信息管理的重要手段。

然而,随之而来的数据爆炸和对数据存储的高要求,对存储系统提出了新的挑战。

为了满足这些需求,软件定义存储(Software-Defined Storage,SDS)和分布式存储被广泛应用于云计算环境,为企业提供了高效的数据存储和管理解决方案。

一、软件定义存储(SDS)软件定义存储是一种基于软件来实现存储功能的技术,通过将存储控制器与硬件存储解耦,实现存储资源的虚拟化和集中管理。

SDS不依赖于特定的硬件设备,而是通过软件定义的方式提供存储服务,使得存储系统更加灵活和可扩展。

1. 软件定义存储的特点软件定义存储具有以下几个显著特点:a. 虚拟化:SDS通过将存储资源虚拟化,使得用户可以根据实际需求灵活配置和调整存储空间,并实现对存储资源的集中管理。

b. 弹性扩展:SDS具有良好的可扩展性,可以根据业务需求快速添加和移除存储节点,实现存储资源的弹性扩展。

c. 自动化管理:SDS可以通过自动化的管理手段,实现对存储资源的智能化管理,提高存储系统的可用性和性能。

d. 数据安全性:SDS提供了多种数据保护和备份的机制,保证数据的安全性和可靠性。

2. 软件定义存储的应用软件定义存储广泛应用于云计算环境中,主要有以下几个方面:a. 虚拟化存储:SDS可以与虚拟化平台结合,为虚拟机提供高效的存储服务,提高虚拟化环境的性能和可用性。

b. 分布式存储:SDS可以实现分布式存储的功能,将多个存储设备组合成一个逻辑存储池,提供高可用性和扩展性的存储服务。

c. 大数据存储:SDS可以通过与大数据平台的结合,提供高性能和高可扩展性的存储解决方案,满足对大数据存储和分析的需求。

二、分布式存储分布式存储是一种将数据分散存储在不同节点上的存储技术,通过将数据切分成多个片段存储在不同的节点上,实现数据的分布式存储和管理。

分布式存储可以提供高可用性和可扩展性的存储服务,适用于大规模的数据存储场景。

云计算中的软件定义存储技术

云计算中的软件定义存储技术云计算是近年来广受欢迎的一种计算机技术,能够提供高效、灵活的计算、存储和网络服务。

而软件定义存储技术作为其关键技术之一,也越来越受到关注。

本文将介绍云计算中的软件定义存储技术,包括其定义、分类、应用及发展趋势。

一、什么是软件定义存储软件定义存储(SDS)是一种新兴的存储技术,它将控制平面和数据平面物理分离,将存储控制软件部署在虚拟机或容器中,通过逻辑卷管理器(LVM)、分布式文件系统等技术,使用集群存储节点提供分布式存储服务。

其特点是具有高可用性、易于扩展、支持各种协议等。

二、软件定义存储分类目前,软件定义存储技术主要分为三类:块存储、文件存储和对象存储。

1.块存储块存储是一种适用于虚拟化、云计算等场景的存储形式,其提供的是一种块设备,支持基于块的协议,如iSCSI、FC等。

它可以在物理服务器和虚拟服务器之间提供数据共享,同时能够实现高可用、灵活扩展、数据冗余备份等功能。

2.文件存储文件存储是一种按文件访问的存储形式,它提供的是一种共享式的存储,例如NFS、SMB、CIFS等协议。

相较于块存储,文件存储可以在不同操作系统和平台之间实现数据共享,同时还可以提供更细粒度的数据访问控制等功能。

3.对象存储对象存储是一种以对象为中心的存储形式,它存储的是一种归档数据,例如图片、视频、文档等等,支持通过API进行存取。

对象存储提供了存储可扩展性、容错性、高性能等特性,并且支持多种访问协议,如AWS S3、OpenStack Swift等。

三、软件定义存储应用软件定义存储技术应用非常广泛,主要包括以下几个方面。

1.云存储软件定义存储技术为云存储提供了良好的支持,例如OpenStack的swift和Ceph都是使用软件定义存储技术来实现云存储服务的。

2.虚拟化存储虚拟化技术发展迅速,越来越多的企业开始使用虚拟化技术来实现服务器的资源共享。

而软件定义存储技术则是实现虚拟化存储的重要手段之一。

软件定义存储(SDS)概述

软件定义存储(SDS)概述软件定义存储(Software Defined Storage,简称SDS)是一种以软件为中心的存储架构,通过将存储功能从硬件设备中解耦,实现了存储资源的虚拟化和集中管理。

SDS借助软件控制层的抽象和智能管理,为企业提供了更灵活、可伸缩和高效的存储解决方案。

本文将对软件定义存储的概念、特点以及优势进行综述。

I. 概念软件定义存储是一种将存储功能集中到控制层,通过软件实现对存储资源的管理、配置和分配的技术。

与传统存储架构相比,SDS通过软件的虚拟化和抽象层实现了存储设备间的解耦,使得存储资源可以集中管理和调度。

通过软件定义存储,企业可以将不同的物理存储设备(包括磁盘阵列、闪存、云存储等)整合为一个虚拟存储池,提供统一的数据访问接口。

II. 特点1. 虚拟化和集中管理:SDS将存储设备的物理细节隐藏,提供统一的控制接口和管理工具,实现了存储设备的虚拟化和集中管理。

管理员可以通过软件界面对存储资源进行统一管理、配置和监控,简化了存储管理的流程和操作。

2. 高度可伸缩性:SDS提供了高度可扩展的存储架构,可以根据业务需求灵活调整存储容量和性能。

通过添加或移除存储设备,管理员可以实现存储容量的无缝扩展,提升了存储系统的可伸缩性。

3. 弹性和灵活性:SDS允许管理员根据实际需求配置存储策略,如数据备份、快照、压缩和加密等。

存储策略可以基于业务需求进行调整,提供了更灵活的数据管理方式。

此外,SDS还支持数据迁移和复制等功能,可以实现数据的高效迁移和保护。

4. 高性能和可靠性:SDS通过智能的数据管理和分发策略,实现了数据的高速传输和访问。

根据业务需求和存储设备的特性,SDS可以自动将数据分发到最合适的存储设备上,提升了存储系统的性能和可靠性。

III. 优势1. 成本效益:SDS采用标准化的硬件设备,与专有的存储设备相比具有更低的成本。

同时,通过存储资源的虚拟化和集中管理,SDS可以实现存储资源的优化配置,提高存储资源的利用率,进一步降低存储成本。

云计算中的软件定义存储技术

云计算中的软件定义存储技术云计算作为当今信息技术领域的热门话题,不仅在商业领域得到广泛应用,也在个人生活中发挥着越来越重要的作用。

而软件定义存储技术作为云计算中的一项关键技术,在云计算发展过程中发挥着至关重要的作用。

本文将就软件定义存储技术在云计算中的应用进行探讨,以及该技术的发展趋势和未来展望。

软件定义存储技术是一种新兴的存储技术范式,它将存储系统的功能从硬件中解耦,转移到软件层面实现。

这种技术的出现,使得存储系统更加灵活和可扩展,同时也为云计算平台提供了更多的选择和优化空间。

在传统的存储系统中,存储设备的控制和数据管理功能都是由硬件设备本身完成的,而软件定义存储技术则将这些功能从硬件中抽离出来,通过软件实现存储资源的管理和数据存取控制。

这种架构的优势在于,它可以将存储资源按需分配,并且可以通过软件升级和更新来实现功能增强和性能优化。

在云计算中,软件定义存储技术为云存储提供了更大的灵活性和可扩展性。

云计算平台需要处理大量的数据,而传统的存储系统往往无法满足这种大规模、高性能的需求。

软件定义存储技术可以将存储资源池化,实现对存储资源的统一管理和调度,从而提高了存储资源的利用率和性能。

同时,软件定义存储技术还可以通过虚拟化技术实现存储资源的动态分配和扩展,使得云计算平台可以根据需求实时调整存储资源的分配和配置,从而更好地满足不同应用的需求。

除了提高存储资源的利用率和可扩展性外,软件定义存储技术还可以实现存储资源的统一管理和数据的统一视图。

在传统的存储系统中,不同的存储设备往往需要单独管理,而且存储资源的管理和控制接口也各不相同,这给云计算平台的管理和运维带来了很大的挑战。

软件定义存储技术可以将不同的存储设备统一管理,通过统一的管理接口对存储资源进行管理和监控,从而简化了云计算平台的管理和运维工作。

同时,软件定义存储技术还可以实现对存储数据的统一视图,使得云计算平台可以更加方便地进行数据管理和数据分析,为业务应用提供更好的支持。

云计算中的软件定义存储技术(四)

云计算中的软件定义存储技术云计算作为当今信息技术领域的热点之一,已经被广泛应用于各行业和领域。

而软件定义存储技术作为云计算的重要支撑之一,也在近年来受到了越来越多的关注。

本文将从软件定义存储技术的定义、特点以及在云计算中的应用等方面进行探讨。

软件定义存储技术是一种基于软件的存储解决方案,它将存储功能从传统的硬件设备中抽象出来,使得存储资源可以由软件来管理和控制。

这种技术的核心理念是将存储资源抽象化,使得存储资源可以被灵活地配置和管理,从而提高了存储资源的利用率和灵活性。

与传统的存储方案相比,软件定义存储技术具有更高的可扩展性和灵活性,能够更好地满足云计算环境下的存储需求。

软件定义存储技术的特点主要包括以下几个方面:首先,它具有高度的可扩展性。

通过软件定义的方式管理存储资源,可以使得存储资源的规模可以根据实际需求进行动态扩展,从而更好地适应云计算环境下的快速增长的存储需求。

其次,软件定义存储技术具有更好的灵活性。

传统的存储设备通常是固定的硬件设备,而软件定义存储技术可以灵活地根据需求进行配置和管理,从而更好地适应云计算环境中不断变化的需求。

此外,软件定义存储技术还具有更好的成本效益。

通过使用标准的服务器硬件和开源软件,可以降低存储成本,并且可以更好地利用现有的硬件资源,从而提高了存储资源的利用率。

在云计算环境下,软件定义存储技术发挥着越来越重要的作用。

首先,软件定义存储技术能够更好地支持云存储。

在云计算环境下,存储资源的规模和复杂度都远远超过了传统的存储环境,传统的存储解决方案已经难以满足云计算环境下的存储需求。

而软件定义存储技术能够更好地支持云存储,能够更好地适应云计算环境下的快速增长的存储需求。

其次,软件定义存储技术能够更好地支持云计算的灵活性和可扩展性。

在云计算环境下,存储资源的需求往往是不断变化的,而软件定义存储技术能够更好地满足云计算环境下的存储需求,能够更好地支持云计算环境下的快速增长的存储需求。

网络中的软件定义存储技术

网络中的软件定义存储技术在信息化时代,数据的存储和处理已经成为各个领域不可或缺的重要环节。

而传统的存储方法已经不能满足大数据背景下的高效、灵活和安全的要求,因此软件定义存储技术应运而生。

本文将介绍网络中的软件定义存储技术,并探讨其在实际应用中的优势和挑战。

一、软件定义存储技术概述软件定义存储技术是一种将存储系统的控制平面和数据平面分离的新型存储架构。

传统的存储系统中,硬件设备与存储功能紧密耦合,而软件定义存储则将存储功能抽象为软件,通过在通用硬件平台上实现存储控制和数据处理,从而实现了存储系统的灵活性和可扩展性。

二、软件定义存储技术的优势1. 灵活性:软件定义存储技术可以根据实际需求动态调整存储系统的容量、性能和可靠性。

用户可以根据自己的存储需求对存储系统进行灵活配置,提高存储资源的利用率。

2. 可扩展性:软件定义存储技术采用分布式架构,可以根据业务需求无缝扩展存储容量和性能。

通过添加更多的存储节点,可以实现存储资源的弹性扩展,满足大规模数据处理的需求。

3. 高性能:软件定义存储技术通过利用多核处理器和高速网络等硬件资源,实现存储系统的并行计算和数据传输,从而提高系统的性能和响应速度。

4. 数据保护:软件定义存储技术具备数据冗余、快照和备份等功能,可以提供数据的高可靠性和安全性。

在存储系统发生故障时,可以通过数据冗余和备份,实现数据的快速恢复,降低数据丢失的风险。

三、软件定义存储技术的应用领域1. 云存储:软件定义存储技术为云存储提供了灵活的架构和高性能的数据处理能力。

通过软件定义的方式,可以实现云存储的动态配置和资源管理,提高存储资源的利用率。

2. 大数据分析:软件定义存储技术能够满足大数据分析对存储容量和计算能力的需求。

通过分布式存储和并行计算,可以提高大数据处理的效率和可靠性。

3. 虚拟化存储:软件定义存储技术可以实现虚拟化环境下的存储资源管理和数据流动控制。

通过对存储功能的抽象和集中管理,可以简化虚拟化存储的配置和维护。

云计算中的软件定义存储与分布式文件系统

云计算中的软件定义存储与分布式文件系统随着云计算技术的不断发展,软件定义存储(Software-Defined Storage,SDS)和分布式文件系统(Distributed File System,DFS)成为了云存储领域的两个重要概念。

在云计算环境中,SDS和DFS的结合为存储资源的管理和利用提供了更高效、可扩展的解决方案。

一、软件定义存储在云计算中的作用在云计算中,软件定义存储充当着存储资源的虚拟化和管理的角色。

传统的存储系统通常是基于硬件的,需要通过专用的存储设备完成数据的读写和存储。

而软件定义存储则将存储功能从硬件中解耦,通过软件的方式实现对存储资源的管理和配置。

软件定义存储具有以下几个特点:1.虚拟化:软件定义存储通过虚拟化技术将存储资源抽象为逻辑单元,使得云计算平台可以更灵活地管理和分配存储资源。

2.可扩展性:软件定义存储可以根据需要对存储资源进行扩展,无需停机或增添额外的硬件设备,提高了存储系统的灵活性和可用性。

3.灵活的数据访问:软件定义存储通过将存储功能从特定硬件中解耦,实现了存储与计算的分离,使得数据可以在不同的服务器之间自由流动,从而提高了存储的效率和可靠性。

二、分布式文件系统在云计算中的应用分布式文件系统是一种将文件分散存储在多个服务器上的存储系统,通过将文件划分为多个块并在多个节点之间进行分布式存储,实现了数据的冗余备份和高可靠性存储。

分布式文件系统具有以下几个特点:1.高可靠性:分布式文件系统将数据冗余存储在多个节点上,若某个节点发生故障,系统可以通过备份数据保证数据的安全和可靠性。

2.可扩展性:分布式文件系统可以根据需求动态地扩展存储节点,实现了存储容量的无缝扩展。

3.高性能:分布式文件系统可以将文件块分散存储在多个节点上,通过并行读写实现了高速的存储和访问性能。

在云计算环境中,分布式文件系统常常被用于存储海量数据和大规模计算任务。

通过将文件划分为多个块,并将这些块分散存储在多个节点上,可以实现高效的数据并行计算和存储。

软件定义存储(SDS)与计算机网络技术

软件定义存储(SDS)与计算机网络技术随着信息技术的快速发展与普及,数据规模不断扩大,对存储系统的需求也变得更为迫切。

软件定义存储(Software Defined Storage,简称SDS)作为一种新型的存储架构,与计算机网络技术密切相关,并在数据存储领域发挥着重要作用。

本文将探讨软件定义存储与计算机网络技术的关系以及在存储系统中的应用。

1. 软件定义存储简介软件定义存储是一种以软件为中心的存储架构,它将存储设备的控制和管理功能从硬件中独立出来,通过软件定义的方式来实现存储资源的管理和分配。

与传统存储架构相比,SDS具有更高的灵活性和可扩展性,能够更好地适应不同应用场景和需求变化。

2. 软件定义存储与计算机网络技术的关系软件定义存储与计算机网络技术密不可分,两者相辅相成,共同构建了高效的存储系统。

首先,计算机网络技术为软件定义存储提供了数据传输的基础设施,通过网络连接不同存储节点,将分散的存储资源整合为一个统一的存储池。

其次,软件定义存储的分布式架构与计算机网络技术的分布式计算相契合,可以通过网络实现数据的快速访问和传输,提高存储系统的性能和效率。

3. 软件定义存储在存储系统中的应用软件定义存储在存储系统中有广泛的应用,可以针对不同的场景和需求进行灵活的配置和扩展。

以下是软件定义存储在存储系统中的几个常见应用:3.1 虚拟化存储虚拟化技术的广泛应用使得存储需求大幅增加,传统的存储架构往往无法满足虚拟化环境的要求。

而软件定义存储通过解耦存储控制与硬件设备,可以更好地适应虚拟化环境中的存储管理需求,并提供高性能和高可用性的存储服务。

3.2 对象存储对象存储是一种新兴的数据存储模式,它以对象的方式来存储和管理数据。

软件定义存储可以通过网络连接多个存储节点,将分散的对象存储资源整合为一个统一的对象存储系统,提供高可靠性和高扩展性的存储服务。

3.3 分布式存储分布式存储的核心思想是将数据分散存储在多个节点上,通过网络协作来实现数据的访问和传输。

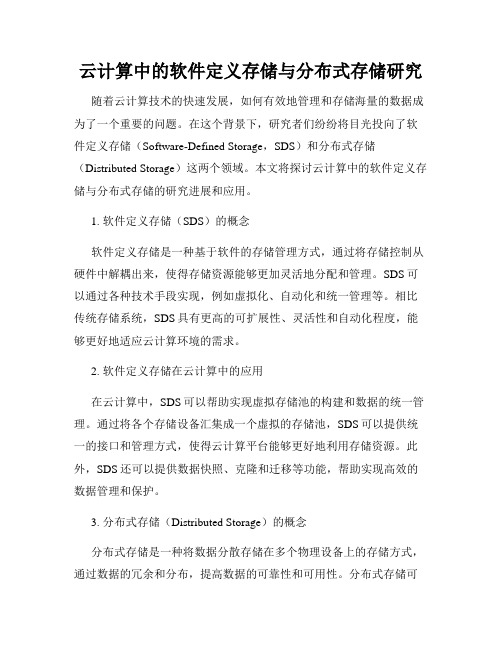

云计算中的软件定义存储与分布式存储研究

云计算中的软件定义存储与分布式存储研究随着云计算技术的快速发展,如何有效地管理和存储海量的数据成为了一个重要的问题。

在这个背景下,研究者们纷纷将目光投向了软件定义存储(Software-Defined Storage,SDS)和分布式存储(Distributed Storage)这两个领域。

本文将探讨云计算中的软件定义存储与分布式存储的研究进展和应用。

1. 软件定义存储(SDS)的概念软件定义存储是一种基于软件的存储管理方式,通过将存储控制从硬件中解耦出来,使得存储资源能够更加灵活地分配和管理。

SDS可以通过各种技术手段实现,例如虚拟化、自动化和统一管理等。

相比传统存储系统,SDS具有更高的可扩展性、灵活性和自动化程度,能够更好地适应云计算环境的需求。

2. 软件定义存储在云计算中的应用在云计算中,SDS可以帮助实现虚拟存储池的构建和数据的统一管理。

通过将各个存储设备汇集成一个虚拟的存储池,SDS可以提供统一的接口和管理方式,使得云计算平台能够更好地利用存储资源。

此外,SDS还可以提供数据快照、克隆和迁移等功能,帮助实现高效的数据管理和保护。

3. 分布式存储(Distributed Storage)的概念分布式存储是一种将数据分散存储在多个物理设备上的存储方式,通过数据的冗余和分布,提高数据的可靠性和可用性。

分布式存储可以通过多种数据分布策略和数据冗余技术实现,例如数据切片、数据复制和纠删码等。

相比集中式存储系统,分布式存储系统具有更好的可扩展性和容错性,能够更好地应对数据量剧增和硬件故障等问题。

4. 分布式存储在云计算中的应用在云计算中,分布式存储可以帮助解决数据的可靠性和可用性问题。

通过将数据冗余存储在多个节点上,分布式存储可以防止单点故障导致的数据丢失,并提供更好的数据访问性能。

此外,分布式存储还可以提供可扩展的存储容量,满足云计算平台大规模数据存储的需求。

近年来,分布式存储技术在云计算中得到了广泛应用,例如Hadoop分布式文件系统(HDFS)和Ceph分布式存储系统等。

云计算中的软件定义存储(SDS)

云计算中的软件定义存储(SDS)云计算已成为现代企业中不可或缺的一部分,它提供了高效的数据存储与管理解决方案。

其中,软件定义存储(Software-Defined Storage,简称SDS)作为一种先进的存储技术,正在在云计算领域发挥重要作用。

本文将重点介绍云计算中的SDS,探讨其特点、优势以及适用场景。

一、SDS简介软件定义存储(SDS)是一种基于软件的存储解决方案,通过将存储功能从硬件中解耦,实现存储管理的灵活性和可扩展性。

与传统存储解决方案相比,SDS更加智能化、灵活和可定制。

其核心理念是通过软件来实现对存储资源的统一管理和调度,以提升存储效率和性能。

二、SDS的特点1. 硬件无关性:SDS可以与不同厂商的硬件存储设备兼容,从而减少了对特定硬件厂商的依赖,提高了存储的灵活性和可扩展性。

2. 软件控制:SDS通过软件来实现对存储资源的控制和管理,使得存储操作更加智能、便捷。

管理员可以通过集中化的管理平台对存储资源进行监控、调度和优化。

3. 弹性扩展:SDS采用分布式架构,允许按需扩展存储容量。

当企业存储需求增加时,可以通过添加新的存储节点来扩展存储容量,而无需停机和数据迁移。

4. 数据高可用性:SDS通过数据冗余和快速恢复机制来保障数据的高可用性。

当存储节点故障时,SDS能够自动将数据迁移到其他正常节点,从而保障数据的完整性和可访问性。

三、SDS的优势1. 成本效益:SDS消除了对昂贵专有硬件的依赖,降低了存储成本。

同时,SDS的灵活性和可扩展性使得企业可以根据需求调整存储容量,避免了资源浪费。

2. 简化管理:SDS通过集中化的管理平台,简化了存储资源的管理和监控工作。

管理员可以通过可视化界面进行操作,提高了管理效率和可操作性。

3. 高性能与可靠性:SDS的分布式架构和数据冗余机制保证了数据的高可靠性和可用性。

同时,SDS可以根据负载情况自动调整数据分布和存储策略,提高了存储性能。

四、适用场景1. 云存储服务:SDS可以为云存储服务提供高效、可扩展的存储解决方案。

计算机网络中的软件定义存储(SDS)

计算机网络中的软件定义存储(SDS)随着计算机网络的发展和数据量的爆发性增长,传统的存储系统已经无法满足当今的需求。

为了满足这一需求,软件定义存储(Software-Defined Storage,简称SDS)应运而生。

SDS是一种以软件为核心的存储架构,通过在标准服务器上运行特定的软件,将物理存储资源进行抽象化和虚拟化,提供统一管理和控制的存储服务。

一、SDS的基本原理SDS的基本原理是将存储控制器功能从硬件中抽离出来,使其成为运行在通用计算机上的软件。

通过这种方式,SDS能够将物理存储资源池化,使其成为一个统一的虚拟化存储资源。

这样一来,SDS可以实现对存储资源的动态管理和分配,提高存储的灵活性和可扩展性。

二、SDS的优势1. 灵活性和可扩展性:SDS可以根据需求动态分配存储资源,无需进行硬件调整。

这样一来,企业可以根据业务需要随时增加或减少存储容量,从而大大提高了存储的灵活性和可扩展性。

2. 统一管理和控制:SDS将存储资源进行虚拟化管理,通过一个中心化的管理界面进行配置和监控。

这样一来,管理员可以集中管理所有存储资源,大大简化了管理工作,并提高了管理的效率。

3. 容错和高可用性:SDS支持数据的冗余备份和热迁移,可以保证数据的安全性和高可用性。

当存储出现故障时,SDS可以自动将数据迁移到其他可用的存储设备上,以保证数据的可访问性。

4. 成本效益:由于SDS采用了通用硬件和虚拟化技术,相比传统的存储系统,SDS更加经济高效。

企业可以根据实际需求选择合适的硬件设备,避免了过度投资,并且可以降低存储管理的成本。

三、SDS的应用领域1. 云存储:SDS可以为云存储提供统一的管理和控制平台,通过虚拟化技术实现资源的弹性分配,提高云存储的可靠性和可用性。

2. 大数据存储:SDS可以将分布式存储设备进行统一管理,提供高性能的数据存储和处理能力,满足大数据处理的需求。

3. 虚拟化存储:SDS可以为虚拟化环境提供高效、可靠的存储服务,提高虚拟机的性能和可用性。

云计算中的软件定义存储(SDS)技术

云计算中的软件定义存储(SDS)技术云计算作为现代信息技术的重要组成部分,在不断得到发展和应用的同时,也面临着许多挑战,其中之一就是存储技术的变革。

传统的存储架构往往受限于硬件设备的局限性,无法满足云计算中海量数据的高效存储和管理需求,因此软件定义存储(SDS)技术应运而生。

一、什么是软件定义存储(SDS)技术软件定义存储(Software Defined Storage,SDS)是一种基于软件的存储架构,它将存储设备从硬件中抽象出来,通过软件实现对存储资源的统一管理和控制。

相对于传统的存储方式,SDS技术具有更高的灵活性、可扩展性和易用性,能够为云计算提供更为先进和高效的存储解决方案。

二、软件定义存储(SDS)技术的特点1. 软件抽象:SDS技术将底层存储设备抽象成虚拟化的存储资源,使得用户可以通过软件进行统一管理和配置,而无需关注底层硬件的细节。

2. 弹性扩展:SDS技术可以根据实际需求自动扩展存储容量,无需手动调整硬件设备,大大提高了存储的灵活性和可扩展性。

3. 数据冗余:SDS技术可以通过数据冗余和快速复制等技术,保证数据的高可靠性和可用性,以防止数据丢失和故障发生。

4. 智能管理:SDS技术可以通过智能管理平台,对存储资源进行智能化的监控和管理,提供全面的存储性能分析和优化。

三、软件定义存储(SDS)技术的应用场景1. 云存储平台:SDS技术可以被广泛应用于云存储平台,为用户提供高效、安全和可靠的云存储服务,支持多租户管理和数据备份。

2. 大数据处理:SDS技术可以为大数据处理提供强大的存储基础设施,支持海量数据的高速读写和分析,为数据挖掘和商业智能提供支持。

3. 虚拟化环境:SDS技术可以为虚拟化环境提供高性能和高可用的存储资源,支持虚拟机的快速迁移和故障恢复。

4. 边缘计算:SDS技术可以被应用于边缘计算场景,为边缘设备提供低延迟、高速的存储服务,满足实时计算和物联网应用的需求。

四、软件定义存储(SDS)技术的挑战与展望尽管软件定义存储(SDS)技术在云计算中的应用前景广阔,但仍面临一些挑战。

了解服务器虚拟化技术的软件定义存储

了解服务器虚拟化技术的软件定义存储随着云计算和大数据时代的到来,服务器虚拟化技术变得越来越重要。

在传统服务器结构中,每个物理服务器都运行着一个操作系统,并且使用自己的硬盘存储数据。

这种方式存在着一些问题,如资源利用率低、管理复杂等。

而软件定义存储(Software Defined Storage,SDS)通过将存储资源从硬件上抽象出来,解决了这些问题,并提供了更高的灵活性和可扩展性。

SDS是一种虚拟化存储的技术,它使用软件层来管理存储资源,而不依赖特定的硬件。

这样,服务器的存储资源可以集中管理,并能够根据需求进行分配和调整。

SDS可以运行在物理服务器上,也可以在云环境中使用,使得存储资源的使用更加灵活。

在SDS中,存储资源被抽象为虚拟机或容器可以使用的存储卷。

这些存储卷可以由多个物理硬盘组成,也可以在网络上的其他服务器上进行分布式存储。

通过利用虚拟化技术,SDS可以实现数据的高可用性和冗余备份,即使出现硬件故障,数据也不会丢失。

SDS还可以提供更高的性能和扩展性。

通过在不同的物理服务器之间分发数据,SDS可以实现负载均衡,提高数据访问的速度。

此外,SDS还可以根据需求进行横向扩展,即在需要更多存储资源时,可以简单地添加更多的物理服务器。

除了灵活性和可扩展性,SDS还提供了更方便的管理和监控功能。

管理员可以通过统一的界面来管理所有的存储资源,并监控它们的使用情况和性能。

这样可以减少管理的复杂性,并提高管理员的工作效率。

然而,SDS也面临一些挑战。

首先,由于SDS是建立在已有的服务器和存储设备之上的,所以在进行虚拟化之前,需要对现有的硬件进行评估和调整。

其次,由于SDS需要在服务器上运行软件来管理存储资源,所以会增加额外的计算开销。

最后,SDS的性能和可靠性也受到服务器和网络的限制。

总的来说,软件定义存储是一种通过虚拟化技术来管理存储资源的方式,它提供了更高的灵活性和可扩展性,同时还简化了存储资源的管理和监控。

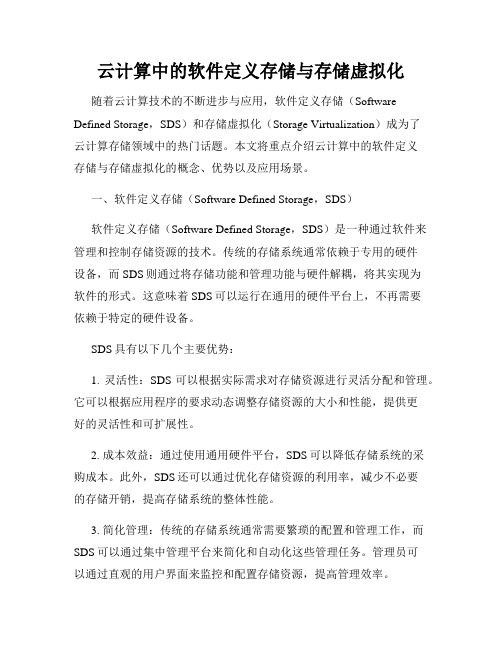

云计算中的软件定义存储与存储虚拟化

云计算中的软件定义存储与存储虚拟化随着云计算技术的不断进步与应用,软件定义存储(Software Defined Storage,SDS)和存储虚拟化(Storage Virtualization)成为了云计算存储领域中的热门话题。

本文将重点介绍云计算中的软件定义存储与存储虚拟化的概念、优势以及应用场景。

一、软件定义存储(Software Defined Storage,SDS)软件定义存储(Software Defined Storage,SDS)是一种通过软件来管理和控制存储资源的技术。

传统的存储系统通常依赖于专用的硬件设备,而SDS则通过将存储功能和管理功能与硬件解耦,将其实现为软件的形式。

这意味着SDS可以运行在通用的硬件平台上,不再需要依赖于特定的硬件设备。

SDS具有以下几个主要优势:1. 灵活性:SDS可以根据实际需求对存储资源进行灵活分配和管理。

它可以根据应用程序的要求动态调整存储资源的大小和性能,提供更好的灵活性和可扩展性。

2. 成本效益:通过使用通用硬件平台,SDS可以降低存储系统的采购成本。

此外,SDS还可以通过优化存储资源的利用率,减少不必要的存储开销,提高存储系统的整体性能。

3. 简化管理:传统的存储系统通常需要繁琐的配置和管理工作,而SDS可以通过集中管理平台来简化和自动化这些管理任务。

管理员可以通过直观的用户界面来监控和配置存储资源,提高管理效率。

二、存储虚拟化(Storage Virtualization)存储虚拟化(Storage Virtualization)是一种将物理存储资源抽象为虚拟存储池,并为应用程序提供逻辑上的存储单元的技术。

它可以将多个物理存储设备(例如硬盘、磁带等)组合成一个逻辑存储池,提供统一的存储接口给应用程序使用。

存储虚拟化具有以下几个主要优势:1. 简化管理:存储虚拟化将多个物理存储设备进行抽象,简化了存储系统的管理和配置工作。

管理员可以通过一个管理界面来管理整个存储池,而不需要关注底层的物理存储设备。

云计算架构中的软件定义存储技术应用与优势

云计算架构中的软件定义存储技术应用与优势随着云计算技术的快速发展,数据存储和管理成为了云计算架构中的重要组成部分。

而软件定义存储技术的出现为云计算架构中的存储管理带来了革命性的改变。

本文将讨论软件定义存储技术在云计算架构中的应用与优势。

一、软件定义存储技术的概念及原理软件定义存储技术,是指通过软件的方式来管理和控制存储资源,从而解耦硬件和软件之间的关系。

它基于虚拟化技术,将存储设备抽象为虚拟存储池,通过软件实现对存储资源的管理和分配。

软件定义存储技术的原理在于将存储设备的控制和管理功能从硬件中抽离出来,转移到软件层面进行统一管理。

二、软件定义存储技术在云计算架构中的应用1. 简化管理和部署:软件定义存储技术可以将不同类型和厂商的存储设备进行统一管理,实现资源的集中化管理和调度。

这大大简化了云计算架构中存储资源的部署和管理工作,提高了存储资源的利用率和灵活性。

2. 提高性能与可扩展性:软件定义存储技术可以对存储资源进行灵活的分配和调度,根据用户需求自动调整存储性能。

同时,软件定义存储技术还支持横向扩展,可以根据需求快速扩展存储容量和性能,提高了云计算架构的存储系统的性能和可扩展性。

3. 数据管理和保护:软件定义存储技术具有灵活的数据管理功能,可以根据不同的业务需求设置数据存储策略,实现对数据的分类和备份。

同时,软件定义存储技术还支持数据的快照和恢复功能,可以在数据发生故障或错误时快速恢复数据,提高了数据的可靠性和安全性。

三、软件定义存储技术在云计算架构中的优势1. 灵活性:软件定义存储技术可以将存储设备进行虚拟化,实现对存储资源的灵活调度和管理。

通过软件定义存储技术,可以将不同类型和厂商的存储设备整合在一起,提高存储资源的利用率和灵活性。

2. 可扩展性:软件定义存储技术支持横向扩展,可以根据业务需求快速扩展存储容量和性能。

这大大降低了云计算架构中存储系统的扩展成本,同时提供了更强大的存储能力。

3. 效率和性能:软件定义存储技术可以实现存储资源的统一管理和调度,提高了存储资源的利用率和性能。

云计算下的软件定义存储研究与实现

云计算下的软件定义存储研究与实现在云计算时代,软件定义存储(Software-Defined Storage,SDS)作为一种创新的存储技术,得到了广泛应用和研究。

本文将详细探讨云计算下的软件定义存储的研究与实现。

首先,我们需要了解软件定义存储的概念和特点。

软件定义存储是一种将存储功能与硬件解耦的技术,通过软件定义的方式,将存储设备抽象化为虚拟的存储资源,实现对存储资源的灵活配置和管理。

相比传统的存储架构,软件定义存储具有灵活性高、可扩展性强、成本低等优势。

在云计算环境下,软件定义存储为云存储提供了强大的技术支持。

首先,云计算场景中的大规模存储需求需要具备高度的可扩展性,软件定义存储的虚拟化特性使得云存储可以根据需求动态分配和释放存储资源。

其次,云计算的高可用性要求存储系统具备高度的容错能力,软件定义存储可以通过数据副本技术和冗余机制提供数据的备份和故障恢复功能。

最后,云计算对于存储性能和IO优化的需求较高,软件定义存储可以通过调整存储的数据分布和调度策略来实现性能的优化。

针对云计算下的软件定义存储研究与实现,首先需要考虑存储资源的虚拟化和管理。

在实现软件定义存储时,可以通过采用存储虚拟化技术,将物理存储设备抽象为虚拟的存储池,并将其划分为若干虚拟存储块。

通过对虚拟存储块的管理,可以实现存储资源的动态分配与释放,并提供灵活的存储服务。

此外,需要考虑对存储资源的QoS(Quality of Service)管理,根据不同业务的需求,为不同用户提供个性化的存储服务。

其次,需要关注软件定义存储的数据管理和保护。

在云计算环境下,数据的完整性和安全性是非常重要的。

为了保护云存储中的数据,可以采用数据冗余技术,通过将数据进行多次副本备份,提高数据的可用性和可靠性。

此外,还需要采用加密技术和访问控制机制,确保数据在传输和存储过程中的安全性。

另外,云计算下的软件定义存储还需要考虑存储性能的优化。

在大规模的云计算环境下,存储性能是一个关键指标。

云计算中的软件定义存储和缓存技术

云计算中的软件定义存储和缓存技术云计算已经成为了当今信息技术领域的热门话题,其提供的灵活性、可扩展性和高效性使得企业和个人能够以更低的成本和更高的效率来处理和存储数据。

在云计算的背后,软件定义存储和缓存技术作为关键的基础设施组成部分,扮演着至关重要的角色。

本文将探讨云计算中的软件定义存储和缓存技术的意义、原理和应用。

一、软件定义存储的意义在传统的数据存储和管理方式中,硬件设备扮演着重要的角色,各种存储设备的协调和管理需要进行复杂的配置和管理工作。

而软件定义存储的出现,改变了传统存储方式的局限性,将存储控制从硬件设备中抽象出来,实现了存储资源的虚拟化和集中化管理。

这使得存储资源的规划和配置更加灵活和高效,降低了企业的存储成本,提升了数据的可靠性和可用性。

二、软件定义存储的原理软件定义存储的核心原理是将物理存储设备进行抽象,以逻辑设备的方式呈现给上层应用。

在软件定义存储系统中,存储逻辑层和物理存储设备之间的关系由软件控制,通过在存储逻辑层进行各种数据管理和存储策略的定义,实现了对底层物理存储设备的控制和管理。

这种抽象的方式使得存储资源可以根据需要进行灵活的分配和调整,提高了存储资源的利用率和效率。

三、软件定义缓存的意义在大规模数据处理中,数据缓存对系统性能的影响不可忽视。

传统的硬件缓存技术面临着成本高、扩展性差等问题,而软件定义缓存技术的出现,通过软件对缓存进行管理,解决了传统硬件缓存技术的局限性,提供了更加灵活和高效的数据处理方式。

软件定义缓存技术能够根据数据的访问模式和需求进行智能的缓存调度,将高频访问的数据缓存在内存中,提升了数据的读取速度和系统的响应性能。

四、软件定义缓存的原理软件定义缓存的原理是通过将数据以逻辑方式进行管理和调度,实现对底层存储介质的缓存控制和管理。

软件定义缓存系统通过分析应用访问模式,将频繁访问的数据缓存到高速介质中,如内存或固态硬盘,使得数据访问的速度更快。

同时,软件定义缓存系统还可以根据缓存的命中率和数据的重要性等因素,调整缓存策略,提高缓存命中率和系统整体性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

IBM 2499-384

Hp 3Par V800

Cluster 3

HP 3Par SS7440

IBM SVC IBM SVC IBM SVC

少量物理机

Cluster 2

HP 3Par SS7440

Brocade DCX

IBM SVC

少量物理机

Cluster 4

Server SAN(基于服务器的分布式块存储):采用标准服务器作为硬件,通过软件对外提 供存储服务的产品 基于服务器的分布式文件存储:采用标准服务器作为硬件,通过软件对外提供文件存储服 务的产品,主流还是NAS,使用NFS/CIFS文件共享传输协议,树形目录+inode管理方法 对象存储(基于服务器的分布式对象存储):采用标准服务器作为硬件,通过软件对外提 供对象服务的产品,对象是一种数据集合,如图片、视频等,每个对象都在一个被称作存 储池的扁平地址空间的同一级别里拥有唯一OID,一个对象不会属于另一个对象的下一级

架构的致命缺点是IBM SVC为A/P模式,单个SVC故障时,Cluster需要软切换 ,敏感数据库业务无法接受切换时长,会Crash,已发生多次,无法避免; 该架构还有个前提条件是任何存储不能出现致命故障,否则全网业务可能宕 机,甚至是数据丢失; IBM SVC原厂早已停止进一步研发投入,且一线人员基本无法排障,升级到 二线也多次排查无果; 只余20TB空间,且IBM DS8800/HP 3par Ss7440存储已满配,无法扩容,只能 新增存储; 分配给了上千台虚拟机及少量物理机,数据库近30套,偶尔个别业务主机有 延时,怀疑是SVC性能问题,但一直无数据支撑,且原厂也分析不出根因;

传统存储网络不宜大规模池化

举例:资源池存储

石桥网管资源池

IBM DS8800

IBM 2499-384

IBM SVC IBM SVC IBM SVC IBM SVC IBM SVC Cluster 1

产业园网管资源池

Exsi集群

Cluster 2

HDS Vspg1000 Brocade DCX

IBM SVC IBM SVC IBM SVC

计算

Controller

计算

Controller

Cache Controller

Cache Controller

存储

Controller

存储

计算

槽点:建议不超过32节点,集群规模需要研究;分级模型不明确,拭目以待;配置成本并不低 ,目前做到5k/TB;软硬解耦增加了太多磨合环节,甲方秒变集成商;大规模SSD的使用,损耗隐 患待研究;架构松耦合挺好的,但是故障点数量是增加的

IBM DS8000 Huawei 18000 分布式存储最早诞生在互联网行业,随着技术的产品化成熟,越 EMC VMAX 来越多的企业级用户也在尝试,将传统的业务迁移到弹性,灵

活的分布式存储资源池

存储基本概念-----RAID

RAID(Redundant Array of Independent Disks)即独立磁 盘冗余阵列,RAID将多个单独 的物理硬盘以不同的方式组合成 一个逻辑硬盘,从而提高了硬盘 的读写性能和数据安全性 RAID5和RAID10

•

磁盘柜

•

磁盘线缆

存储基本概念---DAS、NAS、SAN

DAS

主机

应用

文件/操作系统 逻辑卷管理器 RAID SCSI 设备驱动 SCSI/FC 总线卡 数据库 裸卷

NAS

主机

应用

文件/操作系统

I/O 重定向器 NFS/CIFS TCP/IP 协议栈 网络接口卡

FC SAN

主机

应用

IP SAN

主机

X86服务器1

VM VM

VM

X86服务器2

…

VM

X86服务器N

X86服务器2

VM VM

X86服务器N

VM VM

FC/iSCSI

...

CPU 硬盘 硬盘 CPU … SAN

软件定义存储

硬盘

硬盘

硬盘

硬盘

硬盘

… …

…

硬盘

硬盘

硬盘

硬盘

硬盘

硬盘

硬盘

硬盘

分布式块存储架构

分布式无状态机头 IOPS提升3~5倍,性能线性扩展

应用 数据库 裸卷 文件/操作系统 逻辑卷管理器 数据库 裸卷

文件/操作系统

逻辑卷管理器

SCSI 设备驱动 FC协议栈 FC总线卡

SCSI 设备驱动 iSCSI Layer TCP/IP Stack 网络接口卡

文件处理 I/O 块处理 I/O

IP Network

块处理 I/O

FC Network

块处理 I/O

GE

8G FC

10GE

56G FDR

槽点:成本高,技术支持差,线缆长度受限,网红目前有逐渐被万兆网络和高性能网卡替换的 趋势

分布式块存储---物理组网

组网归一

前端业务网络、后端存储网络均采用10GE,支持向 25GE/100GE平滑演进。 块、文件、对象统一硬件、统一网络管理。

实现SDS的scale-out架构

传统集中存储Scale-Up架构

1. 2. 3. 通过昂贵硬件保证系统的高可用性 管理维护要求能力高 扩展方式通过增加硬件配置实现 VM

X86服务器1

分布式存储Scale-Out架构

1. 2. 3. X86硬件,软件定义实现自动化、智能机制 管理维护要求能力低 扩展容易,可以达到PB级扩容空间

逻辑卷

LUN1

逻辑卷

LUN2

LUN3

物理卷

物理卷

RAID10

RAID5

单个物理卷上创建1个逻辑卷

单个物理卷上创建2个逻辑卷

存储基本概念---磁盘阵列

•

控制器

控制器是磁盘阵列的“大脑”,主要部 件为处理器和缓存,最先主要实现简单 IO操作、RAID管理功能,随着技术发 展,能够提供各种各样的数据管理功能 ,如快照、镜像、复制等 磁盘柜包含了多块的磁盘,本身既没有 处理器,也没有缓存,RAID及数据管 理功能通过控制器实现 槽点:中高端存储经过crossbar架构、 全点对点总线架构等演进,掌握架构基 本靠想象,黑盒子形成

PB时代,10~100GB/s,分布式架 构

1956年 世界第一台磁盘存储 系统IBM 305磁盘介 质取代打孔卡,容量 5MB读写速率10K/s

1980年,薄膜磁头技 术,性能飞跃,容量 8*2.52GB 读写速率3MB/s

1993年 EMC Symmetrix 16MB DRAM, 1 GB Global Memory,容量1 TB, Hypervolume Extension

计算 存储

Cache Controller Controller Cache Controller

存储

分布式Cache 支持400G/800G/1.2T/2.4T的PCIE-SSD做高速缓存 支持多个SSD盘做高速缓存 在SATA盘场景下, 平均每盘100 IOPS以上,每节点最高可达到2000 IOPS 最小时延1mS 平均时延<5ms 在PCIE-SSD做场景下 平均每存储节点100K IOPS 最小时延0.3MS 平均时延<1MS

存储本质上是IT硬件集成,IT软件定义。无非是集成和定义谁来做的问题。

独立业务存储

再修三年 修三年 新三年 旧三年

行业网关

修三年 新三年 旧三年

智能网 短、彩信

新三年 旧三年

统一增值平台 信令监测

新三年

各存储池形成 ,新购减少

移动E管家

MISC

彩铃

彩铃等大 量存储上 线

新增少,替 换成本高.

2003~2005

投资:一次性成本较高,中高端集采单价1.5W/TB,光交30-40万一对,FC适配器可忽略;

如无规模优势,维保成本高;维护人员成本高,令人艳羡的待遇;能耗成本高。

工程集成:zone、LUN、RAID、owner、多链路、卷管理、备份、冗余、容灾。。。。工 作量较大,技能get投入大 维护监控:一套存储三种软件,有额外软件成本;厂家异构型号异构让统一存储运维只是一 个梦想;运维数据难于导出和解读,“拿去!你看不懂!”;故障处理往往需要多方会诊,问 题定位周期长,分析靠创意,排查靠遍历。 扩容升级:需要停机、扩容周期长、实施风险高,0点以后3小时起刷大夜。 性能表现:需根据实际配置进行计算,从不能相信技术指标;性能数据需专业解读,性能优 化基本靠扩 高可用及稳定性:稳定性高的背后,是大量的更换备件和升级版本操作;高可用演练环节多 ,药不能停;设备老旧,稳定性骤减,老干部要好好伺候。

IP Network

网络接口卡 TCP/IP 协议栈

NFS/CIFS

数据管理系统 文件系统+ 逻辑卷管理器 RAID 设备驱动 块处理 I/O

FC总线卡 FC协议栈 数据管理系统 RAID 设备驱动 块处理 I/O

网络接口卡 TCP/IP协议栈

数据管理系统

RAID 设备驱动 块处理 I/O

传统存储的问题总结(满满的槽点)

几个存储新概念

软件定义存储:存储资源由软件自动控制,通过抽象、池化和自动化,将标准服务器内存 存储、直连存储、外置存储或云存储等存储资源整合起来,实现应用感知,或者基于策略 驱动的部署、变更和管理,最终达到存储即服务的目标

超融合(HCI):是指同一套单元设备(如X86通用服务器)同时具备提供计算、存储和网 络服务的能力

架构缺陷与石桥网管资源池相同 HP 3PAR SS7440存储为2TB的SATA盘,降低了存储整体性能 ,厂家检测: Vlun的read latancy为 368ms,高峰为438ms, Write latancy为 44 ms,高峰为59ms,可承受的合理IOPS不超 过9000,目前的实际IOPS为24068,超负核近2.5倍,风险非 常高。 产业园后端FC的3台存储硬盘总数(819块),远低于其他两 个资源池,整池IOPS性能较低,需要扩容。