挑战极限 Oracle数据库一秒导百万数据

网络安全管理员试题库(含参考答案) (2)

网络安全管理员试题库(含参考答案)一、单选题(共69题,每题1分,共69分)1.下面不属于身份认证方法的是()。

A、姓名认证B、智能卡认证C、指纹认证D、口令认证正确答案:A2.安全管理工作必须贯彻“()”的方针?A、安全第一、预防为主、综合治理B、群防群治C、谁使用、谁负责D、一把手问责正确答案:A3.根据《中国南方电网有限责任公司信息安全事件管理办法》,省公司信息部对可能引发重大信息安全事件的情形发布(),对可能引发较大信息安全事件的情形发布()A、橙色预警,黄色预警B、红色黄色橙色预警C、黄色预警橙色预警D、橙色预警红色黄色正确答案:A4.信息安全工程监理是信息系统工程监理的重要组成部分,信息安全工程监理适用的信息化工程中,以下选择最合适的是:()。

A、通用布缆系统工程B、电子设备机房系统工程C、计算机网络系统工程D、以上都适用正确答案:D5.造成系统不安全的外部因素不包含()。

A、黑客攻击B、没有及时升级系统漏洞C、间谍的渗透入侵D、DDOS正确答案:B6.关于光纤的特性,下列说确的是()。

A、因为光速很快,光纤的传输速率是无极限的B、因为光纤传输的是光信号,因此传输信号无衰减C、光纤传输的是光信号,因此抗干扰能力比较强D、光纤传输距离无极限正确答案:C7.依据《网络安全法》规定,网络产品、服务应当符合相关国家标准的()性要求。

A、强制B、推荐C、规定D、规范正确答案:A8.系统管理员属于()。

A、既可以划为管理层,又可以划为执行层B、决策层C、管理层D、执行层正确答案:D9.已投运的电力监控系统应每()进行一次安全评估。

A、半年B、一年C、两年D、三个月正确答案:B10.根据我国《电子签名法》的规定,数据电文是以电子、光学、磁或者类似手段()的信息。

A、生产、接收B、生成、发送C、生成、发送、接收、储存D、生成、接收、储存正确答案:C11.完整的数字签名过程(包括从发送方发送消息到接收方安全的接收到消息)包括()和验证过程。

Exadata产品介绍

信贷 ODS

核心

ERP

报表、风险……

标准化,易于部署

• 所有的数据库一体机都是相同的

• • • • • 开箱既用的 经过测试的 支持优异的 没有独特的配置问题 与Oracle工程部使用的配置相同

• 可以运行现有的OLTP和数据仓库应用

• 继承了30多年的Oracle数据库能力

• 无需Exadata认证 部署只需几天, 而无需数月

2台 8Core * 8CPU (128核)

2台 1T内存(2T内存) X2-2: 8台 6Core * 2CPU (96核) 8台 96G内存(768G内存)

1 Cisco 以太网交换机 (48口,10Gb/s)

3 InfiniBand 交换机(满 半) 1 (1/4) (36口, 40Gb/s)

InfiniBand线缆照片

数据库一体机的完整家族

支持 OLTP、数据仓库和大集中等不同工作负载

Oracle Exadata X2-2 Oracle Exadata X2-8

• ¼配、半配、满配和多机架

• 满配和多机架

Exadata X2&X8 满配

14台存储服务器

存储: 高性能:100T 高容量:336T Flash: 14台 * 378G (5.3T) CPU: 14台 6Core * 2CPU (168核) 内存: 14台 * 24G (336G内存) X2-8: 数据库服务器

I/O 吞吐 (磁盘)

25GB/sec

I/O 吞吐(flash)

磁盘 IOPS Flash IOPS 数据加载

75GB/sec

50,000 1,500,000 12TB/小时

新–Exadata数据库一体机X2-8满配

达梦数据介绍

达梦如何冲击核心业务系统——国产数据库的产品发展之道韩朱忠达梦数据库一家国产数据库厂商愿景——坚持原始创新、实现产业报国提供丰富的数据处理产品和解决方案:•数据交换•数据管理•数据分析达梦坚持以关系数据库(DM7)为基础说到“国产数据库”——起步中国数据库国产化的努力工作,始于上世纪80年代达梦公司的前身——大学的一个课题组,同期起步重大行业核心的生产、控制和管理系统行业外围系统或中小企业信息管理系统关于“国产数据库”——缓慢前行三十年来,国产厂商大部分的努力,都是在低端市场搏杀金融、电信核心交易系统毋容置疑,从市场来看国产数据库发展的太慢低技术含量、低利润、低知名度、低品牌形象高端市场难以突破2008电力调度,生产库——核心系统三家厂商拼了近3年,首单落地——选型PK、定制开发、性能调优、驻场维保Now:90+%份额Get但仅这样,还远远不够!2012中国航信-航空电子客票2013国家工商管理总局-国家企业信用信息公示值得激动的新机遇重大行业核心的生产、控制和管理系统行业外围系统或中小企业信息管理系统金融、电信核心交易系统市场利益&社会责任民航电子客票中国民航市场2016年规模达到900余万次航班4.9亿人次出行经过三年的服务和支持达梦先后在首都航空、西藏航空、国航、东航成功投产,后续将进一步全面替代稳定&可靠——满足365*24的不间断运行性能——从容应对节假日、重大活动等出行高峰期的机票查询、预定请求快速移植——支持开发商在3个月内,完成涉及到约10万行数据库相关源码(对象定义、SQL、过程、触发器)从Oracle向DM的移植国家企业信用信息公示将服务于大量投资者、媒体、监管机构及社会公众全国上亿企业、个体从业者的登记、变更、及查询等服务向相关机构提供全国企业经营数据分析结果截至目前,已部署达梦集群实例三十余套,日检索业务1650万笔性能——满足复杂分析和并发事务处理请求运维——满足数据中心的所有DB实例集中管理要求挑战简要汇总如下稳定&可靠快速移植性能运维01020304更高的产品质量Oracle 兼容高可用方案SQL 优化能力大规模部署监控维护并发性能产品技术的应对——质量365*24运行,意味着产品必须有良好的代码质量常见的稳定性问题内存泄露问题内存初始化问题非法输入问题环境异常问题资源占用问题复杂负载问题……对测试水准提出更高要求执行:自动化的版本编译、执行、问题报告系统•每日冒烟测试•生成用例/场景上万个•纯文本测试脚本达到6GB•覆盖主流软硬件平台•向研发自动提交测试发现的严重问题测试覆盖面:不断扩展测试方法和内容•测试用例自动生成•静态代码分析•动态内存泄露检测•自动故障注入•系统性能剖析•仿真系统测试•……用户量以50%速度增加,而漏出缺陷在下降挑战简要汇总如下稳定&可靠快速移植性能运维01020304更高的产品质量Oracle 兼容高可用方案SQL 优化能力大规模部署监控维护并发性能传统意义上的高可用•实时数据复制•自动故障切换•两地三中心多活•……达梦面临高可用的第二重含义——异构双活•达梦到其他数据库•实时数据复制•故障切换高可用方案的双重含义针对部分初次接触达梦的用户——高可用方案的双重含义购买一套国产数据库把应用移过去上线应用移植完成,经过了调试优化、仿真测试,是否就可以上线?疑问:•仿真测试环境与真实生产环境等效?•万一有潜藏的功能性能问题爆发,导致业务停滞怎么办?•只能选择上线或不上线,没有第三种选择?•是否上线谁能说了算,凭什么说了算?部署方式:达梦数据库其他数据库应用系统实时数据同步DMHS效果实时同步,同时支持国外主流系统和国产系统在线数据对比,不停止在线生产系统情况下,确保两边数据完全一致其他产品为主达梦为备达梦为主其他为备达梦在线数据对比试运行/风险评估期缓解疑虑建立信任中国铁建神华集团用友政务工商管理总局国家电网海南社保中新网湖北知识产权局南方电网国家海洋局中船**河北财政厅中国航信重庆经济信息中心**审计厅……挑战简要汇总如下稳定&可靠快速移植性能运维01020304更高的产品质量Oracle 兼容高可用方案SQL 优化能力大规模部署监控维护并发性能与开源数据库相比商业数据库在产品技术上,核心优势在哪里?达梦在服务于行业用户、核心业务系统时,认识到了一项关键区别——复杂SQL的处理能力来看一条我们曾经经历过的SQL 的例子with“COL1" as(select"I".“XCOL1"+1 "PzPeriod" ,'0.0' "OrderNum" ,null "PzDay" ,'' "VchrNum" ,'' "DFKM" ,1 "SortOrder" ,0 "ItemOrder" ,0x00000000000000000000000000000000 "RECID",'' "Digest" ,'' "CurrencyName" ,1 "POSTFLAG" ,1 "ORIENT" ,'' "DEFAULNAME" ,sum(case when "I"."BF" is nullthen 0.0 else "I"."BF" end*case when“X"."ORIENT"=0x00000000000000000000000000000001 then 1 else -1 end) "BF",……from“Y_T" "S")"S"放进word里,达到359页;共1 3 .9千行)"N"17个inner join、557个子查询、831个or筛选、1000+个查询字段、2451个like筛选条件、2731个case when表达式达梦的SQL引擎需要有处理此类查询的能力!达梦SQL 引擎分析器Parser优化器Optimizer执行器Executor总体来说,达梦拥有一个典型的、基于代价的关系数据库SQL 引擎SELECT A,C FROM T1 WHERE B LIKE ’DM’;统计信息数据字典数据执行结果语法分析语义分析关系代数变换代价优化语法树SFW 结构关系树优化了的关系树SQL 脚本物理计划生成执行计划SQL 引擎的具体处理流程重点打磨对象为提供更强大的SQL 处理能力DM7六年来对SQL 引擎进行持续改进用集合操作取代迭代操作•外层表下压消除相关•内外层半连接(SEMIJOIN)充分考虑多种连接方案代价•计算N个最大表的连接代价•确定候选连接顺序(Catalan数)•过滤条件下放代价计算•变换Or到最外层,便于索引利用•变换Or为IN,利用子查询,成为集合操作针对大量表的Join(如:6表以上)减少Join参与表的数量,改进计划代价生成速度•满足特定条件的表,下推到子查询内•下推:筛选条件下推视图,增强过滤条件•上拉:部分情况下,直接将视图分解到上层查询•前后通配符优化为Position操作•前通配符优化为可利用REVERSE函数索引Such asOr运算符变换相关子查询变换下推探测表视图优化Like优化生成连接次序More and more✓多级分区加列✓truncate ✓删列✓删除多级分区表✓拆分split ✓新增分区✓优化后,很多操作与O 性能相当或快10-100倍✓like 表达式存在可计算函数的优化✓优化分析阶段获取表行数操作的优化,避免了每次从磁盘获取行数信息✓Top n 查询改写为rowid/pk in 子查询,减少字段解析消耗; ✓Union 分支的连接公因子提取优化;✓布尔表达式范围合并的加强;✓增加统计操作符实际返回行数的功能;✓位图连接索引的使用增强;✓in value list 在mpp 、lpq 下的motion 计划优化✓.......分区表优化器改进✓hash 表memset 优化✓分区表hash 连接的裁剪;✓水平分区表分区列的排序、分组优化✓多层嵌套的分组合并✓通过增加排序操作实现归并连接;✓嵌套循环半连接增加key 的缓存处理执行器分区表执行器优化器其他✓内存管理模式优化✓Tpcc 性能提升明显其他改进回过头来看这条SQL20分钟+1分钟以内放进word里,达到359页;共1 3 .9千行17个inner join、557个子查询、831个or筛选、1000+个查询字段、2451个like筛选条件、2731个case when表达式挑战简要汇总如下稳定&可靠快速移植性能运维01020304更高的产品质量Oracle 兼容高可用方案SQL 优化能力大规模部署监控维护并发性能民航客票系统,机票信息的源头接入各航空公司的官网订票系统、机票代理商、互联网出行平台……国家企业信用信息公示,开放的互联网服务平台面向社会公众,日均查询访问1650万次数据库并发性能是用户的核心关注高并发能力系统架构内核设计底层技术•多线程架构•读写分离、共享存储等集群架构•行级封锁•多版本并发控制•并行日志•事务可见性判断•Buffer&Cache 设计•异步检查点机制•……•线程同步机制•原子操作实现•异步IO 模型•用户态线程•……数据库并发设计优化是系统性的工作多版本并发控制•很多数据库实现了MVCC:Oracle、MySQL/InnoDB、PostgreSQL •PostgreSQL:未引入回滚段•各版本数据都存在数据文件,数据膨胀问题•导致大量更新后的扫描性下降•Oracle:基于块的MVCC•DM7:基于行的MVCC•更多并发更新、查询集中在一个Page的情况下•提供更好的并发能力封锁机制•Mysql/Innodb•使用一个hash表总体管理行锁•每个page的行锁使用一个bitmap表示•更新page越多,维护锁的内存开销越大•锁越多,需要进临界区的次序就越多物理实现的锁代价是高昂的•Oracle每个记录的LockBit指向Block的ITL,描述了锁信息•实现锁的消耗要小得多DM7更进一步,彻底消除行锁Mysql/Innodb行锁示结构意图•修改过的行标识对应事务的编号(唯一递增,TID)•读-写:根据本事务ID与记录TID大小判断可见性•写-写:基于页面闩+TID可见性,实现锁定效果•减少资源消耗•没有锁升级问题DM7行级锁示意图TPC-C单机压力极限测试Intel Xeon E5-2697V4*2 384GB DDR4PCI-E SSD 2TB 稳定在:1,330,000 tpmc约相当于:70万QPS (90%为增删改)TPC-C单机并发测试10Warehouse50 Session100Warehouse500 Session1000Warehouse5000Session达梦179802.75tpmc220590.48tpmc134995.45tpmc友商A162375.36tpmc208364.16tpmc46959.04tpmc友商B134974.85tpmc209131.97tpmc69196.5tpmc注:采用benchmarksql4.1.1作为测试工具Intel Xeon E5-2620v3 *296GB DDR3SAS 10K RPM 600GB*2 RAID1设备不变,并发量X100,数据量X100,DM性能损耗最小近期某项目POC测试挑战简要汇总如下稳定&可靠快速移植性能运维01020304更高的产品质量Oracle 兼容高可用方案SQL 优化能力大规模部署监控维护并发性能核心业务系统是国外产品的天下达梦是后来者兼容策略是成本最低的开发人员培育、项目替代方案提供达梦数据迁移工具完成数据迁移,支持数据快速装载包含几乎所有Oracle 的数据库对象,且创建语法及使用方式与Oracle 保持一致高度兼容的数据类型、PL/SQL 、动态视图等特性采用单库、单实例的架构,与Oracle 保持一致文件组织结构、并发控制特性的概念与机制接近逻辑概念相近,快速理解数据库结构Oracle 原生接口级兼容从底层到上层,完整的兼容体系•业务系统几乎没有对数据库相关代码进行修改•保证如期完成系统移植•用户的注意力得以聚焦在系统稳定性和性能•兼容Oracle 的OCCI 接口;•兼容Oracle 的DBLINK 定义和使用;•兼容Oracle 的包PACKAGE 定义和使用;•兼容Oracle 的作业JOB 的定义和实现;•兼容Oracle 的系统包(UTF_FILE 、DBMS_SQL 、DBMS_OUTPUT 、DBMS_JOB 、DBMS_LOB 等);•兼容Oracle 的DMP 文件导入和导出的逻辑备份方式;•兼容Oracle 的DUAL 伪表、ROWNUM 伪列等•兼容Oracle 语法风格的Pro C 接口•……针对民航客票系统的兼容改进•延续了开发商对Oracle 深层技术的使用习惯•实现了原oracle 50万行存储过程的平滑移植•保证了与oracle 一致的用户体验•兼容Oracle 的VPD 虚拟数据库模块;•兼容Oracle 的merge into 语法;•兼容Oracle 的正则表达语法;•兼容Oracle 的系统包、系统视图(DBMS_RANDOM 、DBMS_STATS 、DBA_OBJECTS 、DBA_JOBS 、USER_TYPES 、USER_SEGMENTS 等);•兼容Oracle 的last_value 、to_clob 、decode 等函数;•兼容Oracle 的分区表结构修改语法;•兼容Oracle 的CASE WHEN 动态拼接语法;•兼容Oracle 的序列取值范围;•……南网财务的兼容特性清单Case:VPD 兼容Case:正则语法兼容挑战简要汇总如下稳定&可靠快速移植性能运维01020304更高的产品质量Oracle 兼容高可用方案SQL 优化能力大规模部署监控维护并发性能核心业务系统在部署维护方面与相对外围的、中小规模的系统相比有很大的不同规模化集中化自动化远程化•基于WEB•对象管理•集群部署•状态监控与告警等功能支撑了用户约三十余套达梦集群实例的统一部署、监控和管理产品技术的应对——小结拿下核心系统,是由于对以下需求进行了积极响应提供建立信任的渠道(提供异构同步机制)系统稳定性有保证(充分测试,保证代码质量)性能足够良好(良好的SQL引擎与并发优化)能以较低成本、较快速度与现有应用适配(Oracle兼容)提供较好的管理运维方案(Web化运维管理平台)新进展&新计划共享存储集群•ASM 、VIP、负载均衡、TAF 等特性•已小规模上线试运行易用性•进一步完善DEM 运维管理平台•兼容性持续改进生态•得到ArcGIS 原生支持的唯一国产品牌•更多重量级ISV的合作云•公有云——阿里云市场上架•私有云——H3C 、华为、浪潮云解决方案集成服务•达梦技术支持互联网门户•“管家式、深层次”数据库服务我们梦想做最好的数据库脚踏实地、聚焦技术面对用户永远谦逊扫码微信关注达梦动态扫码加入达梦技术QQ群。

Oracle 常见错误

Oracle 常见错误使用ORACLE的过程过,我们会经常遇到一些ORACLE产生的错误,对于初学者而言,这些错误可能有点模糊,而且可能一时不知怎么去处理产生的这些错误,本人就使用中出现比较频繁的错误代码一一做出分析,希望能够帮助你找到一个合理解决这些错误的方法,同时也希望你能够提出你的不同看法。

毕竟作为一种交流的手段,个人意见难免过于偏颇,而且也必定存在着不足,出错之处在所难免。

写这篇文章的目的就是想通过相互之间的交流共同促进,共同进步。

ORA-01650:unable to extend rollback segment NAME by NUM intablespace NAME产生原因:上述ORACLE错误为回滚段表空间不足引起的,这也是ORACLE数据管理员最常见的ORACLE错误信息。

当用户在做一个非常庞大的数据操作导致现有回滚段的不足,使可分配用的回滚段表空间已满,无法再进行分配,就会出现上述的错误。

解决方式:使用“ALTER TABLESPACE tablespace_name ADD DATAFILE filename SIZE size_of_file”命令向指定的数据增加表空间,根据具体的情况可以增加一个或多个表空间。

当然这与还与你主机上的裸盘设备有关,如果你主机的裸盘设备已经没有多余的使用空间,建议你不要轻意的增加回滚段表空间的大小,可使用下列的语句先查询一下剩余的tablespace 空间有多少:Select user_name,sql_text from V$open_cursor where user_name=‟‟;如果多余的空间比较多,就可以适当追加一个大的回滚段给表空间使用,从而避免上述的错误。

你也可以用以下语句来检测一下rollback segment的竞争状况:Select class,count from V$waitstat where calss in(‘system undo header’,’system undo block’,’undo header’,’undo block’);和Select sum(value) from V$sysstat where name in (…db_block_gets‟,‟consistents gets‟);如果任何一个class in count/sum(value)大于1%,就应该考虑增加rollback segment。

Oracle Exadata数据库一体机极致性能和最佳实践

Exadata 采用更高的单路带宽

- InfiniBand提供40Gb/s的带宽,比高端阵列 的光纤通道技术快8倍

Exadata 提供更高的IOPS

- 智能Exadata Smart Flash Cache技术处理更 多的IOPS

• 冗余40Gb/s 交换机 • 统一的服务器和存储网络

• 5.3 TB PCI 闪存 • 跨服务器进行存储镜像

© 2010 Oracle Corporation – Oracle Confidential

CONFIDENTIAL – ORACLE HIGHLY RESTRICTED

6

– 6–

Exadata X2 体系架构

CONFIDENTIAL – ORACLE HIGHLY RESTRICTED

4

前所未有的交钥匙方案:

Sun Oracle Exadata X2数据库机

• 完整的, 预配置的, 严格测 试的系统提供极限性能 • 随付即用的系统 • 高性能、高可用性

© 2010 Oracle Corporation – Oracle Confidential

Copyright © 2009, Oracle Corporation and/or its affiliates

CONFIDENTIAL – ORACLE HIGHLY RESTRICTED

8

– 8–

Exadata数据库一体机创新的技术架构

集中管理平台

三层架构/两层应用 架构

客户端 避免单点故障

智能存储层 1M IOPS/机架

Exadata Cell

Exadata Cell

Oracle 数据库一体机 — Exadata

• Sun Oracle Database Machine

– 预配置,提供高性能 – 平衡的系统 – 无限扩展性能,容量、带宽和处理 能力

• Exadata Storage Server Software 11gR2

• Exadata Storage Server Software 11gR2 • Oracle Database 11gR2

© 2009 Oracle Corporation - Confidential

6

Exadata 产品

Exadata Storage Server & Database Machine • Exadata Storage Server

– 为Oracle 数据库优化的存储产品 – 提供极限 I/O 和 SQL 执行性能 – 软硬件一体化

数据库处理

超高速并发网络

Exadata Cell

InfiniBand 交换网络

Exadata Cell

Exadata Cell

智能存储

基础技术 – 分布式计算

计算密集型处理 • Exadata 智能存储服务器

– 在存储部件中实现数据密集型处理 • 进行表及索引扫描,过滤查询无关数据

数据密集型处理

• 数据库服务器承担计算密集型处理(同传统结构)

– 50 GB/秒

50 40 30

未压缩数据的查询吞 吐量

50

• 与列压缩相结合

21 11.4 7.5 10

20 – 闪存中有超过 50 TB 的数据 10 – 对压缩数据的查询提高 到 500 GB/秒

0

HITACHI

USP V

TERADATA NETEZZA SUN ORACLE

oracle序列达到最大值处理方法

一、概述在使用Oracle数据库时,序列(Sequence)是一个非常重要的对象,用来生成唯一的连续数字。

但是在实际的数据库应用中,我们经常会遇到序列达到最大值的情况,这时就需要针对这一问题进行处理。

本文将介绍在Oracle数据库中处理序列达到最大值的方法。

二、序列达到最大值的问题1. 什么是序列达到最大值?当一个序列达到其定义的最大值时,再次使用该序列生成值会导致错误,这是因为超出了序列的范围,这就是序列达到最大值的问题。

2. 为什么会出现序列达到最大值的问题?在实际的数据库操作中,特别是在大型系统中,由于数据的增删改查频繁进行,序列的使用也会相应增加。

而如果对序列表进行不当的管理和规划,就容易出现序列达到最大值的问题。

三、处理方法在Oracle数据库中,我们可以采取以下方法来处理序列达到最大值的问题。

1. 修改序列的增长步长在创建序列时,可以指定其增长步长。

如果已经创建的序列达到了最大值,可以通过修改其增长步长来延长序列的使用寿命。

假设我们的序列名为SEQ_TEST,当前的步长为1,最大值为1000,则可以通过如下语句来修改增长步长:```sqlALTER SEQUENCE SEQ_TEST INCREMENT BY 1000;```这样一来,原本每次加1的序列,现在每次加1000,就可以延长序列的使用寿命。

2. 修改序列的起始值另一种处理序列达到最大值的方法是修改序列的起始值。

可以通过以下语句来修改起始值:```sqlALTER SEQUENCE SEQ_TEST RESTART WITH 1;```这样就会使序列重新从1开始增长,可以继续使用。

不过需要注意的是,在数据库中可能会存在使用到该序列值的表,如果不对这些表进行相应处理,就会导致数据不一致。

3. 创建新的序列如果以上两种方法都无法满足需求,也可以考虑创建一个全新的序列来替换原有的序列。

首先需要创建新的序列,并将原有的序列使用替换成新的序列。

Java实现大批量数据导入导出(100W以上) -(二)导出

Java实现⼤批量数据导⼊导出(100W以上) -(⼆)导出使⽤POI或JXLS导出⼤数据量(百万级)Excel报表常常⾯临两个问题:1. 服务器内存溢出;2. ⼀次从数据库查询出这么⼤数据,查询缓慢。

当然也可以分页查询出数据,分别⽣成多个Excel打包下载,但这种⽣成还是很缓慢。

⼤数据量导⼊请参考:那么如何解决呢?我们可以借助XML格式利⽤模板替换,分页查询出数据从磁盘写⼊XML,最终会以Excel多sheet形式⽣成。

亲测2400万⾏数据,⽣成Excel⽂件4.5G,总耗时1.5分钟。

我利⽤StringTemplate模板解析技术对XML模板进⾏填充。

当然也可以使⽤FreeMarker, Velocity等Java模板技术实现。

⾸先引⼊StringTemplate所需Jar包:使⽤技术为 stringTemplatepom.xml:1 <dependency>2<groupId>antlr</groupId>3<artifactId>antlr</artifactId>4<version>2.7.7</version>5</dependency>67<dependency>8<groupId>org.antlr</groupId>9<artifactId>stringtemplate</artifactId>10<version>3.2.1</version>11</dependency>⾸先准备导出Excel模板,然后打开-》另存为-》选择格式为XML,然后⽤⽂本打开XML,提取XML头模板(head.st可通⽤),数据体模板(boday.st):head.st可通⽤:1<?xml version="1.0"?>2<?mso-application progid="Excel.Sheet"?>3<Workbook xmlns="urn:schemas-microsoft-com:office:spreadsheet"4 xmlns:o="urn:schemas-microsoft-com:office:office"5 xmlns:x="urn:schemas-microsoft-com:office:excel"6 xmlns:ss="urn:schemas-microsoft-com:office:spreadsheet"7 xmlns:html="/TR/REC-html40">8<DocumentProperties xmlns="urn:schemas-microsoft-com:office:office">9<Created>1996-12-17T01:32:42Z</Created>10<LastSaved>2013-08-02T09:21:24Z</LastSaved>11<Version>11.9999</Version>12</DocumentProperties>13<OfficeDocumentSettings xmlns="urn:schemas-microsoft-com:office:office">14<RemovePersonalInformation/>15</OfficeDocumentSettings>16<ExcelWorkbook xmlns="urn:schemas-microsoft-com:office:excel">17<WindowHeight>4530</WindowHeight>18<WindowWidth>8505</WindowWidth>19<WindowTopX>480</WindowTopX>20<WindowTopY>120</WindowTopY>21<AcceptLabelsInFormulas/>22<ProtectStructure>False</ProtectStructure>23<ProtectWindows>False</ProtectWindows>24</ExcelWorkbook>25<Styles>26<Style ss:ID="Default" ss:Name="Normal">27<Alignment ss:Vertical="Bottom"/>28<Borders/>29<Font ss:FontName="宋体" x:CharSet="134" ss:Size="12"/>30<Interior/>31<NumberFormat/>32<Protection/>33</Style>34</Styles>boday.st:1 $worksheet:{2<Worksheet ss:Name="$it.sheet$">3<Table ss:ExpandedColumnCount="$it.columnNum$" ss:ExpandedRowCount="$it.rowNum$" x:FullColumns="1"4 x:FullRows="1" ss:DefaultColumnWidth="54" ss:DefaultRowHeight="14.25">5 $it.rows:{6<Row>7<Cell><Data ss:Type="String">$1$</Data></Cell>8<Cell><Data ss:Type="String">$2$</Data></Cell>9<Cell><Data ss:Type="String">$3$</Data></Cell>10</Row>11 }$12</Table>13</Worksheet>14 }$⽣成⼤数据量Excel类:ExcelGenerator:1package test.exportexcel;23import org.antlr.stringtemplate.StringTemplate;4import org.antlr.stringtemplate.StringTemplateGroup;5import test.exportexcel.bean.Row;6import test.exportexcel.bean.Worksheet;78import java.io.*;9import java.util.ArrayList;10import java.util.List;11import java.util.Random;1213/**14 * 类功能描述:generator big data Excel15 *16 * @author WangXueXing create at 19-4-13 下午10:2317 * @version 1.0.018*/19public class ExcelGenerator {20public static void main(String[] args) throws FileNotFoundException{21 ExcelGenerator template = new ExcelGenerator();22 template.output2();23 }2425/**26 * ⽣成数据量⼤的时候,该⽅法会出现内存溢出27 * @throws FileNotFoundException28*/29public void output1() throws FileNotFoundException{30 StringTemplateGroup stGroup = new StringTemplateGroup("stringTemplate");31 StringTemplate st4 = stGroup.getInstanceOf("test/exportexcel/template/test");32 List<Worksheet> worksheets = new ArrayList<>();3334 File file = new File("/home/barry/data/output.xls");35 PrintWriter writer = new PrintWriter(new BufferedOutputStream(new FileOutputStream(file)));3637for(int i=0;i<30;i++){38 Worksheet worksheet = new Worksheet();39 worksheet.setSheet("第"+(i+1)+"页");40 List<Row> rows = new ArrayList<>();41for(int j=0;j<6000;j++){42 Row row = new Row();43 row.setName1("zhangzehao");44 row.setName2(""+j);45 row.setName3(i+" "+j);46 rows.add(row);47 }48 worksheet.setRows(rows);49 worksheets.add(worksheet);50 }5152 st4.setAttribute("worksheets", worksheets);53 writer.write(st4.toString());54 writer.flush();55 writer.close();56 System.out.println("⽣成excel完成");57 }5859/**60 * 该⽅法不管⽣成多⼤的数据量,都不会出现内存溢出,只是时间的长短61 * 经测试,⽣成2400万数据,2分钟内,4.5G⼤的⽂件,打开⼤⽂件就看内存是否⾜够⼤了62 * 数据量⼩的时候,推荐⽤JXLS的模板技术⽣成excel⽂件,谁⽤谁知道,⼤数据量可以结合该⽅法使⽤63 * @throws FileNotFoundException64*/65public void output2() throws FileNotFoundException{66long startTimne = System.currentTimeMillis();67 StringTemplateGroup stGroup = new StringTemplateGroup("stringTemplate");6869//写⼊excel⽂件头部信息70 StringTemplate head = stGroup.getInstanceOf("test/exportexcel/template/head");71 File file = new File("/home/barry/data/output.xls");72 PrintWriter writer = new PrintWriter(new BufferedOutputStream(new FileOutputStream(file)));73 writer.print(head.toString());74 writer.flush();7576int sheets = 400;77//excel单表最⼤⾏数是6553578int maxRowNum = 60000;7980//写⼊excel⽂件数据信息81for(int i=0;i<sheets;i++){82 StringTemplate body = stGroup.getInstanceOf("test/exportexcel/template/body");83 Worksheet worksheet = new Worksheet();84 worksheet.setSheet(" "+(i+1)+" ");85 worksheet.setColumnNum(3);86 worksheet.setRowNum(maxRowNum);87 List<Row> rows = new ArrayList<>();88for(int j=0;j<maxRowNum;j++){89 Row row = new Row();90 row.setName1(""+new Random().nextInt(100000));91 row.setName2(""+j);92 row.setName3(i+""+j);93 rows.add(row);94 }95 worksheet.setRows(rows);96 body.setAttribute("worksheet", worksheet);97 writer.print(body.toString());98 writer.flush();99 rows.clear();100 rows = null;101 worksheet = null;102 body = null;103 Runtime.getRuntime().gc();104 System.out.println("正在⽣成excel⽂件的 sheet"+(i+1));105 }106107//写⼊excel⽂件尾部108 writer.print("</Workbook>");109 writer.flush();110 writer.close();111 System.out.println("⽣成excel⽂件完成");112long endTime = System.currentTimeMillis();113 System.out.println("⽤时="+((endTime-startTimne)/1000)+"秒");114 }115 }定义JavaBean:WorkSheet.java:1package test.exportexcel.bean;23import java.util.List;45/**6 * 类功能描述:Excel sheet Bean7 *8 * @author WangXueXing create at 19-4-13 下午10:219 * @version 1.0.010*/11public class Worksheet {12private String sheet;13private int columnNum;14private int rowNum;15private List<Row> rows;1617public String getSheet() {18return sheet;19 }20public void setSheet(String sheet) {21this.sheet = sheet;22 }2324public List<Row> getRows() {25return rows;26 }27public void setRows(List<Row> rows) {28this.rows = rows;29 }3031public int getColumnNum() {32return columnNum;33 }34public void setColumnNum(int columnNum) {35this.columnNum = columnNum;36 }3738public int getRowNum() {39return rowNum;40 }41public void setRowNum(int rowNum) {42this.rowNum = rowNum;43 }44 }Row.java:1package test.exportexcel.bean;23/**4 * 类功能描述:Excel row bean5 *6 * @author WangXueXing create at 19-4-13 下午10:227 * @version 1.0.08*/9public class Row {10private String name1;11private String name2;12private String name3;1314public String getName1() {15return name1;16 }17public void setName1(String name1) {1 = name1;19 }2021public String getName2() {22return name2;23 }24public void setName2(String name2) {2 = name2;26 }2728public String getName3() {29return name3;30 }31public void setName3(String name3) {3 = name3;33 }34 }另附实现源码: 此外,⼤数据量并并且Excel列较多时,会出现内存溢出。

oracle copy from参数

《深入解析Oracle中的Copy From参数》在Oracle数据库中,Copy From参数是一个非常重要的功能,它可以帮助用户在不同的数据库之间轻松地复制数据。

通过Copy From参数,用户可以将数据从一个数据库复制到另一个数据库,而且操作相对简单,方便快捷。

一、Copy From参数的作用在Oracle数据库中,Copy From参数主要用于实现数据库之间的数据复制。

它可以帮助用户将一个数据库中的数据复制到另一个数据库中,无论是在同一个服务器上,还是在不同的服务器上,都可以轻松搞定。

这对于在不同数据库之间进行数据同步、数据迁移以及备份恢复非常有帮助。

二、使用Copy From参数的步骤1. 连接源数据库和目标数据库在使用Copy From参数进行数据复制之前,首先需要连接源数据库和目标数据库。

用户需要在源数据库中执行一些特定的命令来准备数据,然后连接目标数据库并执行Copy From参数命令来完成数据复制的操作。

2. 执行Copy From参数命令执行Copy From参数命令时,用户需要指定源数据库和目标数据库的连接信息,以及要复制的数据表和字段等相关信息。

在执行命令的过程中,用户还可以根据实际需求进行一些参数配置,如过滤条件、数据转换等,以满足不同的复制需求。

3. 监控复制过程在数据复制过程中,用户需要及时监控复制的进度和状态,以确保复制过程能够顺利进行。

如果在复制过程中出现了一些错误或者异常情况,用户还需要及时处理,以避免数据的丢失或者损坏。

三、Copy From参数的个人观点和理解Copy From参数是Oracle数据库提供的一个非常实用的功能,它可以帮助用户解决数据库之间数据复制的难题,简化了数据迁移和备份恢复的操作流程。

通过Copy From参数,用户可以高效快速地完成数据复制,减少了人工操作的繁琐,提高了工作效率,降低了出错的概率。

总结回顾:通过本文对Oracle数据库中Copy From参数的深入探讨和介绍,相信读者对于该功能有了更全面、更深入的理解。

Oracle数据库及选件概述

创新

持续的技术革新

Oracle 11g

Oracle 8i Oracle 8 Oracle 7 Oracle 6 Oracle 5 Oracle 2

Exadata Storage Real Application Testing Advanced Compression

Automatic Storage Management Transparent Data Encryption Self Managing Database

Tech DB

OLAP

Data Mining Database SES Vault Audit DB Firewall Vault

Oracle DB Oracle Infra

OGG

System

SUN Machine/Tape libaray Oracle VM Unbreakable Linux

6

6

40G IB

智能存储层

1.5M IOPS/机架

6核

24G

Exadata Cell

Exadata Cell

• • • •

存储层智能,解决计算能力问题 横向并发计算,解决带宽和可靠性问题 Flash并发,解决IOPS问题 廉价标准化,解决价格及更新问题

极限性能:数据库云服务的可靠保障

最具设计创新,彻底解决数据库系统性能瓶颈

猜 心

这样的夜,热闹的街

问你想到谁,令你锁眉

面向未来的数据库平台 Exadata

系统架构

单实例数据库

RAC 集群数据库

8核 72G 8核 72G

数据库处理层 最新11g 超高速、并发网络层

InfiniBand Switch/Network

Oracle Exadata一体机解决方案

• 挑战

– 海量数据下的性能、稳定性、可扩展性——数据量在TB甚至几十TB以 上,并且会快速扩展,需要高性能和可扩展的技术支撑平台 – 系统的复杂度与开放性——支持多种不同的数据源,对分析类和操作 类混合负载的支持,与多个业务系统对接,双向数据交互的支持。 – 数据集中管理——数据大集中以后,如何保证各个业务系统的高可靠、 高性能。

IT企业信息化建设需要完整实时、集中的数据中心平 台 • 对于长期发展的企业而言,面临更加激烈的国际、国内竞争 如何提高企业信息系统的运行和管理效率,成为企业的 战略性目标 以客户为中心,为客户提供个性化的服务,提 高客户满意度,提高市场占有率和客户忠诚度 及时、全面、准确地掌握企业的运作信息,科学决 策,降低经营成本,在降低成本的同时扩展市场

© 2010 Oracle Corporation

12

Exadata关键特性满足需求

• 极限性能,卓越的用户体验

• 高可靠性、扩展性满足业务长期发展

• 绿色数据中心

• 整体系统,易管理

© 2011 Oracle Corporation

Exadata – Smart Scan 处理技术

Exadata为什么快10-100x倍?

Байду номын сангаас

20

Exadata 混合列压缩比较

1000

Uncompressed

1000

Uncompressed

100

Pure Columnar Cliff

OLTP Compress

500 500

OLTP

50

Hybrid & Pure Column

Table Size

0 0

Hybrid Pure Column

数据库快速参入百万数据的方法

数据库快速参入百万数据的方法如果您需要在数据库中快速插入大量数据,这通常涉及到的关键点是如何高效地将数据传输到数据库。

以下是一些方法可以帮助您在数据库中快速插入百万级别的数据:1. 批量插入:•批量插入大量数据时,每次插入的数据量越多,性能通常越好。

大多数数据库系统支持批量插入,而不是单条插入。

例如,在MySQL中,您可以使用的形式一次性插入多行数据。

禁用索引和约束:•在插入大量数据时,暂时禁用索引和约束可以提高性能。

完成插入后,您可以重建索引并应用约束。

在MySQL中,您可以使用来禁用索引,使用来禁用外键约束。

调整数据库配置:•根据您的数据库,调整相关的配置参数以获得更好的性能。

例如,调整缓存大小、I/O参数、连接池等。

分批插入:•如果数据量非常大,您可以考虑将数据分成较小的批次进行插入。

这样可以在不耗尽系统资源的情况下完成操作。

使用适当的文件格式:•如果您从文件中导入数据,使用CSV或JSON等格式可能比纯文本更有效,特别是当数据库支持这些格式的导入工具时。

并行处理:•如果您的系统支持并行处理,考虑同时从多个源或多个进程插入数据。

使用专业的ETL工具:•一些ETL(提取、转换、加载)工具专为快速加载大量数据而设计。

这些工具通常具有优化过的数据库接口和批量处理功能。

压缩数据:•在传输和存储之前压缩数据可以显著减少所需的时间和带宽。

考虑硬件和网络优化:* 确保您的服务器硬件足够强大,并且网络连接具有足够的带宽和稳定性。

对于远程数据库,考虑增加带宽或使用更稳定的数据传输协议。

2. 备份:* 在进行大量数据插入操作之前,请确保您有最近的备份。

这是一个好的做法,因为即使是最先进的系统也可能出现错误。

3. 使用专业服务:* 如果您处理的数据库非常大或非常复杂,您可能需要寻求专业的帮助或服务。

许多数据库提供商和服务商都提供这种服务。

4. 考虑数据库分片:•如果数据量非常大,可能需要考虑数据库分片。

分片是将数据分布在多个服务器上的方法,每个服务器都有其自己的数据库副本。

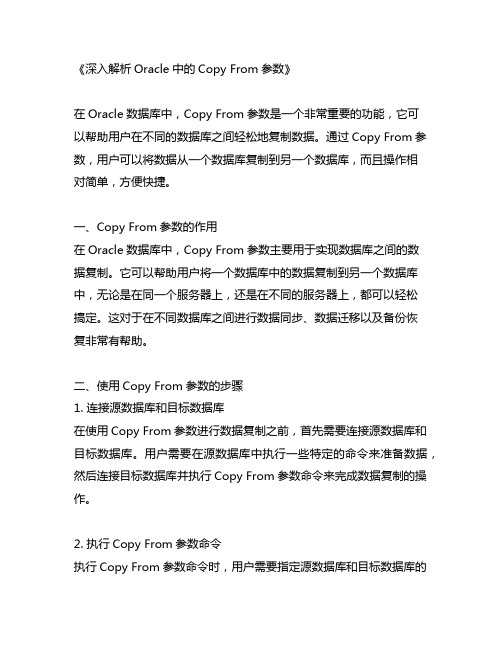

ORACLE导出导入(exp和imp)总结

1.1 EXP AND IMP导入导出的模式a表模式的导入导出b用户模式的导入导出c全库模式的导入导出导出表模式exp system/jaguar@cfp00_cpzb2003 tables=(cp.misywt14,cp.misywt18) file=d:\t8.dmplog=d:\t14t18_exp.log feedback=10000 compress=n用户模式exp system/jaguar@cfp00_cpzb2003 owner=cp file=e:\cp.dmp log=e:\cp_exp.logfeedback=10000 compress=n全库模式exp system/jaguar@bkup full=y filesize=2000M file=(cpzb01.dmp,cpzb02.dmp)log=cpzb_exp.log feedback=10000 compress=n使用参数文件导出(需要在当前路径下执行)exp system/manager@bgd-11_yang1 parfile=t09_exp.part09_exp.par文件内容tables = (test1.misywt09) file=e:\yang\t09.dmp log=e:\yang\t09_exp.log feedback=10000 compress=n快速导出使用参数direct=y recordlength=65535exp system/jaguar@cfp00_cpzb2003 owner=cp file=e:\cp.dmp log=e:\cp_exp.log direct=y recordlength=65535 feedback=10000 compress=n有条件的导出,windowsexp system/ckdb5@ckdb5 tables = (cp962008.misywt40_1) file=t40_96.dmp log=t40_96_exp.log feedback=10000 QUERY='where substr(ckhwh,1,1)="5"'导入表模式imp system/jaguar@cfp99_cpzb fromuser=cp touser=cp tables= (misywt14,misywt18)file=e:\t14t18.dmp log=e:\t14t18_imp.log ignore=y buffer=5120000 commit=yfeedback=10000用户模式imp system/jaguar@cfp99_cpzb fromuser=cp touser=cp file=d:\cp.dmp log=d:\cp_imp.log ignore=y buffer=5120000 commit=y feedback=10000全库模式imp system/jaguar@cfp99_cpzb full=y file=d:\cp.dmp log=d:\cp_imp.log ignore=ybuffer=5120000 commit=y feedback=10000导入大于2G的文件imp system/jaguar@cfp10_cpzbbak filesize=2000M buffer=81920 commyit=y ignore=yfile=(cpzb01.dmp,cpzb02.dmp,cpzb03.dmp,cpzb04.dmp) log=cpzb_imp.log feedback=10000使用参数文件导入(需要在当前路径下执行)imp system/manager@bgd-11_yang1 parfile=t09_imp.part09_imp.par 文件的内容fromuser=test1 touser=test1 tables=(misywt09) file=e:\yang\t09.dmp log=e:\yang\t09_imp.log ignore=y buffer=5120000 commit=y feedback=10000imp步骤说明(1) create table (2) insert data (3) create index (4) create triggers,constraints导出导入常见问题及解决方法1) unix上导出导入,使用多个用户或多个文件时不使用()2) ORACLE不同版本之间的导出导入oracle8.0.4 netwareoracle8.1.5 win2000oracle8.1.7 unix ware 7.1.18.0.4――>8.1.7使用8.0.4从自己导出,使用8.1.5导入8.1.78.1.7――>8.0.4使用8.1.5从8.1.7 导出,使用8.1.5导入8.0.48.1.5――>8.1.7使用8.1.5从自己导出,使用8.1.5导入8.1.78.1.7――>8.1.5使用8.1.7从自己导出,使用8.1.7导入8.1.5oracle8-oracle10之间导入导出的关系1个表的测试oracle8->oracle10test 源数据库目的数据库导出的oracle版本导入的oracle版本文件大小时间结果备注test18 10 8 8 成功有垃圾表BIN$bEheaq87S/q9CiHem/Ty6Q==$0test28 10 8 10 成功test38 10 10 8 失败10无法连接8test48 10 10 10 失败10无法连接8 结论:oracle8->oracle10 导出使用8,导入使用10oracle10->oracle8test 源数据库目的数据库导出的oracle版本导入的oracle版本文件大小时间结果备注test510 8 8 8 成功test610 8 8 10 失败10无法连接8test710 8 10 8 失败8不能读取10得导出文件test810 8 10 10 失败10无法连接8 结论:oracle10->oracle8 导出使用8,导入使用8使用oracle8导出oracle10时,出现错误EXP-00003: 未找到段(10,585868) 的存储定义原因:不能用oracle8导出oracle10。

高校智慧校园私有云解决方案

高校智慧校园私有云解决方案目录第1章数字化校园发展现状及需求分析................................................................................ - 3 -1.1 智慧校园概念............................................................................................................... - 3 -1.2 智慧校园需求分析....................................................................................................... - 4 -第2章高校私有云解决方案 (6)2.1 高校私有云数据中心解决方案 (6)2.1.1 高校云计算的发展与建设 (6)2.1.2 当前高校数据中心面临的问题 (7)2.1.3 高校私有云数据中心解决方案 (8)2.1.4 高校私有云方案亮点 (11)2.1.5 存储产品推荐 (12)2.2 服务器虚拟化解决方案 (13)2.2.1 服务器应用现状 (13)2.2.2 服务器虚拟化技术 (14)2.2.3 集中存储与服务器虚拟化 (17)2.2.4 服务器虚拟化存储解决方案 (18)2.2.5 存储产品推荐 (19)2.3 存储虚拟化解决方案 (20)2.3.1 存储虚拟化双机双柜解决方案 (20)2.3.2 异构存储虚拟化解决方案 (22)2.3.3 实时数据保护解决方案 (23)2.3.4 赛思存储虚拟化平台介绍 (24)2.3.5 赛思实时数据保护介绍 (25)第1章数字化校园发展现状及需求分析1.1 智慧校园概念在20世纪末提出“智慧校园”概念以来的十几年中,智慧校园经过高校信息化建设的不断摸索,逐渐的发展起来,目前已进入快速发展期。

通过数组方式向Oracle大批量插入数据(10万条11秒)

通过数组⽅式向Oracle⼤批量插⼊数据(10万条11秒)1.创建数据库PersonCREATE TABLE Person(id number,name nvarchar2(200) ,age number ,sex nvarchar2(200) ,password nvarchar2(200))2.在数据库建⽴⼀个type,对应JAVA端要传⼊的对象结构:CREATE OR REPLACE TYPE BUT_UKBNOV_CTC_ORDER_REC1 AS OBJECT (id number,name nvarchar2(200) ,age number ,sex nvarchar2(200) ,password nvarchar2(200)) 3.为了数组传输,建⽴⼀个数组类型的type:CREATE OR REPLACE TYPE BUT_UKBNOV_CTC_ORDER_TAB AS TABLE OF BUT_UKBNOV_CTC_ORDER_REC14,建⽴存储过程做插⼊⼯作:create or replace procedure bulkInsertCTDORDER(i_orders IN BUT_UKBNOV_CTC_ORDER_TAB)asctcOrder BUT_UKBNOV_CTC_ORDER_REC1;beginFOR idx IN1..i_orders.COUNT LOOPctcOrder:=i_orders(idx);INSERT INTO person(id,name,age,sex,password)VALUES(ctcOrder.id,,ctcOrder.age,ctcOrder.sex,ctcOrder.password);end loop;exception when others thenraise;end;5,建⽴JAVA端java bean对象package me.person;public class Person {public int getId() {return id;}public void setId(int id) {this.id = id;}public String getName() {return name;}public void setName(String name) { = name;}public int getAge() {return age;}public void setAge(int age) {this.age = age;}public String getSex() {return sex;}public void setSex(String sex) {this.sex = sex;}public String getPassword() {return password;}public void setPassword(String password) {this.password = password;}private int id;private String name;private int age;private String sex;private String password;}6.在JAVA端访问存储过程插⼊数据,需要做JAVA数据类型和存储过程类型type的映射,下⾯的StructDescriptor是mapping Oracle端AS OBJECT类型,tabDesc 是mapping Oracle端数组 AS TABLE OF类型的.package me.arrayinsertbatch;import java.sql.CallableStatement;import java.sql.Connection;import java.util.ArrayList;import java.util.List;import org.springframework.stereotype.Service;import me.person.Person;import oracle.sql.ARRAY;import oracle.sql.ArrayDescriptor;import oracle.sql.STRUCT;import oracle.sql.StructDescriptor;@Service("insertbatchservive")public class ArraybatchInsertFromExcel {public void insertbatchfromexcel() throws Exception//10万条11秒{double begin = System.currentTimeMillis();Connection con = null;CallableStatement cstmt = null;try {con = ArrayInsertBatch.getConn();List<Person> orderList = new ArrayList<Person>();for(int i=0;i<100000;i++){Person per=new Person();per.setId(i);per.setName("InsertName"+i);per.setPassword("insertpassword"+i);per.setSex("男");per.setAge(i);orderList.add(per);}//JSONArray json=JSONArray.fromObject(orderList);//System.out.println(json.toString());StructDescriptor recDesc = StructDescriptor.createDescriptor("BUT_UKBNOV_CTC_ORDER_REC1", con);ArrayList<STRUCT> pstruct = new ArrayList<STRUCT>();for (Person ord:orderList) {Object[] record = new Object[5];record[0] = ord.getId();record[1] = ord.getName();record[2] = ord.getAge();record[3] = ord.getSex();record[4] = ord.getPassword();// JSONArray json1=JSONArray.fromObject(record);// System.out.println(json1.toString());//System.out.println(record[4].toString());STRUCT item = new STRUCT(recDesc, con, record);pstruct.add(item);}//JSONArray json2=JSONArray.fromObject(pstruct);// System.out.println(json2.toString());ArrayDescriptor tabDesc = ArrayDescriptor.createDescriptor("BUT_UKBNOV_CTC_ORDER_TAB", con);ARRAY vArray = new ARRAY(tabDesc, con, pstruct.toArray());//JSONArray json=JSONArray.fromObject(pstruct.toArray());// System.out.println(json.toString());cstmt = con.prepareCall("{call bulkInsertCTDORDER(?)}");cstmt.setArray(1, vArray);//cstmt.setString(2, SYSJ);// cstmt.setString(4, QYSJ);cstmt.execute();mit();double time = (System.currentTimeMillis() - begin) / 1000; System.out.println("插⼊共花费时间" + time + "s");}catch(Exception ex){throw ex;}}}上⾯的⽰例在插⼊10万条记录只⽤了11秒。

Oracle数据库一体机(Exadata)介绍资料

可伸缩性支持增加更多的机架

Copyright © 2010 Oracle Corporation and/or its affiliates

– 7–

Exadata 数据库一体机X2-2满配

提供极限性能

• 8台2CPU(每CPU6核)64位的数据库服务器 • 96 核 (每台服务器12核) • 768 GB内存 (每台服务器96GB) • 对外提供10 GigE(万兆以太网)接口 • 16个10GbE 端口 (每台服务器2个端口 per server) • 14台Exadata存储服务器X2-2 • 高性能600GB SAS磁盘 或者 • 高容量2 TB SAS磁盘 • 3台Sun Datacenter InfiniBand Switch • 36-port Managed QDR (40Gb/s) switch • 1台专门用于管理的Cisco 以太网交换机 • KVM硬件 • 冗余的Power Distributions Units (PDUs)

flash?exadata是最快的?而且可以线形地扩展到更多的机架storagedatabandwidthuncompressedgbsec通用格式disk?存储阵列已经无法提供磁盘的带宽????没有闪存提供的额外带宽没有操作下推没有列压缩没有infiniband通用格式96

<Insert Picture Here>

• 通过提高IOPs20倍来打破随机I/O瓶颈 • 提高用户数据扫描带宽

• Exadata存储索引

• 消除不必要的I/O

• I/O Resource Manager (IORM)

• 按照不同的I/O优先级别使用存储网格, 保证可预知的性能

• 混合列压缩

• 高效的压缩,增加有效的存储空间, 提高用户数据扫描带宽

Pivotal_GemFire 解决方案和案例

© Copyright 2013 Pivotal. All rights reserved.

7

应用之一--ETL加速/报表加速

ETL的数据清洗、处理、加载等原 来基于Oracle/DB2的数据库存储过程, 速度比较慢,有时间窗口,随着数 据增加,处理时间越来越接近或是 超出时间窗口,通过 GemFire/SQLFire把数据加载到内存 中处理,速度提高50-100倍。 报表、统计等数据处理加速, BOCOM做过测试 某城商银行真正做ETL加速

使用 SQL 界面存储关系数据 支持 JDBC、ODBC、Java 和 .NET 界面 使用现有的关系工具

© Copyright 2013 Pivotal. All rights reserved.

5

采用 GemFire 的场景和切入点

应用场景

解决应用性能问题 OLAP数据处理不够快 报表生成 ETL CEP OLTP业务处理不够快 网上银行 录入系统 CRM 网上业务 综合支付平台 数据总线 花旗银行 双活数据中心(全局数据分布) 上海教委

解决方案切入点

PaaS平台 快应用 快数据 数据总线 大数据Installbase需要快数据

orcal中删除百万数据方法

orcal中删除百万数据方法

在Oracle数据库中删除大量数据有几种常见的方法,具体取决

于你的需求和环境。

以下是一些常见的方法:

1. 使用DELETE语句:你可以使用DELETE语句来删除大量数据。

例如,你可以编写类似于以下的SQL语句来删除数据:

sql.

DELETE FROM your_table WHERE your_condition;

这将删除符合条件的数据。

但是需要注意的是,DELETE语

句会生成大量的回滚日志,可能会导致数据库性能下降,特别是在

删除大量数据时。

2. 使用TRUNCATE TABLE语句,如果你需要删除整个表中的数据,而不是特定的行,你可以使用TRUNCATE TABLE语句。

这个语句

会更快速地删除表中的所有数据,因为它不会产生与DELETE语句相

同的回滚日志。

3. 分批删除,如果你需要删除的数据量非常大,可以考虑分批删除。

你可以编写一个循环,每次删除一小部分数据,直到所有数据都被删除。

这样可以减少对数据库的冲击,避免一次性删除大量数据对数据库性能的影响。

4. 使用分区表,如果你的表是分区的,你可以通过删除整个分区来快速删除大量数据。

这种方法可以减少对整个表的影响,提高删除效率。

5. 使用外部表,如果你需要删除的数据可以通过外部数据源进行识别,你可以考虑使用外部表和DELETE语句结合的方式来删除数据,这种方法可以提高删除效率。

需要根据具体情况选择合适的方法,同时在执行任何删除操作之前,请务必做好数据备份,以防止意外发生。

另外,如果可能的话,最好在非高峰期执行删除操作,以减少对数据库的影响。

淘宝网技术

高性能电子商务网站-淘宝网技术架构研究2008年淘宝的交易额是1000亿规模,2009年的时候是2000亿规模,2010年淘宝网的交易额4000亿规模,如何构建一个支撑这么大交易规模的高性能、并发的电子商务平台网站呢?以下结合网络资料,研究一下淘宝网的技术架构变迁。

淘宝网从2003年开始建立的,从1.0到1.5的版本.2005年开始2.0的版本,2012年4.0的版本上线。

马云的创业团队共10个人,马云以及他的秘书,8个里面有3个开发人员,三丰、多龙(音)、虚竹,还有UED的二当家,三位运营人员,小宝、阿柯和破天,总经理是财神。

团队开始研发是2003年4月7日,一个月后的5月10日淘宝第一个版本上线。

这段时间,创业团队关在小区里面写代码,每天早上9点到晚上1、2点。

淘宝网第一个版本MALT架构,采用PHP+MySQL首先花2000美金买了一个MALT架构网站,很精典的LAMP技术架构,刚开始的编程语言和数据库是PHP+MySQL,然后配套开发后台管理系统。

一开始部署在一台单机服务器上,流量增长后,把发邮件功能部署在一台机器上,后来再增加机器出来。

2004年MySQL撑不住了,数据存储的引擎很大缺点会锁表,一读的话把表锁住了,读的量一上来经常会锁掉,然后重启。

MySQL撑不住了,开始考虑换Oracle,除了Oracle强大之外还有一个原因是阿里巴巴那些年03、04年Oracle 人才积累达到非常强大的水平。

那时Oracle给全球的研发人员发一个称号“ACE”,那时全球三百多位,那时中国十来位,而阿里巴巴有三位。

阿里巴巴在Oracle方面能力非常强大。

换了Oracle有一个问题,PHP跟Oracle很不搭的东西,PHP一个用户访问过来建立一个连接切掉一个连接,而Oracle提供的连接数量非常有限的,因为有连接池的功能。

怎么用PHP来连接Oracle?我们就抄袭别人看,eBay用的太贵,没有用。

找了一个日本的,但是上了一个当,总重启。

Oracle Spatial 和 ArcSDE区别与联系

空间聚集函数概括了与几何对象相关的 SQL 查询结果。空间聚集函数返回类型为 SDO_GEOMETRY 的几何对象。空间聚集的使用提高了性能,降低了底层代码的复杂性。

10) 网络数据模型

在 Oracle 数据库 10g 中提供了一个存储网络(图形)结构的数据模型。它显式地存储和维护“连接—节点”网络的连通性并提供网络分析功能(如最短路径、连通性分析)。需要网络解决方案的应用程序包括运输、公共交通、公共设施和生命科学(生物化学路径分析)。

b) 数据库维护要求高。数据库维护人员要有较好的Oracle数据库知识、Arc/Info系列产品知识。

对于建立的高起点、高标准的信息系统,综合考虑城市地理信息系统的延伸性和扩展性、海量数据的存储、高效并发访问、系统的开放性和安全性等因素,选择Arc/Info系列产品来建设本系统自然是最理想的选择。

e) 模块化和可伸缩的特性,在构造系统时提供更大的灵活性,即可以是一个独立的应用也可以是跨越全球的分布式网络应用。

当然,ArcInfo是在系统对安全性和响应性能要求很高的情况下的解决方案。

缺点:

a) ArcSDE的License 限制较严、价格较高。系统的并发用户数较多时,License的购置成本将会很高。

Oracle Spatial 与 ArcSDE在实际应用中的区别

本文主要介绍的是关于Oracle Spatial 和 ArcSDE区别与联系的相关应用的具体介绍,Oracle Spatial 在实际的应用中不但具有传统的GIS所有的特性,而且它还是具有相关的数据库的相关特性。

一、ORACLE SPATIAL概述

对于运输应用程序,该网络数据模型还支持一个路线搜索特性。Oracle 引入了一个可伸缩的路线搜索引擎,该引擎提供了地址(或预先经过地理编码的位置)之间的驾驶距离、时间和方向。它作为一个 Java 客户端库提供给网络数据模型,这个网络数据模型可以容易地部署在 Oracle 应用服务器或独立的 OC4J 环境中。其他的特性包括:最快或最短路径的首选项,返回概要或详细的驾驶指导;并返回沿着一条街道网络从单个位置到多个目标位置的时间和距离。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

上一次文章中提及的试验: 挑战极限 C#百万数据4秒导入SQL Server

这个试验是针对SQL SERVER数据库的,宿主环境也是.Net,有兴趣的朋友可以将这两个试验对比一下,为日后工作批量导数提供支持。

另外,一些朋友对上次试验环境有些异议,认为应该对数据库和服务器做优化或设置,以体现试验最终的时间结果。这个固然会影响试验的时间结果,但考虑到在试验环境中,对数据库优化的标准与优化程度不便统一与定量,试验结果也不易说明其影响源,所以这次试验依然以标准数据库建库后的配置为主,试验所在服务器硬件环境与上次试验保持一致。实验目的在于挖掘、对比宿主程序中的数据批量操作方法。

command.Connection = conn;

//到此为止,还都是我们熟悉的代码,下面就要开始喽 //这个参数需要指定每次批插入的记录数

command.ArrayBindCount = recc;

//在这个命令行中,用到了参数,参数我们很熟悉,但是这个参数在传值的时候

//用到的是数组,而不是单个的值,这就是它独特的地方 mandText = "insert into dept values(:deptno, :deptname, :loc)";

conn.Open();

//下面定义几个数组,分别表示三个字段,数组的长度由参数直接给出

int[] deptNo = new int[recc];

string[]

dname = new string[recc];

string[] loc = new string[recc];

// 为了传递参数,不可避免的要使用参数,下面会连续定义三个

command.ExecuteNonQuery();

sw.Stop();

System.Diagnostics.Debug.WriteLine("批量插入:" + recc.ToString() + "所占时间:" +sw.ElapsedMilliseconds.ToString());

以上代码略显冗长,但是加上注释后基本也就表达清楚了。

图 1 试验中的5种方法

方法一.使用基本的Insert 语句

这种方法是最基本的方法,大多数人一开始都会想到这种方法。但是Insert语句似乎并不适合大批量的操作,是不是这样呢?

本方法中将100万数据分为10个批次,每个批次10万条,每10万条1个事务,分10次导入数据库。

3000 3749 113

4000 5737 40

5000 6820 52

6000 9469 72

7000 10226 69

8000 15280 123

9000 11475 83

10000 14536 121

11000 15705 130

好了,到目前为止,两种方式的插入操作程序已经完成,就剩下对比了。我在主函数处写了一个小函数,循环多次对两个方法进行调用,并且同时记录下时间,对比函数如下:

for (int i = 1; i <= 50; i++) { Truncate(); OrdinaryInsert(i * 1000); Truncate(); BatchInsert(i * 1000); }

源程序放了一段时间直接拷贝贴过来了,可能需要调试一下才能跑通,不过不是本质性问题,对了如果要测试别忘记安装Oracle访问组件。

挑战极限 C#百万数据4秒导入SQL Server

2010年09月07日11:12 来源:李鸣的博客 作者:李鸣 编辑:胡铭娅 评论:0条

● 普通肉垫式

什么叫批量插入呢,就是一次性插入一批数据,我们可以把这批数据理解为一个大的数组,而这些全部只通过一个SQL来实现,而在传统方式下,需要调用很多次的SQL才可以完成,这就是著名的“数组绑定”的功能。我们先来看一下传统方式下,插入多行记录的操作方式:

//设置一个数据库的连接串,

12000 16548 145

13000 18765 125

14000 20393 116

15000 22181 159

因为篇幅原因,不再粘贴全部的数据,但是我们可以看一下由此数据生成的散点图:

其中有些数据有些跳跃,可能和数据库本身有关系,但是大部分数据已经能说明问题了。看了这些数据后,是不是有些心动了?

当数据量达到100万级别时,所用时间依然令人满意,最快一次达到890毫秒,一般为1秒左右。

经过试验,得出一组数据,可以看出两种方式在效率方面惊人的差距(占用时间的单位为毫秒),部分数据如下:

记录数 标准 批处理

1000 1545 29

2000 3514 20

deptLocParam.Direction = ParameterDirection.Input;

deptLocParam.Value = loc; command.Parameters.Add(deptLocParam);

Stopwatch sw = new Stopwatch();

sw.Start();

mandText = sql;

command.ExecuteNonQuery();

}

sw.Stop();

System.Diagnostics.Debug.WriteLine("普通插入:" + recc.ToString() + "所占时间:" + sw.ElapsedMilliseconds.ToString());

//在下面的循环中,先把数组定义好,而不是像上面那样直接生成SQL

for

(int i = 0; i < recc; i++) { deptNo[i] = i;

dname[i] = i.ToString();

loc[i] = i.ToString();

}

//这个调用将把参数数组传进SQL,同时写入数据库

下面进入正题,分别使用基本的Insert 语句、使用BULK INSERT语句、在多线程中使用BULK INSERT、使用SqlBulkCopy类、在多线程中使用SqlBulkCopy类五种方法,挑战4秒极限。

数据库方面使用SQL 2000与SQL 2008,表名TableB,字段名称为Value1,数据库名可以在App.config中修改,默认为test。

本文Tag: Sql Server 2000 c# SQL Server SQL Server 2008 【IT168 技术文档】实际工作中有时候需要把大量数据导入数据库,然后用于各种程序计算,本实验将使用5中方法完成这个过程,并详细记录各种方法所耗费的时间。

本实验中所用到工具为VS2008和SQL SERVER 2000、SQL SERVER 2008,分别使用5中方法将100万条数据导入SQL 2000与SQL 2008中,实验环境是DELL 2850双2.0GCPU,2G内存的服务器。感兴趣的朋友可以下载源代码自己验证一下所用时间。

// 从名称可以直接看出每个参数的含义,不在每个解释了 OracleParameter deptNoParam = new OracleParameter("deptno", OracleDbType.Int32);

deptNoParam.Direction = ParameterDirection.Input;

我们先准备好程序,但是先不做时间的测定,因为在后面我们会用多次循环的方式来计算所占用的时间。

● 使用ODP特性

看上面的程序,大家都很熟悉,因为它没有用到任何ODP的特性,而紧接着我们就要来介绍一个神奇的程序了,我们看一下代码,为了更直观,我把所有的注释及说明直接写在代码里:

//设置一个数据库的连接串

deptNameParam.Direction = ParameterDirection.Input;

deptNameParam.Value = dname;

command.Parameters.Add(deptNameParam);

OracleParameter deptLocParam = new OracleParameter("loc", OracleDbType.Varchar2);

string connectStr = "User Id=scott;Password=tiger;

Data Source=";

OracleConnection conn = new OracleConnection(connectStr);

OracleCommand command = new OracleCommand();

deptNoParam.Value = deptNo;

command.Parameters.Add(deptNoParam);

OracleParameter deptNameParam = new OracleParameter("deptname", OracleDbType.Varchar2);

command.Connection = conn; conn.Open();

Stopwatch sw = new Stopwatch();

sw.Start();

//通过循环写入大量的数据,这种方法显然是肉垫

for

(int i = 0; i < recc; i++)

{ string sql = "insert into dept values(" + i.ToString() + "," + i.ToString() + "," + i.ToString() + ")";