Hive配置和基本操作

Hive入门

Hive⼊门第⼀章 Hive 基本概念1.1 什么是 HiveApache Hive是⼀款建⽴在Hadoop之上的开源数据仓库系统,可以将存储在Hadoop⽂件中的结构化、半结构化数据⽂件映射为⼀张数据库表,基于表提供了⼀种类似SQL的查询模型,称为Hive查询语⾔(HQL),⽤于访问和分析存储在Hadoop⽂件中的⼤型数据集。

Hive核⼼是将HQL转换为MapReduce程序,然后将程序提交到Hadoop群集执⾏。

Hive由Facebook实现并开源。

1.2 为什么使⽤Hive使⽤Hadoop MapReduce直接处理数据所⾯临的问题⼈员学习成本太⾼需要掌握java语⾔MapReduce实现复杂查询逻辑开发难度太⼤使⽤Hive处理数据的好处操作接⼝采⽤类SQL语法,提供快速开发的能⼒(简单、容易上⼿)避免直接写MapReduce,减少开发⼈员的学习成本⽀持⾃定义函数,功能扩展很⽅便背靠Hadoop,擅长存储分析海量数据集1.3 Hive与Hadoop的关系从功能来说,数据仓库软件,⾄少需要具备下述两种能⼒:存储数据的能⼒分析数据的能⼒Apache Hive作为⼀款⼤数据时代的数据仓库软件,当然也具备上述两种能⼒。

只不过Hive并不是⾃⼰实现了上述两种能⼒,⽽是借助Hadoop。

Hive利⽤HDFS存储数据,利⽤MapReduce查询分析数据。

这样突然发现Hive没啥⽤,不过是套壳Hadoop罢了。

其实不然,Hive的最⼤的魅⼒在于⽤户专注于编写HQL,Hive帮您转换成为MapReduce程序完成对数据的分析。

1.4 Hive与MysqlHive虽然具有RDBMS数据库的外表,包括数据模型、SQL语法都⼗分相似,但应⽤场景却完全不同。

Hive只适合⽤来做海量数据的离线分析。

Hive的定位是数据仓库,⾯向分析的OLAP系统。

因此时刻告诉⾃⼰,Hive不是⼤型数据库,也不是要取代Mysql承担业务数据处理。

hive环境搭建

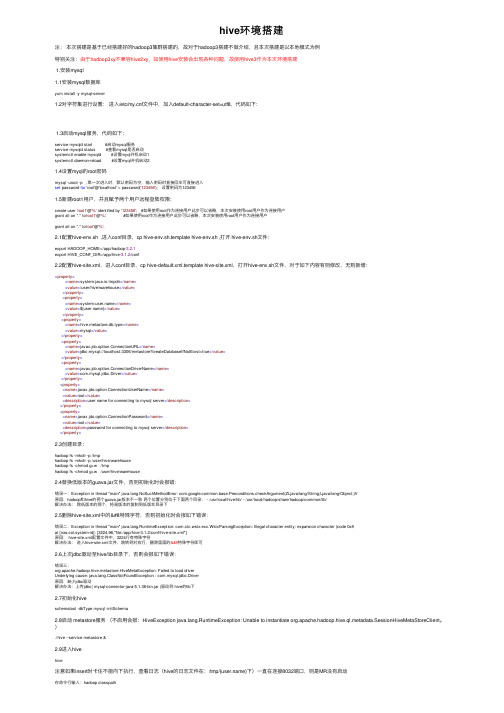

hive环境搭建注:本次搭建是基于已经搭建好的hadoop3集群搭建的,故对于hadoop3搭建不做介绍,且本次搭建是以本地模式为例特别关注:由于hadoop3xy不兼容hive2xy,如使⽤hive安装会出现各种问题,故使⽤hive3作为本次环境搭建1.安装mysql1.1安装mysql数据库yum install -y mysql-server1.2对字符集进⾏设置:进⼊/etc/f⽂件中,加⼊default-character-set=utf8,代码如下:1.3启动mysql服务,代码如下:service mysqld start #启动mysql服务service mysqld status #查看mysql是否启动systemctl enable mysqld #设置myql开机启动1systemctl daemon-reload #设置myql开机启动21.4设置myql的root密码mysql -uroot -p ,第⼀次进⼊时,默认密码为空,输⼊密码时直接回车可直接进⼊set password for 'root'@'localhost' = password('123456'); 设置密码为1234561.5新建root1⽤户,并且赋予两个⽤户远程登陆权限;create user 'root1'@'%' identified by '123456'; #如果使⽤root作为连接⽤户此步可以省略,本次安装使⽤root⽤户作为连接⽤户grant all on *.* to'root1'@'%'; #如果使⽤root作为连接⽤户此步可以省略,本次安装使⽤root⽤户作为连接⽤户grant all on *.* to'root'@'%';2.1配置hive-env.sh ,进⼊conf⽬录,cp hive-env.sh.template hive-env.sh ,打开 hive-env.sh⽂件:export HADOOP_HOME=/app/hadoop-3.2.1export HIVE_CONF_DIR=/app/hive-3.1.2/conf2.2配置hive-site.xml,进⼊conf⽬录,cp hive-default.xml.template hive-site.xml,打开hive-env.sh⽂件,对于如下内容有则修改,⽆则新增:<property><name>system:java.io.tmpdir</name><value>/user/hive/warehouse</value></property><property><name>system:</name><value>${}</value></property><property><name>hive.metastore.db.type</name><value>mysql</value></property><property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://localhost:3306/metastore?createDatabaseIfNotExist=true</value></property><property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.jdbc.Driver</value></property><property><name>javax.jdo.option.ConnectionUserName</name><value>root</value><description>user name for connecting to mysql server</description></property><property><name>javax.jdo.option.ConnectionPassword</name><value>root</value><description>password for connecting to mysql server</description></property>2.3创建⽬录:hadoop fs -mkdir -p /tmphadoop fs -mkdir -p /user/hive/warehousehadoop fs -chmod g+w /tmphadoop fs -chmod g+w /user/hive/warehouse2.4替换低版本的guava.jar⽂件,否则初始化时会报错:错误⼀:Exception in thread "main" ng.NoSuchMethodError: mon.base.Preconditions.checkArgument(ZLjava/lang/String;Ljava/lang/Object;)V原因:hadoop和hive的两个guava.jar版本不⼀致两个位置分别位于下⾯两个⽬录: - /usr/local/hive/lib/ - /usr/local/hadoop/share/hadoop/common/lib/解决办法:除低版本的那个,将⾼版本的复制到低版本⽬录下2.5删除hive-site.xml中的特殊字符,否则初始化时会报如下错误:错误⼆:Exception in thread "main" ng.RuntimeException: com.ctc.wstx.exc.WstxParsingException: Illegal character entity: expansion character (code 0x8at [row,col,system-id]: [3224,96,"file:/app/hive-3.1.2/conf/hive-site.xml"]原因: hive-site.xml配置⽂件中,3224⾏有特殊字符解决办法:进⼊hive-site.xml⽂件,跳转到对应⾏,删除⾥⾯的特殊字符即可2.6上次jdbc驱动⾄hive/lib⽬录下,否则会报如下错误:错误三:org.apache.hadoop.hive.metastore.HiveMetaException: Failed to load driverUnderlying cause: ng.ClassNotFoundException : com.mysql.jdbc.Driver原因:缺少jdbc驱动解决办法:上传jdbc( mysql-connector-java-5.1.36-bin.jar )驱动到 hive的lib下2.7初始化hiveschematool -dbType mysql -initSchema2.8启动 metastore服务(不启⽤会报:HiveException ng.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient。

hive中hiveconf 参数的设置方法

在Hive中,hiveconf参数是一种用于传递配置变量的机制。

通过在Hive命令行中使用-hiveconf选项或在Hive脚本中使用SET命令,可以设置这些参数。

这些参数可以在Hive脚本中使用,并且可以在运行时动态地传递值。

示例:

假设你有一个Hive脚本文件my_script.hql,其中包含如下内容:

SELECT * FROM my_table WHERE date_column = '${hiveconf:target_date}';

然后,你可以通过以下方式在运行脚本时传递target_date参数:

1. 在Hive命令行中:

hive -f my_script.hql -hiveconf target_date='2023-08-04'

2. 在Hive脚本中:

SET target_date='2023-08-04';

SELECT * FROM my_table WHERE date_column = '${hiveconf:target_date}';

这样,target_date参数的值将被动态地传递到Hive脚本中,并在执行时替换${hiveconf:target_date}的位置。

注意:hiveconf参数不支持所有特殊字符,通常建议使用字母数字字符和下划线来定义参数名称,以避免可能的问题。

hiveserver2的配置和启动

hiveserver2的配置和启动概览1.配置hive-site.xml2.配置hadoop中的core-site.xml⽂件3.测试⾸先将hive安装然后更改部分配置⽂件1.配置hive-site.xml利⽤Xshell⼯具连接虚拟机进⼊hive安装⽬录下的conf⽂件夹,更改hive-site.xml配置⽂件其中配置参考hive安装中的配置hive-site.xml你会发现/usr/hive/apache-hive-2.3.3-bin/conf/并没有hive-site.xml⽂件直接新建⼀个就⾏[root@master hive]# cd apache-hive-2.3.3-bin/conf/#创建⽂件[root@master conf]# touch hive-site.xml#编辑[root@master conf]# vim hive-site.xml在hive-site.xml中写⼊ip改为⾃⼰的<?xml version="1.0" encoding="UTF-8" standalone="no"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration><property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://192.168.134.154:3306/hive</value></property><property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.jdbc.Driver</value></property><property><name>javax.jdo.option.ConnectionUserName</name><value>root</value></property><property><name>javax.jdo.option.ConnectionPassword</name><value>root</value></property><property><name>hive.metastore.schema.verification</name><value>false</value></property><property><name>hive.cli.print.current.db</name><value>true</value></property><property><name>hive.cli.print.header</name><value>true</value></property><!-- 这是hiveserver2 --><property><name>hive.server2.thrift.port</name><value>10000</value></property><property><name>hive.server2.thrift.bind.host</name><value>192.168.134.154</value></property></configuration>2.配置hadoop中的core-site.xml⽂件进⼊到hadoop的安装⽬录下的etc/hadoop⽂件夹,配置其中的core-site.xml⽂件注意:如果是hadoop集群⽽不是单机版,需要更改所有虚拟机上的core-site.xml⽂件在最后追加<!-- 如果连接不上10000 --><property><name>hadoop.proxyuser.root.hosts</name><value>*</value></property><property><name>hadoop.proxyuser.root.groups</name><value>*</value></property><property><name>hadoop.proxyuser.zhaoshb.hosts</name><value>*</value></property><property><name>hadoop.proxyuser.zhaoshb.groups</name><value>*</value></property>3.测试⾸先启动你集群中的Zookeeper和Hadoop然后在安装hive的主机上启动hiveserver2因为配置好了hive的环境变量.所以我们可以直接在任何⽂件夹下运⾏不然的话需要进到hive安装⽬录的bin下[root@master ~]# hiveserver2#或者[root@master ~]# hive --service hiveserver2这个时候你的页⾯会⼀直卡在这⾥,这是正常的,因为你是启动了⼀个服务你只需要再开⼀个Xshell窗⼝连接即可在新开的窗⼝操作#进⼊beeline[root@master ~]# beeline#连接10000端⼝beeline> !connect jdbc:hive2://192.168.134.154:10000Connecting to jdbc:hive2://192.168.134.154:10000Enter username for jdbc:hive2://192.168.134.154:10000: root #⽤户名root Enter password for jdbc:hive2://192.168.134.154:10000: **** #密码root然后使⽤浏览器在你的192.168.134.154(安装hive的主机ip地址):10002查看接下来可以在hiveserver2中操作,基本操作和hive中⼀样0: jdbc:hive2://192.168.134.154:10000> show databases;+----------------+| database_name |+----------------+| default |+----------------+1 row selected (2.51 seconds)。

hive -hiveconf 参数

文章标题:深度解析hive -hiveconf参数的使用与影响摘要:本文将深入探讨Hive中的-hiveconf参数的使用与影响,从基础概念、具体用法到个人观点和理解,全面介绍其在数据处理和分析中的重要性和优势。

正文:1. 介绍-hiveconf参数在Hive中,-hiveconf参数是用来指定Hive配置参数的一种方式。

它可以在启动Hive会话或运行Hive脚本时,注入配置参数,以覆盖Hive默认的配置值。

通过-hiveconf参数,用户可以在不修改Hive全局配置的情况下,改变某些配置参数的值,从而实现对Hive行为的精细控制。

2. -hiveconf参数的具体用法在实际应用中,-hiveconf参数可以通过以下方式来使用:```$ hive -hiveconf mapred.reduce.tasks=10```通过上述命令,用户可以在启动Hive会话时,将mapred.reduce.tasks参数的值设置为10,以控制Hive作业的reduce任务数量。

除了在启动Hive会话时使用,-hiveconf参数还可以在Hive脚本中使用,例如:```SET mapred.reduce.tasks=10;```通过在Hive脚本中使用SET命令,用户可以在脚本内部动态地改变Hive配置参数的值,从而实现更灵活的数据处理和分析。

3. -hiveconf参数的影响与优势-hiveconf参数的使用对Hive作业的执行和性能有着重要的影响。

通过灵活配置Hive参数,用户可以根据实际情况调整Hive作业的行为,从而提高作业的执行效率和资源利用率。

通过调整mapred.reduce.tasks参数,用户可以更好地控制Hive作业的reduce任务数量,避免不必要的资源浪费或性能瓶颈。

4. 个人观点与理解作为一个资深的Hive用户,我个人认为-hiveconf参数是Hive中一个非常重要的功能,它为用户提供了灵活地控制Hive行为的能力。

hivemetastoreclient用法

hivemetastoreclient用法HIVETASTORECLIENT是一个用于访问Hive Metastore的客户端工具,它提供了方便的方式来管理和查询Hive Metastore中的元数据信息。

Hive Metastore是Hive中的组件,用于存储和管理集群中的表、存储以及数据转换的元数据信息。

一、安装和配置首先,确保您已经正确安装了Hive集群,并且能够通过Hive客户端访问Hive Metastore。

然后,您需要下载并安装HIVETASTORECLIENT工具。

可以从官方网站或相关文档中找到安装说明。

安装完成后,您需要配置HIVETASTORECLIENT以连接到Hive Metastore。

您需要提供正确的连接参数,包括Metastore服务的主机名、端口号和用户名/密码。

这些参数通常在HIVETASTORECLIENT的配置文件中进行设置。

二、使用方法HIVETASTORECLIENT提供了多种命令行工具来管理和查询Hive Metastore中的元数据信息。

以下是常用的一些命令:1. 列出所有注册的数据库:使用`list-databases`命令可以列出所有已注册的数据库名称。

2. 列出指定数据库中的所有表:使用`list-tables`命令可以列出指定数据库中的所有表名。

3. 查询表的相关信息:使用`describe-table`命令可以获取指定表的详细信息,包括表类型、存储格式、分区信息等。

4. 添加、更新或删除表:使用`create-table`、`alter-table`和`drop-table`命令可以添加、修改或删除表。

这些命令需要提供表的基本信息和详细配置参数。

5. 查询存储信息:使用`list-storage-locations`命令可以列出指定表的存储位置信息。

6. 其他命令:HIVETASTORECLIENT还提供了其他一些命令,如查看Metastore状态、刷新Metastore缓存等。

hive参数配置详细

hive参数配置详细hive.exec.mode.local.auto决定 Hive 是否应该⾃动地根据输⼊⽂件⼤⼩,在本地运⾏(在GateWay运⾏)truehive.exec.mode.local.auto.inputbytes.max如果 hive.exec.mode.local.auto 为 true,当输⼊⽂件⼤⼩⼩于此阈值时可以⾃动在本地模式运⾏,默认是 128兆。

134217728Lhive.exec.mode.local.auto.tasks.max如果 hive.exec.mode.local.auto 为 true,当 Hive Tasks(Hadoop Jobs)⼩于此阈值时,可以⾃动在本地模式运⾏。

4hive.auto.convert.join是否根据输⼊⼩表的⼤⼩,⾃动将 Reduce 端的 Common Join 转化为 Map Join,从⽽加快⼤表关联⼩表的 Join 速度。

falsehive.mapred.local.memMapper/Reducer 在本地模式的最⼤内存量,以字节为单位,0为不限制。

mapred.reduce.tasks所提交 Job 的 reduer 的个数,使⽤ Hadoop Client 的配置。

默认是-1,表⽰Job执⾏的个数交由Hive来分配-1hive.exec.scratchdirHDFS路径,⽤于存储不同 map/reduce 阶段的执⾏计划和这些阶段的中间输出结果。

/tmp/<>/hivehive.metastore.warehouse.dirHive 默认的数据⽂件存储路径,通常为 HDFS 可写的路径。

"hive.groupby.skewindata决定 group by 操作是否⽀持倾斜的数据。

原理是,在Group by中,对⼀些⽐较⼩的分区进⾏合并falsehive.merge.mapfiles是否开启合并 Map 端⼩⽂件,对于 Hadoop 0.20 以前的版本,起⼀⾸新的 Map/Reduce Job,对于 0.20 以后的版本,则是起使⽤ CombineInputFormat 的MapOnly Job。

hive tez 参数

Hive Tez 参数简介Hive是一个基于Hadoop的数据仓库工具,它提供了类似于SQL的查询语言HiveQL,可以将结构化和半结构化的数据映射到表中,并通过MapReduce来处理大规模数据。

而Tez是一个基于YARN的通用执行框架,为Hadoop上的交互式查询和大规模数据处理提供了更高效的计算引擎。

在Hive中使用Tez作为执行引擎可以提供更高性能和更低的延迟。

通过合理配置Tez参数,可以进一步优化查询性能。

本文将详细介绍Hive Tez参数的配置和调优方法。

配置参数在Hive中,可以通过设置以下Tez参数来优化查询性能:tez.task.resource.memory.mb该参数用于设置每个Tez任务可用的内存量(以MB为单位)。

适当增加该值可以提高任务执行速度,但需要根据集群资源情况进行调整。

如果集群资源不足,可能会导致OOM错误。

tez.task.resource.cpu.vcores该参数用于设置每个Tez任务可使用的CPU核心数。

增加核心数可以加快任务执行速度,但同样需要根据集群资源情况进行调整。

tez.runtime.io.sort.mb该参数用于设置Tez运行时排序操作使用的内存量(以MB为单位)。

增加该值可以提高排序性能,但也会占用更多的内存资源。

需要根据查询中涉及的数据量和排序操作的复杂度来进行调整。

tez.runtime.unordered.output.buffer.size-mb该参数用于设置Tez运行时无序输出操作使用的缓冲区大小(以MB为单位)。

增加该值可以提高无序输出性能,但同样会占用更多的内存资源。

需要根据查询中涉及的数据量和无序输出操作的复杂度来进行调整。

tez.grouping.max-size该参数用于设置Tez运行时分组操作使用的最大内存量(以字节为单位)。

适当增加该值可以提高分组性能,但也会占用更多的内存资源。

需要根据查询中涉及的数据量和分组操作的复杂度来进行调整。

Hive简易操作入门

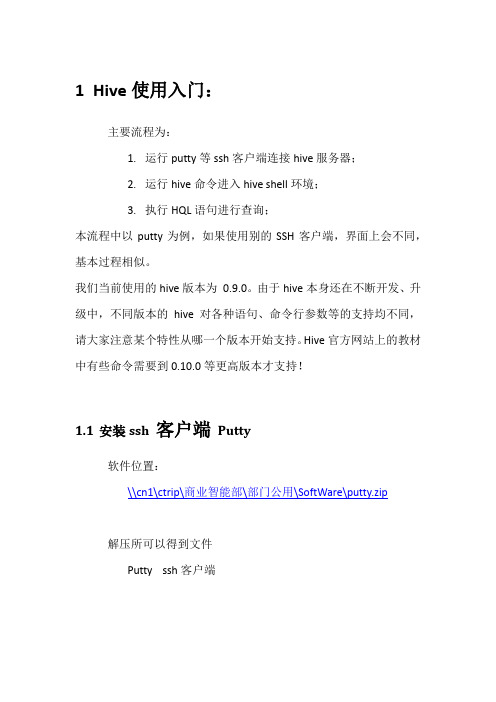

1Hive使用入门:主要流程为:1.运行putty等ssh客户端连接hive服务器;2.运行hive命令进入hive shell环境;3.执行HQL语句进行查询;本流程中以putty为例,如果使用别的SSH客户端,界面上会不同,基本过程相似。

我们当前使用的hive版本为0.9.0。

由于hive本身还在不断开发、升级中,不同版本的hive对各种语句、命令行参数等的支持均不同,请大家注意某个特性从哪一个版本开始支持。

Hive官方网站上的教材中有些命令需要到0.10.0等更高版本才支持!1.1安装ssh 客户端Putty软件位置:\\cn1\ctrip\商业智能部\部门公用\SoftWare\putty.zip解压所可以得到文件Putty ssh客户端1.2登录安装hive的机器1.2.1运行putty输入ip地址192.168.83.96 和端口号信息1022,如下图:注:一般默认的SSH端口是22,此处必须修改!1.2.2登录linux单击open按钮,按提示输入用户名,并回车,然后按提示输入密码,并回车,例如:用户名为ppj 密码为HgeeGxR5提示:可选中复制到剪贴板后,用鼠标右键粘贴如果用户名、密码正确,则登录成功,顺利进入linux 的bash 环境。

注:此环境类似于运行windows的cmd进入的dos环境。

1.2.3输入hive,进入hive 的shell 环境:1.2.4查询执行如下查询语句:Use test_wqd;Select * from pageview limit 5;屏幕输出即为查询语句的结果。

注意:hive的查询语句以分号作为各条命令的分隔符,结尾的分号不能省略。

这一点和SQL Server的T-SQL差异比较大!2Hive简介:Hive shell环境和mysql的客户端比较相似,而且hive的某些语法与mysql比较相似,例如:show databases, show tables, desc 等。

hive安装配置实验实训报告

hive安装配置实验实训报告一、实验目的本实验旨在通过实际操作,掌握Hive的安装与配置过程,了解Hive的基本功能和使用方法,为后续的大数据处理和分析奠定基础。

二、实验环境1.硬件环境:高性能计算机,至少4核CPU、8GB内存、50GB 硬盘。

2.软件环境:Ubuntu 18.04操作系统,Java Development Kit (JDK) 1.8,Apache Hadoop 2.7.3。

三、实验步骤1.安装与配置Hadoop:首先,在实验环境中安装Hadoop,并配置Hadoop集群。

确保NameNode、SecondaryNameNode、DataNode等节点正常运行。

2.安装Hive:使用apt-get命令安装Hive。

在安装过程中,选择与Hadoop版本兼容的Hive版本。

3.配置Hive:编辑Hive的配置文件hive-site.xml,配置Hive连接到Hadoop集群的相关参数。

4.初始化Hive元数据:运行Hive的元数据初始化脚本,创建Hive元数据库。

5.启动Hive服务:使用以下命令启动Hive的元数据库、Metastore和HiveServer2等服务。

1.元数据库:hive --service metastore &2.Metastore:hive --service metastore &3.HiveServer2:hive --service hiveserver2 &6.测试Hive:使用Hive的命令行工具进入Hive交互式查询环境,执行简单的SQL查询语句,测试Hive是否安装成功。

四、实验结果与分析经过上述步骤,我们成功在实验环境中安装和配置了Hive。

通过执行简单的SQL查询语句,验证了Hive的基本功能。

具体而言,我们执行了以下查询语句:1.创建数据库:CREATE DATABASE mydatabase;2.选择数据库:USE mydatabase;3.创建表:CREATE TABLE mytable (id INT, name STRING);4.插入数据:INSERT INTO TABLE mytable VALUES (1, 'Alice'), (2, 'Bob');5.查询数据:SELECT * FROM mytable;6.删除表:DROP TABLE mytable;7.删除数据库:DROP DATABASE mydatabase;通过这些查询语句的执行,我们验证了Hive的基本功能,包括数据库管理、表创建、数据插入、数据查询、表删除和数据库删除等。

hive配置注意事项及初始化hive元数据

hive配置注意事项及初始化hive元数据

今天配置hive 犯了⼀个问题:下载的hive tar.gz ⾥的conf⽂件夹仅仅有⼀个 hive-default.xml.template,于是我就cp 了⼀份命名为:hive-default.xml

结果弄上去总是出现⼀个问题。

就是我在 bin/ 执⾏hive 创建的database和在随意其它⽂件夹执⾏hive 创建的database (已配置好环境变量)

在两个地⽅出现的并不同样,这个让我⼗分头疼。

经过排查,必需要把 hive-default.xml.template 复制⼀份命名为 hive-site.xml ,⼀定要有hive-site.xml 才⾏

然后再执⾏ schematool -dbType mysql -initSchema 把之前创建的元数据都同步到mysql ⾥

看官⽹介绍,hive-default.xml 会被 hive-site.xml 中的值覆盖掉。

那为什么我不⽣成hive-site.xml 直接在defalut.xml ⾥改动就不⾏呢,郁闷!。

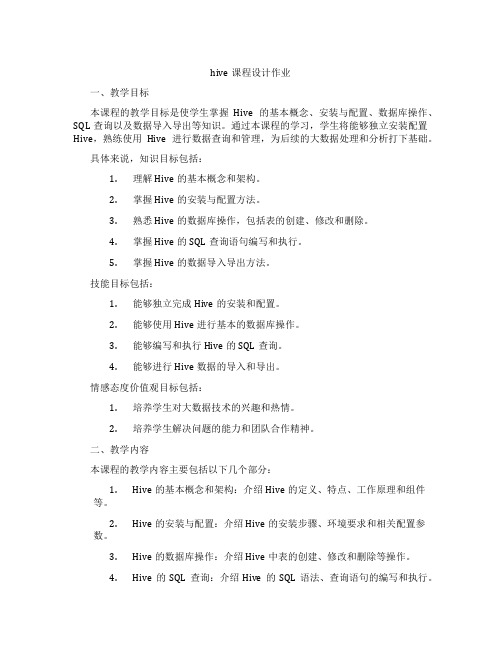

hive课程设计作业

hive课程设计作业一、教学目标本课程的教学目标是使学生掌握Hive的基本概念、安装与配置、数据库操作、SQL查询以及数据导入导出等知识。

通过本课程的学习,学生将能够独立安装配置Hive,熟练使用Hive进行数据查询和管理,为后续的大数据处理和分析打下基础。

具体来说,知识目标包括:1.理解Hive的基本概念和架构。

2.掌握Hive的安装与配置方法。

3.熟悉Hive的数据库操作,包括表的创建、修改和删除。

4.掌握Hive的SQL查询语句编写和执行。

5.掌握Hive的数据导入导出方法。

技能目标包括:1.能够独立完成Hive的安装和配置。

2.能够使用Hive进行基本的数据库操作。

3.能够编写和执行Hive的SQL查询。

4.能够进行Hive数据的导入和导出。

情感态度价值观目标包括:1.培养学生对大数据技术的兴趣和热情。

2.培养学生解决问题的能力和团队合作精神。

二、教学内容本课程的教学内容主要包括以下几个部分:1.Hive的基本概念和架构:介绍Hive的定义、特点、工作原理和组件等。

2.Hive的安装与配置:介绍Hive的安装步骤、环境要求和相关配置参数。

3.Hive的数据库操作:介绍Hive中表的创建、修改和删除等操作。

4.Hive的SQL查询:介绍Hive的SQL语法、查询语句的编写和执行。

5.Hive的数据导入导出:介绍Hive中数据的导入和导出方法,包括文本文件、数据库和外部数据源等。

三、教学方法为了提高学生的学习兴趣和主动性,本课程将采用多种教学方法相结合的方式进行教学。

包括:1.讲授法:通过讲解和演示,使学生掌握Hive的基本概念和操作方法。

2.讨论法:通过小组讨论和问题解答,培养学生的思考能力和团队合作精神。

3.案例分析法:通过分析实际案例,使学生更好地理解和应用Hive的知识。

4.实验法:通过上机实验,使学生亲手操作Hive,巩固所学知识和技能。

四、教学资源为了支持教学内容和教学方法的实施,本课程将准备以下教学资源:1.教材:选用权威、实用的Hive教材,为学生提供系统的学习材料。

hive set语句

在Hive中,可以使用SET语句来设置或更改Hive的配置参数。

Hive的配置参数可以控制Hive 的许多行为,包括优化查询、数据格式和错误处理等。

SET语句的基本语法如下:sqlSET <key>=<value>;其中,<key>是配置参数的名称,<value>是设置的值。

以下是一些常见的Hive配置参数和它们的含义:hive.auto.convert.join: 控制是否自动将小表与大表进行连接时转换为MapJoin。

可以设置为true或false。

hive.exec.dynamic.partition: 控制是否允许动态分区。

可以设置为true或false。

hive.exec.max.dynamic.partitions: 控制动态分区的最大数量。

hive.exec.max.dynamic.partitions.pernode: 控制每个节点上动态分区的最大数量。

hive.optimize.bucketmapjoin: 控制是否优化bucket map join操作。

可以设置为true或false。

hive.optimize.bucketmapjoin.sortedmerge: 控制是否优化bucket map join的排序合并操作。

可以设置为true或false。

hive.orderby.sortfiles: 控制是否对有序文件进行排序。

可以设置为true或false。

hive.query.tereo.type: 控制查询的立体类型。

可以设置为'columnar'或'row'。

hive.server2.authentication: 控制Hive Server2的认证方式,可以选择'NONE', 'KERBEROS', 'LDAP', 'KERBEROS_SSL', 'LDAP_SSL'等。

Hive在云环境中的部署与最佳实践

Hive在云环境中的部署与最佳实践在云计算环境中,Hive是一种开源的数据仓库工具,广泛用于大数据分析和查询。

本文将介绍如何在云环境中部署Hive并提供一些最佳实践。

一、部署Hive在云环境中部署Hive需要以下步骤:1.选择适当的云提供商:根据实际需求选择一个适合的云提供商,如Amazon Web Services(AWS)、Microsoft Azure或Google Cloud Platform(GCP)等。

这些云提供商都提供了Hadoop和Hive的托管服务,可以轻松地进行部署。

2.创建虚拟机实例:在选择的云平台上创建一个虚拟机实例,确保实例的配置满足Hive运行的要求。

通常来说,建议选择具有足够内存和存储容量的实例类型。

3.安装Hadoop和Hive:在虚拟机实例上安装Hadoop和Hive。

可以通过使用云提供商的托管服务或手动安装这些组件。

确保按照Hadoop和Hive的官方文档进行正确的安装和配置。

4.配置Hive:安装完Hadoop和Hive后,需要根据实际需求进行配置。

主要包括设置Hadoop和Hive的环境变量、配置Hive的元数据存储和指定Hive使用的文件系统等。

5.启动Hive服务:配置完成后,启动Hive服务。

可以使用命令行工具或Web界面来访问Hive并执行查询操作。

二、最佳实践以下是一些在云环境中部署Hive时的最佳实践:1.应用资源的弹性伸缩:云提供商的弹性伸缩功能可根据需求自动调整云资源的数量和规模。

在Hive集群中,可以根据查询的负载自动增加或减少节点数量,以充分利用资源并提高性能。

2.数据备份与恢复:云环境中的Hive数据可以进行定期备份,以防止数据丢失。

云提供商通常提供了可靠的数据备份和恢复机制,可根据需要进行数据的备份和还原操作。

3.安全性管理:在云环境中部署Hive时,安全性是一个重要的考虑因素。

确保实施适当的访问控制策略和权限管理措施,以保护数据的机密性和完整性。

Hive学习之路(十八)Hive的Shell操作

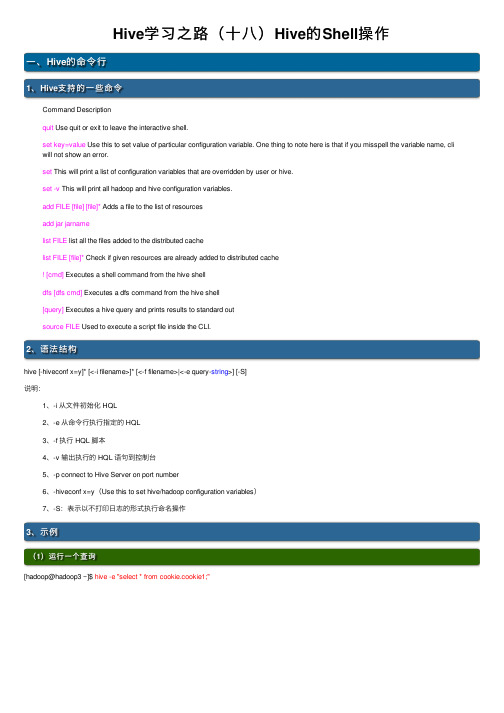

Hive学习之路(⼗⼋)Hive的Shell操作⼀、Hive的命令⾏1、Hive⽀持的⼀些命令Command Descriptionquit Use quit or exit to leave the interactive shell.set key=value Use this to set value of particular configuration variable. One thing to note here is that if you misspell the variable name, cli will not show an error.set This will print a list of configuration variables that are overridden by user or hive.set -v This will print all hadoop and hive configuration variables.add FILE [file] [file]* Adds a file to the list of resourcesadd jar jarnamelist FILE list all the files added to the distributed cachelist FILE [file]* Check if given resources are already added to distributed cache! [cmd] Executes a shell command from the hive shelldfs [dfs cmd] Executes a dfs command from the hive shell[query] Executes a hive query and prints results to standard outsource FILE Used to execute a script file inside the CLI.2、语法结构hive [-hiveconf x=y]* [<-i filename>]* [<-f filename>|<-e query-string>] [-S]说明:1、-i 从⽂件初始化 HQL2、-e 从命令⾏执⾏指定的 HQL3、-f 执⾏ HQL 脚本4、-v 输出执⾏的 HQL 语句到控制台5、-p connect to Hive Server on port number6、-hiveconf x=y(Use this to set hive/hadoop configuration variables)7、-S:表⽰以不打印⽇志的形式执⾏命名操作3、⽰例(1)运⾏⼀个查询[hadoop@hadoop3 ~]$ hive -e "select * from cookie.cookie1;"(2)运⾏⼀个⽂件编写hive.sql⽂件运⾏编写的⽂件(3)运⾏参数⽂件从配置⽂件启动 hive,并加载配置⽂件当中的配置参数⼆、Hive的参数配置⽅式1、Hive的参数配置⼤全2、Hive的参数设置⽅式开发 Hive 应⽤时,不可避免地需要设定 Hive 的参数。

2.Hive常见操作命令整理

2.Hive常见操作命令整理该笔记主要整理了《Hive编程指南》中⼀些常见的操作命令,⼤致如下(持续补充中):1. 查看/设置/修改变量2. 执⾏命令3. 搜索相关内容4. 查看库表信息5. 创建表6. 分区7. 修改表(重命名、修改列、删除列、增加列)8. 找到表位置并导出⾄本地9. 去空格10. case...when...then句式11. 操作符12. group by...having句式13. JOIN14. order by和sort by15. 抽样查询16. 视图17. 分桶表18. 函数19. with...as20. rank() over (partition by ... order by ... asc/desc)和row_number()21. 时间相关的函数(from_unixtime,unix_timestamp,date_add,months_between)22.substr()23.regexp_replace()和regexp_extract()24.动态分区25.nvl和grouping set26. concat_ws()、group_concat()和collect_list()teral view explode()1. 查看/设置/修改变量$ hive############# 查询环境变量############hive>set env:HOME;# 打印命名空间hivevar, hiveconf, system和env所有变量hive>set;# 还打印Hadoop所定义的所有属性hive>set -v;############# 设置hive变量############hive>set hivevar:foo=bar# 查看刚设置的变量hive>set foo;hive>set hivevar:foo;############# 修改属性变量############# hiveconf: Hive相关的配置属性# 不进⼊Hive进⾏配置属性修改hive --hiveocnf hive.cli.print.current.db=true# 进⼊hive进⾏配置修改hive>set hiveconf:hive.cli.print.current_db=true;2. 执⾏命令# 执⾏命令⽅式1:使⽤下⾯的 “⼀次使⽤”命令(-e是指⼀次执⾏,-S是指静默模式,在输出结果中不显⽰Ok和Time taken字段)hive -e -S "select * from mytable limit 3";# 执⾏命令⽅式2:调⽤Hive执⾏hql⽂件hive -f /path/query.hql# 执⾏命令⽅式3:在Hive shell内执⾏hql⽂件$ hivehive>source /path/query.hql3. 搜索相关内容# 模糊搜索set命令的输出结果中某个于warehouse相关的属性$ hive -S -e "set" | grep warehousehive.metastore.warehouse.dir=/user/hive/warehousehive.warehouse.subdir.inherit.perms=false4. 查看库表信息# 查看数据库,使⽤like是以ahf开头,以其他字符结尾(即.*)的数据库名show databases;show databases like 'ahf.*';# 查看表的详细表结构信息(formatted⽐extended输出内容更详细且可读性更⾼)describe mydb.table;describe formatted mydb.table;describe extended mydb.table;5. 创建表# 拷贝表结构,⽽不拷贝数据(⽤like)create table if not exists mydb.mytable like mydb.mytable2;# 拷贝表结构,且拷贝数据(⽤as)create table if not exists mydb.mytable asselect*from mydb.mytable2;# 直接创建表结构create table if not exists mydb.mytable(id string comment 'id',name string comment '姓名')partitioned by (class string)stored as orc;6. 分区# 建⽴分区create table(字段1 字段类型, 字段2 字段类型)paritioned by (字段名3 字段类型, 字段名4 字段类型);# 查看分区show partitions table_name;# 查看某个特定分区键的分区show partitions table_name partition(⼀个分区字段='该分区字段下的某个值');# 增加分区alter table log_message add partition(year=2012, month=1, day=2);# 删除分区alter table log_messages drop if exists partition(year=2012, month=1, day=2);7. 修改表(重命名、修改列、删除列、增加列)# 表重命名alter table log_messages rename to logmsgs;# 修改列信息, 在下⾯的例⼦中,# 我们将字段hms重命名为hour_minutes_seconds,修改其类型和注释,再转移到severity字段之后# 如果⽤户想将这个字段移动到第⼀个为位置,只需要使⽤first关键字替换after severityalter table log_messages change column hms hour_minutes_seconds intcomment 'the hours, minutes, and seconds parts of the timestamp'after severity;# 删除或替换列, 下⾯的例⼦移除了之前所有字段并重新指定了新的字段alter table log_messages replace columns(新字段1 int comment '...',新字段2 string comment '...');# 增加列alter table log_messages add columns(app_name string comment 'application name',session_id long comment 'the current session id');8. 找到表位置并导出⾄本地# 找到表位置describe formatted mydb.mytable;# 例如:Location:hdfs://alg-hdfs/warehouse/user/alvinai.mydb/mytable# 导出⽂件hadoop fs -cp [表来源][⽬标导出路径]9. 去空格# 去空格 ltrim去左空格,rtrim去右空格ltrim(string s)10. case...when...then句式select name,salary,case when salary <5000.0then'low'when salary >=5000.0and salary <70000.0then'middle'else'high'end as bracketfrom employees;11. 操作符# 常见的谓语操作符A<>B跟A!=B是⼀样的A<==>B是指任⼀为NULL,则结果为NULLA is null还有A is not nulla not betweenb and c, between是闭区间# LiKE和RELIKE谓语操作符A like B, A relike B前者是SQL,后者是JAVA的正则表达式A like B, ‘x%’表⽰A必须以字母x开头,‘%x’表⽰A必须以字母x结尾,‘%x%’表⽰A包含字母x,可以位于开头结尾或者字符串中间A relike B, .号表⽰任意字符,*表⽰重复左边的字符串零次到⽆数次,表达式(x|y)表⽰x或者y匹配例⼦:查找住址以Ave结尾的⼈select name, address from where employees where address like'Ave.';例⼦:查找地址以0开头的⼈select name, address from where employees where address like 'O%';# split操作符select split(row_key, '_')[0] as account_id12. group by...having句式# 如果想要对group by语句产⽣的分组进⾏条件过滤,可以⽤having例如:select year(ymd),avg(price_close) from stockswhere exchange ='NASDAQ'and symbol ='AAPL'group by year(ymd)having avg(price_close) >0.0;13. JOINHive连接有:inner join: 交集,就是join。

大数据系列-Hive入门与实战(ppt 69页)

HDFS下对 应存储目 录:

Hive开发使用-Hive的数据模型

28

外部表

外部表指向已经在HDFS中存在的数据,可以创建Partition。它和内 部表在元数据的组织上是相同的,而实际数据的存储则有较大的差异。 内部表的创建过程和数据加载过程这两个过程可以分别独立完成,也可 以在同一个语句中完成,在加载数据的过程中,实际数据会被移动到数 据仓库目录中;之后对数据访问将会直接在数据仓库目录中完成。删除 表时,表中的数据和元数据将会被同时删除。而外部表只有一个过程, 加载数据和创建表同时完成(CREATE EXTERNAL TABLE ……LOCATION),实际数据是存储在LOCATION后面指定的 HDFS 路 径中,并不会移动到数据仓库目录中。当删除一个External Table时,仅 删除该链接。

大数据系列- Hive入门与实战

2

目录

一、 Hive简介 二、 Hive体系结构 三、 Hive工作机制 四、 Hive应用场景 五、 Hive安装部署 六、 Hive开发使用 七、 SparkSQL简介

Hive简介-Hive是什么?

3

Hive是构建在Hadoop之上的数据仓库平台

Hive是一个SQL解析引擎,它将SQL语句转译成 MapReduce作业并在Hadoop上执行。

Hive的优势-上百行MR程序与一条HQL的对比

16

Hive的应用场景-Hive的缺点

17

Hive的HQL表达能力有限:有些复杂运算用HQL不易表 达。 Hive效率低:Hive自动生成MR作业,通常不够智能; HQL调优困难,粒度较粗;可控性差。 针对Hive运行效率低下的问题,促使人们去寻找一种更快, 更具交互性的分析框架。 SparkSQL 的出现则有效的提高 了Sql在Hadoop 上的分析运行效率。

Hive安装配置指北(含HiveMetastore详解)

Hive安装配置指北(含HiveMetastore详解)本⽂介绍Hive安装配置的整个过程,包括MySQL、Hive及Metastore的安装配置,并分析了Metastore三种配置⽅式的区别。

⽹上有很多介绍Hive Metastore三种配置⽅式的⽂章,但是理解都不对,给读者造成了很多误导。

本⼈详细阅读Apache和CDH官⽅⽂档中关于Hive Metastore的部分,并经过实践,终于填好各种坑,安装配置成功,遂记录下本⽂,供⼤家参考。

1. 相关概念Hive Metastore有三种配置⽅式,分别是:1. Embedded Metastore Database (Derby) 内嵌模式2. Local Metastore Server 本地元存储3. Remote Metastore Server 远程元存储1.1 Metadata、Metastore作⽤metadata即元数据。

元数据包含⽤Hive创建的database、tabel等的元信息。

元数据存储在关系型数据库中。

如Derby、MySQL等。

Metastore的作⽤是:客户端连接metastore服务,metastore再去连接MySQL数据库来存取元数据。

有了metastore服务,就可以有多个客户端同时连接,⽽且这些客户端不需要知道MySQL数据库的⽤户名和密码,只需要连接metastore 服务即可。

1.2三种配置⽅式区别内嵌模式使⽤的是内嵌的Derby数据库来存储元数据,也不需要额外起Metastore服务。

这个是默认的,配置简单,但是⼀次只能⼀个客户端连接,适⽤于⽤来实验,不适⽤于⽣产环境。

本地元存储和远程元存储都采⽤外部数据库来存储元数据,⽬前⽀持的数据库有:MySQL、Postgres、Oracle、MS SQL Server.在这⾥我们使⽤MySQL。

本地元存储和远程元存储的区别是:本地元存储不需要单独起metastore服务,⽤的是跟hive在同⼀个进程⾥的metastore服务。

hive tez 参数

hive tez 参数

Hive Tez参数是用于调优Hive查询在Tez执行引擎上的参数配置。

以下是一些常用的Hive Tez参数:

1. hive.execution.engine:设置Hive查询的执行引擎。

对于Tez 执行引擎,该参数的值应设置为tez。

2. tez.grouping.min-size:设置Tez任务的最小分组大小。

该参数是用于优化数据分组操作的。

3. tez.grouping.max-size:设置Tez任务的最大分组大小。

该参数也是为了优化数据分组操作而存在的。

4. tez.container.max.java.heap.fraction:设置每个Tez容器的Java堆内存使用比例。

5. hive.tez.container.size:设置每个Tez容器的内存大小。

6. tez.runtime.sort.threads:设置Tez运行时排序操作的线程数量。

7. tez.runtime.shuffle.connectivity.bw:设置Tez运行时的shuffle操作的带宽限制。

8. hive.tez.auto.reducer.parallelism:设置自动决定Tez任务的Reducer并行度。

9. tez.runtime.optimize.local.fetch:设置是否在本地任务中进行数据取回优化。

这些参数可以通过Hive的SET命令进行临时配置,也可以通过修改Hive的配置文件(如hive-site.xml)进行永久配置。

具体的配置方式和参数含义可以参考Hive的官方文档。

hive配置文件以及join中null值的处理

hive配置⽂件以及join中null值的处理⼀、Hive的參数设置1. 三种设定⽅式:配置⽂件· ⽤户⾃⼰定义配置⽂件:$HIVE_CONF_DIR/hive-site.xml· 默认配置⽂件:$HIVE_CONF_DIR/hive-default.xml⽤户⾃⼰定义配置会覆盖默认配置。

另外,Hive也会读⼊Hadoop的配置,由于Hive是作为Hadoop的client启动的,Hadoop的配置⽂件包含· $HADOOP_CONF_DIR/hive-site.xml· $HADOOP_CONF_DIR/hive-default.xmlHive的配置会覆盖Hadoop的配置。

配置⽂件的设定对本机启动的全部Hive进程都有效。

2. 命令⾏參数 ,bin/hive -hiveconf hive.root.logger=INFO,console这⼀设定对本次启动的Session(对于Server⽅式启动。

则是全部请求的Sessions)有效。

3. 參数声明set mapred.reduce.tasks=100;这⼀设定的作⽤域也是Session级的⼆、使⽤hive⼀些注意的地⽅1. Hive使⽤的字符集默认是UTF-8。

hive中没有转换字符编码的这样的函数press.output 这个參数, 默认是 false。

可是⾮常多时候貌似要单独显式设置⼀遍。

否则会对结果做压缩的,假设你的这个⽂件后⾯还要在hadoop下直接操作, 那么就不能压缩了2. Join中处理null值的语义差别这⾥的特殊逻辑指的是,Hive的Join中,作为Joinkey的字段⽐較。

null=null是有意义的。

且返回值为true。

检查下⾯查询:select u.uid, count(u.uid)from t_weblog l join t_user u on (l.uid = u.uid) groupby u.uid;查询中,t_weblog表中uid为空的记录将和t_user表中uid为空的记录做连接。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验报告(四)</property><property><name>hive.exec.scratchdir</name><value>/tmp/hive</value></property><property><name>hive.server2.logging.operation.log.location</name><value>/usr/local/hive/iotmp</value></property><property><name>hive.downloaded.resources.dir</name><value>/usr/local/hive/iotmp</value></property><property><name>hive.querylog.location</name><value>/usr/local/hive/iotmp</value></property><property><name>hive.metastore.warehouse.dir</name><value>/user/hive/warehouse</value></property><property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.jdbc.Driver</value></property><property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://localhost:3306/hive?characterEncoding=UTF-8</value> </property><property><name>javax.jdo.option.ConnectionUserName</name><value>hive</value></property><property><name>javax.jdo.option.ConnectionPassword</name><value>hive</value></property><property><name>hive.metastore.local</name><value>false</value></property><property><name>hive.metastore.uris</name><value>thrift://localhost:9083</value></property></configuration>二:Hive的基本操作创建表:hive> CREATE TABLE pokes (foo INT, bar STRING);Creates a table called pokes with two columns, the first being an integer and the other a string创建一个新表,结构与其他一样hive> create table new_table like records;创建分区表:hive> create table logs(ts bigint,line string) partitioned by (dt String,country String);加载分区表数据:hive> load data local inpath '/home/hadoop/input/hive/partitions/file1' into table logs partition (dt='2001-01-01',country='GB');展示表中有多少分区:hive> show partitions logs;展示所有表:hive> SHOW TABLES;lists all the tableshive> SHOW TABLES '.*s';lists all the table that end with 's'. The pattern matching follows Java regular expressions. Check out this link for documentation显示表的结构信息hive> DESCRIBE invites;shows the list of columns更新表的名称:hive> ALTER TABLE source RENAME TO target;添加新一列hive> ALTER TABLE invites ADD COLUMNS (new_col2 INT COMMENT 'a comment');删除表:hive> DROP TABLE records;删除表中数据,但要保持表的结构定义hive> dfs -rmr /user/hive/warehouse/records;从本地文件加载数据:hive> LOAD DATA LOCAL INPATH '/home/hadoop/input/ncdc/micro-tab/sample.txt' OVERWRITE INTO TABLE records;显示所有函数:hive> show functions;查看函数用法:hive> describe function substr;查看数组、map、结构hive> select col1[0],col2['b'],col3.c from complex;内连接:hive> SELECT sales.*, things.* FROM sales JOIN things ON (sales.id = things.id);查看hive为某个查询使用多少个MapReduce作业hive> Explain SELECT sales.*, things.* FROM sales JOIN things ON (sales.id = things.id);外连接:hive> SELECT sales.*, things.* FROM sales LEFT OUTER JOIN things ON (sales.id = things.id);hive> SELECT sales.*, things.* FROM sales RIGHT OUTER JOIN things ON (sales.id = things.id);hive> SELECT sales.*, things.* FROM sales FULL OUTER JOIN things ON (sales.id = things.id);in查询:Hive不支持,但可以使用LEFT SEMI JOINhive> SELECT * FROM things LEFT SEMI JOIN sales ON (sales.id = things.id);Map连接:Hive可以把较小的表放入每个Mapper的内存来执行连接操作hive> SELECT /*+ MAPJOIN(things) */ sales.*, things.* FROM sales JOIN things ON (sales.id = things.id);INSERT OVERWRITE TABLE ..SELECT:新表预先存在hive> FROM records2> INSERT OVERWRITE TABLE stations_by_year SELECT year, COUNT(DISTINCT station) GROUP BY year> INSERT OVERWRITE TABLE records_by_year SELECT year, COUNT(1) GROUP BY year> INSERT OVERWRITE TABLE good_records_by_year SELECT year, COUNT(1) WHERE temperature != 9999 AND (quality = 0 OR quality = 1 OR quality = 4 OR quality = 5 OR quality = 9) GROUP BY year;CREATE TABLE ... AS SELECT:新表表预先不存在hive>CREATE TABLE target AS SELECT col1,col2 FROM source;。