用极大似然法进行参数估计

极大似然估计

6

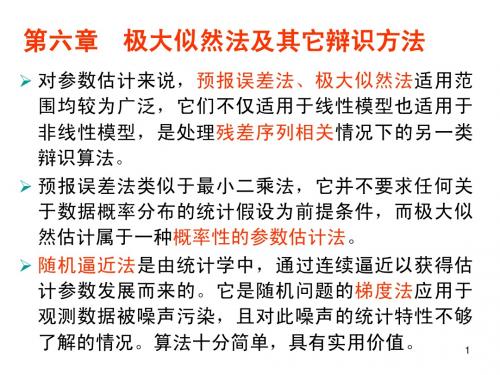

第1章 极大似然估计

1.2.4

方差矩阵的估计方法

( = ∂ 2 LnL −E ′ ∂θ0 ∂θ0 [ [ ])−1

由渐进公式 [I (θ0 )]

−1

ˆ带入上式作为θ ˆ的方差估计量,即信息矩阵的逆, 可以将θ ( ˆ) = Var(θ 在线性回归模型中, [I (θ0 )]−1 = [ ∂ 2 LnL −E ∂θ∂θ′ ( −E ] = [ ])−1

n n i=1 i=1

梯度向量也称为得分向量(score vector) 。梯度向量g 为k × 1向量。将所有观测值对 应的gi 构成的矩阵G = [g1 , g2 , . . . , gN ]′ (N × k )称为梯度向量的贡献矩阵。梯度向量g 的每 个元素为矩阵G的各列的和。 似然函数的二阶导数称为海赛矩阵(Hessian Matrix) : ∂ 2 ln f (y |θ) ∑ ∂ 2 ln f (yi |θ) ∑ H= = = Hi ∂θ∂θ′ ∂θ∂θ′

i=1 i=1

(1.2)

λxi e−λ xi !

第2节

1.2.1 极大似然估计的原理

极大似然估计

极 大 似 然 估 计 是 指 使 得 似 然 函 数 极 大 化 的 参 数 估 计 方 法,即 估 计 那 些 使 得 样 本(x1 , x2 , . . . , xN )出现的概率最大的参数。 例1.3. 正态分布的ML估计 对于n个相互独立的随机变量x = (x1 , x2 , . . . , xn ), xi ∼ N (µ, σ 2 )(i = 1, 2, . . . , n)。 根 据前面推导的(x1 , x2 , . . . , xn )的联合似然函数: ∑n (xi − µ)2 n n LnL(µ, σ |x) = − ln(σ 2 ) − ln(2π ) − i=1 2 2 2σ 2

时间序列的极大似然估计

时间序列的极大似然估计1. 引言(150-200字)时间序列分析是指通过观察时间序列数据,确定数据的模式、趋势和周期性等属性,并预测未来的发展趋势。

在时间序列分析中,极大似然估计(Maximum Likelihood Estimation,简称MLE)是一种常用的参数估计方法,它利用观测到的样本数据,推断出该数据的参数的最优值。

本文将深入探讨时间序列极大似然估计的原理、公式和步骤,以及如何应用于实际数据分析中。

2. 时间序列分析概述(250-300字)时间序列分析可用于统计、金融、经济学等领域,对于预测和决策具有重要意义。

在时间序列分析中,我们通常假设数据是来自某一分布的随机过程,而该分布的参数则需要进行估计。

极大似然估计是一种经典的参数估计方法,它寻求参数使得样本数据在给定参数下出现的概率最大化。

3. 极大似然估计原理(300-400字)极大似然估计的核心思想在于选择参数使得观测到的数据出现的概率最大化。

在时间序列分析中,我们通常假设数据服从某一特定分布,如正态分布、指数分布等。

以正态分布为例,假设观测到的数据为x1, x2, ..., xn,那么极大似然估计的目标就是找到最适合数据分布的参数值。

4. 极大似然估计公式(300-400字)在极大似然估计中,我们通过最大化似然函数的对数来推导参数的最优值。

以正态分布为例,似然函数为L(θx1, ..., xn) = Π[1/(σ√(2π))] * e^(-(xi-μ)²/(2σ²)),其中θ表示参数,μ表示均值,σ表示标准差。

极大似然估计的公式为:θ^ = argmax[ln(L(θx1, ..., xn))]。

5. 极大似然估计步骤(400-500字)极大似然估计的实施步骤分为以下几步:(1)根据数据分析确定所采用的概率分布模型;(2)写出似然函数;(3)对似然函数取对数,并进行化简;(4)求解由对数似然函数导数为零得到的方程组;(5)检查所得估计值的合理性,并进行参数的显著性检验。

各种参数的极大似然估计

各种参数的极大似然估计1.引言在统计学中,参数估计是一项关键任务。

其中,极大似然估计是一种常用且有效的方法。

通过极大化似然函数,我们可以估计出最有可能的参数值,从而进行推断、预测和优化等相关分析。

本文将介绍各种参数的极大似然估计方法及其应用。

2.独立同分布假设下的参数估计2.1参数估计的基本理论在独立同分布假设下,我们假设观测数据相互独立且具有相同的概率分布。

对于一个已知的概率分布,我们可以通过极大似然估计来估计其中的参数。

2.2二项分布参数的极大似然估计对于二项分布,其参数为概率$p$。

假设我们有$n$个独立的二项分布样本,其中成功的次数为$k$。

通过极大似然估计,我们可以得到参数$p$的估计值$\h at{p}$为:$$\h at{p}=\f ra c{k}{n}$$2.3正态分布参数的极大似然估计对于正态分布,其参数为均值$\mu$和标准差$\si gm a$。

假设我们有$n$个独立的正态分布样本,记为$x_1,x_2,...,x_n$。

通过极大似然估计,我们可以得到参数$\mu$和$\si gm a$的估计值$\h at{\m u}$和$\ha t{\s ig ma}$分别为:$$\h at{\mu}=\f rac{1}{n}\su m_{i=1}^nx_i$$$$\h at{\si gm a}=\s q rt{\fr ac{1}{n}\s um_{i=1}^n(x_i-\h at{\mu})^2}$$3.非独立同分布假设下的参数估计3.1参数估计的基本理论在非独立同分布假设下,我们允许观测数据的概率分布不完全相同。

此时,我们需要更加灵活的方法来估计参数。

3.2伯努利分布参数的极大似然估计伯努利分布是一种二点分布,其参数$p$表示某事件发生的概率。

假设我们有$n$组独立的伯努利分布样本,其中事件发生的次数为$k$。

通过极大似然估计,我们可以得到参数$p$的估计值$\h at{p}$为:$$\h at{p}=\f ra c{k}{n}$$3.3泊松分布参数的极大似然估计泊松分布是一种描述罕见事件发生次数的概率分布,其参数$\la mb da$表示单位时间(或单位面积)内平均发生的次数。

python 极大似然估计求解对数正态分布参数

python 极大似然估计求解对数正态分布参数对数正态分布的参数可以使用极大似然估计法进行求解。

以下是一个示例代码,演示如何使用Python进行对数正态分布的极大似然估计。

```pythonimport numpy as npfrom import minimize定义对数正态分布的pdf函数def lognormal_pdf(x, mean, std):return (-(((x) - mean) 2) / (2 std 2)) / (x std (2 ))定义似然函数def lognormal_likelihood(params, data):mean, std = paramsreturn (lognormal_pdf(data, mean, std))生成模拟数据data = (mean=1, sigma=, size=100)初始参数值initial_params = [((data)), (data)]最小化负对数似然函数result = minimize(lambda params: -lognormal_likelihood(params, data), initial_params, method='Nelder-Mead')输出估计参数值print('Estimated mean:', ([0]))print('Estimated std:', ([1]))```在上述代码中,我们首先定义了对数正态分布的pdf函数`lognormal_pdf`,然后定义了似然函数`lognormal_likelihood`,它接受参数和数据作为输入,并返回对数似然函数的值。

接下来,我们使用模拟数据生成器生成了一些模拟数据,并使用初始参数值进行极大似然估计。

最后,我们输出了估计的参数值。

参数估计极大似然法

将其取对数,然后对 1 , 2 ,, 2 , , k ) 0 1 ln L( 1 , 2 , , k ) 0 k

该方程组的解 ˆi ˆi (x1, x2 ,, xn ),i 1,2,, k , 即为 i 的极 大似然估计值.

求极大似然估计的一般步骤归纳如下:

(1)求似然函数 L( ) ;

(2)求出 ln L( ) 及方程

d ln L( ) 0 d

;

(3)解上述方程得到极大似然估计值

ˆ ˆ( x , x ,, x ) 1 2 n .

(4)解上述方程得到极大似然估计量

ˆ ˆ( X , X ,, X ) 1 2 n .

令

ˆ( x , x ,, x ) 解此方程得θ的极大似然估计值 1 2 n ,

从而得到θ的极大似然估计量ˆ( X1, X 2 ,, X n ) .

因为 解方程

L( )

与

ln L( )

具有相同的最大值点

d ln L( ) 0 d

也可得θ的极大似然估计值

ˆ( x , x ,, x ) 和θ的极大似然估计量 ˆ( X , X ,, X ) . 1 2 n 1 2 n

~ x d 2 ln L() 且 0 2 d ~ x

~ 从而得出λ的极大似然估计量为 X

例:设总体 X 服从参数为λ 的指数分布,其中λ 未

( x1 , x2 ,, xn ) ( X 1 , X 2 ,, X n ) 为从总体抽取一个样本, 知,

为其样本观测值, 试求参数λ 的极大似然估计值和 估计量.

例:设随机变量X服从泊松分布:

P{ X k}

k e

k!

,

极大似然估计

a* = m { X1 , X2 ,L Xn } in , b =m ax{ X1 , X2 ,L Xn } ,

*

是取自总体X的一个样本 例5设X1,X2,…Xn是取自总体 的一个样本 设 θ xθ −1 , 0 < x < 1 X ~ f ( x) = 其中θ >0, 的极大似然估计. 求θ 的极大似然估计 解:似然函数为

i =1 n

求导并令其为0 求导并令其为

d ln L(θ ) n n = + ∑ln xi =0 dθ θ i =1

从中解得

θ * = −n

∑ln x

i =1

n

i

即为θ 的MLE .

是取自总体X的一个样本 例6 设X1,X2,…Xn是取自总体 的一个样本

1 −( x−µ ) θ e , x≥µ X ~ f ( x) = θ θ , µ为未知参数 0, 其它

的极大似然估计.(注 我们把σ 看作一个参数) 的极大似然估计.(注:我们把σ2看作一个参数) .(

解:

似然函数L(µ,σ ) = ∏ f ( xi , µ,σ )

2 2 i =1

n

=∏

i =1

n

− 1 e 2πσ

( xi −µ )2 2σ

2

= (2πσ) e

n − 2

−

1 2σ 2

∑

i=1

n

( xi −µ )2

n i i=1

x!

e

−λ

x = 0,1,2,L

i

i =1

i =1

xi !

似然方程为

1 n ∂ log L(λ) = −n + ∑ xi = 0 λ i =1 ∂λ

极大似然估计方法

极大似然估计方法极大似然估计(Maximum Likelihood Estimation,MLE)方法是一种用于估计参数的统计方法,它基于观测到的样本数据,通过选择最大化观测数据出现的概率的参数值来估计未知参数。

极大似然估计是概率论和统计学中最重要的方法之一,广泛应用于各个领域的数据分析与建模中。

极大似然估计方法的核心思想是基于某一参数下观测数据出现的概率,选择使得这个概率最大的参数值。

具体而言,给定一个观测数据集合X,其来自于一个具有参数θ的概率分布,我们要估计未知参数θ的值。

极大似然估计的目标是找到一个参数值θ^,使得给定θ^条件下观测数据集合X出现的概率最大。

数学上,极大似然估计可以通过最大化似然函数来求解。

似然函数是一个参数的函数,表示给定某个参数θ下观测数据出现的概率。

似然函数的定义如下:L(θ|X) = P(X|θ)数的函数,表示给定某个参数θ下观测数据出现的概率。

极大似然估计的目标是寻找一个参数θ^,使得似然函数最大化,即:θ^ = arg max L(θ|X)为了方便计算,通常将似然函数转化为其对数形式,即对数似然函数:l(θ|X) = log L(θ|X)本文将主要介绍如何利用极大似然估计来估计参数。

具体而言,将分为两个部分:首先是介绍极大似然估计的理论基础,包括似然函数和对数似然函数的定义,以及如何通过最大化似然函数来估计参数;其次是通过一个实际的例子,展示如何使用极大似然估计来求解参数。

理论基础似然函数是极大似然估计的核心概念之一。

似然函数是一个参数的函数,表示给定某个参数θ下观测数据出现的概率。

似然函数的定义如下:L(θ|X) = P(X|θ)数的函数,表示给定某个参数θ下观测数据出现的概率。

似然函数的值越大,则表示给定参数θ的取值越可能产生观测数据X。

对数似然函数是似然函数的对数变换,通常在实际计算中会更加方便。

它的定义如下:l(θ|X) = log L(θ|X)对数似然函数和似然函数存在着一一对应关系,因此在求解参数时,两者等价。

极大似然估计 参数回归模型

极大似然估计参数回归模型极大似然估计是统计学中常用的一种参数估计方法,它通过寻找使得观测数据出现的概率最大化的参数值来估计模型的参数。

在回归分析中,极大似然估计可以用来估计线性回归模型的参数。

假设我们有一个简单的线性回归模型,表示为:Y = β0 + β1X + ε。

其中,Y是因变量,X是自变量,β0和β1是我们要估计的参数,ε是误差项。

我们的目标是通过观测数据来估计β0和β1的值,使得观测数据出现的概率最大化。

假设我们有n个观测数据,表示为{(x1, y1), (x2, y2), ..., (xn, yn)},我们假设误差项ε服从正态分布,即ε~N(0, σ^2)。

我们可以建立似然函数来描述观测数据出现的概率。

对于第i 个观测数据,其观测值yi可以表示为:yi = β0 + β1xi + εi.其中,εi服从正态分布N(0, σ^2)。

似然函数可以表示为:L(β0, β1,σ^2) = Π(1/√(2πσ^2)) exp(-(yi β0β1xi)^2 / (2σ^2))。

为了简化计算,通常我们会对似然函数取对数,得到对数似然函数:l(β0, β1, σ^2) = Σ(-log(√(2πσ^2))) Σ((yi β0β1xi)^2 / (2σ^2))。

然后通过最大化对数似然函数来估计参数β0和β1的值。

这通常可以通过数值优化算法来实现,比如梯度下降法或者牛顿法。

通过极大似然估计,我们可以得到对参数β0和β1的估计值,从而建立起回归模型。

这种方法在统计学和机器学习中被广泛应用,能够帮助我们通过观测数据来估计模型参数,从而进行预测和推断。

极大似然估计法步骤

极大似然估计法步骤极大似然估计法(Maximum Likelihood Estimation,MLE)是一种常用的参数估计方法,它利用样本数据来估计概率模型的参数。

它的基本思想是选择参数值使得观测到的样本出现的概率最大化。

极大似然估计法被广泛应用于统计学、机器学习以及其他领域。

极大似然估计法的步骤可以概括为以下几个主要步骤:1.确定参数化模型:首先,必须确定概率模型的形式和参数化,以便进行参数估计。

例如,对于二项分布模型,我们需要确定参数p 表示成功概率。

2.构建似然函数:接下来,需要构建似然函数。

似然函数是指在给定模型参数条件下观测到的样本的条件概率密度(或离散情况下的概率质量函数)。

似然函数的形式可以根据不同的概率模型进行定义。

例如,对于离散情况下的伯努利分布,似然函数可以表示为:L(p) = p^k * (1-p)^(n-k),其中k是观测到的成功次数,n是总的观测次数。

对于连续情况下的正态分布,似然函数可以表示为:L(μ,σ) = (2πσ^2)^(-n/2) * exp[-(1/2σ^2) * Σ(xi-μ)^2]。

3.对数似然函数的求解:通常,为了便于计算和优化,我们会使用对数似然函数进行求解。

对数似然函数和似然函数具有相同的最大值点,但其大大简化了计算过程。

4.最大化对数似然函数:确定参数的MLE估计值等于使得对数似然函数最大化时的参数值。

常见的最大化方法包括数值方法(如牛顿法、梯度下降法等)和解析方法。

对于某些简单的模型,可以通过求导数等条件判断来获得解析解。

例如,对于伯努利分布中的参数p,可以通过求取对数似然函数的一阶导数,并令其等于0,解得MLE估计值为p = k/n。

5.参数估计:得到MLE估计值后,就可以根据估计参数进行进一步的分析和预测了。

通常,MLE估计值具有良好的频率特性,即当样本数量趋近于无穷大时,估计值收敛到真实参数。

极大似然估计法的优点在于其较好的性质和理论基础。

极大似然参数估计

1.4 1.2 1 0.8 0.6

ˆ

0.4 0.2 0 -0.2 -0.4

ML

1

1.2

1.4

1.6

1.8

2

2.2

2.4

2.6

2.8

3

N 1 N [ yi ]2 ln L(YN | ) ln 2 2 2 2 i 1 2

d 1 N 1 ln L(YN | ) 2( yi ) 2 2 d 2 i 1

数的确定问题)

12

似然函数的确定 L(YL | ) ?

1)独立观测情况 各观测量 y(1), y(2),, y( N ) 由随机变量 y 的独立 样本所组成,观测量是独立的。

L(YN | ) p( y(1) | ) p( y(2) | ) p( y( N ) | ) p( y(i) | )

L(YN | ) -------- 似然函数

L(YN | ) p(YN | )

ML

ˆ ML ------- 使似然函数取极大值。 L(YN | ) ˆ

Max ( p (YN | ))

7

或

L(YN | ) 0 ˆ ML ln L(YN | ) 0 ˆ ML

L(YN | )

L(YN | H )

H1N1 !!!

L(YN | S ) > L(YN | H )

ˆ S

11

说明:

极大似然法是根据对观测量(输出量)y 的观测, 估计未知参数的一种方法,必然需要可观测变量

y

的

联合概率密度函数 p(YN | )的先验知识.(涉及到似然函

2 ML

极大似然估计法

n

(3) 对似然函数求导,令其为零,得到似然估计值

n n dl( p) n 1 1 n 1 xi ( ) xi 0 dp 1 p i 1 p 1 p 1 p p(1 p) i 1

1 n T ˆ p xi n i 1 n

6

例2:设某机床加工的轴的直径与图纸规定的中心 尺寸的偏差服从N (, 2 ) ,其中参数 , 2 未知。为 了估计 , 2 ,从中随机抽取n=100根轴,测得其偏 差为x1,x2…x100。试求 , 2的极大似然估计。

i 1 N

如果不要求 的分布密度,只要问 的值为多少 (最可能的值),那么就只要求 使得:

L y1 y N max

14

对于确定了的观测值Y而言,似然函数仅仅是参数 的函数。由极大似然原理可知,ˆML 满足以下方程:

L ˆ

ˆ ˆ ML

0

考虑到似然函数一般为指数函数,而指数函数和 对数函数都是单调的,为了方便求解,上式等价于 如下方程:

ln L ˆ

ˆ ˆ ML

0

ˆ 在特殊情况下,ML 能够通过方程得到解,但在一 般情况下,上式不容易得到解析解,需要采用数值 方法来求近似解。

15

下面利用极大似然原理,分析动态系统模型参数 的极大似然估计问题。首先分析极大似然估计和最 小二乘估计的关系。

考虑系统模型为线性差分方程:

极大似然的思想

先看一个简单例子:

某位同学与一位猎人一起外出打猎,一只野 兔从前方窜过。只听一声枪响,野兔应声到下了, 如果要你推测,这一发命中的子弹是谁打的?

你就会想,只发一枪便打中,由于猎人命中 的概率一般大于这位同学命中的概率,看来这一 枪应该是猎人射中的。这个例子所作的推断就体 现了极大似然的基本思想。

参数估计最大似然估计

构造:n 项连乘,总体分布 p( x, ) 改 p( xi , )

i 1,2,, n

P( A) L( ), 随变而变, A已经发生,由极大

似然原理, L( ) 到达最大,所以 旳最合理

估计值ˆ 应满足:L(ˆ)为最大值 定义 对给定旳样本值 x1, x2 ,, xn ,若

ˆ( x1, x2,, xn )满足

又L

1

n

对

xn的是减函数, 越小,L越大,故ˆL

xn时,L最大;

所以的极大似然估计量为ˆL Xn maxx1, x2, , xn

2 矩估计

由E

X

0

1

xdx

2

X

ˆ 2X

作业

• P173: 4(1)

(1) f ( x) 0, ln[ f ( x)] 单调性相同,从而最大值 点相同.

n

(2) L( ) p( xi; ) n项连乘, 求导麻烦

i1

ln[L( )] n项相加,求导简朴 对数似然函数

从而,

求的 L( ) 最大值点就转为求 ln[L( )]的最大值点

措施二:

解方程

d ln[L( )] 0,

1 i n

n

ln L( ) nln ( 1)ln xi

i 1

对数似然函数为

n

ln L( ) nln ( 1)ln xi

i 1

求导并令其为0

d ln L( )

d

n

n i 1

ln

xi

=0

从中解得

n

θ n ln xi i 1

即为 旳最大似然估计值 .

例4:设总体X 服从0, 上的均匀分布, 0未知,

条件下所使用旳一种参数估计措施. 它首先是由德国数学家

用极大似然法进行参数估计

用极大似然法进行参数估计极大似然估计(Maximum Likelihood Estimation, MLE)是一种统计推断方法,用于通过观测数据确定概率分布的参数值。

它的基本思想是选择使得已观测数据出现的概率最大化的参数值。

在本文中,我们将介绍极大似然法的基本原理、计算步骤以及一些常见的应用。

1.极大似然法的基本原理假设我们有一组独立同分布的随机样本观测值X1,X2,...,Xn,其概率密度函数(或概率质量函数)为f(x;θ),其中θ是待估计的参数。

MLE的目标是通过最大化似然函数(Likelihood Function)L(θ)来估计参数θ的值,即找到能最大化样本观测值出现概率的参数值。

似然函数L(θ)的定义为:L(θ) = f(x1;θ) * f(x2;θ) * ... * f(xn;θ)为了简化计算,常常使用对数似然函数logL(θ)进行最大化:logL(θ) = log(f(x1;θ)) + log(f(x2;θ)) + ... +log(f(xn;θ))2.极大似然法的计算步骤-确定似然函数L(θ)的表达式,即样本观测值的联合概率密度函数(或概率质量函数)的乘积。

- 对似然函数取对数,得到logL(θ)。

- 对logL(θ)求导,并令导数等于0,解出参数θ的估计值。

-检查导数的二阶偏导数,以确保估计值是一个极大值点,并非极小值或驻点。

-检验估计值的结果,并进行统计推断。

值得注意的是,当样本观测值满足一定的正则条件时,估计值通常具有一些优良的统计性质,如渐近正态性、渐近有效性等。

3.极大似然法的常见应用-二项分布参数估计:假设我们有一组成功/失败的观测数据,用于估计成功的概率p。

我们可以建立二项分布模型,并通过MLE来估计参数p 的值。

-正态分布参数估计:假设我们有一组服从正态分布的观测数据,用于估计均值μ和方差σ^2、我们可以通过MLE来分别估计这两个参数的值。

-泊松分布参数估计:假设我们有一组服从泊松分布的观测数据,用于估计平均发生率λ。

用极大似然估计法推出朴素贝叶斯法中的概率估计公式

极大似然估计法是一种常用的概率统计方法,它在统计学领域有着广泛的应用。

朴素贝叶斯法是一种基于贝叶斯定理的分类算法,它在文本分类、垃圾邮件过滤等领域被广泛应用。

本文将通过极大似然估计法推导出朴素贝叶斯法中的概率估计公式,以帮助读者深入理解这一经典的分类算法。

1. 极大似然估计法简介极大似然估计法是一种参数估计方法,它的核心思想是通过已知的样本数据,估计出使样本数据出现的概率最大的参数值。

在数学上,假设有一组观测数据X,我们希望估计出参数θ,使得观测数据X出现的概率P(X|θ)最大。

极大似然估计法就是要找到使得P(X|θ)取得极大值的参数θ。

2. 朴素贝叶斯法简介朴素贝叶斯法是一种基于贝叶斯定理与特征条件独立假设的分类算法。

在文本分类问题中,朴素贝叶斯法通过计算每个类别对应的概率,从而实现对文本进行分类。

在朴素贝叶斯法中,需要计算每个特征在每个类别下出现的概率,以及每个类别的先验概率。

3. 朴素贝叶斯法中的概率估计在朴素贝叶斯法中,需要对每个特征在每个类别下的概率进行估计。

以二元特征为例,假设有一个文本分类问题,特征X1表示某个词汇出现在文本中,特征X2表示另一个词汇出现在文本中,那么我们需要估计P(X1|C)和P(X2|C),其中C表示类别。

根据极大似然估计法,我们可以使用样本数据来估计这些概率。

4. 朴素贝叶斯法中的概率估计公式根据极大似然估计法,我们可以使用样本数据来估计每个特征在每个类别下的概率。

假设训练集中有n个样本,其中属于类别C的样本有nC个,其中特征X1出现的次数为nX1,属于类别C的样本中特征X1出现的次数为nC,X1,则有P(X1|C) ≈ nC,X1/nC。

5. 朴素贝叶斯法中的先验概率估计除了对条件概率进行估计,朴素贝叶斯法还需要对每个类别的先验概率进行估计。

假设训练集中属于类别C的样本占比为nP,总样本数为n,则先验概率P(C)可估计为nP/n。

6. 朴素贝叶斯法的应用朴素贝叶斯法在文本分类、垃圾邮件过滤等领域有着广泛的应用。

参数估计极大似然法

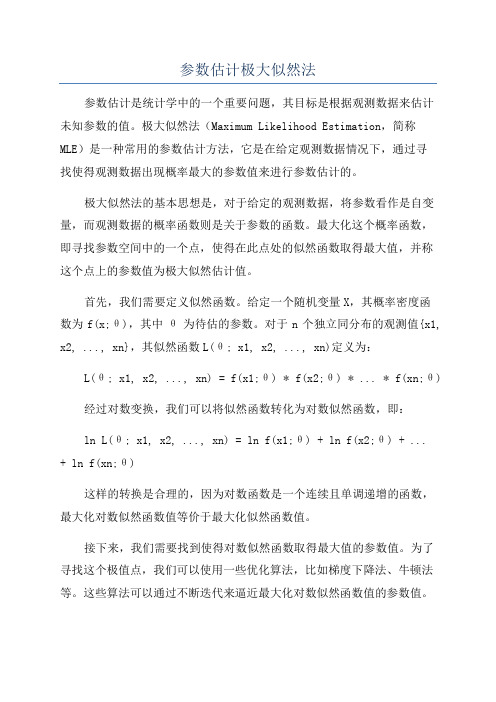

参数估计极大似然法参数估计是统计学中的一个重要问题,其目标是根据观测数据来估计未知参数的值。

极大似然法(Maximum Likelihood Estimation,简称MLE)是一种常用的参数估计方法,它是在给定观测数据情况下,通过寻找使得观测数据出现概率最大的参数值来进行参数估计的。

极大似然法的基本思想是,对于给定的观测数据,将参数看作是自变量,而观测数据的概率函数则是关于参数的函数。

最大化这个概率函数,即寻找参数空间中的一个点,使得在此点处的似然函数取得最大值,并称这个点上的参数值为极大似然估计值。

首先,我们需要定义似然函数。

给定一个随机变量X,其概率密度函数为f(x;θ),其中θ为待估的参数。

对于n个独立同分布的观测值{x1, x2, ..., xn},其似然函数L(θ; x1, x2, ..., xn)定义为:L(θ; x1, x2, ..., xn) = f(x1;θ) *f(x2;θ) * ... * f(xn;θ)经过对数变换,我们可以将似然函数转化为对数似然函数,即:ln L(θ; x1, x2, ..., xn) = ln f(x1;θ) + ln f(x2;θ) + ...+ ln f(xn;θ)这样的转换是合理的,因为对数函数是一个连续且单调递增的函数,最大化对数似然函数值等价于最大化似然函数值。

接下来,我们需要找到使得对数似然函数取得最大值的参数值。

为了寻找这个极值点,我们可以使用一些优化算法,比如梯度下降法、牛顿法等。

这些算法可以通过不断迭代来逼近最大化对数似然函数值的参数值。

当然,寻找极大似然估计值的过程可能会面临一些困难,比如求解似然函数和对数似然函数的最大值可能涉及到复杂的计算问题,此外,对于一些复杂模型,可能无法直接找到解析解。

在这些情况下,我们可以利用数值优化算法来近似求解,或者通过一些近似方法来简化问题。

需要注意的是,极大似然估计的结果并不一定是无偏的,也不一定是最优的。

用极大似然法进行参数估计

用极大似然法进行参数估计极大似然估计(Maximum Likelihood Estimation,MLE)是一种常用的统计方法,用于从已知样本中估计模型的参数。

它基于以下思想:我们选择那些使得已知样本的出现概率最大化的参数值作为估计值。

在进行极大似然估计时,需要知道样本的概率分布模型。

对于连续型分布,我们通常使用概率密度函数(probability density function,PDF)描述该分布的概率情况;而对于离散型分布,我们则使用概率质量函数(probability mass function,PMF)。

根据样本的特点,选择合适的概率分布模型是进行估计的首要步骤。

下面以一个例子来说明如何使用极大似然法进行参数估计。

假设我们有一组数据,表示了城市每天的降雨量,我们希望通过已知数据来估计该城市的降雨量的概率分布的参数。

首先考虑已知数据的概率分布模型,降雨量通常可以使用指数分布来表示。

设随机变量X表示降雨量,参数λ表示降雨率(1/天),则X服从参数为λ的指数分布,其概率密度函数为f(x;λ) = λ * exp(-λx),其中λ > 0。

假设我们有n个样本,分别为x1, x2, ..., xn,它们是独立同分布的,并且都是X的观测值。

我们要通过这些样本来估计参数λ的值。

我们需要计算已知样本的似然函数,即f(x1, x2, ..., xn; λ)。

由于样本是独立同分布的,可以将似然函数表示为各个样本的联合概率密度函数的乘积,即L(λ) = f(x1;λ) * f(x2;λ) * ... * f(xn;λ),将概率密度函数代入,得到L(λ) = λ^n * exp(-λ ∑xi)。

为了方便计算,一般采用对数似然函数进行求解。

对上述似然函数取对数,得到lnL(λ) = nln(λ) - λ∑xi。

我们的目标是最大化似然函数,那么等价于最大化对数似然函数。

接下来,我们需要求解似然函数对参数λ的一阶导数,并将其置为0,得到参数的估计值。

指数分布的矩估计和极大似然估计

指数分布的矩估计和极大似然估计指数分布是概率统计中一个重要的分布类型,它被广泛用于时间,距离,速率等方面的计算。

在实际应用中,我们需要对指数分布的参数进行估计,以便更好地对数据进行分析和预测。

本文将针对指数分布的矩估计和极大似然估计进行介绍。

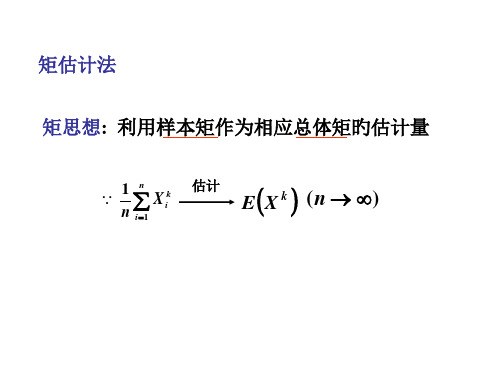

一、矩估计矩估计是一种基于数据的估计方法。

首先,我们通过实际观测数据计算出样本的一阶矩和二阶矩,然后将其代入概率分布函数,得到参数估计值。

对于指数分布而言,其概率密度函数为:f(x|θ) = θe^-θx其中,θ为指数分布的参数。

我们可以通过计算样本的一阶矩和二阶矩来估计θ的值。

样本的一阶矩为:E(X) = 1/θ样本的二阶矩为:E(X^2) = 2/θ^2将计算出的一阶矩和二阶矩代入上述概率密度函数中,得到θ的矩估计值为:θ = 1/(2E(X^2) - E(X)^2)二、极大似然估计极大似然估计是一种基于概率的估计方法。

它假设已知观测数据的分布类型,通过最大化似然函数来估计参数值。

对于指数分布而言,其似然函数为:L(θ|x) = ∏ i=1^n θe^-θxi其中,n为样本个数,x1,x2,...,xn为样本数据。

我们可以通过计算该似然函数的对数,将乘积转换为求和。

即:ln(L(θ|x)) = nln(θ) - θ∑ xi通过求导,令导数等于0,求出使似然函数最大的θ,即为θ的极大似然估计值:θ = n/∑ xi三、矩估计和极大似然估计的比较矩估计和极大似然估计都是常见的参数估计方法。

它们的区别在于矩估计基于统计量而极大似然估计基于似然函数。

从估计结果的准确性和稳定性来看,极大似然估计更加优越,因为它是最大化整个概率函数,利用了全部的数据信息。

而矩估计则只是利用了一阶和二阶矩作为参数的估计依据,忽略了其他高阶矩的信息。

但是,在样本容量较小的情况下,矩估计可能更为可靠,因为极大似然估计会受到极端值和样本大小的影响,而矩估计则更加稳定。

因此,在不同的数据分析和预测应用中,需要根据实际情况选择适合的参数估计方法。

python极大似然估计参数

python极大似然估计参数

极大似然估计是统计学中常用的一种参数估计方法,用于估计

概率分布的参数。

在Python中,我们可以使用各种统计库来进行极

大似然估计的参数计算,比如NumPy、SciPy和StatsModels等库。

首先,假设我们有一组观测数据,我们想要估计这组数据所符

合的概率分布的参数。

以正态分布为例,我们可以使用SciPy库中

的norm模块来进行极大似然估计。

假设我们的数据存储在一个名为data的NumPy数组中,我们可以使用norm.fit(data)来获得数据的均值和标准差的极大似然估计值。

另外,如果我们想要自定义概率分布模型并进行极大似然估计,可以使用StatsModels库。

该库提供了更多复杂的统计模型,比如

线性回归模型、广义线性模型等。

我们可以使用该库来拟合自定义

的概率分布模型,并使用极大似然估计来估计模型参数。

除了使用现有的库,我们也可以手动实现极大似然估计的算法。

这涉及到最大化似然函数的过程,通常可以通过梯度下降等优化方

法来实现。

我们需要定义似然函数,并通过迭代优化来找到使似然

函数最大化的参数值。

总之,在Python中进行极大似然估计参数,我们可以利用现有的统计库进行估计,也可以根据需要自行实现估计算法。

无论采用哪种方法,都需要谨慎处理数据并理解所使用的概率模型,以确保得到合理的参数估计结果。

极大似然估计方法估计GARCH模型参数

极大似然估计方法估计GARCH模型参数极大似然估计方法是一种常用的统计参数估计方法,广泛应用于金融领域中的GARCH模型参数估计。

GARCH模型是一种用于金融市场波动率预测的时间序列模型,它基于过去的波动率来预测未来的波动率。

该模型包括ARCH(自回归条件异方差)模型和GARCH(广义自回归条件异方差)模型。

GARCH模型参数估计的目标是通过观测数据最大化似然函数,找到最优的参数值,从而使模型的预测误差最小化。

1.假设GARCH模型的形式,并将其转化为等价的线性模型形式。

GARCH模型包括自回归方差,平方残差自回归以及方差残差之间的协方差。

为了进行参数估计,可以将GARCH模型转化为等价的线性模型形式,例如,将方差转化为对数形式。

2.构建似然函数。

似然函数是在给定参数的条件下,样本的观测值出现的概率,可以通过对数似然函数的方式来描述。

对GARCH模型,可以根据条件概率密度函数计算似然函数。

3.通过最大化似然函数来估计参数。

通过求解似然函数的导数等于零,可以得到似然函数的最大值,从而得到参数的估计值。

4.进行参数估计的迭代过程。

由于似然函数通常是非线性的,并且具有多个局部最大值,因此需要使用迭代的方法来找到全局最大值。

常用的迭代算法有牛顿-拉弗森法和Broyden-Fletcher-Goldfarb-Shanno (BFGS)法等。

5.通过估计参数来进行模型拟合和波动率预测。

通过估计的参数,可以进行模型拟合和波动率预测。

可以使用已知数据进行模型拟合,然后利用估计的参数来预测未来的波动率。

极大似然估计方法在GARCH模型参数估计中有着广泛的应用。

它可以对金融市场的波动进行有效预测,并为投资者提供重要的决策依据。

然而,极大似然估计方法也存在一些限制,例如对初始值敏感以及计算复杂性较高等问题。

学者们也提出了一些改进方法,例如基于遗传算法的估计方法和贝叶斯估计方法等,以提高参数估计的效果。

总之,极大似然估计方法是一种有效的GARCH模型参数估计方法,可以通过最大化似然函数来得到最优的参数估计值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

北京工商大学《系统辨识》课程上机实验报告(2014年秋季学期)专业名称:控制工程上机题目:极大似然法进行参数估计专业班级:2015年1月实验目的通过实验掌握极大似然法在系统参数辨识中的原理和应用。

二实验原理1极大似然原理设有离散随机过程{V k }与未知参数二有关,假定已知概率分布密度 fMR 。

如果我们得到n 个独立的观测值 V 1 ,V 2,…,V n ,则可得分布密度 , f (V 20),…,f(V n 0)。

要求根据这些观测值来估计未知参数 二,估计的准则是观测值 {{V k } }的出现概率为最大。

为此,定义一个似然函数LMM,f(Vn"上式的右边是n 个概率密度函数的连乘, 似然函数L 是日的函数。

如果L 达到极大值,{V k } 的出现概率为最大。

因此,极大似然法的实质就是求出使 L 达到极大值的二的估值二。

为了便于求d ,对式(1.1 )等号两边取对数,则把连乘变成连加,即n解上式可得二的极大似然估计"ML O2系统参数的极大似然估计Newton-Raphson 法实际上就是一种递推算法,可以用于在线辨识。

不过它是一种依每 L 次观测数据递推一次的算法,现在我们讨论的是每观测一次数据就递推计算一次参数估计值 得算法。

本质上说,它只是一种近似的极大似然法。

设系统的差分方程为a(z') y(k) =b(z°)u(k) + :(k)(2.1 )式中a(z') =1 a 1z^ …a n z 」 b(z')二 b °…dz"因为(k)是相关随机向量,故(2.1 )可写成a(z')y(k) =b(zju(k) +c(z')g(k)(2.2 )式中c(z') ;(k)二(k) (2.3 ) c(z\ =1 C|Z ,亠 亠(2.4 );(k)是均值为0的高斯分布白噪声序列。

多项式a(z=) , b(z*)和c(z^)中的系数 a i,..,a,b o ,…b n,G,…C n 和序列{^(k)}的均方差o ■ln L =瓦 ln f (V i 日)由于对数函数是单调递增函数,当 对二的偏导数,令偏导数为0,可得::ln L cOi 4L 取极大值时,lnL 也同时取极大值。

求式(1.2 ) 1.2 )=0(1.3 )都是未知参数。

设待估参数V - [a 「a n b o b n C iC n 1并设y(k)的预测值为AAAAAy(k) - -a j y(k -1) - - a n y(k - n) b 0u(k)川…^b n u(k - n)AAG e(k-1)…-C n e(k - n)( 2.6)式中e(k -i)为预测误差;a i ,b i ,C i 为a ,,b ,c ,的估值。

预测误差可表示为n ne(k) =y(k) — y(k) = y(k)—卜送 a ,y(k —i)+J : bu(k —i) +IL i4Tn •' Ce(k -i) =(1 a i z " 「a n z 』)y(k)-(b o b i z —「b n z 』)u(k)- y(C I z C 2 z 川…川 sz )e(k)(2.7)或者(1 c i z 」亠 亠C n z 』)e(k) = (1 ■ a i z 」亠 亠 a n z 』)y(k) -(bo + b i z +…+b n z )u(k)(2.8)因此预测误差〈e(k)1满足关系式=a (z 」)y(k) —b (z°)u(k)(2.9)式中j j _n a(z ) =i a z a n zMzHd bz 亠 亠b n znc(z ) = i c z c n z假定预测误差e(k)服从均值为o 的高斯分布,并设序列fe(k 「具有相同的方差c 2。

因 为'e(k) /与c(z JL), a(z °)和b(z 4)有关,所以二2是被估参数二的函数。

为了书写方便, 把式(2.9)写成c(z ,)e(k) =a(z °)y(k) -b(z ,)u(k)(2. i o )e(k) =y(k) a y(k -i )亠亠a “y(k - n) - b o u(k-i) - bi u(k-i)--b n u(k - n) - C i e(k -1 )- -c n (k-n),k = n ,i ,n 2,( 2. i i )或写成nnne(k)二 y(k) ' a^k -i)八 0u(k -i) - ' qe(k -i)(2.1 2)i=1i=oi=1令k=n+1,n+2,…,n+N,可得e(k)的N 个方程式,把这 N 个方程式写成向量-矩阵形式eN =YN八‘ N71(2.5)(2.13 )Y N =_y(n+1)] y(n+2)「e(n +1) | e(n +2)a nb o.y(n + N)__-y( n) -y( n+1)e(n + N)-y(1) -y(2) u(n 1) u(1) u(n 2)u(2)e(n) e(n 1)…e(1) 1 …e(2)u(n N) u(N)e(n N -1) e(N)-y (n + N —1)…-y (N ) 因为已假定 沁(k)■是均值为0的高斯噪声序列,高斯噪声序列的概率密度函数为 1 1 2 f 1 exp[ 2 (y 一 m )] 2 2 2 (2二厂)2式中y 为观测值,二2和m 为y 的方差和均值,那么1 1 2f ?exp[ 2 e (k )] 2 2 2<T(2二广)2对于e (k )符合高斯噪声序列的极大似然函数为 (2.14 ) (2.15 ) L(K 日®)=L[e(n+1),e(n+2),…,e(n + N)|8] = f[e(n+1)8]f[e(n + 2)0]・f[e(n +N)|8] 1 1 2 2 2 N exp{ 2[e (n 1) e (n 2)叶…“ e (n N)]} 口 2 —2厲(2 二;「)21 N2 — (2二厂)2exp( —~2 e N e N )2" (2.16 )—exp[一(Y N ")T (Y N ")] (2心尸 27对上式(2.17 )等号两边取对数得 1 1 T NNln L(Y Nd ;「)=ln N ln exp( 2e N e N ) ln 2 ln(2 — )2 2二 2 22;" 或写为 ln L (Y N D 二号 求In L (Y N 二匚)对二2的偏导数, :Tn L (Y N 叮)(2.17 )1 T2 eN eN2(2.18 )1 n N 八 e 2(k)k =n "1N | _22 2令其等于 0,可得N 1 :N2八、0 24 e(k)=02- 2- *In2- (2.19 )(2.20 )J⑶计算J 的梯度r 和海赛矩阵::e(k)dQ式中 2 i n4N(kr2®e 2(k)(2.21 )J =丄 ' e 2(k) 2心1(2.22 ) 二2越小越好,因为当方差 小 2 2 2 二最小时,e (k)最小,即残差最小。

因此希望 -的估值取最 八22 min J N 因为式(2.10 )可理解为预测模型,而 e(k)可看做预测误差。

因此使式(2.22 )最小 就是使误差的平方之和最小, 即使对概率密度不作任何假设, 这样的准则也是有意义的。

因 此可按J 最小来求c ,…,a,b 0,…b n ,c 1^ c n 的估计值。

(2.23 ) 由于e(k)式参数a v , ,a,b 0^ b n ,c,,…q 的线性函数,因此J 是这些参数的二次型函数。

求使In L(Y N H 二)最大的v ,等价于在式(2.10 )的约束条件下求v 使J 为最小。

由于J 对 C |是非线性的,因而求J 的极小值问题并不好解, 只能用迭代方法求解。

求J 极小值的常用 迭代算法有拉格朗日乘子法和牛顿 -拉卜森法。

下面介绍牛顿-拉卜森法。

整个迭代计算步骤 如下: (1)确定初始的 肌值。

对于 氏中的a 1,…,a,b 0,…0可按模型 A d A d e(k) =a(z )y(k) -b(z )u(k) (2.24 ) 用最小二乘法来求,而对于 中的G ,…Cn 可先假定一些值。

(2)计算预测误差 Ae(k)二 y(k) - y(k) 给出 1 n N 2J e (k)j 1(2.25 ) 并计算 n 'N飞k 』(k)(2.26 )(2.27 )n "N二 ' e(k)k =n "1T出(k) 「£e(k)…6e(k)庞(k)…ce(k) fie(k)…ce(k)~\ ----- = ------- -------- 胡 倒 Ca n 和0 cb n CC| 5C n「[y(k) a !y(k-1)亠 亠a n y(k -n) —b 0u(k) -b |u(k-1) - -b n u(k — n)-Ge(k -1) " -c n e(k - n)]同理可得j=e ca ij =e匚冃CQ i j =ec(z 4) =1c n z 」所以得C(z\ 辿=y(k —i);:e(k)=y(k - i ) - ci;:e(k-1) c ::e(k-2) . .. c ::e(k - n)…c(2.28)::e(k);a::e(k-j)(2.29)b ij =1C jre(k_j)cb(2.30)型Vi 」C j 迴S C ij3将式(2.29 )移项化简,有y(k 」r 型「C ji eM <Cj^^ ta ij mjm Fa j因为e(k - j)二 e(k)z —j由e(k - j)求偏导,故(2.31)(2.32)(2.33)::e(k_j) ::e(k)z —jca i将(2.34 )代入(2.32),所以nn y(k-i)=5: C 哑二n 权 :a i(2.34)(2.35)(2.36)ca i同理可得(2.30 )和(2.31 )为根据(2.36 )构造公式些偏导数分别为{y (k )},{u (k )}和{e (k )}的线性函数。

下面求关于 二的二阶偏导数,即T工 n .N:e(k) :e(k):.N 汽(k)二 2 一 -r re(k丿二 2。

廿 k" 0廿-讯」k=B 十也A当二接近于真值二时,e (k )接近于0。

在这种情况下,式(2.44 )等号右边第2项接近刊 _ 广 fie(k) ®(k)Th k■■将其代入(2.36 ),可得廿)屮-(1)]= / 冬 ce(k)c(z )(2.40)ca消除c (z')可得;:e(k) ::e(k -i j) ,e(k-i 1)(2.41 )a ca j ca 1同理可得(2.37 )和(2.38 ) 式::e(k) ::e(k - i j)::e(k - i)(2.42 );:b cb j ::bo:e(k) ::e(k -i j) ::e(k-i 1)(2.43 ):c i cc j式(2.29 )、式(2.30 ) 和式(2.31 ) 均为差分方程,这些差分方程的初始条件为0,(2.39 )可通过求解这些差分方程,分别求出e (k )关于耳…,a,b 0,…b n ,C |,…G的全部偏导数,而这c 才厂丫)cb i 二-u(k 「i) (2.37 )c(z 」)竺cC i--e(k -i) (2.38 )c(z 」)V f y[k —(i —j) —j] =y(k —i)ca j(2.44 )于0, -2 a才可近似表示为(2.45 )⑷按牛顿-拉卜森计算二的新估值R ,有(2.46)重复(2)至(4)的计算步骤,经过r 次迭代计算之后可得 “,近一步迭代计算可得如果则可停止计算,否则继续迭代计算。