ArchitectureforBigDataOrca一个处理大数据的模块化的

精编2020年最新公需科目:《大数据》模拟考核题库(含标准答案)

2020年最新公需科目《大数据》考试题(含答案)一、选择题1.关于SecndaryNameNde哪项是正确的?a)它是NameNde的热备b)它对内存没有要求c)它的目的是帮助NameNde合并编辑日志,减少NameNde启动时间d)SecndaryNameNde应与NameNde部署到一个节点答案.C。

二、单选题2.根据不同的业务需求来建立数据模型,抽取最有意义的向量,决定选取哪种方法的数据分析角色人员是(C)。

(单选题)A.数据管理人员B.数据分析员C.研究科学家D.软件开发工程师3.在数据生命周期管理实践中,(B)是执行方法。

(单选题)A.数据存储和备份规范B.数据管理和维护C.数据价值发觉和利用D.数据应用开发和管理4.在数据生命周期管理实践中,(B)是(单选题)A.数据存储和备份规范B.数据管理和维护C.数据价值发觉和利用D.数据应用开发和管理三、多选题5.2015年8月31日,国务院印发了《促进大数据发展行动纲要》。

正确错误6.“()阿里巴巴·贵州年货节”销售额突破8.5亿元,促进了贵州电子商务加快发展。

(单选题1分)A.2015■B.2016C.2013D.20147.关于大数据在社会综合治理中的作用,以下理解不正确的是()。

1分 A.大数据的运用能够维护社会治安 B.大数据的运用能够加强交通管理得分.■C.大数据的运用能够杜绝抗生素的滥用D.大数据的运用有利于走群众路线8.根据周琦老师所讲,大数据加速道路网络快速更新,高德()完成全国10万公里15万处更新。

A.2006年■B.2014年C.2008年D.2010年9.第一个提出大数据概念的公司是A.谷歌公司B.微软公司C.脸谱公司■D.麦肯锡公司7.统筹城乡发展,就是要求公共财政向农村倾斜.公共服务向农村覆盖.公共设施向农村延伸。

对8.《中共中央关于全面深化改革若干重大问题的决定》提出,要推进国家()和()现代化。

BD分A.治理文化B.治理能力C.治理制度D.治理体系9.建立大数据需要设计一个什么样的大型系统?■A.能够把应用放到合适的平台上■B.能够开发出相应应用■C.能够处理数据■D.能够存储数据10.宁家骏委员指出,我国发展医疗服务业,同时发展智慧养老。

HCIA-Big Data V3.0 华为认证大数据工程师在线课程章节测试题汇总

HCIA-Big Data V3.0 华为认证大数据工程师在线课程章节测试题汇总1.大数据发展趋势与鲲鹏大数据1、(单选)以下哪个不是大数据时代新兴的技术:A.HBaseB.HadoopC.MySQLD.Spark正确答案:C2、(单选)第三次信息化浪潮的标志是:A.云计算、大数据、物联网技术的普及B.个人电脑的普及C.互联网的普及D.虚拟现实技术的普及正确答案:A3、(多选)大数据的4V特性包括:A.数据量大B.数据类型繁多C.处理速度快D.价值密度低正确答案:ABCD4、(多选)下列对Hadoop各组件的理解正确的是:A.Pig:处理大规模数据的脚本语言B.Kafka:分布式发布订阅消息系统C.Oozie:工作流和协作服务引擎D.Tez:支持DAG作业的计算框架正确答案:ABCD5、(判断) “大”是大数据的关键,大数据中一定包含有用价值! 正确答案:错误2.HDFS分布式文件系统和ZooKeeper1、(单选)HDFS的命名空间不包含:A.块B.字节C.文件D.目录正确答案:B2、(单选)采用多副本冗余存储的优势不包含:A.容易检查数据错误B.保证数据可靠性C.节约存储空间D.加快数据传输速度正确答案:C3、(多选)HDFS只设置唯一一个名称节点带来的局限性包括:A.命名空间的限制B.集群的可用性C.性能的瓶颈D.隔离问题正确答案:ABCD4、(多选)Zookeeper集群主要有以下角色:A.LeaderB.FollowerC.ObserverD.Master正确答案:ABC5、(判断)Zookeeper的子节点Znode会继承父节点的ACL。

正确答案:错误3.Hive分布式数据仓库1、(单选)下列关于Hive基本操作命令的解释错误的是:A. create database userdb;//创建数据库userdbB. create table if not exists usr(id bigint,name string,age int); //如果usr表不存在,创建表usr,含三个属性id,name,ageC. load data local inpath '/usr/local/data’ overwrite into table usr;//把目录'usr/local/data'下的数据文件中的数据以追加的方式装载进usr表D. insert overwrite table student select * from user where age>10;//向表usr1中插入来自usr表的age大于10的数据并覆盖student表中原有数据正确答案:C2、(多选)下列说法正确的是:A.Hive和HDFS、HBase、Spark、Flink等工具可以统一部署在一个Hadoop平台上B.Hive本身不存储和处理数据,依赖HDFS存储数据,依赖MapReduce处理数据C.HiveQL语法与传统的SQL语法很相似D.数据仓库Hive不需要借助于HDFS就可以完成数据的存储正确答案:ABC3、(多选)以下属于Hive的基本数据类型是:A.TINYINTB.BINARYC.FLOATD.STRING正确答案:ABCD4、(判断)Hive是为了降低程序员使用MapReduce的难度而产生的。

大数据模拟试题60道-HCIA-Big Data

HCIA-Big Data Certification V3.0(CN)Mock Exam1.(判断题)传统数据库先有数据后有模式。

A. FalseB. True2.(单选题)在鲲鹏生态系统中,以下哪款操作系统是华为社区开源版?A. CentOSB. 中标麒麟C. OpenEulerD. Ubuntu3. (多选题) 以下哪些选项是华为云MRS服务低成本的体现?A. 存算分离B.按需扩减容C. 临时集群D. 集群自动弹性伸缩4.(判断题)HDSF文件系统不可以存储大量小文件。

A. FalseB. True5.(单选题)HDSF文件系统中哪个模块用来存储元数据?A. Data nodeB. Name nodeC. ZookeeperD. Client6. (多选题) ZooKeeper客户端常用命令包括哪些?A. 创建节点B. 获取节点数据C. 列出子节点D. 删除节点7.(判断题)因为HDFS有多副本机制,所有不存在单点故障。

A. FalseB. True8.(判断题)元数据持久化过程其实质是将数据从内存落盘到磁盘。

A. FalseB. True9.(判断题)Hive适用于低延时的场景,比如联机事务处理。

A. FalseB. True10.(单选题)Hive定义一个自定义函数类时,需要继承以下哪个类?A. FunctionRegistryB. UDFC. MapReduce11. (多选题) Hive支持以下哪些执行引擎?A. MapReduceB. TezC. SparkD. Loader12.(判断题)HBase是一个高可靠性、面向行、可伸缩的分布式存储系统。

A. FalseB. True13.(单选题)HBase的架构不包括哪个功能组件?A. ClientB. HMasterC. HRegionServerD. ZooKeeper14. (多选题) HBase的特点有哪些?A. HBase是一个分布式,基于列式存储的数据库B. HBase适合存储半结构化和非结构化的数据C. HBase是主从架构,HRegionServer为主节点,HMaster为从节点D. HBase中为NULL的数据不会被存储15. (多选题) MapReduce具有以下哪些特点?A. 函数式编程B. 良好扩展性C. 高容错D. 实时计算16.(单选题)Yarn中负责整个集群的资源管理和任务调度的功能模块是哪一个?A.App MasterB. NodeManagerC. Resource ManagerD. Container17.(判断题)Map阶段的Partition、Sort、Combine、Spill四个步骤缺一不可。

hcna(bigdata)-单选题

1.Spark是用以下那种编程语言实现的?A.CB.C++C.JAVAD.Scala2.FusionInsight Manager对服务的管理操作,下面说法错误的是?A.可对服务进行启停重启操作B.可以添加和卸载服务C.可以设置不常用的服务隐藏或显示D.可以查看服务的当前状态4.FusionInsight HD的Loader在创建作业时,Connector有什么作用?A.确定有哪些转换步骤B.提供优化参数,提高数据导入/导出性能C.配置作业如何与外部数据进行连接D.配置作业如何与内部数据进行连接5.下列哪个HDFS命令可用于检测数据块的完成性?A.hdfs fsckB.hdfs fsck /-deleteC.hdfs dfsadmin -reportD.hdfs balancer –threshold 16. YARN中设置队列QueueA的最大使用资源量,需要配置哪个参数?A.yarn_scheduler.capacity.root. er-limit-factorB.yarn_scheduler.capacity.root. QueueA.minimum-user-limit-factorC.yarn_scheduler.capacity.root. QueueA.stateD.yarn_scheduler.capacity.root. QueueA.maximum- capacity7.FusionInsight Manager 对服务的配置功能说法不正确的是A、服务级别的配置可对所有实例生效B、实例级别的配置只针对本实例生效C、实例级别的配置对其他实例也生效D、配置保存后需要重启服务才能生效8.关于fusioninsight HD安装流程,说法正确的是:A 安装manager>执行precheck>执行preinstall>LLD工具配置>安装集群>安装后检查>安装后配置B LLD工具配置>执行preinstall>执行precheck>安装manager>安装集群>安装后检查>安装后配置C安装manager> LLD工具配置>执行precheck>执行preinstall>安装集群>安装后检查>安装后配置D LLD工具配置>执行preinstall>执行precheck>安装集群>安装manager>安装后检查>安装后配置9.关于Kerberos部署,描述正确的是?A. Kerberos仅有一个角色B. Kerberos服务在同一个节点上有两个实例C. Kerberos服务采用主备模式部署D. Kerberos服务必须和LDAP服务部署在同一个节点10.某银行规划fusioninsight HD集群有90个节点,如果控制节点规划了3个,那集群中数据节点推荐规划多少最为合理?A.87B.85C.90D.8618.用户集群有 150 个节点,每个节点 12 块磁盘(不做 RAID,不包括 OS 盘),每块磁盘大小 1T,只安装 HDFS,根据建议,最大可存储多少数据?A、1764TBB、1800TBC、600TBD、588TB20.FusionInsight HD 节点不支持那种主机操作系统?A、Suse 11.1B、RedHat 6.5C、CentOS 6.4D、Ubuntu 11.0421.HBase shell命令中,哪个可以查看当前登陆的用户和权限组?e_permissionB.whoamiC.whoD.get_user23. Fusionsight HD manager界面Hive日志收集,哪个选项不正确?A、可指定实例进行日志收集,比如制定单独收集METASTORE的日志B、可指定时间段进行日志收集,比如只收集2016-1-1 到2016-1-10的日志C、可指定节点IP进行日志收集,例如仅下载某个IP的日志D、可指定特定用户进行日志收集,例如仅下载userA用户产生的日志27. FusionInsight HD 三层组网适合多少节点的集群规模?A、30 节点以下B、100 节点以下C、100-200 节点D、200 节点以上30.Hadoop系统中关于客户端向HDFS文件系统上传文件说法正确的是?A.客户端的文件数据经过NameNode传递给DataNodeB.客户端将文件划分为多个Block,根据DataNode的地址信息,按顺序写入每一个DataNode中C.客户端根据DataNode的地址信息,按顺序将整个文件写入每一个DataNode中,然后由将文件划分为多个BlockD.客户端只上传数据到一个DataNode,然后由NameNode负责Block复制31. FusionInsight HD 系统中,HBase的最小处理单元是region,user region和region server之间的路由信息是保存在哪?A.ZookeeperB.HDFSC.MasterD.Meta表34. 通过 FusionInsight Manager 不能完成以下哪个操作?A、安装部署B、性能监控C、权限管理D、虚拟机分配39. 关于 Hbase 的 Region 分裂流程 split 的描述不正确的是?A、Split 过程中并没有真正的将文件分开,仅仅是创建了引用文件B、Split 为了减少 region 中数据大小,从而将一个 region 分裂成两个 regionC、Split 过程中该表会暂停服务D、Split 过程中被分裂的 region 会暂停服务43. 关于FusionInsight Manager关键特性,说法正确的是?A.能够针对整个集群,某个服务器进行健康检查,不能够针对节点进行健康检查B.Manager引入角色的概念,采用RBAC的方式对系统进行权限管理C.整个系统使用Kerberos管理用户,使用Ldap进行认证,通过CAS实现单点登录D.对于健康检查结果,不能够导出检查报告,只能够在线查看44.查看kafka某topic的partition详细信息时,使用如下哪个命令?A. bin/kafka-topics.sh –createB. bin/kafka-topics.sh –listC. bin/kafka-topics.sh -describeD. bin/kafka-topics.sh -delete45. FusionInsight Hadoop 集群中,在某个节点上通过 df-hT 查询,看到的分区包含以下几个:/var/log Raid 1/srv/BigData Raid 1/srv/BigData/hadoop/data5 Non-Raid/Raid0/srv/BigData/solr/solrserver3Non-Raid/Raid0/srv/BigData/dbdata_om Raid 1这些分区所对应磁盘最佳 Raid 级别的规划组合是?A、Raid0、Raid1、Raid0、Non-Raid、Raid-1B、Raid1、Raid1、Non-Raid、Non-Raid、Raid1C、Raid0、Raid0、Raid0、Raid0D、Non-Raid、Non-Raid、Non-Raid、Non-Raid、Raid146. FusionInsigh HD 系统中 HDFS 默认 Block Size 是多少?A、32MB、64MD、256M47. FusionInsigh HD部署时,同一集群内的Flume server节点建议至少部署几个?A、1B、2C、3D、448. FusionInsight HD 系统设计日志不可以记录下面那些操作?A、手动清除告警B、启停服务实例C、删除服务实例D、查询历史监控50.Hadoop的HBase不适合哪些数据类型的应用场景?A.大文件应用场景B. 海量数据应用场景C. 高吞吐率应用场景D. 半结构化数据应用场景53. 安装 FusionInsight HD 的 Streaming 组件时,Nimbus 角色要求安装几个节点?A、1B、2C、3D、454. 关于FusionInsight HD 中Loader作业描述正确的是?A.Loader将作业提交到Yam执行后,如果Loader服务出现异常,则此作业执行失败B.Loader将作业提交到Yame执行后,如果某个Mapper执行失败,能够自动进行重试C.Loader作业执行失败,将会产生垃圾数据,需要用户手动清除D.Loader将作业提交到Yam执行后,在该作业执行完成前,不能再提交其他作业56. Hadoop 平台中,要查看 YARN 服务中一个 application 的信息,通常需要使用什么命令?A、containerB、applicationattemptC、jarD、application57.在FusionInsight集群规划部署时,建议管理节点最好部署()个,控制节点最少部署(),数据节点最少部署()A.1,2,2B.1,3,2C.2,3,1D.2,3,359. FusionInsight HD安装过程中,执行Preinstall操作不能完成哪项功能?A.修改OS,确保OS满足FusionInsight HD的安装要求B.安装MangerC.格式化分区D.安装OS缺失的RPM包60. SolrCloud 模式是集群模式,在此模式下 Solr 服务强依赖于一下哪个服务?B.HDFSC.ZooKeeperD.Yarn62. Hadoop 的 MapReduce 组件擅长处理哪些场景的计算任务?A、迭代计算B、离线计算C、实时交互计算D、流式计算67. 以下哪些数据不属于半结构化数据?A.HtmlB.XmlC.二维表D.Json68. 关于FusionInsight HD Streaming 客户端的Supervisor描述正确的是?A、Supervisor负责资源分配和资源调度B、Supervisor负责接管 Nimbus 分配的任务,启动和停止属于自己管理的worker进程C、Supervisor 是运行具体处理逻辑的进程D、Supervisor是一个Topology中接收数据然后执行处理的组件70.关于FusionInsight Manager,说法错误的是?A、NTP sever/client负责集群内各节点的时钟同步B、通过FusionInsight Manager,可以对HDFS进行启停控制、配置参数C、FusionInsight Manager所有维护操作只能够通过WebUI来完成,没有提供Shell维护命令D、通过FusionInsight Manager,可以向导式安装集群,缩短集群部署时间74. FusionInsight HD 系统中如果修改了服务的配置项,不进行服务重启,该服务的配置状态是什么状态?A、SYNCHRONIZEDB、EXPIREDC、CONFIGURINGD、UNKNOWN80. Spark应用在运行时, Stage划分的依据是哪个?A、taskB、taskSetC、actionD、shuffle84. 采用 Flume 传输数据过程中,为了防止因 Flume 进程重启而丢失数据,推荐使用以下哪种 channel 类型?A、Memory ChannelB、File ChannelC、JDBC ChannelD、HDFS Channel89. FusionInsight HD 的 Hbase 中一张表包含以下几个Region[10,20),[20,30),[30,+∞),分别编号为①,②,③,那么,11,20,222 分别属于哪个 Region?A、①①③B、①②③C、①②②D、①①②90. 关于Hive建表基本操作描述正确的是?A.创建外部表时需要指定external关键字B.一旦表创建好,不可再修改表名C.一旦表创建好,不可再修改列名D.一旦表创建好,不可再增加新列92. FusionInsight HD 系统中,如果 Solr 索引默认存放在HDFS上,以下理解正确的有?A.不需要考虑各solrserver实例上创建了多少shardB.为保证数据可靠性,创建索引时必须创建多RelicaC.通过HDFS读取索引时占用磁盘IO,因此不建议Solr实例与DataNode部署在同一节点上D.当Solr服务参数INDEX_STORED_ON_HDFS值为HDFS时,创建Collection的索引就默认存储在HDFS上。

企业级应用开发技术考核试卷

B. SOAP

C. CORBA

D. JSON-RPC

15.以下哪个技术主要用于实现分布式系统的服务注册与发现?()

A. Eureka

B. Consul

C. ZooKeeper

D. Etcd

16.企业级应用中,以下哪个组件主要用于实时通信?()

A. WebSocket

B. HTTP

3. Hadoop适合批处理,Spark适合实时处理。Hadoop基于磁盘,Spark基于内存。Hadoop稳定,Spark性能高。

4.容器化技术简化部署,保证环境一致性,促进CI/CD流程自动化。通过容器编排(如Kubernetes)实现滚动更新、蓝绿部署,提高部署效率和稳定性。

3.分布式系统中,CAP定理包含的三个基本特性是______、______和______。()

4.在微服务架构中,服务之间进行通信的常用协议是______。()

5.数据库事务隔离的四个级别分别是______、______、______和______。()

6.下列哪种编程语言被称为“函数式编程语言”:______。()

1.请简述企业级应用开发中,如何实现一个高并发的用户登录系统,并说明需要考虑的技术要点。

2.描述微服务架构的优势和可能面临的挑战,以及如何解决这些挑战。

3.在大数据处理领域,请比较Hadoop和Spark的异同点,并说明它们各自适合解决哪类问题。

4.请阐述容器化技术在企业级应用部署中的作用,以及它如何影响持续集成和持续部署(CI/CD)流程。

7. √

8. √

9. ×

10. √

五、主观题(参考)

1.实现高并发用户登录系统,需要采用分布式缓存、数据库分库分表、使用高效的加密算法和限流措施。技术要点包括缓存一致性、数据库事务、安全性、系统容量规划和性能监控。

hcip-big data developer v2.0题库

hcip-big data developer v2.0题库摘要:1.HCIP-Big Data Developer v2.0 题库概述2.题库的主要内容3.题库的学习价值和适用对象4.如何有效利用题库学习正文:HCIP-Big Data Developer v2.0 题库概述HCIP-Big Data Developer v2.0 题库是一款针对大数据开发领域的专业题库,旨在帮助学习者更好地掌握大数据开发相关知识,提升专业技能。

该题库内容丰富,覆盖了大数据开发领域的各个方面,包括基础理论、技术应用、实践操作等。

题库的主要内容HCIP-Big Data Developer v2.0 题库主要包括以下几个方面的内容:1.大数据基础理论:包括大数据概念、特点、发展历程等;2.大数据技术架构:涉及分布式存储、分布式计算、数据挖掘、数据仓库等技术;3.大数据应用开发:涵盖数据清洗、数据分析、数据可视化、实时计算等应用场景;4.大数据实践操作:提供实际案例,让学习者在实践中掌握大数据开发技能。

题库的学习价值和适用对象HCIP-Big Data Developer v2.0 题库具有很高的学习价值,适合以下几类人群学习:1.对大数据开发感兴趣的初学者,可以帮助他们系统地学习大数据开发知识;2.已有一定大数据开发基础,希望进一步提升专业技能的学习者;3.从事大数据相关工作的专业人士,可以借助题库巩固和拓展知识体系。

如何有效利用题库学习为了更有效地利用HCIP-Big Data Developer v2.0 题库学习,建议学习者采取以下方法:1.制定学习计划:根据个人学习进度和需求,合理安排学习时间,确保按部就班地完成题库学习;2.结合实际案例学习:在理论学习的基础上,动手实践操作,加深对知识的理解和运用;3.定期自测:通过题库的测试功能,检验自己的学习成果,发现并弥补知识盲点;4.参与讨论和交流:加入相关学习社群,与其他学习者分享学习心得,互相答疑解惑,共同进步。

最新2020年最新公需科目《大数据》测试题库(含参考答案)

2020年最新公需科目《大数据》考试题(含答案)一、单选题1.数据仓库的最终目的是(D )° (单选题)A.收集业务需求建立数据仓库逻辑模型C.开发数据仓库的应用分析D.为用户和业务部门提供决策支持二、多选题2.宁家骏委员指出,我国发展医疗服务业,同时发展智慧养老。

©°正确C错误3.2012年,我国农村居民家庭每百户拥有移动电话197.8部。

(判断题1分)分■正确错误46,当今世界四大趋势指的是经济全球化全球城市化.全球信息化.信息智慧化。

(判断题1分)■正确错误47.根据涂子沛先生所讲,数据就是简单的数字。

(判断题1分)正确■错误4.大数据作为一种数据集合,它的含义包括()。

■ A.数据很大B.很有价值■ C.构成复杂■「).变化很快5.“最为成功的商业运作模式是价格最低的资源将会被尽可能的消耗,以此来保存最昂贵的资源”,这是下列哪个定律的内涵?A.牛顿定律B.麦特卡尔夫定律C,摩尔定律■ D.吉尔德定律6.大数据的主要特征表现为()。

ABCE©分A.数据类型多B-处理速度快C.数据容量大D.商业价值高7.林雅华博士指出,网络时代的国家治理必须要借鉴互联网多元向度扁平化.相互竞合的方式进行。

(判断题1分)■正确错误49. 2000年,全国涉农网站超过6000家。

(判断题1分)正确■错误8.以下说法错误的是哪项? QA.大数据是一种思维方式B.大数据不仅仅是讲数据的体量大C.大数据会带来机器智能D.大数据的英文名称是large data9.“ (b)阿里巴巴•贵州年货节”销售额突破8. 5亿元,促进了贵州电子商务加快发展。

A.2015B.2016C.201310.农业农村信息化业务应用深入发展,其业务应用主要表现在哪几个方面?©* A.农业信息资源开发利用水平提高V B.农村电子商务蓬勃兴起V C.农村综合信息服务平台发展迅速17 D.农村电了政务己经基本普及11.下列各项表述中正确的有哪些?⑥得分.0分* A.在网络时代,电子政务的发展刻不容缓,政务微博发声应该成为政府治理的“标配”。

BI工程师招聘笔试题与参考答案(某世界500强集团)2025年

2025年招聘BI工程师笔试题与参考答案(某世界500强集团)(答案在后面)一、单项选择题(本大题有10小题,每小题2分,共20分)1、以下关于大数据和BI技术的说法,错误的是:A. 大数据是指无法用常规软件工具进行捕获、管理和处理的数据集B. BI(商业智能)技术可以帮助企业从大量数据中提取有价值的信息C. 数据仓库是BI系统的核心组件,主要用于存储和分析历史数据D. 实时数据分析是BI技术中的一个重要方向,可以实现即时的数据洞察2、以下关于数据挖掘技术的说法,正确的是:A. 数据挖掘是一种从大量数据中自动发现有价值信息的方法B. 数据挖掘通常用于预测未来的趋势和模式C. 数据挖掘与数据仓库、OLAP(在线分析处理)等技术是相互独立的D. 数据挖掘的结果通常是不可视化的,无法直接展示给用户3、在数据仓库设计中,以下哪个组件负责将数据从源系统抽取到数据仓库中?A. ETL(Extract, Transform, Load)B. OLAP(Online Analytical Processing)C. DWH(Data Warehouse)D. ODS(Operational Data Store)4、在BI(商业智能)项目中,以下哪个工具通常用于数据清洗和预处理?A. TableauB. Power BIC. ExcelD. Alteryx5、题干:在数据仓库中,以下哪个术语通常用来描述从多个数据源提取数据并整合到统一的数据模型中?A、数据湖B、数据仓库C、数据集市D、数据集成6、题干:在BI工具中,以下哪个功能通常用于对数据进行多维分析?A、报表生成B、数据挖掘C、OLAP(在线分析处理)D、数据清洗7、在数据仓库中,以下哪个术语表示将数据从源系统移动到数据仓库的过程?A. ETLB. DMLC. DDLD. ODS8、在BI(商业智能)项目中,以下哪个工具通常用于创建交互式的数据可视化报告?A. SQLB. ExcelC. TableauD. R9、题干:在BI(商业智能)系统中,以下哪个功能不属于数据仓库的核心功能?A. 数据集成B. 数据清洗C. 数据分析D. 数据可视化 10、题干:以下关于ETL(Extract, Transform, Load)过程的描述,不正确的是:A. ETL过程用于将数据从源系统提取到目标系统中B. 数据转换是ETL过程中最复杂的部分C. ETL过程通常在数据仓库环境中进行D. ETL过程不包括数据的加载阶段二、多项选择题(本大题有10小题,每小题4分,共40分)1、以下哪些工具或技术通常被用于数据可视化?()A. TableauB. Power BIC. Qlik SenseD. ExcelE. SQL2、以下哪些是数据分析中的数据清洗步骤?()A. 处理缺失值B. 数据类型转换C. 去除重复数据D. 异常值检测E. 数据脱敏3、在数据仓库设计过程中,关于维度表和事实表的说法正确的有:A. 维度表通常包含描述性的属性信息。

大数据开发是什么 大数据开发是干什么的

大数据开发是什么大数据开发是干什么的在当今数字化的时代,“大数据”这个词频繁地出现在我们的生活和工作中。

但对于很多人来说,大数据开发似乎是一个神秘而遥远的概念。

那么,大数据开发究竟是什么?它又是干什么的呢?让我们一起来揭开它的神秘面纱。

简单来说,大数据开发就是处理和利用大量数据的过程。

这些数据的规模通常非常庞大,以至于传统的数据处理方法和工具无法有效地应对。

想象一下,海量的数据就像一片无边无际的海洋,而大数据开发就是我们在这片海洋中航行、探索和获取有价值信息的手段。

大数据开发的核心工作之一是数据采集。

这就好比是在海洋中撒网捕鱼,我们需要从各种来源获取数据,比如网站、社交媒体、传感器、企业内部系统等等。

这些数据的格式和结构可能各不相同,有的是结构化的数据,像整齐排列的表格;有的则是非结构化的数据,比如文本、图像、音频、视频等。

大数据开发者需要运用各种技术和工具,将这些杂乱无章的数据收集起来,并进行初步的整理和转换,使其能够被后续的处理和分析所使用。

数据存储是大数据开发的另一个重要环节。

当我们采集到大量的数据后,需要有一个安全、高效的地方来存放它们。

这就像是建造一个巨大的仓库来存放货物一样。

传统的数据库可能无法胜任存储如此海量的数据,因此大数据开发者会使用专门的大数据存储技术,如Hadoop 分布式文件系统(HDFS)、NoSQL 数据库等。

这些技术能够在大规模的服务器集群上存储数据,并且具备高可靠性、高扩展性和高性能等特点。

数据处理和分析是大数据开发的关键步骤。

这就像是对捕捞上来的鱼进行筛选、分类和加工,以提取出有价值的部分。

大数据开发者会运用各种数据分析工具和算法,对海量的数据进行挖掘和分析,找出其中的规律、趋势和关联。

通过数据处理和分析,我们可以发现隐藏在数据背后的信息,比如消费者的行为模式、市场的需求变化、疾病的传播规律等等。

这些信息对于企业制定决策、优化业务流程、提高竞争力,以及政府制定政策、改善公共服务等都具有重要的意义。

商业大数据分析智慧树知到答案章节测试2023年上海商学院

第一章测试1.数据分析的一般流程是()。

A:数据采集->数据预处理->数据管理->数据分析->数据展示B:数据采集->数据分析->数据处理->数据管理->数据产品C:数据采集->数据展示->数据分析->数据管理->数据报告D:数据采集->数据管理->数据分析->数据预处理->数据可视化答案:A2.与大数据密切相关的技术是()。

A:博弈论B:云计算C:WiFiD:蓝牙答案:B3.交通大数据的信息种类包括出行者、位置、车辆、交通流、气象、舆情、活动、用地。

()A:错B:对答案:B4.现在的自动驾驶系统最高可以达到()级别。

A:L1B:L2C:L4D:全自动E:L3答案:C数据是作为信息的重要来源, 信息经过加工转化为知识。

()A:错B:对答案:B第二章测试1.下列属于分布式并行计算框架的是()A:YARNB:HDFSC:MapReduceD:Spark答案:CD2.HDFS集群中至少有3个数据节点, 即DataNode。

()A:对B:错答案:A3.每个HDFS集群有且仅有一个主节点, 即NameNode。

()A:错B:对答案:B4.Harmony是一种移动设备操作系统。

()A:对B:错答案:A5.微信小程序开发提供的是一种()云服务模式。

A:PaaSB:IaaSC:SaaS答案:A第三章测试1.指一个用来描述或者匹配一系列符合某个句法规则的字符串的单个字符串称为()。

A:语法B:正则表达式C:通配符D:字符集答案:B2.图像是以数字()形式存储在计算机中的, 其中每一个数字表示一个像素。

A:向量B:矩阵C:张量D:标量答案:B3.智能健康手环的应用开发, 体现了()的数据采集技术的应用。

A:网络爬虫B:统计报表C:传感器D:API接口答案:C4.在网络爬虫的爬行策略中, 应用最为基础的是()。

A:反向链接策略B:广度优先遍历策略C:大站优先策略D:深度优先遍历策略E:高度优先遍历策略答案:BD5.等级型和数值型数据可以排序和比较大小。

DAMA-CDGA(数据治理工程师)-重点章节习题-第14章(大数据和数据科学)

数据治理工程师 CDGA 认证考试习题集第十四章大数据和数据科学(重点章节)1. 数据科学家开展工作依赖于哪些要素()A. 丰富的数据源B. 信息组织和分析C. 展示发现和数据洞察D. 以上全部2. 那些从数据中探究、研发预测模型、机器学习模型、规范性模型和分析方法并将研发结果进行部署供相关方分析的人,被称为()A. CDO 首席数据官B. 数据分析师C. 数据科学家D. 数据架构师3. 早期,人们通过 3V 来定义大数据含义的特征,请从下列选项中选择不包含在 3V 中的一个选项。

()A. 数据量大B. 数据粘度大1C. 数据更新频繁D. 数据类型多样4. 尝试通过概率估计来预测未来结果的应用程序称为?()A.维度分析B.预测分析C.即时报告D.描述性分析5. 以下哪种技术已经成为面向数据科学的大数据集分析标准平台。

()A、MPP 技术。

B、Hadoop 技术。

C、Hbase 技术。

D、Redis 技术。

6. 以下哪一项是提升一个组织大数据和数据科学能力的最大业务驱动力。

()A、提升业务效率。

B、期望抓住从多种流程生成的数据集中发现的商机。

C、保障数据合规与安全。

D、加强业务管控。

7、以下选项中不属于数据挖掘经常使用的技术是()A.剖析(Profiling)B.向上卷积(Roll-up)C.数据缩减(Data reduction)D.自组织映射(Self-organizing maps)8、ETL 的作用主要体现在()A.构建数据集市B.管理数据仓库C.把数据转换为信息、知识D.数据库数据存储9、关于数据仓库和数据湖的主要差别,以下哪项描述是不正确的()A.存储数据类型和数据结构化流程不同B.主要提供的服务不同C.面向主要用户不同D.应用侧重点不同10、定义大数据战略和业务需求,应该考虑提供数据的及时性和范围,许多元素可以实施提供,也可以定时提供快照,甚至可以整合和汇总,其中流式计算越来越成为热点,以下不属于流式计算框架的是:()A.StromB.FlinkC.HadoopD.Spark11、MapReduce 模型有三个主要步骤()A.剖析、关联、聚类B.提取、转换、加载C.映射、修正、转换D.映射、洗牌、归并数据治理工程师 CDGA 认证考试习题答案第十四章大数据和数据科学(重点章节)1. 正确答案:D【答案解析】详见书本 P388-389 页。

(完整)GCP培训考试题库及答案

(完整)GCP培训考试题库及答案一、单选题1. GCP中,以下哪个服务提供了无服务器计算功能?A. Google Compute EngineB. Google App EngineC. Google Kubernetes EngineD. Google Cloud Functions答案:D2. 在GCP中,以下哪个服务用于存储和检索任意类型的非结构化数据?A. Google Cloud StorageB. Google Cloud SQLC. Google Cloud BigtableD. Google Cloud Spanner答案:A3. GCP中,以下哪个服务提供了完全托管的数据库服务?A. Google Cloud SQLB. Google Cloud BigtableC. Google Cloud Spanner答案:A4. 在GCP中,以下哪个服务可以用于构建、训练和部署机器学习模型?A. Google Cloud AI PlatformB. Google Cloud Vision APIC. Google Cloud Natural Language APID. Google Cloud Speech-to-Text答案:A5. GCP中,以下哪个服务提供了全球分布式的存储服务?A. Google Cloud StorageB. Google Cloud SQLC. Google Cloud BigtableD. Google Cloud Spanner答案:A二、多选题6. 在GCP中,以下哪些服务可以用于部署和管理容器化应用?A. Google Kubernetes Engine (GKE)C. Google App EngineD. Google Cloud Functions答案:A7. 以下哪些是GCP提供的数据库服务?A. Google Cloud SQLB. Google Cloud SpannerC. Google Cloud BigtableD. Google Cloud Datastore答案:A、B、C、D8. 在GCP中,以下哪些服务可以用于大数据处理和分析?A. Google BigQueryB. Google Cloud DataflowC. Google Cloud DataprocD. Google Cloud Datalab答案:A、B、C、D9. 以下哪些是GCP中的计算选项?A. Google Compute EngineB. Google App EngineC. Google Cloud FunctionsD. Google Kubernetes Engine答案:A、B、C、D10. GCP中,以下哪些服务可以用于监控和日志管理?A. Stackdriver MonitoringB. Stackdriver LoggingC. Cloud MonitoringD. Cloud Logging答案:A、B、C、D三、判断题11. GCP中的Compute Engine支持自定义虚拟机规格。

大数据在建筑设计中的应用

大数据在建筑设计中的应用随着科技的不断发展,信息技术已经渗透到了各个领域,建筑设计也不例外。

随着大数据的出现,建筑设计也迎来了新的发展机遇。

大数据在建筑设计中的应用,可以让设计师更好地了解用户的需求,提高建筑设计的质量和效率,同时也可以为建筑的运营和维护提供更多的数据支持。

一、大数据在建筑设计中的应用1、用户调研在建筑设计中,了解用户的需求是非常重要的。

而大数据可以从多个方面收集用户信息,比如收集用户的搜索记录、购买记录等来分析用户的生活习惯,偏好等,这些信息可以为建筑设计提供很好的参考和借鉴。

2、CAD/CAM在建筑设计中,CAD/CAM起着至关重要的作用。

与传统的手工绘图相比,CAD/CAM可以大大提高建筑设计的效率和准确率,同时也可以把建筑设计变得更加精细、实用和美观。

3、智能化系统智能化系统也是大数据在建筑设计中的应用之一。

通过对大数据的分析,设计师可以更好地了解用户的生活习惯和需求,进而设计出更加贴合用户需求的智能化系统。

4、环境监测在建筑设计中,环境监测也是非常重要的。

大数据可以通过监测气体排放、温度、湿度等因素,为建筑设计提供更加准确的数据支持,让建筑设计更加符合环保要求,同时也可以为建筑的运营和维护提供更多的数据支持。

二、大数据在建筑运营和维护中的应用1、能源管理在建筑运营和维护中,能源管理非常重要。

大数据可以通过对建筑的能耗进行分析,为建筑的能源管理提供更加详细和准确的数据支持,让建筑的能源管理更加高效和可持续。

2、设备维护建筑中的设备维护也是很重要的。

通过将设备的运行数据与大数据相结合,可以实现对设备的实时监测和预警,有效防范设备故障和损坏,从而延长设备寿命,提高工作效率和减少维修成本。

3、安全管理在建筑的运营过程中,保证建筑的安全是非常重要的。

同时,通过对大数据的分析,可以及早发现并解决安全隐患,加强安全管理,从而提高建筑的安全性和可靠性。

三、总结随着时代的变迁,大数据已经成为了建筑设计和运营维护的重要工具。

big data英文解释

big data英文解释【原创版】目录1.大数据的英文解释2.大数据的概念和背景3.大数据的应用领域4.大数据的未来发展趋势正文【大数据的英文解释】大数据(Big Data)是指在传统数据处理软件难以处理的庞大数据集。

它涉及到从不同来源获取、存储、处理、分析和可视化各种类型的数据,包括结构化和非结构化数据。

英文解释中,大数据常被描述为“the collection of data that is too large and complex for traditional data processing software to manage”。

【大数据的概念和背景】大数据的概念源于 21 世纪初,随着互联网的普及和信息技术的发展,数据量呈现出爆炸式增长。

大数据的核心价值在于数据分析,它可以帮助企业或组织发现潜在的商业价值和未知的信息。

大数据的概念可以分为三个关键特征:数据量、数据多样性和处理速度,通常被概括为“3V”(Volume、Variety、Velocity)。

【大数据的应用领域】大数据的应用领域广泛,涵盖了政府、金融、医疗、教育、零售等多个行业。

以下是一些典型的应用场景:1.政府领域:大数据在政策制定、城市规划、公共安全等方面发挥作用,帮助政府提高治理能力。

2.金融领域:大数据在信用评估、风险控制、金融产品创新等方面具有重要价值。

3.医疗领域:大数据在疾病预测、药物研发、医疗资源配置等方面具有广泛应用。

4.教育领域:大数据可以为教育资源分配、学生个性化学习等方面提供支持。

5.零售领域:大数据可以帮助企业了解消费者需求,实现精准营销。

【大数据的未来发展趋势】随着 5G、物联网、人工智能等技术的发展,大数据在未来将继续保持高速增长。

以下是一些大数据未来的发展趋势:1.数据量持续增长:随着各种智能设备的普及,数据量将继续呈现爆炸式增长。

2.数据分析技术不断创新:人工智能、机器学习等技术将推动大数据分析技术的进步。

DAMA-CDGA(数据治理工程师)-模拟卷4

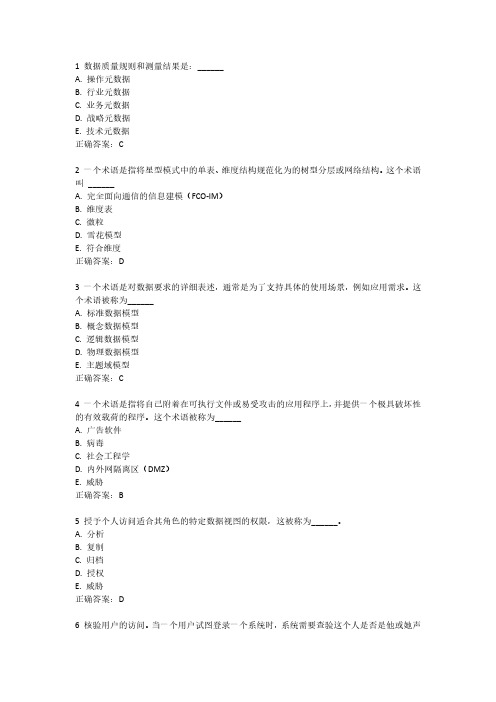

1 数据质量规则和测量结果是:______A. 操作元数据B. 行业元数据C. 业务元数据D. 战略元数据E. 技术元数据正确答案:C2 一个术语是指将星型模式中的单表、维度结构规范化为的树型分层或网络结构。

这个术语叫______A. 完全面向通信的信息建模(FCO-IM)B. 维度表C. 微粒D. 雪花模型E. 符合维度正确答案:D3 一个术语是对数据要求的详细表述,通常是为了支持具体的使用场景,例如应用需求。

这个术语被称为______A. 标准数据模型B. 概念数据模型C. 逻辑数据模型D. 物理数据模型E. 主题域模型正确答案:C4 一个术语是指将自己附着在可执行文件或易受攻击的应用程序上,并提供一个极具破坏性的有效载荷的程序。

这个术语被称为______A. 广告软件B. 病毒C. 社会工程学D. 内外网隔离区(DMZ)E. 威胁正确答案:B5 授予个人访问适合其角色的特定数据视图的权限,这被称为______。

A. 分析B. 复制C. 归档D. 授权E. 威胁正确答案:D6 核验用户的访问。

当一个用户试图登录一个系统时,系统需要查验这个人是否是他或她声称的人,密码是一种方法。

这被称为______A. 分析B. 复制C. 归档D. 验证E. 威胁正确答案:D7 审查安全行动和用户活动,以确保符合法规并符合公司政策和标准。

这被称为______A. 分析B. 复制C. 归档D. 审计E. 威胁正确答案:D8 这个术语既指损失的可能性,也指构成潜在损失的事物或条件。

这个术语被称为______A. 分析B. 复制C. 归档D. 审计E. 风险正确答案:E9 当一个组织有以下哪种情况时,会给予正式批准文件?A. 采集并存储在其数据库中的数据B. 被黑客攻击,关于个人的信息被公开C. 在收集、使用或披露个人信息时,获得了信息个体的同意D. 与其数据管理委员会一起审查其现行政策E. 公布有关其政策和做法的具体信息正确答案:C10 在数据处理道德伦理学中,“社会许可”指的是在以下哪个方面的一致性?A. 利益相关者的要求和技术成果B. 社会的需求和他们获取数据的权利C. 利益相关者的期望和组织D. 社会和政治决策矩阵E. 公众的看法和公布的事实正确答案:E11 ______是对一个组织可能采取的潜在进攻性行动。

智慧树知到《大数据工具应用》章节测试答案

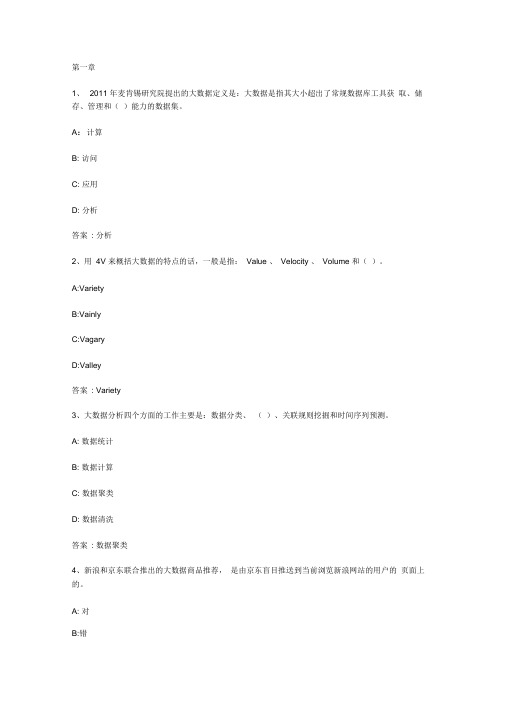

1、2011 年麦肯锡研究院提出的大数据定义是:大数据是指其大小超出了常规数据库工具获取、储存、管理和()能力的数据集。

A:计算B: 访问C: 应用D: 分析答案: 分析2、用4V 来概括大数据的特点的话,一般是指:Value 、Velocity 、Volume 和()。

A:VarietyB:VainlyC:VagaryD:Valley答案: Variety3、大数据分析四个方面的工作主要是:数据分类、()、关联规则挖掘和时间序列预测。

A: 数据统计B: 数据计算C: 数据聚类D: 数据清洗答案: 数据聚类4、新浪和京东联合推出的大数据商品推荐,是由京东盲目推送到当前浏览新浪网站的用户的页面上的。

A: 对B:错5、目前的大数据处理技术只能处理结构化数据。

A: 对B: 错答案: 错第二章1、我们常用的微软Office 套件中的Access 数据库软件的数据库文件格式后缀名是()。

A:mdfB:mdbC:dbfD:xls答案: mdb2、大多数日志文件的后缀名是()。

A:txtB:csvC:xmlD:log答案: log3、本课程重点介绍的weka 软件的专有文件格式是()。

A:MongoDBB:ARFFC:valueD:key map4、数据清洗工作的目的主要是要解决数据的完整性、唯一性、合法性和()。

A: 专业性B: 排他性C: 一致性D: 共享性答案: 一致性5、八爪鱼软件的“自定义采集”工作方式下,需要在软件里输入一个()来作为采集的目标。

A: 电话号码B: 关键词C: 网页地址D: 用户名答案: 网页地址6、八爪鱼软件的采集规则可以通过文件的形式来导入或者导出,这种文件的后缀名是()。

A:otdB:jpgC:pngD:gif答案: otd7、Excel 可以通过“数据有效性”按钮操作来规范数据输入的范围。

A:对B: 错8、Excel 不能导入txt 或csv 格式的文件。

A: 对B: 错答案: 错9、八爪鱼软件只能对软件内建了“简易采集”规则的网站采集数据。

信息系统集成考核试卷

5.以下哪些技术可用于企业应用集成?()

A. ESB(企业服务总线)

B. SOA(面向服务架构)

C. Web服务

D.数据库同步

6.项目管理中,项目进度管理包括以下哪些内容?()

A.进度计划

B.进度控制

C.工作分解结构

D.甘特图

7.以下哪些测试类型属于系统测试?()

A.功能测试

B.性能测试

A.供应商管理

B.库存控制

C.客户关系管理

D.财务报告

20.以下哪个不是大数据处理的关键技术?()

A.分布式存储

B.数据挖掘

C.实时处理

D.数据压缩

(后续题目类型请按需继续指示)

二、多选题(本题共20小题,每小题1.5分,共30分,在每小题给出的四个选项中,至少有一项是符合题目要求的)

1.信息系统集成的关键要素包括哪些?()

B.文档审查

C.原型法

D.硬件检测

5.在系统设计阶段,下列哪一项不是需要考虑的因素?()

A.数据流程图

B.系统架构

C.编程语言选择

D.用户界面设计

6.以下哪项不是企业应用集成(EAI)的技术?()

A.数据库集成

B.应用程序接口(API)

C.中间件

D.云计算

7.在项目管理中,哪一项不是项目范围管理的内容?()

14. ABCD

15. ABC

16. ABCD

17. ABC

18. ABCD

19. ABC

20. ABC

三、填空题

1.集成

2.系统规划

3.需求规格说明书

4.可行

5.松耦合

6.控制项目范围

7.逻辑

ACA大数据判断题题库(62道)

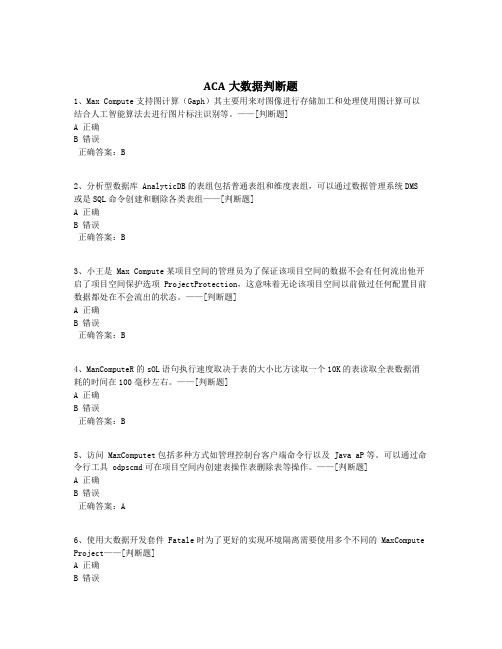

ACA大数据判断题1、Max Compute支持图计算(Gaph)其主要用来对图像进行存储加工和处理使用图计算可以结合人工智能算法去进行图片标注识别等。

——[判断题]A 正确B 错误正确答案:B2、分析型数据库 AnalyticDB的表组包括普通表组和维度表组,可以通过数据管理系统DMS或是SQL命令创建和删除各类表组——[判断题]A 正确B 错误正确答案:B3、小王是 Max Compute某项目空间的管理员为了保证该项目空间的数据不会有任何流出他开启了项目空间保护选项 ProjectProtection,这意味着无论该项目空间以前做过任何配置目前数据都处在不会流出的状态。

——[判断题]A 正确B 错误正确答案:B4、ManComputeR的sOL语句执行速度取决于表的大小比方读取一个10K的表读取全表数据消耗的时间在100毫秒左右。

——[判断题]A 正确B 错误正确答案:B5、访问 MaxComputet包括多种方式如管理控制台客户端命令行以及 Java aP等。

可以通过命令行工具 odpscmd可在项目空间内创建表操作表删除表等操作。

——[判断题]A 正确B 错误正确答案:A6、使用大数据开发套件 Fatale时为了更好的实现环境隔离需要使用多个不同的 MaxCompute Project——[判断题]A 正确B 错误正确答案:A7、某个创业公司打算采用阿里云大数据计算服务 Max Compute为自身用户提供产品推荐的服务但是公司初期的用户数并不太多而 Max Compute的存储费用相对云数据库RDs较高应该推荐其等到用户数量增加到一定规模再使用 Max Compute的服务。

——[判断题]A 正确B 错误正确答案:B8、联机分析处理是数据仓库系统最重要的应用专门设计用于支持复杂的分析操作侧重对决策人员和高层管理人员的决策支持,可以根据要求快速灵活地进行大数据量的复杂查询处理井以种直观易懂的形式将查询结果提供给决策人员以便他们准确掌握企业的经营状况了解对象的需求制定正确的方案。

Big Data Expert, MC岗位职责

Big Data Expert, MC岗位职责

大数据专家是一种高级数据分析职业。

他们负责分析大型数据库,以发现业务趋势并为业务提供优化建议。

以下是大数据专家(MC)的工作职责:

1. 设计和执行数据分析方法:大数据专家需要开发并实施数据分析方案,以便从大量的数据中提取有用的信息。

他们应该了解大数据技术,并能够使用现代统计学工具来分析数据。

2. 确定数据需求:根据业务范围创建或更新数据模型。

3. 协作团队:大数据专家必须与其他部门合作,以了解他们的数据需求并为他们提供有效的解决方案。

4. 数据可视化:将收集到的数据转换成报告、图表和控制面板等可视化数据,并设计可操作的指标。

5. 优化查询性能:大数据专家负责设计和优化数据库查询以提高查询性能。

6. 数据质量管理:确保数据的准确性、完整性和一致性,并跟踪数据的源头以及打印数据提供方的稳定性。

7. 寻找业务机会:通过数据分析发现业务机会,并为业务提供优质建议。

8. 报告结果:大数据专家需要将结果与问题部门分享,并解释数据如何影响业务,以便员工更好地理解数据。

9. 数据隐私:辨别数据隐私问题,并采取措施确保保护数据真正贯彻。

大数据专家在处理海量数据方面有着深入的知识。

他们可以处理和分析不同格式和类型的数据,以便为业务提供重要机会。

智慧树知到大数据工具应用章节测试答案

智慧树知到大数据工具应用章节测试答案第一题:大数据工具是指用于处理大规模数据的软件和技术工具。

它们能够帮助用户快速、高效地处理和分析海量数据,从而发现数据中隐藏的规律和价值。

大数据工具的应用范围非常广泛,包括数据清洗、数据存储、数据分析、数据可视化等方面。

第二题:Hadoop是一种分布式计算框架,主要用于存储和处理大规模数据。

它由Hadoop分布式文件系统(HDFS)和Hadoop分布式计算框架(MapReduce)两部分组成。

HDFS用于将数据分布式存储在多台机器上,而MapReduce则用于将数据分布式处理和计算。

Hadoop具有高可靠性、高扩展性和高容错性的特点,适用于处理大规模数据。

第三题:Hive是一种基于Hadoop的数据仓库工具,它提供了类似于SQL的查询语言,可以将结构化数据映射到Hadoop集群上进行查询和分析。

Hive将查询语句转化为MapReduce任务,在Hadoop集群上执行。

Hive适用于处理结构化数据,如日志数据、用户行为数据等。

它提供了丰富的数据处理函数和数据转换功能,能够满足大部分数据分析的需求。

第四题:Spark是一种快速、通用的大数据处理引擎,它可以在内存中高效地处理大规模数据。

Spark提供了丰富的API,支持多种编程语言,如Java、Scala和Python。

Spark的核心概念是弹性分布式数据集(RDD),它是一种抽象的数据结构,可以在集群中并行处理和计算。

Spark具有高速、易用和可扩展的特点,适用于各种大数据处理场景。

第五题:Flink是一种流式处理框架,它能够实时处理和分析数据流。

Flink提供了流处理和批处理两种模式,可以处理无界数据流和有界数据集。

Flink具有低延迟、高吞吐量和容错性的特点,适用于实时数据处理和流式计算。

Flink支持多种数据源和数据接收器,可以与其他大数据工具无缝集成。

第六题:Kafka是一种分布式消息队列系统,用于高吞吐量的发布/订阅消息传输。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

The results of applying transformation rules are copied-in to the Memo, which may result in creating new groups and/or adding new group expressions to existing groups. Each transformation rule is a selfcontained component that can be explicitly activated/deactivated in Orca configurations.

Memo.

The space of plan alternatives generated by the optimizer is encoded in a compact in-memory data structure called the Memo .

The Memo structure consists of a set of containers called groups, where each group contains logically equivalent expressions.

The output of Orca is a DXL plan. During optimization, the database system can be

queried for metadata (e.g., table definitions). Orca abstracts metadata access details by allowing

Interaction of Orca with database system

Figure 2 shows the interaction between Orca and an external database system. The input to Orca is a DXL query.

Metadata Cache

Since metadata (e.g., table definitions) changes infrequently, shipping it with every query incurs an overhead. Orca caches metadata on the optimizer side and only retrieves pieces of it from the catalog if something is unavailable in the cache, or has changed since the last time it was loaded in the cache.

主管服务器负责协调与其他数据库实例共同工作,处理和存储数据。每 一个数据库实例成为一个segment。

当一个查询被提交给主管服务器,查询将被优化并分解为更加细化的任 务,分布到每一个segment进行处理,共同提交最终结果。

网络层负责segments之间的进程进行通讯。

HAWQ

HAWQ , a massively parallel SQL-compliant engine on top of HDFS(Hadoop分布式系 统).

GPDB architecture

GPDB architecture工作原理

储存和处理如此大量的数据是通过将负载分布到几个独立的服务器或主 机,创建一系列个体数据库,一起协作,提供一个单一的数据库映像。

主管服务器(master severs)是GPDB的入口,也就是用户连接数据库提 交SQL语句的地方。

Property Enforcement

Orca includes an extensible framework for describing query requirements and plan characteristics based on formal property specifications. Properties have different types including logical properties (e.g., output columns), physical properties (e.g., sort order and data distribution), and scalar properties (e.g., columns used in join conditions).

Orca: A Modular Query Optimizer Architecture for Big Data Orca: 一个处理大数据的模块化 的查询优化体系

Sigmod 2014

报告人 万丽蓉

研究背景

In this paper we present the architecture of Orca, the new query optimizer for all Pivotal ( Pivotal 公司) data management products,including Pivotal Greenplum Database (GPDB) and Pivotal HAWQ.

Metadata cache also abstracts the database system details from the optimizer, which is particularly useful during testing and debugging.

Orca特点

Modularity(模块化) Extensibility(可扩展性) Multi-core ready:Orca deploys a highly

Search and Job Scheduler

Orca uses a search mechanism to navigate through the space of possible plan alternatives and identify the plan with the least estimated cost.

Transformations

Plan alternatives are generated by applying transformation rules that can produce either equivalent logical expressions (e.g., InnerJoin(A,B) →InnerJoin(B,A)), or physical implementations of existing expressions (e.g., Join(A,B) → HashJoin(A,B)).

Group members, called group expressions, achieve the group goal in different logical ways (e.g., different join orders).

Each group expression is an operator that has other groups as its children.

HAWQ 在内核中使用Orca体系设计高效的查询 方案,降低Hadoop集群的数据访问成本。

HAWQ把最新的基于成本的优化和 Hadoop的可扩展性容错性结合了起来, 在PB级规模上实现了数据的交互处理。

Interaction of Orca with database system

Orca is the new query optimizer for Pivotal data management products, including GPDB and HAWQ.

database system to register a metadata provider (MD Provider) that is responsible for serializing metadata into DXL before being sent to Orca.

The database system needs to include translators that consume/emit data in DXL format. Query2DXL translator converts a query parse tree into a DXL query, while DXL2Plan translator converts a DXL plan into an executable plan.

efficient multi-core aware scheduler that distributes individual negrained optimization subtasks across multiple cores for speed-up of the optimization process.