robot文件介绍

robots.txt文件语法写法总结(南昌新媒体公司古怪科技)

对于seo学习博客在谷歌的收录有很多的过期页面的问题,黑雨seo找了很多的资料,robots.txt怎么写?首先要解决的问题是:什么是robots.txt?①什么是robots.txt?这是一个文本文件,是搜索引擎爬行网页要查看的第一个文件,你可以告诉搜索引擎哪些文件可以被查看,哪些禁止。

当搜索机器人(也叫搜索蜘蛛)访问一个站点时,它首先会检查根目录是否存在robots.txt,如果有就确定抓取范围,没有就按链接顺序抓取。

②robots.txt有什么用为何需要用robots.txt这个文件来告诉搜索机器人不要爬行我们的部分网页,比如:后台管理文件、程序脚本、附件、数据库文件、编码文件、样式表文件、模板文件、导航图片和背景图片等等。

说到底了,这些页面或文件被搜索引擎收录了,用户也看不了,多数需要口令才能进入或是数据文件。

既然这样,又让搜索机器人爬行的话,就浪费了服务器资源,增加了服务器的压力,因此我们可以用robots.txt告诉机器人集中注意力去收录我们的文章页面。

增强用户体验。

③robots.txt如何配置:robots.txt基本语法User-agent: *Disallow: /我们在说这四行是什么意思之前来先看看robots.txt的几个关键语法:a、User-agent: 应用下文规则的漫游器,比如Googlebot,Baiduspider等。

b、Disallow: 要拦截的网址,不允许机器人访问。

c、Allow: 允许访问的网址d、”*”: 通配符—匹配0或多个任意字符。

e、”$”: 匹配行结束符。

f、”#”: 注释—说明性的文字,不写也可。

g、Googlebot: 谷歌搜索机器人(也叫搜索蜘蛛)。

h、Baiduspider: 百度搜索机器人(也叫搜索蜘蛛)。

i、目录、网址的写法:都以以正斜线(/) 开头。

如Disallow:/Disallow:/images/Disallow:/admin/Disallow:/css/由此可看:上面例子所表示的意思是禁止所有搜索引擎访问网站的任何部分。

简述urdf文件的构成

简述urdf文件的构成urdf文件是用于描述机器人模型的一种文件格式,它由一系列的标签组成,每个标签代表了机器人的一个部件或连接关系。

urdf文件的构成如下所述。

1. urdf标签:urdf文件的根标签,用于定义整个机器人模型。

在urdf标签中,可以包含一系列的子标签,用于描述机器人的各个部件和连接关系。

2. robot标签:robot标签是urdf文件中的必需标签,用于定义机器人的基本信息,如机器人的名称、版本号等。

3. link标签:link标签用于定义机器人的各个部件,如机器人的身体、手臂、腿等。

在link标签中,可以定义部件的名称、位置、姿态、外观等信息。

4. joint标签:joint标签用于定义机器人的连接关系,如机器人的关节。

在joint标签中,可以定义关节的类型、名称、位置、姿态、运动范围等信息。

5. material标签:material标签用于定义机器人部件的外观材质,如颜色、纹理等。

在material标签中,可以定义材质的名称、颜色值等信息。

6. collision标签:collision标签用于定义机器人部件的碰撞形状,用于进行碰撞检测。

在collision标签中,可以定义碰撞形状的类型、尺寸、位置、姿态等信息。

7. visual标签:visual标签用于定义机器人部件的可视化外观,用于显示机器人的外观。

在visual标签中,可以定义外观的类型、尺寸、位置、姿态等信息。

8. inertia标签:inertia标签用于定义机器人部件的惯性参数,用于进行运动学和动力学计算。

在inertia标签中,可以定义惯性参数的质量、惯性矩阵等信息。

通过以上标签的组合,可以构建出一个完整的urdf文件,描述了机器人的模型、连接关系、外观、碰撞形状和惯性参数等信息。

urdf 文件的结构清晰,方便阅读和编辑,是机器人模型描述的重要工具。

Robots文件的应用(古怪科技)

Robots.txt文件告诉搜索引擎哪些页面是可以被收录的哪些是不可以被收录的。

如果您不想让搜索引擎收录某些页面,请用robots.txt文件制定搜索引擎在你网站的抓取范围。

所以Robots的写置是优化网站所必须的。

Robots.Txt文件的设置:了解robots先从百度开始:下面是百度的robots:/robots.txtUser-agent: Baiduspider (蜘蛛类型:Baiduspider为百度蜘蛛只对百度蜘蛛有效)Disallow: /baidu (限定蜘蛛不能爬取的目录,也可以是页面)User-agent: * (这里就是代表所有蜘蛛的一个限定)Disallow: /shifen/Disallow: /homepage/Disallow: /cpro从以上的百度robots简单了解到,robots.txt能够屏蔽蜘蛛访问特定的目录,方法就是Disallow: /目录名。

改方法是屏蔽此目录包含子目录的所有文件,当然如果子目录不屏蔽,我们可以使用Disallow: /目录名/,我们发现robots.txt一个简单的/ 所起到的作用却截然不同,所以在我们书写robots.txt 的时候一定不能大意,写完后要反复检查或者交站长工具检测。

下面介绍几种特殊写法,用于不同情况:①屏蔽动态页面:Disallow: /*?* Robots检测解释:禁止所有引擎抓取网站所有动态页面这个应该很容易理解,/*?* 表示网站任何带?的url链接,我们知道这种链接一般就是动态页面,鉴于网站静态化处理过的网站完全可以通过屏蔽动态页面来避免出现重复页面,当然如果是数据库驱动的网站,而没有做静态或伪静态处理的网站,就不必要做此特殊处理了。

②屏蔽特殊后缀的文件例如:Disallow: /*.php$ Robots检测解释:禁止所有引擎抓取网站后缀为并且包含。

php的文件$代表以什么后缀结束,介绍符号。

我们可以通过此方法来屏蔽css文件甚至js文件,当然目前我们不是很清楚蜘蛛对于js爬取情况,有朋友做过类似测试的或者查看过日志文件朋友可以分享下。

robot文件相关知识大全

你真的懂robots文件吗?前些日子针对企业网站内部优化和大家分享了下,相信大家也都比较了解站内优化所包含的几大步骤。

其中robots文件的设置相信很多的seoer都知道起着举足轻重的作用。

今天我菜鸟seo郝晓奇就来为大家相信的介绍介绍robots文件,让您真的更懂它。

搜索引擎都有自己的“搜索机器人”(Robots),并通过这些Robots在网络上沿着网页上的链接不断抓取资料建立自己的数据库。

但是有时候对于网站管理者和内容提供者来说,有时候会有一些站点内容,不希望被Robots抓取公开。

为了解决这个问题,robots文件就应运而生了。

robots.txt是一个纯文本文件,通过在这个文件中声明该网站中不想被robots访问的部分,这样,该网站的部分或全部内容就可以不被搜索引擎收录了,或者指定搜索引擎只收录指定的内容。

当一个搜索机器人访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果找到,搜索机器人就会按照该文件中的内容来确定访问的范围,如果该文件不存在,那么搜索机器人就沿着链接抓取。

robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

相信很多seoer都知道如何书写robots文件,那么我就针对像我一样菜鸟级的seoer们在啰嗦啰嗦robots文件的格式问题。

robots文件中的记录通常以一行或多行User-agent开始,后面加上若干Disallow 行,详细情况如下:1、 User-agent:该项的值用于描述搜索引擎robot的名字,在"robots.txt"文件中,如果有多条User-agent记录说明有多个robot会受到该协议的限制,对该文件来说,至少要有一条User-agent记录。

如果该项的值设为*,则该协议对任何机器人均有效,在"robots.txt"文件中, "User-agent: *"这样的记录只能有一条。

robot协议

robot协议Robot协议。

Robot协议,又称为爬虫协议、机器人协议,是一种被网站服务器用来和网络爬虫或网络机器人交流的协议。

它的作用是告诉爬虫程序哪些页面可以抓取,哪些页面不可以抓取。

这个协议通常是一个叫做robots.txt的文本文件,位于网站的根目录下。

在这个文件中,网站管理员可以指定哪些页面可以被抓取,哪些页面不可以被抓取,以及抓取频率等信息。

首先,Robot协议的作用是保护网站的隐私和安全。

通过robots.txt文件,网站管理员可以限制搜索引擎爬虫抓取一些敏感信息,比如个人隐私数据、财务信息等。

这样可以有效地保护网站的隐私和安全,防止这些敏感信息被不明身份的爬虫程序获取。

其次,Robot协议可以控制搜索引擎爬虫的抓取行为,避免对网站造成过大的负担。

有些网站可能由于各种原因,比如服务器性能不足、带宽有限等,无法承受过多的爬虫访问。

通过robots.txt文件,网站管理员可以限制搜索引擎爬虫的抓取频率和深度,避免对网站造成过大的负担,保证网站的正常运行。

另外,Robot协议也可以帮助网站管理员指导搜索引擎爬虫更有效地抓取网站的内容。

通过robots.txt文件,网站管理员可以指定哪些页面是重要的,哪些页面是不重要的,以及抓取的优先级等信息。

这样可以帮助搜索引擎爬虫更有效地抓取网站的内容,提高网站在搜索引擎中的排名。

总的来说,Robot协议在互联网的发展中起到了非常重要的作用。

它不仅可以保护网站的隐私和安全,还可以控制搜索引擎爬虫的抓取行为,避免对网站造成过大的负担,同时还可以帮助网站在搜索引擎中更好地展现自己的内容。

因此,作为一名网站管理员,我们应该充分了解Robot协议的相关知识,合理地配置robots.txt 文件,以保证网站的正常运行和良好的搜索引擎排名。

总结一下,Robot协议是一种非常重要的协议,它可以帮助网站管理员保护网站的隐私和安全,控制搜索引擎爬虫的抓取行为,以及帮助网站更好地展现自己的内容。

什么是robots

亿推英文新闻稿,亿推英文软文,英文新闻稿推广,亿推英文软文写手,英文软文代写,亿推英文软文推广,英文推广,亿推发1000个英文新闻站,亿推标准化英文推广,TuiGuang123 亿推有超过1200个英文文章数据库平台合作站,超过60人欧洲美洲本土英文软文写手团队,超过20人英语法语专业软文团队,超过1600位外贸企业用户信赖亿推营销团队。

这是伟大的时候,搜索引擎经常访问你的站点和索引你的内容,但往往在有些情况下,当索引部分,你的线上内容是不是你想要的。

举例来说,如果你有两个版本的网页(一个用于观景,在浏览器和一个用于打印),你都宁愿有印刷版排除在爬行,否则,你就有可能被强加的重复内容的刑罚。

另外,如果你恰好有机密资料对你的站点说,你不想让世界看到的,你也会喜欢,搜索引擎不要索引这些页面(虽然在这种情况下,唯一可靠的途径不是索引敏感的数据,是保持离线对一个单独的机器)。

此外,如果您想节省一些带宽所不计形象,样式和JavaScript从索引中,你也需要有一个方式告诉蜘蛛,远离了这些项目。

其中一个方法告诉搜索引擎哪些文件和文件夹上你的网站,以避免是与使用robotMetaTags。

但由于并非所有的搜索引擎阅读MetaTags,机robotMetaTags可以简单地被忽视。

更好的方式来告知搜索引擎对您将是使用robots.txt文件。

什么是robots.txt的?robots.txt的是一个文字(而不是HTML)的档案,你把你的网站告诉搜索机器人哪些页面,你想他们不要访问。

robots.txt的绝不是强制性的搜索引擎,但一般来说,搜索引擎服从什么却要求他们不要做。

这是必须澄清的robots.txt是没有办法阻止搜索引擎从抓取你的网站(即它不是一个防火墙,或者说是一种密码保护)和事实,即你把robots.txt文件是一样的东西再一次说明:"拜托,不要输入",对一个没有上锁的门-例如,你不能防止窃贼进入,但好人不会公开进行盘查,并进入。

robots.txt文件的作用和语法介绍

robots.txt文件的作用和语法介绍1、什么是robots.txt文件搜索引擎有自己的搜索习惯,当它对一个网站进行搜索时,哪些目录和文件要看,哪些不用看,它有自己的算法。

我们也可以自己建立一个robots.txt文件,告诉搜索引擎的机器人哪些可以被收录,哪些不需要收录。

这样可以节约自己网站的资源,提高被搜索引擎收录的效率。

2、robots.txt放置位置robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

3、robots相关语法1)User-agent: 适用下列规则的漫游器(搜索引擎)该项的值用于描述搜索引擎robot的名字。

在robots.txt文件中,如果有多条User-agent 记录,就说明有多个robot会受到robots.txt的限制,对该文件来说,至少要有一条User-agent 记录。

如果该项的值设为*,则对任何robot均有效。

●Google爬虫名称: Googlebot●百度(Baidu)爬虫名称:Baiduspider●雅虎(Yahoo)爬虫名称:Yahoo Slurp●有道(Yodao)蜘蛛名称:YodaoBot●搜狗(sogou)蜘蛛名称:sogou spider●MSN的蜘蛛名称(微软最新搜索引擎Bing蜘蛛名也是这个):Msnbot2)Disallow: 拒绝访问的目录或文件该项的值用于描述不希望被访问的一组URL,这个值可以是一条完整的路径,也可以是路径的非空前缀,以Disallow项的值开头的URL不会被robot访问。

例如:Disallow:/seo.html 表示禁止robot访问文件/seo.html3)Allow:允许访问的目录或文件该项的值用于描述希望被访问的一组URL,与Disallow项相似,这个值可以是一条完整的路径,也可以是路径的前缀,以Allow项的值开头的URL是允许robot访问的。

例如:Allow:/hibaidu/ 表示允许robot访问目录/hibaidu/4)使用通配符"*"和"$":$ 匹配行结束符。

网站robots.txt文件如何生成

载验证文件就可以下载了.下载之后把文件放到

网站的根目录下. 当前面步骤操作完成后,回到站长平台点验

只好收下提回家去。出门时她还一个劲地嘱咐我老公:小舅舅

收录得出的结论,s一个其它的,反正会更好,感谢您关注,如果

觉得可以,请在上方点赞,同时想了解其它的网

络可关注.

2db0f0c9b

同事记在同一个文件里,

这时可以看到下方的"robots.txt 内容"就 会出现相关内容.如果确认自己所有页面添加完 成,就点"下载",然后再把该文件上传的根目录

只好收下提回家去。出门时她还一个劲地嘱咐我老公:小舅舅

下就可以了. robots.txt 文件可以用手写的,但是有些网 页太多了,手写麻烦而已,这可以看各人意愿啦. 就介绍到这里.希望你能成功.ts.txt 文件,那么下面 来写一下 robots.txt 文件怎么做吧.准备: 首先准备好 urllist.txt 文件,至于这个文 件去哪弄呢您可以到 xml-sitemapst 处去生成.在 xml-sitemaps 这个生成网页地图时会有一个 urllist.txt 文件, 下载下来.这个文件的好处是因为在线地图已经

证,成功后,双击网址 选择左手边的网站分析下的 Robots 选择"生成 robots.txt"处,然后 User-agent 按自己意愿选择,状态也是,如果您是允许就选 择允许,如果是不允许就选择不允许, 在路容.粘贴到路径框里,格式 都是/类型的.后缀不强烈要求的.再点"创建", 就会在上面记录一条信息,可以把允许与不允许

robotframework对文件的基本操作

robotframework对文件的基本操作摘要:1.介绍Robot Framework2.文件操作的基本概念3.Robot Framework 中的文件操作方法4.示例:使用Robot Framework 进行文件操作5.总结正文:1.介绍Robot FrameworkRobot Framework 是一个用于自动化测试、验证和执行的Python 库。

它提供了一个易于使用的语法,使得开发人员和测试人员可以快速创建自动化脚本。

在Robot Framework 中,我们可以使用不同的库和方法来对文件进行操作。

2.文件操作的基本概念在Robot Framework 中,文件操作是指对文件进行读取、写入、删除等操作。

文件操作是自动化测试中常见的场景,例如,我们需要在测试过程中创建、修改或删除文件。

3.Robot Framework 中的文件操作方法Robot Framework 提供了一系列内置的库,用于处理文件操作。

以下是一些常用的库和方法:- `File`: 这个库提供了一些基本的文件操作方法,例如`open file`、`closefile`、`read file`和`write file`。

- `Filesystem`: 这个库提供了一些高级的文件操作方法,例如`get file size`、`get file content`和`delete file`。

- `Process`: 这个库可以用于执行外部命令,例如在命令行中对文件进行操作。

4.示例:使用Robot Framework 进行文件操作下面是一个简单的示例,展示了如何在Robot Framework 中创建、读取和删除文件:```python*** Settings ***Library File*** Test Cases ***Create FileOpen File output.txt For WritingWrite File This is a test file.Close FileRead FileOpen File output.txt For ReadingRead File And Save Contents output_contents.txtClose FileDelete FileOpen File output.txt For ReadingDelete File```在这个示例中,我们首先创建了一个名为`output.txt`的文件,并向其中写入一些内容。

robots介绍

其中

<META NAME=”ROBOTS” CONTENT=”INDEX,FOLLOW”>

可以写成<META NAME=”ROBOTS” CONTENT=”ALL”>;

<META NAME=”ROBOTS” CONTENT=”NOINDEX,NOFOLLOW”>

网站中的程序脚本、样式表等文件即使被蜘蛛收录,也不会增加网站的收录率,还只会浪费服务器资源。因此必须在robots.txt文件里设置不要让搜索蜘蛛索引这些文件。具体哪些文件需要排除,在robots.txt使用技巧一文中有详细介绍。

误区三:搜索蜘蛛抓取网页太浪费服务器资源,在robots.txt文件设置所有的搜索蜘蛛都不能抓取全部的网页。

302 - 临时重定向,资源临时重定向

304 - 网页未更新

404 - 请求的网页不存在

503 - 服务器超时

500 503 都是服务器访问超时

如果出现了大量的

200 0 64 你的网站有被K的可能

"robots.txt"文件包含一条或更多的记录,这些记录通过空行分开(以CR,CR/NL, or NL作为结束符),每一条记录的格式如下所示:

2. 网站管理员必须使蜘蛛程序远离某些服务器上的目录——保证服务器性能。比如:大多数网站服务器都有程序储存在“cgi-bin”目录下,因此在robots.txt文件中加入“Disallow: /cgi-bin”是个好主意,这样能够避免将所有程序文件被蜘蛛索引,可以节省服务器资源。一般网站中不需要蜘蛛抓取的文件有:后台管理文件、程序脚本、附件、数据库文件、编码文件、样式表文件、模板文件、导航图片和背景图片等等。

robots文件怎么写?-robots文件的标准写法

robots是搜索引擎访问你网站的第一站!这是一个协议!当你网站有这个文件时就会遵循这个协议!哪些文件需要它收录,哪些URL不需要它收录!我们应该怎么写呢?首先,我们来了解robots文件的语法:1、User-agent 定义搜索引擎一般情况下,网站里面都是:User-agent: *,这里*的意思是所有,表示定义所有的搜索引擎。

比如,我想定义百度,那么就是User-agent: Baiduspider;定义google User-agent: Googlebot。

2、Disallow 禁止爬取如,我想禁止爬取我的admin文件夹,那就是Disallow: /admin。

禁止爬取admin文件夹下的login.html,Disallow: /admin/login.html。

3、Allow 允许我们都知道,在默认情况下,都是允许的。

那为什么还要允许这个语法呢?举个例子:我想禁止admin 文件夹下的所有文件,除了.html的网页,那怎么写呢?我们知道可以用Disallow一个一个禁止,但那样太费时间很精力了。

这时候运用Allow就解决了复杂的问题,就这样写:Allow: /admin/.html$Disallow: /admin。

4、$ 结束符例:Disallow: .php$ 这句话的意思是,屏蔽所有的以.php结尾的文件,不管前面有多长的URL,如abc/aa/bb//index.php也是屏蔽的。

5、* 通配符符号*表示0或多个任意字符。

例:Disallow: *?* 这里的意思是屏蔽所有带“?”文件,也是屏蔽所有的动态URL。

robots.txt文件写法举例说明禁止Google/百度等所有搜索引擎访问整个网站User-agent: *Disallow: /允许所有的搜索引擎spider访问整个网站(Disallow:可以用Allow: /替代)User-agent: *Disallow:禁止Baiduspider访问您的网站,Google等其他搜索引擎不阻止User-agent: BaiduspiderDisallow: /只允许Google spider:Googlebot访问您的网站,禁止百度等其他搜索引擎User-agent: GooglebotDisallow:User-agent: *Disallow: /禁止搜索引擎蜘蛛spider访问指定目录(spider不访问这几个目录。

robotframework对文件的基本操作

Robot Framework对文件的基本操作Robot Framework是一个开源的自动化测试框架,它提供了一种简单而强大的方式来编写和执行自动化测试脚本。

除了测试功能,Robot Framework还提供了对文件的基本操作,包括文件的创建、读取、写入和删除等操作。

本文将详细介绍如何使用Robot Framework对文件进行基本操作。

1. 创建文件要创建文件,可以使用Create File关键字。

以下是一个示例:*** Test Cases ***Create a FileCreate File path/to/file.txt上述示例中,Create File关键字将在指定路径下创建一个名为file.txt的文件。

如果路径不存在,则会自动创建。

如果文件已存在,则会被覆盖。

2. 读取文件要读取文件,可以使用Read File关键字。

以下是一个示例:*** Test Cases ***Read a File${content}= Read File path/to/file.txtLog ${content}上述示例中,Read File关键字将读取指定路径下的file.txt文件,并将其内容存储在${content}变量中。

然后,可以使用Log关键字将内容输出到日志中。

3. 写入文件要写入文件,可以使用Write File关键字。

以下是一个示例:*** Test Cases ***Write to a File${content}= Set Variable Hello, World!Write File path/to/file.txt ${content}上述示例中,Write File关键字将把${content}变量的内容写入到指定路径下的file.txt文件中。

如果文件不存在,则会自动创建。

4. 追加文件要追加文件内容,可以使用Append to File关键字。

以下是一个示例:*** Test Cases ***Append to a File${content}= Set Variable New contentAppend to File path/to/file.txt ${content}上述示例中,Append to File关键字将把${content}变量的内容追加到指定路径下的file.txt文件中。

ROBOT操作入门

ROBOT操作入门ROBOT操作入门简介ROBOT是一种自动化测试框架,可以帮助开发人员执行各种自动化任务。

它使用简单且易于理解的DSL(Domn-Specific Language)来描述测试用例的步骤和预期结果。

本文档将介绍ROBOT的基本概念和操作入门,帮助读者快速上手。

安装和配置在开始使用ROBOT之前,您需要先安装ROBOT框架。

ROBOT支持Windows、Linux和Mac操作系统,可以从官方网站()上安装包,并按照官方文档的指导进行安装。

安装完成后,您需要配置ROBOT的环境变量。

在Windows系统中,您可以将ROBOT的安装路径添加到系统的PATH变量中。

在Linux和Mac系统中,您可以将ROBOT的安装路径添加到.bashrc或者.profile文件中。

配置完成后,您可以在命令行中输入`robot --version`命令来验证ROBOT是否成功安装。

编写测试用例ROBOT使用.robot文件来编写测试用例。

每个.robot文件由多个测试用例组成,每个测试用例由关键字和参数组成。

下面是一个简单的测试用例示例:markdownTest Cases按钮[Documentation] 测试按钮功能[Tags] Regression输入用户名 admin输入密码 56登录按钮验证登录成功在上述示例中,` Test Cases `表示测试用例的开始,`按钮`表示这个测试用例的名称。

接下来是测试用例的详细步骤,每行一个关键字和参数。

可以看到,ROBOT的DSL语法非常简洁,易于理解和编写。

您可以根据实际需求,自定义关键字并在测试用例中调用。

运行测试用例编写完测试用例后,您可以使用ROBOT来运行这些测试用例。

在命令行中输入以下命令即可:robot path/to/testcase.robot其中,`path/to/testcase.robot`是您编写的测试用例文件的路径。

ROBOT会自动解析并执行这些测试用例,并测试报告。

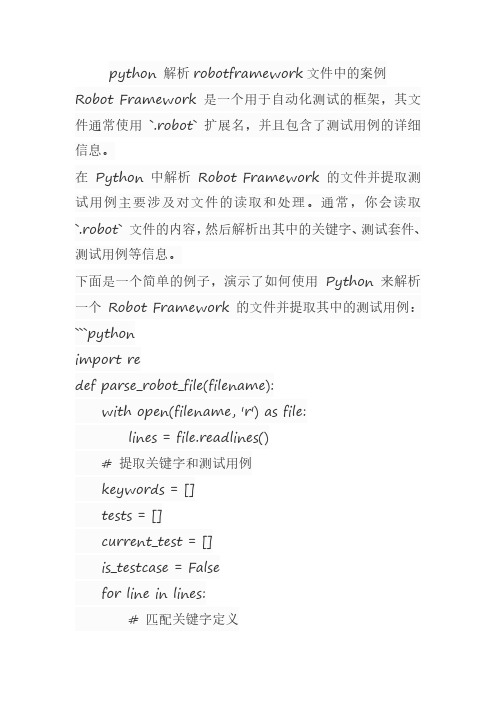

python 解析robotframework文件中的案例

python解析robotframework文件中的案例Robot Framework是一个用于自动化测试的框架,其文件通常使用`.robot`扩展名,并且包含了测试用例的详细信息。

在Python中解析Robot Framework的文件并提取测试用例主要涉及对文件的读取和处理。

通常,你会读取`.robot`文件的内容,然后解析出其中的关键字、测试套件、测试用例等信息。

下面是一个简单的例子,演示了如何使用Python来解析一个Robot Framework的文件并提取其中的测试用例:```pythonimport redef parse_robot_file(filename):with open(filename,'r')as file:lines=file.readlines()#提取关键字和测试用例keywords=[]tests=[]current_test=[]is_testcase=Falsefor line in lines:#匹配关键字定义keyword_match= re.match(r'^\s*Keyword\s+(\S+)\s*:',line)if keyword_match:keywords.append(keyword_match.group(1))#匹配测试用例定义elif re.match(r'^\s*Test\s*:',line):is_testcase=Trueelif re.match(r'^\s*${',line):#匹配变量定义,跳过变量行continueelif re.match(r'^\s*$',line):#匹配空行,跳过空行continueelif is_testcase:current_test.append(line.strip())if re.match(r'^\s*}$',line):#匹配测试用例结束标记tests.append(current_test)current_test=[]is_testcase=Falsereturn keywords,tests#使用示例:robot_file='path/to/your/testfile.robot'#替换为你的Robot Framework文件路径keywords,tests=parse_robot_file(robot_file) print("Keywords:",keywords)#输出关键字列表for test in tests:print("Test Case:")for line in test:print(line)#输出测试用例内容```这个例子使用了正则表达式来解析Robot Framework文件,提取关键字和测试用例。

robots文件的语法及用法

只允许Google的蜘蛛抓取;

User-agent: *

允许所有蜘蛛抓取。

注意:User-agent必须出现在第一行(有意义的行,注释除外),首先声明用户代理。

(2)Disallow:

指定禁止蜘蛛抓取的目录或文件,如:

Disallow: /help.php

noindex,nofollow可以写成none,如:

<meta name=”robots” content=”none” />

需要注意的是,robots Meta标签很多搜索引擎是不支持的,只有少数搜索引擎能够识别并按给定的值抓取。所以,尽可能的使用robots.txt文件来限制抓取。

最后,给大家一个建议,不要太刻意的在robots.txt中设置过多禁止文件或目录,只设置确实不希望被搜索引擎索引的目录和文件就可以了。

这就是前面说到的那两位朋友网站robots.txt的问题,他们用“Disallow: /”禁止了蜘蛛抓取根目录下的所有内容。

4、robots.txt需要注意的几个问题:

robots.txt文件中任意一行Disallow的值为空,其他指定的项都将失效,整站允许User-agent指定的蜘蛛抓取;robots.txt文件中允许使用注释,以“#”开头的内容被认作注释;但注释最好独立成一行,尽量不要加在参数后面,如“Disallow: /admin/ #manage dir”,某些蜘蛛可能将注释当作值的一部分。

# All robots will spider the domain

User-agent: *

Disallow:

以上文本表达的意思是允许所有的搜索机器人访问站点下的所有文件。

robots的用法详解

该项的值用来描述不希望被访问到的一个URL,这个地址可以是一条完整的路径,也可以是一部分。任何以disallow开头的URL都不会被robots访问到。例如:disallow:/admin 对admin.html和admin/index.html都不允许搜索引擎访问,而disallow:/admin/ 则会允许访问admin.html 而不能访问admin文件下所有的文件、任何一条disallow记录为空时,说明该网站的所有内容都允许被访问。在robots.txt文件中,至少要有一条disallow记录。如果robots.txt是一个空文件,则对于所有的搜索引擎蜘蛛,该网站都是开放的!

Disallow:

User-agent:*

Disallow:/

Ps4:禁止访问特定的3个目录。目录文件里面的文件不允许访问

User-agent:*

Disallow:/admin/

Disallow:/js/

Disallow:/img/

值得注意的是对每一个目录都必须分开声明,而不能罗列在一起。

user-agent

该项的值用于描述搜索引擎蜘蛛的名字。robots文件中,如果有多条user-agent记录的话,就表示有多个robots会受到该协议的限制。对于robots.txt至少要有一条user-agent记录。如果该项的值设为“*”,则该协议对任何robots都有效,在robots.txt文件中,user-agent:*这样的记录只能有一条。

值得一提的是robots.txt必须放在一个网站的根目录下,并且文件名称要全部小写。

那么如果你有些网页或者文件不想让蜘蛛访问,那该如何设置呢实现的呢?

首先要创建一个纯文本文件并命名为:robots.txt,在文件中声明网站中禁止蜘蛛访问的部分。把robots.txt文件放在网站根目录下。文件中可以使用“#”进行注释,文件中记录通常以一行或者多行user-agent开始,后面加上一些disallow行,详细情况如下:

robotframework对文件的基本操作

robotframework对文件的基本操作标题: Robot Framework对文件的基本操作摘要:Robot Framework是一个流行的自动化测试框架,广泛应用于软件开发领域。

在测试过程中,对于文件的处理是必不可少的。

本文将详细介绍Robot Framework中文件的基本操作,包括文件的创建、读取、写入、复制、移动和删除等功能,以及如何处理不同类型的文件。

第一部分:文件的创建和读取操作1. 创建新文件:- 使用BuiltIn库中的`Create File`关键字创建新的空文件。

- 使用OperatingSystem库中的`Call`关键字执行系统命令来创建新文件。

2. 读取文件内容:- 使用BuiltIn库中的`Get File`关键字获取文件的内容。

- 使用OperatingSystem库中的`Run`关键字执行系统命令来读取文件的内容。

第二部分:文件的写入和编辑操作1. 写入文件:- 使用BuiltIn库中的`Append To File`关键字向文件中追加内容。

- 使用BuiltIn库中的`Write To File`关键字覆盖文件的内容。

- 使用OperatingSystem库中的`Call`关键字执行系统命令来写入文件。

2. 编辑文件:- 使用OperatingSystem库中的`Call`关键字执行系统命令来编辑文件内容。

第三部分:文件的复制和移动操作1. 复制文件:- 使用OperatingSystem库中的`Copy File`关键字将文件复制到指定目录。

2. 移动文件:- 使用OperatingSystem库中的`Move File`关键字将文件移动到指定目录。

第四部分:文件的删除操作1. 删除文件:- 使用OperatingSystem库中的`Remove File`关键字删除指定文件。

2. 删除文件夹:- 使用OperatingSystem库中的`Remove Directory`关键字删除指定文件夹。

robotframework文件类型含义和用法

robotframework文件类型含义和用法Robot Framework 文件类型含义和用法引言在使用 Robot Framework 进行测试自动化时,文件类型扮演着重要的角色。

不同的文件类型具有不同的含义和用途,正确使用它们可以提高自动化测试的效率和可维护性。

本文将详细讲解一些常用的Robot Framework 文件类型及其用法。

1. 测试套件文件(Test Suite Files)测试套件文件是 Robot Framework 中最常见的文件类型,一般以.robot扩展名结尾。

它用于组织和管理测试用例,通常包含了多个测试用例,以及配置文件和全局变量的设置。

创建测试套件文件我们可以使用任何文本编辑器创建测试套件文件,并将其保存为.robot格式。

示例测试套件文件的基本结构如下:*** Settings ***Documentation 这是一个示例测试套件Library SeleniumLibrary*** Variables ***${URL}${BROWSER} Chrome*** Test Cases ***Example Test Case[Documentation] 这是一个示例测试用例Open Browser ${URL} ${BROWSER}Maximize Browser WindowClose Browser运行测试套件文件可以使用robot命令行工具来运行测试套件文件。

在命令行输入以下命令:robot path/to/test_2. 测试用例文件(Test Case Files)测试用例文件一般以.robot或.txt扩展名结尾,用于存储和管理单个测试用例。

它可以被测试套件文件引用,也可以独立运行。

创建测试用例文件使用文本编辑器创建测试用例文件,并将其保存为.robot或.txt格式。

示例测试用例文件的基本结构如下:*** Settings ***Documentation 这是一个示例测试用例Library SeleniumLibrary*** Variables ***${URL}${BROWSER} Chrome*** Test Cases ***Example Test Case[Documentation] 这是一个示例测试用例Open Browser ${URL} ${BROWSER}Maximize Browser WindowClose Browser运行测试用例文件与测试套件文件相似,使用robot命令行工具来运行测试用例文件。

robotframework对文件的基本操作

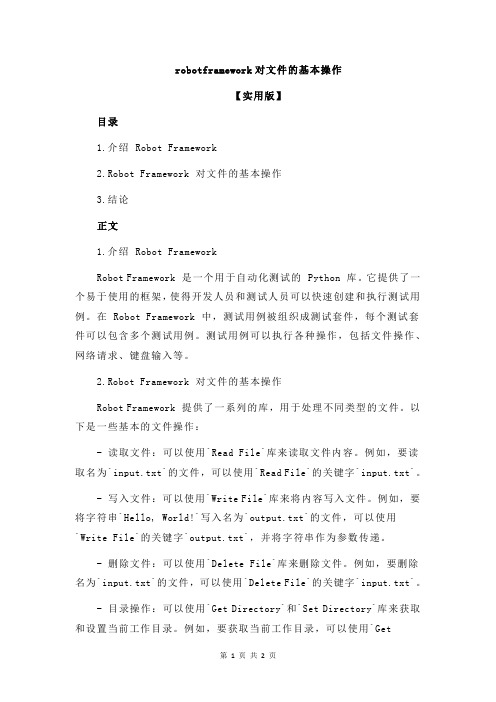

robotframework对文件的基本操作【实用版】目录1.介绍 Robot Framework2.Robot Framework 对文件的基本操作3.结论正文1.介绍 Robot FrameworkRobot Framework 是一个用于自动化测试的 Python 库。

它提供了一个易于使用的框架,使得开发人员和测试人员可以快速创建和执行测试用例。

在 Robot Framework 中,测试用例被组织成测试套件,每个测试套件可以包含多个测试用例。

测试用例可以执行各种操作,包括文件操作、网络请求、键盘输入等。

2.Robot Framework 对文件的基本操作Robot Framework 提供了一系列的库,用于处理不同类型的文件。

以下是一些基本的文件操作:- 读取文件:可以使用`Read File`库来读取文件内容。

例如,要读取名为`input.txt`的文件,可以使用`Read File`的关键字`input.txt`。

- 写入文件:可以使用`Write File`库来将内容写入文件。

例如,要将字符串`Hello, World!`写入名为`output.txt`的文件,可以使用`Write File`的关键字`output.txt`,并将字符串作为参数传递。

- 删除文件:可以使用`Delete File`库来删除文件。

例如,要删除名为`input.txt`的文件,可以使用`Delete File`的关键字`input.txt`。

- 目录操作:可以使用`Get Directory`和`Set Directory`库来获取和设置当前工作目录。

例如,要获取当前工作目录,可以使用`GetDirectory`的关键字。

要设置当前工作目录为`/path/to/directory`,可以使用`Set Directory`的关键字`/path/to/directory`。

- 文件夹操作:可以使用`Get Subdirs`和`Get Files`库来获取文件夹中的子目录和文件。

urdf 整理格式 -回复

urdf 整理格式-回复URDF是一种用于描述机器人的文件格式,它被广泛用于机器人仿真、视觉感知和运动规划等领域。

本文将深入探讨URDF文件的基本结构和常用元素,并介绍如何使用URDF创建各种机器人模型。

[URDF文件结构]URDF文件是一个XML格式的文本文件,通过标签描述机器人的各个部分和其属性。

一个典型的URDF文件包含以下几个主要部分:1. robot标签:用于定义机器人的整体结构。

2. link标签:用于描述机器人的连接部分,比如机械臂的关节。

3. joint标签:定义机器人连接部分的关节属性。

4. material标签:描述机器人的材料属性,比如颜色和纹理。

[创建URDF机器人模型]在使用URDF创建机器人模型时,我们需要按照以下步骤进行:1. 定义机器人的整体结构:首先我们需要在robot标签中定义机器人的名称和版本信息。

此外,我们还可以添加一些其他的全局属性,比如机器人的作者和模型文件的单位。

2. 描述机器人的连接部分:使用link标签描述机器人的各个连接部分。

每个link标签包含一个唯一的名称和可选的形状、材质等属性。

可以通过多个link标签来创建机器人的复杂结构。

3. 定义连接部分的关节属性:使用joint标签来描述连接部分之间的关节属性。

每个joint标签包含一个唯一的名称和关节类型(如旋转关节、固定关节等)。

通过定义连接部分的位置和旋转限制等属性,我们可以模拟机器人的运动范围。

4. 添加材料属性:在material标签中定义机器人的材料属性,比如颜色、纹理等。

可以将不同的材料属性应用于机器人的不同部分。

[URDF模型的应用]URDF模型在机器人仿真、视觉感知和运动规划等领域都有着广泛的应用。

以下是其中几个常见的应用场景:1. 机器人仿真:URDF文件可以被用于各种机器人仿真平台,如ROS的Gazebo仿真器。

通过将URDF文件导入仿真平台,我们可以模拟机器人的运动和操作,以便进行算法开发和性能评估。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Disallow: .jpeg$

Disallow: .png$

Disallow: .bmp$ 12. 仅禁止spider抓取.jpg格式图片

User-agent: spider Disallow:

5. 禁止spider访问特定目录

Disal仅允许抓取网页,禁止抓取任何 .jpg$

Disallow: .jpeg$

Disallow: .gif$

robots.txt文件用法举例:

1. 允许所有的robot访问

User-agent: * Allow: / 或者 User-agent: * Disallow:

2. 禁止所有搜索引擎访问网站的任何部分

User-agent: *

Disallow: /

robots.txt 格式

文件包含一条或更多的记录,这些记录通过空行分开(以CR,CR/NL, or NL作为结束符),每一条记录的格式如下所示:”:”。在该文件中可以使用#进行注解。该文件中的记录通常以一行或多行User-agent开始,后面加上若干Disallow和Allow行,详细情况如下。

什么是robots.txt?

搜索引擎使用spider程序自动访问互联网上的网页并获取网页信息。spider在访问一个网站时,会首先会检查该网站的根域下是否有一个叫做robots.txt的纯文本文件。您可以在您的网站中创建一个纯文本文件robots.txt,在文件中声明该网站中不想被robot访问的部分或者指定搜索引擎只收录特定的部分。

需要特别注意的是Disallow与Allow行的顺序是有意义的,robot会根据第一个匹配成功的 Allow或Disallow行确定是否访问某个”来模糊匹配url。 “$” 匹配行结束符。 “*” 匹配0或多个任意字符。

"Disallow:"说明允许robot访问该网站的所有url,在”/robots.txt”文件中,至少要有一条Disallow记录。如果”/robots.txt”不存在或者为空文件,则对于所有的搜索引擎robot,该网站都是开放的。

Allow:

该项的值用于描述希望被访问的一组URL,与Disallow项相似,这个值可以是一条完整的路径,也可以是路径的前缀,以Allow项的值开头的URL是允许rom.html。一个网站的所有URL默认是Allow的,所以Allow通常与Disallow搭配使用,实现允许访问一部分网页同时禁止访问其它所有URL的功能。

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

6. 允许访问特定目录中的部分url

User-agent: *

Allow: /cgi-bin/see

A望被搜索引擎收录的内容时,才需要使用robots.txt文件。如果您希望搜索引擎收录网站上所有内容,请勿建立robots.txt文件或者创建一个内容为空的robots.txt文件。

robots.txt 放置位置

robots.txt文件应该放置在网站根目录下。举例来说,当spider访问一个网站(比如)时,首先会检查该网站中是否存在/robots.txt这个文件,如果 Spider找到这个文件,它就会根据这个文件的内容,来确定它访问权限的范围。

Disallow: .png$

Disallo

允许抓取网页和gif格式图片,不允许抓取其他格if$

Disallow: .jpg$

Disallow: /cgi-bin/*.htm

8. 使用”$”限制访问url

仅允许访问以”.htm”为后缀的URL。

User-agent: *

Allow: .htm$

Disallow: /

例9. 禁止访问网站中所有的动态页面

User-agent: *

Allow: /~joe/look

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

7. 使用”*”限制访问url

禁止访问/cgi-bin/目录下的所有以”.htm”为后缀的URL(包含子目录)。

User-agent: *

User-agent:

该项的值用于描述搜索引擎robot的名字。在”robots.txt”文件中,如果有多条User-agent记录说明有多个robot会受到”robots.txt”的限制,对该文件来说,至少要有一条User-agent记录。 如果该项的值设为*,则对任何robot均有效,在”robots.txt”文件中,”User-agent:*”这样的记录只能有一条。如果在”robots.txt”文件中,加入”User- agent:SomeBot”和若干Disallow、Allow行,那么名为”SomeBot”只受到”User-agent:SomeBot”后面的 Disallow和Allow行的限制。 Disallow: 该项的值用于描述不希望被访问的一组URL,这个值可以是一条完整的路径,也可以是路径的非空前缀,以Disallow项的值开头的URL不会被robot访问。例 如”Disallow: /help”禁止robot访问/help*.html、/help/index.html, 而”Disallow: /help/”则允许robot访问/help*.html,不能访问/help/index.html。