BP神经网络实例含源码

BP神经网络步骤及应用实例

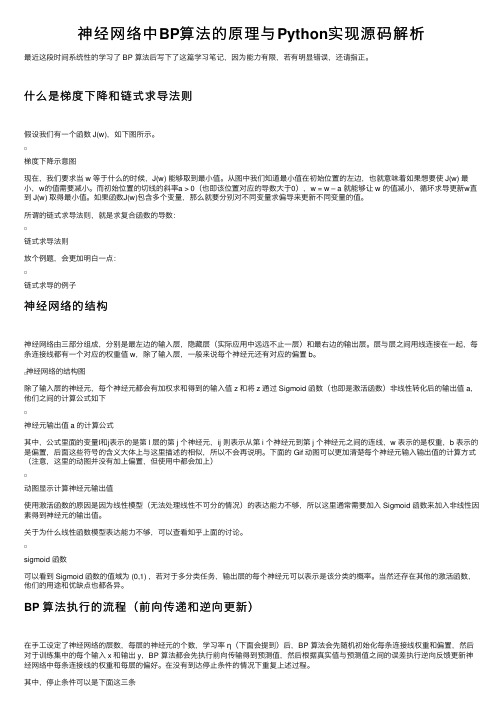

1、数据归一化2、数据分类,主要包括打乱数据顺序,抽取正常训练用数据、变量数据、测试数据3、建立神经网络,包括设置多少层网络(一般3层以内既可以,每层的节点数(具体节点数,尚无科学的模型和公式方法确定,可采用试凑法,但输出层的节点数应和需要输出的量个数相等),设置隐含层的传输函数等。

关于网络具体建立使用方法,在后几节的例子中将会说到。

4、指定训练参数进行训练,这步非常重要,在例子中,将详细进行说明5、完成训练后,就可以调用训练结果,输入测试数据,进行测试6、数据进行反归一化7、误差分析、结果预测或分类,作图等数据归一化问题归一化的意义:首先说一下,在工程应用领域中,应用BP网络的好坏最关键的仍然是输入特征选择和训练样本集的准备,若样本集代表性差、矛盾样本多、数据归一化存在问题,那么,使用多复杂的综合算法、多精致的网络结构,建立起来的模型预测效果不会多好。

若想取得实际有价值的应用效果,从最基础的数据整理工作做起吧,会少走弯路的。

归一化是为了加快训练网络的收敛性,具体做法是:1 把数变为(0,1)之间的小数主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

2 把有量纲表达式变为无量纲表达式归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量比如,复数阻抗可以归一化书写:Z = R + jωL = R(1 + jωL/R) ,复数部分变成了纯数量了,没有量纲。

另外,微波之中也就是电路分析、信号系统、电磁波传输等,有很多运算都可以如此处理,既保证了运算的便捷,又能凸现出物理量的本质含义。

神经网络归一化方法:由于采集的各数据单位不一致,因而须对数据进行[-1,1]归一化处理,归一化方法主要有如下几种,供大家参考:1、线性函数转换,表达式如下:复制内容到剪贴板代码:y=(x-MinVal ue)/(MaxVal ue-MinVal ue)说明:x、y分别为转换前、后的值,MaxVal ue、MinVal ue分别为样本的最大值和最小值。

bp神经网络实例分析

数据集划分

01

02

03

训练集

用于训练神经网络,占总 数据的70%-90%。

验证集

用于调整超参数和选择最 佳模型,占估模型的性能,占 总数据的10%-30%。

03

BP神经网络模型构建

神经元模型

神经元模型

神经元是神经网络的基本单元, 它模拟了生物神经元的基本功能,

误差计算

根据实际输出与期望输出计算误差。

权值调整

根据误差反向传播算法调整各层的权值和阈值。

迭代训练

重复前向传播和权值调整过程,直到达到预设的迭代次 数或误差要求。

02

BP神经网络实例选择与数据准备

实例选择

选择一个具有代表性的问题

为了展示BP神经网络的应用,选择一个具有代表性的问题,例如 分类、回归或聚类等。

成。

节点数量

02

每一层的节点数量需要根据具体问题来确定,过多的节点可能

导致过拟合,而节点过少则可能无法充分提取数据特征。

连接权重

03

连接权重是神经网络中非常重要的参数,它决定了神经元之间

的连接强度和信息传递方式。

激活函数选择

激活函数的作用

激活函数用于引入非线性特性,使得神经网络能够更好地处理复 杂的非线性问题。

误差反向传播

当实际输出与期望输出不符时,进入 误差反向传播阶段,误差信号从输出 层开始逐层向输入层传播,并根据误 差调整各层的权值和阈值。

训练过程

数据准备

准备训练数据和测试数据,并对数据进行预 处理,如归一化等。

网络初始化

为各层神经元设置初始权值和阈值。

前向传播

输入样本数据,通过正向传播计算每一层的输出 值。

3

BP算法代码实现

BP算法代码实现BP算法(Backpropagation Algorithm)是一种常用的神经网络训练算法,它主要用于监督式学习任务中的模型训练。

BP算法的核心思想是通过反向传播来更新神经网络的权重和偏差,以使得神经网络的输出逼近目标输出。

在反向传播的过程中,通过求解梯度来更新每个连接权重和偏置的值,从而最小化损失函数。

以下是BP算法的代码实现示例:```pythonimport numpy as npclass NeuralNetwork:def __init__(self, layers):yers = layersself.weights = []self.biases = []self.activations = []#初始化权重和偏置for i in range(1, len(layers)):self.weights.append(np.random.randn(layers[i], layers[i-1])) self.biases.append(np.random.randn(layers[i]))def sigmoid(self, z):return 1 / (1 + np.exp(-z))def sigmoid_derivative(self, z):return self.sigmoid(z) * (1 - self.sigmoid(z))def forward_propagate(self, X):self.activations = []activation = X#前向传播计算每一层的激活值for w, b in zip(self.weights, self.biases):z = np.dot(w, activation) + bactivation = self.sigmoid(z)self.activations.append(activation)return activationdef backward_propagate(self, X, y, output):deltas = [None] * len(yers)deltas[-1] = output - y#反向传播计算每一层的误差(梯度)for i in reversed(range(len(yers)-1)):delta = np.dot(self.weights[i].T, deltas[i+1]) * self.sigmoid_derivative(self.activations[i])deltas[i] = delta#更新权重和偏置for i in range(len(yers)-1):self.weights[i] -= 0.1 * np.dot(deltas[i+1],self.activations[i].T)self.biases[i] -= 0.1 * np.sum(deltas[i+1], axis=1)def train(self, X, y, epochs):for epoch in range(epochs):output = self.forward_propagate(X)self.backward_propagate(X, y, output)def predict(self, X):output = self.forward_propagate(X)return np.round(output)```上述代码使用numpy实现了一个简单的多层神经网络,支持任意层数和任意神经元个数的构建。

BP人工神经网络的基本原理模型与实例

BP人工神经网络的基本原理模型与实例BP(Back Propagation)人工神经网络是一种常见的人工神经网络模型,其基本原理是模拟人脑神经元之间的连接和信息传递过程,通过学习和调整权重,来实现输入和输出之间的映射关系。

BP神经网络模型基本上由三层神经元组成:输入层、隐藏层和输出层。

每个神经元都与下一层的所有神经元连接,并通过带有权重的连接传递信息。

BP神经网络的训练基于误差的反向传播,即首先通过前向传播计算输出值,然后通过计算输出误差来更新连接权重,最后通过反向传播调整隐藏层和输入层的权重。

具体来说,BP神经网络的训练过程包括以下步骤:1.初始化连接权重:随机初始化输入层与隐藏层、隐藏层与输出层之间的连接权重。

2.前向传播:将输入向量喂给输入层,通过带有权重的连接传递到隐藏层和输出层,计算得到输出值。

3.计算输出误差:将期望输出值与实际输出值进行比较,计算得到输出误差。

4.反向传播:从输出层开始,将输出误差逆向传播到隐藏层和输入层,根据误差的贡献程度,调整连接权重。

5.更新权重:根据反向传播得到的误差梯度,使用梯度下降法或其他优化算法更新连接权重。

6.重复步骤2-5直到达到停止条件,如达到最大迭代次数或误差小于一些阈值。

BP神经网络的训练过程是一个迭代的过程,通过不断调整连接权重,逐渐减小输出误差,使网络能够更好地拟合输入与输出之间的映射关系。

下面以一个简单的实例来说明BP神经网络的应用:假设我们要建立一个三层BP神经网络来预测房价,输入为房屋面积和房间数,输出为价格。

我们训练集中包含一些房屋信息和对应的价格。

1.初始化连接权重:随机初始化输入层与隐藏层、隐藏层与输出层之间的连接权重。

2.前向传播:将输入的房屋面积和房间数喂给输入层,通过带有权重的连接传递到隐藏层和输出层,计算得到价格的预测值。

3.计算输出误差:将预测的价格与实际价格进行比较,计算得到输出误差。

4.反向传播:从输出层开始,将输出误差逆向传播到隐藏层和输入层,根据误差的贡献程度,调整连接权重。

神经网络中BP算法的原理与Python实现源码解析

神经⽹络中BP算法的原理与Python实现源码解析最近这段时间系统性的学习了 BP 算法后写下了这篇学习笔记,因为能⼒有限,若有明显错误,还请指正。

什么是梯度下降和链式求导法则假设我们有⼀个函数 J(w),如下图所⽰。

梯度下降⽰意图现在,我们要求当 w 等于什么的时候,J(w) 能够取到最⼩值。

从图中我们知道最⼩值在初始位置的左边,也就意味着如果想要使 J(w) 最⼩,w的值需要减⼩。

⽽初始位置的切线的斜率a > 0(也即该位置对应的导数⼤于0),w = w – a 就能够让 w 的值减⼩,循环求导更新w直到 J(w) 取得最⼩值。

如果函数J(w)包含多个变量,那么就要分别对不同变量求偏导来更新不同变量的值。

所谓的链式求导法则,就是求复合函数的导数:链式求导法则放个例题,会更加明⽩⼀点:链式求导的例⼦神经⽹络的结构神经⽹络由三部分组成,分别是最左边的输⼊层,隐藏层(实际应⽤中远远不⽌⼀层)和最右边的输出层。

层与层之间⽤线连接在⼀起,每条连接线都有⼀个对应的权重值 w,除了输⼊层,⼀般来说每个神经元还有对应的偏置 b。

神经⽹络的结构图除了输⼊层的神经元,每个神经元都会有加权求和得到的输⼊值 z 和将 z 通过 Sigmoid 函数(也即是激活函数)⾮线性转化后的输出值 a,他们之间的计算公式如下神经元输出值 a 的计算公式其中,公式⾥⾯的变量l和j表⽰的是第 l 层的第 j 个神经元,ij 则表⽰从第 i 个神经元到第 j 个神经元之间的连线,w 表⽰的是权重,b 表⽰的是偏置,后⾯这些符号的含义⼤体上与这⾥描述的相似,所以不会再说明。

下⾯的 Gif 动图可以更加清楚每个神经元输⼊输出值的计算⽅式(注意,这⾥的动图并没有加上偏置,但使⽤中都会加上)动图显⽰计算神经元输出值使⽤激活函数的原因是因为线性模型(⽆法处理线性不可分的情况)的表达能⼒不够,所以这⾥通常需要加⼊ Sigmoid 函数来加⼊⾮线性因素得到神经元的输出值。

BP神经网络模型应用实例

BP神经网络模型第1节基本原理简介近年来全球性的神经网络研究热潮的再度兴起,不仅仅是因为神经科学本身取得了巨大的进展.更主要的原因在于发展新型计算机和人工智能新途径的迫切需要.迄今为止在需要人工智能解决的许多问题中,人脑远比计算机聪明的多,要开创具有智能的新一代计算机,就必须了解人脑,研究人脑神经网络系统信息处理的机制.另一方面,基于神经科学研究成果基础上发展出来的人工神经网络模型,反映了人脑功能的若干基本特性,开拓了神经网络用于计算机的新途径.它对传统的计算机结构和人工智能是一个有力的挑战,引起了各方面专家的极大关注.目前,已发展了几十种神经网络,例如Hopficld模型,Feldmann等的连接型网络模型,Hinton等的玻尔茨曼机模型,以及Rumelhart等的多层感知机模型和Kohonen的自组织网络模型等等。

在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。

多层感知机神经网络的研究始于50年代,但一直进展不大。

直到1985年,Rumelhart等人提出了误差反向传递学习算法(即BP算),实现了Minsky的多层网络设想,如图34-1所示。

BP 算法不仅有输入层节点、输出层节点,还可有1个或多个隐含层节点。

对于输入信号,要先向前传播到隐含层节点,经作用函数后,再把隐节点的输出信号传播到输出节点,最后给出输出结果。

节点的作用的激励函数通常选取S 型函数,如Qx e x f /11)(-+=式中Q 为调整激励函数形式的Sigmoid 参数。

该算法的学习过程由正向传播和反向传播组成。

在正向传播过程中,输入信息从输入层经隐含层逐层处理,并传向输出层。

每一层神经元的状态只影响下一层神经输入层 中间层 输出层 图34-1 BP 神经网络模型元的状态。

如果输出层得不到期望的输出,则转入反向传播,将误差信号沿原来的连接通道返回,通过修改各层神经元的权值,使得误差信号最小。

社含有n 个节点的任意网络,各节点之特性为Sigmoid 型。

神经网络BP算法源代码(C++)

(完整版)BP神经网络matlab实例(简单而经典)

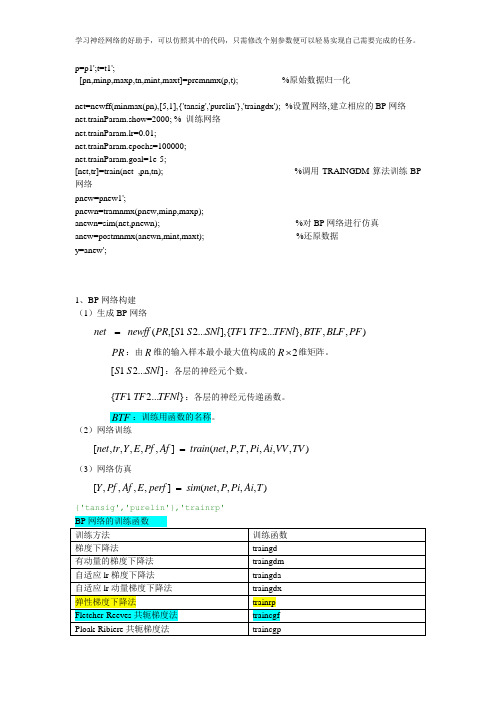

p=p1';t=t1';[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始数据归一化net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx');%设置网络,建立相应的BP网络net.trainParam.show=2000; % 训练网络net.trainParam.lr=0.01;net.trainParam.epochs=100000;net.trainParam.goal=1e-5;[net,tr]=train(net ,pn,tn); %调用TRAINGDM算法训练BP 网络pnew=pnew1';pnewn=tramnmx(pnew,minp,maxp);anewn=sim(net,pnewn); %对BP网络进行仿真anew=postmnmx(anewn,mint,maxt); %还原数据y=anew';1、BP网络构建(1)生成BP网络=net newff PR S S SNl TF TF TFNl BTF BLF PF(,[1 2...],{ 1 2...},,,)PR:由R维的输入样本最小最大值构成的2R⨯维矩阵。

S S SNl:各层的神经元个数。

[ 1 2...]{ 1 2...}TF TF TFNl:各层的神经元传递函数。

BTF:训练用函数的名称。

(2)网络训练[,,,,,] (,,,,,,)=net tr Y E Pf Af train net P T Pi Ai VV TV(3)网络仿真=[,,,,] (,,,,)Y Pf Af E perf sim net P Pi Ai T{'tansig','purelin'},'trainrp'2、BP网络举例举例1、%traingdclear;clc;P=[-1 -1 2 2 4;0 5 0 5 7];T=[-1 -1 1 1 -1];%利用minmax函数求输入样本范围net = newff(minmax(P),T,[5,1],{'tansig','purelin'},'trainrp');net.trainParam.show=50;%net.trainParam.lr=0.05;net.trainParam.epochs=300;net.trainParam.goal=1e-5;[net,tr]=train(net,P,T);net.iw{1,1}%隐层权值net.b{1}%隐层阈值net.lw{2,1}%输出层权值net.b{2}%输出层阈值sim(net,P)举例2、利用三层BP神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。

BP神经网络算法的C语言实现代码

BP神经网络算法的C语言实现代码以下是一个BP神经网络的C语言实现代码,代码的详细说明可以帮助理解代码逻辑:```c#include <stdio.h>#include <stdlib.h>#include <math.h>#define INPUT_SIZE 2#define HIDDEN_SIZE 2#define OUTPUT_SIZE 1#define LEARNING_RATE 0.1//定义神经网络结构体typedef structdouble input[INPUT_SIZE];double hidden[HIDDEN_SIZE];double output[OUTPUT_SIZE];double weights_ih[INPUT_SIZE][HIDDEN_SIZE];double weights_ho[HIDDEN_SIZE][OUTPUT_SIZE];} NeuralNetwork;//激活函数double sigmoid(double x)return 1 / (1 + exp(-x));//创建神经网络NeuralNetwork* create_neural_networNeuralNetwork* nn =(NeuralNetwork*)malloc(sizeof(NeuralNetwork));//初始化权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}return nn;//前向传播void forward(NeuralNetwork* nn)//计算隐藏层输出for (int i = 0; i < HIDDEN_SIZE; i++)double sum = 0;for (int j = 0; j < INPUT_SIZE; j++)sum += nn->input[j] * nn->weights_ih[j][i];}nn->hidden[i] = sigmoid(sum);}//计算输出层输出for (int i = 0; i < OUTPUT_SIZE; i++)double sum = 0;for (int j = 0; j < HIDDEN_SIZE; j++)sum += nn->hidden[j] * nn->weights_ho[j][i];}nn->output[i] = sigmoid(sum);}void backpropagation(NeuralNetwork* nn, double target)//计算输出层误差double output_error[OUTPUT_SIZE];for (int i = 0; i < OUTPUT_SIZE; i++)double delta = target - nn->output[i];output_error[i] = nn->output[i] * (1 - nn->output[i]) * delta;}//更新隐藏层到输出层权重for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] += LEARNING_RATE * nn->hidden[i] * output_error[j];}}//计算隐藏层误差double hidden_error[HIDDEN_SIZE];for (int i = 0; i < HIDDEN_SIZE; i++)double delta = 0;for (int j = 0; j < OUTPUT_SIZE; j++)delta += output_error[j] * nn->weights_ho[i][j];}hidden_error[i] = nn->hidden[i] * (1 - nn->hidden[i]) * delta;}//更新输入层到隐藏层权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] += LEARNING_RATE * nn->input[i] * hidden_error[j];}}void train(NeuralNetwork* nn, double input[][2], double target[], int num_examples)int iteration = 0;while (iteration < MAX_ITERATIONS)double error = 0;for (int i = 0; i < num_examples; i++)for (int j = 0; j < INPUT_SIZE; j++)nn->input[j] = input[i][j];}forward(nn);backpropagation(nn, target[i]);error += fabs(target[i] - nn->output[0]);}//判断误差是否已达到允许范围if (error < 0.01)break;}iteration++;}if (iteration == MAX_ITERATIONS)printf("Training failed! Error: %.8lf\n", error); }void predict(NeuralNetwork* nn, double input[]) for (int i = 0; i < INPUT_SIZE; i++)nn->input[i] = input[i];}forward(nn);printf("Prediction: %.8lf\n", nn->output[0]); int maiNeuralNetwork* nn = create_neural_network(; double input[4][2] ={0,0},{0,1},{1,0},{1,1}};double target[4] =0,1,1,};train(nn, input, target, 4);predict(nn, input[0]);predict(nn, input[1]);predict(nn, input[2]);predict(nn, input[3]);free(nn);return 0;```以上代码实现了一个简单的BP神经网络,该神经网络包含一个输入层、一个隐藏层和一个输出层。

BP神经网络模型及实例

(1)由动量的梯度下降法

在神经网络工具箱中, traingdm函数采用了由动量的梯度下降法,提高 了学习速度并增加了算法的可靠性。

x x1, x2,

hi hi1, hi2,

ho ho1, ho2,

yi yi1, yi2,

yo yo1, yo2,

do d1, d2,

, xn

, hip

, hop

, yiq

, yoq

, dq

2.4.2 BP网络的标准学习算法

– 输入层与中间层的连接权值:

wih

– 隐含层与输出层的连接权值:

2.4.1 BP神经网络模型

• 三层BP网络

2.4.1 BP神经网络模型

• 激活函数

– 必须处处可导

• 一般都使用S型函数

• 使用S型激活函数时BP网络输入与输出关 系

– 输入 net x1w1 x2w2 ... xnwn

– 输出

y

f

(net)

1

1 enet

2.4.1 BP神经网络模型

2.4 BP神经网络模型与学习算法

概述

• Rumelhart,McClelland于1985年提出了BP网络的误差 反向后传BP(Back Propagation)学习算法

David Rumelhart

J. McClelland

• BP算法基本原理

– 利用输出后的误差来估计输出层的直接前导层的误差,再用这个 误差估计更前一层的误差,如此一层一层的反传下去,就获得了 所有其他各层的误差估计。

BP神经网络的设计实例(MATLAB编程)

神经网络的设计实例(MATLAB编程)例1 采用动量梯度下降算法训练BP 网络。

训练样本定义如下:输入矢量为p =[-1 -2 3 1-1 1 5 -3]目标矢量为t = [-1 -1 1 1]解:本例的MATLAB 程序如下:close allclearecho onclc% NEWFF——生成一个新的前向神经网络% TRAIN——对BP 神经网络进行训练% SIM——对BP 神经网络进行仿真pause% 敲任意键开始clc% 定义训练样本P=[-1, -2, 3, 1; -1, 1, 5, -3]; % P 为输入矢量T=[-1, -1, 1, 1]; % T 为目标矢量pause;clc% 创建一个新的前向神经网络net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值inputWeights=net.IW{1,1}inputbias=net.b{1}% 当前网络层权值和阈值layerWeights=net.LW{2,1}layerbias=net.b{2}pauseclc% 设置训练参数net.trainParam.show = 50;net.trainParam.lr = 0.05;net.trainParam.mc = 0.9;net.trainParam.epochs = 1000;net.trainParam.goal = 1e-3;pauseclc% 调用TRAINGDM 算法训练BP 网络[net,tr]=train(net,P,T);pauseclc% 对BP 网络进行仿真A = sim(net,P)% 计算仿真误差E = T - AMSE=mse(E)pauseclcecho off例2 采用贝叶斯正则化算法提高BP 网络的推广能力。

在本例中,我们采用两种训练方法,即L-M 优化算法(trainlm)和贝叶斯正则化算法(trainbr),用以训练BP 网络,使其能够拟合某一附加有白噪声的正弦样本数据。

bp网络实例及vb代码

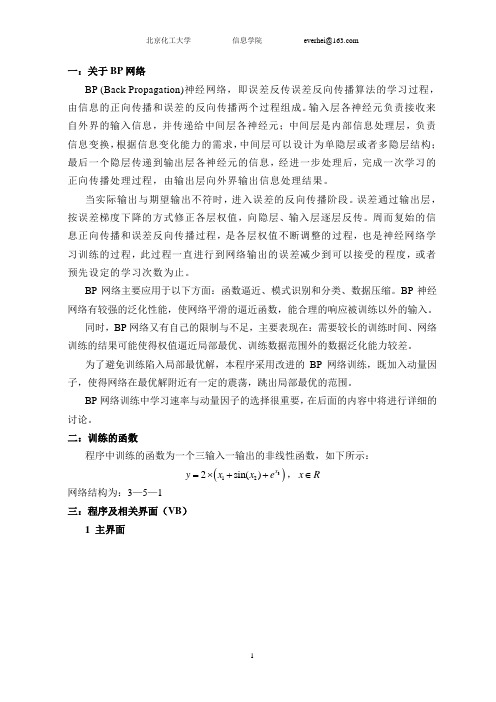

一:关于BP 网络BP (Back Propagation)神经网络,即误差反传误差反向传播算法的学习过程,由信息的正向传播和误差的反向传播两个过程组成。

输入层各神经元负责接收来自外界的输入信息,并传递给中间层各神经元;中间层是内部信息处理层,负责信息变换,根据信息变化能力的需求,中间层可以设计为单隐层或者多隐层结构;最后一个隐层传递到输出层各神经元的信息,经进一步处理后,完成一次学习的正向传播处理过程,由输出层向外界输出信息处理结果。

当实际输出与期望输出不符时,进入误差的反向传播阶段。

误差通过输出层,按误差梯度下降的方式修正各层权值,向隐层、输入层逐层反传。

周而复始的信息正向传播和误差反向传播过程,是各层权值不断调整的过程,也是神经网络学习训练的过程,此过程一直进行到网络输出的误差减少到可以接受的程度,或者预先设定的学习次数为止。

BP 网络主要应用于以下方面:函数逼近、模式识别和分类、数据压缩。

BP 神经网络有较强的泛化性能,使网络平滑的逼近函数,能合理的响应被训练以外的输入。

同时,BP 网络又有自己的限制与不足,主要表现在:需要较长的训练时间、网络训练的结果可能使得权值逼近局部最优、训练数据范围外的数据泛化能力较差。

为了避免训练陷入局部最优解,本程序采用改进的BP 网络训练,既加入动量因子,使得网络在最优解附近有一定的震荡,跳出局部最优的范围。

BP 网络训练中学习速率与动量因子的选择很重要,在后面的内容中将进行详细的讨论。

二:训练的函数程序中训练的函数为一个三输入一输出的非线性函数,如下所示:()3122sin()x y x x e =⨯++,x R ∈网络结构为:3—5—1三:程序及相关界面(VB )1 主界面代码:Private Sub Command1_Click() form2.Visible = FalseForm3.Visible = TrueEnd SubPrivate Sub Command2_Click() form2.Visible = FalseForm1.Visible = TrueEnd SubPrivate Sub Command3_Click() form2.Visible = FalseForm4.Visible = TrueEnd SubPrivate Sub Command4_Click() form2.Visible = FalseForm5.Visible = TrueEnd SubPrivate Sub Command5_Click() EndEnd SubPrivate Sub Form_Load() Command3.Enabled = False Command4.Enabled = False End Sub2 查看网络结构代码:Private Sub Command1_Click() Form3.Visible = Falseform2.Visible = TrueEnd Sub3 网络训练代码:Private Sub Command1_Click()Form1.Visible = Falseform2.Visible = TrueEnd SubPrivate Sub Command2_Click()Label2.Caption = "样本训练中…"Dim i As Integer, j As Integer, k As Integer, p As Integer, s As SingleDim Maxx(1 To 3) As Single, Minx(1 To 3) As Single, Meanx(1 To 3) As SingleDim x(1 To 3, 1 To 100) As Single, sumx(1 To 3) As Single, Temp As SingleDim Datex(1 To 3, 1 To 100) As Single, inputx(1 To 3) As Single, outputx(1 To 100) As Single Dim Ex(1 To 100) As SingleDim time(1 To 5000) As Integer, cishu(1 To 100) As IntegerDim Dv_1(1 To 5, 1 To 3) As Single, Dw_1(1 To 5) As SingleDim R As SingleDim Maxd As Single, Mind As SingleDim s1(1 To 5) As Single, y1(1 To 5, 1 To 100) As Single, s2 As Single, y2(1 To 100) As Single Dim deltW(1 To 100) As Single, deltV(1 To 5, 1 To 100) As SingleDim Dw(1 To 5) As Single, Dv(1 To 5, 1 To 3) As SingleDim MyIn(1 To 3) As SingleDim Errorx(1 To 5000) As SingleRandomizeFor i = 1 To 3Maxx(i) = 0Minx(i) = 0Meanx(i) = 0Next iTemp = 0Maxd = 0Mind = 0For i = 1 To 5For j = 1 To 3Dv_1(i, j) = 0v(i, j) = 2 * Rnd - 1Next jDw_1(i) = 0w(i) = 2 * Rnd - 1Next iFor j = 1 To 3For i = 1 To 100x(j, i) = 4 * (2 * Rnd - 1)Next isumx(j) = 0Next j'求最值For j = 1 To 3For i = 1 To 100If x(j, i) >= Maxx(j) ThenMaxx(j) = x(j, i)End IfIf x(j, i) <= Minx(j) ThenMinx(j) = x(j, i)Temp = Temp + x(j, i)End IfNext isumx(j) = TempTemp = 0Meanx(j) = sumx(j) / 100Next j'归一化For j = 1 To 3For i = 1 To 100If Maxx(j) - x(j, i) >= x(j, i) - Minx(j) ThenR = Maxx(j) - x(j, i)ElseR = x(j, i) - Minx(j)End IfDatex(j, i) = (x(j, i) - Meanx(j)) / RNext iNext j'期望输出For i = 1 To 100For j = 1 To 3inputx(j) = Datex(j, i)Next joutputx(i) = 2 * (inputx(1) + Sin(inputx(2)) + Exp(inputx(3))) Next i'输出归一化For i = 1 To 100If Maxd <= outputx(i) ThenMaxd = outputx(i)End IfIf Mind >= outputx(i) ThenMind = outputx(i)End IfNext iFor i = 1 To 100Ex(i) = (outputx(i) - Mind) / (Maxd - Mind)Next i'训练For s = 1 To 5000 Step 1time(s) = sFor p = 1 To 100cishu(p) = pFor i = 1 To 3MyIn(i) = Datex(i, p)Next iFor i = 1 To 5For j = 1 To 3Temp = Temp + v(i, j) * MyIn(j)Next js1(i) = TempTemp = 0Next iFor i = 1 To 5y1(i, p) = 1 / (1 + Exp(-s1(i)))Next iFor i = 1 To 3Temp = y1(i, p) * w(i) + TempNext is2 = TempTemp = 0y2(p) = 1 / (1 + Exp(-s2))deltW(p) = (Ex(p) - y2(p)) * y2(p) * (1 - y2(p))For i = 1 To 5deltV(i, p) = deltW(p) * w(i) * y1(i, p) * (1 - y1(i, p))Next iNext p'误差For i = 1 To 100Temp = Temp + (Ex(i) - y2(i)) ^ 2Next iErrorx(s) = TempTemp = 0'调整权值For i = 1 To 5Dw_1(i) = Dw(i)Next iFor i = 1 To 5For j = 1 To 100Temp = Temp + deltW(j) * y1(i, j)Next jDw(i) = TempTemp = 0Next iFor i = 1 To 5For j = 1 To 3Dv_1(i, j) = Dv(i, j)Next jNext iFor i = 1 To 5For j = 1 To 3For k = 1 To 100Temp = Temp + deltV(i, k) * Datex(j, k)Next kDv(i, j) = TempTemp = 0Next jNext iFor i = 1 To 5w(i) = 0.2 * Dw(i) + 0.2 * Dw_1(i) + w(i)Next iFor i = 1 To 3For j = 1 To 5v(j, i) = 0.2 * Dv(j, i) + 0.2 * Dv_1(j, i) + v(j, i)Next jNext i'画图Picture1.ClsPicture1.ScaleTop = 1.5Picture1.ScaleHeight = -2Picture1.ScaleLeft = -10Picture1.ScaleWidth = 120Picture1.Line (-9, 0)-(110, 0)Picture1.Line (0, 0)-(0, 1.5)For i = 1 To 100Picture1.PSet (cishu(i), Ex(i)), RGB(128, 128, 0)Picture1.PSet (cishu(i), y2(i)), RGB(128, 0, 0)Next iFor i = 1 To 99Picture1.Line (cishu(i), Ex(i))-(cishu(i + 1), Ex(i + 1)), RGB(128, 128, 0)Picture1.Line (cishu(i), y2(i))-(cishu(i + 1), y2(i + 1)), RGB(128, 0, 0)Next i'延时For j = 1 To 1000For k = 1 To 50Next kNext jPicture2.ClsPicture2.Print sDoEventsNext sLabel2.Caption = ""mand3.Enabled = Truemand4.Enabled = True'泛化Dim test(1 To 3, 1 To 20) As Single, sumE(1 To 3) As SingleDim MaxE(1 To 3) As Single, MinE(1 To 3) As Single, MeanE(1 To 3) As SingleDim MaxxE As Single, MinxE As SingleDim des(1 To 3) As Single, outE(1 To 20) As SingleDim MIn(1 To 3) As Single, s11(1 To 5) As Single, y11(1 To 5, 1 To 20) As Single, s22 As Single Dim DateE(1 To 3, 1 To 20) As SingleFor i = 1 To 20For j = 1 To 3test(j, i) = 4 * (2 * Rnd - 1)Next jNext iFor j = 1 To 3For i = 1 To 20If test(j, i) >= MaxE(j) ThenMaxE(j) = test(j, i)End IfIf test(j, i) <= MinE(j) ThenMinE(j) = test(j, i)Temp = Temp + test(j, i)End IfNext isumE(j) = TempTemp = 0MeanE(j) = sumE(j) / 100Next j'归一化For j = 1 To 3For i = 1 To 20If MaxE(j) - test(j, i) >= test(j, i) - MinE(j) ThenR = MaxE(j) - test(j, i)ElseR = test(j, i) - MinE(j)End IfDateE(j, i) = (test(j, i) - MeanE(j)) / RNext iNext j'求输出For p = 1 To 20Ti(p) = pFor i = 1 To 3MIn(i) = DateE(i, p)Next iFor i = 1 To 5For j = 1 To 3Temp = Temp + v(i, j) * MIn(j)Next js11(i) = TempTemp = 0Next iFor i = 1 To 5y11(i, p) = 1 / (1 + Exp(-s11(i)))Next iFor i = 1 To 3Temp = y11(i, p) * w(i) + TempNext is22 = TempTemp = 0y22(p) = 1 / (1 + Exp(-s22))Next p'输出及归一化For j = 1 To 20For i = 1 To 3des(i) = DateE(i, j)Next ioutE(j) = 2 * (des(1) + Sin(des(2)) + Exp(des(3))) Next j'输出归一化For i = 1 To 20If MaxxE <= outE(i) ThenMaxxE = outE(i)End IfIf MinxE >= outE(i) ThenMinxE = outE(i)End IfNext iFor i = 1 To 20outD(i) = (outE(i) - MinxE) / (MaxxE - MinxE) Next iEnd Sub4 查看训练结果代码:Private Sub Command1_Click()Form5.Visible = Falseform2.Visible = TrueEnd SubPrivate Sub Command2_Click()Picture1.ClsPicture2.ClsDim i As Integer, j As IntegerFor i = 1 To 5For j = 1 To 3Picture2.Print v(i, j); Spc(4);Next jPicture2.PrintPicture2.PrintPicture1.Print w(i);Next iEnd Sub5 泛化代码:Private Sub Command1_Click()Form4.Visible = Falseform2.Visible = TrueEnd SubPrivate Sub Command2_Click()For s = 1 To 20'Picture1.ClsPicture1.ScaleTop = 1.5Picture1.ScaleHeight = -2Picture1.ScaleLeft = -5Picture1.ScaleWidth = 30Picture1.Line (-5, 0)-(25, 0)Picture1.Line (0, -0.5)-(0, 1.5)For i = 1 To 20Picture1.PSet (Ti(i), outD(i)), RGB(128, 128, 0)Picture1.PSet (Ti(i), y22(i)), RGB(128, 0, 0)Next iFor i = 1 To 19Picture1.Line (Ti(i), outD(i))-(Ti(i + 1), outD(i + 1)), RGB(128, 128, 0)Picture1.Line (Ti(i), y22(i))-(Ti(i + 1), y22(i + 1)), RGB(128, 0, 0)Next iNext sEnd Sub6 全局模块Public w(1 To 5) As Single, v(1 To 5, 1 To 3) As SinglePublic Ti(1 To 20) As Single, y22(1 To 20) As Single, outD(1 To 20) As Single四:相关分析及讨论以上编程实现了对一个三输入、一输出非线性函数的逼近,在模型训练中采用改进的BP网络——动量因子法,输入是随机产生的100组数据,输出是通过已知函数得到的相应期望输出,通过BP网络的5000代训练可以与期望输出拟合的很好,泛化也较理想,训练误差和泛化误差都在可接受范围内。

BP神经网络详细代码

运用BP神经网络进行预测代码如下:clcclear allclose all%bp神经网络预测%输入输出赋值p=[493 372 445;372 445 176;445 176 235;176 235 378;235 378 429;378 429 561;429 561 651;561 651 467;651 467 527;467 527 668;527 668 841; 668 841 526;841 526 480;526 480 567;480 567 685]';t=[176 235 378 429 561 651 467 527 668 841 526 480 567 685 507];%数据归一化[p1ps]=mapminmax(p);[t1ts]=mapminmax(t);%数据集分配[trainsample.pvalsample.ptestsample.p] =dividerand(p0.70.150.15);[alsample.ttestsample.t] =dividerand(t0.70.150.15);%建立BP神经网络TF1='tansig';TF2='purelin';net=newff(minmax(p)[101]{TF1 TF2}'traingdm');%网络参数的设置net.trainParam.epochs=10000;%训练次数设置net.trainParam.goal=1e-7;%训练目标设置net.trainParam.lr=0.01;%学习率设置net.trainParam.mc=0.9;%动量因子的设置net.trainParam.show=25;%显示的间隔次数% 指定训练参数net.trainFcn='trainlm';[nettr]=train(nettrainsample.ptrainsample.t);%计算仿真[normtrainoutputtrainPerf]=sim(nettrainsample.p[][]trainsample.t);%训练数据,经BP得到的结果[normvalidateoutputvalidatePerf]=sim(netvalsample.p[][]valsample.t);%验证数据,经BP得到的结果[normtestoutputtestPerf]=sim(nettestsample.p[][]testsample.t);%测试数据,经BP得到的结果%计算结果反归一化,得到拟合数据trainoutput=mapminmax('reverse'normtrainoutputts);validateoutput=mapminmax('reverse'normvalidateoutputts);testoutput=mapminmax('reverse'normtestoutputts);%输入数据反归一化,得到正式值trainvalue=mapminmax('reverse'trainsample.tts);%正式的训练数据validatevalue=mapminmax('reverse'valsample.tts);%正式的验证数据testvalue=mapminmax('reverse'testsample.tts);%正式的测试数据%输入要预测的数据pnewpnew=[313256239]';pnewn=mapminmax(pnew);anewn=sim(netpnewn);anew=mapminmax('reverse'anewnts);%绝对误差的计算errors=trainvalue-trainoutput;%plotregression拟合图figureplotregression(trainvaluetrainoutput)%误差变化图figureplot(1:length(errors)errors'-b')title('误差变化图')%误差值的正态性的检验figurehist(errors);%频数直方图figurenormplot(errors);%Q-Q图[muhatsigmahatmucisigmaci]=normfit(errors);%参数估计均值方差均值的0.95置信区间方差的0.95置信区间[h1sigci]= ttest(errorsmuhat);%假设检验figure ploterrcorr(errors);%绘制误差的自相关图figure parcorr(errors);%绘制偏相关图。

基于BP神经网络的PID自整定程序源码

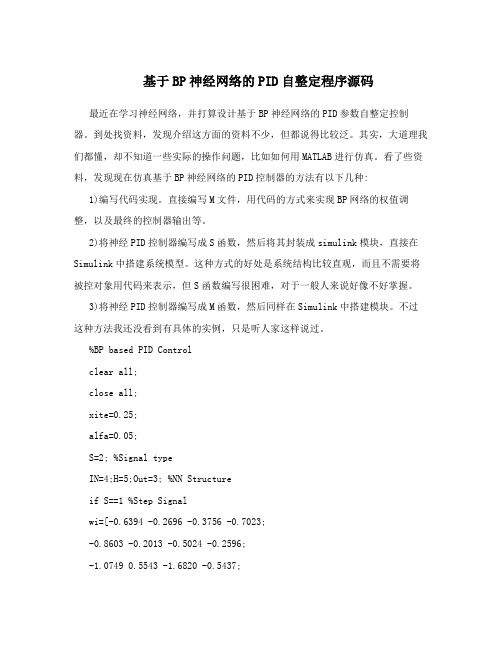

基于BP神经网络的PID自整定程序源码最近在学习神经网络,并打算设计基于BP神经网络的PID参数自整定控制器。

到处找资料,发现介绍这方面的资料不少,但都说得比较泛。

其实,大道理我们都懂,却不知道一些实际的操作问题,比如如何用MATLAB进行仿真。

看了些资料,发现现在仿真基于BP神经网络的PID控制器的方法有以下几种:1)编写代码实现。

直接编写M文件,用代码的方式来实现BP网络的权值调整,以及最终的控制器输出等。

2)将神经PID控制器编写成S函数,然后将其封装成simulink模块,直接在Simulink中搭建系统模型。

这种方式的好处是系统结构比较直观,而且不需要将被控对象用代码来表示,但S函数编写很困难,对于一般人来说好像不好掌握。

3)将神经PID控制器编写成M函数,然后同样在Simulink中搭建模块。

不过这种方法我还没看到有具体的实例,只是听人家这样说过。

%BP based PID Controlclear all;close all;xite=0.25;alfa=0.05;S=2; %Signal typeIN=4;H=5;Out=3; %NN Structureif S==1 %Step Signalwi=[-0.6394 -0.2696 -0.3756 -0.7023;-0.8603 -0.2013 -0.5024 -0.2596;-1.0749 0.5543 -1.6820 -0.5437;-0.3625 -0.0724 -0.6463 -0.2859;0.1425 0.0279 -0.5406 -0.7660]; %wi=0.50*rands(H,IN);wi_1=wi;wi_2=wi;wi_3=wi;wo=[0.7576 0.2616 0.5820 -0.1416 -0.1325;-0.1146 0.2949 0.8352 0.2205 0.4508;0.7201 0.4566 0.7672 0.4962 0.3632]; %wo=0.50*rands(Out,H); wo_1=wo;wo_2=wo;wo_3=wo;endif S==2 %Sine Signalwi=[-0.2846 0.2193 -0.5097 -1.0668;-0.7484 -0.1210 -0.4708 0.0988;-0.7176 0.8297 -1.6000 0.2049;-0.0858 0.1925 -0.6346 0.0347;0.4358 0.2369 -0.4564 -0.1324]; %wi=0.50*rands(H,IN);wi_1=wi;wi_2=wi;wi_3=wi;wo=[1.0438 0.5478 0.8682 0.1446 0.1537;0.1716 0.5811 1.1214 0.5067 0.7370;1.0063 0.7428 1.0534 0.7824 0.6494]; %wo=0.50*rands(Out,H); wo_1=wo;wo_2=wo;wo_3=wo;endx=[0,0,0];u_1=0;u_2=0;u_3=0;u_4=0;u_5=0;y_1=0;y_2=0;y_3=0;Oh=zeros(H,1); %Output from NN middle layer I=Oh; %Input to NN middle layer error_2=0;error_1=0;ts=0.001;for k=1:1:6000time(k)=k*ts;rin(k)=1.0;%Unlinear modela(k)=1.2*(1-0.8*exp(-0.1*k));yout(k)=a(k)*y_1/(1+y_1^2)+u_1;error(k)=rin(k)-yout(k);xi=[rin(k),yout(k),error(k),1];x(1)=error(k)-error_1;x(2)=error(k);x(3)=error(k)-2*error_1+error_2;epid=[x(1);x(2);x(3)];I=xi*wi';for j=1:1:HOh(j)=(exp(I(j))-exp(-I(j)))/(exp(I(j))+exp(-I(j))); %Middle Layer endK=wo*Oh; %Output Layerfor l=1:1:OutK(l)=exp(K(l))/(exp(K(l))+exp(-K(l))); %Getting kp,ki,kdendkp(k)=K(1);ki(k)=K(2);kd(k)=K(3); Kpid=[kp(k),ki(k),kd(k)]; du(k)=Kpid*epid;u(k)=u_1+du(k);if u(k)>=10 % Restricting the output of controlleru(k)=10;endif u(k)<=-10u(k)=-10;enddyu(k)=sign((yout(k)-y_1)/(u(k)-u_1+0.0000001));%Output layerfor j=1:1:OutdK(j)=4/(exp(K(j))+exp(-K(j)))^2;delta3(j)=error(k)*dyu(k)*epid(j)*dK(j); endfor l=1:1:Outfor i=1:1:Hd_wo=xite*delta3(l)*Oh(i)+alfa*(wo_1-wo_2);endendwo=wo_1+d_wo+alfa*(wo_1-wo_2); %Hidden layerfor i=1:1:HdO(i)=4/(exp(I(i))+exp(-I(i)))^2; endsegma=delta3*wo;for i=1:1:Hdelta2(i)=dO(i)*segma(i);endd_wi=xite*delta2'*xi;wi=wi_1+d_wi+alfa*(wi_1-wi_2);%Parameters Updateu_5=u_4;u_4=u_3;u_3=u_2;u_2=u_1;u_1=u(k); y_2=y_1;y_1=yout(k);wo_3=wo_2;wo_2=wo_1;wo_1=wo;wi_3=wi_2;wi_2=wi_1;wi_1=wi;error_2=error_1;error_1=error(k);endfigure(1);plot(time,rin,'r',time,yout,'b');xlabel('time(s)');ylabel('rin,yout'); figure(2);plot(time,error,'r');xlabel('time(s)');ylabel('error'); figure(3);plot(time,u,'r');xlabel('time(s)');ylabel('u'); figure(4);subplot(311);plot(time,kp,'r');xlabel('time(s)');ylabel('kp'); subplot(312); plot(time,ki,'g');xlabel('time(s)');ylabel('ki'); subplot(313); plot(time,kd,'b');xlabel('time(s)');ylabel('kd');。

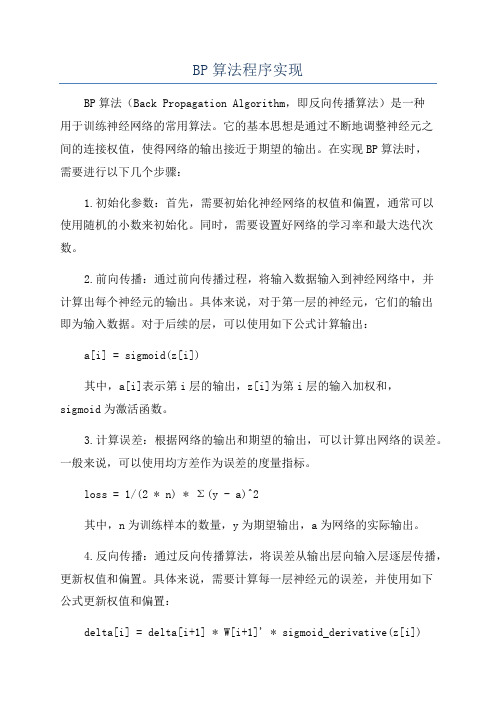

BP算法程序实现

BP算法程序实现BP算法(Back Propagation Algorithm,即反向传播算法)是一种用于训练神经网络的常用算法。

它的基本思想是通过不断地调整神经元之间的连接权值,使得网络的输出接近于期望的输出。

在实现BP算法时,需要进行以下几个步骤:1.初始化参数:首先,需要初始化神经网络的权值和偏置,通常可以使用随机的小数来初始化。

同时,需要设置好网络的学习率和最大迭代次数。

2.前向传播:通过前向传播过程,将输入数据输入到神经网络中,并计算出每个神经元的输出。

具体来说,对于第一层的神经元,它们的输出即为输入数据。

对于后续的层,可以使用如下公式计算输出:a[i] = sigmoid(z[i])其中,a[i]表示第i层的输出,z[i]为第i层的输入加权和,sigmoid为激活函数。

3.计算误差:根据网络的输出和期望的输出,可以计算出网络的误差。

一般来说,可以使用均方差作为误差的度量指标。

loss = 1/(2 * n) * Σ(y - a)^2其中,n为训练样本的数量,y为期望输出,a为网络的实际输出。

4.反向传播:通过反向传播算法,将误差从输出层向输入层逐层传播,更新权值和偏置。

具体来说,需要计算每一层神经元的误差,并使用如下公式更新权值和偏置:delta[i] = delta[i+1] * W[i+1]' * sigmoid_derivative(z[i])W[i] = W[i] + learning_rate * delta[i] * a[i-1]'b[i] = b[i] + learning_rate * delta[i]其中,delta[i]为第i层的误差,W[i]为第i层与i+1层之间的权值,b[i]为第i层的偏置,learning_rate为学习率,sigmoid_derivative为sigmoid函数的导数。

5.迭代更新:根据步骤4中的更新公式,不断迭代调整权值和偏置,直到达到最大迭代次数或误差小于一些阈值。

BP人工神经网络的基本原理模型与实例

w14

0.2+(0.9) (-0.0087)(1)=0.192

w15

-0.3+(0.9) (-0.0065)(1)=-0.306

w24

0.4+(0.9) (-0.0087)(0)=0.4

w25

0.1+(0.9) (-0.0065)(0)=0.1

w34

-0.5+(0.9) (-0.0087)(1)=-0.508

8.1人工神经网络旳基本概念

人工神经网络在本质上是由许多小旳非线性函数构成 旳大旳非线性函数,反应旳是输入变量到输出变量间旳复 杂映射关系。先给出单个人工神经网络旳一般模型描述:

8.1人工神经网络旳基本概念

先来看一种单一输入旳神经元模型 输入变量:x1 连接权重:w1 激活函数:f (·)

x1 w1

w1x1 f (·)

8.1人工神经网络旳基本概念

8.1人工神经网络旳基本概念

单极sigmoid函数

8.1人工神经网络旳基本概念

双曲函数

8.1人工神经网络旳基本概念

增长激活阈值后旳神经元模型 输入变量:x1 连接权重:w1 激活函数:f (·)

x1 w1

w1x1-θ f (·)

-1

小练习:请你算一算,当初始输入、权重和激活阈值为如下数值时,该神 经元旳净输入和输出分别是多少?

2.反向传播 反向传播时,把误差信号按原来正向传播旳通路反向

传回,并对每个隐层旳各个神经元旳权系数进行修改,以 望误差信号趋向最小。

8.2 误差反向传播(BP)神经网 络

8.2 误差反向传播(BP)神经网 络

x1 x2

x3

单元 j 6

1 w14

Err4=

BP神经网络算法的C语言实现代码

//BP神经网络算法,c语言版本//VS2010下,无语法错误,可直接运行//添加了简单注释//欢迎学习交流#include <yerNum>#include <yerNum>#include <yerNum>#include <yerNum>#define N_Out 2 //输出向量维数#define N_In 3 //输入向量维数#define N_Sample 6 //样本数量//BP人工神经网络typedef struct{int LayerNum; //中间层数量double v[N_In][50]; //中间层权矩阵i,中间层节点最大数量为50double w[50][N_Out]; //输出层权矩阵double StudyRate; //学习率double Accuracy; //精度控制参数int MaxLoop; //最大循环次数} BPNet;//Sigmoid函数double fnet(double net){return 1/(1+exp(-net));}//初始化int InitBpNet(BPNet *BP);//训练BP网络,样本为x,理想输出为yint TrainBpNet(BPNet *BP, double x[N_Sample][N_In], int y[N_Sample][N_Out]) ; //使用BP网络int UseBpNet(BPNet *BP);//主函数int main(){//训练样本double x[N_Sample][N_In] = {{0.8,0.5,0},{0.9,0.7,0.3},{1,0.8,0.5},{0,0.2,0.3},{0.2,0.1,1.3},{0.2,0.7,0.8}};//理想输出int y[N_Sample][N_Out] = {{0,1},{0,1},{0,1},{1,1},{1,0},{1,0}};BPNet BP;InitBpNet(&BP); //初始化BP网络结构TrainBpNet(&BP, x, y); //训练BP神经网络UseBpNet(&BP); //测试BP神经网络return 1;}//使用BP网络int UseBpNet(BPNet *BP){double Input[N_In];double Out1[50];double Out2[N_Out]; //Out1为中间层输出,Out2为输出层输出//持续执行,除非中断程序while (1){printf("请输入3个数:\n");int i, j;for (i = 0; i < N_In; i++)scanf_s("%f", &Input[i]);double Tmp;for (i = 0; i < (*BP).LayerNum; i++){Tmp = 0;for (j = 0; j < N_In; j++)Tmp += Input[j] * (*BP).v[j][i];Out1[i] = fnet(Tmp);}for (i = 0; i < N_Out; i++){Tmp = 0;for (j = 0; j < (*BP).LayerNum; j++)Tmp += Out1[j] * (*BP).w[j][i];Out2[i] = fnet(Tmp);}printf("结果:");for (i = 0; i < N_Out; i++)printf("%.3f ", Out2[i]);printf("\n");}return 1;}//训练BP网络,样本为x,理想输出为yint TrainBpNet(BPNet *BP, double x[N_Sample][N_In], int y[N_Sample][N_Out]) {double f = (*BP).Accuracy; //精度控制参数double a = (*BP).StudyRate; //学习率int LayerNum = (*BP).LayerNum; //中间层节点数double v[N_In][50], w[50][N_Out]; //权矩阵double ChgH[50], ChgO[N_Out]; //修改量矩阵double Out1[50], Out2[N_Out]; //中间层和输出层输出量int MaxLoop = (*BP).MaxLoop; //最大循环次数int i, j, k, n;double Tmp;for (i = 0; i < N_In; i++)// 复制结构体中的权矩阵for (j = 0; j < LayerNum; j++)v[i][j] = (*BP).v[i][j];for (i = 0; i < LayerNum; i++)for (j = 0; j < N_Out; j++)w[i][j] = (*BP).w[i][j];double e = f + 1;//对每个样本训练网络for (n = 0; e > f && n < MaxLoop; n++){e = 0;for (i= 0; i < N_Sample; i++){//计算中间层输出向量for (k= 0; k < LayerNum; k++){Tmp = 0;for (j = 0; j < N_In; j++)Tmp = Tmp + x[i][j] * v[j][k];Out1[k] = fnet(Tmp);}//计算输出层输出向量for (k = 0; k < N_Out; k++){Tmp = 0;for (j = 0; j < LayerNum; j++)Tmp = Tmp + Out1[j] * w[j][k];Out2[k] = fnet(Tmp);}//计算输出层的权修改量for (j = 0; j < N_Out; j++)ChgO[j] = Out2[j] * (1 - Out2[j]) * (y[i][j] - Out2[j]);//计算输出误差for (j = 0; j < N_Out ; j++)e = e + (y[i][j] - Out2[j]) * (y[i][j] - Out2[j]);//计算中间层权修改量for (j = 0; j < LayerNum; j++){Tmp = 0;for (k = 0; k < N_Out; k++)Tmp = Tmp + w[j][k] * ChgO[k];ChgH[j] = Tmp * Out1[j] * (1 - Out1[j]);}//修改输出层权矩阵for (j = 0; j < LayerNum; j++)for (k = 0; k < N_Out; k++)w[j][k] = w[j][k] + a * Out1[j] * ChgO[k];for (j = 0; j < N_In; j++)for (k = 0; k < LayerNum; k++)v[j][k] = v[j][k] + a * x[i][j] * ChgH[k];}if (n % 10 == 0)printf("误差: %f\n", e);}printf("总共循环次数:%d\n", n);printf("调整后的中间层权矩阵:\n");for (i = 0; i < N_In; i++){for (j = 0; j < LayerNum; j++)printf("%f ", v[i][j]);printf("\n");}printf("调整后的输出层权矩阵:\n");for (i = 0; i < LayerNum; i++) {for (j = 0; j < N_Out; j++)printf("%f ", w[i][j]);printf("\n");}//把结果复制回结构体for (i = 0; i < N_In; i++)for (j = 0; j < LayerNum; j++)(*BP).v[i][j] = v[i][j];for (i = 0; i < LayerNum; i++)for (j = 0; j < N_Out; j++)(*BP).w[i][j] = w[i][j];printf("BP网络训练结束!\n");return 1;}//初始化int InitBpNet(BPNet *BP){printf("请输入中间层节点数,最大数为100:\n");scanf_s("%d", &(*BP).LayerNum);printf("请输入学习率:\n");scanf_s("%lf", &(*BP).StudyRate); //(*BP).StudyRate为double型数据,所以必须是lf printf("请输入精度控制参数:\n");scanf_s("%lf", &(*BP).Accuracy);printf("请输入最大循环次数:\n");scanf_s("%d", &(*BP).MaxLoop);int i, j;srand((unsigned)time(NULL));for (i = 0; i < N_In; i++)for (j = 0; j < (*BP).LayerNum; j++)(*BP).v[i][j] = rand() / (double)(RAND_MAX);for (i = 0; i < (*BP).LayerNum; i++)for (j = 0; j < N_Out; j++)(*BP).w[i][j] = rand() / (double)(RAND_MAX);return 1;}。

BP人工神经网络的基本原理、模型与实例

BP人工神经网络的实例

BP人工神经网络可以应用于多个领域,如图像识别、语音处理、预测分析等,为解决复杂问题提供了有效的神经网络的输入是具体问题的相关数据,比如图像数据、声音数据等。 输出是经过神经网络计算后得出的结果。

神经元和连接权重

神经元是BP人工神经网络的基本单元,通过调整连接权重来不断优化神经网 络的表现和学习能力。

前向传播和反向传播

前向传播是指输入数据从输入层经过隐藏层到达输出层的过程。反向传播是指根据误差计算,通过调整连接权 重来优化神经网络的过程。

训练和优化算法

BP人工神经网络的训练过程是通过不断调整连接权重使得神经网络的输出结 果接近于期望结果的过程。优化算法如梯度下降算法等可以加速训练的过程。

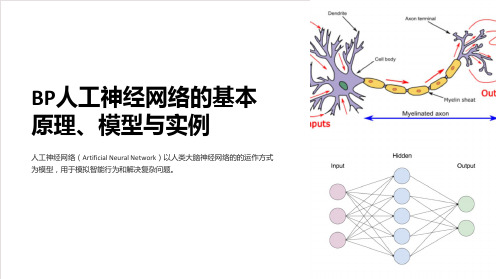

BP人工神经网络的基本 原理、模型与实例

人工神经网络(Artificial Neural Network)以人类大脑神经网络的的运作方式 为模型,用于模拟智能行为和解决复杂问题。

BP人工神经网络的基本原理

BP人工神经网络通过多层神经元和连接权重的组合,实现输入数据到输出结 果的计算和转换过程。

BP人工神经网络的模型

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

BP神经网络实例含源码BP神经网络算法实现一:关于BP网络BP (Back Propagation)神经网络,即误差反传误差反向传播算法的学习过程,由信息的正向传播和误差的反向传播两个过程组成。

输入层各神经元负责接收来自外界的输入信息,并传递给中间层各神经元;中间层是内部信息处理层,负责信息变换,根据信息变化能力的需求,中间层可以设计为单隐层或者多隐层结构;最后一个隐层传递到输出层各神经元的信息,经进一步处理后,完成一次学习的正向传播处理过程,由输出层向外界输出信息处理结果。

当实际输出与期望输出不符时,进入误差的反向传播阶段。

误差通过输出层,按误差梯度下降的方式修正各层权值,向隐层、输入层逐层反传。

周而复始的信息正向传播和误差反向传播过程,是各层权值不断调整的过程,也是神经网络学习训练的过程,此过程一直进行到网络输出的误差减少到可以接受的程度,或者预先设定的学习次数为止。

BP网络主要应用于以下方面:函数逼近、模式识别和分类、数据压缩。

BP神经网络有较强的泛化性能,使网络平滑的逼近函数,能合理的响应被训练以外的输入。

同时,BP网络又有自己的限制与不足,主要表现在:需要较长的训练时间、网络训练的结果可能使得权值逼近局部最优、训练数据范围外的数据泛化能力较差。

为了避免训练陷入局部最优解,本程序采用改进的BP网络训练,既加入动量因子,使得网络在最优解附近有一定的震荡,跳出局部最优的范围。

BP网络训练中学习速率与动量因子的选择很重要,在后面的内容中将进行详细的讨论。

二:训练的函数程序中训练的函数为一个三输入一输出的非线性函数,如下所示: x3xR,yxxe,,,,2sin(),,,12网络结构为:3—5—1三:程序及相关界面(VB)1 主界面1代码:Private Sub Command1_Click() form2.Visible = FalseForm3.Visible = TrueEnd SubPrivate Sub Command2_Click() form2.Visible = FalseForm1.Visible = TrueEnd SubPrivate Sub Command3_Click() form2.Visible = FalseForm4.Visible = TrueEnd SubPrivate Sub Command4_Click() form2.Visible = FalseForm5.Visible = TrueEnd SubPrivate Sub Command5_Click() EndEnd SubPrivate Sub Form_Load() Command3.Enabled = False Command4.Enabled = False End Sub2 查看网络结构2代码:Private Sub Command1_Click()Form3.Visible = False form2.Visible = True End Sub3 网络训练代码:3Private Sub Command1_Click()Form1.Visible = Falseform2.Visible = TrueEnd SubPrivate Sub Command2_Click()Label2.Caption = "样本训练中…"Dim i As Integer, j As Integer, k As Integer, p As Integer, s As SingleDim Maxx(1 To 3) As Single, Minx(1 To 3) As Single, Meanx(1 To 3) As SingleDim x(1 To 3, 1 To 100) As Single, sumx(1 To 3) As Single, Temp As SingleDim Datex(1 To 3, 1 To 100) As Single, inputx(1 To 3) As Single, outputx(1 To 100) As SingleDim Ex(1 To 100) As SingleDim time(1 To 5000) As Integer, cishu(1 To 100) As IntegerDim Dv_1(1 To 5, 1 To 3) As Single, Dw_1(1 To 5) As SingleDim R As SingleDim Maxd As Single, Mind As SingleDim s1(1 To 5) As Single, y1(1 To 5, 1 To 100) As Single, s2 As Single, y2(1 To 100) As SingleDim deltW(1 To 100) As Single, deltV(1 To 5, 1 To 100) As SingleDim Dw(1 To 5) As Single, Dv(1 To 5, 1 To 3) As Single Dim MyIn(1 To 3) As SingleDim Errorx(1 To 5000) As SingleRandomizeFor i = 1 To 3Maxx(i) = 0Minx(i) = 0Meanx(i) = 0Next iTemp = 0Maxd = 0Mind = 0For i = 1 To 5For j = 1 To 3Dv_1(i, j) = 0v(i, j) = 2 * Rnd - 1Next jDw_1(i) = 0w(i) = 2 * Rnd - 1Next iFor j = 1 To 3For i = 1 To 100x(j, i) = 4 * (2 * Rnd - 1)Next isumx(j) = 0Next j'求最值For j = 1 To 3For i = 1 To 100If x(j, i) >= Maxx(j) ThenMaxx(j) = x(j, i)End IfIf x(j, i) <= Minx(j) ThenMinx(j) = x(j, i)Temp = Temp + x(j, i)End IfNext isumx(j) = Temp4Temp = 0Meanx(j) = sumx(j) / 100 Next j'归一化For j = 1 To 3For i = 1 To 100If Maxx(j) - x(j, i) >= x(j, i) - Minx(j) Then R = Maxx(j) - x(j, i)ElseR = x(j, i) - Minx(j)End IfDatex(j, i) = (x(j, i) - Meanx(j)) / RNext iNext j'期望输出For i = 1 To 100For j = 1 To 3inputx(j) = Datex(j, i)Next joutputx(i) = 2 * (inputx(1) + Sin(inputx(2)) + Exp(inputx(3))) Next i'输出归一化For i = 1 To 100If Maxd <= outputx(i) ThenMaxd = outputx(i)End IfIf Mind >= outputx(i) ThenMind = outputx(i)End IfNext iFor i = 1 To 100Ex(i) = (outputx(i) - Mind) / (Maxd - Mind)Next i'训练For s = 1 To 5000 Step 1time(s) = sFor p = 1 To 100cishu(p) = pFor i = 1 To 3MyIn(i) = Datex(i, p)Next iFor i = 1 To 5For j = 1 To 3Temp = Temp + v(i, j) * MyIn(j)Next js1(i) = TempTemp = 0Next iFor i = 1 To 5y1(i, p) = 1 / (1 + Exp(-s1(i)))Next iFor i = 1 To 3Temp = y1(i, p) * w(i) + TempNext is2 = TempTemp = 0y2(p) = 1 / (1 + Exp(-s2))deltW(p) = (Ex(p) - y2(p)) * y2(p) * (1 - y2(p))5For i = 1 To 5deltV(i, p) = deltW(p) * w(i) * y1(i, p) * (1 - y1(i, p)) Next iNext p'误差For i = 1 To 100Temp = Temp + (Ex(i) - y2(i)) ^ 2Next iErrorx(s) = TempTemp = 0'调整权值For i = 1 To 5Dw_1(i) = Dw(i)Next iFor i = 1 To 5For j = 1 To 100Temp = Temp + deltW(j) * y1(i, j)Next jDw(i) = TempTemp = 0Next iFor i = 1 To 5For j = 1 To 3Dv_1(i, j) = Dv(i, j)Next jNext iFor i = 1 To 5For j = 1 To 3For k = 1 To 100Temp = Temp + deltV(i, k) * Datex(j, k)Next kDv(i, j) = TempTemp = 0Next jNext iFor i = 1 To 5w(i) = 0.2 * Dw(i) + 0.2 * Dw_1(i) + w(i)Next iFor i = 1 To 3For j = 1 To 5v(j, i) = 0.2 * Dv(j, i) + 0.2 * Dv_1(j, i) + v(j, i) Next jNext i'画图Picture1.ClsPicture1.ScaleTop = 1.5Picture1.ScaleHeight = -2Picture1.ScaleLeft = -10Picture1.ScaleWidth = 120Picture1.Line (-9, 0)-(110, 0)Picture1.Line (0, 0)-(0, 1.5)For i = 1 To 100Picture1.PSet (cishu(i), Ex(i)), RGB(128, 128, 0)Picture1.PSet (cishu(i), y2(i)), RGB(128, 0, 0)Next iFor i = 1 To 99Picture1.Line (cishu(i), Ex(i))-(cishu(i + 1), Ex(i + 1)), RGB(128, 128, 0)Picture1.Line (cishu(i), y2(i))-(cishu(i + 1), y2(i + 1)), RGB(128, 0, 0)6Next i'延时For j = 1 To 1000For k = 1 To 50Next kNext jPicture2.ClsPicture2.Print sDoEventsNext sLabel2.Caption = ""mand3.Enabled = True mand4.Enabled = True '泛化Dim test(1 To 3, 1 To 20) As Single, sumE(1 To 3) As SingleDim MaxE(1 To 3) As Single, MinE(1 To 3) As Single, MeanE(1 To 3) As SingleDim MaxxE As Single, MinxE As Single Dim des(1 To 3) As Single,outE(1 To 20) As SingleDim MIn(1 To 3) As Single, s11(1 To 5) As Single, y11(1 To 5, 1 To 20) As Single, s22 As SingleDim DateE(1 To 3, 1 To 20) As SingleFor i = 1 To 20For j = 1 To 3test(j, i) = 4 * (2 * Rnd - 1)Next jNext iFor j = 1 To 3For i = 1 To 20If test(j, i) >= MaxE(j) ThenMaxE(j) = test(j, i)End IfIf test(j, i) <= MinE(j) ThenMinE(j) = test(j, i)Temp = Temp + test(j, i)End IfNext isumE(j) = TempTemp = 0MeanE(j) = sumE(j) / 100Next j'归一化For j = 1 To 3For i = 1 To 20If MaxE(j) - test(j, i) >= test(j, i) - MinE(j) Then R = MaxE(j) - test(j, i)ElseR = test(j, i) - MinE(j)End IfDateE(j, i) = (test(j, i) - MeanE(j)) / RNext iNext j'求输出For p = 1 To 20Ti(p) = pFor i = 1 To 3MIn(i) = DateE(i, p)Next iFor i = 1 To 57For j = 1 To 3Temp = Temp + v(i, j) * MIn(j)Next js11(i) = TempTemp = 0Next iFor i = 1 To 5y11(i, p) = 1 / (1 + Exp(-s11(i)))Next iFor i = 1 To 3Temp = y11(i, p) * w(i) + TempNext is22 = TempTemp = 0y22(p) = 1 / (1 + Exp(-s22))Next p'输出及归一化For j = 1 To 20For i = 1 To 3des(i) = DateE(i, j)Next ioutE(j) = 2 * (des(1) + Sin(des(2)) + Exp(des(3))) Next j'输出归一化For i = 1 To 20If MaxxE <= outE(i) ThenMaxxE = outE(i)End IfIf MinxE >= outE(i) ThenMinxE = outE(i)End IfNext iFor i = 1 To 20outD(i) = (outE(i) - MinxE) / (MaxxE - MinxE)Next iEnd Sub4 查看训练结果代码:8Private Sub Command1_Click() Form5.Visible = False form2.Visible = TrueEnd SubPrivate Sub Command2_Click() Picture1.ClsPicture2.ClsDim i As Integer, j As Integer For i = 1 To 5For j = 1 To 3Picture2.Print v(i, j); Spc(4);Next jPicture2.PrintPicture2.PrintPicture1.Print w(i); Next iEnd Sub5 泛化代码:Private Sub Command1_Click() Form4.Visible = False form2.Visible = TrueEnd SubPrivate Sub Command2_Click() For s = 1 To 20'Picture1.ClsPicture1.ScaleTop = 1.5Picture1.ScaleHeight = -2Picture1.ScaleLeft = -5Picture1.ScaleWidth = 30Picture1.Line (-5, 0)-(25, 0)Picture1.Line (0, -0.5)-(0, 1.5)For i = 1 To 20Picture1.PSet (Ti(i), outD(i)), RGB(128, 128, 0)Picture1.PSet (Ti(i), y22(i)), RGB(128, 0, 0)9Next iFor i = 1 To 19Picture1.Line (Ti(i), outD(i))-(Ti(i + 1), outD(i + 1)), RGB(128, 128, 0)Picture1.Line (Ti(i), y22(i))-(Ti(i + 1), y22(i + 1)), RGB(128, 0, 0) Next iNext sEnd Sub6 全局模块Public w(1 To 5) As Single, v(1 To 5, 1 To 3) As Single Public Ti(1To 20) As Single, y22(1 To 20) As Single, outD(1 To 20) As Single 四:相关分析及讨论以上编程实现了对一个三输入、一输出非线性函数的逼近,在模型训练中采用改进的BP网络——动量因子法,输入是随机产生的100组数据,输出是通过已知函数得到的相应期望输出,通过BP网络的5000代训练可以与期望输出拟合的很好,泛化也较理想,训练误差和泛化误差都在可接受范围内。