多元回归分析估计问题

多元线性回归分析

S /(n k 1) 或 t ˆi / cii

S /(n k 1)

c 式中 ii 是矩阵 (X ' X )1对角线上的第 i 个元素,S 表示残

差平方和 。 当检验统计量的值大于给定显著性下的临界值时,拒绝 原假设,认为回归系数是显著的

(六)利用已通过检验的回归方程进行预测。

市场调查

多元线性回归分析

多元线性回归是在简单线性回归基础上推广而来。是 用来分析多个自变量对多个因变量如何产生影响的,最常见 的是分析多个自变量对一个因变量的影响方向和影响程度。

一、多元线性回归分析在市场调查中的应用

(一)确定市场调查中因变量与自变量之间的关系 是否存在,若存在,还要分析自变量对因变量的影 响程度是多大,影响方向如何。

Yt

因变量

X it (i 1,2,, k)

自变量

i (i 1,2,, k)

总体回归系数

ut

随机误差项

作为总体回归方程的估计,样本回归方程如下:

Yˆt ˆ1 ˆ2 X 2t ˆ3 X3t ˆk X kt et

ˆi (i 1,2,, k)

总体回归系数的估计

t 1,2,, n

样本数

et 是 Yt与其估计 Yˆt之间的离差,即残差

(二)确定因变量和自变量之间的联系形式,关 键是要找出回归系数。

(三)利用已确定的因变量和自变量之间的方程 形式,在已知自变量的情况下,对因变量的取值 进行预测。

(四)在众多影响因变量的因素中,通过评价其 对因变量的贡献,来确定哪些自变量是重要的或 者说是比较重要的,为市场决策行为提供理论依 据。

(五)回归的显著性检验

包括对回归方程的显著性检验和对回归系数的显著性检验。

数据分析技术中常用的多元回归分析方法简介

数据分析技术中常用的多元回归分析方法简介多元回归分析是一种常用的数据分析技术,用于建立解释一个或多个自变量与一个或多个因变量之间关系的数学模型。

在实际应用中,多元回归分析可以帮助我们理解和预测因变量的变化情况,同时揭示自变量对因变量的影响程度和方向。

在多元回归分析中,我们通常会考虑多个自变量对一个因变量的影响。

这些自变量可以是连续变量,也可以是分类变量。

为了进行多元回归分析,我们需要收集包含自变量和因变量数据的样本,并建立一个数学模型来描述它们之间的关系。

常用的多元回归分析方法有以下几种:1. 线性回归分析:线性回归是最基本的多元回归分析方法之一。

它假设自变量和因变量之间的关系是线性的,即可以通过一条直线来描述。

线性回归可以用于预测新的因变量值或者探究自变量对因变量的影响程度和方向。

2. 多项式回归分析:多项式回归是线性回归的扩展形式,它允许通过非线性方程来描述自变量和因变量之间的关系。

多项式回归可以用于处理具有非线性关系的数据,通过增加自变量的幂次项,可以更好地拟合数据。

3. 逐步回归分析:逐步回归是一种渐进式的回归分析方法,它通过不断添加或删除自变量来选择最优的模型。

逐步回归可以帮助我们识别对因变量影响最显著的自变量,并且去除对模型没有贡献的自变量,以减少复杂度和提高预测准确性。

4. 岭回归分析:岭回归是一种用于处理共线性问题的回归方法。

共线性指的是自变量之间存在高度相关性,这会导致模型参数估计不稳定。

岭回归通过添加一个正则化项来缩小模型参数的值,从而减少共线性的影响。

5. 主成分回归分析:主成分回归结合了主成分分析和回归分析的方法,用于处理多重共线性问题。

主成分分析通过将自变量转换为一组无关的主成分来降维,然后进行回归分析。

这样可以减少自变量之间的相关性,并提高模型的解释力。

6. 逻辑回归分析:逻辑回归是一种广义线性回归,常用于处理二分类问题。

它通过对因变量进行逻辑变换,将线性回归的结果映射到一个[0, 1]的区间,表示某事件发生的概率。

多元线性回归模型的估计与解释

多元线性回归模型的估计与解释多元线性回归是一种广泛应用于统计学和机器学习领域的预测模型。

与简单线性回归模型相比,多元线性回归模型允许我们将多个自变量引入到模型中,以更准确地解释因变量的变化。

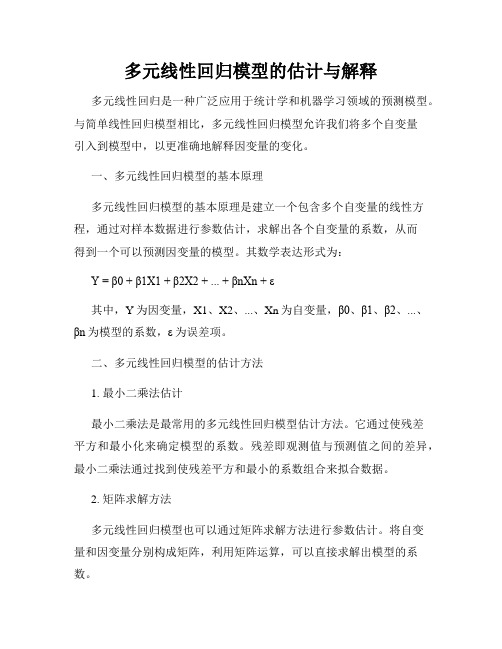

一、多元线性回归模型的基本原理多元线性回归模型的基本原理是建立一个包含多个自变量的线性方程,通过对样本数据进行参数估计,求解出各个自变量的系数,从而得到一个可以预测因变量的模型。

其数学表达形式为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y为因变量,X1、X2、...、Xn为自变量,β0、β1、β2、...、βn为模型的系数,ε为误差项。

二、多元线性回归模型的估计方法1. 最小二乘法估计最小二乘法是最常用的多元线性回归模型估计方法。

它通过使残差平方和最小化来确定模型的系数。

残差即观测值与预测值之间的差异,最小二乘法通过找到使残差平方和最小的系数组合来拟合数据。

2. 矩阵求解方法多元线性回归模型也可以通过矩阵求解方法进行参数估计。

将自变量和因变量分别构成矩阵,利用矩阵运算,可以直接求解出模型的系数。

三、多元线性回归模型的解释多元线性回归模型可以通过系数估计来解释自变量与因变量之间的关系。

系数的符号表示了自变量对因变量的影响方向,而系数的大小则表示了自变量对因变量的影响程度。

此外,多元线性回归模型还可以通过假设检验来验证模型的显著性。

假设检验包括对模型整体的显著性检验和对各个自变量的显著性检验。

对于整体的显著性检验,一般采用F检验或R方检验。

F检验通过比较回归平方和和残差平方和的比值来判断模型是否显著。

对于各个自变量的显著性检验,一般采用t检验,通过检验系数的置信区间与预先设定的显著性水平进行比较,来判断自变量的系数是否显著不为零。

通过解释模型的系数和做假设检验,我们可以对多元线性回归模型进行全面的解释和评估。

四、多元线性回归模型的应用多元线性回归模型在实际应用中具有广泛的应用价值。

多元线性回归模型常见问题及解决方法

Yi 0 1 X i1 2 X i 2

k X ik i ; i 1, 2, , n

基本假设 (1)随机扰动项ui数学期望(均值)为零。E(ui)=0 (2)随机扰动项ui的同方差性且无自相关Var(ui)=σ2 (3)解释变量X列线性无关。R(Xn×k)=K (4)随机扰动项ui与解释变量X不相关。cov(ui,X)=0

0 0 0 1 2 0

0 0 0 1 2

0 0 0 0 1

Yt 0 1 X t1

k X tk Yt 1 t

(4)回归模型含有截距项。 D.W.检验的原假设为:H0: ρ=0,即μt不存在一 阶自回归。

构造统计量:

DW . .

2 ( e e ) t t 1 t 2 2 e t t 1 n

n

该统计量的分布与给定样本中的X值有复杂关 系,其精确分布很难得到。

n1 n 2 2 n

其中,Ω为对称正定矩阵,故存在一可逆矩阵 D,使得 Ω=DD’ 用D-1左乘模型两边,得到新模型: D-1Y=D-1Xβ+D-1μ 即Y*=X*β+μ*

由于 E ( * * ') E[ D 1 '( D 1 ) '] D 1E ( ')( D 1 ) ' D 1 2( D 1 ) ' D 1 2 DD '( D 1 ) ' 2 I 故,可用普通最小二乘法估计新模型,记参数 ˆ * ,则 估计量为 ˆ * ( X * ' X * )1 X * ' Y * [ X '( D 1 ) ' D 1 X ]1 X '( D 1 ) ' D 1Y

多元回归分析及其应用

多元回归分析及其应用多元回归分析是一种统计分析方法,可以用来研究多个自变量对一个因变量的影响关系。

相比于简单回归分析,多元回归分析考虑了更多因素的影响,能够更准确地描述变量之间的关系。

本文将介绍多元回归分析的基本原理和应用,以及如何进行该分析的步骤和解读结果。

一、多元回归分析的基本原理多元回归分析建立在线性回归的基础上,使用线性方程来描述因变量与自变量之间的关系。

它的基本模型可以表示为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y表示因变量,X1、X2...Xn表示自变量,β0、β1...βn表示模型的系数,ε表示误差项。

多元回归分析的目标是通过拟合最佳的模型,得到各个自变量的系数,以及判断自变量对因变量的影响是否显著。

二、多元回归分析的步骤进行多元回归分析时,需要按照以下步骤进行:1. 数据收集与准备:收集与研究问题相关的数据,并进行数据清洗与整理,确保数据的准确性和完整性。

2. 模型设定:根据研究问题和数据特点,选择适当的模型。

根据自变量和因变量的关系类型,可以选择线性回归、多项式回归、对数回归等各种模型。

3. 模型拟合:使用统计软件进行多元回归分析,拟合出最佳模型。

统计软件会给出各个自变量的系数、截距项以及模型的可靠性指标。

4. 模型诊断:对模型进行诊断,检查模型的合理性和符合假设的程度。

可以通过观察残差图、相关系数矩阵、变量的显著性检验等方法来评估模型的质量。

5. 结果解读:根据模型的系数和统计指标,对结果进行解读。

判断自变量对因变量的影响是否显著,并分析各个自变量之间的相互影响。

三、多元回归分析的应用领域多元回归分析在各个学科和领域都有广泛的应用。

以下是其中几个具体领域的示例:1. 经济学:多元回归分析可以用来研究经济变量之间的关系,如GDP、失业率、通货膨胀率等。

2. 医学:多元回归分析可以帮助医学研究人员研究不同因素对疾病发展的影响,如药物剂量、生活方式等。

第2章多元回归分析

y = b0 + b1x1 + b2x2 + . . . bkxk + u

1

Multiple Regression Analysis

y = b0 + b1x1 + b2x2 + . . . bkxk + u

1. Estimation

2

Parallels with Simple Regression

fIrno mthethgeefniersrtalocrdaeser cwointhd iktioinnd, ewpeencdanengtevt akriab1 les,

lwineeasreeeqkueasttiiomnastienskbˆ0,1bˆu1,n k n,obˆwk

tynˆheryebiˆf0orbeˆb,0ˆ1mx1ibnˆ1ixmi1 izebˆtkhxekbˆskuxmik of

The STATA command

Use [path]wage1.dta (insheet using [path]wage1.raw/wage1.txt) Reg wage educ exper tenure Reg lwage educ exper tenure

7

A “Partialling Out” Interpretation

8

“Partialling Out” continued

Previous equation implies that regressing y on x1 and x2 gives same effect of x1 as regressing y on residuals from a regression of x1 on x2

多元回归分析方法

多元回归分析方法一、简介多元回归分析是一种经济学和统计学中常用的分析方法,它可以用来研究多个自变量对一个因变量的影响关系。

在实际问题中,我们往往需要考虑多个因素对某个现象的影响,多元回归分析可以帮助我们揭示这种复杂关系。

二、回归模型回归分析基于回归模型,常见的多元回归模型可以表示为:Y = β0 + β1X1 + β2X2 + ... + βkXk + ε,其中Y是因变量,Xi是自变量,βi是对应的回归系数,ε是随机误差项。

回归系数反映了自变量对因变量的影响程度,通过对样本数据进行估计,我们可以得到回归系数的估计值。

三、数据收集与准备在进行多元回归分析之前,我们需要收集和准备相关的数据。

这包括确定因变量和自变量的测量指标,选择合适的样本规模,保证数据的有效性和可靠性。

同时,对于因变量和自变量之间可能存在的非线性关系,我们需要进行适当的变量转换或添加高阶项,以确保模型的拟合程度。

四、回归模型的选择在进行多元回归分析时,我们需要选择合适的回归模型。

这可以通过观察数据的分布情况、变量之间的关系以及领域知识来进行判断。

常见的回归模型包括线性回归、多项式回归和逻辑回归等。

选择合适的模型能够提高分析的准确性和可解释性。

五、模型拟合与评估在得到回归模型的估计值后,我们需要评估模型的拟合程度和预测能力。

常见的评估指标包括均方误差(MSE)、决定系数(R-squared)和F统计量等。

通过这些指标,我们可以判断模型的拟合优度和自变量的显著性,进而确定模型是否可靠以及变量是否具有统计显著性。

六、多重共线性检验多元回归分析中存在一个重要的问题,即多重共线性。

当自变量之间存在强相关关系时,容易导致模型估计结果的不稳定和不可靠。

因此,在进行多元回归分析之前,必须对自变量进行多重共线性的检验。

常用的方法包括方差膨胀因子(VIF)和特征值分解等。

七、模型解释与应用通过对多元回归模型的估计和评估,我们可以得到自变量对因变量的影响程度和方向,并进行合理的解释。

多元线性回归分析估计

• 5. OLS的有效性:高斯-马尔科夫定理 Efficiency of OLS: The Gauss-Markov Theorem

2

本课大纲

• 1. 多元回归模型的结构 • 2. 为什么使用多元回归 • 3.多元回归模型中的零值条件期望假定 • 4.多元回归模型的OLS 估计及代数性质 • 5.解释多元回归模型参数 • 6. 简单回归模型与多元回归模型的比较

• 多元回归模型能容许很多解释变量,而这些变量可以是相关的。 • 在使用非实验数据时,多元回归模型对推断y与解释变量x间的因

果关系很重要。

11

为什么使用多元回归? 2. 更好地预测

• 一个变量y的变化,不仅与一种因素有关,可能 决定于许多因素。

• 预测一个变量的变化,往往需要尽可能多地知道 影响该变量变化的因素。

• 因此,多元线性回归模型,是实证分析中 应用最广泛的分析工具。

13

为什么使用多元回归模型? 例1: 教育对工资的影响

• 教育educ对工资wage的影响 • 一个简单回归模型:

Wage= 0 + 1 • uc +u

• 然而,上述工资方程中,许多影响工资,同时又与教 育年限相关的变量,被包含于误差项u中,如劳动力 市场经验等。一方面,他们影响工资,但又不同于教 育,故包含于u中。另一方面,他们又与教育相关。 如教育年限越长,则参与劳动市场的时间就相对越短。 因此,零值条件期望假定不成立,会导致OLS估计量

• 4. Unites of Measurement and Functional Form 测量单位和函数形式

• 5. Expected Values and Variances of the OLS estimators OLS估计量的期望值和方差

多元线性回归模型常见问题及解决方法

上述即为加权最小二乘法,其中权数 为1 。

f ( X ji )

普通最小二乘法只是加权最小二乘法中权数恒 取1的一种特例,加权最小二乘法具有比普通 最小二乘法更普遍的意义。

加权最小二乘法也称为广义最小二乘法 (Generalized Least Squares, GLS)。

加权最小二乘法的关键是寻找适当的权,或者

nR2~χ2

在大样本下,对统计量nR2进行相应的χ2检验。

若存在异方差性,表明 e%i2与解释变量的某种 组合有显著的相关性,这时往往有较大的可决 系数R2,并且某一参数的t检验值较大。

加权最小二乘法(WLS)

加权最小二乘法(Weighted Least Squares, WLS) 是对原模型加权,使之变成一个新的不存在异 方差性的模型,然后采用普通最小二乘法估计 其参数。

2

L k

f

1 (X

ji )

X ki

f

1 (X

ji

)

i

f

1 (X

ji )

X 2i

在新模型中,

2

Var

f

1 (X

ji

)

i

1

f (X ji )

Var(i )

1 f (X ji )

f (X ji ) 2

2

即满足同方差性,可用普通最小二乘法估计其 参数,得到参数β0,β1,…,βk的无偏、有效估计量。

序列相关性产生的原因

经济变量故有的惯性(物价指数,消费) 模型设定的偏误 数据的编造 (由已知数据生成)

(一)经济变量故有的惯性

消费函数模型:

多元线性回归分析的参数估计方法

多元线性回归分析的参数估计方法多元线性回归是一种常用的数据分析方法,用于探究自变量与因变量之间的关系。

在多元线性回归中,参数估计方法有多种,包括最小二乘估计、最大似然估计和贝叶斯估计等。

本文将重点讨论多元线性回归中的参数估计方法。

在多元线性回归中,最常用的参数估计方法是最小二乘估计(Ordinary Least Squares,OLS)。

最小二乘估计是一种求解最优参数的方法,通过最小化残差平方和来估计参数的取值。

具体而言,对于给定的自变量和因变量数据,最小二乘估计方法试图找到一组参数,使得预测值与观测值之间的残差平方和最小。

这样的估计方法具有几何和统计意义,可以用来描述变量之间的线性关系。

最小二乘估计方法有一系列优良的性质,比如无偏性、一致性和有效性。

其中,无偏性是指估计值的期望等于真实参数的值,即估计值不会出现系统性的偏差。

一致性是指当样本容量趋近无穷时,估计值趋近于真实参数的值。

有效性是指最小二乘估计具有最小的方差,即估计值的波动最小。

这些性质使得最小二乘估计成为了多元线性回归中最常用的参数估计方法。

然而,最小二乘估计方法在面对一些特殊情况时可能会出现问题。

比如,当自变量之间存在多重共线性时,最小二乘估计的解不存在或不唯一。

多重共线性是指自变量之间存在较高的相关性,导致在估计回归系数时出现不稳定或不准确的情况。

为了解决多重共线性问题,可以采用一些技术手段,如主成分回归和岭回归等。

另外一个常用的参数估计方法是最大似然估计(Maximum Likelihood Estimation,MLE)。

最大似然估计方法试图找到一组参数,使得给定样本观测值的条件下,观测到这些值的概率最大。

具体而言,最大似然估计方法通过构建似然函数,并对似然函数求导,找到能够最大化似然函数的参数取值。

最大似然估计方法在一定条件下具有良好的性质,比如一致性和渐近正态分布。

但是,在实际应用中,最大似然估计方法可能存在计算复杂度高、估计值不唯一等问题。

多元回归中方差的无偏估计

多元回归中方差的无偏估计

多元回归分析是统计学中常用的一种分析方法,用于研究多个

自变量对因变量的影响。

在进行多元回归分析时,我们不仅关心自

变量对因变量的影响程度,还需要对模型的拟合程度进行评估。

而

方差的无偏估计是评估模型拟合程度的重要指标之一。

在多元回归中,我们通常使用残差平方和来度量观测值与回归

平面的偏离程度,而方差的无偏估计则是对残差平方和的一个重要

评估。

方差的无偏估计可以帮助我们判断模型的拟合程度,进而评

估模型的可靠性。

在多元回归中,方差的无偏估计通常使用均方误差(Mean Squared Error,MSE)来进行计算。

MSE是残差平方和除以自由度

的比值,自由度是样本量减去自变量的个数。

通过计算MSE,我们

可以得到对方差的无偏估计,从而评估模型的拟合程度。

方差的无偏估计在多元回归分析中具有重要的意义,它可以帮

助我们判断模型的拟合程度,为模型的可靠性提供重要参考。

同时,方差的无偏估计也可以帮助我们进行模型的比较和选择,以及对模

型的改进提供指导。

总之,方差的无偏估计在多元回归分析中扮演着重要的角色,它是评估模型拟合程度和可靠性的重要指标之一。

在实际应用中,我们需要充分理解方差的无偏估计的计算原理和意义,以便更好地进行多元回归分析和模型的评估。

多元线性回归模型计算分析题

多元线性回归模型计算分析题1、某地区通过一个样本容量为722的调查数据得到劳动力受教育年数的一个回归方程为R2=0.214式中,为劳动力受教育年数,为劳动力家庭中兄弟姐妹的个数,与分别为母亲与父亲受到教育的年数。

问(1)sibs是否具有预期的影响?为什么?若与保持不变,为了使预测的受教育水平减少一年,需要增加多少?(2)请对的系数给予适当的解释。

(3)如果两个劳动力都没有兄弟姐妹,但其中一个的父母受教育的年数均为12年,另一个的父母受教育的年数均为16年,则两人受教育的年数预期相差多少年2、考虑以下方程(括号内为标准差):(0.080) (0.072) (0.658)其中:——年的每位雇员的工资——年的物价水平——年的失业率要求:(1)进行变量显著性检验;(2)对本模型的正确性进行讨论,是否应从方程中删除?为什么?3、以企业研发支出(R&D)占销售额的比重(单位:%)为被解释变量(Y),以企业销售额(X1)与利润占销售额的比重(X2)为解释变量,一个容量为32的样本企业的估计结果如下:其中,括号中的数据为参数估计值的标准差。

(1)解释ln(X1)的参数。

如果X1增长10%,估计Y会变化多少个百分点?这在经济上是一个很大的影响吗?(2)检验R&D强度不随销售额的变化而变化的假设。

分别在5%和10%的显著性水平上进行这个检验。

(3)利润占销售额的比重X2对R&D强度Y是否在统计上有显著的影响?4、假设你以校园内食堂每天卖出的盒饭数量作为被解释变量,以盒饭价格、气温、附近餐厅的盒饭价格、学校当日的学生数量(单位:千人)作为解释变量,进行回归分析。

假设你看到如下的回归结果(括号内为标准差),但你不知道各解释变量分别代表什么。

(2.6) (6.3) (0.61) (5.9)试判定各解释变量分别代表什么,说明理由。

5、下表给出一二元模型的回归结果。

方差来源平方和(SS)自由度(d.f.)来自回归(ESS)65965—来自残差(RSS)_——总离差(TSS)6604214求:(1)样本容量是多少?RSS是多少?ESS和RSS的自由度各是多少?(2)和?(3)检验假设:解释变量总体上对无影响。

多元线性回归模型常见问题及解决方法

特点

03

04

05

适用于多个自变量对因 变量的影响研究;

适用于线性关系假设下 的数据;

可通过参数估计和模型 检验来评估模型的可靠 性和预测能力。

多元线性回归模型的应用场景

经济预测

用于预测股票价格、GDP等经济指标;

市场营销

用于分析消费者行为、预测销售额等;

医学研究

用于分析疾病风险因素、预测疾病发 病率等;

自相关问题

残差序列之间存在相关性,违 反了线性回归模型的独立性假 设。

异常值和离群点问题

异常值和离群点对回归模型的 拟合和预测精度产生影响。

解决方法的总结与评价

01

02

03

04

05

多重共线性的解 决方法

异方差性的解决 方法

自相关问题的解 决方法

解释变量的选择 异常值和离群点

方法

处理方法

如逐步回归、主成分回归 、岭回归和套索回归等。 这些方法在处理多重共线 性问题时各有优缺点,需 要根据具体问题和数据特 点选择合适的方法。

2. 稳健标准误

使用稳健标准误来纠正异方差性 对模型估计的影响。

总结词

异方差性是指模型残差在不同观 测点上的方差不相等,导致模型 估计失真。

3. 模型诊断检验

使用如White检验、BP检验等异 方差性检验方法来诊断异方差性 问题。

自相关问题

01

02

03

04

05

总结词

详细描述

1. 差分法

2. 广义最小二乘 3. 自相关图和偏

详细描述

例如,在时间序列数据中,如果一个观测值的残差 与前一个观测值的残差正相关,则会导致模型的预 测精度降低。

解决方法

多元回归分析:估计

更多关于R2

考虑从一个解释变量开始,然后加入第二个。 OLS性质:最小化残差平方和。 如果OLS恰好使第二个解释变量系数取零,那

么不管回归是否加入此解释变量,SSR相同。 如果OLS使此解释变量取任何非零系数,那么

加入此变量之后,SSR降低了。 实际操作中,被估计系数精确取零是极其罕见

的,所以,当加入一个新解释变量后,一般来 说,SSR会降低。

那么所有系数的OLS估计量都有偏。

4

更一般的情形

假设总体模型

• 满足假定MLR.1~MLR.4。但我们遗漏了 变量x3,并估计了模型

• 假设X2和X3无关, X1和X3相关。 • 是β1的一个有偏估计量,但 是否有偏

?

更一般的情形

此时,我们通常假设X1和X2无关。

当X1和X2无关时,可以证明:

差项u的条件方差都是一样的。

▪ 如果这个假定不成立,我们说模型存在异方

差性。

OLS估计量的方差(续)

用x表示(x1, x2,…xk)

假定Var(u|x) = s2,也就意味着Var(y| x) = s2

假定MLR.1-5共同被称为高斯-马尔可夫假定 (Gauss-Markov assumptions)

效应) OLS的性质 什么时候简单回归和多元回归的估计值

相同 OLS的无偏性

多元回归分析:估计(2) Multiple Regression Analysis: Estimation

(2)

y = b0 + b1x1 + b2x2 + . . . bkxk + u

1

本章大纲

使用多元回归的动因 普通最小二乘法的操作和解释 OLS估计量的期望值 OLS估计量的方差 OLS的有效性:高斯-马尔科夫定理

多元线性回归分析

多元线性回归分析多元线性回归分析是一种常用的统计方法,用于研究多个自变量与因变量之间的关系。

它可以帮助我们理解多个因素对于一个目标变量的影响程度,同时也可以用于预测和解释因变量的变化。

本文将介绍多元线性回归的原理、应用和解读结果的方法。

在多元线性回归分析中,我们假设因变量与自变量之间存在线性关系。

具体而言,我们假设因变量是自变量的线性组合,加上一个误差项。

通过最小二乘法可以求得最佳拟合直线,从而获得自变量对因变量的影响。

多元线性回归分析的第一步是建立模型。

我们需要选择一个合适的因变量和若干个自变量,从而构建一个多元线性回归模型。

在选择自变量时,我们可以通过领域知识、经验和统计方法来确定。

同时,我们还需要确保自变量之间没有高度相关性,以避免多重共线性问题。

建立好模型之后,我们需要对数据进行拟合,从而确定回归系数。

回归系数代表了自变量对因变量的影响大小和方向。

通过最小二乘法可以求得使残差平方和最小的回归系数。

拟合好模型之后,我们还需要进行模型检验,以评估模型拟合的好坏。

模型检验包括对回归方程的显著性检验和对模型的拟合程度进行评估。

回归方程的显著性检验可以通过F检验来完成,判断回归方程是否显著。

而对模型的拟合程度进行评估可以通过判断决定系数R-squared的大小来完成。

解读多元线性回归结果时,首先需要看回归方程的显著性检验结果。

如果回归方程显著,说明至少一个自变量对因变量的影响是显著的。

接下来,可以观察回归系数的符号和大小,从中判断自变量对因变量的影响方向和相对大小。

此外,还可以通过计算标准化回归系数来比较不同自变量对因变量的相对重要性。

标准化回归系数表示自变量单位变化对因变量的单位变化的影响程度,可用于比较不同变量的重要性。

另外,决定系数R-squared可以用来评估模型对观测数据的拟合程度。

R-squared的取值范围在0到1之间,越接近1说明模型对数据的拟合越好。

但需要注意的是,R-squared并不能反映因果关系和预测能力。

多元回归分析

多元回归分析在经济学、社会学、心理学、医学等领域的实证研究中,多元回归分析是一种重要的统计方法。

它能够帮助研究者建立模型,估计各个变量的影响力,并对研究问题作出预测。

本文将介绍多元回归分析的概念、基本假设、模型建立、参数估计、模型诊断和解释结果等方面。

一、概念多元回归分析是一种用来研究因变量与多个自变量之间关系的统计方法。

在多元回归分析中,我们以因变量为被解释变量,以自变量为解释变量,建立一个多元线性回归模型,然后用样本数据估计各个系数,进而对总体进行推断。

通常,我们所研究的因变量与自变量之间是存在着某种联系的。

这种联系可以是线性关系,也可以是非线性关系。

我们可以通过多元回归模型来表达和解释完整的联系。

二、基本假设在进行多元回归分析时,我们需要基于以下三个基本假设:1.线性假设:多元回归模型中,因变量与自变量之间的关系是线性的。

2.独立假设:所有观测量之间都是相互独立的。

3.常态假设:模型的误差项服从正态分布。

三、模型建立建立一个多元回归模型通常有以下几个步骤:1.选择自变量:确定那些自变量对目标变量具有影响。

2.确定函数形式:使用线性函数或者非线性函数建立多元回归模型。

3.估计参数:使用样本数据来估计函数中的系数。

4.模型检验:验证模型是否可以拟合样本数据以及是否可以推广到总体。

五、参数估计在确定自变量和函数形式之后,我们需要使用已有数据来估计模型中的系数。

在多元线性回归中,一般采用最小二乘法对模型中的系数进行估计。

最小二乘法会尝试选择一组系数,使得用这组系数确定的模型与观测值之间的残差平方和最小。

残差平方和表示由于模型和观测值之间的差异而产生的差异的度量。

六、模型诊断模型的诊断是一个非常重要的步骤,用于检查多元回归模型的各种假设是否得到满足。

模型诊断的两个步骤:1.检查多元回归模型的基本假设是否得到满足。

这包括线性假设、独立假设和常态假设。

2.分析模型的残差以检查模型是否存在某种偏差。

如果存在偏差,可能会导致模型不准确,预测不可信。

3计量经济学(多元回归分析估计)

拟合优度

• 拟合优度:样本方差中被OLS回归线所解释的部分。

n

R2

( yˆ

y)

(y

y)

i 1

n

i 1

n

(y

i 1

i

y)

i

i

2

n

uˆ

2

1

2

i 1

n

(y

i

i 1

n

( yˆ

i 1

i

y)

2

2

i

y )2

n

uˆ

i 1

2

i

• 拟合优度介于0和1之间。

– 无论模型中包含了多少解释变量,总有一些因

素无法被包括进来,所有这些因素就包括在了

误差项中。

– 线性是指回归方程是诸参数的线性函数。

– 参数的解释,例4:

log( salary ) 0 1 log sales 2 ceoten 3ceoten 2 u

•

1

是其他条件不变的情况下薪水对销售量的弹性。

ˆ

0

i 1

i 1

n

n

L

2 xim rˆij 0 xim rˆij 0, m j

ˆ m

i 1

i 1

n

n

x rˆ (ˆ

ij ij

i 1

i 1

0

ˆ1 xi1 ˆ j 1 xi , j 1 ˆ j 1 xi , j 1 ˆ k xik rˆij )rˆij

Ƹ 是样本自变量的函数,因此

rˆ y

rˆ u

i n

ˆ j

n

第三章多元线性回归模型

( k + 1 )×1

1 2 μ= M n n ×1

用来估计总体回归函数的样本回归函数 : 样本回归函数为: 样本回归函数

Yi = β 0 + β1 X1i + β 2 X 2i + L+ β ki X ki

样本观测值: 样本观测值:

Yi = β0 +β1X1i +β2 X2i +L+βkiXki +ei

b10、 β1的经济涵义、先验符号?

例1 “期望扩充”菲利普斯曲线

估计结果

原始菲利普斯曲线

yt = 6.127172+ 0.244934x1t se : 4.285283 0.630456 t : 1.429817 0.388502 p : 0.180552 0.705058 R2 = 0.013536 F = 0.150934 p( F ) = 0.705058

1i 2 i 2 1i

2 2i

对有k 对有k个解释变量的多元回归模型

, 对于随机抽取的n组观测值 (Yi , X ji ),i =1,2,L n, j = 0,1,2,Lk

如果样本函数 样本函数的参数估计值已经得到,则有: 样本函数

Yi = β 0 + β 1 X 1i + β 2 X 2i + L + β ki X Ki

n n

n

i=1,2…n

2

Q = ∑ei2 = ∑(Yi Yi )2 = ∑(Yi (β0 + β1X1i + β2 X2i +L+ βk Xki ))

i =1 i=1

i=1

根据最小二乘原理 最小二乘原理, 最小二乘原理 参数估计值应该是右列 方程组的解

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第三节 多元判定系数R2与复相关系数R

在双变量的情形中我们曾看到, r2 是回归方程拟合优度的一个度量。 它给出在因变量Y的总变异种由(单一个)解释变量X解释了的比例或 百分比。 在三变量模型中,由X2 和X3 联合解释Y的变异的比例的数量称为复判 定系数(multiple coefficient of determination),记为R2 。(总平方和 TSS等于解释平方和ESS+残差平方和RSS),则

2020/4/5

2020/4/5

3. OLS估计量的性质

多元回归模型的OLS估计量和双变量模型的OLS有着平行的性质。

(1)三变量回归线(面)通过均值

这个性质可以推广到一

般情形,在k变量线性回归模型(一个回归子和(k-1)个回归元)中:

我们有:

(2)估计的Yi的均值等于真实Yi的均值。 两边对所有样本值求和并 除以样本大小n,由于

三、对多元回归方程的解释

给定经典回归模型的诸假定,那么,在(7.1.1)的两边对Y求条 件期望得:

(7.2.1)

该式给出以变量X2 和X3 的固定值的条件的Y的条件均值或期望值。

因此,如同双变量情形那样,多元回归分析是以多个解释变量的 固定值为条件的回归分析,并且我们所获取的,是给定回归元值 时Y的平均值或Y的平均响应。

第七章 多元回归分析:估计问题

◆对多元回归方程的解释 ◆偏回归系数的含义与估计 ◆多元判定系数R2与复相关系数R ◆从多元回归的角度看简单回归 ◆R2及校正R2 ◆多项式回归模型

第一节 对多元回归方程的解释

一、三变量模型:符号与假定

将双变量的总体回归模型推广,便可写出三变量PRF为: (7.1.1)

二、偏回归系数的OLS估计 1. OLS估计量

与(7.1.1)的 PRF相对应的样本回归函数如下: OLS方法 是要选择未知参数的值,使残差平方和RSS尽可能小,即:

将该式对三个未知数求偏导数,并令其为零,解得:

由上述正规方程组可以得到β1、β2 和β3 的OLS估计量: 小写字母表示对样本均值离差的惯例。

如果仅当

时成立,则说X2 和X3 线性独立。

无多重共线性

假设(7.1.1)中的Y、 X2 和X3 分别代表消费支出、收入 和财富,经济理论设想收入和财富对消费各有独立影响。 若收入和财富之间有线性关系,则无从区分各自的影响了。

令

,则(7.1.1)变成:

给出的是X2 和X3 对Y的联合影响。没有办法

分别估计X2 的单独影响和X3 的单独影响。

二、多元线性回归模型的基本假设

(1)ui 有零均值,或: (2)无序列相关,或: (3)同方差性,或:

(7.1.2) (7.1.3) (7.1.4)

(4)ui与每一X变量之间都有零协方差,或:

(5)无设定偏误,或:模型被正确地设定 (6)X诸变量间无精确的共线性,或:

X2 和X3 之间无精确的线性关系

建立模型为:

(7.6.1)

Dependent Variable: CM

Method: Least Squares

Date: 02/18/12 Time: 14:22

Sample: 1 64

Included observations: 64

Variable

Coefficient

C

263.6416

PGNP

即得:

(3) 由于 (4)残差 与

,两边对样本值求和可得。 和 都不相关,即

(5)残差 与 不相关,即

。

两边同时乘以 ,然后对样本值求和。

(6)在7.1节的经典线性模型的假定下,可以证明偏回归系数的OLS估计量 不仅是线性和无偏的,而且在所有线性无偏估计量类中有最小方差。简言 之,它们是BLUE。或它们满足高斯-马尔可夫定理。

-0.00565

FLR

-2.23159

R-squared

0.707665

Adjusted R-squared

0.698081

S.E. of regression

41.7478

Sum squared resid

106315.6

(7.1.5) (7.1.6)

(7.1.7)

假设(7.1.6)中 X2 和X3之间无精确的线性关系,称为无共线性 (no collinearity)或无多重共线性(no multicollinearity)。

无共线性 不存在一关系式存在,则说X2 和X3 是共线的或线性相关。

第二节 偏回归系数的含义与估计

一、偏回归系数的含义

前面指出,系数β2 和β3 称为偏回归(partial regression)系数。 其含义如下: β2 度量着在X3 保持不变的情况下,X2 每变化一 单位,Y的均值E(Y| X2 ,X3 )的变化。 换句话说, β2 给出保持X3 不变时E(Y| X2 ,X3 )对X2 的斜率。

R2 越靠近1,模型的“拟合”越好。

例7.1 儿童死亡率与人均GNP和妇女识字率的关系

Table 6.4 64个国家的生育率及其他数据 CM = child mortality(儿童死亡率)

CM为每1000名产婴中不足5岁便死亡的人数 FLR = female literacy rate(妇女识字率) PGNP = per capita GNP in 1980(1980年的人均GNP) TFR = total fertility rate(总生育率)

其中Y是因变量,X2 和X3 是解释变量,u 是随机干扰项,而 i 指第i次 观测。当数据为时间序列时,下标t将用来指第i次观测。

在上述方程中β1 是截距项,它代表X2 和X3 均为零时Y的均值,如通 常所说,它给出了所有未包含到模型中来的变量对Y的平均影响。系 数β2 和β3 称为偏回归系数(partial regression coefficients)。

2.OLS估计量的方差和标准误

我们计算标准误有两个目的:建立置信区间和检验统计假设。

在上述公式中σ2 是总体干扰项 ui的方差。

可以证实, σ2 的一个无偏估计量是:

现在的自由度是(n-3),这是因为在估计 之前,我们必须先 估计β1 ,β2 和β3 ,从而消耗了3个自由度。 一旦算出残差ui ,就能从该式算出估计量σ2 。