神经网络源程序(二)ART1

人工神经网络基础与应用-幻灯片(1)

4.4.2 根据连接方式和信息流向分类

反馈网络

y1 y2 ... y n 特点

仅在输出层到输入层存在反 馈,即每一个输入节点都有 可能接受来自外部的输入和 来自输出神经元的反馈,故 可用来存储某种模式序列。

应用

x 1 x 2 .... xn

神经认知机,动态时间序列 过程的神经网络建模

25

4.4.2 根据连接方式和信息流向分类

w ij : 从ui到xj的连接权值(注意其下标与方向);

s i : 外部输入信号;

y i : 神经元的输出

18

4.3.2 人工神经元的激励函数

阈值型 f 1 0

分段线性型

f

f max k

f

Neit10

Nei t0 Nei t0

Net i

0

0NietNie0 t

fNiet kNietNie0tNie0tNietNi1 et

典型网络

回归神经网络(RNN)

x 1 x 2 .... xn

27

第4.5节 人工神经网络的学习

连接权的确定方法: (1)根据具体要求,直接计算出来,如Hopfield网络作 优化计算时就属于这种情况。 (2)通过学习得到的,大多数人工神经网络都用这种方 法。

学习实质: 针对一组给定输入Xp (p=1,2,…, N ),通过学习使网络动态 改变权值,从而使其产生相应的期望输出Yd的过程。

树 突

细胞核 突

触

细胞膜 细胞体

轴 突

来自其 它细胞 轴突的 神经末 稍

神经末稍

11

4.2.1 生物神经元的结构

突触:是神经元之间的连接 接口。一个神经元,通过其 轴突的神经末梢,经突触与 另一个神经元的树突连接, 以实现信息的传递。

基于ART1人工神经网络的数据聚类

Z UO o g , TA M i g fT L n N n - e

{. 1 中国 国防 科技信 息 中心 .北京 103 ;2 00 6 .国防科技 大学 计算 机学 院 ,湖 南 长 沙

f . hn e neSi c n eh oo yIfr t nC ne ,B i 喀 10 3 ; 1C iaD f s c nea dT c n l noma o e tr e h 00 6 e e g i j 2 Sh o f o ue c n 。N t n l nvri f  ̄ es eh o g" Ch n sa 10 3 C  ̄ l .c o l mp trSi c oC ee aia iesy 0 neT cn l y o U t I o , a gh 0 7 , h a 4 摘 要 :本文 对教据 聚类进 行 了研 究 ,提 出 了一种 利 用  ̄t 1 工神 经 网络的数 据 聚 类 方 法的结 MT 人

9 2

维普资讯

是 数 据库 、人 工 智能 、数 理统 计 、可 视化 、并 行

接 。该 网 络 结 构 还 包 括 三 个 附 加 模 块 ,即增 益

计算等方面的学者和工程技术人员。

利用 D ( D )技术 可以完成多项决 策所 M KD

需 任务 ,大致 可 分为下 述 几方 面 :()预测 :从 J

据的能力大幅度提高,千万个数据 等 ,这 一趋

势仍将持续发展下去 。因此 ,信息过量几乎成 为人 人需要 面对 的 问题 。如 何从 中及 时发现 有用 的知

数据分析 、数据融合 ( a ui )以及决策支 Dt Fs n a o 持等 。人 们把 原 始数 据 看 作 是形 成知 识 的源 泉 , 就像 从矿 石 中采矿 一样 。原 始 数据 可 以是 结构 化 的,如关系数据库中的数据 ;也可以是半结构化 的 ,如文本 、图形 、图像数据 ;甚至是分布在网 络 上 的异构 型数据 。发现 知识 的方 法可 以是数 学 的 ,也 可 以是非 数学 的 ;可 以是 演绎 的 ,也 可 以 是归纳的。发现 了的知识可 以被用于信息管理 、 查询优化 、决策支持 、过程控制等 ,还可以用于 数据 自 身的维护。因此 , 数据挖掘是一门很广义 的交叉 学科 ,它 汇 聚了不 同领域 的研 究者 ,尤其

基于ART1神经网络的统计过程控制系统

A a y Con r y t Qu l i t tolS s em s d On AR Ba e TI Ne lNe w or ur t a k

s N X e ig L U F i U u- n . I e j

( u m tnIste Suhm Y nt n esy Wui 112 C ia A t ao tu , ote ag eU i rt, x 242 , hn) o i nit z v i

孙 学静 ,刘 飞

无锡 24 2 ) 112 ( 江南大学 汁过 ]J (I: 改 进 过 水 I提 禹 产 质 } 统 -r 制 S ( : i1  ̄ ) 『、 ^

作 … J 人 献

小义 讨论 _ ・ r 种 丁 ¨遁 } 皆振 论 ( R ) A T 神 常, 埘 种 控 制 【惫 似 没 I 常 模 还 实 时,: 、 、 住

l 引 言

Se hr控制 图利 用控 制 界限 判断 过 程是 否发 生 异 常 , hw at 这

种 方 法 对 于 较 大 幅度 的 异 常 过 程 变 动 很 灵 敏 。不 足 的是 它 仅 利

式 自动识别的方法被用来 解决控 制 图难 以解 释的 问题 , 免完 避 全依赖训练有数 的质量人员才能 正确解 释 、 分析控制 图 , 而神经

泛 作 为 ・ 新 的 SC 1 , R 1 经 络 为 改进 控 制 _l 『 提 供 r ・ 种 P . A T 冲 j 卫的 } j 种新 的 能 叮 关键 词 :P ;质 { 制 ; . T ;fI 『 ;控 制 ;十 l SC 控  ̄ 1 I 叫络 R f I ! 别 t 分 类 : I8 文献 f l : i t r 13 ) , 】 义 编 i :10 —2 12o )500 —3 0374 (o6 0 — 1 7 1 0 0

神经网络的基本原理与使用教程

神经网络的基本原理与使用教程神经网络是一种模拟人脑神经元之间相互连接的计算模型,它具备学习和自适应的能力,被广泛应用于图像识别、自然语言处理、智能推荐等领域。

本文将介绍神经网络的基本原理和使用教程,帮助读者更好地理解和应用这一强大的工具。

一、神经网络的基本原理神经网络由输入层、隐藏层和输出层组成。

输入层接收外部输入数据,隐藏层进行信息处理和特征提取,输出层产生最终的结果。

每个神经元接收来自上一层神经元的输入,并通过激活函数进行非线性转换,将结果传递给下一层神经元。

在神经网络中,最常用的激活函数是Sigmoid函数和ReLU函数。

Sigmoid函数将输入值映射到0到1之间的概率值,适用于输出层的二分类问题。

ReLU函数在输入大于0时输出输入值,小于0时输出0,适用于隐藏层的非线性变换。

神经网络的训练过程通过反向传播算法实现。

首先,随机初始化神经网络的权重和偏置。

然后,将输入数据送入神经网络,计算输出结果。

接着,根据输出结果与真实标签之间的误差,通过梯度下降法更新权重和偏置,不断优化网络的性能。

重复这一过程直到收敛,即网络的输出与真实标签之间的误差达到可接受的范围。

二、神经网络的使用教程1. 数据预处理在使用神经网络之前,需要对输入数据进行预处理。

常见的预处理方法包括数据归一化、特征选择和数据增强。

数据归一化可以将输入数据缩放到0到1之间,提高神经网络的收敛速度和稳定性。

特征选择可以从原始数据中选择最具有代表性的特征,减少输入维度,提高网络的泛化能力。

数据增强可以通过旋转、平移、缩放等操作扩充数据集,增加样本的多样性,提高网络的鲁棒性。

2. 网络结构设计神经网络的结构设计是应用中的关键一步。

合理的网络结构可以提高网络的性能和效率。

常见的网络结构包括全连接神经网络、卷积神经网络和循环神经网络。

全连接神经网络适用于处理结构化数据,如表格数据和时间序列数据。

卷积神经网络适用于处理图像数据,通过卷积和池化操作提取图像的局部特征。

ART_example

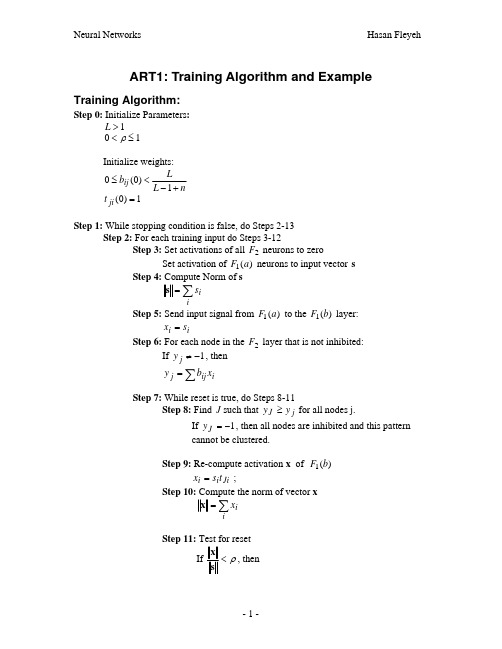

ART1: Training Algorithm and ExampleTraining Algorithm:Step 0: Initialize Parameters :1>L 10≤<ρInitialize weights: nL L b ij +−<≤1)0(0 1)0(=ji tStep 1: While stopping condition is false, do Steps 2-13Step 2: For each training input do Steps 3-12Step 3: Set activations of all 2F neurons to zeroSet activation of )(1a F neurons to input vector sStep 4: Compute Norm of s ∑=ii s sStep 5: Send input signal from )(1a F to the )(1b F layer:i i s x =Step 6: For each node in the 2F layer that is not inhibited:If 1−≠j y , then∑=i ij j x b yStep 7: While reset is true, do Steps 8-11Step 8: Find J such that j J y y ≥ for all nodes j.If 1−=J y , then all nodes are inhibited and this pattern cannot be clustered.Step 9: Re-compute activation x of )(1b FJi i i t s x = ;Step 10: Compute the norm of vector x∑=i i x xStep 11: Test for reset If ρ<sx , then1−=J y (inhibit node) J ( and continue executing Step 7 again) If ρ≥sx , then proceed to Step 12Step 12: Update the weights for node J (fast learning)x +−=1)(L Lx new b i iJ i Ji x new t =)(Step 13: Test for stopping condition. Comments:• Step 3 removes all inhibitions from the previous learning trail (presented of a pattern)• Setting 1−=j y for an inhibited node (in Step 6) will prevent that node from being a winner. Since all weights and signals in the net are nonnegative a unit with a negative activation can never have the largest activation.• In Step 8, take J to be the smallest such index.• In Step 9, unit i x is ON only if it receives both an external signal i s and a signal sent down from 2F to 1F , Ji t .• The Stopping conditions in Step 13 might consist of any of the following:o No weight changeso No unit reseto Maximum number of epochs reached.Parameters:Example:Use ART1 Algorithm to cluster the vectors(1, 1, 0, 0)(0, 0, 0, 1)(1, 0, 0, 0)(0, 0, 1, 1)Values of parameters used in this example are:Number of components in the input vector 4=nMaximum number of clusters to be formed 3=mVigilance Parameter 4.0=ρParameter used to update of bottom-up weights 2=L Initial bottom-up weights (0ne-half of the maximum value allowed) nb ij +=11)0( Initial top-down weights 1)0(=ji tStep 0: Initialize Parameters :2=L4.0=ρInitialize weights: 2.041111)0(=+=+=n b ij 1)0(=ji t Since i is the current neuron in the 1F layer and number of components in the input vector 4=n then 41≤≤i .Since j is the current neuron in the 2F layer and max number of classes in this layer is 3=m then 31≤≤j .Hence:)0(ij b is a 4x3 matrix in which the rows represent the nodes in the 1F layer and the columns are nodes in 2F layer)0(ji t is a 3x4 matrix in which the rows represent the nodes in the 2F layer and the columns are nodes in 1F layer.⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=2.02.02.02.02.02.02.02.02.02.02.02.0)0(ij b ⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=111111111111)0(ji tStep 1: Begin computationStep 2: For the first input vector, (1, 1, 0, 0) do Steps 3-12 Step 3: Set activations of all 2F neurons to zeroSet activation of input neurons to input vector )0,0,1,1(=s Step 4: Compute Norm of s2=sStep 5: Compute activations for each node in 1F layer:)0,0,1,1(=xStep 6: Compute net input to each node in the 2F layer:4.0)0(2.0)0(2.0)1(2.0)1(2.01=+++=y4.0)0(2.0)0(2.0)1(2.0)1(2.02=+++=y4.0)0(2.0)0(2.0)1(2.0)1(2.03=+++=yStep 7: While reset is true. Do Steps 8-11Step 8: since the units have the same net input1=JStep 9: Re-compute the 1F activitiesi i i t s x 1= ; currently )1,1,1,1(1=t therefore )0,0,1,1(=xStep 10: Compute the norm of x2=xStep 11: test for reset4.00.1≥=s xTherefore, reset is false Proceed to step 12Step 12: Update 1b ; for 2=L , the equilibrium weights are x+=12)(1i i x new b Therefore, the bottom-up weight matrix becomes⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡2.02.002.02.002.02.067.02.02.067.0Update 1t ; the fast learning weight values arei J x new t =)(1Therefore, the top-down weight matrix becomes⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡111111110011Step 2: For the second input vector, (0, 0, 0, 1) do Steps 3-12Step 3: Set activations of all 2F neurons to zeroSet activation of input neurons to input vector )1,0,0,0(=sStep 4: Compute Norm of s1=sStep 5: Compute activations for each node in 1F layer:)1,0,0,0(=xStep 6: Compute net input to each node in the 2F layer:0)1(0)0(0)0(67.0)0(67.01=+++=y2.0)1(2.0)0(2.0)0(2.0)0(2.02=+++=y2.0)1(2.0)0(2.0)0(2.0)0(2.03=+++=yStep 7: While reset is true. Do Steps 8-11Step 8: since units 2Y and 3Y have the same net input2=JStep 9: Re-compute the 1F activitiesi i i t s x 2= ; currently )1,1,1,1(2=t therefore )1,0,0,0(=xStep 10: Compute the norm of x1=xStep 11: test for reset4.00.1≥=s xTherefore, reset is false Proceed to step 12 Step 12: Update 2b ; the bottom-up weight matrix becomes⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡2.0102.0002.0067.02.0067.0Update 2t ; the top-down weight matrix becomes⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡111110000011Step 2: For the third input vector, (1, 0, 0, 0) do Steps 3-12Step 3: Set activations of all 2F neurons to zeroSet activation of input neurons to input vector )0,0,0,1(=s Step 4: Compute Norm of s1=sStep 5: Compute activations for each node in 1F layer:)0,0,0,1(=xStep 6: Compute net input to each node in the 2F layer:67.0)0(0)0(0)0(67.0)1(67.01=+++=y0)0(1)0(0)0(0)1(02=+++=y2.0)0(2.0)0(2.0)0(2.0)1(2.03=+++=yStep 7: While reset is true. Do Steps 8-11Step 8: since unit 1Y has the largest net input1=JStep 9: Re-compute the 1F activitiesi i i t s x 1= ; currently )0,0,1,1(1=t therefore )0,0,0,1(=xStep 10: Compute the norm of x1=xStep 11: Test for reset0.1=s xProceed to step 12 Step 12: Update 1b ; the bottom-up weight matrix becomes⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡2.0102.0002.0002.001Update 1t ; the top-down weight matrix becomes⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡111110000001Step 2: For the fourth input vector, (0, 0, 1, 1) do Steps 3-12Step 3: Set activations of all 2F neurons to zeroSet activation of input neurons to input vector )1,1,0,0(=s Step 4: Compute Norm of s2=sStep 5: Compute activations for each node in 1F layer:)1,1,0,0(=xStep 6: Compute net input to each node in the 2F layer:0)1(0)1(0)0(0)0(11=+++=y0.1)1(1)1(0)0(0)0(02=+++=y4.0)1(2.0)1(2.0)0(2.0)1(2.03=+++=yStep 7: While reset is true. Do Steps 8-11Step 8: since unit 2Y has the largest net input2=JStep 9: Re-compute the 1F activitiesi i i t s x 2= ; currently )1,0,0,0(2=t therefore )1,0,0,0(=xStep 10: Compute the norm of x1=xStep 11: Test for reset4.05.0≥=s xTherefore, reset is false and Proceed to step 12Step 12: Update 2b ; the bottom-up weight matrix becomes (no change)⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡2.0102.0002.0002.001Update 1t ; the top-down weight matrix becomes (no change)⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡111110000001Step13: Test stopping conditionThis completes one epoch of training。

ART神经网络

自适应共振理论ART(Adaptive Resonance Theory)模型是美国Boston大学的S.Grossberg和A.Carpenet在1976年提出的。

ART是一种自组织神经网络结构,是无教师的学习网络。

当在神经网络和环境有交互作用时,对环境信息的编码会自发地在神经网中产生,则认为神经网络在进行自组织活动。

ART 就是这样一种能自组织地产生对环境认识编码的神经网络理论模型。

ART神经网络源程序:/***************************************************************************** ** ADAPTIVE RESONANCE THEORY (ART) NETWORK ** ******************************************************************************/#include <stdio.h>#include <stdlib.h>#include <string.h>#include <conio.h>#include <math.h>// DEFINES#define MAXCNEURONS 75 // MAX COMPARISON LAYER NEURONS#define MAXRNEURONS 30 // MAX RECOGNITION LAYER NEURONS#define MAXPATTERNS 30 // MAX NUMBER OF PATTERNS IN A TRAINING SET#define VERBOSE 1class ARTNET{private:double Wb[MAXCNEURONS][MAXRNEURONS]; // Bottom up weight matrixint Wt[MAXRNEURONS][MAXCNEURONS]; // Top down weight matrixint InData[MAXPATTERNS][MAXCNEURONS];// Array of input vectors to be// presented to the networkint NumPatterns; // Number of input patternsdouble VigilThresh; // Vigilence threshold valuedouble L; // ART training const (see text)int M; // # of neurons in C-layerint N; // # of neurons in R-layerint XVect[MAXCNEURONS]; // Current in vect at C-layer.int CVect[MAXCNEURONS]; // Output vector from C-layerint BestNeuron; // Current best R-layer Neuronint Reset; // Active when vigilence has// disabled someoneint RVect[MAXCNEURONS]; // Output vector from R-layerint PVect[MAXCNEURONS]; // WeightedOutput vector from R-layer int Disabled[MAXRNEURONS]; // Resets way of disqualifying neurons int Trained[MAXRNEURONS]; // To identify allocated R-Neurons void ClearPvect();void ClearDisabled();void RecoPhase(); // Recognition phasevoid CompPhase(); // Comparison phasevoid SearchPhase(); // Search Phasevoid RunCompLayer(); // Calc comparison layer by 2/3 rulevoid RunRecoLayer(); // Calc recognition layers R-vectvoid Rvect2Pvect(int); // Distribute winners resultint Gain1(); // Comp layer gainint Gain2(); // Reco layer gaindouble Vigilence(); // Calc vigilence metricvoid InitWeights(); // Initialize weightsvoid Train(); // Weight adjustment is done herepublic:ARTNET(void); // Constructor/initializationsint LoadInVects(char *Fname); // load all data vectorsvoid Run(int i); // Run net w/ ith patternvoid ShowWeights(); // display top down and// bottom up weightsvoid ShowInVect(); // Display current input patternvoid ShowOutVect(); // P-vector from Reco layer(see text)};// ------------------------------------------------------------------------// METHOD DEFINITIONSARTNET::ARTNET(){int i;L=2.0;N=MAXRNEURONS;for (i=0; i<N; i++) { //Set all neurons to untrained and enabled Trained[i]=0;Disabled[i]=0;} /* endfor */}int ARTNET::LoadInVects(char *Fname){FILE *PFILE;int i,j,k;PFILE = fopen(Fname,"r");if (PFILE==NULL){printf("\nUnable to open file %s\n",Fname);exit(0);}fscanf(PFILE,"%d",&NumPatterns); //How many patternsfscanf(PFILE,"%d",&M); //get width of input vectorfscanf(PFILE,"%lf",&VigilThresh);for (i=0; i<NumPatterns; i++) {for (j=0; j<M; j++) {fscanf(PFILE,"%d",&k); //Read all the pattern data and...InData[i][j]=k; // ...save it for later.} /* endfor */} /* endfor */InitWeights();return NumPatterns;}int ARTNET::Gain2(){int i;for (i=0; i<M; i++) {if (XVect[i]==1)return 1;} /* endfor */}void ARTNET::Rvect2Pvect(int best){ int i;for (i=0; i<M; i++) {PVect[i]= Wt[best][i];} /* endfor */}int ARTNET::Gain1(){int i,G;G=Gain2();for (i=0; i<M; i++) {if (RVect[i]==1)return 0;} /* endfor */return G;}void ARTNET::RunCompLayer(){ int i,x;for (i=0; i<M; i++) {x=XVect[i]+Gain1()+PVect[i];if (x>=2) {CVect[i]=1;}else {CVect[i]=0;} /* endif */} /* endfor */}int i;double S,K,D;// count # of 1's in p-vect & x-vectK=0.0;D=0.0;for (i=0; i<M; i++) {K+=CVect[i];D+=XVect[i];} /* endfor */S=K/D;return S;}void ARTNET::RunRecoLayer(){int i,j,k;double Net[MAXRNEURONS];int BestNeruon=-1;double NetMax=-1;for (i=0; i<N; i++) { //Traverse all R-layer NeuronsNet[i]=0;for (j=0; j<M; j++) { // Do the productNet[i] +=Wb[i][j]*CVect[j];} /* endfor */if ((Net[i]>NetMax) && (Disabled[i]==0)) { //disabled neurons cant win!BestNeuron=i;NetMax=Net[i];}} /* endfor */for (k=0; k<N; k++) {if (k==BestNeuron)RVect[k]=1; // Winner gets 1elseRVect[k]=0; // lateral inhibition kills the rest} /* endfor */}int i;//First force all R-layer outputs to zerofor (i=0; i<N; i++) {RVect[i]=0;} /* endfor */for (i=0; i<M; i++) {PVect[i]=0;} /* endfor *///Now Calculate C-layer outputsRunCompLayer(); //C-vector now has the resultRunRecoLayer(); //Calc dot prod w/ bot up weight & CRvect2Pvect(BestNeuron);}void ARTNET::CompPhase(){double S;RunCompLayer(); //Cvector<-dif between x & pS=Vigilence();if (S<VigilThresh){Reset=1;RVect[BestNeuron]=0;Disabled[BestNeuron]=1;}elseReset=0;}void ARTNET::SearchPhase(){double S;while (Reset) {ClearPvect();RunCompLayer(); //Xvect -> CvectRunRecoLayer(); //Find a new winner with prev winners disabled Rvect2Pvect(BestNeuron); //new pvect based on new winnerS=Vigilence(); //calc vigilence for the new guyif (S<VigilThresh){ //check if he did okReset=1; // if not disable him tooRVect[BestNeuron]=0;Disabled[BestNeuron]=1;}elseReset=0; //Current Best neuron is a good winner...Train him } /* endwhile */if (BestNeuron!=-1) {Train();}else {//Failed to allocate a neuron for current pattern.printf("Out of neurons in F2\n");} /* endif */ClearDisabled();}void ARTNET::ClearDisabled() { int i;for (i=0; i<M; i++) {Disabled[i]=0;} /* endfor */}void ARTNET::ClearPvect() { int i;for (i=0; i<M; i++) {PVect[i]=0;} /* endfor */}void ARTNET::Train(){int i,z=0;for (i=0; i<M; i++) {z+=CVect[i];} /* endfor */for (i=0; i<M; i++) {Wb[BestNeuron][i]=L*CVect[i]/(L-1+z);Wt[BestNeuron][i]=CVect[i];} /* endfor */Trained[BestNeuron]=1;}void ARTNET::Run(int tp){int i,j;ClearPvect();for (i=0; i<M; i++) {XVect[i]=InData[tp][i];} /* endfor */RecoPhase();CompPhase();SearchPhase();}void ARTNET::InitWeights(){ // Initialize weights int i,j;double b;for (i=0; i<N; i++) { // from R-neuron i for (j=0; j<M; j++) { // to C-neuron jWt[i][j]= 1; // All init'd to 1} /* endfor */} /* endfor */b=L/(L-1+M);for (i=0; i<N; i++) { // from C-neuron i for (j=0; j<M; j++) { // to R-neuron jWb[i][j]= b;} /* endfor */} /* endfor */}void ARTNET::ShowWeights(){int i,j;printf("\nTop Down weights:\n");for (i=0; i<N; i++) {if(Trained[i]==1){for (j=0; j<M; j++) {printf("%d ",Wt[i][j]);} /* endfor */printf("\n");} /* endif */} /* endfor */printf("\nBottom up weights:\n");for (i=0; i<N; i++) {if(Trained[i]==1){for (j=0; j<M; j++) {printf("%f ",Wb[i][j]);} /* endfor */printf("\n");} /* endif */} /* endfor */}void ARTNET::ShowInVect(){int i;printf("BEST NEURON:%d\nIN: ",BestNeuron); for (i=0; i<M; i++) {printf("%d ",XVect[i]);} /* endfor */printf("\n");}void ARTNET::ShowOutVect(){int i;printf("OUT: ");for (i=0; i<M; i++) {printf("%d ",CVect[i]);} /* endfor */printf("\n");}// ------------------------------------------------------------------------ARTNET ART;/****************************************************************************** * MAIN *******************************************************************************/int main(int argc, char *argv[]){int TstSetSize;int i;if (argc>1) {TstSetSize=ART.LoadInVects(argv[1]);for (i=0; i<TstSetSize; i++) {ART.Run(i); //Evaluate ith test patternprintf("\n");ART.ShowInVect();ART.ShowOutVect();if (VERBOSE==1) ART.ShowWeights();} /* endfor */}else {printf("USAGE: ART PATTERN_FILE_NAME\n");exit(0);}return 0;}。

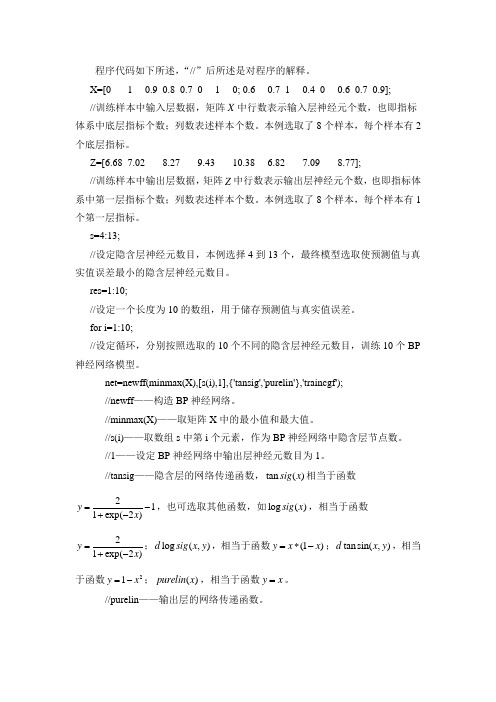

神经网络程序

程序代码如下所述,“//”后所述是对程序的解释。

X=[0 1 0.9 0.8 0.7 0 1 0; 0.6 0.7 1 0.4 0 0.6 0.7 0.9]; //训练样本中输入层数据,矩阵X 中行数表示输入层神经元个数,也即指标体系中底层指标个数;列数表述样本个数。

本例选取了8个样本,每个样本有2个底层指标。

Z=[6.68 7.02 8.27 9.43 10.38 6.82 7.09 8.77];//训练样本中输出层数据,矩阵Z 中行数表示输出层神经元个数,也即指标体系中第一层指标个数;列数表述样本个数。

本例选取了8个样本,每个样本有1个第一层指标。

s=4:13;//设定隐含层神经元数目,本例选择4到13个,最终模型选取使预测值与真实值误差最小的隐含层神经元数目。

res=1:10;//设定一个长度为10的数组,用于储存预测值与真实值误差。

for i=1:10;//设定循环,分别按照选取的10个不同的隐含层神经元数目,训练10个BP 神经网络模型。

net=newff(minmax(X),[s(i),1],{'tansig','purelin'},'traincgf');//newff ——构造BP 神经网络。

//minmax(X)——取矩阵X 中的最小值和最大值。

//s(i)——取数组s 中第i 个元素,作为BP 神经网络中隐含层节点数。

//1——设定BP 神经网络中输出层神经元数目为1。

//tansig ——隐含层的网络传递函数,tan ()sig x 相当于函数211exp(2)y x =-+-,也可选取其他函数,如log ()sig x ,相当于函数21exp(2)y x =+-;log (,)d sig x y ,相当于函数(1)y x x =*-;tan sin(,)d x y ,相当于函数21y x =-;()purelin x ,相当于函数y x =。

人工神经网络matlab源程序代码_光环大数据人工智能培训

人工神经网络matlab源程序代码_光环大数据人工智能培训人工神经网络matlab 源程序代码%产生指定类别的样本点,并在图中绘出X = [0 1; 0 1]; % 限制类中心的范围clusters = 5; % 指定类别数目points = 10; % 指定每一类的点的数目std_dev = 0.05; % 每一类的标准差P = nngenc(X,clusters,points,std_dev);plot(P(1,:),P(2,:),'+r');title('输入样本向量');xlabel('p(1)');ylabel('p(2)');%建立网络net=newc([0 1;0 1],5,0.1); %设置神经元数目为5%得到网络权值,并在图上绘出figure;plot(P(1,:),P(2,:),'+r');w=net.iw{1}hold on;plot(w(:,1),w(:,2),'ob');hold off;title('输入样本向量及初始权值');xlabel('p(1)');ylabel('p(2)');figure;plot(P(1,:),P(2,:),'+r');hold on;%训练网络net.trainParam.epochs=7;net=init(net);net=train(net,P);%得到训练后的网络权值,并在图上绘出w=net.iw{1}plot(w(:,1),w(:,2),'ob');hold off;title('输入样本向量及更新后的权值');xlabel('p(1)');ylabel('p(2)');a=0;p = [0.6 ;0.8];a=sim(net,p)-------------------example8_2%随机生成1000个二维向量,作为样本,并绘出其分布P = rands(2,1000);plot(P(1,:),P(2,:),'+r')title('初始随机样本点分布');xlabel('P(1)');ylabel('P(2)');%建立网络,得到初始权值net=newsom([0 1; 0 1],[5 6]);w1_init=net.iw{1,1}%绘出初始权值分布图figure;plotsom(w1_init,yers{1}.distances)%分别对不同的步长,训练网络,绘出相应的权值分布图for i=10:30:100net.trainParam.epochs=i;net=train(net,P);figure;plotsom(net.iw{1,1},yers{1}.distances)end%对于训练好的网络,选择特定的输入向量,得到网络的输出结果p=[0.5;0.3];a=0;a = sim(net,p)--------------------------example8_3%指定输入二维向量及其类别P = [-3 -2 -2 0 0 0 0 +2 +2 +3;0 +1 -1 +2 +1 -1 -2 +1 -1 0];C = [1 1 1 2 2 2 2 1 1 1];%将这些类别转换成学习向量量化网络使用的目标向量T = ind2vec(C)%用不同的颜色,绘出这些输入向量plotvec(P,C),title('输入二维向量');xlabel('P(1)');ylabel('P(2)');%建立网络net = newlvq(minmax(P),4,[.6 .4],0.1);%在同一幅图上绘出输入向量及初始权重向量figure;plotvec(P,C)hold onW1=net.iw{1};plot(W1(1,1),W1(1,2),'ow')title('输入以及权重向量');xlabel('P(1), W(1)');ylabel('P(2), W(2)');hold off;%训练网络,并再次绘出权重向量figure;plotvec(P,C);hold on;net.trainParam.epochs=150;net.trainParam.show=Inf;net=train(net,P,T);plotvec(net.iw{1}',vec2ind(net.lw{2}),'o');%对于一个特定的点,得到网络的输出p = [0.8; 0.3];a = vec2ind(sim(net,p))为什么大家选择光环大数据!大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请专业的大数据领域知名讲师,确保教学的整体质量与教学水准。

ART1神经网络在隧道围岩分类中的应用

慢、 局部极 小 非 全局 最 优 等 问题 。本文 将 自适 应

共 振 理 论 ( a tv Re o a c Th o y — — Ad p ie snne er

进行 识别 。在 识 别过 程 中 , 输 入 是 已记 忆 的或 若 与 已记忆 的模 式 十分 相 似 , 网络 会 把它 回想 出 则

具 有 非线 性 、 行 性 等 特 点 , 于 处理 具 有 强 噪 并 对 声、 模糊 性 、 线性 的地 质 体信 息 , 有广 泛 的 应 非 具

用前 景 。 目前 , 泛 应 用 的 神 经 网络 主 要 是 B 广 P 网 络 ; 是 , 典 的 B 神 经 网 络 存 在 收 敛 速 度 但 经 P

V 1 3 N . o. o5 3

(c .2 06 )t 0

20 0 6年 1 0月

[ 章 编 号 ]17 7 7 2 0 )50 5 —5 文 19 2 ( 0 60 4 50 6

A T R 1神 经 网络 在 隧 道 围岩 分 类 中 的应 用

李 天 斌 王 睿。

利 用 川 藏公 路 二 郎 山 隧道 围岩 分 类样 本 对模 型进 行 检 验 , 果 表 明 , T1神 经 网 络 模 型 性 能 I 结 AR

良好 , 隧 道 围岩 分 类 的精 度 较 高 , 一种 值 得 推 广 和 应 用 的 围 岩 智 能分 类 方 法 对 是 [ 键 词 ]AR 关 T1神经 网 络 ;围岩 分 类 ;隧道 [ 类 号 ]u 5 . 分 4 2 1 2 [ 献标 识码 ]A 文

来 。 如 果 是 没 有 记 忆 过 的 新 模 式 或 与 记 忆 过 的 模 式 差 别 很 大 , 在 不 影 响 原 有 记 忆 的 前 提 下 , 它 则 把 记 忆 下 来 , 用 一 个 没 有 用 过 的 输 出层 神 经 元 作 并

人工神经网络8ART神经网络ppt课件

络 运

G1=1。G1为1时允许输入模式直接从C层输出,并向前传至R 层,与

行 原

R 层节点对应的所有内星向量Bj 进行匹配计算:

理

n

net j

B

T j

X

bij xi

j=1,2,…,m

选择具有最大匹配度(即具有最i大1 点积)的竞争获胜节点:

net j*

max j

{net

j

}

使获胜节点输出

r j

*

=1,其它节点输出为0。

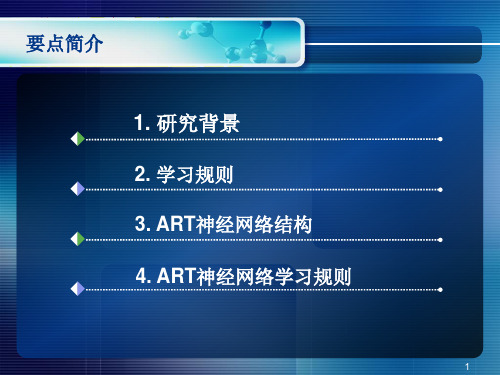

要点简介

1. 研究背景

2. 学习规则 3. ART神经网络结构 4. ART神经网络学习规则

1

研究背景

▪ 1969年,美国学者格诺斯博格(Grossberg)和卡普特

尔(Carperter)提出了自适应共振理论(ART)模型。

研究背景

▪ ART是一种自组织神经网络结构,是无教师的学

习网络。当在神经网络和环境有交互作用时,对 环境信息的编码会自发地在神经网中产生,则认 为神经网络在进行自组织活动。ART就是这样一 种能自组织地产生对环境认识编码的神经网络理 论模型。

▪ ART1用于处理二进制输入的信息; ▪ ART2用于处理二进制和模拟信息这两种输人; ▪ ART3用于进行分级搜索。 ▪ ART理论可以用于语音、视觉、嗅觉和字符识别

等领域。

ART模型的结构

▪ ART模型来源于Helmboltz无意识推理学说的竞争

学习网络交互模型。这个模型如图所示。 竞争层

输入层

结 构

c1

ci

cn

……

G1

x1

xI

xn

(1)C层结构

该层有n个节点,每个节点接受来自3

神经网络程序

P=ones(b,a);

x=W*P+B %计算神经网络加权输入

A=logsig(x)%计算神经网络输出

% % % % % %建立一个感知神经网络% % % % % %

x=[0 1 0 1;0 0 1 1];

t=[0 0 0 1];

net=perceptron;

es=errsurf(p,t,wv,bv,'logsig');

plotes(wv,bv,es,[60 30]) %画误差曲面,后面的矩阵是期望视角

%22计算误差曲面函数errsurf

p=[3 2]

t=[0.4 0.8]

wv=-4:0.4:4; bv=wv; %权值矩阵和偏差矩阵

plot(n,a)

grid on

在网络中需要调用这些函数作为传递函数用函数

yer{i}.transferFcn='tansig'

a=3; %行数

b=3; %列数

c=4; %神经元数

W=ones(c,b);

net=fitnet(10)

net.performFcn='sse'

net=train(net,x,t)

y=net(x)

e=t-y

perf=sse(net,t,y)

%计算线性层最大稳定学习速率函数maxlinlr

P=[1 2 -4 7;0.1 3 10 6];

lr=maxlinlr(P,'bias')

%选取输入变量的变化范围

x=-4:0.01:4;

%输入目标函数

y1=sin((1/2)*pi*x)+sin(pi*x);

使用二次连接神经网络的基于ART的分层聚类算法

clcu trn loih i s g e td a l seigag rtm u g se .Th i n p c o pe i ft eag rtm ic se .A - a t iil aa s et mea ds a ecm lxt o h lo ih i ds u sd y s 2 D ri ca t f d

人工数据集的实验模拟结果 以及与 K men 算 法 的比较 ; - as 最

后是总结和进一步的研究方 向。

题 , 以这些方法在估算正确的簇数方面都有一定的局限性 。 所

相似性 测量 面临的问题是簇 的一般形式化定 义 。大部分传 统

的簇算 法假 定 , 相 似位 置或 连续 密度 的模式 属 于一个 簇 。 有 为了从数学上识 别数据集 中的簇 , 首先需要定义相似性 ( 亲近

A s at I i p p r srcuea dpo et so e rl ew rswi ud aijn t n aepee td bt c nt s a e, tutr n rpri fnua n t ok t qa rt u ci r rsne.Unu e— r h e h c o sp r

Ma a nbs h l o i距离有着相 似的影 响 。另外 , a 存储 在簇一 测一 检 标

这意味着根据什么原则来安排输入模式 到相应 的簇 。解决 第 个 问题 的传统方法 是增加或 合并存 在的簇 数 , 每次增加 或 合并后都计算簇 有效 性 , 直到获 得优化 的簇 数 ] 。因为 大 部分有效性测量方法都涉 及到簇形状有 一定的几何结 构的问

1 引言

在聚类算法 中 , 有两个主要的问题需要解决 : 一个 是优 化 簇数 的确定 , 这被称为簇有 效性 问题 ; 另一个 是相似性 测量 ,

神经网络实用教程讲解与源码

演示程序2

%使用训练函数对创建的网络进行训练 net=train(net,P,T); %对训练后的网络进行仿真,即根据训练后的网络和样

本数据给出输出 a=net.b{1} b=net.iw{1} Y=sim(net,P);

%计算网络的平均绝对误差,表示网络错误分类 E1=mae(Y-T)

%给定测试数据,检测训练好的神经网络的性能 Q=[0.6 0.9 -0.1 0.7;-0.1 -0.5 0.5 -0.3]; %使用测试数据,对网络进行仿真,仿真输出即为分类

演示程序 1

% set(hndl2,'linewidth',2); % %设置图形标题 % title('线性神经网络逼近非线性函数的MATLAB实现'); % %设置图例 % legend('线性神经网络逼近非线性函数','原线性数据') % % ------------------------------------------------

量 % plotpc(net.iw{1},net.b{1}+0.1)

实验三单层感知器的构建与使用

3、有下面一组样本数据:输入数据为 P=[0 0 0 1;1 0 1 1],目标值为[0 1 1 0],能否使用单层感知器对其进行正确分 类,请编写MATLAB程序验证,并对结果进 行分析?

演示程序3

% 设置第二个图形的绘图位置为第一行第二列 subplot(2,2,2); hnd2=plot(x,y2); %设置图形线条宽度 set(hnd2,'linewidth',2); %设置图形线条颜色 set(hnd2,'color','green'); title('对数S型激活函数'); legend('logsig'); grid on

ART2神经网络在手写体汉字识别中的应用

a t r c aa t r t . h h r ce si e e t h r ce gs a e—dsr u ig c a a trs c a d i c n b o b n td ce  ̄ h r ce si T e c a a tr t r f csc a a tr p c i c i c l it b t h ce t , n t a e c m i ae i n r i i t ih dme so a e t r S ti a p ia l s e i l o te l r ep t r e o n tn s c s c i e e c a a t rr c o h g i n in lv co , O i s p l b e e p ca y t h a g atn r c g i u h a h n s h r ce e — c l e o o nt n g i o .T e e p r n e u t s o h t h r s n e g r h c n a h e e a hg e o nt nr t f 4 .wh c i h x e me trs l h w t a ep e e t d a o t m a c iv ih rc g i o aeo % i s t l i i 9 ih

t e a v n a e o b rF l r ie t n, ea i mei s st eg i b r h r c e si a a d i e h n s h r h d a tg f Ga o i e g d r ci t rt t o h h t u e rd Ga o aa t r t s h n wr tn c ie ec a- c h c i c t

神经网络的设计流程代码

神经网络的设计流程代码下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!1. 数据准备收集和整理数据集。

对数据进行预处理,例如数据清洗、归一化、特征工程等。

Art2神经网络源程序

/**************************************************************************** * * * ADAPTIVE RESONANCE THEORY (ART) NETWORK * * * *****************************************************************************/#include <stdio.h>#include <stdlib.h>#include <string.h>#include <conio.h>#include <math.h>// DEFINES#define MAXCNEURONS 75 // MAX COMPARISON LAYER NEURONS#define MAXRNEURONS 30 // MAX RECOGNITION LAYER NEURONS#define MAXPATTERNS 30 // MAX NUMBER OF PATTERNS IN A TRAINING SET#define VERBOSE 1class ARTNET{private:double Wb[MAXCNEURONS][MAXRNEURONS]; // Bottom up weight matrixint Wt[MAXRNEURONS][MAXCNEURONS]; // Top down weight matrixint InData[MAXPATTERNS][MAXCNEURONS];// Array of input vectors to be// presented to the networkint NumPatterns; // Number of input patternsdouble VigilThresh; // Vigilence threshold valuedouble L; // ART training const (see text)int M; // # of neurons in C-layerint N; // # of neurons in R-layerint XVect[MAXCNEURONS]; // Current in vect at C-layer.int CVect[MAXCNEURONS]; // Output vector from C-layerint BestNeuron; // Current best R-layer Neuronint Reset; // Active when vigilence has// disabled someoneint RVect[MAXCNEURONS]; // Output vector from R-layerint PVect[MAXCNEURONS]; // WeightedOutput vector from R-layerint Disabled[MAXRNEURONS]; // Resets way of disqualifying neuronsint Trained[MAXRNEURONS]; // To identify allocated R-Neuronsvoid ClearPvect();void ClearDisabled();void RecoPhase(); // Recognition phasevoid CompPhase(); // Comparison phasevoid SearchPhase(); // Search Phasevoid RunCompLayer(); // Calc comparison layer by 2/3 rule void RunRecoLayer(); // Calc recognition layers R-vect void Rvect2Pvect(int); // Distribute winners resultint Gain1(); // Comp layer gainint Gain2(); // Reco layer gaindouble Vigilence(); // Calc vigilence metricvoid InitWeights(); // Initialize weightsvoid Train(); // Weight adjustment is done here public:ARTNET(void); // Constructor/initializationsint LoadInVects(char *Fname); // load all data vectorsvoid Run(int i); // Run net w/ ith patternvoid ShowWeights(); // display top down and// bottom up weightsvoid ShowInVect(); // Display current input pattern void ShowOutVect(); // P-vector from Reco layer(see text) };// ------------------------------------------------------------------------// METHOD DEFINITIONSARTNET::ARTNET(){int i;L=2.0;N=MAXRNEURONS;for (i=0; i<N; i++) { //Set all neurons to untrained and enabled Trained[i]=0;Disabled[i]=0;} /* endfor */}int ARTNET::LoadInVects(char *Fname){FILE *PFILE;int i,j,k;PFILE = fopen(Fname,"r");if (PFILE==NULL){printf("\nUnable to open file %s\n",Fname);exit(0);}fscanf(PFILE,"%d",&NumPatterns); //How many patternsfscanf(PFILE,"%d",&M); //get width of input vector fscanf(PFILE,"%lf",&VigilThresh);for (i=0; i<NumPatterns; i++) {for (j=0; j<M; j++) {fscanf(PFILE,"%d",&k); //Read all the pattern data and...InData[i][j]=k; // ...save it for later.} /* endfor */} /* endfor */InitWeights();return NumPatterns;}int ARTNET::Gain2(){int i;for (i=0; i<M; i++) {if (XVect[i]==1)return 1;} /* endfor */}void ARTNET::Rvect2Pvect(int best){int i;for (i=0; i<M; i++) {PVect[i]= Wt[best][i];} /* endfor */}int ARTNET::Gain1(){int i,G;G=Gain2();for (i=0; i<M; i++) {if (RVect[i]==1)return 0;} /* endfor */return G;}void ARTNET::RunCompLayer(){int i,x;for (i=0; i<M; i++) {x=XVect[i]+Gain1()+PVect[i];if (x>=2) {CVect[i]=1;}else {CVect[i]=0;} /* endif */} /* endfor */}double ARTNET::Vigilence(){int i;double S,K,D;// count # of 1's in p-vect & x-vectK=0.0;D=0.0;for (i=0; i<M; i++) {K+=CVect[i];D+=XVect[i];} /* endfor */S=K/D;return S;}void ARTNET::RunRecoLayer(){int i,j,k;double Net[MAXRNEURONS];int BestNeruon=-1;double NetMax=-1;for (i=0; i<N; i++) { //Traverse all R-layer NeuronsNet[i]=0;for (j=0; j<M; j++) { // Do the productNet[i] +=Wb[i][j]*CVect[j];} /* endfor */if ((Net[i]>NetMax) && (Disabled[i]==0)) { //disabled neurons cant win!BestNeuron=i;NetMax=Net[i];}} /* endfor */for (k=0; k<N; k++) {if (k==BestNeuron)RVect[k]=1; // Winner gets 1elseRVect[k]=0; // lateral inhibition kills the rest} /* endfor */}void ARTNET::RecoPhase(){int i;//First force all R-layer outputs to zerofor (i=0; i<N; i++) {RVect[i]=0;} /* endfor */for (i=0; i<M; i++) {PVect[i]=0;} /* endfor *///Now Calculate C-layer outputsRunCompLayer(); //C-vector now has the resultRunRecoLayer(); //Calc dot prod w/ bot up weight & CRvect2Pvect(BestNeuron);}void ARTNET::CompPhase(){double S;RunCompLayer(); //Cvector<-dif between x & pS=Vigilence();if (S<VigilThresh){Reset=1;RVect[BestNeuron]=0;Disabled[BestNeuron]=1;}elseReset=0;}void ARTNET::SearchPhase(){double S;while (Reset) {ClearPvect();RunCompLayer(); //Xvect -> CvectRunRecoLayer(); //Find a new winner with prev winners disabled Rvect2Pvect(BestNeuron); //new pvect based on new winnerS=Vigilence(); //calc vigilence for the new guyif (S<VigilThresh){ //check if he did okReset=1; // if not disable him tooRVect[BestNeuron]=0;Disabled[BestNeuron]=1;}elseReset=0; //Current Best neuron is a good winner...Train him } /* endwhile */if (BestNeuron!=-1) {Train();}else {//Failed to allocate a neuron for current pattern.printf("Out of neurons in F2\n");} /* endif */ClearDisabled();}void ARTNET::ClearDisabled() {int i;for (i=0; i<M; i++) {Disabled[i]=0;} /* endfor */}void ARTNET::ClearPvect() {int i;for (i=0; i<M; i++) {PVect[i]=0;} /* endfor */}void ARTNET::Train(){int i,z=0;for (i=0; i<M; i++) {z+=CVect[i];} /* endfor */for (i=0; i<M; i++) {Wb[BestNeuron][i]=L*CVect[i]/(L-1+z);Wt[BestNeuron][i]=CVect[i];} /* endfor */Trained[BestNeuron]=1;}void ARTNET::Run(int tp){int i,j;ClearPvect();for (i=0; i<M; i++) {XVect[i]=InData[tp][i];} /* endfor */RecoPhase();CompPhase();SearchPhase();}void ARTNET::InitWeights(){ // Initialize weights int i,j;double b;for (i=0; i<N; i++) { // from R-neuron i for (j=0; j<M; j++) { // to C-neuron j Wt[i][j]= 1; // All init'd to 1} /* endfor */} /* endfor */b=L/(L-1+M);for (i=0; i<N; i++) { // from C-neuron i for (j=0; j<M; j++) { // to R-neuron j Wb[i][j]= b;} /* endfor */} /* endfor */}void ARTNET::ShowWeights(){int i,j;printf("\nTop Down weights:\n");for (i=0; i<N; i++) {if(Trained[i]==1){for (j=0; j<M; j++) {printf("%d ",Wt[i][j]);} /* endfor */printf("\n");} /* endif */} /* endfor */printf("\nBottom up weights:\n");for (i=0; i<N; i++) {if(Trained[i]==1){for (j=0; j<M; j++) {printf("%f ",Wb[i][j]);} /* endfor */printf("\n");} /* endif */} /* endfor */}void ARTNET::ShowInVect(){int i;printf("BEST NEURON:%d\nIN: ",BestNeuron);for (i=0; i<M; i++) {printf("%d ",XVect[i]);} /* endfor */printf("\n");}void ARTNET::ShowOutVect(){int i;printf("OUT: ");for (i=0; i<M; i++) {printf("%d ",CVect[i]);} /* endfor */printf("\n");}// ------------------------------------------------------------------------ARTNET ART;/****************************************************************************** * MAIN *******************************************************************************/int main(int argc, char *argv[]){int TstSetSize;int i;if (argc>1) {TstSetSize=ART.LoadInVects(argv[1]);for (i=0; i<TstSetSize; i++) {ART.Run(i); //Evaluate ith test patternprintf("\n");ART.ShowInVect();ART.ShowOutVect();if (VERBOSE==1) ART.ShowWeights();} /* endfor */}else {printf("USAGE: ART PATTERN_FILE_NAME\n");exit(0);}return 0;}。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

" OO O",

" OO ",

===========================

Application: Brain Modeling

Stability-Plasticity Demonstration

Author: Karsten Kutza

REAL Rho; /* - vigilance parameter */

} NET;

/******************************************************************************

#define M 10

#define NO_WINNER M

#define NUM_DATA 30

CHAR Pattern[NUM_DATA][N] = { " O ",

" O O",

/******************************************************************************

D E C L A R A T I O N S

******************************************************************************/

" O O",

" OO O",

" OO ",

A P P L I C A T I O N - S P E C I F I C C O D E

******************************************************************************/

#define N 5

"OOO ",

"OO ",

"OOOO ",

" O O",

" O",

" OO O",

Date: 27.6.96

Reference: G.A. Carpenter, S. Grossberg

A Massively Parallel Architecture

for a Self-Organizing Neural Pattern Recognition Machine

"OOOOO",

"O ",

" O ",

#define MAX_REAL +HUGE_VAL

typedef struct { /* A LAYER OF A NET: */

INT Units; /* - number of units in this layer */

#include <stdlib.h>

#include <stdio.h>

#include <math.h>

typedef int BOOL;

typedef char CHAR;

typedef int INT;

typedef double REAL;

REAL D1; /* - D parameter for F1 layer */

REAL L; /* - L parameter for net */

}

}

Net->A1 = 1;

Net->B1 = 1.5;

Net->C1 = 5;

Net->D1 = 0.9;

Net->L = 3;

Net->Rho = 0.9;

for (i=0; i<Net->F1->Units; i++) {

/******************************************************************************

===========================

Network: Adaptive Resonance Theory 1

INT Winner; /* - last winner in F2 layer */

REAL A1; /* - A parameter for F1 layer */

void InitializeApplication(NET* Net)

{

INT n,i,j;

for (n=0; n<NUM_DATA; n++) {

for (i=0; i<N; i++) {

Input[n][i] = (Pattern[n][i] == 'O');

" O",

" O O",

" O",

Computer Vision, Graphics, and Image Processing, 37,

pp. 54-115, 1987

******************************************************************************/

REAL B1; /* - B parameter for F1 layer */

REAL C1; /* - C parameter for F1 layer */

"OOOOO" };

BOOL Input [NUM_DATA][N];

BOOL Output[NUM_DATA][M];

FILE* f;

BOOL* Output; /* - output of ith unit */

REAL** Weight; /* - connection weights to ith unit */

LAYER* F1; /* - F1 layer */

LAYER* F2; /* - F2 layer */

#define FALSE 0

#define TRUE 1

#define NOT !

#define AND &&

#define OR ||

#define MIN_REA#34;,

" O ",

" O",

"OOO ",

"OO ",

"O ",

"OO ",

"OOO ",

"OOOO ",

BOOL* Inhibited; /* - inhibition status of ith F2 unit */

} LAYER;

typedef struct { /* A NET: */