基于特征值提取文本分类方案

文本特征提取的常用方法(五)

文本特征提取的常用方法1. 引言文本特征提取是自然语言处理(NLP)领域的一个重要问题,它涉及到从文本数据中提取出有效的特征,用于文本分类、情感分析、信息检索等任务。

随着深度学习技术的发展,文本特征提取方法也在不断演化和完善。

本文将介绍一些常用的文本特征提取方法,包括词袋模型、TF-IDF、Word2Vec和BERT等。

2. 词袋模型词袋模型是最简单且常用的文本特征提取方法之一。

它将文本表示为一个由词汇表中的词组成的向量,每个维度代表一个词在文本中出现的频率。

词袋模型忽略了单词之间的顺序和语法结构,只考虑了单词的出现频率。

虽然词袋模型简单,但在许多文本分类和信息检索任务中仍然表现良好。

3. TF-IDFTF-IDF(Term Frequency-Inverse Document Frequency)是一种用于评估单词在文档中重要性的方法。

它考虑了单词的频率以及在语料库中的稀疏程度,从而能够更好地捕捉单词的重要性。

TF-IDF在信息检索和文本分类领域被广泛应用,它可以帮助识别并突出文本中的关键词。

4. Word2VecWord2Vec是一种基于神经网络的词嵌入技术,它能够将单词映射到一个低维向量空间中,从而捕捉单词之间的语义关系。

Word2Vec模型可以根据上下文的单词预测目标单词,或者根据目标单词预测上下文的单词,通过这种方式学习单词的分布式表示。

Word2Vec在词义相似度计算、情感分析等任务中表现出色。

5. BERTBERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer模型的预训练语言模型,它能够捕捉句子和单词之间的语义关系。

BERT通过对大规模文本语料进行无监督训练,学习文本中的上下文信息,从而得到丰富的文本表示。

在文本分类、命名实体识别和问答系统等任务中,BERT 已经成为了一种非常有效的文本特征提取方法。

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述摘要:文本分类是信息检索和过滤过程中的一项关键技术,其任务是对未知类别的文档进行自动处理,判别它们所属于的预定义类别集合中的类别。

本文主要对文本分类中所涉及的特征选择和分类算法进行了论述,并通过实验的方法进行了深入的研究。

采用kNN和Naive Bayes分类算法对已有的经典征选择方法的性能作了测试,并将分类结果进行对比,使用查全率、查准率、F1值等多项评估指标对实验结果进行综合性评价分析.最终,揭示特征选择方法的选择对分类速度及分类精度的影响。

关键字:文本分类特征选择分类算法A Review For Feature Selection And ClassificationAlgorithm In Text CategorizationAbstract:Text categorization is a key technology in the process of information retrieval and filtering,whose task is to process automatically the unknown categories ofdocuments and distinguish the labels they belong to in the set of predefined categories. This paper mainly discuss the feature selection and classification algorithm in text categorization, and make deep research via experiment.kNN and Native Bayes classification algorithm have been applied to test the performance of classical feature detection methods, and the classification results based on classical feature detection methods have been made a comparison. The results have been made a comprehensive evaluation analysis by assessment indicators, such as precision, recall, F1. In the end, the influence feature selection methods have made on classification speed and accuracy have been revealed.Keywords:Text categorization Feature selection Classification algorithm前言互联网技术的高速发展引起了信息量的爆炸式增长,面对庞大的数据信息,如何在大规模的文本异构信息中准确、快速、全面地查找到个人所需的特定信息,已经成为了一项具有非常重要意义的研究课题[1]。

文本分类及其特征提取

文本分类及其特征提取文本分类是指根据文本的内容、主题或语义将文本划分到不同的预定义类别中,是自然语言处理领域的一个重要任务。

文本分类在许多应用中都有着广泛的应用,如垃圾邮件过滤、情感分析、新闻分类、文档归档等。

在进行文本分类任务时,常常需要进行特征提取,提取文本中的关键信息以帮助分类器更好地进行分类。

特征提取是文本分类的关键步骤之一,其目的是将原始的文本数据转化为机器学习算法能够理解和处理的向量表示。

下面将介绍几种常用的文本分类方法及其特征提取方式:1.词袋模型词袋模型是文本分类中最常用的特征表示方法之一、该模型将文本看作是一个由词语组成的无序集合,通过统计文本中每个词语的频率或者权重来表示文本的特征。

常见的词袋模型包括TF-IDF(Term Frequency-Inverse Document Frequency)和词频统计。

- TF-IDF是一个常用的特征表示方法,它考虑了词语在文本中的重要性。

TF(Term Frequency)表示词语在文本中出现的频率,IDF (Inverse Document Frequency)表示词语在整个文本语料库中的重要性。

TF-IDF的值可以通过TF和IDF的乘积来计算。

-词频统计是指直接统计词语在文本中的出现次数。

将文本转化为词频向量后,可以使用机器学习算法(如朴素贝叶斯、支持向量机等)进行分类。

2. Word2VecWord2Vec是一种将词语转化为向量表示的方法,能够将词语的语义信息编码到向量中。

Word2Vec根据词语的上下文关系学习得到词向量空间,通过计算词语之间的距离或者相似性来表示词语的特征。

- CBOW(Continuous Bag-of-Words)模型根据上下文预测中心词,从而学习得到词向量。

- Skip-gram模型则根据中心词预测上下文词,同样可以得到词向量。

Word2Vec的特点是能够很好地捕捉到词语之间的语义关系,例如可以通过词向量的加减法来进行类比推理操作。

一种基于语义分析的中文特征值提取方法

一种基于语义分析的中文特征值提取方法

基于语义分析的中文特征值提取方法是一种被广泛用于文本处理

和自然语言处理研究领域的技术。

该方法可以从文本中提取出有效的

特征值,用于文本分类与检索。

它能够准确提取出文本单元的解释特征,以有效地描述文本的内容和语义,从而改进文本处理中的检索准

确性和召回率。

基于语义分析的中文特征值提取方法通常包括以下几个步骤:第

一步,首先分析文本文本语义,尝试抽取文本中的主题、情感、情景

以及意图等高级特征;第二步,根据这些特征对文档的话题进行细粒

度的划分;第三步,根据文档的划分结果提取出特征值;最后,输出特

征值以及相关的语义信息,用于文本分类、检索和聚类等相关任务。

基于语义分析的中文特征值提取方法可以有效解决传统特征提取

方法在提取字词、短语上所存在的维数灾难问题。

该方法可以从更高

级别的文本解释特征,如主题、情感等方面,来抽取文本特征,进一

步降低文本处理中的维数灾难,从而提高文本处理中的效率和准确性,为文本处理研究提供更实用的语义特征值抽取技术。

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述特征提取和分类算法是文本分类中非常重要的步骤,对于智能化应用和信息检索具有重要的意义。

本文将综述文本分类中常用的特征提取方法和分类算法,并对其优缺点进行分析和比较。

一、特征提取方法特征提取是将文本转化为计算机可识别的特征向量的过程。

下面介绍几种常用的特征提取方法:1. 词袋模型(Bag of Words):词袋模型将文本转换为一个包含词袋(词汇表)中所有单词的向量。

对于每个文档,词袋模型统计每个词在文档中的词频或词重。

这种方法简单有效,但忽略了文本中的语法和顺序信息。

2. N-gram模型:N-gram模型将文本分成N个连续的词组,统计每个词组的出现频率。

该方法考虑了词组的局部关系,能够捕捉文本中的一定的语序信息。

3.TF-IDF:TF-IDF(Term Frequency-Inverse Document Frequency)是一种基于词频和逆文档频率的特征提取方法。

它衡量了一个词在文档中的重要性,高频率出现且在整个语料库中稀有的词被认为具有较高的区分能力。

4.主题模型:主题模型通过对文档进行主题聚类,将文本转化为对应主题的概率分布向量。

主题模型可以提取文本中的语义信息,但参数估计较为困难。

5. Word2Vec:Word2Vec是一种基于神经网络的词嵌入模型,通过学习词的分布式表示。

Word2Vec可以捕捉词之间的语义相似性,提取更加丰富的特征。

二、分类算法分类算法是根据提取的特征向量对文本进行分类。

常用的分类算法包括:1.朴素贝叶斯分类器:朴素贝叶斯分类器基于贝叶斯定理和特征条件独立假设,计算每个类别的概率,并选择概率最大的类别作为分类结果。

朴素贝叶斯分类器简单高效,对于大规模数据集适用。

2.支持向量机:支持向量机通过寻找一个超平面,将不同类别的样本点分开。

它可以处理高维数据,具有较好的泛化性能。

3.决策树:决策树根据特征之间的关系构建一棵树型结构,通过比较特征值进行分类。

文本分类中常用的特征提取方法对比研究

文本分类中常用的特征提取方法对比研究在文本分类任务中,特征提取是至关重要的步骤,它决定了分类准确度和效率。

特征提取旨在将文本数据转化为可供机器学习算法使用的数字表示。

下面将介绍几种常用的特征提取方法,并进行对比研究。

1. 词袋模型(Bag of Words,BoW)词袋模型是一种简单而常用的特征提取方法。

它将文本看作是一个无序的词的集合,忽略了词语的顺序和语法结构。

具体来说,词袋模型通过统计每个词在文本中的出现频率构成一个向量表示文本。

这种方法简单直观,易于实现。

然而,它忽略了词语的顺序和语义信息。

2. TF-IDFTF-IDF(Term Frequency-Inverse Document Frequency)是一种常见的特征提取方法,它综合考虑了词语在文本中的出现频率和在语料库中的普遍程度。

TF-IDF首先计算每个词在文本中的出现频率,然后乘以一个逆文档频率,该逆文档频率通过计算语料库中包含该词的文档数目的倒数得到。

这样,TF-IDF能够减少常见词汇的权重,强调仅在特定文本中出现的重要词汇。

TF-IDF能够较好地捕捉词语的重要性,它具有保留词语顺序的优点。

3. Word2VecWord2Vec是一种基于神经网络的词嵌入(Word Embedding)方法。

它通过训练一个神经网络,将每个词语映射到一个低维的实数向量空间中,这样相似的词语在向量空间中距离也会比较接近。

Word2Vec能够从大量的文本语料中学习到词语之间的语义关系,能够很好地捕捉语义信息。

但相比于前两种方法,Word2Vec的训练时间较长,且需要足够大的语料库。

4. 特征哈希特征哈希是一种将文本特征映射到固定维度的稀疏向量的方法。

它通过利用哈希函数将文本中不同的词语映射到同一维度上。

这样,所有的文本经过特征哈希处理后都具有相同的维度,方便了后续的特征表示和分类。

特征哈希可以简化特征处理过程,减少存储空间和计算复杂度。

然而,由于多个词语可能映射到同一维度上,可能会产生冲突,导致信息丢失。

基于特征值提取文本分类方案

目录一、综述 2(一)实现目标 2(二)主要功能 2二、总体架构 2三、各模块建模挖掘层详解 4(一)无监督学习模块 4(二)有监督学习模块 5四、输入层和输出层详解 5(一)输入层 5(二)输出层 5基于特征值提取文本分类设计方案一、综述(一)实现目标本模块实现了对文本文档集合的分类特征值提取。

对输入的分类文档,基于词频、互信息、类别信息的综合特征,从每个分类中挖掘出对应的有效特征值。

该模块还实现了对特征值的权重计算,按照特征词的权重值,构造了分类器。

新增文本可以通过文本分类器进行分类,无法分类的文本可以人工分类后重新执行特征值抽取功能,重新调整特征值,从而达到优化分类器的目的。

该模块由Java编写,可用于任何需要挖掘文本主题的项目中,也可以单独使用。

(二)主要功能该模块的主要功能包括以下几个方面:● 对原始语料库进行中文分词、去除停用词● 词性过滤,只提取名词,动词● 按类别进行特征词提取● 特征词权重计算● 文本分类二、总体架构三、挖掘层详解1.文本分词中文分词采用开源的Ansj分词工具,基于中科院的 ictclas 中文分词算法,采用隐马尔科夫模型(HMM),比其他常用的开源分词工具(如mmseg4j)的分词准确率更高。

Ansj是一款纯Java的、主要应用于自然语言处理的、高精度的分词工具,目标是“准确、高效、自由地进行中文分词”,可用于人名识别、地名识别、组织机构名识别、多级词性标注、关键词提取、指纹提取等领域,支持行业词典、用户自定义词典。

Ansj实现了用户自定义词典的动态添加删除,当然,也支持从文件加载词典。

用户自定义词典默认路径:项目目录/library/userLibrary/userLibrary.dic。

格式为:[自定义词] [词性] [词频],其中[词性]和[词频]两项可以空缺不写。

本项目在Ansj原本自带的词典(367425条)基础上,扩展了以下词典:1) 从数据库中抽取的电信业务词库(5767条)2) 广深东佛城市信息精选词库(来源:搜狗细胞词库)(62617条)3) 搜狗标准词库(392778条)4) 搜狗精选词库(392507条)5) 搜狗万能词库(362333条)本模块还提供了从数据库加载词库的功能。

中文文本聚类中的特征提取

中文文本聚类中的特征提取在中文文本聚类中,特征提取是一个关键的步骤,它将文本数据转化为机器可识别的数值特征,以便进行聚类分析。

特征提取的质量直接影响聚类结果的准确性和可解释性。

以下是一些常用的中文文本特征提取方法:1. 词袋模型(Bag-of-Words, BoW):将文本看作是一个词的集合,通过统计每个词在文本中出现的频次或者使用词频-逆文档频率(Term Frequency-Inverse Document Frequency, TF-IDF)对词进行加权,将文本表示为一个稀疏向量。

这些向量可以用来计算文本之间的相似性,从而进行聚类。

2. n-gram模型:将文本中相连的n个词看作一个整体,称为n-gram。

通过统计n-gram在文本中出现的频次或者使用TF-IDF进行加权,将文本表示为一个向量。

n-gram模型可以捕捉到词之间的局部顺序信息。

常见的n值包括1-gram(单词)、2-gram(连续两个单词)和3-gram(连续三个单词)。

3. 主题模型(Topic Model):主题模型可以将文本表示为一组主题的分布,每个主题表示一种概念或主题。

其中,常用的主题模型包括潜在狄利克雷分配(Latent Dirichlet Allocation, LDA)和潜在语义分析(Latent Semantic Analysis, LSA)。

通过主题模型,可以发现文本中隐藏的主题结构,从而进行聚类分析。

4. Word2Vec:Word2Vec是一种基于神经网络的词向量表示方法,可以将每个词表示为一个稠密的向量。

Word2Vec尤其适合捕捉词之间的语义信息。

通过将文本中的词进行Word2Vec表示,可以得到一个词向量矩阵,然后通过计算文本特征向量的平均值或者加权平均值来表示整个文本。

5.文本结构特征:中文文本具有丰富的结构信息,例如句子的分词、词性标注、句法分析等。

这些结构信息可以作为文本的附加特征,用来丰富文本的表示。

一种基于PCA的组合特征提取文本分类方法

信 息( M I ) 、 文档频 率 ( D F ) 、 信 息增益 ( I G ) 和 统计 ( C H I ) 算 法 的研 究 , 利 用其 各 自的优 势 互补 , 提 出一 多重组合特征提取算法( P C A — C F E A ) 。通过 P C A算法的正交变换快速地将文本特征空间 降维, 再通过 多重组合特征提取算法在降维后的特征空间中快速提取 出更具代表性的特征项, 过滤掉一些代表

性 较弱 的特征 项 , 最后使 用 S V M 分类 器对文 本进行 分 类 。实验 结果 表 明 , P C A — C F E A能有 效 地提 高 文本 分 类 的

正 确率和执 行 效率 。

关 键词 :基 于 P C A的 组合特征 提取 算 法( P C A — C F E A ) ; 主成 分分析 ; 特征提 取 ; 文本 分 类 中图分 类号 :T P 3 9 1 文 献标 志码 :A 文 章编号 :1 0 0 1 — 3 6 9 5 ( 2 0 1 3 ) 0 8 . 2 3 9 8 . 0 4

第3 0卷第 8 期

2 0 1 3年 8月

计 算 机 应 用 研 究

Ap p l i c a t i o n Re s e a r c h o f C o mp u t e r s

Vo L 3 0 No . 8 Au g . 2 0 1 3

一

种基于 P C A的组 合 特征 提 取 文本 分 类方 法

李建林

( 1 . 南京信 息 职 业技 术 学 院 计 算机 与 软件 学 院,南 京 2 1 0 0 2 3 ; 2 . 里 贾纳 大 学 计 算 机科 学 系 , 加 拿 大 里 贾纳

S 4 S 0 A2

文本特征提取以及分类结果分析

文本特征提取以及分类结果分析文本特征提取是文本挖掘领域的重要任务,通过对文本中的特征进行提取和表示,能够实现对文本的分类、聚类、情感分析等任务。

本文将介绍文本特征提取的常见方法,并利用这些特征进行文本分类,并对分类结果进行分析。

一、文本特征提取方法1.词袋模型(Bag of Words)词袋模型是文本特征提取的基本方法,它将一篇文本表示为一个词频向量。

首先对文本进行分词处理,然后统计每个词在文本中出现的频率,最后将每个词的频率作为特征,构成一个向量。

2.TF-IDFTF-IDF(Term Frequency-Inverse Document Frequency)是一种常用的文本特征提取方法,对于每个词,它结合了在文本中出现的频率和在整个语料库中出现的频率。

TF(词频)表示词在文本中的频率,而IDF (逆文档频率)表示词在整个语料库中的频率。

TF-IDF的计算公式为:TF-IDF = TF * log(N / IDF),其中N表示语料库中的文档数。

3. Word2VecWord2Vec是一种通过训练神经网络从文本中学习词的向量表示的方法。

它能够将每个词映射到一个固定维度的实数向量,使得具有相似语义的词在向量空间中距离较近。

Word2Vec的训练方法有两种:CBOW (Continuous Bag of Words)和Skip-gram。

4. GloVeGloVe(Global Vectors for Word Representation)是一种利用全局语料统计信息来进行词向量训练的方法。

与Word2Vec类似,GloVe也能够将词转化为固定维度的实数向量,但是在计算上更加高效。

二、文本分类1.特征表示上述介绍的文本特征提取方法可以用于构建文本的特征表示。

通过选择合适的特征提取方法,可以有效地提取文本中的关键信息,帮助模型区分不同的类别。

2.模型训练常见的文本分类方法有朴素贝叶斯、支持向量机(SVM)、随机森林、神经网络等。

基于特征提取的文本分类算法研究

基于特征提取的文本分类算法研究随着数据量的增加和人类活动的数字化,文本数据成为越来越重要的信息来源。

文本分类作为文本挖掘的核心任务,已经广泛应用于商品评论、新闻分类、社交媒体监测等领域。

文本分类的关键是通过文本特征提取来自动化地识别文本的类别。

在这篇文章中,我们将探讨基于特征提取的文本分类算法研究的相关问题。

一、特征提取特征提取是文本分类的第一步,目标是从原始文本中提取出有意义的特征。

通常的做法是将文本转换成数字向量,以供后续处理和分析。

常用的特征提取方法包括:1.词频-逆文档频率(TF-IDF)在TF-IDF方法中,将文档中出现的单词当作特征,计算每个单词在文本中出现的频率,然后乘以逆文档频率。

逆文档频率是IDF的倒数,IDF是反映单词在整个语料库中出现频率的度量。

应用TF-IDF特征提取方法能够降低常见词汇对分类的影响,同时提高重要词汇的权重。

2.关键词抽取关键词是文档中最能够代表文本内容的单词或短语,通过对每个文本进行关键词抽取获得文本的特征。

常用的关键词抽取方法包括TF-IDF、TextRank、Rake等。

3.主题模型主题模型是一种将文档表示为主题分布的技术。

主题是一个概念,可以看作是描述文本中的某种抽象概念,例如新闻中的政治、娱乐、体育等。

主题模型技术可以将文本特征转换为主题分布特征,作为文本分类的输入特征。

二、文本分类算法文本分类算法是将文本转换成数字向量后,对向量进行分类的过程。

主要的算法包括:1.贝叶斯分类器贝叶斯分类器是一种基于概率理论的分类方法,在文本分类中表现出色。

贝叶斯分类器最常用的是朴素贝叶斯分类器,通过对每个特征进行条件独立假设,计算得到文本属于每个类别的概率,并选择概率最大的分类结果作为文本分类的结果。

2.支持向量机支持向量机是一种基于统计学习理论的分类方法,通过构造一个划分超平面将不同类别的数据点分开。

支持向量机通常采用核函数来将原始的特征空间投影到一个高维空间中,使得数据点在新的空间中线性可分或近似线性可分。

特征提取算法在文本分类中研究

特征提取算法在文本分类中研究在当今信息时代,文本分类已成为一个重要的研究领域。

以网络平台为代表的信息爆炸,使得大量文本数据积累,而如何从这些数据中提取出有用的信息,则成为了文本分类研究的重要目标。

文本分类的过程需要特征提取,即将原始文本转化成一些有意义的特征向量,从而实现分类。

而特征提取算法的好坏,直接影响了文本分类的准确性和效率。

因此,特征提取算法的优化和研究,对于文本分类的实现具有重要的意义。

在文本分类中,特征提取算法主要分为两种:基于词频的算法和基于词向量的算法。

下面将分别介绍这两种特征提取算法的实现原理和优缺点,并进行比较。

基于词频的特征提取算法基于词频的特征提取算法,简单来说,就是将文本中每个词出现的频率作为该词的特征值,然后建立一个文本特征向量,以此来进行分类。

比如,将若干篇文章中的每个单词看作一个特征,然后将每个单词出现的频率作为该单词的特征值。

这样就可以得到一个大量的特征向量,每个文本都可以用特征向量表示。

当然,为了排除一些无关紧要的词汇,我们还需要对文本进行一些预处理,如去除停用词、词干提取等。

基于词频的特征提取算法相对简单,易于实现。

但是由于只考虑了单词出现的频率,没有考虑词汇之间的关系,所以可能会存在一些问题,如过于稀疏、维数过大等。

此外,对于一些在不同文本中频率相同的词汇,难以起到区分不同文本的作用。

基于词向量的特征提取算法基于词向量的特征提取算法,顾名思义就是将文本中的词转化成向量,然后将这些向量作为特征表示文本,最后进行分类。

具体来说,基于词向量的特征提取算法有多种实现方法。

其中最常用的是词嵌入技术,即将文本中的每个词语映射到一个高维空间中,使得每个词语可以用一个向量表示。

这些向量都具有相似的语义和语法含义。

词嵌入技术的实现可以使用Word2Vec等算法,其中最常见的是Skip-gram模型。

该模型先通过一个窗口扫描文本,然后通过神经网络将中心词与上下文词语之间的关系进行学习,从而获得词向量。

文本特征提取的常用方法(六)

文本特征提取的常用方法在自然语言处理领域,文本特征提取是一个非常重要的环节。

通过提取文本的特征,我们可以进行文本分类、情感分析、实体识别等任务。

本文将介绍一些常用的文本特征提取方法,包括词袋模型、TF-IDF、词嵌入等。

词袋模型词袋模型是文本特征提取中最简单也是最常用的方法之一。

它将文本表示为一个由词汇表中的词组成的向量。

在这个向量中,每个维度对应一个词,而向量的值则表示该词在文本中的出现次数。

词袋模型忽略了单词的顺序和语法,只关注单词的频次。

尽管词袋模型非常简单,但在许多文本分类任务中仍然表现出色。

TF-IDFTF-IDF(Term Frequency-Inverse Document Frequency)是一种衡量词在文本中重要性的方法。

它通过计算词频和逆文档频率来确定一个词的权重。

词频表示一个词在文本中出现的次数,而逆文档频率表示一个词在整个文本集合中出现的频率。

TF-IDF的计算公式为 TF*IDF = (词在文本中的频次 / 文本中所有词的总数) * log(文本集合中文本的总数 / 包含该词的文本数)。

利用TF-IDF可以剔除一些常见的词,突出一些重要的词,从而提高文本特征的质量。

词嵌入词嵌入是将词语映射到一个低维向量空间的技术。

它可以将词语的语义信息编码为向量,使得语义相近的词在向量空间中距离较近。

词嵌入方法有很多种,比较常见的有word2vec、GloVe和FastText等。

这些方法基于大型文本语料库,通过学习词语的上下文关系来生成词向量。

词嵌入在自然语言处理领域中被广泛应用,可以用于文本相似度计算、命名实体识别等任务。

n-gram模型n-gram模型是一种基于词语序列的文本特征提取方法。

它将文本看作一个由词语组成的序列,然后提取n个词语组成的片段作为特征。

n可以是1、2、3等,分别表示unigram、bigram、trigram等。

n-gram模型可以捕捉词语之间的局部依赖关系,能够更好地表达文本的语义信息。

一种基于特征提取的二级文本分类方法

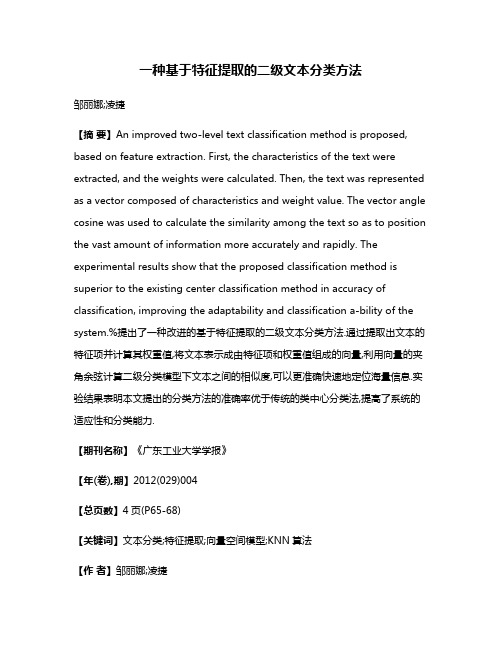

一种基于特征提取的二级文本分类方法邹丽娜;凌捷【摘要】An improved two-level text classification method is proposed, based on feature extraction. First, the characteristics of the text were extracted, and the weights were calculated. Then, the text was represented as a vector composed of characteristics and weight value. The vector angle cosine was used to calculate the similarity among the text so as to position the vast amount of information more accurately and rapidly. The experimental results show that the proposed classification method is superior to the existing center classification method in accuracy of classification, improving the adaptability and classification a-bility of the system.%提出了一种改进的基于特征提取的二级文本分类方法.通过提取出文本的特征项并计算其权重值,将文本表示成由特征项和权重值组成的向量,利用向量的夹角余弦计算二级分类模型下文本之间的相似度,可以更准确快速地定位海量信息.实验结果表明本文提出的分类方法的准确率优于传统的类中心分类法,提高了系统的适应性和分类能力.【期刊名称】《广东工业大学学报》【年(卷),期】2012(029)004【总页数】4页(P65-68)【关键词】文本分类;特征提取;向量空间模型;KNN算法【作者】邹丽娜;凌捷【作者单位】广东工业大学计算机学院,广东广州510006;广东工业大学计算机学院,广东广州510006【正文语种】中文【中图分类】TP391.1文本分类是将文本按一定的策略归于一个或多个预先定义好的类别中的应用技术.随着Internet的飞速发展,网络信息量与日俱增,对这些蕴涵丰富的信息进行人工分类远远不能满足各种领域获取信息的需求.因此,为了能够有效地组织和准确定位海量信息,自动分类已经成为信息处理领域中的一个重要研究课题[1].文本自动分类的一个关键问题是如何构造分类函数,并利用此分类函数将待分类文本划分到相应的类别空间中.目前常用的文本分类方法主要有支持向量机(Support Vector Machine,SVM)和K近邻(K-Nearest Neighbor,KNN).然而这些方法存在一些不足之处:支持向量机主要针对两类分类问题,不能直接应用于多类分类,且该方法应用于大数据集时训练速度较慢;K近邻方法对于样本容量较小的类域容易产生错分,且K的取值不容易确定[2-3].本文引入了基于同义词合并的特征提取方法,在进行特征选择之前先进行同义词的合并,这样可以有效降低特征空间的维数,结合类中心向量法设计出一种二级文本分类方法,并利用分类准确率对实验结果进行评估.1 文本分类的关键技术1.1 空间向量模型在文本分类系统中,计算机面对的是非结构化的自然语言.而计算机只认识0和1,它并不能识别出自然语言文本的内容,因此对这些自然语言文本进行形式化处理,即建立相应的数学模型是对它们进行分类处理的前提.目前较成熟的文本表示模型是向量空间模型(Vector Space Model)[4-5].在该模型中,将从文本中提取的特征词组成特征向量,并计算每一个特征词的权重.例如文档表示为向量 T=(t1,t2,…,tn),其中ti(1≤i≤n)是特征词.根据特征词的重要程度,可以赋予不同的权值wi进行量化,这样文档也可表示为 T=(w1,w2,…,wn),其中每一项 wi与相应的特征词ti相对应.在VSM中,不考虑特征词在文中出现的先后顺序,只保证特征词的唯一性,可以把n个特征词看成一个n维坐标系,则相应的权重wi为文档在坐标系中的坐标值,一个文档就可以被表示成一个n维空间的向量.一个文档的集合可以表示为A=(T1,T2,…,Tm),其中,Tk(1≤k≤m)表示文档集中的一个文档向量,即 T=(w1,w2,…,wn)T,m 表示文档集中的文档数,这样一个文档集就可以表示为一个n×m的矩阵:1.2 基于同义词合并的特征提取为了提高分类精度和速度,要去除那些表现力不强的词汇,筛选出对该类有特定意义的特征项集合.一般的特征选择方法对每一个特征词都单独统计其函数评估值[6],没有考虑同一主题下同义词的合并处理问题.如果在特征选择之前,先统计文档集中的同义词,并将这些词合并替换,作为一个词来处理,将有效地降低特征空间维数,提高自动分类系统的效率.基于同义词合并的特征选择是根据《同义词词林》,对经过分词处理后的文本中的特征词进行处理,如果多个特征词出现在词典的一个同义词词组中,则合并为一个特征词[7].其特征选择的详细步骤如下:1)采用中科院的ICTCLS分词系统对训练文本进行分词、去停用词处理.2)根据同义词词典对分词后的特征词进行同义词合并.3)重新统计文本中特征词的频度,得到特征词的概率估算公式为其中,Nt表示训练文本中出现特征词t的文档数,Nt'表示训练文本中不出现特征词t但出现其同义词的文档数,Nt'_Ci表示Ci类文档集中不出现特征词t,但出现其同义词的文档数.4)根据概率估算公式(1)~(3),计算每一特征项的权值,选取满足某一阈值的特征项生成向量空间.对于阈值的大小,可在试验过程中选取具有最优分类效果的阈值.1.3 TF-IDF 权值算法在文本自动分类过程中,由于不同的特征项对于文本的重要程度和区分度不同,因此系统在对文本进行形式化处理的时候,需要对特征项进行赋权.权值计算的准则就是最大限度地区分文档,所以特征项频率TF与反文档频率IDF通常是联合使用的[8-10],其中,Wik代表第i个特征项在文档Tk中的权重,TFik为词条ti在文档Tk中的词频.IDFik为逆文本词频,其计算方法有很多种.目前较为常用的公式为其中,N代表所有训练文本的总数,Nk代表的是训练文本中出现该特征项的文本数.2 二级文本分类方法2.1 构建分类模型文本分类是指在给定的分类体系下,由计算机自动对已知类别的样本进行学习,并且总结出不同类别文本的特征值作为判断依据,然后根据文本的内容特征自动判别文本类别的过程.图1给出了文本分类的结构图,主要包括训练阶段和分类阶段.训练阶段首先对训练文本进行预处理,然后进行特征选择和参数训练,最后生成文本分类器.分类阶段通过对待分类文本的预处理及特征选择后,由文本分类器自动对文本进行分类.图1 文本分类结构图Fig.1 Structural diagram of text classification2.2 训练及分类过程类中心向量法简单直观,待分类文本只需与极少的类中心向量对比,就可以将其分类,因此训练和分类速度很快,但是分类精度受类别的分布影响较大.当类别分布均匀、边界清晰时,分类精度较高;当类别分布不平衡、边界模糊时,分类的效果不好.本文采用一种二级分类方法:先训练出各个类别的中心特征向量,通过计算待分类文本与各类别中心向量的相似度来初步判断待分类文本的类别;当利用类中心向量法难以判断文本所属类别时,再根据KNN算法计算相似度,判断文本的最终类别[11-13].详细步骤如下.1)训练阶段(1)对训练集中的文本进行分词等预处理;(2)提取特征项,根据同义词合并原则进行维数压缩;(3)根据TF-IDF公式计算特征项的权重值,生成特征向量表,每篇文档表示为向量<w1,w2,…,wn>,其中wi(1≤i≤n)为对应的特征项的权重值;(4)对于每一类中的特征项词条ti,计算其在该类所有文档特征向量中权重值的算术平均值¯wi,作为该词条在类中心向量中的权重,构造第j类的类中心向量Cj:<¯w1,¯w2,…,¯wm>.2)分类阶段(1)取出测试集中的一篇文本,进行预处理之后构造特征向量di.(2)计算 di与各类中心向量 Cj的相似度Sim(di,Cj),计算公式为式中:di为测试文本的特征向量,Cj为第j类的类中心向量;m为特征向量的维数;Wk为向量的第k维.(3)将相似度结果由大到小排序,若前几位相差较大,则将di归入相似度最大的类别.(4)若前几位相似度很接近,计算这几个相近类别中所有训练文本与测试文本的相似度Sim(di,Dj),选取相似度最大的前k个训练文本.(5)将这k篇文本的相似度按式(7)进行求和,将属于同一个类的文本的相似度相加求和,然后对每个类所求得的和进行排序,将测试文本归到相似度和最大的那个类中.式中,Cj(Dj)表示文本Dj是否属于Cj类,若属于则值为1,否则为0.3 实验结果分析为了验证分类方法的效果,本文采用搜狗实验室的文本分类语料库作为训练集和测试集,该语料库包含财经、IT、健康、教育等9个主题的文本文档.将语料库的一部分用于训练,一部分用于测试,训练和测试的文档互不重复.各个主题类文档用于测试和训练的分布情况如表1所示.表1 训练集与测试集各主题类文本分布Tab.1 Text distribution of testing set and training set类别财经 IT 健康体育旅游教育招聘文化军事训练文本100 100 100 100 100 100 100 100 100测试文本60 60 60 80 80 60 60 60 60评估文本分类系统的标志是映射的准确程度和映射的速度,映射的速度取决于映射规则的复杂程度,而评估映射准确程度的参照物是通过专家思考判断后对文本的分类结果.评价分类性能的两个重要指标是分全率、分准率.分全率是指所有判断的文本与专家分类的吻合率,分准率是指所有判断的文本与分类系统分类的吻合率.F 测试值是将分全率和分准率综合起来的另外一个常用指标[14].各评价指标的公式为其中,TP表示专家和分类程序都把文档di分配到类别Cj;FP表示分类程序把文档di分配到类别Cj,而专家没有;FN表示专家把文档di分配到类别Cj,而分类程序没有.F测试值为其中β是一个可以调整分全率和分准率重要程度的参数,在实际应用中通常取β=1时的值即F1值,采用类中心向量分类法与本文的二级分类方法的分类结果分别如表2、表3所示. 表2 类中心向量法分类的实验结果Tab.2 Experimental results of clustering center vector method for classification类别财经 IT 健康体育旅游教育招聘文化军事分全率 0.851 0.883 0.781 0.905 0.822 0.798 0.882 0.815 0.916分准率 0.843 0.852 0.760 0.887 0.856 0.695 0.868 0.725 0.882 F1 测试值 0.847 0.867 0.770 0.896 0.839 0.742 0.875 0.767 0.899表3 二级文本分类方法的实验结果Tab.3 Experimental results of two-level text classification method类别财经 IT 健康体育旅游教育招聘文化军事分全率 0.865 0.884 0.855 0.905 0.845 0.835 0.893 0.868 0.916分准率 0.847 0.863 0.760 0.887 0.860 0.862 0.888 0.846 0.882 F1 测试值 0.856 0.8730.804 0.896 0.852 0.848 0.890 0.857 0.899比较表1、表2的数据,可以看出类中心向量法能很好地分类出一些与其他类别相差较大的主题类,如军事类、体育类;对于一些界限不是很明显的类别,如教育类和文化类,分全率和分准率都较低.而用类中心向量法粗分类之后,再利用KNN 算法进行二级分类得到的分全率和分准率都相对更高.使用传统的KNN算法分类时,要计算每个测试文本与所有训练文本之间的相似度,其时间复杂度为O(n×m),其中n是训练集文本的个数,m是特征向量的维数[15].本文通过引入类中心向量,建立二级分类模型,只有当测试文本与某几个类别的类中心向量相似度很接近时,再计算测试文本与这几个类别中的所有训练文本之间的相似度,其时间复杂度为O(kn)≤O(di)<O(n×m),其中k为类别个数.4 结束语特征提取和分类方法是文本分类系统的核心,本文引入了基于同义词合并的特征提取方法,使特征词的提取从词的层面上升到主题概念层面,不仅极大地缩小了原始的特征空间,而且有利于提高分类精度.实验结果表明,二级分类模式比类中心向量法具有更高的分全率和分准率.该方法避免了单独使用KNN算法时时间消耗过大,同时又降低了单独使用类中心向量法对文本定位的不准确性.参考文献:[1]Wu Xing-dong.News filtering and summarization on the web[J].IEEE Transactions on Knowledge and Data Engineering,2010,25(5):68-76.[2]Marta Capdevila.A communication perspective on automatic text categorization[J].IEEE Transactions on Knowledge and Data Engineering,2009,21(7):1027-1041.[3]吕震宇,林永民,赵爽,等.基于类信息的文本特征选择与加权算法研究[J].计算机工程与应用,2008,44(20):145-147.Lü Zhen-yu,Lin Yong-min,Zhao Shuang,et al.The research of text feature selection and weighting algorithm based on the information[J].Computer Engineering and Applications,2008,44(20):145-147.[4]王之鹏.Web文本分类系统中文本预处理技术的研究与实现[D].南京:南京理工大学,2009.[5]Rullo P.Effective rule learning for text categorization[J].IEEE Transactions on Knowledge and Data Engineering,2009,21(8):1118-1132. [6]Liu Li-zhen,Liang Qian-hui.A high-performing comprehensive learning algorithm for text classification without pre-labeled training set [J].Knowledge and Information Systems,2011,29(3):727-738.[7]Wang Tai-yue,Chiang Huei-Min.Solving multi-label text categorization problem using support vector machine approach with membership function[J].Neurocomputing,2011,74(17):3682-3689. [8]Chang Yi-sing.Automatically constructing an effective domain ontology for document classification[J].Computer Technology and Application,2011,2(3):182-189.[9]Chulyun Kim,Kyuseok Shim.Automatic template extraction from heterogeneous web pages[J].IEEE Transactions on Knowledge and Data Engineering,2011,23(4):612-626.[10]Jiang Jung-yi,Liou Ren-jia,Lee Shie-jue.A fuzzy selfconstructing feature clustering algorithm for text classification[J].IEEE Transactions on Knowledge and Data Engineering,2011,23(3):335-349.[11]祝伟华,卢熠,刘斌斌.基于HMM的Web信息抽取算法的研究与应用[J].计算机科学,2010,37(2):203-206.Zhu Wei-hua,Lu Yi,Liu Bin-bin.The research and application of Web information extraction based on HMM[J].Computer Science,2010,37(2):203-206.[12]王维娜.基于聚类算法的KNN文本分类系统研究与实现[D].海口:海南大学,2009.[13]张宁,贾自艳,史忠植.使用KNN算法的文本分类[J].计算机工程,2005,31(8):171-172.Zhang Ning,Jia Zi-yan,Shi Zhong-zhi.The text classification used KNN algorithm[J].Computer Engineering,2005,31(8):171-172.[14]袁津生,赵传刚.搜索引擎与信息检索教程[M].北京:中国水利水电出版社,2008:156-174.[15]陈玉芹.多类别科技文献自动分类系统[D].武汉:华中科技大学,2008:31-35.。

基于概念的文本类别特征提取与文本模糊匹配

1引言Internet和数字图书馆等信息查询服务都要求高效地组织海量的文本信息,因而文本特征提取和文本分类显得特别重要,它是当前智能信息服务系统研究的一个重点。

传统的文本类别特征提取是基于术语频度统计的,由于术语数量庞大,导致特征向量维数过大,并且各分量相关性太强,独立特征词选取困难且不精确。

因此,需要采取其他的途径来有效地表示类别。

将类别概念化,一方面可降低文本自动分类算法中特征向量的维数[1,4],另一方面,以特征概念为基础,对文本进行标引,用有限的概念来表征文本,既可方便地按知识规律组织和存储文本,同时也克服了文本不同语种的表述差异,为人们按类别进行精确信息的检索提供了依据。

由于知识体系的复杂性,类别的数量也比较多。

如中图分类法中,就有71168个类别(中图分类法第四版)。

随着知识、信息的膨胀,完全人工组织这些类别的特征显然是行不通的。

事实上,在文本自动分类算法中,类别的特征一般是通过训练文本来获取。

为了准确有效地提取类别的特征概念,笔者以类别训练文本集为基础,给出一种类别特征概念的提取方法。

并且基于这种特征表示,提出了一种通过模糊距离计算来对文本进行概念层次的匹配计算方法。

全文组织如下:第2节介绍了文本的向量空间模型,并给出文本的综合术语加权计算方法以及术语—概念空间的转换方法。

第3节主要描述训练算法中类别特征的表示与提取计算方法。

第4节给出基于模糊匹配的距离修正算法,最后归纳该文的主要贡献。

基于概念的文本类别特征提取与文本模糊匹配罗三定1陆文彦1王浩1贾维嘉21(中南大学信息科学与工程学院,长沙410083)2(香港城市大学电脑工程与信息技术系,香港)E-maiI:**************摘要文本信息特征提取和文本分类是当前智能信息服务系统基础研究的重点。

该文给出一种新的类别特征提取与文本匹配方法。

首先对术语特征权进行了综合计算,然后基于概念网络术语—概念映射关系,将特征权由术语空间转换到概念空间并做权值限幅处理。

文本分类算法的使用技巧和特征提取方法

文本分类算法的使用技巧和特征提取方法文本分类算法是自然语言处理领域的重要任务之一,它可以帮助我们对大规模的文本数据进行分类和归类,从而更好地理解和利用这些文本。

本文将介绍文本分类算法的使用技巧和特征提取方法,希望能够为研究者和开发者提供一些有用的参考。

首先,文本分类算法的使用需要考虑以下几个关键技巧。

第一,选择合适的训练数据集。

为了训练和评估文本分类算法,我们需要一个具有标注分类的训练数据集。

这个数据集应该包含足够数量和多样性的文本样本,以保证算法的泛化能力。

第二,进行数据预处理。

在使用文本分类算法之前,我们需要对原始文本进行一些预处理操作,如去除停用词、进行词形还原和词干提取等,以减少噪音和提高分类效果。

第三,选择适当的特征表示方法。

文本分类算法通常需要将文本转化为向量形式进行处理,我们可以使用词袋模型、TF-IDF等方法来表示文本特征,选择合适的方法可以帮助提高分类准确率。

第四,选择合适的分类器。

常用的文本分类算法包括朴素贝叶斯、支持向量机、深度学习等,我们需要根据具体任务选择合适的分类器,并进行调优和评估。

其次,特征提取是文本分类算法中一个关键的步骤。

文本的特点在于其高维、稀疏和复杂的数据结构,如何从文本中提取有用的特征是影响分类效果的重要因素。

以下是一些常用的特征提取方法:1. 词袋模型(Bag-of-Words):词袋模型是一种简单而常用的特征表示方法,它将文本看作一个无序的词集合,统计每个词在文本中出现的频次作为特征向量的值。

该方法忽略了词的顺序和语义信息,但在很多场景下表现良好。

2. TF-IDF(Term Frequency-Inverse Document Frequency):TF-IDF是基于词袋模型的一种改进方法,它考虑到了词的重要性和文本的普遍性。

TF-IDF将每个词在文本中出现的频次与在整个语料库中出现的频次相比较,通过权重余弦相似度来衡量词的重要性。

3. Word2Vec:Word2Vec是一种基于神经网络的词嵌入模型,它可以将词语表示为连续的实数向量。

基于特征值提取文本分类实施方案

基于特征值提取文本分类方案————————————————————————————————作者:————————————————————————————————日期:目录一、综述 (4)(一)实现目标 (4)(二)主要功能 (4)二、总体架构 (5)三、各模块建模挖掘层详解 (7)(一)无监督学习模块 .......................................... 错误!未定义书签。

(二)有监督学习模块 .......................................... 错误!未定义书签。

四、输入层和输出层详解 (9)(一)输入层 (9)(二)输出层 (9)基于特征值提取文本分类设计方案一、综述(一)实现目标本模块实现了对文本文档集合的分类特征值提取。

对输入的分类文档,基于词频、互信息、类别信息的综合特征,从每个分类中挖掘出对应的有效特征值。

该模块还实现了对特征值的权重计算,按照特征词的权重值,构造了分类器。

新增文本可以通过文本分类器进行分类,无法分类的文本可以人工分类后重新执行特征值抽取功能,重新调整特征值,从而达到优化分类器的目的。

该模块由Java编写,可用于任何需要挖掘文本主题的项目中,也可以单独使用。

(二)主要功能该模块的主要功能包括以下几个方面:●对原始语料库进行中文分词、去除停用词●词性过滤,只提取名词,动词●按类别进行特征词提取●特征词权重计算●文本分类二、总体架构训练数据预处理词库停用词词性过滤综合特征选择权重计算主题权重文件输出(主题名,前N 个特征,特征权重)待分析数据预处理词库停用词改进贝叶斯的快速文本分类器分类结果输入层数据挖掘层输出层三、挖掘层详解1. 文本分词中文分词采用开源的Ansj分词工具,基于中科院的ictclas 中文分词算法,采用隐马尔科夫模型(HMM),比其他常用的开源分词工具(如mmseg4j)的分词准确率更高。

Ansj是一款纯Java的、主要应用于自然语言处理的、高精度的分词工具,目标是“准确、高效、自由地进行中文分词”,可用于人名识别、地名识别、组织机构名识别、多级词性标注、关键词提取、指纹提取等领域,支持行业词典、用户自定义词典。

文本分类及其特征提取

Anheuser-Busch Joins Bid for San

Miguel

Italy’s La Fondiaria to Report Higher 1986 Profits

Isuzu Plans No Interim Dividend

Senator Defends U.S. Mandatory Farm Control Bill

分类的质量评估

Given n test documents and m classes in consideration, a classifier makes n m binary decisions. A two-by-two contingency table can be computed for each class.

tfc-weighting:考虑了文档的长短,使用本 字对本分类的信息量在所有字对本分类的 信息量之和的比例。

确定的aik方法(3)

ltc-weighting:类似tfc,弱化了一些fjk的权 重,在文献⑦中使用的表示方法。同时文献 ⑦中表示,在实际应用中,如果计算能力 有限可以丢弃idf因子。

1986

Japan Ministry Says

Open Farm Trade Would

Hit U.S.

Vieille Montagne Says 1986 Conditions

Unfavourable

Jardine Matheson Said It Sets Two-for-Five Bonus Issue Replacing “B”

词有数以10万计,每个文档中只出现几百个词, 所以向量表示是稀疏的。

而且向量维数巨大,不利于计算,并且分类性能 容易受到噪声的影响。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目录

一、综述 (2)

(一)实现目标 (2)

(二)主要功能 (2)

二、总体架构 (3)

三、各模块建模挖掘层详解 (4)

(一)无监督学习模块.............................................. 错误!未定义书签。

(二)有监督学习模块.............................................. 错误!未定义书签。

四、输入层和输出层详解 (6)

(一)输入层 (6)

(二)输出层 (6)

基于特征值提取文本分类设计方案

一、综述

(一)实现目标

本模块实现了对文本文档集合的分类特征值提取。

对输入的分类文档,基于词频、互信息、类别信息的综合特征,从每个分类中挖掘出对应的有效特征值。

该模块还实现了对特征值的权重计算,按照特征词的权重值,构造了分类器。

新增文本可以通过文本分类器进行分类,无法分类的文本可以人工分类后重新执行特征值抽取功能,重新调整特征值,从而达到优化分类器的目的。

该模块由Java编写,可用于任何需要挖掘文本主题的项目中,也可以单独使用。

(二)主要功能

该模块的主要功能包括以下几个方面:

●对原始语料库进行中文分词、去除停用词

●词性过滤,只提取名词,动词

●按类别进行特征词提取

●特征词权重计算

●文本分类

二、总体架构

三、挖掘层详解

1.文本分词

中文分词采用开源的Ansj分词工具,基于中科院的ictclas 中文分词算法,采用隐马尔科夫模型(HMM),比其他常用的开源分词工具(如mmseg4j)的分词准确率更高。

Ansj是一款纯Java的、主要应用于自然语言处理的、高精度的分词工具,目标是“准确、高效、自由地进行中文分词”,可用于人名识别、地名识别、组织机构名识别、多级词性标注、关键词提取、指纹提取等领域,支持行业词典、用户自定义词典。

Ansj实现了用户自定义词典的动态添加删除,当然,也支持从文件加载词典。

用户自定义词典默认路径:项目目录/library/userLibrary/userLibrary.dic。

格式为:[自定义词] [词性] [词频],其中[词性]和[词频]两项可以空缺不写。

本项目在Ansj原本自带的词典(367425条)基础上,扩展了以下词典:

1)从数据库中抽取的电信业务词库(5767条)

2)广深东佛城市信息精选词库(来源:搜狗细胞词库)(62617条)

3)搜狗标准词库(392778条)

4)搜狗精选词库(392507条)

5)搜狗万能词库(362333条)

本模块还提供了从数据库加载词库的功能。

目前整理了以下的数据库版本的词库:

1)公积金领域词(1332条)

2)医保领域词(2503条)

2.词性过滤

代词、连词、介词等的表征能力比较弱,因为一篇文本中的代词、连词或介词对于区分这个文本所属哪个领域几乎没什么参考价值。

为此可以将表征能力很差的词性的词过滤掉。

而名词和动词的表征能力最强,它们是文本中具有代表性的关键词项,因为大量的汉语知识表明,名词和动词是一个汉语句子中的核心部分,它们的简单组合,往往就可以表达出一种中心思想,一种主题。

因此,我们只保留名词和动词,将其他词性的词作为弱词性词过滤掉。

3.基于词频、互信息、类别信息的综合特征选择

1)词频:平常我们判别一篇文章的类型时,基本方法就是大致浏览一下文章,从文章里出现比较频繁的一些字眼即可判别出文章的类型。

词频最高的前几个词,基本上都是分类能力最强的词。

在中文文本自动分类中,高词频对分类贡献很大。

2)互信息:互信息表示特征与类别之间的相关程度。

当特征的出现只依赖于某一个类别时,特征与该类型的互信息很大;当特征与类型相互独立时,互信为O;当特征很少在该类型文本中出现时,它们之间的互信息为负数,即负相关。

度小的特征对互信息的影响大,使得低频特征具有较大的互信息。

3) 类别信息:

(1)特征项只出现在一个类中,从直观上看,这个特征项非常有价值,因为我们可以从统计规律来确定,只要某文档中出现此特征项,就可以确此文档的类别。

(2)如果特征项出现在两个或多个类当中,但在有些类中没有出现,那么此特征项也是有价值的。

它说明了出现此特征项的文档可能会属于某些类,并不应该属于另一些类。

(3)如果特征项在所有类中都出现了,并且出现的频率比较均,那么这样的特征项对分类就几乎没有价值,应当过滤掉。

也就是说,特征项出现的类别数越少,权重应该越大。

其中:t k为特征词t在q类中出现的词频,MI(t k,C j)为t k与q类的互信息,

N为训练文档集中包含的类别数,C tk为特征项t k出现的类别个数。

4.权重计算

对于特征的权重,我们是从测试文档的角度考虑的。

当一个待测文档与一个别进行比对时,我们往往需要找出待测文档中出现的最能说明它属于该类的词语。

此时我们需要考虑2个因素,一方面是词在c类中的代表性,另一方面是词在待

文章中的代表性。

考虑到以上两个因素,我们选择词的作为衡量词在c类中代表

性的标准,选择词在待测文章中出现的次数.

权重= 特征评估值* 词频

5.改进的贝叶斯分类

在文本训练阶段,每类根据特征评估函数选出最能代表类别的前k个特征词,注意在特征提取的候,只是简单的统计在某类文档中出现的频率,并不考虑出现的位置。

在分析阶段,将一篇待分类文档分词后,然后与第一个类别提取出的k 个词进行比对,若出现则计算权值,最后将得到的权值相加,作为文档与该类比较的最终结果。

待文档与所有类别比较完毕后,对最终结果由大到小排序,选出结果最大的作为最终的分类结果。

该算法的基本思想和贝叶斯分类器的思想相同,即计算文本属于类别的概率,文本属于类别的几率等于文本中每个词属于类别的几率的综合表达式。

但本算法提出了一种更有效的特征提取算法来衡量特征词与类别的相关性,并且利用新的权重计算方法来判断测试文本的类别,比传统的贝叶斯算法更加简单有效。

四、输入层和输出层详解

(一)输入层

文本输入允许有三种形式:

1)单个文本文件:将语料库整合为单个文本文件,文件的第一行为语料库

中文档的数量,之后每一行为一篇文档。

附加保存文档ID或标题的文

件,按行一一对应语料库中的文档。

2)数据库:数据库中的纯文本字段也可以作为系统的输入,一条记录表示

一篇文档。

另有字段对应文档的ID。

3)多个文本文件:所有文本表示一个语料库,一个文本文件代表一篇文档,

文件名为文档的ID或标题。

(二)输出层

模块的输出为分类结果,包含以下信息:

文本ID

所属分类名称。