Kettle 3.1 数据同步研究

基于kettle自动完成API数据解析入库

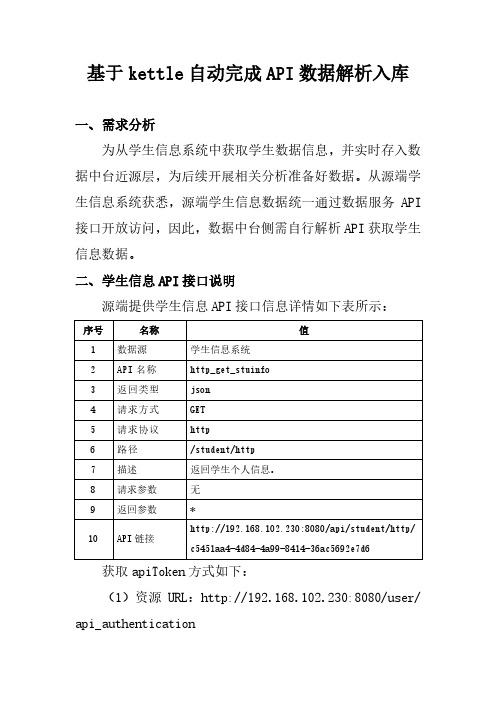

基于kettle自动完成API数据解析入库一、需求分析为从学生信息系统中获取学生数据信息,并实时存入数据中台近源层,为后续开展相关分析准备好数据。

从源端学生信息系统获悉,源端学生信息数据统一通过数据服务API 接口开放访问,因此,数据中台侧需自行解析API获取学生信息数据。

二、学生信息API接口说明源端提供学生信息API接口信息详情如下表所示:获取apiToken方式如下:(1)资源URL:http://192.168.102.230:8080/user/ api_authentication(2)HTTP协议:post(3)Content-Type:application/json;charset=UTF-8(4)POST Body JSON 参数:(5)返回成功示例:三、kettle设计3.1 转换设计根据转换需求,设计流程如下:(1)生成记录主要设置ETL 转换中用到的一些变量及其值,如下:配置截图如下:(2)REST client主要配置访问Restful 接口,配置截图如下:(3)JSON input主要配置对Json 格式的数据源进行解析,配置截图如下:(4)表输出主要配置向数据库的表中写入数据,目标表需提前创建。

配置截图如下:3.2 作业设计根据作业运行需求,设计作业运行流程如下:(1)Start作业起点,配置作业运行周期为2分钟,每2分钟自动执行一次作业,实现API数据的解析和入库。

(2)SQL通过SQL脚本,在每次作业运行前,先对目标表进行清空数据,脚本如下:(3)转换调用3.1章节已设计好的转换,配置截图如下:(4)发送邮件对上一步转换运行结果,及时通过发送邮件告知作业运行状态,分为运行成功和运行失败2种情况。

运行成功时,组件配置如下:运行失败时,组件配置如下:四、验证启动作业,运行结果如下:到目录库查看数据表,如下图显示,确认作业运行成功,数据如期写入目标表中,同时收到作业运行成功的邮件通知。

kettle解除同步条数限制

kettle解除同步条数限制

现象:最近在进⾏开发kettle程序的时候,在本地环境测试的时候是没有问题的,但是当上线到⽣产环境,每次当数据同步到10000条的时候,程序就卡主,也不报错,就是不往下进⾏了。

问题分析:1、⽣产个本地是相同的环境,所以先排除环境问题的⼲扰

2、在本次进⾏测试的时候,由于只是测试器功能,并未对其性能进⾏测试,故使⽤了少量的⼏条数据,⽽⽣产环境中源表中的数据量是三万条,并且根据问题的现象,判定是是由于数据量引起的。

3、经过排查发现,kettle有⼀个默认的条数限制,默认情况下是10000,也就是说,⼀个集合中只能查询出来10000条数据。

问题解决:既然找到问题的原因,那接下来就是解决问题了。

打开kettle,转换页⾯,双击空⽩处,会出现上图所⽰的弹框,在杂项中会看到记录集合中的记录数,需要修改这⼀栏的数值,也就是解除同步条数的限制,可以⼤概评估⼀下⾃⼰的数据量,来合理的设置该值,设置完成之后,重新运⾏,成功。

kettle的数据同步原理

kettle的数据同步原理The data synchronization principle of kettle is an essential aspect of its functionality.Kettle的数据同步原理是其功能的一个重要方面。

From a technical perspective, kettle's data synchronization works by establishing a connection between the kettle itself and a designated app or system, such as a smartphone app or a cloud-based platform. This connection allows the kettle to send and receive data, such as temperature settings, usage history, and maintenance alerts, ensuring that the user has real-time access and control over the kettle's operation.从技术角度来看,kettle的数据同步是通过在本身和指定的应用或系统(比如智能手机应用或基于云的平台)之间建立连接来实现的。

这种连接允许kettle发送和接收数据,比如温度设置、使用记录和维护警报,确保用户可以实时访问和控制kettle的操作。

From a user experience perspective, the data synchronization principle ensures that the kettle seamlessly integrates into the user's daily routine, providing convenience and peace of mind. By syncing data across devices, the user can have a unified experience, regardless of whether they are using the kettle from their smartphone, tablet, or any other compatible device.从用户体验的角度来看,数据同步原理确保kettle能够无缝地融入用户的日常生活,提供便利和安心。

用kettle爬取网页数据的简洁流程

用kettle爬取网页数据的简洁流程下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!用kettle爬取网页数据的简洁流程好的,以下是简洁的kettle爬取网页数据的流程,包括5个方面的详细描述和总结:流程概述:1. 配置爬虫任务:在kettle中创建新的转换,选择Web抓取步骤。

kettle中通过 时间戳(timestamp)方式 来实现数据库的增量同步操作(一)

kettle中通过时间戳(timestamp)方式来实现数据库的增量同步操作(一)这个实验主要思想是在创建数据库表的时候,通过增加一个额外的字段,也就是时间戳字段,例如在同步表tt1 和表tt2 的时候,通过检查那个表是最新更新的,那个表就作为新表,而另外的表最为旧表被新表中的数据进行更新。

实验数据如下:mysql database 5.1test.tt1( id int primary key , name varchar(50) );mysql.tt2( id int primary key, name varchar(50) );快照表,可以将其存放在test数据库中,同样可以为了简便,可以将其创建为temporary 表类型。

数据如图kettle-1kettle-1============================================== ==============主流程如图kettle-2kettle-2在prepare中,向tt1,tt2 表中增加时间戳字段,由于tt1,tt2所在的数据库是不同的,所以分别创建两个数据库的连接。

preparekettle-3在执行这个job之后,就会在数据库查询的时候看到下面的字段:kettle-4然后,我们来对tt1表做一个insert 操作一个update操作吧~kettle-5在原表上无论是insert操作还是update操作,对应的updateTime都会发生变更。

如果tt1 表和tt2 表中updateTime 字段为最新时间的话,则说明该表是新表。

下面只要是对应main_thread的截图:kettle-6在这里介绍一下Main的层次:MainSTARTMain.prepareMain.main_thread{STARTmain_thread.create_tempTablemain_thread.insert_tempTablemain_thread.tt1_tt2_synSUCCESS}Main.finishSUCCESS在main_thread中的过程是这样的:作为一个局部的整体,使它每隔200s内进行一次循环,这样的话,如果在其中有指定的表tt1 或是tt2 对应被更新或是插入的话,该表中的updateTime字段就会被捕捉到,并且进行同步。

Kettle(二)实战案例(1)关系型数据库之间的数据同步

Kettle(⼆)实战案例(1)关系型数据库之间的数据同步Kettle (⼆)实战案例 (1) 关系型数据库之间的数据同步操作前的准备:建库建表auto_increment=1 这个是修饰主键primary key,⾃动增长1--================================-- ⽇志库--================================create database etl;use etl;alter table control_table auto_increment =1;drop table control_table;create table control_table(id int primary key auto_increment,task_name varchar(255),run_flag int,created_at datetime,updated_at datetime);drop table task_log;create table task_log(id int primary key auto_increment,task_name varchar(50),status varchar(50),log_time datetime);--================================-- 测试数据--================================use test;drop table order_detail;create table order_detail(id bigint,user_id bigint,product_id bigint,status varchar(50),amount double,created_at datetime,updated_at datetime);insert into order_detailselect1,123,10001,'new',100.2,now(),now();commit;--step2insert into order_detailselect2,222,10001,'new',200,now(),now();update order_detailset status ='success'where id =1;commit;select*from order_detail;create database ods;create table order_detail(id bigint,user_id bigint,product_id bigint,status varchar(50),amount double,created_at datetime,updated_at datetime);use etl;insert into control_table(task_name,run_flag,created_at,updated_at) select'order_detail',1,now(),now()from dual;insert into control_table(task_name,run_flag,created_at,updated_at) select'customer',0,now(),now()from dual;commit;select*from control_table;commit;select task_namefrom control_tablewhere run_flag =1;--=====================================-- mysql 表--=====================================use test;drop table customer;create table customer(user_id bigint,user_name varchar(50),created_at datetime,updated_at datetime);drop table product;create table product(id bigint,product_id bigint,product_name varchar(50),created_at datetime,updated_at datetime);insert into productselect1,1,'name1',now(),now();commit;drop table product_info;create table product_info(product_id bigint,product_name varchar(50),created_at datetime,updated_at datetime);--===================================delete from etl.control_table where task_name ='customer';insert into etl.control_table(task_name,run_flag,created_at,updated_at) select'customer',1,now(),now()from dual;delete from etl.control_table where task_name ='product';insert into etl.control_table(task_name,run_flag,created_at,updated_at) select'product',1,now(),now()from dual;delete from etl.control_table where task_name ='product_info'; insert into etl.control_table(task_name,run_flag,created_at,updated_at) select'product_info',1,now(),now()from dual;commit ;select*from etl.control_table;关系型数据库间的同步开始-->初始化变量-->写⽇志--加载数据到关系型数据库中(数据的转换和同步),如果转换同步失败就会重试(先判断重试次数,然后等待15秒再继续尝试执⾏),如果转换同步成功,就会写⽇志然后更新元数据信息,最后同步转换数据成功。

利用 kettle 实现数据迁移的实验总结

数据迁移是指将数据从一个系统或评台移动到另一个系统或评台的过程。

在进行数据迁移时,我们通常需要借助一些工具来帮助我们高效地完成数据迁移任务。

Kettle 是一款功能强大的开源数据集成工具,它可以帮助用户实现数据的抽取、转换和加载(ETL)操作,非常适用于数据迁移的实施。

在本文中,我们将结合我们的实际经验,对利用Kettle 实现数据迁移的实验进行总结,并共享一些经验和教训。

一、实验背景1.1 实验目的在进行数据迁移的实验之前,我们首先需要明确实验的目的和意义。

数据迁移的目的通常是为了将数据从一个系统迁移到另一个系统,实现数据的共享、备份或者更新等操作。

我们希望通过本次实验,探索并验证 Kettle 工具在数据迁移中的实际效用,为以后的项目工作提供参考和借鉴。

1.2 实验环境在进行实验之前,我们需要搭建相应的实验环境,以确保实验的顺利进行。

在本次实验中,我们使用了一台装有 Windows 操作系统的服务器,并在上面成功安装了Kettle 工具。

我们还准备了两个数据源,分别用于模拟数据的来源和目的地,以便进行数据迁移的实验。

二、实验过程2.1 数据抽取在进行数据迁移之前,我们首先需要从数据源中抽取需要迁移的数据。

在本次实验中,我们使用 Kettle 工具的数据抽取功能,成功地将源数据抽取到 Kettle 中,并对数据进行了初步的清洗和处理。

通过Kettle 的直观界面和丰富的抽取组件,我们轻松地完成了数据抽取的工作,为后续的数据转换和加载操作奠定了基础。

2.2 数据转换在数据抽取之后,我们往往需要对数据进行一定的转换和处理,以满足目的系统的要求。

在本次实验中,我们利用 Kettle 的数据转换功能,对抽取得到的数据进行了格式化、清洗和加工操作。

Kettle 提供了丰富的转换组件和灵活的数据转换规则,让我们能够快速地实现各种复杂的数据转换需求。

Kettle 还支持可视化的数据转换设计,让我们可以直观地了解数据转换的过程和结果。

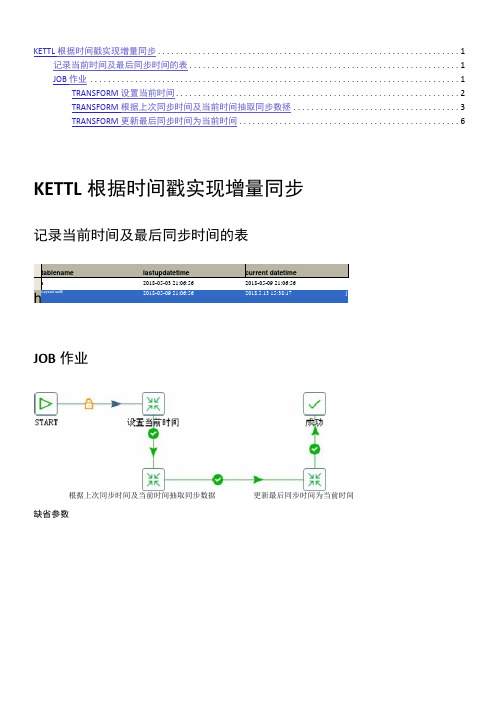

KETTLE根据时间戳实现增量同步

KETTL根据时间戳实现增量同步 (1)记录当前时间及最后同步时间的表 (1)JOB作业 (1)TRANSFORM设置当前时间 (2)TRANSFORM根据上次同步时间及当前时间抽取同步数拯 (3)TRANSFORM更新最后同步时间为当前时间 (6)KETTL根据时间戳实现增量同步记录当前时间及最后同步时间的表JOB作业根据上次同步时间及当前时间抽取同步数据更新最后同步时间为当前时间缺省参数rr a&a&:$ (XnlarxL^l. Eatry. Currant. Bircict&r?O | 型菟..Op i ionic 世Ct曰古Ar xwi-ntx命爼为尊.Rur» conE3 jjur »t i on 'P<Ko 1 aa<lE=・CU<AQSV□执行毎一个辙入行^□在执行笳涵附结束行郭丙□在执行狛啟豳》!文件列衣?B勢得;云侔转找扶•行型宝□本IA转投线止时氐理转换也曲知耀止[①他“]缺省参数口回冈rrtuis fot-mat a on:$<Intarn<l. Entry. Currant. Diroctar'O ( SliS. • 7")Oxtlonc ift矗曰忠2arangy iCW公i8?口但制上一册於舉SlMtrE公数0临朋吉芳敬<fi別伎逆逊子芬换命E公矽[荻职乡皴][① He"]TRANSFORM设置当前时间执行SQL语句-设蚤当前时间B 回冈步聘令怖 4 m 行so 旬-疋鉴古at 时恒銀頭]迪 丨Vizard.迪行<5—扫。

口Exacuta s a sincl<r EtysojU 匸 1 灰7彰血口£Lnd patunat^r i? I Quot« S tri&ca?-】update tjastupdatetimeset currentdatetime = date 」ormat(now()/%Y-%c-%d %H:%i:%s‘) where tablename^t^zyml^xxx*TRANSFORM 根据上次同步时间及当前时间抽取同步数据设置变量-最后同步时间及当前时间 表输入一读取最后同步时间到当前时间源表数据厶1 非为涉咖1宁欧1SOL script to execute. Cstaterients sep^rated by . ) Ones11on narks will be repL^ced by arcunertts⑦Hdp®-^-K6入世孩如:越@含咄唆程寒的宁2包含淒M 豹字仪-表输入SELECTlastupdatetime,currentdatetimeFROM tjastupdatetimewhere tablename='t_zyml_xxx°步骤名称:设置变量-绘后同步时间及当前时间I A p p l y f o r m a t t i n g[y]SELECTID Z ZYMUD, ZWMC z YWMC, SJLX, SJCD, CZRY, CZRYMC, CZDW, CZDWMC, CZRQ GXLX, GXTJ, SFXSHKF, KFTJ, GXZQ FBRQ PARENTDEPART, lastupdatetimeFROM t_zyml_xxx where SFXSHKF=Tand lastupdatetime>= and lastupdatetime <SB®Xdp ] [ 确定@) ][ 取消 © ] I 亚比枝符擁里的宇段1爲里的宇段21ID二ID更新用来査询的关薛字:史斬宁段:|立耿宇啟」TD012345679 23456TS9111111111HLHCMUrcIQ丽训珂加口切於切认皿曲 缢蟲SJ1CCZCZCZCZCZ发盂亂Em ZYWUBZWWC WWC SJLI SJCDCZXT CZ 辭忙 CZDY UZDYWC CZRQ 欲LI cocrj SFXSHKF N?rj GXZQ FBRQFARERTDEFAR7TRANSFORM更新最后同步时间为当前时间执行SQL语句-更新最后同步时间为当前时间update tjastupdatetimeset lastupdatetime = currentdatetimewhere tablename=,t_zyml_xxx,。

Kettle定时同步数据库方法

Kettle定时同步数据库方法

Kettle定时同步数据库方法

安装Kettle

一、需要安装JDK1.8

二、配置本机的JAVA环境变量

三、解压pdi-ce-7.0.0.0-25压缩包

四、将用到的数据库Jar包Copy到lib文件夹下

五、打开Spoon.bat程序进行操作

使用Kettle

一、连接数据库。

右键点击转换——新建——点击主对象树——DB连接——创建

1、配置数据库连接(需要配置目标数据库和源数据库的连接)选

择数据库并根据本机配置连接属性

二、创建转换。

1.点击核心对象——输入——拖动表输入到页面上——在页面上双击表输入——选择源数据库连接——获取SQL查询语句

2.点击输出——拖动表输出到页面上——双击表输出——选择数据库连接——浏览选择目标表

3.将两个转换摁住shift键连接起来,点击左上角开始按钮运行转换,确认可以正常运行后,保存到本地文件夹中。

三、创建作业定时执行转换

1.右上角New file新建一个作业,在作业中创建DB 连接,点击核心对象——通用,依次从列表中托出START、转换、成功,并连接。

双击转换选择创建好的转换文件位置。

2.点击START设置定时执行的时间

3.完成定时同步数据库。

2024年史上最强Kettle培训教程

史上最强Kettle培训教程一、引言Kettle是一款开源的ETL工具,具有简单易用、功能强大、扩展性强等特点。

本教程旨在帮助读者全面了解Kettle的基础知识、高级应用以及最佳实践,从而掌握这款强大的ETL工具。

二、Kettle简介1.1Kettle概述Kettle是一款基于Java开发的ETL工具,主要用于数据抽取、转换和加载。

它由Pentaho公司开发,并在2006年开源。

Kettle支持多种数据源,如关系型数据库、文本文件、Excel文件等,并且提供了丰富的转换组件,可以满足各种复杂的数据处理需求。

1.2Kettle主要组件Kettle主要包括两个组件:Spoon和Pan。

Spoon是Kettle的图形界面设计工具,用于创建和编辑ETL转换;Pan是Kettle的命令行执行工具,用于执行Spoon中创建的转换。

三、Kettle基础教程2.1环境搭建2.2Spoon界面介绍启动Spoon,看到的是欢迎界面。

“新建”按钮,创建一个转换或作业。

在转换编辑界面,左侧为组件面板,右侧为画布。

在画布上,我们可以通过拖拽组件来创建ETL流程。

2.3创建转换在本节中,我们将学习如何创建一个简单的ETL转换。

从组件面板中拖拽一个“表输入”组件到画布上,双击该组件,设置数据库连接和SQL查询。

然后,拖拽一个“表输出”组件到画布上,双击该组件,设置目标数据库连接和表名。

将“表输入”和“表输出”组件连接起来,保存并运行转换。

2.4执行转换pan.sh-file=/path/to/your/transformation.ktr其中,`/path/to/your/transformation.ktr`为转换文件的路径。

四、Kettle高级教程3.1数据类型转换在ETL过程中,我们经常需要对数据进行类型转换。

Kettle提供了丰富的类型转换组件,如“复制记录”、“字段选择”等。

在本节中,我们将学习如何使用这些组件进行数据类型转换。

2024版kettle使用教程(超详细)

分布式计算原理

阐述Kettle分布式计算的原理, 如何利用集群资源进行并行处理 和任务调度。

01 02 03 04

集群配置与部署

详细讲解Kettle集群的配置步骤, 包括环境准备、节点配置、网络 设置等。

集群监控与管理

介绍Kettle提供的集群监控和管 理工具,方便用户实时了解集群 状态和作业执行情况。

03

实战演练

以一个具体的实时数据处理任务为例, 介绍如何使用Kettle设计实时数据处理 流程。

案例四:Kettle在数据挖掘中应用

数据挖掘概念介绍

01

数据挖掘是指从大量数据中提取出有用的信息和知识的

过程,包括分类、聚类、关联规则挖掘等任务。

Kettle在数据挖掘中的应用

02

Kettle提供了丰富的数据处理和转换功能,可以方便地

Chapter

案例一:ETL过程自动化实现

ETL概念介绍

ETL即Extract, Transform, Load,是数据仓 库技术中重要环节,包括数据抽取、清洗、转 换和加载等步骤。

Kettle实现ETL过程

通过Kettle的图形化界面,可以方便地设计ETL流程, 实现数据的自动化抽取、转换和加载。

作业项配置

对作业项进行详细配置,包括数据源、目标库、 字段映射等。

作业项管理

支持作业项的复制、粘贴、删除等操作,方便快速构建作业。

定时任务设置与执行

定时任务设置

支持基于Cron表达式的定时任务设置,实现 周期性自动执行。

立即执行

支持手动触发作业执行,满足即时数据处理 需求。

执行日志查看

Kettle 3.1 数据同步研究

Kettle 3.1 数据同步研究摘要:随着信息化的发展,各应用系统之间共用数据越来越普遍。

Kettle就像水壶一样,各种数据流入壶里,然后以一种指定的格式流出,这就使得完成数据同步工作变得高效稳定、安全可靠。

关键词:Kettle;触发器;数据同步0引言随着信息技术的日益的发展,各应用系统间的数据同步问题也凸现出来。

目前,众多系统和应用都对数据的完整性和安全性要求很高,同时又不能降低系统的灵活性,为此数据库层面的数据同步技术被广泛应用。

数据同步的方法有很多,而借助Kettle工具来完成数据库之间的数据同步工作是一个非常正确的选择。

Kettle是一款国外开源的ETL工具,纯Java编写,可以在Window、Linux、Unix等多个系统平台上运行,绿色无需安装,数据抽取高效稳定。

Kettle是“Kettle E.T.T.L. Envirnonment”首字母的缩写,这就意味着它被设计用来帮助实现用户的ETTL需要:抽取、转换、装入和加载数据。

Kettle的中文意思为水壶,该项目的主程序员Matt希望把各种数据放到一个壶里,然后以一种指定的格式流出,这就是Kettle名字的由来。

1技术理论概述利用Kettle作为中间软件来实现数据同步的方法有很多,其中比较常用的有以下5种方法:触发器法、日志法、时间戳法、数据比较法以及全表拷贝法。

本文主要介绍的是利用Kettle通过触发器法同步不同数据源之间的数据。

触发器法的原理及流程:为源数据库相应的表建立新增、修改、删除3个触发器,和一个与源表相对应的临时表。

每当源数据库有数据变化时,相应的触发器就会被触发,触发器会将变更的数据保存在临时表中,然后再利用Kettle同步数据到目标数据库相应的表中,这样就完成了不同数据库中相应表的数据同步。

其流程如图1所示。

2运行环境和准备工作本文主要针对Oracle10G进行研究测试,两台数据库服务器安装的操作系统是Windows2003企业版。

基于Kettle的数据转换同步方法研究

基于Kettle的数据转换同步方法研究

韦亚军;张文文;李冬青

【期刊名称】《软件导刊》

【年(卷),期】2022(21)8

【摘要】为解决自然资源信息化体系建设过程中的数据整合问题,更加高效、安全、灵活地实现自然资源各部门业务的数据转换、同步工作,从业务需求角度出发,分析

数据整合技术的应用现状,开展对开源ETL工具Kettle的研究。

通过分析Kettle的概念模型及应用场景,结合自然资源信息化体系建设中数据多源、数据量大、结构

复杂的特点,构建基于Kettle的源数据库转换同步环境,并提出一种新的基于Kettle 的数据转换同步方法。

在实际项目案例中进行应用验证,与传统方法相比,基于Kettle的数据转换同步方法提高了ETL的开发速度和工作效率,不仅解决了自然资

源信息化建设过程中多源数据到目标数据的转换、同步难题,同时也为其他企业数

据集成工作提供了更多思路。

【总页数】6页(P126-131)

【作者】韦亚军;张文文;李冬青

【作者单位】南京国图信息产业有限公司

【正文语种】中文

【中图分类】TP301.6

【相关文献】

1.一种基于Kettle的无损增量数据同步方法研究

2.基于Kettle的数据整合研究与实践

3.基于KETTLE的专项项目库数据同步方法研究

4.一种基于Kettle的无损增量数据同步方法研究

5.基于Kettle数据传输与同步方法的研究

因版权原因,仅展示原文概要,查看原文内容请购买。

kettle实现表同步

同步数据常见的应用场景包括以下4个种类型:Ø只增加、无更新、无删除Ø只更新、无增加、无删除Ø增加+更新、无删除Ø增加+更新+删除1只增加、无更新、无删除对于这种只增加数据的情况,可细分为以下2种类型:1) 基表存在更新字段。

通过获取目标表上最大的更新时间或最大ID,在“表输入”步骤中加入条件限制只读取新增的数据。

这里要注意的是,获取最大更新时间或最大ID时,如果目标表还没有数据,最大值会获取不了。

其中的一个解决方法是在“获取最大ID”步骤的SQL中,加入最小日期或ID的联合查询即可,如:SELECT MAX(ID) FROM(SELECT MAX(ID) AS ID FROM T1 UNION ALL SELECT 0 AS ID FROM DUAL)2) 基表不存在更新字段。

通过“插入/更新”步骤进行插入。

插入/更新步骤选项:2只更新、无增加、无删除通过“更新”步骤进行更新。

更新选项:3增加+更新、无删除通过“插入/更新”步骤进行插入。

区别是“插入/更新步骤”中的选项,去掉“不执行任何更新”的勾选:4增加+更新+删除这种数据同步情况,可细分为以下2种情况:1) 源库有表保存删除、更新和新增的信息。

通过条件判断,分别进行“插入/更新”和“删除”即可,如下图所示。

2) 源库没有保存增删改信息Kettle提供了一种对比增量更新的机制处理这种情况,可通过“合并记录”步骤实现,该步骤的输入是新旧两个数据源,通过关键字进行数据值比对,对比结果分为以下4种类型:“Identical” : 关键字在新旧数据源中都存在,域值相同“changed” : 关键字在新旧数据源中都存在,但域值不同“new” :旧数据源中没有找到关键字“deleted”:新数据源中没有找到关键字两个数据源的数据都进入下一步骤,上述4种结果类型作为输出表的标志字段进行保存。

以下为示例:Ø源数据库测试脚本create table k1 (f1 varchar2(200),f2varchar2(200))truncate table k1;insert into k1(f1,f2) values('1','11');insert into k1(f1,f2) values('2','22');insert into k1(f1,f2) values('5','5');commit;Ø目标数据库测试脚本create table k1 (f1 varchar2(200),f2varchar2(200))truncate table k1;insert into k1(f1,f2) values('1','1');insert into k1(f1,f2) values('2','2');insert into k1(f1,f2) values('3','3');insert into k1(f1,f2) values('4','4');commit;合并过程如下:其中“合并记录”步骤的选项:执行后,查询K1_TEST结果如下:可以看到,该结果表的BZ字段保存了更新、删除、新增的记录信息,通过条件分支即可分别对这些记录进行相应的处理。

一种基于数据血缘分析的数据治理方法研究与应用

一种基于数据血缘分析的数据治理方法研究与应用【摘要】:在数据中台的建设过程中,作为数据治理的重要手段,引入了数据血缘可视化分析的思想,针对数据表级、字段级等不同级别下的数据实现,介绍了数据血缘解析、数据血缘可视化两个部分的技术架构和解决方案,以及在电力交易数据管理中的应用,从而提高对数据加工和处理过程的监控和管理水平。

【关键词】:数据血缘;数据中台;数据治理1 研究背景随着大数据、云平台等技术的发展,很多企业开启了数字化、智能化转型的战略,采用了数据中台的建设思想,将传统的独立的信息孤岛进行整合,建立企业的数据资产体系,提供数据产品和数据服务的能力。

然而,在实施的过程中,在数据治理方面会面临非常大的困难和挑战,具体如下:(1)数据流向及关联关系展现:数据中台的架构通常采用数据分层建模的体系,会按照数据仓库的建模规范对业务数据进行分层建模,从下而上依次是贴源层(ODS)、明细层(DWD)、汇总层(DWS)、应用层模型(ADS),各层之间相互独立,又相互关联,上层的数据都由下一层的数据加工获取,而原始数据位于数仓的最底层,离应用层数据还有多层的数据加工。

因此不同层级之前的数据库表存在着错综复杂的数据流向关系,随着项目规模的扩大,数据管理者无法从全局角度清晰地查看整体系统的数据流向及关联关系。

(2)数据质量的可追溯性[1]:在进行数据处理的过程中,往往会出现对一些数据质量问题,然而数据处理过程环节多,实现形式多样,依赖关系复杂,数据开发和运维人员很难准确记忆数据的来龙去脉,很难及时有效地定位问题的位置,同样当某个数据处理环节出现问题时,也难以分析影响的范围。

(3)面向非结构化文件数据内容的血缘分析:随着大数据技术的发展和普及,相比传统的数据仓库体系,数据来源和数据产品呈现多样化特点,例如word、PDF、excel、E文件等。

因此,需要研究对非结构文件的数据血缘分析能力,使之能够支持从数据产生到数据应用的全链路的跟踪和监控,并且能够提供良好的交互模式。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Kettle 3.1 数据同步研究

摘要:随着信息化的发展,各应用系统之间共用数据越来越普遍。

Kettle就像水壶一样,各种数据流入壶里,然后以一种指定的格式流出,这就使得完成数据同步工作变得高效稳定、安全可靠。

关键词:Kettle;触发器;数据同步

0引言

随着信息技术的日益的发展,各应用系统间的数据同步问题也凸现出来。

目前,众多系统和应用都对数据的完整性和安全性要求很高,同时又不能降低系统的灵活性,为此数据库层面的数据同步技术被广泛应用。

数据同步的方法有很多,而借助Kettle工具来完成数据库之间的数据同步工作是一个非常正确的选择。

Kettle是一款国外开源的ETL工具,纯Java编写,可以在Window、Linux、Unix等多个系统平台上运行,绿色无需安装,数据抽取高效稳定。

Kettle是“Kettle E.T.T.L. Envirnonment”首字母的缩写,这就意味着它被设计用来帮助实现用户的ETTL需要:抽取、转换、装入和加载数据。

Kettle的中文意思为水壶,该项目的主程序员Matt希望把各种数据放到一个壶里,然后以一种指定的格式流出,这就是Kettle名字的由来。

1技术理论概述

利用Kettle作为中间软件来实现数据同步的方法有很多,其中比较常用的有以下5种方法:触发器法、日志法、时间戳法、数据比较

法以及全表拷贝法。

本文主要介绍的是利用Kettle通过触发器法同步不同数据源之间的数据。

触发器法的原理及流程:为源数据库相应的表建立新增、修改、删除3个触发器,和一个与源表相对应的临时表。

每当源数据库有数据变化时,相应的触发器就会被触发,触发器会将变更的数据保存在临时表中,然后再利用Kettle同步数据到目标数据库相应的表中,这样就完成了不同数据库中相应表的数据同步。

其流程如图1所示。

2运行环境和准备工作

本文主要针对Oracle10G进行研究测试,两台数据库服务器安装的操作系统是Windows2003企业版。

准备工作如下:

2.1JDK的安装

安装JDK1.6或以上版本。

2.2JA V A环境配置

编辑用户变量:JA V A_HOME C:Javajdk1.6.0_29;

编辑系统变量:Path C:Javajdk1.6.0_29bin。

2.3新建测试表和触发器

(1)源数据库。

创建源表,表名为TAB1,源表为提取同步数据的表,其创建SQL语句如下:

create table TAB1 (XH V ARCHAR2(20),AA V ARCHAR2(20),BB V ARCHAR2(20));

创建临时表,表名为TAB2,临时表为记录源表发生数据新增、修改或删除操作动作的表,其创建SQL语句如下:

create table TAB2 (OPT V ARCHAR2(20),OLDXH V ARCHAR2(20),XH NUMBER(10),AA V ARCHAR2(20),BB V ARCHAR2(20));

创建新增触发器,触发器名为Ins_TAB1,源表发生新增数据操作时,此触发器被触发,其创建SQL语句如下:

create or replace trigger Ins_TAB1 after insert on TAB1 For each Row begin Insert Into TAB2 (OPT,XH,AA,BB)values ('I',:new.XH,:new.AA,:new.BB);end ;

创建修改触发器,触发器名为Upd_TAB1,源表发生修改数据操作时,此触发器被触发,其创建SQL语句如下:

create or replace trigger Upd_TAB1 after update on TAB1 For each Row begin Insert Into TAB2 (OPT,OLDXH,XH,AA,BB)values ('U',:old.XH,:new.XH,:new.AA,:new.BB);end;

创建删除触发器,触发器名为Del_TAB1,源表发生删除数据操作时,此触发器被触发,其创建SQL语句如下:

create or replace trigger Del_TAB1 after delete on TAB1 For each Row begin Insert Into TAB2 (OPT,OLDXH)values ('D',:old.XH);end;

(2)目标数据库。

创建目标表,表名为TAB3,目标表为需要同步数据的表,其创建SQL语句如下:

create table TAB3 (XH V ARCHAR2(20),AA V ARCHAR2(20),BB V ARCHAR2(20));

3Kettle同步数据

我们将每个需要同步的数据表叫做一个数据接口,每个接口都给定一个接口编号,设计一个配置表来存放接口的相关信息。

每次运行时先根据接口编号从配置表中取出需要抽取数据操作类型。

按照特定时间段从源表提取数据,然后更新到目标数据库的相应表中。

在同步过程中,临时表TAB2起到了举足轻重的作用,它是整个同步过程的关键。

临时表TAB2中的字段OPT是标记操作类型的字段,当源表TAB1发生新增、修改、删除操作时,相应触发器被触发,OPT字段被填入相应的值“I”、“U”、“D”,标记了相应的新增、修改、删除操作。

字段OLDXH是在源表TAB1数据发生修改或删除时起作用,它记录了源表TAB1被修改或删除某条数据之前,主键字段XH的值。

在对目标表TAB3相应数据做修改或删除时,字段OLDXH 的值被作为唯一查询条件来确定被修改或删除的是哪条记录。

XH、AA和BB字段是源表TAB1中的原有字段,记录了源表TAB1新增或修改后每个字段的最新当前值,在对目标表TAB3相应数据做新增或修改时,这3个字段的值将被从临时表TAB2更新到目标表TAB3中。

数据同步过程有以下几个最核心的部分:

(1)提取数据。

从数据库表里读取临时表TAB2的数据信息,表TAB2中包含表TAB1中所有添加、修改、删除的信息,字段OPT 标记操作类型,字段XH为主键,判断、确定更新数据。

(2)字段选择。

提取表中数据后,选择、比对、修改需要同步

的数据,源表TAB1与目标表TAB3需要同步数据的字段一一对应。

(3)同步数据。

根据临时表TAB2中标记的操作类型,新增、修改、删除目标表TAB3中的数据。

(4)删除数据。

数据同步成功后,删除临时表TAB2中标记操作的数据,以免重复更新数据。

数据同步核心过程如图2所示。

4成果检验

经过测试,上述方法完全能够实现数据的同步更新,并处于稳定的应用中,但数据仅做到单向同步。

源表TAB1中的数据新增、修改或删除后,记录操作在临时表TAB2中,利用Kettle处理数据后,目标表TAB3中的数据同步成功,临时表TAB2中标记操作的数据被删除。

此时,表TAB1和表TAB3中的数据一致,表TAB2无数据。

5结语

对于利用Kettle工具对数据库数据进行同步的研究,此次实验仅仅是把一个Oracle数据库中某一张表的数据单向同步到另一个Oracle数据库中相应的一张表中。

Kettle这个ETL工具集,它允许用户管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述用户想做什么,而不是用户想怎么做。

Kettle中有两种脚本文件:transformation和job,transformation完成针对数据的基础转换;job 则完成整个工作流的控制。

作为Pentaho的一个重要组成部分,现在在国内项目应用上逐渐增多。

目前,Kettle支持绝大部分数据库,可以做到不同类型的多个数据库之间数据的同步更新。

而触发器法也仅

仅是其中的一个方法,还有很多更加新颖、更加优化的方法需要进一步探索和研究。

参考文献:

[1]孙风栋. Oracle 10g数据库基础教程[M].第2版.北京:电子工业出版社,2012.

[2](美)欧文斯.Oracle触发器与存储过程高级编程[M].第3版.欧阳宇,译.北京:清华大学出版社,2004.。