人工神经网络学习总结笔记

基础知识续人工神经网络常用学习规则

基于误差函数的梯度信息,沿着梯度的负方向更 新权重和偏置,以逐渐减小误差。

03 应用场景

适用于训练多层前馈神经网络,尤其是深度神经 网络。

反向传播算法

定义

反向传播算法是一种监督学习算 法,通过计算输出层与目标值之 间的误差,逐层反向传播误差, 并更新神经网络的权重和偏置。

工作原理

基于链式法则,将误差信号从输 出层向输入层逐层传递,并根据 误差梯度调整权重和偏置。

自组织映射

概念

01

自组织映射是一种无监督学习规则,通过训练神经网络来学习

输入数据的低维表示。

工作原理

02

通过迭代地更新神经元的权重,使得相似的输入数据映射到同

一神经元上,从而形成低维表示。

应用场景

03

自组织映射常用于数据压缩、可视化、聚类和特征提取等任务。

贪婪逐层预训练

概念

贪婪逐层预训练是一种无监督学习规则,通过逐层贪婪地训练神经网络来预训练模型。

梯度下降法简单易行,适用于大多数 情况,但可能会陷入局部最小值,影 响学习效果。

反向传播算法

反向传播算法是另一种常用的学习规则,通过计 算输出层与目标值之间的误差来反向传播误差, 并更新权重。

反向传播算法能够自动调整权重,适用于多层神 经网络,但计算量较大,训练时间较长。

随机梯度下降法

随机梯度下降法是一种基于梯度下降 法的变种,每次迭代只使用一个样本 来计算梯度,提高了训练速度。

在实际应用中的挑战与机遇

挑战

如何克服数据噪声和过拟合问题,提高网络的泛化能力; 如何设计更有效的网络结构,满足复杂任务需求。

机遇

随着技术的发展,人工神经网络在各个领域的应用越来 越广泛,如自然语言处理、计算机视觉、语音识别等; 同时,随着计算能力的提升,更大规模的网络训练成为 可能,为解决复杂问题提供了更多可能性。

神经网络学习笔记-激活函数的作用、定义和微分证明

神经⽹络学习笔记-激活函数的作⽤、定义和微分证明神经⽹络学习笔记 - 激活函数的作⽤、定义和微分证明看到上对激活函数(Activation Function)的解释。

我⼀下⼦迷失了。

因此,匆匆写下我对激活函数的理解。

激活函数被⽤到了什么地⽅⽬前为⽌,我见到使⽤激活函数的地⽅有两个。

逻辑回归(Logistic Regression)神经⽹络(Neural Network)这两处,激活函数都⽤于计算⼀个线性函数的结果。

了解激活函数激活函数的作⽤:就是将权值结果转化成分类结果。

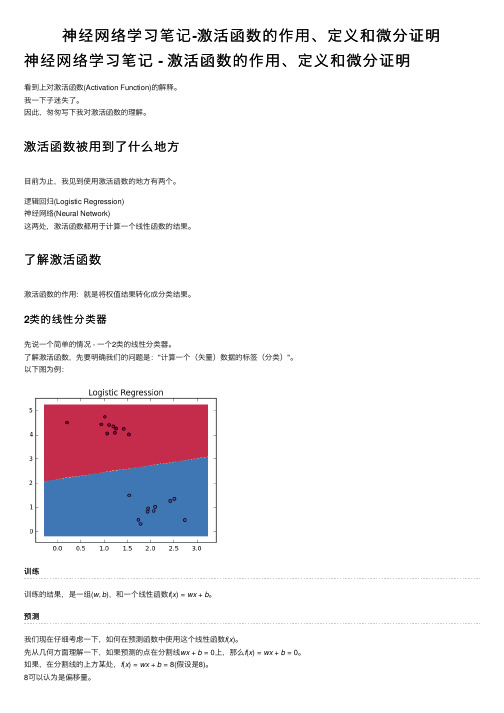

2类的线性分类器先说⼀个简单的情况 - ⼀个2类的线性分类器。

了解激活函数,先要明确我们的问题是:"计算⼀个(⽮量)数据的标签(分类)"。

以下图为例:训练训练的结果,是⼀组(w,b),和⼀个线性函数f(x)=wx+b。

预测我们现在仔细考虑⼀下,如何在预测函数中使⽤这个线性函数f(x)。

先从⼏何⽅⾯理解⼀下,如果预测的点在分割线wx+b=0上,那么f(x)=wx+b=0。

如果,在分割线的上⽅某处,f(x)=wx+b=8(假设是8)。

8可以认为是偏移量。

注:取决于(w, b),在分割线上⽅的点可以是正的,也可能是负的。

例如: y - x =0,和 x - y = 0,这两条线实际上是⼀样的。

但是,应⽤点(1, 9)的结果,第⼀个是8, 第⼆个是 -8。

问题然后,你该怎么办???如何⽤这个偏移量来得到数据的标签?激活函数激活函数的作⽤是:将8变成红⾊。

怎么变的呢?⽐如:我们使⽤sigmoid函数,sigmoid(8) = 0.99966464987。

sigmoid函数的结果在区间(0, 1)上。

如果⼤于0.5,就可以认为满⾜条件,即是红⾊。

3类分类器的情况我们再看看在⼀个多类分类器中,激活函数的作⽤。

以下图为例:训练3类a,b,c分类器的训练结果是3个(w,b),三个f(x),三条分割线。

每个f(x),可以认为是针对⼀个分类的model。

神经网络读书笔记

神经网络部分知识点总结一、神经网络的基础1.1神经网络概念神经网络是由简单处理单元构成的大规模并行分布式处理器,天然具有存储经验知识和使之可用的特性。

神经网络在这两方面与大脑相似:1.神经网络是通过学习过程从外界环境中获取知识的。

2.互连神经元的连接强度,即突触权值,用于存储获取的知识。

1.2神经网络性质和能力神经网络具有以下有用的性质和能力:1.非线性:人工神经网络可以是线性或者非线性的。

2.输入输出映射:称之为有教师学习(learning with a teacher)或监督学习(supervised learning)的关于学习的流行方法。

它使用带标号的的训练样例(training example)或任务样例(task example)对神经网络的突触权值进行修改。

3.自适应性:神经网络具有调整自身突触权值以适应外界环境变化的固有能力。

4.证据响应(evidential response):在模式分类问题中,神经网络可以设计成不仅能够提供选择哪一个特定模式的信息,还提供关于决策的置信度信息。

后者可以用来拒判那些可能出现的过于模糊的模式,从而进一步改善网络的分类性能。

5.上下文信息(contextual information):神经网络的特定结构和激发状态代表知识。

网络中每一个神经元都受到所有其他神经元全局活动的潜在影响。

6.容错性:一个以硬件形式实现的神经网络具有天生的容错性,或者是鲁棒性的计算能力。

7.VLSI实现:神经网络的大规模并行性使它具有快速处理某些任务的潜在能力,很适合使用超大规模集成(VLSI)技术来实现。

8.分析和设计一致性。

9.神经生物类比。

1.3神经元模型的三个基本元素1、突触或连接链集,每一个都由其权值或者强度作为特征。

如在连到神经元k的突触j上的输入信号被乘以k的突触权值,第一个下标指正在研究的这个神经元,第二个下标指权值所在突触的输入端。

2、加法器,用于求输入信号被神经元相应突触加权的和。

今日学习总结

今日学习总结今日学习总结篇1今日学习总结:探索自我与认知的边界今天的学习经历对我来说充满了深度和启示。

尽管时间短暂,但我能明显感受到每一次学习都像是在一块未开垦的土地上耕耘,不断探索自我和认知的边界。

在早上,我参加了心理学的研讨会。

我深入了解了认知心理学的一些前沿理论,如大脑的模块化理论、场依存理论等。

这些理论对我理解人类行为和思维模式产生了深远影响。

我开始思考自己的认知模式,以及它在日常生活中是如何影响我的决策和行为的。

午饭后,我进行了一场辩论,主题是人工智能对人类认知的影响。

这次辩论让我更清楚地认识到,人工智能的发展不仅提高了我们的生产效率,还为我们开辟了全新的认知领域。

我深深地体验到科技的发展是如何推动我们认知的边界。

下午,我阅读了一篇关于自我认知的论文。

这篇论文使我对自我认知的重要性有了更深的理解,并启发我反思自己的价值观和人生目标。

我意识到,了解自我、提升自我认知,是实现个人成长和内心平衡的关键。

回顾今天的学习过程,我深感每一次的学习都是一次对自我和认知的深化。

我不仅学习了新的理论知识,更是在思考和讨论的过程中,深化了对这些知识的理解和应用。

我期待在未来的学习中,能够将这些知识和思考应用到日常生活和工作中,不断提升自我。

今日学习总结篇2标题:今日学习总结今日,我全身心地投入到学习中。

早晨,我6点就起床了,打开书包,开始复习昨天学习的课程内容。

整个一天,我都在听课、做笔记、解决问题,不断地循环往复。

在数学课上,我深入理解了线性代数的基本概念,如向量、矩阵和行列式。

通过实例和习题,我更好地掌握了这些数学工具。

在物理课上,我理解了如何将量子力学原理应用到光学现象中,这让我对科学有了更深入的理解。

傍晚时分,我在图书馆花了大部分时间查阅资料,为即将到来的的项目做准备。

我学到了一些新的研究方法和技巧,让我深受启发。

虽然整个一天的学习过程充满了挑战,但我收获颇丰。

我意识到学习不仅仅是知识的累积,更是思考、理解和解决问题的过程。

今日学习总结

今日学习总结今日学习总结1刚得知要在家上课学习,我其实还是有点高兴的。

因为我的家离学校稍稍有点远,所以在家上课意味着我可以不用那么早起床,也不用浪费太多时间在上下学的路上了。

但是刚上课没几天,我就遇到了一系列的难题——在家学习,没有老师的督促,也没有同学们的陪伴,感觉就没有学习的氛围,对学习也不怎么有兴趣。

虽然省了上下学的时间,但省下来的时间感觉都荒废了。

而且长时间坐在电脑前,不仅对眼睛不好,心情也很烦躁。

但是,办法总比困难多,这些问题是一定能够找到方法解决的!于是,我便开始调整我的生活方式。

下面是我的.一些小方法和小建议,希望能让大家有所收获。

一、认真完成必做任务首先,老师在网上布置的必做任务,一定要认认真真地完成,因为这些看似简单的题目和学案都是最基础,最核心,也是最重要的。

如果不认真完成学案,那么这些知识点就不能很好地掌握,做题也会迷迷糊糊的。

可是如何认真地完成呢?首先,读题审题是最重要的。

在题干里,通常会有一些关于这道题的提示,把重点圈画出来对做题就会很有帮助。

其次,做完后要认真改错,建议写写错因、知识点等等。

坚持做下去,你会发现——其实只要认真完成老师布置的任务,就已经很有收获了。

二、认真记笔记一开始上网课我就仅仅是盯着屏幕看,并没有记下什么东西。

上完课后,我觉得上直播课并没有留下什么有用的东西。

于是我看了一遍回放,把一些重点都记了下来,又加深了一遍印象。

看着一篇篇笔记,特别有成就感!今日学习总结2今日,我在学习上取得了许多的进步。

首先,我练习了数学,物理和英语等科目。

我完成了数学试卷,纠正了错误,并对一些难题进行了深入的探索。

在物理方面,我复习了牛顿运动定律,加深了对这些概念的理解。

在英语学习中,我阅读了一些新闻文章,提高了我的`阅读技巧。

其次,我花了大量的时间在编程和数据分析的学习上。

我使用Python编写了一个简单的程序,并使用R语言进行数据分析和可视化。

这些技能在我的日常工作中非常有用,帮助我更好地理解和处理数据。

人工神经网络基础知识

x0 x0

• MP模型

可知当神经元i的输入信号加权和超过阈值时,输出为

“1”,即“兴奋”状态;反之输出为“0”,是“抑制” 状态。

激发函数的基本作用

– 控制输入对输出的激活作用 – 对输入、输出进行函数转换 – 将可能无限域的输入变换成指定的有限范围内的输出

例、实现逻辑函数“与门”(AND gate)运 算。

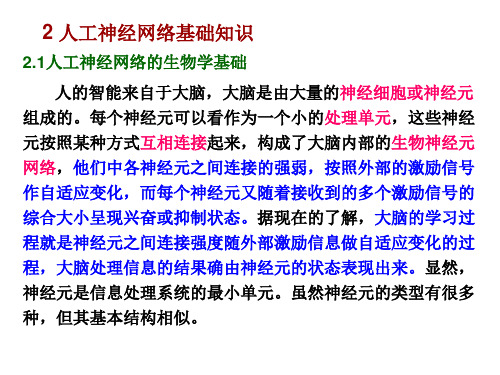

2 人工神经网络基础知识

2.1人工神经网络的生物学基础

人的智能来自于大脑,大脑是由大量的神经细胞或神经元 组成的。每个神经元可以看作为一个小的处理单元,这些神经 元按照某种方式互相连接起来,构成了大脑内部的生物神经元 网络,他们中各神经元之间连接的强弱,按照外部的激励信号 作自适应变化,而每个神经元又随着接收到的多个激励信号的 综合大小呈现兴奋或抑制状态。据现在的了解,大脑的学习过 程就是神经元之间连接强度随外部激励信息做自适应变化的过 程,大脑处理信息的结果确由神经元的状态表现出来。显然, 神经元是信息处理系统的最小单元。虽然神经元的类型有很多 种,但其基本结构相似。

(1)每个神经元都是一个多输入单输出的信息处理单元; (2)突触分兴奋性和抑制性两种类型; (3)神经元具有空间整合特性和阈值特性; (4)神经元输入输出间有固定的时滞,主要取决于突触延搁; (5)忽略时间整合作用和不应期; (6)神经元本身是非时变的,即其突触时延和突触强度均为常 数。

MP模型:

1

x 1ex

f(x) (1t 2

h2)1ex

f(x) 1.0

o

x

-1.0

图

双极 性 S型函数

3、线性函数 (1)线性作用函数:输出等于输入,即 yf(x)x

(2)饱和线性作用函数 (3)对称饱和线性作用函数

《神经网络心得[定稿]》

![《神经网络心得[定稿]》](https://img.taocdn.com/s3/m/1c11581589eb172dec63b70b.png)

《神经网络心得[定稿]》时间如白马过隙,很快八周的人工神经网络学习即将结束,仿佛昨天才刚刚开始学习这门课程,在这段时间的学习中,我有起初对神经网络的不了解到现在的熟悉和掌握,这其中的变化,是我知识提高的过程。

我在这个过程中有一些自己的体会和感想。

我是一名学习控制科学和工程的研究生,起初对于神经网络的认识很肤浅,由于我相应知识的欠缺,想要理解神经网络的结构会很不容易。

在开始的几节课中,老师给我们讲了神经网络的发展史、结构和原理,当时感觉有压力、紧张。

因为我感觉和生物的神经学差不多,一开始接触觉得它不是一门智能控制学,而是一门生物学,所以只能慢慢学习和理解,最终完成课程的学习。

虽然相比于其他学过的课程,我对这门学科的了解稍微逊色点,但我还不是一个害怕困难的人,越是困难我越是会迎头前进的,不会倒下,去努力掌握这些知识。

接下来的几周,是老师的授课过程,说实话老师讲的论文我听的不太懂,讲的软件的应用也是一知半解……有种痛苦的感觉,好像什么也没学到,问了其他同学,他们也有同样的感觉,哦,原来都一样啊,没事,那就继续坚持吧……过了这个彷徨期,该是呐喊的时候了,该写期末作业了,开始做题的时候还挺紧张,害怕题很难做,找了很多资料,照葫芦画瓢,硬着头皮写,写完了之后有一点小小的成就感,我终于给做出来了,可当时我们还是不知道如rbf网络和bp网络怎么应用,只是有那么点熟悉,有那么点感觉。

最重要的时刻到了,在课堂中老师提的问题,我显得是那么生疏,满脸的惆怅,对问题不知所措,迷茫与疲惫缠绕着我的身心。

每次上课之前我都要花上一段时间去预习课程内容,但是每次看的都是一脸迷茫,一知半解。

老师所说的每一句话,我要想半天才会明白过来。

这事我猜知道,基础是多么的重要,而且我知道学习知识最重要的是要学会应用和实践。

不然就只能只上谈兵,但是一到应用我就不知从何下手。

因此,我知道我还有很长的路要走。

其中的辛酸与乐趣大概也只有一块学习的学友们了解。

人工神经网络基础_ANN课程笔记 1、前向神经网络

第一章前向神经网络一、感知器1、感知器网络结构设网络输入模式向量为:对应的输出为:连接权向量为:2、感知器的学习➢初始化连接权向量及输出单元的阈值赋予(-1,+1)区间内的随机值,一般为较小的随机非零值。

➢连接权的修正每个输入模式作如下计算:(a)计算网络输出:(b)计算输出层单元希望输出与实际输出y之间的误差:(c)修正各单元与输出层之间的连接权与阈值:➢对m个输入模式重复步骤,直到误差k d(k=1,2,…,m)趋于零或小于预先给定的误差限ε。

3、感知器的图形解释➢整个学习和记忆过程,就是根据实际输出与希望输出之间的误差调整参数w 和θ,即调整截割平面的空间位置使之不断移动,直到它能将两类模式恰当划分的过程。

➢学习过程可看作是由式决定的n维超平面不断向正确划分输入模式的位置移动的过程。

4、感知器的局限性➢两层感知器只能解决线性可分问题➢增强分类能力的唯一出路是采用多层网络,即在输入及输出层之间加上隐层构成多层前馈网络。

➢Kolmogorov理论经过严格的数学证明:双隐层感知器足以解决任何复杂的分类问题。

➢简单的感知器学习过程已不能用于多层感知器,必须改进学习过程。

二、BP 神经网络 1、反向传播神经网络1) 误差逆传播神经网络是一种具有三层或三层以上的阶层型神经网络: ➢ 上、下层之间各神经元实现全连接,即下层的每一个单元与上层的每个单元都实现权连接;➢ 而每层各神经元之间无连接; ➢ 网络按有监督的方式进行学习。

2)➢ 当一对学习模式提供给网络后,神经元的激活值,从输入层经各中间层向输出层传播,在输出层的各神经元获得网络的输入响应。

➢ 在这之后,按减小希望输出与实际输出误差的方向,从输出层经各中间层逐层修正各连接权,最后回到输入层,故得名“误差逆传播算法”。

➢ 随着这种误差逆传播修正的不断进行,网络对输入模式响应的正确率也不断上升。

2、梯度下降法1)梯度法是一种对某个准则函数的迭代寻优算法。

学习笔记之人工神经网络

简介:人工神经网络(artificial neural network,缩写ANN),简称神经网络(neural network,缩写NN),是一种模仿生物神经网络的结构和功能的数学模型或计算模型。

神经网络由大量的人工神经元联结进行计算。

大多数情况下人工神经网络能在外界信息的基础上改变内部结构,是一种自适应系统。

现代神经网络是一种非线性统计性数据建模工具,常用来对输入和输出间复杂的关系进行建模,或用来探索数据的模式。

人工神经网络是一个能够学习,能够总结归纳的系统,也就是说它能够通过已知数据的实验运用来学习和归纳总结。

人工神经网络通过对局部情况的对照比较(而这些比较是基于不同情况下的自动学习和要实际解决问题的复杂性所决定的),它能够推理产生一个可以自动识别的系统。

与之不同的基于符号系统下的学习方法,它们也具有推理功能,只是它们是建立在逻辑算法的基础上,也就是说它们之所以能够推理,基础是需要有一个推理算法则的集合。

神经网络是一种运算模型,由大量的节点(或称“神经元”,或“单元”)和之间相互联接构成。

每个节点代表一种特定的输出函数,称为激励函数(activation function)。

每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重(weight),这相当于人工神经网络的记忆。

网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。

而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

它的构筑理念是受到生物(人或其他动物)神经网络功能的运作启发而产生的。

人工神经网络通常是通过一个基于数学统计学类型的学习方法(Learning Method)得以优化,所以人工神经网络也是数学统计学方法的一种实际应用,通过统计学的标准数学方法我们能够得到大量的可以用函数来表达的局部结构空间,另一方面在人工智能学的人工感知领域,我们通过数学统计学的应用可以来做人工感知方面的决定问题(也就是说通过统计学的方法,人工神经网络能够类似人一样具有简单的决定能力和简单的判断能力),这种方法比起正式的逻辑学推理演算更具有优势。

实训神经网络实验报告总结

一、实验背景随着人工智能技术的快速发展,神经网络作为一种重要的机器学习算法,已经在图像识别、自然语言处理、推荐系统等领域取得了显著的成果。

为了更好地理解和掌握神经网络的基本原理和应用,我们进行了为期一周的神经网络实训实验。

二、实验目的1. 理解神经网络的基本原理和结构;2. 掌握神经网络训练和推理的基本方法;3. 通过实际操作,加深对神经网络的理解和应用。

三、实验内容1. 神经网络基本原理在实验过程中,我们首先学习了神经网络的基本原理,包括神经元结构、激活函数、损失函数等。

通过学习,我们了解到神经网络是一种模拟人脑神经元结构的计算模型,通过学习大量样本数据,实现对未知数据的分类、回归等任务。

2. 神经网络结构设计我们学习了神经网络的结构设计,包括输入层、隐含层和输出层。

输入层负责接收原始数据,隐含层负责对数据进行特征提取和抽象,输出层负责输出最终结果。

在实验中,我们尝试设计了不同层级的神经网络结构,并对比分析了其性能。

3. 神经网络训练方法神经网络训练方法主要包括反向传播算法和梯度下降算法。

在实验中,我们使用了反向传播算法对神经网络进行训练,并对比了不同学习率、批量大小等参数对训练效果的影响。

4. 神经网络推理方法神经网络推理方法主要包括前向传播和后向传播。

在前向传播过程中,将输入数据通过神经网络进行处理,得到输出结果;在后向传播过程中,根据输出结果和实际标签,计算损失函数,并更新网络参数。

在实验中,我们实现了神经网络推理过程,并对比分析了不同激活函数对推理结果的影响。

5. 实验案例分析为了加深对神经网络的理解,我们选择了MNIST手写数字识别数据集进行实验。

通过设计不同的神经网络结构,使用反向传播算法进行训练,最终实现了对手写数字的识别。

四、实验结果与分析1. 不同神经网络结构对性能的影响在实验中,我们尝试了不同层级的神经网络结构,包括单层神经网络、多层神经网络等。

结果表明,多层神经网络在性能上优于单层神经网络,尤其是在复杂任务中,多层神经网络具有更好的表现。

神经网络总结

神经网络总结一、神经网络的定义生物神经网络和人工神经网络。

1. 生物神经网络:一般指生物的大脑神经元,细胞,触点等组成的网络,用于产生生物的意识,帮助生物进行思考和行动。

2. 人工神经网络(Artificial Neural Networks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(Connection Model),它是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型,是一种应用类似于大脑神经突触联接的结构进行信息处理的数学模型。

在工程与学术界也常直接简称为“神经网络”或类神经网络。

这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。

二、神经网络研究内容神经网络的研究内容相当广泛,反映了多学科交叉技术领域的特点。

主要的研究工作集中在以下几个方面:1.生物原型从生理学、心理学、解剖学、脑科学、病理学等方面研究神经细胞、神经网络、神经系统的生物原型结构及其功能机理。

2.建立模型根据生物原型的研究,建立神经元、神经网络的理论模型。

其中包括概念模型、知识模型、物理化学模型、数学模型等。

3.算法在理论模型研究的基础上构作具体的神经网络模型,以实现计算机模拟或准备制作硬件,包括网络学习算法的研究。

这方面的工作也称为技术模型研究。

神经网络用到的算法就是向量乘法,并且广泛采用符号函数及其各种逼近。

并行、容错、可以硬件实现以及自我学习特性,是神经网络的几个基本优点,也是神经网络计算方法与传统方法的区别所在。

三、神经网络模型神经网络是由大量的神经元互联而构成的网络。

根据网络中神经元的互联方式,常见网络结构主要可以分为下面3类:(1) 前馈神经网络:前馈网络也称前向网络。

这种网络只在训练过程会有反馈信号,而在分类过程中数据只能向前传送,直到到达输出层,层间没有向后的反馈信号,因此被称为前馈网络。

感知机( perceptron)与BP神经网络就属于前馈网络。

每周学习总结

每周学习总结(经典版)编制人:__________________审核人:__________________审批人:__________________编制单位:__________________编制时间:____年____月____日序言下载提示:该文档是本店铺精心编制而成的,希望大家下载后,能够帮助大家解决实际问题。

文档下载后可定制修改,请根据实际需要进行调整和使用,谢谢!并且,本店铺为大家提供各种类型的经典范文,如规章制度、岗位职责、会议纪要、应急预案、合同协议、条据文书、策划方案、教学资料、作文大全、其他范文等等,想了解不同范文格式和写法,敬请关注!Download tips: This document is carefully compiled by this editor. I hope that after you download it, it can help you solve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you!Moreover, our store provides various types of classic sample texts, such as rules and regulations, job responsibilities, meeting minutes, emergency plans, contract agreements, document documents, planning plans, teaching materials, essay summaries, and other sample texts. If you want to learn about different sample formats and writing methods, please pay attention!每周学习总结每周学习总结(优秀5篇)每周学习总结要怎么写,才更标准规范?根据多年的文秘写作经验,参考优秀的每周学习总结样本能让你事半功倍,下面分享【每周学习总结(优秀5篇)】相关方法经验,供你参考借鉴。

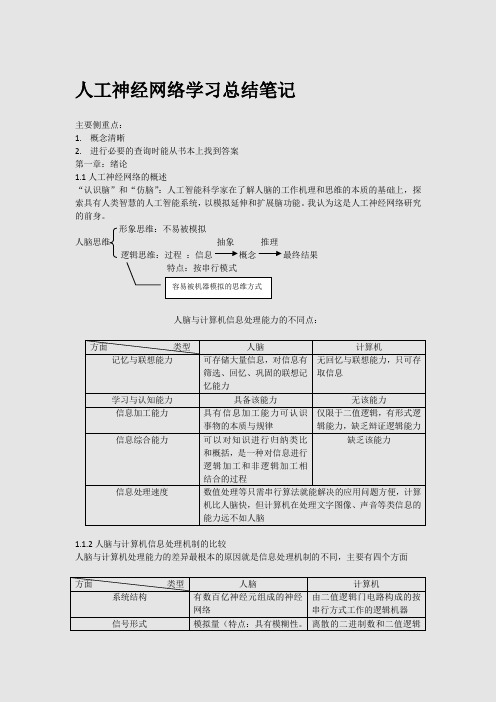

深度学习笔记(3)神经网络,学习率,激活函数,损失函数

深度学习笔记(3)神经⽹络,学习率,激活函数,损失函数神经⽹络(NN)的复杂度空间复杂度:计算神经⽹络的层数时只统计有运算能⼒的层,输⼊层仅仅起到将数据传输进来的作⽤,没有涉及到运算,所以统计神经⽹络层数时不算输⼊层输⼊层和输出层之间所有层都叫做隐藏层层数 = 隐藏层的层数 + 1个输出层总参数个数 = 总w个数 + 总b个数时间复杂度:乘加运算次数学习率以及参数的更新:w t+1=w t−lr∗∂loss ∂w t指数衰减学习率的选择及设置可以先⽤较⼤的学习率,快速得到较优解,然后逐步减⼩学习率,使模型在训练后期稳定。

指数衰减学习率 = 初始学习率 * 学习率衰减率(当前轮数 / 多少轮衰减⼀次)指数衰减学习率=初始学习率∗学习率衰减率当前轮数多少轮衰减⼀次#学习率衰减import tensorflow as tfw = tf.Variable(tf.constant(5, dtype=tf.float32))epoch = 40LR_BASE = 0.2LR_DECAY = 0.99LR_STEP = 1for epoch in range(epoch):lr = LR_BASE * LR_DECAY**(epoch / LR_STEP)with tf.GradientTape() as tape:loss = tf.square(w + 1)grads = tape.gradient(loss, w)w.assign_sub(lr * grads)print("After %2s epoch,\tw is %f,\tloss is %f\tlr is %f" % (epoch, w.numpy(), loss,lr)) After 0 epoch, w is 2.600000, loss is 36.000000 lr is 0.200000After 1 epoch, w is 1.174400, loss is 12.959999 lr is 0.198000After 2 epoch, w is 0.321948, loss is 4.728015 lr is 0.196020After 3 epoch, w is -0.191126, loss is 1.747547 lr is 0.194060After 4 epoch, w is -0.501926, loss is 0.654277 lr is 0.192119After 5 epoch, w is -0.691392, loss is 0.248077 lr is 0.190198After 6 epoch, w is -0.807611, loss is 0.095239 lr is 0.188296After 7 epoch, w is -0.879339, loss is 0.037014 lr is 0.186413After 8 epoch, w is -0.923874, loss is 0.014559 lr is 0.184549After 9 epoch, w is -0.951691, loss is 0.005795 lr is 0.182703After 10 epoch, w is -0.969167, loss is 0.002334 lr is 0.180876After 11 epoch, w is -0.980209, loss is 0.000951 lr is 0.179068After 12 epoch, w is -0.987226, loss is 0.000392 lr is 0.177277After 13 epoch, w is -0.991710, loss is 0.000163 lr is 0.175504After 14 epoch, w is -0.994591, loss is 0.000069 lr is 0.173749After 15 epoch, w is -0.996452, loss is 0.000029 lr is 0.172012After 16 epoch, w is -0.997660, loss is 0.000013 lr is 0.170292After 17 epoch, w is -0.998449, loss is 0.000005 lr is 0.168589After 19 epoch, w is -0.999308, loss is 0.000001 lr is 0.165234After 20 epoch, w is -0.999535, loss is 0.000000 lr is 0.163581After 21 epoch, w is -0.999685, loss is 0.000000 lr is 0.161946After 22 epoch, w is -0.999786, loss is 0.000000 lr is 0.160326After 23 epoch, w is -0.999854, loss is 0.000000 lr is 0.158723After 24 epoch, w is -0.999900, loss is 0.000000 lr is 0.157136After 25 epoch, w is -0.999931, loss is 0.000000 lr is 0.155564After 26 epoch, w is -0.999952, loss is 0.000000 lr is 0.154009After 27 epoch, w is -0.999967, loss is 0.000000 lr is 0.152469After 28 epoch, w is -0.999977, loss is 0.000000 lr is 0.150944After 29 epoch, w is -0.999984, loss is 0.000000 lr is 0.149434After 30 epoch, w is -0.999989, loss is 0.000000 lr is 0.147940After 31 epoch, w is -0.999992, loss is 0.000000 lr is 0.146461After 32 epoch, w is -0.999994, loss is 0.000000 lr is 0.144996After 33 epoch, w is -0.999996, loss is 0.000000 lr is 0.143546After 34 epoch, w is -0.999997, loss is 0.000000 lr is 0.142111After 35 epoch, w is -0.999998, loss is 0.000000 lr is 0.140690After 36 epoch, w is -0.999999, loss is 0.000000 lr is 0.139283After 37 epoch, w is -0.999999, loss is 0.000000 lr is 0.137890After 38 epoch, w is -0.999999, loss is 0.000000 lr is 0.136511After 39 epoch, w is -0.999999, loss is 0.000000 lr is 0.135146激活函数sigmoid 函数tf.nn. sigmoid(x)f (x )=11+e−x图像:相当于对输⼊进⾏了归⼀化多层神经⽹络更新参数时,需要从输出层往输⼊层⽅向逐层进⾏链式求导,⽽sigmoid 函数的导数输出是0到0.25之间的⼩数,链式求导时,多层导数连续相乘会出现多个0到0.25之间的值连续相乘,结果将趋近于0,产⽣梯度消失,使得参数⽆法继续更新且sigmoid 函数存在幂运算,计算⽐较复杂tanh 函数tf.math. tanh(x)f (x )=1−e −2x1+e−2x图像:和上⾯提到的sigmoid 函数⼀样,同样存在梯度消失和幂运算复杂的缺点Relu 函数tf.nn.relu(x)f (x )=max (x ,0)=0(x <0)时或者x (x >=0)时图像:Relu 函数在正区间内解决了梯度消失的问题,使⽤时只需要判断输⼊是否⼤于0,计算速度快训练参数时的收敛速度要快于sigmoid 函数和tanh 函数输出⾮0均值,收敛慢Dead RelU 问题:送⼊激活函数的输⼊特征是负数时,激活函数输出是0,反向传播得到的梯度是0,致使参数⽆法更新,某些神经元可能永远不会被激活。

智能信息处理 人工神经网络总结

第1讲:神经网络信息处理方法人工神经网络是一种旨在模仿人脑结构及其功能的信息处理系统人工神经网络特点:1.大规模并行处理2.分布式存储3.自适应(学习)过程人工神经网络的基本要素:神经元功能函数、神经元之间的连接形式和网络的学习(训练)。

1.神经元功能函数神经元在输入信号作用下产生输出信号的规律由神经元功能函数f(Activation Function)给出,也称激活函数,或称转移函数,这是神经元模型的外特性。

2 神经元之间的连接形式*前向网络(前馈网络)网络可以分为若干“层”,各层按信号传输先后顺序依次排列,第i层的神经元只接受第(i-1)层神经元给出的信号,各神经元之间没有反馈。

======前馈型网络可用一有向无环路图表示.*反馈网络典型的反馈型神经网络每个节点都表示一个计算单元,同时接受外加输入和其它各节点的反馈输入,每个节点也都直接向外部输出。

Hopfield网络即属此种类型。

在某些反馈网络中,各神经元除接受外加输入与其它各节点反馈输入之外,还包括自身反馈。

有时,反馈型神经网络也可表示为一张完全的无向图.3. 人工神经网络的学习(训练)Hebb 有例子,学习规则,感知器学习,Hidrow_Hoff,胜者为王第2讲:BP神经网络模型BP神经网络其基本思想是:学习过程由信号的正向传播与误差的反向传播两个过程组成。

正向传播时,输入样本从输入层传入,经隐层逐层处理后,传向输出层。

若输出层的实际输出与期望输出(教师信号)不符,则转向误差的反向传播阶段。

误差的反向传播是将输出误差以某种形式通过隐层向输入层逐层反传,并将误差分摊给各层的所有单元,从而获得各层单元的误差信号,此误差信号即作为修正各单元权值的依据。

这种信号正向传播与误差反向传播的各层权值调整过程,是周而复始地进行的。

权值不断调整过程,也就是网络的学习训练过程。

此过程一直进行到网络输出的误差减少到可以接受的程度,或进行到预先设定的学习次数为止。

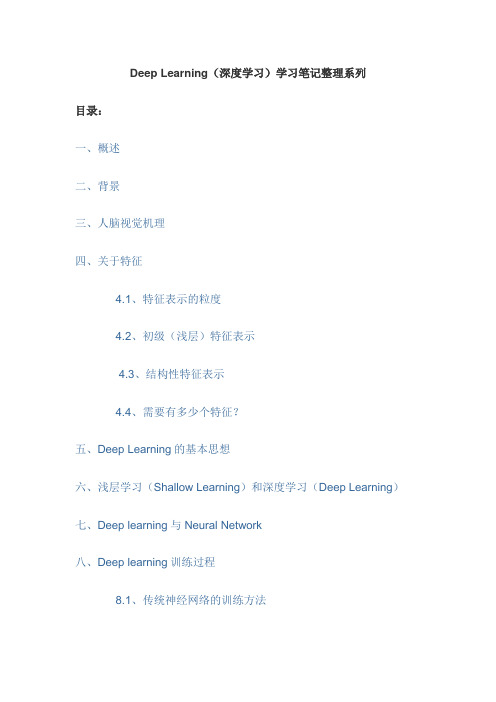

(完整版)DeepLearning(深度学习)学习笔记整理系列

Deep Learning(深度学习)学习笔记整理系列目录:一、概述二、背景三、人脑视觉机理四、关于特征4.1、特征表示的粒度4.2、初级(浅层)特征表示4.3、结构性特征表示4.4、需要有多少个特征?五、Deep Learning的基本思想六、浅层学习(Shallow Learning)和深度学习(Deep Learning)七、Deep learning与Neural Network八、Deep learning训练过程8.1、传统神经网络的训练方法8.2、deep learning训练过程九、Deep Learning的常用模型或者方法9.1、AutoEncoder自动编码器9.2、Sparse Coding稀疏编码9.3、Restricted Boltzmann Machine(RBM)限制波尔兹曼机9.4、Deep BeliefNetworks深信度网络9.5、Convolutional Neural Networks卷积神经网络十、总结与展望十一、参考文献和Deep Learning学习资源接上注:下面的两个Deep Learning方法说明需要完善,但为了保证文章的连续性和完整性,先贴一些上来,后面再修改好了。

9.3、Restricted Boltzmann Machine (RBM)限制波尔兹曼机假设有一个二部图,每一层的节点之间没有链接,一层是可视层,即输入数据层(v),一层是隐藏层(h),如果假设所有的节点都是随机二值变量节点(只能取0或者1值),同时假设全概率分布p(v,h)满足Boltzmann 分布,我们称这个模型是Restricted BoltzmannMachine (RBM)。

下面我们来看看为什么它是Deep Learning方法。

首先,这个模型因为是二部图,所以在已知v的情况下,所有的隐藏节点之间是条件独立的(因为节点之间不存在连接),即p(h|v)=p(h1|v)…p(h n|v)。

神经网络作业总结范文

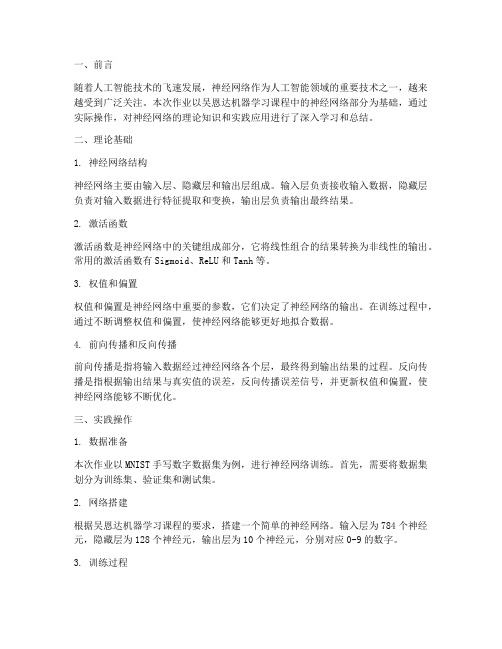

一、前言随着人工智能技术的飞速发展,神经网络作为人工智能领域的重要技术之一,越来越受到广泛关注。

本次作业以吴恩达机器学习课程中的神经网络部分为基础,通过实际操作,对神经网络的理论知识和实践应用进行了深入学习和总结。

二、理论基础1. 神经网络结构神经网络主要由输入层、隐藏层和输出层组成。

输入层负责接收输入数据,隐藏层负责对输入数据进行特征提取和变换,输出层负责输出最终结果。

2. 激活函数激活函数是神经网络中的关键组成部分,它将线性组合的结果转换为非线性的输出。

常用的激活函数有Sigmoid、ReLU和Tanh等。

3. 权值和偏置权值和偏置是神经网络中重要的参数,它们决定了神经网络的输出。

在训练过程中,通过不断调整权值和偏置,使神经网络能够更好地拟合数据。

4. 前向传播和反向传播前向传播是指将输入数据经过神经网络各个层,最终得到输出结果的过程。

反向传播是指根据输出结果与真实值的误差,反向传播误差信号,并更新权值和偏置,使神经网络能够不断优化。

三、实践操作1. 数据准备本次作业以MNIST手写数字数据集为例,进行神经网络训练。

首先,需要将数据集划分为训练集、验证集和测试集。

2. 网络搭建根据吴恩达机器学习课程的要求,搭建一个简单的神经网络。

输入层为784个神经元,隐藏层为128个神经元,输出层为10个神经元,分别对应0-9的数字。

3. 训练过程使用训练集对神经网络进行训练。

在训练过程中,通过调整学习率、批处理大小等参数,使神经网络能够更好地拟合数据。

4. 验证和测试使用验证集和测试集对神经网络进行验证和测试。

通过计算准确率等指标,评估神经网络的性能。

四、总结1. 理论知识的重要性通过本次作业,深刻体会到理论知识在神经网络实践中的重要性。

只有掌握扎实的理论基础,才能更好地进行实践操作。

2. 神经网络的优化在训练过程中,不断调整学习率、批处理大小等参数,使神经网络能够更好地拟合数据。

这表明,优化神经网络参数对于提高性能至关重要。

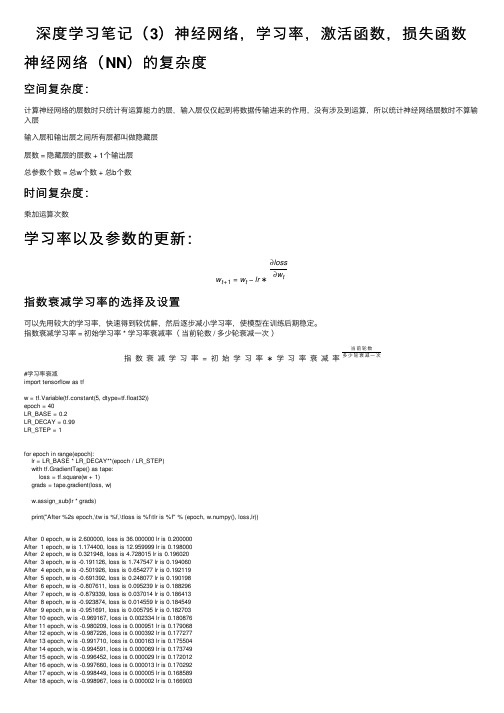

人工神经网络学习总结笔记

人工神经网络学习总结笔记主要侧重点:1.概念清晰2.进行必要的查询时能从书本上找到答案第一章:绪论1.1人工神经网络的概述“认识脑”和“仿脑”:人工智能科学家在了解人脑的工作机理和思维的本质的基础上,探索具有人类智慧的人工智能系统,以模拟延伸和扩展脑功能。

我认为这是人工神经网络研究的前身。

形象思维:不易被模拟人脑思维抽象推理逻辑思维:过程:信息概念最终结果特点:按串行模式人脑与计算机信息处理能力的不同点:方面类型人脑计算机记忆与联想能力可存储大量信息,对信息有筛选、回忆、巩固的联想记忆能力无回忆与联想能力,只可存取信息学习与认知能力具备该能力无该能力信息加工能力具有信息加工能力可认识事物的本质与规律仅限于二值逻辑,有形式逻辑能力,缺乏辩证逻辑能力信息综合能力可以对知识进行归纳类比和概括,是一种对信息进行逻辑加工和非逻辑加工相结合的过程缺乏该能力信息处理速度数值处理等只需串行算法就能解决的应用问题方便,计算机比人脑快,但计算机在处理文字图像、声音等类信息的能力远不如人脑1.1.2人脑与计算机信息处理机制的比较人脑与计算机处理能力的差异最根本的原因就是信息处理机制的不同,主要有四个方面方面类型人脑计算机系统结构有数百亿神经元组成的神经网络由二值逻辑门电路构成的按串行方式工作的逻辑机器信号形式模拟量(特点:具有模糊性。

离散的二进制数和二值逻辑容易被机器模拟的思维方式难以被机器模拟)和脉冲两种形式形式信息储存人脑中的信息分布存储于整个系统,所存储的信息是联想式的有限集中的串行处理机制信息处理机制高度并行的非线性信息处理系统(体现在结构上、信息存储上、信息处理的运行过程中)1.1.3人工神经网络的概念:在对人脑神经网络的基本认识的基础上,用数理方法从信息处理的角度对人脑神经网络进行抽象,并建立某种简化模型,称之为人工神经网络,是对人脑的简化、抽象以及模拟,是一种旨在模仿人脑结构及其功能的信息处理系统。

其他定义:由非常多个非常简单的处理单元彼此按某种方式相互连接而形成的计算系统,外部输入信息之后,系统产生动态响应从而处理信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人工神经网络学习总结笔记主要侧重点:1.概念清晰2.进行必要的查询时能从书本上找到答案第一章:绪论1.1人工神经网络的概述“认识脑”和“仿脑”:人工智能科学家在了解人脑的工作机理和思维的本质的基础上,探索具有人类智慧的人工智能系统,以模拟延伸和扩展脑功能。

我认为这是人工神经网络研究的前身。

形象思维:不易被模拟人脑思维抽象推理逻辑思维:过程:信息概念最终结果特点:按串行模式人脑与计算机信息处理能力的不同点:方面类型人脑计算机记忆与联想能力可存储大量信息,对信息有筛选、回忆、巩固的联想记忆能力无回忆与联想能力,只可存取信息学习与认知能力具备该能力无该能力信息加工能力具有信息加工能力可认识事物的本质与规律仅限于二值逻辑,有形式逻辑能力,缺乏辩证逻辑能力信息综合能力可以对知识进行归纳类比和概括,是一种对信息进行逻辑加工和非逻辑加工相结合的过程缺乏该能力信息处理速度数值处理等只需串行算法就能解决的应用问题方便,计算机比人脑快,但计算机在处理文字图像、声音等类信息的能力远不如人脑1.1.2人脑与计算机信息处理机制的比较人脑与计算机处理能力的差异最根本的原因就是信息处理机制的不同,主要有四个方面方面类型人脑计算机系统结构有数百亿神经元组成的神经网络由二值逻辑门电路构成的按串行方式工作的逻辑机器信号形式模拟量(特点:具有模糊性。

离散的二进制数和二值逻辑容易被机器模拟的思维方式难以被机器模拟)和脉冲两种形式形式信息储存人脑中的信息分布存储于整个系统,所存储的信息是联想式的有限集中的串行处理机制信息处理机制高度并行的非线性信息处理系统(体现在结构上、信息存储上、信息处理的运行过程中)1.1.3人工神经网络的概念:在对人脑神经网络的基本认识的基础上,用数理方法从信息处理的角度对人脑神经网络进行抽象,并建立某种简化模型,称之为人工神经网络,是对人脑的简化、抽象以及模拟,是一种旨在模仿人脑结构及其功能的信息处理系统。

其他定义:由非常多个非常简单的处理单元彼此按某种方式相互连接而形成的计算系统,外部输入信息之后,系统产生动态响应从而处理信息。

它是由许多简单的并行工作的处理单元组成的系统,其功能会因网络结构、连接强度以及各单元的处理方式的不同而不同1.3神经网络的基本特点与功能基本特点:1、结构特点:信息处理的并行性、信息存储的分布性、信息处理单元的互联性、结构的可塑性。

神经网络内在的并行性与分布性表现在其信息的存储于处理都是空间上分布、时间上并行的。

2、性能特点:高度的非线性、良好的容错性和计算的非精确性。

3、能力特征:自学习、自组织(重构)与自适应性。

神经网络的基本功能:1、联想记忆:自联想记忆与异联想记忆2、非线性映射3、分类与识别4、优化计算5、知识处理第二章人工神经网络建模基础2.1~2.2 讲述了生物神经系统以及生物神经网络的建模基础神经元所产生的信息是具有电脉冲形式的神经冲动,脉冲的宽度和幅度相同,但是间隔是随机变化的。

人脑中,外界的刺激不同可以改变神经元之间的突触关系,即突触厚膜电位的方向以及大小,从突触信息传递的角度来看,表现为放大倍数和极性的变化。

空间整合的概念(BP29)信息整合这一段中阀值特性:我认为阀值特性即静息电位必须上升到一定数值范围即超过阀值电位之后,神经元才会产生兴奋,信息才能以脉冲的形式得到传递。

所谓的时间整合,如果由一个脉冲所引起的突触膜后电位很小,只有在持续时间内当另一脉冲到达的时候,总的突触膜后电位增大。

2.3 人工神经元模型人工神经网络是在现代神经生物学研究基础上提出的模拟生物的过程,反映人脑某些特性的一种计算结构,是人脑神经系统的一种抽象、简化和模拟而不是对它的真实描写。

神经网络的基本器件是神经元和突触。

人工神经网络当中的神经元是处理单元,也称之为节点。

人工神经元是对生物神经元的信息处理过程的抽象模拟,通过数学语言对其进行描述,对其结构和功能进行模拟,用模型图予以表达。

2.3.1 神经元的建模其建模的六点假设(BP30)加权系数的概念:又称之为权重值,其正负模拟了神经元当中的兴奋和抑制,大小呢模拟了突触之间的不同连接强度。

整合之后的信息相当于生物神经网络当中的膜电位,整合之后的信息通过变换函数可以得出输出以后的信息大小,这个变换函数通常是非线性的。

所谓的变换函数我认为它是表征了不用的信息处理特性,反映神经元输入与激活状态之间的关系。

2.3.2神经元的数学模型(BP31)神经元的状态表达式(BP31式2.1 2.2 为最基本的表达方式),这个表达式清晰地反映了神经元建模的6种假设。

其中,输出o j下标体现了多输入,单输出。

权重w ij的正负体现了突触的兴奋与抑制,T j代表了阀值特性,输入的总和为信息的净输入,常用net j或是net j’来表示,只有净输入大于阀值的时候,神经元才能被激活,输出值与输入值之间的单位时差则体现了假定当中的突触延搁,而权重值(也就是代表突触之间的连接强度)与时间无关体现了假定当中的第六点神经元本来是非时变的。

用向量的关系来表示净输入:net j=w j T X 下表是从0开始的。

神经元的模型表达式为o j=f(net j)=f(w j T X)2.3.3神经元的变换函数本节讲述了四种不同的变换函数,分别是阀值型变换函数,非线性变换函数(单极以及双极的Sigmoid函数,即s型函数),分段线性变换函数,概率型变换函数。

(其公式在BP32 ~BP33)2.4人工神经网络模型人工神经网络模型可以按照网络连接的拓扑结构(神经元间的联系方式)分类,还有内部信息流向。

单纯型层次网络结构,定义见BP35(就是说每一层的神经元只接受来自上一层的信息,并且只负责把信息传递到下一层,神经元内部以及各个神经元之间没有信息交流)也可称为前馈层次型层次型结构输入层与输出层之间有连接的层次网络结构,与上一种结构不同的是,输入层神经单元具有信息处理功能,也可称为输入输出有反馈的前馈层次型层内有互联的层次网络结构,与第一种结构不同的是这一种结构的同一层神经元之间有互联,也可称为前馈层内互联型拓扑结构(1)全互联型,网络中每个节点都与所有其他节点相连接,也可称为反馈前互联型互连型结构(2)局部互联型,网络中每个节点只与其邻近节点相连接,也可称为反馈局部互联型(3)稀疏连接性,网络节点只与少数相距较远的节点相连接前馈型网络:单纯前馈型与单纯型层次网络结构完全相同网络信息流向型反馈型网络:单纯反馈型网络与输入层与输出层之间有连接的层次网络结(按功能分成若干层,包括输入层,隐层,输出层)网络中任意两个节点之间都可能存在连接路径,根据互联程度对这种结构进行划构完全相同决定神经网络特性的三大要素:神经元的变换函数、神经网络的拓扑结构(特点:分布式存储记忆与分布式信息处理、高度互联性、高度并行性和结构可塑性),神经网络的学习方式2.5 神经网络学习学习的定义:根据与环境的相互作用而发生的行为改变,其结果将导致对外界刺激产生反应的新模式的建立。

学习过程就是经过训练使个体在行为上产生较持久的改变的过程。

通过不停地学习以及训练,改变拓扑结构以及权重值,目的是是输出值与期望值更加接近,这就是学习的过程。

人工神经网络的功能特性由拓扑结构以及突触之间连接的强度即权重值决定。

学习规则/算法:改变权重值的规则,可能是某一非线性函数。

有导师/教师/监督学习:通俗的讲就是给定一个输入值和期望输出值,如果得到的实际值与期望值相差太大,则调整权重值使直到输出值与期望值,之前并没有先验信息。

之前这种做法就像有教师指导一般,在学习之后,如果可以输出期望值的时候,就说明学会了。

无导师/教师/监督学习:这种方法本身具有特定的内部结构和信息处理方式学习算法 ,是可以根据大量的动态输入数据,在总结、提炼的基础上找到规律和模式,(BP 37) 自动调整拓扑结构和权值,这是个自组织的过程,通过不断地调节之后,使其结构具有适应需求的特性。

灌输式学习:它对信息处理的模式和方法是特定的,只能对相应的例子做出对应的判断通用学习规则:权向量在某一时刻的调整量与该时刻的输入向量和学习信号的乘积成正比。

权向量的调整量的数学表达式在(BP 39),该表达式表明权向量的改变量与权向量,输入量,以及教师信号们还有决定学习效率的学习常数有关。

2.5常用学习算法的介绍,包括Hebb 学习规则,离散感知器学习规则。

连续感知器的学习规则,最小均方学习规则,相关学习规则,胜者为王学习规则,外星学习规则。

其一览表在(BP 44)在Hebb 学习规则(BP 39)当中,它是一种无导师学习方法,学习信号简单的等于信号的输出。

连续感知器的学习规则,也称为δ规则,是一种有导师学习方法,其中对式2.20的理解还不透彻,在例题2.2当中为何未出现关于d j 的字样。

2.5.4最小均方学习规则。

(是δ规则的特例)算法有一个共同点权向量的调整量均为学习常数与学习信号以及输入值的乘积,在例题当中输入值是给定的,求每一个调整向量时,式子当中的输出值中所取的权向量都是上一次输入值经过信息处理单元处理之后的输出值为下一次的输入值。

2.5.5相关学习规则,是Hebb 学习规则的特例,区别在于,前者是有导师学习,后者是无导师学习,其权值初始化为零。

2.5.6胜者为王学习规则 为无导师学习,权值初始化为任意值。

2.5.7外星学习规则和内星学习规则:内星学习规则与胜者为王的学习规则一致,外星学习规则是有导师学习规则,与内星学习规则不同的是,其权向量是向期望输出向量靠拢,不是向输入向量靠拢几种不同学习规则的总结表在 BP 44 在BP 42 ~43关于静息电位,相当于一个下限的临界点,阀值是一个兴奋的临界点。

主要过程在P27思考与练习题的回答人工神经网络是如何体现生物神经网络特性的?答:生物神经网络当中的神经元在人工神经网络当中是用信息处理单元来取代的,神经元的模型表达式为o j=f(net j)=f(w j T X),生物神经元当中具有不同的突触性质以及突触连接强度,在人工神经网络当中就相当于输入信号的大小,而加权系数也就是权重值其正负模拟了生物神经元当中的兴奋与抑制,大小相当于模拟了突触连接强度的大小,输入强度的总和值就是生物神经网络里面的膜电位。

输入和输出的关系一般是非线性的,这种关系相当于是生物神经网络当中的信息处理过程,将输入脉冲处理后输出。

如果权值只能按照1和-1来变化,对神经元的学习会有什么影响?我个人的理解是,如果只按照1和-1来变化是说明突出的连接强度只有一种,对生物神经元当中突触连接强度是不相同这一特点没有进行完整的描述,导致整合之后很有可能出现输入和输出正负一致导致权值无约束增长。

例子在P39中有所体现。

举例说明什么是有导师学习,什么是无导师学习?比较典型的无导师学习是Hebb学习,有导师学习是δ规则,关于有导师与无导师学习规则具体的概念已经在上面讲述过,拿Hebb学习规则来讲它的权值调整量表达式中没有期望输出,而δ规则则是相反。