Loadrunner_性能测试结果分析

LoadRunner性能测试实验指导书

LoadRunner 性能测试实验指导书一、实验目的1. 掌握LoadRunner 8.1 操作界面的组成。

2. 着重掌握如何在不同的环境中使用LoadRunner 来作为自动化的功能测试工具。

3. LoadRunner 的性能测试流程4. LoadRunner 的主界面5. LoadRunner 的脚本录制6. LoadRunner 的场景设计7. LoadRunner 的场景监视8. LoadRunner 的结果分析二、基本知识1. 具有微软Windows 的使用经验2. 熟悉网络和浏览器知识3. 熟悉测试概念4. LoadRunner8.1 的使用概要。

三、实验设备及环境①windows 操作系统、LoadRunner8.1 应用软件②参考资料:电子稿件Mercury LoadRunner教程四、实验内容第一部分:LoadRunner 入门1. 环境配置(1)安装Mercury Tours 程序和Xitami 服务器选择"开始> 所有程序> Mercury LoadRunner > Samples Setup”安装,进行到Installation components and sub-components 时选择“WEB ”,安装完成后选择"开始> 所有程序> Mercury LoadRu nn er > Samples > Web ”查看。

(2)配置XitamiXitami 安装后默认端口为80 ,与IIS 的端口冲突,所以需要修改配置文件xitami.cfg ,将portbase=0 改为portbase=1000 ,修改完成后重新启动Xitami 服务器。

(3)启动Xitami选择“开始> 所有程序> Mercury LoadRunner > Samples > Web > Start Web Server”启动XitamiMercury Tours 程序URL 地址为:http://localhost:1080/WebTours/2. 测试Mercury Tours 程序使用LoadRunner 对Mercury Tours 程序进行负载测试。

LoadRunner性能测试分析

1 衡量web 性能的基本指标(1)响应时间:响应时间=网络响应时间+应用程序响应时间,反映完成某个业务所需要的时间,响应时间通常随负载的增加而增加。

响应时间的单位一般为“秒”或者“毫秒”。

(2)吞吐量:反应系统处理能力指标,随着负载的增加,吞吐量往往增长到一个峰值后下降,队列变长。

通常情况下,吞吐量用“请求数/秒”或者“页面数/秒”来衡量。

(3)服务器资源占用:反应系统能耗指标。

随着用户和吞吐量的上升,服务器的资源会被占用的越来越多,直到服务器资源被完全占用。

资源利用率通常以占用最大值的百分比n%来衡量。

(4)轻负载区:随着用户数量的上升,响应时间基本上没有太大的变化,吞吐量随着用户的增加而增加,说明这个系统资源是足够的,所以没有出现响应时间和吞吐量的明显变化。

在这个状态下,系统完全能够轻松地处理业务,所以称之为轻负载区。

(5)重负载区:当用户数量继续上升,响应时间开始明显上升,吞吐量上升速度开始变慢,并且到达峰值,随后开始小幅回落,逐渐稳定。

在这个阶段中,系统已经达到了处理的高峰,由于资源的逐渐匮乏,吞吐量下降,而响应时间变长。

在这个状态下,说明系统资源已经高负荷使用,处理能力达到极限。

在重负载区有几个数据比较关键:轻负载区到重负载区分界点的用户数:这个用户数是系统最优的高性能用户数,系统资源正在被高效的分配和利用。

重负载区中的吞吐量峰值:这个峰值就是系统的最高处理能力,而同时的用户数也是系统所能达到的高性能处理能承受的用户数,在这个时刻资源利用率应该正好达到峰值。

重负载区到负载失效区分界点的用户数:这个用户数是系统所能达到性能需求的最大在线用户数,超过这个数目的用户将无法正常使用系统。

负载失效区:当用户数量继续增加,响应时间会大幅上升,而吞吐量会逐渐加速下降,资源被消耗殆尽。

当响应时间超出用户能够忍受的范围时,这部分用户将会选择放弃访问。

通过上面的说明可以看出一个系统最好能够工作在轻负载区,接近重负载区即可,不能出现系统进入负载失效区的情况。

具体实例教你如何做LoadRunner结果分析

具体实例教你如何做LoadRunner结果分析LoadRunner是一款性能测试工具,经常被用来测试服务器的各种性能指标,如响应时间、吞吐量、并发用户数等等。

LoadRunner测试的结果包含了大量的数据,要对这些数据进行分析,找出问题和优化空间,需要一定的技巧和经验。

本文将通过具体实例,教你如何做LoadRunner结果分析。

1. 准备工作在做结果分析之前,需要先进行一些准备工作:•理解LoadRunner的基本概念和原理,如Vuser、脚本、场景、控制器、分析器等等。

•在测试服务器上安装Agent,以便能够在控制器上收集服务器性能数据。

•确定测试目标和测试场景,并编写好对应的LoadRunner测试脚本。

2. 开始测试在进行测试之前,需要将测试场景配置好:包括虚拟用户数、时间间隔、测试时长、目标机器等等信息。

在测试期间,需要密切关注控制器监控的指标,如吞吐量、响应时间、错误率等等。

在测试结束后,可以在控制器上保存测试结果,以便进行后续的分析。

3. 结果分析LoadRunner测试结果包含了各种各样的数据,如服务器响应时间、客户端响应时间、网络延迟、CPU利用率、内存利用率等等。

这些数据需要进行分析,以便找到测试结果中的关键问题和瓶颈。

3.1. 关注响应时间响应时间是衡量系统性能的重要指标之一,它反映了用户等待系统响应的时间。

在LoadRunner测试结果中,响应时间是一个极为重要的数据,需要对其进行仔细的分析。

可以通过绘制响应时间曲线图,来分析服务器的响应情况:如果响应时间线性增长,那么说明系统在承受更大的负载时,响应时间会更慢,需要对系统进行优化;如果响应时间突然跃升,说明系统在某个时刻发生了大规模的性能问题,需要进行问题排查和修复。

3.2. 分析吞吐量吞吐量是表示系统在单位时间内处理的请求数量,也是衡量系统性能的重要指标之一。

在LoadRunner测试结果中,可以通过绘制吞吐量曲线图,来分析服务器的负载情况:如果吞吐量随着虚拟用户数的增多而增大,那么说明服务器在承受更大的负载时,可以保持系统性能的稳定;如果吞吐量突然下降,说明系统在承受更大的负载时已经不能满足用户的需求,需要进行系统优化或扩容。

软件测试报告性能测试结果与建议

软件测试报告性能测试结果与建议软件测试报告性能测试结果与建议一、测试概述在本次软件测试中,我们对XXX软件进行了性能测试,以评估其在负载压力下的表现。

本文将介绍测试过程、得到的结果以及基于结果所提出的建议。

二、测试环境与工具1. 测试环境- 操作系统:Windows 10- 处理器:Intel Core i7- 内存:8GB- 网络:1Gbps以太网2. 测试工具- JMeter:用于模拟多用户并发请求- Performance Monitor:用于监控系统资源利用率- LoadRunner:用于生成和管理测试脚本三、测试目标本次性能测试的主要目标如下:1. 评估软件在正常使用负载下的响应时间;2. 确定软件在高负载情况下的稳定性;3. 识别软件在负载峰值时的性能瓶颈;4. 提供性能改进的建议。

四、测试方案1. 测试场景设计在本次性能测试中,我们设计了以下两个测试场景:- 场景一:100个用户同时登录软件并进行基本操作,如浏览页面、搜索功能等;- 场景二:200个用户同时使用软件进行复杂操作,如上传大文件、处理复杂计算等。

2. 测试步骤- 步骤一:配置并启动测试环境- 步骤二:根据测试场景,使用JMeter和LoadRunner创建并运行相应的测试脚本- 步骤三:使用Performance Monitor监控系统资源利用率- 步骤四:记录测试运行时间、响应时间等关键指标- 步骤五:分析测试结果,确定性能瓶颈和改进方向五、测试结果与分析1. 性能指标在本次测试中,我们关注了以下几个重要的性能指标:- 页面响应时间:用户发送请求到页面显示完整的时间;- 吞吐量:单位时间内系统处理的请求数量;- 并发用户数:同时操作软件的用户数量;- 错误率:系统处理请求时发生错误的比例。

2. 测试结果根据测试数据分析,我们得出以下结果:- 场景一:- 页面响应时间平均为2秒,在用户可接受范围内;- 系统吞吐量在100个用户时稳定,并发用户数较低;- 错误率为0%,系统稳定性较高。

软件测试报告性能负载测试报告分析

软件测试报告性能负载测试报告分析1. 引言软件性能负载测试是衡量软件系统在高负载情况下的性能表现的重要手段。

本报告旨在对进行的性能负载测试进行详细分析和评估,以便为软件的性能优化提供参考和指导。

2. 测试环境2.1 硬件环境- 服务器:**************************,64核心,128GB 内存- 客户端:*************************,16GB内存2.2 软件环境- 操作系统:Windows Server 2016- 被测软件版本:xxx软件 v1.0.03. 测试目标本次性能负载测试的目标是评估xxx软件在高负载情况下的性能特征,包括并发用户支持能力、响应时间、吞吐量等指标。

4. 测试方法4.1 负载测试场景设计根据xxx软件的实际使用情况和预期负载水平,设计了以下负载测试场景:- 场景一:200个并发用户,每秒发送10个请求- 场景二:500个并发用户,每秒发送20个请求- 场景三:1000个并发用户,每秒发送30个请求4.2 测试工具本次测试使用了LoadRunner作为性能测试工具,通过模拟用户行为来构建负载场景并记录性能数据。

5. 测试结果与分析5.1 并发用户支持能力在场景一下,xxx软件在200个并发用户的情况下表现良好,无明显的性能下降。

然而,在场景二和场景三下,随着并发用户数量的增加,系统的响应时间逐渐增加,并出现了一些请求超时。

说明xxx 软件在高并发用户压力下性能有限,需进行性能优化。

5.2 响应时间在场景一下,xxx软件的平均响应时间为500ms,在合理范围内。

然而,在场景二和场景三下,平均响应时间分别增至800ms和1200ms,超过了用户期望的范围。

这表明在高负载情况下,xxx软件的响应速度明显下降,需要进一步优化。

5.3 吞吐量在场景一下,xxx软件的吞吐量为200个请求/秒,达到了预期目标。

然而,随着并发用户数量的增加,吞吐量逐渐下降,分别为400个请求/秒和600个请求/秒。

基于Loadrunner的性能测试结果分析与研究

基于Loadrunner的性能测试结果分析与研究作者:张伟来源:《数字化用户》2013年第21期【摘要】软件系统的性能越来越受重视,通过Loadrunner性能测试工具可以对软件系统的性能进行确定、评估和优化。

本文以SugarCRM系统的性能测试为例,对Loadrunner的多种结果分析技术进行研究与实践。

【关键词】Loadrunner 性能测试 Analysis 软件测试测试案例一、SugarCRM系统介绍SugarCRM系统是由Sugar公司基于Linux+Apache+MySql+PHP平台开发的新一代B/S架构客户关系管理系统,主要包括客户关系管理、销售自动化、客户服务跟踪等模块。

本案例按照客户需求对客户管理模块进行了并发性和响应时间测试。

二、Loadrunner的工作流程Loadrunner由三大组件组成,通过这三大组件的协作去完成性能测试,它们分别为虚拟用户发生器(VuGen)、控制器(Controller)和分析器(Analysis)。

Loadrunner工作流程如下:(一)通过VuGen生成脚本,强化脚本并调试脚本。

(二)通过Controller设计场景,执行场景,同时监控场景。

(三)通过Analysis分析结果,并得出测试报告。

三、案例的测试需求与测试执行本文选取SugarCRM系统中客户管理业务流程中大数据提交操作的性能测试作为研究案例,该性能测试要求:系统处理提交数据的响应时间最大不超过15s,至少可以支持30个用户并发操作。

脚本与场景按照需求设计好后,执行30个用户并发操作的响应时间为29.586s,超出了预期的最大值15s。

然后,多次减少并发用户数去重复测试,得出系统可支持的最大并发用户数为14个,此时的响应时间为14.902s,而当并发用户数为15个时,响应时间为15.932s。

四、测试结果分析利用Analysis的技术去分析软件系统可能存在的问题,Analysis常用的技术有:合并、关联、页面细分等。

软件测试实验报告loadrunner

软件测试实验报告loadrunner引言软件测试是保证软件质量的重要手段,而性能测试则是其中的一部分。

在实际应用中,软件的性能往往是用户持续使用的关键因素。

本实验通过使用LoadRunner工具对一个Web应用进行性能测试,旨在评估系统的可扩展性和稳定性。

实验目的1. 了解性能测试的概念和一般流程;2. 掌握LoadRunner工具的基本使用方法;3. 学会分析性能测试结果并调优。

实验环境- 操作系统:Windows 10- 浏览器:Google Chrome- LoadRunner版本:12.55实验步骤步骤一:录制脚本1. 打开LoadRunner主界面,在“组织测试”中选择“录制脚本”;2. 输入脚本名称,选择协议为“Web HTTP/HTML”,点击“开始录制”按钮;3. 在弹出的浏览器中输入被测应用的URL,进入应用的登录页面;4. 按照测试用例的要求进行操作,录制脚本过程中可以对测试步骤进行注释和标记;5. 完成录制后,点击“停止录制”按钮。

步骤二:设计场景1. 在LoadRunner主界面,选择“组织测试”中的“设计场景”;2. 在“设计场景”界面中,将录制的脚本添加到“事务”中,可以设置事务的名称和模式;3. 将事务进行参数化,设置不同的参数取值,以模拟用户的不同行为;4. 可以设置事务之间的延迟时间,模拟用户的思考和操作过程。

步骤三:运行测试1. 在LoadRunner主界面,选择“执行测试”;2. 在“执行测试”界面中,选择要执行的场景,设置并发用户数、循环次数等参数;3. 启动测试并观察测试过程中的各项指标的变化情况,包括响应时间、吞吐量、错误率等;4. 完成测试后,查看测试报告,分析测试结果。

步骤四:优化调整1. 根据测试报告,可以发现系统的瓶颈和性能问题所在;2. 可以对系统进行优化调整,比如增加硬件资源、调整系统配置、修改代码逻辑等;3. 重新运行测试,对比测试结果,看优化效果。

loadrunner性能测试计数器分析

1. Windows性能计数器分析对象计数器分析Processor%processor time 建议阈值85%memoryAvailable bytes建议阈值少于4MB需要添加内存;另外,又建议至少要有10%的物理内存值Pages reads/secPage Reads/sec 是指为解析硬页错误而读取磁盘的次数,如果该值一直持续较大,表明可能内存不足建议阈值30(5?),大数值表示磁盘读而不是缓存读Pages writes/secPage Writes/sec 是指为了释放物理内存空间而将页写入磁盘的次数Pages Input/secPages Input/sec 指为解决页错误从磁盘上读取的页数Pages Output/secPages Output/sec 是指为了释放物理内存空间而写入磁盘的页数如果该值远远大于Pages Input/sec,可能有内存泄露Pages/secPages/sec 是指为解析硬页错误从磁盘读取或写入磁盘的页数建议阈值20Network interface(对于TCP/IP)Bytes received/sec该数据结合Bytes total/sec看Bytes sent/sec该数据结合Bytes total/sec看Bytes total/sec推荐不要超过带宽的50%Packets/sec根据实际数据量大小,无建议阈值,该数据结合Bytes total/sec看Physical diskDisk reads/sec取决于硬盘制造商的规格,检查磁盘的指定传送速度,以验证此速度没有超出规格Disk writes/sec取决于硬盘制造商的规格,检查磁盘的指定传送速度,以验证此速度没有超出规格又:上两值相加,应小于磁盘设备的最大容量%Disk Time建议阈值90%Current disk queue lengthAvg. disk queue length(如果使用RAID设备,%Disk Time计数器显示的值可以大于100%。

Jmeter与loadrunner性能测试工具对比报告

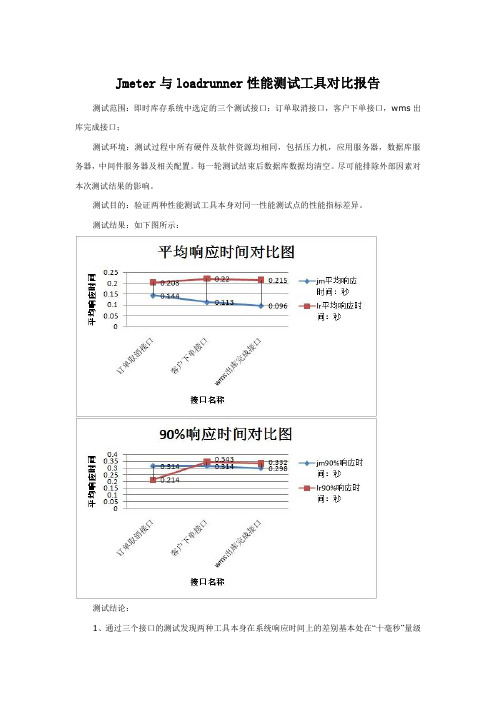

Jmeter与loadrunner性能测试工具对比报告测试范围:即时库存系统中选定的三个测试接口:订单取消接口,客户下单接口,wms出库完成接口;

测试环境:测试过程中所有硬件及软件资源均相同,包括压力机,应用服务器,数据库服务器,中间件服务器及相关配置。

每一轮测试结束后数据库数据均清空。

尽可能排除外部因素对本次测试结果的影响。

测试目的:验证两种性能测试工具本身对同一性能测试点的性能指标差异。

测试结果:如下图所示:

测试结论:

1、通过三个接口的测试发现两种工具本身在系统响应时间上的差别基本处在“十毫秒”量级

上。

2、jmeter相比loadrunner在系统响应时间上略短,系统处理能力略高;

测试问题:通过统计测试结果发现,jmeter在统计系统处理能力,即TPS时,它算出的结果不是平均值,是一个不断上升增加的状态,最后需要手动进行平均,该问题还需在后期测试中进一步验证。

工具使用可行性分析:

1、针对直接调用java代码的一些webservice接口、应用程序的性能测试。

2、数据库sql性能测试。

LoadRunner性能测试结果分析

LoadRunner性能测试结果分析性能测试的需求指标:本次测试的要求是验证在30分钟内完成2000次⽤户登录系统,然后进⾏考勤业务,最后退出,在业务操作过程中页⾯的响应时间不超过3秒,并且服务器的CPU使⽤率、内存使⽤率分别不超过75%、70%LoadRunner性能测试结果分析内容:1、结果摘要LoadRunner进⾏场景测试结果收集后,⾸先显⽰的该结果的⼀个摘要信息,如图1- 2所⽰。

概要中列出了场景执⾏情况、“Statistics Summary(统计信息摘要)”、“Transaction Summary(事务摘要)”以及“HTTP Responses Summary(HTTP响应摘要)”等。

以简要的信息列出本次测试结果。

图1- 2性能测试结果摘要图场景执⾏情况:该部分给出了本次测试场景的名称、结果存放路径及场景的持续时间,如图1- 3所⽰。

从该图我们知道,本次测试从15:58:40开始,到16:29:42结束,共历时31分2秒。

与我们场景执⾏计划中设计的时间基本吻合。

图1- 3场景执⾏情况描述图Statistics Summary(统计信息摘要)该部分给出了场景执⾏结束后并发数、总吞吐量、平均每秒吞吐量、总请求数、平均每秒请求数的统计值,如图1- 4所⽰。

从该图我们得知,本次测试运⾏的最⼤并发数为7,总吞吐量为842,037,409字节,平均每秒的吞吐量为451,979字节,总的请求数为211,974,平均每秒的请求为113.781,对于吞吐量,单位时间内吞吐量越⼤,说明服务器的处理能越好,⽽请求数仅表⽰客户端向服务器发出的请求数,与吞吐量⼀般是成正⽐关系。

图1- 4统计信息摘要图Transaction Summary(事务摘要)该部分给出了场景执⾏结束后相关Action的平均响应时间、通过率等情况,如图1- 5所⽰。

从该图我们得到每个Action的平均响应时间与业务成功率。

注意:因为在场景的“Run-time Settings”的“Miscellaneous”选项中将每⼀个Action当成了⼀个事务执⾏,故这⾥的事务其实就是脚本中的Action。

LoadRunner性能测试介绍

2 LoadRunner特点

(1) 广泛支持业界标准协议 (2) 支持多平台开发的脚本 (3) 创建真实的系统负载 (4) 强大的实时监控与数据采集功能 (5) 精确分析结果,定位问题所在

由“性能”想到的。。。

LOGO

(1)性能测试是什么? 在一定的负载情况下,系统的响应时间、资源利用、效率等特性是否满足特定的性 能需求。 (2)性能测试包含哪些方面? 压力测试、负载测试、并发测试、容量测试、配置测试、基准测试等。 (3)应用系统性能指标主要有哪些? 响应时间、吞吐量、服务器资源利用 (4)性能分析方法主要有哪些? 指标达成法、最优化分析(应用程序诊断、系统调优)。 (5)性能测试的重要性,为什么要进行性能测试? 评估系统的能力 识别系统中的弱点 系统调优 验证可伸缩性和可靠性 ......

(1)不同用户使用不同的数据(通过“参数化”实现) (2) 多用户并发操作(通过“集合点”实现) (3) 用户请求间的依赖关系(通过“关联”实现) (4) 请求间的延时时间(通过“思考时间”实现)

LOGO

性能指标监控

(1) 请求响应时间监控(通过“事务”实现) (2) 服务器处理能力监控(通过“事务”计算吞吐量获得) (3) 服务器资源利用率监控(计数器接口)

d 检查点

LOGO

在进行压力测试时,为了检查Web 服务器返回的网页是否正确,VuGen 允许我们插入Text/Imag 检查点,这些检查点验证网页上是否存在指定的Text 或者Imag,还可以测试在比较大的压力测试环境中,被测的网站功能是否保持 正确。以下是插入检查点的步骤及检查点在脚本中的函数表示。

关联 概念:所谓关联(correlation)就是把脚本 中某些写死的(hard-coded)资料,转 变成是来自服务器的、动态的、每次都不 一样的资料。 原理:服务器在每个浏览器第一次跟它要资 料时,都会在资料中夹带一个唯一的辨识 码,接下来就会利用这个辨识码来辨识跟 它要资料的是不是同一个浏览器。一般称 这个辨识码为Session ID。对于每个新的 交易,服务器都会产生新的Session ID给 浏览器。这也就是为什么执行脚本会失败 的原因,因为VuGen还是用旧的Session ID向服务器要资料,服务器会发现这个 Session ID是失效的或是它根本不认识这 个Session ID,当然就不会传送正确的网 页资料给VuGen了。 要对付这种服务器,我们必须想办法 找出这个Session ID到底是什么、位于何 处,然后把它记录下来,放到某个参数中 ,并且取代掉脚本中有用到Session ID的 部份,这样就可以成功骗过服务图标的视图。 对于录制期间所执行的每一步骤, VuGen 都在测试树中生成一个图 标和一个标题,并附带相应的录制 快照。

Loadrunner的使用及结果分析

使用率保持在70%-85%较理想,低了说明其它 瓶颈(或大型程序对CPU利用率不足)

Processor queue>2且CPU使用率过低说明系 统架构不理想

Processor queue>2且CPU使用率过高说明 CPU瓶颈

C/S系统中,CPU,内存若某一项根据用户请求 的增加而未发生增加一般是由硬件瓶颈造成

吞吐量( Throughput )

吞吐量极限为网络带宽的10%左右,若均值低于5% , 基本可视为网络无瓶颈

一般随着负载的增加呈线性增长

每秒连接数( Connections Per Second )

当添加系统负载,而每秒连接数无明显增加时,一般为 服务器,数据库连接池限制

录制脚本:将所有功能录制在一个脚本中的不同 事务中

内存(Availiable bytes)

内存随着固定用户,固定操作,持续一段时间后 可用内存明显减少一般是发生内存泄露(稳定性 测试)

平均响应时间( Average Transaction Response Time )

衡量系统性能的重要参数 检查其有效性时一般采用对比,其他参数校验

对比:与不同负载时进行数值对比,一般会呈现线性增 长(针对大型软件),出现状态拐点时进行参数校验 其他参数校验:获取响应时间时看其他参数是否异常(比 如CPU,内存,吞吐量等)

状态

上升:指数函数一般性能较差,另一种为性能理想或系 统瓶颈

下降:出现情况比较少,一般是由于服务异常 水平:负载不够或瓶颈

周期性:波动较大的图形注意周期性

平稳状态线:状ห้องสมุดไป่ตู้相对比较稳定的状态 拐点:相对平稳状态间的拐点

loadrunner报告分析报告

LoadRunner报告分析报告1. 引言本文将对LoadRunner的报告进行详细分析,帮助读者了解应用测试的性能瓶颈和优化方向。

LoadRunner是一款常用的性能测试工具,通过模拟真实用户的行为对系统进行压力测试,从而评估系统的性能和可靠性。

2. 报告概览在本节中,我们将对LoadRunner报告的整体概况进行分析。

报告包括以下几个关键指标:2.1 响应时间分析LoadRunner报告提供了每个请求的平均响应时间、最大响应时间和最小响应时间等指标。

通过对这些指标的分析,我们可以了解系统在不同负载下的响应情况。

2.2 事务响应时间分布LoadRunner报告还提供了事务响应时间的分布情况。

通过观察事务响应时间的分布情况,我们可以了解系统中存在的性能瓶颈和优化的空间。

2.3 错误分析LoadRunner报告中的错误分析可以帮助我们定位系统中出现的错误,并分析错误的原因。

通过对错误的分析,我们可以找到系统中的问题,并提出相应的解决方案。

3. 响应时间分析在这一节中,我们将对LoadRunner报告中的响应时间进行详细分析。

通过对响应时间的分析,我们可以了解系统在不同压力下的性能表现。

3.1 平均响应时间平均响应时间是衡量系统性能的重要指标之一。

根据报告显示的平均响应时间,我们可以了解系统对用户请求的平均处理时间。

如果平均响应时间过长,说明系统的性能存在问题,需要进一步优化。

3.2 最大响应时间最大响应时间是指系统处理用户请求的最长时间。

通过分析最大响应时间,我们可以找到系统中存在的性能瓶颈。

如果最大响应时间过长,可能会导致用户体验不佳,需要优化系统的性能。

3.3 最小响应时间最小响应时间是指系统处理用户请求的最短时间。

通过分析最小响应时间,我们可以了解系统在轻负载下的性能表现。

如果最小响应时间过长,可能会导致用户等待时间增加,需要优化系统的性能。

4. 事务响应时间分布在这一节中,我们将对LoadRunner报告中的事务响应时间分布进行分析。

loadrunner测试_200个不同用户登陆的报告模板

200个不同用户登陆结果分析1、L oadrunner测试结果分析如下:Summary(场景摘要)结果及分析如下:Secenario name 场景名称Results in session 场景运行的结果目录Duration 场景运行时间Maximum running vusers(场景最大用户数)Total throughput (bytes)(总带宽流量)Average throughput (bytes/second)(平均每秒宽带流量)Total hit(总点击数)Average hits per second(平均每秒点击数)图1-1此次测试我用了200个用户, 163个passed, 所以实际参与测试的虚拟用户总共有163个。

其中, 总的吞吐量为535484969bytes, 平均吞吐量为1459087bytes, 总的请求量为12321, 平均每秒请求量为33.572, 错误共有37个。

从该图可以看出, 该网页在用户登陆方面存在问题。

图1-2图1-3(注: Action.c(92): Error -27796: Failed to connect to server "61.177.55.188:8080": [10060] Connection timed out.Action.c(104).Erro.-27727.Ste.downloa.timeou.(12.seconds.ha.expire.whe.downloadin.reso urce(s).Se.th."Ste.Timeou.cause.b.resource.i..warning.Run-Tim.Settin.t.Yes/N.t.hav.thi.mes sag.a..warning/error.respectively.Error: missing newline in D:\Program Files\HP\LoadRunner\tutorial\账户登陆1\Name.dat)Running Vusers结果及分析如下:图2-1通过上面图形结果可知, 在刚开始虚拟用户为100个, 11s左右时达到200个, 从1min45s 后逐渐减少, 6min7s左右时用户全部退出访问。

loadrunner中各性能指标解释

1、Transactions(用户事务分析)用户事务分析是站在用户角度进行的基础性能分析。

1.1、TransationSunmmary(事务综述)对事务进行综合分析是性能分析的第一步,通过分析测试时间内用户事务的成功与失败情况,可以直接判断出系统是否运行正常。

1.2、Average Transaciton Response Time(事务平均响应时间)“事务平均响应时间”显示的是测试场景运行期间的每一秒内事务执行所用的平均时间,通过它可以分析测试场景运行期间应用系统的性能走向。

例:随着测试时间的变化,系统处理事务的速度开始逐渐变慢,这说明应用系统随着投产时间的变化,整体性能将会有下降的趋势。

1.3、Transactions per Second(每秒通过事务数/TPS)“每秒通过事务数/TPS”显示在场景运行的每一秒钟,每个事务通过、失败以及停止的数量,是考查系统性能的一个重要参数。

通过它可以确定系统在任何给定时刻的时间事务负载。

分析TPS主要是看曲线的性能走向。

将它与平均事务响应时间进行对比,可以分析事务数目对执行时间的影响。

例:当压力加大时,点击率/TPS曲线如果变化缓慢或者有平坦的趋势,很有可能是服务器开始出现瓶颈。

1.4、Total Transactions per Second(每秒通过事务总数)“每秒通过事务总数”显示在场景运行时,在每一秒内通过的事务总数、失败的事务总数以及停止的事务总数。

1.5、Transaction Performance Sunmmary(事务性能摘要)“事务性能摘要”显示方案中所有事务的最小、最大和平均执行时间,可以直接判断响应时间是否符合用户的要求。

重点关注事务的平均和最大执行时间,如果其范围不在用户可以接受的时间范围内,需要进行原因分析。

1.6、Transaction Response Time Under Load(事务响应时间与负载)“事务响应时间与负载”是“正在运行的虚拟用户”图和“平均响应事务时间”图的组合,通过它可以看出在任一时间点事务响应时间与用户数目的关系,从而掌握系统在用户并发方面的性能数据,为扩展用户系统提供参考。

使用Loadrunner测试数据库性能

使用Load runne r测试数据库性能使用LR对数据库进行性能测试,实际上有多种办法,包括通过现有的数据库协议进行CS模式的先录制后执行的模式,以及通过so cket方式向服务器发包方式的测试方式。

这些是常规书籍上介绍的比较简单上手的测试方法,但是不具备通用性,受已有协议或socke t编程方式的限制,所以需要更为通用的测试方法。

使用Java user的协议进行所有数据库性能的测试工作:Java user 不需要录制,把所有的操作通过jav a语言进行实现,通过lr调用j a va的class进行加压批量操作,这样可以不关心被测系统是哪个数据库,只要能够通过jdbc进行访问,就能实现性能测试。

一、测试环境准备1.被测服务器准备,根据测试目的,搭建需要的数据库服务器,确保数据库能够正常访问,正常操作;2.Java代码的准备,无论使用哪种IDE,只要能够编写访问数据库的class就可以,形式可以是j2se,也可以是j2ee,因为在操作时只使用cl a ss的部分方法,所以j2ee就可以了;3.LR的脚本调试,把java的class导入到脚本调试模式,根据需要添加事务以及其他操作。

二、编写数据库访问1.使用myec lipse,创建webprojec t,创建如下图的包目录:Java文件中包含各种访问数据库的方法。

需要注意的是,class中的方法必须是public static,否则LR中无法调用。

由于创建的是j2ee程序,所以不用ma in函数,在web中就可以进行功能验证。

确认clas s中的方法编写完成,创建一个we b.jsp文件,如下:导入clas s声明类,并实例化,直接调用刚才编写的3个方法,因为这3个方法是直接对数据库进行操作,不需要实参,也没有返回值,所以直接实现即可。

loadrunner结果分析报告

LoadRunner 结果分析报告1. 引言在软件开发的过程中,性能测试是一个至关重要的环节。

性能测试能够帮助我们评估系统的负载能力、稳定性和响应时间等关键指标。

本文将通过分析LoadRunner 测试结果来评估系统的性能表现,为进一步的优化提供指导。

2. 测试背景在进行结果分析之前,首先需要了解测试背景。

我们在一个电子商务平台上进行了性能测试,模拟了多个用户同时访问系统的情况。

测试目的是评估系统在高负载下的性能表现,并发现潜在的性能问题。

3. 测试设计在进行性能测试之前,需要明确测试的设计。

我们使用了 LoadRunner 这一常用的性能测试工具。

测试设计主要包括测试场景的设置、虚拟用户的模拟和测试数据的准备等。

3.1 测试场景设置我们选择了一些常见的用户行为作为测试场景,包括登录、浏览商品、添加购物车和下单等。

这些场景模拟了用户在电商平台上的典型行为。

3.2 虚拟用户模拟为了模拟真实的用户场景,我们使用了 LoadRunner 提供的虚拟用户功能。

通过设置虚拟用户的数量和行为,我们可以模拟多个用户同时访问系统的情况。

3.3 测试数据准备为了模拟真实的情况,我们需要准备一些测试数据。

这些数据包括用户信息、商品信息和订单信息等。

通过使用真实的数据,我们可以更准确地评估系统的性能。

4. 测试结果分析在进行性能测试后,我们得到了一系列的测试结果数据。

下面将详细分析这些数据,以评估系统的性能表现。

4.1 吞吐量分析吞吐量是衡量系统性能的重要指标之一,它表示在单位时间内系统处理的请求数量。

我们通过 LoadRunner 的结果数据计算出了系统在不同负载下的吞吐量,并绘制成图表进行分析。

4.2 响应时间分析响应时间是用户感知系统性能的关键指标,它表示用户发送请求到系统返回结果的时间。

我们通过 LoadRunner 的结果数据计算出了系统在不同负载下的平均响应时间,并绘制成图表进行分析。

4.3 错误率分析错误率是衡量系统稳定性的指标之一,它表示系统在处理请求时出现错误的比率。

LoadRunner性能测试系统学习教程:Analysis分析器(1)

LoadRunner性能测试系统学习教程:Analysis分析器(1)分析器顾名思义就是对测试结果数据进⾏分析的组件,它是LoadRunner三⼤组件之⼀,其重要性不⾔⽽喻。

在Controller组件执⾏场景的过程中,LoadRunner会将数据收集起来并保存到数据库中。

当场景执⾏完成后,可以进⼊Analysis组件对这些数据进⾏分析。

分析器中保存着⼤量⽤来分析性能测试结果的数据视图,但并不⼀定要对每个视图进⾏分析,可以根据实际情况选择相关的数据视图进⾏分析,分析结果可以⽣成⼀些不同格式的测试报告。

主要讲述以下⼏部分内容:Analysis简介摘要报告Analysis常见图分析Analysis报告Analysis简介介绍Analysis分析器如何收集数据,在分析器中对视图进⾏分析中常⽤到的设置选项;介绍分析视图中的摘要报告的内容;分析器中常⽤的分析视图,最后介绍通过分析器如何⽣成测试报告。

Analysis基础知识要分析系统瓶颈,就必须借助LoadRunner分析器中的数据来帮助分析。

在场景执⾏过程中,LoadRunner会收集执⾏过程中的数据,并将数据存储到结果⽂件中,其扩展名为.lrr。

在Analysis分析器,打开保存的结果⽂件,Analysis会对收集到的信息进⾏处理,并⽣成图和报告。

Analysis会话⾄少包含⼀组⽅案结果(lrr⽂件)。

Analysis会将活动图的显⽰信息和布局设置存储在扩展名为.lrr的⽂件中。

关于数据分析,不仅仅局限于只在Analysis分析器中对数据进⾏分析,可以采⽤多种⽅式进⾏分析:Vuser⽇志⽂件:Vuser⽇志⽂件包括每个Vuser运⾏⽅案的完整跟踪。

这些⽂件位于⽅案结果⽬录中。

Controller输出窗⼝:在Controller输出窗⼝会显⽰出整个⽅案运⾏过程中的错误或警告信息,当然其中最关注的信息还是输出的错误信息,通过查看这些错误信息有利于帮助性能调试⼯作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

5.4.2测试结果分析LoadRunner性能测试结果分析是个复杂的过程,通常可以从结果摘要、并发数、平均事务响应时间、每秒点击数、业务成功率、系统资源、网页细分图、Web服务器资源、数据库服务器资源等几个方面分析,如图5- 1所示。

性能测试结果分析的一个重要的原则是以性能测试的需求指标为导向。

我们回顾一下本次性能测试的目的,正如错误!未找到引用源。

所列的指标,本次测试的要求是验证在30分钟内完成2000次用户登录系统,然后进行考勤业务,最后退出,在业务操作过程中页面的响应时间不超过3秒,并且服务器的CPU 使用率、内存使用率分别不超过75%、70%,那么按照所示的流程,我们开始分析,看看本次测试是否达到了预期的性能指标,其中又有哪些性能隐患,该如何解决。

图5- 1性能测试结果分析流程图结果摘要LoadRunner进行场景测试结果收集后,首先显示的该结果的一个摘要信息,如图5- 2所示。

概要中列出了场景执行情况、“Statistics Summary(统计信息摘要)”、“Transaction Summary(事务摘要)”以及“HTTP Responses Summary(HTTP响应摘要)”等。

以简要的信息列出本次测试结果。

图5- 2性能测试结果摘要图场景执行情况该部分给出了本次测试场景的名称、结果存放路径及场景的持续时间,如图5- 3所示。

从该图我们知道,本次测试从15:58:40开始,到16:29:42结束,共历时31分2秒。

与我们场景执行计划中设计的时间基本吻合。

图5- 3场景执行情况描述图Statistics Summary(统计信息摘要)该部分给出了场景执行结束后并发数、总吞吐量、平均每秒吞吐量、总请求数、平均每秒请求数的统计值,如图5- 4所示。

从该图我们得知,本次测试运行的最大并发数为7,总吞吐量为842,037,409字节,平均每秒的吞吐量为451,979字节,总的请求数为211,974,平均每秒的请求为113.781,对于吞吐量,单位时间内吞吐量越大,说明服务器的处理能越好,而请求数仅表示客户端向服务器发出的请求数,与吞吐量一般是成正比关系。

图5- 4统计信息摘要图Transaction Summary(事务摘要)该部分给出了场景执行结束后相关Action的平均响应时间、通过率等情况,如图5- 5所示。

从该图我们得到每个Action的平均响应时间与业务成功率。

图5- 5事务摘要图HTTP Responses Summary(HTTP响应摘要)该部分显示在场景执行过程中,每次HTTP请求发出去的状态,是成功还是失败,都在这里体现,如图5- 6所示。

从图中可以看到,在本次测试过程中LoadRunner共模拟发出了211974次请求(与“统计信息摘要”中的“Total Hits”一致),其中“HTTP 200”的是209811次,而“HTTP 404”则有2163,说明在本次过程中,经过发出的请求大部分都能正确响应了,但还是有部分失败了,但未影响测试结果,“HTTP 200”表示请求被正确响应,而“HTTP 404”表示文件或者目录未能找到。

有朋友可能会问,这里出现了404的错误,为什么结果还都通过了。

出现这样问题的原因是脚本有些页面的请求内容并非关键点,比如可能请求先前的cookie信息,如果没有就重新获取,所以不会影响最终的测试结果。

图5- 6 HTTP响应摘要常用的HTTP状态代码如下:并发数分析“Running Vusers(运行的并发数)”显示了在场景执行过程中并发数的执行情况。

它们显示Vuser的状态、完成脚本的Vuser的数量以及集合统计信息,将这些图与事务图结合使用可以确定Vuser的数量对事务响应时间产生的影响。

图5- 7显示了在OA系统考勤业务性能测试过程中Vusers运行情况,从图中我们可以看到,Vusers的运行趋势与我们场景执行计划中的设置是一样,表明在场景执行过程中,Vusers是按照我们预期的设置运行的,没有Vuser出现运行错误,这样从另一个侧面说明我们的参数化设置是正确的,因为使用唯一数进行参数化设置,如果设置不正确,将会导致Vuser运行错误。

在脚本中我们加入了这样一段代码:上述代码的意思是说,如果登录失败了,就退出脚本的迭代,那么什么原因可能会导致登录失败呢?就是我们前面参数化的设置,一旦Vuser分配不到正确的登录账号,就可能导致登录失败,从而引起Vuser停止运行。

所以,从图5- 7的表现,可以认为参数化是没有问题的。

图5- 7运行的并发数图测试脚本中我们还使用了集合点,那么这里还可以看看集合点在场景执行过程中的表现,点击左边的“New Graph”,出现图5- 8,展开“Vusers”前的加号,双击“Rendezvous”,出现集合点的图形后,点击【Close】,关闭添加新图界面。

图5- 8添加集合点统计图集合点的图形如图5- 9所示,从图中可以看到,所有用户到达集合点后,立刻就释放了。

与之前设定的集合点策略设置“所有运行用户到达后释放“是一致的。

假设这样的一种情况,Running的Vusers有10个,集合点策略设置是“所有运行用户到达后释放”,而集合点图形显示的最大释放Vusers是7个,那么就表示有些Vuser超时了,引起超时的原因可能是Vuser得到的响应超时了,可以结合平均事务响应时间再详细分析原因。

图5- 9集合点状态图我们本次测试Running Vusers与集合点是一致,说明整个场景执行过程中,并发数用户的执行正确,OA系统测试服务器能够应付7个并发用户的业务操作。

响应时间在性能测试要求中我们知道,有一项指标是要求登录、考勤业务操作的页面响应时间不超过3秒,那么本次测试是否达到了这个要求呢?我们先来看“Average Transaction Response Time(平均事务响应时间图)”(图5- 10),这张图是平均事务响应时间与结果摘要中的“Transaction Summary”合成的。

图5- 10平均事务响应时间图从图形下部我们可以看到,登录部分对应的Action是“submit_login”,考勤业务提交对应的Action是“submit_sign”,他们的“Average Time(平均响应时间为)”分别是4.425秒与0.848秒,从这两个数值来看,考勤业务的事务响应时间0.848秒小于预期的3秒,达到了要求,而登录是4.425秒,大于预期的3秒,不符合要求。

这样的结果是不正确的,因为在统计的登录业务的时候,我们没有去除思考时间,所以,登录功能的实际事务时间应该是4.425秒-3秒=1.425秒,小于预期的3秒,故登录业务的事务响应时间也达到了我们的要求。

在平时的性能测试活动中,统计结果的时候需要去掉思考时间,加上思考时间是为了真实的模拟用户环境,统计结果中除去思考时间是为了更真实的反映服务器的处理能力,两者并不矛盾。

看完了“Average Time”,我们再看“90 Percent Time”,这个时间从某种程度来说,更准确衡量了测试过程中各个事务的真实情况,表示90%的事务,服务器的响应都维持在某个值附近,“Average Time”值对于平均事务响应时间变动趋势很大的情况统计就不准确了,比如有三个时间:1秒、5秒、12秒,则平均时间为6秒,而另外一种情况:5秒、6秒、7秒,平均时间也为6秒,显然第二种比第一种要稳定多了。

所以,我们在查看平均事务响应时间的时候,先看整体曲线走势,如果整体趋势比较平滑,没有忽上忽下的波动情况,取“Average Time”与“90 Percent Time”都可以,如果整体趋势毫无规律,波动非常大,我们就不用“Average Time”而使用“90 Percent Time”可能更真实些。

从图5- 10可以看出,所有Action平均事务响应时间的趋势都非常平滑,所以使用“Average Time”与“90 Percent Time”差别不是很大,用哪个都可以。

这里是使用最常用的统计方法“90 Percent Time”。

登录业务的“90 Percent Time”是5.298秒-3秒(思考时间)=2.298秒,考勤业务的“90 Percent Time”是1.469秒,没有思考时间,那么就是实打实的表5- 1测试结果对照表一每秒点击数“Hits per Second(每秒点击数)”反映了客户端每秒钟向服务器端提交的请求数量,如果客户端发出的请求数量越多,与之相对的“Average Throughput (bytes/second)”也应该越大,并且发出的请求越多会对平均事务响应时间造成影响,所以在测试过程中往往将这三者结合起来分析。

图5- 11显示的是“Hits per Second”与“Average Throughput (bytes/second)”的复合图,从图中可以看出,两种图形的曲线都正常并且基本一致,说明服务器能及时的接受客户端的请求,并能够返回结果。

如果“Hits per Second”正常,而“Average Throughput (bytes/second)”不正常,则表示服务器虽然能够接受服务器的请求,但返回结果较慢,可能是程序处理缓慢。

如果“Hits per Second”不正常,则说明客户端存在问题,那种问题一般是网络引起的,或者录制的脚本有问题,未能正确的模拟用户的行为。

具体问题具体分析,这里仅给出一些建议。

图5- 11每秒点击数与每秒吞吐量复合图对于本次测试来说,“Hits per Second”与“Average Throughput (bytes/second)”都是正常的,而且整体表现还是不错的。

一般情况下,这两种指标用于性能调优,比如给定了几个条件,去检测另外一个条件,用这两个指标衡量,往往起到很好的效果。

比如要比较某两种硬件平台的优劣,就可以使用相同的配置方法部署软件系统,然后使用相同的脚本、场景设计、统计方法去分析,最终得出一个较优的配置。

业务成功率“业务成功率”这个指标在很多系统中都提及到,比如电信的、金融的、企业资源管理的等等。

举个例子,我们楼下的建行,假如每天的业务类别是这样的:20个开户,5个销户,300个存款,500取款,100个汇款等,那么在做他们的营业系统测试时就需要考虑业务成功率了,一般不得低于98%。

具体的业务成功率是什么意思呢?排除那些复杂的业务,比如异步处理的业务(移动的套卡开通就是异步的),业务成功率就是事务成功率,用户一般把一个Aciton当做一笔业务,在LoadRunner场景执行中一笔交易称为一个事务。

所以,说业务成功率其实就是事务成功率、通过率的意思。