ffmpeg的tutorial中文版

[转]ffmpeg开发指南(一)--中文版

![[转]ffmpeg开发指南(一)--中文版](https://img.taocdn.com/s3/m/868a452b4a35eefdc8d376eeaeaad1f34693113b.png)

[转]ffmpeg开发指南(⼀)--中⽂版原地址:Ffmpeg 中的Libavformat 和 libavcodec库是访问⼤多数视频⽂件格式的⼀个很好的⽅法。

不幸的是,在开发您⾃⼰的程序时,这套库基本上没有提供什么实际的⽂档可以⽤来作为参考(⾄少我没有找到任何⽂档),并且它的例程也并没有太多的帮助。

这种情况意味着,当我在最近某个项⽬中需要⽤到 libavformat/libavcodec 库时,需要作很多试验来搞清楚怎样使⽤它们。

这⾥是我所学习的--希望我做的这些能够帮助⼀些⼈,以免他们重蹈我的覆辙,作同样的试验,遇到同样的错误。

你还可以从这⾥下载⼀个demo程序。

我将要公开的这部分代码需要0.4.8 版本的ffmpeg库中的 libavformat/libavcodec 的⽀持(我正在写最新版本)。

如果您发现以后的版本与我写的程序不能兼容,请告知我。

在这个⽂档⾥,我仅仅涉及到如何从⽂件中读⼊视频流;⾳频流使⽤⼏乎同样的⽅法可以⼯作的很好,不过,我并没有实际使⽤过它们,所以,我没于办法提供任何⽰例代码。

或许您会觉得奇怪,为什么需要两个库⽂件 libavformat 和 libavcodec :许多视频⽂件格式(AVI就是⼀个最好的例⼦)实际上并没有明确指出应该使⽤哪种编码来解析⾳频和视频数据;它们只是定义了⾳频流和视频流(或者,有可能是多个⾳频视频流)如何被绑定在⼀个⽂件⾥⾯。

这就是为什么有时候,当你打开了⼀个AVI⽂件时,你只能听到声⾳,却不能看到图象--因为你的系统没有安装合适的视频解码器。

所以, libavformat ⽤来处理解析视频⽂件并将包含在其中的流分离出来,⽽libavcodec 则处理原始⾳频和视频流的解码。

打开视频⽂件:⾸先第⼀件事情--让我们来看看怎样打开⼀个视频⽂件并从中得到流。

我们要做的第⼀件事情就是初始化libavformat/libavcodec:av_register_all();这⼀步注册库中含有的所有可⽤的⽂件格式和编码器,这样当打开⼀个⽂件时,它们才能够⾃动选择相应的⽂件格式和编码器。

《FFmpegBasics》中文版-06-填充视频

《FFmpegBasics》中文版-06-填充视频写在前面如果您对音视频技术感兴趣,可以订阅我的专题:音视频专辑也可以关注我的简书账户:张芳涛,我后期会发布更多的音视频以及图像处理方面的文章。

正文填充视频意味着向视频帧添加额外的区域以包含额外的内容。

当输入应在具有不同宽高比的显示器上播放时,通常需要填充视频。

填充视频基础知识对于视频填充,我们使用表格中描述的填充过滤器。

描述在输入视频帧中添加彩色填充,该帧位于协调系统中的[x,y]点,其中输出帧的左上角是[0,0]。

输出的大小由宽度和高度参数设置。

语法pad=width[:height[:x[:y[:color]]]] 中括号里面的参数都是可选的*********** 参数的描述color 十六进制形式的RGB颜色值:0xRRGGBB [@AA],其中AA的范围是(0,1)中的十进制值或任何有效的颜色名称,如白色,蓝色,黄色等,默认值为黑色,请参见颜色有关详细信息,请参阅FFmpeg基本介绍章节中的名称部分width, height 带填充的输出帧的宽度和高度,宽度的值可以从高度导出,反之亦然,两个参数的默认值都是0x, y 输入左上角的坐标(偏移量)与输出帧的左上角有关,两个参数的默认值均为0*********** 参数的高度,宽度,x, y的表达式的可用变量a 纵横比,与iw/ih相同dar 输入显示宽比,与*sar相同hsub, vsub 水平和垂直的色度子样本值,对于像素格式yuv422p, hsub的值为2,vsub为1in_h, ih 输入的高度描述在输入视频帧中添加彩色填充,该帧位于协调系统中的[x,y]点,其中输出帧的左上角是[0,0]。

输出的大小由宽度和高度参数设置。

in_w, iw 输入的宽度n 输入框的数目,从0开始out_h, oh 输出高度,默认值=高度out_w, ow 输出宽度,默认值=宽度pos 位置在输入框的文件中,如果不知道NANsar 输入样本比例t 时间戳以秒表示,如果输入时间戳未知x, y x和y的偏移量由x和y表示,或者NAN如果没有指定例如,为了在一个svga大小的照片周围创建一个30像素宽的粉红色框架,我们可以使用以下命令:ffmpeg -i photo.jpg -vf pad=860:660:30:30:pink framed_photo.jpg•这里面给大家说一下,我自己测试的结果是,我首先用了一张1920*1200大小的图片,一点问题都没有,命令如下:•ffmpeg -i /Users/zhangfangtao/Desktop/Work/002.jpg -vf pad=1980:1260:30:30:pink /Users/zhangfangtao/Desktop/Work/003.jpg原来的图片如下图:原来的图片新的图片如下图:新的图片后来我又用了一下一个尺寸是250*250的图片,做实验,结果发现乱码了:指令如下:ffmpeg -i /Users/zhangfangtao/Desktop/Work/001.jpg -vf pad=310:310:30:30:pink/Users/zhangfangtao/Desktop/Work/003.jpg原图如下:001.jpg生成的图片如下:(虽然你们看到的没花屏,不过在我这儿确实是花的)003.jpg我看到的,其实这是一张图,我上传上去就正常了见了鬼的图片。

FFmpeg用户指南说明书

Table of ContentsAbout1 Chapter 1: Getting started with ffmpeg2 Remarks2 Examples2 Installation or Setup2 OS X2 Windows2 Unix3 What is FFmpeg?3 Chapter 2: Decoding4 Introduction4 Examples4 Find a stream4 Open a codec context4 Decode frames5 Chapter 3: Ffmpeg Restream7 Examples7 Simple Device Restream7 Chapter 4: Reading Media8 Introduction8 Examples8 Reading from memory8 Reading from a file9 Reading from a format context9 Reading from an IStream in a IOContext9 Seeking within an IStream in an IOContext10 Credits11AboutYou can share this PDF with anyone you feel could benefit from it, downloaded the latest version from: ffmpegIt is an unofficial and free ffmpeg ebook created for educational purposes. All the content is extracted from Stack Overflow Documentation, which is written by many hardworking individuals at Stack Overflow. It is neither affiliated with Stack Overflow nor official ffmpeg.The content is released under Creative Commons BY-SA, and the list of contributors to each chapter are provided in the credits section at the end of this book. Images may be copyright of their respective owners unless otherwise specified. All trademarks and registered trademarks are the property of their respective company owners.Use the content presented in this book at your own risk; it is not guaranteed to be correct nor accurate, please send your feedback and corrections to ********************Chapter 1: Getting started with ffmpeg RemarksFFMpeg This section provides an overview of what ffmpeg is, and why a developer might want to use it.It should also mention any large subjects within ffmpeg, and link out to the related topics. Since the Documentation for ffmpeg is new, you may need to create initial versions of those related topics.ExamplesInstallation or SetupFFmpeg can be installed on a mixture of Operating Systems, including Unix and OS X. Using a command line extension, this utility can also be installed on Windows using a dll.OS XTo install this utility on OS X, just head over to , download the release relative to your Macs architecture (instructions on finding this can be found here). Then put the application into an accessible directory and run it from command line.Another way is using HomeBrew: https:///211541/homebrew-for-os-x-easily-installs-desktop-apps-and-terminal-utilities/For examplebrew install ffmpeg --with-fdk-aac --with-ffplay --with-libass --with-libvorbis --with-libvpx --with-rtmpdump --with-openh264 --with-toolsWindowsTo install this utility on Windows, head over to[](https:///download.html#build-windows) and follow the download link, using your architecture. Instructions on finding this can be seen[here](/en-us/windows/forum/windows_7-hardware/i-need-to-know-how-to-determine-my-processors/3ede9c69-25f5-427b-8e8d-e9dd2d032d22). Then place the downloaded software into an accessible directory and run from command line.UnixTo install this utility on Unix, just follow the instructions found at[](https:///download.html#build-linux)To check if ffmpeg is installed correctly and see a list of available commands try running the following command in the command line:ffmpeg -helpWhat is FFmpeg?FFmpeg (or "Fast Forward MPEG") is a simple yet feature rich command line utility to allow the manipulation (including decoding, encoding, transcoding, muxing, demuxing, streaming, filtering, and playing) of media and video files. This utility differs from other GUI orientated software as it employs the WYSIWYG methodology (What You See Is What You Get). Instead of hidden away menus and features, everything can be found by just typing ffmpeg -h when set up, or following the comprehensive documentation. In addition to the command line tool there are a number of C libraries (which it uses), that can be used to bring the functionality of FFmpeg into other projects. The documentation for the libraries includes many examples to help get you started.Read Getting started with ffmpeg online: https:///ffmpeg/topic/4935/getting-started-with-ffmpegChapter 2: DecodingIntroductionGetting the raw video/audio from encoded media streams.ExamplesFind a streamMedia stream containers usually have a several streams, such as a video stream and an audio stream. For example, you can get the audio stream using the following:// A Format Context - see Reading Data for more infoAVFormatContext *formatContext;// Inspect packets of stream to determine propertiesif (avformat_find_stream_info(formatContext, NULL) < 0){// Error finding info}// Find the stream and its codecAVCodec* audioCodec;int audioStreamIndex = av_find_best_stream(formatContext, // The media streamAVMEDIA_TYPE_AUDIO, // The type of stream we are looking for - audio for example-1, // Desired stream number, -1 for any-1, // Number of related stream, -1 for none&audioCodec, // Gets the codec associated with the stream, can be NULL0 // Flags - not used currently);if(audioStreamIndex = AVERROR_STREAM_NOT_FOUND || !audioCodec){// Error finding audio (ie. no audio stream?)}To get other types of streams, you just need to replace the type of stream. The following are valid types:AVMEDIA_TYPE_VIDEO,AVMEDIA_TYPE_AUDIO,AVMEDIA_TYPE_SUBTITLE,AVMEDIA_TYPE_DATA, // Usually continuousAVMEDIA_TYPE_ATTACHMENT, // Usually sparseOpen a codec contextOnce you have a stream Format Context and its respective Codec, you can open it for decoding using the following code:// The format context and codec, given - see Find a stream for how to get theseAVFormatContext *formatContext;AVCodec* codec;int streamIndex;// Get the codec contextAVCodecContext *codecContext = avcodec_alloc_context3(codec);if (!codecContext){// Out of memoryavformat_close_input(&formatContext);}// Set the parameters of the codec context from the streamint result = avcodec_parameters_to_context(codecContext,formatContext->streams[streamIndex]->codecpar);if(result < 0){// Failed to set parametersavformat_close_input(&formatContext);avcodec_free_context(&codecContext);}// Ready to open stream based on previous parameters// Third parameter (NULL) is optional dictionary settingsif (avcodec_open2(codecContext, codec, NULL) < 0){// Cannot open the video codeccodecContext = nullptr;}// Do something with the opened codec context... (ie decode frames through the context) Decode framesGiven a codec context and encoded packets from a media stream, you can start decoding media into raw frames. To decode a single frame, you can use the following code:// A codec context, and some encoded data packet from a stream/file, given.AVCodecContext *codecContext; // See Open a codec contextAVPacket *packet; // See the Reading Media topic// Send the data packet to the decoderint sendPacketResult = avcodec_send_packet(codecContext, packet);if (sendPacketResult == AVERROR(EAGAIN)){// Decoder can't take packets right now. Make sure you are draining it.}else if (sendPacketResult < 0){// Failed to send the packet to the decoder}// Get decoded frame from decoderAVFrame *frame = av_frame_alloc();int decodeFrame = avcodec_receive_frame(codecContext, frame);if (decodeFrame == AVERROR(EAGAIN)){// The decoder doesn't have enough data to produce a frame// Not an error unless we reached the end of the stream// Just pass more packets until it has enough to produce a frameav_frame_unref(frame);av_freep(frame);}else if (decodeFrame < 0){// Failed to get a frame from the decoderav_frame_unref(frame);av_freep(frame);}// Use the frame (ie. display it)If you want to decode all frames, you can simply place the previous code in a loop, feeding it consecutive packets.Read Decoding online: https:///ffmpeg/topic/10090/decodingChapter 3: Ffmpeg RestreamExamplesSimple Device RestreamFfmpeg is a swiss knife for streaming project. For any kind of device streaming you only need to get the specification of device. To list the deviceffmpeg -f dshow -list_devices true -i dummyCommand prompt will list all the aviable device on machine.[dshow @ 0000000004052420] DirectShow video devices[dshow @ 0000000004052420] "ManyCam Virtual Webcam"[dshow @ 0000000004052420] "UScreenCapture"[dshow @ 0000000004052420] DirectShow audio devicesFor restreaming the audio&video device,ffmpeg -f dshow -i video="DirectShow video devices":audio="DirectShow audio devices"-vcodec libx264 -acodec aac -strict experimental 2 -tune zerolatency -f flvrmtp://WOWZA_IP/WOWZA_APP/STREAMNAMEThis can be extended all kind of device like medical devices or video hardware.Read Ffmpeg Restream online: https:///ffmpeg/topic/9517/ffmpeg-restreamChapter 4: Reading MediaIntroductionThere are a few ways to read Audio/Video into FFmpeg.ExamplesReading from memorylibavformat usually takes in a file name and reads media directly from the filesystem. If you want to read from memory (such as streams), do the following:// Define your buffer sizeconst int FILESTREAMBUFFERSZ = 8192;// A IStream - you choose where it comes fromIStream* fileStreamData;// Alloc a buffer for the streamunsigned char* fileStreamBuffer = (unsigned char*)av_malloc(FILESTREAMBUFFERSZ);if (fileStreamBuffer == nullptr){// out of memory}// Get a AVContext streamAVIOContext* ioContext = avio_alloc_context(fileStreamBuffer, // BufferFILESTREAMBUFFERSZ, // Buffer size0, // Buffer is only readable - set to 1 for read/writefileStreamData, // User (your) specified dataFileStreamRead, // Function - Reading Packets (see example)0, // Function - Write PacketsFileStreamSeek // Function - Seek to position in stream (see example));if(ioContext == nullptr){// out of memory}// Allocate a AVContextAVFormatContext *formatContext = avformat_alloc_context();// Set up the Format ContextformatContext->pb = ioContext;formatContext->flags |= AVFMT_FLAG_CUSTOM_IO; // we set up our own IO// Open "file" (open our custom IO)// Empty string is where filename would go. Doesn't matter since we aren't reading a file// NULL params are format and demuxer settings, respectivelyif (avformat_open_input(&formatContext, "", nullptr, nullptr) < 0){// Error opening file}// Do something with the formatContext// Free resources!avformat_close_input(&formatContext);av_free(ioContext);Reading from a fileOpening a media file from the local file system.AVFormatContext *formatContext;// Open the fileif(avformat_open_file(&formatContext, "path/to/file.ogg", NULL, NULL) < 0){// Error opening file}// Do something with the file// Free resourcesavformat_close_input(&formatContext);Reading from a format contextFormats contain one or more encoded and muxed streams. We usually read these in chunks, which are often called frames (though in certain cases, FFmpeg refers exclusively to decoded, raw media chunks as frames, and encoded chunks as packets, which may be confusing). To read a single frame from a format, use the following:// A Format Context - see other examples on how to create itAVFormatContext *formatContext;// Initialize the AVPacket manuallyAVPacket avPacket;av_init_packet(&avPacket); // set fields of avPacket to default.avPacket.data = NULL;avPacket.size = 0;// Read from the context into the packetif(av_read_frame(formatContext, &avPacket) == 0){// nothing read}// Use the packet (such as decoding it and playing it)// Free packetav_packet_unref(&avPacket);Reading from an IStream in a IOContextThe API call avio_alloc_context, which sets up a custom IO context, takes in a pointer to a Read function. If you are reading from an IStream, you can use the following:/*** Reads from an IStream into FFmpeg.** @param ptr A pointer to the user-defined IO data structure.* @param buf A buffer to read into.* @param buf_size The size of the buffer buff.** @return The number of bytes read into the buffer.*/int FileStreamRead(void* ptr, uint8_t* buf, int buf_size){// This is your IStreamIStream* stream = reinterpret_cast<IStream*>(ptr);ULONG bytesRead = 0;HRESULT hr = stream->Read(buf, buf_size, &bytesRead);if(hr == S_FALSE)return AVERROR_EOF; // End of fileif(FAILED(hr))return -1;return bytesRead;}Seeking within an IStream in an IOContextThe API call avio_alloc_context, which sets up a custom IO context, takes in a pointer to a Seek function. If you are reading from an IStream, you can use the following:/*** Seeks to a given position on an IStream.** @param ptr A pointer to the user-defined IO data structure.* @param pos The position to seek to.* @param origin The relative point (origin) from which the seek is performed.** @return The new position in the IStream.*/int64_t FileStreamSeek(void* ptr, int64_t pos, int origin){// Your custom IStreamIStream* stream = reinterpret_cast<IStream*>(ptr);// Prevent overflowsLARGE_INTEGER in = { pos };ULARGE_INTEGER out = { 0 };// Origin is an item from STREAM_SEEK enum.// STREAM_SEEK_SET - relative to beginning of stream.// STREAM_SEEK_CUR - relative to current position in stream.// STREAM_SEEK_END - relative to end of stream.if(FAILED(stream->Seek(in, origin, &out)))return -1;// Return the new positionreturn out.QuadPart;}Read Reading Media online: https:///ffmpeg/topic/10089/reading-mediaCredits。

《FFmpegBasics》中文版-25-调试和测试

《FFmpegBasics》中文版-25-调试和测试写在前面如果您对音视频技术感兴趣,可以订阅我的专题:音视频专辑也可以关注我的简书账户:张芳涛,我后期会发布更多的音视频以及图像处理方面的文章。

正文为了检测错误并测试各种输入,参数,性能等,我们可以使用多个FFmpeg过滤器,选项和来源。

当控制台输出很长时,-report选项会将测试结果保存到名为ffmpeg-yyyymmdd-hhmmss.log的文件中,其中斜体部分表示当前日期和时间。

debug, debug_ts and fdebug选项FFmpeg中的基本调试工具是一个-debug选项,其中在下表中描述了17个可能值:描述打印关于所选音频,字幕或视频流的特定调试信息语法-debug[:stream_specifier]可用值的描述pict 图片信息rc 速率控制bitstream 比特流mb_type 宏块(MB)类型qp 每块量化参数(QP)mv 运动矢量dct_coeff DCT系数skip 进度跳跃startcode 起始码pts 演示文稿时间戳er 错误识别mmco 内存管理控制操作(H.264)bugs bugs(错误)vis_qp 可视化量化参数(QP),较低的QP是更绿色的描述打印关于所选音频,字幕或视频流的特定调试信息vis_mb_type 可视化块类型buffers 图片缓冲区分配thread_ops 线程操作例如,我们将mptestsrc源的短输出保存为具有mmco值的MP4(H.264)文件:ffmpeg -debug mmco -f lavfi -i mptestsrc -t 0.5 output.mp4 向控制台输出添加了12行描述各个帧; 包含的术语说明:•QP - 量化参数•NAL - 网络抽象层单元•切片:B - 双向预测,I - 帧内编码,P - 预测另一个调试选项是-debug_ts,它可以在处理期间打印时间戳信息,例如我们可以修改前面的示例并仅使用0.1秒(3帧):ffmpeg -debug_ts -f lavfi -i mptestsrc -t 0.1 output.mp4向控制台输出添加下一行:选项-fdebug只有1个可能的值ts,通常与-debug_ts选项一起用于各种测试,例如调试DTS(解码时间戳)和PTS(演示时间戳)关系。

FFMPEG完美入门资料

1. 文档介绍 ......................................................................................................................... 3 1.1 文档目的 .................................................................................................................... 3 1.2 文档范围 .................................................................................................................... 3 1.3 读者对象 .................................................................................................................... 3 1.4 参考文献 .................................................................................................................... 3 1.5 术语与缩写解释 ......................................................................................................... 3 2. FFMPEG 支持能力说明 ......................

ffmpeg中文文档

ffmpeg的中⽂⽂档1. 概要ffmpeg [global_options] {[input_file_options] -iINPUT_FILE} ... {[output_file_options] OUTPUT_FILE} ... 2. 说明ffmpeg是⼀个⾮常快的视频和⾳频转换器,还可以抓取实时的⾳频/视频流。

它可以在任意的采样率之间的转换和调整视频,并同时使⽤⾼品质的多相滤波器。

ffmpeg从输⼊“⽂件”(其可以是常规⽂件,管道,⽹络流,录制装置等),由指定任意数量的读取-i选项,并写⼊到任意数量的输出“⽂件”,只需指定⼀个输出的⽂件名。

任何⼀个命令⾏中不能被解释为选项的内容都被认为是⼀个输出⽂件名。

每个输⼊或输出⽂件可以在原则上,包含任意数量的不同类型(视频/⾳频/字幕/附件/数据)的流。

输出⽂件中允许流的数量和类型是由输出格式容器限制决定的。

输⼊流和输出流直接的映射可以⾃动完成也可以⽤-map选项给定(⻅流选择章节)。

引⽤输⼊⽂件的选项时,则必须使⽤他们的索引(从0开始)。

例如:第⼀输⼊⽂件是0 ,第⼆个是1等。

类似地,⼀个⽂件中的流也通过其索引指定。

例如2:3指的是在第三个输⼊⽂件中的第四数据流。

参⻅流章节。

作为⼀般规则,选项作⽤于下⼀个指定的⽂件。

因此,命令的顺序是重要,你可以在命令⾏上多次相同的选项。

每次选项的出现都将作⽤于下⼀个输⼊或输出⽂件。

这条规则若有例外将会提前声明(例如冗余级别)。

不要混合输⼊和输出⽂件。

⾸先指定所有输⼊⽂件,那么所有的输出⽂件。

也不要混⽤属于不同的⽂件的选项。

所有选项仅适⽤于下⼀个输⼊或输出⽂件,之后选项将被重置。

设置输出⽂件以64千⽐特/秒的视频⽐特率:ffmpeg -i input.avi -b:V 64K -bufsize 64K output.avi要强制输出⽂件为24 fps的帧速率:ffmpeg -i input.avi -r 24 output.avi要强制输⼊⽂件的帧频(仅对原始格式有效),以1 FPS读⼊⽂件,以每秒24帧的帧速率输出:ffmpeg -r 1 -i input.m2v -r 24 output.aviformat 选项可能需要指定,对于原始输⼊⽂件。

ffmpeg go语言示例-概述说明以及解释

ffmpeg go语言示例-概述说明以及解释1.引言1.1 概述概述ffmpeg是一款跨平台的开源多媒体处理工具,能够对音视频文件进行解码、编码、转码等操作。

它支持多种格式的音视频文件,包括常见的MP4、AVI、FLV等,也能够处理各种编码方式,如H.264、AAC等。

ffmpeg 以其高效稳定的性能和丰富的功能,成为了许多多媒体应用开发中的重要工具。

而go语言作为一种现代化的编程语言,具有简洁明了的语法和高效的性能。

它的并发模型和垃圾回收机制等特性,使得开发者能够轻松地编写出高性能的应用程序。

go语言在网络编程、分布式系统、云计算等领域有着广泛的应用,被许多开发者称赞为一门非常实用的语言。

本文将探讨ffmpeg与go语言的结合,介绍如何使用go语言调用ffmpeg的API,实现对音视频文件的处理。

通过这种结合,我们能够充分发挥ffmpeg和go语言的优势,提供高效稳定的音视频处理功能,并且能够利用go语言的并发特性,实现高性能的多媒体应用。

接下来的章节将分别介绍ffmpeg和go语言的基本概念和特点,然后详细说明如何使用go语言调用ffmpeg的API进行音视频处理。

同时,我们还将探讨ffmpeg与go语言结合的一些实际应用场景,并对未来的发展进行展望。

通过阅读本文,读者将了解到ffmpeg和go语言的基本原理和特点,了解如何使用go语言调用ffmpeg的API进行音视频处理,以及掌握一些实际应用场景。

通过这些内容的学习,读者可以更好地理解ffmpeg和go语言的优势,并能够应用到自己的项目中,提高开发效率和应用性能。

希望本文能够对读者有所启发,为大家在多媒体应用开发和go语言学习中提供一定的帮助。

在接下来的章节中,我们将深入探讨ffmpeg与go语言的结合,带领读者一起进入多媒体应用开发的世界。

在文章结构部分,将会对整篇文章的组织方式进行介绍。

首先,本文将分为引言、正文和结论三个主要部分。

引言部分(Section 1)将主要进行一些基础的概述,包括对文章的总体介绍(1.1 概述)、文章的组织架构(1.2 文章结构)以及文章写作的目的(1.3 目的)。

《FFmpegBasics》中文版-18-隔行视频

《FFmpegBasics》中文版-18-隔行视频写在前面如果您对音视频技术感兴趣,可以订阅我的专题:音视频专辑也可以关注我的简书账户:张芳涛,我后期会发布更多的音视频以及图像处理方面的文章。

正文隔行扫描是在单色模拟电视开发过程中发明的技术,可以消除旧CRT显示器的闪烁。

视频帧被水平划分为规则线,然后划分为2个场,其中第一个场包含奇数行,第二个场包含偶数行。

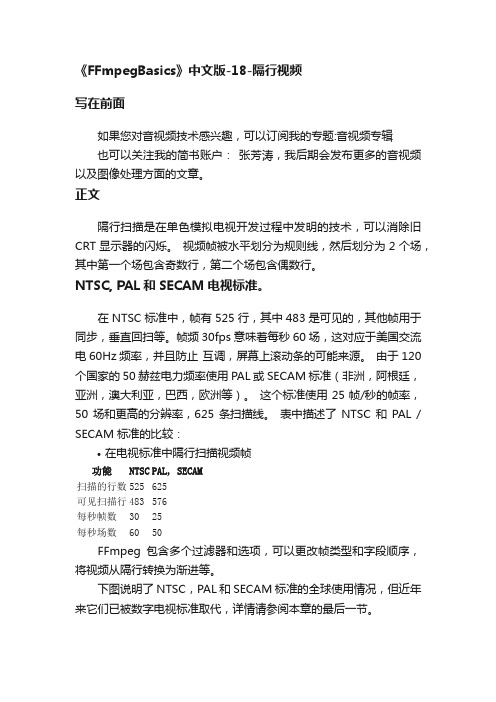

NTSC, PAL和SECAM电视标准。

在NTSC标准中,帧有525行,其中483是可见的,其他帧用于同步,垂直回扫等。

帧频30fps意味着每秒60场,这对应于美国交流电60Hz频率,并且防止互调,屏幕上滚动条的可能来源。

由于120个国家的50赫兹电力频率使用PAL或SECAM标准(非洲,阿根廷,亚洲,澳大利亚,巴西,欧洲等)。

这个标准使用25帧/秒的帧率,50场和更高的分辨率,625条扫描线。

表中描述了NTSC和PAL / SECAM标准的比较:•在电视标准中隔行扫描视频帧功能NTSC PAL, SECAM扫描的行数525 625可见扫描行483 576每秒帧数30 25每秒场数60 50FFmpeg包含多个过滤器和选项,可以更改帧类型和字段顺序,将视频从隔行转换为渐进等。

下图说明了NTSC,PAL和SECAM标准的全球使用情况,但近年来它们已被数字电视标准取代,详情请参阅本章的最后一节。

隔行帧类型设置当使用本章描述的fieldorder和yadif过滤器时,在使用多个过滤器进行复杂转码时,使用setfield过滤器设置输出帧的字段类型可能很有用:描述在输出帧中标记隔行场的类型,帧的内容不变,只更新其属性。

对于下一个使用fieldorder和yadif等过滤器进行处理的过滤链非常有用。

语法setfield=type类型的数值auto 不要标记任何东西,默认值bff 帧首先是底部的场tff 帧首先是顶部的场prog 帧是渐进的例如,要首先将字段类型设置为顶部字段,我们可以使用以下命令:ffmpeg -i input.vob -vf setfield=tff output.mov我的测试命令:ffmpeg -i /Users/zhangfangtao/Desktop/test.mp4 -vf setfield=tff /Users/zhangfangtao/Desktop/test2.mp4•看不出来有啥不一样。

FFMPEG开发指南

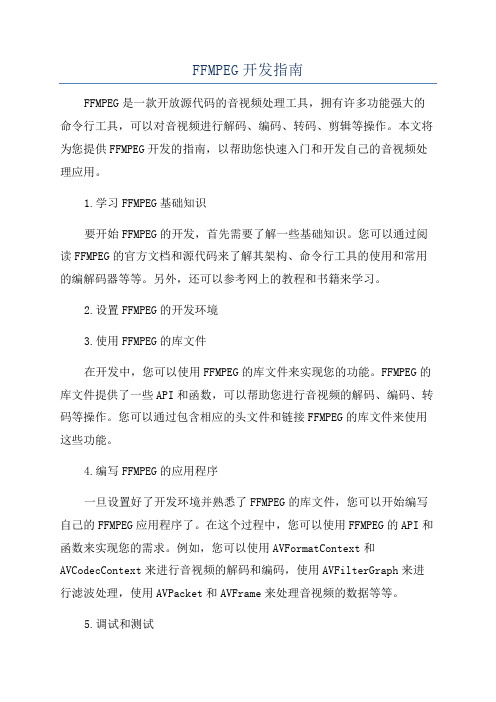

FFMPEG开发指南FFMPEG是一款开放源代码的音视频处理工具,拥有许多功能强大的命令行工具,可以对音视频进行解码、编码、转码、剪辑等操作。

本文将为您提供FFMPEG开发的指南,以帮助您快速入门和开发自己的音视频处理应用。

1.学习FFMPEG基础知识要开始FFMPEG的开发,首先需要了解一些基础知识。

您可以通过阅读FFMPEG的官方文档和源代码来了解其架构、命令行工具的使用和常用的编解码器等等。

另外,还可以参考网上的教程和书籍来学习。

2.设置FFMPEG的开发环境3.使用FFMPEG的库文件在开发中,您可以使用FFMPEG的库文件来实现您的功能。

FFMPEG的库文件提供了一些API和函数,可以帮助您进行音视频的解码、编码、转码等操作。

您可以通过包含相应的头文件和链接FFMPEG的库文件来使用这些功能。

4.编写FFMPEG的应用程序一旦设置好了开发环境并熟悉了FFMPEG的库文件,您可以开始编写自己的FFMPEG应用程序了。

在这个过程中,您可以使用FFMPEG的API和函数来实现您的需求。

例如,您可以使用AVFormatContext和AVCodecContext来进行音视频的解码和编码,使用AVFilterGraph来进行滤波处理,使用AVPacket和AVFrame来处理音视频的数据等等。

5.调试和测试在开发过程中,您可能会遇到一些问题和bug。

将FFMPEG库集成到您的应用程序中可能会带来一些困难。

因此,及时调试和测试是非常重要的。

您可以使用断点和调试工具来跟踪代码的执行,并使用各种测试数据来验证您的应用程序的正确性。

6.优化和性能调整当您的应用程序基本完成后,您可能还需要进行一些优化和性能调整。

FFMPEG的处理过程可能消耗较多的计算资源,因此应该尽可能地优化您的代码和算法,以提高性能和效率。

7.文档和交流在开发过程中,您可能会遇到一些问题和困惑。

在这种情况下,您可以参考FFMPEG的官方文档和论坛,以获取帮助和解决问题。

ffmpeg函数手册

ffmpeg函数手册ffmpeg是一款功能强大的多媒体处理工具,它提供了许多函数用于处理音频、视频、字幕、水印等多媒体数据。

在本手册中,我们将介绍一些常用的ffmpeg函数,帮助您更好地使用ffmpeg进行多媒体处理。

一、输入和输出文件1.ffmpeg命令行工具:ffmpeg是命令行工具,可以通过命令行输入和输出文件。

常用的命令格式为:ffmpeg[选项]-i输入文件-i输出文件[过滤器]...[输出选项]2.输入文件格式:ffmpeg支持多种输入文件格式,如AVI、MP4、MKV、TS 等。

在命令中,您需要指定输入文件的路径和文件名。

3.输出文件格式:输出文件的格式可以是AVI、MP4、MKV、TS等。

在命令中,您需要指定输出文件的路径和文件名,并使用输出选项设置输出格式。

二、常用函数1.音频处理函数a.audio_input():用于读取音频输入流。

b.audio_output():用于将音频数据输出到目标设备。

c.audio_filter():用于对音频数据进行过滤和处理。

d.audio_output_options():用于设置音频输出选项,如采样率、比特率等。

2.视频处理函数a.video_input():用于读取视频输入流。

b.video_output():用于将视频数据输出到目标设备。

c.video_filter():用于对视频数据进行过滤和处理。

d.video_display():用于显示视频帧。

e.video_output_options():用于设置视频输出选项,如分辨率、比特率等。

3.文件操作函数a.file_open():用于打开文件。

b.file_close():用于关闭文件。

c.file_read():用于读取文件内容。

d.file_write():用于写入文件内容。

e.file_seek():用于设置文件指针的位置。

f.file_tell():用于获取当前文件指针的位置。

FFmpeg教程(超级详细版)

FFmpeg教程(超级详细版)一、参考资料FFmpeg命令(一)、使用filter_complex命令拼接视频FFmpeg 视频处理入门教程FFmpeg命令行转码ffmpeg 翻译文档 (ffmpeg-all 包含重要组件)FFmpeg—源码编译FFmpeg常用命令Linux上的ffmpeg完全使用指南视频和视频帧:FFMPEG 硬件解码API介绍二、安装ffmpeg、ffmpy安装ffmpeg# 更新源sudo apt update# 添加源sudo add-apt-repository ppa:kirillshkrogalev/ffmpeg-next# 安装ffmpegsudo apt-get install ffmpeg# 查看版本ffmpeg -version# 查看编码器和解码器ffmpeg -encoders安装ffmpypip install ffmpy==0.2.2 # 需要权限就添加sudo三、关键指令1.查看FFmpeg支持的编码器ffmpeg configure -encoders2.查看FFmpeg支持的解码器ffmpeg configure -decoders3.查看FFmpeg支持的通信协议ffmpeg configure -protocols4.查看FFmpeg所支持的音视频编码格式、文件封装格式与流媒体传输协议ffmpeg configure --help5.播放视频6.FFmpeg命令行工具学习(二):播放媒体文件的工具ffplay7.ffplay input.mp48.9.# 播放完自动退出ffplay -autoexit input.mp410.设置视频的屏幕高宽比ffmpeg -i input.mp4 -aspect 16:9 output.mp4通常使用的宽高比是:16:94:316:105:42:21:12:35:12:39:111.编码格式转换MPEG4编码转成H264编码ffmpeg -i input.mp4 -strict -2 -vcodec h264 output.mp4H264编码转成MPEG4编码ffmpeg -i input.mp4 -strict -2 -vcodec mpeg4 output.mp4四、视频压缩ffmpeg -i 2020.mp4 -vcodec h264 -vf scale=640:-2 -threads 4 2020_conv.mp4ffmpeg -i 1579251906.mp4 -strict -2 -vcodec h264 1579251906_output.mp4参数解释:-i 2020.mp4输入文件,源文件2020_conv.mp4输出文件,目标文件-vf scale=640:-2改变视频分辨率,缩放到640px宽,高度的-2是考虑到libx264要求高度是偶数,所以设置成-2,让软件自动计算得出一个接近等比例的偶数高-threads 44核运算其他参数:-s 1280x720设置输出文件的分辨率,w*h。

ffmpeg中文参数详细说明

ffmpeg中⽂参数详细说明FFMPEG 3.4.1 版本参数详细说明⽤法:ffmpeg [options] [[infile options] -i infile] … {[outfile options] outfile} …FFMPEG获得帮助:-h - 打印基本选项-h long - 打印更多选项-h full - 打印所有选项(包括所有格式和编解码器特定选项,⾮常长)-h type = name - 打印指定解码器/编码器/解复⽤器/ muxer / filter的所有选项有关选项的详细说明,请参见man ffmpeg。

打印帮助/信息/功能:-L显⽰许可证-h主题显⽰帮助- ?主题显⽰帮助-help主题显⽰帮助--help主题显⽰帮助-version显⽰版本-buildconf显⽰构建配置-formats显⽰可⽤格式-muxers显⽰可⽤的复⽤器-demuxers显⽰可⽤的解复⽤器-devices显⽰可⽤的设备-codecs显⽰可⽤的编解码器-decoders显⽰可⽤的解码器-encoders显⽰可⽤的编码器-bsfs显⽰可⽤的位流过滤器- 协议显⽰可⽤的协议-filters显⽰可⽤的过滤器-pix_fmts显⽰可⽤的像素格式-layouts显⽰标准通道布局-sample_fmts显⽰可⽤的⾳频样本格式-colors显⽰可⽤的颜⾊名称-sources设备列出输⼊设备的源-sinks设备列表输出设备的接收器-hwaccels显⽰可⽤的硬件加速⽅法全局选项(影响整个程序⽽不仅仅是⼀个⽂件:-loglevel loglevel设置⽇志记录级别-v loglevel设置⽇志记录级别-report⽣成报告-max_alloc bytes设置单个已分配块的最⼤⼤⼩-y覆盖输出⽂件-n永远不会覆盖输出⽂件-ignore_unknown忽略未知的流类型-filter_threads⾮复杂过滤器线程的数量-filter_complex_threads -filter_complex的线程数-stats在编码期间打印进度报告-max_error_rate错误率(0.0:⽆错误,1.0:100%错误最⼤错误率-bits_per_raw_sample number设置每个原始样本的位数-vol⾳量改变⾳量(256 =正常)每个⽂件的主要选项:-f fmt force格式-c编解码器编解码器名称-codec编解码器编解码器名称- pre preset 预设预设名称-map_metadata outfile [,metadata]:infile [,metadata]设置来⾃infile的outfile的元数据信息-t持续时间记录或转码⾳频/视频的“持续时间”秒-to time_stop记录或转码停⽌时间-fs limit_size设置限制⽂件⼤⼩(以字节为单位)-ss time_off设置开始时间偏移量-sseof time_off设置相对于EOF的开始时间偏移量-seek_timestamp使⽤-ss启⽤/禁⽤时间戳搜索-timestamp time设置录制时间戳('now'设置当前时间)-metadata string = string add metadata-program title = string:st = number ...⽤指定的流添加程序-target type指定⽬标⽂件类型(“vcd”,“svcd”,“dvd”,“dv”或“dv50”,带有可选前缀“pal-”,“ntsc-”或“film-”)-apad⾳频垫-frames number设置要输出的帧数-filter filter_graph set stream filtergraph-filter_script filename从⽂件中读取流过滤器描述-reinit_filter对输⼊参数更改重新启动filtergraph-discard 丢弃-disposition 配置FFMPEG视频选项:-vframes number设置要输出的视频帧数-r速率设置帧速率(Hz值,分数或缩写)-s size设置框架⼤⼩(WxH或缩写)- ⽅⾯设定宽⾼⽐(4:3,16:9或1.3333,1.77777)-bits_per_raw_sample number设置每个原始样本的位数-vn禁⽤视频-vcodec编解码器强制视频编解码器('复制'复制流)-timecode hh:mm:ss [:;。

ffmpeg中文文档

指导1:制作屏幕录像源代码:tutorial01.c概要电影文件有很多基本的组成部分。

首先,文件本身被称为容器Container,容器的类型决定了信息被存放在文件中的位置。

A VI和Quicktime就是容器的例子。

接着,你有一组流,例如,你经常有的是一个音频流和一个视频流。

(一个流只是一种想像出来的词语,用来表示一连串的通过时间来串连的数据元素)。

在流中的数据元素被称为帧Frame。

每个流是由不同的编码器来编码生成的。

编解码器描述了实际的数据是如何被编码Coded和解码DECoded 的,因此它的名字叫做CODEC。

Divx和MP3就是编解码器的例子。

接着从流中被读出来的叫做包Packets。

包是一段数据,它包含了一段可以被解码成方便我们最后在应用程序中操作的原始帧的数据。

根据我们的目的,每个包包含了完整的帧或者对于音频来说是许多格式的完整帧。

基本上来说,处理视频和音频流是很容易的:10 从video.avi文件中打开视频流video_stream20 从视频流中读取包到帧中30 如果这个帧还不完整,跳到2040 对这个帧进行一些操作50 跳回到20在这个程序中使用ffmpeg来处理多种媒体是相当容易的,虽然很多程序可能在对帧进行操作的时候非常的复杂。

因此在这篇指导中,我们将打开一个文件,读取里面的视频流,而且我们对帧的操作将是把这个帧写到一个PPM文件中。

打开文件首先,来看一下我们如何打开一个文件。

通过ffmpeg,你必需先初始化这个库。

(注意在某些系统中必需用<ffmpeg/avcodec.h>和<ffmpeg/avformat.h>来替换)#include <avcodec.h>#include <avformat.h>...int main(int argc, charg *argv[]) {av_register_all();这里注册了所有的文件格式和编解码器的库,所以它们将被自动的使用在被打开的合适格式的文件上。

ffmpeg fontprovider coretext

ffmpeg fontprovider coretext(中英文实用版)Title: Integrating FFmpeg and FontProvider with CoreTextSubject: Enhancing Media Processing and Font Management in ApplicationsIntroduction:FFmpeg, a powerful multimedia framework, is often used for audio and video processing tasks.On the other hand, FontProvider is a component designed for efficient font handling in applications.By combining FFmpeg with FontProvider and CoreText, developers can create robust media processing applications with enhanced font management capabilities.英文:FFmpeg是一个强大的多媒体框架,常用于音频和视频处理任务。

另一方面,FontProvider是一个用于高效字体处理的组件。

通过将FFmpeg与FontProvider和CoreText结合使用,开发者可以创建具有增强字体管理能力的强大媒体处理应用程序。

中文:FFmpeg是一个功能强大的多媒体框架,常用于音频和视频处理任务。

另一方面,FontProvider是一个用于高效字体处理的组件。

通过将FFmpeg与FontProvider和CoreText结合使用,开发者可以创建具有增强字体管理能力的强大媒体处理应用程序。

Explanation:When it comes to processing media files, FFmpeg provides a comprehensive set of tools and libraries.By integrating FFmpeg into an application, developers gain access to a wide range of functionalities such as video encoding, decoding, filtering, and more.This allows developers to create powerful media processing applications that can handle various tasks with ease.解释:当涉及到处理媒体文件时,FFmpeg提供了全面的工具和库。

ffmpeg超详细综合教程

ffmpeg超详细综合教程本⽂的⽰例将实现:读取安卓⼿机摄像头数据并使⽤H.264编码格式实时编码保存为flv⽂件。

⽰例包含了1、编译适⽤于安卓平台的ffmpeg库2、在java中通过JNI使⽤ffmpeg3、读取安卓摄像头数据并在后台线程中使⽤ffmpeg进⾏编码的基本流程具有较强的综合性。

编译适⽤于安卓平台的ffmpeg库平时我们编译ffmpeg类库都是在x86平台下,⽽安卓⼿机属于arm平台,所以要先通过交叉编译的⽅法在x86平台下编译出可以在arm平台下使⽤的 ffmpeg类库。

Google就为我们提供了⼀套可以再Linux下完成该任务的r10e,在cygwin下使⽤。

ndk的下载安装基本是傻⽠式的,但要注意linux系统对x86和x64是分的很清楚的,不像windows那么随性,此外还需要提醒的是,在下载安装cygwin时,只需要选择binutils, gcc , gcc-mingw , gdb , make这⼏个组件。

安装完成后,在cygwin安装⽬录下点击cygwin.bat打开命令窗⼝,输⼊make -version验证是否安装成功。

做好以上的准备⼯作之后就可以正式开始ffmpeg源码的编译了。

⾸先需要修改configure⽂件,确保类库版本号不会出现在.so后缀名的后⾯,否则安卓平台⽆法识别这样的类库找到下⾯⼏句[plain]view plaincopy1. SLIBNAME_WITH_MAJOR='$(SLIBNAME).$(LIBMAJOR)'2. LIB_INSTALL_EXTRA_CMD='$$(RANLIB)"$(LIBDIR)/$(LIBNAME)"'3. SLIB_INSTALL_NAME='$(SLIBNAME_WITH_VERSION)'4. SLIB_INSTALL_LINKS='$(SLIBNAME_WITH_MAJOR)$(SLIBNAME)'修改为[plain]view plaincopy1. SLIBNAME_WITH_MAJOR='$(SLIBPREF)$(FULLNAME)-$(LIBMAJOR)$(SLIBSUF)'2. LIB_INSTALL_EXTRA_CMD='$$(RANLIB)"$(LIBDIR)/$(LIBNAME)"'3. SLIB_INSTALL_NAME='$(SLIBNAME_WITH_MAJOR)'4. SLIB_INSTALL_LINKS='$(SLIBNAME)'之后进⾏常规的configure配置,make, make install步骤即可,下⾯给出⼀个常规的脚本⽰例[plain]view plaincopy1. make clean2.3. export NDK=xxxx/android-ndk-r10e4. export PREBUILT=$NDK/toolchains/arm-linux-androideabi-4.8/prebuilt5. export PLATFORM=$NDK/platforms/android-8/arch-arm6. export PREFIX=../android_ffmpeglib7.8. ./configure --target-os=linux --prefix=$PREFIX \9. --enable-cross-compile \10. --enable-runtime-cpudetect \11. --disable-asm \12. --arch=arm \13. --cc=$PREBUILT/windows/bin/arm-linux-androideabi-gcc \14. --cross-prefix=$PREBUILT/windows/bin/arm-linux-androideabi- \15. --disable-stripping \16. --nm=$PREBUILT/windows/bin/arm-linux-androideabi-nm \17. --sysroot=$PLATFORM \18. --enable-gpl --enable-shared --disable-static --enable-small \19. --disable-ffprobe --disable-ffplay --disable-ffmpeg --disable-ffserver --disable-debug \20. --extra-cflags="-fPIC -DANDROID -D__thumb__ -mthumb -Wfatal-errors -Wno-deprecated -mfloat-abi=softfp -marm -march=armv7-a"21.22. make23. make install成功编译后,可以看到如下类库在java中通过JNI使⽤ffmpegJNI 即java本地接⼝,java native interface,它是⼀个协议, 该协议⽤来沟通Java代码和外部的本地C/C++代码, 通过该协议 Java代码可以调⽤外部的本地代码, 外部的C/C++ 代码可以调⽤Java代码。

FFmpeg从入门到精通

4.1 FFmpeg软编 码H.264与H.265

4.2 FFmpeg硬编 解码

4.3 FFmpeg输出 MP3

4.4 FFmpeg输出 AAC

4.5 系统资源使用 情况

4.6 小结

4 FFmpeg转码

4.1 FFmpeg软编码 H.264与H.265

4.1.1 x264编码参数简介

4.1.2 H.264编码举例

9 FFmpeg接口 libavcodec的使用

9.2 FFmpeg新接口的使用

9.2.1 FFmpeg新接口音频编码 9.2.2 FFmpeg新接口音频解码 9.2.3 FFmpeg新接口视频编码 9.2.4 FFmpeg新接口视频解码

10 FFmpeg接口libavfilter的使用

10.1 filtergraph 和filter简述

1.3 FFmpeg的基本组成

1.5 FFmpeg的播放器 ffplay

1.2 FFmpeg的历史

1.4 FFmpeg的编解码工 具ffmpeg

1.6 FFmpeg的多媒体分 析器ffprobe

1 FFmpeg简介

1.7 FFmpeg编

译

1.8 FFmpeg 编码支持与定

制

1.9 小结

1 FFmpeg简 介

5 FFmpeg流媒体

5.6 FFmpeg生成HDS流

5.6.1 HDS参数说明 5.6.2 HDS使用举例

5 FFmpeg流媒体

5.7 FFmpeg生成DASH流

5.7.1 DASH参数说明 5.7.2 DASH参数使用举例

6 FFmpeg滤镜使用

6.1 FFmpeg滤镜Filter描述 格式

6.3 FFmpeg生成画中画

ffmpeg命令中文用法详解

ffmpeg命令中文用法详解FFmpeg是一款开源的音视频处理工具,凭借其强大的功能和广泛的应用领域而备受欢迎。

本文将对FFmpeg命令的中文用法进行详细解析,帮助读者更好地理解和应用该工具。

首先,FFmpeg可以通过命令行进行操作,其中最基本的命令包括输入、输出、编解码、滤镜等参数。

输入参数用于指定源文件,可以是视频、音频或者图像;输出参数用于指定目标文件,可以是各种音视频格式;编解码参数用于指定使用的编码器和解码器;滤镜参数用于对音视频进行处理和修改。

在使用FFmpeg时,我们可以根据需求选择合适的命令组合。

例如,若要将一个视频文件转换为另一种格式,可以使用以下命令:ffmpeg -i input.mp4 output.avi其中,"-i"表示输入参数,后面跟着源文件的路径和文件名;"output.avi"表示输出参数,指定了转换后的文件格式和文件名。

这样,FFmpeg会读取input.mp4文件,并将其转换为output.avi文件。

除了基本的格式转换,FFmpeg还支持一系列强大的功能。

例如,我们可以将视频按照时间段进行剪辑,可以使用以下命令:ffmpeg -i input.mp4 -ss 00:01:30 -t 00:00:30 output.mp4其中,"-ss"表示起始时间,"00:01:30"表示从视频的1分30秒处开始剪辑;"-t"表示持续时间,"00:00:30"表示剪辑后的视频长度为30秒;"output.mp4"为输出文件名。

通过这样的命令,我们可以只保留指定时间段内的视频内容。

另外,FFmpeg还支持音视频的混流和分离功能。

如果我们想将视频和音频合并成一个文件,可以使用以下命令:ffmpeg -i video.mp4 -i audio.mp3 -c:v copy -c:a copy output.mp4其中,"-i"分别表示输入的视频文件和音频文件;"-c:v copy"表示视频流的编码方式保持不变,"-c:a copy"表示音频流的编码方式保持不变;"output.mp4"为输出文件名。

《FFmpegBasics》中文版-13-数学函数

《FFmpegBasics》中文版-13-数学函数写在前面如果您对音视频技术感兴趣,可以订阅我的专题:音视频专辑也可以关注我的简书账户:张芳涛,我后期会发布更多的音视频以及图像处理方面的文章。

正文FFmpeg工具提供的一个巨大优势是内置的数学函数,可以对某些音频和视频过滤器、选项和源进行各种修改。

可以使用数学函数的表达式许多FFmpeg选项都需要数值作为参数,其中一些可以是表达式形式,可以包含算术运算符、常量和各种数学函数。

函数通常用于音频和视频过滤器和源,下一个表包含它们的列表,包括在哪里找到它们的描述。

FFmpeg中的算术表达式的评估提供了一个内部公式评估器,通过位于文件libavutil/eval.h中的接口实现。

这个评估人员也接受国际系统编号前缀(在FFmpeg文档中被称为后缀,因为它们是在数字之后立即输入的)。

如果我是在前缀后面加上,使用的是2的幂而不是10的幂。

B(字节)前缀将值乘以8,并且可以在另一个前缀后附加或单独使用。

这意味着,例如B, KB, MiB可以像前缀一样使用。

可用的SI数字前缀的列表在FFmpeg基础上。

C代码中的开发人员可以扩展一元函数和二进制函数的列表,并定义额外的常量,这些常量将在描述的表达式中可用。

名称类型具体描述的章节aevalsrc 音频源数字音频章节asettb 音频过滤器高级技术章节aspect option 词汇表章节astreamsync 音频过滤器数字音频章节boxblur 视频过滤器模糊,锐化和其他去噪章节名称类型具体描述的章节crop 视频过滤器裁剪视频章节drawtext 视频过滤器为视频添加文字章节hue 视频过滤器颜色修正章节lut, lutrgb, lutyuv 视频过滤器颜色修正章节overlay 视频过滤器overlay-画中画章节rc_eq option 格式之间转换章节pad 视频过滤器填充视频章节scale 视频过滤器调整和伸缩视频章节select 视频过滤器高级技术章节setdar, setsar 视频过滤器高级技术章节setpts 视频过滤器时间操作章节settb 视频过滤器高级技术章节volume 音频过滤器数字音频章节内置算术运算符FFmpeg工具的用户可以使用常用的单目和双目算术运算符,如下表所述。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

// Retrieve stream information if(av_find_stream_info(pFormatCtx)<0)

return -1; // Couldn't find stream information

这个函数为 pFormatCtx->streams 填充上正确的信息。我们引进一个手工调试的 函数来看一下里面有什么:

} if(videoStream==-1)

return -1; // Didn't find a video stream

// Get a pointer to the codec context for the video stream pCodecCtx=pFormatCtx->streams[videoStream]->codec;

fprintf(stderr, "Unsupported codec!\n"); return -1; // Codec not found } // Open codec if(avcodec_open(pCodecCtx, pCodec)<0) return -1; // Could not open codec

// Is this a packet from the video stream? if(packet.stream_index==videoStreபைடு நூலகம்m) {

唯一的问题是它的文档基本上是没有的。有一个单独的指导讲了它的基本原理另 外还有一个使用 doxygen 生成的文档。这就是为什么当我决定研究 FFMPEG 来弄 清楚音视频应用程序是如何工作的过程中,我决定把这个过程用文档的形式记录 并且发布出来作为初学指导的原因。

在 FFMPEG 工程中有一个示例的程序叫作 ffplay。它是一个用 C 编写的利用 ffmpeg 来实现完整视频播放的简单播放器。这个指导将从原来 Martin Bohme 写 的一个更新版本的指导开始(我借鉴了一些),基于 Fabrice Bellard 的 ffplay, 我将从那里开发一个可以使用的视频播放器。在每一个指导中,我将介 绍一个 或者两个新的思想并且讲解我们如何来实现它。每一个指导都会有一个 C 源文 件,你可以下载,编译并沿着这条思路来自己做。源文件将向你展示一个真正 的 程序是如何运行,我们如何来调用所有的部件,也将告诉你在这个指导中技术实 现的细节并不重要。当我们结束这个指导的时候,我 们将有一个少于 1000 行代 码的可以工作的视频播放器。

这里注册了所有的文件格式和编解码器的库,所以它们将被自 动的使用在被打 开的合适格式的文件上。注意你只需要调用 av_register_all()一次,因此我们 在主函数 main()中来调用它。如果你喜欢, 也可以只注册特定的格式和编解码 器,但是通常你没有必要这样做。

现在我们可以真正的打开文件:

打开文件

首先,来看一下我们如何打开一个文件。通过 ffmpeg,你必需先初始化这个库。 (注意在某些系统中必需 用<ffmpeg/avcodec.h>和<ffmpeg/avformat.h>来替 换)

#include <avcodec.h> #include <avformat.h> ... int main(int argc, charg *argv[]) { av_register_all();

基本上来说,处理视频和音频流是很容易的:

10 从 video.avi 文件中打开视频流 video_stream 20 从视频流中读取包到帧中 30 如果这个帧还不完整,跳到 20 40 对这个帧进行一些操作 50 跳回到 20

在这个程序中使用 ffmpeg 来处理多种媒体是相当容易的,虽然很多程序 可能在 对帧进行操作的时候非常的复杂。因此在这篇指导中,我们将打开一个文件,读 取里面的视频流,而且我们对帧的操作将是把这个帧写到一个 PPM 文件中。

在写播放器的过程中,我们将使用 SDL 来输出音频和视频。SDL 是一个优秀的跨 平台的多媒体库,被用在 MPEG 播放、模拟器和很多视频游戏中。你将需要下载 并安装 SDL 开发库到你的系统中,以便于编译这个指导中的程序。

这篇指导适用于具有相当编程背景的人。至少至少应该懂得 C 并且有队列和互斥 量等概念。你应当了解基本的多媒体中的像波形一类的概念,但是你不必知道的 太 多,因为我将在这篇指导中介绍很多这样的概念。

// Allocate an AVFrame structure pFrameRGB=avcodec_alloc_frame(); if(pFrameRGB==NULL)

return -1;

即使我们申请了一帧的内存,当转换的时候,我们仍然需要一个地方来放置原始

的数据。我们使用 avpicture_get_size 来获得我们需要的大小, 然后手工申请 内存空间:

更新:我修正了在指导 7 和 8 中的一些代码错误,也添加-lavutil 参数。欢迎 给我发邮件到 dranger@,讨论关于程序问题、疑问、注释、思路、 特 性等任何的问题

源代码:tutorial01.c

指 导 1:制作屏幕录像

概要

电影文件有很多基本的组成部分。首先,文件本身被称为容 器 Container,容 器的类型决定了信息被存放在文件中的位置。AVI 和 Quicktime 就是容器的例 子。接着,你有一组流, 例如,你经常有的是一个音频流和一个视频流。(一 个流只是一种想像出来的词语,用来表示一连 串的通过时间来串连的数据元 素)。在流中的数据元素被称为帧 Frame。 每个流是由不同的编码器来编码生 成的。编解码器描述了实际的数据是如何被编码 Coded 和解码 DECoded 的,因此 它的名字叫做 CODEC。Divx 和 MP3 就是编解码器的例子。接着从流中被读出来 的叫做包 Packets。包是一段数据,它包含了一段可以被解码成方便我们最后在 应用程序中操作的原始帧的数据。根据我们的目的,每个包包含 了完整的帧或 者对于音频来说是许多格式的完整帧。

pCodecCtx->width, pCodecCtx->height);

最后,我们已经准备好来从流中读取数据了。

读取数据

我们将要做的是通过读取包来读取整个视频流,然后把它解码成帧,最好后转换 格式并且保存。

int frameFinished; AVPacket packet;

i=0; while(av_read_frame(pFormatCtx, &packet)>=0) {

uint8_t *buffer; int numBytes; // Determine required buffer size and allocate buffer numBytes=avpicture_get_size(PIX_FMT_RGB24, pCodecCtx->width,

pCodecCtx->height); buffer=(uint8_t *)av_malloc(numBytes*sizeof(uint8_t));

int i; AVCodecContext *pCodecCtx;

// Find the first video stream videoStream=-1; for(i=0; i<pFormatCtx->nb_streams; i++)

if(pFormatCtx->streams->codec->codec_type==CODEC_TYPE_VIDEO) { videoStream=i; break;

如何用 FFmpeg 编写一个简单播放器详 细步骤介绍(转载)

FFmpeg, 播放器, 编写 FFMPEG 是一个很好的库,可以用来创建视频应用或者生成特定的工具。FFMPEG 几乎为你把所有的繁重工作都做了,比 如解码、编码、复用和解复用。这使得 多媒体应用程序变得容易编写。它是一个简单的,用 C 编写的,快速的并且能够 解码 几乎所有你能用到的格式,当然也包括编码多种格式。

AVFormatContext *pFormatCtx;

// Open video file if(av_open_input_file(&pFormatCtx, argv[1], NULL, 0, NULL)!=0)

return -1; // Couldn't open file

我们通过第一个参数来获得文件名。这个函数读取文件的头部并且把信息保存到 我们给的 AVFormatContext 结构体中。最后三个参数用来指定特殊的 文件格式, 缓冲大小和格式参数,但如果把它们设置为空 NULL 或者 0,libavformat 将自动 检测这些参数。

// Dump information about file onto standard error dump_format(pFormatCtx, 0, argv[1], 0);

现在 pFormatCtx->streams 仅仅是一组大小为 pFormatCtx->nb_streams 的指针, 所以让我们先跳过它直到 我们找到一个视频流。

// Assign appropriate parts of buffer to image planes in pFrameRGB // Note that pFrameRGB is an AVFrame, but AVFrame is a superset // of AVPicture avpicture_fill((AVPicture *)pFrameRGB, buffer, PIX_FMT_RGB24,

有些人可能会从旧的指导中记得有两个关于这些代码其它部分:添加 CODEC_FLAG_TRUNCATED 到 pCodecCtx->flags 和添 加一个 hack 来粗糙的修正帧 率。这两个修正已经不在存在于 ffplay.c 中。因此,我必需假设它们不再必要。 我们移除了那些代码后还有一个需要指出的 不同点:pCodecCtx->time_base 现 在已经保存了帧率的信息。time_base 是一个结构体,它里面有一个分子和分母 (AVRational)。我们使用分数的方式来表示帧率是因为很多编解码器使用非整数 的帧率(例如 NTSC 使用 29.97fps)。