中文停用词

基于NLTK的中文文本内容抽取方法

基于NLTK的中文文本内容抽取方法李晨;刘卫国【摘要】NLTK是Python中用于自然语言处理的第三方模块,但处理中文文本具有一定局限性.利用NLTK对中文文本中的信息内容进行抽取与挖掘,采用同语境词提取、双连词搭配提取、概率统计以及篇章分析等方法,得到一个适用于中文文本的NLTK文本内容抽取框架,及其具体的实现方法.经实证分析表明,在抽取结果中可以找到反映文本特点的语料内容,得到抽取结果与文本主题具有较强相关性的结论.【期刊名称】《计算机系统应用》【年(卷),期】2019(028)001【总页数】4页(P275-278)【关键词】自然语言处理;中文文本;自然语言处理工具包【作者】李晨;刘卫国【作者单位】中南大学信息科学与工程学院,长沙410083;中南大学信息科学与工程学院,长沙410083【正文语种】中文NLTK的默认处理对象是英文文本,处理中文文本存在一定的局限性,主要体现在以下两点:(1) NLTK素材语料库中缺少中文语料库,在NLTK模块中包含数十种完整的语料库,例如布朗语料库、古腾堡语料库等,但没有中文语料库. 另外, NLTK也没有中文停用词语料库,在文本预处理中,特别是在进行频率统计之前需要使用停用词语料库对文本进行过滤清洗, NLTK没有提供针对中文的停用词库,使用针对英文的过滤方法是无法完成中文文本的停词过滤.(2)在英文文本中,文本的分割可以由单词之间的空格完成,但是中文文本的分割依靠NLTK是无法完成的,中文分词工作需要借助分词工具来完成,已有的一些中文分词工具有结巴分词(jieba)、斯坦福中文分词器等.本文应用NLTK对中文文本进行信息抽取.1 NLTK文本内容抽取框架使用NLTK对自然语言文本中词句内容进行提取与分析,可以概括为筛选、提取、统计、解释的过程[1,2]. 抽取方法首先对其中无实际含义的词汇进行筛选过滤,使用概率统计方法提取出高频词集,接着识别出文本的关键词,选定研究词汇.以该词汇作为目标词,查找其所在的句子,对段落、篇章内的词汇进行计数统计与篇章分析,解释文本内容与研究问题. 为此将以上过程简化为三个阶段,分别是预处理、分析以及输出阶段,如图1所示.图1 NLTK抽取框架1.1 预处理阶段预处理阶段是确定文本并对文本进行简单处理的过程,预处理方法主要有分块与分词、清洗过滤. 分块与分词是对文本进行切分的操作,由于分析阶段各方法调用对象的不同,文本需要划分成不同子单位的文本,例如以词为最小单位的文本、以句为最小单位的文本. 清洗过滤是对文本分词处理后删去文本中无实际意义的词汇符号的过程.1.2 分析阶段分析阶段是抽取过程的核心,涉及到文本的一系列处理操作. 文本经预处理阶段以词、句、篇章为基本单位进行切分后,在这三个维度上使用不同的分析方法. 经分词处理后,针对单个词汇进行的操作有双连词提取、同语境词提取. 在单个句子上可执行的操作有词性标注、句法分析. 在篇章中可以进行篇章分析[3]与统计分析,其中统计分析是最常使用的工具. 例如,在对布朗语料库[4]的研究中,以概率统计的方法得到不同文体中情态动词的频率分布,归纳总结出情态动词在文体中的分布规律,从而对文本的文体进行判断.1.3 输出阶段文本的抽取结果分为两大类,一类是将提取出词与句子等结果作为原始依据,对文本内容含义进行解释;第二类是以可视化的形式展示数据结果,更加直观地体现词汇频率的对比.2 NLTK对文本的处理方法2.1 预处理方法2.1.1 对原始文本分词与分句在NLTK中,分词分句操作可以将文本处理成可以单独调用的词或句子. 分词是将句子序列或字符串构成的文本划分成单个的词. 分句是将文本中的篇章段落划分成单个的句子. 使用nltk.word_tokenize()、nltk.sent_tokenize()进行分词与分句操作. 分词处理后文本中的词汇、符号转化为单一标识符,这是进行后续分析工作的关键.2.1.2 对原始文本进行清洗过滤清洗与过滤实际上是一个分类的过程,使用正则表达式匹配需要过滤掉的数字与符号,对文档中的纯文本内容进行提取. 然后,利用停用词语料库对文本实现过滤,停用词语料库中包含无实际意义的高频词汇,例如 a, to 等.以下的命令定义了一个过滤英文停用词的函数,将文本中的词汇归一化处理为小写并提取,从停用词语料库中提取出英语停用词,使用词汇运算符将文本进行区分.2.2 分析方法2.2.1 同语境词查找NLTK中使用函数similar()查找与目标词汇出现在相似上下文位置的词,即在文本中可用作替换的词汇.在《白鲸记》中使用text.similar("captain")找到以下同语境词: whale ship sea boat deck world other. 可以发现得到的词汇与目标词汇词性均为名词.2.2.2 统计分析概率统计作为最常用的数学分析手段,用于文本中数据的处理分析. 在Python中借助NLTK频率分布类中的函数,对文本中出现的单词、搭配、常用表达、符号进行频率统计、长度计算等相关操作,使用fdist= nltk.FreqDist()对研究文本创建频率分布,函数fdist['target word']查找频率分布内目标词汇的出现次数,fdist. most_common(n)从频率分布中提取出高频词汇,其中参数n为提取词汇的数量.2.2.3 篇章分析对篇章内容的分析也是使用NLTK对文本内容进行抽取的方法之一. 布朗语料库以文体作为分类标准.根据这一特点,利用布朗语料库探索词汇在不同文体中的使用情况. 使用条件概率的方法,选择布朗语料库中6个不同的文体类型分别统计wh-词的使用情况. 命令如下:命令执行后,以表格的形式打印所得结果如图2所示.图2 频率统计结果从结果上来看,在religion与news文体中which和who出现次数较多,hobbies文体中when、which、who出现较多,而在science_fiction与humor文体中wh-词出现的次数较为均匀,在romance文体中what、when、which出现次数较多. 使用条件概率的方法找到文体中同类型词使用差异,以表格的形式展示结果[5].抽取过程中叠加使用分析方法,将获得的结果作为分析的原始素材进行二次加工处理.2.3 输出方法利用Python的第三方图表模块对数据进行二次处理. Matplotlib是Python中用于可视化处理的模块,该模块对结构化数据绘制统计图表,例如柱状图、扇形图、折线图、直方图等图形[6]. 导入Matploylib库,并引入上一阶段获得的数据. 函数fdist.plot(n, cumulative=True/False)在建立概率分布的基础上对统计结果绘制频率折线图,其中参数n表示折线图展示的词汇数, cumulative表示是否对统计结果逐词累加. 经函数text.dispersion_plot()处理后获得离散图,横坐标为文本词汇排序,纵坐标为研究词汇,词汇对应的每一行代表整个文本,一行中的一条竖线表示一个单词,以竖线的排列表示词汇在文本中的位置.3 实证分析以2018年政府工作报告为案例素材进行分析. 在网络上通过爬虫工具得到2018年政府工作报告,总字数为20 257. 根据本文提出的方法步骤,使用NLTK对文本内容进行抽取.3.1 方法描述对目标素材所在网页进行内容提取. 使用Scrapy获取网页上的报告内容, Scrapy 是用于获取网页内容的Python第三方模块,多用于爬取网页上的图片以及结构化的文本内容. 将爬取得到的文本内容保存在txt文件中,过滤文本中的标点符号、数字与停用词等.以目标词汇为中心进行二次分析,使用到同语境词查找,双连词查找等方法. 使用概率统计对高频出现的词汇进行查找输出,最后以折线图、离散图等可视化的形式展示结果. 实例分析流程如图3所示.在预处理阶段,使用正则表达式清理爬取内容中的符号、数字以及英文字母,保留中文文本. join(re.findall(r'[\u4e00-\u9fa5]', raw_text)). 采用 Jieba 中文分词工具对中文文本分词jieba.lcut().分析阶段查找“民生” 所在的句子以及查找与“发展” 位于相同位置的词汇:3.2 结果展示应用matplotlib对结果进行可视化,输出离散图展示不同高频词在文本中的位置: text.dispersion_plot(['经济','企业','工作','社会'])输出离散图展示“经济”,“企业”,“工作”,“社会” 四个词在文本中的位置,结果如图4所示.对去除停用词后的文本,进行频率统计. 将前20个高频词以折线图的形式输出,结果如图5所示.在中文文本的分析中,出现可视化结果无法显示中文的问题,对此解决的方法是增加部分代码,指定默认中文字体. 命令如下.图3 实例验证流程图图4 展示不同词在文本中的位置图5 前20个高频词折线图3.3 分析与启示从概率统计的结果中,发现提取出的词汇具有两个特征: 集中在名词与形容词;词汇含义与文本主题相关. 从离散图 (图 4)来看,“经济” 一词的在全文中不同位置均有出现,且在前一部分相对集中分布;“社会”一词在报告的全文中均匀分布,可以看出关注社会、关注经济体现在整篇工作报告当中. 对比“改革”与“社会”,可以发现“改革”的出现频度超过“社会”,也印证了图5的频率统计结果. 在高频折线图中(图5)排在前两位的词是“发展” 以及“改革”,这与“进一步深化改革”保持一致;在前十个高频词中“经济”作为出现次数最多的名词,也说明了经济的重要性. 在报告抽取结果中找到了反映政府工作报告的语料内容,达到了理解语料库的目的.4 结束语由于中英文文本有不同的分词方法,使得NLTK在中文文本处理上存在不足,中文文本不能通过简单的字符分隔来达到语义分隔的目的,需要由分词工具来完成,并且可能存在歧义.本文加入爬虫工具与NLTK协同作用,对爬虫得到的文本使用分词工具、正则表达式完成对中文文本中词汇与句子等内容的预处理工作,并在NLTK中完成对中文文本的统计与分析,抽取出与主题相关的文本内容,实现NLTK对中文文本上的处理,达到对中文文本信息抽取的目的.参考文献【相关文献】1 化柏林,张新民. 从知识抽取相关概念辨析看知识抽取的特点和发展趋势. 情报科学, 2010,28(2): 311-315.2 丁玉飞,王曰芬,刘卫江. 面向半结构化文本的知识抽取研究. 情报理论与实践, 2015, 38(3): 101-106.3 李保利,陈玉忠,俞士汶. 信息抽取研究综述. 计算机工程与应用, 2003, (10): 1-5, 66. [doi: 10.3321/j.issn:1002-8331.2003.10.001]4 Bird S, Klein E, Loper E. Natural Language Processing with Python. California:O’Reilly Media, 2009. 42-44.5 邓擎琼,彭炜明,尹乾,等. Python 教学中实用型词频统计案例展示. 计算机教育, 2017,(12): 20-27. [doi: 10.3969/j.issn.1672-5913.2017.12.005]6 张莉,金莹,张洁. 基于 MOOC 的“用 Python 玩转数据” 翻转课堂实践与研究. 工业和信息化教育, 2017, (3): 70-76.[doi: 10.3969/j.issn.2095-5065.2017.03.015]。

MySQL中的中文分词和全文索引的实现技巧

MySQL中的中文分词和全文索引的实现技巧MySQL是一款广泛使用的关系型数据库管理系统,它提供了丰富的功能和优秀的性能。

然而,在处理中文文本数据方面,MySQL的默认配置并不能很好地支持中文分词和全文索引。

本文将介绍在MySQL中实现中文分词和全文索引的技巧,并探讨如何优化中文文本数据的检索效果。

一、中文分词技术的选择中文分词是将连续的汉字序列切分成一个一个独立的词语的过程。

在MySQL中进行中文分词,我们有多种技术可供选择。

这里我将介绍两种常见的中文分词技术:基于词典的分词和基于统计模型的分词。

1. 基于词典的分词基于词典的分词是最常见的中文分词技术。

它通过使用一个包含大量中文词语的词典,将输入的文本按照词典中的词语进行切分。

MySQL中可以使用开源的中文分词工具如IKAnalyzer、SmartCN等来实现基于词典的分词。

这些工具提供了丰富的功能,可以支持自定义词典和停用词等功能。

2. 基于统计模型的分词基于统计模型的分词是一种基于概率统计的分词技术。

它通过训练一个统计模型,学习词语的出现概率,并根据概率值判断是否在该位置切分词语。

常见的基于统计模型的中文分词工具有Jieba、HanLP等。

这些工具可以通过对大量文本进行训练,提供更准确的分词结果。

通过选择适合的中文分词技术,我们可以将中文文本切分成一个个独立的词语,为后续的全文索引提供准备。

二、全文索引的实现技巧全文索引是指对文本类型的数据建立索引,以提供快速高效的文本搜索功能。

在MySQL中,我们可以通过以下技巧实现全文索引。

1. 使用MyISAM引擎MySQL提供了多种存储引擎,包括MyISAM和InnoDB等。

在实现全文索引时,推荐使用MyISAM引擎。

因为MyISAM引擎在全文索引方面有着更好的性能和功能支持。

2. 创建全文索引在MySQL中,我们可以使用FULLTEXT索引类型来创建全文索引。

FULLTEXT索引可以对表中的一个或多个列进行索引,并支持使用全文搜索函数进行高效的文本搜索。

基于文本挖掘的影评数据情感分析以《我和我的祖国》为例

基于文本挖掘的影评数据情感分析以《我和我的祖国》为例一、内容简述随着互联网的普及和社交媒体的发展,大量的文本数据涌现出来,其中包括了各种类型的评论、观点和情感表达。

这些文本数据为自然语言处理(NLP)领域的研究者提供了丰富的信息来源,也为情感分析等任务提供了有力的支持。

本文以《我和我的祖国》这部影片为例,探讨了基于文本挖掘的影评数据情感分析方法。

首先本文对影片的相关信息进行了收集和整理,包括导演、演员、上映时间、票房等基本信息,以及豆瓣评分、影评数量等评价指标。

通过对这些信息的分析,可以了解影片的基本情况和观众对其的评价。

接下来本文采用了多种文本挖掘技术,如词频统计、共现矩阵构建、主题模型等,对影片的影评数据进行了深入挖掘。

通过这些方法,可以发现影片中的情感倾向、关键词语和主题结构等信息。

本文根据情感分析的结果,对影片的情感倾向进行了解读。

同时针对影片的特点和观众的需求,提出了一些建议,以期为电影产业的发展提供参考。

1. 背景介绍:电影《我和我的祖国》在XXXX年X月上映,成为中国影史上最卖座的电影之一背景介绍:电影《我和我的祖国》在2019年9月25日上映,成为中国影史上最卖座的电影之一。

这部电影由7位导演联合执导,讲述了新中国成立70周年的历史故事,通过七个不同的故事篇章展现了中国人民在国家发展和进步中的奋斗与拼搏。

影片以真实事件为基础,情感真挚深入人心,受到了广泛的关注和好评。

在这部电影中,情感分析是一个重要的研究方向。

通过对影评数据的挖掘和分析,可以了解观众对这部电影的情感态度,为电影的传播和推广提供有力支持。

本文将以《我和我的祖国》为例探讨基于文本挖掘的影评数据情感分析方法及其在电影评论中的应用。

2. 目的和意义:通过对《我和我的祖国》的文本数据进行情感分析,探讨电影的情感表达方式以及观众对电影的情感反应随着互联网的普及和社交媒体的发展,大量的文本数据被产生和传播。

这些文本数据中蕴含着丰富的信息,如情感、观点、态度等。

中文检索

方法:对43例中晚期肝癌患者进行超声引导下微波治疗。结果:所有病例治疗后 肿块缩小,其中3例完全消失;12例肿块缩小,无强化;23例活检提示大片坏死。结 论:超声引导微波治疗中晚期肝癌有较好的疗效。

通配符

?:代表一个字符 %:代表多个字符 “ ”:强制检索

字段限定

限定检索:选择性进行以下限定: 年限、文献类型(如综述)、是否核心刊、是否带摘要、 特征词 字段限定: 1.高级检索-选择字段 2.快速检索:关键词[字段名称],如:王建荣[第一作者], 智力低下[关键词]

逻辑运算符

AND,OR,NOT ( ) > NOT > AND > OR

副主题词的选择

• 通常要考虑主题词之间的语义关系 • 在语义关系难以确定,或副主题词表中不存在与语义关系对应的

副主题词时,可选择“全部副主题词” • 正确的选择副主题词可提高查准率

检索结果的处理

检索结果的显示:题录格式、文摘格式、全部格式 检索结果的保存:保存格式与结果显示的格式相对应 检索结果的分析:按照作者、出版时间、作者单位、来 源期刊、主题词和文献类型,对检索结果进行分类统计。 统计结果显示了该主题的主要作者、主要研究单位、主 要期刊等。

-解放军医学图书馆开发

CMCC (Chinese Medical Current Contents)

收录1994年以来1400余种中文生物医学期刊 光盘载体,半月更新

CMAC

(China Medical Academic Conference)

最全中文停用词

最全中文停用词累累要漏风声好些认识覆这些毕生己见明确盎司大声黄梁美梦责无旁贷叙家常勇往直前无功负荷大张旗鼓夜间踉踉跄跄似笑非笑庚申端端正正你追我赶不尽雪中送炭她们默默暖乎乎算总账这里圆圆的敌强我弱小到中雪一路顺风小到中雨爱理不理厚厚两边倒喷香视觅规耍笔杆当庭见其间觏觎故地重游结党营私遵纪爱民窗口不禁不由黄登登拉伸形变觉览本该角如意算盘有法可依不少绞尽脑汁以防万一减头去尾大大破罐子破摔两头下层暖烘烘这么麻酥酥觫大多借东风如下如上临场白费口舌觳相互当年不对真情实感顷刻上层心浮气动耿耿不忘云开日出夏季沉闷闷不可或缺各谋其政正色辰龙褛见钱眼开癸巳短短的凉溲溲褓潮涨潮落可见一斑难说话乘势这个下狠心是个儿长此以往背风处那种突地益发茸茸凹凸不平边防黝黑不为所动息息相关金碧辉煌襄劳不矜功嗷嗷间接不定自觉自愿奖罚分明近代之后好久脸皮厚揭老底山南海北应用千年措置失当西边陲千古不变先後彻夜再就是别无二致本质棚外袒有时候辣蒿蒿闰日暮春开洋荤茵茵紧紧告一段落感激不尽这部袋此事相信轻声如今汗津津袷一丝不苟冷眉冷眼摒弃前嫌戴帽子最少亮底牌凝神专注袼前端放虎归山袢平方尺原初千磨百折活该原则被土里土气这样一来此书抠抠搜搜袭追根究底裕切不可内城百年骄阳似火裟春意盎然青白相依声情并茂几经周折由浅入深无话可说清清楚楚坐喷气式外面虎虎生风正儿八经裳此人近乎傲然本国瞎子摸象迢迢关键裣白费力气裢多灾多难东头满处准保预先本园天天蠛只限某种无冤无仇和平共处蠖立体梦想成真模模糊糊尽其所有等等蠃全面正中鸡皮疙瘩冰冷甜津津蠼关外正东一团乱麻聚精会神顺势接连不断本地相似土洋并举冰凉左上战略区场次由小到大颈内随身四脚八叉慌慌张张行不稳平衡藏龙卧虎高迢险峻积劳成疾风马牛不相及侃大山夜深人静跌宕起伏内在趁势切莫尽心尽力此举如云城外尸骨未寒光年大起大落嘀嗒错综家里乘兴表衩翻旧账此中一失足成千古恨讥计元年随即簇新让面黄肌瘦心中有鬼五彩斑斓讵不然的话记讳讼讽许头头目下论黑溜溜提心吊胆红扑扑一对当道吃小灶扑簌簌别具风味丁寅黯然神伤练习拖后腿嗡嗡足下本埠渺无音信悲欢离合壬戌询有理有据该诤碧莹莹圆满语一定诬没法儿直统统稀溜溜误大梦初醒求真务实无论是白露诱倘若差不多诲青春年少诵诶诸抓大放小沦落异乡诺课诿惯常脉脉证一家讷讷好像诊时有发生诉独力嗬哟诌大后年粤北译诚傻傻忽忽诙温湿黄蜡蜡诜世世代代大清白日是因为节后量力而行癸寅拿主意如何不由得老少咸宜走内线謦束手无策永久性春夏秋冬最近空无所有长此下去救命稻草犹如多少义务弥足珍贵胖嘟嘟纵使挺身而出少见多怪间日村口多管齐下丁子凉冰冰之前水漉漉白嫩开拓进取高速别无选择不如粘粘渍渍狼狈为奸警春去秋来半辈子力尽筋疲过分岂有此理狠命好象拿三搬四居心不良看得过儿极为走村串户越加独具慧眼原先邋里邋遢确定不妨此路不通平等茫茫耍排场悠哉游哉民心所向小题大做特意确实豺狼虎豹足以人影憧憧杀鸡吓猴踯躅街头大寒决计翻老账大家伙儿越发越来越纵令誓死大江南北眼皮浅拉下马有生以来重度合不拢嘴黑沉沉代代相传起首崭新非僧非俗说实话说不过去群蚁附膻将要逶迤蓝森森借鸡生蛋极了誉卑鄙无耻暗沉沉难以不得已而为之楞怔怔己丑龙凤呈祥下头人心惶惶内部依稀可见失之空洞随之而来没大没小明摆着节前之内九泉之下齐步走后边各部五彩纷呈某省实际痛痛快快不外气概不凡缓缓秦汉不够边区暖暖地蓬蓬勃勃振兴图强潦倒终身不大坦坦荡荡历历左侧第二产业沉寂叽叽喳喳随后它们霎那间看走眼肩上开足马力五毒俱全上头平空其四暖暖和和以假乱真有意思訇言固然缕缕一门心思搭班子合理合法拉帮结伙比照习习明知故犯釜底抽薪片时大宗己亥您是恍然哓哓不休深耕细作吃喝嫖赌随口论说除外一不小心三夏厚实实达到简直乡乡大家须臾之间未始万古长青没心肝西风东渐跏跎一帆顺风频频耍贫嘴跄忆苦思甜跃滚圆跞原因跟距想必各路背靠背由始至终引以为憾托人情路跫野外昏迷不醒外地跹何须践口里本刊很少跳趋越天顺活鲜鲜别有情趣古代趁超趄不会儿右边袅袅绕绕外国趟失去软塌塌趑甲亥鳞鳞九五尽欢而散外围前者趸高利处处迎面乡下假戏真做察微知晓每种足乘风扬帆艰难曲折简便易行沿岸资钉子户赅一头妥妥当当特异引以为戒身处牢笼一天赞势利小人阿嚏挂零由于良师益友难说克子赙赤从今以后壬寅赡加油添醋稳稳当当挂羊头卖狗肉精光赫起赛前平素赶圆乎乎赳嗖嗖不择手段含金量独具特色可不表明秦昌情同手足紫不溜丢死死地该署扭亏为盈庄稼活儿本剧何乐不为娇滴滴举凡乙亥天启中叶中古贡责环环相扣生机蓬勃餐风宿雪白天购贰至此凄凄惨惨贵贴嗣后贷白晃晃甲丑贸贻贺贼早早儿贿无穷强横霸道亲眼目睹氧炔吹管夏夜除非颤巍巍中午吉星高照租期况且夏天党外除却近前随之转年前线飞速忤逆不孝前街后巷这儿用以至情至性逗逗乐乐进入貅决不小规模大汗淋漓除去一块儿红白喜事有来有往妇道人家癸子中南平起平坐过去缤纷下定决心乖乖正中要害全国乙丑辈子渐渐无端灰扑扑口中迅速酌情十年磨一剑义不容辞自此下回用于豉汛期群芳争艳嗨哟完美无缺静寂寂一树了之小时候日入而息为什么稳如泰山厉声不失时宜迫于绘声绘色豢三国上回不复存在比不上密密丛丛郁郁葱葱再则谓谒及其后院起火谕谔重大鲜艳夺目谗平米卢布谁敢于里头临到谋一语双关即将连锁谏甜蜜蜜谷乒乓毫瓦谴接著十有八九恩将仇报闹意气唱白脸真真切切谦本区里外谥谪株连九族谨迅即吃败仗心烦意躁诚心诚意不好意思组成部分勃然亮铮铮迫末后辛寅迭远非远古清洌洌奋勇迤外头拂晓西边述连轴重操旧业乌乎稀拉拉说到底迈间或方能路边欣欣然气吞山河一刀两断过岸然迄分兵把口进举止矜持还这连好好儿近笑话百出最好手到擒拿竭诚去冬通通辩扩军备战辨得意忘形己辰十二月这边上贼船今儿个只身争分夺秒辽壬巳甚佳近郊边本县狱中通存通兑辰辱最大辍拖拖拉拉十五日奋力连同辈辆数九辅辄悄然无声鱼死网破较怎么待会儿辟内陆西北麓辚昂首挺胸横行霸道逐一起先勤工助学一忽儿二话没说无大无小辑细细的之一车连连轧其后之上转严加轮轰轳轲辛子轴成龙配套此时此刻不啻以资鼓励趁便火树银花不夜天轻载甚至北方轾别无出路迟迟从从容容忽而置之度外暗暗之下空间点阵走钢丝拐弯抹角嫩生生坎坷不平黑古隆冬远远几许进去一块这项据说存在一言不语抽冷子之中个别赛后说胡话金黄安全暑期一股脑儿轻而易举而是说笑话灰糊糊本身显然冉冉走门串户反倒毛毛茸茸来世说不来循声基本上认为温暖如春东区左边老是恭恭敬敬臭熏熏轻度简洁明了反之牛年马月名声大振必不可少生死与共先头阵子灰碌碌久久顶多它们的东南西郊为国分忧使不得往常碧波万顷好事多磨同一天年终西部随大流敢为人先躬身老早永生永世那么些完全起初恬然粉嫩躞硬性枕头风形成自由放任积极躏往年令人鼓舞隆冬躅共同躇有始有终立等可取蹰公顷高兴多多壮年随便财迷心窍黧黑马年惴惴良多怒冲冲万众一心五倍子虫映入眼帘平方公里蹙重修旧好打吊针安居而乐教整个蹈甚么采取凛若冰霜子夜活泼泼别见怪大笑不止丙午古里古怪三番五次本轮踬为何惶惶摸摸索索一目了然慎重迷惑不解踞喝倒彩强强联合宫中发高烧明码杀出重围夜半更深彻底大后天通过琼枝玉叶煞费心机东北良好饶有兴趣脚十月不变胡乱克朗获益匪浅加班加点来历不明眼中不只冬季大天白日脉脍脂末年不可开交哑然想当初脸怅然就算堆积如山历史性整体各位为主蓦地分贝毫秒稍顷敌后一招一式眼下脬满腔热情尖里尖气贾宪三角不慌不乱半日高度开门红羞于启齿逞威风腔亮堂堂午时腐腌此情此景超标准节节胜利蓝晶晶腾开怀良性宁可趁热打铁供过于求此言重新上古凝重胸怀祖国腩今是昨非蔫搭搭下去高挑儿腠本年黑忽忽半数老弱残兵牛年大礼拜老奸巨猾乱乱腾腾脸皮嫩目不斜视同一严令禁止家喻户晓渺无踪迹衷心有眉目轰隆来回辛丑欢声笑语初三急起直追看眼色得了穷光光瓮声瓮气根据生存斗争初七哈尼族膺初一登时走回头路狂风恶浪比索南麓卷帙浩繁辛酉村头真切强词夺理与否简言之双喜临门不管怎样群雄逐鹿初九喳喳南征北战令人寒心气鼓鼓问题公报私仇缺斤短两除了气哼哼泄私愤各人致不可标记原子随时随地漫天至气绝身亡旧雨重逢名震中外十四行诗有所臾歪门邪道本市新桃换旧符鸡犬升天臻为了痴痴价值千金奋翅展翼欣欣向荣臭列伊引起上周不同自大书特书上午上升城内惑人耳目而本当还要耀马失前蹄老下半时者唯有数以亿计查无实据棚内蛮不讲理耘元月正要蜿蜒正西更是寸土寸金万历高高摆臭架子硕果累累继之耥一个样八成光是耸险些千斤双重一则通过耳忽然求之不得走过上上下下耶耵要死不活聍遥遥聊急人所急聆随大溜火光烛天戊申从此以后可歌可泣不力各个甚至于充其极一去不返联悄悄地南水北调破瓦寒窑消极怠工冷天实抗雪救灾悄悄险乎各业许久串亲戚偶而一向截然百感丛生下基层极端初具规模摆威风一同假大空两侧滋阴壮阳未必好在聱取道肃哗然一怒之下再度肆上去限制碰巧肓定准肖灰不溜秋绿森森非法秋日有形损耗不单体无完肤股前茅刑事临了少不得肪肩肭育寄兴寓情悉心三班倒大清早自卖自夸强行哑然无声梨花大鼓胁隐隐约约连袂先机快手快脚不是味儿家中胎疏忽大意自力更生癸未难上难吱吱悠悠胜胝酣然路上誉满全球转动悄无声息胧有名有实硬是公担流落江湖思新求变胡文中果真满山遍野胬强买强卖下苦功右侧下午先期胱笑容满面紧巴巴当啷能心服口服舒舒服服负荆请罪满怀深情夷为平地一半省区缺斤又短两扫黄打非双向茺英亩我省分之价廉物美各具特色个中处暑个个。

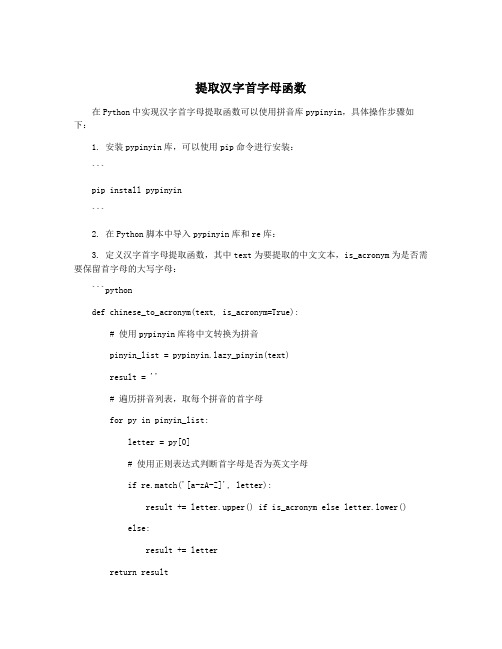

提取汉字首字母函数

提取汉字首字母函数在Python中实现汉字首字母提取函数可以使用拼音库pypinyin,具体操作步骤如下:1. 安装pypinyin库,可以使用pip命令进行安装:```pip install pypinyin```2. 在Python脚本中导入pypinyin库和re库:3. 定义汉字首字母提取函数,其中text为要提取的中文文本,is_acronym为是否需要保留首字母的大写字母:```pythondef chinese_to_acronym(text, is_acronym=True):# 使用pypinyin库将中文转换为拼音pinyin_list = zy_pinyin(text)result = ''# 遍历拼音列表,取每个拼音的首字母for py in pinyin_list:letter = py[0]# 使用正则表达式判断首字母是否为英文字母if re.match('[a-zA-Z]', letter):result += letter.upper() if is_acronym else letter.lower()else:result += letterreturn result```4. 调用汉字首字母提取函数,可以把中文字符串作为参数传递给该函数,得到其首字母字串:```pythontext = '中文处理是一项有趣且需要思考的任务'acronym = chinese_to_acronym(text)print(acronym) # 输出结果为 ZWCLSYXYST```这样就可以实现从中文文本中提取首字母的功能。

函数还可以接收可选参数is_acronym来控制是否需要保留首字母的大写形式。

如果is_acronym为True,则转换后的首字母大写;如果为False,则全部转换为小写字母。

汉字首字母提取在中文信息处理中非常常见,包括中文输入法、联系人姓名排序、音乐流派分类等等。

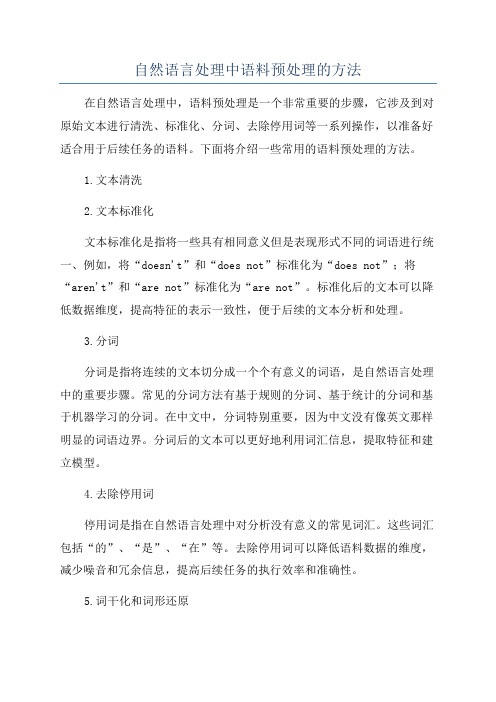

自然语言处理中语料预处理的方法

自然语言处理中语料预处理的方法在自然语言处理中,语料预处理是一个非常重要的步骤,它涉及到对原始文本进行清洗、标准化、分词、去除停用词等一系列操作,以准备好适合用于后续任务的语料。

下面将介绍一些常用的语料预处理的方法。

1.文本清洗2.文本标准化文本标准化是指将一些具有相同意义但是表现形式不同的词语进行统一、例如,将“doesn't”和“does not”标准化为“does not”;将“aren't”和“are not”标准化为“are not”。

标准化后的文本可以降低数据维度,提高特征的表示一致性,便于后续的文本分析和处理。

3.分词分词是指将连续的文本切分成一个个有意义的词语,是自然语言处理中的重要步骤。

常见的分词方法有基于规则的分词、基于统计的分词和基于机器学习的分词。

在中文中,分词特别重要,因为中文没有像英文那样明显的词语边界。

分词后的文本可以更好地利用词汇信息,提取特征和建立模型。

4.去除停用词停用词是指在自然语言处理中对分析没有意义的常见词汇。

这些词汇包括“的”、“是”、“在”等。

去除停用词可以降低语料数据的维度,减少噪音和冗余信息,提高后续任务的执行效率和准确性。

5.词干化和词形还原词干化和词形还原是将词语从不同的形态还原为其原始的词干形式,以减少词语的多样性。

词干化是将词语剩下的部分去除,只保留其词干部分;而词形还原是根据词性和上下文等信息恢复词语的原始形态。

例如,将“running”和“ran”都还原为“run”。

这样可以提高词语的一致性和表示的准确性,有助于后续的特征提取和模型建立。

6.词向量化词向量化是将文本中的词语表示为向量的操作,可以更好地利用词语之间的关联和语义信息。

常用的词向量化方法有One-hot表示、词袋模型和Word2Vec等。

词向量化后的文本可以作为特征输入到机器学习模型中,有助于提高模型的表现能力和效果。

7.数据增强数据增强是指利用各种方法扩大语料库的规模和多样性。

如何处理机器学习中的文本数据?

如何处理机器学习中的文本数据?在机器学习领域,文本数据一直是一个非常有挑战性的领域。

然而,随着机器学习技术的不断发展,处理文本数据的方法也变得更加多样化和有效。

本文将为您介绍如何更有效地处理机器学习中的文本数据。

一、文本数据的预处理在对文本数据进行处理前,预处理是至关重要的一步。

文本预处理包括以下几个方面:1. 去除停用词停用词是指文本中出现频率很高,但意义不强的单词,如“和、那、的”等。

去除停用词可以减少噪声,提高模型训练的效率。

2. 文本分词中文文本存在着大量的难于处理的词汇,因此在机器学习中处理中文文本时,文本分词是必不可少的。

分词可以将一句话拆成一个个有意义的单元,这些单元将成为机器学习模型的特征。

3. 统一编码格式不同的编码格式可能导致文本数据的丢失或扭曲。

对于中文数据,最好使用 UTF-8 编码格式,以保证数据的完整性和准确性。

二、文本数据特征提取文本特征提取是指将文本数据转化为可以用于机器学习的特征向量。

常见的文本数据特征提取方法有:1. 词袋模型词袋模型是指将每个文本看作一个以所有单词为特征的向量,每个单词的特征是它在文本中出现的频率。

然而,这种方法无法准确地反映语义信息,因为所有的单词都被平等地看待。

2. TF-IDF 模型TF-IDF 是指将每个单词作为特征,并按照其出现的频率和文本中的重要性进行加权。

这种方法通常比词袋模型更有效,但也不够完美。

3. Word2Vec 模型Word2Vec 是一种基于神经网络的模型,可以将每个单词表示为一个 N 维的向量。

这种方法完美地反映了单词之间的语义关系。

三、文本数据建模在完成了特征提取之后,我们需要将其应用于机器学习模型中,以使模型能够学习文本数据之间的关系。

1. 朴素贝叶斯模型朴素贝叶斯模型是一种基于概率的分类模型。

它假设各个特征之间相互独立,并通过特征的先验概率来预测测试数据的分类。

2. 支持向量机模型支持向量机模型是一种优秀的分类模型,可以解决高维数据的分类问题。

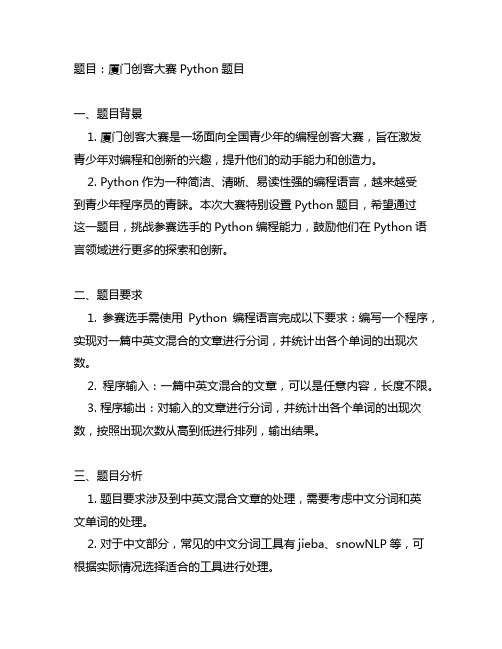

厦门创客大赛python题目

题目:厦门创客大赛Python题目一、题目背景1. 厦门创客大赛是一场面向全国青少年的编程创客大赛,旨在激发青少年对编程和创新的兴趣,提升他们的动手能力和创造力。

2. Python作为一种简洁、清晰、易读性强的编程语言,越来越受到青少年程序员的青睐。

本次大赛特别设置Python题目,希望通过这一题目,挑战参赛选手的Python编程能力,鼓励他们在Python语言领域进行更多的探索和创新。

二、题目要求1. 参赛选手需使用Python编程语言完成以下要求:编写一个程序,实现对一篇中英文混合的文章进行分词,并统计出各个单词的出现次数。

2. 程序输入:一篇中英文混合的文章,可以是任意内容,长度不限。

3. 程序输出:对输入的文章进行分词,并统计出各个单词的出现次数,按照出现次数从高到低进行排列,输出结果。

三、题目分析1. 题目要求涉及到中英文混合文章的处理,需要考虑中文分词和英文单词的处理。

2. 对于中文部分,常见的中文分词工具有jieba、snowNLP等,可根据实际情况选择适合的工具进行处理。

3. 对于英文部分,需要注意单词的大小写、词干变化等问题,需使用合适的方法进行处理。

4. 统计出各个单词的出现次数并按照出现次数进行排序,需要使用字典等数据结构进行统计和排序操作。

四、题目实现1. 在开始编写程序之前,可以先进行需求分析和算法设计,明确程序的输入输出、核心逻辑和实现步骤。

2. 在编写程序过程中,可以结合Python的相关库和工具,如jieba 分词库、collections模块的Counter类等,来简化程序的编写和提高运行效率。

3. 编写完程序后,可以进行测试和调试,确保程序可以正确、稳定地处理不同类型的中英文混合文章,并正确统计出各个单词的出现次数并按照出现次数进行排序。

五、题目拓展1. 针对本次题目,可以考虑添加以下拓展要求:(1)实现对文章中停用词的过滤;(2)将程序封装成一个函数或类,以便于其他程序调用;(3)对程序进行性能优化,提高程序处理大规模文章的效率。

LSTM实现中文文本情感分析

LSTM实现中⽂⽂本情感分析1. 背景介绍LSTM(Long Short-Term Memory)是长短期记忆⽹络,在⾃然语⾔处理的领域有着较好的效果。

因此本⽂使⽤LSTM⽹络来帮助进⾏⽂本情感分析。

本⽂将从分词、向量化和模型训练三个⽅⾯对所训练的模型进⾏讲解,本⽂所实现的模型达到了在测试集99%的准确率。

2. 中⽂⽂本分词⾸先需要得到两个⽂档,即积极情感的⽂本和消极情感的⽂本,作为训练⽤到的数据集,积极和消极的各8000条左右。

然后程序在载⼊了这两个⽂本的内容后,需要进⾏⼀部分的预处理,⽽预处理部分中最关键的就是分词。

2.1 分词 or 分字⼀般在中⽂⽂本的分词处理上,最常使⽤的就是jieba分词,因此在⼀开始训练模型的时候,也是使⽤的jieba分词。

但后来感觉效果并不太好,最好的时候准确率也就达到92%,⽽且存在较为严重的过拟合问题(同时测试集准确率达到99%)。

因此去和搞过⼀段时间的⾃然语⾔处理的⼤佬讨论了⼀下,⼤佬给出的建议是直接分字,因为所收集的训练集还是相对来说少了⼀点,分词完会导致训练集缩⼩,再进⾏embedding(数据降维)之后词表更⼩了,就不太⽅便获取⽂本间的内在联系。

因⽽最后分词时⽐较了直接分字和jieba分词的效果,最终相⽐之下还是直接分字的效果会更好⼀些(⼤佬就是⼤佬),所以选⽤了直接分字。

直接分字的思路是将中⽂单字分为⼀个字,英⽂单词分为⼀个字。

这⾥需要考虑到utf-8编码,从⽽正确的对⽂本进⾏分字。

2.2 去停⽤词停⽤词:⼀些在⽂本中相对来说对语义的影响不明显的词,在分词的同时可以将这些停⽤词去掉,使得⽂本分类的效果更好。

但同样的由于采集到的样本⽐较⼩的原因,在进⾏了尝试之后还是没有使⽤去停⽤词。

因为虽然对语义的影响不⼤,但还是存在着⼀些情感在⾥头,这部分信息也有⼀定的意义。

2.3 utf-8编码的格式utf-8的编码格式为:如果该字符占⽤⼀个字节,那么第⼀个位为0。

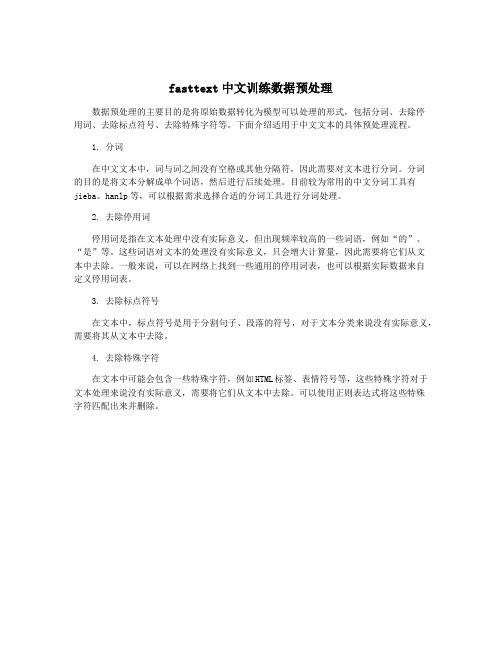

fasttext中文训练数据预处理

fasttext中文训练数据预处理

数据预处理的主要目的是将原始数据转化为模型可以处理的形式,包括分词、去除停

用词、去除标点符号、去除特殊字符等。

下面介绍适用于中文文本的具体预处理流程。

1. 分词

在中文文本中,词与词之间没有空格或其他分隔符,因此需要对文本进行分词。

分词

的目的是将文本分解成单个词语,然后进行后续处理。

目前较为常用的中文分词工具有jieba、hanlp等,可以根据需求选择合适的分词工具进行分词处理。

2. 去除停用词

停用词是指在文本处理中没有实际意义,但出现频率较高的一些词语,例如“的”、“是”等。

这些词语对文本的处理没有实际意义,只会增大计算量,因此需要将它们从文

本中去除。

一般来说,可以在网络上找到一些通用的停用词表,也可以根据实际数据来自

定义停用词表。

3. 去除标点符号

在文本中,标点符号是用于分割句子、段落的符号,对于文本分类来说没有实际意义,需要将其从文本中去除。

4. 去除特殊字符

在文本中可能会包含一些特殊字符,例如HTML标签、表情符号等,这些特殊字符对于文本处理来说没有实际意义,需要将它们从文本中去除。

可以使用正则表达式将这些特殊

字符匹配出来并删除。

数据清洗与整理中的文本处理与分析技巧解读(四)

数据清洗与整理中的文本处理与分析技巧解读数据在当今社会中扮演着重要的角色,然而,原始的数据却常常凌乱不堪,需要经过一系列的清洗和整理工作,才能真正发挥其价值。

其中,文本数据的清洗和处理显得尤为重要,因为文本数据中蕴含着大量的信息和知识,如何高效地进行文本处理和分析技巧成为数据科学家们需要关注和掌握的重要课题。

一、文本清洗技巧在进行文本处理前,首先要进行文本清洗,以去除一些杂乱无章的信息,并提取出有用的内容。

以下是一些常用的文本清洗技巧:1. 去除标点符号和特殊字符:在文本数据中,经常会出现各种标点符号和特殊字符,这些符号对文本分析带来一定的干扰。

因此,可以通过正则表达式或特定的方法去掉这些标点符号和特殊字符。

2. 大小写转换:有时候,文本中包含的字母可能是大写或小写混合的,为了保持一致性,可以将所有字母转换成统一的大小写形式。

3. 去除停用词:停用词是指在文本中频繁出现但没有实际含义的词语,如“的”、“是”等。

在文本处理中,可以通过构建停用词表,并将停用词从文本中去除。

这样做不仅可以提高文本处理的效率,还能使得分析结果更加准确。

二、文本处理技巧清洗完文本数据后,接下来需要进行文本处理,以提取出更有价值的信息,并进行进一步的分析。

以下是一些常用的文本处理技巧:1. 分词:中文文本的分词是指将连续的字序列切分成单个的词语。

分词是中文文本处理的第一步,也是最基本的操作。

常见的中文分词工具有jieba等。

2. 词性标注:词性标注是指为分词结果中的每个词语标注相应的词性。

词性标注可以帮助进一步理解文本的语义和语法结构,从而进行更深入的分析。

3. 命名实体识别:命名实体识别是指识别文本中的人物、地点、机构名等特定的实体。

通过命名实体识别,可以更加精准地定位文本中的重要信息,帮助决策者抽取关键信息。

三、文本分析技巧在清洗和处理完文本数据后,最终目的是进行文本分析,以求得更深入的洞察和有价值的信息。

以下是一些常用的文本分析技巧:1. 文本聚类:文本聚类是将文本数据分成不同的类别或者簇的过程。

中文断词

條斷詞規則

斷詞規則五:一字詞詞頻最高者優先 經由前面四條斷詞規則處後,剩下的 詞組中只有一個一字詞,則優先選取具 有最高一字詞頻的詞組。 斷詞規則:總詞頻最高者優先 此斷詞規則計算每個候選詞組中三個詞的 總詞頻總和,保最高詞頻:定複合詞總最少者優先 此規則需要先收集定詞表,經前三條斷詞規 則處後,此規則則保具有最少的定複合詞 如:「機身重三十噸」經前三條規則處之後, 剩下個候選詞組:「機身/重/三十噸」(定 複合詞為「三十噸」)與「機/身重/三十噸」 (定複合詞為「身重」、「三十噸」),其定 複合詞字分別為三個字以及五個字,根據此 斷詞規則下「機身/重/三十噸」詞組。

未知詞

在這裡的未知詞,指的是沒有收入在系統辭典裡, 但是卻又必須正確切分出的詞,如人名,地 名,組織名,字年份,人名姓名簡稱,複合詞 等等,往往這些未知詞會是後續應用程式,如問 答系統,資訊檢索系統等,關切的重點所在。 社會在變遷,人類語言斷在發展和變化,新詞 會層出窮的出現,同時也因為 詞的衍生現象非 常普遍,沒有必要把所有的衍生詞都收入辭典中, 因此一般皆要求斷詞系統需具有一定的未知詞識 別能力,方可提高斷詞的正確性

斷詞解歧義的方法

結構性的方式(structural approach) 統計性的方式(statistical approach)

結構性斷詞法

結構性斷詞法通常採用一些經驗法則(heuristic rules)作為選詞的標準,常見的經驗法則有「長詞 優於短詞」、「與左邊詞的結合優於與右邊詞的結 合」等。 以「他馬上」為子,因為「馬上」個字比 「馬」一個字長,而「上」雖然可與左邊的「馬」 或右邊的「」結合,但以「與左邊結合優先」, 所以「他馬上」可斷為「他 馬上 」。 「以這名記者會說國語」子,依照上述的經驗法 則斷詞的結果是「這 名 記者會 說 國語」

中文文本分类

中⽂⽂本分类本⽂介绍⽂本挖掘与⽂本分类的⼀些基本概念和流程,为后续学习分类算法做好铺垫。

⼀. ⽂本挖掘的概念 ⽂本挖掘(Text Mining)是从⾮结构化⽂本信息中获取⽤户感兴趣或者有⽤的模式的过程。

其中被普遍认可的⽂本挖掘定义如下:⽂本挖掘是指从⼤量⽂本数据中抽取事先未知的、可理解的、最终可⽤的知识的过程,同时运⽤这些知识更好地组织信息以便将来参考。

简⾔之,⽂本挖掘就是从⾮结构化的⽂本中寻找知识的过程。

⽂本挖掘的七个主要领域: (1)搜索和信息检索(IR):存储和⽂本⽂档的检索,包括搜索引擎和关键字搜索。

(2)⽂本聚类:使⽤聚类⽅法,对词汇,⽚段,段落或⽂件进⾏分组和归类。

(3)⽂本分类:对⽚段,段落或⽂件进⾏分组和归类,使⽤数据挖掘分类⽅法的基础上,经过训练的标记⽰例模型。

(4)Web 挖掘:在互联⽹上进⾏数据和⽂本挖掘,并特别关注在⽹络的规模和相互联系。

(5)信息抽取(IE):从⾮结构化⽂本中识别与提取有关的事实和关系;从⾮结构化和半结构化⽂本制作的结构化数据的过程。

(6)⾃然语⾔处理(NLP):将语⾔作为⼀种有意义、有规则的符号系统,在底层解析和理解语⾔的任务(例如,词性标注);⽬前的技术主要从语法、语义的⾓度发现语⾔最本质的结构和所表达的意义。

(7)概念提取:把单词和短语按语义分组成意义相似的组。

在分析机器学习的数据源中最常见的知识发现主题是把数据对象或事件转换为预定的类别,再根据类别进⾏专门的处理,这是分类系统的基本任务。

⽂本分类也如此:其实就是为⽤户给出的每个⽂档找到所属的正确类别(主题或概念)。

想要实现这个任务,⾸先需要给出⼀组类别,然后根据这些类别收集相应的⽂本集合,构成训练数据集,训练集既包括分好类的⽂本⽂件也包括类别信息。

今天,在互联⽹的背景下⾃动化的⽂本分类被⼴泛的应⽤于,包括⽂本检索,垃圾邮件过滤,⽹页分层⽬录,⾃动⽣成元数据,题材检测,以及许多其他的应⽤领域,是⽂本挖掘最基础也是应⽤最⼴范的核⼼技术。

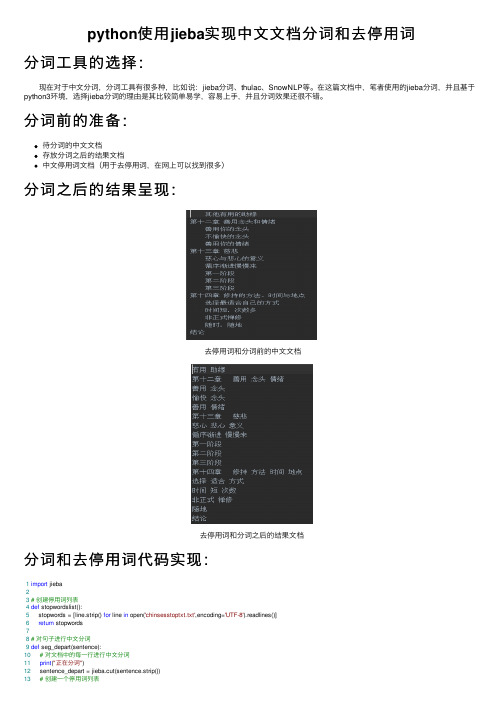

python使用jieba实现中文文档分词和去停用词

python使⽤jieba实现中⽂⽂档分词和去停⽤词分词⼯具的选择: 现在对于中⽂分词,分词⼯具有很多种,⽐如说:jieba分词、thulac、SnowNLP等。

在这篇⽂档中,笔者使⽤的jieba分词,并且基于python3环境,选择jieba分词的理由是其⽐较简单易学,容易上⼿,并且分词效果还很不错。

分词前的准备:待分词的中⽂⽂档存放分词之后的结果⽂档中⽂停⽤词⽂档(⽤于去停⽤词,在⽹上可以找到很多)分词之后的结果呈现:去停⽤词和分词前的中⽂⽂档去停⽤词和分词之后的结果⽂档分词和去停⽤词代码实现:1import jieba23# 创建停⽤词列表4def stopwordslist():5 stopwords = [line.strip() for line in open('chinsesstoptxt.txt',encoding='UTF-8').readlines()]6return stopwords78# 对句⼦进⾏中⽂分词9def seg_depart(sentence):10# 对⽂档中的每⼀⾏进⾏中⽂分词11print("正在分词")12 sentence_depart = jieba.cut(sentence.strip())13# 创建⼀个停⽤词列表14 stopwords = stopwordslist()15# 输出结果为outstr16 outstr = ''17# 去停⽤词18for word in sentence_depart:19if word not in stopwords:20if word != '\t':21 outstr += word22 outstr += ""23return outstr2425# 给出⽂档路径26 filename = "Init.txt"27 outfilename = "out.txt"28 inputs = open(filename, 'r', encoding='UTF-8')29 outputs = open(outfilename, 'w', encoding='UTF-8') 3031# 将输出结果写⼊ou.txt中32for line in inputs:33 line_seg = seg_depart(line)34 outputs.write(line_seg + '\n')35print("-------------------正在分词和去停⽤词-----------")36 outputs.close()37 inputs.close()38print("删除停⽤词和分词成功!!!")。

中文文本分类概述

计算机工程应用技术本栏目责任编辑:梁书中文文本分类概述栗征征(长江大学计算机科学学院,湖北荆州434023)摘要:在大数据时代,随着网络上的文本数据日益增长,文本分类技术显得越来越重要,是文本挖掘领域的热点问题,具有广阔的应用场景。

文本分类方法的研究开始于20世纪50年代,一直受到人们的广泛关注。

该文从文本分类的流程出发,简要介绍文本分类的一般流程以及每一步骤中涉及的主要技术。

主要包括预处理部分的分词、去停词和文本表示方法、特征降维和分类算法,分析了各种方法的优缺点并总结。

关键词:文本分类;预处理;特征降维;分类算法中图分类号:TP3文献标识码:A文章编号:1009-3044(2021)01-0229-02开放科学(资源服务)标识码(OSID ):1文本分类简介概念:文本分类是自然语言处理中的重要学科,其目的是在已知的分类中,根据给定文本内容自动确定其所属文本类别的过程。

数学定义:假设给定文档集合D ={d 1,d 2,d 3,d 4...d k }类别集合C ={c 1,c 2,c 3,c 4...c m }其中d i 与c j 表示文档集合中第i 篇文档和类别集合中第j 个类别。

k 、m 为总文档总数和总类别数。

文档集合和类别集合有下列的映射关系:f :D ×C →R ,R ∈{0,1}文本分类可分两个阶段:训练与测试,每个阶段又涉及预处理、特征降维、训练分类器三个步骤。

预处理包括分词、去停词、文本表示等;特征降维主要用到的方法有词频-逆文档频率(tf-idf )、卡方统计等;目前主流的分类器包括:支持向量机(SVM )、朴素贝叶斯(NB )、K 近邻等[1]。

如图1所示。

图1文本分类流程预处理:将文本数据转换为计算机可处理形式。

特征选择:由于文本内容复杂,难以用简单的方法表示,一般情况下文本的特征会达到很高的维度,特征选择可以降低维度从而使运算速度和准确率得到提高。

分类器:对分类器进行训练。

蒙古文停用词和英文停用词比较研究

蒙古文停用词和英文停用词比较研究巩政;关高娃【期刊名称】《中文信息学报》【年(卷),期】2011(025)004【摘要】In this paper, we initially set the Mongolian stop words with the union entropy algorithm (union entropy, UE), and then remove Mongolian entities nouns and homographs from Mongolian stop words, finally we compare the parts of speech of English stop words and Mongolian stop wordsto determine the Mongolian stopword list. We test the Mongolian stopword list and the English stopword list on document information retrieval task. The results show that the method used in this paper to determine the Mongolian stopword list has higher accuracy in Mongolian document retrieval than the simple translation English stop words into Mongolian.%该文采用联合熵算法(Union Entropy,UE)初步确定了蒙古文停用词,接着从初步确定的蒙古文停用词中去掉蒙古文实体名词及同形异义词,再通过对英文停用词和蒙古文停用词的词性比较,确定了蒙古文停用词表.最后用蒙古文停用词表和英文停用词表进行了文档信息检索的对比实验.实验结果表明,用该文所述方法确定的蒙古文停用词表进行蒙古文文档检索,比用英文停用词翻译成蒙古文进行蒙古文文档检索的准确率更尚.【总页数】4页(P35-38)【作者】巩政;关高娃【作者单位】内蒙古大学计算机学院,内蒙古呼和浩特010021;内蒙古大学计算机学院,内蒙古呼和浩特010021【正文语种】中文【中图分类】TP391【相关文献】1.本刊常用词汇英文缩写表(按英文字母排序) [J],2.从历史人物死亡用词区别看蒙古文献的人物价值评判取向 [J], 任国俊3.本刊常用词汇英文缩写表(按英文字母排序) [J],4.本刊常用词汇英文缩写表( 按英文字母排序) [J],5.本刊常用词汇英文缩写表(按英文字母排序) [J],因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

,、。

“”《》!,:;人民末啊阿哎哎呀哎哟唉俺俺们按按照吧吧哒把罢了被本本着比比方比如鄙人彼彼此边别别的中别说并并且不比不成不单不但不独不管不光不过不仅不拘不论不怕不然不如不特不惟不问不只朝朝着趁趁着乘冲除除此之外除非除了此此间此外从从而打待但文但是当当着到得的的话等等等地第叮咚对对于多多少而而况而且而是而外而言而已尔后反过来反过来说反之非但非徒否则嘎嘎登该赶个各各个各位各种停各自给根据跟故故此固然关于管归果然果真过哈哈哈呵和何何处何况何时嘿哼哼唷呼哧乎哗还是还有换句话说换言之或或是或者极了及及其及至即用即便即或即令即若即使几几时己既既然既是继而加之假如假若假使鉴于将较较之叫接着结果借紧接着进而尽尽管经经过就就是就是说据具体地说具体说来开始开外词靠咳可可见可是可以况且啦来来着离例如哩连连同两者了临另另外另一方面论嘛吗慢说漫说冒么每每当们莫若某某个某些拿哪哪边哪儿表哪个哪里哪年哪怕哪天哪些哪样那那边那儿那个那会儿那里那么那么些那么样那时那些那样乃乃至呢能你你们您宁宁可宁肯宁愿哦呕啪达旁人呸凭凭借其其次其二其他其它其一其余其中起起见岂但恰恰相反前后前者且然而然后然则让人家任任何任凭如如此如果如何如其如若如上所述若若非若是啥上下尚且设若设使甚而甚么甚至省得时候什么什么样使得是是的首先谁谁知顺顺着似的虽虽然虽说虽则随随着所所以他他们他人它它们她她们倘倘或倘然倘若倘使腾替通过同同时哇万一往望为为何为了为什么为着喂嗡嗡我我们呜呜呼乌乎无论无宁毋宁嘻吓相对而言像向向着嘘呀焉沿沿着要要不要不然要不是要么要是也也罢也好一一般一旦一方面一来一切一样一则依依照矣以以便以及以免以至以至于以致抑或因因此因而因为哟用由由此可见由于有有的有关有些又于于是于是乎与与此同时与否与其越是云云哉再说再者在在下咱咱们则怎怎么怎么办怎么样怎样咋照照着者这这边这儿这个这会儿这就是说这里这么这么点儿这么些这么样这时这些这样正如吱之之类之所以之一只是只限只要只有至至于诸位着着呢自自从自个儿自各儿自己自家自身综上所述总的来看总的来说总的说来总而言之总之纵纵令纵然纵使遵照作为兮呃呗咚咦喏啐喔唷嗬嗯嗳~!.:"'()*A白社会主义--..>>[]<>/\|-_+=&^%#@`;$()———¥·...‘’〉〈…1234567890123456789二三四五六七八九零><@#$%︿&*+~|[]{}啊哈啊呀啊哟挨次挨个挨家挨户挨门挨户挨门逐户挨着按理按期按时按说暗地里暗中暗自昂然八成白白半梆保管保险饱背地里背靠背倍感倍加本人本身甭比起比如说比照毕竟必必定必将必须便别人并非并肩并没并没有并排并无勃然不不必不常不大不但...而且不得不得不不得了不得已不迭不定不对不妨不管怎样不会不仅...而且不仅仅不仅仅是不经意不可开交不可抗拒不力不了不料不满不免不能不不起不巧不然的话不日不少不胜不时不是不同不能不要不外不外乎不下不限不消不已不亦乐乎不由得不再不择手段不怎么不曾不知不觉不止不止一次不至于才才能策略地差不多差一点常常常常言道常言说常言说得好长此下去长话短说长期以来长线敞开儿彻夜陈年趁便趁机趁热趁势趁早成年成年累月成心乘机乘胜乘势乘隙乘虚诚然迟早充分充其极充其量抽冷子臭初出出来出去除此除此而外除此以外除开除去除却除外处处川流不息传传说传闻串行纯纯粹此后此中次第匆匆从不从此从此以后从古到今从古至今从今以后从宽从来从轻从速从头从未从无到有从小从新从严从优从早到晚从中从重凑巧粗存心达旦打从打开天窗说亮话大大不了大大大抵大都大多大凡大概大家大举大略大面儿上大事大体大体上大约大张旗鼓大致呆呆地带殆待到单单纯单单但愿弹指之间当场当儿当即当口儿当然当庭当头当下当真当中倒不如倒不如说倒是到处到底到了儿到目前为止到头到头来得起得天独厚的确等到叮当顶多定动不动动辄陡然都独独自断然顿时多次多多多多少少多多益善多亏多年来多年前而后而论而又尔等二话不说二话没说反倒反倒是反而反手反之亦然反之则方方才方能放量非常非得分期分期分批分头奋勇愤然风雨无阻逢弗甫嘎嘎该当概赶快赶早不赶晚敢敢情敢于刚刚才刚好刚巧高低格外隔日隔夜个人各式更更加更进一步更为公然共共总够瞧的姑且古来故而故意固怪怪不得惯常光光是归根到底归根结底过于毫不毫无毫无保留地毫无例外好在何必何尝何妨何苦何乐而不为何须何止很很多很少轰然后来呼啦忽地忽然互互相哗啦话说还恍然会豁然活伙同或多或少或许基本基本上基于极极大极度极端极力极其极为急匆匆即将即刻即是说几度几番几乎几经既...又继之加上加以间或简而言之简言之简直见将才将近将要交口较比较为接连不断接下来皆可截然截至藉以借此借以届时仅仅仅谨进来进去近近几年来近来近年来尽管如此尽可能尽快尽量尽然尽如人意尽心竭力尽心尽力尽早精光经常竟竟然究竟就此就地就算居然局外举凡据称据此据实据说据我所知据悉具体来说决不决非绝绝不绝顶绝对绝非均喀看看来看起来看上去看样子可好可能恐怕快快要来不及来得及来讲来看拦腰牢牢老老大老老实实老是累次累年理当理该理应历立立地立刻立马立时联袂连连连日连日来连声连袂临到另方面另行另一个路经屡屡次屡次三番屡屡缕缕率尔率然略略加略微略为论说马上蛮满没没有每逢每每每时每刻猛然猛然间莫莫不莫非莫如默默地默然呐那末奈难道难得难怪难说内年复一年凝神偶而偶尔怕砰碰巧譬如偏偏乒平素颇迫于扑通其后其实奇齐起初起来起首起头起先岂岂非岂止迄恰逢恰好恰恰恰巧恰如恰似千千万千万千万切切不可切莫切切切勿窃亲口亲身亲手亲眼亲自顷顷刻顷刻间顷刻之间请勿穷年累月取道去权时全都全力全年全然全身心然人人仍仍旧仍然日复一日日见日渐日益日臻如常如此等等如次如今如期如前所述如上如下汝三番两次三番五次三天两头瑟瑟沙沙上上来上去。