多媒体技术之数据无损压缩

多媒体关键技术

多媒体信息处理的关键技术1)多媒体数据压缩技术2)多媒体数据存储技术3)集成电路制作技术4)多媒体数据库技术5)虚拟现实技术多媒体信息处理的关键技术1) 多媒体数据压缩技术为了快速传输数据、提高处理速度和节省存储空间,一些压缩算法和压缩手段已经标准化和模块化,被写入芯片中。

数据压缩的条件●数据冗余度(重复数据、可忽略数据)●人类不敏感因素例如:人类对某些频率的音频信号不敏感,人眼对亮度比较敏感,而对边缘的强烈变化并不敏感。

●信息传输与存储数据有损压缩数据无损压缩数据存储数据传输数据解压缩数据解压缩多媒体信息处理的关键技术数据压缩算法无损压缩有损压缩●无损压缩编码——压缩数据还原后,与原始数据一致,无损失。

●有损压缩编码——压缩后再还原的数据有损失。

多媒体信息处理的关键技术2) 多媒体数据存储技术存储技术逐步走向成熟,光盘存储器从单一品种的CD-ROM 存储器发展到CD-R、CD-RW、DVD-R、DVD-RW存储器等。

多媒体信息处理的关键技术3) 集成电路制作技术具有强大数据压缩运算能力的大规模集成电路是解决数据压缩等大量计算问题的硬件保证,为多媒体技术的发展创造了有利的条件。

多媒体信息处理的关键技术4) 多媒体数据库技术多媒体数据库、面向对象的数据库以及智能化多媒体数据库的发展越来越迅速,它们将进一步发展或取代传统的关系数据库。

多媒体信息处理的关键技术5) 虚拟现实技术虚拟现实技术是一种能够创建和体验虚拟世界的计算机仿真技术,它利用计算机生成一种交互式的三维动态视景,其实体行为的仿真系统能够使用户沉浸到该环境中。

多媒体数据的压缩与传输优化技术

多媒体数据的压缩与传输优化技术随着科技的迅猛发展和互联网的普及,多媒体数据的传输需求越来越高。

然而,传输大量的多媒体数据不仅需要大量的带宽资源,还需要考虑数据压缩和传输优化技术,以提高传输效率。

本文将探讨多媒体数据的压缩与传输优化技术,并讨论它们在不同领域的应用。

一、多媒体数据的压缩技术多媒体数据压缩技术是将多媒体数据的冗余信息去除,以减少数据的存储空间和传输带宽的技术。

常见的多媒体数据压缩技术包括图像压缩、音频压缩和视频压缩。

1. 图像压缩图像压缩是将图像数据进行编码压缩,以减少存储空间和传输带宽,并保持较好的图像质量。

目前,常用的图像压缩方法包括无损压缩和有损压缩。

无损压缩通常用于要求图像质量没有任何损失的场景,而有损压缩则常用于需要降低图像质量但能大幅度减少数据量的场景。

2. 音频压缩音频压缩是将音频数据进行编码压缩,以减少存储空间和传输带宽,同时保持较好的音质。

常用的音频压缩方法包括无损压缩和有损压缩。

无损压缩适用于要求音质不受损的场景,而有损压缩则适用于需要大幅度减少数据量但允许一定音质损失的场景。

3. 视频压缩视频压缩是将视频数据进行编码压缩,以减少存储空间和传输带宽,同时保持较好的视觉质量。

常用的视频压缩方法包括帧内压缩和帧间压缩。

帧内压缩是指对视频帧内的像素进行压缩,而帧间压缩则是通过利用相邻帧之间的冗余信息进行压缩,能有效减少数据量。

二、多媒体数据的传输优化技术传输优化技术是指通过优化传输过程中的算法和协议,提高多媒体数据的传输效率。

常见的传输优化技术包括流媒体传输、分布式传输和错误控制。

1. 流媒体传输流媒体传输是指将多媒体数据以流的形式传输,实现边下载边播放的功能。

该技术有效节约了用户端的存储空间,并提供了较好的可观看体验。

流媒体传输常用的协议包括实时传输协议(Real-time Transport Protocol,RTP)和实时流传输协议(Real-time Streaming Protocol,RTSP)等。

多媒体技术基础知识

多媒体技术基础知识多媒体技术是指将多种媒体元素(如文字、图片、音频、视频等),通过计算机和其他电子设备进行处理、传输和展示的技术手段。

它已经成为现代信息社会中不可或缺的一部分,广泛应用于娱乐、教育、广告、医疗等各个领域。

多媒体技术的基础知识包括以下几个方面:1. 图像处理:图像处理是多媒体技术中的重要部分,它涉及到对图像进行获取、编码、存储、传输和显示等一系列操作。

常用的图像处理技术有图像压缩、图像增强、图像分割等。

2. 视频处理:视频处理是多媒体技术中的另一个重要方面,它涉及到对连续的图像序列进行处理。

视频处理的主要技术包括视频压缩、视频编码、视频解码等,以实现对视频的高效存储和传输。

3. 音频处理:音频处理是多媒体技术中的另一个重要方面,它涉及到对声音信号的获取、编码、存储和传输等处理。

音频处理的主要技术包括音频压缩、音频解码、音频增强等。

4. 数据压缩:数据压缩是多媒体技术中的核心技术之一,它通过对多媒体数据进行编码压缩,以减少数据的存储空间和传输带宽。

常用的数据压缩算法有JPEG、MPEG、MP3等。

5. 数据传输:多媒体技术中的数据传输是指将多媒体数据从一个地方传输到另一个地方。

常用的数据传输技术有有线传输和无线传输两种方式,其中无线传输技术包括蓝牙、WiFi和4G 等。

6. 用户界面设计:用户界面设计是多媒体技术中非常重要的一部分,它涉及到设计和实现用户与多媒体应用之间的交互界面。

好的用户界面设计可以提高用户的体验和使用效率。

7. 数据存储:多媒体技术生成的数据量庞大,因此需要一种高效的数据存储方式。

常用的数据存储技术有硬盘、固态硬盘和云存储等。

综上所述,多媒体技术的基础知识包括图像处理、视频处理、音频处理、数据压缩、数据传输、用户界面设计和数据存储等方面。

了解这些基础知识可以帮助我们更好地理解和应用多媒体技术,推动多媒体技术在各个领域的发展和应用。

多媒体技术的应用越来越广泛,不仅在娱乐领域中如电子游戏、电影和音乐中变得更加丰富和真实,还在教育、医疗和企业领域中发挥着重要的作用。

面向多媒体数据的无损压缩技术研究

面向多媒体数据的无损压缩技术研究在今天的数字化时代下,越来越多的多媒体数据被创建和传输。

无论是音频、视频、图片还是文本都已成为人们日常生活中不可或缺的组成部分。

随之而来的是数据的爆炸式增长,这给传输和存储带来了巨大的挑战。

为了解决这个问题,研究人员们一直在努力探索一种有效的数据压缩方式。

其中,无损压缩技术因为它可以在不降低数据质量的情况下将数据压缩到较小的空间,被广泛应用。

一、无损压缩技术的定义无损压缩技术是指将数据压缩到更小的空间长度,同时不损失数据本身,使其可以恢复到其原始状态的压缩技术。

与有损压缩技术相比,它不会丢失任何数据或信息,并且不会对质量进行任何改变。

因此,无损压缩技术在很多领域都有广泛的应用,如图片压缩、音频压缩和视频压缩等。

二、多媒体数据无损压缩技术的发展随着数字化时代的到来,多媒体数据的需求越来越大,因此相关压缩技术的发展也得到了更多的重视。

目前,无损压缩技术已经有了很多的发展,主要包括以下几个方面:1.总体压缩算法总体压缩算法是一种可以减少数据体积的压缩算法。

它在编码数据之前,通过对数据进行概率建模来尽可能多地减少数据的体积。

该方法被广泛应用于音频和视频压缩中。

2.图像压缩算法图像压缩算法基于不同的原理进行设计,例如直接编码、预测编码、离散余弦变换(DCT)、小波变换和自适应算法等。

利用这些算法,可以在保持图像质量的前提下,将图像压缩到更小的大小。

3.音频压缩算法音频压缩算法通常使用子带编码技术、预测编码技术和的DCT 技术等技术。

这些算法可以实现无损压缩和有损压缩,并且通常比图像压缩算法更有效。

4.视频压缩算法视频压缩算法通常使用预测编码和变换编码技术。

在预测编码中,通过预测视频下一帧的内容,然后只针对预测残差进行编码。

在变换编码中,通常使用DCT进一步压缩预测残差数据。

三、多媒体数据无损压缩技术的局限性虽然无损压缩技术在多媒体领域中取得了很大的成功,但是它还有一些局限性。

多媒体压缩技术

多媒体压缩技术在当今数字化的时代,多媒体信息如音频、视频、图像等在我们的生活中无处不在。

从在线视频播放到手机中的照片存储,从远程会议到虚拟现实体验,多媒体数据的生成和传播呈爆炸式增长。

然而,大量的多媒体数据需要占用巨大的存储空间和传输带宽,这给存储设备和网络带来了沉重的负担。

为了解决这个问题,多媒体压缩技术应运而生,它就像是一位神奇的魔法师,能够在不损失太多质量的前提下,将庞大的多媒体数据变得小巧玲珑。

多媒体压缩技术的基本原理其实并不复杂,就像是我们收拾行李时把衣物尽可能紧凑地叠放起来,以节省空间。

在多媒体世界里,数据也可以通过各种巧妙的方式被“压缩”。

首先,让我们来谈谈图像压缩。

图像是由一个个像素点组成的,每个像素点都包含了颜色和亮度等信息。

在图像压缩中,有一种常见的方法叫做无损压缩。

无损压缩就像是把一个拼图完整地放进一个小盒子里,虽然盒子变小了,但拼图的每一块都还在,没有任何缺失。

比如说,行程编码就是一种无损压缩方法。

它通过记录相同像素值连续出现的次数来减少数据量。

假设一幅图像中有一大片蓝色区域,使用行程编码就可以只记录“蓝色,连续出现 100 个像素”,而不是逐个记录每个蓝色像素的信息。

除了无损压缩,还有有损压缩。

有损压缩就像是为了把更多的衣服塞进箱子,稍微牺牲一些不太重要的衣物。

在图像有损压缩中,JPEG格式是非常常见的。

它会根据人眼对颜色和细节的敏感度,去除一些不太容易被察觉的信息。

比如,人眼对亮度的变化比较敏感,但对颜色的细微差别不那么敏感,JPEG 压缩就会更多地保留亮度信息,而对颜色信息进行较大程度的压缩。

接下来是视频压缩。

视频本质上是一系列快速播放的图像帧。

视频压缩不仅要考虑每一帧图像的压缩,还要利用帧与帧之间的相似性。

比如,在一段视频中,如果背景几乎不变,只有人物在移动,那么就不需要对每一帧的背景都进行完整的记录,只需要记录第一帧的背景,后续帧只记录人物移动的变化部分。

这种方法被称为帧间压缩。

多媒体技术教程课后习题答案

第1章 多媒体技术概要1.1 多媒体是什么?多媒体是融合两种或者两种以上媒体的一种人-机交互式信息交流和传播媒体。

使用的媒体包括文字、图形、图像、声音、动画和视像(video )。

1。

4 无损压缩是什么?无损压缩是用压缩后的数据进行重构(也称还原或解压缩),重构后的数据与原来的数据完全相同的数据压缩技术.无损压缩用于要求重构的数据与原始数据完全一致的应用,如磁盘文件压缩就是一个应用实例.根据当前的技术水平,无损压缩算法可把普通文件的数据压缩到原来的1/2~1/4。

常用的无损压缩算法包括哈夫曼编码和LZW 等算法.1。

5 有损压缩是什么?有损压缩是用压缩后的数据进行重构,重构后的数据与原来的数据有所不同,但不影响人对原始资料表达的信息造成误解的数据压缩技术。

有损压缩适用于重构数据不一定非要和原始数据完全相同的应用。

例如,图像、视像和声音数据就可采用有损压缩,因为它们包含的数据往往多于我们的视觉系统和听觉系统所能感受的信息,丢掉一些数据而不至于对图像、视像或声音所表达的意思产生误解。

1。

9 H.261~H.264和G.711~G 。

731是哪个组织制定的标准?国际电信联盟(ITU ).1.10 MPEG —1,MPEG-2和MPEG —4是哪个组织制定的标准?ISO/IEC ,即国际标准化组织(ISO)/ 国际电工技术委员会(IEC)。

第2章 无损数据压缩2。

1假设{,,}a b c 是由3个事件组成的集合,计算该集合的决策量。

(分别用Sh ,Nat 和Hart作单位)。

H 0 = (log 23) Sh = 1.580 Sh= (log e 3) Nat = 1.098 Nat= (log 103) Hart = 0.477 Hart2.2 现有一幅用256级灰度表示的图像,如果每级灰度出现的概率均为()1/256i p x =,0,,255i =,计算这幅图像数据的熵.22111()()log ()256(log )256256n i i i H X p x p x ==-=-⨯⨯∑=8 (位), 也就是每级灰度的代码就要用8比特,不能再少了。

多媒体技术基础第3版第2章数据无损压缩

*

2.0 数据无损压缩概述(续2)

2章 数据无损压缩

The Father of Information Theory—— Claude Elwood Shannon Born: 30 April 1916 in Gaylord, Michigan, USA Died: 24 Feb 2001 in Medford, Massachusetts, USA

统计编码

编码特性

编码方法

香农-范诺编码 霍夫曼编码 算术编码

*

*

2.2.1 统计编码——香农-范诺编码 香农-范诺编码(Shannon–Fano coding) 在香农的源编码理论中,熵的大小表示非冗余的不可压缩的信息量 在计算熵时,如果对数的底数用2,熵的单位就用“香农(Sh)”,也称“位(bit)” 。“位”是1948年Shannon首次使用的术语。例如 最早阐述和实现“从上到下”的熵编码方法的人是Shannon(1948年)和Fano(1949年),因此称为香农-范诺(Shannon- Fano)编码法

2章 数据无损压缩

02

霍夫曼(D.A. Huffman)在1952年提出和描述的“从下到上”的熵编码方法

根据给定数据集中各元素所出现的频率来压缩数据的一种统计压缩编码方法。这些元素(如字母)出现的次数越多,其编码的位数就越少

广泛用在JPEG, MPEG, H.26X等各种信息编码标准中

*

*

2.2.2 霍夫曼编码— Case Study 1 现有一个由5个不同符号组成的30个符号的字符串:BABACACADADABBCBABEBEDDABEEEBB 计算 该字符串的霍夫曼码 该字符串的熵 该字符串的平均码长 编码前后的压缩比 霍夫曼编码举例1

简述多媒体计算机的关键技术。

简述多媒体计算机的关键技术。

多媒体计算机是一种专门用于处理音视频等多媒体数据的计算机系统。

其关键技术包括:

1. 数据压缩:多媒体数据通常具有较高的数据量和带宽要求,压缩技术被广泛应用,包括无损压缩和有损压缩技术,如JPEG、MPEG 等。

2. 数据传输:多媒体数据通常要求实时传输,需要保证其稳定性和实时性,常用的数据传输技术包括TCP/IP、UDP、RTP等。

3. 信号处理:视频数据需要进行去噪、去色差、增强等处理,音频数据需要进行降噪、混响等处理。

4. 显示技术:多媒体计算机通常采用高分辨率的显示器,也需要特殊的图形处理器来处理复杂的图像数据,如3D图像。

5. 输入输出设备:多媒体计算机需要专门的输入设备,如麦克风、摄像头等,也需要高保真的输出设备,如扬声器、投影仪等。

总的来说,多媒体计算机的关键技术在于对音视频等多媒体数据的处理和传输,需要涉及到数据压缩、信号处理、显示技术、输入输出设备等多个方面。

多媒体数据处理中几种无损压缩算法的比较概要

119摘要:为了使大容量的多媒体数据在网络上有效的传输,必须对多媒体数据进行压缩。

对多媒体数据压缩中的几种无损压缩方法进行了比较,并对每种方法用一个例子说明。

关键词:数据压缩;霍夫曼树;LZW;二叉树引言随着网络发展的速度越来越快,视频,音频的广泛应用使得大数据量的传输显得尤为重要,如何更快、更多、更好地传输与存储数据成为数据信息处理的首要问题。

在压缩算法中分为无损压缩和有损压缩。

相对于有损压缩来说,无损压缩的占用空间大,压缩比不高,但是它100%的保存了原始信息,没有任何信号丢失并且音质高,不受信号源的影响,这点是有损压缩不可比拟的。

而且随着时间的推移,限制无损格式的种种因素将逐渐被消除,比如说硬盘容量的急剧增长以及低廉的价格使得无损压缩格式的前景无比光明。

1、无损压缩的原理以及几种常见算法本质上压缩数据是因为数据自身具有冗余性。

数据压缩是利用各种算法将数据冗余压缩到最小,并尽可能地减少失真,从而提高传输效率和节约存储空间。

常见的无损压缩算法有,游长编码;香浓-凡诺算法;霍夫曼算法;LZW算法;下面详细介绍这些算法或编码步骤,并比较其优缺点。

2、游长编码也叫行程编码,它是数据压缩中最简单的一种方法。

它的思想是:将图像一行中颜色值相同的相邻象素用一个计数值和该颜色值来代替。

例如:aabbbccccdddddeeeeee对其进行游长编码可得2a3b4c5d6e,可见其效率很高。

但它有两个致命缺点。

一:如果图象中每两个相邻点的颜色都不同,用这种算法不但不能压缩,反而数据量会增加,例如对abcdeabcde进行编码得1a2b3c4d5e1a2b3c4d5e,可见数据量反而增加了1倍。

二:容错性差。

还是以aabbbccccdddddeeeeee为例,如果在第二位a出错,例如丢失了a,那么编码后结果为1a3b4c5d6e,虽然只有一位发生了错误,但是在恢复数据时,将和原始数据完全不同。

所以说游长编码在要压缩信息源中的符号形成连续出现片段时才有效,并且它不是一种自适应的编码方式。

多媒体数据压缩

多媒体数据压缩

多媒体数据压缩是指通过一系列算法和技术,将多媒体数据以

更小的尺寸进行存储或传输的过程。

多媒体数据主要包括图像、音

频和视频等形式。

压缩多媒体数据可以减少存储空间和传输带宽的

需求,从而提高数据的传输效率和用户体验。

常见的多媒体数据压缩方法有以下几种:

1. 图像压缩:常见的图像压缩算法有无损压缩和有损压缩两种。

无损压缩方法包括Run-length Encoding (RLE)、LZW和Huffman编码等;有损压缩方法如JPEG使用了离散余弦变换(DCT)和量化等技术,通过牺牲一定的图像质量来实现较高的压缩率。

2. 音频压缩:音频压缩方法主要有无损压缩和有损压缩两种。

无损压缩方法如FLAC和ALAC能够将音频数据压缩到更小的文件大

小且不损失音频质量;有损压缩方法如MP3和AAC利用了人耳的听

觉特性,通过减少对听觉上不敏感的部分数据来实现较高的压缩率。

3. 视频压缩:视频压缩方法通常采用有损压缩。

常见的视频压缩标准包括MPEG-2、MPEG-4和H.264等。

视频压缩技术主要利用了时域和空域的冗余性,以及运动补偿、帧间预测等技术,通过减少冗余信息和丢弃一些不重要的细节来实现高效的压缩。

多媒体数据压缩对于互联网、移动通信、存储设备等领域都非常重要,可以大大提升数据的传输速度和存储效率。

但也会牺牲一定的数据质量,在实际应用中需要根据具体需求权衡压缩率和数据质量。

多媒体技术课件--lesson07数据压缩基本算法-有损压缩算法

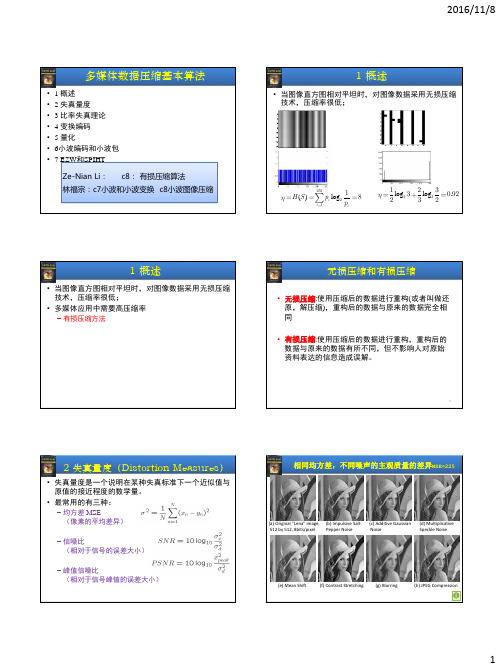

多媒体数据压缩基本算法•1概述•2失真量度•3比率失真理论• 4 变换编码• 5 量化•6小波编码和小波包•7 EZW 和SPIHT Ze-Nian Li :c8:有损压缩算法林福宗:c7小波和小波变换c8小波图像压缩1概述•当图像直方图相对平坦时,对图像数据采用无损压缩技术,压缩率很低;()log i i iH S p p 2552118log log .2212330922321概述•当图像直方图相对平坦时,对图像数据采用无损压缩技术,压缩率很低;•多媒体应用中需要高压缩率–有损压缩方法无损压缩和有损压缩•无损压缩:使用压缩后的数据进行重构(或者叫做还原,解压缩),重构后的数据与原来的数据完全相同•有损压缩:使用压缩后的数据进行重构,重构后的数据与原来的数据有所不同,但不影响人对原始资料表达的信息造成误解。

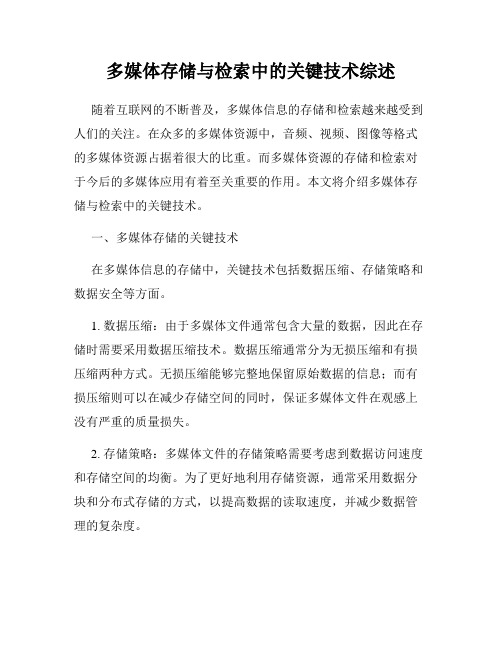

4•失真量度是一个说明在某种失真标准下一个近似值与原值的接近程度的数学量。

•最常用的有三种:–均方差MSE(像素的平均差异)–信噪比(相对于信号的误差大小)–峰值信噪比(相对于信号峰值的误差大小)2 失真量度(Distortion Measures )5(a) Original "Lena" image,512 by 512, 8bits/pixel (b) Impulsive Salt-Pepper Noise (c) Additive Gaussian Noise (d) Multiplicative Speckle Noise(e) Mean Shift(f) Contrast Stretching(g) Blurring(h) JPEG Compression相同均方差,不同噪声的主观质量的差异MSE=2253率失真理论Rate-Distortion7信息率:重现源信号所需要的平均比特数(信息量)R(D):率失真函数1、D=0是没有缺损时的最小比特率,即源数据的熵H ;2、而在R(D)=0时,失真达到最大值。

多媒体数据压缩编码技术概述

多媒体数据压缩编码技术概述多媒体数据压缩编码技术是一种通过减少或去除冗余数据来减小多媒体文件的存储空间或传输带宽的过程。

这些技术广泛应用于图像、音频和视频等各种形式的多媒体数据。

下面将对多媒体数据压缩编码技术的主要方法进行概述。

1. 无损压缩编码:无损压缩编码技术可以将多媒体数据压缩到较小的大小,而不会丢失原始数据。

该技术通过利用多媒体数据中的冗余和统计特性来实现压缩效果。

其中,哈夫曼编码、算术编码和Lempel-Ziv编码等是常用的无损压缩编码方法。

2. 有损压缩编码:有损压缩编码技术可以在一定程度上丢失原始数据,并将其转换为较小的文件大小。

这种压缩方法适用于某些多媒体数据,如音频和视频等,因为人类的感知系统对这些数据中的一些细微变化不太敏感。

有损压缩编码方法包括离散余弦变换(DCT)、小波变换、运动补偿和预测编码等。

3. 基于上下文的压缩编码:这种压缩编码技术利用多媒体数据内部的上下文信息来实现更高的压缩效果。

上下文信息包括像素点的位置、颜色和周围像素点的关系等。

基于上下文的编码方法有助于提高压缩比,并减少信号的失真。

包括了一些流行的基于上下文的压缩编码算法,如JPEG(图像)、MP3(音频)和H.264/AVC(视频)。

4. 神经网络压缩编码:近年来,神经网络技术在多媒体数据压缩编码领域取得了显著的进展。

这些技术利用深度学习的方法来学习多媒体数据中的复杂模式,并使用这些模式进行压缩编码。

神经网络压缩编码方法通常能够在保持较高视觉和听觉质量的同时,实现更高的压缩比。

综上所述,多媒体数据压缩编码技术是一种通过减少或去除冗余数据来减小多媒体文件的存储空间或传输带宽的过程。

该技术涵盖了无损压缩编码、有损压缩编码、基于上下文的压缩编码和神经网络压缩编码等方法。

这些技术在多媒体数据领域发挥着重要的作用,帮助人们有效地处理和传输大量的多媒体数据。

5. 图像压缩编码技术:图像压缩编码技术是多媒体数据压缩编码中的一个重要领域。

多媒体数据文件与压缩技术

多媒体数据文件与压缩技术多媒体数据文件与压缩技术1. 概述1.1 介绍多媒体数据文件1.2 多媒体数据的特点1.3 压缩技术的重要性2. 多媒体数据文件的类型2.1 图像文件2.1.1 常见的图像文件格式2.1.2 图像文件压缩技术2.2 音频文件2.2.1 常见的音频文件格式2.2.2 音频文件压缩技术2.3 视频文件2.3.1 常见的视频文件格式2.3.2 视频文件压缩技术3. 图像压缩技术3.1 无损压缩技术3.1.1 RLE压缩算法3.1.2 Huffman压缩算法 3.1.3 LZW压缩算法3.2 有损压缩技术3.2.1 JPEG压缩算法3.2.2 WebP压缩算法4. 音频压缩技术4.1 无损压缩技术4.1.1 FLAC压缩算法4.1.2 ALAC压缩算法4.2 有损压缩技术4.2.1 MP3压缩算法4.2.2 AAC压缩算法5. 视频压缩技术5.1 无损压缩技术5.1.1 Lagarith压缩算法5.1.2 FFV1压缩算法5.2 有损压缩技术5.2.1 H.264压缩算法5.2.2 VP9压缩算法6. 本文所涉及的法律名词及注释- 数据文件:根据著作权法第2条第2款的规定,指用来记录、存储、预示、发送以及接收各种形式的作品的一切物质载体。

- 压缩技术:指通过对多媒体数据文件进行编码或转换来减小文件的大小,从而节省存储空间和提高传输效率的技术。

- 无损压缩:压缩后的文件与原始文件完全一致,没有任何数据损失。

- 有损压缩:压缩后的文件与原始文件存在一定的数据损失,但可以通过不同的算法设置来控制损失程度。

- RLE:Run Length Encoding,一种基于重复数据的无损压缩算法。

- Huffman:一种基于数据出现频率的无损压缩算法,采用可变长度编码。

- LZW:Lempel-Ziv-Welch,一种基于字符串替换的无损压缩算法。

- JPEG:Joint Photographic Experts Group,一种广泛应用于图像压缩的有损压缩算法。

多媒体数据压缩

多媒体数据压缩多媒体数据压缩1. 介绍多媒体数据压缩是一种广泛应用于图片、音频和视频等多媒体文件的技术。

由于多媒体文件通常包含大量的数据,压缩技术能够减小文件的存储空间和传输带宽要求,提高数据的传输速率和存储效率。

本文将介绍多媒体数据压缩的原理和常用的压缩算法。

2. 图片压缩2.1 无损压缩无损压缩是指在压缩过程中不丢失任何原始数据的压缩方法。

其中最常用的无损压缩算法是GIF和PNG格式。

GIF格式通过限制颜色数量和使用LZW编码来实现数据压缩,而PNG格式则使用DEFLATE算法对图片数据进行压缩。

2.2 有损压缩有损压缩是指在压缩过程中会有一定的信息丢失的压缩方法。

最常用的有损压缩算法是JPEG格式。

JPEG格式通过使用离散余弦变换(DCT)将图像从时域转换到频域,并通过量化和哈夫曼编码来减小数据量。

压缩的程度可以通过调整量化表的精度来控制。

3. 音频压缩3.1 无损压缩无损压缩在音频领域并不常见,因为音频文件通常比较大,无损压缩往往无法达到很高的压缩比。

其中一个常用的无损压缩算法是FLAC格式。

FLAC格式通过使用线性预测和残差编码来减小数据的大小,保持音频的质量不变。

3.2 有损压缩有损压缩在音频领域非常常见,因为人耳对音频的感知有一定的容忍度。

最常用的有损压缩算法是MP3格式。

MP3格式通过使用MDCT变换将音频从时域转换到频域,并通过子带编码和声学模型来减小数据量。

压缩的程度可以通过调整比特率来控制。

4. 视频压缩4.1 无损压缩无损压缩在视频领域并不常见,因为视频文件通常非常大,无损压缩往往无法达到很高的压缩比。

其中一个常用的无损压缩算法是HuffYUV格式。

HuffYUV格式通过使用无损哈夫曼编码来减小数据的大小,保持视频的质量不变。

4.2 有损压缩有损压缩在视频领域非常常见,因为视频的冗余性很高,有很多可以被压缩的信息。

最常用的有损压缩算法是H.264和HEVC格式。

H.264和HEVC格式通过使用运动估计和帧间预测等技术来减小数据量。

第二章 多媒体数据压缩技术

的一个间隔,信息越长,编码表示它的间隔就

越小,表示这一间隔所需的二进制位就越多。 2、编码方法:后一个编码字符是在前面编码字符 的范围内,利用原概率分配区间重新求解该编 码字符的范围。

33

2.2.2 常用无损压缩算法

3、编码过程举例:假设信源符号为{a,e,i,o,u},

这些符号的概率分别为{ 0.2, 0.3, 0.1, 0.2, 0.2 },根据这些概率可把间隔[0, 1)分成5个子 间隔(如下图): 字符 概率 范围 a 0.2 e 0.3 i 0.1 o 0.2 u 0.2

概述

(1)数据压缩研究主要集中于图像和视频信号的压缩 (2)数据压缩是以一定的质量损失为代价, 质量损失 一般都是在人眼允许的误差范围之内。 (3)压缩处理过程:

编码过程:将原始数据经过编码进行压缩,以便存 储与传输; 解码过程:对编码数据进行解码,还原为可以使用 的数据。

18

2.1

概述

四、衡量数据压缩技术的指标

第二章 多媒体数据压缩技术

2.1

概述

2.2

常用的数据压缩技术

1

2.1 概述

一、为什么要进行数据压缩

1. 多媒体信息数据量大

例:对语音信号来说(20HZ—4KHZ) 依据采样定理,设数字化精度为8bit,则1秒

数据量为:

4k 2 8b 64kb

2

2.1 概述

对动态图像信息来说,采用代表光强、色彩和饱 和度的YIQ彩色空间,如果带宽分别为: 4.2MHZ、1.5MHZ、0.5MHZ,则1秒钟数据量为:

(1)第一个字符e被编码时: rangelow=0.2, rangehigh=0.5 low=low+range*rangelow = 0+1*0.2=0.2, high=low+range*rangehigh=0+1*0.5=0.5 Range=high-low=0.5-0.2=0.3 此时分配给e的范围为[0.2,0.5)

多媒体存储与检索中的关键技术综述

多媒体存储与检索中的关键技术综述随着互联网的不断普及,多媒体信息的存储和检索越来越受到人们的关注。

在众多的多媒体资源中,音频、视频、图像等格式的多媒体资源占据着很大的比重。

而多媒体资源的存储和检索对于今后的多媒体应用有着至关重要的作用。

本文将介绍多媒体存储与检索中的关键技术。

一、多媒体存储的关键技术在多媒体信息的存储中,关键技术包括数据压缩、存储策略和数据安全等方面。

1. 数据压缩:由于多媒体文件通常包含大量的数据,因此在存储时需要采用数据压缩技术。

数据压缩通常分为无损压缩和有损压缩两种方式。

无损压缩能够完整地保留原始数据的信息;而有损压缩则可以在减少存储空间的同时,保证多媒体文件在观感上没有严重的质量损失。

2. 存储策略:多媒体文件的存储策略需要考虑到数据访问速度和存储空间的均衡。

为了更好地利用存储资源,通常采用数据分块和分布式存储的方式,以提高数据的读取速度,并减少数据管理的复杂度。

3. 数据安全:由于多媒体文件通常包含大量的个人隐私信息,因此数据安全也成为了多媒体存储的重要问题。

为了保证数据的安全性,常用的措施包括加密算法、访问控制和备份等。

二、多媒体检索的关键技术在多媒体信息的检索中,关键技术包括多媒体信息表示、相似性度量和查询优化等方面。

1. 多媒体信息表示:多媒体信息通常通过特定的数据结构进行表示。

对于不同的多媒体类型,需采用不同的数据结构进行表示。

例如对于图像信息,可采用颜色矩、纹理等结构进行表示;而对于音频信息,则可以采用谱系数等结构进行表示。

2. 相似性度量:在多媒体检索中,需要对多媒体信息进行相似性度量。

通常采用欧式距离、余弦相似度等方式进行相似性度量。

由于多媒体信息通常包含多个维度,因此需要在受限的时间内快速计算出相似度。

3. 查询优化:多媒体检索包括精确查询和模糊查询两种方式。

对于精确查询,可以采用B树等结构进行优化。

而对于模糊查询,则需要采用特定的算法进行优化。

例如,可以采用基于语义的查询优化方式,提高检索效率。

第4章 多媒体数据压缩技术

如上图的行程长度编码可写为:白8黑5白3黑8白6……

2023/4/20

Multimedia Technology & Application

2023/4/20

Multimedia Technology & Application

24

4.2 静态图像的压缩标准JPEG

4.2.1 JPEG标准简介 4.2.2 JPEG标准中的主要技术 4.2.3 JPEG标准的压缩过程 4.2.4 JPEG2000

2023/4/20

Multimedia Technology & Application

8

方式3:不等长编码

考查字符串中不同字符出现的概率并对其重新定义一 个编码字如表4.2所示:

则其编码的总长度为:8×1+4×3×3+2×4×2=60(bit)

2023/4/20

Multimedia Technology & Application

9

4.1.3 常用的数据压缩方法

1.行程长度(也称游程长度编码)

2023/4/20

Multimedia Technology & Application

19

5.熵编码

2) 熵编码实例——哈夫曼编码

算法可描述为: (1) 对图像中出现的不同像素值进行概率统计,得到n个不同概率的信 息符号。 (2) 按符号出现的概率由大到小、由上到下排列。 (3) 对两个最低概率符号分别以二进制0、1赋值。 (4) 两最低概率相加后作为一个新符号的概率重新置入符号序列中。 (5) 对概率按从大到小重新排列。 (6) 重复(2)~(5),直到只剩下两个概率符号的序列。 (7) 分别以二进制0、1赋值后,以此为根结点,沿赋值的顺序的逆序依 次写出该路径上的二进制代码,得到哈夫曼编码。

多媒体压缩技术

多媒体压缩技术多媒体压缩技术是通过对多媒体数据进行压缩,以减少数据量并维持较高的质量,从而使其能够在各种媒体平台上进行传输和存储。

这种技术在现代社会中起着重要的作用,因为它能够快速传输和存储大量的图像、音频和视频数据。

在多媒体压缩技术中,最常用的方法是有损压缩和无损压缩。

有损压缩技术通过牺牲一些细节和质量来减小数据量,以便在保持足够可接受的有效性的同时,实现更高的压缩比。

这种技术通常用于音频和视频数据,包括MPEG(Moving Picture Experts Group)和JPEG(Joint Photographic Experts Group)等格式。

而无损压缩技术则是通过减小冗余来改善数据的存储效率,而不丢失任何信息。

这种技术主要用于图像和文本数据,如GIF(Graphics Interchange Format)和ZIP(Zone Information Provider)等格式。

多媒体压缩技术的主要目标是实现高效的压缩和解压缩速度。

为了达到这个目标,许多算法和编码技术被开发出来。

其中之一是离散余弦变换(Discrete Cosine Transform,DCT),它被广泛应用于图像和视频压缩中。

DCT将图像或视频分解成一系列频率成分,并且较高频率的数据将会被丢弃或量化以实现更高的压缩比。

此外,熵编码也是一种常见的压缩技术,它通过对数据进行编码来改进数据的压缩效果,例如霍夫曼编码和算术编码等。

当今的多媒体技术越来越普及和便宜,人们对高质量的图像、音频和视频有着更高的需求。

因此,多媒体压缩技术的研究和创新变得更加重要。

随着技术的不断发展,我们将能够实现更高的压缩率和更低的失真率,从而使更多的多媒体内容能够在不同的平台上得到传输和存储。

综上所述,多媒体压缩技术在现代社会中发挥着重要的作用。

通过减小数据量并维持较高的质量,这项技术实现了快速的传输和存储,使得多媒体内容能够在各种平台上得到应用。

大数据分析中的数据压缩与存储优化方法介绍(十)

大数据分析中的数据压缩与存储优化方法介绍随着互联网技术的不断发展,大数据分析已经成为了企业决策和业务发展的重要手段。

然而,大数据的处理和存储也带来了巨大的挑战,尤其是数据的压缩和存储优化问题。

本文将围绕大数据分析中的数据压缩与存储优化方法进行介绍。

一、数据压缩技术1. 无损压缩无损压缩是一种保证数据完整性的压缩方法,它通过消除数据中的冗余信息来减小数据占用的空间。

在大数据分析中,无损压缩常常用于对结构化数据的压缩,比如关系型数据库中的表格数据。

常见的无损压缩算法包括哈夫曼编码、LZW算法等。

2. 有损压缩有损压缩是一种通过舍弃部分数据信息来减小数据占用空间的压缩方法。

在大数据分析中,有损压缩通常用于对图像、音频、视频等多媒体数据的压缩。

常见的有损压缩算法包括JPEG、MP3、MPEG等。

3. 字典压缩字典压缩是一种基于字典的压缩方法,它通过构建和维护一个数据字典来实现压缩。

在大数据分析中,字典压缩常常用于对文本数据的压缩,比如对大规模日志文件的压缩。

常见的字典压缩算法包括LZ77、LZSS、LZMA等。

二、数据存储优化方法1. 列式存储列式存储是一种将数据按列而不是按行进行存储的方法,它可以显著提高数据的压缩效率和查询性能。

在大数据分析中,列式存储常常用于对结构化数据的存储,比如对关系型数据库的表格数据进行存储。

常见的列式存储引擎包括Apache Parquet、Apache ORC等。

2. 分区存储分区存储是一种将数据按特定的分区进行存储的方法,它可以减小数据的读取范围,提高查询性能。

在大数据分析中,分区存储常常用于对分布式文件系统的数据进行存储,比如对HDFS、Amazon S3等的数据进行分区存储。

常见的分区存储策略包括按时间分区、按地域分区、按业务分区等。

3. 压缩存储压缩存储是一种将数据在存储时进行压缩的方法,它可以减小数据占用的存储空间,降低存储成本。

在大数据分析中,压缩存储常常用于对大规模文本数据的存储,比如对日志文件、监控数据等的存储。

信息科学中的数据压缩技术

信息科学中的数据压缩技术数据压缩技术是信息科学领域中的重要研究方向,它对于有效利用存储空间和传输带宽至关重要。

本文将对数据压缩技术进行探讨,介绍其在不同领域的应用以及最新的研究进展。

一、数据压缩的基本概念数据压缩是指通过某种算法和方法,将原始数据进行处理,以便减少占用的存储空间或传输带宽。

数据压缩可以分为有损压缩和无损压缩两种方式。

有损压缩是指在数据压缩的过程中,丢失一部分信息,从而降低数据的质量。

这种方式适用于那些对数据精确性要求不高的场景,比如音频和视频文件的压缩。

而无损压缩则是保留了原始数据的全部信息,在解压缩后可以完全恢复原始数据。

二、数据压缩在不同领域的应用1. 多媒体数据压缩多媒体数据压缩是最广泛应用和研究的领域之一。

图像、音频和视频等多媒体数据通常具有大量冗余信息,通过数据压缩可以减少数据的存储空间和传输带宽。

在图像压缩中,常用的压缩算法有JPEG和PNG,它们采用了有损和无损的压缩方式。

音频和视频压缩则采用了一系列复杂的压缩算法,如MP3和H.264。

2. 网络传输数据压缩随着互联网和移动通信的普及,网络传输数据压缩成为了一项重要的技术。

压缩后的数据可以降低网络延迟,提高传输速度,节省带宽资源。

在网络传输中,压缩算法主要通过减少数据量或数据冗余来实现。

常用的压缩算法有GZIP和Deflate,它们被广泛应用于HTTP协议中的数据压缩。

3. 数据库数据压缩数据库中存储的数据往往占据大量的存储空间,通过数据压缩可以大幅度提高数据库的存储效率。

数据库数据压缩算法主要分为两类:字典压缩和编码压缩。

字典压缩是通过维护一个数据字典来实现的,将重复出现的数据存储为索引,并用较小的数据表示。

编码压缩则是通过对数据进行编码来减小存储空间。

三、数据压缩的最新研究进展1. 深度学习在数据压缩中的应用近年来,深度学习在数据压缩领域取得了显著的研究成果。

传统的数据压缩算法通常需要手工设计特征和编码规则,而深度学习可以通过训练神经网络自动学习数据的表达和压缩方式。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2019/2/24

2章 数据无损压缩

20

2.2.2 霍夫曼编码— Case Study 1 (续2)

(1) 计算该字符串的霍夫曼码

步骤①:按照符号出现概率大小的顺序对符号进行排序 步骤②:把概率最小的两个符号组成一个节点P1 步骤③:重复步骤②,得到节点P2,P3,P4,……, PN,形成一棵树,其中的PN称为根节点 步骤④:从根节点PN开始到每个符号的树叶,从上到下 标上0(上枝)和1(下枝),至于哪个为1哪个为0则 无关紧要,但通常把概率大的标成1,概率小的 标成0 步骤⑤:从根节点PN开始顺着树枝到每个叶子分别写出 每个符号的代码

2019/2/24

2章 数据无损压缩

8

2.1 数据的冗余(续2)

信息量(information content)

具有确定概率事件的信息的定量度量 在数学上定义为

I ( x )l o g [ 1 /( p x ) ] l o g p ( x ) 2 2 其中, p ( x ) 是事件出现的概率

一个等概率事件的集合,每个事件的信息量等于该 集合的决策量

2章 数据无损压缩

2019/2/24

9

2.1 数据的冗余(续3)

熵(entropy)

按照香农(Shannon)的理论,在有限的互斥和联合穷举事件的 集合中,熵为事件的信息量的平均值,也称事件的平均信息 量(mean information content) 用数学表示为

(2) 符号编码

对每个符号进行编码时采用“从上到下”的方法。 首先按照符号出现的频度或概率排序,如A,B,C, D和E,见表2-2。然后使用递归方法分成两个部分, 每一部分具有近似相同的次数,如图2-1所示

2019/2/24

2章 数据无损压缩

16

2.2.1 香农-范诺编码(续3)

图2-1 香农-范诺算法编码举例

2.2 统计编码

2.2.1 香农-范诺编码 2.2.2 霍夫曼编码 2.2.3 算术编码

参考文献和站点

2019/2/24

2章 数据无损压缩

2

三种多媒体数据类型

数据本身存在冗余 听觉系统的敏感度有限 视觉系统的敏感度有限 文字 (text)数据——无损压缩

2019/2/24

2章 数据无损压缩

19

2.2.2 霍夫曼编码— Case Study 1 (续1)

符号出现的概率

符号 B A C D E 合计 出现的次数 log2(1/pi) 分配的代码 需要的位数 10 8 3 4 5 30 1.585 1.907 3.322 2.907 2.585 ? ? ? ? ?

Master's thesis, A symbolic analysis of relay and switching circuits Doctoral thesis: on theoretical genetics

In 1948:

A mathematical theory of communication, landmark, climax (An important feature of Shannon's theory: concept of entropy )

(1) 计算该图像可能获得的压缩比的理论值 (2) 对5个符号进行编码 (3) 计算该图像可能获得的压缩比的实际值 表2-1 符号在图像中出现的数目

符号 A B C D E

出现的次数 出现的概率

2019/2/24

15 15/4 0

7 7/40

7 7/40

6 6/40

5 5/40

14

2章 数据无损压缩

这个数值表明,每个符号不需要用3位构成的代码 表示,而用2.196位就可以,因此40个像素只需用 87.84位就可以,因此在理论上,这幅图像的的压缩 比为120:87.84≈1.37:1,实际上就是3:2.196≈1.37

2章 数据无损压缩

2019/2/24

15

2.2.1 香农-范诺编码(续2)

2章 数据无损压缩

数据无损压缩的方法

2019/2/24

4

2.0 数据无损压缩概述(续2)

信息论之父介绍

The Father of Information Theory—— Claude Elwood Shannon

Born: 30 April 1916 in Gaylord, Michigan, USA Died: 24 Feb 2001 in Medford, Massachusetts, USA

i 1 n

p ( A ) l o g ( p ( A ) ) p ( B ) l o g ( p ( B ) ) p ( E ) l o g ( p ( E ) ) 2 2 2 = ( 1 5 / 4 0 ) l o g ( 4 0 / 1 5 ) + ( 7 / 4 0 ) l o g ( 4 0 / 7 ) + + ( 5 / 4 0 ) l o g ( 4 0 / 5 ) 2 . 1 9 6 2 2 2

2章 数据无损压缩

编码方法

编码特性

2019/2/24

12

2.2.1 统计编码——香农-范诺编码

香农-范诺编码(Shannon–Fano coding)

在香农的源编码理论中,熵的大小表示非冗余的不 可压缩的信息量 在计算熵时,如果对数的底数用2,熵的单位就用 “香农(Sh)”,也称“位(bit)” 。“位”是1948年 Shannon首次使用的术语。例如

2019/2/24

2章 数据无损压缩

10

2.1 数据的冗余(续4)

数据的冗余量

2019/2/24

2章 数据无损压缩

11

2.2 统计编码

统计编码

给已知统计信息的符号分配代码的数据无损压缩方法 香农-范诺编码 霍夫曼编码 算术编码 香农-范诺编码和霍夫曼编码的原理相同,都是根据符 号集中各个符号出现的频繁程度来编码,出现次数越 多的符号,给它分配的代码位数越少 算术编码使用0和1之间的实数的间隔长度代表概率大 小,概率越大间隔越长,编码效率可接近于熵

(3)压缩比的实际值

按照这种方法进行编码需要的总位数为 30+14+14+18+15=91,实际的压缩比为 120:91≈1.32 : 1

2章 数据无损压缩

2019/2/24

17

2.2.2 统计编码——霍夫曼编码

霍夫曼编码(Huffman coding)

霍夫曼(D.A. Huffman)在1952年提出和描述的 “从下到上”的熵编码方法 根据给定数据集中各元素所出现的频率来压 缩数据的一种统计压缩编码方法。这些元素 (如字母)出现的次数越多,其编码的位数就越 少 广泛用在JPEG, MPEG, H.26X等各种信息编码 标准中

多媒体技术基础(第3版)

第2章 数据无损压缩

林福宗 清华大学 计算机科学与技术系 2008年9月

第2章 数据无损压缩目录

2.1 数据的冗余

2.1.1 冗余概念 2.1.2 决策量 2.1.3 信息量 2.1.4 熵 2.1.5 数据冗余量

2.3 RLE编码 2.4 词典编码

2.4.1 词典编码的思想 2.4.2 LZ77算法 2.4.3 LZSS算法 2.4.4 LZ78算法 2.4.5 LZW算法

举例:假设X={a,b,c}是由3个事件构成的集合, p(a)=0.5,p(b)=0.25,p(b)=0.25分别是事件a, b和c出 现的概率,这些事件的信息量分别为,

I(a)=log2(1/0.50)=1 sh I(b)=log2(1/0.25)=2 sh I(c)=log2(1/0.25)=2 sh

根据数据本身的冗余(Based on data redundancy) 根据数据本身的冗余(Based on data redundancy) 根据人的听觉系统特性( Based on human hearing system) 根据数据本身的冗余(Based on data redundancy) 根据人的视觉系统特性(Based on human visual system)

/news/2001/february/26/1.html

2019/2/24

2章 数据无损压缩

5

2.0 数据无损压缩概述(续3)

Claude Shannon ——The founding father of electronic communications age; American mathematical engineer In 1936~1940, MIT:

2.2.1 香农-范诺编码(续1)

(1) 压缩比的理论值

按照常规的编码方法,表示5个符号最少需要3位, 如用000表示A,001表示B,…,100表示E,其余3 个代码 (101,110,111)不用。这就意味每个像素用 3位,编码这幅图像总共需要120位。按照香农理论, 这幅图像的熵为

H ( X ) p ( x ) l o g p ( x ) i 2 i