Ch4-Hadoop MapReduce

简述mapreduce的工作流程

简述mapreduce的工作流程

MapReduce是一种分布式数据处理模型,它由Google提出,用于处理海量的数据。

它由map和reduce两个阶段组成,是一种函数式编程模型。

MapReduce的工作流程如下:

1. Map阶段:

该阶段是分割数据的过程,它将大量的数据分隔成小块,并将每个数据块分发到不同的机器上进行处理;

2. Reduce阶段:

该阶段是合并数据的过程,它将map阶段产生的数据块组织成一个完整的结果。

3. JobTracker:

该阶段是调度map和reduce阶段的阶段。

它将map和reduce阶段按照用户给定的参数调度到不同的机器上执行。

4. TaskTracker:

该阶段是运行map和reduce阶段的阶段,它根据jobtracker调度的参数,在不同的机器上执行map和reduce阶段的任务。

5. HDFS:

HDFS是运行mapreduce任务所必须的Hadoop分布式文件系统,它可以把大量的数据存储在不同的机器上,以便mapreduce能更有效地处理数据。

6. Output:

mapreduce最后的输出是由reduce阶段产生的,它是mapreduce 处理的最终结果。

Hadoop 生态系统介绍

Hadoop 生态系统介绍Hadoop生态系统是一个开源的大数据处理平台,它由Apache基金会支持和维护,可以在大规模的数据集上实现分布式存储和处理。

Hadoop生态系统是由多个组件和工具构成的,包括Hadoop 核心,Hive、HBase、Pig、Spark等。

接下来,我们将对每个组件及其作用进行介绍。

一、Hadoop核心Hadoop核心是整个Hadoop生态系统的核心组件,它主要由两部分组成,一个是Hadoop分布式文件系统(HDFS),另一个是MapReduce编程模型。

HDFS是一个高可扩展性的分布式文件系统,可以将海量数据存储在数千台计算机上,实现数据的分散储存和高效访问。

MapReduce编程模型是基于Hadoop的针对大数据处理的一种模型,它能够对海量数据进行分布式处理,使大规模数据分析变得容易和快速。

二、HiveHive是一个开源的数据仓库系统,它使用Hadoop作为其计算和存储平台,提供了类似于SQL的查询语法,可以通过HiveQL 来查询和分析大规模的结构化数据。

Hive支持多种数据源,如文本、序列化文件等,同时也可以将结果导出到HDFS或本地文件系统。

三、HBaseHBase是一个开源的基于Hadoop的列式分布式数据库系统,它可以处理海量的非结构化数据,同时也具有高可用性和高性能的特性。

HBase的特点是可以支持快速的数据存储和检索,同时也支持分布式计算模型,提供了易于使用的API。

四、PigPig是一个基于Hadoop的大数据分析平台,提供了一种简单易用的数据分析语言(Pig Latin语言),通过Pig可以进行数据的清洗、管理和处理。

Pig将数据处理分为两个阶段:第一阶段使用Pig Latin语言将数据转换成中间数据,第二阶段使用集合行处理中间数据。

五、SparkSpark是一个快速、通用的大数据处理引擎,可以处理大规模的数据,支持SQL查询、流式数据处理、机器学习等多种数据处理方式。

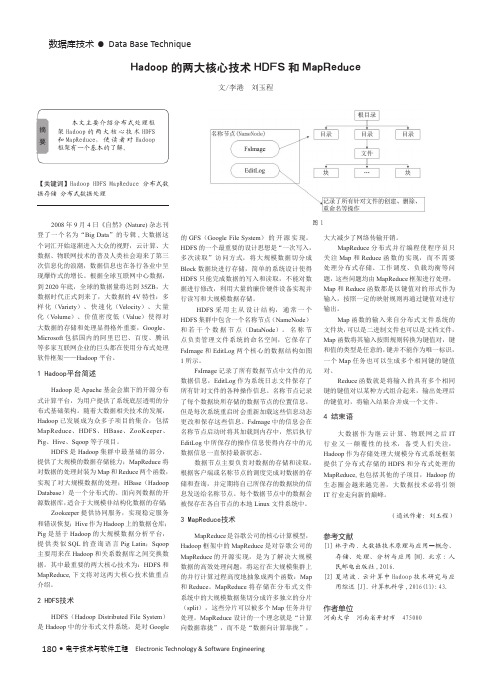

Hadoop的两大核心技术HDFS和MapReduce

Hadoop的两大核心技术HDFS和MapReduce作者:李港刘玉程来源:《电子技术与软件工程》2018年第07期摘要本文主要介绍分布式处理框架Hadoop的两大核心技术HDFS和MapReduce,使读者对Hadoop框架有一个基本的了解。

【关键词】Hadoop HDFS MapReduce 分布式数据存储分布式数据处理2008年9月4日《自然》(Nature)杂志刊登了一个名为“Big Data”的专辑,大数据这个词汇开始逐渐进入大众的视野,云计算、大数据、物联网技术的普及人类社会迎来了第三次信息化的浪潮,数据信息也在各行各业中呈现爆炸式的增长。

根据全球互联网中心数据,到2020年底,全球的数据量将达到35ZB,大数据时代正式到来了,大数据的4V特性:多样化( Variety)、快速化(Velocity)、大量化( Volume)、价值密度低(Value)使得对大数据的存储和处理显得格外重要,Google、Microsoft包括国内的阿里巴巴、百度、腾讯等多家互联网企业的巨头都在使用分布式处理软件框架--Hadoop平台。

1 Hadoop平台简述Hadoop是Apache基金会旗下的开源分布式计算平台,为用户提供了系统底层透明的分布式基础架构。

随着大数据相关技术的发展,Hadoop已发展成为众多子项目的集合,包括MapReduce. HDFS. HBase. ZooKeeper.Pig、Hive、Sqoop等子项目。

HDFS是Hadoop集群中最基础的部分,提供了大规模的数据存储能力;MapReduce将对数据的处理封装为Map和Reduce两个函数,实现了对大规模数据的处理;HBase (HadoopDatabase)是一个分布式的、面向列数据的开源数据库,适合于大规模非结构化数据的存储Zookeeper提供协同服务,实现稳定服务和错误恢复;Hive作为Hadoop上的数据仓库;Pig 是基于Hadoop的大规模数据分析平台,提供类似SQL的查询语言Pig Latin; Sqoop主要用来在Hadoop和关系数据库之间交换数据。

hadoop基本架构和工作原理

hadoop基本架构和工作原理Hadoop是一个分布式开源框架,用于处理海量数据。

它能够使用廉价的硬件来搭建集群,同时还提供了高度可靠性和容错性。

Hadoop基本架构包括Hadoop Common、Hadoop Distributed File System (HDFS)和Hadoop MapReduce三个部分,下面将详细介绍Hadoop的工作原理。

1. Hadoop CommonHadoop Common是整个Hadoop架构的基础部分,是一个共享库,它包含了大量的Java类和应用程序接口。

Hadoop集群的每一台机器上都要安装Hadoop Common,并保持相同版本。

2. HDFSHadoop Distributed File System(HDFS)是Hadoop的分布式文件存储部分。

它的目的是将大型数据集分成多个块,并且将这些块在集群中的多个节点间分布式存储。

HDFS可以实现高度可靠性,因为它将每个块在存储节点之间备份。

HDFS可以在不同的节点中进行数据备份,这确保了数据发生故障时,可以轻松恢复。

3. MapReduceHadoop MapReduce是一种编程模型,用于处理大型数据集。

它将处理任务分成两个主要阶段,即Map阶段和Reduce阶段。

在Map阶段,MapReduce将数据集分成小块,并将每个块分配给不同的节点进行处理。

在Reduce阶段,结果被聚合,以生成最终的输出结果。

总的来说,MapReduce作为Hadoop的核心组件,负责对数据集进行处理和计算。

它充当的角色是一个调度员,它会将不同的任务分发到集群中的不同节点上,并尽力保证每个任务都可以获得足够的计算资源。

Hadoop采用多种技术来提供MapReduce的分布式计算能力,其中包括TaskTracker、JobTracker和心跳机制等。

TaskTracker是每个集群节点的一个守护程序,负责处理MapReduce任务的具体实现。

mapreduce的核心概念

mapreduce的核心概念

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。

其核心概念包括“Map(映射)”和“Reduce(归约)”。

MapReduce

把整个并行运算过程高度抽象到两个函数上,一个是Map函数,另一个是Reduce函数。

Map函数会将小的数据集转换为适合输入的<key,value>键值对的形式,

然后处理成一系列具有相同key的<key,value>作为输出,可以看做

list(<key,value>)。

Reduce函数会把Map函数的输出作为输入,然后提

取具有相同key的元素,并进行操作,最后的输出结果也是<key,value>键值对的形式,并合并成一个文件。

“分而治之”是MapReduce的核心思想,它表示把一个大规模的数据集切分成很多小的单独的数据集,然后放在多个机器上同时处理。

这种思想类似于制作三明治的例子,即把一个复杂的任务分解成多个小任务,然后分发给不同的人或机器同时处理,以提高效率。

以上内容仅供参考,建议查阅关于MapReduce的书籍或咨询技术人员以获取更多信息。

Hadoop MapReduce简介

Hadoop MapReduce简介本节首先简单介绍大数据批处理概念,然后介绍典型的批处理模式MapReduce,最后对Map 函数和Reduce 函数进行描述。

批处理模式批处理模式是一种最早进行大规模数据处理的模式。

批处理主要操作大规模静态数据集,并在整体数据处理完毕后返回结果。

批处理非常适合需要访问整个数据集合才能完成的计算工作。

例如,在计算总数和平均数时,必须将数据集作为一个整体加以处理,而不能将其视作多条记录的集合。

这些操作要求在计算进行过程中数据维持自己的状态。

需要处理大量数据的任务通常最适合用批处理模式进行处理,批处理系统在设计过程中就充分考虑了数据的量,可提供充足的处理资源。

由于批处理在应对大量持久数据方面的表现极为出色,因此经常被用于对历史数据进行分析。

为了提高处理效率,对大规模数据集进行批处理需要借助分布式并行程序。

传统的程序基本是以单指令、单数据流的方式按顺序执行的。

这种程序开发起来比较简单,符合人们的思维习惯,但是性能会受到单台计算机的性能的限制,很难在给定的时间内完成任务。

而分布式并行程序运行在大量计算机组成的集群上,可以同时利用多台计算机并发完成同一个数据处理任务,提高了处理效率,同时,可以通过增加新的计算机扩充集群的计算能力。

Google 最先实现了分布式并行处理模式MapReduce,并于2004 年以论文的方式对外公布了其工作原理,Hadoop MapReduce 是它的开源实现。

Hadoop MapReduce 运行在HDFS 上。

MapReduce 简释如图1 所示,如果我们想知道相当厚的一摞牌中有多少张红桃,最直观的方式就是一张张检查这些牌,并且数出有多少张是红桃。

这种方法的缺陷是速度太慢,特别是在牌的数量特别高的情况下,获取结果的时间会很长。

图1 找出有多少张红桃MapReduce 方法的规则如下。

∙把这摞牌分配给在座的所有玩家。

∙让每个玩家数自己手中的牌中有几张是红桃,然后把这个数目汇报上来。

Hadoop的两大核心技术HDFS和MapReduce

180 •电子技术与软件工程 Electronic Technology & Software Engineering数据库技术• Data Base Technique【关键词】Hadoop HDFS MapReduce 分布式数据存储 分布式数据处理2008年9月4日《自然》(Nature)杂志刊登了一个名为“Big Data ”的专辑,大数据这个词汇开始逐渐进入大众的视野,云计算、大数据、物联网技术的普及人类社会迎来了第三次信息化的浪潮,数据信息也在各行各业中呈现爆炸式的增长。

根据全球互联网中心数据,到2020年底,全球的数据量将达到35ZB ,大数据时代正式到来了,大数据的4V 特性:多样化(Variety )、快速化(Velocity )、大量化(V olume )、价值密度低(Value )使得对大数据的存储和处理显得格外重要,Google 、Microsoft 包括国内的阿里巴巴、百度、腾讯等多家互联网企业的巨头都在使用分布式处理软件框架——Hadoop 平台。

1 Hadoop平台简述Hadoop 是Apache 基金会旗下的开源分布式计算平台,为用户提供了系统底层透明的分布式基础架构。

随着大数据相关技术的发展,Hadoop 已发展成为众多子项目的集合,包括MapReduce 、HDFS 、HBase 、ZooKeeper 、Pig 、Hive 、Sqoop 等子项目。

HDFS 是Hadoop 集群中最基础的部分,提供了大规模的数据存储能力;MapReduce 将对数据的处理封装为Map 和Reduce 两个函数,实现了对大规模数据的处理;HBase (Hadoop Database )是一个分布式的、面向列数据的开源数据库,适合于大规模非结构化数据的存储;Zookeeper 提供协同服务,实现稳定服务和错误恢复;Hive 作为Hadoop 上的数据仓库;Pig 是基于Hadoop 的大规模数据分析平台,提供类似SQL 的查询语言Pig Latin ;Sqoop 主要用来在Hadoop 和关系数据库之间交换数据。

hadoop用法之mapreduce的应用场景

hadoop⽤法之mapreduce的应⽤场景本节和⼤家⼀起学习⼀下Hadoop,通过它的实际应⽤来向⼤家展⽰它的功能,从⽽使读者更容易了解,希望通过本节的介绍⼤家对Hadoop 有初步的了解。

Hadoop最佳实践1.简介Hadoop是Apache⾃由软件基⾦会资助的顶级项⽬,致⼒于提供基于map-reduce计算模型的⾼效、可靠、⾼扩展性分布式计算平台。

2.Map-Reduce应⽤场景作为⼀种受限的分布式计算模型,Map-Reduce计算模型有其擅长的领域,也有其不擅长的⽅⾯:条款1:map-reduce计算模型适⽤于批处理任务,即在可接受的时间内对整个数据集计算某个特定的查询的结果,该计算模型不适合需要实时反映数据变化状态的计算环境。

条款2:map-reduce计算模型是以“⾏”为处理单位的,⽆法回溯已处理过的“⾏”,故每⾏⽇志都必须是⼀个独⽴的语义单元,⾏与⾏之间不能有语义上的关联。

条款3:相对于传统的关系型数据库管理系统,Map-Reduce计算模型更适合于处理半结构化或⽆结构话的数据。

因为Map-Reduce计算模型是在处理的时候对数据进⾏解释的,这就意味着输⼊的Key和Value可以不是数据本⾝固有的属性,Key、Value 的选择完全取决于分析数据的⼈。

条款4:Map-Reduce是⼀个线性可扩展模型,服务器越多,处理时间越短。

以下是同⼀个任务在不同机器数下获得的测试结果:3.任务调度优化⾸先对⼀些术语进⾏⼀下说明。

Job是⼀组客服端想要完成的⼯作,包括输⼊数据,map-reduce程序以及配置信息,Hadoop通过将Job划分为⼀些task来执⾏,task⼜分为maptask和reducetask。

如何调度Hadoop任务才能充分发挥集群中所有服务器的能⼒呢?条款5:每个Job的输⼊⽂件不宜过⼤,也不宜过⼩。

⽂件过⼤会造成reduce任务分布不均匀,导致reducetime的不可预知性,⽽⼤量的⼩⽂件则会严重影响Hadoop的性能。

简述hadoop核心组件及功能应用

简述hadoop核心组件及功能应用Hadoop是一个开源的分布式计算系统,由Apache组织维护。

它可以处理大量的数据,支持数据的存储、处理和分析。

其核心组件包括HDFS(Hadoop分布式文件系统)、MapReduce计算框架、YARN(资源管理)。

以下是对每个核心组件的简要介绍:1. HDFSHDFS是Hadoop分布式文件系统,它是Hadoop最核心的组件之一。

HDFS是为大数据而设计的分布式文件系统,它可以存储大量的数据,支持高可靠性和高可扩展性。

HDFS的核心目标是以分布式方式存储海量数据,并为此提供高可靠性、高性能、高可扩展性和高容错性。

2. MapReduce计算框架MapReduce是Hadoop中的一种计算框架,它支持分布式计算,是Hadoop的核心技术之一。

MapReduce处理海量数据的方式是将数据拆分成小块,然后在多个计算节点上并行运行Map和Reduce任务,最终通过Shuffle将结果合并。

MapReduce框架大大降低了海量数据处理的难度,让分布式计算在商业应用中得以大规模应用。

3. YARNYARN是Hadoop 2.x引入的新一代资源管理器,它的作用是管理Hadoop集群中的资源。

它支持多种应用程序的并行执行,包括MapReduce和非MapReduce应用程序。

YARN的目标是提供一个灵活、高效和可扩展的资源管理器,以支持各种不同类型的应用程序。

除了以上三个核心组件,Hadoop还有其他一些重要组件和工具,例如Hive(数据仓库)、Pig(数据分析)、HBase(NoSQL数据库)等。

这些组件和工具都是Hadoop生态系统中的重要组成部分,可以帮助用户更方便地处理大数据。

总之,Hadoop是目前最流行的大数据处理框架之一,它的核心组件和工具都为用户提供了丰富的数据处理和分析功能。

如何在Hadoop中使用MapReduce进行数据分析

如何在Hadoop中使用MapReduce进行数据分析在当今信息爆炸的时代,数据分析已经成为了企业和组织决策的重要工具。

而Hadoop作为一个开源的分布式计算框架,提供了强大的数据处理和分析能力,其中的MapReduce就是其核心组件之一。

本文将介绍如何在Hadoop中使用MapReduce进行数据分析。

首先,我们需要了解MapReduce的基本原理。

MapReduce是一种分布式计算模型,它将大规模的数据集划分成若干个小的数据块,然后通过Map和Reduce两个阶段进行并行处理。

在Map阶段,数据集会被分割成若干个键值对,每个键值对由一个键和一个值组成。

然后,Map函数会对每个键值对进行处理,生成一个新的键值对。

在Reduce阶段,相同键的值会被分组在一起,然后Reduce函数会对每个键的值进行聚合和处理,最终生成最终的结果。

在Hadoop中使用MapReduce进行数据分析的第一步是编写Map和Reduce函数。

在编写Map函数时,我们需要根据具体的数据分析任务来定义键值对的格式和生成方式。

例如,如果我们要统计某个网站的访问量,那么键可以是网站的URL,值可以是1,表示一次访问。

在Reduce函数中,我们需要根据具体的需求来定义对键的值进行聚合和处理的方式。

例如,如果我们要统计每个网站的总访问量,那么Reduce函数可以将所有的值相加得到最终的结果。

编写好Map和Reduce函数后,我们需要将数据加载到Hadoop中进行分析。

在Hadoop中,数据通常以HDFS(Hadoop Distributed File System)的形式存储。

我们可以使用Hadoop提供的命令行工具或者编写Java程序来将数据加载到HDFS 中。

加载完成后,我们就可以使用Hadoop提供的MapReduce框架来进行数据分析了。

在运行MapReduce任务之前,我们需要编写一个驱动程序来配置和提交任务。

在驱动程序中,我们需要指定Map和Reduce函数的类名、输入数据的路径、输出数据的路径等信息。

基于Hadoop的MapReduce分析共19页

2 MapReduce能做什么,不能做什么

解决办法:

Bulk Synchronous Programming,BSP 大同步编程模型

3 Hadoop-MapReduce 技术简介

3 Hadoop-MapReduce 技术简介

1 分布式并行计算 MapReduce框架是由JobTracker和TaskTracker两类服务 调度的。JobTracker是主控服务,只有一个,负责调度和 管理TaskTracker,把Map任务和Reduce任务分配给空闲 的TaskTracker,使这些服务并行运行,并监控任务的运 行情况。TaskTracker是从服务,可以有多个,负责执行 任务。如果某个TaskTracker执行失败或者出现故障, JobTracker将这一任务分发给其他空闲的TaskTracker中。

4 Hadoop-MapReduce程序性能调优

4.1 从应用程序角度进行优化

4.1.1 避免不必要的reduce任务。对于 4.1.2 外部文件引入,可以将文件通过DistributedCache放入缓存中,以在

多个task之间共享文件。

例子:JNI ,索引文件,基本数据的共享

4.1.3 考虑combiner

下一代MapReduce(YARN/MRv2)

• 状态机:每个对象被建模成有限状态机

下一代MapReduce(YARN/MRv2)

• 基于actors model的事件模型

[1] 每一个计算实体可以: 1 向其他actor发送有限个信息 2 收到的消息时触发一个行为 3 创建若干个新的aARN/MRv2)

• Hadoop 0.23.0是一个通用的资源分配框架,它不仅 支持MapReduce计算框架,同时也支持流式计算框 架,迭代计算框架。它实现时采用基于了事件驱动机 制,异步编程模型,如下图所示:

使用Hadoop MapReduce高效处理大规模数据的方法

使用Hadoop MapReduce高效处理大规模数据的方法随着互联网的快速发展,大规模数据的处理成为了一个重要的挑战。

传统的数据处理方法已经无法满足这一需求,因此,使用Hadoop MapReduce成为了一种高效处理大规模数据的方法。

一、Hadoop MapReduce的基本原理Hadoop MapReduce是一种分布式计算模型,它将大规模数据划分为多个小块,并将这些小块分发到不同的计算节点上进行并行处理。

其基本原理可以概括为以下几个步骤:1. 输入数据划分:将大规模数据划分为多个小块,每个小块的大小通常为64MB或128MB。

2. Map阶段:在每个计算节点上,对输入数据进行处理,生成中间结果。

这个阶段可以并行处理多个小块。

3. Shuffle阶段:将Map阶段生成的中间结果按照键值对进行排序,并将相同键的值归并在一起,以便进行后续的处理。

4. Reduce阶段:对Shuffle阶段生成的中间结果进行处理,得到最终的结果。

二、优化Hadoop MapReduce的性能虽然Hadoop MapReduce能够高效处理大规模数据,但是在实际应用中,还存在一些性能瓶颈。

下面介绍一些优化Hadoop MapReduce性能的方法。

1. 数据本地化:在MapReduce任务中,数据的传输是一个耗时的操作。

为了减少数据传输的开销,可以将计算节点的选择与数据的位置相匹配,尽量将计算任务分配到存储数据的节点上进行处理。

2. 压缩数据:大规模数据的处理通常需要大量的磁盘空间。

为了减少磁盘空间的占用,可以对输入数据进行压缩,减少存储和传输的开销。

同时,在Map阶段和Reduce阶段的中间结果也可以进行压缩,以减少网络传输的开销。

3. 合并小文件:在Hadoop中,每个小文件都会占用一个数据块的存储空间,这样会导致存储空间的浪费。

可以将多个小文件合并成一个大文件,减少存储空间的占用。

4. 调整任务数量:在Hadoop MapReduce中,任务的数量对性能有很大的影响。

hadoop介绍讲解

hadoop介绍讲解Hadoop是一个由Apache软件基金会开发的开源分布式系统。

它的目标是处理大规模数据集。

Hadoop可以更好地利用一组连接的计算机和硬件来存储和处理海量数据集。

Hadoop主要由Hadoop分布式文件系统(HDFS)和MapReduce两部分组成。

以下是hadoop的详细介绍。

1. Hadoop分布式文件系统(HDFS)HDFS是Hadoop的分布式文件系统。

HDFS将大量数据分成小块并在多个机器上进行存储,从而使数据更容易地管理和处理。

HDFS适合在大规模集群上存储和处理数据。

它被设计为高可靠性,高可用性,并且容错性强。

2. MapReduceMapReduce是Hadoop中的计算框架。

它分为两个阶段:Map和Reduce。

Map阶段将数据分为不同的片段,并将这些片段映射到不同的机器上进行并行处理,Reduce阶段将结果从Map阶段中得到,并将其组合在一起生成最终的结果。

MapReduce框架根据数据的并行处理进行拆分,而输出结果则由Reduce阶段组装而成。

3. Hadoop生态系统Hadoop是一个开放的生态系统,其包含了许多与其相关的项目。

这些项目包括Hive,Pig,Spark等等。

Hive是一个SQL on Hadoop工具,用于将SQL语句转换为MapReduce作业。

Pig是另一个SQL on Hadoop工具,它是一个基于Pig Latin脚本语言的高级并行运算系统,可以用于处理大量数据。

Spark是一个快速通用的大数据处理引擎,它减少了MapReduce 的延迟并提供了更高的数据处理效率。

4. Hadoop的优点Hadoop是一个灵活的、可扩展的与成本优势的平台,它可以高效地处理大规模的数据集。

同时,它的开放式和Modular的体系结构使得其在大数据环境下无论是对数据的处理还是与其他开发者的协作都非常便利。

5. 总结Hadoop是一个很好的大数据处理工具,并且在行业中得到了广泛的应用。

请简述hadoop框架中的核心组件和其作用

请简述hadoop框架中的核心组件和其作用

Hadoop框架中的核心组件包括HDFS(分布式文件系统)、MapReduce(分布式计算)和YARN(资源调度)。

1.HDFS:HDFS是一个分布式文件系统,它将数据划分为多个块,并存储在多个数据节点上。

它能够提供高吞吐量的数据存储,并确保数据的安全性和可靠性。

2.MapReduce:MapReduce是一个编程模型,它允许用户编写分布式程序来处理大规模数据集。

它将数据划分为多个小任务,并在集群中的多个节点上并行执行这些任务,从而加快数据处理速度。

3.YARN:YARN是一个资源调度框架,它负责管理和调度集群中的资源,以便MapReduce和其他应用程序可以有效地使用这些资源。

它允许用户根据需要分配计算资源,并确保资源的使用是高效和可靠的。

总的来说,Hadoop框架中的这些核心组件协同工作,能够实现大规模数据的分布式处理和存储,从而提高数据处理速度和效率。

请简述hadoop的体系结构和主要组件。

请简述hadoop的体系结构和主要组件。

Hadoop是一个分布式计算框架,旨在帮助开发者构建大规模数据处理系统。

Hadoop的体系结构和主要组件包括:1. Hadoop HDFS:Hadoop的核心文件系统,用于存储和管理数据。

HDFS采用块存储,每个块具有固定的大小,支持数据的分片和分布式访问。

2. Hadoop MapReduce:Hadoop的主要计算引擎,将数据处理任务分解为小块并分配给多个计算节点进行并行处理。

MapReduce算法可以处理大规模数据,并实现高效的数据处理。

3. Mapper:Mapper是MapReduce中的一个核心组件,负责将输入数据映射到输出数据。

Mapper通常使用特定的语言处理数据,并将其转换为机器可以理解的形式。

4.Reducer:Reducer是MapReduce的另一个核心组件,负责将输出数据分解为较小的子数据,以便Mapper进行进一步处理。

5. Hive:Hive是一种查询引擎,允许用户在HDFS上执行离线查询。

Hive支持多种查询语言,并支持并行查询。

6. HBase:HBase是一种分布式数据库,用于存储大规模数据。

HBase采用B 树结构来存储数据,并支持高效的查询和排序。

7. Kafka:Kafka是一种分布式流处理引擎,用于处理大规模数据流。

Kafka 支持实时数据处理,并可用于数据共享、实时分析和监控等应用。

8. YARN:YARN是Hadoop的生态系统中的一个子系统,用于支持分布式计算和资源管理。

YARN与HDFS一起工作,支持应用程序在Hadoop集群中的部署和管理。

Hadoop的体系结构和主要组件提供了一种处理大规模数据的有效方法。

随着数据量的不断增加和数据处理需求的不断提高,Hadoop将继续发挥着重要的作用。

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案第一章:Hadoop概述1.1 Hadoop简介了解Hadoop的发展历程理解Hadoop的核心价值观:可靠性、可扩展性、容错性1.2 Hadoop生态系统掌握Hadoop的主要组件:HDFS、MapReduce、YARN理解Hadoop生态系统中的其他重要组件:HBase、Hive、Pig等1.3 Hadoop安装与配置掌握Hadoop单机模式安装与配置掌握Hadoop伪分布式模式安装与配置第二章:HDFS文件系统2.1 HDFS简介理解HDFS的设计理念:大数据存储、高可靠、高吞吐掌握HDFS的基本架构:NameNode、DataNode2.2 HDFS操作命令掌握HDFS的基本操作命令:mkdir、put、get、dfsadmin等2.3 HDFS客户端编程掌握HDFS客户端API:Configuration、FileSystem、Path等第三章:MapReduce编程模型3.1 MapReduce简介理解MapReduce的设计理念:将大数据处理分解为简单的任务进行分布式计算掌握MapReduce的基本概念:Map、Shuffle、Reduce3.2 MapReduce编程步骤掌握MapReduce编程的四大步骤:编写Map函数、编写Reduce函数、设置输入输出格式、设置其他参数3.3 典型MapReduce应用掌握WordCount案例的编写与运行掌握其他典型MapReduce应用:排序、求和、最大值等第四章:YARN资源管理器4.1 YARN简介理解YARN的设计理念:高效、灵活、可扩展的资源管理掌握YARN的基本概念:ResourceManager、NodeManager、ApplicationMaster等4.2 YARN运行流程掌握YARN的运行流程:ApplicationMaster申请资源、ResourceManager 分配资源、NodeManager执行任务4.3 YARN案例实战掌握使用YARN运行WordCount案例掌握YARN调优参数设置第五章:Hadoop生态系统扩展5.1 HBase数据库理解HBase的设计理念:分布式、可扩展、高可靠的大数据存储掌握HBase的基本概念:表结构、Region、Zookeeper等5.2 Hive数据仓库理解Hive的设计理念:将SQL查询转换为MapReduce任务进行分布式计算掌握Hive的基本操作:建表、查询、数据导入导出等5.3 Pig脚本语言理解Pig的设计理念:简化MapReduce编程的复杂度掌握Pig的基本语法:LOAD、FOREACH、STORE等第六章:Hadoop生态系统工具6.1 Hadoop命令行工具掌握Hadoop命令行工具的使用:hdfs dfs, yarn命令等理解命令行工具在Hadoop生态系统中的作用6.2 Hadoop Web界面熟悉Hadoop各个组件的Web界面:NameNode, JobTracker, ResourceManager等理解Web界面在Hadoop生态系统中的作用6.3 Hadoop生态系统其他工具掌握Hadoop生态系统中的其他工具:Azkaban, Sqoop, Flume等理解这些工具在Hadoop生态系统中的作用第七章:MapReduce高级编程7.1 二次排序理解二次排序的概念和应用场景掌握MapReduce实现二次排序的编程方法7.2 数据去重理解数据去重的重要性掌握MapReduce实现数据去重的编程方法7.3 自定义分区理解自定义分区的概念和应用场景掌握MapReduce实现自定义分区的编程方法第八章:Hadoop性能优化8.1 Hadoop性能调优概述理解Hadoop性能调优的重要性掌握Hadoop性能调优的基本方法8.2 HDFS性能优化掌握HDFS性能优化的方法:数据块大小,副本系数等8.3 MapReduce性能优化掌握MapReduce性能优化的方法:JVM设置,Shuffle优化等第九章:Hadoop实战案例9.1 数据分析案例掌握使用Hadoop进行数据分析的实战案例理解案例中涉及的技术和解决问题的方法9.2 数据处理案例掌握使用Hadoop进行数据处理的实战案例理解案例中涉及的技术和解决问题的方法9.3 数据挖掘案例掌握使用Hadoop进行数据挖掘的实战案例理解案例中涉及的技术和解决问题的方法第十章:Hadoop项目实战10.1 Hadoop项目实战概述理解Hadoop项目实战的意义掌握Hadoop项目实战的基本流程10.2 Hadoop项目实战案例掌握一个完整的Hadoop项目实战案例理解案例中涉及的技术和解决问题的方法展望Hadoop在未来的发展和应用前景重点和难点解析重点环节1:Hadoop的设计理念和核心价值观需要重点关注Hadoop的设计理念和核心价值观,因为这是理解Hadoop生态系统的基础。

hadoop mapreduce的工作流程

hadoop mapreduce的工作流程

HadoopMapReduce是一个分布式计算框架,用于处理海量数据。

以下是Hadoop MapReduce的工作流程:

1. 分片数据:MapReduce将输入数据切分为若干个小块,每个小块称为一个分片。

2. 映射(Map):每个分片都会被发送到Map任务中进行处理。

Map任务读取分片中的数据,然后将其转换为键-值对。

3. 合并(Combine):可选的步骤,它在Map任务之后,Reduce 任务之前进行。

Combine任务对Map任务产生的键-值对进行合并和排序,以减少Reduce任务的工作量。

4. 分组(Partition):MapReduce将键-值对根据键进行分组。

同一个键的所有值会被发送到同一个Reduce任务中进行处理。

5. 排序(Sort):Reduce任务接收到已经分好组的键-值对后,对键进行排序,以便更容易地进行聚合操作。

6. 聚合(Reduce):Reduce任务对同一组的所有值进行聚合操作,并将结果写入输出文件。

7. 输出(Output):Reduce任务将结果写入输出文件,完成整个数据处理过程。

以上就是Hadoop MapReduce的工作流程。

通过将数据切分为小块,并对每个块进行映射、合并、分组、排序和聚合操作,MapReduce 可以高效地处理大规模数据。

- 1 -。

实验二 Hadoop环境下MapReduce并行编程

实验二Hadoop环境下MapReduce并行编程一. 实验目的1.学习MapReduce编程模型,理解MapReduce的编程思想。

会用MapReduce框架编写简单的并行程序。

2.熟悉使用eclipse编写、调试和运行MapReduce并行程序。

二. 实验内容1.登录Openstack云平台,进入搭建好Hadoop的虚拟机,按照实验指导说明,在终端启动hadoop、启动eclipse。

2.用MapReduce编程思想,修改hadoop自带的例子程序WordCount,实现如下功能:统计给定文件data.dat中出现频率最多的三个单词,并输出这三个单词和出现的次数。

(注:这里不区分字母大小写,如he与He当做是同一个单词计数)三. 实验指导1.进入虚拟机,打开终端,切换为root用户,命令使用:su root输入密码2.进入hadoop安装目录,本实验中hadoop安装目录为:/usr/local/hadoop-2.6.0/,使用ls命令查看该目录中的文件:3.所有与hadoop启动/关闭有关的脚本位于sbin目录下,所以继续进入sbin目录。

其中,hadoop2.X版本的启动命令主要用到start-dfs.sh和start-yarn.sh。

关闭hadoop主要用到stop-dfs.sh和stop-yarn.sh。

执行start-dfs.sh,然后使用jps命令查看启动项,保证NameNode和DataNode 已启动,否则启动出错:执行start-yarn.sh,jps查看时,保证以下6个启动项已启动:4.打开eclipse,在右上角进入Map/Reduce模式,建立eclispe-hadoop连接5.连接成功后,能够在(1)这个文件夹下再创建文件夹(创建后需refresh)6.建立wordcount项目,如下步骤:7.next,项目名任意(如wordcount),finish。

将WordCount.java文件复制到wordcount项目下src文件中,双击打开。

hadoop工作原理

hadoop工作原理Hadoop工作原理Hadoop是一个开源的分布式计算框架,被广泛应用于大数据处理和分析。

它的工作原理是基于分布式存储和计算的概念,能够高效地处理大规模数据集。

Hadoop的工作原理可以简单地分为两个主要部分:Hadoop分布式文件系统(Hadoop Distributed File System,简称HDFS)和Hadoop分布式计算框架(Hadoop MapReduce)。

让我们来了解HDFS。

HDFS是Hadoop的分布式文件系统,它被设计用于在大规模集群上存储和处理数据。

HDFS将大文件切分成多个数据块,然后将这些数据块分散存储在集群中的不同节点上。

每个数据块都有多个副本,这样可以提高数据的可靠性和容错性。

HDFS采用了主从架构,其中有一个主节点(NameNode)负责管理文件系统的命名空间和访问控制,以及多个从节点(DataNode)负责存储和处理数据。

当客户端需要读取或写入文件时,它会首先与主节点通信,获取文件的位置信息,然后直接与数据节点进行交互。

接下来,我们来看Hadoop MapReduce的工作原理。

MapReduce是一种编程模型,用于处理大规模数据集的并行计算。

它将计算任务分为两个阶段:Map阶段和Reduce阶段。

在Map阶段,输入数据被切分成多个独立的片段,然后由多个Map任务并行处理。

每个Map任务将输入数据转化为键值对,并生成中间结果。

在Reduce阶段,中间结果按照键进行分组,然后由多个Reduce任务并行处理。

每个Reduce任务将同一键的中间结果合并,并生成最终的计算结果。

Hadoop的工作原理可以总结为以下几个步骤:1. 客户端向HDFS发送文件读取或写入请求。

2. 主节点(NameNode)接收请求,并返回文件的位置信息。

3. 客户端直接与数据节点(DataNode)进行数据交互,实现文件的读取或写入操作。

4. 当需要进行大规模计算时,客户端编写MapReduce程序,并提交给Hadoop集群。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

someone@anynode:hadoop$ bin/hadoop dfs –put /home/someone/interestingFile.txt

/user/yourUserName/

Put上传整个目录 someone@anynode:hadoop$ bin/hadoop dfs –put source-directory destination

-test -[ezd] path

Returns 1 if path exists; has zero length; or is a directory, or 0 otherwise.

Prints information about path. format is a string which accepts file size in blocks (%b), filename (%n), block size (%o), replication (%r), and modification date (%y, %Y). Shows the last 1KB of file on stdout.

Multiple FsImage and EditLog Checkpoint

HDFS设计要点

命名空间 副本选择 Rack Awareness 安全模式 刚启动的时候,等待每一个DataNode报告情况 退出安全模式的时候才进行副本复制操作 NameNode有自己的 FsImage和EditLog,前者有自己的文件系统

HDFS文件系统操作命令

-setrep [-R] [-w] rep path Sets the target replication factor for files identified by path to rep. (The actual replication factor will move toward the target over time)

HDFS基本实现构架

MapReduce App App. MapReduce Framework Abstract FileSystem

HDFS (ClietnProtocol,DataNodeProtocol) (NameNode,DataNode,DFSClient)

IPC(Hadoop RPC) TCP Socket JMX

建立用户自己的目录,用户目录在/user中,需要建立

someone@anynode:hadoop$ bin/hadoop dfs -mkdir /user someone@anynode:hadoop$ bin/hadoop dfs -mkdir /user/someone

用-put命令在Linux文件系统与HDFS之间复制数据文件

Retrieves all files that match the path src in HDFS, and copies them to a single, merged file in the local file system identified by localDest.

-cat filename -copyToLocal [-crc] src localDest -moveToLocal [-crc] src localDest

-cp src dest

Copies the file or directory identified by src to dest, within HDFS.

HDFS文件系统操作命令

-rm path Removes the file or empty directory identified by path.

鸣谢:本课程得到Google公司(北京) 中国大学合作部精品课程计划资助

Ch.4. Hadoop MapReduce基本构架

1.Hadoop 分布式文件系统HDFS

2.Hadoop MapReduce的基本工作原理

3.分布式结构化数据表HBase

HDFS的基本特征

模仿Google GFS设计实现 存储极大数目的信息(terabytes or petabytes),将数据保存到

-touchz path

Creates a file at path containing the current time as a timestamp. Fails if a file already exists at path, unless the file is already size 0.

HDFS文件系统操作命令

someone@anynode:hadoop$ bin/hadoop dfs -ls someone@anynode:hadoop$ someone@anynode:hadoop$ bin/hadoop dfs -ls / Found 2 items drwxr-xr-x - hadoop supergroup 0 2008-09-20 19:40 /hadoop drwxr-xr-x - hadoop supergroup 0 2008-09-20 20:08 /tmp

HDFS文件系统操作命令

-get [-crc] src localDest Copies the file or directory in HDFS identified by src to the local file system path identified by localDest.

-getmerge src localDest [addnl]

Displays the contents of filename on stdout. Identical to -get Works like -get, but deletes the HDFS copy on success.

-mkdir path

Creates a directory named path in HDFS. Creates any parent directories in path that are missing (e.g., like mkdir -p in Linux).

HDFS文件系统操作命令

Command: bin/hadoop dfs -put foo bar Assuming: Outcome: No file/directory named Uploads local file foo to a file /user/$USER/bar exists in HDFS named /user/$USER/bar Uploads local file foo to a file named /user/$USER/bar/foo Uploads local file foo to a file named /user/$USER/somedir/somefile, creating the missing directory No change in HDFS, and an error is returned to the user.

HDFS数据分布设计

多副本数据块形式存储,按照块的方式随机选择存储节点 默认副本数目是3

HDFS数据分布设计

HDFS可靠性与出错恢复

DataNode节点的检测 心跳:NameNode 不断检测DataNode是否有效 若失效,则寻找新的节点替代,将失效节点数据重新分布 集群负载均衡 数据一致性: 校验和checksum 主节点元数据失效

状态,后者是还没有更新的记录

HDFS的安装和启动

下载hadoop-0.20.1.tar.gz(或者最新版本0.21) tar zxvf hadoop-0.20.1.tar.gz,解压后Hadoop系统包括HDFS和所

有配置文件都在指定的文件目录中 在Linux下进行必要的系统配置 设置与Hadoop相关的Java运行环境变量 启动Java虚拟机 启动Hadoop,则Hadoop和HDFS文件系统开始运行

减少元数据的量块的方式随机选择存储节点,

默认副本数目是3

HDFS基本构架

对等于GFS Master

应用程序 HDFS客户端

文件名或数据块号

HDFS NameNode

数据块号,数据块位置

对等于GFS ChunkServer DataNode 数据 DataNode 数据 DataNode 数据

-copyFromLocal localSrc dest -moveFromLocal localSrc dest

Copies the file or directory from the local file system identified by localSrc to dest within the HDFS. Identical to -put Copies the file or directory from the local file system identified by localSrc to dest within HDFS, then deletes the local copy on success.

/user/$USER/bar is already a file in HDFS

HDFS文件系统操作命令

-ls path Lists the contents of the directory specified by path, showing the names, permissions, owner, size and modification date for each entry.

-lsr path

-du path -dus path -mv src dest

Behaves like -ls, but recursively displays entries in all subdirectories of path.