CacheSize 属性范例

Cache基础知识介绍

• 两极cache相比较而言,L1 cache的容量小,但数据存取速 度较快,L2 cache的容量大,但数据存取速度较慢。部分 系统中也存在三级cache的结构。

Microprocessor

Fastest

CPU

Level 1 cache

Fast

Level 2 cache

Slow

memory

Cache的作用是什么

• 通过优化代码提高cache命中率

对数组int x[1024][4]进行求和 代码段A for(i=0;i<1024;i++) for(j=0;j<4;j++) sum += x[i][j]

Entry 0 Way 0 x[i][0] x[i][1]

代码段B for(j=0;j<4;j++) for(i=0;i<1024;i++) sum += x[i][j]

• 块:块是cache与主存的传输单位。 • 路(way): 路是组相联映射方式的cache结构中的基本存 储单位,每一路存储一个块的数据。 • 组(entry):组是组相联映射方式的cache对块进行管理的 单位。 • 区 (tag) :块的地址对应的主存储器中的区。 • 块内偏移地址(offset): 用来标示块内一个字节的地址。 • 组相联映射方式下主存储器的地址空间由,区,组和块内 偏移地址组成。

什么是cache

• Cache又叫高速缓冲存储器,位于CPU与内存之间,是一种 特殊的存储器子系统。 • 目前比较常见的是两极cache结构,即cache系统由一级高 速缓存L1 cache和二级高速缓存L2 cache组成,L1 cache通 常又分为数据cache(I-Cache)和指令cache(D-Cache), 它们分别用来存放数据和执行这些数据的指令。

cache的基本结构

cache的基本结构摘要:一、引言二、Cache的基本概念1.缓存的作用2.Cache的分类三、Cache基本结构1.组成要素2.工作原理四、Cache的优化策略1.缓存过期策略2.缓存替换策略3.缓存更新策略五、案例分析1.常见Cache应用场景2.Cache在实际项目中的应用六、结论正文:一、引言随着互联网技术的不断发展,网站性能优化成为越来越重要的课题。

在此背景下,缓存技术(Cache)应运而生,成为提高系统性能的有效手段。

本文将从Cache的基本概念、基本结构、优化策略等方面进行详细阐述,以期帮助读者更好地理解和应用Cache技术。

二、Cache的基本概念1.缓存的作用缓存的主要作用是减轻服务器负担,提高数据访问速度。

通过在客户端或服务器端存储热点数据,可以在访问数据时避免重复计算或查询,从而提高系统性能。

2.Cache的分类根据缓存的位置和作用,可以分为以下几类:- 客户端缓存:位于客户端(如浏览器)的缓存,用于存储访问过的网页、图片等资源。

- 服务器端缓存:位于服务器上的缓存,用于存储热点数据,如数据库查询结果、动态生成的内容等。

- 分布式缓存:通过多个服务器协同工作,实现大容量、高性能的缓存系统。

三、Cache基本结构1.组成要素一个典型的Cache结构包括以下几个要素:- 缓存空间:用于存储数据的空间,通常有限。

- 缓存策略:决定如何存储、更新和替换数据的规则。

- 缓存命中率:访问的数据在缓存中命中的比例,用以评估缓存效果。

2.工作原理Cache的工作原理简单来说就是“存、取、更新”:- 存:当客户端请求数据时,服务器将数据存储到缓存中。

- 取:当客户端再次请求相同数据时,优先从缓存中取出数据。

- 更新:当数据发生变化时,更新缓存中的数据,以确保客户端获取到最新数据。

四、Cache的优化策略1.缓存过期策略缓存数据具有一定的过期时间,超过过期时间后,数据会被自动删除。

常见的过期策略有:- 固定过期时间:设置一个固定的时间,如10分钟、30分钟等。

osCache 配置说明

osCache 配置说明作者: onebodysoftware@ (MSN)E文地址:/display/CACHE/Configuration这个东西今天小试了一下,总体感觉还不错.就不知道比起JBoss cache 有没什么差别(现在本人还不得而知啊),主要是针对osCache 的配置文件做了简单的翻译; 如有错误敬请修正.修改的文档请共享一下,谢谢!oscache.properties:osCache的配置文件,放在webapp/WEB-INF/classes/下;oscache.properties 中的配置项如下:1、cache.memory:原文:Valid values are true or false, with true being the default value. If you want to disable memory caching, just comment out or remove this line.Note: disabling memory AND disk caching is possible but fairly stupid译文:是否使用内存缓存; true 或false。

默认为true;个人推荐内存方法,在速度会有些优势;2、cache.capacity原文:The maximum number of items that a cache will hold. By default the capacity is unlimited - the cache will never remove any items.Negative values will also be treated as meaning unlimited capacity.译文:缓存的最大数量。

默认是不限制,cache不会移走任何缓存内容。

负数被视不限制。

3、cache.algorithm原文:The default cache algorithm to use. Note that in order to use an algorithm the cache size must also be specified.If the cache size is not specified, the cache algorithm will be Unlimited cache regardless of the value of this property. If you specify a size but not an algorithm, the cache algorithm used will be com.opensymphony.oscache.base.algorithm.LRUCache.OSCache currently comes with three algorithms:●com.opensymphony.oscache.base.algorithm.LRUCache - Least Recently Used.This isthe default when a cache.capacity is set.●com.opensymphony.oscache.base.algorithm.FIFOCache - First In First Out.●com.opensymphony.oscache.base.algorithm.UnlimitedCache - Content that is added tothe cache will never be discarded.This is the default when no value is set for the cache.capacity property.译文:运算规则。

freetype的缓存[整理版]

![freetype的缓存[整理版]](https://img.taocdn.com/s3/m/29d94efd541810a6f524ccbff121dd36a32dc4bf.png)

FreeType的缓存子系统提供了一个高性能的管理face、size、glyph image和charmap的途径。

I. Requirements and Design Goals:When dealing with fonts, caching rapidly becomes a necessity for at least the following reasons:当处理字体时,高速缓存是必要的,原因如下:l 打开字体文件是相当慢的,因为它需要加载数据到内存中。

所以,尽可能地保持FT_Face对象处于打开状态是一个好主意。

l 每一个FT_Face 或 FT_Size对象会占用几百KB,假设它总是很大,应该限制打开的face的个数到最小。

l 每个face包含成百上千的字形,由于通常只是使用一个face中的一小部分字形,一次性加载所有的字形是完全没有必要的。

应该缓存我们经常使用的字形。

l 当属于给定face的所有字形已经载入内存时,对应的FT_Face对象可以被关闭已减少内存的占用。

FreeType缓存子系统提供了自动完成上述任务的很好的途径。

II. The Cache Manager:FTC_Manager用于处理缓存中的各种数据。

应首先调用FTC_Manager_New 来创建它。

1. 通过FTC_FaceID鉴别face:FTC_Manager并不直接知晓哪些字体被安装了或者在运行期是否有效。

应用程序有责任定位和鉴别face,并打开相应的字体文件。

这意味着应用程序必须使用一个指针(FTC_FaceID)来唯一鉴别一个给定的有效的或已安装的face。

虽然这个指针对于FTC_Manager来说并不重要,但是它们的值在程序运行期必须始终保持不变,用于关联缓存的数据和它们相应的face。

应用程序也必须提供(在FTC_Manager_New期间)一个专门的回调函数FTC_Face_Requester。

cache rules规则

cache rules规则【原创版】目录1.Cache 规则的概述2.Cache 规则的分类3.Cache 规则的优缺点4.Cache 规则的应用实例5.Cache 规则的发展前景正文一、Cache 规则的概述Cache 规则,即缓存规则,是一种计算机技术,其主要目的是提高数据访问速度。

在计算机系统中,缓存是一种存储器,用于临时存储经常访问的数据和指令。

当计算机需要访问某个数据或指令时,缓存规则会根据一定的策略判断该数据或指令是否已经在缓存中,如果在缓存中则直接从缓存中读取,否则再从主存储器中读取并存入缓存。

这种机制可以减少主存储器的访问次数,提高数据访问速度。

二、Cache 规则的分类Cache 规则主要分为两类:写通式缓存(Write-Through Cache,简称 WT)和写回式缓存(Write-Back Cache,简称 WB)。

1.写通式缓存:在写通式缓存中,当 CPU 写入缓存时,缓存中的数据会被立即更新。

这种缓存规则的优点是减少了主存储器和缓存之间的数据不一致性,缺点是写入速度较慢。

2.写回式缓存:在写回式缓存中,当 CPU 写入缓存时,缓存中的数据并不会立即更新,而是等待缓存满时再进行更新。

这种缓存规则的优点是写入速度快,缺点是可能导致主存储器和缓存之间的数据不一致性。

三、Cache 规则的优缺点Cache 规则的优点主要体现在提高了数据访问速度,减少了对主存储器的访问次数,从而提高了计算机系统的运行效率。

然而,Cache 规则也存在一定的缺点,如缓存失效、缓存一致性等问题。

四、Cache 规则的应用实例Cache 规则广泛应用于各种计算机系统中,如 CPU 缓存、磁盘缓存、Web 浏览器缓存等。

以 CPU 缓存为例,目前市面上大多数处理器都采用了多级缓存结构,如 L1 Cache、L2 Cache 和 L3 Cache,这些缓存层次之间具有不同的访问速度和容量,可以有效地提高数据访问速度。

tomcat cachemaxsize设置规则

tomcat cachemaxsize设置规则在Tomcat中,`cachemaxsize` 不是一个直接的配置属性,而是在与缓存有关的一些组件中的一个可能用于设置缓存大小的属性。

以下是一些与缓存相关的配置属性和组件,以及它们的设置规则:1. Tomcat 缓存配置:在Tomcat 的`server.xml` 文件中,你可以配置各种缓存组件,如静态资源缓存、会话缓存等。

这些组件中的一些可能涉及到设置缓存大小的属性。

以下是一些相关的配置示例:```xml<!--示例:静态资源缓存--><Context docBase="/your/web/application" path="/" reloadable="true"><Resources cachingAllowed="true" cacheMaxSize="100000" /></Context>```2. Tomcat 会话管理器配置:如果你使用Tomcat 进行会话管理,那么`Manager` 组件可能包含缓存大小的设置。

以下是一个示例:```xml<!--示例:会话管理器配置--><Manager className="org.apache.catalina.session.PersistentManager"maxIdleBackup="1"><!--可能包含其他与缓存相关的属性--></Manager>```具体的`cacheMaxSize` 的设置规则取决于你的具体需求和应用场景。

一般来说,它表示缓存的最大容量,可以根据应用的大小和性能要求进行调整。

3. 其他组件配置:除了上述的示例之外,还可能有其他组件,如缓存过滤器、类加载器等,它们可能也包含`cacheMaxSize` 相关的属性。

通过C代码和Intel手册详细理解cache参数

通过C代码和Intel手册详细理解cache参数Cache的容量一般都很小,即使是最大的三级Cache(L3)也只有20MB ~30MB。

cache加快了CPU对内存的读写速率,CPU第一次执行需要将数据时候需要从主存-->L3 Cache--->L2 Cache -->L1 Cache传递到CPU的计算单元。

cache分成多个组,每个组分成多个行,linesize是cache的基本单位,从主存向cache迁移数据都是按照linesize 为单位替换的。

下面通过C代码和Intel手册详细理解cache参数。

Intel CPU可以通过CPUID命令获取cpu相关信息,查询Intel可以获取到相应的指令信息,获取cache 参数有下面两种方法:分别是当CPUID指令Initial EAX Value为0x02和0x04时候,由于方法一种CPUID指令的入口参数存放在EAX寄存器中,所以获取cache信息需要给EAX寄存器赋值为0x02,然后分别读取EAX、EBX、ECX、EDX四个寄存器得到Cache and TLB Information。

查看Intel手册(图1)得到方法一的指令码。

图1参考Linux内核中header.c文件中的cpuid函数实现获取cache代码函数,图2有两种方式实现获取cache函数,原理都是一样,赋值然后读取值。

图2本次试验采用gcc 4.7.2版本编译程序并且运行得到如下结果:d_eax : 55035a01d_ebx : f0b2ded_ecx : 0d_edx : 9ca212c查看intel 手册可以得到每个字节的解释,ebx寄存器中低八位查表得到如图3所示相关信息,3级cache 容量6M,12路组相连(每组有12个line),每个line大小为64 字节。

其它信息查表得到如下:EAX:。

cache大小调整问题

今天同事提了一个有趣的问题:

在IBM的两台X460合成的partition上,在他跑了8个vmware虚拟机后,8G的内存在top命令下的freed字段值不到10%。

当然了,这很正常,因为cached字段的值是高达6.8G,大量的内存缓存了文件IO的数据了。

然后他做了一件事:他运行了一个一开始就需要分配很大的内存的程序。

此时由于绝大多数的内存都用来做cache了,将这些cache回收需要一定时间,于是他感觉到了明显的延时。

现在的问题是如何限制cache与整个内存大小的百分比呢?即不让cache的占用超过一定的上限。

我知道/proc/sys/vm/swappiness可以调整swap分区和cache的偏好,将这个值设高一些会有一些帮助,但我觉得还不够。

ip route cache 参数

ip route cache 参数摘要:I.引言- 介绍ip route cache 参数的作用II.ip route cache 参数详解- 参数含义及作用1.cache-size2.cache-timeout3.route-cacheIII.如何配置ip route cache 参数- 配置实例及步骤IV.总结- 概括ip route cache 参数的重要性和配置方法正文:I.引言在网络通信中,路由器扮演着至关重要的角色。

为了提高路由器性能,减少网络延迟,ip route cache 参数起到了关键作用。

本文将详细介绍ip route cache 参数的作用及如何配置这些参数。

II.ip route cache 参数详解ip route cache 参数主要用于控制路由器缓存的路由信息。

以下是ip route cache 参数的含义及作用:1.cache-size:指定路由器缓存的路由条目数量。

合理的设置可以避免路由器处理过多的路由信息,从而提高性能。

2.cache-timeout:设置路由信息在缓存中的有效时间。

当路由信息超过有效期时,路由器会重新向其他路由器发送请求,更新路由表。

3.route-cache:用于开启或关闭路由缓存功能。

当网络中存在大量的动态路由时,开启此参数可显著提高路由器性能。

III.如何配置ip route cache 参数以下是一个配置ip route cache 参数的实例:```interface GigabitEthernet0/0/1ip route-cache```在这个例子中,我们通过在接口上配置ip route-cache 命令来开启路由缓存功能。

此外,还可以通过命令行方式配置cache-size 和cache-timeout 参数,如下:```ip route cache-size 1000ip route cache-timeout 120```这个例子中,我们设置了路由器缓存的路由条目数量为1000 条,并设置了路由信息在缓存中的有效时间为120 秒。

用c语言编写获取个人计算机cache数据的代码

获取个人计算机cache数据的代码需要使用特定的库和系统调用函数,以下是一个简单的C程序代码示例,可用于获取CPU三级缓存的信息:#include <stdio.h>#include <stdlib.h>#include <string.h>#include <unistd.h>#define L1_CACHE_SIZE (32 * 1024) // 一级缓存大小为32KB#define L2_CACHE_SIZE (256 * 1024) // 二级缓存大小为256KB#define L3_CACHE_SIZE (16 * 1024 * 1024) // 三级缓存大小为16MBint get_cache_info(int level, int type){FILE *fp;char buf[4096];int size = 0;if (level == 1) {size = L1_CACHE_SIZE;} else if (level == 2) {size = L2_CACHE_SIZE;} else if (level == 3) {size = L3_CACHE_SIZE;} else {printf("Invalid cache level.\n");return -1;}if (type == 1) { // 获取缓存大小sprintf(buf, "grep 'cache size' /sys/devices/system/cpu/cpu0/cache/index%d/uevent | awk -F '=' '{print $2}'", level -1);} else if (type == 2) { // 获取缓存行大小sprintf(buf, "grep 'coherency_line_size' /sys/devices/system/cpu/cpu0/cache/index%d/uevent | awk -F '=' '{print $2}'", level -1);} else if (type == 3) { // 获取缓存组数sprintf(buf, "grep 'number_of_sets' /sys/devices/system/cpu/cpu0/cache/index%d/uevent | awk -F '=' '{print $2}'", level -1);} else {printf("Invalid cache type.\n");return -1;}fp = popen(buf, "r");if (fp == NULL) {printf("Failed to execute command.\n");return -1;}memset(buf, 0, sizeof(buf));fgets(buf, sizeof(buf), fp);pclose(fp);return atoi(buf) * size;}int main(){int cache_size = 0;int line_size = 0;int num_sets = 0;cache_size = get_cache_info(3, 1);line_size = get_cache_info(3, 2);num_sets = get_cache_info(3, 3);printf("L3 Cache Size: %d KB\n", cache_size / 1024);printf("Cache Line Size: %d bytes\n", line_size);printf("Number of Sets: %d\n", num_sets);return 0;}该程序使用了Linux系统的/sys文件系统接口,通过读取/sys/devices/system/cpu/cpu0/cache目录下的信息来获取CPU三级缓存的大小、行大小和组数等信息。

python 中cache的用法

python 中cache的用法在 Python 中,`cache`通常用于缓存函数的计算结果,以避免在后续的调用中重复计算。

这样可以提高程序的性能,特别是对于计算密集型或耗时的函数。

Python 中的`functools`模块提供了`lru_cache`装饰器来实现简单的缓存功能。

以下是一个示例代码:```pythonfrom functools import lru_cache@lru_cache(maxsize=None)def expensive_function(x):# 进行一些复杂、耗时的计算return x * x# 调用缓存后的函数result1 = expensive_function(2)result2 = expensive_function(2)# 输出结果print(result1)print(result2)```在上述示例中,`@lru_cache`装饰器被应用于`expensive_function`函数,它会将函数的调用结果缓存起来。

当相同的输入再次调用该函数时,它会直接返回缓存中的结果,而不会再次执行函数内部的计算。

通过使用缓存,可以避免重复计算,提高函数的调用效率。

需要注意的是,`lru_cache`装饰器提供了一些参数可以配置缓存的行为,例如`maxsize`参数可以限制缓存的最大容量,超过限制后旧的缓存会被自动删除。

除了`functools.lru_cache`,还有其他一些第三方库提供了更高级的缓存功能,例如`django-cache`和`memcached`等,可以根据具体需求选择适合的缓存方案。

希望这个回答对你有帮助。

如果你有任何其他问题,请随时提问。

jvm codecache 参数

jvm codecache 参数JVM(Java Virtual Machine)是一种可以运行Java字节码的虚拟机。

而JVM的CodeCache(代码缓存)是JVM中的一个重要组件,用于存储已经被即时编译器(Just-in-Time Compiler)编译为本地机器码的Java字节码。

本文将以"JVM CodeCache 参数"为主题,详细介绍JVM CodeCache的作用、配置、优化以及可能出现的问题。

第一部分:JVM CodeCache 简介JVM CodeCache是JVM用来缓存已经编译为本地机器码的Java字节码的内存区域。

它的主要作用是提高Java程序的运行效率,通过缓存频繁执行的代码,避免反复的进行即时编译。

CodeCache 通常位于Java堆外,有着较小的初始大小。

CodeCache分为两部分:方法区域的CodeHeap和HotSpot VM自身用于编译器对象的内存区域CompactibleFreeListSpace。

前者主要用于缓存已经编译的方法,后者则用于缓存编译器生成的其他对象。

第二部分:JVM CodeCache 的配置JVM CodeCache的大小可以通过JVM启动参数进行配置。

以下是一些常用的CodeCache参数:1. `-XX:InitialCodeCacheSize`:指定初始的CodeCache大小,默认大小为240MB。

2. `-XX:ReservedCodeCacheSize`:指定CodeCache的最大大小,当CodeCache超过该大小时,JVM会尝试进行垃圾回收以释放空间。

3. `-XX:CodeCacheExpansionSize`:当CodeCache空间不足时,JVM会试图扩展其大小,该参数用于指定扩展的大小。

4. `-XX:CodeCacheMinimumFreeSpace`:指定CodeCache 中用于碎片整理(Compaction)的最小剩余空间。

计算机组成原理与系统结构14

块大小与命中率之间的关系复杂,它取决 于特定程序的局部性特征

没有找到确定的最优值 块大小为8~64B比较合适

Caches的数目

Cache

单一Cache和多级Cache

片内 Cache(L1):到CPU的路径短,速度快,减少 了对总线访问。 外部 Cache(L2):只有L1访问未命中会导致访问L2。 多级Cache能显著地提高性能, 但多级Cache也会使关于Cache设计的所有问题变得复杂

结合使用

Caches的数目

Cache

Caches的数目

CaБайду номын сангаасhe

统一 Cache和分立 Cache

统一 Cache

一个Cache既能装入指令又能装入数据 在获取指令和数据之间能自动加以平衡 命中率高

Caches的数目

Cache

统一 Cache和分立 Cache

分立 Cache 存放单一信息的专用Cache 数据 Cache & 指令 Cache、TLB 并行性好 更好的支持指令的并行

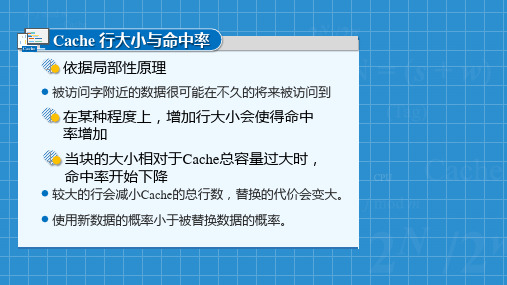

Cache 行大小与命中率

Cache

依据局部性原理

被访问字附近的数据很可能在不久的将来被访问到

在某种程度上,增加行大小会使得命中 率增加

当块的大小相对于Cache总容量过大时, 命中率开始下降

较大的行会减小Cache的总行数,替换的代价会变大。

使用新数据的概率小于被替换数据的概率。

Cache 行大小与命中率

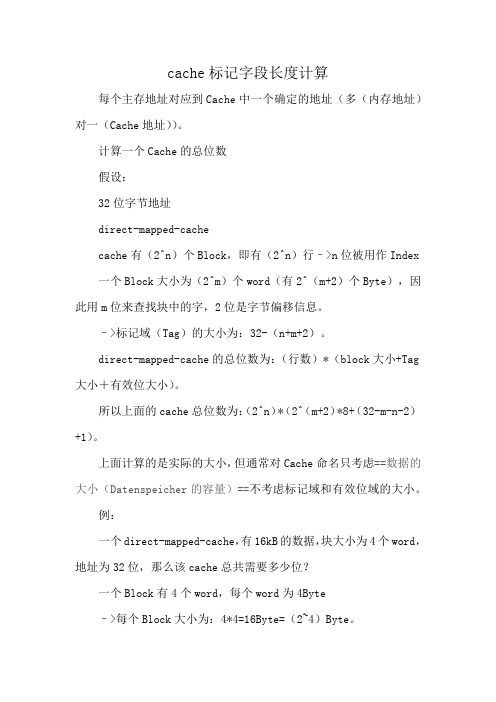

cache标记字段长度计算

cache标记字段长度计算每个主存地址对应到Cache中一个确定的地址(多(内存地址)对一(Cache地址))。

计算一个Cache的总位数假设:32位字节地址direct-mapped-cachecache有(2^n)个Block,即有(2^n)行–>n位被用作Index 一个Block大小为(2^m)个word(有2^(m+2)个Byte),因此用m位来查找块中的字,2位是字节偏移信息。

–>标记域(Tag)的大小为:32-(n+m+2)。

direct-mapped-cache的总位数为:(行数)*(block大小+Tag 大小+有效位大小)。

所以上面的cache总位数为:(2^n)*(2^(m+2)*8+(32-m-n-2)+1)。

上面计算的是实际的大小,但通常对Cache命名只考虑==数据的大小(Datenspeicher的容量)==不考虑标记域和有效位域的大小。

例:一个direct-mapped-cache,有16kB的数据,块大小为4个word,地址为32位,那么该cache总共需要多少位?一个Block有4个word,每个word为4Byte–>每个Block大小为:4*4=16Byte=(2~4)Byte。

Datenspeicher有16=(2^14)B数据,每个Block大小为(2^4)Byte–>Block的数目为:(2^14)/(2*4)=2~10.–>Index域大小为10位每个Block中有4个Word———>定位到一个Word需要2位每个word中有4个Byte———–>定位到一个Byte需要2位所以标记域(Tag)的大小为:32-16-2-2=18bit。

所以总共需要的位数:(2^10)*((4*4*8)+(32-10-2-2)+1)=(2^10)*147=147kbit。

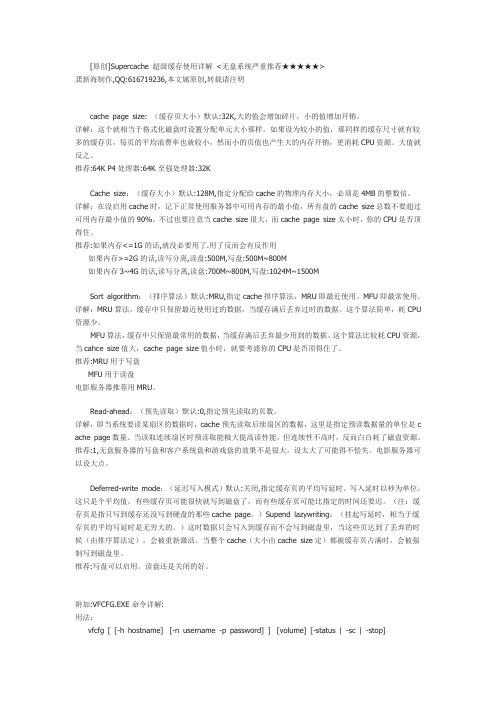

Supercache超级缓存使用详解

[原创]Supercache 超级缓存使用详解<无盘系统严重推荐★★★★★>龚新海制作,QQ:616719236,本文属原创,转载请注明cache page size: (缓存页大小)默认:32K,大的值会增加碎片,小的值增加开销。

详解:这个就相当于格式化磁盘时设置分配单元大小那样。

如果设为较小的值,那同样的缓存尺寸就有较多的缓存页,每页的平均浪费率也就较小,然而小的页值也产生大的内存开销,更消耗CPU资源。

大值就反之。

推荐:64K P4处理器:64K 至强处理器:32KCache size:(缓存大小)默认:128M,指定分配给cache的物理内存大小,必须是4MB的整数倍。

详解:在没启用cache时,记下正常使用服务器中可用内存的最小值,所有盘的cache size总数不要超过可用内存最小值的90%。

不过也要注意当cache size很大,而cache page size太小时,你的CPU是否顶得住。

推荐:如果内存<=1G的话,就没必要用了.用了反而会有反作用如果内存>=2G的话,读写分离,读盘:500M,写盘:500M~800M如果内存3~4G的话,读写分离,读盘:700M~800M,写盘:1024M~1500MSort algorithm:(排序算法)默认:MRU,指定cache排序算法,MRU即最近使用。

MFU即最常使用。

详解:MRU算法,缓存中只保留最近使用过的数据,当缓存满后丢弃过时的数据。

这个算法简单,耗CPU 资源少。

MFU算法,缓存中只保留最常用的数据,当缓存满后丢弃最少用到的数据。

这个算法比较耗CPU资源,当cahce size值大,cache page size值小时,就要考滤你的CPU是否顶得住了。

推荐:MRU用于写盘MFU用于读盘电影服务器推荐用MRU。

Read-ahead:(预先读取)默认:0,指定预先读取的页数。

详解,即当系统要读某扇区的数据时,cache预先读取后续扇区的数据,这里是指定预读数据量的单位是c ache page数量。

cache硬件设计实验总结

cache硬件设计实验总结Cache硬件设计实验总结Cache是计算机系统中的一种高速缓存,用于存储最近被访问的数据,以提高计算机系统的性能。

在计算机系统中,CPU访问内存的速度比访问Cache的速度慢得多,因此,Cache的设计对于计算机系统的性能至关重要。

本文将对Cache硬件设计实验进行总结。

实验目的本次实验的目的是设计一个Cache硬件,实现Cache的读写操作,并测试Cache的性能。

具体实验要求如下:1. 设计一个Cache硬件,包括Cache的大小、块大小、组数、替换策略等参数的设置。

2. 实现Cache的读写操作,包括Cache的读取、写入和替换等操作。

3. 测试Cache的性能,包括Cache的命中率、访问时间等指标。

实验过程1. Cache硬件设计在本次实验中,我们设计了一个4KB大小的Cache,块大小为16B,共有256组。

采用的替换策略是LRU(Least Recently Used,最近最少使用)。

具体的Cache硬件设计如下:(1)Cache的地址结构Cache的地址结构包括标记位、组索引和块内偏移量。

在本次实验中,我们采用了直接映射的Cache结构,因此组索引的位数为8位,块内偏移量的位数为4位。

标记位的位数为16-8-4=4位。

(2)Cache的数据结构Cache的数据结构包括标记位、有效位、块内数据和LRU计数器。

标记位用于存储主存地址的高位,有效位用于表示Cache中的数据是否有效,块内数据用于存储主存地址对应的数据,LRU计数器用于记录Cache中每个块的使用情况。

2. Cache的读写操作Cache的读写操作包括Cache的读取、写入和替换等操作。

具体的操作流程如下:(1)Cache的读取操作当CPU需要读取主存中的数据时,首先会查询Cache中是否存在该数据。

如果存在,则直接从Cache中读取数据;如果不存在,则从主存中读取数据,并将数据存储到Cache中。

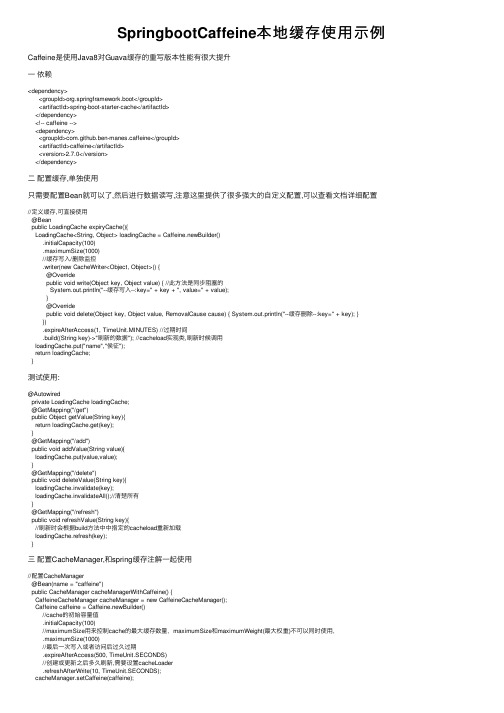

SpringbootCaffeine本地缓存使用示例

SpringbootCaffeine本地缓存使⽤⽰例Caffeine是使⽤Java8对Guava缓存的重写版本性能有很⼤提升⼀依赖<dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-cache</artifactId></dependency><!-- caffeine --><dependency><groupId>com.github.ben-manes.caffeine</groupId><artifactId>caffeine</artifactId><version>2.7.0</version></dependency>⼆配置缓存,单独使⽤只需要配置Bean就可以了,然后进⾏数据读写,注意这⾥提供了很多强⼤的⾃定义配置,可以查看⽂档详细配置//定义缓存,可直接使⽤@Beanpublic LoadingCache expiryCache(){LoadingCache<String, Object> loadingCache = Caffeine.newBuilder().initialCapacity(100).maximumSize(1000)//缓存写⼊/删除监控.writer(new CacheWriter<Object, Object>() {@Overridepublic void write(Object key, Object value) { //此⽅法是同步阻塞的System.out.println("--缓存写⼊--:key=" + key + ", value=" + value);}@Overridepublic void delete(Object key, Object value, RemovalCause cause) { System.out.println("--缓存删除--:key=" + key); }}).expireAfterAccess(1, TimeUnit.MINUTES) //过期时间.build((String key)->"刷新的数据"); //cacheload实现类,刷新时候调⽤loadingCache.put("name","侯征");return loadingCache;}测试使⽤:@Autowiredprivate LoadingCache loadingCache;@GetMapping("/get")public Object getValue(String key){return loadingCache.get(key);}@GetMapping("/add")public void addValue(String value){loadingCache.put(value,value);}@GetMapping("/delete")public void deleteValue(String key){loadingCache.invalidate(key);loadingCache.invalidateAll();//清楚所有}@GetMapping("/refresh")public void refreshValue(String key){//刷新时会根据build⽅法中中指定的cacheload重新加载loadingCache.refresh(key);}三配置CacheManager,和spring缓存注解⼀起使⽤//配置CacheManager@Bean(name = "caffeine")public CacheManager cacheManagerWithCaffeine() {CaffeineCacheManager cacheManager = new CaffeineCacheManager();Caffeine caffeine = Caffeine.newBuilder()//cache的初始容量值.initialCapacity(100)//maximumSize⽤来控制cache的最⼤缓存数量,maximumSize和maximumWeight(最⼤权重)不可以同时使⽤,.maximumSize(1000)//最后⼀次写⼊或者访问后过久过期.expireAfterAccess(500, TimeUnit.SECONDS)//创建或更新之后多久刷新,需要设置cacheLoader.refreshAfterWrite(10, TimeUnit.SECONDS);cacheManager.setCaffeine(caffeine);cacheManager.setCacheLoader(cacheLoader);cacheManager.setCacheNames(names);//根据名字可以创建多个cache,但是多个cache使⽤相同的策略cacheManager.setAllowNullValues(false);//是否允许值为空return cacheManager;}配置 cacheload/*** 必须要指定这个Bean,refreshAfterWrite配置属性才⽣效*/@Beanpublic CacheLoader<Object, Object> cacheLoader() {return new CacheLoader<Object, Object>() {@Overridepublic Object load(Object key) throws Exception { return null;}// 重写这个⽅法将oldValue值返回回去,进⽽刷新缓存@Overridepublic Object reload(Object key, Object oldValue) throws Exception {System.out.println("--refresh--:"+key);return oldValue;}};}其他就是在service中配置spring的⼏个缓存注解使⽤就⾏了,这⾥放⼀张截图,这些注解⽤法,⽹上很多:[/code]以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

MIPS_Cache管理

MIPS--cache管理2009年02月15日星期日 13:12没有Cache的MIPSCPU不能称为真正的RISC。

可能这样说不公平。

但为了一些特殊的目的,你可以设计一个含有小而紧密内存的MIPSCPU,而这些内存只需要固定个数的流水线步骤(最好是一个)就可以被访问到。

但绝大部分MIPS CPU都是含有cache的。

这一章将介绍MIPS的cache怎样工作和软件应该怎么做才能使它可以被使用而且是可靠的。

MIPSCPU重新启动后,cache的状态是不确定的,所以软件必须非常小心。

你有一些线索知道cache的大小(如果你直接知道cache的大小后去初始化,这是一个不好的软件习惯。

)。

对于诊断程序员,我们将讨论怎样测试cache和获取特殊入口。

对于实时应用程序的程序员,希望在CPU运行时能够正确地控制cache。

我们也将讨论怎么做,虽然我对使用一些窍门方式有怀疑。

当然这些也随着MIPSCPU的发展而进步。

对于早期的32位MIPS处理器,初始化cache或者使其无效,首先让cache进入一种特殊的状态,然后通过普通的读写操作来完成。

对于后来的处理器,一些特殊的指令被定义出来做这些相关的操作。

4.1 cache和cache的管理cache的工作就是将内存中的一部分数据在cache中保留一个备份,使这些数据能一个固定的极短的时间内被快速的存取并返回给CPU,这样能保证流水线的连续运行。

绝大部分MIPSCPU针对指令和数据有其各自的cache(分别称为Icache和Dcache),这样读一条指令和一个数据的读操作或者写操作就能同时发生。

老的CPU家族(象x86)为了保证被写入CPU的代码的一致性,所以没有cache。

现在的x86芯片拥有更灵活的硬件设计,从而保证软件没有必要从更本上了解cache(如果你正在装一台机器跑MS/DOS,它将在本质上提供一致性)。

但因为MIPS机器有各自的cache,所以就没有必要那么灵活。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CacheSize 属性范例

该范例使用CacheSize属性,说明当使用和不使用记录数为 30 的缓存时,所执行的操作在性能上的差别。

Public Sub CacheSizeX()

Dim rstRoySched As ADODB.Recordset

Dim strCnn As String

Dim sngStart As Single

Dim sngEnd As Single

Dim sngNoCache As Single

Dim sngCache As Single

Dim intLoop As Integer

Dim strTemp As String

' 打开 RoySched 表。

strCnn = "Provider=sqloledb;" & _

"Data Source=srv;Initial Catalog=pubs;User Id=sa;Password=; " Set rstRoySched = New ADODB.Recordset

rstRoySched.Open "roysched", strCnn, , , adCmdTable

' 枚举记录集对象两次并记录经历的时间。

sngStart = Timer

For intLoop = 1 To 2

rstRoySched.MoveFirst

Do While Not rstRoySched.EOF

' Execute a simple operation for the

' performance test.

strTemp = rstRoySched!title_id

rstRoySched.MoveNext

Loop

Next intLoop

sngEnd = Timer

sngNoCache = sngEnd - sngStart

' 以 30 个记录为一组缓存记录。

rstRoySched.MoveFirst

rstRoySched.CacheSize = 30

sngStart = Timer

' 枚举记录集对象两次并记录经历的时间。

For intLoop = 1 To 2

rstRoySched.MoveFirst

Do While Not rstRoySched.EOF

' 执行一个简单操作,进行性能测试。

strTemp = rstRoySched!title_id

rstRoySched.MoveNext

Loop

Next intLoop

sngEnd = Timer

sngCache = sngEnd - sngStart

' 显示性能结果。

MsgBox "Caching Performance Results:" & vbCr & _ " No cache: " & Format(sngNoCache, _

"##0.000") & " seconds" & vbCr & _

" 30-record cache: " & Format(sngCache, _ "##0.000") & " seconds"

rstRoySched.Close

End Sub。