cuda编程2.0

2024版CUDA编程入门极简教程

行划分,每个线程处理一部分数据;任务并行是将任务划分为多个子任

务,每个线程执行一个子任务。

02

共享内存与全局内存

CUDA提供共享内存和全局内存两种存储空间。共享内存位于处理器内

部,访问速度较快,可用于线程间通信;全局内存位于处理器外部,访

问速度较慢,用于存储大量数据。

03

异步执行与流

CUDA支持异步执行,即CPU和GPU可以同时执行不同的任务。通过创

2023

PART 02

CUDA环境搭建与配置

REPORTING

安装CUDA工具包

下载CUDA工具包

01

访问NVIDIA官网,下载适用于您的操作系统的CUDA工具包。

安装CUDA工具包

02

按照安装向导的指示,完成CUDA工具包的安装。

验证安装

03

安装完成后,可以通过运行CUDA自带的示例程序来验证算,每个线 程处理一个子任务。计算完成后, 将结果从设备内存传输回主机内 存,并进行必要的后处理操作。

2023

PART 05

CUDA优化策略与技巧

REPORTING

优化内存访问模式

合并内存访问

通过确保线程访问连续的内存地址,最大化内 存带宽利用率。

使用共享内存

利用CUDA的共享内存来减少全局内存访问, 提高数据重用。

避免不必要的内存访问

精心设计算法和数据结构,减少不必要的内存读写操作。

减少全局内存访问延迟

使用纹理内存和常量内存

利用CUDA的特殊内存类型,如纹理内存和常量内存,来加速数 据访问。

数据预取和缓存

通过预取数据到缓存或寄存器中,减少全局内存访问次数。

展望未来发展趋势

CUDA与深度学习

cuda发展历程

cuda发展历程CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种并行计算架构,允许科学家和工程师利用GPU (Graphics Processing Unit)进行高性能计算和并行编程。

下面将介绍CUDA发展历程。

CUDA的发展可以追溯到2006年,当时NVIDIA发布了第一版的CUDA架构,并推出了第一代的CUDA编程工具包(CUDA Toolkit)。

这一版本的CUDA主要用于加速科学计算和图形渲染任务。

初期的CUDA架构由一个称为“流处理器”的多个执行单元组成,这些执行单元同步执行GPU上并行计算的指令流。

随着时间的推移,NVIDIA不断推出新的CUDA架构和工具包,以提供更好的性能和功能。

2008年,NVIDIA发布了第二代的CUDA架构,并推出了CUDA 2.0工具包,引入了一些重要的功能,如双精度浮点数和纹理内存。

这使得科学计算和数据处理等高性能计算任务在GPU上的加速效果更加显著。

在2010年,NVIDIA发布了第三代的CUDA架构和CUDA3.0工具包。

这一版本引入了动态并行性(Dynamic Parallelism)的概念,允许GPU上的线程能够生成其他线程,从而实现更复杂的并行计算任务。

此外,NVIDIA还增加了对并行数据传输的支持,提高了内存访问的效率。

随后几年中,NVIDIA继续推出新的CUDA架构和工具包。

例如,在2012年,NVIDIA发布了Kepler架构和CUDA 5.0工具包,引入了许多新的功能和改进。

其中一个重要的改进是支持动态并行性的进一步增强,使得GPU上的线程能够更好地调度和协同工作。

此外,NVIDIA还引入了一种新的内存模型,称为统一虚拟内存(Unified Virtual Memory),以简化GPU和CPU之间的数据传输。

在2014年,NVIDIA发布了Maxwell架构和CUDA 6.0工具包。

cuda发展历程 -回复

cuda发展历程-回复CUDA,全称Compute Unified Device Architecture,是由NVIDIA开发的一种并行计算平台和编程模型。

CUDA的发展历程可以追溯到2006年,以下将详细介绍CUDA的发展过程。

2006年,NVIDIA推出第一版的CUDA。

当时,CUDA的主要目标是使用GPU(图形处理器)进行通用计算。

在过去,GPU主要用于图形渲染,但NVIDIA意识到GPU的强大并行计算能力,因此决定为开发者提供编程接口,使其能够利用GPU进行更大范围的计算任务。

第一版的CUDA 主要支持C语言,并提供了一套对开发者友好的API,使其能够方便地进行GPU编程。

2007年,NVIDIA发布了CUDA Toolkit 1.0,这是一个全面的开发工具包,为开发者提供了编译器、调试器、性能分析器等工具,以及一系列的开发库。

这些工具大大简化了开发GPU应用程序的过程,使得更多的开发者可以参与到GPU计算的开发中来。

随着CUDA的不断推出和开发者的参与,越来越多的应用程序开始使用GPU进行加速计算。

2008年,NVIDIA发布了CUDA 2.0版本,并引入了线程块和线程束的概念,使得开发者可以更好地管理和利用GPU上的计算资源。

此外,CUDA 2.0还支持动态并行调度,使得开发者能够更加灵活地控制并行计算的流程。

在接下来的几年里,NVIDIA持续不断地更新和改进CUDA平台。

2010年,CUDA 3.0发布,引入了一种新的内存模型,即统一虚拟寻址(Unified Virtual Addressing,UVA)。

这一功能使得开发者可以更方便地在CPU 和GPU之间共享内存,并且不再需要显示地进行内存拷贝。

UVA的引入大大简化了编程的流程,提高了开发效率。

2012年,NVIDIA发布了CUDA 5.0版本,引入了动态并行调度的新特性,这使得开发者能够更好地响应计算需求的变化。

此外,CUDA 5.0还支持GPU加速的MPI(Message Passing Interface),使得CUDA可以更好地与传统的MPI编程模型结合起来,实现更高效的并行计算。

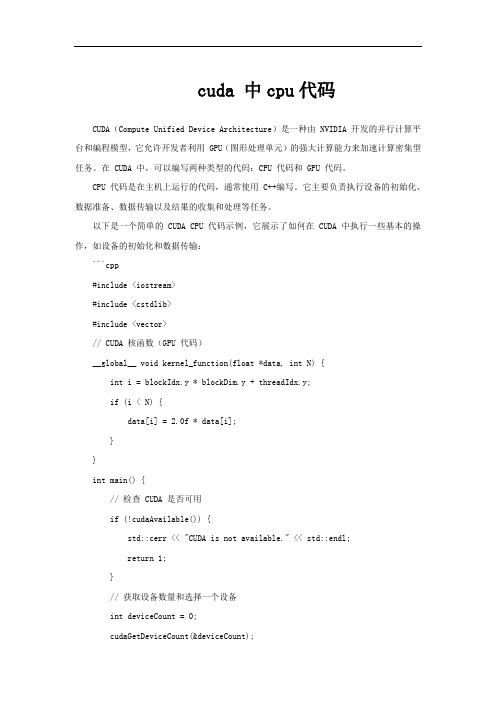

cuda 中cpu代码

cuda 中cpu代码CUDA(Compute Unified Device Architecture)是一种由 NVIDIA 开发的并行计算平台和编程模型,它允许开发者利用 GPU(图形处理单元)的强大计算能力来加速计算密集型任务。

在 CUDA 中,可以编写两种类型的代码:CPU 代码和 GPU 代码。

CPU 代码是在主机上运行的代码,通常使用 C++编写。

它主要负责执行设备的初始化、数据准备、数据传输以及结果的收集和处理等任务。

以下是一个简单的 CUDA CPU 代码示例,它展示了如何在 CUDA 中执行一些基本的操作,如设备的初始化和数据传输:```cpp#include <iostream>#include <cstdlib>#include <vector>// CUDA 核函数(GPU 代码)__global__ void kernel_function(float *data, int N) {int i = blockIdx.y * blockDim.y + threadIdx.y;if (i < N) {data[i] = 2.0f * data[i];}}int main() {// 检查 CUDA 是否可用if (!cudaAvailable()) {std::cerr << "CUDA is not available." << std::endl;return 1;}// 获取设备数量和选择一个设备int deviceCount = 0;cudaGetDeviceCount(&deviceCount);if (deviceCount == 0) {std::cerr << "No CUDA devices found." << std::endl;return 1;}int device = 0;cudaSetDevice(device);// 定义 GPU 上的数组大小size_t N = 1024;// 在 GPU 上分配内存float *d_data;cudaMalloc(&d_data, N * sizeof(float));// 在 CPU 上初始化数据std::vector<float> h_data(N);for (size_t i = 0; i < N; i++) {h_data[i] = i;}// 将数据从 CPU 传输到 GPUcudaMemcpy(d_data, h_data.data(), N * sizeof(float), cudaMemcpyHostToDevice);// 调用核函数dim3 threadsPerBlock(2, 2);dim3 numBlocks(N / threadsPerBlock.x, N / threadsPerBlock.y);kernel_function<<<numBlocks, threadsPerBlock>>>(d_data, N);// 将数据从 GPU 传输回 CPUcudaMemcpy(h_data.data(), d_data, N * sizeof(float), cudaMemcpyDeviceToHost);// 输出结果for (const auto &value : h_data) {std::cout << value << " ";}std::cout << std::endl;// 释放 GPU 内存cudaFree(d_data);return 0;}```这个示例代码展示了如何在 CUDA 中使用 CPU 代码来初始化设备、分配内存、传输数据以及调用核函数。

cuda发展历程

cuda发展历程CUDA(Compute Unified Device Architecture)是由NVIDIA 公司开发的一种并行计算平台和API模型。

以下是CUDA发展的主要里程碑:1. 2006年:NVIDIA发布了第一代CUDA架构,支持NVIDIA的GeForce 8系列和Tesla架构的显卡。

这一版本主要用于通用计算和图像处理。

2. 2007年:NVIDIA发布了CUDA 1.1版本,添加了对64位操作系统和64位浮点数的支持。

此外,还增加了对多GPU的支持。

3. 2008年:NVIDIA发布了CUDA 2.0版本,引入了CUDA C 编程语言,允许程序员使用类C语言的语法来编写并行计算代码。

此外,这一版本还引入了纹理内存、统一虚拟寻址和动态并行ism等功能。

4. 2010年:NVIDIA发布了CUDA 3.0版本,引入了GPU内存共享和主机线程同步等特性。

这一版本还大幅提升了GPU 和CPU之间的数据传输效率。

5. 2012年:NVIDIA发布了CUDA 5.0版本,引入了动态并行调度和GPUDirect技术,可以直接将数据从存储设备传输到GPU内存。

6. 2014年:NVIDIA发布了CUDA 6.0版本,增加了对动态并行ism和GPU内存引用计数的支持,提升了GPU的并行计算能力。

7. 2016年:NVIDIA发布了CUDA 8.0版本,引入了Pascal架构的显卡支持,这一架构在性能和能效方面都有显著改进。

8. 2020年:NVIDIA发布了CUDA 11.0版本,支持了NVIDIA的Ampere架构的显卡,这一版本在性能和功能上都有所提升。

目前,CUDA已经成为了广泛使用的并行计算平台,用于加速科学计算、机器学习、深度学习等领域。

同时,NVIDIA也在持续推进CUDA的发展,进一步提高GPU的计算能力和开发者的编程体验。

NVIDIACUDA编程指南

NVIDIACUDA编程指南一、CUDA的基本概念1. GPU(Graphics Processing Unit):GPU是一种专门用于图形处理的处理器,但随着计算需求的增加,GPU也被用于进行通用计算。

相比于CPU,GPU拥有更多的处理单元和更高的并行计算能力,能够在相同的时间内处理更多的数据。

2. CUDA核心(CUDA core):CUDA核心是GPU的计算单元,每个核心可以执行一个线程的计算任务。

不同型号的GPU会包含不同数量的CUDA核心,因此也会有不同的并行计算能力。

3. 线程(Thread):在CUDA编程中,线程是最基本的并行计算单元。

每个CUDA核心可以执行多个线程的计算任务,从而实现并行计算。

开发者可以使用CUDA编程语言控制线程的创建、销毁和同步。

4. 线程块(Thread Block):线程块是一组线程的集合,这些线程会被分配到同一个GPU的处理器上执行。

线程块中的线程可以共享数据,并且可以通过共享内存进行通信和同步。

5. 网格(Grid):网格是线程块的集合,由多个线程块组成。

网格提供了一种组织线程块的方式,可以更好地利用GPU的并行计算能力。

不同的线程块可以在不同的处理器上并行执行。

6.内存模型:在CUDA编程中,GPU内存被划分为全局内存、共享内存、寄存器和常量内存等几种类型。

全局内存是所有线程可访问的内存空间,而共享内存只能被同一个线程块的线程访问。

寄存器用于存储线程的局部变量,常量内存用于存储只读数据。

二、CUDA编程模型1.编程语言:CUDA编程语言是一种基于C语言的扩展,可在C/C++代码中嵌入CUDA核函数。

开发者可以使用CUDA编程语言定义并行计算任务、管理线程和内存、以及调度计算任务的执行。

2. 核函数(Kernel Function):核函数是在GPU上执行的并行计算任务,由开发者编写并在主机端调用。

核函数会被多个线程并行执行,每个线程会处理一部分数据,从而实现高效的并行计算。

CUDA编程指南2.0

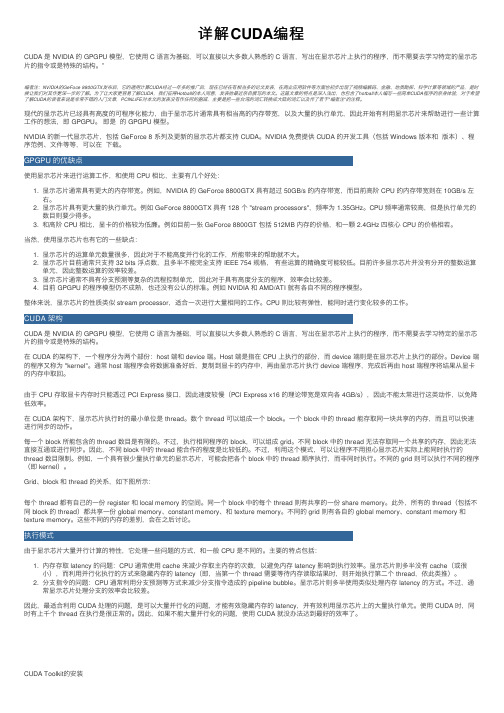

NVIDIA CUDA计算统一设备架构编程指南版本 2.06 /7 / 2008目录第 1 章简介 (1)1.1 CUDA:可伸缩并行编程模型 (1)1.2 GPU:高度并行化、多线程、多核处理器 (1)1.3 文档结构 (3)第2章编程模型 (4)2.1 线程层次结构 (4)2.2 存储器层次结构 (6)2.3 主机和设备 (6)2.4 软件栈 (7)2.5 计算能力 (8)第 3 章GPU 实现 (9)3.1 具有芯片共享存储器的一组SIMT 多处理器 (9)3.2 多个设备 (11)3.3 模式切换 (11)第 4 章应用程序编程接口 (12)4.1 C 编程语言的扩展 (12)4.2 语言扩展 (12)4.2.1 函数类型限定符 (12)4.2.1.1 _device_ (12)4.2.1.2 _global_ (13)4.2.1.3 _host_ (13)4.2.1.4 限制 (13)4.2.2 变量类型限定符 (13)4.2.2.1 _device_ (13)4.2.2.2 _constant_ (13)4.2.2.3 _shared_ (14)4.2.2.4 限制 (14)4.2.3 执行配置 (15)4.2.4 内置变量 (15)4.2.4.1 gridDim (15)4.2.4.2 blockIdx (15)4.2.4.3 blockDim (15)4.2.4.4 threadIdx (15)4.2.4.5 warpSize (16)4.2.4.6 限制 (16)4.2.5 使用NVCC 进行编译 (16)4.2.5.1 _noinline_ (16)4.2.5.2 #pragma unroll (16)4.3 通用运行时组件 (17)4.3.1 内置向量类型 (17)4.3.1.1 char1、uchar1、char2、uchar2、char3、uchar3、char4、uchar4、short1、ushort1、short2、ushort2、short3、ushort3、short4、ushort4、int1、uint1、int2、uint2、int3、uint3、int4、uint4、long1、ulong1、long2、ulong2、long3、ulong3、long4、ulong4、float1、float2、float3、float4、double2 (17)4.3.1.2 dim3 类型 (17)4.3.2 数学函数 (17)4.3.3 计时函数 (17)4.3.4 纹理类型 (18)4.3.4.1 纹理参考声明 (18)4.3.4.2 运行时纹理参考属性 (18)4.3.4.3 来自线性存储器的纹理与来自CUDA 数组的纹理 (19)4.4 设备运行时组件 (19)4.4.1 数学函数 (19)4.4.2 同步函数 (19)4.4.3 纹理函数 (19)4.4.3.1 来自线性存储器的纹理 (19)4.4.3.2 来自CUDA 数组的纹理 (20)4.4.4 原子函数 (20)4.4.5 warp vote 函数 (20)4.5 主机运行时组件 (21)4.5.1 一般概念 (21)4.5.1.1 设备 (21)4.5.1.2 存储器 (22)4.5.1.3 OpenGL 互操作性 (22)4.5.1.4 Direct3D 互操作性 (22)4.5.1.5 异步并发执行 (22)4.5.2 运行时API (23)4.5.2.1 初始化 (23)4.5.2.2 设备管理 (23)4.5.2.3 存储器管理 (24)4.5.2.4 流管理 (25)4.5.2.5 事件管理 (25)4.5.2.6 纹理参考管理 (25)4.5.2.7 OpenGL 互操作性 (27)4.5.2.8 Direct3D 互操作性 (27)4.5.2.9 使用设备模拟模式进行调试 (28)4.5.3 驱动程序API (29)4.5.3.1 初始化 (29)4.5.3.2 设备管理 (29)4.5.3.3 上下文管理 (29)4.5.3.4 模块管理 (30)4.5.3.5 执行控制 (30)4.5.3.6 存储器管理 (31)4.5.3.7 流管理 (32)4.5.3.8 事件管理 (32)4.5.3.9 纹理参考管理 (33)4.5.3.10 OpenGL 互操作性 (33)4.5.3.11 Direct3D 互操作性 (33)第 5 章性能指南 (35)5.1 指令性能 (35)5.1.1 指令吞吐量 (35)5.1.1.1 数学指令 (35)5.1.1.2 控制流指令 (36)5.1.1.3 存储器指令 (36)5.1.1.4 同步指令 (37)5.1.2 存储器带宽 (37)5.1.2.1 全局存储器 (37)5.1.2.2 本地存储器 (43)5.1.2.3 固定存储器 (43)5.1.2.4 纹理存储器 (43)5.1.2.5 共享存储器 (43)5.1.2.6 寄存器 (48)5.2 每个块的线程数量 (49)5.3 主机和设备间的数据传输 (49)5.4 纹理获取与全局或固定存储器读取的对比 (50)5.5 整体性能优化战略 (50)第 6 章矩阵乘法示例 (52)6.1 概述 (52)6.2 源代码清单 (53)6.3 源代码说明 (54)6.3.1 Mul() (54)6.3.2 Muld() (54)附录A 技术规范 (56)A.1 一般规范 (56)A.1.1 计算能力1.0 的规范 (56)A.1.2 计算能力1.1 的规范 (57)A.1.3 计算能力1.2 的规范 (57)A.1.4 计算能力1.3 的规范 (57)A.2 浮点标准 (57)附录B 标准数学函数 (59)B.1 一般运行时组件 (59)B.1.1 单精度浮点函数 (59)B.1.2 双精度浮点函数 (60)B.1.3 整型函数 (62)B.2 设备运行时组件 (62)B.2.1 单精度浮点函数 (62)B.2.2 双精度浮点函数 (63)B.2.3 整型函数 (64)附录C 原子函数 (65)C.1 数学函数 (65)C.1.1 atomicAdd() (65)C.1.2 atomicSub() (65)C.1.3 atomicExch() (65)C.1.4 atomicMin() (65)C.1.5 atomicMax() (66)C.1.6 atomicInc() (66)C.1.7 atomicDec() (66)C.1.8 atomicCAS() (66)C.2 位逻辑函数 (66)C.2.1 atomicAnd() (66)C.2.2 atomicOr() (67)C.2.3 atomicXor() (67)附录D 纹理获取 (68)D.1 最近点取样 (68)D.2 线性过滤 (69)D.3 表查找 (69)图表目录图1-1. CPU 和GPU 的每秒浮点运算次数和存储器带宽图1-2. GPU 中的更多晶体管用于数据处理...... .............. .......... .............. .............. (2)图2-1. 线程块网格.......................................... ....... ..................... (5)图2-2. 存储器层次结构................................. .............. . (6)图2-3. 异构编程............................................... .............. .............. .............. (7)图2-4. 计算统一设备架构软件栈................ .............. .............. .............. .. .. (8)图3-1. 硬件模型................................................................... .............. . (10)图4-1. 库上下文管理......................................................... .............. ....... ......... (30)图5-1. 接合后的存储器访问模式示例................... .............. .............. .............. .............. . (39)图5-2. 未为计算能力是 1.0 或1.1 的设备接合的全局存储器访问模式示例 (40)图5-3. 未为计算能力是 1.0 或1.1 的设备接合的全局存储器访问模式示例 (41)图5-4. 计算能力为 1.2 或更高的设备的全局存储器访问示例..... .............. ............ .. .. (42)图5-5. 无存储体冲突的共享存储器访问模式示例... .............. .............. .............. .............. (45)图5-6. 无存储体冲突的共享存储器访问模式示例... .............. .............. .............. .............. (46)图5-7. 有存储体冲突的共享存储器访问模式示例......... .............. .............. .............. (47)图5-8. 使用广播机制的共享存储器读取访问模式示例... .............. .............. .............. (48)图6-1. 矩阵乘法........................................................... .............. .............. (52)第 1 章简介1.1 CUDA:可伸缩并行编程模型多核CPU 和多核GPU 的出现意味着并行系统已成为主流处理器芯片。

详解CUDA编程

详解CUDA编程CUDA 是 NVIDIA 的 GPGPU 模型,它使⽤ C 语⾔为基础,可以直接以⼤多数⼈熟悉的 C 语⾔,写出在显⽰芯⽚上执⾏的程序,⽽不需要去学习特定的显⽰芯⽚的指令或是特殊的结构。

”编者注:NVIDIA的GeFoce 8800GTX发布后,它的通⽤计算CUDA经过⼀年多的推⼴后,现在已经在有相当多的论⽂发表,在商业应⽤软件等⽅⾯也初步出现了视频编解码、⾦融、地质勘探、科学计算等领域的产品,是时候让我们对其作更深⼀步的了解。

为了让⼤家更容易了解CUDA,我们征得Hotball的本⼈同意,发表他最近亲⾃撰写的本⽂。

这篇⽂章的特点是深⼊浅出,也包含了hotball本⼈编写⼀些简单CUDA程序的亲⾝体验,对于希望了解CUDA的读者来说是⾮常不错的⼊门⽂章,PCINLIFE对本⽂的发表没有作任何的删减,主要是把⼀些台湾的词汇转换成⼤陆的词汇以及作了若⼲"编者注"的注释。

现代的显⽰芯⽚已经具有⾼度的可程序化能⼒,由于显⽰芯⽚通常具有相当⾼的内存带宽,以及⼤量的执⾏单元,因此开始有利⽤显⽰芯⽚来帮助进⾏⼀些计算⼯作的想法,即 GPGPU。

即是的 GPGPU 模型。

NVIDIA 的新⼀代显⽰芯⽚,包括 GeForce 8 系列及更新的显⽰芯⽚都⽀持 CUDA。

NVIDIA 免费提供 CUDA 的开发⼯具(包括 Windows 版本和版本)、程序范例、⽂件等等,可以在下载。

使⽤显⽰芯⽚来进⾏运算⼯作,和使⽤ CPU 相⽐,主要有⼏个好处:1. 显⽰芯⽚通常具有更⼤的内存带宽。

例如,NVIDIA 的 GeForce 8800GTX 具有超过 50GB/s 的内存带宽,⽽⽬前⾼阶 CPU 的内存带宽则在 10GB/s 左右。

2. 显⽰芯⽚具有更⼤量的执⾏单元。

例如 GeForce 8800GTX 具有 128 个 "stream processors",频率为 1.35GHz。

【SoCVista】NVIDIA_CUDA_Programming_Guide_2.0_cn

NVIDIA CUDA计算统一设备架构编程指南版本 2.06 /7 / 2008目录目录 (iii)图表目录 (vi)第1 章简介 (1)1.1 CUDA:可伸缩并行编程模型 (1)1.2 GPU:高度并行化的多线程、众核处理器 (1)1.3 文档结构 (3)第2章编程模型 (4)2.1 线程层次结构 (4)2.2 存储器层次结构 (6)2.3 宿主和设备 (7)2.4 软件栈 (8)2.5 计算能力 (9)第3 章GPU 实现 (10)3.1 具有片上共享存储器的一组SIMT 多处理器 (10)3.2 多个设备 (12)3.3 模式切换 (12)第4 章应用程序编程接口 (13)4.1 C 编程语言的扩展 (13)4.2 语言扩展 (13)4.2.1 函数类型限定符 (13)4.2.1.1 __device__ (13)4.2.1.2 __global__ (14)4.2.1.3 __host__ (14)4.2.1.4 限制 (14)4.2.2 变量类型限定符 (14)4.2.2.1 __device__ (14)4.2.2.2 __constant__ (14)4.2.2.3 __shared__ (15)4.2.2.4 限制 (15)4.2.3 执行配置 (16)4.2.4 内置变量 (16)4.2.4.1 gridDim (16)4.2.4.2 blockIdx (16)4.2.4.3 blockDim (16)4.2.4.4 threadIdx (16)4.2.4.5 warpSize (17)4.2.4.6 限制 (17)4.2.5 使用NVCC 进行编译 (17)4.2.5.1 __noinline__ (17)4.2.5.2 #pragma unroll (17)4.3 通用运行时组件 (18)4.3.1 内置向量类型 (18)4.3.1.1 char1、uchar1、char2、uchar2、char3、uchar3、char4、uchar4、short1、ushort1、short2、ushort2、short3、ushort3、short4、ushort4、int1、uint1、int2、uint2、int3、uint3、int4、uint4、long1、ulong1、long2、ulong2、long3、ulong3、long4、ulong4、float1、float2、float3、float4、double2 (18)4.3.1.2 dim3 类型 (18)4.3.2 数学函数 (18)4.3.3 计时函数 (18)4.3.4 纹理类型 (19)4.3.4.1 纹理参考声明 (19)4.3.4.2 运行时纹理参考属性 (19)4.3.4.3 来自线性存储器的纹理与来自CUDA 数组的纹理 (20)4.4 设备运行时组件 (20)4.4.1 数学函数 (20)4.4.2 同步函数 (20)4.4.3 纹理函数 (21)4.4.3.1 来自线性存储器的纹理 (21)4.4.3.2 来自CUDA 数组的纹理 (21)4.4.4 原子函数 (21)4.4.5 Warp vote 函数 (22)4.5 宿主运行时组件 (22)4.5.1 一般概念 (22)4.5.1.1 设备 (22)4.5.1.2 存储器 (23)4.5.1.3 OpenGL 互操作性 (23)4.5.1.4 Direct3D 互操作性 (23)4.5.1.5 异步并发执行 (23)4.5.2 运行时API (24)4.5.2.1 初始化 (24)4.5.2.2 设备管理 (24)4.5.2.3 存储器管理 (25)4.5.2.4 流管理 (26)4.5.2.5 事件管理 (26)4.5.2.6 纹理参考管理 (27)4.5.2.7 OpenGL 互操作性 (28)4.5.2.8 Direct3D 互操作性 (28)4.5.2.9 使用设备模拟模式进行调试 (29)4.5.3 驱动程序API (30)4.5.3.1 初始化 (30)4.5.3.2 设备管理 (30)4.5.3.3 上下文管理 (30)4.5.3.4 模块管理 (31)4.5.3.5 执行控制 (31)4.5.3.6 存储器管理 (32)4.5.3.7 流管理 (33)4.5.3.8 事件管理 (33)4.5.3.9 纹理参考管理 (34)4.5.3.10 OpenGL 互操作性 (34)4.5.3.11 Direct3D 互操作性 (35)第5 章性能指南 (36)5.1 指令性能 (36)5.1.1指令吞吐量 (36)5.1.1.1 数学指令 (36)5.1.1.2 控制流指令 (37)5.1.1.3 存储器指令 (37)5.1.1.4 同步指令 (38)5.1.2 存储器带宽 (38)5.1.2.1 全局存储器 (38)5.1.2.2 本地存储器 (44)5.1.2.3 常量存储器 (44)5.1.2.4 纹理存储器 (44)5.1.2.5 共享存储器 (44)5.1.2.6 寄存器 (49)5.2 每个块的线程数量 (50)5.3 宿主和设备间的数据传输 (50)5.4 纹理拾取与全局或常量存储器读取的对比 (51)5.5 整体性能优化策略 (51)第6 章矩阵乘法示例 (53)6.1 概述 (53)6.2 源代码清单 (54)6.3 源代码说明 (55)6.3.1 Mul() (55)6.3.2 Muld() (55)附录A技术规范 (57)A.1 一般规范 (57)A.1.1 计算能力1.0 的规范 (57)A.1.2 计算能力1.1 的规范 (58)A.1.3 计算能力1.2 的规范 (58)A.1.4 计算能力1.3 的规范 (58)A.2 浮点标准 (58)附录B标准数学函数 (60)B.1 通用运行时组件 (60)B.1.1 单精度浮点函数 (60)B.1.2 双精度浮点函数 (62)B.1.3 整型函数 (63)B.2 设备运行时组件 (63)B.2.1 单精度浮点函数 (64)B.2.2 双精度浮点函数 (65)B.2.3 整型函数 (65)附录C原子函数 (66)C.1 数学函数 (66)C.1.1 atomicAdd() (66)C.1.2 atomicSub() (66)C.1.3 atomicExch() (66)C.1.4 atomicMin() (66)C.1.5 atomicMax() (67)C.1.6 atomicInc() (67)C.1.7 atomicDec() (67)C.1.8 atomicCAS() (67)C.2 位逻辑函数 (67)C.2.1 atomicAnd() (67)C.2.2 atomicOr() (68)C.2.3 atomicXor() (68)附录D纹理拾取 (69)D.1 最近点采样 (69)D.2 线性过滤 (70)D.3 表查找 (70)录表目录图表目图1-1. CPU 和GPU 的每秒浮点运算次数和存储器带宽...... ......... ..... .............. (2)图1-2. GPU 中的更多晶体管用于数据处理...... .............. .......... .............. .............. (2)图2-1. 线程块网格.......................................... ....... ..................... (6)图2-2. 存储器层次结构................................. .............. . (7)图2-3. 异构编程............................................... ............. .............. .............. (8)图2-4. CUDA软件栈................ .............. .............. ..................... .............. .. .. (9)图3-1. 硬件模型................................................................... .............. . (11)图4-1. 库上下文管理......................................................... .............. ....... ......... (31)图5-1. 存储器合并后的存储器访问模式示例................... .............. .............. .............. .. ........ ..40 图5-2. 未为计算能力是1.0 或1.1 的设备进行存储器合并的全局存储器访问模式示例. (41)图5-3. 未为计算能力是1.0 或1.1 的设备进行存储器合并的全局存储器访问模式示例... .42 图5-4. 计算能力为1.2 或更高的设备的全局存储器访问示例..... .............. ............ .. .. (43)图5-5. 无存储体冲突的共享存储器访问模式示例... .............. .............. .............. .............. (46)图5-6. 无存储体冲突的共享存储器访问模式示例... .............. .............. .............. .............. (47)图5-7. 有存储体冲突的共享存储器访问模式示例......... .............. .............. .............. (48)图5-8. 使用广播机制的共享存储器读取访问模式示例... .............. .............. .............. (49)图6-1. 矩阵乘法........................................................... .............. .............. (53)第 1 章简介1.1 CUDA:可伸缩并行编程模型多核CPU 和众核(manycore)GPU 的出现意味着主流处理器芯片已进入并行时代。

cuda发展历程

cuda发展历程CUDA是一种用于并行计算的计算机平台和编程模型。

它由NVIDIA公司开发,最初是为了支持其图形处理器(GPU)上的并行计算任务而设计的。

下面是CUDA发展历程的相关参考内容:1. GPGPU计算的出现:在20世纪90年代,NVIDIA的工程师们开始尝试将GPU用于通用计算,即将其作为一个通用的并行计算设备。

他们发现GPU的高度并行的结构使其特别适合某些计算密集型任务,如科学计算和图像处理。

2. CUDA的起源:为了更好地支持GPU的并行计算功能,NVIDIA于2006年推出了CUDA(Compute Unified Device Architecture)平台和编程模型。

CUDA允许程序员使用类似于C语言的编程语言来编写并在GPU上执行并行计算任务。

3. 第一代CUDA架构:NVIDIA在2006年推出了第一代CUDA架构,它被称为“Tesla”。

这个架构引入了CUDA C编程语言和CUDA C++编译器,使开发人员能够通过CUDAAPI直接访问和操作GPU上的并行计算单元。

4. CUDA的普及:随着第一代CUDA架构的推出,越来越多的开发人员和研究机构开始关注和使用CUDA进行并行计算。

这一点由NVIDIA与多家全球领先的研究机构和大学合作的事实所证明,他们一起建立了CUDA Research Centers计划。

5. CUDA的演化:随着时间的推移,CUDA平台不断演化并引入了新的功能和技术。

例如,在2008年,NVIDIA推出了CUDA 2.0,它引入了共享内存和动态并行调度等新功能,进一步增强了CUDA平台的灵活性和性能。

6. CUDA的扩展:除了在科学计算领域的应用,CUDA还在其他领域得到了扩展。

例如,CUDA被广泛应用于机器学习和深度学习,在这些领域的算法通常需要进行大量的并行计算。

7. CUDA在超级计算中的应用:CUDA相对于传统的CPU并行计算而言具有更高的计算能力和能效比。

pytorch的cuda编程教程

pytorch的cuda编程教程CUDA是一种用于在GPU上进行并行计算的编程模型。

而PyTorch作为一种强大的深度学习框架,提供了对CUDA加速的支持。

本教程将向您介绍如何在PyTorch中使用CUDA进行编程。

首先,您需要确保您的系统上安装了合适的CUDA驱动程序和CUDA工具包。

然后,您需要安装合适版本的PyTorch,以确保其与您的CUDA驱动程序兼容。

在PyTorch中,使用CUDA加速主要涉及两个步骤:将数据和模型转移到GPU上进行计算,并使用GPU执行计算。

首先,您可以使用`.to()`方法将PyTorch的张量(Tensor)数据移动到GPU上。

例如,假设您有一个张量`x`,您可以使用以下代码将其移动到GPU上:```pythonx = x.to('cuda')```此外,如果您有一个模型,您可以使用以下代码将其转移到GPU上:```pythonmodel = model.to('cuda')```这样,所有模型的参数和计算都将在GPU上执行。

其次,当您想要在GPU上执行计算时,您需要将输入数据与模型都设置为GPU上的张量。

例如,假设您有一批训练数据`inputs`和`labels`,您可以使用以下代码将它们移动到GPU上:```pythoninputs = inputs.to('cuda')labels = labels.to('cuda')```接下来,您可以将数据输入到模型中,并在GPU上执行计算:```pythonoutputs = model(inputs)```最后,别忘了将输出数据移回CPU上,以便进一步处理或进行显示:```pythonoutputs = outputs.to('cpu')```需要注意的是,如果您的系统上没有GPU,或者您的GPU内存不足以容纳所有数据,您可以使用`.cuda()`方法将模型或数据从CPU转移到GPU上,在这种情况下使用的代码与上述代码类似。

cuda发展历程

cuda发展历程CUDA(Compute Unified Device Architecture)是由NVIDIA 公司推出的一种并行计算模型和编程框架,可利用显卡的GPU(图形处理器)进行高性能并行计算。

CUDA的发展历程如下:- 2006年:NVIDIA推出了第一个支持CUDA的显卡Tesla。

- 2007年:NVIDIA发布了CUDA开发工具包(CUDA Toolkit),使开发者可以使用CUDA编程模型进行开发,利用GPU进行并行计算。

- 2008年:推出了第一个支持双精度浮点数运算的显卡Tesla C1060。

- 2009年:发布了CUDA 2.0版本,引入了动态并行调度(Dynamic Parallelism)的概念,开发者可以在GPU上启动更多的线程,并且线程可以递归地启动其他线程。

- 2010年:发布了CUDA 3.0版本,引入了统一虚拟地址空间(Unified Virtual Addressing)的概念,使得CPU和GPU可以共享同一块内存。

- 2011年:发布了CUDA 4.0版本,支持C++编程,并引入了C++11标准的一些特性。

- 2012年:发布了CUDA 5.0版本,引入了动态并行规约(Dynamic Parallelism Reduction)的概念,使得开发者可以在GPU上进行更加灵活的并行规约操作。

- 2013年:发布了CUDA 6.0版本,引入了支持GPU内存分配和管理的Unified Memory概念。

- 2014年:发布了CUDA 7.0版本,引入了CUDNN(CUDADeep Neural Network library),提供了一套高性能的深度学习库,用于加速神经网络的训练和推断。

- 2015年:发布了CUDA 7.5版本,引入了Dynamic Parallelism的改进和扩展,进一步提高了GPU的可编程性和灵活性。

- 2016年:发布了CUDA 8.0版本,引入了支持并行计算任务调度的异步处理流(Stream)机制,提供了更好的任务并行性和资源利用率。

cuda教程

cuda教程CUDA 是一种并行计算平台和编程模型,用于利用 NVIDIA GPU 的计算能力。

本教程旨在介绍 CUDA 并提供一些基本的示例代码,以帮助初学者理解和使用 CUDA 编程。

安装 CUDA要开始使用 CUDA,首先需要在计算机上安装 CUDA 工具包和驱动程序。

您可以从 NVIDIA 的官方网站上下载相应的安装包,并按照指示进行安装。

安装完成后,您就可以使用CUDA 了。

编写 CUDA 程序CUDA 程序是由 CPU 和 GPU 两部分组成的。

CPU 部分负责协调和控制计算任务的分发,而 GPU 部分则负责实际的计算工作。

在编写 CUDA 程序时,您需要区分 CPU 和 GPU 代码,并合理地进行任务分配。

CUDA 编程模型CUDA 使用了一种称为「流式处理」的并行计算模型。

在CUDA 中,将计算任务划分为多个线程块(thread block),并将线程块分配给 GPU 的多个处理器进行并行计算。

每个线程块里面又包含多个线程,线程之间可以进行通信和同步。

CUDA 编程语言CUDA 可以使用多种编程语言进行开发,包括 C、C++ 和Fortran 等。

下面是一个简单的示例,演示了如何使用 CUDAC 编写一个向量相加的程序。

```c#include <stdio.h>__global__ void vector_add(int *a, int *b, int *c, int n) { int i = threadIdx.x;if (i < n) {c[i] = a[i] + b[i];}}int main(void) {int n = 10;int *a, *b, *c;int *d_a, *d_b, *d_c;int size = n * sizeof(int);// 分配设备内存cudaMalloc((void **)&d_a, size);cudaMalloc((void **)&d_b, size);cudaMalloc((void **)&d_c, size);// 分配主机内存a = (int *)malloc(size);b = (int *)malloc(size);c = (int *)malloc(size);// 初始化向量for (int i = 0; i < n; i++) {a[i] = i;b[i] = i * 2;}// 将数据从主机内存复制到设备内存cudaMemcpy(d_a, a, size, cudaMemcpyHostToDevice); cudaMemcpy(d_b, b, size, cudaMemcpyHostToDevice);// 启动 GPU 计算vector_add<<<1, n>>>(d_a, d_b, d_c, n);// 将结果从设备内存复制到主机内存cudaMemcpy(c, d_c, size, cudaMemcpyDeviceToHost);// 打印结果for (int i = 0; i < n; i++) {printf("%d + %d = %d\n", a[i], b[i], c[i]);}// 释放内存free(a);free(b);free(c);cudaFree(d_a);cudaFree(d_b);cudaFree(d_c);return 0;}```在这个示例中,我们定义了一个向量相加函数 `vector_add`,并在主函数中调用它。

(2024年)CUDA教程新手入门学编程

管理、并行计算等关键技能。

图像处理算法并行化

02

学习如何将图像处理算法进行并行化设计,以便在GPU上实现

高效处理。

CUDA优化技巧

03

了解CUDA编程中的优化技巧,如内存访问优化、线程同步等

,以提高图像处理程序的性能。

21

效果展示与性能对比

效果展示

性能分析

案例分享

将基于CUDA实现的图像处理 程序与常规CPU处理程序进行 对比,展示其在处理速度、效 果等方面的优势。

内存管理

合理利用CUDA的内存层次结构,如全局内存、 共享内存和寄存器,以提高程序性能。

优化同步

避免不必要的线程同步,减少等待时间,提高并 行计算效率。

ABCD

2024/3/26

并行化策略

设计高效的并行算法,利用CUDA的多线程并行 计算能力,加速程序运行。

错误处理

编写健壮的错误处理代码,确保程序在出现异常 时能够正确处理。

配置开发环境

在安装CUDA工具包后,需要配 置开发环境,包括设置环境变量 、添加库文件路径等。这些配置 可以确保在编译和运行CUDA程 序时能够找到正确的库和工具。

2024/3/26

选择合适的IDE

为了方便编写和调试CUDA程序 ,可以选择一个合适的集成开发 环境(IDE),如NVIDIA Nsight 、Visual Studio等。这些IDE提 供了丰富的功能和工具,可以提 高开发效率。

2024/3/26

04

使用共享内存来减少访存延迟。

05

对数据进行合理的划分和排布,以减少数据传输的开销。

06

使用CUDA提供的数学库函数(如cublas、cusparse等) 来加速计算。

NVIDIACUDA编程指南

NVIDIACUDA编程指南引言:CUDA编程模型:CUDA编程模型是一种基于主机-设备计算模式的编程范式。

在CUDA 编程中,主机(CPU)将计算任务分配给设备(GPU)来执行,并通过主机和设备之间的数据传输来协调计算过程。

CUDA编程模型包括两个关键概念:主机代码和设备代码。

主机代码是在主机上执行的代码,通常由CPU执行。

主机代码用于控制计算过程,包括任务的创建、数据的传输和设备的管理。

主机代码使用CUDA API(Application Programming Interface)来与设备进行交互。

设备代码是在设备上执行的代码,通常由GPU执行。

设备代码是并行的,可以同时执行多个线程来进行计算。

设备代码使用CUDA核函数(Kernel)来定义并行任务,并由设备上的线程执行。

CUDA编程的基本步骤:1.初始化CUDA环境:首先,需要初始化CUDA环境,包括选择合适的设备、创建CUDA上下文等。

可以使用CUDAAPI来完成这些操作。

2.分配和传输数据:在进行计算之前,需要将数据从主机内存传输到设备内存。

可以使用CUDAAPI中的内存管理函数来分配和传输数据。

4.处理计算结果:核函数在设备上执行完毕后,可以将计算结果传输回主机内存。

可以使用CUDAAPI中的数据传输函数来完成这一步骤。

5.清理CUDA环境:最后,需要清理CUDA环境,包括释放设备内存、销毁CUDA上下文等。

同样,可以使用CUDAAPI来完成这些操作。

CUDA编程的优势和应用领域:CUDA编程具有以下优势:1.高性能:利用GPU进行并行计算可以显著提高计算性能,特别是在需要处理大量数据的科学计算、数据分析和机器学习等领域。

2.灵活性:CUDA编程提供了丰富的工具和库,可以方便地开发各种类型的并行计算应用,包括图像处理、物理模拟、信号处理等。

3.可移植性:由于CUDA是一种通用的并行计算平台,可以在不同的硬件平台上进行开发和使用。

NVIDIA还提供了一套CUDA工具链,可以方便地将CUDA代码移植到不同的平台上。

CUDA C++ 编程指南版本12.0 NVIDIA 2023年2月21日说明书

Just-in-Time Compilation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

6.1.2 Binary Compatibility . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

5.3 Memory Hierarchy . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

5.4 Heterogeneous Programming . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

6.1.1 Compilation Workflow . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

Offline Compilation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

6.2.8 Asynchronous Concurrent Execution . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45 Concurrent Execution between Host and Device . . . . . . . . . . . . . . . . . . . . . 46 Concurrent Kernel Execution . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46 Overlap of Data Transfer and Kernel Execution . . . . . . . . . . . . . . . . . . . . . . 47 Concurrent Data Transfers . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 Streams . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 Creation and Destruction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 Default Stream . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48 Explicit Synchronization . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49 Implicit Synchronization . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49 Overlapping Behavior . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49 Host Functions (Callbacks) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50 Stream Priorities . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51 Programmatic Dependent Launch and Synchronization . . . . . . . . . . . . . . . . . 51 Background . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51 API Description . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52 CUDA Graphs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53 Graph Structure . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54 Creating a Graph Using Graph APIs . . . . . . . . . . . . . . . . . . . . . . . . . 55 Creating a Graph Using Stream Capture . . . . . . . . . . . . . . . . . . . . . . 56 Updating Instantiated Graphs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58 Using Graph APIs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61 Device Graph Launch . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62 Events . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69 Creation and Destruction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69 Elapsed Time . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70 Synchronous Calls . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

2024版CUDA编程指南30中文版pdf

CUDA编程指南30中文版pdf目录CATALOGUE•CUDA 概述与基础•内存管理与数据传输•线程同步与并发控制•CUDA 核函数设计与优化•多GPU 编程技术探讨•CUDA 在图像处理中的应用•总结与展望01CATALOGUE CUDA概述与基础CUDA(Compute Unified Device Architecture)是NVIDIA推出的并行计算平台和API模型,允许开发者使用NVIDIA GPU进行通用计算。

CUDA的发展历程始于2006年,当时NVIDIA发布了CUDA的第一个版本,为开发者提供了一种利用GPU进行高性能计算的新途径。

随着CUDA的不断发展,其应用领域逐渐扩展,包括科学计算、数据分析、深度学习、图形处理等多个领域。

CUDA定义及发展历程GPU(Graphics Processing Unit)架构是CUDA的基础,CUDA利用GPU中的并行处理单元进行高性能计算。

CUDA编程模型针对GPU架构进行了优化,使得开发者能够充分利用GPU的计算能力,提高程序的执行效率。

随着GPU架构的不断发展,CUDA也在不断升级和改进,以适应新的硬件特性和性能需求。

010203 GPU架构与CUDA关系编程模型及基本概念01CUDA编程模型包括主机端(Host)和设备端(Device)两部分,其中主机端负责逻辑控制和数据传输,设备端负责并行计算。

02CUDA中的基本概念包括线程(Thread)、线程块(Block)、网格(Grid)等,这些概念构成了CUDA的并行计算模型。

03开发者需要了解这些基本概念及其之间的关系,以便编写高效的CUDA程序。

开发环境搭建与配置01搭建CUDA开发环境需要安装CUDA工具包(Toolkit)和相应的驱动程序。

02配置开发环境时需要注意操作系统、编译器等软件的兼容性问题。

03在配置过程中可能遇到的一些问题包括驱动不兼容、编译错误等,需要仔细检查和调试。

cuda发展历程

cuda发展历程2006年6月,美国半导体制造商NVIDIA公司发布了CUDA (Compute Unified Device Architecture)这一并行计算平台和编程模型,它将当时NVIDIA图形处理器(GPU)的潜力拓展到通用计算领域。

CUDA的出现标志着GPU并行计算的革命,极大地推动了科学计算、机器学习和人工智能等领域的发展。

一、CUDA的初衷和概念CUDA的初衷是利用GPU强大的并行处理能力来加速科学计算任务。

之前,GPU主要用于图形渲染,而传统的CPU在并行计算方面的表现有限。

CUDA的概念是通过将计算任务分解为多个并行线程,在GPU上同时执行这些线程以加速计算过程。

这种基于并行的计算模型为科学家和工程师们提供了一个高性能、易用的平台。

二、CUDA的发展里程碑1. 第一代CUDA架构(2007年)NVIDIA在2007年发布了第一代支持CUDA的图形处理器,该架构提供了大量的核心数和全新的线程模型,使得计算性能得到了显著提升。

研究人员和开发者们开始尝试使用CUDA来解决各种科学计算问题,取得了令人瞩目的成果。

2. CUDA C/C++编程语言(2007年)为了简化CUDA编程的难度,NVIDIA公司在2007年发布了CUDA C/C++编程语言。

这个扩展自C/C++的编程语言使得开发者可以更方便地利用GPU进行并行计算,打破了以往GPU编程的限制。

3. CUDA 2.0和GPU互操作(2008年)CUDA 2.0的发布引入了GPU互操作的概念,使得GPU和CPU能够更紧密地结合起来。

这种互操作性使得开发者们能够在应用程序中有效地将CPU和GPU的计算能力结合起来,达到更高的性能。

4. CUDA 3.0和动态并行调度(2010年)CUDA 3.0引入了动态并行调度(Dynamic Parallelism)的概念,这是CUDA的一个里程碑式的突破。

动态并行调度允许GPU线程中创建新的线程,使得计算任务的粒度更细,进一步提高了并行计算的效率和灵活性。

NVIDIA Parallel Nsight 2.0和CUDA 4.0技术更新说明书

NVIDIA Parallel Nsight™ 2.0 and CUDA 4.0 for the Win!Jeff Kiel, Manager of Graphics Tools NVIDIA Corporation, SIGGRAPH 2011AgendaCUDA UpdateNVIDIA Parallel NsightCUDA Debugging and ProfilingGraphics Debugging and ProfilingApplication AnalysisCUDA Update: New in 4.0Easier ProgrammingUse any GPU on any threadC++ new/delete and support for virtual functionsInline PTX assemblyThrust C++ Template Performance Primitives Libraries (sort, reduce, etc.) NVIDIA Performance Primitives library (image/video processing) Faster Multi-GPU ProgrammingUnified Virtual Addressing (UVA)GPU Direct 2.0: GPU peer-to-peer communication technology Developer Tools for Linux and MacOSCUDA-GDBVisual Profiler with Automated Performance AnalysisVisual Studio with Parallel Nsight Integrated development for CPU and GPUBuild Debug ProfileNVIDIA Parallel Nsight for Graphics & Compute Graphics Inspector Real-time inspection of Direct3D API calls Investigate GPU pipeline state See contributing fragments with Pixel History Profile frames to find GPU bottlenecksSystem AnalysisView CPU & GPU events on a single timelineExamine workload dependenciesCUDA, Direct3D, and OpenGL API TraceProfile CUDA kernels using performance counters Free License!CUDA/Graphics Debugger Visual Studio debugging environment GPU Accelerated CUDA and HLSL debugging Examine code executing in parallel Conditional breakpoints, memory viewer, etc.Host + Target (32/64 bit)✓System Analysis✓Graphics InspectorInstall appropriate NVIDIA driverInstall Parallel Nsight Host and MonitorHost + Target (32/64 bit)✓System Analysis✓Graphics Inspector✓CUDA DebuggerInstall appropriate NVIDIA driverInstall Parallel Nsight Host and MonitorConfigure Local Headless Debugging (see User’s Manual)✓System Analysis ✓Graphics Inspector ✓CUDA Debugger ✓Graphics DebuggerNetwork Target (32/64-bit)Host (32/64-bit)Two computers, one with NVIDIA GPUs Install appropriate NVIDIA driver on the Target System Install Parallel Nsight Monitor on the Target System Install Parallel Nsight Host on the Development SystemHost + Target (32/64-bit)Install Parallels Desktop and guest OS Install appropriate NVIDIA drivers Install Parallel Nsight Host and Monitor One computer, two NVIDIA GPUs Full GPU acceleration✓System Analysis✓Graphics Inspector✓CUDA Debugger✓Graphics DebuggerFFT Ocean Demo OverviewBased on “Simulating Ocean Water” by Jerry Tenssendorf Statistical model, not physics basedGenerates wave distribution in frequency domain on GPUInverse FFT on GPUMovies: Large height map (2048x2048)Games on CPU: Small height map (64x64)GPU Based: Medium height map (512x512)The ocean surface is composed by enormous simple wavesEach simple wave is a hybrid sine wave (Gerstner wave)A mass point on the surface is doing vertical circular motionScene Rendering ComponentsWave Simulation in CUDARendering in DX11Demo: Launching…Start Nsight MonitorConfigure Parallel Nsight Project SettingsLaunch Your ApplicationDemo: Graphics Debugging -HUDDemo: HUD Showing 2x2 TextureDemo: HUD in Graphics InspectorDemo: HUD Render Target, Depth & StencilDemo: Host Frames PageDemo: Draw Call PageDemo: Texture ViewerDemo: Pixel Shader State InspectorDemo: Buffer InspectorDemo: Output Merger InspectorDemo: Pixel HistoryDemo: Shader Debugger BreakpointView all graphics resources at a glance Version 2.0Numerous usability and workflow improvementsGraphics profiler performance and accuracyDriver independenceStability improvementsSupport for latest drivers and hardwareVersion 2.0CUDA Toolkit 4.0 SupportFull Visual Studio 2010 Platform Support Tesla Compute Cluster (TCC) Analysis PTX Assembly DebuggingAttach to ProcessDerived Metrics and Experiments Concurrent Kernel TraceRuntime API TraceAdvanced Conditional Breakpoints Support for latest drivers hardwareWrap Up…Thank You!Call to action!Download Parallel Nsight and try it outSend us feedback on what features you find important Come talk to us here at SIGGRAPHContact us on the NVIDIA Developer Forums/index.php?showforum=191。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

编程指南

版本 2.0

6 / 7 / 2008

A 编程指南,版本 2.0

i

ii

CUDA 编程指南,版本 2.0

目

第 1 章 1.1 1.2 1.3 第2章 2.1 2.2 2.3 2.4 2.5 第 3 章 3.1 3.2 3.3 第 4 章 4.1 4.2

录

简介.................................................................................................................................................... 1 CUDA:可伸缩并行编程模型................................................................................................................ 1 GPU:高度并行化、多线程、多核处理器........................................................................................... 1 文档结构................................................................................................................................................... 3 编程模型............................................................................................................................................ 4 线程层次结构........................................................................................................................................... 4 存储器层次结构....................................................................................................................................... 6 主机和设备............................................................................................................................................... 6 软件栈....................................................................................................................................................... 7 计算能力................................................................................................................................................... 8 GPU 实现.......................................................................................................................................... 9 具有芯片共享存储器的一组 SIMT 多处理器...................................................................................... 9 多个设备................................................................................................................................................. 11 模式切换................................................................................................................................................. 11 应用程序编程接口.......................................................................................................................... 12 C 编程语言的扩展.................................................................................................................................12 语言扩展................................................................................................................................................. 12 4.2.1 函数类型限定符.......................................................................................................................... 12 4.2.1.1 _device_.............................................................................................................................12 4.2.1.2 _global_............................................................................................................................. 13 4.2.1.3 _host_.................................................................................................................................13 4.2.1.4 限制................................................................................................................................... 13 4.2.2 变量类型限定符.......................................................................................................................... 13 4.2.2.1 _device_.............................................................................................................................13 4.2.2.2 _constant_..........................................................................................................................13 4.2.2.3 _shared_.............................................................................................................................14 4.2.2.4 限制................................................................................................................................... 14 4.2.3 执行配置...................................................................................................................................... 15 4.2.4 内置变量...................................................................................................................................... 15 4.2.4.1 gridDim...................