数据库系统实现实验报告1

数据库实验报告1

数据库实验报告1一、实验目的熟悉sql数据定义语言,能够熟练使用sql语句来创建和更改基本表,创建和取消索引。

二、实验内容1、创建数据库表CUSTOMERS(CID,CNAME,CITY,DISCNT)数据库表AGENTS(AID,ANAME,CITY,PERCENT)、数据库表PRODUCTS(PID,PNAME),其中,CID,AID,PID 分别是各表的主键,具有唯一性约束。

createtable CUSTOMERS(CID char(8)notnull primarykey,CNAME char(16),CITY char(16),DISCNT int)createtable AGENTS(AID char(8)notnull primarykey,ANAME char(16),CTIY char(16),PERCENTS float,)createtable PRODUCTS(PID char(8)notnull primarykey,PNAME char(16),)2、创建数据库表ORDERS(ORDNA,MONTH,CID,AID,PID,QTY,DOLLARS)。

其中ORDNA是主键,具有唯一性约束。

CID,AID,PID分别是外键引用自表CUSTOMERS、AGENTS、PRODUCTS。

createtable ORDERS( ORDNA char(8)notnull primarykey,MONTHS int,CID char(8)notnull unique,AID char(8)notnull unique,PID char(8)notnull unique,foreignkey(CID)references CUSTOMERS ondeletecascade,foreignkey(AID)references AGENTS,foreignkey(PID)references PRODUCTS,)3、增加数据库表PRODUCTS三个属性列,CITY,QUANTITY,PRICE。

数据库实验实验报告

一、实验目的1. 熟悉数据库的基本概念和结构。

2. 掌握数据库的创建、修改和删除操作。

3. 熟练运用SQL语言进行数据的查询、插入、更新和删除操作。

4. 了解数据库的安全性和备份与恢复。

二、实验环境1. 操作系统:Windows 102. 数据库管理系统:MySQL 5.73. 开发工具:MySQL Workbench三、实验内容1. 创建数据库2. 创建表3. 插入数据4. 查询数据5. 更新数据6. 删除数据7. 修改表结构8. 删除表9. 数据库备份与恢复四、实验步骤1. 创建数据库(1)打开MySQL Workbench,连接到本地MySQL服务器。

(2)在“查询”窗口中输入以下SQL语句创建数据库:```sqlCREATE DATABASE student;```(3)执行SQL语句,创建名为student的数据库。

2. 创建表(1)在“查询”窗口中输入以下SQL语句创建学生表:```sqlCREATE TABLE student (id INT PRIMARY KEY,name VARCHAR(50),age INT,gender VARCHAR(10));```(2)执行SQL语句,创建名为student的表。

3. 插入数据(1)在“查询”窗口中输入以下SQL语句插入数据:```sqlINSERT INTO student (id, name, age, gender) VALUES (1, '张三', 20, '男'); INSERT INTO student (id, name, age, gender) VALUES (2, '李四', 21, '男'); INSERT INTO student (id, name, age, gender) VALUES (3, '王五', 22, '女'); ```(2)执行SQL语句,向student表中插入三条数据。

数据库实验报告范本

数据库实验报告范本一、实验目的本次数据库实验的主要目的是深入了解数据库的基本操作和管理,掌握数据的存储、查询、更新和删除等功能,提高对数据库的实际应用能力和问题解决能力。

二、实验环境1、操作系统:Windows 102、数据库管理系统:MySQL 803、开发工具:Navicat Premium 12三、实验内容及步骤(一)数据库的创建1、打开 Navicat Premium 12 工具,连接到本地 MySQL 服务器。

2、在连接成功后,右键点击“连接”,选择“新建数据库”。

3、在弹出的“新建数据库”对话框中,输入数据库名称(例如:student_management),选择字符集和排序规则,点击“确定”按钮创建数据库。

(二)表的创建1、展开新建的数据库,右键点击“表”,选择“新建表”。

2、在“表设计器”中,依次添加表的字段,包括字段名、数据类型、长度、是否允许为空等属性。

以学生表(students)为例,字段包括:student_id(INT 主键,自增)、student_name(VARCHAR(50))、student_age(INT)、student_gender(VARCHAR(10))。

课程表(courses)字段:course_id(INT 主键,自增)、course_name(VARCHAR(50))、course_credit(INT)。

成绩表(scores)字段:score_id(INT 主键,自增)、student_id (INT 外键,关联 students 表的 student_id)、course_id(INT 外键,关联 courses 表的 course_id)、score(FLOAT)。

3、设置完字段属性后,点击“保存”按钮,输入表名(如 students、courses、scores)创建表。

(三)数据的插入1、打开创建好的表,点击“插入”按钮。

2、在弹出的“插入行”对话框中,按照字段顺序输入相应的数据。

数据库系统原理实验报告

数据库系统原理实验报告一、实验目的1.熟悉数据库系统的基本概念和原理;2.掌握数据库系统的基本操作;3.学会使用数据库系统进行数据管理和查询。

二、实验设备1.计算机;2.数据库管理系统软件。

三、实验过程1.创建数据库通过数据库管理系统软件,我们首先需要创建一个新的数据库。

在数据库管理系统软件的界面上,点击“新建数据库”按钮,输入数据库名称、用户名、密码等信息,并确定创建。

2.设计数据表在创建完数据库后,我们需要设计数据表结构。

点击数据库管理系统软件界面上的“表设计”按钮,弹出数据表设计界面。

根据实验需求,在数据表设计界面上添加字段、设置字段类型、设置主键等,最后确定设计。

3.插入数据数据表设计好后,我们需要将数据插入到数据表中。

通过数据库管理系统软件,点击“插入数据”按钮,弹出插入数据界面。

在插入数据界面上,输入要插入的数据信息,点击确定插入。

4.查询数据将数据插入到数据表中后,我们需要查询特定的数据。

通过数据库管理系统软件,点击“查询数据”按钮,弹出查询数据界面。

在查询数据界面上,输入查询条件,点击确定查询。

系统将会返回符合条件的数据。

五、实验结果通过以上实验步骤,我们成功地创建了一个新的数据库,设计了数据表结构,并将数据插入到数据库中。

同时,我们还可以通过数据库管理系统软件查询数据并获取到结果。

这些实验结果表明我们对数据库系统的基本操作具有熟练掌握的能力。

六、实验总结通过本次实验,我们深入了解了数据库系统的基本概念和原理,掌握了数据库系统的基本操作方法,并成功地应用到实际数据管理和查询中。

通过实验,我们意识到数据库系统在现代信息管理中的重要性,并且清楚地了解到数据库系统的优势和应用场景。

通过进一步的学习和实践,我们相信我们可以更加熟练地应用数据库系统,并将其应用到实际工作中。

数据库系统概论实验报告1

实验一认识DBMS【实验目的】1.通过对某个商用数据管理系统的安装使用,初步了解DBMS的工作环境和系统构架。

2.熟悉对SQL Server的安装。

【实验环境】1.操作系统:Windows XP。

2.数据库管理系统:Microsoft SQL Server 2005。

【实验内容及步骤】1.安装Microsoft SQL Server 2005。

①运行Microsoft SQL Server 2005安装程序,选中“我接受许可条款和协议”,单击“下一步”,点击“安装”。

随后继续单击“下一步”即可。

②待出现“服务账户”窗口时,选择“使用内置系统账户”,单击“下一步”。

③选择“混合模式”,输入密码,单击“下一步”。

④最后单击“安装”,等待完成即可。

2.启动和停止数据库服务。

①启动SQL Server Management Studio后,数据库服务自动启动。

右击对象资源管理器窗口中的数据库引擎,选择“停止”,即可停止数据库服务。

②“Microsoft SQL Server 2005”→“配置工具”→“SQL Server外围应用配置器”,单击“服务和连接的外围应用配置器”,可启动和停止数据库服务。

3.SQL Server的登录。

“开始”→“程序”→“Microsoft SQL Server 2005”→“SQL Server Management Studio”。

①Windows身份验证登录。

②SQL Server身份验证登录。

【出现的问题及解决方案】1.在安装IIS服务时要求选择安装源,否则无法继续安装。

解决方法:单独下载IIS的组件并安装那可。

2.在登录时选择“SQL Server身份验证”,输入密码后无法登录。

解决方法:在“SQL Server Configuration Manager”中,检查SQL Server服务是否正在运行,并确定密码的大小写,重新登录即可。

数据库实验报告(通用3篇)

数据库实验报告(通用3篇)数据库试验报告篇1一、实训时间:20_年5月13日至5月24日二、实训地点:三、实训目的与意义:1,这次实习可以使我们在课本上学到的学问用于实践增加了我对电脑技巧的一些认知。

2,通过这次实习也可以让我体验到上班族的生活为我将来毕业后找工作打下了基础。

3,并且这次实习可以非常好的关心我完成将来的毕业论文。

四、实训感悟:还依旧记得来的第一天对这里很茫然,不知道实习要做些什么。

然后经过老师的急躁讲解,熟悉了自己实习要做些什么,得到了许多心理熟悉,对许多问题都有了一些更深的了解。

同时,我熟识了河北玛世电子商务有限公司,总部位于国家命名的“中国丝网之乡”、“中国丝网产业基地”、中国丝网产销基地“、”中国丝网出口基地“—河北省安平县。

使我们队公司有了更进一步的了解实习,就是在实践中学习。

经过这半个月的实习训练,我了解到自己所学的如何在实践中运用。

当然学的更多的是如何在更新网站内容和添加商品,每天不厌其烦的更新添加,观察自己的胜利更多的是兴奋。

还有发布了一些关于公司产品的博客,比如新浪,网易。

而后又尝试在百度知道上提问与回答,在回答问题的过程中,通过网站搜寻相关内容来回答各种丝网问题,通过百度知道这个平台,我对公司又了更一步的了解。

经过半个月的实训我学到了许多之前没有学过没有接触到的东西,熟悉到自己的不足,需要更加努力,才能尽快的学会在社会上生活,敢于面对社会的压力,使自己可以在社会上成长进展。

数据库试验报告篇2由于平常接触的都是一些私人项目,这些项目大都是一些类库,其他人的沟通相对可以忽视不计,因此也就不考虑规范化的文档。

实际上从学习的经受来看,我们接触的学问体系都是属于比较老或比较传统的,与现在进展快速的IT行业相比许多状况已不再适用,尤其是当开源模式渐渐走近开发者后更是如此。

虽然这次是一个数据库课程设计,由于本人在选择项目的时候是本着对自己有实际应用价值的角度考虑的,所以其中也涉及到一些数据库以外的设计。

数据库实验报告

数据库实验报告一、实验目的本次数据库实验的主要目的是通过实际操作和实践,深入了解数据库的基本概念、原理和技术,掌握数据库的设计、创建、管理和数据操作的方法,提高对数据库系统的应用能力和问题解决能力。

二、实验环境本次实验使用的数据库管理系统是 MySQL,操作系统为 Windows 10。

实验中使用的开发工具包括 MySQL Workbench 和命令行终端。

三、实验内容与步骤(一)数据库设计1、需求分析根据给定的业务场景,确定数据库需要存储的信息和数据之间的关系。

例如,对于一个学生管理系统,需要存储学生的基本信息、课程信息、成绩信息等,并且明确这些信息之间的关联,如学生与课程的选课关系、课程与成绩的对应关系等。

2、概念模型设计使用 ER 图(实体关系图)来描述数据库的概念模型。

确定实体(如学生、课程)、属性(如学生的学号、姓名,课程的课程号、课程名)以及实体之间的关系(如多对多、一对多等)。

3、逻辑模型设计将概念模型转换为关系模型,确定数据表的结构,包括表名、字段名、数据类型、主键、外键等。

例如,学生表(学号、姓名、性别、出生日期),课程表(课程号、课程名、学分),选课表(学号、课程号、成绩)等。

(二)数据库创建1、使用 MySQL Workbench 或命令行创建数据库。

2、创建数据表,按照设计好的逻辑模型定义表结构。

(三)数据插入与操作1、使用 INSERT 语句向数据表中插入数据,以模拟实际的业务数据。

2、进行数据的查询操作,使用 SELECT 语句查询满足特定条件的数据。

3、进行数据的更新和删除操作,使用 UPDATE 和 DELETE 语句修改或删除数据。

(四)数据库索引与优化1、了解索引的概念和作用,为经常用于查询、连接和排序的字段创建索引。

2、分析查询语句的执行计划,通过优化查询语句、调整数据表结构等方式提高数据库的性能。

(五)数据库备份与恢复1、学习数据库备份的方法,使用 mysqldump 工具或 MySQL Workbench 进行数据库的备份。

数据库系统实验课实验报告

数据库系统实验课实验报告一、实验目的数据库系统实验课是一门重要的实践课程,旨在通过实际操作和实验,深入理解数据库系统的原理和应用,提高我们的数据库设计、管理和应用开发能力。

本次实验的具体目的包括:1、熟悉数据库管理系统(DBMS)的操作环境和基本命令。

2、掌握数据库的创建、表的设计、数据的插入、查询、更新和删除等基本操作。

3、学会使用 SQL 语句进行复杂的数据查询和数据处理。

4、理解数据库的完整性约束、索引和存储过程的概念及应用。

5、培养解决实际数据库问题的能力和团队协作精神。

二、实验环境本次实验使用的数据库管理系统是 MySQL 80,实验在 Windows 10 操作系统上进行。

使用的开发工具包括 MySQL Workbench 和命令行终端。

三、实验内容1、数据库的创建使用 CREATE DATABASE 语句创建了一个名为“student_management”的数据库,用于存储学生管理相关的数据。

2、表的设计在“student_management”数据库中,设计了以下几张表:“students”表,包含学生的学号(student_id)、姓名(student_name)、性别(gender)、年龄(age)等字段。

“courses”表,包含课程的课程号(course_id)、课程名称(course_name)、学分(credit)等字段。

“enrolls”表,用于记录学生选课的信息,包含学号(student_id)、课程号(course_id)、成绩(grade)等字段。

在设计表时,为每个字段选择了合适的数据类型,并设置了主键和外键约束,以保证数据的完整性和一致性。

3、数据的插入使用 INSERT INTO 语句向“students”、“courses”和“enrolls”表中插入了一些示例数据,以便进行后续的查询和操作。

4、数据的查询使用简单的 SELECT 语句查询了“students”表中的所有学生信息。

数据库系统实验报告

数据库系统实验报告篇一:数据库系统实验报告实验一SQL语言一、实验目的(1)通过上机实践,熟悉Oracle的SQL * Plus环境及使用方法(2)掌握SQL语言,能熟练运用SQL语言进行数据定义和数据操纵(3)加深对关系数据模型的数据结构和约束的理解二、实验环境硬件:微机软件:ORACLE 8i或9i三、实验内容及要求1.了解并掌握SQL * Plus环境的使用2.用SQL的DDL语句图书管理系统创建基表3.为基表“读者”补充定义:职称只能取初级、中级、高级之一4.用SQL的DML语句向上述基表中增加、修改和删除数据5.用SQL的QL语句完成指定查询6.用SQL的DDL语句创建视图、索引7.为自己创建一张结构与scott用户的员工表emp相同的员工表。

四、实验过程1、用SQL的DDL语句图书管理系统创建基表图书(图书编号、分类号、书名、作者、出版单位、单价) CREATE TABLE 图书(图书编号VARCHAR(4) PRIMARY KEY,分类号VARCHAR(5),书名VARCHAR(18),作者VARCHAR(8),出版单位VARCHAR(10),单价DEC(5,2));读者(借书证号、姓名、单位、职称)CREATE TABLE 读者(借书证号VARCHAR(6) PRIMARY KEY,姓名VARCHAR(10),单位VARCHAR(10),职称VARCHAR(10));借阅(借书证号、图书编号、借阅日期、备注)CREATE TABLE 借阅(借书证号VARCHAR(6),图书编号VARCHAR(4), 借阅日期DATE,备注VARCHAR(30),PRIMARY KEY(借书证号,图书编号),FOREIGN KEY(借书证号)REFERENCES 读者(借书证号),FOREIGN KEY(图书编号) REFERENCES 图书(图书编号));2、为基表“读者”补充定义:职称只能取初级、中级、高级之一ALTER TABLE 读者ADD CHECK(职称IN(‘初级’,’中级’,’高级’));3、向三个基表中插入指定数据。

数据库系统实验报告

竭诚为您提供优质文档/双击可除数据库系统实验报告篇一:数据库应用系统设计报告数据库应用系统设计报告工资管理系统专业:计算机科学与技术班级:08级计算机x班组员:xxx指导老师:xxx一.简介1.1开发小组人员组成:组长:xxxx。

各自担负任务整体设计:资料搜索:数据库的设计:建立数据库:数据库分析:需求分析撰写:设计报告撰写:Java设计:Java代码及界面实现:1.2运行环境:开发环境:sQLservermanagementstudio与myeclipseforspring8.6操作系统:windows20XX1.3开发意图:为了检验数据库课程学习情况,我们模拟设计了一份给某公司的工资管理系统。

如下:管理信息系统(mIs)不仅是一个技术系统,而且也是一个社会系统。

这从另一个方面可看出,任何企事业单位的管理信息系统都是基于自己单位的实际情况而建立,即使是同行企业建立的相同系统都会由于企业的实际情况而有所不同。

工资管理是任何企事业单位都面临的问题,由于各个公司的工资处理方式总是有所区别,因此目前还没有一个通用的工资管理系统,只能针对公司情况去开发适合本公司需求的工资管理系统。

早期的工资管理是人工化的,工作量大时,出现错误的机率也会随之升高,这会导致会计人员花费更多的时间去改正错误,延误工资发放的时间,或出现工资发放错误的现象。

而企业工资管理系统就是使用电脑代替大量的人工统计和计算,完成企业工资信息的处理,而且还可以用电脑安全完整地保存企业工资记录。

系统初步调查的内容主要是了解公司组织的整体信息,包括员工信息和员工工资信息。

通过对系统特点进行调查和分析,可以得到本系统的关键部分如下:(1)员工职务工资的设定,是工资管理系统的基础,可以实现工资的基本管理。

这样可以减少出错,提高效率。

(2)其他工资的设置,是对员工基本工资的补充。

(3)系统应该可以输出工资报表,可以通过报表侧面反映员工工作的好坏。

(4)系统还应包括员工基本信息的录入、修改和删除。

数据库系统实验报告

数据库系统实验班级姓名学号任课教师计算机学院实验一:基本SQL语言1.实验目标1.1.熟练掌握基本的SQL语言。

能够利用SQL定义语言(DDL)创建、删除和修改数据库的基本对象(表、视图、约束和索引等),利用SQL查询语言(Select)对数据中数据进行检索,利用SQL修改语言(Insert、Update、Delete)对数据中数据进行插入、修改和删除操作。

能够利用SQL控制语言(DCL)将数据库的基本对象(表和视图等)的各种权限授予其它用户。

1.2.熟悉SQL Server 2000的交互式SQL语言的操作环境。

能够利用查询分析器进行SQL语言的编辑和提交。

2.实验要求2.1.写出以下各个实验的SQL语句。

2.2.在SQL Server 2000的查询分析器环境中执行SQL语句,写出每次执行的结果。

2.3.对于错误的执行结果,分析产生错误的原因,并写出纠正错误的方案。

2.4.SQL语句的书写规范,要求每个查询子句独占一行,如:Select SNO, SNAMEFrom SWhere Sage>=20 ;注意:每次实验之后请作好数据库备份。

下次实验之前进行数据库恢复。

3.实验课时本次实验共计10课时。

4.实验数据本次实验中用到6个关系表(当前用户):COURSE(课程)、DEPT(系)、S(学生)、PROF(教师)、PC(授课)、SC(选修)。

4.1.关系模式。

4.2.6个关系表的定义。

⑵DEPT(系)4.3.6个关系表的元组数据。

5.实验步骤5.1.SQL Server 2000数据库的安装、启动和创建新的数据库。

SQL Server 2000已安装在本机,一般采用的是Windows认证方式。

因此当你以默认Windows用户administrator登陆进window操作系统之后,你就可以直接通过服务管理器启动SQL Server 2000。

启动成功之后的状态如下(启动成功之后,可以关闭服务管理器):之后可以通过打开查询分析器登陆到SQL Server 2000,建立和DBMS的会话。

数据库系统实训报告书

一、实训目的本次数据库系统实训旨在通过实际操作,使学生掌握数据库的基本概念、设计方法、实现技术以及数据库系统的维护与管理,提高学生的数据库应用能力。

通过本次实训,学生能够:1. 理解数据库的基本概念和原理;2. 掌握数据库设计的方法和步骤;3. 学会使用数据库管理系统(DBMS)进行数据库的创建、修改、查询和维护;4. 了解数据库安全性和完整性控制的基本方法;5. 培养学生实际应用数据库解决实际问题的能力。

二、实训内容1. 数据库基本概念和原理(1)数据库系统的组成:数据库、数据库管理系统、数据库管理员、用户。

(2)数据库的三个级别:物理级别、概念级别、逻辑级别。

(3)数据模型:层次模型、网状模型、关系模型。

(4)数据库设计方法:需求分析、概念设计、逻辑设计、物理设计。

2. 数据库设计工具(1)E-R图:实体-联系图,用于表示实体和实体之间的关系。

(2)ERwin:实体-联系图绘制工具。

(3)PowerDesigner:数据库设计工具,支持多种数据库系统。

3. 数据库管理系统(DBMS)(1)SQL语言:结构化查询语言,用于数据库的创建、修改、查询和维护。

(2)Oracle、MySQL、SQL Server等数据库管理系统。

4. 数据库实现技术(1)数据库的创建、修改、删除。

(2)数据的查询、更新、删除。

(3)数据库的备份与恢复。

5. 数据库安全性和完整性控制(1)用户权限管理:授予、回收、修改用户权限。

(2)完整性约束:主键约束、外键约束、唯一性约束、非空约束。

(3)事务管理:事务的概念、特性、事务控制语句。

三、实训过程1. 实训环境:Windows操作系统,Oracle 11g数据库管理系统。

2. 实训步骤:(1)创建数据库:使用SQL语句创建数据库。

(2)创建表:根据需求设计表结构,使用SQL语句创建表。

(3)插入数据:使用SQL语句向表中插入数据。

(4)查询数据:使用SQL语句查询表中的数据。

数据库系统实训报告

本次数据库系统实训旨在通过实际操作,使学生深入了解数据库系统的基本原理、设计方法和技术,提高学生运用数据库技术解决实际问题的能力。

实训过程中,我们将以实际项目为背景,学习数据库设计、SQL语言操作、数据库应用系统开发等知识,培养数据库系统分析、设计和实施能力。

二、实训环境1. 操作系统:Windows 102. 数据库管理系统:MySQL 5.73. 开发工具:MySQL Workbench4. 编程语言:Python三、实训内容1. 数据库设计(1)需求分析:了解项目背景,分析项目需求,确定数据库功能模块。

(2)概念设计:根据需求分析,绘制E-R图,确定实体、属性和关系。

(3)逻辑设计:将E-R图转换为关系模型,确定表结构,定义字段类型、约束等。

(4)物理设计:根据逻辑设计,确定存储引擎、索引策略、分区策略等。

2. SQL语言操作(1)数据定义语言(DDL):创建、修改、删除数据库、表、索引等。

(2)数据操作语言(DML):插入、查询、更新、删除数据。

(3)数据控制语言(DCL):授权、回收权限。

3. 数据库应用系统开发(1)使用Python进行后端开发,实现数据库的连接、查询、更新等操作。

(2)使用MySQL Workbench进行前端界面设计,实现用户交互。

(3)实现数据库的备份、恢复、优化等功能。

1. 需求分析以学校教务系统为例,分析项目需求,确定数据库功能模块,包括学生信息、课程信息、成绩信息、教师信息等。

2. 概念设计绘制E-R图,确定实体、属性和关系,如学生实体(学号、姓名、性别、年龄等)、课程实体(课程号、课程名、学分等)。

3. 逻辑设计将E-R图转换为关系模型,确定表结构,如学生表(学号、姓名、性别、年龄等)、课程表(课程号、课程名、学分等)。

4. 物理设计确定存储引擎、索引策略、分区策略等,如选择InnoDB存储引擎,为常用字段建立索引。

5. SQL语言操作创建数据库、表、索引等,如创建学生表、课程表等。

数据库管理系统实训报告

数据库管理系统实训报告一、实训的目的和意义数据库管理系统是现代科技发展中不可或缺的一部分,它为各种信息系统提供了高效、安全、可靠的数据管理和操作功能。

为了帮助学生更好地理解和应用数据库管理系统,提高他们的实际操作能力,本次实训将以MySQL为例,通过实际搭建和操作数据库,进行数据的增删改查等常见操作,让学生深入了解数据库管理系统的原理和应用。

通过本次实训,我意识到掌握数据库管理系统的能力对于我今后从事计算机相关工作至关重要。

数据库是现代信息系统的核心和基石,准确高效地管理和操纵数据将成为我未来工作中的必备能力。

能够熟练运用数据库管理系统,不仅能提高我在软件开发中的工作效率,还能提供更好的数据管理服务,满足用户的需求,从而为企业创造更大的价值。

二、实训的内容和流程1.实训内容:本次实训的主要内容包括以下几个方面:(1)数据库的基本概念和原理:包括数据库的定义、特点、组成等基础知识。

(3)数据库的设计和建表:根据需求设计数据库结构,建立相应的数据表并定义字段。

(4)数据的增删改查:通过SQL语句实现数据的增加、删除、修改和查询等操作。

2.实训流程:(1)学习数据库基本概念和原理:通过阅读相关书籍和参加课堂讲解,学习数据库的基本概念和原理,了解数据库的定义、特点和组成等基础知识。

(3)数据库的设计和建表:根据需求设计数据库的结构,包括确定数据库的主题、实体、属性和关系等,然后通过SQL语句在MySQL中创建相应的数据表,并定义字段的名称、类型、长度等。

(4)数据的增删改查:根据需求,通过SQL语句实现数据的增加、删除、修改和查询等操作。

例如,可以使用INSERT语句添加新的数据记录,使用DELETE语句删除指定的数据记录,使用UPDATE语句修改已有的数据记录,使用SELECT语句查询指定的数据记录等。

三、实训的收获和体会通过这次实训,我深入了解了数据库管理系统的原理和应用,掌握了MySQL数据库的安装和配置,学会了使用SQL语句进行数据库的设计和操作。

数据库实验报告

数据库实验报告一、实验目的本次数据库实验的主要目的是深入了解数据库的基本概念和操作,掌握数据库管理系统的使用方法,提高对数据的管理和处理能力。

通过实际操作,我们希望能够熟练运用SQL 语句进行数据的查询、插入、更新和删除,以及创建和管理数据库表、索引和视图等对象。

二、实验环境本次实验使用的数据库管理系统是 MySQL 80,操作系统为Windows 10。

实验在个人计算机上进行,使用 MySQL Workbench 作为数据库管理工具。

三、实验内容1、数据库创建使用 CREATE DATABASE 语句创建了一个名为“student_management”的数据库,用于存储学生管理相关的数据。

2、表的创建在“student_management”数据库中,创建了以下几张表:“students”表,包含学生的学号(student_id)、姓名(name)、性别(gender)、年龄(age)等字段。

“courses”表,包含课程的课程号(course_id)、课程名称(course_name)、学分(credit)等字段。

“enrolls”表,用于关联学生和课程,包含学生学号(student_id)、课程号(course_id)和成绩(grade)等字段。

3、数据插入使用 INSERT INTO 语句向上述表中插入了一些示例数据,以方便后续的查询和操作。

4、数据查询通过 SELECT 语句进行了多种查询操作,例如:查询所有学生的信息。

查询特定性别学生的信息。

查询选修了某门课程的学生名单及成绩。

5、数据更新使用 UPDATE 语句对部分学生的年龄或成绩进行了修改。

6、数据删除使用 DELETE 语句删除了一些不再需要的数据记录。

7、索引创建为“students”表的“student_id”字段和“courses”表的“course_id”字段创建了索引,以提高查询效率。

8、视图创建创建了一个名为“student_course_grade_view”的视图,用于展示学生的学号、姓名、课程名称和成绩。

数据库系统实验课实验报告

2.使用命令完成下列扣作(1)查找用户所有表的表名(2)查看每张表的结构(要求把每张表的结构截图放到实验报告中)(3)查看表takes的约束信息

3.修改表结构

(1)在instructor表中增加列存储教师家庭地址,其地址包括省、市、区、街道、门牌号等列,列的数据类型自己给出,列允许为空。

(2)对student表中的姓名字段长度都改为10,设置是否成功?原因是什么?将该字段长度改为50,能否成功?说明原因。

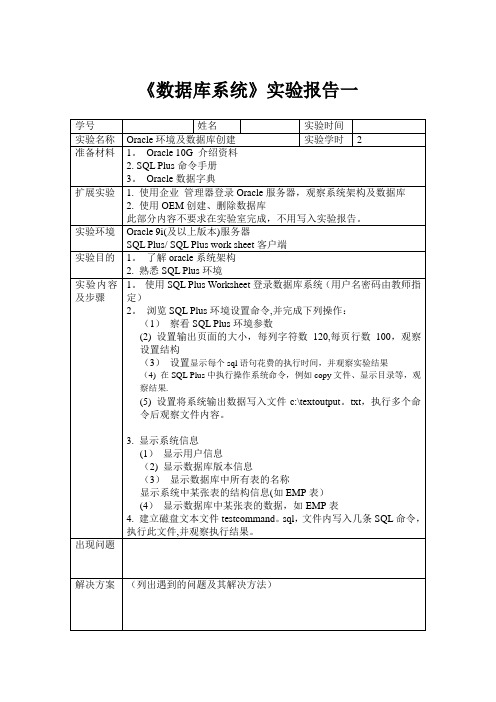

学号

姓名

实验时间

实验名称

数据查询

实验学时

4

准备材料

1。SQL Plus命令手册

2. Oracle数据字典

扩展实验

1。利用企业管理器的图形界面构造查询语句,并察看查询结果

2.利用企业管理器完成视图、索引的创建与使用。

3。利用DBMS进行对第三章习题所设计SQL语句的检查

(此部分内容不要求在实验室完成,不用写入实验报告。)

2。使用University数据库的数据库结构和数据(smallRelations即可),完成下列查询:

(1)Find the names of courses in Computer science department which have 3 credits

(2)For the student with ID 12345 (or any other value),show all course_id and title of all courses registered for by the student.

数据库设计实验报告5篇

数据库设计实验报告数据库设计实验报告5篇在不断进步的时代,需要使用报告的情况越来越多,写报告的时候要注意内容的完整。

相信很多朋友都对写报告感到非常苦恼吧,以下是小编为大家收集的数据库设计实验报告,仅供参考,希望能够帮助到大家。

数据库设计实验报告1有关于数据库实验的心得体会,总的来说,受益匪浅。

在这些天中,我们学到了很多东西,包括建表,导入数据,查询,插入。

最重要的是我们有机会用电脑自己进行实践,没接触的时候总是觉得它比较深奥或是不可接近的新型语言,尽管自己对C语言非常感兴趣,但还是有些心理上的陌生感。

学习数据库就和我们平时的其它科目学习一样感觉它有永无止境的知识,数据库是我在高中时候听过,到了大学渐渐了解了些,但就其原理性的内容还不知道,也就是根本就不清楚什么是数据库,只是知道一个所谓的中国字典里的名词。

我认识它是从我接触实验运作开始的,刚开始就是建立数据库,两种验证模式,没什么东西但还觉得不错。

进而就是操作语言了,紧接着就是触发器的使用,进而对数据库高级的使用,等等。

开始知道数据库的时候想学,不知道从何而起,不懂的话怎么问,从什么地方学起。

后来到大三开学后有数据库原理必修课,非常高兴。

当时感觉SQL Sever数据库管理既然是单独一门课程一定会讲的比较细,也能学到真正实用的内容。

学了这门课以后发现和我想的基本是一样的,老师对学生也比较和蔼可亲,对我们要求也不是很紧。

让每个人都觉得轻轻松松就能把这门课程学完,没有多么紧张的作业,也没有太苛刻的要求。

当老师在最后说这个课程结束了,回顾一下以前老师给我们讲过的东西,真的有很多是我们应该去注意的。

学习完SQL Sever数据库后感觉可分两大块,一块是开发,一块是管理。

开发主要是写写存储过程、触发器什么的,还有就是用Oracle的Develop工具做form。

有点类似于程序员。

开发还需要有较强的逻辑思维和创造能力,自己没有真正做过,但感觉应该会比较辛苦,是青春饭;管理则需要对SQL Sever数据库的原理有深刻的认识,有全局操纵的能力和紧密的思维,责任较大,因为一个小的失误就会弄掉整个数据库,相对前者来说,后者更看重经验。

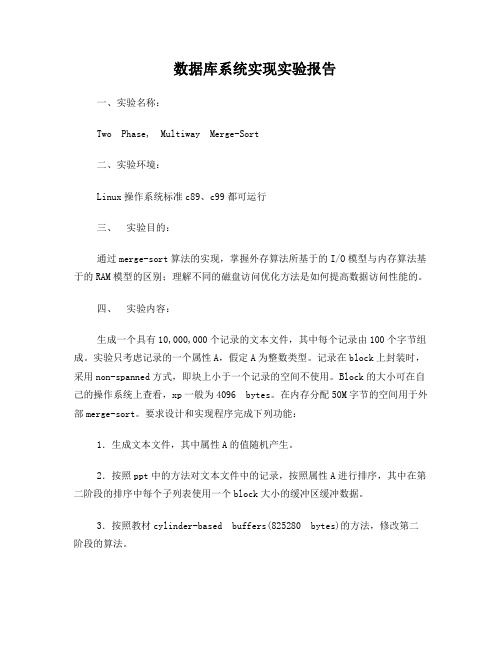

数据库系统实现实验报告1

数据库系统实现实验报告一、实验名称:Two Phase, Multiway Merge-Sort二、实验环境:Linux操作系统标准c89、c99都可运行三、实验目的:通过merge-sort算法的实现,掌握外存算法所基于的I/O模型与内存算法基于的RAM模型的区别;理解不同的磁盘访问优化方法是如何提高数据访问性能的。

四、实验内容:生成一个具有10,000,000个记录的文本文件,其中每个记录由100个字节组成。

实验只考虑记录的一个属性A,假定A为整数类型。

记录在block上封装时,采用non-spanned方式,即块上小于一个记录的空间不使用。

Block的大小可在自己的操作系统上查看,xp一般为4096 bytes。

在内存分配50M字节的空间用于外部merge-sort。

要求设计和实现程序完成下列功能:1.生成文本文件,其中属性A的值随机产生。

2.按照ppt中的方法对文本文件中的记录,按照属性A进行排序,其中在第二阶段的排序中每个子列表使用一个block大小的缓冲区缓冲数据。

3.按照教材cylinder-based buffers(825280 bytes)的方法,修改第二阶段的算法。

4.比较两种方法的时间性能,如果有更大的内存空间,算法性能还能提高多少?五、实验分析:一个具有10,000,000个记录的文本文件共计10,000,000*100B=1000MB,而内存只有50MB,50MB/4KB=50*1024 KB/4KB=12800块,每块可以存放4*1024B/100B=40个记录,每块剩余96KB,内存一共可以存放12800*40=512000个记录,一共有10,000,000个记录。

所以要进行10,000,000/512000=19.53次,即20次排序,每次排序的记录数为10,000,000/20=500,000个记录。

因此此次实验需要将文本文件分成20个子文件。

分别对子文件分别进行内部排序。

数据库系统实验报告1 (数据库的基本操作)

数据库系统课程实验报告

图1-1

图1-2

单击下一步,打开向导的选择目的对话框,该对话框用于指定将数据复制到何处。

这里

图1-3

单击下一步,打开向导的保存、调度和复制包对话框。

使用默认设置。

单击对话框的下一步,打开向导的完成信息对话框,在对话框中显示了当前任务的摘要信息,单击

图1-4

单击完成,结束数据复制工作。

服务器管理器主要用于启动、暂停、停止和检查本地服务的状态,稍后的内容将详细介绍如何管理服。

,可选择

3

服务管理器窗口中,、和

、和

任务栏中看到服务管理器的指示器图标。

可用鼠标右击服务器管理器的指示图标选择“退出”结束

图1-6

客户端网络实用工具

图1-8

事件探察器可监视服务器和数据库活动(如死锁数、严重错误、跟踪存储过程和

事件探察器数据捕获到SQL Server表或文件供以后分析,还可以逐步重播在

5

2.导入导出数据

7

9

11

IIS中配置SQL XML支持——虚拟目录

备注:

1、表头及以下的栏目和内容,不得更改;其它栏目的位置可以适当调整,可以根据需要适当增加或减少页。

2、本课程包含多次实验,请每次实验项目填写一份。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

七、 实验流程图:

Step2:

开始

(nr=read(f0,tr,LS)) >0

N

Y 快速排序 关闭文件 f0

创建新文件 fi

结束

写入新文件拍好的数据

关闭文件

Step3: 开始

i<=20

N

Y 打开 i 文件

打开目标文件

进行基于堆排序的归并算法 读取 BS 个字节 删除 20 个小文 件 进行堆排序上调算法 关闭文件 f1

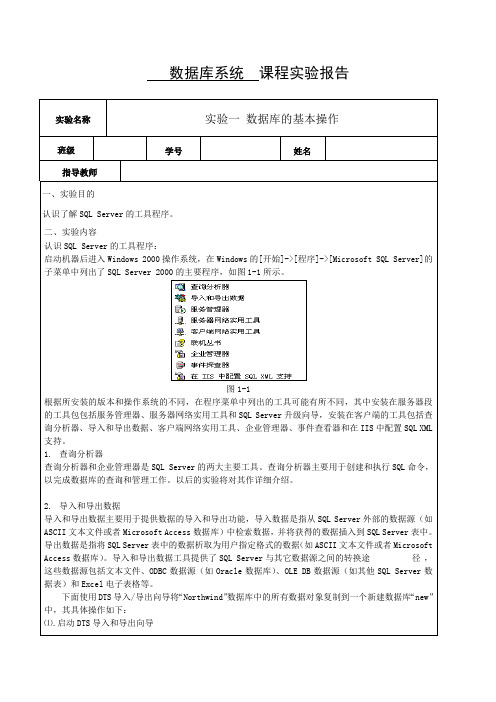

clock_t a,b,c,d; int step1(const char*, struct btr *);//生成一个 10,000,000 个随机记录的文 件 struct pstr step2(const char*, struct btr *);//将上面的文件分成 20 个小文件 并排序 void step3(struct pstr,struct btr *);//用归并算法将上面的 20 个小文件排好续 重新放入源文件 startT=time(NULL); a=clock(); char * str="f0.txt"; //原始文件的目录 struct btr *tr; tr = (struct btr *)malloc(LS); step1(str,tr); sdT=time(NULL); b=clock(); printf("第一阶段的运行时间为%f\n",difftime( sdT, startT)); printf("%f\n",(double)(b-a)/1000); struct pstr ps= step2(str,tr); sfT=time(NULL); c=clock(); printf("第二阶段的运行时间为%f\n",difftime( sfT, sdT)); printf("%f\n",(double)(c-b)/1000); step3(ps,tr); endT=time(NULL); d=clock(); printf("%f\n",(double)(d-c)/1000); printf("第三阶段的运行时间为%f\n",difftime( endT, sfT)); printf("总运行时间为%f\n",difftime( endT, startT)); free(tr); return 0; } int step1(const char*str,struct btr *tr) { int f0; srand((unsigned)time(NULL)); f0 = open(str,O_WRONLY|O_CREAT|O_TRUNC,S_IRUSR|S_IWUSR); int i=0,j=0,m=L; while(j<D) { i=0; while(i<m) { (tr+i)->record[A]=rand();

20 的,平均次数为1 2 × ������������������2 × n ≈ 3 × n(n=1000000000)但是它的 io 次数太多

������ 20

为 250020 次,即增加了程序中断开销,又增加了磁盘读取和写入的开销。 第二阶段的解决办法,减少递归的次数在数据量小于 16 时用插入排序。 第三阶段用题目要求的 cylinder-based buffers(8255280 bytes)的方法

六、 实验步骤:

1. 生成一个具有 10,000,000 个记录的文本文件 f0.txt,其中每个记录由 100 个字 节组成,其中有一个整数类型属性 A。程序生成一个 int 型随机整数作为每条记 录的属性 A。记录写入 f0.txt 文件中。

2. 根据实验分析,将 f0.txt 文件分为 20 个子文件,并且按照文件中每个记录的 属性对各个子文件进行内部排序(使用快速排序加快时间) ,最终形成 20 个有序 的子文件 3. 对 20 个有序的子文件进行归并排序 (在比较 20 个数大小的时候使用堆排序算 法) ,最终形成一个有序的结果文件 f0.txt,同时删除 20 个中间生成的小文件。

//printf("%d\n",(tr+i)->record[A]); i++; } write(f0,tr,i*sizeof(struct btr)); j++; if((j==(D-1))) m= R-(D-1)*L; } close(f0); return 0; } //将上面的文件分成 20 个小文件并排序 struct pstr step2(const char*str, struct btr *tr) { //快速排序 void kuip(struct btr *,int,int); //int cmp(struct btr* a, struct btr* b) //{ // return (a->record[A]-b->record[A]); //} struct pstr nps; int f0 = open(str,O_RDONLY); int nr,h=0; while((nr=read(f0,tr,LS))>0) { //qsort(tr,L,S,cmp); kuip(tr,0,nr/S-1); sprintf(nps.pt[h],"%s%d","file",h); // printf("%s\n",nps.pt[h]); int fi=open(nps.pt[h],O_WRONLY|O_CREAT|O_TRUNC,S_IRUSR|S_IWUSR); write(fi,tr,nr); close(fi); h++; } close(f0); return nps; } //快速排序 void kuip(struct btr* tr,int low1,int high1) { if(high1-low1>15){ int l1=tr[low1].record[A]-tr[high1].record[A]; int l2=tr[low1].record[A]-tr[(low1+high1)/2].record[A];

十、实验代码

/* ============================================================================ Name : dbt.c Author : sunbo Version : Copyright : Your copyright notice Description : Hello World in C, Ansi-style ============================================================================ */ #include<stdio.h> #include<stdlib.h> #include<time.h> #include<malloc.h> #include<unistd.h> #include <sys/types.h> #include <sys/stat.h> #include <fcntl.h> #define R 10000000//总记录数 #define L 512000 //内存最大记录数 #define S 100 //单个记录的长度 #define D 20 //R/L+1 #define A 0 //记录中属性 A 的位置 #define B 82252 //一个子文件的内存中的记录数 #define SB 8225200 //S*B #define LS 51200000 //L*S //表示一个记录 struct btr{ int record[25]; }; //表示子文件的路径 struct pstr{ char pt[D][30]; }; int main() { time_t startT,sdT,sfT, endT;

3.改进后的结果(cylinder-based buffers(825280 bytes)的方法)

考虑到一个记录 100 个字节所以去每个子列表的缓冲区为 825200bytes

图6

图7

九、实验总结

改进后的算法明显要好于第一次运行的结果。第三阶段表现最明显, Io 次数减少后时间减少了 60 秒。 如果每个子列表的缓冲区为 cylinder 的整数倍或略小于他的整数倍的话效果 都会非常的好,如果有更大的内存空间它将与第二阶段的时间一样甚至还要少。

五、 实验分析:

一个具有 10,000,000 个记录的文本文件共计 10,000,000*100B=1000MB,而内 存 只 有 50MB , 50MB/4KB=50*1024 KB/4KB=12800 块 , 每 块 可 以 存 放 4*1024B/100B=40 个记录,每块剩余 96KB,内存一共可以存放 12800*40=512000 个记录,一共有 10,000,000 个记录。所以要进行 10,000,000/512000=19.53 次, 即 20 次排序,每次排序的记录数为 10,000,000/20=500,000 个记录。 因此此次实验需要将文本文件分成 20 个子文件。分别对子文件分别进行内 部排序。最后对 20 个排好序的子文件进行归并排序,完成排序。

图4

图5

2.结果分析

从图上可以看出 第一阶段生成一个 10000000 个记录的文件在 13 秒左右, 第 二 阶 段 生 成 20 个 小 文 件 并 排 序 在 37 秒 左 右 , 但 是 其 算 法 复 杂 度 为 o(n × ������������������2 ) ≈ ������(������)(n=512000 比较小所以可以)在考虑到 cup 的运算速度和第一 阶段生成随即数花费 的时间,第二阶段的时间应该和第一阶段的时间差不多。 第三阶段的时间为 80 秒左右,但是其算法复杂度按理来说是是三个阶段中最少