2015-Faster-RCNN-slide

faster方法

faster方法Faster方法随着科技的发展和计算机性能的提升,人们对于计算速度的要求越来越高。

在深度学习领域中,训练一个复杂的模型需要大量的计算资源和时间。

为了提高训练速度,许多研究者提出了各种方法,其中最著名的就是Faster方法。

本文将介绍Faster方法的原理、实现步骤以及应用场景。

一、Faster方法简介Faster方法是一种基于区域卷积神经网络(R-CNN)的目标检测算法,由Ross Girshick等人于2015年提出。

该算法通过引入候选区域池化(Region Proposal Pooling)和共享卷积特征图(Shared Convolutional Feature Map)两个创新点来加速目标检测过程。

传统的目标检测算法需要对整张图像进行滑动窗口检测,这会导致大量冗余计算和低效率。

而Faster方法则先通过Selective Search等区域生成算法得到一些可能包含目标的候选区域,再对这些候选区域进行分类和回归。

这样可以避免对整张图像进行检测,从而大幅提高了检测速度。

二、Faster方法原理1.候选区域池化候选区域池化是Faster方法的核心创新点之一。

传统的R-CNN算法需要对每个候选区域进行卷积和池化操作,这样会导致大量冗余计算和低效率。

而Faster方法则将所有候选区域拼接成一个大的特征图,然后对这个特征图进行卷积和池化操作。

这样可以避免对每个候选区域进行重复计算,从而大幅提高了检测速度。

2.共享卷积特征图共享卷积特征图是Faster方法的另一个创新点。

传统的R-CNN算法需要对每个候选区域单独提取特征,这样会导致大量冗余计算和低效率。

而Faster方法则将整张图像只进行一次卷积操作,并将得到的特征图共享给所有候选区域。

这样可以避免对每个候选区域单独提取特征,从而大幅提高了检测速度。

三、Faster方法实现步骤1.生成候选区域首先需要使用一种区域生成算法(如Selective Search)来得到一些可能包含目标的候选区域。

Faster RCNN的交通场景下行人检测方法

Faster RCNN的交通场景下行人检测方法Faster RCNN是一种流行的目标检测算法,它在目标检测领域取得了很大的成功。

在交通场景下,行人检测是一项非常重要的任务,它可以帮助交通管理部门监测人员流动情况、改善交通安全等方面都具有重要的意义。

本文将从交通场景下的行人检测需求出发,介绍Faster RCNN在此场景下的应用方法。

一、交通场景下的行人检测需求在交通场景下,行人检测是非常重要的,它具有以下几个方面的重要意义:1. 交通安全:行人在交通场景中往往容易受到车辆的威胁,行人检测可以帮助交通管理部门对行人的行为和分布进行监测,从而及时发现危险情况并应对。

2. 交通流量管理:交通流量管理部门需要掌握道路上行人的流动情况,以便做出合理的交通管理决策。

3. 前沿科技应用:在智慧城市建设、自动驾驶等领域,行人检测技术也是非常重要的。

Faster RCNN是一种端到端的目标检测方法,它由两个网络构成:一个用于提取特征的卷积神经网络(CNN),和一个用于目标检测的区域提议网络(RPN)。

Faster RCNN能够实现端到端的目标检测,在准确性和速度上取得了很大的突破,因此在交通场景下的行人检测中具有很大的潜力。

1. 数据准备:首先需要收集交通场景下的行人图片数据,并标记出行人的位置信息。

2. 模型训练:利用已标记的数据,对Faster RCNN模型进行训练,通过大量数据的学习,模型可以逐步提高准确率和鲁棒性。

3. 模型调优:在交通场景下,由于行人可能会出现在各种复杂的环境中,因此需要针对具体场景对模型进行调优,以提高检测效果。

4. 模型应用:经过训练和调优后的Faster RCNN模型可以应用于实际的交通场景中,对行人进行准确的检测和定位。

1. 准确性高:Faster RCNN基于深度学习,在大量数据的学习下,能够实现较高的准确性。

2. 适应性强:Faster RCNN能够适应各种复杂的交通场景,对光照、天气等因素具有一定的鲁棒性。

基于深度学习的行人检测与行为分析算法

基于深度学习的行人检测与行为分析算法概述行人检测与行为分析在计算机视觉领域起着重要的作用。

随着深度学习技术的发展,基于深度学习的行人检测与行为分析算法在准确性和效率方面取得了显著的进展。

本文将介绍基于深度学习的行人检测与行为分析算法的原理和应用,并分析了其优缺点。

1. 行人检测算法基于深度学习的行人检测算法通常采用卷积神经网络(Convolutional Neural Network, CNN)作为主要架构。

其中,常用的行人检测算法包括Faster R-CNN, YOLO和SSD等。

1.1 Faster R-CNNFaster R-CNN是一种流行的目标检测算法,能够实现准确且快速的行人检测。

它使用区域提议网络(Region Proposal Network, RPN)生成可能包含行人的候选框,然后通过分类网络进行行人检测。

Faster R-CNN在行人检测领域取得了显著的性能提升。

1.2 YOLOYOLO (You Only Look Once)是一种实时的目标检测算法,能够在一次前向传播中同时完成检测和定位。

YOLO将图像划分为网格,并为每个网格预测边界框和类别置信度。

它具有快速的检测速度,但可能对小尺寸的目标检测效果较差。

1.3 SSDSSD(Single Shot MultiBox Detector)是一种多尺度目标检测算法,能够在不同层级上检测目标。

SSD通过在不同层级的特征图上预测边界框位置和类别置信度,从而实现对不同尺寸的行人进行准确检测。

2. 行为分析算法基于深度学习的行为分析算法主要通过对行人运动进行跟踪和分类,实现对行为的分析和理解。

常用的行为分析算法包括姿态估计、动作识别和行为预测等。

2.1 姿态估计姿态估计算法通过预测行人的关节点坐标来实现对行为的分析。

它可以估计行人的姿势和动作,如站立、行走、跑步等。

深度学习技术通常通过卷积神经网络和关节回归网络来进行姿态估计。

2.2 动作识别动作识别算法旨在识别行人的动作,如举手、打招呼、走路等。

基于深度学习的Faster R-CNN小目标检测方法

基于深度学习的Faster R-CNN小目标检测方法基于深度学习的Faster R-CNN小目标检测方法随着计算机视觉技术的快速发展,目标检测一直是一个备受关注的课题。

在传统的目标检测方法中,由于小目标的特点与挑战,检测精度常常不高。

然而,随着深度学习的兴起,基于卷积神经网络的目标检测方法在解决小目标检测问题上取得了较好的效果。

本文将介绍一种基于深度学习的Faster R-CNN小目标检测方法。

Faster R-CNN(Region Convolutional Neural Network)是目标检测领域中一种非常重要的算法。

它的核心思想是将目标检测任务分解为两个子任务,即生成候选框和分类定位。

生成候选框的算法又称为区域提议(Region Proposal)算法,在Faster R-CNN中,作者采用了一种名为RPN(Region Proposal Network)的网络结构来实现。

RPN主要通过滑动窗口的方式,以一定的步长在输入特征图上生成多个不同尺寸的候选框,并对每个候选框进行是否包含目标的二分类预测和候选框的精确位置回归。

与传统的区域提议方法相比,RPN在召回率和速度上都取得了较好的平衡。

在生成候选框的基础上,Faster R-CNN还需要对每个候选框进行分类和位置回归。

为了解决小目标检测的问题,Faster R-CNN引入了RoI(Region of Interest)Pooling层。

RoI Pooling层的作用是将不同尺寸的候选框转化为固定尺寸的特征图,以便输入到后续的全连接层进行分类和位置回归。

通过RoI Pooling层,Faster R-CNN可以对不同尺寸的目标进行统一处理,提高了小目标检测的精度。

为了进一步提高小目标检测的性能,Faster R-CNN还采用了多尺度融合(Multi-Scale Fusion)的策略。

传统的目标检测方法通常只关注单一尺度的特征图,而小目标的尺寸普遍较小,因此很容易被忽略。

FasterRCNN理解(精简版总结)

FasterRCNN理解(精简版总结)Faster R-CNN(Faster Region-based Convolutional Neural Networks)是一种用于目标检测的深度学习模型,它能够准确、快速地检测图像中的物体并对其进行分类。

本文将对Faster R-CNN进行精简版总结。

目标分类与边界框回归:在生成的候选区域之后,每个候选区域都需要进行分类和位置回归。

为了解决这个问题,Faster R-CNN引入了一个用于分类和位置回归的全连接层网络,在区域特征图上进行目标分类和边界框回归操作。

此外,从RPN得到的候选区域与这个全连接层网络之间共享卷积特征,以减少计算量。

具体来说,Faster R-CNN采用了RoI (Region of Interest)池化层来从特征图上提取固定大小的特征向量,然后输入到全连接层网络进行分类和回归。

Faster R-CNN的训练过程包括两个阶段:预训练阶段和微调阶段。

在预训练阶段,使用一个大规模数据集(如ImageNet)对整个网络进行训练,以提取通用特征。

在微调阶段,使用目标检测数据集对RPN和全连接层网络进行微调。

为了加快训练速度,Faster R-CNN采用了两阶段的训练策略,即首先训练RPN网络,然后使用RPN生成的候选区域进行目标分类和边界框回归的训练。

Faster R-CNN的优势在于其准确性和速度。

相比于传统的目标检测方法,Faster R-CNN在准确率上有显著的提升,并且其检测速度更快。

这是因为RPN网络可以一次性生成大量候选区域,在这些候选区域上进行分类和回归操作,从而减少了计算量。

总而言之,Faster R-CNN是一种用于目标检测的深度学习模型,通过引入Region Proposal Network生成候选区域,并使用全连接层网络进行目标分类和边界框回归。

它在准确性和速度上都有很好的表现,成为目标检测领域的重要模型之一。

详细解读Faster RCNN

一副MxN大小的矩阵送入Faster RCNN网络后,到RPN网络变为(M/16)x(N/16),不妨设W=M/16, H=N/16。在进入reshape与softmax之前,先做了1x1卷积,可以看到其num_output=18,也就是经 过该卷积的输出图像为WxHx18大小。这也就刚好对应了feature maps每一个点都有9个anchors,同时 每个anchors又有可能是foreground和background,所有这些信息都保存WxHx(9x2)大小的矩阵。后 面接softmax分类获得foreground anchors,也就相当于初步提取了检测目标候选区域box(一般认为 目标在foreground anchors中)。那么为何要在softmax前后都接一个reshape layer?其实只是为了便 于softmax分类,至于具体原因这就要从caffe的实现形式说起了在caffe基本数据结构blob中以如下形式 保存数据: blob=[batch_size, channel,height,width]对应至上面的保存bg/fg anchors的矩阵,其在caffe blob中的存储形式为[1, 2*9, H, W]。而在softmax分类时需要进行fg/bg二分类,所以reshape layer会 将其变为[1, 2, 9*H, W]大小,即单独“腾空”出来一个维度以便softmax分类,之后再reshape回复原状。

论文作者看来FasterRCNN可以分为4个部分

1、Conv layers。作为一种CNN网络目标检测方法,Faster RCNN首先使用一组基础的 conv+relu+pooling层提取image的feature maps。该feature maps被共享用于后续RPN层和全 连接层。 2、Region Proposal Networks。RPN网络用于生成region proposals。该层通过softmax判断 anchors属于foreground或者background,再利用bounding box regression修正anchors获得 精确的proposals。 3、Roi Pooling。该层收集输入的feature maps和proposals,综合这些信息后提取 proposal feature maps,送入后续全连接层判定目标类别。 4、Classification。利用proposal feature maps计算proposal的类别,同时再次bounding box regression获得检测框最终的精确位置。

令我“细思极恐”的Faster-R-CNN

令我“细思极恐”的Faster-R-CNN作者简介CW,⼴东深圳⼈,毕业于中⼭⼤学(SYSU)数据科学与计算机学院,毕业后就业于腾讯计算机系统有限公司技术⼯程与事业群(TEG)从事Devops⼯作,期间在AI LAB实习过,实操过道路交通元素与医疗病例图像分割、视频实时⼈脸检测与表情识别、OCR等项⽬。

⽬前也有在⼀些⾃媒体平台上参与外包项⽬的研发⼯作,项⽬专注于CV领域(传统图像处理与深度学习⽅向均有)。

前⾔CW每次回顾Faster R-CNN的相关知识(包括源码),都会发现之前没有注意到的⼀些细节,从⽽有新的收获,既惊恐⼜惊喜,可谓“细思极恐”!Faster R-CNN可以算是深度学习⽬标检测领域的祖师爷了,⾄今许多算法都是在其基础上进⾏延伸和改进的,它的出现,可谓是开启了⽬标检测的新篇章,其最为突出的贡献之⼀是提出了 'anchor' 这个东东,并且使⽤ CNN 来⽣成region proposal(⽬标候选区域),从⽽真正意义上完全使⽤CNN 来实现⽬标检测任务(以往的架构会使⽤⼀些传统视觉算法如Selective Search来⽣成⽬标候选框,⽽ CNN 仅⽤来提取特征或最后进⾏分类和回归)。

Faster R-CNN 由 R-CNN 和 Fast R-CNN发展⽽来,R-CNN是第⼀次将CNN应⽤于⽬标检测任务的家伙,它使⽤selective search算法获取⽬标候选区域(region proposal),然后将每个候选区域缩放到同样尺⼨,接着将它们都输⼊CNN提取特征后再⽤SVM进⾏分类,最后再对分类结果进⾏回归,整个训练过程⼗分繁琐,需要微调CNN+训练SVM+边框回归,⽆法实现端到端。

Fast R-CNN则受到 SPP-Net 的启发,将全图(⽽⾮各个候选区域)输⼊CNN进⾏特征提取得到feature map,然后⽤RoI Pooling将不同尺⼨的候选区域(依然由selective search算法得到)映射到统⼀尺⼨。

FasterRCNN详解

FasterRCNN详解摘⾃: 这篇是我看过讲faster-RCNN最清楚的,很多地⽅茅塞顿开,特转。

⼀、 faster-RCNN的背景 Faster R-CNN 发表于 NIPS 2015,其后出现了很多改进版本,后⾯会进⾏介绍. R-CNN - Rich feature hierarchies for accurate object detection and semantic segmentation 是 Faster R-CNN 的启发版本. R-CNN 是采⽤ Selective Search 算法来提取(propose)可能的 RoIs(regions of interest) 区域,然后对每个提取区域采⽤标准 CNN 进⾏分类. 出现于 2015 年早期的 Fast R-CNN 是 R-CNN 的改进,其采⽤兴趣区域池化(Region of Interest Pooling,RoI Pooling) 来共享计算量较⼤的部分,提⾼模型的效率. Faster R-CNN 随后被提出,其是第⼀个完全可微分的模型. Faster R-CNN 是 R-CNN 论⽂的第三个版本.R-CNN、Fast R-CNN 和Faster R-CNN 作者都有 Ross Girshick.⼆、faster-RCNN的⽹络结构 Faster R-CNN 的结构是复杂的,因为其有⼏个移动部件. 这⾥先对整体框架宏观介绍,然后再对每个部分的细节分析.问题描述:针对⼀张图⽚,需要获得的输出有:边界框(bounding boxes) 列表,即⼀幅图像有多少个候选框(region proposal),⽐如有2000个;每个边界框的类别标签,⽐如候选框⾥⾯是猫?狗?等等;每个边界框和类别标签的概率。

2.1 faster-RCNN的基本结构 除此之外,下⾯的⼏幅图也能够较好的描述发图尔-RCNN的⼀般结构:2.2 faster-RCNN的⼤致实现过程 整个⽹络的⼤致过程如下: (1)⾸先,输⼊图⽚表⽰为 Height × Width × Depth 的张量(多维数组)形式,经过预训练 CNN 模型的处理,得到卷积特征图(conv feature map)。

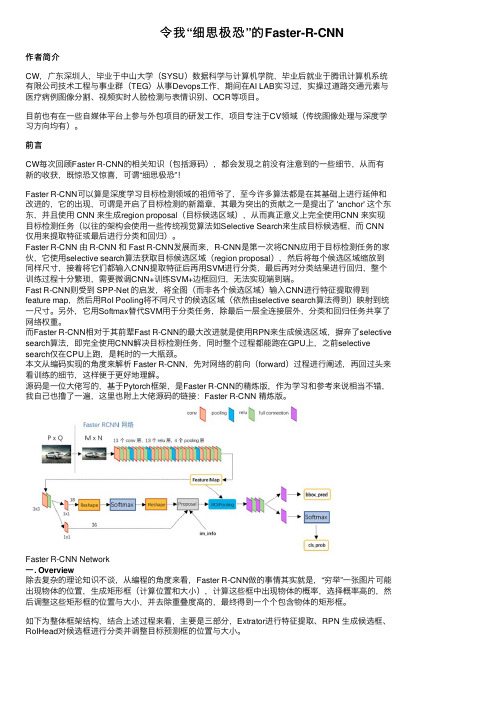

Faster R-CNN论文及源码解读

2018/9/6Faster R-CNN论文及源码解读R-CNN是目标检测领域中十分经典的方法,相比于传统的手工特征,R-CNN将卷积神经网络引入,用于提取深度特征,后接一个分类器判决搜索区域是否包含目标及其置信度,取得了较为准确的检测结果。

Fast R-CNN和Faster R-CNN是R-CNN的升级版本,在准确率和实时性方面都得到了较大提升。

在Fast R-CNN中,首先需要使用Selective Search的方法提取图像的候选目标区域(Proposal)。

而新提出的Faster R-CNN模型则引入了RPN网络(Region Proposal Network),将Proposal的提取部分嵌入到内部网络,实现了卷积层特征共享,Fast R-CNN则基于RPN提取的Proposal做进一步的分类判决和回归预测,因此,整个网络模型可以完成端到端的检测任务,而不需要先执行特定的候选框搜索算法,显著提升了算法模型的实时性。

模型概述Faster R-CNN模型主要由两个模块组成:RPN候选框提取模块和Fast R-CNN检测模块,如下图所示,又可细分为4个部分;Conv Layer,Region Proposal Network(RPN),RoI Pooling,Classification and Regression。

Faster R-CNN网络模型2018/9/6 Faster R-CNN论文及源码解读Conv Layer: 卷积层包括一系列卷积(Conv + Relu)和池化(Pooling)操作,用于提取图像的特征(feature maps),一般直接使用现有的经典网络模型ZF或者VGG16,而且卷积层的权值参数为RPN和FastRCNN 所共享,这也是能够加快训练过程、提升模型实时性的关键所在。

Region Proposal Network: RPN网络用于生成区域候选框Proposal,基于网络模型引入的多尺度Anchor,通过Softmax对anchors属于目标(foreground)还是背景(background)进行分类判决,并使用Bounding Box Regression对anchors进行回归预测,获取Proposal的精确位置,并用于后续的目标识别与检测。

Faster RCNN的交通场景下行人检测方法

Faster RCNN的交通场景下行人检测方法近年来,随着计算机视觉和深度学习技术的快速发展,行人检测在自动驾驶、智能交通管理等领域变得越来越重要。

针对交通场景下的行人检测问题,Faster RCNN成为了一种比较有效的方法。

本文将介绍Faster RCNN在交通场景下的行人检测方法,并探讨其在实际应用中的优势和不足之处。

Faster RCNN是一种经典的目标检测算法,由多个组件构成,包括卷积神经网络(CNN)、区域建议网络(RPN)和检测网络。

在交通场景下的行人检测中,Faster RCNN通过CNN来提取图像特征,并通过RPN来提取候选区域,然后通过检测网络来完成最终的行人检测任务。

Faster RCNN通过CNN来提取图像特征。

在交通场景下,由于道路背景复杂,会有大量的非行人区域,因此需要一种强大的图像特征提取器来区分行人和背景。

Faster RCNN采用了深度卷积神经网络来提取图像特征,这种网络结构能够学习到更加抽象的特征表示,从而提高了行人检测的准确性和鲁棒性。

Faster RCNN通过RPN来提取候选区域。

在交通场景下,行人可能会出现在各种位置和姿态,因此需要一种有效的候选区域提取方法。

RPN是一种基于锚框的方法,它能够在图像中生成多个候选区域,并通过CNN网络来对这些候选区域进行分类和回归,从而得到最终的行人检测结果。

这种方法能够灵活地适应不同尺度和形状的行人,从而提高了行人检测的准确性和鲁棒性。

Faster RCNN在交通场景下的行人检测方法也存在一些不足之处。

由于道路交通场景下的背景复杂性,可能会导致误检和漏检的问题,需要进一步提高检测的准确性和鲁棒性。

由于交通场景下的光照和遮挡等问题,可能会影响行人检测的效果,需要进一步提高检测的鲁棒性和稳定性。

Faster RCNN在交通场景下的行人检测方法具有很大的优势,但也面临着一些挑战。

未来,我们可以通过引入更加先进的深度学习技术,如目标跟踪和姿态估计等方法,来进一步提高交通场景下的行人检测效果。

详细解读FasterRCNN

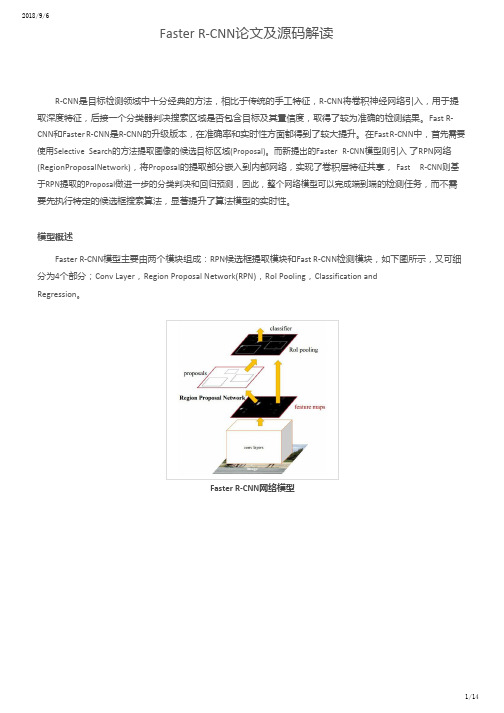

下图展示了RPN网络的具体结构。可以看到RPN网络实际分为2条线,上面一条通过softmax分类 anchors获得foreground和background(检测目标是foreground),下面一条用于计算对于anchors 的bounding box regression偏移量,以获得精确的proposal。而最后的Proposal层则负责综合 foreground anchors和bounding box regression偏移量获取proposals,同时剔除太小和超出边界的 proposals。其实整个网络到了Proposal Layer这里,就完成了相当于目标定位的功能。

.

3

Conv layers部分共有13个conv层,13个relu层,4个pooling层。在Conv layers中:所有的conv层都 是:kernel_size=3,pad=1,所有的pooling层都是:kernel_size=2,stride=2。最终ቤተ መጻሕፍቲ ባይዱ张M x N的图 像经过Conv layers之后固定变为 (M/16)x(N/16)

对于窗口一般使用四维向量(x, y, w, h)表示,分别表示窗口的中心点坐标和宽高。对于上图,红色的框 A代表原始的Foreground Anchors,绿色的框G代表目标的GT,我们的目标是寻找一种关系,使得输入 原始的anchor A经过映射得到一个跟真实窗口G更接近的回归窗口G',即:给定anchor A=(Ax, Ay, Aw, Ah),GT=[Gx, Gy, Gw, Gh],寻找一种变换F:使得F(Ax, Ay, Aw, Ah)=(G'x, G'y, G'w, G'h),其中(G'x, G'y, G'w, G'h)≈(Gx, Gy, Gw, Gh)。

fasterrcnn损失函数

fasterrcnn损失函数Faster R-CNN是一种流行的目标检测算法,其损失函数主要由两部分组成:分类损失和回归损失。

1.分类损失:在Faster R-CNN中,分类任务的损失函数采用交叉熵损失函数。

分类损失的目标是根据物体的特征将其正确地分类为不同的类别。

具体而言,对于每个RoI(Region of Interest,感兴趣区域),将其特征向量输入全连接层进行线性变换,然后通过Softmax函数进行归一化,得到各个类别的概率分布。

分类损失函数如下所示:L_cls = - ∑ (y_i * log(p_i))2.回归损失:另一方面,Faster R-CNN中还设计了一种回归损失函数,用于根据候选框的位置信息来精确定位物体。

回归损失是通过计算预测的候选框和真实候选框之间的差异来定义的。

具体而言,对于每个候选框,首先通过回归层对其位置进行线性变换,得到预测的候选框位置。

然后,计算预测候选框与真实候选框之间的差异。

回归损失函数如下所示:L_reg = ∑ (smooth_L1(t_i - t*_i))其中,t_i表示真实候选框的位置,t*_i表示预测候选框的位置,smooth_L1表示平滑L1损失函数。

该损失函数可以使得预测候选框的位置和真实候选框的位置之间的平均绝对误差最小化。

综合以上两个损失函数,Faster R-CNN的总损失函数可以定义为:L_total = L_cls + λ * L_reg其中,L_cls代表分类损失,L_reg代表回归损失,λ是一个可调参数用于平衡两个损失的权重。

通过最小化总损失函数,可以同时优化分类和定位的性能。

需要注意的是,Faster R-CNN还引入了一个辅助损失函数用于训练候选框的生成网络(Region Proposal Network,RPN)。

RPN的损失函数与回归损失函数类似,有助于更好地生成候选框。

整体而言,Faster R-CNN的损失函数是通过多任务学习来同时优化分类、定位和候选框生成的性能。

基于多尺度的Faster R-CNN算法的PCB板缺陷识别

基于多尺度的Faster R-CNN算法的PCB板缺陷识别基于多尺度的Faster R-CNN算法的PCB板缺陷识别随着电子工业的快速发展,印制电路板(PrintedCircuit Board,PCB)在各个领域中广泛应用。

然而,由于PCB制造过程中的不可避免的缺陷,如焊接不良、线路断裂等,这些缺陷可能导致电路板的性能和可靠性下降。

因此,对于PCB板缺陷的快速识别和检测显得尤为重要。

传统的PCB板缺陷识别方法通常采用基于规则或特征提取的方式,需要人工设定一些规则或特征来判定缺陷。

然而,由于PCB板上的缺陷形状和大小各不相同,并且存在一定的复杂性,这些传统方法往往难以准确地检测和识别缺陷。

近年来,深度学习技术的发展使得使用卷积神经网络(Convolutional Neural Network,CNN)进行缺陷识别成为可能。

Faster R-CNN是一种基于深度学习的目标检测算法,具有高效、准确、可扩展等优点,并且可以通过多尺度的方式识别不同大小的缺陷。

针对PCB板缺陷识别问题,本文提出了一种基于多尺度的Faster R-CNN算法。

该算法首先对PCB板进行预处理,包括灰度化、二值化、边缘检测等操作,以便更好地提取缺陷的特征。

然后,利用CNN网络对图像进行特征提取,获取图像的高层抽象表达。

接下来,利用Faster R-CNN算法进行目标检测,对图像中的缺陷进行定位和分类。

为了适应不同大小的缺陷,我们提出了一种多尺度的策略,通过设置不同的感受野和卷积核大小来适应不同尺寸的缺陷。

实验结果表明,我们的算法在PCB板缺陷识别方面取得了良好的效果。

与传统的基于规则或特征提取的方法相比,该算法具有更高的准确性和鲁棒性。

同时,多尺度的策略使得算法对于不同大小的缺陷具有较好的识别能力。

总之,本文提出的基于多尺度的Faster R-CNN算法能够有效地识别PCB板上的缺陷。

这种算法不仅具有较高的准确性和鲁棒性,而且能够适应不同大小的缺陷,具有较好的可扩展性。

详细解读Faster RCNN

bounding box regression原理

如图所示绿色框为飞机的Ground Truth(GT),红色为提取的foreground anchors,那么即便红色 的框被分类器识别为飞机,但是由于红色的框定位不准,这张图相当于没有正确的检测出飞机。所 以我们希望采用一种方法对红色的框进行微调,使得foreground anchors和GT更加接近。

进Proposal Layer forward(caffe layer的前传函数)按照以下顺序依次处理: 1、生成anchors,利用[dx(A),dy(A),dw(A),dh(A)]对所有的anchors做bbox regression 回归(这里的anchors生成和训练时完全一致) 2、按照输入的foreground softmax scores由大到小排序anchors,提取前pre_nms_topN(e.g. 6000)个anchors,即提取修正位置后的foreground anchors。 3、利用im_info将fg anchors从MxN尺度映射回PxQ原图,判断fg anchors是否大范围超过边界, 剔除严重超出边界fg anchors。 4、进行nms(nonmaximum suppression,非极大值抑制) 5、再次按照nms后的foreground softmax scores由大到小排序fg anchors,提取 post_nms_topN(e.g. 300)结果作为proposal输出。

RoI Pooling layer forward过程:在之前有明确提到:proposal=[x1, y1, x2, y2]是对应MxN尺度 的,所以首先使用spatial_scale参数将其映射回(M/16)x(N/16)大小的feature maps尺度;之后将 每个proposal水平和竖直都分为7份,对每一份都进行max pooling处理。这样处理后,即使大小不 同的proposal,输出结果都是7x7大小,实现了fixed-length output(固定长度输出)。

【目标检测】用FasterR-CNN训练自己的数据集超详细全过程

【⽬标检测】⽤FasterR-CNN训练⾃⼰的数据集超详细全过程⽬录:⼀、环境准备⼆、训练步骤三、测试过程四、计算mAP寒假在家下载了Faster R-CNN的源码进⾏学习,于是使⽤⾃⼰的数据集对这个算法进⾏实验,下⾯介绍训练的全过程。

⼀、环境准备我这⾥的环境是win10系统,pycharm + python3.7⼆、训练过程1、下载Faster R-CNN源码2、安装扩展包下载的源码中有⼀个 requirements.txt⽂件,列出了需要安装的扩展包名字。

可以在cmd中直接运⾏以下代码:pip install -r requirements.txt或者使⽤pip命令⼀个⼀个安装,所需要的扩展包有:cython、opencv-python、easydict、Pillow、matplotlib、scipy。

如果使⽤conda管理,按conda的下载⽅式也可以。

3、下载并添加预训练模型源码中预训练模型使⽤的是VGG16,VGG16模型可点开下⽅链接直接下载:下载的模型名字应该是vgg_16.ckpt,重命名为vgg16.ckpt 后,把模型保存在data\imagenet_weights\⽂件夹下。

也可以使⽤其他的模型替代VGG16,其他模型在下⽅链接中下载:4、修改训练参数打开源码的lib\config⽂件夹下的config.py⽂件,修改其中⼀些重要参数,如:(1)network参数该参数定义了预训练模型⽹络,源码中默认使⽤了vgg16模型,我们使⽤vgg16就不需修改,如果在上⼀步中使⽤其他模型就要修改。

(2)learning_rate这个参数是学习率,如果设定太⼤就可能产⽣振荡,如果设定太⼩就会使收敛速度很慢。

所以我们可以先默认为源码的0.001进⾏实验,后期再取0.01或0.0001等多次实验,找到运⾏后的相对最优值。

(3)batch_size该参数表⽰梯度下降时数据批量⼤⼩,⼀般可以取16、32、64、128、256等。

FasterR-CNN论文详解

FasterR-CNN论⽂详解⽬录&创新点设计Region Proposal Networks【RPN】,利⽤CNN卷积操作后的特征图⽣成region proposals,代替了Selective Search、EdgeBoxes等⽅法,速度上提升明显;训练Region Proposal Networks与检测⽹络【Fast R-CNN】共享卷积层,⼤幅提⾼⽹络的检测速度。

&问题是什么继Fast R-CNN后,在CPU上实现的区域建议算法Selective Search【2s/image】、EdgeBoxes【0.2s/image】等成了物体检测速度提升上的最⼤瓶颈。

&如何解决问题测试过程Faster R-CNN统⼀的⽹络结构如下图所⽰,可以简单看作RPN⽹络+Fast R-CNN⽹络。

注意:上图Fast R-CNN中含特有卷积层,博主认为不是所有卷积层都参与共享。

1. ⾸先向CNN⽹络【ZF或VGG-16】输⼊任意⼤⼩图⽚;2. 经过CNN⽹络前向传播⾄最后共享的卷积层,⼀⽅⾯得到供RPN⽹络输⼊的特征图,另⼀⽅⾯继续前向传播⾄特有卷积层,产⽣更⾼维特征图;3. 供RPN⽹络输⼊的特征图经过RPN⽹络得到区域建议和区域得分,并对区域得分采⽤⾮极⼤值抑制【阈值为0.7】,输出其Top-N【⽂中为300】得分的区域建议给RoI池化层;4. 第2步得到的⾼维特征图和第3步输出的区域建议同时输⼊RoI池化层,提取对应区域建议的特征;5. 第4步得到的区域建议特征通过全连接层后,输出该区域的分类得分以及回归后的bounding-box。

解释分析RPN⽹络结构是什么?实现什么功能?具体如何实现?单个RPN⽹络结构如下图:注意:上图中卷积层/全连接层表⽰卷积层或者全连接层,作者在论⽂中表⽰这两层实际上是全连接层,但是⽹络在所有滑窗位置共享全连接层,可以很⾃然地⽤n×n卷积核【论⽂中设计为3×3】跟随两个并⾏的1×1卷积核实现,⽂中这么解释的,博主并不是很懂,尴尬。

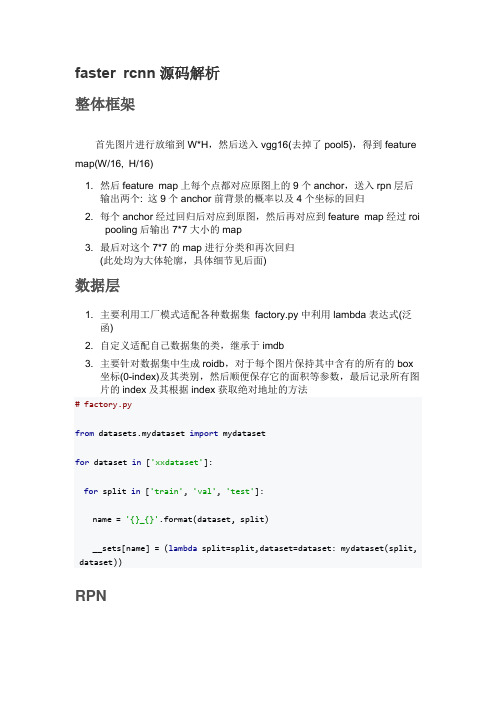

faster rcnn源码解析

faster rcnn源码解析整体框架首先图片进行放缩到W*H,然后送入vgg16(去掉了pool5),得到feature map(W/16, H/16)1. 然后feature map上每个点都对应原图上的9个anchor,送入rpn层后输出两个: 这9个anchor前背景的概率以及4个坐标的回归2. 每个anchor经过回归后对应到原图,然后再对应到feature map经过roipooling后输出7*7大小的map3. 最后对这个7*7的map进行分类和再次回归(此处均为大体轮廓,具体细节见后面)数据层1. 主要利用工厂模式适配各种数据集factory.py中利用lambda表达式(泛函)2. 自定义适配自己数据集的类,继承于imdb3. 主要针对数据集中生成roidb,对于每个图片保持其中含有的所有的box坐标(0-index)及其类别,然后顺便保存它的面积等参数,最后记录所有图片的index及其根据index获取绝对地址的方法# factory.pyfrom datasets.mydataset import mydatasetfor dataset in ['xxdataset']:for split in ['train', 'val', 'test']:name = '{}_{}'.format(dataset, split)__sets[name] = (lambda split=split,dataset=dataset: mydataset(split, dataset))RPNanchors生成经过feature extraction后,feature map的大小是(W/16, H/16), 记为(w,h),然后每个feature map每个点生成k个anchor,论文中设置了3中ratio, 3种s cale 共产生了w*h*9个anchors# # array([[ -83., -39., 100., 56.],# [-175., -87., 192., 104.],# [-359., -183., 376., 200.],# [ -55., -55., 72., 72.],# [-119., -119., 136., 136.],# [-247., -247., 264., 264.],# [ -35., -79., 52., 96.],# [ -79., -167., 96., 184.],# [-167., -343., 184., 360.]])# 先以左上角(0,0)为例生成9个anchor,然后在向右向下移动,生成整个feature ma p所有点对应的anchoranchors前背景和坐标预测正如整体框架上画的那样,feature map后先跟了一个3*3的卷积,然后分别用2个1*1的卷积,预测feature map上每个点对应的9个anchor属于前背景的概率(9*2)和4个回归的坐标(9*4)# rpnself.rpn_net = nn.Conv2d(self._net_conv_channels, cfg.RPN_CHANNELS, [3, 3], padding=1)self.rpn_cls_score_net = nn.Conv2d(cfg.RPN_CHANNELS, self._num_anchors * 2, [1, 1])self.rpn_bbox_pred_net = nn.Conv2d(cfg.RPN_CHANNELS, self._num_anchors * 4, [1, 1])rpn = F.relu(self.rpn_net(net_conv))rpn_cls_score = self.rpn_cls_score_net(rpn) # batch * (num_anchors * 2) * h * wrpn_bbox_pred = self.rpn_bbox_pred_net(rpn) # batch * (num_anchors * 4) * h * wanchor target对上一步产生的anchor分配target label,1前景or0背景or-1忽略,以便训练rpn(只有分配了label的才能计算loss,即参与训练)无NMS1. 对于每个gt box,找到与他iou最大的anchor然后设为正样本2. 对于每个anchor只要它与任意一个gt box iou>0.7即设为正样本3. 对于每个anchor它与任意一个gt box iou都<0.3即设为负样本4. 不是正也不是负的anchor被忽略注意正样本的数量由num_fg = int(cfg.TRAIN.RPN_FG_FRACTION * cfg.TRAIN. RPN_BATCHSIZE)控制,默认是256*0.5=128,即最多有128个正样本参与rpn 的训练. 假如正样本有1234个,则随机抽1234-128个正样本将其label设置为-1,即忽略掉,当然正样本也有可能不足128个,那就都保留下来.负样本的数量由num_bg = cfg.TRAIN.RPN_BATCHSIZE - np.sum(labels = = 1),同理如果超额也为多余的忽略.TRAIN.RPN_FG_FRACTION控制参与rpn训练的正样本的数量。

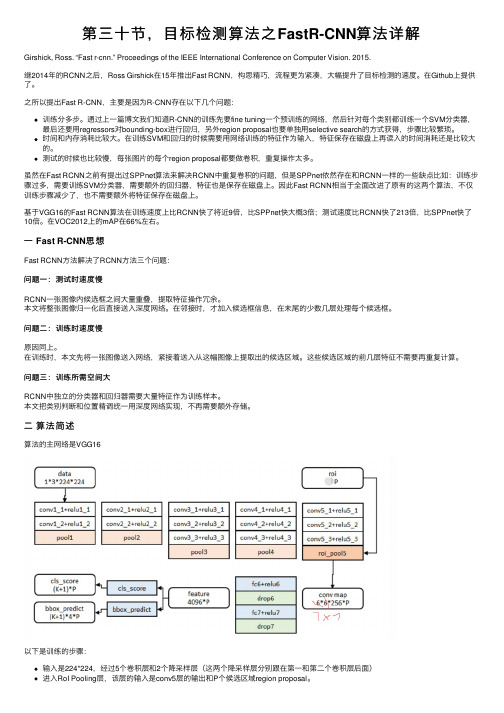

第三十节,目标检测算法之FastR-CNN算法详解

第三⼗节,⽬标检测算法之FastR-CNN算法详解Girshick, Ross. “Fast r-cnn.” Proceedings of the IEEE International Conference on Computer Vision. 2015.继2014年的RCNN之后,Ross Girshick在15年推出Fast RCNN,构思精巧,流程更为紧凑,⼤幅提升了⽬标检测的速度。

在Github上提供了。

之所以提出Fast R-CNN,主要是因为R-CNN存在以下⼏个问题:训练分多步。

通过上⼀篇博⽂我们知道R-CNN的训练先要fine tuning⼀个预训练的⽹络,然后针对每个类别都训练⼀个SVM分类器,最后还要⽤regressors对bounding-box进⾏回归,另外region proposal也要单独⽤selective search的⽅式获得,步骤⽐较繁琐。

时间和内存消耗⽐较⼤。

在训练SVM和回归的时候需要⽤⽹络训练的特征作为输⼊,特征保存在磁盘上再读⼊的时间消耗还是⽐较⼤的。

测试的时候也⽐较慢,每张图⽚的每个region proposal都要做卷积,重复操作太多。

虽然在Fast RCNN之前有提出过SPPnet算法来解决RCNN中重复卷积的问题,但是SPPnet依然存在和RCNN⼀样的⼀些缺点⽐如:训练步骤过多,需要训练SVM分类器,需要额外的回归器,特征也是保存在磁盘上。

因此Fast RCNN相当于全⾯改进了原有的这两个算法,不仅训练步骤减少了,也不需要额外将特征保存在磁盘上。

基于VGG16的Fast RCNN算法在训练速度上⽐RCNN快了将近9倍,⽐SPPnet快⼤概3倍;测试速度⽐RCNN快了213倍,⽐SPPnet快了10倍。

在VOC2012上的mAP在66%左右。

⼀ Fast R-CNN思想Fast RCNN⽅法解决了RCNN⽅法三个问题:问题⼀:测试时速度慢RCNN⼀张图像内候选框之间⼤量重叠,提取特征操作冗余。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Faster R-CNNTowards Real-Time Object Detection with Region Proposal NetworksFaster R-CNN(NIPS 2015)Computer Vision TaskHistory(?) of R-CNN•Rich feature hierarchies for accurate object detection and semantic segmentation(2013)•Fast R-CNN(2015)•Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks(2015)•Mask R-CNN(2017)Is Faster R-CNN Really Fast?•Generally R-FCN and SSDmodels are faster onaverage while Faster R-CNN models are moreaccurate•Faster R-CNN models canbe faster if we limit thenumber of regionsproposedR-CNN ArchitectureR-CNNRegion Proposals –Selective Search •Bottom-up segmentation, merging regions at multiple scalesConvertregions toboxesR-CNN Training•Pre-train a ConvNet(AlexNet) for ImageNet classification dataset •Fine-tune for object detection(softmax+ log loss)•Cache feature vectors to disk•Train post hoc linear SVMs(hinge loss)•Train post hoc linear bounding-box regressors(squared loss)“Post hoc” means the parameters are learned afterthe ConvNet is fixedBounding-Box Regressionspecifies the pixel coordinates of the center of proposal P i’sbounding box together with P i’s width and height in pixelsmeans the ground-truth bounding boxBounding-Box RegressionProblems of R-CNN•Slow at test-time: need to run full forward path of CNN for each region proposal▪13s/image on a GPU(K40)▪53s/image on a CPU•SVM and regressors are post-hoc: CNN features not updated in response to SVMs and regressors•Complex multistage training pipeline (84 hours using K40 GPU)▪Fine-tune network with softmax classifier(log loss)▪Train post-hoc linear SVMs(hinge loss)▪Train post-hoc bounding-box regressions(squared loss)Fast R-CNN•Fix most of what’s wrong with R-CNN and SPP-net •Train the detector in a single stage, end-to-end ▪No caching features to disk▪No post hoc training steps•Train all layers of the networkFast R-CNN ArchitectureFast R-CNNRoI PoolingVGG-16RoIPoolingTraining & Testing1.Takes an input and a set of bounding boxes2.Generate convolutional feature maps3.For each bbox, get a fixed-length feature vector from RoIpooling layer4.Outputs have two information▪K+1 class labels▪Bounding box locations•Loss functionR-CNN vs SPP-net vs Fast R-CNNRuntime dominated byregion proposals!Problems of Fast R-CNN•Out-of-network region proposals are the test-time computational bottleneck•Is it fast enough??Faster R-CNN(RPN + Fast R-CNN)•Insert a Region ProposalNetwork (RPN) after the lastconvolutional layer using GPU!•RPN trained to produce regionproposals directly; no need forexternal region proposals•After RPN, use RoI Pooling andan upstream classifier and bboxregressor just like Fast R-CNNTraining Goal : Share Features3 x 3•Slide a small window on the feature map•Build a small network for▪Classifying object or not-object▪Regressing bbox locations•Position of the sliding window provides localization information with reference to the image•Box regression provides finer localization information with reference to this sliding window ZF : 256-d, VGG : 512-d•Use k anchor boxes at each location•Anchors are translation invariant: use the same ones at every location•Regression gives offsets from anchor boxes•Classification gives the probability that each (regressed) anchor shows an objectRPN(Fully Convolutional Network)•Intermediate Layer –256(or 512)3x3 filter, stride 1, padding 1•Cls layer –18(9x2) 1x1 filter, stride1, padding 0•Reg layer –36(9x4) 1x1 filter, stride 1, padding 0ZF : 256-d, VGG : 512-d3 x 3Anchors as references•Anchors: pre-defined reference boxes•Multi-scale/size anchors:▪Multiple anchors are used at each position:3 scale(128x128, 256x256, 512x512) and 3 aspect rations(2:1, 1:1, 1:2) yield 9anchors▪Each anchor has its own prediction function▪Single-scale features, multi-scale predictionsPositive/Negative Samples•An anchor is labeled as positive if▪The anchor is the one with highest IoU overlap with a ground-truth box▪The anchor has an IoU overlap with a ground-truth box higher than0.7•Negative labels are assigned to anchors with IoU lower than 0.3 for all ground-truth boxes•50%/50% ratio of positive/negative anchors in a minibatchRPN Loss Function4-Step Alternating TrainingResultsIs It Enough?•RoI Pooling has some quantization operations•These quantizations introduce misalignments between the RoI and the extracted features•While this may not impact classification, it can make a negative effect on predicting bbox•Mask R-CNN extends Faster R-CNN by adding a branch for predicting segmentation masks on each Region of Interest (RoI), in parallel with the existing branch for classification and bounding box regressionLoss Function, Mask Branch•The mask branch has a K x m x m -dimensional output for each RoI, which encodes K binary masks of resolution m ×m, one for each of the K classes.•Applying per-pixel sigmoid•For an RoI associated with ground-truth class k, Lmask is only defined on the k-th maskRoI Align•RoI Align don’t use quantization of the RoI boundaries •Bilinear interpolation is used for computing the exact valuesof the input featuresResults –MS COCOThank You。