ARM架构服务器

arm x86 计算差异

arm x86 计算差异ARM和x86是两种不同的计算机架构,它们在处理器设计和指令集上存在一些差异。

本文将对ARM和x86的差异进行详细介绍。

ARM和x86都是广泛应用于个人电脑、服务器和移动设备等领域的计算机架构。

ARM架构主要用于低功耗设备,如智能手机和平板电脑,而x86架构则主要用于高性能计算机和服务器。

一、指令集差异ARM和x86的指令集存在一些差异。

ARM使用的是精简指令集(RISC)指令集,指令长度固定为32位。

而x86使用的是复杂指令集(CISC)指令集,指令长度可变,有16位和32位两种指令。

由于指令集的不同,ARM和x86在执行相同的任务时可能会有一些差异。

ARM的指令集设计更加简单,执行速度较快,适合用于低功耗设备。

而x86的指令集设计更加复杂,执行速度相对较慢,但可以处理更复杂的任务。

二、寄存器差异ARM和x86在寄存器的数量和用途上也存在一些差异。

ARM架构通常具有较少的通用寄存器,一般为16个。

而x86架构通常具有更多的通用寄存器,一般为8个。

ARM和x86在浮点寄存器和向量寄存器的设计上也存在一些差异。

ARM架构通常具有较多的浮点寄存器和向量寄存器,可以更高效地进行浮点运算和向量计算。

而x86架构通常使用协处理器来处理浮点运算。

三、内存管理差异ARM和x86在内存管理方面也存在一些差异。

ARM架构使用了一种称为页表的数据结构来管理内存,以实现虚拟内存和内存保护。

而x86架构使用了一种称为分段机制的方式来管理内存。

在虚拟内存方面,ARM和x86的实现方式略有不同。

ARM使用了一种称为TLB(Translation Lookaside Buffer)的高速缓存来加速地址转换,而x86使用了一种称为页表缓冲器(Translation Lookaside Buffer)的高速缓存。

四、操作系统支持差异由于ARM和x86在指令集和寄存器等方面存在一些差异,因此它们对操作系统的支持也有所不同。

linux cpu架构类型

linux cpu架构类型Linux支持多种CPU架构类型,每种架构都有其特定的特点和用途。

以下是一些常见的Linux CPU架构类型:1. x86架构,这是最常见的CPU架构类型,广泛应用于个人电脑和服务器。

x86架构包括32位和64位的变体,如Intel的x86和AMD的x86-64(也称为AMD64)。

大多数常见的Linux发行版都支持x86架构。

2. ARM架构,ARM架构最初设计用于低功耗嵌入式系统,如智能手机、平板电脑和物联网设备。

随着其性能的提升,ARM架构也被广泛用于服务器和超级计算机。

许多Linux发行版都提供针对ARM架构的版本,如Raspberry Pi上的Raspbian。

3. Power架构,Power架构最初由IBM开发,用于高性能计算和企业级服务器。

它也被广泛应用于超级计算机和大型企业服务器。

一些Linux发行版,如Red Hat Enterprise Linux和SUSE Linux Enterprise Server,提供了针对Power架构的支持。

4. SPARC架构,SPARC架构最初由Sun Microsystems(现在是Oracle)开发,用于其服务器和工作站产品。

尽管SPARC架构的市场份额较小,但仍然有一些专门针对SPARC架构的Linux发行版。

除了上述列举的架构类型外,还有一些其他的架构类型,如MIPS、IA-64等,它们在特定的场景下也得到了应用。

总的来说,Linux作为一个开放源代码的操作系统,支持多种不同的CPU架构类型,这使得它能够在各种设备和系统上运行,并且为开发者和用户提供了更多的选择。

arm架构 cpu技术参数

arm架构 cpu技术参数

ARM处理器的技术参数主要包括以下几个方面:

1. 处理器架构:ARM处理器基于ARM架构进行设计。

ARM架构是一种精简指令集(RISC)架构,具有低功耗、低成本和高性能的特点。

2. 指令集:ARM处理器支持多种指令集,包括Thumb(16位)/ARM (32位)双指令集。

3. 寄存器:ARM处理器使用大量的寄存器,这有助于提高指令执行速度。

4. 高速缓存:ARM处理器通常具有高速缓存(Cache)功能,用于存储常用的数据和指令,以加速内存访问速度。

5. 内存管理单元(MMU):ARM处理器具有内存管理单元,用于实现虚拟内存到物理内存的转换。

6. 浮点单元(FPU):对于需要高性能浮点运算的应用,ARM处理器可以配备浮点单元。

7. 功耗管理:ARM处理器具有低功耗设计,支持多种节能模式和电源管理模式。

8. 安全性:ARM处理器具备硬件安全功能,支持加密和安全启动等安全特性。

9. 互连:ARM处理器支持多种互连技术,如高速串行接口、总线互连等,以实现多个处理器或模块之间的通信。

10. 应用领域:ARM处理器广泛应用于移动设备、嵌入式系统、物联网设备、服务器等领域。

以上是ARM架构CPU的一些常见技术参数,具体的技术规格可能会因不同的处理器型号而有所差异。

arm架构原理

arm架构原理ARM架构原理ARM架构是一种广泛应用于移动设备、嵌入式系统和智能家居等领域的计算机处理器架构。

它的设计理念注重低功耗和高性能,并且具有高度的可伸缩性和灵活性。

本文将介绍ARM架构的原理和特点。

1. ARM架构的历史ARM(Advanced RISC Machines)是由英国公司ARM Holdings 开发的一种精简指令集(RISC)架构。

ARM公司成立于1990年,最初是作为Acorn计算机公司的一个子公司,致力于开发用于Acorn电脑的低功耗、高性能的处理器。

随着移动设备市场的崛起,ARM架构逐渐被广泛应用于手机、平板电脑和其他移动设备中。

2. ARM架构的特点ARM架构的特点之一是精简指令集。

它采用了较少的指令集,每条指令的执行时间短,可以提高系统的性能。

此外,ARM架构还支持多级流水线和乱序执行等技术,进一步提高了处理器的效率。

另一个特点是低功耗。

ARM架构的设计注重节能,通过优化电路设计、降低电压和频率等方式来降低功耗。

这使得ARM处理器在移动设备等对电池寿命要求较高的环境中表现出色。

ARM架构还具有高度的可伸缩性和灵活性。

ARM公司提供了多个不同的处理器核心和架构版本,以满足不同市场和应用的需求。

开发者可以根据具体需求选择适合的ARM架构,从而实现性能和功耗的最佳平衡。

3. ARM架构的工作原理ARM架构的处理器由多个功能单元组成,包括指令译码器、运算单元、存储器和控制单元等。

当程序运行时,处理器从内存中读取指令,并按照指令集的规则进行解码和执行。

ARM架构采用的是load-store架构,即所有的数据访问都通过加载和存储指令来完成。

这种架构的优点是简化了指令集和硬件设计,提高了处理器的性能和效率。

ARM架构还支持条件执行和分支预测等技术。

条件执行允许指令根据特定条件是否满足来决定是否执行,从而减少了分支指令的使用,提高了程序的执行效率。

分支预测则是根据过去的执行情况来预测分支指令的执行路径,以减少分支带来的延迟。

X86架构与ARM架构区别

X86架构与ARM架构区别1.设计理念:-X86架构是传统的复杂指令集计算机(CISC)架构,它的设计目标是提供功能丰富和灵活的指令集,以支持多样化的计算任务。

-ARM架构则是精简指令集计算机(RISC)架构,它更注重的是简化指令集,提高整体效率和节省功耗。

2.指令集:-X86架构有一套复杂的指令集,包含大量的指令,可完成复杂的任务,支持多种操作模式和寻址模式。

这使得X86架构的处理器在处理大型软件和运算密集型任务时表现出色。

-ARM架构的指令集相对精简,仅有32位或64位的固定长度指令。

虽然指令集较少,但非常高效,适用于移动设备和嵌入式系统,可以提供较低的功耗和较高的性能。

3.功耗和性能:-X86架构的处理器通常具有较高的功耗,适用于高性能计算领域,如桌面电脑、工作站和服务器。

它们通常拥有更高的主频和更多的核心,能够处理更大的数据集和更多的并行任务。

-ARM架构的处理器功耗较低,适合用在移动设备和嵌入式系统中。

虽然单个处理核心的性能可能不如X86处理器高,但ARM架构的优势在于可以通过多核心并行处理来提高整体性能。

4.软件兼容性:- X86架构是PC领域的标准架构,几乎所有的桌面软件和操作系统都能够运行在基于X86架构的处理器上,例如Windows、MacOS和Linux。

这使得X86架构成为主流的计算平台。

-ARM架构则是移动设备领域的主流架构,大部分移动设备和嵌入式系统都采用ARM架构。

但是,由于指令集和结构的不同,ARM架构与X86架构不兼容,因此软件和操作系统需要适配才能在ARM处理器上运行。

5.生态系统:-X86架构具有非常庞大的生态系统,有大量的硬件设备和软件开发者支持,同时拥有成熟的工具链和开发环境,使得开发者能够更轻松地开发和优化软件。

-ARM架构经过近年来的迅速发展,也建立了庞大的生态系统,并且已经在移动设备和物联网领域得到了广泛应用。

随着ARM服务器和高性能计算的兴起,ARM架构的生态系统也在不断扩大。

arm架构通俗理解

arm架构通俗理解ARM架构是一种非常常见的计算机处理器架构,广泛应用于移动设备、嵌入式系统和低功耗领域。

本文将以通俗易懂的方式介绍ARM 架构的基本概念和特点。

ARM架构最早由英国的ARM公司开发,它的全称是Advanced RISC Machines。

相比于传统的复杂指令集计算机(CISC)架构,ARM采用了精简指令集计算机(RISC)的设计理念,使得处理器的指令集更加简洁高效。

ARM架构的核心特点之一是低功耗。

由于移动设备的电池寿命限制和嵌入式系统对功耗的要求,ARM架构在设计上非常注重节能。

ARM 处理器通过优化指令集和电源管理技术,能够在保证性能的同时,尽量减少功耗的消耗。

另一个重要特点是高性能。

尽管ARM处理器的指令集相对精简,但通过增加指令级并行和高速缓存等技术手段,ARM架构的处理器能够实现较高的性能表现。

这使得ARM架构不仅适用于低功耗领域,也能够满足高性能计算的需求。

ARM架构还具有高度可定制性的特点。

根据不同的应用需求,ARM处理器可以进行各种程度的定制。

这使得ARM架构在不同的领域和市场上有着广泛的应用。

例如,移动设备上的ARM处理器通常会针对功耗和性能进行优化,而服务器和网络设备上的ARM处理器则可能会更加注重多核处理和数据处理能力。

ARM架构还具有较好的软件兼容性。

由于ARM架构的广泛应用和开放性,许多操作系统和软件都提供了ARM平台的支持。

这使得开发人员可以比较轻松地将软件移植到不同的ARM设备上,提高了开发效率和软件的可移植性。

总的来说,ARM架构是一种低功耗、高性能、可定制和软件兼容性好的处理器架构。

它在移动设备、嵌入式系统和低功耗领域有着广泛的应用,并且在高性能计算领域也逐渐崭露头角。

随着物联网和人工智能等新兴领域的发展,ARM架构将继续发挥重要作用,推动计算技术的进步和创新。

服务器的基本参数有哪些

引言概述:服务器是现代计算机系统中的重要组成部分,负责存储、处理和传输数据。

服务器的基本参数对于其性能和功能起着至关重要的作用。

本文将介绍服务器的基本参数,包括处理器、内存、硬盘、网络接口和操作系统。

正文内容:一、处理器1.架构类型:常见的服务器处理器架构有x86、ARM和PowerPC 等,每种架构都有其特点和适用的场景。

2.核心数量:多核处理器能同时执行多个计算任务,提高服务器的处理能力。

3.频率和缓存:处理器的频率决定了其每秒钟可执行的指令数量,缓存大小则影响了数据的读写速度。

二、内存1.容量:服务器的内存容量决定了能同时处理的数据量大小。

2.类型:常见的内存类型有DDR3和DDR4,后者具有更高的数据传输速率。

3.错误检测与校正(ECC):ECC内存能检测和修正内存中的错误,提高服务器的可靠性和稳定性。

三、硬盘1.类型:服务器常用的硬盘类型包括HDD(机械硬盘)和SSD (固态硬盘),后者具有更快的读写速度和更低的能耗。

2.容量:硬盘容量决定了服务器能存储的数据量大小。

3.RD级别:RD技术能实现对多个硬盘的数据冗余和备份,提高服务器的数据可靠性和安全性。

四、网络接口1.速度:网络接口的速度决定了服务器与外部网络的数据传输速度,常见的速度有千兆以太网和万兆以太网。

2.接口类型:服务器常用的网络接口类型有RJ45(以太网)和光纤接口。

3.冗余:服务器通常具备冗余的网络接口,以保障在一接口故障时仍能正常工作。

五、操作系统1.类型:常见的服务器操作系统有WindowsServer、Linux和UNIX等,每个操作系统有各自的优势和适用场景。

2.版本:操作系统的版本决定了其功能和安全性的程度。

3.更新和补丁:定期更新操作系统和安装安全补丁是保持服务器安全性的重要步骤。

总结:服务器的基本参数包括处理器、内存、硬盘、网络接口和操作系统。

处理器的架构、核心数量、频率和缓存量决定了服务器的计算能力;内存的容量和类型直接影响了服务器的数据处理能力;硬盘的类型、容量和RD级别决定了服务器的存储能力和数据安全性;网络接口的速度、类型和冗余性能决定了服务器与外部网络的连接质量;操作系统的类型、版本和更新情况直接关系到服务器的功能和安全性。

一文看懂arm架构和x86架构有什么区别

一文看懂arm架构和x86架构有什么区别本文主要介绍的是arm架构和x86架构的区别,首先介绍了ARM架构图,其次介绍了x86架构图,最后从性能、扩展能力、操作系统的兼容性、软件开发的方便性及可使用工具的多样性及功耗这五个方面详细的对比了arm架构和x86架构的区别,具体的跟随小编一起来了解一下。

什么叫arm架构ARM架构过去称作进阶精简指令集机器(AdvancedRISCMachine,更早称作:AcornRISCMachine),是一个32位精简指令集(RISC)处理器架构,其广泛地使用在许多嵌入式系统设计。

由于节能的特点,ARM处理器非常适用于移动通讯领域,符合其主要设计目标为低耗电的特性。

在今日,ARM家族占了所有32位嵌入式处理器75%的比例,使它成为占全世界最多数的32位架构之一。

ARM处理器可以在很多消费性电子产品上看到,从可携式装置(PDA、移动电话、多媒体播放器、掌上型电子游戏,和计算机)到电脑外设(硬盘、桌上型路由器)甚至在导弹的弹载计算机等军用设施中都有他的存在。

在此还有一些基于ARM设计的派生产品,重要产品还包括Marvell的XScale架构和德州仪器的OMAP系列。

ARM架构图下图所示的是ARM构架图。

它由32位ALU、若干个32位通用寄存器以及状态寄存器、32&TImes;8位乘法器、32&TImes;32位桶形移位寄存器、指令译码以及控制逻辑、指令流水线和数据/地址寄存器组成。

1、ALU:它有两个操作数锁存器、加法器、逻辑功能、结果以及零检测逻辑构成。

2、桶形移位寄存器:ARM采用了32&TImes;32位的桶形移位寄存器,这样可以使在左移/右移n位、环移n位和算术右移n位等都可以一次完成。

3、高速乘法器:乘法器一般采用“加一移位”的方法来实现乘法。

ARM为了提高运算速度,则采用两位乘法的方法,根据乘数的2位来实现“加一移位”运算;ARM高速乘法器采用32&TImes;8位的结构,这样,可以降低集成度(其相应芯片面积不到并行乘法器的1/3)。

arm架构分类

arm架构分类ARM架构是一种广泛使用的计算机处理器架构,常用于移动设备、嵌入式系统、服务器等领域。

根据不同的应用场景和需求,ARM架构可以分为以下几类:1. Cortex-A系列Cortex-A系列是ARM架构中最强大的处理器系列,主要用于高性能计算领域。

它们具有多核心、高频率和大缓存等特点,能够支持复杂的操作系统和应用程序。

常见的Cortex-A系列处理器包括Cortex-A7、Cortex-A9、Cortex-A15、Cortex-A53和Cortex-A72等。

2. Cortex-R系列Cortex-R系列是ARM架构中专门设计用于实时计算领域的处理器系列。

它们具有高度可靠性、低延迟和快速响应等特点,适合于控制系统、汽车电子和医疗设备等领域。

常见的Cortex-R系列处理器包括Cortex-R4、Cortex-R5和Cortex-R8等。

3. Cortex-M系列Cortex-M系列是ARM架构中专门设计用于微控制器领域的处理器系列。

它们具有低功耗、低成本和小尺寸等特点,适合于嵌入式系统、传感器和智能家居等领域。

常见的Cortex-M系列处理器包括Cortex-M0、Cortex-M3、Cortex-M4和Cortex-M7等。

4. Neoverse系列Neoverse系列是ARM架构中专门设计用于数据中心和云计算领域的处理器系列。

它们具有高度可扩展性、高效能和低功耗等特点,适合于大规模数据处理和分布式计算等场景。

常见的Neoverse系列处理器包括Neoverse N1和Neoverse V1等。

总之,ARM架构根据不同的应用场景和需求,设计了多个不同系列的处理器,以满足各种计算需求。

浅析CPU两大架构ARM和X86区别及拓展windowsx86与x64的区别

浅析CPU两⼤架构ARM和X86区别及拓展windowsx86与x64的区别 由于在 linux 安装nodejs环境时遇到⼀个不可执⾏⽂件的问题,涉及到了ARM和x64⽂件,所以查了点资料初步了解了⼀下cpu两⼤架构:ARM与X86的区别。

⼀、CPU是什么 中央处理单元(CPU)主要由运算器、控制器、寄存器三部分组成,从字⾯意思看运算器就是起着运算的作⽤,控制器就是负责发出CPU每条指令所需要的信息,寄存器就是保存运算或者指令的⼀些临时⽂件,这样可以保证更⾼的速度。

CPU有着处理指令、执⾏操作、控制时间、处理数据四⼤作⽤,打个⽐喻来说,CPU就像我们的⼤脑,帮我们完成各种各样的⽣理活动。

因此如果没有CPU,那么电脑就是⼀堆废物,⽆法⼯作。

移动设备其实很复杂,这些CPU需要执⾏数以百万计的指⽰,才能使它向我们期待的⽅向运⾏,⽽CPU的速度和功率效率是⾄关重要的。

速度影响⽤户体验,⽽效率影响电池寿命。

最完美的移动设备是⾼性能和低功耗相结合。

⼆、要了解X86和ARM,就得先了解复杂指令集(CISC)和精简指令集(RISC) 从CPU发明到现在,有⾮常多种架构,从我们熟悉的X86,ARM,到不太熟悉的MIPS,IA64,它们之间的差距都⾮常⼤。

但是如果从最基本的逻辑⾓度来分类的话,它们可以被分为两⼤类,即所谓的“复杂指令集”与“精简指令集”系统,也就是经常看到的“CISC”与“RISC”。

Intel和ARM处理器的第⼀个区别是,前者使⽤复杂指令集(CISC),⽽后者使⽤精简指令集(RISC)。

属于这两种类中的各种架构之间最⼤的区别,在于它们的设计者考虑问题⽅式的不同。

我们可以继续举个例⼦,⽐如说我们要命令⼀个⼈吃饭,那么我们应该怎么命令呢?我们可以直接对他下达“吃饭”的命令,也可以命令他“先拿勺⼦,然后舀起⼀勺饭,然后张嘴,然后送到嘴⾥,最后咽下去”。

从这⾥可以看到,对于命令别⼈做事这样⼀件事情,不同的⼈有不同的理解,有⼈认为,如果我⾸先给接受命令的⼈以⾜够的训练,让他掌握各种复杂技能(即在硬件中实现对应的复杂功能),那么以后就可以⽤⾮常简单的命令让他去做很复杂的事情——⽐如只要说⼀句“吃饭”,他就会吃饭。

ARM体系架构解析

ARM体系架构解析

ARM体系架构是由英国ARM公司推出的常见的32位RISC处理器架构,其在移动设备、嵌入式系统和服务器市场上有广泛应用。

其发展历史源远

流长,经过数十年的发展,其功能也在不断扩展,ARM体系架构已经成为

一种标准处理器架构。

ARM体系架构主要由四大部分组成,分别是内核、外设、中断和指令集。

其中,内核是ARM体系架构的核心,负责处理计算机的所有功能,包

括控制、数据存储和算法处理等。

外设又称外围设备,是处理器与外部世

界的桥梁,可以操控外部设备,比如键盘、显示器、磁盘和网络等。

中断

则是处理器如何处理外部设备发出的信号,其中有多重中断,监听外部设

备的信号,基于不同的中断模式,让处理器运行起来。

指令集是ARM体系

架构的核心,指令集是一组程序指令,它们描述了处理器如何处理和操作

数据,ARM有自己的专有指令集,被广泛应用到移动设备和嵌入式系统中。

ARM体系架构的另一个重要组成部分就是嵌入式软件,由于ARM的低

功耗、低成本和安全性,使得ARM广泛应用于很多嵌入式系统,而这些嵌

入式系统也需要嵌入式软件的支持,嵌入式软件具有低功耗、低功耗和嵌

入式系统的高稳定性等优点,此外。

Linux x86与arm特性区别?

Linux 操作系统在x86 架构和ARM 架构上都有广泛的应用,它们在体系结构、特性和应用场景上存在一些区别。

1. **体系结构**:

- x86 架构:主要用于个人计算机(PC)和服务器,包括Intel 和AMD 等厂商的处理器。

x86 架构以其强大的计算能力和广泛的兼容性而闻名。

- ARM 架构:主要用于嵌入式系统、移动设备和低功耗场景,包括智能手机、平板电脑、物联网设备等。

ARM 处理器以其低功耗和高性能效率而著称。

2. **指令集**:

- x86 架构使用复杂指令集计算机(CISC)架构,其指令集更为复杂,但可以执行更多的操作。

- ARM 架构使用精简指令集计算机(RISC)架构,其指令集更加简洁高效,适用于低功耗和嵌入式场景。

3. **应用场景**:

- x86 架构常用于桌面计算机、服务器和高性能计算领域,适用于需要高性能和通用性的场景。

- ARM 架构主要用于移动设备、嵌入式系统和物联网设备等低功耗场景,以及对功耗和散热有严格要求的领域。

4. **操作系统支持**:

- Linux 支持x86 架构的广泛应用,同时也在ARM 架构上有着日益增长的应用,尤其是随着物联网和嵌入式系统的普及。

总的来说,x86 架构和ARM 架构在应用场景、指令集和处理器特性上存在一些区别,而Linux 作为开源操作系统,能够灵活地适配不同的硬件架构,因此在x86 和ARM 架构下都有丰富的应用。

看最适合服务器的CPU排行榜

看最适合服务器的CPU排行榜CPU(Central Processing Unit,中央处理器)可以说是一台服务器的心脏。

在选择服务器时,了解最适合服务器的CPU排行榜是至关重要的。

本文将以清晰、有条理的方式,整理介绍各类服务器CPU的优势和劣势,帮助读者更好地选择适合自己需求的服务器CPU。

一、Intel Xeon系列Intel Xeon系列是服务器领域最受欢迎的CPU之一。

它们具有高性能、可靠性和安全性,广泛应用于企业级服务器和数据中心。

最新的Intel Xeon Scalable系列针对不同的用途进行了划分,适合不同级别的工作负载。

1. Intel Xeon Bronze系列Intel Xeon Bronze系列是入门级服务器CPU。

尽管它在核心数和缓存容量上可能相对较低,但其仍然具备可靠性和稳定性,适合小型企业或对性能要求不高的任务。

2. Intel Xeon Silver系列Intel Xeon Silver系列是中级服务器CPU。

它提供了更高的核心数和缓存容量,适合处理中等工作负载的企业。

对于需要同时运行多个虚拟机或处理大型数据库的企业来说,这个系列是一个不错的选择。

3. Intel Xeon Gold系列Intel Xeon Gold系列是高级服务器CPU。

拥有更高的核心数和缓存容量,以及更高的主频和线程数。

这些CPU适用于具有高性能要求的任务,例如科学模拟、金融分析和机器学习等。

4. Intel Xeon Platinum系列Intel Xeon Platinum系列是顶级服务器CPU。

它们是目前最强大的服务器CPU,具备最高的核心数、缓存容量和主频。

适用于处理极高工作负载的企业,如大规模数据中心和云计算提供商等。

二、AMD EPYC系列AMD EPYC系列是AMD公司推出的一类服务器CPU。

它们提供了与Intel Xeon系列相当的性能,并在某些方面具有优势。

AMD EPYC 系列的主要特点包括可扩展性、内存容量和价格优势。

X86架构与ARM架构区别

X86架构与ARM架构区别X86和ARM是两种主要的CPU架构,而X86架构的CPU是PC服务器行业的老大,ARM架构的CPU则是移动端的老大。

它们在设计理念、性能、功耗和应用领域等方面都有显著的区别。

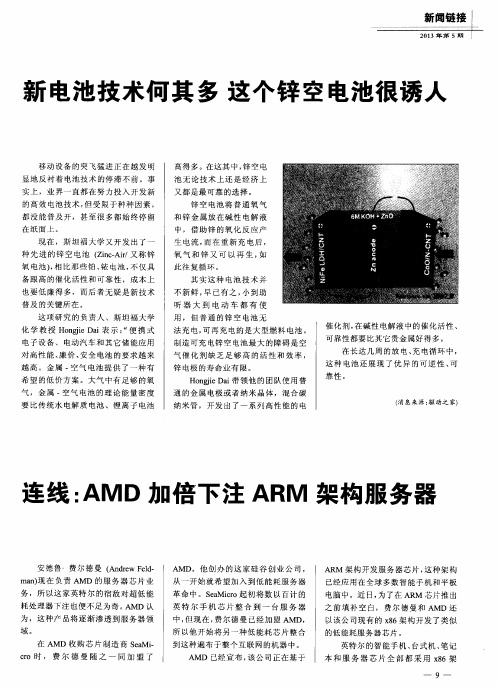

设计理念:X86(The X86 architecture)架构是由Intel开发的微处理器执行的计算机语言指令集,它是一种复杂指令集计算机(CISC)架构,其设计是指在通过提高时钟速度和提高每个时钟周期内的操作数量来增加总体性能。

这意味着它有大量的指令,每个指令可以执行复杂的操作,如内存访问、算术运算等。

ARM架构是由ARM公司开发的32位精简指令集,这是一种精简指令集计算机(RISC)架构,它的设计重点是在限制的功率和热环境下,优化每瓦特的性能。

因此,它的指令集相对较小,每个指令执行的操作相对简单,但是可以通过组合多个指令来完成复杂的操作。

性能和功耗:●X86架构的处理器通常具有较高的时钟频率和更强的计算能力,因此它的功耗也是常年居高不下的。

一般来说,X86架构的处理器,尤其是用于桌面和服务器的处理器,其功耗相对较高,即使是用于笔记本电脑的Intel Core系列处理器,其功耗通常在15W 到45W之间。

●ARM架构的处理器设计更注重能效,即在单位能耗下完成的计算量。

因此,ARM处理器通常在功耗敏感的应用中更受欢迎,如移动设备(手机、平板电脑)、嵌入式系统等。

应用领域:●X86架构由于其强大的计算能力,主要应用在个人电脑、工作站和服务器等领域。

●ARM架构由于其低功耗的特性,主要应用在嵌入式系统设计,低耗电节能,非常适用移动通讯领域。

消费性电子产品,例如可携式装置(PDA、移动电话、多媒体播放器、掌上型电子游戏,和计算机),电脑外设(硬盘、桌上型路由器),甚至导弹的弹载计算机等军用设施。

软件兼容性:●X86架构有着丰富的软件生态,尤其是在桌面操作系统(如Windows、Linux、macOS等)和各类应用软件上,这使得X86成为许多不同应用场景的理想选择。

电脑技术新手必备了解电脑处理器的不同架构

电脑技术新手必备了解电脑处理器的不同架构电脑技术新手必备:了解电脑处理器的不同架构作为如今生活中不可或缺的工具,电脑在各行各业中扮演着重要角色。

然而,对于电脑技术新手而言,了解电脑处理器的不同架构可能是一个较为陌生的概念。

本文将介绍几种常见的电脑处理器架构,以帮助新手更好地理解和选择适合自己需求的处理器。

一、x86架构x86架构是目前最为常见和广泛应用的处理器架构之一。

x86架构最早由英特尔公司和AMD公司开发,并在个人电脑行业广泛使用。

x86架构处理器的特点是具有较高的兼容性和性能。

不同代的x86处理器在性能上有所不同,用户可以根据自己的需求选择适合的型号。

二、ARM架构ARM架构是嵌入式系统和移动设备领域常见的处理器架构。

与x86架构不同,ARM架构处理器通常具有较低的功耗和较小的体积。

这使得ARM架构处理器在移动设备领域应用广泛,例如智能手机和平板电脑。

此外,由于ARM架构在功耗上的优势,近年来开始在个人电脑领域逐渐崭露头角。

三、RISC架构RISC架构,全称为精简指令集计算机(Reduced Instruction Set Computer),它的特点是指令集更精简,执行效率更高。

相比之下,CISC架构(复杂指令集计算机)的指令集更为复杂,但可以通过一条指令完成复杂的操作。

如今,大部分的处理器采用了RISC架构。

四、多核架构随着科技的不断发展,处理器从单核逐渐过渡到多核架构。

多核架构指的是在一个处理器中集成了多个处理核心,可以同时处理多个任务。

多核处理器相较于单核处理器在同时处理多任务时具有更高的效率和性能,能够提升电脑的运行速度和响应能力。

五、集成显卡架构集成显卡架构是一种将显卡整合到处理器中的设计。

传统计算机系统中,显卡和处理器是分开的,而集成显卡架构可以将显卡直接与处理器集成在同一芯片上。

集成显卡架构的优点在于节省了空间和功耗,同时简化了计算机系统的设计。

六、高性能架构高性能架构指的是专为高性能计算而设计的处理器架构。

连线:AMD加倍下注ARM架构服务器

v e l l 提供 的 3 2位 A R M 架构处理器。

虽 然在 数据 中心里 使 用 A R M 架 构 的 实 际案例 不 多 , 但F a c e b o o k和 亚 马 逊

A R M 架构 开发服 务器 芯片 , 这种 架构 已经应 用在全 球多数 智能手 机和平 板 电脑 中。近 日, 为 了在 A R M 芯片 推 出

之前 填补 空 白, 费尔德 曼和 A MD 还

ma n ) 现在负责 A MD 的服 务 器芯 片业 务 ,所 以这家 英特 尔的宿 敌对 超低 能

AMD。他 创 办的 这家硅 谷 创 业公 司 , 从一 开始就希 望加 入到低 能耗 服务 器 革命 中。S e a Mi c r o起初将 数 以百计 的 英特 尔 手 机 芯 片 整 合 到 一 台服 务 器 中, 但现在 , 费尔德 曼 已经加盟 A MD, 所 以他 开始将 另一种 低 能耗芯 片整 合 到这种遍布 于整个 互联 网的机器 中。 AMD 已经宣布 , 该公 司正 在基 于

服 务器芯 片 。据 戴尔服 务器 部 门主管 福 瑞斯 特 ・诺 洛 德 ( F o r r e s t N o r r o d ) 透

都 没 能 普 及 开 ,甚 至 很 多 都 始 终 停 留

在纸面 上 。

池 无 论技术 上还 是 经济 上

又都 是最可靠 的选择 。 锌 空 电 池 将 普 通 氧 气 和 锌 金 属 放 在 碱 性 电解 液 中 , 借 助 锌 的 氧 化 反 应 产

生 电流 , 而在 重新 充 电后 ,

新 电池 技 术何 其 多 这个 锌 空 电池 很诱 人

ARM架构从PC到服务器无处不在

ARM架构从PC到服务器无处不在ARM架构是一种精简指令集计算机(RISC)架构,是目前全球广泛应用于移动设备和嵌入式系统的主流架构。

然而,随着技术的不断演进和发展,ARM架构不仅仅局限于移动设备领域,其应用范围已经拓展到了PC和服务器等领域,无处不在。

一、ARM架构在移动设备中的应用移动设备是ARM架构最早应用和最为广泛的领域之一。

众多的手机、平板电脑、可穿戴设备都采用ARM架构,因为ARM处理器具有低功耗、高性能和高度集成化的特点。

ARM架构的优势使得移动设备可以在有限的电量和空间条件下提供出色的性能和用户体验。

二、ARM架构在PC中的渗透随着处理器的不断升级,ARM架构也逐渐应用到PC领域。

传统上,PC主要使用基于x86架构的处理器。

然而,ARM架构的低功耗、高度集成化和良好的性能表现,使得其成为PC领域的有力竞争者。

因此,现在市场上也有越来越多基于ARM架构的PC产品。

这些产品不仅在能效方面具备优势,而且可以运行多种操作系统,如Windows、Chrome OS等。

三、ARM架构在服务器领域的崛起过去,服务器市场主要由x86架构垄断,但随着云计算和大数据的迅速发展,对于低功耗、高性能的需求日益增加。

ARM架构的低功耗和高度并行化的特点使得其成为服务器领域的新宠。

ARM架构的服务器不仅能够提供良好的性能,而且能够降低数据中心的能源消耗和运营成本。

目前,一些大型云服务提供商已经开始采用ARM架构的服务器来构建自己的数据中心。

四、ARM架构在物联网中的应用物联网是指将普通物体与互联网相连,实现智能化的网络系统。

在物联网中,ARM架构也发挥着重要作用。

物联网设备通常具有体积小、功耗低、成本低的特点,而这些正是ARM架构的长处。

通过搭载ARM架构的芯片,物联网设备可以高效地处理海量数据,并进行智能化的数据分析和决策。

五、ARM架构未来的发展方向ARM架构的未来发展方向可以说是多样化和多领域化。

除了继续在移动设备、PC和服务器领域应用广泛外,ARM架构还将进一步拓展到汽车、工业控制、人工智能等领域。

一篇文章读懂ARM架构(附ARM授权使用方及相关产品目录)

一篇文章读懂ARM架构(附ARM授权使用方及相关产品目录)当今处理器一共有三个最强大的架构,一个是以intel和AMD为代表的x86架构(CISC),另一个是手机、平板处理器所使用的ARM 架构(RISC),最后一个是MIPS架构(RISC)。

其中,x86和ARM 架构是公认的在商业化进程中表现最为优秀的两大架构。

ARM架构过去称作进阶精简指令机器(Advanced RISC Machine),更早时期被称作Acorn RISC Machine,是一位32位精简指令集(RISC)处理器架构,被广泛地使用在嵌入式系统设计中。

ARM属RISC类,走IP授权商业模式,不直接生产IC,采用Fabless方式运营。

在技术上,ARM坚持走与Intel差异化的路线,从而形成了自己庞大的生态系统。

说得直白一点,ARM相当于移动领域的x86,全球有超过95%的移动设备采用ARM设计架构的处理器。

虽然ARM被软银收购了,不过这并不妨碍ARM的发展势头。

凭借着低功耗、低廉价,ARM迅速在移动端杀出了一条血路,其系列家族占了所有32位嵌入式处理器的75%。

今天咱们就来侃一侃伟大的ARM架构:什么是ARM架构?有些人将“指令集体系结构”称为架构,这样就有了ARMv8架构、ARMv7-A架构、ARMv6架构等等,这些都是ARM设计的一些RISC 指令集。

所谓指令集体系结构,就是ARM公司推出的一整套的精简指令,它是计算机最低层的命令,比如说应用程序需要从内存读取数据,那么最后就是通过调用ARM设计的指令是实现内存读取。

不过,也有人将ARM7、ARM9、ARM11以及Cortex等系列内核也称为架构。

譬如,现在ARM主流的架构应该就是智能手机领域的Cortex-A系列架构、工业控制嵌入式领域的Cortex-M系列架构、对稳定性要求高的Cortex-R系列架构等。

值得一提的是,ARM架构在不断演变的同时,仍保持了各个版本之间的兼容性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2月27日在上一篇关于ARM和x86在数据中心应用的较量,已经不是一个新话题了。

我们经常看到功耗、性能数字,以及应用软件和生态系统丰富程度的讨论。

《华为UDS对象存储:ARM自组织硬盘满足CERN功耗》一文里面,笔者曾经提到“功耗和成本正是UDS使用ARM而不是Intel Atom等处理器的原因,据了解华为此前在这一系列的产品中使用过Atom。

”现在我想以大型用户的实际研发和部署进度为切入点,继续谈谈ARM和x86之间各自的优势,以及可能存在的不足。

本文的两个主要论点是:ARM在用于数据中心的SoC方面,目前相对于x86的功能和集成度有一定优势;另外百度与Facebook主导的Open Compute Project(开放计算项目),其存储(服务器)设计的密度和灵活性也有些差别。

那为什么标题中还说两家“异曲同工”呢?先来看看百度的情况。

百度ARM云存储支持纯x86/ARM,或两者混布ChinaByte比特网:关于百度的ARM云存储节点,是否方便透露使用了来自哪家的处理器?系统来自哪个ODM?以我的了解,华为UDS对象存储(云存储)也使用了ARM,在存储节点上每颗ARM (应该是单核)对应一个硬盘,而管理(元数据)节点仍然是x86。

我看到百度也是每个ARM核心对应一个硬盘,因此想了解下整套系统的组成,是否也需要x86的管理节点搭配使用?ARM在这里是什么样的角色(承担着哪些处理工作)?百度:我们与ARM、Marvell 等业界领导者共同设计开发了这款ARM 云存储服务器,并拥有相关专利。

完整的系统架构不方便透露。

可以明确的是,我们的这套系统可以支持纯X86,或者纯ARM,或者两者混布。

点评:我想这个答复还算简单清楚,下面再看看实物照片:百度的ARM云存储服务器,采用在2U机架中6个节点的机箱设计上图下方为抽出的一个ARM节点,在外形尺寸上接近刀片服务器。

我们可以看到4块希捷的3.5英寸硬盘,在右边红圈中的区域,2个带有散热片的芯片中应该有一个是来自Marvell的4核心ARM,附近斜插着一条ECC内存。

而放在机箱上的那个模块则是从机箱后部抽出来,在它两边是一对冗余电源模块。

除了风扇排之外,这里大一点红圈中的3颗芯片应该是用于计算节点与对外万兆以太网(10GbE)接口之间的交换单元,右下方那个小芯片看上去像是ASPEED 的图形和远程管理(BMC)处理器。

可以看出,该2U系统有一块“中板”,负责内部通信和供电连接。

至本文截稿之时,笔者又看到了百度云首席架构师林仕鼎在HPCA大会上的演讲资料——《Application-Driven Datacenter Computing》。

上图中提到了12 HDD/U 的密度,也就是2U 24块硬盘;另外内置网络交换模块也符合我们在上面的判断。

接下来讨论下Facebook的存储设计。

开放计算项目:30、15(45)盘位2U SAS JBOD上图来自Open Compute Project(开放计算项目)的Open Vault Storage Hardware v0.7规格文档,作者自然是Facebook的人了。

这里的Open Vault存储实际上不包含服务器(主机)部分,只是一个JBOD硬盘扩展柜。

关于x86和ARM在Facebook的应用我们会在后面谈及。

在2U的机箱里,上下容纳有2个像这样抽出硬盘“托盘(tray)”,那一共就是30个3.5英寸驱动器。

WD 4TB企业级黑盘(单节点裸容量可达120TB)在该文档的多个照片中出现(如果换作我是西部数据的市场人员,把这些盘白送给Facebook也蛮值得的)。

从横向并排可以放5块硬盘这一点,可以确定Open Rack机柜不是标准的19英寸(682.5mm)宽度。

如下图,它的宽度为538mm。

这张图机架尺寸图来自Open Compute Project的Open Rack Hardware v1.0文档至于硬盘与外界的I/O部分,主要是由前面那块绿色的SAS扩展板(SEB)来实现,上面关键的芯片和一般的JBOD都是用的SAS Expander。

Facebook关键不同的一点是:在机箱前后气流进出的位置,居然不像传统服务器/存储那样安装塑料防尘面板。

正如我们的判断,有知情者表示,他们是在整个数据中心机房的进风口来做防尘处理。

因此如果有人想直接完全照搬Open Compute Project的设计,需要考虑一下。

拿来做参考,或者在其基础上改动当然是可以的。

Open Vault Storage单元后视图从使用的台达风扇等情况来看,这款有可能来自广达的Facebook存储机箱,用料和做工还是不错的。

Open Vault系统结构图这张图,有的读者可能在网上看到过。

这里我们想简单交待一下逻辑关系。

2U机箱中的两个硬盘抽屉,各自通过Drive Plane Board来连接15块硬盘。

这些SAS盘的双端口分别可以连接到A和B两块SAS扩展板(以实现连接路径的高可用,默认是每个tray一个SEB)。

对于LSI Expander SAS2x28扩展器芯片来说,除了15个lane用于硬盘,还设计了一个外部mini-SAS x4连接器向上与主机端通信,以及两个内部mini-SAS x4连接器向下级联Open Vault(也可以是接下来要讲到的另一种JBOD?)。

定制系统的一大好处是,多余用不上的东西可以基本上去掉。

没有前面板的开放机箱,自然也就可以在一个机柜的节点之间使用SFF-8087内部SAS线缆。

这时我又想起了一个问题:“工作人员进出这样的Facebook机房,在着装上是否要放尘不好说,但没准要穿防辐射服。

因为传统服务器/PC面板内侧的金属片是起到EMC电磁保护作用的。

”这张示意图来自Open Compute Project的Torpedo Design Concept Storage Server for Open Rack Hardware v0.3文档,尽管叫做“存储服务器”,其实也是一种JBOD。

Torpedo Design Concept(存储单元)的设计可以说比前面的Open Vault更加简单,空间效率更高。

在2U的机架空间内应该可以容纳3个这样的单元,每个里面安装15块3.5英寸硬盘(一共就是45个驱动器)。

作为 JBOD,它的核心也是SAS扩展器,这里使用了一块标准PCIe尺寸的Intel Expander RES2SV240。

Intel Expander RES2SV240 24端口6Gb/s SAS扩展卡RES2SV240使用的芯片是LSISAS2x24,我们道SAS扩展器芯片并不需要PCIe信号连接,因此下方的金手指只用于+12V供电,与上方的大4pin电源接头选择一个使用即可。

6个SFF-8087 mini-SAS x4连接器中有4个用于连接硬盘,另外2个作为上行或者下行连接(initiator or target)均可。

Torpedo Design Concept Storage Server for Open Rack除了比Open Vault 单位空间内的存储密度更大之外,还有一个重要的不同——就是不具备控制单元(SAS扩展器)的冗余连接,由于这个单点故障,也不太适合通过它再向下级联其它JBOD了。

为什么写到这里还没有涉及ARM和x86?因为在Facebook的“冷数据存储”(Cold Storage)应用中,前面2种JBOD存储扩展柜最初应该都是配合x86服务器节点来工作的,而ARM则是像百度那样的计算/存储一体化设计——这就是后面一页要谈的内容。

ARM服务器板:将JBOD变为存储服务器这张照片来自开放计算项目的ARM Server Motherboard Design for Open Vault Chassis Hardware v0.3文档,其实就是上文中的Open Vault Storage机箱,只不过SAS扩展板的PCB颜色由绿色变成了红色。

这在广达的产品中有专门的含义,当然它不是我们要讨论的重点,基于ARM的服务器主板在这里的作用是:替换机箱中的红色SAS扩展版,将Open Vault JBOD转变为一台存储服务器。

也就是说,上一页中的存储密度计算,是无法直接和百度比较的,因为只包含硬盘而没有CPU。

基于Calxeda ECX-1000 SoC的ARM服务器板结构图Facebook使用的ARM CPU是来自Calxeda的ECX-1000 SoC。

它连接了4GB DDR3 ECC内存,提供4个以太网接口,和5个SATA硬盘接口,后者通过Multiplier (倍增器)将每个SATA接口1转3,这样就满足了连接Open Vault机箱一个tray 上硬盘的需求。

Calxeda EnergyCore ARM SoC结构图上图供大家参考,其中除了4核心的ARM Cortex处理器之外,我们想重点说的是右边的EnergyCore Fabric Switch模块,它能够提供最多5个10GbE(万兆以太网)或者最多6个千兆接口。

当然受限于处理能力和该芯片的定位,5个万兆可能达不到全线速,在 Calxeda推荐的针对均衡系统的优化I/O中,使用了3个带有DMA的10Gbps XAUI以太网界面。

Facebook也提供了4种不同的网络选项:双1GbE、4个CX4、4个QSFP和4个SFP+。

CPU当中集成的只有MAC而没有PHY(物理层),其中双1GbE选项是ECX1000提供SGMII界面到2个1Gbps PHY;而每个QSFP在这里只提供一个10GbE连接(通过QSFP+提供的40GbE在这个接口中不被支持)。

带有4个CX4接口的ARM服务器板,提供最低成本的10GbE网络接口,只是在线缆和连接距离上比较受限。

带有4个SFP+接口的ARM服务器板,提高成本来增加在物理介质类型和线缆方面更多的灵活性,需要10GbE PHY芯片转换XAUI到XFI界面来驱动插入的SFP+模块。

上图所示的主板上使用了2颗Vitesse VSC8488双端口以太网收发器。

SFP+接口可以支持DAC直连铜缆,或者通过安装光纤模块来连接光纤线缆。

百度宣称自主研发的万兆交换机,与服务器的连接采用的就是DAC线缆,这是目前在短距离内(不超过10米)比较成熟且相对廉价的一种万兆连接方式。

至于RJ-45接口的10GBase-T,主流网络厂商的交换机最近这段时间才纷纷推出,再加上功耗方面的问题,尽管被许多人看好但普及尚需时日。

如果说百度和Facebook是在(存储)服务器中使用ARM的话,华为UDS也是将ARM用于存储系统,只是后者的硬件定制化程度更高。

最后一页我们再对它们进行一下总结比较。