MPI_ludepOrder

mpi_reduce的原理

MPI_Reduce是一种集合通信操作,它允许在MPI进程之间进行归约操作。

MPI_Reduce的原理是将每个进程的数据通过指定的操作(如求和、求积、取最大值等)进行归约,最终得到一个结果,并将结果发送到指定的根进程。

具体来说,MPI_Reduce函数的参数包括:

- sendbuf:发送缓冲区,即要进行归约操作的本地数据。

- recvbuf:接收缓冲区,即根进程接收归约结果的缓冲区,其他进程不需要指定该参数。

- count:发送缓冲区中要发送的数据量。

- datatype:数据类型。

- op:归约操作。

- root:根进程。

MPI_Reduce函数首先对sendbuf中的数据进行归约操作,然后将结果发送到根进程(root)。

如果MPI_Reduce被调用的是非根进程,那么它的结果会被忽略。

根进程接

收到所有进程的结果后,将它们再次进行归约,得到最终的结果,并将结果存储在recvbuf中。

MPI_Reduce函数的实现方式可以是基于点对点通信的方法,也可以是基于集合通信的

方法。

其中,基于点对点通信的方法会引入更多的通信开销,而基于集合通信的方法

则能够更好地利用网络带宽和处理器的计算能力,从而提高MPI_Reduce的性能。

mpi allreduce rabenseifner算法详解

mpi allreduce rabenseifner算法详解Rabenseifner算法是一种在MPI中用于实现Allreduce操作的算法,它基于一种称为"recursive doubling"的通信模式。

在Rabenseifner算法中,所有进程被划分为两两一组,并按照rank号进行排序。

然后,每个进程将其本地数据与配对进程的本地数据进行归约操作,然后将结果发送给配对进程。

算法的具体步骤如下:1. 初始化通信数据结构:对于每个进程i,创建两个临时缓冲区sendbuf和recvbuf,它们的大小都为数据的大小乘以进程数,用于存储归约结果和接收其他进程发送的数据。

2. 通过循环算法来进行归约操作:- Loop 1:- 对于每个步长step = 1, 2, 4, ..., p/2(其中p为进程数),进程i使用MPI_Send将发送缓冲区sendbuf中的数据发送给配对进程j = i xor step,并使用MPI_Recv接收配对进程j发送的数据到接收缓冲区recvbuf。

- Loop 2:- 对于每个步长step = p/2, p/4, p/8, ..., 1,进程i使用MPI_Send将接收缓冲区recvbuf中的数据发送给配对进程j = i xor step,并使用MPI_Recv接收配对进程j发送的数据到发送缓冲区sendbuf。

3. 所有进程通过MPI_Allgather将最终的归约结果从缓冲区sendbuf发送到recvbuf中,确保所有进程都能获取到最终的归约结果。

Rabenseifner算法的优点是通信模式简单,且在一些情况下能够有效地提高性能。

然而,该算法的主要缺点是需要较大的缓冲区来存储数据,且在某些情况下可能会导致额外的通信开销。

总的来说,Rabenseifner算法是MPI中用于实现Allreduce操作的一种有效算法,它基于递归双倍通信模式,并通过循环算法来进行数据归约和通信。

openfoam mpi编译

OpenFOAM是一个由英国OpenCFD公司开发的开源计算流体力学软件。

它采用C++编程语言,可以在Linux操作系统上运行。

OpenFOAM具有模块化的结构,使得用户可以方便地定制和扩展其功能。

为了加快计算速度,OpenFOAM还支持MPI并行计算。

MPI(Message Passing Interface)是一种用于编写并行程序的标准。

使用MPI,用户可以在多个处理器上同时执行程序,从而加快计算速度。

在OpenFOAM中,MPI被用于加速求解大规模计算流体力学问题的速度。

在本文中,我们将介绍如何在OpenFOAM中使用MPI进行编译。

一、安装MPI库我们需要安装MPI库。

在Linux系统中,MPI一般通过包管理器进行安装。

以Ubuntu系统为例,可以使用以下命令安装MPI库:sudo apt-get install mpich二、配置MPI环境安装完MPI库后,需要配置MPI环境。

在OpenFOAM中,MPI的配置是通过修改OpenFOAM的环境变量来实现的。

我们需要找到OpenFOAM的安装路径,然后在用户目录下找到.bashrc文件,在其中添加如下行:export WM_MPLIB=SYSTEMOPENMPIexport WM_COMPILE_OPTION=mpi其中,WM_MPLIB指定了使用的MPI库,这里我们使用了OpenMPI;WM_COMPILE_OPTION指定了编译选项为MPI。

三、进行编译配置完成后,就可以进行编译了。

需要清理之前的编译结果,可以使用以下命令进行清理:wclean all进行新的编译:wmake这样就可以在OpenFOAM中使用MPI进行编译了。

四、检查编译结果需要检查编译结果是否正确。

可以通过运行一个包含MPI并行计算的例子来验证编译是否成功。

如果例子能够正确运行并且加速效果明显,说明MPI编译成功。

总结通过本文介绍,我们了解了如何在OpenFOAM中使用MPI进行编译。

提交python程序到集群运行在HPC集群上使用python代码(mpi4py)提交作业

提交python程序到集群运行在HPC集群上使用python代码(mpi4py)提交作业在HPC(高性能计算)集群上使用Python代码(mpi4py)提交作业,是一种常见且高效的方式。

HPC集群是由多台计算机组成的集合,并且集群中的节点可以同时运行多个任务,从而实现高并发和高性能计算。

使用mpi4py库可以在HPC集群上进行并行计算。

mpi4py是Python的一个模块,它对MPI(Message Passing Interface)进行了封装,使得在多台计算机上进行并行计算变得更加容易。

MPI是一种用于并行计算的标准,它定义了一组函数和语法规则,允许在多个计算节点之间进行通信和数据交换。

下面是使用mpi4py提交Python程序到HPC集群运行的一般步骤:1. 编写Python程序:首先,你需要编写一个Python程序,使用mpi4py库进行并行计算。

这个程序应该包含一些需要并行计算的任务,并使用mpi4py提供的函数在不同计算节点之间进行通信。

```bash#!/bin/bash#PBS -l nodes=4:ppn=8#PBS -N myjobcd $PBS_O_WORKDIRmpiexec -np 32 python my_mpi_program.py```在这个提交脚本中,`#PBS`开头的注释行指定了作业的运行参数,例如使用的节点数和每个节点的进程数。

`cd $PBS_O_WORKDIR`用于切换到提交脚本所在的目录。

`mpiexec -np 32 python my_mpi_program.py`是实际运行作业的命令,其中`-np 32`指定了使用32个进程来运行Python 程序。

3.提交作业:使用提交脚本提交作业。

在终端中,你可以使用类似于以下的命令来提交作业:```bashqsub my_submit_script.sh```这个命令将根据提交脚本的规格和资源需求,将作业提交到HPC集群的调度系统中进行排队和调度。

MPI使用操作流程

MPI的编程语言与环境

总结词

MPI的编程语言与环境包括使用C/C、Fortran等编程语言编写MPI程序,以及使用MPI开发环境进行 调试和优化等操作。

详细描述

MPI是一种并行计算编程接口,支持多种编程语言,如C、C和Fortran等。在使用MPI进行并行程序设 计时,需要了解MPI提供的各种函数和库,以及相应的使用方法。同时,还需要掌握如何使用MPI开 发环境进行程序的调试和优化,以确保程序的正确性和性能。

数据分析

MPI还可以用于大规模数据 分析,如处上述领域,MPI还在金 融、医疗、图像处理等领域 得到了应用。

02

MPI的基本原理

MPI的通信方式

点对点通信

MPI允许两个进程之间直接发送和接收消息,实现同步通信。

广播和汇聚通信

MPI也支持广播和汇聚操作,让一个进程发送消息给所有其他进程或让所有进 程聚集到一个进程。

MPI将进一步推动标准化和开放性发展,促进不同厂商 和平台的互操作性和兼容性,以降低使用门槛和成本。

可扩展性和灵活性

MPI将进一步增强可扩展性和灵活性,支持更大规模和 不同类型的并行计算任务,以满足不断增长的计算需求 。

安全性与可靠性

MPI将进一步关注安全性与可靠性,确保并行计算过程 中的数据安全和系统稳定性,以满足重要应用的需求。

3

处理单元与通信单元分离

MPI将处理单元和通信单元分离,让程序员更 加专注于算法实现,而不需要过多考虑通信细 节。

03

MPI的使用方法

MPI的安装与配置

总结词

MPI的安装与配置是使用MPI进行并行计算的第一步 ,包括安装MPI运行时环境、设置环境变量和配置网 络等步骤。

详细描述

mpi_allreduce原理

MPI_Allreduce是Message Passing Interface(MPI)标准中的一个集合通信操作,用于将每个进程中的数据累加(或者执行其他集合操作)并将结果分发给所有进程。

它的原理是实现了分布式计算环境下的全局归约操作。

全局归约是指在一个分布式系统中,将各个节点上的部分数据合并为一个全局的数据。

MPI_Allreduce具体实现如下:

1.数据分发:初始时,每个进程都有一份局部数据。

MPI_Allreduce将这些局部数据

分发到其他进程。

2.局部归约:每个进程在本地执行一个归约操作,将局部数据进行归约。

归约操作可

以是求和、求积、最大值、最小值等,取决于MPI_Allreduce的参数。

3.通信:进程之间通过消息传递机制交换局部结果。

这可以是点对点通信、广播、或

其他通信方式,根据具体实现而定。

4.全局归约:每个进程收到其他进程的局部结果后,再次进行本地的归约操作,将所

有局部结果汇总为一个全局结果。

5.结果分发:最后,每个进程都能够获得全局的结果。

这样,所有进程都拥有了对所

有局部数据进行归约后的最终结果。

MPI_Allreduce的一个重要特性是,它保证了在通信结束时,所有进程都能够获得相同的全局结果。

这是通过MPI 库的集体通信机制来实现的,确保进程之间的同步和一致性。

这个操作的性能和效率可能取决于底层MPI 实现的具体细节,如通信机制、算法选择等。

在实际应用中,了解MPI 库的具体实现对于优化和调优非常重要。

mpi规约

MPI规约1. 什么是MPIMPI(Message Passing Interface)是一种用于并行计算的通信协议和编程模型。

它定义了一组函数、常量和数据类型,用于在并行计算中进行进程间的通信和同步操作。

MPI的目标是提供一个标准化的并行编程接口,使得开发者可以方便地编写并行程序,并在不同的计算平台上进行移植。

MPI最初由一些高性能计算领域的研究人员发起,目前已成为广泛使用的并行编程框架之一。

MPI的设计理念是基于消息传递的分布式内存模型,它允许开发者在多个进程之间进行通信,通过发送和接收消息来共享数据和进行协作计算。

2. MPI的特点MPI具有以下几个特点:2.1 并行性MPI是一种并行编程模型,它允许开发者将计算任务划分为多个子任务,并在多个进程之间进行并行计算。

每个进程都可以独立地执行指定的计算任务,通过消息传递来交换数据和协调计算。

2.2 分布式内存模型MPI采用分布式内存模型,每个进程都拥有独立的内存空间。

进程之间通过消息传递来进行通信,而不需要共享内存。

这种模型使得MPI程序可以在分布式计算环境中运行,充分利用多台计算机的计算资源。

2.3 灵活性MPI提供了丰富的通信和同步操作函数,开发者可以根据具体需求选择合适的函数来实现进程间的通信和同步。

MPI支持点对点通信、广播、规约、散射、聚集等常见的通信模式,同时也支持自定义通信操作。

2.4 可移植性MPI的标准化设计使得开发者可以方便地编写可移植的并行程序。

只要目标计算平台支持MPI标准,就可以在该平台上运行MPI程序,而不需要对程序进行修改。

这种可移植性使得MPI成为并行计算领域的重要工具。

3. MPI的规约操作MPI规约操作(MPI Reduction)是一种在并行计算中常用的操作,用于将多个进程的数据合并为一个结果。

MPI规约操作可以用于求和、求积、求最大值、求最小值等各种聚合计算。

MPI规约操作的基本思想是将多个进程的数据按照指定的操作进行合并,然后将合并结果发送给指定的进程。

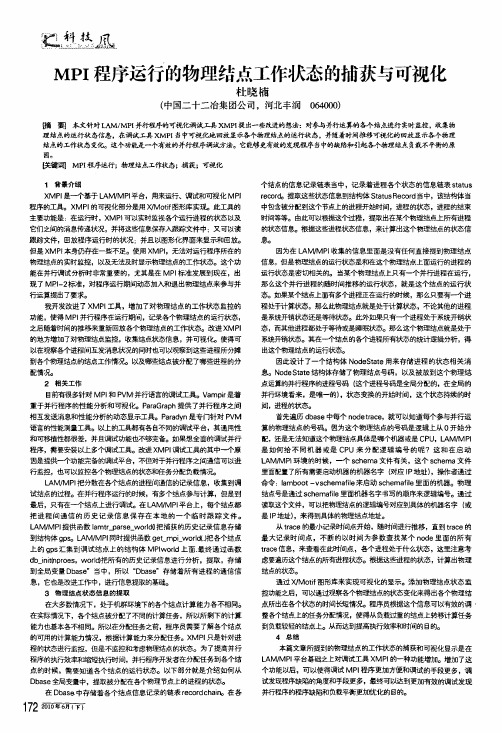

mpi程序运行的物理结点工作状态的捕获与可视化

鼹熊苎凰.M PI程序运行的物理结点工作状态的捕获与可视化杜晓楠(中国二十二冶集团公司,河北丰润064000)f}i毒要j本文针对L A M/M PI并行程序的可视化调试工具xM P I提出一些改进的想法:对参与并行运算的各个结点进行实时监控,收集物理结点的运行状态信息,在调试工具X M Pl当中可视Je.Jg回放显示各个物理结点的运行嗽态,并随着时间推移可视化的回放显示各个物理结点的工作状态变化。

这个功能是一个有效的并行程亭调试方法。

它能够更有效的发现程序当中的缺陷和引起各个物理结点负栽不平衡的原因。

鹾墨看§司M PI程序运行;物理结点工作状态;捕获;可粳化1背景介绍X M PI是—个基于L A M/M PI平台,用来运行、调试和可视化M P l 程序的工具。

X M PI的可视化部分是用X/M ot i f图形库实现。

此工具的主要功能是:在运行时,X M PI可以实时监视各个运行进程的状态以及它们之间的消息传递状况,并将这些信息保存^跟踪文件中:又可以读跟踪文件,回放程序运行时的状况:并且以图形化界面来显示和回放。

但是X M P I本身仍存在一些不足。

使用X M PI,无法对运行程序所在的物理结点的实时监控,以及无法及时显示物理结点的工作状态。

这个功能在并行调试分析时非常重要的,尤其是在M P I标准发展到现在,出现了M P I一2标准,对程序运行期间动态加入和退出物理结点来参与并行运算提出了要求。

我开发改进了X M P I工具,增加了对物理结点的工作状态监控的功能,使得M PI并行程序在运行期间,记录各个物理结点的运行状态,之后随着时间的推移来重新回放各个物理结点的工作状态。

改进X M PI 的地方增加了对物理结点监控,收集结点状态信息,并可视化。

使得可以在观察各个进程间互发消息状况的同时也可以观察到这些进程所分摊到各个物理结点的结点工作情况。

以及哪些结点被分配了哪些进程的分配情况。

高性能计算导论课件-第三章PPT

通信子

通信子的进程数

my rank (正在调用的进程在通信子中的进程号)

单程序多数据流(SPMD)

单程序多数据流(Single Program,Multiple Data, SPMD)

注意,我们刚才编译的是单个程序,而不是为每个进程 编译不同的程序.

0号进程本质上做的事情与其他进程不同. 当其他进程生成和发送消息时,它负责接收消息并 打印出来.

集合通信vs.点对点通信

在通信子中的所有进程都必须调用相同 的集合通信函数。

例如,试图将一个进程中的MPI_Reduce 调用与另一个进程的MPI_Recv调用相匹 配的程序会出错,此时程序会被悬挂或 者崩溃。

集合通信vs.点对点通信

每个进程传递给MPI集合通信函数的参数 必须是“相容的”。

正如我们在第1章中见到的那样,可以使用一 棵像图3-6所描绘的二叉树结构。

树形结构通信

树形结构通信

在图3-6中,一开始1号进程、3号进程、5号进程、7号 进程将它们的值分别发送给0号进程、2号进程、4号进 程、6号进程。然后0号进程、2号进程、4号进程、6号 进程将接收到的值加到它们自己原有的值上,整个过 程重复两次:

通信——发送消息

第四个参数dest指定了要接收消息的进 程的进程号。第五个参数tag是个非负int 型,用于区分看上去完全一样的消息。

通信——发送消息

MPI_Send的最后一个参数是一个通信子 。所有涉及通信的MPI函数都有一个通信 子参数。

数据类型

通信——接收消息

前三个参数指定了用于接收消息的内存:msg_buf_p指 向内存块,buf_size指定了内存块中要存储对象的数量, buf_type说明了对象的类型。后面的三个参数用来识别 消息

mpi用法

MPI(Message Passing Interface)是一种并行计算中的通信协议,用于在多个计算节点之间传递消息以实现数据共享和协同计算。

下面是关于MPI的基本用法的一些关键点:1. 安装MPI库:要使用MPI,您需要安装MPI库,这通常涉及到下载和安装适用于您的操作系统的特定版本的MPI库。

2. 创建进程组:在MPI中,进程组是一个包含多个进程的集合。

您可以使用MPI_Init和MPI_Init_thread等函数来初始化MPI环境并创建进程组。

3. 发送消息:您可以使用MPI_Send函数将消息发送到指定的进程。

发送消息时,您需要指定接收消息的进程的标识符以及要发送的数据。

4. 接收消息:您可以使用MPI_Recv函数从指定的进程接收消息。

接收消息时,您需要指定接收消息的进程的标识符以及用于存储接收数据的缓冲区。

5. 分发数据:您可以使用MPI_Scatter等函数将数据分布到多个进程中,以便在并行计算中共享数据。

6. 收集数据:您可以使用MPI_Gather等函数将多个进程中的数据收集到一个中央位置,以便进行进一步的处理。

7. 使用标签:在发送和接收消息时,您可以使用标签来指定要发送或接收的消息的标识符。

这有助于区分不同的消息并在多个消息之间进行区分。

8. 处理错误:在MPI中,您应该始终处理可能的错误情况,例如发送消息失败或接收消息超时等。

您可以使用MPI_Error_string等函数来获取有关错误的详细信息。

下面是一个简单的MPI程序的示例,用于在两个进程之间发送和接收整数数据:```c#include <mpi.h>#include <stdio.h>int main(int argc, char **argv) {int rank, size;int sendbuf, recvbuf;int host_rank;MPI_Init(&argc, &argv);MPI_Comm_rank(MPI_COMM_WORLD, &rank);MPI_Comm_size(MPI_COMM_WORLD, &size);if (rank == 0) {sendbuf = rank + 1;printf("Sender: sending value %d\n", sendbuf);MPI_Send(&sendbuf, 1, MPI_INT, 1, 0, MPI_COMM_WORLD);} else {MPI_Recv(&recvbuf, 1, MPI_INT, 0, 0, MPI_COMM_WORLD, MPI_STATUS_IGNORE);printf("Receiver: received value %d\n", recvbuf);}MPI_Finalize();return 0;}```在这个示例中,我们使用MPI_Send将整数发送到进程号为1的进程,并使用MPI_Recv从该进程接收整数。

mpirun使用指南

mpirun使用指南mpirun是一个用于在多个计算节点上启动并行作业的命令。

它通常与MPI(消息传递接口)库一起使用,用于在分布式内存系统上运行并行程序。

下面是mpirun的使用指南:1. 基本语法:mpirun [选项] 可执行文件 [参数]2. 选项:-np <进程数>,指定要启动的进程数。

-hosts <主机列表>,指定要在哪些主机上运行进程。

-machinefile <机器文件>,指定包含主机列表的文件。

-npernode <每个节点的进程数>,指定每个节点上要启动的进程数。

-bind-to <选项>,指定进程绑定到处理器的方式,如core、socket等。

3. 示例用法:mpirun -np 4 ./my_program.这将在4个进程上运行可执行文件my_program。

4. 主机列表和机器文件:可以使用-hosts选项或-machinefile选项来指定要在哪些主机上运行进程。

主机列表是一个逗号分隔的主机名列表,而机器文件是一个包含主机名的文件。

5. 进程绑定:使用-bind-to选项可以指定进程绑定到处理器的方式。

这对于优化并行程序的性能非常重要,可以根据处理器的拓扑结构来指定进程的绑定方式。

总之,mpirun是一个强大的工具,可以帮助你在多个计算节点上管理并行作业。

通过灵活运用选项和参数,你可以根据自己的需求来启动并管理并行作业,从而充分发挥分布式计算系统的性能优势。

希望以上信息能够帮助你更好地使用mpirun命令。

MPICHPBS使用指南使用指南使用说明mp使用指南使用说明mp

MPICH&PBS使用指南一、MPI编程 (1)二、MPICH下编译和运行 (3)三、PBS环境下运行 (4)一、MPI编程1、MPI编程函数介绍MPI实际上是一个提供并行程序消息传递机制的函数库,有40多个函数,常用的有6个基本函数。

下面以C语言为例简单介绍这些函数。

(1)MPI_Init函数定义:int MPI_Init(int *argc, char ***argv)功能:用命令行参数初始化MPI环境输入:argc、argv—表示命令行参数,同C语言的main()函数参数格式,argv中包含欲并行运行的进程数输出:返回值—非零/零表示初始化是否成功说明:该函数必须为程序中第一个调用的MPI函数示例:MPI_Init(&argc, &argv); // argc、argv引用的是mian()函数的参数(2)MPI_Finalize函数定义:int MPI_Finalize (void)功能:结束MPI程序的运行,指结束MPI环境的使用输入:无输出:返回值—非零/零表示结束MPI环境是否成功说明:该函数必须为程序中最后一个调用的MPI函数示例:MPI_ Finalize ();(3)MPI_Comm_size函数定义:int MPI_Comm_size(MPI_Comm comm, int *size)功能:得到总进程数输入:comm 通信域句柄(系统默认的为MPI_COMM_WORLD,也可自己定义)输出:size,即通信域comm内包括的进程数整数(4)MPI_Comm_rank函数定义:int MPI_Comm_rank(MPI_Comm comm, int *rank)功能:得到本进程的进程号输入:comm,该进程所在的通信域句柄输出:rank,调用进程在comm中的标识号(5)MPI_Send函数定义:int MPI_Send(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm) 功能:发送消息给特定的进程输入:buf 发送缓冲区的起始地址(可选类型)count 将发送的数据的个数(非负整数)datatype 发送数据的数据类型(句柄)dest 目的进程标识号(整型)tag 消息标志(整型)comm 通信域(句柄)输出:无(6)MPI_Recv函数定义:int MPI_Recv(void* buf, int count, MPI_Datatype datatype, int source, int tag,MPI_Comm comm,MPI_Status *status)功能:接受别的进程发过来的消息输入:count 最多可接收的数据的个数(整型)datatype 接收数据的数据类型(句柄)source 接收数据的来源即发送数据的进程的进程标识号(整型)tag 消息标识与相应的发送操作的表示相匹配相同(整型)comm 本进程和发送进程所在的通信域(句柄)输出:buf 接收缓冲区的起始地址(可选数据类型)status 返回状态(状态类型MPI_Status)2、MPI程序示例MPI程序中必须包含MPI库的头文件,C语言头文件名为mpi.h,FORTRAN语言头文件名为mpif.h。

c++的mpi编程

c++的mpi编程C++的MPI编程是一种用于实现并行计算的方法。

MPI(Message Passing Interface)是一种通信协议,它允许在分布式计算系统中进行高效的消息传递。

在C++中使用MPI编程,可以充分利用多核处理器和集群计算机等并行资源。

以下是C++ MPI编程的基本步骤:1. 配置MPI环境:首先,需要在操作系统上安装MPI库。

安装完成后,可以通过编译器参数或环境变量指定MPI库的路径。

2. 编写程序:编写一个C++程序,使用MPI库提供的函数进行通信和同步。

常见的MPI函数包括发送和接收消息的函数(如MPI_Send 和MPI_Recv),以及用于进程间通信的函数(如MPI_Comm_size和MPI_Comm_rank)。

3. 分配计算资源:在程序中,使用MPI_Comm_size函数获取进程数量,然后根据问题规模和计算资源分配任务。

可以使用MPI_Comm_rank函数获取当前进程的编号。

4. 初始化MPI:在程序开始时,使用MPI_Init函数初始化MPI库。

在程序结束时,使用MPI_Finalize函数关闭MPI库。

5. 编写主函数:在主函数中,使用MPI函数进行进程间通信和数据交换。

例如,可以使用MPI_Send和MPI_Recv函数实现数据的发送和接收。

6. 编写并行区域:在并行区域中,使用MPI_Barrier函数同步进程。

这样可以确保所有进程在执行并行区域之前达到相同的进度。

7. 结束MPI:在程序结束时,使用MPI_Finalize函数关闭MPI库。

以下是一个简单的C++ MPI编程示例:```cpp#include <iostream>#include <mpi.h>int main(int argc, char *argv[]) {// 初始化MPI库MPI_Init(&argc, &argv);// 获取进程数量和当前进程编号int size, rank;MPI_Comm_size(MPI_COMM_WORLD, &size);MPI_Comm_rank(MPI_COMM_WORLD, &rank);// 输出进程信息std::cout << "Hello, I am process " << rank << " of " << size << "." << std::endl;// 结束MPI库MPI_Finalize();return 0;}```这个示例程序将输出各个进程的编号和总进程数。

基于MPI的模拟退火算法求解货郎担问题的并行算法算法

基于MPI的模拟退火算法求解货郎担问题的并行算法算法基于MPI的模拟退火算法求解货郎担问题的并行算法#include "mpi.h"#include <math.h>#include <stdio.h>#include <stdlib.h>#include <time.h>#define maxn 51#define maxnp 100#define maxlp 5000int myrandom(int m){return abs(((clock()*rand()))%m); }float myrandom0_1(){return((float)myrandom(32767)/32767.f); }float dist(int x1,int y1,int x2,int y2) {return sqrt((float)(x1-x2)*(float)(x1-x2)+(float)(y1-y2)*(float)(y1-y2));}void init_d(int x[maxn],int y[maxn],float d[maxn][maxn],intpath[maxn],int n){int i,j;for(i=1;i<=n;i++){path[i]=i;for(j=1;j<=i;j++)1d[i][j]=dist(x[i],y[i],x[j],y[j]);}for(i=1;i<=n;i++)for(j=i;j<=n;j++)d[i][j]=d[j][i]; }void generate(int n,int *r,int *m,int c[7]) { int i;do{c[1]=1+myrandom(n);c[2]=1+myrandom(n-1);if(c[2]==c[1]) c[2]++;i=1+(c[1]-c[2]+n-1)%n;}while(i<3);c[3]=1+(c[1]+n-2)%n;c[4]=1+c[2]%n;c[5]=0;c[6]=0;*r=2+myrandom(2);*m=4;if(*r==3){c[5]=1+(c[2]+myrandom(abs(i-2)))%n;c[6]=1+c[5]%n;*m=6;}}float delta_length(int r,int m,int c0[7],int p[maxn],floatd[maxn][maxn]){2float df;int j,c[7];for(j=1;j<=m;j++)c[j]=p[c0[j]];if(r==2)df=d[c[1]][c[4]]+d[c[2]][c[3]]-d[c[1]][c[3]]-d[c[2]][c[4]];elsedf=d[c[1]][c[5]]+d[c[2]][c[6]]+d[c[3]][c[4]]-d[c[1]][c[3]]-d[c[2]][c[4]]-d[c[5]][c[6]];return(df);}int accept(float t,float df) {return (df<0.0)||((df/t<88.)&&(exp(-df/t)>myrandom0_1())); }void twochain(int n,int c[7],int p[maxn]) {int i,j,u,v,w;i=(1+(c[2]-c[1]+n)%n)/2;for(j=1;j<=i;j++){u=1+(c[1]+j-2)%n;v=1+(c[2]-j+n)%n;w=p[u];p[u]=p[v];p[v]=w;}}void threechain(int n,int c[7],int p[maxn]) {3int p0[maxn],i,j,m1,m2,m3,w;m1=1+(c[2]-c[1]+n)%n;m2=1+(c[3]-c[6]+n)%n;m3=1+(c[5]-c[4]+n)%n;i=1;for(j=1;j<=m1;j++){w=1+(j+c[1]-2)%n;p0[i]=p[w];i++;}for(j=1;j<=m2;j++){w=1+(j+c[6]-2)%n;p0[i]=p[w];i++;}for(j=1;j<=m3;j++){w=1+(j+c[4]-2)%n;p0[i]=p[w];i++;}for(j=1;j<=n;j++)p[j]=p0[j]; }float annealing(int n, int lp, int s, float t, float dt, int p[maxn], float d[maxn][maxn]){float df,f=0;int c[7],k,r,m,a,s0=0;for(k=1;k<n;k++)f=f+d[p[k]][p[k+1]];4f=f+d[p[n]][p[1]];do{a=0;for(k=1;k<=lp;k++){generate(n,&r,&m,c);df=delta_length(r,m,c,p,d);if(accept(t,df)==1){if(r==2) twochain(n,c,p);else threechain(n,c,p);f=f+df;a=1;}}t=t*dt;if(a==0) s0++;else s0=0;}while(s0<s);return(f);}int main(int argc,char **argv) {int np,myid,root=0,no[2],loop,Lp,i,j,k,n,lp,s=0;int x[maxn],y[maxn];int path[maxn],best_path[maxn],npath[maxnp][maxn],keep[maxnp][maxn];float d[maxn][maxn],ngood[maxnp],nlit,nbig,best,good,maybe_min,t,dt;long start_time,end_time;MPI_Comm comm;FILE *f;5//MPI_Init(&argc,&argv);MPI_Comm_size(MPI_COMM_WORLD,&np);MPI_Comm_rank(MPI_COMM_WORLD,&myid);comm=MPI_COMM_WORLD;//x[0]=y[0]=0;if(np<2){printf("\n np must be set >1\n");goto abandon;}if(myid==root){/******************************************************************* */x[1]=3639;y[1]=1315; x[2]=4177;y[2]=2244; x[3]=3712;y[3]=1399;x[4]=3569;y[4]=1438; x[5]=3757;y[5]=1187; x[6]=3493;y[6]=1696;x[7]=3904;y[7]=1289; x[8]=3488;y[8]=1535; x[9]=3791;y[9]=1339;x[10]=3506;y[10]=1221; x[11]=3374;y[11]=1750; x[12]=3376;y[12]=1306;x[13]=3237;y[13]=1764; x[14]=3326;y[14]=1556; x[15]=3188;y[15]=1881;x[16]=3089;y[16]=1251; x[17]=3258;y[17]= 911; x[18]=3814;y[18]= 261;x[19]=3238;y[19]=1229; x[20]=3646;y[20]= 234; x[21]=3583;y[21]= 864;x[22]=4172;y[22]=1125; x[23]=4089;y[23]=1387; x[24]=4297;y[24]=1218;x[25]=4020;y[25]=1142; x[26]=4196;y[26]=1044; x[27]=4116;y[27]=1187;6x[28]=4095;y[28]= 626; x[29]=4312;y[29]= 790; x[30]=4252;y[30]= 882;x[31]=4403;y[31]=1022; x[32]=4685;y[32]= 830; x[33]=4386;y[33]= 570;x[34]=4361;y[34]= 73; x[35]=4720;y[35]= 557; x[36]=4643;y[36]= 404;x[37]=4634;y[37]= 654; x[38]=4153;y[38]= 426; x[39]=4784;y[39]= 279;x[40]=2846;y[40]=1951; x[42]=2831;y[42]=2099; x[42]=3007;y[42]=1970;x[43]=3054;y[43]=1710; x[44]=3086;y[44]=1516; x[45]=1828;y[45]=1210;x[46]=2562;y[46]=1756; x[47]=2716;y[47]=1924; x[48]=2061;y[48]=1277;x[49]=2291;y[49]=1403; x[50]=2751;y[50]=1559;/******************************************************************* */n=50;init_d(x,y,d,path,n);/*printf("\ninput number of loop = (<=5000)");scanf("%d",&Lp);*/Lp=500;start_time=clock();//time(&s);}MPI_Bcast(&n,1,MPI_INT,root,comm);MPI_Bcast(&Lp,1,MPI_INT,root,comm);MPI_Bcast(d,maxn*maxn,MPI_FLOAT,root,comm);MPI_Bcast(path,maxn,MPI_INT,root,comm);for(loop=0;loop<Lp;loop++){lp=20000;s=1;t=10.0f;dt=0.95f;7maybe_min=annealing(n,lp,s,t,dt,path,d);MPI_Gather(&maybe_min,1,MPI_FLOAT,ngood,1,MPI_FLOAT,root,comm); MPI_Gather(path,maxn,MPI_INT,npath,maxn,MPI_INT,root,comm); MPI_Bcast(npath,np*maxn,MPI_INT,root,comm);if(myid==root){if(loop==0) best=maybe_min;nlit=maybe_min;nbig=nlit;i=0;j=0;for(k=1;k<np;k++){if(ngood[k]<nlit){nlit=ngood[k];i=k;}if(ngood[k]>nbig){nbig=ngood[k];j=k;}}no[0]=i;no[1]=j;keep[loop][0]=(int)nlit; for(k=1;k<=n;k++)keep[loop][k]=path[k]; if(best>nlit){best=nlit;8for(k=0;k<=n;k++)best_path[k]=keep[loop][k];}printf("\n lp=%4d;best:%9.2f i=%2d: %9.2f(min) j=%2d: %9.2f(max)", loop,best, i,ngood[i],j,ngood[j]);}MPI_Bcast(no,2,MPI_INT,root,comm);if(myid<=np/3) k=no[0];else k=no[1];for(i=0;i<maxn;i++)path[i]=npath[k][i];MPI_Barrier(comm);}if(myid==root){end_time=clock();//time(&s);t=(float)((end_time-start_time)/1000/1000);printf("\nTSP-%d, time=%d best=%10.2f\n", n, (int)t, best);}abandon: MPI_Finalize();return 0;}9。

并行计算中的MPI编程技巧及实践经验总结

并行计算中的MPI编程技巧及实践经验总结在并行计算中,MPI(Message Passing Interface)已成为一种广泛应用的并行编程模型。

MPI是一套并行通信协议和编程规范的集合,它可以在分布式内存系统中进行多个进程之间的通信和数据传输。

本文将总结一些MPI编程的技巧和实践经验,帮助开发人员更好地理解和应用MPI,以提高并行计算的效率和性能。

首先,了解MPI的基本概念和术语是理解和应用MPI编程的关键。

MPI中最重要的概念是通信域(communicator)。

通信域是一组进程的集合,这些进程可以相互通信。

在MPI中,有一个默认的通信域MPI_COMM_WORLD,它包含所有参与并行计算的进程。

另外,还有一些常用的通信域操作函数,例如MPI_Comm_size和MPI_Comm_rank函数,用于获取通信域中的进程数和当前进程的标识。

熟悉这些概念和函数,有助于编写可靠和高效的MPI程序。

其次,合理划分任务和数据,对于并行计算的效率至关重要。

在MPI中,一种常见的并行模式是将任务划分为多个子任务,并由不同进程来处理。

例如,可以将一个大规模的计算问题分解为多个小规模的子问题,由多个进程并行计算,最后将结果汇总。

另外,还可以将数据划分为多个块,分配给不同的进程进行处理。

合理的任务和数据划分可以最大程度地利用并行计算资源,提高计算效率和性能。

在MPI编程中,注意避免过多的通信操作,尽量减少进程间的通信次数和数据传输量。

频繁的通信操作会增加通信开销,降低程序的效率。

因此,可以通过合并通信操作,减少数据传输的次数。

例如,可以将多个小消息合并为一个大消息,进行一次批量传输,而不是每个小消息都单独进行传输。

此外,还可以使用非阻塞通信函数,例如MPI_Isend和MPI_Irecv函数,来实现异步通信,减少通信的等待时间。

另一个需要注意的是并行计算中的负载均衡。

负载均衡是指保证多个进程之间的工作量大致相等,避免某些进程一直处于空闲状态,导致计算效率低下。

mpi reduce用法 -回复

mpi reduce用法-回复MPI(Message Passing Interface)是一种在并行计算中广泛使用的通信接口标准,它可以在不同的计算节点之间进行消息的发送和接收。

MPI Reduce是MPI中的一个重要函数,可以用于将一个分布在多个计算节点上的值聚合成单个结果。

MPI Reduce函数的用法相对简单,其基本语法如下:cMPI_Reduce(void* sendbuf, void* recvbuf, int count, MPI_Datatype datatype, MPI_Op op, int root, MPI_Comm comm)其中,参数说明如下:- `sendbuf`:指向发送缓冲区的指针,即每个计算节点上的值。

- `recvbuf`:指向接收缓冲区的指针,用于存储聚合结果的计算节点。

- `count`:发送数据的元素数量。

- `datatype`:发送数据元素的类型。

- `op`:聚合操作的类型,例如求和、求积、求最大值等。

- `root`:目标节点的标识符,即接收聚合结果的计算节点。

- `comm`:通信子,用于定义计算节点间的通信域。

MPI Reduce函数的执行过程可以分为以下几个步骤:1. 首先,在计算节点上定义好发送缓冲区sendbuf和接收缓冲区recvbuf。

2. 调用MPI Reduce函数,将数据从各个计算节点发送到目标节点。

3. 目标节点将接收到的数据按照指定的聚合操作进行处理。

4. 处理结果存储在目标节点的接收缓冲区recvbuf中。

下面通过一个具体的例子来说明MPI Reduce的用法。

假设有一个并行计算程序,需要求解一个向量中的最大值。

我们通过MPI Reduce函数来完成这个任务,其中向量的元素分布在不同的计算节点上。

c#include <stdio.h>#include <stdlib.h>#include <mpi.h>int main(int argc, char argv) {int rank, size;int local_max, global_max;int* vector;int N = 100; 向量元素的个数MPI_Init(&argc, &argv);MPI_Comm_rank(MPI_COMM_WORLD, &rank); MPI_Comm_size(MPI_COMM_WORLD, &size);初始化向量vector = (int*)malloc(N * sizeof(int));for (int i = 0; i < N; i++) {vector[i] = rand() 100;}每个计算节点计算局部最大值local_max = vector[0];for (int i = 1; i < N / size; i++) {if (vector[i] > local_max) {local_max = vector[i];}}聚合所有计算节点的最大值MPI_Reduce(&local_max, &global_max, 1, MPI_INT, MPI_MAX, 0, MPI_COMM_WORLD);if (rank == 0) {printf("Global Max: d\n", global_max);}free(vector);MPI_Finalize();return 0;}在上述例子中,每个计算节点生成一个随机的向量,并计算局部最大值。

fortran中的mpi_gather的用法

fortran中的mpi_gather的用法MPI_Gather是Fortran中的一种MPI函数,用于将所有进程的数据收集到一个进程中。

具体用法如下:MPI_Gather(sendbuf, sendcount, sendtype, recvbuf, recvcount, recvtype, root, comm, ierror)其中,sendbuf表示发送缓冲区的起始地址,sendcount表示每个进程要发送的元素数,sendtype表示发送元素的类型。

recvbuf表示接收缓冲区的起始地址,recvcount表示每个进程要接收的元素数,recvtype表示接收元素的类型。

root表示接收缓冲区所在的进程的编号,comm表示通信子,ierror表示错误码。

使用MPI_Gather时,每个进程都会向root进程发送数据。

root 进程会将所有数据收集到recvbuf中。

由于每个进程发送的元素数可能不同,因此在接收时,需要指定每个进程要接收的元素数(recvcount)。

如果接收缓冲区的大小不足以容纳所有数据,则可能会发生错误。

下面是一个简单的例子,展示了MPI_Gather的用法:program maininclude 'mpif.h'integer :: rank, size, ierrorinteger, allocatable :: sendbuf(:), recvbuf(:)integer :: sendcount, recvcount, root, icall MPI_Init(ierror)call MPI_Comm_rank(MPI_COMM_WORLD, rank, ierror)call MPI_Comm_size(MPI_COMM_WORLD, size, ierror)sendcount = 1recvcount = sizeroot = 0allocate(sendbuf(sendcount))allocate(recvbuf(recvcount))sendbuf = rankcall MPI_Gather(sendbuf, sendcount, MPI_INTEGER, &recvbuf, recvcount, MPI_INTEGER, root, &MPI_COMM_WORLD, ierror)if (rank == root) thendo i = 1, sizewrite(*,*) recvbuf(i)end doend ifdeallocate(sendbuf)deallocate(recvbuf)call MPI_Finalize(ierror)end program在上面的例子中,每个进程发送一个整数(即其rank),root进程将所有整数收集到一个数组中,并输出。

mpirun参数

mpirun参数mpirun是一种对于大规模计算的并行编程非常重要的工具,它可以在不同的计算节点上运行并行程序来提高计算效率,并且可以通过不同的参数设置来满足不同的需求。

在本文中,我们将介绍一些mpirun参数的基本用法和一些高级用法,帮助用户更好地使用mpirun工具。

1.基本用法mpirun的基本用法非常简单,可以直接在终端中输入mpirun和并行程序的命令行参数即可,例如:mpirun -n 4 ./test其中,-n参数表示要启动的进程数量,./test表示并行程序的可执行文件名。

通过这样的命令,mpirun将在4个进程上同时运行test程序,实现并行计算。

除此之外,mpirun还支持一些其他的基本参数,例如:-h或--help:查看mpirun的帮助文档。

-bind-to none:不进行绑定,允许进程在任何CPU上运行。

-bind-to core:将进程绑定到物理CPU的核上。

-bind-to socket:将进程绑定到物理CPU的socket 上。

2.高级用法除了基本用法之外,mpirun还支持一些高级特性,以下是一些常用的高级参数:2.1 np参数-n或--np参数可以指定要启动的进程数量,例如:mpirun -np 8 ./test这个命令将在8个进程上同时运行test程序。

2.2 host参数- host参数可以指定要在哪些主机上运行进程。

例如:mpirun -n 4 -host host1,host2 ./test这个命令将在host1和host2上启动4个进程来运行test程序。

2.3 map-by参数- map-by参数可以指定进程的分配方式。

例如:mpirun -np 4 -map-by slot ./test这个命令将按照CPU的数量来分配进程。

2.4 bind-to参数- bind-to参数可以指定进程的绑定方式,例如:mpirun -np 4 -bind-to core -map-by slot ./test 这个命令将把进程绑定到CPU核心上。

mpi reduce用法

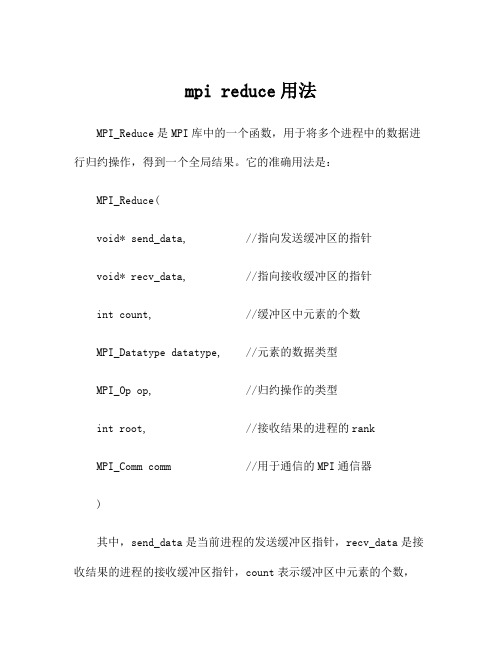

mpi reduce用法MPI_Reduce是MPI库中的一个函数,用于将多个进程中的数据进行归约操作,得到一个全局结果。

它的准确用法是:MPI_Reduce(void* send_data, //指向发送缓冲区的指针void* recv_data, //指向接收缓冲区的指针int count, //缓冲区中元素的个数MPI_Datatype datatype, //元素的数据类型MPI_Op op, //归约操作的类型int root, //接收结果的进程的rankMPI_Comm comm //用于通信的MPI通信器)其中,send_data是当前进程的发送缓冲区指针,recv_data是接收结果的进程的接收缓冲区指针,count表示缓冲区中元素的个数,datatype表示元素的数据类型,op表示归约操作的类型,root表示接收结果的进程的rank,comm表示用于通信的MPI通信器。

适当拓展:-归约操作的类型可以是预定义的MPI_Op类型,如MPI_SUM、MPI_MIN、MPI_MAX等,也可以是用户自定义的操作。

-对于MPI_Reduce的调用,所有进程都必须参与调用,即使某些进程不需要发送数据或接收结果,需要将send_data和recv_data设置为NULL。

- MPI_Reduce的结果将被发送到指定的root进程,root进程的接收缓冲区中将包含所有进程归约操作的结果。

- MPI_Reduce操作是一种全局归约操作,因此它需要在所有进程中调用,并且每个进程的send_data中包含的数据都会被归约操作影响。

- MPI_Reduce函数的调用一般是阻塞的,直到所有进程完成归约操作后才会继续执行后续代码。

mpi reduce用法

mpi reduce用法MPI Reduce是一种在并行计算中经常使用的通信操作,它允许从多个进程中收集数据并将其合并为一个进程中的结果。

MPI Reduce操作可用于执行各种归约操作,如求和、求最大/最小值、计数等。

在MPI编程中,Reduce操作需要指定一个通信域(通常是MPI_COMM_WORLD),以及需要归约的数据、结果存储的进程以及归约操作的类型。

MPI Reduce可用于整型、浮点型和自定义数据类型等不同类型的数据。

使用MPI Reduce的步骤如下:1. 各个进程首先需要初始化MPI环境,并确定自己的进程ID 和总进程数量。

2. 每个进程准备自己的数据。

3. 调用MPI Reduce函数,指定归约操作的类型、数据、结果存储的进程和通信域。

4. 在结果存储的进程中,收集来自其他进程的数据,并执行归约操作。

结果将存储在该进程的内存中。

5. 释放MPI资源,并结束程序。

例如,下面是使用MPI Reduce进行整型求和的示例代码:```c#include <stdio.h>#include <mpi.h>int main(int argc, char** argv) {int rank, size;int my_data, sum;MPI_Init(&argc, &argv);MPI_Comm_rank(MPI_COMM_WORLD, &rank);MPI_Comm_size(MPI_COMM_WORLD, &size);// 每个进程准备自己的数据my_data = rank + 1;// 调用MPI Reduce函数,将各个进程的my_data求和到进程0中MPI_Reduce(&my_data, &sum, 1, MPI_INT, MPI_SUM, 0,MPI_COMM_WORLD);if (rank == 0) {printf("Sum: %d\n", sum);}MPI_Finalize();return 0;}```在上述示例中,每个进程准备自己的数据,此处为rank + 1。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MPI_Recv(&a(i,0),M,MPI_FLOAT,0,i+1,MPI_COMM_WORLD,&status);

else

for(i=0;i<m;i++)

MPI_Send(&A(i,0),M,MPI_FLOAT,i1,i2,MPI_COMM_WORLD);

}

}

}//my_rank = 0

else//my_rank != 0

{

if (left != 0)

if (my_rank < left)

if(left == 0)

v = j*m + i;

else if (j < left)

v = j * m + i;

else

v = left * m + (j - left)*mm + i;

if (my_rank>j)

for(k=0;k<mm;k++)

{

a(k,v)=a(k,v)/f[v];

for(w=v+1;w<M;w++)

a(k,w)=a(k,w)-f[w]*a(k,v);

}

}//m==1

}//left !=0

else//left == 0

{

i2 = 0;

for(i=m;i< M;i++)

{

i1=i/m;

i2=i2%m+1;

#define floatsize sizeof(float)

#define intsize sizeof(int)

int M,N;

int m;

int mm;

int mmm;

float *A;

int my_rank;

int p;

MPI_Status status;

int left=0;

MPI_Bcast(f,M,MPI_FLOAT,j,MPI_COMM_WORLD);

}

/*编号等于my_rank的进程利用主行对其第i+1,…,m-1行数据做行变换*/

if (my_rank==j)

for(k=i+1;k<mm;k++)

{

a(k,v)=a(k,v)/f[v];

for(w=v+1;w<M;w++)

a(k,w)=a(k,w)-f[w]*a(k,v);

}

/*编号大于my_rank的进程利用主行对其各行数据做行变换*/

{

for(i = m;i < M;i++)

{

i1=i;

i2=1;

MPI_Send(&A(i,0),M,MPI_FLOAT,i1,i2,MPI_COMM_WORLD);

if(left != 0)

{

i2 = 0;

for(i=m;i< left * m;i++)

{

i1=i/m;

i2=i2%m+1;

MPI_Send(&A(i,0),M,MPI_FLOAT,i1,i2,MPI_COMM_WORLD);

i2=i2%(m-1)+1;

MPI_Send(&A(i,0),M,MPI_FLOAT,i1,i2,MPI_COMM_WORLD);

}

}//m!=1

else//m==1

for(i=0;i<m;i++)

MPI_Recv(&a(i,0),M,MPI_FLOAT,0,i+1,MPI_COMM_WORLD,&status);

else

{

int i,j,k,my_rank,group_size;

int i1,i2;

int v,w;

float *a,*f,*l,*u;

FILE *fdA;

double time1,time2;

MPI_Init(&argc,&argv);

for (k=v;k<M;k++)

f[k]=a(i,k);

MPI_Bcast(f,M,MPI_FLOAT,my_rank,MPI_COMM_WORLD);

}

else

{

if(left == 0)

v = j*m + i;

else if (j < left)

v = j * m + i;

else

v = left * m + (j - left)*mm + i;

void fatal(char *message)

{

printf("%s\n",message);

exit(1);

}

void Environment_Finalize(float *a,float *f)

{

free(a);

free(f);

}

int main(int argc, char **argv)

if (my_rank==0)

{

l=(float*)malloc(floatsize*M*M);

u=(float*)malloc(floatsize*M*M);

}

/*0号进程采用顺序行划分将矩阵A划分为大小m*M的p块子矩阵,依次发送给1至p-1号进程*/

}

/*分配至各进程的子矩阵大小为m*M*/

a=(float*)malloc(floatsize*m*M);

/*各进程为主行元素建立发送和接收缓冲区*/

f=(float*)malloc(floatsize*M);

/*0号进程为l和u矩阵分配内存,以分离出经过变换后的A矩阵中的l和u矩阵*/

}

}

}

/*0号进程从其余各进程中接收子矩阵a,得到经过变换的矩阵A*/

if (my_rank==0)

{

for(i=0;i<m;i++)

for(j=0;j<M;j++)

A(i,j)=a(i,j);

}

if (my_rank!=0)

{

if (left == 0)

mm = m;

else if (my_rank < left)

mm = m;

else if(j < left)

mm = m;

else

mm = m - 1;

for(i=0; i<mm; i++)

{

/*j号进程负责广播主行元素*/

if (my_rank==j)

{

//v=i*p+j;

exit(0);

}

A=(float *)malloc(floatsize*M*M);

for(i = 0; i < M; i ++)

for(j = 0; j < M; j ++)

fscanf(fdA, "%f", A+i*M+j);

fclose(fdA);

}

/*0号进程将M广播给所有进程*/

MPI_Bcast(&M,1,MPI_INT,0,MPI_COMM_WORLD);

m=M/p;

if (M%p!=0) Leabharlann m++;

left = M%p;

}

if (m != 1)

{

i2 = 0;

for(i = left * m; i < M; i++)

{

i1=left + (I – left*m) / (m - 1);

if (a==NULL) fatal("allocate error\n");

if (my_rank==0)

{

for(i=0;i<m;i++)

for(j=0;j<M;j++)

a(i,j)=A(i,j);

#include "stdio.h"

#include "stdlib.h"

#include "mpi.h"

#define a(x,y) a[x*M+y]

/*A为M*M矩阵*/

#define A(x,y) A[x*M+y]

#define l(x,y) l[x*M+y]

#define u(x,y) u[x*M+y]

MPI_Comm_size(MPI_COMM_WORLD,&group_size);

MPI_Comm_rank(MPI_COMM_WORLD,&my_rank);

p=group_size;

time1=MPI_Wtime();

if (my_rank==0)

MPI_Recv(&a(i,0),M,MPI_FLOAT,0,i+1,MPI_COMM_WORLD,&status);

}

for(j=0;j<p;j++){

if (left == 0)