连续动作分割综述

三大有机物鉴定实验综述

(三)生物组织中蛋白质的鉴定

1 实验原理

在碱性溶液(NaOH)中,双缩脲(H2NOC-NHCONH2)能与Cu 2+作用,形成紫色的络合物,这个 反应叫做双缩脲反应。

由于蛋白质分子中含有很多与双缩脲结构相似 的肽键,因此,蛋白质都可与双缩脲试剂发生颜色 反应。

2

实验目的 初步掌握鉴定生物组织中蛋白质的基本方法。

苏丹Ⅲ溶液:将0.1g苏丹Ⅲ干粉溶于100mL体积 分数为95%的酒精溶液中,待全部溶解后即成。

5

实验步骤

(1)切片制作

①去掉花生种皮

②用左手的三个手指夹住花生的一片子叶, 使花生子叶高于手指之上(为什么?)。右 手持刀片,将子叶削去一层,形成平面。 ③刀口向内,与花生断面平行,以均匀的动作, 自左前方向右后方快速拉刀,滑行切片(注意 要整个臂部用力,而不要腕部用力。)如此连 续动作,切下一些薄片。

4

试剂配制 甲液(0.1g/mL的氢氧化钠溶液)

本尼迪特试剂

乙液(0.05g/mL的硫酸铜溶液)

甲、乙试剂千万要分开放,不可混 合。在实验过程中,将4-5滴乙液 滴入2mL甲液中现混现用!!!

5

实验步骤

(1)制备组织样液(教师制备) (2)鉴定样液

先在试管中加入 2mL组织样液

注意观察整个实验 过程中,溶液颜色 的变化!!!

3、将三个鉴定实验与其使用的试剂和结果之间用直线连 接起来。

可溶性还原糖 斐林 剂 紫 色

脂

蛋 白

肪

质

双缩脲试剂

苏 丹 Ⅲ

橘黄色

砖红色

NH2 | 4 、实验可知,在尿素(O=C)溶液中加入双缩脲试剂,也能产 生紫色反应。依据蛋 | 白质鉴定实验原理说明之。 NH2

如何在强化学习算法中处理连续动作空间问题(Ⅱ)

强化学习算法是一种通过试错来学习和改进决策的机器学习方法。

在强化学习中,智能体通过与环境的交互,根据不同的状态和行为来获得奖励或惩罚,从而逐步学习如何做出最优的决策。

在传统的强化学习算法中,通常处理的是离散动作空间,即智能体可以选择的行为是有限的。

然而,在许多实际问题中,行为的选择是连续的,这就给强化学习算法带来了挑战。

如何在强化学习算法中处理连续动作空间问题成为了一个热门的研究方向。

在处理连续动作空间问题时,一个常见的方法是使用函数逼近器来近似值函数或策略函数。

函数逼近器可以将状态和行为的组合映射到一个连续的值域中,从而可以更好地处理连续动作空间问题。

常见的函数逼近器包括线性函数、神经网络和高斯过程等。

其中,神经网络由于其强大的表达能力和良好的泛化能力,在处理连续动作空间问题时得到了广泛的应用。

另一个处理连续动作空间问题的方法是使用策略梯度方法。

策略梯度方法是一类直接学习策略函数的强化学习方法,它通过最大化累积奖励来更新策略函数的参数。

在处理连续动作空间问题时,策略梯度方法可以直接对策略函数进行参数化,从而可以更好地处理连续动作空间问题。

常见的策略梯度方法包括REINFORCE算法、TRPO算法和PPO算法等。

这些算法在处理连续动作空间问题时都取得了一定的成效。

除了以上提到的方法外,还有一些其他的技术可以用于处理连续动作空间问题。

例如,可以将连续动作空间离散化为有限的动作空间,然后使用传统的强化学习算法来处理。

这种方法虽然简单,但在一些情况下也可以取得不错的效果。

另外,还可以使用演员-评论家(Actor-Critic)框架来处理连续动作空间问题。

演员-评论家框架将策略函数和值函数结合起来训练,可以更好地处理连续动作空间问题。

在处理连续动作空间问题时,还需要考虑探索与利用的平衡。

在连续动作空间中,由于行为的选择是连续的,因此需要采取一些特殊的方法来保证智能体能够充分地探索环境。

一种常见的方法是使用探索噪声来引入随机性,从而使智能体能够更好地探索环境。

剪辑

比如:一个女子下班回家。 5个镜头:

古典剪辑

古典剪辑比连续性剪辑更进 一步。其剪辑目的在于加强 戏剧性,强调情感而不是简 单的连续性而已。 格里菲斯用特写造成戏剧效 果,是用特写做心理效果第 一人。 古典剪辑的插入镜头较多, 它打破空间的统一性,引导 观众注意细节,较具感性。

《机械舞蹈》(机械芭蕾)1923-1924

《战舰波将军号》1925:石狮子

运用

用于象征

用于表现同一时间

用于省略 趋向于表现:《情书》《十面埋伏》《持摄影机 的人》 趋向于叙事

趋向游戏

组合的并列镜头

经典的并列镜头——构成并列的单位是镜头

组合的并列镜头——形成并列的元素或单位是一组 镜头。在这一组镜头的内部,并不存在并列的形 式,而是普通的叙事——有因果和逻辑关系的叙事。 《尼罗河上的惨案》1978:波洛询问

Master shot, reaction shot, two-shot

格里菲斯《一个国家 的诞生》 李安《理智与情感》

苏联蒙太奇与形式主义传统

敖德萨阶梯片段是默片史上剪辑的经典。爱森斯 坦充分运用其撞击蒙太奇理论,使每个镜头的光 亮-黑暗、直线-横线、远景-特写、长拍-短拍、静 止-运动,成为强烈的对比。

抽象剪辑

形式主义

《机械芭蕾》1924

并列镜头

电影画面的组合就如同电流在电路中的状态,呈 “并列”(并联)和“序列”(串联)两种基本形 态。

什么是并列镜头

在同一主题下具有某些相似之处,且彼此没有逻 辑上的呈递或因果关系的一组镜头。

主题内容的同一性 镜头形式的相似性 因果逻辑关系的缺失

好莱坞电影自然流畅的连续剪辑举例

好莱坞电影自然流畅的连续剪辑举例【最好的视角】

好莱坞电影自然流畅的连续让我们处于旁观者位置,强化我们对影像的感知并使我们精力高度集中。

只要好莱坞电影一开始,无论从生理上,还是内心感受上,实际上都成了面对银幕的隐性观众。

好莱坞的最终目的是让我们能目不转睛地观看那儿发生的一切。

作为回报,好莱坞为观众提供了一个偷窥和偷听银幕故事的最佳观察点。

好莱坞的空间组织方式通常被称为连贯性机制,通过镜头运动,动作在一个平滑连贯的空间中展开,摄影机相对自由地在空间中运动,观众很少注意摄影机作为中介物的存在。

几乎没有镜头长到让观众意识到摄影机在银幕空间的位置,每个镜头都仿佛被故事中逐渐展开的事件所俘虏,摄影机的画框总是会跟随影片人物的运动而产生相应的变化。

摄影机的运动具有连贯性和透明性。

观众之所以感到安全,是因为他们极少意识到剪辑的存在,剪辑的地方刚好是信息最不受观众注意的地方。

好莱坞的空间组织模式是相当人性化的,它为观众提供了最佳视角。

这种对空间加以组织的模式也使剪辑尽可能透明和易于理解,有助于为观众提供安全空间。

24式太极拳野马分鬃的运动生物力学文献综述

中图分类号:g852.1 文献标识:a 文章编号:1009-9328(2016)09-000-01摘要武术是中华民族传统文化的优秀代表,它伴随着中国五千年的文明一直走到了今天。

作为中华武术之精髓的太极拳,是我们祖先在长期生活实践中创造和逐步发展起来的一种具有技击效果和抗衰老及保健作用的运动方式。

笔者在自身武术训练经验的基础上,通过查阅大批量的文献综述,对24式太极拳野马分鬃的动作技术要领进行综述。

关键词 24式太极拳右野马分鬃动作变化规律生物力学太极拳野马分鬃的完整动作过程是从动作速度的变化、身体重心变化和下肢的移动变化。

为了方便叙述,我们将野马分鬃的完整动作分为坐腿转身分手阶段、抱手收脚阶段、提膝上步出脚合手阶段、弓步分手阶段和右边抠脚坐腿转身四个部分进行探讨。

以上是右野马分鬃动作,左侧动作同理。

一、坐腿转身分手髋关节在太极拳下肢运动中处于重要地位,而髋关节角度变化,可以在一定程度上反映运动中髋关节运动是否合理。

左髋关节的角度增加幅度很大,说明不能很好的控制髋关节,这必然导致在下阶段的转体时,为了保持稳定而左髋关节角度剧减。

髋关节在增加到一定角度时,从收脚开始基本保持在这一水平,才能够更好的控制左髋关节,在旋转时能够继续保持松腰、坐胯。

与以上持有相同观点的学者,如孙绪生、胡影、李玉华[1](2004年),孙绪生(2002年),孙绪生(2006年)所著简化太极拳运动中的位移和重心变化。

因此,笔者认为,膝关节角度减小是太极拳增进膝关节稳定性的主要运动学机理。

太极拳运动中双膝关节角度变化无明显差异,说明太极拳锻炼左、右膝的效果相似。

二、抱手收脚阶段此阶段包括动作的速度,在单个动作中它是遵循动作从启动到完成,速度由慢到快再到慢的变化规律。

所谓的均匀是动作速度变化的节奏比较均匀。

而在连续的动作与动作之间几乎没有停顿,这就体现了太极拳连绵不断的风格特点。

主要以左侧肢体为轴转动,重心向左前旋移阶段。

重心在正中方向上继续下沉至右脚脚尖离地时刻达到最低:左髋关节和左踝关节到重心垂线的距离继续缩小,即上支点和下支点的转动半径是同时缩小的,使重心无限接近左髓关节;躯干前倾角有小幅度的增大,肩、髓扭转角都有较大幅度的增大;以左侧肢体为轴转动过程中,同时出现了左右、前后、上下方向的运动;在转动的过程中,左髋关节角度不断增大;左膝关节角度随着重心向左前旋移逐渐较小(从135°减小到110°左右)。

脑机接口技术中连续动作识别的训练策略分享

脑机接口技术中连续动作识别的训练策略分享近年来,随着科技的飞速发展,脑机接口(Brain-Computer Interface, BCI)技术逐渐走进人们的视野。

BCI技术作为一种将人脑与计算机直接连接起来的技术,能够实现人脑通过意念控制计算机或外部设备的交互方式。

其中,连续动作识别是BCI技术的一个重要研究方向。

本文将分享一些脑机接口技术中连续动作识别的训练策略。

首先,为了实现连续动作识别,需要建立一个高效可靠的脑机接口系统。

该系统通常包括信号获取、信号处理和动作识别三个主要模块。

信号获取模块主要通过脑电图(Electroencephalogram, EEG)设备获取脑电信号。

信号处理模块对脑电信号进行预处理、滤波和特征提取,以提高后续动作识别的准确率和稳定性。

动作识别模块利用机器学习算法对预处理后的信号进行分析和识别,从而实现对连续动作的准确识别。

其次,连续动作识别的训练策略是实现准确识别的关键。

一种常见的训练策略是基于事件驱动的思想,即通过对特定的脑电事件进行训练,从而实现对特定动作的识别。

例如,对特定动作进行模拟实验,观察被试者脑电信号在进行该动作或想象该动作时的变化,并利用机器学习算法对这些特征进行训练,最终实现对连续动作的识别。

此外,个体差异是连续动作识别中需要注意的问题。

不同个体的脑电信号可能存在差异,这可能影响到连续动作的准确识别。

为了解决这个问题,一种常见的方法是个性化训练,即根据不同个体的特点对脑机接口系统进行调整和优化。

个性化训练可以提高系统的适应性和准确性,从而更好地满足不同个体的需求。

此外,在连续动作识别的训练过程中,反馈机制也是至关重要的。

通过及时给予被试者正确的反馈,可以帮助其调整意念和动作,从而提高动作识别的准确率。

反馈可以以视觉、听觉或触觉的形式呈现,例如通过显示器上的游戏或虚拟现实环境来引导被试者进行想象或执行特定的动作。

通过不断的练习和反馈,被试者可以逐渐提高连续动作的识别能力。

视频剪辑各手法步骤分析(精)

编辑技术就是构成的技术影像编辑并不是单纯的把不用的部份剪去,把要用的部份连接起来的单纯作业。

编辑的目的是透过构成的技术,使影像的表现凸显新的意义。

因此编辑是充满挑战而有趣的工作,也是一个很知性的谜题。

同样的素材交由不同的人编辑,就有不同的结果产生。

构成的表现正是作者能力的表现。

编辑是”感性的技术”,而非”感性的魔术”。

”感性的判断并非编辑的全部,它必须具备编辑的技术。

理想的编辑是使人感觉不到编辑的存在好比我们观看一部影片,你觉得过程很顺畅,就像看一处连贯的风景般。

这样的编辑就是理想的编辑。

剪去不要的部份以后会产生不连贯的画面,如何把这些不相干画面巧妙平顺的衔接起来,这就是编辑的技术。

很多时候我们用感性的眼光剪接影片,却无法编辑出顺畅的影片。

编辑有它的基本原则,并非凭我们的直觉随性的剪接就能完成。

剪接点cuting point会产生对立与融合的不同状况,也就是两个画面相接合时会有顺畅(融合)和异样感(对立)的差异,为什么会有这种差异?造成异样感的原因又是什么?跳接我们用一个人5秒钟步行的画面来想象,如果我们剪掉第2秒的30格,影像会如何变化?步行的人在第二秒时会突然向前跳,此时观赏影像的人就会有"异样感"。

在一连贯的动作中,剪去衔接部份,产生跳动现象,这种剪接叫“跳接”(Jumping cut)。

譬如,有一个人正把各种物品放入行李箱,在一连贯的动作中,如果使用跳接将会比不经修剪的原始毛片,不但节奏变快,而且会频频跳动。

上面所举的例子,实际上已令人产生了异样感、当然无法流利自然的连接。

所以如非为了持殊的目的和需要应尽量避免使用。

编辑的基本NO.1为了使影像的流动避免产生不协调的异样感觉,编辑的基本首要原则是:不要用大小和位置不变的同一被摄体以卡接(cut in、cut out)的方式来衔接。

同一大小和位置不变的被摄体卡接,视觉上会产生连续性中断(不连续)的”跳接”现象。

进一步的说,除非为了强调连续镜头之间关连性的强度,和表现某些特殊的意义。

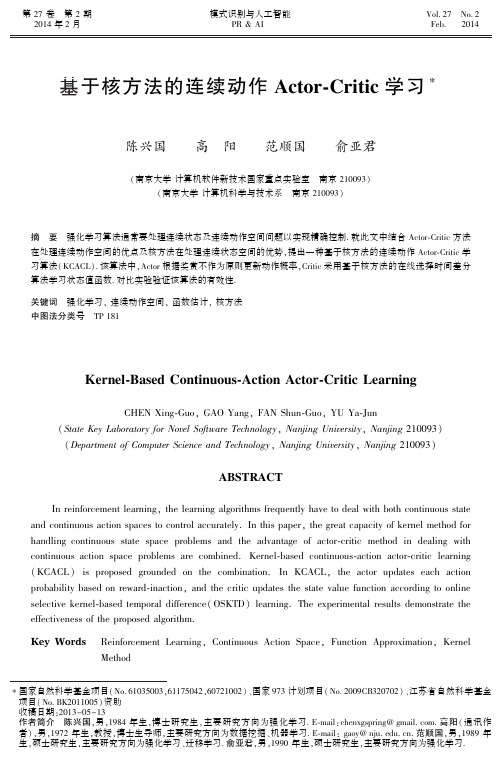

基于核方法的连续动作Actor-Critic学习-

2 强化学习与 Actor-Critic 方法

过自主性地探索环境㊁感知环境㊁采用动作影响环境 并从环境中获得奖赏, 最终在这个交互过程中不断 学习得到最优策略 [1] ,具体框架见图 1. 强化学习以最大化长期的奖赏总和为目标, 通

函数,并采用噪声机制搜索连续动作空间. 1999 年, ted Neural Network Q-Learning) , 该算法的优点是可 快速找到最大的 Q 值及最大的动作, 缺点是线的个 数及位置需预先设定. 2000 年,Doya [15] 提出一种基 于 Hamilton-Jacobi-Bellman 等 式 的 连 续 Actor-Critic ( Continuous Actor-Critic Learning Automaton, CACLA) ,该方法也采用奖赏不作为方式. 2008 年,Melo 等

( Continuous Action Reinforcement Learning Automata, 年,Gross 等 [12] 采用递归神经网络对连续动作进行 编码和动作选择,并使用分布式 Q 学习进行参数更 新. 同年,Lee 等 [13] 采用 BP 神经网络来学习动作值 Gaskett 等

[18]

提出线拟合神经网络 Q 学习( Wire-Fit-

方法来处理连续时间和空间的强化学习问题. 同年, Hasselt 等 [16-17] 提 出 连 续 Actor-Critic 学 习 自 动 机 提 出 适 应 性 自 然 Actor-Critic 算 法 ( Fitted

Fig. 1 Reinforcement learning framework 图 1 强化学习框架

Monte Carlo, SMC) 学习算法. 2009 年,Pazis 等 [20] 提 出动作折半查找法 ( Binary Action Search) 来学习连 续动作控制问题. 2011 年,Xu 等 [21] 提出连续动作近 似策 略 迭 代 ( Continuous-Action Approximate Policy 数进行稀疏化. Iteration, CAPI) 算法, 该算法采用基于核函数近似 线性关 系 ( Approximate Linear Dependence) 对 基 函 作强 化 学 习 的 一 个 有 效 手 段, 其 优 点 在 于 ActorCritic 方法能处理好上述要素 2 ) ~ 5 ) . 众所周知, Actor-Critic 方法的另一个核心是 Critic,Critic 针对 状态值估计的好坏将直接影响 Actor 的策略更新. 在值函数估计中,因为表达定理,基于核方法的值函 数具有较强的表达能力. 2013 年,Chen 等 [22] 提出基 于核方法的在线选择时间差分学习( Online Selective Kernel-Based Temporal Difference Learning, OSKTD) . OSKTD 的每次更新复杂度低, 适合在线学习, 并且 OSKTD 中基于核函数的选择值函数具有局部 有效性,能大幅度提高值函数的准确性. 因此, 本文 结合 Actor-Critic 方法的优点, 及核方法的优势, 提 出基 于 核 方 法 的 连 续 动 作 Actor-Critic 学 习 算 法 ( Kernel-Based Continuous-Action Actor-Critic Learning, KCACL) ,并解决上述连续动作强化学习的 5 个要点. 在 KCACL 中,Actor 根据奖赏不作为原则更 新动作执行的概率,Critic 根据 OSKTD 更新状态值 函数. 实验结果验证 KCACK 在求解连续动作空间 强化学习问题上的有效性. 从上述文献可看出,Actor-Critic 方法是连续动

应用行为分析法(ABA)基本概念综述

关于ABA的几个基本概念(一)ABA的基本特点ABA大家都知道就是行为应用分析法。

1将人的社会交往活动和行为进行分解,直到最细小的但可观测的行为单元。

如:“吃饭”可以分解为:“走到餐桌前”、“坐在椅子上”、“拿自己的餐具”“吃自己碗里的东西”等等。

行为可以无限往下分,尽可能的细小。

通过有系统的训练,帮助孩子学会有社会适应性的行为和活动。

每一种特殊儿童不能出来的行为,从简单的“看”别人,到复杂的如主动的交流和社会活动,都可以被分解成为许多工作步骤。

2、要求孩子必须对每个指令做出反应。

3、孩子的错误反应肯定不能得到解决奖励,即不能被强化。

例如:发脾气,刻板行为,自伤,退缩等)。

4、同一课题的训练要重复很多次,直到在没有成人的任何指导和辅助下,孩子也能有稳定的正确的反应,将孩子的反应记录下来并且按照特定的、客观的定义和标准来评价。

课题的不同孩子的接受能力也不同,有的孩子三次就会了,有的孩子则需要一个月甚至更长时间,每个孩子都如此不同。

多长时间学会只有上帝知道。

5、教学计划是针对每个孩子的不同特点而个别化设计的(IEP)。

就是因人而异,因材施教的意思。

(二)ABA的基本操作分式——回合操作教学法(DTT)指令(刺激)——(孩子)反应——结果(强化)——停顿。

下一个回合。

要对指令作出反应,听指令做反应是社会行为。

(三)行为的分解和目标行为1、行为的分解——将一个行为分解成一系列单元行为,对每一个单元行为还可以继续分解,这样逐级将一个行为拆分为更小的,有先后顺序的行为链。

洗手的分解:会洗手要具备的能力:开水龙头——洗手——关水——擦手。

如果不会洗手,就要现分解洗手——搓手——打香皂——冲手。

现在都是用洗手液,更方便了,设备的发展也可以改善孩子们生活的艰难。

平时没事的时候不要怨天尤人,不要总想多少年后自己S了后孩子怎么办哪。

不试永远不了解孩子。

教孩子时不要一根筋,一种方法打不开孩子的心灵再寻求另一种。

科学的思维方式不但能解决孩子的问题也能对自己的生活有所帮助,但要一步步的来。

钢琴弹奏与声乐训练课程综述范文

钢琴弹奏与声乐训练课程综述范文在音乐的奇妙世界里,钢琴弹奏与声乐训练就像是一对活力四射的搭档,各自散发着独特的魅力,又能相辅相成。

这两门课程,无论是对于想要深入音乐领域的专业人士,还是仅仅热爱音乐、希望提升自身音乐素养的业余爱好者来说,都像是两座蕴藏着无尽宝藏的艺术殿堂。

一、钢琴弹奏课程。

# (一)基础入门:认识黑白键的魔法世界。

对于初学者来说,钢琴就像是一个巨大而神秘的乐器怪兽。

那些黑白相间的琴键,一开始让人眼花缭乱。

但是,一旦开始学习基本的乐理知识,比如音符、节拍,就仿佛拿到了打开这个魔法世界的钥匙。

从简单的中央C开始,慢慢地熟悉每个琴键对应的音高,就像结交新朋友一样,一个一个地去认识它们。

指法的训练是这个阶段的重要部分。

那些看似复杂的指法组合,其实就像是一套精心编排的舞蹈动作。

老师会像严厉又耐心的舞蹈教练一样,纠正每一个手指的位置和动作。

大拇指要怎么自然地从其他手指下穿过,而其他手指又要如何灵活地移动到指定的琴键上。

这可不像看起来那么简单,每一个小细节都需要反复练习,直到手指像是有了自己的意识,能够准确无误地在琴键上跳跃。

# (二)进阶之路:技巧与情感的融合。

当掌握了基础之后,就开始踏上钢琴弹奏的进阶之旅啦。

这个阶段,各种弹奏技巧像潮水一样涌来,像是琶音、颤音、滑音等等。

琶音就像是一串晶莹剔透的珍珠项链,手指需要快速而流畅地在琴键上划过,弹出那一串连续而又美妙的音符。

颤音则像是微微颤抖的心跳,手指快速而有规律地颤动,给音符增添了一种灵动的生命力。

滑音就更有趣了,手指像是在琴键上做滑梯,从一个音顺滑地过渡到另一个音,营造出一种梦幻般的效果。

仅仅掌握技巧是不够的,就像一个人空有一身武艺却没有灵魂。

在这个阶段,更重要的是学会把情感融入到弹奏之中。

每一首曲子都像是一个有故事的小世界,有的曲子欢快得像春天里跳跃的小鹿,有的曲子悲伤得像秋风中的落叶。

演奏者要像一个优秀的演员一样,深入理解曲子背后的情感,然后通过自己的手指,把这种情感传递给每一个听众。

如何在强化学习算法中处理连续动作空间(四)

在强化学习中,连续动作空间的处理一直是一个挑战。

传统的强化学习算法通常是针对离散的动作空间设计的,这在处理连续动作空间时会遇到很多问题。

然而,随着深度学习和强化学习的发展,越来越多的研究者开始探索如何在强化学习算法中处理连续动作空间。

本文将讨论一些常见的方法和技巧,以及它们的优缺点。

1. 基于值函数的方法基于值函数的方法是处理连续动作空间的一种常见方式。

其中,最著名的算法之一是深度确定性策略梯度(DDPG)算法。

DDPG算法结合了值函数和策略网络,通过值函数来学习动作的价值,然后利用策略网络来选择动作。

这种方法在处理连续动作空间时表现良好,但是在实际应用中需要大量的样本来训练,而且对超参数的选择非常敏感。

另一种基于值函数的方法是双重深度Q网络(DQN)。

DQN算法通过使用两个深度Q网络来估计动作的价值,从而解决了传统Q学习算法在处理连续动作空间时的问题。

然而,DQN算法在处理连续动作空间时需要对动作空间进行离散化处理,这会导致信息损失和训练复杂度增加的问题。

2. 策略梯度方法策略梯度方法是另一种常见的处理连续动作空间的方式。

这种方法直接对策略进行建模,通过对策略参数的梯度进行优化来学习动作的选择。

其中,最经典的算法之一是确定性策略梯度(DPG)算法。

DPG算法通过对策略进行参数化建模,然后通过梯度上升的方式来优化策略参数,从而学习到最优的策略。

然而,DPG算法在处理高维状态空间和大规模动作空间时会遇到维度灾难的问题,导致训练效率低下。

另一种常见的策略梯度方法是深度确定性策略梯度(DDPG)算法。

DDPG算法结合了值函数和策略网络,通过值函数来学习动作的价值,然后利用策略网络来选择动作。

这种方法在处理连续动作空间时表现良好,但是在实际应用中需要大量的样本来训练,而且对超参数的选择非常敏感。

3. 模仿学习方法除了基于值函数和策略梯度的方法,模仿学习方法也是一种处理连续动作空间的有效方式。

模仿学习方法通过观察专家的行为来学习策略,并利用这些策略来指导智能体的决策。

如何在强化学习算法中处理连续动作空间(Ⅲ)

在强化学习领域,处理连续动作空间是一个挑战性的问题。

传统的强化学习算法往往只适用于离散动作空间,而对于连续动作空间的处理则需要采用一些特殊的技巧和方法。

在本文中,我们将探讨如何在强化学习算法中处理连续动作空间的问题,并介绍一些常用的方法和技巧。

首先,要处理连续动作空间,我们需要了解什么是连续动作空间。

在强化学习中,动作空间通常可以分为离散动作空间和连续动作空间。

离散动作空间是指动作的取值是有限个数的,比如向左、向右、停止等;而连续动作空间则是指动作的取值是一个连续的范围,比如在一个连续的空间中选择一个位置或者一个方向。

处理连续动作空间的关键问题在于如何对动作空间进行建模和采样。

一种常用的处理连续动作空间的方法是使用参数化的策略。

在参数化的策略中,我们假设策略是由一个参数向量来决定的,然后通过优化这个参数向量来找到一个最优的策略。

这样的方法可以很好地处理连续动作空间,因为参数向量的维度通常是有限的,而且可以使用各种优化方法来对参数向量进行优化。

常见的参数化策略包括高斯策略和确定性策略等。

另一种处理连续动作空间的方法是使用动作值函数。

在强化学习中,动作值函数通常用来评估在当前状态下采取某个动作的价值。

对于连续动作空间,我们可以使用动作值函数来对动作空间进行建模,然后通过优化动作值函数来找到一个最优的策略。

常见的动作值函数包括Q函数和动作值函数等。

除了参数化的策略和动作值函数,还有一些其他方法可以用来处理连续动作空间。

比如,可以使用近似动作值函数来对动作空间进行建模,然后通过近似动作值函数来选择一个最优的动作。

这样的方法可以很好地处理动作空间的连续性,并且可以通过各种近似方法来对动作值函数进行优化。

除了上述方法以外,还有一些其他的技巧和方法可以用来处理连续动作空间。

比如,可以使用基于模型的强化学习方法来对动作空间进行建模,然后通过模型来选择一个最优的动作。

这样的方法可以很好地处理动作空间的连续性,并且可以通过各种模型来对动作空间进行建模和优化。

如何在强化学习算法中处理连续动作空间(Ⅰ)

在强化学习中,处理连续动作空间是一个重要的问题,因为在现实世界中,很多任务都涉及到连续动作的执行。

传统的强化学习算法往往只适用于离散动作空间,对于连续动作空间的处理往往需要额外的技巧和方法。

本文将介绍一些在强化学习算法中处理连续动作空间的方法和技巧。

首先,对于处理连续动作空间,最常见的方法是使用策略梯度方法。

策略梯度方法是一种基于梯度下降的优化方法,它直接优化策略函数,使得在当前状态下选择每个动作的概率尽可能地接近最优策略。

在连续动作空间中,策略梯度方法可以通过参数化策略函数来实现,例如使用高斯分布来参数化策略函数,然后通过梯度下降来更新参数,从而学习到一个在连续动作空间中的最优策略。

其次,除了策略梯度方法,还可以使用数值优化方法来处理连续动作空间。

数值优化方法是一种通过解决优化问题来学习最优策略的方法,它可以通过优化动作值函数或者优化策略函数来实现。

在连续动作空间中,可以使用数值优化方法来学习最优的动作值函数或者策略函数,从而得到在连续动作空间中的最优策略。

另外,还可以使用深度强化学习方法来处理连续动作空间。

深度强化学习是一种结合深度学习和强化学习的方法,它可以通过深度神经网络来学习复杂的策略函数,从而在连续动作空间中实现最优策略的学习。

在深度强化学习中,可以使用深度神经网络来参数化策略函数或者动作值函数,然后通过梯度下降或者其他优化方法来学习最优的策略函数。

此外,还可以使用基于模型的强化学习方法来处理连续动作空间。

基于模型的强化学习是一种通过学习环境模型来实现最优策略学习的方法,它可以通过学习环境模型来规划出最优的动作序列,从而在连续动作空间中实现最优策略的学习。

在基于模型的强化学习中,可以使用深度神经网络来学习环境模型,然后通过规划方法来学习最优的动作序列。

最后,还可以使用分层强化学习方法来处理连续动作空间。

分层强化学习是一种通过将任务分解成多个子任务来实现最优策略学习的方法,它可以通过学习每个子任务的最优策略,然后将这些子任务的最优策略组合起来得到整体任务的最优策略。

如何在强化学习算法中处理连续动作空间问题(六)

强化学习是一种通过与环境互动学习最佳行为策略的机器学习方法。

在强化学习中,智能体通过尝试不同的行为,并观察环境对其行为的反馈来学习。

连续动作空间问题是强化学习中一个重要的挑战,因为在连续动作空间中,智能体可以选择的动作数量非常大,甚至是无穷大。

在本文中,我们将讨论如何在强化学习算法中处理连续动作空间问题。

首先,对于连续动作空间问题,最常见的处理方法是使用函数逼近。

函数逼近是利用一个函数来估计动作值函数或策略函数,以减少动作空间的复杂性。

常见的函数逼近方法包括神经网络、线性回归和高斯过程等。

通过使用函数逼近,可以将连续动作空间中的动作值函数或策略函数表示为一个参数化的函数,从而减少需要探索的动作数量。

其次,另一种处理连续动作空间问题的方法是使用策略梯度方法。

策略梯度方法直接优化策略函数,而不是优化值函数。

通过使用策略梯度方法,可以在连续动作空间中直接对策略函数进行参数化,从而避免对动作值函数进行估计。

常见的策略梯度方法包括REINFORCE算法、TRPO算法和PPO算法等。

这些方法通过直接优化策略函数,可以有效地处理连续动作空间问题。

此外,还有一种处理连续动作空间问题的方法是使用深度确定性策略梯度(DDPG)算法。

DDPG算法是一种结合了策略梯度方法和Q-learning方法的深度强化学习算法。

通过使用DDPG算法,可以实现在连续动作空间中的高效学习。

DDPG 算法通过使用两个神经网络来分别估计动作值函数和策略函数,并且使用经验回放和目标网络来稳定学习过程。

DDPG算法已被广泛应用于多种连续动作空间问题中,并取得了良好的效果。

最后,还有一种处理连续动作空间问题的方法是使用分层强化学习算法。

分层强化学习算法通过将复杂的连续动作空间问题分解为多个子任务,并使用不同的策略函数来解决每个子任务。

通过使用分层强化学习算法,可以有效地降低学习的复杂度,并提高学习的效率。

常见的分层强化学习算法包括H-DQN算法、FeUdal Networks算法和Option-Critic算法等。

如何在强化学习算法中处理连续动作空间(九)

强化学习是一种通过试错来学习最佳行为策略的机器学习方法。

它的目标是使智能体在与环境的交互中获得最大的长期奖励。

在强化学习的框架下,智能体通过观察环境状态并采取与之对应的动作来获取奖励。

然而,对于连续动作空间而言,强化学习算法面临着一些挑战。

本文将探讨如何在强化学习算法中处理连续动作空间,并提出一些解决方案。

首先,连续动作空间指的是动作空间是由连续的实数值构成的情况。

与离散动作空间不同,连续动作空间需要面对无穷多个可能的动作选择,这给强化学习算法的训练和优化带来了挑战。

传统的强化学习算法,例如Q学习和Sarsa算法,很难直接应用于连续动作空间,因为它们需要对动作空间进行离散化处理。

因此,我们需要针对连续动作空间设计新的算法和技术。

一种常见的处理连续动作空间的方法是使用策略梯度算法。

策略梯度算法是一种直接对策略进行学习的方法,它通过最大化长期奖励来更新智能体的策略。

在处理连续动作空间时,策略梯度算法可以直接输出动作的概率分布,而不需要对动作空间进行离散化处理。

这使得策略梯度算法在处理连续动作空间时具有一定的优势。

除了策略梯度算法外,还可以使用值函数逼近方法来处理连续动作空间。

值函数逼近方法是一种通过学习值函数来近似最优策略的方法。

在处理连续动作空间时,可以使用函数逼近技术来近似值函数,从而获得对连续动作空间的高效处理。

另外,为了更好地处理连续动作空间,还可以采用行为者-评论者(Actor-Critic)结构。

行为者-评论者结构是一种将策略梯度算法和值函数逼近方法结合起来的方法。

在行为者-评论者结构中,行为者负责学习策略,评论者负责学习值函数。

通过行为者-评论者结构,可以更好地处理连续动作空间,从而提高算法的效率和性能。

在实际应用中,处理连续动作空间的强化学习算法还需要考虑到一些实际问题。

例如,连续动作空间可能会导致算法的收敛速度较慢,需要更多的训练时间。

此外,连续动作空间还可能引发算法的稳定性问题,需要进行一定的技术优化。

如何在强化学习算法中处理连续动作空间问题(七)

在强化学习领域,处理连续动作空间问题一直是一个挑战。

传统的强化学习算法通常是针对离散动作空间设计的,但在实际问题中,很多情况下动作空间是连续的,比如机器人在空间中的运动、无人驾驶汽车的控制、甚至是金融领域中的交易决策。

因此,如何在强化学习算法中处理连续动作空间问题成为了当前研究的热点之一。

为了解决这一问题,研究者们提出了许多方法和算法。

其中,最为经典的方法之一就是使用深度强化学习算法,尤其是深度确定性策略梯度(DDPG)算法。

DDPG算法是一种结合了深度学习和确定性策略梯度方法的算法,能够有效地处理连续动作空间问题。

DDPG算法的核心思想是将动作选择策略参数化为一个确定性函数,通过神经网络来学习这个函数的参数。

这个确定性函数可以直接输出一个连续动作的值,而不是像传统的强化学习算法那样输出一个离散动作的概率分布。

这样一来,就能够很好地处理连续动作空间问题。

同时,DDPG算法还使用了经验回放和目标网络的技巧,来提高算法的稳定性和收敛性。

然而,尽管DDPG算法在处理连续动作空间问题上表现出了很好的性能,但它也存在一些局限性。

比如,对于高维连续动作空间和非线性动作空间,DDPG算法的学习效率会受到限制。

为了进一步提高算法的性能,研究者们提出了一些改进的方法。

一种常见的改进方法是使用分布式深度确定性策略梯度(D4PG)算法。

D4PG 算法在DDPG算法的基础上,引入了分布式经验回放和分布式动作选择策略,能够更好地处理高维和非线性动作空间。

具体来说,D4PG算法通过在多个Actor-Agent 之间共享经验数据来进行训练,并且使用了一个分布式的动作选择策略,这样一来就能够更好地探索高维连续动作空间,提高算法的学习效率。

除了D4PG算法之外,还有一些其他的方法可以用来处理连续动作空间问题。

比如,使用连续动作空间的分箱方法,将连续动作空间离散化,然后再应用传统的强化学习算法。

这种方法虽然牺牲了一部分动作空间的精度,但却能够在一定程度上降低问题的复杂度,提高算法的学习效率。

如何在强化学习算法中处理连续动作空间(七)

强化学习是一种通过试错来学习最优决策的机器学习方法,而动作空间则是指一个系统可以采取的所有可能动作的集合。

在强化学习算法中,处理离散动作空间相对来说较为简单,但是在处理连续动作空间时,算法的效率和性能就会受到挑战。

在本文中,我们将探讨如何在强化学习算法中处理连续动作空间的一些方法和技巧。

首先,对于处理连续动作空间的问题,我们需要考虑的是动作空间的维度。

在这里,维度指的是动作空间的具体数量和范围。

通常情况下,动作空间的维度越高,处理起来就越复杂。

因此,我们需要对动作空间进行合理的降维处理。

一种常见的方法是使用函数逼近器来近似表示连续动作空间,例如使用神经网络来表示动作空间的连续值。

这样可以有效地降低动作空间的维度,从而减小处理的复杂度。

其次,我们还需要考虑如何在训练过程中有效地探索连续动作空间。

由于动作空间是连续的,因此在训练过程中需要保证对动作空间的充分探索,以便找到最优的动作策略。

一种常见的方法是使用探索-利用策略,即在选择动作时既要考虑当前最优的动作,又要以一定的概率进行随机探索。

此外,还可以采用多步骤学习的方法,即在每个时间步中执行多个动作,以增加对动作空间的探索。

另外,我们还需要考虑如何在强化学习算法中有效地处理连续动作空间的奖励函数。

奖励函数是指在强化学习中用来评估一个动作的好坏的函数。

对于连续动作空间而言,奖励函数的设计更加复杂,因为需要考虑到动作空间的连续性。

一种常见的方法是使用基于模型的奖励函数,即根据环境模型和动作空间的连续性来设计奖励函数,以便更好地评估动作的好坏。

此外,对于处理连续动作空间的问题,我们还可以考虑使用分层强化学习的方法。

分层强化学习是一种将学习任务分解成多个子任务,然后分别学习每个子任务的方法。

对于连续动作空间而言,分层强化学习可以有效地减小动作空间的复杂度,从而提高算法的效率和性能。

在实际应用中,处理连续动作空间的问题是非常具有挑战性的,但是通过合理的方法和技巧,我们可以有效地提高算法的效率和性能。

连续动作分割综述

连续动作分割综述动作分割是视频动作识别的前奏⼯作,需要判别视频流当中⼀个动作的开始和结束帧,同时还需要拒识⾮典型动作运动分割⽅法分类序列分析⽅法分类有关动作分割,可以是序列分析的⼀种,有关序列分析的解决⽅法主要有:l ) 离散分析法这种⽅法只考虑序列中的⼀项,但是在某些应⽤中还是可以得到整个序列的含义。

这类⽅法假设观测物体的特征变化在时间上没有规律,或者忽略规律。

2 ) 点集分析法这种⽅法只看到了每个序列的向量值,但是忽略了它们之间的时序联系,相当于把序列看成是⼀个没有顺序关系的特征点集合,之后我们可以⽤分布来描述这个点集,所以信息没有被完全利⽤。

3 ) 均匀采样分析法在这种⽅法中,考虑序列的顺序性,但是序列的长度是⼀样的。

假设序列长度都是 T,⽽每⼀项的观察值都是⼀个N 维向量,那么每个序列可以⽤⼀个N x T 维向量统⼀表⽰。

这样在建模识别的时候,可以直接使⽤各种的距离函数衡量序列之间的相似度。

4 ) 时域模型法这种分析法,对序列长度没有限制,处理时需要对时间轴上的扭曲变化进⾏建模,这是⽬前处理时间序列中较完善的⽅法。

为了处理时间域上的扭曲,这种⽅法需要采⽤动态规划的框架,因此计算复杂度⽐较⼤,计算时间⽐较长。

与以上均匀采样的相⽐,时域模型法在匹配轨迹上应⽤⽐较⼴泛它可以同时得到时间上的扭曲程度和空间上的相似度。

但是对于序列变化幅度较⼤或者时间扭曲较⼤的情况下D TW ⽅法效果较差。

对于这种情况,H M M 模型得到⼴泛应⽤学习⽅法分类对于动作分割的学习⽅法,现在主要有以下三种解决⽅法:监督式连续动作分割,即根据事先定义好的模型进⾏匹配分割,但是需要⼈⼯⼲预;⽆监督式连续动作聚类,即在⽆监督的情况下⾃动进⾏聚类,然后根据类别分类;还有就是介于监督式分割和⽆监督式分割的半监督式分割⽅法,即先基于监督式⽅法事先定义好部分类别,之后利⽤⽆监督的⽅式⾃动聚类后期应⽤中获取的异常样本与识别先后关系分类l ) 直接分割⽅法即分割与识别过程分开,运动的分割在识别之前完成。

蒙太奇

在日常生活中,我们在观察和认识周围的事物时,既可以通过连续的跟踪而不破坏显示的时空同意,也可以通过分割现实打乱现实的时空同意来进行,连着看,跳着看,这是人们观察和认识生活的两种基本方法。

连续与离散,完整与分割,静止与跳跃这是人们日常的活动、情绪、思维、心理的两种表现形态。

人们通常把这种分割的、离散的、跳跃的思维方式称之为蒙太奇思维。

最早的原始蒙太奇手法——停机再拍早期蒙太奇——摄影机并不一定要固定在一个位置上,可以把摄影机推进到对象面前拍摄人物的细部,也可以使摄影机原理对象展现广阔的空间环境,于是就出现了特写、近景、中景、全景、远景等不同的景别,以及根据内容需要把不同景别德镜头连接起来的手法。

决定性的一步。

格里菲斯[美国]《一个国家的诞生》《党同伐异》。

格里菲斯的巨大功绩在于它吸取了各派或者各个导演点滴的分散的发明并且加以融会贯通,使得电影语言出现了质的飞跃。

他总结了前人的经验,依靠了省略的原则,发现可以对事件的时空连续体进行分解,选择时间和动作的若干要点,以中景、全景、远景等展现空间关系,以近景、特写等强调视觉细节和重点,然后,再将这些镜头按照连贯性和同时性(平行交叉)的原则加以剪辑,其省略的时空部分由观者的经验得到补充,从而构成电影时间和电影动作,形成了电影叙事结构的基本形式。

重点人物:维尔托夫、爱森斯坦、普多夫金。

声画蒙太奇——《未来的有声影片》:只有将音响作为一段蒙太奇的对位去使用时,音响才能使我们有可能去发展并且改进蒙太奇。

在音响方面进行的初步试验必须遵循“音画分立”的方向去进行。

这种进攻式的方法将能产生一种精确的感觉,而在时间的配合下,这就能创造一种画面——视像同画面——音响的交响式对位。

蒙太奇理论综述:1、蒙太奇是镜头剪辑的方法蒙太奇是镜头的剪辑工作,而电影的素材只是一段段拍下的胶片。

演员只是像模特那样在镜头空间里做出一些单纯而明确的动作,这种演员的表演和画面的安排只不过是素材的准备阶段。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

[4]是DTW算法的一个扩展,可以有效解决子序列 匹配问题。在CDP中,一个输入序列与动作模型 一帧一帧地匹配。为了得到侯选动作姿势,所得到 的累积距离必须与相应阈值做个比较。 在应用匹配算法检测出姿势候选集之后,我们 可以使用一系列的规则来选择最佳候选动作姿势, 并将其归属到事先定义好的相应的类别当中去。这 些规则比如说:峰值查找规则[8】8,分割规则【9】9, 以及用户交互模型【10]。 对于CDP算法引入由训练数据而构建的剪枝 分类器,形成CDPP(continuous

to

a

to

locate the

start

and end flames of

gesture.and simultaneously

on

rejects

non-gesture motion

a to

paRems.This paper makes a

recent

detailed summary about the research the applications,the main

与普适计算服务(智能家居、智能会议室);虚拟现 实(VR)中的navigating/manipulating接口;机器人 示范学习;辅助手语教学;辅助小孩与计算机的交 互等等。 2.2上体动作分割 即用上体的动作姿势来表达相应意思,

Jinyoung

Song,Daijin Kim[1]基于二维到三维的模型

A Survey

on

Continuous Gesture Spotting

HUANG Yan.huan,YE Shao.zhen

(The

College

ofMathematics and

Computer Science

ofFuzhou

UnБайду номын сангаасversity,Fuzhou

Fuflan 350002)

Abstract:Gesture spotting is the preparation of gesture recognition,which needs the video sUearn that correspond

Lee and

DTW及其扩展CDP

DTW(dvnarnjc time warping)是一种度量时

序序列间距离的简单方法。但是DTW只适用于两 个时间序列的时序变化不大的场合,并且只适用于 衡量已经分割好了的两个序列之间的距离,也就是 说输入姿势的开始和结束点都是已知的,而对于连 续动作分割问题,需要解决的就是确定动作的界 限,也就是说要在输入序列中匹配参考序列的子序 列匹配问题,所以单纯的DTW算法无法解决。

立为一个单独的阈值模型。之后,Kahol[7]等人试 图分割一个复杂的运动序列,并且提出了层次活动 分割(hierarchical

activity segmentation

subgesture

reasoning)[1 1】,实际地提高了分割正确

性。

HAS)。这

个算法使用动态层次结构来表示人类解剖结构,使 用低层动作参数来从底向上标识简单动作。他们的 方法由两步骤组成:首先使用三条线索来识别出侯 选动作姿势界限,然后将侯选动作姿势界限输入贝 叶斯分类器从而得到最优的姿势界限。其中,耦合 隐马尔可夫模型(CHMM)得到了使用。同时,他 们的方法使用的是三维的特征提取。 HMMS有着它的优势,可以有效解决时空差 异性问题,但是HMMS需要大量的训练集,并且 随着状态数的增多,尤其是引入了非典型动作的自 适应阈值状态以后,状态数急剧增多,并且针对复 杂动作分割及识别所建立的HMMS模型本身的结 构也相当复杂,各个方面都降低了HMMS分割识 别的效率。

与外部世界的交流(手语识别/交互);智能人机接口

1问题背景

许多基于视觉的动作识别系统都假设输入的各 个动作是相互独立或者已经分割好的,也就是动作 开始之前和结束之后都是非动作的休息状态。这样 假设使现有的识别工作变得简单,但是同时也限制 了用户和系统之间交互的自然性。在更多的自然情 况中,一个独立的动作是嵌入在连续动作流里的, 它们的发生必须作为识别的一部分来检测,也就是 需要有连续动作的分割工作。

Model)得到广泛应用。

3.2学习方法分类 对于动作分割的学习方法,现在主要有以下三 种解决方法:监督式连续动作分割,即根据事先定

Stiefelhagen[6]使用立体摄相机将HMM应用于

and

识别三维建模表示的动作姿势。Lee

Kim【3】所

提出来的基于HMMS的识别方法将非典型动作建

黄艳欢等:连续动作分割综述

dynamic

Kim[3]所提出的识别方法是第一个将非典

型动作当做单独的模型建立一个阈值模型的方法, 对于从此而导致的状态数大幅增加,他们使用了相 对信息熵约简。但是这个方法仅仅局限于用在识别 二维的手部轨迹,在两个状态的熔合问题上也存在 着问题。之后的Hee.Deok Yang和A—Yeon Park[2】 基于以上的可变阈值模型做了相应的修改并且成功 地将它应用三维运动模型表示当中。对于CDP方 法,通过构建过渡分类器[11】,实现基于两个模型 帧之间的过渡可能性的相应的剪枝,形成CDPP算 法,可以有效解决拒识问题。但是有关分类器的构 建有着一定的难度和欠准确性,所以相应构建方法 还在研究中。 5.2子动作的识别

表示提出了分割和识别上体姿势的用于控制窗帘和 灯光的智能家居控制系统,该系统同时考虑到观察 的突变性,从而采用了滑动窗口机制,减少由于在 短时间内观察发生突变所导致的错误或不完整的特

2主要应用领域

2.1手势识别 手势识别的研究较多,主要有:辅助聋哑人士

征提取。 2.3全身动作分割 即对全身动作姿势进行建模,Hee.Deok

4.2

5难点以及解决方法

作为动作分割,最难的地方就是分割二义性和 时空差异性。分割二义性指的是如何在一个连续的 动作姿势轨迹当中判断出一个动作姿势的开始点和 结束点(也就是典型动作),以及一个动作姿势与 另一个动作姿势之间的过渡动作(我们称为非典型 动作)。当一个动作姿势的界限未知的时候,我们 不得不将参考模式与输入信号的所有可能分割片段 都进行匹配。此时,非典型动作就会被误认为是典 型动作当中的一种,从而发生识别出错。另一个难 点是时空差异性,也就是同一个动作每次所持续的 时间和其轨迹形状都各有不同,甚至对于同一个 人,可能也存在不同程度的差异。详细地说,运动 分割的难点如下: 5.1非典型动作的拒识问题 即分割二义性的解决,动作识别当中有个很重 要的问题是必须能够识别有意义的动作,以及拒识 或丢弃无意义动作。现有的方法多是设定一个阈 值,这个阈值可以是固定的也可以是可自适应变化 的,对于这个阈值的设定的偏差对于识别结果有着 很大的影响。 现在针对运动分割的比较流行的两大类算法: HMMS与CDP,各自有其解决方法。对于HMM,

and

warping相比,时域模型法中的相应方

time

法称为dynamic

warping(DTW)的方法,这种

方法在匹配轨迹上应用比较广泛,它可以同时得到 时间上的扭曲程度和空间上的相似度。但是对于序 列变化幅度较大或者时间扭曲较大的情况下, DTW方法效果较差。对于这种情况,HMM模型

(Hidden Markov

the continuous gesture sporing during

long time in the solve it.

years,including

method,the

difficulty in this field and the approaches

Keywords:gesture sporting:gesture recognition;video sffeam;contmuous motion

黄艳欢等:连续动作分割综述

连续动作分割综述

黄艳欢 叶少珍

(福州大学数学与计算机学院,福建福州,350002)

摘要:动作分割是视频动作识别的前奏工作,需要判别视频流当中一个动作的开始和结束帧,同时还需要拒 识非典型动作。本文对近年来长时间连续运动分割领域的研究进展做出比较详细的总结,主要包括适用领域, 主要使用方法和难点,并在以上归纳的基础上提出初步的解决方法。 关键词:动作分割;动作识别;视频流;连续运动

220

第十四届全国图象图形学学术会议

动作姿势的分割和识别,并结合隐马尔可夫 (HMMS)的自适应阈值模型达到了很好的效果。

义好的模型进行匹配分割,但是需要人工干预:无 监督式连续动作聚类,即在无监督的情况下自动进 行聚类,然后根据类别分类;还有就是介于监督式 分割和无监督式分割的半监督式分割方法,即先基 于监督式方法事先定义好部分类别,之后利用无监 督的方式自动聚类后期应用中获取的异常样本。 3.3与识别先后关系分类 1)直接分割方法 即分割与识别过程分开,运动的分割在识别之 前完成。在这种识别方法中,首先检测计算一些动 作参数,比如速度,加速度,轨迹曲线等,或者中 级动作参数,然后寻找突变(比如零值),以此确 定分割边界侯选值。这种方法的一个缺陷就是要求 输入的动作与动作之间必须被非动作所间隔,对于 我们所研究的连续运动的情况,这个条件是得不到 满足的。 2)间接分割方法 即运动分割和运动识别同时完成。间接的方法 【3】【4】通过在输入序列当中寻找与已经标识的动作 类别当中有着最大识别可能性的一段输入序列作为 分割出来的结果,即动作的开始点和结束点。大多 数的间接分割及识别方法都是基于动态规划算法 (DP>的基础上扩展起来的,比如HMMS或者 DTW[5】以及DTW算法的扩展CDP算法[4】。

programming with pruning),可以有效提高效率。

在此基础上,加上有关子动作识别,形成CDPPS

(continuous dynamic programming with pruning and