盲源分离的SVM概率密度函数估计算法

盲源分离matlab

盲源分离matlab【原创实用版】目录1.盲源分离的概念与应用2.MATLAB 在盲源分离中的作用3.盲源分离的步骤与实践4.盲源分离的优缺点与未来发展正文盲源分离(Blind Source Separation,简称 BSS)是一种从观测数据中提取独立源信号的技术。

这种技术广泛应用于信号处理、通信、语音识别等领域。

在这些领域中,盲源分离可以有效去除数据中的噪声和干扰,从而提高系统的性能。

MATLAB 是一种广泛应用于科学计算和工程设计的语言,它为盲源分离的理论研究和实践应用提供了便利。

盲源分离的核心思想是利用信号的统计特性,从观测数据中提取出独立源信号。

具体来说,盲源分离包括以下步骤:1.对观测数据进行预处理,包括去除噪声、滤波等操作;2.提取观测数据的统计特性,如协方差矩阵、相关矩阵等;3.利用统计特性,通过优化算法求解源信号;4.对源信号进行解耦,从而得到独立源信号。

在盲源分离的过程中,MATLAB 发挥了重要作用。

首先,MATLAB 提供了丰富的函数库,如信号处理工具箱、优化工具箱等,这些工具箱为盲源分离的理论研究提供了便利。

其次,MATLAB 具有强大的计算能力,可以高效地解决盲源分离中的复杂计算问题。

此外,MATLAB 还提供了可视化工具,可以直观地展示盲源分离的结果,便于研究者对算法进行评估和优化。

盲源分离技术在各个领域都有广泛的应用。

例如,在通信领域,盲源分离可以用于信道均衡、信号解调等任务;在语音识别领域,盲源分离可以用于去除背景噪声、提高识别准确率等任务。

然而,盲源分离技术也存在一些缺点,如计算复杂度高、对初始值敏感等。

因此,研究者需要不断探索新的算法,以提高盲源分离的性能。

总之,盲源分离是一种重要的信号处理技术,它为各个领域提供了有效的解决方案。

MATLAB 作为一款强大的科学计算工具,为盲源分离的研究和应用提供了便利。

第1页共1页。

svm模型计算过程

svm模型计算过程支持向量机(Support Vector Machine,SVM)是一种强大的监督学习算法,可用于分类和回归问题。

下面是 SVM 模型计算的一般过程:1. 数据预处理:将数据集划分为训练集和测试集,并进行必要的数据预处理,如特征缩放、标准化等。

2. 定义核函数:SVM 算法通过核函数将数据从原始空间映射到高维空间,从而能够处理非线性问题。

常见的核函数包括线性核、多项式核、径向基函数核(RBF)和 Sigmoid 核等。

3. 构建优化问题:SVM 的目标是找到一个最佳的决策边界,可以最大化两个类别之间的间隔。

这个问题可以通过构建一个优化目标函数来表示,常见的是使用拉格朗日乘数法将原始问题转化为对偶问题。

4. 求解对偶问题:对偶问题是一个二次规划问题,可以使用各种优化算法来求解,如SMO(Sequential Minimal Optimization)算法。

5. 获取支持向量:在求解对偶问题的过程中,会得到一组最优的拉格朗日乘子。

这些拉格朗日乘子对应于数据集中的支持向量,即对决策边界的确定起关键作用的样本。

6. 计算决策函数:根据支持向量和核函数的参数,可以计算出决策函数。

对于分类问题,决策函数用于预测新数据的类别;对于回归问题,决策函数用于预测新数据的输出值。

7. 模型评估:使用测试集对训练好的 SVM 模型进行评估,计算准确率、召回率、F1 分数等指标,以评估模型的性能。

需要注意的是,SVM 模型的计算过程涉及到大量的矩阵运算和优化算法,计算复杂度较高。

为了降低计算负担,可以采用一些技巧,如使用核技巧(Kernel Trick)来避免直接计算高维空间中的点积。

这只是 SVM 模型计算过程的一个简要概述,实际的实现过程可能会因具体的问题、算法和工具而有所不同。

SVM算法详解范文

SVM算法详解范文SVM(支持向量机)是一种常用的监督学习算法,广泛应用于分类和回归问题。

它的基本思想是找到一个最优的超平面,能够将不同类别的样本点分开。

支持向量机具有较好的泛化能力和鲁棒性,在实际应用中取得了很好的效果。

一、SVM的基本原理1.线性可分情况下当训练样本线性可分时,SVM算法的目标是找到一个能够将正负样本完全分开的超平面。

这个超平面的选择是使得所有样本点到超平面的距离最大化,即最大化间隔。

2.线性不可分情况下当样本线性不可分时,SVM使用核函数将样本映射到高维特征空间中,使得样本可以在高维空间线性可分。

常用的核函数有线性核函数、多项式核函数和高斯核函数等。

二、SVM的数学模型SVM的数学模型可以表示为一个凸二次规划问题,即:min 1/2 ∥w∥²s.t. yi(w·xi+b)≥1 , i=1,2,...,n其中w是超平面的法向量,b是超平面的截距,(xi,yi)是训练样本点,n是样本总数。

这个问题可以通过拉格朗日函数和KKT条件等方法求解。

三、SVM的优缺点SVM具有以下优点:1.SVM能够处理高维特征空间中的分类问题。

2.SVM对于小样本数据集效果较好。

3.SVM能够处理非线性问题,通过核函数将样本映射到高维特征空间。

SVM的缺点包括:1.SVM对于大规模样本集需要较长的训练时间。

2.SVM对于噪声和缺失数据敏感。

3.SVM模型的选择和核函数的选取对结果有较大影响。

四、SVM算法的步骤1.数据预处理:对数据进行标准化和归一化处理。

2.选择核函数:根据问题的特点选择合适的核函数。

3.参数选择:确定正则化项参数和核函数的参数。

4.求解凸二次规划问题:通过优化算法求解凸二次规划问题。

5.模型评估:通过交叉验证等方法评估模型的性能。

6.预测与分类:使用训练好的SVM模型进行预测和分类。

五、SVM的改进和拓展1.核函数选择:根据问题需求和数据特点选择合适的核函数。

2.超参数调优:使用交叉验证等方法调优SVM模型的超参数。

svm的预测公式

svm的预测公式支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,用于分类和回归分析。

它的预测公式可以被描述为一个线性函数,其形式为:f(x) = sign(w·x + b)其中,f(x)表示样本x的预测结果,sign为符号函数,w为权重向量,x为输入特征向量,b为偏置项。

在SVM中,我们的目标是找到一个最优的超平面,将不同类别的样本分开。

这个最优的超平面可以被表示为w·x + b = 0,其将样本空间分成两个区域,分别对应于不同的类别。

对于线性可分的情况,SVM通过最大化间隔来寻找最优超平面。

间隔是指离超平面最近的样本点到超平面的距离,而支持向量则是离最优超平面最近的样本点。

因此,支持向量机的名称由此而来。

在实际应用中,我们往往面临非线性可分的情况。

为了解决这个问题,SVM引入了核函数的概念。

核函数可以将输入特征映射到高维空间中,从而使得原本线性不可分的问题在高维空间中变得线性可分。

常用的核函数包括线性核函数、多项式核函数、高斯核函数等。

通过使用核函数,SVM可以处理更加复杂的分类问题。

SVM具有许多优点。

首先,它可以处理高维空间的数据,适用于特征维度较高的问题。

其次,SVM可以通过调整参数来灵活地控制模型的复杂度和鲁棒性。

此外,SVM的预测结果具有较好的鲁棒性,对于噪声和异常点的影响较小。

最后,SVM的训练过程是一个凸优化问题,可以通过现有的优化算法高效地求解。

然而,SVM也存在一些限制。

首先,SVM在处理大规模数据集时的计算复杂度较高,需要较长的训练时间。

其次,SVM对于参数的选择较为敏感,不同的参数组合可能导致不同的结果。

此外,SVM对于非线性问题的处理需要选择合适的核函数,并且核函数的选择也需要依赖于经验和领域知识。

为了提高SVM的性能,研究者们提出了许多改进的方法。

例如,通过使用多个核函数的组合,可以进一步提高SVM的分类性能。

SVM算法说明和优化算法介绍

SVM算法说明和优化算法介绍SVM(Support Vector Machine,支持向量机)是一种常用的机器学习算法,用于分类和回归分析。

SVM的基本思想是通过在特征空间中构造一个最优超平面,将不同类别的样本分开。

本文将为您介绍SVM的基本原理、分类和回归问题的实现方法以及一些常见的优化算法。

SVM的基本原理是寻找一个能够最大化类别间间隔(margin)的超平面,从而达到更好的分类效果。

在特征空间中,样本点可以用向量表示,所以SVM也可以看作是在特征空间中寻找一个能够最优分割两类样本的超平面。

为了找到这个最优超平面,SVM使用了支持向量(Support Vector),即离超平面最近的样本点。

支持向量到超平面的距离被称为间隔,而最优超平面使得间隔最大化。

对于线性可分的情况,SVM的目标是最小化一个损失函数,同时满足约束条件。

损失函数由间隔和误分类样本数量组成,约束条件则包括对超平面的限制条件。

通过求解优化问题,可以得到最优超平面的参数值。

对于非线性可分的情况,SVM使用核函数进行转换,将低维特征空间中的样本映射到高维特征空间中,从而使得样本在高维空间中线性可分。

SVM在分类问题中的应用广泛,但也可以用于回归问题。

在回归问题中,SVM的目标是找到一个超平面,使得点到该平面的距离尽可能小,并且小于一个给定的阈值。

SVM回归的思想是通过引入一些松弛变量,允许样本点在一定程度上偏离超平面来处理异常数据,从而得到更好的回归结果。

在实际应用中,SVM的性能和效果受到许多因素的影响,如数据集的分布、样本的数量和特征的选择等。

为了进一步优化SVM的性能,许多改进算法被提出。

下面我们介绍几种常见的SVM优化算法。

1.序列最小优化算法(SMO):SMO是一种简单、高效的SVM优化算法。

它通过将大优化问题分解为多个小优化子问题,并使用启发式方法进行求解。

每次选择两个变量进行更新,并通过迭代优化这些变量来寻找最优解。

基于SVM的概率密度估计及分布估计算法

总第236期2009年第6期计算机与数字工程Computer&Digital EngineeringVol.37No.625基于SVM的概率密度估计及分布估计算法3徐玉兵 谭 瑛 曾建潮 张建华(太原科技大学系统仿真与计算机应用研究所 太原 030024)摘 要 在最大熵分布估计算法中,根据Jaynes原理来建立分布估计算法中的概率密度。

基于SVM的概率密度估计则是根据概率密度的定义,由核函数构造一个包含未知参数的概率密度函数。

它根据样本点建立这个概率密度的数学规划模型,并用不敏感损失函数的支持向量机方法来求解这个模型。

对得到的概率密度进行仿真测试,最后将得到的密度应用到分布估计算法中。

关键词 核函数 样本点 舍选法 分布估计算法中图分类号 TP301De nsit y Esti mation Based on Supp ort Vect or Machi ne wit h its Application i n Esti mation of Dist ribution Algorit h msXu Yubing Ta n Ying Ze ng J ia nchao Zha ng J ia nhua(Systems Simulation and Computer Application Institute,T aiyuan University of Science and T enchnology,T aiyuan 030024) Abs t rac t In t he maximum e nt rop y dist ribution estimate algorit hm and its application,it const ructs t he density of t he estimation of dist ribution algorit hms according t o J aynes p rinciple.O n t he basis of p robability density a nd t hrough t he ker nel f unction,de nsity estimation based on supp ort vect or machine const ructs a p robability density f unction w hich in2 cludes unknow n p ara meters.It ta kes use of inse nsitive loss f unctionπs SVM t o solve t he mat hematical model t hat was con2 st ructed by sa mple p oints.Having a simulation test on t he density,t he n it will be applied in t he estimate of dist ribution al2 gorit hm.Ke y w ords ker nel f unction,e mpirical dist ribution f unction,regression estimate,accep tance-rejection met hod,es2 timation of dist ribution algorit hmsClass Nu m ber TP3011 引言概率密度具有广泛应用,可用于数据挖掘中的聚类分析[1]以及电子器件寿命估计和排队论[2]。

SVM算法原理及SMO算法概述

SVM算法原理及SMO算法概述SVM (Support Vector Machine) 是一种广泛应用于分类和回归问题的机器学习算法。

它基于统计学习理论中的VC理论,使用间隔最大化的方法进行分类。

在SVM中,我们将训练数据集视为一个在高维空间中的点集。

SVM的目标是找到一个超平面,能够将不同类别的点分开,并且使其离超平面的距离最大化。

这个超平面被称为最优分隔超平面。

具体来说,SVM算法的原理如下:1.数据预处理:将训练样本映射到高维特征空间,使得样本点能够被线性分隔。

2.寻找最优超平面:在高维特征空间中,寻找能够将不同类别的点分开的超平面。

通常情况下,有多个超平面可以进行分类,而SVM的目标是找到使得间隔最大化的那个超平面。

3.使用支持向量进行分类:SVM找到了最优超平面后,它会选择离该超平面最近的一些点,这些点被称为支持向量。

分类时,SVM根据测试点和支持向量的关系进行判断。

SMO (Sequential Minimal Optimization) 是一种用来训练SVM的优化算法。

传统的SVM算法需要同时优化所有的模型参数,计算量较大。

而SMO算法则是一种序列化的简化方法,每次只优化两个模型参数。

SMO算法的主要思想如下:1.初始化模型参数:选择两个待优化的参数α1和α22.选择两个参数:基于一定的策略,选择两个不同的参数α进行优化。

3.通过求解两个参数的约束最优化问题,更新模型参数。

4.更新阈值和偏置:根据更新后的模型参数,计算出新的阈值和偏置。

5.判断终止条件:检查是否满足终止条件,如果满足则停止优化,否则返回第2步。

SMO算法的核心在于选择两个参数进行优化,并通过解决约束最优化问题来更新参数。

通过反复迭代这个过程,最终得到训练好的SVM模型。

SMO算法的优点是可以有效地处理大规模数据集,并且能够避免陷入局部最优解。

同时,SMO算法还可以引入核函数,使得SVM具有非线性分类和回归能力。

总结来说,SVM是一种基于统计学习理论的分类和回归算法,通过间隔最大化的方法寻找最优分隔超平面。

盲源分离技术在信号处理中的应用研究

盲源分离技术在信号处理中的应用研究随着数字技术的不断发展,信号处理成为越来越重要的一门学科。

信号处理的核心在于信号的提取和分离,而盲源分离技术正是这一领域中的重要技术之一。

盲源分离技术可以对多个混合信号进行分离,并且无需预先知道原始信号的具体情况。

这种技术的应用范围广泛,包括语音信号处理、图像处理、生物医学信号处理等领域。

本文将介绍盲源分离技术在信号处理中的应用和研究进展。

一、盲源分离技术的原理和方法盲源分离技术是一种无监督学习方法。

它的主要思想是从多个混合信号中分离出一组原始信号,这些原始信号可能是独立的或者相互相关的。

盲源分离技术不需要预先知道混合信号的具体情况,也就是说,不需要对混合信号进行建模。

这种方法最早应用于信号处理的反卷积中,后来逐渐发展为一个独立的研究领域。

盲源分离技术的基本方法是利用高阶统计独立性来进行信号的分离。

在实际应用中,可以通过以下几种方法实现盲源分离:(1)信息论方法:信息论方法的基本思想是利用信息熵来衡量信号的独立性或相关性,进而进行信号的分离。

常用的算法有独立成分分析(ICA)和自适应回归模型(ARMA)等。

(2)最小平方误差法:最小平方误差法是一种基于线性代数的方法。

它通过矩阵分解来进行信号的分离。

常用的算法有奇异值分解(SVD)和特征值分解(EVD)等。

(3)机器学习方法:机器学习方法是指利用机器学习算法来学习混合信号的特征,从而进行信号的分离。

常用的算法有神经网络、支持向量机(SVM)等。

二、盲源分离技术在语音信号处理中的应用语音信号处理是盲源分离技术应用最广泛的领域之一。

在语音信号处理中,盲源分离技术可以实现对多说话人的语音信号进行分离,或者对噪声干扰的语音信号进行去噪。

其中,一种典型的应用是麦克风阵列音频信号处理,该技术可以实现对多路语音信号进行分离,提高语音信号质量。

在语音信号处理中,独立成分分析(ICA)是最常用的盲源分离算法之一。

ICA算法使用高阶统计独立性来进行信号分离,可以很好地解决语音信号中的混叠问题。

svm算法公式

svm算法公式【原创版】目录1.SVM 算法概述2.SVM 算法公式简介3.SVM 算法公式详解4.SVM 算法公式的应用5.总结正文一、SVM 算法概述支持向量机(Support Vector Machine,SVM)是一种经典的二分类机器学习算法,由 Corinna Cortes 和 Vladimir Vapnik 于 1995 年提出。

它的主要思想是找到一个最佳超平面,使得不同类别的数据点之间的距离最大化。

SVM 算法在实际应用中表现出卓越的性能,被广泛应用于模式识别、图像识别、文本分类等领域。

二、SVM 算法公式简介SVM 算法的核心是基于最大间隔分隔超平面,其公式可以表示为:1.找到一个超平面 $w * x + b = 0$,使得所有样本点到这个超平面的几何距离最大化。

2.通过对所有样本点进行分类,得到分类结果。

三、SVM 算法公式详解SVM 算法的公式可以分为以下三个部分:1.最大间隔超平面假设我们有一组样本点 $(x_1, y_1), (x_2, y_2),..., (x_n, y_n)$,其中 $y_i in {-1, 1}$ 表示样本点属于正负两个类别。

我们的目标是找到一个超平面 $w * x + b = 0$,使得所有样本点到这个超平面的几何距离最大化。

我们可以通过拉格朗日乘子法(Lagrange Multiplier)来解决这个问题。

2.拉格朗日乘子法拉格朗日乘子法是一种用于求解带约束优化问题的方法。

在 SVM 算法中,我们希望在满足约束条件的前提下,最大化超平面的几何距离。

我们可以引入拉格朗日乘子 $alpha_i$,将问题转化为求解无约束问题的最大化问题。

3.软间隔和硬间隔根据拉格朗日乘子法的求解结果,我们可以得到两种类型的超平面:软间隔超平面和硬间隔超平面。

- 软间隔超平面:当某些样本点不满足约束条件时,我们称之为软间隔超平面。

在这种情况下,我们可以继续调整超平面,使得更多的样本点满足约束条件。

机器学习基础:SVM算法总结

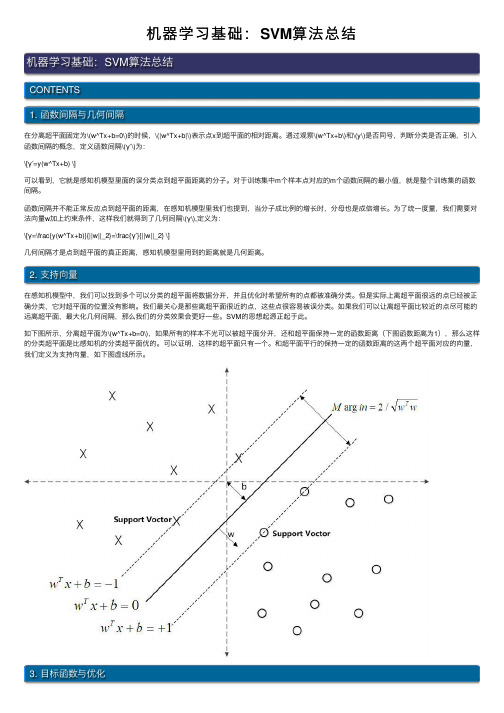

机器学习基础:SVM算法总结机器学习基础:SVM算法总结CONTENTS1. 函数间隔与⼏何间隔在分离超平⾯固定为\(w^Tx+b=0\)的时候,\(|w^Tx+b|\)表⽰点x到超平⾯的相对距离。

通过观察\(w^Tx+b\)和\(y\)是否同号,判断分类是否正确,引⼊函数间隔的概念,定义函数间隔\(γ′\)为:\[γ′=y(w^Tx+b) \]可以看到,它就是感知机模型⾥⾯的误分类点到超平⾯距离的分⼦。

对于训练集中m个样本点对应的m个函数间隔的最⼩值,就是整个训练集的函数间隔。

函数间隔并不能正常反应点到超平⾯的距离,在感知机模型⾥我们也提到,当分⼦成⽐例的增长时,分母也是成倍增长。

为了统⼀度量,我们需要对法向量w加上约束条件,这样我们就得到了⼏何间隔\(γ\),定义为:\[γ=\frac{y(w^Tx+b)}{||w||_2}=\frac{γ′}{||w||_2} \]⼏何间隔才是点到超平⾯的真正距离,感知机模型⾥⽤到的距离就是⼏何距离。

2. ⽀持向量在感知机模型中,我们可以找到多个可以分类的超平⾯将数据分开,并且优化时希望所有的点都被准确分类。

但是实际上离超平⾯很远的点已经被正确分类,它对超平⾯的位置没有影响。

我们最关⼼是那些离超平⾯很近的点,这些点很容易被误分类。

如果我们可以让离超平⾯⽐较近的点尽可能的远离超平⾯,最⼤化⼏何间隔,那么我们的分类效果会更好⼀些。

SVM的思想起源正起于此。

如下图所⽰,分离超平⾯为\(w^Tx+b=0\),如果所有的样本不光可以被超平⾯分开,还和超平⾯保持⼀定的函数距离(下图函数距离为1),那么这样的分类超平⾯是⽐感知机的分类超平⾯优的。

可以证明,这样的超平⾯只有⼀个。

和超平⾯平⾏的保持⼀定的函数距离的这两个超平⾯对应的向量,我们定义为⽀持向量,如下图虚线所⽰。

3. ⽬标函数与优化SVM的模型是让所有点到超平⾯的距离⼤于⼀定的距离,也就是所有的分类点要在各⾃类别的⽀持向量两边。

SVM算法原理及SMO算法概述

SVM算法原理及SMO算法概述支持向量机(Support Vector Machine,SVM)是一种非常常用的机器学习算法,被广泛应用于分类和回归问题中。

SVM算法的原理基于统计学习理论,具有较强的理论基础和实际应用。

具体来说,SVM算法的原理可以分为以下几个步骤:1.数据预处理:对原始数据进行标准化处理,使得不同特征之间具有相同的尺度。

2.特征转换:将数据从低维特征空间转换到高维特征空间。

这个转换的方法可以通过核函数来实现,常用的核函数有线性核函数、多项式核函数和高斯核函数等。

3.寻找最优超平面:在高维特征空间中,通过优化问题求解,找到一个最优的超平面,使得样本点距离该超平面的间隔最大。

4.生成分类模型:根据最优超平面,将数据点分为不同的类别。

简单来说,SVM算法的目标是在保证分类精度的前提下,找到使得间隔最大化的超平面,从而提高模型的鲁棒性和泛化能力。

SMO算法(Sequential Minimal Optimization)是一种用于求解SVM 二次规划问题的优化算法。

SMO算法的基本思想是将大规模的二次规划问题分解为一系列求解两个变量的二次规划子问题。

SMO算法的基本流程如下:1.初始化:选择两个变量作为优化变量,然后初始化所有变量的值。

2.选择变量:选择两个变量作为待优化变量。

选择的原则一般是按照最大步长原则,即第一个变量选择违反KKT条件最严重的变量,第二个变量选择使得优化问题目标函数增大最快的变量。

3.优化变量:固定其他变量的值,针对选定的两个变量,求解二次规划问题,更新这两个变量的值。

4.更新阈值:根据更新后的变量值,更新阈值。

5.检验终止条件:检验是否满足终止条件,如果满足则输出最优解,否则返回第二步。

SMO算法的关键在于选择变量和优化变量这两个步骤。

通过选择合适的变量和高效的求解二次规划子问题的方法,可以有效地提高算法的运算效率。

总结来说,SVM算法是一种基于统计学习理论的强大分类算法,通过优化目标函数找到最优的超平面。

svm计算过程

svm计算过程支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,主要用于分类和回归问题。

它的核心思想是通过在数据集中找到一个最优的超平面来实现分类或回归任务。

在本文中,我们将详细介绍SVM的计算过程。

1. 数据准备首先,我们需要准备用于训练和测试的数据集。

数据集应该包含输入特征和对应的类别标签。

输入特征可以是任意维度的向量,而类别标签可以是离散的类别或连续的数值。

2. 特征缩放在进行SVM计算之前,通常需要对输入特征进行缩放,以确保不同特征之间的数值范围相似。

常用的缩放方法包括标准化(将特征值转化为均值为0,标准差为1的正态分布)和归一化(将特征值缩放到0到1之间)。

3. 选择核函数SVM可以使用不同的核函数来将输入特征映射到高维空间,以便在低维空间中实现非线性分类或回归。

常用的核函数包括线性核、多项式核和高斯核。

选择适合问题的核函数是SVM计算的关键步骤。

4. 计算目标函数SVM的目标是找到一个最优的超平面,使得离超平面最近的样本点到超平面的距离最大化。

这个距离被称为间隔(margin)。

目标函数通常被定义为最大化间隔,并且可以通过求解一个凸优化问题来实现。

5. 求解优化问题为了求解目标函数,我们需要使用优化算法来最小化目标函数。

常用的优化算法包括梯度下降法、牛顿法和拟牛顿法。

这些算法可以通过迭代的方式来逐步优化目标函数,并找到最优的超平面。

6. 寻找支持向量在计算过程中,我们还需要找到离超平面最近的样本点,这些样本点被称为支持向量。

支持向量对于确定最优超平面的位置非常重要,因为它们决定了超平面的位置和形状。

7. 预测和评估一旦找到了最优的超平面,我们可以使用它来进行新样本的预测。

对于分类问题,我们可以根据样本点与超平面的位置关系来判断其所属的类别。

对于回归问题,我们可以使用超平面的输出值来预测目标变量的数值。

同时,我们还可以使用各种评估指标来评估模型的性能,如准确率、召回率和F1值等。

Matlab盲源分离方法与实例

Matlab盲源分离方法与实例在信号处理领域中,盲源分离是一项重要的任务。

盲源分离即通过对混合信号进行分析和处理,将原始信号从混合信号中分离出来。

这项技术在语音识别、音频处理、图像处理等领域中有着广泛的应用。

在本文中,我们将通过介绍Matlab中的盲源分离方法和实例,帮助读者更好地理解和应用这一技术。

一、盲源分离的基本原理盲源分离的基本原理是利用混合信号中的统计特性来估计信号源的分布。

通过对混合信号的统计特性进行分析,可以得到源信号的估计结果。

这样,就可以实现对混合信号中的源信号的分离和重构。

1.1 盲源分离的前提假设盲源分离的方法一般基于以下两个假设:1) 混合信号是线性叠加的。

2) 源信号之间是相互独立的。

在实际应用中,尽管这两个假设并不总是成立,但是通常可以通过一定的预处理方法来满足这些假设。

例如,可以通过滤波、噪声抑制等方式来满足混合信号是线性叠加的假设。

1.2 盲源分离的方法盲源分离的方法可以分为线性方法和非线性方法两类。

线性方法主要包括独立成分分析(ICA)、主成分分析(PCA)等,而非线性方法包括二次熵最小化(QCM)、最小均方误差(MMSE)等。

在本文中,我们将重点介绍其中的独立成分分析(ICA)方法。

二、Matlab中的盲源分离方法Matlab是一种常用的科学计算软件,提供了丰富的工具箱和函数来支持信号处理任务。

在盲源分离领域,Matlab提供了ICA工具箱,可以方便地实现独立成分分析方法。

下面将介绍Matlab中ICA工具箱的使用方法,并通过一个实例来展示其应用效果。

2.1 Matlab中的ICA工具箱Matlab中的ICA工具箱是一个方便易用的工具,提供了多种ICA算法的实现。

使用该工具箱,可以通过简单的函数调用实现对混合信号的盲源分离。

以下是在Matlab中使用ICA工具箱实现盲源分离的基本步骤:1) 加载混合信号数据:首先,需要将混合信号数据加载到Matlab中。

可以使用Matlab提供的文件读取函数将数据读入到变量中。

svm计算过程

svm计算过程

支持向量机(SVM)是一种强大的监督学习算法,主要用于分类和回归分析。

以下是SVM 的基本计算过程:

首先,SVM的目标是找到一个超平面,该超平面可以将数据集中的样本划分为两类,并且使得这两类样本到超平面的距离最大化。

这个超平面被称为决策边界,而距离决策边界最近的样本点被称为支持向量。

在计算过程中,SVM使用了一个称为核技巧的方法,将原始输入空间中的非线性问题转化为某个高维特征空间中的线性问题。

通过选择合适的核函数,SVM可以处理各种类型的数据,包括线性可分和非线性可分的数据。

SVM的训练过程可以转化为一个优化问题,即最小化一个目标函数,同时满足一些约束条件。

这个目标函数通常是一个二次规划问题,可以使用一些优化算法,如序列最小优化(SMO)算法来求解。

在找到决策边界后,SVM可以使用这个边界对新的样本进行分类。

对于给定的新样本,SVM会计算该样本到决策边界的距离,并根据这个距离的符号来判断样本的类别。

值得注意的是,SVM也可以处理多类分类问题。

对于多类分类,SVM通常使用一种称为“一对多”或“一对一”的策略,将多类分类问题转化为多个二类分类问题来解决。

总的来说,SVM的计算过程包括选择核函数、解决优化问题、找到决策边界和使用决策边界进行分类等步骤。

这些步骤使得SVM成为一种强大而灵活的分类算法,可以处理各种类型的数据和分类问题。

SVM算法说明和优化算法介绍

x ⋅w+b = 0, 我们可以对它进行归一化, 使得对线性可分的样本集 ( xi , y i ) , i = 1,..., n ,x ∈ R d ,

y ∈ {+1,−1} ,满足

y i [( w ⋅ x i ) + b] − 1 ≥ 0 , i = 1,L, n

2

2

(1)

此时分类间隔等于 2/||w ||,使间隔最大等价于使||w|| 最小。满足条件(1)且使 1 2 w 最小的分类 面就叫做最优分类面,H1、H2 上的训练样本点就称作支持向量。 利用 Lagrange 优化方法可以把上述最优分类面问题转化为其对偶问题[2],即:在约束条 件

yi [( w ⋅ xi ) + b] − 1 + ξ i ≥ 0 , i = 1,L , n

1 而在目标——最小化 2 w ——中加入惩罚项 C ∑i =1 ξ i ,这样,Wolf 对偶问题可以写成: 2

(7)

n

Maximize:

Q(α ) = ∑ α i −

i =1

n

1 n ∑ α i α j yi y j K ( x i , x j ) 2 i , j =1

式中的求和实际上只对支持向量进行。 b*是分类阈值,可以用任一个支持向量(满足 (1)中的 等号)求得,或通过两类中任意一对支 持向量取中值求得。 对非线性问题, 可以通过非线性变 换转化为某个高维空间中的线性问题, 在变换空间求最优分类面。 这种变换可 能比较复杂, 因此这种思路在一般情况 下不易实现。但是注意到,在上面的对 偶问题中, 不论是寻优目标函数(3)还是 分类函数 (4)都只涉及训练样本之间的 内积运算 ( xi ⋅ x j ) 。 设有非线性映射Φ : R → Η 将输入空间的样本映射到高维 (可能是无穷维)的特征空间Η 中。当在特征空间 H 中构造最优超平面时,训练算法仅使用空间 中的点积,即Φ (x i).Φ (x j),而没有单独的Φ (x i)出现。因此,如果能够找到一个函数 K 使得 K( x i , x j )=Φ (x i).Φ (x j),这样,在高维空间实际上只需进行内积运算,而这种内积运算是可以 用原空间中的函数实现的,我们甚至没有必要知道变换Φ 的形式。根据泛函的有关理论,只 要一种核函数 K( x i,x j)满足 Mercer 条件,它就对应某一变换空间中的内积。 因此,在最优分类面中采用适当的内积函数 K( x i,x j)就可以实现某一非线性变换后的线 性分类,而计算复杂度却没有增加,此时目标函数(3) 变为:

盲源分离的SVM概率密度函数估计算法

2009,45(17)Computer Engineering and Applications计算机工程与应用1引言随着信号处理技术和神经网络技术的日趋成熟,盲源分离技术已经被广泛地应用在通信、语音识别、图像处理等众多领域。

盲源分离的信号模型为Z=A×S+Noise,其中Z=[z1,z2,…,z N]T是N维观测矢量,S=[s1,…,s M]T是M维独立分量矢量,A为N×M的混合矩阵,Noise为噪声。

盲源分离就是在混合矩阵A和信号源S未知的情况下,寻找分离矩阵W,使得Y=WZ为信号源S的一个最优估计。

Cardoso对盲分离领域的发展进行了详细地介绍并指出信源自适应是一个比较困难的问题[1]。

Boscolo 提出用投影搜索的核密度方法估计代价函数[2]。

Vlassis用一种加权高斯和的方法估计信源概率密度[3],该方法能实现对超高斯和亚高斯信源的估计,但误差较大并且具有较高的时间复杂度。

Choi提出用扩展高斯模型估计超高斯与亚高斯分布[4],实现盲分离,该方法的局限在于只能估计单峰,判别超高斯与亚高斯用经验选择系数不够准确。

盲信号抽取定点(Fixed-Point)算法由Hyvarinen和Oja提出[5],也称为快速ICA(Fast ICA),它通过多层神经网络顺序从混合信号中抽取源信号。

该算法分别对分离矩阵的每一列进行更新,每一次找到一个独立分量,这种算法可以运用于任何的非平方的代价函数来获得对独立性的估计。

设第i个抽取单元的输出为:yi=w Tiz(1)式中:w i=[w i1,w i2,…,w in]T,z是去均值和白化处理后的混合信号。

对于任一抽取单元输出y i,取负熵作为其非高斯性度量的代价函数:Δwi∝坠J(yi)坠wi=γE[zf(w Tiz)](2)式中w Ti是分离矩阵W的第i行,γ=E[F(yi)]-E[F(v)],v为N(0,1),F(·)是用来逼近概率密度的非线性函数,f(·)是F(·)的导数。

svm算法简介

w i yi xi

i 1

n

b

i: yi 1

max w xi min w xi

i: yi 1

T

T

2

• 可求出最优的w和b,即最优超平面。

一个简单的例子:

x4

x1 =(0, 0), y1 = +1

x2 =(1, 0), y2 = +1 x3 =(2, 0), y3 = -1 x4 =(0, 2), y4 = -1

拉格朗日乘数法的扩展形式

• minf(w) • s.t. gi(w)≤0 i=1,2,...,k hi(w)=0 i=1,2,...,l (这里0指的是零向量)

L( w, , ) f ( w) i gi ( w) i hi ( w)

i 1 i 1 k l

L( w, , ) 定义: p ( w) max 0

解决方法

允许一些点到分类平面的距离不满足原先的要求。原 先对样本点的要求是(意思是说离分类面最近的样本 点函数间隔要比1大):

如果引入容错性,就给1这个硬性的阈值加一个松弛 变量,即允许:

因为松弛变量是非负的,因此最终的结 果是要求间隔可以比1小。但是当某些点出 现这种间隔比1小的情况时(这些点叫离群 点),意味着我们放弃了对这些点的精确 分类,而这对我们的分类器来说是种损失。 但是放弃这些点也带来了好处,那就是使 分类面不必向这些点的方向移动,因而可 以得到更大的间隔。

0 1 3/ 4 1/ 4 1 2 1 2

1 3 2 1 0 w 4 0 4 2 0 1 1 1 3 3 b , 2 2 2 0 4 g ( x ) 3 2 x1 2 x2 0

基于加权最小二乘支持向量机的欠定盲源分离

基于加权最小二乘支持向量机的欠定盲源分离赵立权;刘珊珊【期刊名称】《电讯技术》【年(卷),期】2015(55)11【摘要】为了进一步提高欠定盲源分离算法中混合矩阵估计方法的性能,提出了一种基于加权最小二乘支持向量机( SVM)的欠定盲源分离混合矩阵估计方法。

该方法利用信号的方向角度特征估计出有效信源信号个数,然后采用加权最小二乘支持向量机方法获得初始权值,每次将其中一个权值对应的样本点作为测试样本,其余点作为训练样本,依次对样本的误差变量进行更新,再根据权值计算公式实现所有权值的更新,进而确定最优分类平面,实现对观测信号的最优分类,最终估计出混合矩阵。

实验结果表明,新算法是有效的,其平均误差是基于K-均值方法误差的0.2倍左右,是基于SVM算法平均误差的0.5倍左右。

%To further improve the performance of the underdetermined blind source separation algorithm,an algorithm based on weighted least square support vector machine( WLS-SVM) is proposed. Firstly,it esti-mates the number of source signal using the characteristic of frequency domain signal. Secondly, it uses WLS-SVM to obtain the initial weight values. The sample point corresponding to one of the weight values is used as the test sample every time,and the other is used as training sample. The error variable is upda-ted sequentially,and then all weight values are updated according to the weight calculation formula to de-termine the optimal classification plane and realize optimal classification of observed signals to estimate the mixedmatrix. Simulation results prove that the proposed algorithm has smaller error compared with tradi-tional algorithm. The error of proposed algorithm is twenty percent of that of K-means based method,and fifty percent of that of SVM-based method.【总页数】6页(P1200-1205)【作者】赵立权;刘珊珊【作者单位】东北电力大学信息工程学院,吉林吉林132012;东北电力大学信息工程学院,吉林吉林132012【正文语种】中文【中图分类】TN911.7【相关文献】1.基于源数估计的无约束欠定盲源分离算法 [J], 付永庆;郭慧;苏东林;刘焱2.基于OS-SASP算法的欠定盲源分离 [J], 季策;张欢;耿蓉;李伯群3.基于欠定盲源分离的同步跳频信号网台分选 [J], 李红光;郭英;张东伟;杨银松;齐子森;眭萍4.混响环境下基于卷积模型的欠定盲源分离 [J], 李帅;刘宏清;彭鹏;罗臻;周翊5.基于STFD的轴承多故障信号欠定盲源分离方法 [J], 诸葛航;吕勇;易灿灿;袁锐因版权原因,仅展示原文概要,查看原文内容请购买。

svm算法过程

svm算法过程SVM算法过程一、引言SVM(Support Vector Machine,支持向量机)是一种常用的机器学习算法,广泛应用于分类和回归问题。

其核心思想是通过找到一个最优的超平面,将不同类别的样本分开。

本文将介绍SVM算法的具体过程。

二、数据预处理在使用SVM算法之前,需要对数据进行预处理。

首先,需要将数据集划分为训练集和测试集。

然后,对数据进行标准化处理,使其具有相同的尺度和分布。

最后,根据需要选择合适的特征提取方法,以提高模型的准确性和泛化能力。

三、构建模型1. 定义问题在使用SVM算法之前,需要明确问题的定义。

例如,如果是一个二分类问题,需要明确两个类别,并将其转化为标签0和1。

2. 选择核函数核函数在SVM算法中起到了关键作用,它可以将数据从原始空间映射到高维空间,从而使数据在高维空间中线性可分。

常用的核函数包括线性核函数、多项式核函数和高斯核函数等。

3. 定义目标函数SVM算法的目标是找到一个最优的超平面,使得训练样本与超平面的间隔最大化。

为了实现这一目标,需要定义一个目标函数,通常为最小化正则化的损失函数。

4. 优化求解为了求解目标函数,可以使用优化算法进行求解。

常用的优化算法包括最小二乘法、梯度下降法和牛顿法等。

通过迭代优化求解,可以找到最优的超平面参数。

四、模型评估在构建好模型之后,需要对其进行评估,以判断其性能和泛化能力。

常用的评估指标包括准确率、精确率、召回率和F1值等。

通过对测试集进行预测,并与真实标签进行比较,可以得到模型的评估结果。

五、参数调优在实际应用中,常常需要对模型的参数进行调优,以达到更好的性能。

常用的参数调优方法包括网格搜索和交叉验证等。

通过尝试不同的参数组合,并使用交叉验证方法进行评估,可以选择最优的参数组合。

六、模型应用在模型评估和参数调优之后,可以将模型应用于实际问题。

例如,可以使用训练好的模型对新的样本进行分类,或者进行预测分析等。

七、总结SVM算法是一种常用的机器学习算法,具有良好的分类和回归性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2009,45(17)Computer Engineering and Applications计算机工程与应用1引言随着信号处理技术和神经网络技术的日趋成熟,盲源分离技术已经被广泛地应用在通信、语音识别、图像处理等众多领域。

盲源分离的信号模型为Z=A×S+Noise,其中Z=[z1,z2,…,z N]T是N维观测矢量,S=[s1,…,s M]T是M维独立分量矢量,A为N×M的混合矩阵,Noise为噪声。

盲源分离就是在混合矩阵A和信号源S未知的情况下,寻找分离矩阵W,使得Y=WZ为信号源S的一个最优估计。

Cardoso对盲分离领域的发展进行了详细地介绍并指出信源自适应是一个比较困难的问题[1]。

Boscolo 提出用投影搜索的核密度方法估计代价函数[2]。

Vlassis用一种加权高斯和的方法估计信源概率密度[3],该方法能实现对超高斯和亚高斯信源的估计,但误差较大并且具有较高的时间复杂度。

Choi提出用扩展高斯模型估计超高斯与亚高斯分布[4],实现盲分离,该方法的局限在于只能估计单峰,判别超高斯与亚高斯用经验选择系数不够准确。

盲信号抽取定点(Fixed-Point)算法由Hyvarinen和Oja提出[5],也称为快速ICA(Fast ICA),它通过多层神经网络顺序从混合信号中抽取源信号。

该算法分别对分离矩阵的每一列进行更新,每一次找到一个独立分量,这种算法可以运用于任何的非平方的代价函数来获得对独立性的估计。

设第i个抽取单元的输出为:yi=w Tiz(1)式中:w i=[w i1,w i2,…,w in]T,z是去均值和白化处理后的混合信号。

对于任一抽取单元输出y i,取负熵作为其非高斯性度量的代价函数:Δwi∝坠J(yi)坠wi=γE[zf(w Tiz)](2)式中w Ti是分离矩阵W的第i行,γ=E[F(yi)]-E[F(v)],v为N(0,1),F(·)是用来逼近概率密度的非线性函数,f(·)是F(·)的导数。

J(·)是负熵,它是任意概率密度函数和具有同样方差的高斯型概率密度函数间的K-L散度。

固定点算法的表达式为[5]:wi(k+1)=E{zf[w Ti(k)z]}-E[f′(w Ti(k)z)]wi(k)(3a)wi(k+1)←wi(k+1)‖wi(k+1)‖2(3b ‖‖‖‖‖‖‖‖‖‖‖)收敛后的w Ti是矩阵W中的一行,因此由yi(n)=w Tiz(n)分离出某一信源si(n)。

盲分离算法中,通常采用非线性函数代替信号的激活函数;而对于统计特性未知的信号源,非线性函数只能凭经验选取。

如盲源分离的SVM概率密度函数估计算法胡波平,何选森HU Bo-ping,HE Xuan-sen湖南大学计算机与通信学院,长沙410082School of Computer and Communication,Hunan University,Changsha410082,ChinaE-mail:hbp1982@HU Bo-ping,HE Xuan-sen.Novel BSS algorithm for estimating PDF based on puter Engineering and Applications,2009,45(17):142-144.Abstract:This paper utilizes radial basis function to construct the kernel function and forms a sparse representation of the probability density of the mixed signal based on SVM regression method of Neural network theory,so the expressions of the PDF of the output signals is gotten and a new method of estimating the active function is put forward.A novel BSS algorithm is pre-sented in this paper by combining the PDF estimation with the fixed-point algorithm.The simulations have verified that this algo-rithm can successfully separate the mixed sub-Gaussian and super-Gaussian source signals.Key words:support vector machine;probability density function;active function;fixed-point algorithm摘要:基于神经网络理论中的支持向量机回归方法,利用径向基函数构造核函数,给出类高斯函数的混合信号概率密度稀疏表达,进而得到输出信号的概率密度的显式表达;提出一种估计激活函数的新方法,与盲信号抽取定点算法相结合,形成一种新的盲分离算法。

通过仿真实验,验证了该方法能成功地分离超、亚高斯混合信号。

关键词:支持向量机;概率密度;激活函数;定点抽取算法DOI:10.3778/j.issn.1002-8331.2009.17.043文章编号:1002-8331(2009)17-0142-03文献标识码:A中图分类号:TN911基金项目:湖南省湘潭市科技计划项目(No.ZJ20071008)。

作者简介:胡波平(1982-),男,硕士研究生,主要研究领域为盲信号处理、阵列信号处理;何选森(1958-),男,副教授,研究方向为信号与信息处理。

收稿日期:2008-04-09修回日期:2008-06-231422009,45(17)信号服从亚高斯分布,其激活函数为Фi (y i )=αy i +y i |y 2i |,而对于超高斯情况,其激活函数为Фi (y i )=αy i +tan h (βy i ),这里α≥0,β≥2。

但是在实际中并不知道源信号是服从超高斯还是亚高斯分布,如果按照某一种统计特性来选取非线性函数,对源信号的分离效果差,甚至根本无法分离。

提出一种基于支持向量机(Support Vector Machine )对分离信号进行概率密度函数的回归估计,得到一组稀疏的解系数,配合选定的核函数得出对分离信号概率密度函数的显式表达,并以此构造激活函数应用到FastICA 算法中,有效实现超高斯和亚高斯混合信源的分离。

2基于支持向量机(SVM )的概率密度函数回归方法常用的概率密度估计方法分为参数估计和非参数估计两大类。

参数估计方法具有较大的局限性;而非参数估计具有更广的应用范围,其中又以Parzen 窗方法最为常用。

但该方法估计概率密度要用到所有的训练样本,当训练样本非常多时,这种方法不实用[6]。

为了解决这个问题,就必须寻找稀疏解的办法。

而支持向量机(SVM )的解只和训练样本中的支持向量有关,因此它提供了一种良好稀疏解的方法。

若考虑损失函数为ε-的不敏感函数L ε(d ,y ),其中d 为期望输出,y 为实际输出,即:L ε(d ,y )=0if |d-y|≤ε|d-y|-εotherwis ≤e(4)SVM 的基于结构风险最小化(SRM )原则为求使经验风险1nni =1ΣL ε(d i,y i)与结构风险之和最小的u ,即:min R SVM (C )=C 1n ni =1ΣL ε(d i +y i )+12‖u ‖2(5)概率密度估计就是求线性算子方程:+∞-∞乙θ(x-t )p (t )d t=F (x )(6)的解,其中θ(x )=1,x >00,x ≤乙0,p (·)是概率密度函数,F(·)为其未知分布函数。

同时解必需满足如下条件:p (x )≥0,+∞-∞乙p (x )d x =1。

在上述线性算子方程(6)中,分布函数F (x )未知,但是给出了一定的独立同分布样本x 1,…,x n ,利用这些样本,构造经验分布函数F n (x)=1n ni =1Σθ(x-x i)。

从概率密度的定义求解线性算子方程Ap (x )=+∞-∞乙θ(x-t )p (t )d t 寻找该方程的解与在F (x ,u )=∞r =0Σu rΦr(x )的空间中寻找线性回归函数是等价的。

由于概率密度函数通常为非线性函数,为使其线性可分,将样本空间X 奂Rn映射到高维特征空间Φ(X )奂R N(Φ(·)为非线性映射,N 可能为无穷):X →Φ(X )以构造超平面。

因此上述问题就转化为用SVM 方法对(x 1,F n (x 1)),…,(x n ,F n (x n))在像空间中进行回归估计的问题,其解为u =n *i =0Σα*i Φ(x *i )(7)其中n *为支持向量数目,x *i 为支持向量,α*i 为其对应的非零拉格朗日系数,Φ(x )是样本空间到高维空间映射的像。

定义像空间中的核函数为[6]:K (x i ,x j )=∞r =0ΣΦr (x i )Φr (x j)(8)交叉核函数为:K (x i ,x )=∞r =0ΣΦr (x i )φr (x)(9)其中φ为Φ的微分,利用SVM 方法解线性算子方程可转换为利用核函数和数据对(x 1,F n (x 1)),…,(x n ,F n (x n ))在象空间中进行回归估计,获得u ,并通过交叉核函数得到线性算子方程的解[6]:p (x ,α)=n *i =1Σα*i k (x *i ,x)(10)3基于SVM 概率密度估计的FastICA 算法在对观测信号x 概率密度的SVM 估计当中可以选择多种核函数,为了使估计出的概率密度函数曲线更平滑,取径向基函数为核函数,其形式为:K (x ,y )=exp{-σ‖x-y ‖2},σ>0为指数因子,得到关于观测信号的概率密度函数的形式为[7]:p (x ,α)=n *i =1Σα*i exp{-σ‖x-x *i ‖2}(11)这样的形式跟高斯函数多项式非常相似,只是差一个常系数,而这一点可以由α*i 来弥补。

盲信号分离中,源信号是未知的,没有训练样本,所以根据概率密度函数的估计方法并不能直接用来估计源信号的概率密度函数。

要构造激活函数只能用源信号的估计y 来实现。

直接对y 的概率密度进行估计,看起来似乎可行;但是y 由迭代产生,增大了计算量,而且分离矩阵W 的初值是人为选定的,不能保证算法收敛。