一种分布式数据流连接查询算法

什么是计算机网络大数据常见的计算机网络大数据处理技术有哪些

什么是计算机网络大数据常见的计算机网络大数据处理技术有哪些计算机网络大数据处理技术概述计算机网络大数据处理技术是指通过计算机网络连接不同的计算资源,对大规模的数据进行存储、处理和分析的技术方法。

随着互联网的发展和智能设备的普及,大数据的规模不断增大,传统的数据处理方法已经无法满足对大数据的需求。

计算机网络大数据处理技术应运而生,为大数据的处理提供了高效、便捷和可扩展的解决方案。

一、分布式存储技术分布式存储技术是计算机网络大数据处理的基础技术之一。

它通过将大量的数据分散存储在多个节点上,实现数据的可靠性和可扩展性。

常见的分布式存储技术包括:1. Hadoop分布式文件系统(HDFS):HDFS是Apache Hadoop项目中的一部分,它的设计目标是存储和管理大规模数据集。

Hadoop将数据拆分成块并分布存储在不同的服务器上,提供高容错性和高吞吐量的数据访问。

2. 分布式对象存储(Ceph):Ceph是一个开源的分布式存储系统,它用于存储海量的数据,并提供统一的接口进行访问。

Ceph将数据切分成对象并分布存储在多个节点上,通过数据副本和自动数据迁移实现数据的容错性和负载均衡。

3. 分布式键值存储(Redis):Redis是一个高性能的内存数据库,它将键值对存储在内存中,通过网络访问并支持持久化存储。

Redis分布式存储通过使用集群和主从复制等技术实现数据的可扩展性和高可用性。

二、分布式处理技术分布式处理技术是计算机网络大数据处理的核心技术之一。

它通过将大规模的任务切分成多个子任务,并分布在不同的计算资源上并行处理,提高数据处理的效率和速度。

常见的分布式处理技术包括:1. MapReduce:MapReduce是一种编程模型和计算框架,用于支持大规模数据集的并行处理。

MapReduce将数据处理任务划分为Map阶段和Reduce阶段,通过分布式计算的方式实现数据的处理和计算。

2. Spark:Spark是一个开源的大数据计算框架,它提供了丰富的API和工具,用于支持大规模数据的分布式处理。

分布式(计算机的一种算法)

分布式存储系统

P2P数据存储 系统

云存储系统

P2P数据存储系统采用 P2P网络的特点,即每个用户都是数据的获取者和提供者,没有中心节点,所以每个 用户都是对等存在的。利用这种特点建立而成的P2P数据存储系统可以将数据存放于多个对等节点上,当需要数 据时,可以利用固定的资源搜索算法寻找数据资源,从而获取想要的数据。

分布式(计算机的一种算法)

计算机的一种算法

目录

01 分布式计算

03 应用方向,它研究如何把一个需要非常巨大的计算能力才能解决的问题分成 许多小的部分,然后把这些部分分配给多个计算机进行处理,最后把这些计算结果综合起来得到最终的结果。分 布式网络存储技术是将数据分散地存储于多台独立的机器设备上。分布式网络存储系统采用可扩展的系统结构, 利用多台存储服务器分担存储负荷,利用位置服务器定位存储信息,不但解决了传统集中式存储系统中单存储服 务器的瓶颈问题,还提高了系统的可靠性、可用性和扩展性。

传统的集中式GIS起码对两大类地理信息系统难以适用,需用分布式计算模型。第一类是大范围的专业地理 信息系统、专题地理信息系统或区域地理信息系统。这些信息系统的时空数据来源、类型、结构多种多样,只有 靠分布式才能实现数据资源共享和数据处理的分工合作。比如综合市政地下管网系统,自来水、燃气、污水的数 据都分布在各自的管理机构,要对这些数据进行采集、编辑、入库、提取、分析等计算处理就必须采用分布式, 让这些工作都在各自机构中进行,并建立各自的管理系统作为综合系统的子系统去完成管理工作。而传统的集中 式提供不了这种工作上的必要性的分工。第二类是在一个范围内的综合信息管理系统。城市地理信息系统就是这 种系统中一个很有代表性的例子。世界各国管理工作城市市政管理占很大比例,城市信息的分布特性及城市信息 管理部门在地域上的分散性决定了多层次、多成份、多内容的城市信息必须采用分布式的处理模式。

分布式计算算法

分布式计算算法分布式计算是一种计算方法,它可以将一个大的计算任务分解成许多小的部分,然后将这些部分分配给多台计算机进行处理。

这种方法可以提高计算效率,因为它可以利用多台计算机的并行处理能力。

分布式计算算法的设计需要考虑到如何将任务分配给各个计算机,如何协调各个计算机之间的通信和协作,以及如何处理分布式计算中的数据一致性和错误恢复等问题。

分布式计算算法可以根据其应用场景和数据处理方式的不同,采用不同的设计方法和技术。

其中一些常见的分布式计算算法包括:1. MapReduce:这是一种常见的分布式计算算法,它将一个大型任务分解成许多小的Map任务,并将这些任务分配给各个计算机进行处理。

然后,通过Reduce阶段将各个计算机的处理结果进行汇总和整合,得到最终的输出结果。

2. Flink:Flink是一种流处理框架,它支持大规模的流处理和批处理任务。

Flink通过数据流的方式将任务分配给各个计算机进行处理,并支持实时流处理和批处理之间的无缝切换。

3. Hadoop:Hadoop是一种分布式计算框架,它使用MapReduce算法进行大规模数据的分布式处理。

Hadoop可以处理海量数据,并且可以跨多个计算机集群进行并行处理。

4. Spark:Spark是一种通用的分布式计算框架,它支持大规模的数据处理和分析。

Spark提供了丰富的数据操作函数和转换操作,并可以在多个计算机集群上进行并行处理。

5. DAG(有向无环图)计算:这种分布式计算算法通过将任务分解成多个子任务,并使用有向无环图的方式将各个子任务连接起来,形成一个完整的计算流程。

DAG计算可以更好地利用并行处理能力,并支持更复杂的计算任务。

以上是一些常见的分布式计算算法,它们各自具有不同的特点和适用场景。

在实际应用中,需要根据具体的需求和场景选择合适的分布式计算算法。

langchain实现原理_理论说明以及概述

langchain实现原理理论说明以及概述1. 引言1.1 概述在当今数字化时代,区块链技术以其分布式、去中心化和安全性等特点,在各个领域得到广泛应用。

作为一种创新的底层技术,区块链被认为具备颠覆性的潜力,能够改变传统行业的商业模式和生态系统。

本文将深入研究并论述langchain 技术的实现原理,旨在帮助读者更好地理解并掌握这一重要的区块链应用。

1.2 文章结构本文分为五个主要部分。

首先是引言部分,其中我们将简要介绍文章的背景和目的。

第二部分介绍了langchain实现原理,包括基本概念、架构设计和工作原理等内容。

第三部分对与langchain相关的理论进行了详细说明,包括分布式账本技术、智能合约原理和加密算法应用等方面。

第四部分概述了langchain 在不同行业中的应用场景及其竞争优势,并展望其未来发展趋势。

最后,在结论部分对langchain实现原理及其重要性进行总结,并提供未来发展的展望和建议。

1.3 目的本文的目的是介绍和解释langchain技术的实现原理。

通过深入探讨其基本概念、架构设计以及工作原理,希望读者能够全面了解这一区块链技术,并认识到它在各个行业中的潜在应用价值。

同时,本文还将对与langchain相关的理论进行说明,以便读者更好地理解其底层原理和安全性保障机制。

最终,我们希望通过本文的阐述,能够为读者提供有关langchain实现原理的详尽信息,并为未来发展提出展望和建议。

2. langchain实现原理:2.1 基本概念:langchain是一种基于区块链技术的分布式账本系统。

它通过将数据存储在分布式网络中的不同节点上,确保了数据的安全性和可靠性。

langchain采用了去中心化的机制,消除了中心化服务器的单点故障问题,并且能够实现更高效的数据交互和共享。

2.2 架构设计:langchain的架构设计包括以下几个关键组件:- 分布式网络:由多个节点组成的网络,每个节点都具有完整的账本副本。

分布式数据库系统的结构的特点 数据分片技术 连接技术 范式 基本流程 MapReduce 模型

注:考生属哪种类别请划“√”(博士、在校硕士、工程硕士、师资硕士、同等学力、研究生班)√研究生考试试卷考试时间:考试科目:分布式数据库考生姓名:评卷人:考试分数:注意事项1、考前研究生将上述项目填写清楚2、字迹要清楚,保持卷面清洁3、试题、试卷一齐交监考老师4、教师将试题、试卷、成绩单,一起送研究生学院;专业课报所在院、系分布式数据库课程考试题签一、说明分布式数据库系统的结构的特点(不低于 6 个)。

(1)物理分布性(2)场地自治性(3)场地之间协作性(4)数据独立性(5)集中与自治相结合的控制机制(6)适当增加数据冗余度(7)事务管理的分布性二、分布式查询处理的查询时间如何计算,根据数据在不同的场地分布分别说明。

查询涉及多个库或者多张分表:1.排序,即多个来源的数据查询出来以后,在应用层进行排序的工作。

查出来如果是已经排序号的,则对多路进行归并排序否则就要进行一个全排序。

2.函数处理,即使用Max,Min,Sum,Count 等函数对多个数据来源的值进行相应的函数处理3.求平均值,从多个数据来源进行查询时,需要把SQL改为查询SUM和Count,然后对多个数据来源的Sum求和,count求和后,计算平均值,这是需要注意的地方。

4非排序分页,这需要看具体实现所采取的策略,是同等步长地在多个数据源上分页处理,还是同等比例地分页处理。

5排序后分页。

二、分布式数据库系统的数据分片技术有哪些?分别说明。

三种分片方式:hash方式、一致性hash、按照数据范围(range based)。

hash方式:哈希表(散列表)是最为常见的数据结构,根据记录(或者对象)的关键值将记录映射到表中的一个槽(slot),便于快速访问。

绝大多数编程语言都有对hash表的支持,如python中的dict,C++中的map,Java中的Hashtable,Lua中的table等等。

在哈希表中,最为简单的散列函数是 mod N(N为表的大小)。

大数据开发工程师招聘笔试题与参考答案2025年

2025年招聘大数据开发工程师笔试题与参考答案(答案在后面)一、单项选择题(本大题有10小题,每小题2分,共20分)1、在大数据处理中,以下哪个技术或框架主要用于实时数据流处理?A. HadoopB. SparkC. KafkaD. Flink2、在大数据存储中,HDFS(Hadoop Distributed File System)的设计目标是?A. 提供低延迟的数据访问B. 支持随机读写操作C. 提供高吞吐量的数据访问D. 适用于小型数据集3、题干:以下哪种数据结构最适合存储大规模数据集,并支持快速的数据检索?A. 数组B. 链表C. 树D. 哈希表4、题干:在分布式系统中,以下哪个组件负责处理数据分片和分布式事务?A. 数据库B. 应用服务器C. 分布式文件系统D. 分布式数据库中间件5、大数据开发工程师在处理大规模数据集时,通常使用的分布式文件系统是:A. HDFS(Hadoop Distributed File System)B. NFS(Network File System)C. SMB(Server Message Block)D. APFS(Apple File System)6、在数据仓库中,用于存储元数据的表通常被称为:A. fact table(事实表)B. dimension table(维度表)C. lookup table(查找表)D. metadata table(元数据表)7、大数据开发工程师在处理海量数据时,以下哪种技术通常用于数据存储和管理?A. 关系型数据库B. NoSQL数据库C. 文件系统D. 数据库管理系统8、在大数据技术中,以下哪个组件通常用于实现数据流处理?A. Hadoop MapReduceB. Apache KafkaC. Apache SparkD. Apache HBase9、在Hadoop生态系统中,用于进行分布式存储的是哪一个组件?A. HDFSB. YARNC. MapReduceD. Hive 10、以下哪个算法不是机器学习中的监督学习算法?A. 支持向量机(SVM)B. 决策树C. 深度学习D. K-均值聚类二、多项选择题(本大题有10小题,每小题4分,共40分)1、以下哪些技术或工具通常用于大数据开发?()A、Hadoop HDFSB、Spark SQLC、MongoDBD、ElasticsearchE、MySQL2、以下哪些算法或模型在机器学习的大数据处理中应用广泛?()A、K-Means聚类B、决策树C、神经网络D、朴素贝叶斯E、线性回归3、关于大数据开发工程师所需掌握的技术栈,以下哪些技术是必要的?()A. Hadoop生态系统(包括HDFS、MapReduce、Hive等)B. Spark大数据处理框架C. NoSQL数据库(如MongoDB、Cassandra)D. 关系型数据库(如MySQL、Oracle)E. 容器技术(如Docker)4、以下关于大数据处理流程的描述,哪些是正确的?()A. 数据采集是大数据处理的第一步,需要从各种数据源获取原始数据。

一种基于代表点的分布式数据流聚类算法

di1 .9 9 j i n 1 0 ・6 5 2 1 . 80 1 o:0 3 6 /.s .0 13 9 .0 2 0 . 1 s

e pei n a e u t e la d s n h tc d ts t mo sr t ha he ag rt m a nd t l tr n di e e ts a s a d x rme t lr s lson r a n y t ei a a esde n tae t tt lo ih c n f he cuse s i f r n h pe n i f

Ab t a t T n h l s r fd f r n h p s u d r t e d s b t d d t te ms e vr n n ,h s p p r p o o e h s r c : o f d t e cu t s o i e e ts a e n e h it u e aa sr a n i me t t i a e rp s d t e i e f i r o rp e e tt e b s d cu tr ga g rtm. i t i p e e td t e c n e t f i u a — o n a e n t e rp e e tt e p i t a d e r s na i ・ a e lse i lo h F r , rs ne h o c p r lrp i t s d o h e r s na i on s n v n i s t occ b v

无线mesh网络中的分布式路由算法与协议

无线mesh网络中的分布式路由算法与协议一、引言随着物联网技术的飞速发展,将各种设备连接到互联网已经变得越来越容易。

然而,传统的中心化网络设计已经无法满足我们对联网设备的要求。

在很多情况下,这些设备的数量很多,它们分散在不同的地方并且需要同时与其他设备进行通信。

这时,分布式网络的设计就变得至关重要。

而无线mesh网络正是一种用于实现分布式网络的解决方案。

本文将着重介绍无线mesh网络中的分布式路由算法与协议。

二、无线mesh网络概述1. 无线mesh网络定义无线mesh网络,也称为mesh网络或网状网络,是一种分布式网络拓扑结构,其中数据通过多个中间节点进行传输,从而将多个设备连接到互联网。

每个节点可以成为信息的源和目的地,因此该网络结构可以在没有中心节点的情况下实现。

2. 无线mesh网络的特点相对于传统的无线网络,无线mesh网络具有以下特点:(1) 去中心化:无线mesh网络没有固定的中心节点和明确的路由。

数据通过自组织和自适应的方式在网络中传递。

(2) 高可靠性:因为没有固定的中心节点,即使一个节点发生故障,数据依然可以通过其他节点进行传输,从而保证了网络的可靠性。

(3) 省电:无线mesh网络利用多节点进行传输,因此数据可以通过一个节点的转发,从而减少每个设备的功耗。

(4) 高速度:无线mesh网络可以通过多路径传输数据,从而提高数据的传输速度。

(5) 扩展性:因为是分布式网络,节点可以根据需要加入或离开网络,从而实现网络的扩展性。

三、分布式路由算法1. 分类路由算法根据其计算方式和信息交换方式可以被划分为以下几类:(1) 纯分布式算法:每个节点都是平等的,每个节点都可以决定自己的路由表。

(2) 局部信息算法:每个节点只需要维护自己的一部分拓扑信息。

(3) 全局信息算法:每个节点需要维护网络中所有节点的信息。

(4) 混合信息算法:每个节点维护自己的信息和部分邻居节点的信息。

2. 常用的无线mesh网络路由算法(1) Ad-hoc On-demand Distance Vector (AODV):是一种基于距离向量的路由协议,它适用于变化迅速的网络环境。

一种分布式数据流查询重用算法研究

一

种 分 布 式 数 据 流 查 询 重 用算 法研 究 水

张付 志 , 晓晨 任

( 山大 学 信 息科 学与 工程 学院 , 北 秦 皇 岛 060 ) 燕 河 6 04

摘

要 :提 出了一种 基 于查询树 匹配 的查询 重用 算法 。首先 , 系统 中原有 查询 树 与新 生成的 查询 树进 行 匹配并

ZHANG Fu-hi REN a — he z , Xio c n

( colfI omai c ne& E gnen ,Y nh n U i rt;Qn u nd oHee 06 0 ,C ia Sh o o fr t nSi c n o e n i r g a sa nv sy ih ag a bi 60 4 hn ) ei ei

计 算 对新 查询树 的 重用收 益 ; 然后 根据 重 用收益 来 实现 重 叠的 查询 操 作 的 重 用。 实验 结 果表 明 , 算 法 能 够有 该

效地减 少连 续查 询 的执行 代价 总量 。 关 键词 :数 据流 ;查询树 ;查询 重 用 ;匹配

中图分 类号 :T 3 3 P9

常适合于分布式处理 , 如传 感器 网络 、 布式 网络监控 等 。相 分

r 和 T l rp C 等 ; a e gah Q e 另一类是 分布式数 据流管 理 系统 , 如

M e s 4 B r l _ 等。 目前 在大量数据 流应用 系统 中, 据 du a_J o a s e i5 数

、

是来 自于地理上分布 的数据 源或不 同 的 自治单元 。其 本身非

维普资讯

第2 5卷 第 2期 20 0 8年 2月

计 算 机 应 用 研 究

Ap l ai n Re e r h o mp t r p i t s a c fCo u e s c o

分布式数据流聚类算法

mo e aa tr r ban db M loi m ihi e s iet i a au . DAM — s e m rsn s e st ae lo tm d l rmeesaeo tie yE ag rt whc sn iv oi t l le p h s t n i v Dit a pe e t n i b s dag r h t r d y i o

c to c to hes se . ai n os ft y tm

Ke r s ds iu e aasra s cu trn ; d n i —a e ; mo e— ae ; d t nn ywo d : il b tdd t t m ; ls i g e st b sd r e e y d lb s d aamiig

0 引 言

为 了 适 应 Itme ne t传 感 器 网络 、 以及 P P 算 等 这 些 应 用 2计 的 要 求 , 布 式 数 据 流 挖 掘 技 术 尤 其 是 聚 类 分 析 成 为 当前 数 分

部站 点 不 能 传 送 聚 类 簇 的 完 整 描 述 ,而 是 传 递 每 个 簇 的近 似 概括 , 即簇 的 充 分 统 计 量 。中心 站 点 则 需 要 综 合 分 析 、 理各 处 个 局 部 站 点 上 传 的统 计 信 息 , 到 一 个 全 局 的聚 类 描 述 。 得

l we o o r mmu iai nc ss DAM — s e m, a l s rn lo t m o i i gd n i t o dmo e t o r p s d 1 l 1 c n c t o t, o Dit a r u ti g ag r h c mb n n e st meh da d l c e i y n meh di p o o e . 1e 一 s a

实时数据流处理中的流式计算与分布式处理策略

实时数据流处理中的流式计算与分布式处理策略在当今大数据时代,实时数据处理变得越来越重要。

实时数据流处理是一种处理连续流数据的方式,它可以快速而准确地分析、处理和提取有用的信息。

在实时数据流处理的过程中,流式计算和分布式处理策略是两个核心概念。

流式计算是指对流数据进行实时处理和计算的过程。

与传统的批处理不同,流式计算能够快速处理数据,并即时生成结果。

流式计算通常基于流数据的特点,它可以处理无限的数据流,而不需要事先知道数据的总量或到达时间。

流式计算可以实时地对数据进行过滤、聚合、计算和转换,从而得到有用的信息。

在实时数据流处理中,分布式处理策略是实现高效处理的关键。

分布式处理是将任务分发给多个计算节点,并将结果合并起来,以加快处理速度。

分布式处理能够充分利用多台计算机的计算资源,实现大规模数据的快速处理。

在分布式处理中,计算节点之间通过通信来交换数据和共享计算结果。

这样的分布式处理架构可以实现高可靠性和可扩展性,并能够适应不断增长的数据规模。

为了实现流式计算和分布式处理,一些流行的技术和工具被广泛使用。

Apache Kafka是一种开源的流式处理平台,它可以实现高吞吐量的实时数据流处理。

Kafka可以将数据流分发给多个消费者,并将结果写入到分布式存储系统中。

同时,Apache Flink是另一个流式计算框架,它支持快速而准确的数据流处理,并提供了丰富的操作符和API。

使用Flink,可以方便地进行流式处理和分布式计算。

在实时数据流处理中,处理大规模数据的效率和性能是非常关键的。

为了实现高效的数据处理,通常需要考虑以下几个方面的策略:1. 数据分区和并行计算:将数据划分成多个分区,并在多个计算节点上进行并行计算,可以充分利用计算资源,提高处理速度。

2. 任务优化和负载均衡:根据任务的复杂度和计算资源的可用性,优化任务的调度和分配,以确保计算节点的负载均衡,避免资源浪费和任务堵塞。

3. 状态管理和容错机制:在处理实时数据流时,通常需要维护一些状态信息。

一种改进的分布式数据流查询操作放置算法

Mu aj n ec e’ C l g , u aj n , el ga g 17 1 ,hn dni gT ahrS ol e M dni g H i nj n 5 0 3 C ia a e a o i

E Байду номын сангаас i c a aj @16cm — a :h i oi . l b e 2 o

CH a -i. rv d o e ao lcme t ag r h fr dsr ue a tem u r sCo u r E gne n n AI B o j I o e p rtr pae n l i m o i i td d t sra q ei . mp t n ier g a d e mp ot tb a e e i

A pi t n 。08 4 ( )13 1 6 p l ai s 2 0 。 4 S : 8 - 8 . c o

Ab t a t I s b t d Da a S r a Ma a e n y t ms o e  ̄o a e e e u e n d f r n r c s ig n d sI i r ia s s c : n Dit u e t te m n g me t S se , p r m r x c t d i i e e t p o e sn o e . s a c t l i- r i r f t i c s e t d t r n o e a o lc me t n u o e emi e p r t r p a e n i Di r u e D t S r a Ma a e n S se . o e ao lc me t lo t m b s d n si t d a a te m n g me t y tms tb An p r tr p a e n ag r h i a e o l tn y p c n p n r lx t n t c n lg s p o o e b e e t 1 t’ e a g rt m s u s t a h aa r c b t e ae c s a e a d s r g ea ai e h oo y i r p s d y P tr e a. i o Bu t l oi h h a s me h t t e d t a e ewe n t o o e  ̄o w p r m i o s n n d e n t c n i e h r lt i b t e h d t r c o a a sr a a d p rt r h r f r t i s c n t t a d o s ’ o sd r t e e ai t ewe n t e a a a e f d t te ms n o e ao T ee oe h s a vy

kafka ksql 查询语法

Kafka KSQL 查询语法Kafka是一款分布式流处理评台,可用于处理和分析实时数据流。

它的关键组件之一是Kafka Streams,它是一个库,可以让开发人员通过编写应用程序来处理和分析Kafka主题中的数据。

Kafka Streams 是用Java构建的,这限制了它的使用范围,不适合那些不熟悉Java 语言的开发人员。

为了解决这个问题,Confluent公司开发了KSQL,它是一种SQL查询引擎,可以让用户通过简单的SQL语句来处理实时数据流。

本文将介绍Kafka KSQL查询语法。

KSQL是一种基于SQL的流处理引擎,它可以用于处理Kafka主题中的数据流。

KSQL提供了一种简单而强大的方式来处理实时数据流,使开发人员能够通过简单的SQL语句来执行流处理操作。

下面是Kafka KSQL查询语法的详细介绍:1. 创建流在KSQL中,可以使用CREATE STREAM语句来创建一个流。

下面的语句创建了一个名为“user_actions”的流,该流从名为“user_actions_topic”的Kafka主题中获取数据:```sqlCREATE STREAM user_actions (user_id VARCHAR, action VARCHAR) WITH (kafka_topic='user_actions_topic',value_format='json');```2. 创建表另外,可以使用CREATE TABLE语句创建一个表。

下面的语句创建了一个名为“user_summary”的表,该表从名为“user_summary_topic”的Kafka主题中获取数据:```sqlCREATE TABLE user_summary (user_id VARCHAR, total_actions INT) WITH (kafka_topic='user_summary_topic',value_format='json', key='user_id');```3. 查询数据一旦创建了流或表,就可以使用SELECT语句来查询数据。

高效处理流式数据的常见算法与框架分析

高效处理流式数据的常见算法与框架分析高效处理流式数据的常见算法与框架分析随着大数据时代的到来,流式数据处理成为了重要的技术领域。

流式数据不仅数量庞大,而且具有时效性,需要及时、高效地处理。

在处理流式数据过程中,算法的选择和框架的使用至关重要。

本文将对高效处理流式数据的常见算法与框架进行分析,以期为读者提供指导和参考。

一、流式数据处理算法1. 滑动窗口算法滑动窗口算法是流式数据处理中常用的一种算法。

它通过将数据分为固定大小的窗口,然后在窗口内进行聚合操作或者计算窗口内的某些统计量。

滑动窗口算法可以有效处理连续的数据流,并在保证实时性的同时具备一定的容错性。

2. 布隆过滤器算法布隆过滤器算法是一种概率型的数据结构,用于判断一个元素是否存在于某个集合中。

在流式数据处理中,布隆过滤器可以用于去重,过滤掉已经出现过的数据,从而减少处理的数据量。

布隆过滤器的特点是占用内存较小,但可能会有一定的误判率。

3. 基于统计的算法基于统计的算法常用于流式数据的聚合操作和分析。

通过对数据流进行采样和统计,可以得到数据流的大致分布情况,进而可以进行一些预测和决策。

基于统计的算法在流式数据处理中可以帮助用户更好地理解和应用数据。

二、流式数据处理框架1. Apache StormApache Storm是一个开源的分布式实时计算系统,广泛应用于大规模流式数据处理场景。

它提供了高可靠性、容错性和可扩展性的特性,支持多种编程语言,并且易于集成其他数据处理工具和系统。

2. Apache FlinkApache Flink是另一个开源的流式数据处理框架。

它提供了丰富的流式数据处理算子和函数库,支持事件时间处理、窗口操作和迭代计算等。

Apache Flink具有低延迟、高吞吐量和exactly-once语义的特点,适用于流式数据处理的各种应用场景。

3. Apache KafkaApache Kafka是一个分布式流式数据平台,用于高吞吐量的数据订阅与发布。

ignite 分布式计算

ignite 分布式计算Ignite是一种开源的分布式计算平台,专注于高性能和可扩展性。

它提供了一套强大的工具和库,可以用于在大规模集群上进行分布式计算,处理大量的数据和高负载的应用程序。

Ignite的设计目标是让开发人员能够轻松地利用分布式系统的潜力,实现高性能和可靠的分布式计算。

它提供了许多功能,包括内存计算、集群服务、分布式数据结构、分布式SQL、流式处理、机器学习、事件和消息驱动编程等。

下面将详细介绍Ignite的一些关键特性。

首先,Ignite支持内存计算。

它可以将数据存储在内存中,从而实现快速访问和处理。

内存计算可以大幅提升计算性能,特别适用于需要处理大量数据的任务。

Ignite的内存计算功能可以极大地加速大规模分布式计算任务的执行。

其次,Ignite提供了分布式数据结构。

这些数据结构包括分布式集合、映射、队列、栈等,可以在集群中分布式地存储和访问数据。

开发人员可以使用这些数据结构来设计高效的分布式算法和应用程序。

Ignite还提供了事务支持,确保数据一致性和可靠性。

Ignite还提供了分布式SQL。

开发人员可以使用标准的SQL语句来查询分布式数据,并且可以在整个集群中执行这些查询。

这使得开发人员无需编写复杂的分布式代码,就可以以常规的方式进行查询和处理数据。

分布式SQL的功能大大简化了开发人员的工作,提高了代码的可读性和可维护性。

此外,Ignite还支持流式处理和机器学习。

开发人员可以使用Ignite的流式处理功能来处理实时数据流,对数据进行过滤、转换和聚合操作。

这对于处理大量产生的实时数据非常有用,如物联网应用程序、日志处理和实时分析等。

Ignite的机器学习功能则提供了一套强大的算法和工具,用于训练模型和进行预测分析。

Ignite还提供了集群服务和事件驱动编程。

集群服务可以在集群中的节点之间进行通信和协调。

开发人员可以使用这些服务实现分布式锁、计数器、计时器等功能。

事件和消息驱动编程则允许开发人员基于事件来设计和实现分布式应用程序。

flink sql insert into原理

Flink SQL:深入理解INSERT INTO原理导语:Apache Flink 是一种开源分布式流处理和批处理框架,具有出色的容错性和高效的数据处理能力。

Flink SQL 是Flink 的SQL 查询引,使用户能够使用SQL 语句来查询和处理数据流。

本文将深入探讨Flink SQL 中的INSERT INTO 语句的原理和工作方式。

一、INSERT INTO 简介INSERT INTO 是一种SQL 语句,用于向数据库表中插入新的行。

在Flink SQL 中,INSERT INTO 语句用于将计算结果写入表或者其他存储系统。

二、INSERT INTO 的执行流程1. 解析和验证:Flink SQL 在执行INSERT INTO 语句之前,首先需要对SQL 语句进行解析和验证。

这个过程包括语法解析、语义解析和类型检查等步骤,确保SQL 语句的正确性和合法性。

2. 查询计划生成:一旦SQL 语句通过验证,Flink SQL 将生成一个查询计划。

查询计划是一个逻辑和物理执行计划的树形结构,描述了如何对输入数据进行计算和转换。

3. 数据转换和计算:查询计划被翻译成一个Flink 数据流程序,可以在Flink 的分布式计算引擎上执行。

在执行过程中,Flink 会根据查询计划的逻辑进行数据转换和计算操作。

4. 结果写入:当计算完成后,Flink SQL 将根据INSERT INTO 语句中指定的目标表或者存储系统,将计算结果写入到相应的位置。

这可能涉及到网络传输、数据序列化和存储等操作。

三、INSERT INTO 的性能优化为了提高INSERT INTO 的性能和效率,可以采取以下一些优化措施:1. 批量写入:将多个计算结果批量写入目标表,可以减少网络传输和存储操作的开销,提高写入效率。

2. 异步写入:将写入操作异步化,不阻塞主线程的执行,可以提高整体处理能力和响应性能。

3. 分区写入:将数据按照不同的分区进行写入,可以提高并行处理能力和写入吞吐量。

分布式数据流连接查询算法

近几年,数据流管理 已经成为数据库领域 的一个研究热

点。 数据流管理系统 的连接操作与关系数据库有较大的/ 同, I

足通 过分解并发的连接请求 ,台 并j 同的连接谓训 ,形成分布式查询操作算 于;二是数 流住 符分布式代理( e I I : I I l l流转实现部分连接 , 1 I ) 井在查询引擎处组 台成最终 结果 D J i 算法采用了 ・ M3o n 种类似路 d表的结构执 行窗口连接 ,山于一 以 l J 『 1 遍。分析和实验证 明,该连 接算法是高放 的。 l 问结 果,算法H需扫 描数据 I I

apoc a dDM3oni po o e . p rahnme Ji rp sd DM3onc nito’w at On ) eo oecn urn lq ey meg h a 0npe i t s J i o ss t oprs ei t d c mp s o c r t l u r, retesmeji rdc e s t s( e a

o e ed ts ems ic i ee tonq eis hr eitr da eut T e x ei , sl h w ta te loi m f cie v rh aa t a nedf rn i u r aeh eme iersl . h pr md eut so th g rh ief t . t r s j es t n t s e me r s h a t s e v [ yw r s D t sersWid w』 i; o t u u u r sDitbtdss m Ke o d ] aa t an ; no on C ni o s ei ; sr ue t r n q e i ye

rsl u r e gn. feetrm m so te loi msteag rh xc t n o is e omslearue n e d nyo e c n eut i q ey n i Di rn f o t f hr g rh ,h loi m ee ue wid wj n r r k tr dne s l n a sn e f o o a t t s o pf i o a o s

流式查询原理

流式查询原理随着互联网技术的日益发展,大数据处理成为数据科学领域的重要分支之一。

而流式查询原理就是这个领域的一个核心概念。

流式查询的核心是通过不间断地采集和处理数据流来实现实时数据处理。

随着技术的不断革新,如今的流式查询已经成为各种业务场景中的利器。

那么,流式查询是如何实现的呢?第一步:数据采集流式查询的第一步是采集数据。

数据采集的方式非常多,可以是传感器的数据、日志系统的数据、web服务器的数据,也可以是社交媒体等多种数据源。

数据的采集方式可以是异步的或者同步的,可以采用批量传输的方式,也可以是单条数据。

在数据采集的过程中,需要保证数据的正确性和完整性,同时要考虑数据的实时性,保证数据的即时性以及连续性。

第二步:数据存储采集到的数据需要存储下来以供后续的处理。

流式查询通常使用分布式数据存储技术,例如NoSQL、Hadoop、HBase、Cassandra等。

在存储数据的过程中,需要考虑数据的可靠性和数据的分布式特性,以保证数据的可扩展性和高性能。

第三步:数据处理在数据存储完成后,需要进行一系列的数据处理,以获取有用的信息。

数据处理包括数据的过滤、聚合、排序等操作。

流式查询采用持续推动式与事件驱动方式实时处理大量不规则数据。

数据处理过程需要保证高效率实现,数据处理的算法需要具有较高的容错能力和可扩展性。

第四步:数据输出在数据处理之后,需要将处理结果输出。

数据输出可以是实时的也可以是非实时的,可以是文件也可以是数据库。

流式查询的数据输出通常是以实时的形式向业务系统提供数据。

需要注意保证数据的传输安全和准确性,同时也要保证数据的格式规范以便后续处理。

综上所述,流式查询原理是在数据采集、存储、处理和输出的完整流程中实现实时数据处理的一种技术。

它能够实现对大量数据的快速处理和分析,并为各种企业业务场景提供一站式数据处理的解决方案。

随着人工智能、物联网等技术的发展,流式查询必将成为数据处理的重要途径。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

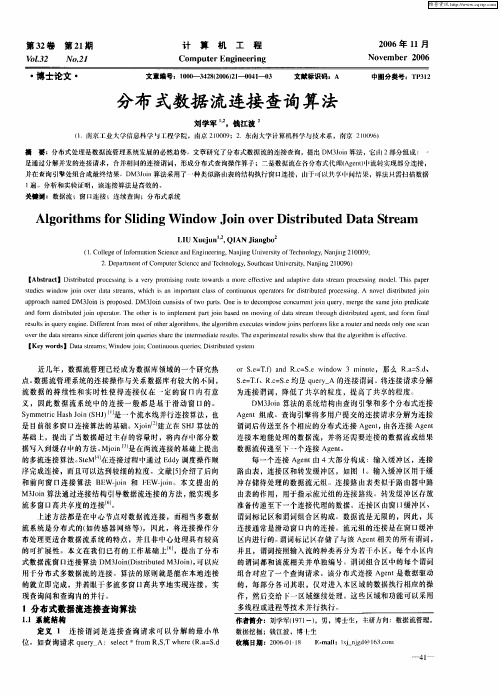

第31卷 第3期2009年2月武 汉 理 工 大 学 学 报JOURNA L OF WUHAN UNIVERSIT Y OF TECHN OLOG Y Vol.31 No.3 Feb.2009DOI :10.3963/j.issn.167124431.2009.03.008一种分布式数据流连接查询算法郭庆平1,欧阳琳2(1.武汉理工大学计算机科学与技术学院,武汉430070;2.武汉理工大学信息工程学院,武汉430070)摘 要: 分布式处理是数据流管理系统发展的必然趋势。

研究了分布式数据流系统中的基于滑动窗口的连接操作,提出了DMS 2Join 算法。

通过将多连接操作中的子操作分解置于不同的网络节点上,以减少数据的传输。

分析与实验结果表明,DMS 2Join 算法具有较高的查询性能。

关键词: 数据流; 分布式; 连接查询中图分类号: TP 31文献标识码: A 文章编号:167124431(2009)0320029204A Join Q uery Algorithm for Distributed Data StreamsGU O Qi ng 2pi ng 1,O U YA N G L i n 2(1.School of Computer Science and Technology ,Wuhan University of Technology ,Wuhan 430070,China ;2.School of Information Engineering ,Wuhan University of Technology ,Wuhan 430070,China )Abstract : Following the development of database technology ,distributed data stream 2processing system becomes a hot re 2search field.In this paper ,we research on sliding window based join query ,and propose a distributed multi data streams join query algorithm DMS 2Join.By rearranging sub join query and locating them on various nodes ;it can decrease the data trans 2portation.The experimental results show that the algorithm is effective.K ey w ords : data stream ; distributed ; join query 收稿日期:2008210210.作者简介:郭庆平(19452),男,教授,博导.E 2mail :qpguo @近年来,处理大量输入数据流的新应用正变得越来越普遍,如网络监视、通信数据管理、传感器网络数据处理、金融分析、交通管理以及环境监测等。

这些应用具有几个共同的特点:数据量巨大;数据持续不断到达且没有边界;具有一定的实时性;数据具有时效性。

数据流的这些特点,对数据库管理技术提出了巨大的挑战。

连接操作是数据库管理系统的一种重要操作,在数据流管理系统中的连接操作与关系数据库有较大的不同,流数据的持续性和实时性使得连接操作仅在一定的窗口中有意义。

因此,数据流系统中的连接操作一般都是基于滑动窗口(sliding window )的。

Viglas 等人提出了一种基于速率的连续查询优化模型[1]。

Kang 等人提出了一种内存约束条件下的非对称连接算法[2]。

X Join 在SH J (Symmetric Hash Join )的基础上,提出了当数据超过主存容量时,将内存中的部分数据写入缓存的方法[3]。

MJoin 是在2流连接的基础上,提出的多流连接算法,它除了为每一个数据流规划一个单独的查询计划外,并不维护中间结果[4]。

SteM 在连接过程中使用Eddy 算子操作顺序完成连接[5]。

Hammad 等人提出了后向和前向连接算法B EW 2Join 和FEW 2Join [6]。

G omes 等人提出了一种固定顺序的多流连接优化算法FODP [7]。

这些算法都是集中式连接算法,所以连接操作均在一个中心节点完成。

由于数据流系统天然的分布性,将连接操作分布处理更适合数据流系统的特点。

在分布式环境下,网络传输带宽是一定的。

在网络传输结束条件下,如何有效地完成多数据流的分布式连接操作,是一个值得研究的课题。

针对这一问题,提出了一种基于滑动窗口的分布式多数据流连接03 武 汉 理 工 大 学 学 报 2009年2月算法(DMS2Join),DMS2Join算法相对于集中式臬法具有良好的性能。

1 DMS2Join算法数据流系统中的数据流通常分布在各个不同的地方,集中式处理方式中,所有的数据流都直接传输到中心处理节点,由此中心节点进行统一处理。

由于数据量通常很大,传输全部的数据需要消耗大量的网络带宽,同时造成较大的数据延迟。

通过将连接操作前移至数据流源节点,可以有效地减小数据的传输。

提出的DMS2Join算法,可以有效地减少网络中数据的传输,从而提高系统性能。

1.1 系统开销计算有n条数据流R1,R2,…,R n,数据流R i={x1,x2,…,x w}由一系列数据元组x i组成。

用a(i)表示数据流R i的数据到达率,用w(i)表示数据流R i的滑动窗口大小。

对于定序连接查询O=R1 R2 … R n,整个连接操作形成一棵连接树,每一个叶子节点代表一条数据流,每一个非终端节点代表每一次二元连接操作的中间结果,根节点代表最终的多数据流连接结果O。

定序连接中,各个输入之间可以组合,但不可交换。

s=l r,其中l,r表示数据流R i的叶子节点或者代表中间结果的非终端节点。

中间结果的数据流窗口大小用w(s)表示,其值可由公式1计算得到w(s)=w(l)・w(r)・pj(s)(1)其中,w(l)和w(r)分别表示查询操作树的左子树和右子树的数据流窗口大小,当左右子树为叶子节点时,即位于数据流入口所在节点时,其值分别为a(l)和a(r)。

pj(s)表示连接操作在节点s的连接率。

假设每个数据流中的连接属性变量服从均匀分布,则连接操作的连接率可用公式2计算pj(s)=1/max(dv(l),dv(r))(2)其中,dv(l)和dv(r)分别表示左子树和右子树的数据流的不同取值数。

对于其它类型的分布,可使用不同的连接率计算算法,以更好地估计连接操作的中间输出结果。

算法1DMS2Join算法1:初始化尚未连接的数据流信息;2:cost total=03:for i=0to stream num-1do4:{计算最小代价的连接操作;}5:cost min←∞;6:for j=0to stream num-1-i do7:for k=0to nodes do8:计算相邻数据流在节点k上运行时的开销cost(1,r,k)←max(out(1)・w(r)+out(r)・w(1))・pj(s);9:if cos(1,r,k)<cost min then10:计算dv←1/max(dv(1),dv(r));11:计算pj←1/max(dv(1),dv(r));12:计算out←(out(1)・w(r)+out(r)・w(l))・pj;13:记录相对应的网络节点和右数据流号;14:end if15:end for16:end for17:更新尚未连接数据流信息;18:cost total=cost total+cost min;19:end for每一个节点的输出数据元组的个数可由公式3计算得到out(s)=(out(l)・w(r)+out(r)・w(l))・pj(s)(3)其中out (s )表示当l 或者r 中有新的数据元组到达时,连接操作所增加的数据元组数,即新增的部分连接结果。

设一个有n +1个节点的网络,其中前n 个节点分别与n 个数据流R i 相连,第n +1个节点用于返回连接查询结果。

所有的子二元连接操作均可位于网络中的任意一个节点。

用nv (i ,j )表示节点i 与j 之间的网络连接速度(用单位时间所能处理的数据元组个数表示)。

nv (i ,i )=∞。

为了简化算法,假定系统中的每一个节点都有足够大的内存来保存中间结果。

每一次二元连接操作的开销用cost (s )表示,其值可用公式4计算cost (s )=max (out (l )/nv (l ,s ),out (r )/nv (r ,s ))(4)cost (s )表示l 与r 连接操作时网络传输代价(由于每条数据流的滑动窗口大小不会太大,并且插入、删除与匹配数据元组都能在内存中完成,相对于网络传输而言其开销可以忽略不计)。

1.2 算法描述DMS 2Join 算法中,所有节点组成一个网络,每一个子连接操作包括两条数据流,并将运行于网络中的某一个节点。

整个连接操作由多个子连接操作组成。

算法首先初始化尚未连接的数据流信息;然后根据数据流源的流速,以及子二元连接操作的连接率,利用式(4)计算并找出代价最小的一对二元连接操作以及运行此子连接操作的网络节点,之后将这一对数据流从尚未连接数据流信息表中删除;同时,根据公式3估计此子连接操作的中间结果大小,并将此结果大小做为下一级连接操作的输入之一,插入尚未连接数据流信息表中;根据新的尚未连接数据流信息表,反复计算,直至所有数据流全部参与连接操作,从而最终得到一棵查询计划树。

算法的计算复杂度为O (m 2・n ),其中m 为数据流条数,n 为网络节点个数。

DMS 2Join 算法描述见算法1。

2 实验与分析为了验证算法的有效性和性能,我们将DMS 2Join 算法和集中式算法进行了仿真实验。

实验中一共有9条数据流R 1,R 2,…,R 9和10个网络节点N 1,N 2,…,N 10,9条数据流分别位于9个网络节点,余下的一个网络节点N 10用于返回查询结果。

同时假设所有数据流连接属性变量的取值个数dv 相等,滑动窗口大小w 也相等。

在集中式算法中,整个连接操作运行在网络节点N 10上(假设N 10有足够大的内存和性能)。

图1反映了在滑动窗口大小固定,数据流不同取值个数不同的情况下,DMS 2Join 算法和集中式算法系统开销比。

随着数据流不同取值个数dv 的增大,系统开销比率不断减小,分布式算法性能越好。

图2反映了在dv 值固定,数据流滑动窗口大小不同的情况下,2种算法的开销比。