K-means分类中K的最优值实例分析

k-means算法

k-means算法k-means算法是无监督学习领域最为经典的算法之一。

接触聚类算法,首先需要了解k-means算法的实现原理和步骤。

本文将对k-means算法的基本原理和实现实例进行分析。

希望对喜欢机器学习的童鞋们,有一定的帮助和启发。

首先看看wiki上对k-means算法的基本阐述。

k-means clustering is a method of vectorquantization, originally from signalprocessing, that is popular for clusteranalysis in data mining. k-means clusteringaims to partition n observations into kclusters in which each observation belongs tothe cluster with the nearest mean, serving asa prototype of the cluster.可以看出,k-means算法就是将 n 个数据点进行聚类分析,得到 k 个聚类,使得每个数据点到聚类中心的距离最小。

而实际上,这个问题往往是NP-hard的,以此有许多启发式的方法求解,从而避开局部最小值。

值得注意的是,k-means算法往往容易和k-nearest neighbor classifier(k-NN)算法混淆。

后者是有监督学习的分类(回归)算法,主要是用来判定数据点属于哪个类别中心的。

A simple example for k-means clusteringk-means算法有很多应用:•图像分割(Image Segmentation)•基因分割数据聚类分析(Clustering GeneSegementation Data)•新闻聚类分析(News Article Clustering)•语言聚类分析(Clustering Languages)•物种分析(Species Clustering)•异常检测(Anomaly Detection)•\cdots数学描述给定数据集 X=\{x^{(1)},x^{(2)},\cdots,x^{(n)}\} ,其中每个数据样本 x^{(i)}\in \mathbb{R}^d . k-mean算法旨在将 n 个数据点划分为 k(k\leq n) 个聚类集合\bm{S}=\{S_1,S_2,\cdots,S_k\} ,使得每个聚类集合中的样本点与聚类中心的距离平方和最小(WCSS, within-cluster sum of squares),i.e. 方差最小。

kmeans matlab 最佳聚类数

K-means算法是一种常用的聚类算法,它通过迭代将数据集划分为K个不同的簇,使得每个数据点都属于与其最近的簇。

在实际应用中,确定最佳的聚类数K是非常重要的,因为它直接影响了聚类的效果和结果的可解释性。

在Matlab中,我们可以使用kmeans函数来实现K-means聚类算法。

然而,对于给定的数据集,如何选择最佳的聚类数K仍然是一个挑战。

下面将介绍一些常用的方法来确定最佳的聚类数K,并结合Matlab的实现来说明。

1. 肘部法则(Elbow method)肘部法则是一种直观的方法,它通过绘制不同聚类数K下的聚类效果图,并观察随着K的增大,聚类效果的提升趋势。

当K增大到一定程度之后,聚类效果的提升趋势会变得平缓,这一点通常被称为“肘部”,也就是最佳的聚类数K。

在Matlab中,可以使用kmeans函数计算不同K下的聚类效果,并结合绘图函数plot来实现肘部法则的判断。

2. 轮廓系数(Silhouette coefficient)轮廓系数是一种定量的方法,它通过衡量每个数据点与所属簇的相似度,来评估聚类的效果。

轮廓系数的取值范围在[-1, 1]之间,值越大表示聚类效果越好。

在Matlab中,可以使用silhouette函数来计算轮廓系数,并结合绘图函数bar来对不同聚类数K下的轮廓系数进行可视化分析。

3. 间隔统计量(Gap statistic)间隔统计量是一种比较复杂的方法,它通过对比原始数据集和随机生成数据集的聚类效果来评估最佳的聚类数K。

在Matlab中,可以使用evalclusters函数来计算间隔统计量,并结合绘图函数plot来确定最佳的聚类数K。

总结而言,确定最佳的聚类数K是K-means算法中的一个重要问题,对于不同的数据集和应用场景,选择合适的方法来确定最佳的K是非常重要的。

在Matlab中,可以结合肘部法则、轮廓系数和间隔统计量等方法来进行综合分析,从而确定最佳的聚类数K。

希望本文介绍的方法能够为使用Matlab进行K-means聚类分析的研究人员和工程师提供一些参考和帮助。

K均值聚类算法优缺点

J.B.MacQueen 在 1967 年提出的K-means算法[22]到目前为止用于科学和工业应用的诸多聚类算法中一种极有影响的技术。

它是聚类方法中一个基本的划分方法,常常采用误差平方和准则函数作为聚类准则函数,误差平方和准则函数定义为:(3-1)其中,是类中数据对象的均值,即,(j=1,2,…,n),是K个聚类中心,分别代表K个类。

K-means算法的工作原理:算法首先随机从数据集中选取 K个点作为初始聚类中心,然后计算各个样本到聚类中的距离,把样本归到离它最近的那个聚类中心所在的类。

计算新形成的每一个聚类的数据对象的平均值来得到新的聚类中心,如果相邻两次的聚类中心没有任何变化,说明样本调整结束,聚类准则函数已经收敛。

本算法的一个特点是在每次迭代中都要考察每个样本的分类是否正确。

若不正确,就要调整,在全部样本调整完后,再修改聚类中心,进入下一次迭代。

如果在一次迭代算法中,所有的样本被正确分类,则不会有调整,聚类中心也不会有任何变化,这标志着已经收敛,因此算法结束。

算法描述如下:算法:K-means。

划分的 K-means 算法基于类中对象的平均值。

输入:类的数目K和包含N个对象的数据库。

方法:① 对于数据对象集,任意选取K个对象作为初始的类中心;② 根据类中对象的平均值,将每个对象重新赋给最相似的类;③ 更新类的平均值,即计算每个类中对象的平均值;④ Repeat ②③;⑤ 直到不再发生变化。

其中,初始聚类中心的选择对聚类结果的影响是很大的,如图3.1,图a是三个类的实际分布,图b是选取了好的初始聚类中心(+字标记的数据对象)得到的结果。

图c是选取不好的初始聚类中心得到的结果,从中可以看到,选择初始聚类中心是很关键的。

a b c图3.1基于K-means算法的一组对象的聚类算法的数据描述为:把n个向量(j=1,2,…,n)分成c个类( i=1,2,…,c) ,并求每类的聚类中心,使得非相似性(或距离)指标的目标函数达到最小。

K-means分类中K的最优值选取

K-means分类中K的最优值选取在聚簇大的数据集时,K-means算法是被广泛应用的十分有效的算法之一,是典型的基于原型的目标函数聚类方法的代表,K-means的实现需要事先给定确定值k,但在实践的过程中k很难被精确地确定,使得该算法无法应用于某些具体问题。

本文的目的在于通过研究不同k值的数据,计算不同k值的组内距离平方和函数)W并作出图像,以此来确定k的最优值。

分析数据并用具体算法以确定k(最优k值,有助于为解决实际问题提供重要参照,促进K-means算法在更广泛的领域达到更精确的应用。

数据挖掘是数据库研究、开发和应用最活跃的分支科学之一,从大量数据中用非平凡的方法发现有用的知识和人们感兴趣的数据模式成了人们的一种自然需求[1]。

现如今,数据的爆炸式增长、广泛可用和巨大数量使得我们的时代成为真正的数据时代[1]。

随着数据挖掘研究的蓬勃发展,出现很多数据挖掘的方法,其中聚簇是最基本的方法,而在聚簇方法中,K-means算法是最著名和最常用的划分法之一。

K-means算法是一种硬聚类算法,是典型的基于原型的目标函数聚类方法的代表。

K-means算法的基本思想是初始随机给定K个簇中心,按照最邻近原则把待分类样本点分到各个簇。

然后按平均法重新计算各个簇的质心,从而确定新的簇心。

一直迭代,直到簇心的移动距离小于某个给定的值。

关于K-means算法,前人已经做了很多工作,1967年MaQueen就提出了K-means算法[2],他总结了Cox[3]、Fisher[4]、Sebestyen[5]等的研究成果,给出了K-means算法的详细步骤,并用数学方法进行了证明。

而早在1975年Hartigan就在其专注《Clustering Algorithms》[6]中对聚类算法进行了系统的论述。

K-means的实现需要事先给定确定值k,但在实践的过程中K很难被精确地确定,使得该算法无法应用于某些具体问题,研究K-means算法中K的最优值的选取,有助于为解决实际问题提供重要参照,促进K-means算法在更广泛的领域达到更精确的应用。

kmeans应用案例

kmeans应用案例Kmeans应用案例。

Kmeans是一种常用的聚类算法,它可以将数据集分成不同的组别,每个组别内的数据点之间的相似度较高,而不同组别之间的数据点相似度较低。

Kmeans算法在数据挖掘、模式识别、图像分割等领域有着广泛的应用。

下面我们将介绍Kmeans算法在实际应用中的一些案例。

首先,Kmeans算法在市场细分中的应用。

在市场营销中,我们经常需要对客户进行细分,以便更好地了解客户的需求和行为习惯。

Kmeans算法可以根据客户的消费行为、地理位置、年龄等特征,将客户分成不同的群体,从而帮助企业更好地制定营销策略,提高营销效果。

其次,Kmeans算法在医学影像分析中的应用。

在医学影像分析领域,医生需要对大量的影像数据进行分析,以辅助诊断和治疗。

Kmeans算法可以对医学影像数据进行聚类,将相似的影像分成一组,有助于医生更快地找到病变区域,提高诊断的准确性。

另外,Kmeans算法在推荐系统中也有着重要的应用。

在电商平台、社交媒体等应用场景中,推荐系统可以帮助用户发现他们感兴趣的产品或内容。

Kmeans算法可以根据用户的历史行为和偏好,将用户分成不同的群体,从而为用户推荐更符合其兴趣的产品或内容,提高推荐的准确性和用户满意度。

此外,Kmeans算法还可以在无人驾驶领域中发挥重要作用。

无人驾驶汽车需要对周围环境进行感知和理解,Kmeans算法可以对传感器获取的数据进行聚类,识别出不同的交通参与者、道路情况等,从而帮助无人驾驶汽车更好地做出决策,确保行车安全。

总的来说,Kmeans算法在各个领域都有着广泛的应用,它可以帮助我们更好地理解和利用数据,从而提高工作效率和决策的准确性。

随着人工智能和大数据技术的发展,相信Kmeans算法在未来会有着更广阔的应用前景。

kmeans k值最优算法

kmeans k值最优算法k-means算法是一种常用的聚类算法,它通过将数据集划分为k个簇来实现数据的分类和聚类。

在k-means算法中,选择合适的k值非常重要,因为k值的选择直接影响到聚类的效果和准确性。

本文将介绍k-means算法中如何选择最优的k值。

我们需要了解k-means算法的基本原理。

k-means算法的核心思想是将数据集划分为k个簇,每个簇都有一个代表点,称为簇中心或质心。

算法的步骤如下:1. 随机选择k个样本作为初始质心;2. 将每个样本点分配给距离其最近的质心所在的簇;3. 根据每个簇中的样本点重新计算质心的位置;4. 重复步骤2和3,直到质心不再改变或达到最大迭代次数。

在k-means算法中,k值是需要我们指定的。

选择合适的k值是非常重要的,因为一个恰当的k值可以更好地刻画数据的特征和结构。

下面介绍几种常见的选择k值的方法。

一、手肘法:手肘法是一种常用的选择k值的方法。

它的基本思想是随着k值的增大,簇内误差平方和(SSE)会逐渐减小。

当k值增大到一定程度后,再增加一个簇所能带来的SSE的减小效果会逐渐变小。

因此,我们可以选择使得SSE减小幅度显著降低的k值作为最优的k值。

二、轮廓系数法:轮廓系数是一种用于评价聚类效果的指标,它综合了簇内的紧密度和簇间的分离度。

轮廓系数的取值范围是[-1,1],越接近1表示聚类效果越好,越接近-1表示聚类效果越差。

因此,我们可以选择使得轮廓系数最大的k值作为最优的k值。

三、Gap统计量法:Gap统计量是一种基于随机抽样的方法,用于选择最优的k值。

它的基本思想是将原始数据集与随机生成的参考数据集进行对比,通过比较两者的聚类效果来选择最优的k值。

Gap统计量的计算公式比较复杂,不在本文中展示。

我们可以选择使得Gap统计量最大的k值作为最优的k值。

四、经验法:经验法是一种基于经验和领域知识的选择k值的方法。

根据实际问题的特点和领域知识,我们可以根据经验来选择合适的k值。

K-means算法详解

算法实例

O x y

1

2 3 4 5Βιβλιοθήκη 00 1.5 5 5

2

0 0 0 2

数据对象集合S见表1,作为一个聚类分析的二 维样本,要求的簇的数量k=2。 O (1)选择 O1 0,2 , 2 0,0 为初始的簇中心, 即 M 1 O1 0,2 , M 2 O2 0,0 。 (2)对剩余的每个对象,根据其与各个簇中心的 距离,将它赋给最近的簇。 对 O3 : 2 2

0 5

0 5

2

2 2

2

2

5

29

1

5

5

2

0 2

• 因为 d M 1 , O 5 d M 2 , O 5 所以将 O 5分配给 C

• 更新,得到新簇

E1 0 0

2 2

C1 O1 ,O5

和

2

C 2 O 2 , O 3 , O 4

xi1,xi2,„xid和xj1,xj2,„xjd分别是样本xi和xj对应d个描 述属性A1,A2,„Ad的具体取值。 • 样本xi和xj之间的相似度通常用它们之间的距离d(xi,xj) 来表示,距离越小,样本xi和xj越相似,差异度越小;距

离越大,样本xi和xj越不相似,差异度越大。

欧式距离公式如下:

d xi , x j

x

d k 1

ik

x jk

2

平均误差准则函数

• K-means聚类算法使用误差平方和准则函数来评价聚类 性能。给定数据集X,其中只包含描述属性,不包含类别

属性。假设X包含k个聚类子集X1,X2,„XK;各个聚类子集

中的样本数量分别为n1,n2,„,nk;各个聚类子集的均值代 表点(也称聚类中心)分别为m1,m2,„,mk。 • 误差平方和准则函数公式为:

K均值算法中的K值选择方法

K均值算法(K-means algorithm)是一种常见的聚类算法,它能够将一组数据点分成K个不同的簇。

在K均值算法中,最重要的一步就是选择合适的K值,也就是确定数据点应该被分成多少个簇。

K值的选择会直接影响到聚类的效果,因此如何选择K值是K均值算法中的一个关键问题。

一般来说,K值的选择方法可以分为基于经验的方法和基于数学计算的方法。

基于经验的方法是指根据对数据的直观理解和经验来确定K值,而基于数学计算的方法则是通过数学模型和算法来确定K值。

基于经验的方法是最直观的选择K值的方法。

它可以根据对数据的了解和经验来选择K值,比如通过可视化数据来观察数据的分布情况,然后根据经验来确定K值。

这种方法的优点是简单易行,不需要太多的数学知识,但缺点是容易受主观因素的影响,选择出的K值可能不够准确。

除了基于经验的方法,还有一些基于数学计算的方法可以帮助我们选择K值。

其中比较常见的方法有肘部法则(elbow method)、轮廓系数(silhouette score)和DB指数(Davies-Bouldin index)。

肘部法则是一种常见的基于数学计算的K值选择方法。

它的基本思想是随着K值的增大,簇内的平方和误差(SSE)会逐渐减小,直到某个K值之后,SSE的下降速度会急剧减缓,形成一个肘部状的曲线。

这个肘部点对应的K值就可以作为最佳的K值。

肘部法则的优点是简单易行,但缺点是对于一些数据集来说,肘部并不明显,导致选择K值有一定的困难。

轮廓系数是另一种常用的基于数学计算的K值选择方法。

它结合了簇内的紧密度和簇间的分离度,用来衡量聚类的效果。

对于每个数据点,轮廓系数可以通过计算其与同簇内其他数据点的距离(a)和与最近其他簇的数据点的距离(b)来得到。

然后对于每个数据点,轮廓系数可以通过计算(b - a) / max(a, b)来得到,最后对所有数据点的轮廓系数取平均值,得到整个数据集的轮廓系数。

轮廓系数的取值范围在-1到1之间,越接近1表示聚类效果越好。

kmeans聚类算法python案例

标题:探究K均值聚类算法在Python中的实际应用1. 介绍K均值聚类算法是一种常见的无监督学习算法,广泛应用于数据分析、模式识别和图像处理等领域。

本文将深入探讨K均值聚类算法在Python中的实际应用,并通过实例演示其在数据聚类中的效果和价值。

2. K均值聚类算法简介K均值聚类算法是一种基于计算距离的聚类方法,其核心思想是将数据集划分为K个簇,并使每个数据点都属于距离最近的簇中心。

通过迭代更新簇中心的位置,最终实现簇内数据点的相似性最大化,簇间数据点的相似性最小化。

K均值聚类算法的主要优点是简单易实现,但也存在对初始聚类中心敏感、对异常值敏感的缺点。

3. K均值聚类算法Python实现在Python中,我们可以使用scikit-learn库中的KMeans类来实现K均值聚类算法。

我们需要导入所需的库和模块,然后准备数据集并进行标准化处理。

接下来,我们可以通过KMeans类来拟合数据并进行聚类分析,最终得到每个数据点所属的簇标签。

4. K均值聚类算法实例分析我们以一个实际案例来演示K均值聚类算法的应用。

假设我们有一个包含多个维度的数据集,并希望将其划分为三个簇。

我们可以通过Python代码来实现K均值聚类算法,并可视化展示聚类结果。

通过分析实例,我们可以深入理解K均值聚类算法在实际应用中的效果和局限性。

5. 总结与展望本文通过深入探究K均值聚类算法在Python中的实际应用,对该算法的原理、实现和实例进行了全面评估。

通过此次学习,我们理解了K均值聚类算法在数据分析中的重要性和实用性。

但也需要注意到K均值聚类算法对初始聚类中心的敏感性,并且在处理大规模数据时的效率问题。

未来,我们可以进一步研究改进的K均值聚类算法及其在更多领域的应用。

6. 个人观点作为我的文章写手,我对K均值聚类算法的个人观点是,它是一种简单而有效的聚类算法,在实际应用中具有较好的效果。

但在处理大规模高维数据时,需要结合其他聚类算法来提高效率和准确性。

K-Means算法中K值的确定

K-Means算法中K值的确定聚类算法在数据处理中有广泛的应用,K-Means算法是一种较为常用且有效的聚类算法。

但它有一个缺点,在进行算法之前需要预先给出聚类的个数。

因此,如何在K-Means算法中确定合适的K值成为该算法的一大问题。

本文讨论了几种常用的确定K值的方法,并详细讨论了一种利用评价函数判断K值好坏的方法,之后在若干个数据集中进行了测试,取得了较好的效果。

1.1 聚类算法的演变正所谓,物以类聚,人以群分。

将可识别的物体进行分类一直以来都是符合人类的基本认知规律的。

早在公元前三世纪的古希腊,分类学就已经作为一门科学盛行于当下,而作为其代表人物的亚里士多德不仅对五百余种不同的动植物进行了分类,还对五十余种动物进行了解剖,并首先指出鲸鱼是胎生的。

我国著名医药学家李时珍外出至我国的各大名山大川考察,尝遍百草,将千余种植物分为五部,三十类。

俄罗斯著名化学家门捷列夫更是首创了元素周期表,将化学元素依其质子数分门别类,并以此对一些尚未被发现的元素作出预言。

可以看到的是,不论在人类的何种时期,将事物分门别类都是一个恒久的问题。

在工业时代之前,通过人工的方法进行分类尚且是没有问题的。

然而,在信息革命后的今天,我们若还是一味的依赖传统方法,就将难逃被时代淘汰的命运。

因为信息时代所需要分门别类的,是海量的数据。

而面对这样规模的数据,人工的方法将会有过大的消耗,再加上人类对于数据的认知是十分抽象的,缺乏直观的认识,因此其效果大打折扣。

面对这些问题,聚类分析应运而生。

聚类分析,又名群分析。

它以相似性为基础,在没有鲜艳信息的前提下,将看似无序的研究样本分类成多个类簇。

其原则是组内的相似性较高,而组间的相似性较低。

它的起源便是上文所提到的分类学。

在早期的分类学中,人们主要依靠经验和专业知识进行分类。

纵观人类科技发展史,随着科技进程的不断推进,当原始的分类方法不足以满足我们对分类的需求,人们便将数学工具应用到分类学中,逐步形成了数值分类学、聚类分析等学科。

kmedoids算法简单例题

Kmedoids算法简单例题在数据挖掘领域,Kmedoids算法是一种常用的聚类算法。

它是Kmeans算法的改进版本,与Kmeans算法相比,Kmedoids算法更加鲁棒,能够更好地处理噪声数据,并且在簇的个数K确定的情况下,其聚类结果不受初始聚类中心的选择影响。

接下来,我们将通过一个简单的例题来讲解Kmedoids算法的原理和应用。

假设我们有一个数据集,包含如下10个数据点:1. (2, 6)2. (3, 4)3. (3, 8)4. (4, 7)5. (6, 2)6. (6, 4)7. (7, 3)8. (7, 4)9. (8, 5)10. (7, 6)现在,我们希望利用Kmedoids算法将这些数据点聚类成两个簇。

为了简化计算,我们假设初始的簇中心为数据点3和数据点8。

接下来,按照Kmedoids算法的步骤来进行计算。

计算每个数据点到两个初始簇中心的距离。

根据最近的簇中心将每个数据点分配到相应的簇中。

经过计算和分配后,我们得到了两个簇:簇1:(2, 6), (3, 4), (3, 8), (4, 7), (6, 4)簇2:(6, 2), (7, 3), (7, 4), (8, 5), (7, 6)接下来,我们需要计算每个簇中所有数据点对簇中心的距离之和,并选择一个新的簇中心使得这个距离之和最小。

经过计算,我们发现数据点3和数据点8并不是最佳的簇中心。

事实上,数据点3和数据点7更适合作为新的簇中心。

我们将簇中心更新为数据点3和数据点7,然后重新进行数据点的分配和簇中心的更新。

经过若干轮迭代后,我们最终得到了两个簇:簇1:(2, 6), (3, 4), (3, 8), (4, 7), (6, 4)簇2:(6, 2), (7, 3), (7, 4), (8, 5), (7, 6)在这个例题中,我们简单介绍了Kmedoids算法的原理和应用。

通过不断计算和更新簇中心,Kmedoids算法能够有效地将数据点聚类成符合我们期望的簇。

kmeans聚类肘部法则

kmeans聚类肘部法则聚类是机器学习中的一种重要技术,它可以将数据集中的数据按照相似性进行分类。

而Kmeans聚类则是聚类中最常用的一种算法,它通过将数据集中的数据划分到k个簇中,以使得簇内的数据点之间的距离尽可能小,簇间的距离尽可能大。

但是在实际应用中,如何确定最优的聚类数k却是一个难题。

这时候,肘部法则就可以派上用场了。

什么是肘部法则?肘部法则是一种通过观察数据的变化趋势来确定最优聚类数k 的方法。

具体而言,它是通过计算不同聚类数k下的聚类误差平方和(SSE)的变化趋势来得到最优聚类数k的。

聚类误差平方和SSE 是指每个数据点到其所属簇中心的距离的平方和。

当聚类数k较小时,SSE会逐渐减小;而当聚类数k继续增大时,SSE的下降速度会逐渐变缓,直到最后趋于平稳。

这时候,SSE的变化趋势就会呈现出一个类似于手肘的形状,因此被称为肘部法则。

如何应用肘部法则?应用肘部法则的过程可以分为以下几个步骤:1. 计算不同聚类数k下的SSE值首先,需要确定聚类数k的范围,一般来说,k的取值范围为1到数据集中样本数量的一半。

然后,对于每个k值,都需要进行一次Kmeans聚类,并计算其SSE值。

2. 绘制SSE与k的变化趋势图将不同聚类数k下的SSE值绘制成一张折线图,其中k为横轴,SSE为纵轴。

根据图形的变化趋势,找到一个k值,使得增加k 值所带来的SSE下降幅度较大,而增加k值所带来的SSE下降幅度开始变缓。

这个k值就是最优聚类数。

3. 进行聚类最后,使用最优聚类数对数据进行聚类。

肘部法则的优缺点肘部法则是一种简单有效的聚类数选择方法,它不需要对数据的分布和特征进行详细分析,只需要对不同聚类数下的SSE值进行计算和比较。

因此,肘部法则具有以下优点:1. 简单易懂:肘部法则的原理和应用方法都很简单易懂,不需要过多的数学知识和技能。

2. 直观可视:通过绘制SSE与k的变化趋势图,可以直观地看到聚类数k对SSE的影响,从而确定最优聚类数。

一种新的K—means最佳聚类数确定方法

( 中共 湛 江 市 委 党 校 干 部 在 线 学 习管 理 科 ,湛 江 5 2 4 0 3 2 )

摘

要 :在 传 统 的 K~ me a n s 算 法 中 .聚 类 数 K 是 随机 给 定 的 . K 值 选 取 不合 理 会 造 成 K— me a n s 算 法 陷入 局 部 最 优 。针 对 这 个 缺 点 , 提 出一 种 新 的 K— me a n s 聚 类数 确 定 方 法 . 根 据 聚 类 算 法

接 决 定 着 聚 类 效 果 的 好 坏 针 对 这 个 问题 .有 文 章 提 出 了一 些 检 验 聚类 有 效

标按照相似性准则划分 到若 干个子集 中.使得相 同子 集中各元素间差别最小 .而 不同子集 中各元素差 别最

大 K - m e a n s 算法设计过程 中. 首 先 需 由人 工 确 定 所 要 聚类的准确书 目 K , 并 随机 选 择 K个 对 象 , 每 一 个 对 象

中类 内相 似 度 最 大差 异 度 最 小和 类 问 差异 度 最 大相 似 度 最 小 的基 本 原 则 . 提 出距 离评 价 函

数 作 为 最 佳 聚 类 数 的 检 验 函数 , 建 立相 应 的 数 学 模 型 . 并 通 过 实例 结 果 进 一 步 验 证 新 算 法

的有 效 性 。

( 1 ) 针对数 据集 , z , …. n } , 任选 k个样 本作 为

初始聚类中心 , ( z 1 , z 2 , …, z k ) ; ( 2 ) 对每个样本 X i 找 到 离 它 最 近 的 聚 类 中心 z , 并

i n g - t h e o r y&P r a c t i c e 杂 志上杨 善林等人提 出的一种距 离代价 函数作 为聚类算法 的有效性指 标进行 进一步 的

kmeans算法一维例题

kmeans算法一维例题K-means算法一维例题K-means算法是一种常用的聚类算法,它通过将n个数据对象划分为k个不同的组或簇,使得每个对象在同一簇内的相似度最大化,而在不同簇之间的相似度最小化。

本文将通过一个一维数据的例题来探讨K-means算法的应用。

假设我们有以下一维数据集合:[5, 6, 9, 10, 14, 15, 18, 21, 23, 25]。

我们的目标是将这些数据划分为3个不同的簇。

首先,我们需要选择3个初始的簇中心点,可以是随机选择或者根据经验选择。

在本例中,我们选择簇中心点分别为6、15和23。

接下来,我们将每个数据点与这些簇中心点进行比较,并将其分配到最近的簇中。

第一次迭代后,我们得到了以下的划分结果:簇1:[5, 6, 9, 10]簇2:[14, 15, 18]簇3:[21, 23, 25]然后,我们需要重新计算每个簇的中心点。

在本例中,我们可以计算得到新的簇中心点为7.5、15.7和23。

接着,我们再次将每个数据点与新的簇中心点进行比较,并重新将其分配到最近的簇中。

第二次迭代后,我们得到了以下的划分结果:簇1:[5, 6, 9, 10]簇2:[14, 15, 18]簇3:[21, 23, 25]再次计算每个簇的中心点,我们可以得到新的簇中心点为7.5、15.7和23。

由于没有数据点发生改变,算法收敛并达到了停止的条件。

最终的聚类结果为:簇1:[5, 6, 9, 10]簇2:[14, 15, 18]簇3:[21, 23, 25]在本例中,K-means算法成功地将一维数据划分为3个不同的簇。

这个例题展示了K-means算法的基本步骤和流程。

通过多次迭代,算法不断优化簇中心点的位置,直到收敛为止。

需要注意的是,K-means算法对于初始簇中心点的选择是敏感的,不同的初始选择可能导致不同的聚类结果。

因此,在实际应用中,需要通过多次尝试来选择最优的初始簇中心点,或者采用其他改进的K-means变种算法。

【kmeans聚类】如何选择最为合适的k值

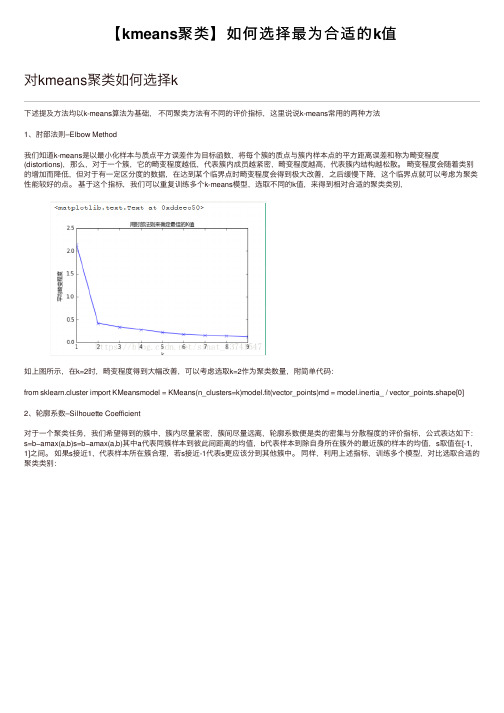

【kmeans聚类】如何选择最为合适的k值对kmeans聚类如何选择k下述提及⽅法均以k-means算法为基础,不同聚类⽅法有不同的评价指标,这⾥说说k-means常⽤的两种⽅法1、肘部法则–Elbow Method我们知道k-means是以最⼩化样本与质点平⽅误差作为⽬标函数,将每个簇的质点与簇内样本点的平⽅距离误差和称为畸变程度(distortions),那么,对于⼀个簇,它的畸变程度越低,代表簇内成员越紧密,畸变程度越⾼,代表簇内结构越松散。

畸变程度会随着类别的增加⽽降低,但对于有⼀定区分度的数据,在达到某个临界点时畸变程度会得到极⼤改善,之后缓慢下降,这个临界点就可以考虑为聚类性能较好的点。

基于这个指标,我们可以重复训练多个k-means模型,选取不同的k值,来得到相对合适的聚类类别,如上图所⽰,在k=2时,畸变程度得到⼤幅改善,可以考虑选取k=2作为聚类数量,附简单代码:from sklearn.cluster import KMeansmodel = KMeans(n_clusters=k)model.fit(vector_points)md = model.inertia_ / vector_points.shape[0] 2、轮廓系数–Silhouette Coefficient对于⼀个聚类任务,我们希望得到的簇中,簇内尽量紧密,簇间尽量远离,轮廓系数便是类的密集与分散程度的评价指标,公式表达如下:s=b−amax(a,b)s=b−amax(a,b)其中a代表同簇样本到彼此间距离的均值,b代表样本到除⾃⾝所在簇外的最近簇的样本的均值,s取值在[-1, 1]之间。

如果s接近1,代表样本所在簇合理,若s接近-1代表s更应该分到其他簇中。

同样,利⽤上述指标,训练多个模型,对⽐选取合适的聚类类别:s = silhouette_score(vector_points, bels_)当然还有其他的⼀些评判标准,后⾯会具体详细介绍⼀部分如上图, 当k=3时,轮廓系数最⼤,代表此时聚类的效果相对合理,简单代码如下:from sklearn.cluster import KMeansfrom sklearn.metrics import silhouette_scoremodel = KMeans(n_clusters=k)model.fit(vector_points)。

kmeans应用案例

kmeans应用案例K-means 应用案例。

K-means 是一种常见的聚类算法,它可以对数据进行分组,找出数据中的相似性,并将数据划分为不同的类别。

在实际应用中,K-means 算法被广泛应用于数据挖掘、模式识别、图像分割等领域。

下面将介绍 K-means 算法在实际案例中的应用。

首先,我们来看一个简单的 K-means 应用案例,鸢尾花数据集。

鸢尾花数据集是一个经典的数据集,其中包含了鸢尾花的四个特征,花萼长度、花萼宽度、花瓣长度和花瓣宽度。

我们可以利用 K-means 算法对这些特征进行聚类,找出不同种类的鸢尾花。

通过 K-means 聚类分析,我们可以将鸢尾花数据集分为三个类别,分别对应于不同的鸢尾花种类。

这样的聚类结果有助于我们更好地理解鸢尾花数据的特点,对鸢尾花进行分类和识别。

除了鸢尾花数据集,K-means 算法还可以应用于其他领域。

例如,在市场营销中,我们可以利用 K-means 算法对客户进行分群,找出具有相似行为和偏好的客户群体,从而针对不同的客户群体制定个性化的营销策略。

在医学影像分析中,K-means 算法可以用于图像分割,将医学影像中的不同组织和结构进行分离,有助于医生更准确地诊断疾病。

在互联网广告投放中,K-means 算法可以对用户进行行为分析,找出具有相似兴趣和偏好的用户群体,从而提高广告的投放效果。

总的来说,K-means 算法是一种简单而有效的聚类算法,它在实际应用中具有广泛的应用前景。

通过对数据进行聚类分析,我们可以更好地理解数据的特点,发现数据中的规律和趋势,为决策提供有力的支持。

希望本文介绍的 K-means 应用案例能够帮助大家更好地理解和应用这一算法。

k均值分类

k均值分类【原创版】目录1.K 均值分类的概述2.K 均值分类的基本原理3.K 均值分类的步骤4.K 均值分类的应用实例5.K 均值分类的优缺点正文1.K 均值分类的概述K 均值分类(K-means Clustering)是一种将数据集划分为 K 个不同簇的无监督学习方法。

这种分类方法主要依赖于数据本身的内部结构,通过迭代计算来更新簇中心和簇成员,以达到将数据集划分为 K 个簇的目标。

K 均值分类广泛应用于数据挖掘、模式识别和图像处理等领域。

2.K 均值分类的基本原理K 均值分类的基本原理是:将数据集中的每个数据点分配给距离最近的簇中心。

每个簇中心是其所属数据点的均值。

通过迭代计算,不断更新簇中心和簇成员,使得每个数据点都尽可能地靠近其所属簇的中心。

3.K 均值分类的步骤K 均值分类主要包括以下步骤:(1)随机选择 K 个数据点作为初始簇中心。

(2)计算每个数据点到各个簇中心的距离,将数据点分配给距离最近的簇中心。

(3)根据分配结果,更新每个簇的簇中心。

新的簇中心是其所属数据点的均值。

(4)重复步骤(2)和(3),直到簇中心不再发生变化或达到预定的最大迭代次数。

4.K 均值分类的应用实例K 均值分类在许多领域都有广泛应用,例如:(1)数据挖掘:通过分析客户购买行为,将客户划分为不同的市场细分,以发现潜在的商业机会。

(2)模式识别:在图像处理中,可以将图像中的像素点划分为不同的颜色区域,从而实现图像的自动分类。

(3)文本分析:将文本数据划分为不同的主题,有助于分析和挖掘文本数据中的信息。

5.K 均值分类的优缺点K 均值分类的优点包括:(1)简单易懂,易于实现。

(2)不需要先验知识,适用于多种类型的数据。

(3)可以处理大规模数据集。

K 均值分类的缺点包括:(1)对初始簇中心的选择敏感,可能导致局部最优解。

(2)需要预先设定簇数 K,不同的 K 值可能导致不同的分类结果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

K-means 分类中K 的最优值实例分析

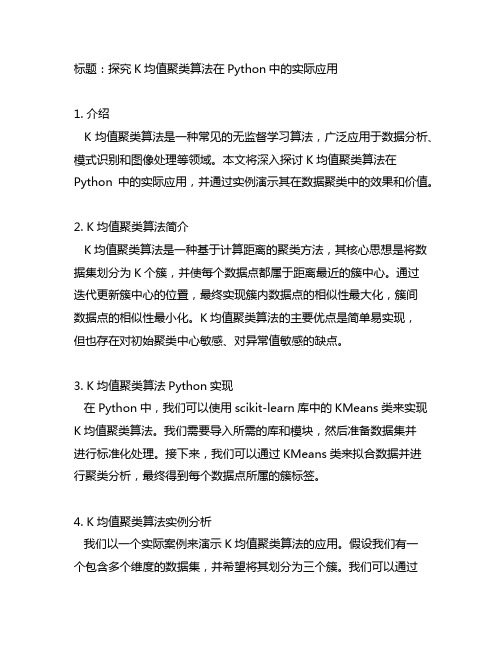

以下我们将用鸢尾花(iris )数据进行实例分析,数据来自维基百科-----安德森鸢尾花卉数据集,该数据为150X4矩阵,其中每一组行向量代表每一种花的数据,列向量分别代表花萼长度、花萼宽度、花瓣长度、花瓣宽度。

一共150多花的数据,我们运用K-means 算法对150组数据进行分类,并按照本文的算法分析出最有k 值,对其他关于鸢尾花(iris )的研究起到参照的作用。

4.1 编写程序计算)k (W 的值

从文本中导入数据并命名为Z ,以k =2为例进行分类(k 为其他值只需略改程序)然后我们对分类后的数据进行分离,并且用分离后的数据计算出组内距离平方和函数)k (W ,作出图像和表格确定最优k 值。

# 程序7:

[u re]=K-means(Z,2); Y=[Z,u];

[m,n]=size(Y);

k=0;j=0;l=0;q=0;w=0; for i=1:m

if Y(i,5)==1 k=k+1; end

if Y(i,5)==2 j=j+1; end

if Y(i,5)==3 l=l+1; end

if Y(i,5)==4 q=q+1; end

if Y(i,5)==5 w=w+1; end end

M1=zeros(k,4); M2=zeros(j,4); M3=zeros(l,4); M4=zeros(q,4); M5=zeros(w,4);

x=1;y=1;z=1;c=1;v=1;

for i=1:m

if Y(i,5)==1

M1(x,1)=Y(i,1);

M1(x,2)=Y(i,2);

M1(x,3)=Y(i,3);

M1(x,4)=Y(i,4);

x=x+1;

end

if Y(i,5)==2

M2(y,1)=Y(i,1);

M2(y,2)=Y(i,2);

M2(y,3)=Y(i,3);

M2(y,4)=Y(i,4);

y=y+1;

end

if Y(i,5)==3

M3(z,1)=Y(i,1);

M3(z,2)=Y(i,2);

M3(z,3)=Y(i,3);

M3(z,4)=Y(i,4);

z=z+1;

end

if Y(i,5)==4

M4(c,1)=Y(i,1);

M4(c,2)=Y(i,2);

M4(c,3)=Y(i,3);

M4(c,4)=Y(i,4);

c=c+1;

end

if Y(i,5)==5

M5(v,1)=Y(i,1);

M5(v,2)=Y(i,2);

M5(v,3)=Y(i,3);

M5(v,4)=Y(i,4);

v=v+1;

end

end

D1=sum(pdist(M1).^2)*2 D2=sum(pdist(M2).^2)*2 D3=sum(pdist(M3).^2)*2 D4=sum(pdist(M4).^2)*2 D5=sum(pdist(M5).^2)*2 W1=(D1/k)/2

W2=(D1/k+D2/j)/2

W3=(D1/k+D2/j+D3/l)/2

W4=(D1/k+D2/j+D3/l+D4/q)/2

W5=(D1/k+D2/j+D3/l+D4/q+D5/w)/2

4.2作出图表如下:

表4.1 iris 数据的一阶差分

K 1

2 3 4 5

D1 204411.2 3026.52 4937.8 1197.02 137.02 D2 24016.4

1515.1 1515.1 828.96 D3 1814.84

1089.98 259.32 D4 545.96 1531.28 D5

545.96 Wk 681.3706

152.348 78.85144

57.22847

49.85942

logWk

6.524106358 5.026167378 4.367565576

4.047051502 3.909207445 一阶差分 -1.49793898 -0.658601802 -0.320514074 -0.137844056

得到的折线图如下:

图4.1 iris 数据的))k (W (log 关于k 的函数图像

通过得到的一阶差分和折线图,我们发现k 的值从1到2时))k (W (log 变化最快,但k 的值从1到2时))k (W (log 变化仍旧很大,因此k 取2或者3都是可以考虑的。