Rittal数据中心制冷规划和小型数据中心整体解决方案

模块化数据中心解决方案

模块化数据中心解决方案模块化数据中心解决方案是一种通过将数据中心的各个组件模块化设计,以提高数据中心的可扩展性、灵活性和效率的解决方案。

这种解决方案能够满足不同规模和应用需求的数据中心,例如企业数据中心、云计算数据中心和边缘计算数据中心。

下面将详细介绍模块化数据中心解决方案的优势和实施方法。

1.可扩展性:模块化数据中心解决方案允许根据实际需求逐步扩展数据中心的规模,而不需要进行整体的重建或大规模的修改。

这种可扩展性可以提高数据中心的灵活性,并节约成本。

2.灵活性:模块化数据中心解决方案将数据中心的各个组件模块化设计,使得不同的组件可以独立运行和管理。

这种灵活性使得数据中心可以根据实际需求进行自定义配置和调整,适应不同的应用场景和工作负载。

3.效率提升:模块化数据中心解决方案通过优化设计和集成先进的技术,提供高效的能源利用率和计算资源利用率。

这种高效性可以显著降低能源消耗和维护成本,提高数据中心的运行效率。

4.简化部署和维护:模块化数据中心解决方案可以提供预先配置好的模块化组件,使得数据中心的部署过程更加简化和快速。

同时,模块化设计也使得数据中心的维护更加方便和高效,可以实现模块的独立维护和升级。

实施模块化数据中心解决方案的方法有:1.模块化硬件设计:通过将数据中心的硬件组件模块化设计,例如服务器、存储设备和网络设备,可以实现组件的独立扩展和管理。

这种模块化硬件设计可以通过标准化接口和模块化连接方式来实现。

2.软件定义的数据中心技术:软件定义的数据中心技术允许将数据中心的各个功能模块抽象为软件,通过软件定义的方式进行管理和调配。

这种技术可以实现数据中心的灵活性和可扩展性,并提高数据中心的自动化程度。

3.高度集成的解决方案:选择高度集成的解决方案可以简化数据中心的部署和维护过程。

这些解决方案通常提供预先配置好的模块化组件,例如预先集成的服务器和网络设备,可以减少配置错误和部署时间。

4.能源管理和热管理技术:模块化数据中心解决方案通常包括先进的能源管理和热管理技术,例如高效的制冷系统和智能能源监控系统。

模块化数据中心方案

模块化数据中心方案在当今数字化时代,数据中心作为企业和组织的核心基础设施,其重要性不言而喻。

随着业务的不断发展和技术的快速更新,传统的数据中心建设模式已经难以满足日益增长的需求。

模块化数据中心方案应运而生,为数据中心的建设和运营带来了全新的思路和方法。

一、什么是模块化数据中心模块化数据中心是一种将数据中心的基础设施(如机柜、制冷、供电、布线等)进行模块化设计和构建的解决方案。

它将整个数据中心分解为多个独立的模块,每个模块都具备完整的功能,并且可以根据需求进行灵活的组合和扩展。

与传统数据中心相比,模块化数据中心具有以下显著特点:1、快速部署模块化数据中心采用预制化的模块,在工厂完成生产和测试,现场只需进行简单的组装和调试,大大缩短了建设周期,从数月甚至数年缩短至数周。

2、灵活扩展可以根据业务的增长逐步增加模块,实现按需扩容,避免了一次性过度投资和资源浪费。

3、高可靠性每个模块都经过严格的质量检测和优化设计,确保了系统的稳定性和可靠性。

同时,模块化的架构也便于进行故障隔离和快速修复。

4、节能高效通过优化的制冷和供电设计,以及智能化的管理系统,提高能源利用效率,降低运营成本。

二、模块化数据中心的组成模块1、机柜模块机柜是数据中心用于安装服务器、存储设备等IT设备的基本单元。

模块化数据中心的机柜通常采用标准化设计,具备良好的散热性能、布线管理和承重能力。

2、制冷模块制冷系统是确保数据中心设备正常运行的关键。

模块化数据中心的制冷模块可以采用风冷、水冷或冷冻水等不同的制冷方式,根据实际环境和需求进行选择。

常见的制冷模块包括行间空调、机柜级空调等。

3、供电模块供电模块为数据中心提供稳定可靠的电力支持。

它包括UPS(不间断电源)、配电柜、变压器等设备。

模块化的供电系统可以实现电源的冗余配置,提高供电的可靠性。

4、布线模块布线模块负责数据中心内各类线缆的敷设和管理,包括网络线、电源线、光纤等。

采用模块化的布线系统可以提高布线的规范性和可维护性。

打造高效的数据中心制冷系统

打造高效的数据中心制冷系统作者:来源:《中国计算机报》2015年第15期2015年3月26日,国家相关部门发布了《关于印发国家绿色数据中心试点工作方案》。

方案指出,目前美国数据中心平均电能使用效率(PUE)已达1.9,先进数据中心PUE已达到1.2以下。

近年来,我国数据中心发展迅猛,总量已超过40万个,年耗电量超过全社会用电量的1.5%,其中大多数数据中心的PUE仍大于2.2,与国际先进水平相比有较大差距,节能潜力巨大。

这充分说明了建设低PUE的绿色数据中心的重要性,而建设绿色数据中心的关键之一在于打造高效的制冷系统。

深圳市英维克科技股份有限公司(以下简称英维克)副总经理王铁旺认为,打造高效绿色数据中心制冷系统的关键有两点:一是提升制冷系统本身的效率,二是利用好自然冷源。

英维克CyberMate系列高效机房专用空调,通过集成高效压缩机、高效EC风机、高效电子膨胀阀等高能效制冷器件,通过先进的EVO管理系统,实现制冷系统高能效比和科学能效管理;可集成多种直接、间接自然冷却方案,提高制冷系统的全年能效比(AEER)。

英维克XRow系列高效列间空调,靠近热源高效冷却,配合以采用封闭冷通道或封闭热通道的数据中心设计方案,可有效提高空调系统的回风温度,从而提高制冷系统的能效比和显热比,有效降低数据中心的PUE值。

不同规模的数据中心应采用不同的高效制冷方案:大型数据中心,可采用集采自然冷却的冷冻水型的制冷系统;中小型数据中心可采用集成直接、间接自然冷却方案的直接蒸发式的制冷系统。

英维克CyberMate高效制冷系统已经应用于中国联通华北基地、中国移动广东基地等多个超大型数据中心,XRow列间空调系统应用于腾讯、阿里巴巴微模块数据中心等多个模块化数据中心,iFreecooling自然冷却系统已经为中国联通、中国移动、中石油、中海油等多个数据中心大幅降低机房能耗。

针对企业级机房,英维克可以提供XRackTM微模块服务器机柜高效制冷解决方案。

Rittal数据中心制冷规划和小型数据中心整体解决方案

Rittal数据中心制冷规划和小型数据中心整体解决方案

Rittal数据中心制冷规划和小型数据中心整体解决方案

⒈引言

在当今信息技术迅猛发展的背景下,数据中心已成为许多组织处理和存储数据的核心设施。

为了确保数据中心的可靠性、高效性和可持续性,数据中心制冷规划和小型数据中心整体解决方案变得至关重要。

⒉制冷需求分析

⑴数据中心的热负荷评估

⑵环境要求和标准

⑶制冷技术选择(包括传统制冷设备、液冷技术、空气冷却技术等)

⒊制冷系统设计

⑴制冷系统组成部分(包括冷却塔、冷却机组、风冷却器等)

⑵冷却系统配置和布局

⑶制冷系统的能耗管理和监控

⒋小型数据中心整体解决方案

⑴数据中心布局规划

⑵系统集成和模块化设计

⑶电力供应和电气设备

⑷网络和通信设备

⑸灭火系统和安全设备

⑹监控和管理系统

⒌附件

附件一:数据中心热负荷评估表

附件二:制冷系统设计图纸

附件三:数据中心布局示意图

法律名词及注释:

⒈数据保护条例

数据保护条例是一种法律和法规框架,旨在保护个人的隐私和数据安全。

根据这一条例,组织在处理个人数据时必须遵守特定的规定和措施,以确保数据的机密性和完整性。

⒉知识产权法

知识产权法是一项法律体系,旨在保护创作者和创新者的知识

产权,包括专利、商标、著作权和商业秘密等。

它为创意和创新提

供了保护,促进经济和社会的发展。

⒊法律责任和赔偿

在数据中心运营过程中,如果违反了相关法律法规或合同约定,将承担相应的法律责任和赔偿责任。

这可能包括经济赔偿、行政处

罚或刑事责任等。

意大利RC Group X TYPE 绿色高效高水温IT制冷系统解决方案

意大利RC公司绿色高效高水温IT制冷系统解决方案XTYPE目录X 型大风量高温型大温差冷冻水系统 - 目录末端机组13冷水机组 26自控系统 34PUE 计算40研发背景 3PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE研发背景 -解决的问题大型数据中心在中国基本上采用冷冻水系统压缩机系统的室外机无处安放压缩机系统的制冷密度小,占地面积太大压缩机系统与间接自然冷却难以配合冷冻水系统轻松解决上述问题但采用传统7-12℃水温系统能效太低,同时数据中心采用气流遏制技术后回风温度上升最明显的提高系统能效方式是:冷冻水温提升很快从进出水温从 7-12℃ ------10-15 ℃------12-18℃大型数据冷冻水系统冷冻水温提高的优点-----冷源侧水温从7/12℃提高到12/18℃时:制冷量提高:提高10-15%能效比提高:提高10%自然能冷却大大加长:加长1250小时(每年8760小时,大约每度的小时长为250小时,根据各地点有差异)大型数据冷冻水系统冷冻水温提高的优缺点-----末端侧水温从7/12℃提高到12/18℃时:制冷量下降:约30-40%能效比下降:约30%制冷密度下降:约30%显冷比上升—除湿能力下降:SHR从0.89到1.00弥补措施:回风温度提高24℃--28℃--32℃需要按新的热交换参数新设计结构及参数匹配冷冻水温提高的下一步发展方向在哪里?为了进一步降低PUE值,肯定还需要提高水温许多项目在试点14-19℃,如果进一步提高水温,,,,,冷水机组:是否支持长时间高水温运行?厂家是否研发小众市场?时间如何?价格如何?末端空调:高水温后空调缺点如何避免?厂家支持程度?水温到底多少度合适?是否有标准支持?是否能形成成熟的产品规格?是否具备商业模式?用户、厂家、咨询、设计、总包谁来牵头做?风险谁承担?节点如何控制?Rcgroup 给出的成熟解决方案----18/28℃水温末端+主机全套成熟方案标准:美国ASHARE TC 9.9 2008 温度 18-27℃湿度 5.5℃DB-15℃DB 60%回风温度:35℃出风温度:25℃回水温度:28℃出水温度:18℃末端空调:X TYPE系列冷水主机:UNICO TR FREE CLA 系列已集成自然冷却系统从一个想法,变为一个成熟的完美的工程产品!完整的系统解决方案领导行业发展的标杆1963-为意大利银行提供首台空调1980-MRE/A 首台自由冷却风冷机组2003 -首台磁悬浮SILVER BULLET 冷水机组2015-首次高水温IT制冷系统解决方案XTYPE 简介新标准2015 : X 型大风量高温型大温差冷冻水系统的革新应用将大大提高用户收益25°C35°C 25°C35°C现在的系统设计送回风温度:•回风温度 35°C •送风温度 25°C回风温度35°C送风温度25°C冷冻水进口温度18°C冷冻水出口温度28°CX TYPEXTYPE 简介空气处理示意图35 °C35 °C25 °C25 °CXTYPE 简介水侧换热示意图28 °C23°C23°C18 °C28 °CXTYPE 简介系统 组成意大利RC 公司 XTYPE 高水温冷冻水IT 制冷系统图CHW ΔT = 10°C回风温度 35°C送风温度25°CX TYPE专用风冷机组变频水泵组18°C18°C28°C28°C出水温度自控系统回水温度PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-高水温室内空调Unit suitablefor site assembly风机段换热控湿段独立电器控制及调节阀空间过滤段3段式下送风末端以降低风阻和水阻为目的的内部组件设计过滤段低压降G4 级袋式过滤器一年一换俯视图前视图换热控湿段Array前视图Air handling section with:•4排管2级冷却•2排管预冷,2排管再冷;•2通阀;•电器面板,调节阀,及接管安排在气流方向外独立的电器和阀门空间电器面板调节阀红色部分即为此独立接线配管段In/Out CHW connectionfrom the bottom气流道外设计,提高效率风机段前视图•风机段内可安装2,3,4个EC 风机:-大直径, 630 mm; -高效率 (特殊翅片形状).3维 CFD 分析选择140Kw , 8排管的传统设计末端与X 型设备末端进行3维CFD 分析CFD Analysis – X coil CFD Analysis – Traditional 8-row coilX 型CFD 分析前视图X型CFD 分析左视图4 x 4排盘管“X” 型布置的合理性4 x 4排盘管“X”型布置替代传统8排布置的原因:•风阻小;•气流均匀;•水阻合适;•满足TIER IV 要求两台独立运行盘管的设计标准.Nr. 4 x 4 row coils with “X” layoutX型机组冷量范围和特点3段式设计3 个型号: 从 100 - 190 kW •EER 很高• 3 个独立段• 2 级盘管•2通阀•EC 无蜗壳风机•袋式过滤器•冷冻水底部接管X TYPE适配不同机房设计TIER等级•TIER II设计要求: 单冷源:− 1 套x 2 级冷却方式处理全负荷•TIER IV设计要求: 双冷源:- 2 套x( 1 级冷却方式,满足一半负荷)调节阀设于风道外.COOLINGLOGIC TIER IICOOLINGLOGIC TIER IV TIER II TIER IV冷量kW140101风量m3/h3100022000输入功率kW4,51,92 EER kW/kW31,152,6TIER IV 冷却方案TIER IV - SCHEME 1 18°C28°CTIER IV - SCHEME 228°C18°C12LEGENDAMVMD – 中压主分配器LVMD – 低压主分配器UPS – 不间断电源STS – 静态转换开关SD – 二级分配器G – 发电机XTYPE – 末端TURBO FL G X chiller – 冷水机TURBOFL G Xchiller气流水流气流水流TURBOFL G XchillerPUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-高水温自然冷却主机专用冷水机组 高水温 大温差X 型末端的完美表现需要和专用冷水机组的配套来支持: RC 集团设计了一系列常规及带自由冷却冷水机组: • 回水温度: >=28°C ;•delta-T: >=10 °. (出水温度18 °C )UNICO TURBO FL X & FL G XUNICO TURBO FL X FREE & FL G XFREE磁悬浮冷水机组传统型及带自由冷却型风冷冷水机组R134a 及 HFO1234ze冷媒 :500 – 700 – 1000 – 1250 kW •EER (EUROVENT STD)高达3,51•EER 在28/18°C 高达5,25•ESEER (EUROVENT STD) 高达5,71•SEER at 28/18°C up to 7.20 (常规机组l) and20.00 (自由冷却)•单冷回路•R134a & HFO R1234ze 冷媒•磁悬浮无油离心压缩机•高温大温差满液壳管式蒸发器UNICO TURBO FL X &FL X FREE UNICO TURBO FL G X & FL G XFREE磁悬浮压缩机技术介绍特点变转速两级离心压缩机;•磁悬浮无油轴承;•适应现场对水温的精密调节需求;•压缩机内置变频可将启动电流降至5安培;•R134a 或 HFO1234ze 冷媒可选.益处•无需润滑;•无需功率因素校正电容器;•部分负荷EER 增高;•启动电流变小(LRA);•低噪音;•重量轻;•无震动.冷冻水进出口温度从传统的 15 / 10°C 调整到 28 / 18°C自由冷却冷水机组: 自由冷却时间延长;常规冷水机组: EER 增加及减小尺寸;泵组: 降低输入功率;管路: 降低管径,无需保温自由冷却时间延长差值%伦敦[h/y]+ 46 %巴黎[h/y]+ 66 %米兰[h/y]+ 92 %冷水机组 EER 增加及减小机组尺寸进出口水温15 / 10 °C 进出口水温28 / 18 °C差值%冷量[kW]10001000冷凝温度[°C]5050蒸发温度[°C]816输入功率[kW]272,47197,23- 28% EER[kW/kW]3,675,07+ 38%降低水泵功率及管径进出口水温15 / 10 °C 进出口水温28 / 18 °C差值%冷量[kW]10001000冷冻水量[m3/h]17286- 50%冷水机内压降(蒸发器+ 管路)[kPa]4040100 kPa外压时水泵输入功率[kW]8,54,8- 43,5 %管径(330 m 当量)[in]6”5”-16,7%管道保温YES NO-100%重量[kg/m]2016-20%PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-自控系统软硬件配套控制系统人工智能---基于能效计算,异地联网,及远程监视应用基础的软件开发机房专用负荷分配软件: COOL NET机房群控: Master Plant SEQuencer机房监控: RC Cloud Platform能效计算软件: RC SpectrumCOOLNET 室内机组群控节能COOL NET:基于机房空调多机不同负荷工况的优化控制•通过局域网接入并管理多达15台设备;•避免了局部制冷局部制热的对冲损失制冷区域平均温度设定温度回风温度待机SEQuencer 是对用同一制冷水力系统中采用多台同型号或不同型号冷水机组来生产冷热水的机房系统进行统一管理的自控系统。

克莱门特数据中心空调解决方案

CMS-480/600系列模块化UPS CMS-480(480KVA) 1)静态开关模块、监控模块和 1-30个20KVA功率模块组成. 最 大容量600KVA 2)所有功率模块共享电池组, 输入直流为±384V. 3)模块内部具备整流、逆变、 充电和控制一体系统 4)系统可随需设定为1/1、1/3、 3/1或3/3进出线方式

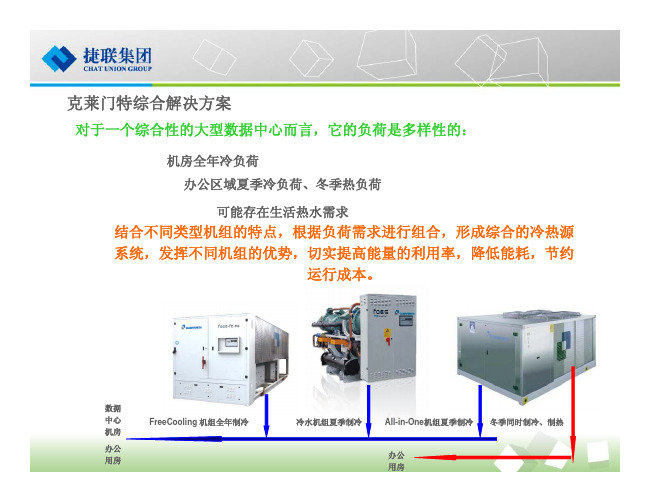

克莱门特综合解决方案

对于一个综合性的大型数据中心而言,它的负荷是多样性的:

机房全年冷负荷 办公区域夏季冷负荷、冬季热负荷 可能存在生活热水需求

结合不同类型机组的特点,根据负荷需求进行组合,形成综合的冷热源 系统,发挥不同机组的优势,切实提高能量的利用率,降低能耗,节约 运行成本。

数据 中心 机房 办公 用房

推荐方案一:模块机集中就近供电

集中就近配电优点: 1)有效减少功率损耗; 2)有效减少配电故障; 3)有效减小“零地”电压。

集中就近配电方案实际图

适用于中小型数据中心(200KVA以下负载供电),可完全取代传统 单机1+1并联的运行方式

Company Logo

推荐方案二:模块机双回路供电(1)

分电柜1 分电柜1 单电源负块机1 模块机2 模块机2 用户设备 静态开关 分电柜2 分电柜2

双 电 源 负 载

市电2 市电2

适用于中、小型数据中心(400KVA以下负载供电),可完全替代传统UPS双机双总线工作方式

Company Logo

推荐方案二:模块机双回路供电(2)

嵌入式ECMS系列模块化UPS电源

1)监控模块(含静态开关)和1到 6个功率模块(最大容量 3KVA×6=18KVA、 6KVA×6=36KVA) 组成。 2)所有功率模块共享电池组,输 入直流为±384V。 3)模块内部具备整流、逆变、充 电和控制一体系统。 4)系统可随需设定为1/1、1/3、 3/1或3/3进出线方式。

数据中心制冷方案

数据中心制冷方案数据中心是一个集中存储、管理和处理大量数据和信息的设施,而其中最重要的技术之一就是制冷技术。

数据中心中的服务器和IT设备运行时会产生大量的热量,如果不能有效地处理这些热量,将导致设备故障、性能下降甚至停机。

因此,如何在数据中心中实现高效而可靠的制冷成为了一个重要的问题。

目前,数据中心制冷方案主要有以下几种:1.传统的机械制冷系统机械制冷系统是目前最常见的数据中心制冷技术,它通过空调机组来调节室内温度和湿度。

空调机组通过蒸发冷却和压缩循环来实现制冷效果,能够有效地控制室内温度,并且具有稳定的性能。

然而,机械制冷系统的能耗较高,同时还需要大量的机械设备,增加了设备的成本和运维的难度。

2.可循环制冷系统可循环制冷系统是一种新型的制冷技术,其核心是利用冷凝器和蒸发器之间的热管循环来完成热量的转移。

这种制冷系统具有高度的可靠性和稳定性,同时能够提高数据中心的能效。

相比于传统的机械制冷系统,可循环制冷系统的成本更低,运维更方便,并且对环境的影响也更小。

3.直接液冷技术直接液冷技术是一种较为先进的数据中心制冷技术,它通过将冷却剂直接引入服务器设备的散热器中,实现对服务器的散热。

这种技术能够有效地提高散热效果,降低能耗,并且还能够减少数据中心的占地面积。

但是,直接液冷技术的实施成本较高,需要对服务器进行改造,同时对于冷却剂的选择和管理也有一定的要求。

4.自由冷却技术自由冷却技术是一种利用自然空气进行制冷的方法,它通过利用大自然的温度差异来实现制冷效果,并且不需要额外的能源消耗。

自由冷却技术适用于一些地理位置有利的数据中心,如北欧等地。

然而,在一些高温和高湿度的地区,自由冷却技术的效果可能会受到限制。

综上所述,不同的数据中心制冷方案各有优劣,选择适合的制冷方案需要考虑多个因素,如数据中心的规模、地理位置、能耗要求和成本预算等。

在未来,随着科技的进步和能源的需求,数据中心制冷技术将会不断发展和创新,以实现更高效、可靠和可持续的制冷效果。

集装箱式数据中心解决方案

2023-11-08CATALOGUE目录•引言•集装箱式数据中心解决方案的优势•集装箱式数据中心的架构与技术•集装箱式数据中心的实施步骤•集装箱式数据中心的应用场景与案例分析•总结与展望01引言随着云计算、大数据、人工智能等技术的快速发展,传统数据中心面临着诸多挑战,如高能耗、建设周期长、难以扩展等问题。

集装箱式数据中心解决方案应运而生,作为一种高度集成、可快速部署和灵活扩展的数据中心解决方案,得到了广泛关注和应用。

背景介绍集装箱式数据中心解决方案是由多个标准化集装箱组成,每个集装箱内都配备了计算、存储、网络等基础设施资源。

这种解决方案具有高效、灵活、可扩展等优点,能够快速满足不断增长的数据需求,同时降低了数据中心的能耗和成本。

集装箱式数据中心解决方案的提02集装箱式数据中心解决方案的优势提高数据中心的能效集装箱式数据中心通过智能监控系统,实时监测数据中心的温度、湿度和电力等参数,确保数据中心在最佳状态下运行,进一步降低能源消耗。

集装箱式数据中心还采用了先进的冷却技术和设备,如高效冷却塔、冷凝器等,能够更有效地散发热量,保持数据中心的稳定运行。

集装箱式数据中心采用高效节能设计和绿色建筑材料,能够显著降低能源消耗,提高能源利用效率。

快速部署与灵活扩展集装箱式数据中心采用预制化设计,能够快速部署和安装,缩短建设周期。

集装箱式数据中心的模块化设计使其具有灵活扩展的能力,可以根据业务需求增加模块或进行堆叠,方便扩展数据中心的规模和功能。

集装箱式数据中心的标准化设计使其易于维护和升级,可以根据需要进行设备替换或升级。

03集装箱式数据中心采用可回收材料和设备,能够减少废弃物处理成本。

减少数据中心的建设与运营成本01集装箱式数据中心采用预制化和模块化设计,能够降低建设和维护成本。

02集装箱式数据中心的节能设计和高效运营能够降低运营成本。

提高数据中心的可用性与可靠性集装箱式数据中心采用高可靠性设备、备份系统和容灾措施,能够提高数据中心的可用性和可靠性。

SmartAisle2模块化数据中心方案建议书V1.0

XXXXXXXXXXXXXXXXX数据中心项目XXXXXXXX模块化数据中心方案建议书XXXX有限公司2019年6月目录第一章项目概述及方案推介 (5)1.1项目背景 (5)1.2S MART S OLUTION介绍 (7)1.2.1 Smart Solution家族成员 (9)1.2.2 部分行业Smart Solution案例 (10)1.3设计原则 (13)1.4设计依据 (14)第二章系统方案设计 (15)2.1S MART A SILE系统架构 (15)2.2S MART A SILE平面布局图 (16)2.3微模块供配电系统 (16)2.4产品选型 (16)2.5产品特点 (17)2.5.1 工作原理 (17)2.5.2 eXM系列UPS技术特性 (18)2.5.3 eXM系列UPS技术参数 (20)2.5.4 产品结构尺寸 (23)2.6双总线原理图 (24)2.7电池计算 (24)2.7.1 计算方法介绍 (24)2.7.2 电池容量计算 (25)2.8微模块制冷系统 (25)2.8.1 微模块热负荷计算 (25)2.8.2 微模块空调选型概述 (26)1、采用地板下送风 (26)2、EC风机下沉式安装: (28)3、架空地板高度建议 (28)4、末端送风口 (29)LIEBERT.PEX4.0风冷超高效空调产品介绍 (31)一、L IEBERT.PEX4.0风冷系列空调描述 (31)二、L IEBERT.PEX4.0风冷空调机组的特点 0三、L IEBERT.PEX4.0风冷机组的节能设计 (1)LIEBERT.VCC集中式冷凝器产品介绍 (5)1.中大型数据中心室外机解决方案 (5)2.LVC冷凝器介绍 (6)3.LVC冷凝器参数 (7)4.LVC冷凝器特点 (8)5.给您带来的优点 (8)6.主要部件 (8)2.9动环监控单元 (10)2.9.1 动环监控单元组成 (10)2.9.2 监控采集器特点 (14)2.10机柜 (17)2.10.1 机柜附件 (19)2.11封闭冷通道 (20)第三章系统周边产品 (29)3.1RDU-M易睿管理器 (29)3.2数字视频系统 (32)3.3服务器管理系统 (34)3.3.1 MPU数字KVM切换器 (34)第一章项目概述及方案推介1.1 项目背景XXXXXXXXXXXXXXXXX数据中心项目机房位于XXXXXXXXXXXXXXXXX4楼西侧,机房面积约为185m2。

RiLine技术系统手册-Rittal

RiLine 技术系统手册母线系统Rittal 针对各种客户解决方案提供带有组件的完整系统包。

无论用于世界何地,Rittal 母线系统经过全面的检测、设计认证并获得高度认可,适用于多种用途。

简单的项目规划、快速的安装和优化的防接触保护是所有 Rittal 母线系统解决方案的基本标准。

为此,威图提供母线支撑系统、母线及连接技术、元件适配器和保险丝组件,这些灵活多样的产品将完美地满足您的需求。

Ⅲ设计认证:设计认证由软件支持,符合 IEC61 439-1Ⅲ性能:最佳设计参数,适用于交流和直流情况Ⅲ省时:安装操作简单,性价比高Ⅲ能效:功能良好的触点和连接技术带来运行低损耗Ⅲ安全:全方位优化的防接触保护Ⅲ针对 IEC 和 UL 市场: RiLine 组件满足多项相关标准和许可条件Mini-PLS 母线系统Rittal Mini-PLS 母线系统的母线中心距为 40 mm ,能够广泛装备在电流范围高达 250 A 、带负载输出的场合,节约空间。

Ⅲ可不受限制顶装的母线支架和母线连接器带来紧凑设计。

ⅢT 型母线型材的高静态载荷和热载荷。

Ⅲ前部插入和锁定连接,使得像连接适配器、元件适配器和母线式熔丝座这些系统组件安装简单快捷。

Ⅲ通过内置在连接适配器中的联接功能,连接多个母线系统。

另外,连接适配器 (250 A) 的外壳盖板能够直接固定断路器和 NH 开关(规格000,SV 3431.000)。

Ⅲ母线系统的全封闭结构(由底部槽型件、盖板和端盖组成)构成安全的防接触保护系统。

Ⅲ与单独母线盖相比,防接触保护盖板的剪裁更省时简便。

RiLine 母线系统在低压技术领域,RiLine 在机械、工厂设备、工业系统和数据中心的控制工程以及Ri4Power 系统技术中扮演了一个相当重要的角色。

Ⅲ高达 800 A 的扁平母线系统。

ⅢPLS 母线系统 800 A/1600 A 。

Ⅲ60 mm 母线中心距,3 极和 4 极。

Ⅲ通过IEC61439-1和UL508检测认证的系统技术。

数据中心冷却设计方案

数据中心冷却设计方案随着云计算和大数据时代的到来,数据中心的重要性日益突出。

而数据中心的运行离不开有效的冷却系统,以确保设备的稳定运行和数据的安全。

本文将介绍一种有效的数据中心冷却设计方案。

一、背景介绍数据中心是指大规模的计算机服务器集群,用于存储、管理和处理大量的数据。

数据中心运行时会产生大量的热量,如果不能及时有效地进行冷却,将会导致设备的过热、运行不稳定甚至损坏。

因此,冷却系统是数据中心必不可少的一部分。

二、设计原则1. 效率性:冷却系统应该具备高效能的特点,能够快速降低数据中心的温度,提供稳定的运行环境。

2. 可持续性:冷却系统应该采用可持续的能源,减少对环境的负面影响,并且应该具备能耗低、运行稳定的特点。

3. 可靠性:冷却系统应该具备高度的可靠性,能够在设备故障时自动切换到备用系统,并及时发出警报。

4. 灵活性:冷却系统应该具备灵活的设计,能够根据数据中心的负载情况进行自动调整,以提高能源利用率。

三、具体方案1. 空气冷却系统空气冷却系统是目前数据中心中最常用的冷却系统之一。

它通过将冷却空气引入数据中心,并将热空气排出建筑物外部来实现冷却的效果。

这种冷却系统成本较低,但效率相对较低。

为了提高冷却效率,可以在数据中心内部设置冷通道和热通道,以确保冷却空气能够快速流过设备,并将热空气集中排出。

此外,可以采用新型的降温材料来提高冷却效果。

2. 水冷却系统水冷却系统是一种高效能的冷却系统,它使用水来降低设备的温度。

相比于空气冷却系统,水冷却系统能够提供更高的冷却效率。

在水冷却方案中,可以采用冷却塔或者液冷板来降低水温。

冷却塔通过水的蒸发来带走热量,而液冷板则通过直接接触散热器和设备来将热量转移到水中。

水冷却系统需要更多的设备和管道,但效率高、可靠性强。

3. 相变材料冷却系统相变材料冷却系统是一种新型的冷却方案,它利用相变材料的热存储特性实现冷却效果。

相变材料在固态和液态之间的相变过程中释放或吸收大量的热量,从而实现冷却效果。

Rittal威图数据中心解决方案PPT

Rittal – The System.Faster better F t – b tt – worldwide ld idDominik Mizdrak Rittal Ltd. Hong Kong Director Global Business Development ITINDUSTRIAL ENCLOSURES POWER DISTRIBUTION ELECTRONIC PACKAGINGThe simple route to the perfect Data CentreSYSTEM CLIMATE CONTROL IT SYSTEMS11DCD Hong Kong 2010Rittal – The System.IT SystemsUPS systems1-18 kVA, 1-phase 10 – 960 kW, 3-phaseRiZoneManages and monitors the entire data centreRoom, Room raised floor, rack coolingIndividual cooling conceptsPower distributionFully wired and contact hazard proofServer racksA large range with comprehensive accessoriesIT recooling systemsHolistic solutions for IT coolingNetwork enclosuresNetwork enclosures IT wall mounted wall-mounted enclosuresPipeworkOptimum designSecurity roomsProtection P t ti against a i t large number of physical hazardsSensor network monitoringOptimum availability & transparencyINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS22DCD Hong Kong 2010The simple route to the perfect Data Center3 Key StepsReduce your DC footprintMinimize Energy ConsumptionDeploy modular DC InfrastructureINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS33DCD Hong Kong 2010The simple route to the perfect Data CenterStep 1Reduce your DC footprintMinimize Energy ConsumptionDeploy modular DC InfrastructureINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS44DCD Hong Kong 2010Reduce footprint drasticallyUnderstanding Cooling LimitationsPlus OEMBasic solutions- HP MCS - SUN GlacierCRAC-system With Cold Aisle ContainmentLCP ExtendLCP Inline With Cold Aisle ContainmentLCP Smart LCP Plus LCP T3+ fully redundantLow DensityMid DensityHigh DensityELECTRONIC PACKAGINGHeat Load in the ServerracksSYSTEM CLIMATE CONTROL IT SYSTEMSINDUSTRIAL ENCLOSURESPOWER DISTRIBUTION55DCD Hong Kong 2010Reduce footprint drasticallyUnderstanding Cooling LimitationsUp to 6kW per rack6-12kW per rack12 – 35kW Per rackLow DensityMid DensityHigh DensityINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS66DCD Hong Kong 2010Reduce footprint drasticallyLCP+ EC – Rack Based HD CoolingFacts and features:+ + + Cooling output up to 30 kW per rack g y g High availability for enclosures with high loads Access-protected because cooling and rack are separatedSaves time by ... • Less time required for service and maintenance $ Saves cost by ... • Using energy-efficient EC fan technology energy efficient • Being energy-efficient due to the high water inlet temperature • Providing the option of high-density cooling g p g y g without raised floorINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS77DCD Hong Kong 2010Reduce footprint drasticallyBring cooling closer to the heatsource+=INDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS88DCD Hong Kong 2010Reduce Footprint drasticallyFootprint comparison Raised Floor vs. Rack based cooling vsRaised-Floor Cooling g Rack-Based Cooling g0,8m 1,2m 1,2m11mTier 210m 10,8mBase plate cold aisle Base plate warm aisle Racks CRAC units Free floor spaceRacks LCP Free floor space Floor space for expansionINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS910,2m150kW N+1… • Cooling units • Chiller0,8m1,2m 1m9DCD Hong Kong 2010Reduce footprint drasticallyInvestment Comparison Raised Floor vs. Rack based cooling vsInitial InvestmentRaised-Floor Cooling Rack-Based Cooling150kW n+1 Cooling Units Chiller Racks Piping Sum Cost Savings due to unneeded Footprint Sum with Footprint SavingsRaised-Floor (5kW per Rack) 600,000 HK$ 1,320,000 1 320 000 HK$ 400,000 HK$ 350,000 HK$ 2,670,000 HK$ 0€Rack-Based Cooling (25kW) 1,200,000 HK$ 1,320,000 1 320 000 HK$ 100,000 HK$ 400,000 HK$ 3,020,000 HK$ 930,000 HK$Space needed Space free Cost savings (116 HK$/sqft) Raised-Floor R i d Fl 1100 sqft 0 sqft 0 Rack-Based R kB d 300 sqft 800 sqft0.93 Mio2,670,000 HK$2,090,000 HK$65% less space neededPOWER DISTRIBUTION ELECTRONIC PACKAGING SYSTEM CLIMATE CONTROL IT SYSTEMSINDUSTRIAL ENCLOSURES1010DCD Hong Kong 2010Reference WETA Digital New Zealand Reference WETA Digital New ZealandReference WETA Digital –Key Parameters Reference WETA Digital Key ParametersData Centre designed for 60HD racks @ 25kW each1.5 Megawatts in 62.8 m²The LCP+ was chosen for its proven ability to cool high densities in facilities around theWorld, it s intuitive management system thatWorld it’s intuitive management system thathelp regulates fan energy and water usageand for its ability to work at high water inlettemperatures35 Rittal LCP+ currently installed35Rittal LCP+currently installedReference WETA Digital Energy Efficiency4 HP blade chassis with a total of 64 servers in Reference WETA Digital –Energy Efficiency each rackFully optimised dynamic control though PLC/SCADAAll pumps and fans on variable speedFree cooling is estimated to be 80% of the year Free cooling kicks in at an ambient temperature Free cooling kicks in at an ambient temperature below 17°C -quite a lot of the year in Wellington.Current PUE value of between 1.25 and 1.35 depending on the time of yearFully loaded with 60 racks the facility should have a PUE of 1.15 in the winter and 1.3 when free cooling is not possible !coo g s ot poss b eReference Lenovo Beijing 13MW HD Cooling Complete HD Cooling Solution Reference Lenovo Beijing –1.3 MW HD Cooling Complete HD Cooling Solution Technology gy¾Cooling -54x LCP+ 30KW-3x 460KW Chillers ¾Racks-48x HPC RacksWhy Rittal ?Highest Density based on footprint Highest Density based on footprint OEM DesignRedundant Cooling solutionHighest Efficiencyg yThe simple route to the perfect Data CenterStep 2Step2Reduce your DC footprintMinimize Energy ConsumptionDeploy modular DC InfrastructureWhere most money can be savedWhere most money can be saved3 % light et cetera10 % power distributionand backup50 % server37 % coolingStep 2COOLINGStep 2$COOLING MONITORING AND INTELLIGENT CONTROL$MONITORING AND INTELLIGENT CONTROL $POWER DISTRIBUTION & BACKUPSavings by optimizing the complete Savings by optimizing the completeCOOLING Infrastructure IT chiller & Piping systems Room-based coolingRack-based coolingSuite-based coolingPiping systems•Cooling output from 8.5 to 462 kW•Redundant pump design •Cooling output up to 118 kW •Efficiency can be increased withoptional aisle containment systems •High-performance cooling with up to 30 kW / rack •High energy efficiency•Cooling system integrated into the enclosure suite•Efficiency can be increased with ti l i l t i t t •Optimised COP value •Inexpensive plastic pipework•Optimised energy and room efficiencyoptional aisle containment systems •Raised floor not requiredAisle Containment Separate from •Cold Aisle Containment with raised-floor cooling:Aisle Containment –Separate Cold from Warmg-Use of conventional CRAC system-Reduced heights between enclosure and ceiling, maximized raised floor height possible maximized raised-floor height possible-Homogenous temperature distribution in the cold aisle -Extended life-cycle of raised-floor cooling systems•Cold Aisle Containment with row-based cooling:-Reduced heights between enclosure and ceiling possible H t t di t ib ti i th ld i l -Homogenous temperature distribution in the cold aisle -Easy pipe work in the plinth components•Hot Aisle Containment with row-based Hot Aisle Containment with row based cooling:-No heat dissipation to an existing data center-Only works with LCP Inline-More capacity for every cooling unit availableMinimize Energy ConsumptionCold Aisle Containment – Where do the savings come from?Energy Savings:Fans: Pumps: Chilled water: Total: 19 MWh/a 6 MWh/a 65 MWh/a 90 MWh/aQnet (Qsens.) Tair;return (rel. hum.) Tair;supply (rel. hum.) Vair (ext. press.) Twater;in t i Twater;out Vwater (Pelectr.) Pelectr. for CRAC fans Pelectr. for chilled water Pelectr. total80kW (80kW) 26°C (45%) 15°C (89%)80kW (80kW) 36°C(25%) 21,3°C(54,2%) 17000m³/h (20Pa)22000m³/h (80Pa) 10 C 10°C 15°C 15 C 15°C 23,5°C13,8m³/h (3kW) 3,6kW 1,5kW8,09m³/h (2,3kW)190MWh/a 248MWh/a125MWh/a 158MWh/aCost Savings with Cold Aisle Containment: Up to 36%INDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS2121DCD Hong Kong 2010Minimize Energy ConsumptionCold Aisle Containment – Where do the savings come from?Cost Savings for a cell of 80KW: g 108,000HK per year*ROI for the CAC in 1,5 years!*1kWh = HK$ 1.2INDUSTRIAL ENCLOSURES POWER DISTRIBUTION ELECTRONIC PACKAGING SYSTEM CLIMATE CONTROL IT SYSTEMS2222DCD Hong Kong 2010Minimize Energy ConsumptionCold Aisle Containment – Reference 30 % less energy consumed by means simple optimising• • Host Europe – 3rd largest provider of hosting solutions 2 separated data centres with about 24,000 servers; one of them used to be a warehouse that had to be converted to fulfil data centre standardsInitial situation: Data centre in a former warehouse with 500 racks and raised floor cooling based on CRAC systems Effect: Cold and warm air was mixed in front of the servers. Air inlet temperature has to be a couple of °C below the temperature required C to cool the servers Solution: Aisle containment system installed and server front transferred to the separated area (cold aisle) Effect: This prevents cold and warm air from mixing up, and helps to increase inlet temperature. After free cooling was added, f f 30% less energy was consumedINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS2323DCD Hong Kong 2010Minimize Energy ConsumptionSavings through revolutionary MONITORING AND CONTROLRiZone• is the data centre management software from Rittal • permits the administration of the th complete physical i f t t l t h i l infrastructure of a data centreMKD• Compact design, 1 U only • Various keyboard layouts • VGA input • Optional KVM switch (SSC view) for 8 or 32 servers may be integratedKVM• The right KVM solution for any KVM solution • KVM-over-IP and multi-user environments with up t 2 048 servers i t ith to 2,048 • May be extended at any timeDynamic Rack Control• Asset management based on RFID • Exact overview of unused U slots inside the rack • Information is saved on tags as specified by ISO standardsINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS2424DCD Hong Kong 2010Minimize Energy ConsumptionWhat is RiZone?Facts and features:+ RiZone is the new infrastructure management software + RiZone monitors and controls: + Intelligent power supply, distribution and back-up + Cooling generation and distribution y + Enclosure security + Room security + Efficiency and energy consumption$ Saves cost by ...Increasing security and reliability of the data centre • Saving energy consumption with monitoring and control functions • Offering a modular, scalable license model to suit g , the customer's requirements•INDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS2525DCD Hong Kong 2010Minimize Energy ConsumptionRiZone - InterfacesBacNet and other GLT protocols via partnersUPS systemsCMCUPS CMC PSMBACnet Ri4PowerDynamic y Rack ControlRi4 PowerPower distributionCooling / LCPDynamic Rack ControlChillerCoolingIT chillerINDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS2626DCD Hong Kong 2010Minimize Energy ConsumptionRFID Based Inventory Management Facts and features:+ + + Components installed inside the rack can be precisely located down to a U Server-related data such as power consumption and p p service times can be saved systematically Easy to integrate into the Rittal CMC and RiZone systems Saves time by ... • Displays all components inside the rack at the push of a button • A user-friendly administration tool for a large number of servers $ Saves cost by ... • Optimising rack assignment by organising and displaying power consumption • Protecting against losses of hardware and data; it f issues alarm messages when components are dismantledINDUSTRIAL ENCLOSURES POWER DISTRIBUTION ELECTRONIC PACKAGING SYSTEM CLIMATE CONTROL IT SYSTEMS2727DCD Hong Kong 2010Minimize Energy ConsumptionRiZone – Management PackFacts and features:+ Member of the Microsoft System Center Alliance p y y g y + A physical infrastructure may be allocated logically to an application that is provided by a server. + New options of defining availability and energy saving functionsBenefits:Displays the data centre's power usage effectiveness (PUE) • Higher availability because based on organised planning beforehand • Capable of determining consumption figures down to server level • E Energy consumption i optimised while i ti is ti i d hil increasing i availability•INDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS2828DCD Hong Kong 2010Minimize Energy ConsumptionHolistic Control Algorithm – cool only what you need!RiZone monitors permanently the complete cooling chain:o cooling (chillers, free coolers) o cooling transportation (pumps, valves) o cooling distribution (LCP, CRAC)Gain in cooling efficiencySub-optimum cooling output Optimum cooling output IT loadOnce all parameters are known the software creates a control algorithm to keep the server air inlet temperature constantThe Result: The automatic adjustments of the operating points of each component results in an optimum in energy efficiency of the overall systemINDUSTRIAL ENCLOSURES POWER DISTRIBUTION ELECTRONIC PACKAGING SYSTEM CLIMATE CONTROL IT SYSTEMS2929DCD Hong Kong 2010Minimize Energy ConsumptionIT Power Distribution & BackupLow-voltage main distributor with Ri4Power•Power back-up with the UPS system PMC• Rack-mounted modular design Rack-mounted,• •Power sub-distribution with PDR and PDM• Modular construction; can be extended with the system operational•Busbar systems up to 5 500 A for 5,500 individual configurations Integrates measuring systems for different worksPower distribution inside the rack with PSM• •Scalable up to 960 kW Highly efficient, with 95% energy conversion efficiency in the partial load range alreadyPlug and play power supply Modules with different sockets Manageable modules with current measuring and switching functions•Phase current up to 250 A at the input; VDE-certified Shock-hazard protected••INDUSTRIAL ENCLOSURESPOWER DISTRIBUTIONELECTRONIC PACKAGINGSYSTEM CLIMATE CONTROLIT SYSTEMS3030DCD Hong Kong 2010Modular &Scalable UPS Solutions from 1kW Modular & Scalable UPS Solutions from 1kW –960kWPMC 12PMC 40PMC 200PMC 800All according to VFI All according to VFI--SS SS--1111 –18 kVA•Compact, 1-phase UPS •Scalable autonomyUp to 55min at 100%load 10 –40 kW•Rack-independent, 3-phase UPS •Redundant system for maximum availability 8 –800 kW•High level of efficiency: 95% •Flexible, almost unlimited scalability and redundancy 64 –960 kW•Maximum availability and performance in a modular design Up to 55 min. at 100% load •Optional monitoring via web browsermaximum availability•Mixed population e.g. with servers in the same rack also supportedscalability and redundancy.•Less capital tie-up,may be expanded thanks to its modularity•Service-friendly because modules are divided into a power and a control modulel Saves time by ... Making maintenance work easier and quicker whilst the system is operational due to a rack-mounted,modular system$Saves cost by ... High-level efficiency and scalability in line with requirementsLow loads + high efficiencyLow loads+high efficiencyGrow with your demand ––Stop wasting money and energy!Z Grow with your demand2%Efficiency makes a major difference2% Efficiency makes a major differenceRittal PMC 200PMC 200XYThe simple route to the perfect Data CenterStep 3Step3Reduce your DC footprintMinimize Energy ConsumptionDeploy modular DC InfrastructureModular IT-Infrastructure Solutions...RimatriX5Pay as you grow!Pay as you grow!•A total scalable solution thatcontains 5 elements:–Rack –Power –Cooling –Security–Remote Mgmt & MonitoringHot Plug &Play Power infrastructure PMC modular UPSHot Plug & Play Power infrastructurePMC -modular UPS ►N+1 technology in one rack►Real modularity, even for batteries ►High level of efficiencyPDR –power distribution rack ►power sub distribution►Plug & play technologyWith all benefits of a pre-wired system ►With all benefits of a pre-wired systemPDM -power distribution modules40kW power distribution per rack►40 kW power distribution per rack ►Plug & play installationPSM Modular iPDUsPSM -Modular iPDUs ►Fully shock-hazard protected busbar ►Minimum assembly costsBenefits of modular and scalable UPS solutions Only invest what you need...Benefits of modular and scalable UPS solutionsZ No need to back up and cool another 80kW!Plug &Play Power Distribution Rack Plug & Play Power Distribution RackFacts and features:+Power distribution rack designed to accommodate up to 8Power Distribution Modules (PDM)+ 4 racks (PSM busbars) may be connected to each PDM module+Simple installation and expansion while operational due to l t t t h d t tiSaves time bycomplete contact hazard protection +Pre-configured cables also available in special lengthsl Saves time by ... •Easy to expand without the help oftrained personnel, even whilst the system is operational •Quick to service thanks to its modular design Quick to service thanks to its modular design $Saves cost by ...•Minimising installation costs due to plug &play Minimising installation costs due to plug & play technologyPlug &Play Power Strip Facts and features:Plug & Play Power Strip +Modular power distribution in IT racks+3-phase system with redundant power supply (A/B) up to 192 A+Plug-in modules with different sockets, (e.g. C13 / C19) and country versions+Modules that can be actively managed, including currenti d it hi f ti d t i di id l l Saves time by ...measuring and switching functions down to individualoutputs•Facilitating module replacement during service works or expansion while the system is operational $Saves cost by ...•Ensuring a redundant power supply in a single busbar •Facilitating integration into Rittal's IT racks •Saving valuable height units inside the rack •Using the remote management function via IPModular Monitoring and Fire Extinguishing Modular Monitoring and Fire ExtinguishingCMC TC Fire detection and extinguishers CMC-TC•The Rittal sensor network:It can monitor temperatures andair humidity, for instance and also links with PSM or LCP for example.Fire detection and extinguishers•Preventive solutions for data centres•Systems for early fire detection d ti i hiPSM or LCP for example.•Can be connected by cables or with wireless systemsand extinguishingDeploy Modular DC InfrastructurePhysical IT Security Physical IT SecurityInternal requirements •Data loss / replacement cost •EDP failure / economic loss•Economic espionage /loss of know-how Legislation / directives•Federal Data Protection Act •EU legislation / Product liability law •Quality assurance systems: ISO 9001/ Economic espionage / loss of know how •Accidents / fire / arson •Theft / sabotage / manipulationISO 27001•Expert guidelines (VdS in Germany)•Basel II, Solvency II and Sarbanes-Oxley ActData Centre Container Mini data centre Data centre Micro data centre Data Centre Container•Temporary outdoor data centre during conversions, extension or relocationsE ffi i th h di t f Mini data centre•Energy-efficient climate control •Monitoring and extinguisher system •Modular UPS and power distribution Data centre•Physical security:From high availability to basic protectionR i t i t d k ith Micro data centre•The smallest security solution: 15 U, turn-key,including physical security I l li t t l t•Energy efficiency through direct free cooling (PUE less than 1.2)•Provides space for 329 UModular UPS and power distribution Physical protection against threats likefire, water, smoke gases and burglary•Requirement-oriented package with energy-efficient infrastructure•Incl. climate control conceptAPAC:Selected References APAC: Selected ReferencesEfficiency up costs down!Thank you!Efficiency up –costs down!yEfficiencyCO2 emissions Costs。

硬件+软件+服务

硬件+软件+服务作者:来源:《中国计算机报》2014年第48期工业4.0、大数据……正向我们袭来。

作为领先的系统解决方案提供商,威图一方面推出高密度制冷解决方案,另一方面不断优化模块化解决方案,同时还采用“硬件+软件+服务”的战略,提出“更快、更好、无处不在”的口号,旨在为用户提供绿色、节能、可靠的服务的同时,走出自己的工业4.0之路。

在工业4.0正炙手可热之际,作为领先的系统解决方案提供商,威图(Rittal)近日展示了旗下的Micro Data Center(微型数据中心)、DCIM软件平台RiZone和LCP机柜空调三大数据中心系统解决方案。

这些解决方案涵盖了机柜管理、配电管理、温度控制、监控和安全管理等功能,旨在为用户提供绿色、节能、可靠的服务。

经过50多年的发展,威图已经成为全球领先的机箱机柜系统供应商。

但是,未来的制造可能是融入大数据和互联网,通过各种信息技术来实现的柔性制造。

那么,如何才能建设绿色、高效、节能、安全的数据中心,以应对大数据时代的数据中心变革,引领数据中心行业稳健发展呢?高密度制冷方案是趋势近几年,大数据开始全面跃入大众视野。

“数据,已经渗透到当今每一个行业和业务职能领域,成为重要的生产因素。

”最早提出“大数据”时代到来的是全球知名咨询公司麦肯锡。

在大数据时代,数据将不断被存储和挖掘,这就意味着更大一波的数据中心基础建设浪潮到来,这也对数据中心建设提出了新的要求。

过去企业在规划数据中心时以面积作为标准,利用效率非常低。

随着数据中心的密度越来越高,服务器集群规模越来越大,单纯地扩大规模已经无法解决数据中心的散热和能耗问题,而且会带来更多的管理难题。

威图电子机械技术(上海)有限公司IT事业部经理韩勇认为:散热和能耗一直是数据中心建设过程中的重要话题,如今用户急需把关注焦点从面积转移到热密度上。

传统机房机柜热密度在4千瓦以下,远不足15~20千瓦/机柜的标准。

如果能有效提升机柜热密度,那么仅空调能耗就可减少30%~50%。

数据中心的制冷与散热

数据中心的制冷与散热在当今数字化时代,数据中心已成为支撑企业运营、互联网服务和科技创新的关键基础设施。

然而,随着数据中心的规模不断扩大,其产生的热量也日益惊人。

高效的制冷与散热系统对于确保数据中心的稳定运行、延长设备寿命以及降低能耗至关重要。

数据中心的设备,如服务器、存储设备和网络交换机等,在运行过程中会不断产生大量的热量。

如果这些热量不能及时有效地散发出去,设备的温度将迅速升高,从而导致性能下降、故障甚至损坏。

此外,高温环境还会缩短电子元件的使用寿命,增加维修和更换成本。

因此,制冷与散热是数据中心运营中必须要解决的重要问题。

目前,数据中心常见的制冷方式主要包括风冷和液冷两种。

风冷是最为常见和传统的制冷方式。

它通过空调系统将冷空气吹入数据中心,然后冷空气吸收设备产生的热量后变成热空气,再被排出数据中心。

风冷系统的优点是安装和维护相对简单,成本较低。

但是,随着数据中心的密度不断增加,风冷系统在散热效率方面逐渐显得力不从心。

因为空气的热导率较低,对于高密度的服务器机架,风冷很难实现均匀和高效的散热。

液冷则是一种更为先进和高效的制冷方式。

液冷系统主要包括直接液冷和间接液冷两种类型。

直接液冷是将冷却液直接与服务器的发热部件接触,从而迅速带走热量。

间接液冷则是通过热交换器将冷却液与发热部件隔开,冷却液吸收热量后通过外部的冷却装置进行散热。

液冷的优势在于其散热效率极高,能够有效地应对高功率密度的服务器。

此外,由于冷却液的热导率远高于空气,所以液冷系统可以实现更均匀的散热,从而提高设备的稳定性和可靠性。

在散热技术方面,热交换技术是一个重要的手段。

热交换器可以将数据中心内部的热量传递到外部环境中,而不需要直接将热空气排放到室外。

这种方式可以在一定程度上降低制冷系统的能耗。

另外,自然冷却技术也越来越受到关注。

在适宜的气候条件下,利用室外的低温空气来冷却数据中心,可以大大减少机械制冷的使用,从而降低能源消耗。

为了实现高效的制冷与散热,数据中心的布局和气流组织也非常关键。

数据中心建设TIA标准级别定义

数据中心建设TIA -942标准级别定义详解一、数据中心定级T1数据中心:基本型可用级别为99.67%;一年中断28.908小时 T1数据中心可以接受数据业务的计划性和非计划性中断..要求提供计算机配电和冷却系统;但不一定要求高架地板、UPS或者发电机组..如果没有UPS或发电机系统;那么这将是一格单回路系统并将产生多处单点故障..在年度检修和维护时;这类系统将完全宕机;遇紧急状态时宕机的频率会更高;同时操作故障或设备自身故障也会导致系统中断..T2数据中心:组件冗余可用级别为99.75%;一年中断21.9小时 T2数据中心的设备具有组件冗余功能;以减少计划性和非计划性的系统中断..这类数据中心要求提供高架地板;UPS和发电机组;同时设备容量设计应满足N+1备用要求;单路由配送..当重要的电力设备或其他组件需要维护时;可以通过设备切换来实现系统不中断或段时间中断..T3数据中心:在线维护全冗余系统可用级别为99.98%;一年中断1.752小时 T3级别的数据中心允许支撑系统设备任何计划性的动作而不会导致机房设备的任何服务中断..计划性的动作包括规划好的定期的维护、保养、元器件更换、设备扩容或减容、系统或设备测试等等..大型数据中心会安装冷冻水系统;要求双路或环路供水..当其他路由执行维护或测试动作时;必须保证工作路由具有足够的容量和能力支撑系统的正常运行..非计划性动作诸如操作错误;设备自身故障等导致数据中心中断是可以接受的..当业主有商业需求或有充足的预算追加;T3机房应可以方便升级为T4机房..T4数据中心:容错系统可用级别为99.995%;一年中断0.438小时;约26分钟 T4级别的数据中心要求支撑系统有足够的容量和能力规避任何计划性动作导致的重要负荷停机风险..同时容错功能要求支撑系统有能力避免至少1次非计划性的故障或者事件导致的重要负荷停机风险;这要求至少两个实时有效地配送路由;N+N是典型的系统架构..对于电器系统;两个独立的N+1UPS是一定要设置的..但根据消防电气规范的规定;火灾时允许消防电力系统强切..T4机房要求所有的机房设备双路容错供电..同时应注意T4机房支撑设备必须与机房IT设备的特性相匹配..二、建筑定级建筑T1级别对于可能引起数据中心瘫痪的人为地或自然灾害不做任何建筑防护措施:设备区地面活荷载不小于7.2kPa;同时露面另需满足1.2kPa的吊挂活荷载..建筑T2级别T2机房应满足所有T1机房的要求外应有建筑防护用于避免由于自然灾害或人为破坏造成的机房瘫痪:机房区域的隔离吊顶应能阻止湿气侵入并破坏机房设备的实用;所有安防门应为金属框实心木门;安防设备间和安防室的门应提供180度全视角观察孔;所有的安防门必须为全高门由地面到吊顶;安保设备间及安保室的隔离墙必须为硬质隔离并加装厚度不小于16mm三合板;至少每隔300mm要用螺丝固定;设备区地面活荷载不小于8.4kPa;同时露面另需满足1.2kPa的吊挂活荷载..建筑T3级别除满足T2要求外还应满足如下要求:需提供备用的出入口和安全监察点;提供备用的安全出入通道;机房外墙上不能有外窗;建筑系统应提供电磁屏蔽保护;钢结构应提供电磁屏蔽保护;屏蔽层可以是贴铝箔的板材或金属网;机房入口应设置防跟入系统;对于冗余的设备应提供物理隔断以降低同时宕机的可能性;应设置防护栅栏以控制非正常侵入事件;同时建筑外围应设置微波探测和视频监控系统;厂区应设置门禁控制系统;机房区;动力区应设置门禁系统;并提供门禁控制中心监控系统;设备区地面活荷载不小于12kPa;同时楼面另需满足2.4kPa的吊挂活荷载..建筑T4级别除满足T3要求外还应满足如下要求:考虑对于同意灾害的冗余保护措施;考虑潜在的地震、洪水、火灾、暴风、暴风雨以及恐怖主义者或精神病人防护措施;柴油发动机应位于室外或其他建筑内;在室外规划油罐区且尽量靠近柴油机;位于地震带1;1和2上的数据中心建筑抗震按地震带3的要求设计抗震;位于地震带3和4上的数据中心抗震按地震带4的要求设计抗震;所有的设备设计重要系数取1.5;位于地震带3和4上的数据中心设备和机架应设计顶安装的抗震支架;设备区地面活荷载不小于12kPa;同时楼面另需满足2.4kPa的吊顶活荷载..二、电气定级电气T1级别T1级别的机房只需要提供最低的电气配电以满足IT设备负荷要求;供电容量少量或无冗余要求;单路供电;供电回路无检修冗余要求;单套等容量柴油发动机系统可以安装用于容量备用;但不需要冗余;ATS开关用于柴油机发电机系统和变压器系统的电力切换;ATS并不是强制要求的;需要提供模拟负载;需要提供单套等容量UPS系统;UPS 系统应与柴油机系统兼容;UPS应带有维修旁路以确保UPS检修时正常供电;应急电源可以来至不同的变压器和配电盘;变压器应能满足非线性负载实用要求;要求提供PDU和现场隔离变压器;配电系统不需要冗余;提供接地系统;数据中心接地干网不需要;但应满足设备制造商的接地要求;防雷保护应满足NFPA780相关规定;电气T2级别T2级别数据中心除满足T1要求外;还应满足如下要求: T2机房应提供N+1的UPS系统..提供发电机系统;其容量应满足所有数据中心负荷要求;备用发电机是不需要的..动力设备和配电设备不需要冗余设计..发电机和UPS系统测试时应提供模拟负载连接..重要的机房设备配电应提供集中地PDU配电..PDU出线应配置分支回路..两个冗余的PDU应有不同的UPS系统供电;并为同一IT配线架供电..单项或三项IT机架供电来源不同的PDU;且双路电源可实现静态无间隙转换..双进线静态转换PDU供电来自不同的UPS系统;并可为单项或三项设备供电..颜色标示标准被用来区分A;B两路供电电缆..每个回路只能为一个配线架供电;防止单回路故障影响过多的配线架..为实现配电冗余;每个机架或机柜配电回路开关容量为20A;来源于不同的PDU或配电盘..满足NEMAL5-20R标准的工业自锁插座被要求应用于机架配电系统;同时配电开关容量应根据设备容量调整放大;并标明配电回路来源..机械设备配电不需要冗余设计..要求提供接地系统;接地电阻小于5欧姆..要求消防电力系统强切..电气T3级别T3级别数据中心除满足T2要求外;还应满足如下要求: T3数据中心要求所有的机房设备配电、机械设备配电、配电路由、发电机、UPS等等提供N+1冗余;同时空调末端双电源配电;电缆和配电柜的维护或单点故障不影响设备运行..中高压系统至少双路供电;配置ATS;干式变压器;变压器在自然风冷状态下满足N+1或2N冗余;在线柴油机系统用于电力中断时电源供应..储油罐就近安装于厂区;并满足柴油机满载72小时运行..市电失电时通过ATS自动将油机系统电力计入主系统..双供油泵系统可以手动或自动控制;配电来自不同电源..提供独立的冗余的日用油罐和供油管路系统;以确保故障或油路污染时仍然能正常的为油机供油;不影响油机运行..油机应装备双启动器和双电池系统..ASTS用于PDU实现双路拓扑的配电体系用于重要IT负荷配电..设置中央电力监控系统用于监控所有主要的电力系统设备如主配电柜、主开关、发电机、UPS、ASTS、PDU、MCC、浪涌保护、机械系统等..另外需提供一套独立的可编程逻辑控制系统PLC用于机械系统的监控和运行管理;以提高系统的运行效率;同时一套冗余的服务器系统用于保证控制系统的稳定运行..电气T4级别T4级别数据中心除满足T3要求外;还应满足如下要求: T4机房所有设备、系统、模块、路由等需设计2N+1模式;所有进线和设备具有手动旁路以便于设备维护和故障时检修;在重要负荷不断电的情况下实现故障电源与待机电源的自动切换;电池监控系统可以实时监视电池的内阻、温度、故障等状态;以确保电池时刻处于良好的工作状态;机房设备维修通道必须与其他重要设备维修通道隔离;建筑至少有两路电力或其他动力进线路由并相互备用..四、机械定级机械T1级别空调系统设置单台或多台空调设备集中制冷用来维持重要区域的温湿度;设备不需要冗余;如果空调系统采用水冷设备如冷冻水系统或冷却水系统;那么在满足设计条件的前提下;尽量采用相同规格的设备;设备不需要冗余;管路系统采用单回路系统;因此管路故障或维修时;将导致局部或全部的空调系统停机;如果有发电机系统;那么空调设备容量将计入发电机容量内..机械T2级别T2级别的数据中心空调系统是采用多台空调设备集中制冷来维持重要区域的温湿度控制要求;一般采用N+1的备用方式;如果采用水冷系统;相关设备需要采用相同规格;并提供额外1台设备用于备用;管路系统采用单回路系统;因此管路故障或维修时;将导致局部或全部的空调系统停机;机房空调系统应设计全年365天;每周7天;每天24小时连续运行模式;机房空调至少采用N+1备用模式;同时每三台或四台设备要求至少提供一台备用;机房及其辅助区域相对于室外要求维持一定的正压;所有的空调设备配电容量应记入发电机容量;为降低电气系统故障对空调系统的影响;空调设备供电尽量来源于多组配电盘的多条回路;温度控制系统配电应来源于UPS且提供冗余的备用电源;数据中心的送风形式应根据机架和服务器的排布来调整;空调机房设备应有充足的容量来抵消所有发热设备和热传导负荷;同时维持一定的机房温度要求;设备的制冷量应基于KW而不是KVA计算;且设备由UPS供电;被处理的空气将通过安装了平衡风阀的穿孔高架地板送到设备处;发电机系统用来给UPS系统和其他机械设备提供电力;厂区内需安装储油罐系统;以满足额定工况下24小时发电机运行;需设计双路供油系统;且可以提供手自动控制;每路供油泵供电来源于独立的配电系统;设计冗余的和相互隔离的储油系统以保证油路污染或其他机械故障时不影响整个发电机系统的运行.. 机械T3级别T3级别的数据中心空调系统是采用多台空调设备集中制冷来维持重要区域的温湿度控制要求;设备冗余的方式是允许单台配电盘故障时空调系统仍能满足制冷需求;如果空调系统采用水冷设备如冷冻水系统或冷却水系统;那么在满足设计条件下的前提下;尽量采用相同规格的设备;设备冗余的方式是允许单台配电盘故障时空调系统仍能满足制冷需求;这个级别的冗余要求空调及其相关设备末端双回路供电;管路系统采用双回路路由;任何管路维护或故障时不会引起空调系统的中断;机房空调电源采用双回路供电;电源来自不同的配电系统;所有的机房空调容量需要记入发电机容量;数据中心制冷设备N+1、N+2、2N或N+1的冗余方式都是可行的;前提是设备维护和故障时不影响正常的制冷要求;针对精密空调的安装数量;考虑到维护和备用的因素;精密空调冷却回路应尽量细化分组;如果实用了冷冻水或冷却水;每个数据中心应有专用的分支回路;并由独立的泵系统从主供水环路上引出;水环路应位于数据中心周边下夹层水槽中;以确保漏水被收集在水槽中;漏液侦测传感器安装于水槽中;检测管路漏水状态;应考虑冷冻水管路的冗余和充分隔离..机械T4级别T3几倍的数据中心空调系统是采用多台空调设备集中制冷来维持重要区域的温湿度控制要求;设备冗余的方式是允许单台配电盘故障时空调系统仍能满足制冷需求;如果空调系统采用水冷设备如冷冻水系统或冷却水系统;那么在满足设计条件下的前提下;尽量采用相同规格的设备;设备冗余方式是允许单台配电盘故障时空调系统仍能满足制冷需求;这个几倍的冗余要求空调及其相关设备末端双回路供电;管路系统采用双回路路由;任何管路维护或故障时不会引起空调系统的中断;机房空调电源采用双回路供电;电源来自不同的配电系统;条件允许的情况下;储水池是可以实用的..。

制冷:数据中心节能的关键

制冷:数据中心节能的关键作者:邹大斌来源:《计算机世界》2015年第28期在数据中心里制冷是耗电大头,高效制冷是数据中心高效节能的关键。

一直以来,降低数据中心的电能消耗、提升能源利用效率都是数据中心的核心需求之一。

根据有关机构的统计,用电成本占数据中心整体运营成本的40%,4年的电费就可以重建一个数据中心,而在数据中心的电力消耗中制冷又是大户,占30%,与IT设备用电相当。

因此,降低制冷用电量对降低数据中心的电能消耗至关重要,特别是如今数据中心正在朝着规模化、大型化发展,对供电部门而言,保障这些巨型数据中心的电力供应存在不小挑战,而在国家大力推进节能减排政策的背景下,这一需求就更加凸显。

根据长期从事空调系统设计的中讯邮电咨询设计院建筑设计部高级工程师李红霞教授的设计经验,在一个典型的T3级数据中心中,空调用电基本接近IT设备,由于IT设备用电属于刚性需求,因此数据中心节能很大程度上依靠空调系统。

不仅如此,在数据中心的各种投资构成中,空调配电系统占比也超过20%。

“可以说,空调系统既是数据中心的基础保证,又是建设中的主要成本,而且是运营成本的关键指标,所以合理设计和选择空调系统对数据中心非常关键。

”李红霞表示。

节能的自然风冷却鉴于在常规数据中心中,空调系统无论是其构建成本还是用电成本都是数据中心的各项成本构成中的重要部分。

因此,一个很自然的想法就是去掉空调。

其中,最为常见的就是利用自然风,特别是在一些高海拔和高寒地区,这一想法得到了很好的实践。

Google在比利时的圣吉兰(Saint Ghislain)数据中心就根本没有冷却装置,完全依靠纯自然冷却,即用室外的新鲜空气来为数据中心降温。

此外,Google还透过“蒸发冷却”的方式来降低空调冷却的费用。

Google位于俄勒冈州的数据中心,其冷却水塔采用蒸发冷却的方式,即先将数据中心所产生的热用冷却水来降温,这些热水再通过冷却水塔与外界的冷空气进行热交换,来达到冷却的目的,这就不需要额外负担电费来将热水降温了,通过这种“免费的冷却模式”来降低数据中心空调的电费。

Rittal数据中心制冷规划和小型数据中心整体解决方案

Racks 3kW each ,CRAC’s 50kW, Chillers 220kW (4 x compressors)

Rittal / Henry Han / 17-09-2012

7

Why are Containment Systems so popular

Cold Aisle Containment • Contains the cold air within the aisle • Increases cooling capacity to 10 kW+ per rack • Can either use CRACS or In Line cooling (60kW In line available) • Retro-fitable in most cases (uses existing CRACS) • Takes up less space than HACs (not In Line cooling) • In line Cooling or CRACs can be used

Higher cooling capacity, with reduction in hotspots

Rittal / Henry Han / 17-09-2012

10

Scaling the Data centre - High Density Infrastructure (N+1)

Year 4 12 3 – 18 56 98 28 Racks, Racks, 15 9 6 3x xx 40kW 40kW 40kW UPS UPS UPS modules, modules, modules, 3 2 1 2 x xx PDR PDR PDR Rack Rack Rack, 3 chillers (15oC out) 0kW 100kW 200kW 300kW 400kW 500kW

维萨拉数据中心冷却系统监测解决方案说明书

应用指南对于几乎任何一家需要依靠高效可靠的软件运作取得成功的公司而言,数据中心就是公司的大脑。

由于数据中心场内存放着相当强大的硬件设备,因此必须要有保护措施避免其受到外界和内部环境的影响,而其所在的建筑物也需要充分冷却。

数据中心通常无人值守,并且位于偏远地区,但它们每年的运行时间却需要达到99.999%(5 个 9),这意味着每年允许的最长停机时间仅为 5 分钟。

数据中心故障可能会对服务商和最终用户的业务造成毁灭性的影响。

因此,维护有助于计算的环境条件至关重要。

数据中心运营商不断努力提高运营效率。

通过采用良好的空调和冷却系统,电源使用效率得到了显著改进。

利用空气侧节能器和绝热冷却技术可节省大量电力,但同时也提高了对空调系统和控制空调系统的可靠仪器的要求。

准确而稳定的仪器可以实现对数据中心冷却系统的高效控制,同时将温度和相对湿度保持在合适的水平。

维萨拉可提供测量湿度、温度和 CO2所需的产品和服务。

我们拥有功能各异的各种传感器,所有这些传感器均可提供同样可靠和稳定的长期测量数据。

数据中心只是维萨拉在全球范围内为其提供湿度和暖通空调传感器的其中一项关键设施应用。

为什么选择维萨拉?我们的核心价值之一就是质量,我们的宗旨则是为客户提供集性能、可靠性以及便利性于一身的产品和服务,满足客户的需求。

我们的传感器由我们自己设计,并在我们位于芬兰的洁净室内制作而成,因此我们可以完全控制其生产质量。

我们研发了相对湿度传感器,并已生产此类传感器 40 余年,产品质量久经考验。

维萨拉 HU MICAP®相对湿度传感器可靠性良好,美国国家航空航天局将其部署于好奇号火星探测车,一同发送到了火星。

我们的暖通空调传感器和变送器在用于实现能源效率优化方面表现良好,广泛应用于冷却塔优化和按需通风等领域。

维萨拉制造的产品经久耐用。

用于数据中心的湿度和条件监测请联系我们,网址为:/zh/lp/contact-form扫描代码获取更多信息参考编号 B211592ZH-C -R ©Vaisala 2021本资料受到版权保护,所有版权为 Vaisala 及其各个合作伙伴所有。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Rittal / Henry Han / 17-09-2012

13

Tuning the CRAC with Cold Aisle Containment

68kW 49kW 110kW

49kW

Cold Aisle Standard Hot Aisle Containment Cold Aisle increases Delta T by Configuration 10o C5oC Delta T

240KW 1,471,680 367,920 2,207,520

40 120平米 11台 40KW LCP Inline

170KW 1,042,440 797,160 3,985,800

* PUE=2

Rittal / Henry Han / 17-09-2012

高效率冷却 – 机柜级制冷

密集安装的服务器系统以及高运算能力 的刀片式服务器产生了大量的热量,威 图创新的LCP液体冷却系统轻松应对单 个机柜高达55KW的热散耗。 LCP系统在解决机房过热问题的同时, 也大幅降低机房噪音至65dBA以下,更 可全面节能30%-50%。

传统精密空调 热密度(单机架) IT设备总功率 4KW 400KW 冷通道封闭 6KW 400KW 列级制冷 10KW 400KW

机架数量 机房面积 空调设备配置

空调设备总功耗 年度耗电(70%) 每年节省 5年节省

100 300平米 5台118KW CRAC

300KW* 1,839,600

70 210平米 5台118KW CRAC

6

Scaling the Data centre - Modular Infrastructure (N+1)

Year 4 12 3 – 140 56 98 28 Racks, Racks, Racks, 9 6 3 12 x x 40kW 40kW x 40kW UPS UPS UPS modules, modules, modules, 3 2 1x x 4PDR PDR x PDR Rack Rack Rack 0kW 100kW 200kW 300kW 400kW 500kW

数据中心制冷规划 小型数据中心整体解决方案

和

DCD Beijing 2012.12.11

Rittal / Henry Han / 02-08-2012

1

Rittal – The System.

IT Systems

Sensor network monitoring UPS systems

1-18 kVA, 1-phase 10 – 960 kW, 3-phase Optimum availability & transparency

15oC 15oC 15oC 20oC

49 kW 68 kW 110 kW 49 kW

3 kW 3 kW 3 kW 1.5 kW

Hot Aisle Cold Aisle

Cold Aisle Containment

Rittal / Henry Han / 17-09-2012

14

彻底节省空间和成本

机房级制冷和列级制冷的对比

Network enclosures Security room

Protection against a large number of physical hazards Network enclosures IT wall-mounted enclosures

Pipework

Optimum design

RiZone Monitoring software for the physical IT infrastructure Fully integrated containers for relocatable applications

Room, raised floor, rack cooling Power distribution

50%

Racks 30kW each ,CRAC’s 50kW, Chillers 265kW (4 x compressors)

Rittal / Henry Han / 17-09-2012

11

数据中心制冷规划

• 数据中心制冷概况 • 数据中心的热密度

• 空调节能的实践

小型数据中心解决方案

• 中小企业数据中心 • 集装箱数据中心 • 保险柜式数据中心

18℃ 10℃ 0℃

根据气象资料, 全年8760小时中,上海 气温低于18℃的时间有 5023小时, 气温低于10℃的时间有 2864小时,占32.7%。

-15℃

Hours

Rittal / Henry Han / 17-09-2012

IT Chiller

专为IT应用打造 -威图循环冷水机组为LCP提供不间断的冷冻水源(15℃)。 -循环冷水机组集成Free Cooling自然冷却技术,拥有杰出的节能效果。 -冷水机组内部关键组件使用冗余设计,双回路,双压缩机,双循环泵, 提高了安全性。

Fully wired and contact hazard proof Individual cooling concepts

Server racks

A large range with comprehensive accessories

IT recooling systems

Holistic solutions for IT cooling

Increased load up to 30kW Increased efficiency

– 35-45% reduction in required real estate – 10-20% reduction on total annual fan power consumption – 30-45% reduction in light related cost. – 12-14% reduction in power delivered to mechanical chilled water plant

Rittal / Henry Han / 17-09-2012

4

Rittal / Henry Han / 17-09-2012

5

数据中心制冷规划

• 数据中心制冷概况

•

数据中心的热密度Biblioteka • 空调节能的实践小型数据中心解决方案

• 中小企业数据中心 • 集装箱数据中心 • 保险柜式数据中心

Rittal / Henry Han / 17-09-2012

Rittal / Henry Han / 17-09-2012

12

Future proofing your cooling

General for rules Increasing Cooling efficiency:•

Separate hot and cold paths • Increase water temperatures • Reduce fan speeds • Reduce pump speeds

Rittal / Henry Han / 17-09-2012

彻底节省空间和成本

机房级制冷和机柜级制冷的对比

传统精密空调 热密度(单机架) IT设备总功率 机架数量 机房面积 空调设备配置 4KW 400KW 100 300平米 5台118KW CRAC 列级制冷 10KW 400KW 40 120平米 11台 40KW LCP Inline 机柜级制冷 25KW 400KW 16 50平米 10台 55KW LCP Rack

Fan Power Fan Power

Fan Power

DeltaT T Delta T Delta TDelta

Air Inlet Temperature

20oC 25oC 30oC 30oC

Fan Power

Delta T

Air Outlet Temperature

CRAC kW Rating

Fan Power

Rittal / Henry Han / 17-09-2012

8

Scaling the Data centre - Cold Aisle Containment (N+1)

Year 56 Racks, 12 3 – 98 56 28 15 Racks, Racks, x 40kW 9 6 3x x UPS 40kW 40kW modules, UPS UPS modules, modules, 3 x PDR 3 2 1Rack, x x PDR PDR 4Rack Rack x chillers (9oC out) 0kW 100kW 200kW 300kW 400kW 500kW

Racks 3kW each ,CRAC’s 50kW, Chillers 220kW (4 x compressors)

Rittal / Henry Han / 17-09-2012

7

Why are Containment Systems so popular

Cold Aisle Containment • Contains the cold air within the aisle • Increases cooling capacity to 10 kW+ per rack • Can either use CRACS or In Line cooling (60kW In line available) • Retro-fitable in most cases (uses existing CRACS) • Takes up less space than HACs (not In Line cooling) • In line Cooling or CRACs can be used