ICTBLAST算法优化与并行算法设计研究

集成电路设计中的算法优化与实践

集成电路设计中的算法优化与实践随着信息技术的不断进步,我们的世界正变得越来越数字化。

而在这个数字化的时代,集成电路(Integrated Circuit, IC)已经成为我们日常生活中必不可少的一部分,尤其是在高科技的领域中。

集成电路主要是由数百万个微小的晶体管组成,构成了电子设备中各种复杂的电路,如计算机芯片、微波电路、数字信号处理器等等。

与此同时,为了更好地发挥集成电路的性能,各种算法也开始登场。

那么,本文将介绍集成电路设计中的算法优化与实践。

一、背景知识在介绍算法优化的基础上,我们需要了解一些背景知识。

现代的计算机由计算器(ALU)、寄存器、控制器等组成,这些单元都是由大量的逻辑门和基本单元组成的。

其中,逻辑门可以实现并、或、非等逻辑运算。

一般而言,逻辑门可以通过门电路(Gate)实现。

集成电路的设计方法主要有两种:可编程逻辑设计(Programmable Logic Design, PLD)和标准单元库设计(Standard Cell Design)。

可编程逻辑设计中使用的主要是通用门阵列(Generic Array Logic, GAL)和可编程逻辑器件(Programmable Logic Device, PLD)。

标准单元库设计采用的是一系列的标准单元,其中包括与门、或门、异或门等。

在工业中,集成电路设计通常采用硬件说明语言,如VHDL、Verilog等,进行模块化设计。

模块化设计使设计过程更容易,同时更快、更简单、更透明、更改基础方式和接口适合硬件设备。

在设计时,通常会进行的任务包括主系统的分解、模块的定义、模块之间的界面和通信协议定义和I/O 状态机的设计。

二、算法优化在集成电路的设计过程中,算法优化是必不可少的一步。

目前,主要的算法优化方法包括:Simulated Annealing Algorithm(模拟退火算法)、Genetic Algorithm(遗传算法)、Particle Swarm Optimization(粒子群算法)等。

并行计算的优化技巧

并行计算的优化技巧并行计算是指将一个大问题分解成多个小问题,并使用多个处理单元同时执行这些小问题的方法。

在当今大数据时代,利用并行计算可以极大地提高计算效率和处理速度。

然而,并行计算本身也面临着许多挑战和问题,因此需要采用一些优化技巧来提高并行计算性能。

本文将介绍一些常用的并行计算优化技巧。

一、任务划分与负载均衡任务划分是将问题分解成多个子问题,并分配给不同的处理单元并行执行。

在任务划分过程中,需要考虑任务的粒度和分配方式。

通常情况下,任务应该被划分成足够小的粒度,以便能够充分利用处理单元;同时,任务的负载均衡也非常重要,即确保每个处理单元的工作量尽可能均衡,避免出现某些处理单元负载过重而造成性能瓶颈。

二、数据通信与同步在并行计算过程中,处理单元之间需要进行数据通信和同步操作。

数据通信包括处理单元之间的数据传输和消息传递,而同步操作则是确保各个处理单元的计算进度同步,以避免数据冲突和计算错误。

因此,良好的数据通信和同步机制是保证并行计算正确性和性能的关键。

三、数据局部性数据局部性是指在并行计算过程中,尽量减少处理单元间的数据传输,使得每个处理单元尽可能地访问本地数据而不是远程数据。

这可以通过合理的任务划分和数据位置优化来实现。

例如,可以将计算任务划分成多个子任务,并将每个子任务与其所需的数据尽可能放置在同一处理单元上,以减少数据传输的开销。

四、并行算法选择并行算法的选择也对并行计算的性能影响巨大。

不同的并行算法适用于不同类型的问题和应用场景。

因此,在进行并行计算时,需要根据问题的特点选择合适的并行算法,以充分发挥并行计算的优势。

五、硬件优化在并行计算中,硬件优化也起着至关重要的作用。

合理选择处理单元的数量、类型和配置,对硬件进行调优和升级,可以显著提升并行计算的性能。

此外,还可以通过使用高效的并行计算工具和库来简化并行计算的编程和调试过程。

六、并行计算性能评估与调优对于复杂的并行计算应用,性能评估和调优是不可或缺的环节。

并行计算算法优化与性能分析

并行计算算法优化与性能分析随着计算机科学和技术的快速发展,计算任务的规模和复杂度不断增加,传统的串行计算已经难以满足处理大规模数据和高性能计算的需求。

并行计算技术应运而生,通过同时使用多个处理单元来执行计算任务,大幅提高计算性能和效率。

然而,并行计算并不是一种简单的将计算任务分配给各个处理单元并同时执行的方式。

为了发挥并行计算的最大潜力,我们需要优化并行算法,并对其性能进行全面的分析。

首先,优化并行计算算法是实现高性能并行计算的关键。

在设计并行算法时,我们需要考虑以下几个因素:1. 数据分布:对于需要进行并行计算的问题,我们需要合理划分输入数据,使之能够同时被多个处理单元处理。

数据划分的负载均衡是优化并行算法的一个关键要素,确保每个处理单元的计算工作量均衡,并最小化通信开销。

2. 通信开销:在并行计算中,不同处理单元之间需要进行数据交换和协同工作。

减少通信开销是提高并行计算性能的重要手段。

我们可以通过减少数据交换的次数和数据量,采用更高效的通信模式(如异步通信)等方式来降低通信开销。

3. 同步机制:并行计算的多个处理单元需要进行协同工作,确保各个单元按照正确的顺序执行。

同步机制是实现协同工作的关键,在设计并行算法时需要明确各个处理单元之间的依赖关系,并合理选择同步机制,以避免冲突和死锁。

其次,对并行计算算法的性能进行分析是进一步优化算法的关键一步。

性能分析可以帮助我们找到并行算法中的瓶颈和热点,从而有针对性地进行优化。

1. 时间复杂度分析:计算并行算法的时间复杂度是评估算法性能的重要指标之一。

通过分析算法的时间复杂度,我们可以了解算法的计算需求和时间开销,从而评估其是否满足实际需求。

2. 并行效率分析:并行效率衡量了并行计算的性能提升程度。

通过比较并行计算与串行计算的时间开销,我们可以评估并行计算的效率。

高并行效率意味着算法能够有效利用并行计算资源,提高计算性能。

3. 加速比分析:加速比是评估并行计算效果的重要指标,它衡量了并行计算相对于串行计算的加速程度。

OpenCL Snort性能优化与并行设计说明书

Parallel Design and Performance Optimization based on OpenCLSnortHongying Xie*,Yangxia Xiang †, Caisen Chen †*Unit 61175, China†Academy of Armored Force Engineering, ChinaKeywords: OpenCL snort, GPU, AC algorithm, parallel programmingAbstractWith the rapid increasement of the network speed and number of threats which hide in the network poses enormous challenges to network intrusion detection systems (NIDS). As the most popular NIDS, snort can run as a single threaded application. However, it may not be able to detect intrusions in real-time especially in networks with high traffic. In this paper, a parallel module OpenCL Snort (OCLSnort) is introduced: realize parallel pattern matching algorithm using GPU and innovate new architecture which is more suitable for the parallel algorithm. The result showed that OCLSnort can detect the attacks correctly and effectively, the new system not only has markedly improved on throughput, also effectively reduced the CPU utilization and memory usage.1 IntroductionIntrusion detection systems (IDSs) are of critical importance to the integrity of computer networks due to massive growth in the data transmission speed and the frequency of attacks. With the rapid development of computer network, more and more data need to be searched, analyzed and detected whether they have threat or not. Such as network monitoring application snort, which is an open source network intrusion prevention and detection system (IDS/IPS) developed by Sourcefire. Combining the benefits of signature, protocol, and anomaly-based inspection, and as so far, Snort is the most widely deployed IDS/IPS technology worldwide [1].In snort, they are using pattern matching algorithm such as AC, BM algorithm to detect thread. Pattern matching is one of the core operations used by applications such as traffic classification [2], intrusion detection systems [3] and content monitoring filters [1]. Unfortunately, packet detecting part occupies the most of the time of the whole processing time in modern NIDSes [4,5] and this operation has significant overheads in terms of both memory space and CPU cycles, so when the data or packet which will be detected is very large, there will be packet-losing problem about snort.Several research efforts have used GPU for security purposes, including cryptography [6], data carving [7] and intrusion detection [8]. And Jacob and Brodley were the first that tried to use the GPU as a pattern matching engine for NIDS in PixelSnort [8]. They changed KMP algorithm to parallel version but the performance result is not very ideal. This paper is organized as follows: In Section 2 and 3, two methods to realize OpenCL snort are presented. In section 4, we evaluate our implementation and compare with the original snort. Experimental results and analysis are given. Finally, conclusions are given in Section 5.2 ArchitectureThe overall architecture of Snort NIDS is shown in Fig.1 and the OpenCL version Snort’s architecture is showed in Fig.2. From Fig.1 and Fig.2, there are some differences between the original snort and the new version snort, one is collecting packets at packet classification part; the other is detecting packet content at packet detecting part.g ss2.1 Packet detecting using OpenCL AC algorithmFor the multi-pattern matching algorithm, the first thing is to build DFA such as Fig.3, and this section is finished before2nd Joint International Information Technology, Mechanical and Electronic Engineering Conference (JIMEC 2017)the beginning of the packet detected in snort. In our design of the OpenCL version Snort, the realized DFA is represented as a two-dimensional state table array that is mapped on the memory space of the GPU. The dimensions of the array are equal to the number of states and the size of the alphabet (256 in our case), respectively. Each cell contains the next state to move, as well as an indication of whether the state is a final state or not.Fig.3 AC State Machine of P atterns “he”, “hers”, “his”, “she” Fig.3 shows a state machine of patterns which used in our OpenCL AC algorithm, from this figure we can see that the difference between original AC state machine and OpenCL AC state machine is that whether it is needed about failure transitions. The failure transitions are used to back-track the state machine to recognize patterns in any location of an input stream. Given a current state and an input character, the original AC machine first looks up the valid transition table to check whether there is a valid transition for the input character; otherwise, the machine looks up the failure transition table and jumps to the failure state where the failure transition points. Then the machine regards the same input character until the character causes a valid transition. In our OpenCL version snort, we used OpenCL to change the AC algorithm for parallelism based on PFAC [9]. The idea of the parallel algorithm of AC is: Give an input stream have N byte, we will create N threads corresponding to N byte. And for each thread, it is only responsible for identifying the pattern starting at the thread starting position. So in OpenCL AC algorithm, the failure transitions of the AC state machine can all be removed as well as the self-loop transition of the initial state. And the whole process of the OpenCL AC is showed by Fig.4.Fig.4 OpenCL AC Algorithm Execution ProcessThere are several characteristics of the OpenCL AC algorithm. First, although it creates huge amounts of threads, most threads have a high probability of terminating very early because a thread in OpenCL AC is only responsible for matching the pattern beginning at its starting position. Second, the maximum detection length of each thread is the maximumlength in whole patterns, and based on this, when the larger the input stream is, the faster the detect speed is. And finally, the failure transitions are all removed when we are using OpenCL AC, and this simplifies the algorithm and the thread can detect the input stream automatically without rollback. 2.2 Packet collecting and transfer to GPUBefore the packet detecting in GPU, the first thing must to consider is how and how many packets will be transferred from the network to the GPU memory. The simplest method is according to the original snort architecture, transfer one packet to GPU for processing once time. However, as we know, the TCP or UDP packet size is usually hundreds byte,the performance is much better batching many small transfers into a large one than making each transfer separately [16].Thus, we realized the two methods (1) using original snort architecture, transferring one packet to GPU once time, and (2)change packet classification part, transferring more than onepackets to GPU once time and get the performancecomparison based on two methods. As we know, the process flow of original snort is showed as Fig.1: capture a packet from network once time, then packet analysis and classification, detecting packet and output the result finally. Using method (1), the process flow can be changed as follows: capture a packet from network, packet analysis and classification is not changed, then transfer the packet to GPU and detecting it using OpenCL AC algorithm, then transfer the results to CPU and output the result finally. So using method (1), we changed Detection part, using OpenCL AC take the place of original ac algorithm and the other part of snort ’s architecture are not changed, processing packet one by one.And using method 1, the performance improvement is not exciting, there are two reasons: (1) the DMA time occupied most of the time; (2) the input stream transferring to GPU only have hundreds byte each time. It does not make full use of GPU resources. Based on this, we proposed a new method that can transfer more than one packets to GPU, the architecture of OpenCL Snort are showed by Fig.2. From Fig.2 we can see the difference between OpenCL Snort and original snort is processing packet number once time. In OpenCL version Snort, we change the interface to realizecapture multi-packets at the beginning of snort and then deal with packets, transfer multi-packets to GPU once time, and finally output alerts/logs.3 Implementation In this section, we are showed the implementation details about the OpenCL version snort. In snort, they are using different rules to detecting whether the packet has threatened or not according to packet type. Different rules create different state transition tables. So we are focus on the packets collecting and the state transition tables correspond to packets part when using method (2) transfer multi-packets to GPU once time.3.1 Transferring a Single Packet to GPUIn this approach, when capturing a packet from network, snort will decode and classify it, then send it to GPU for detecting,send the result to CPU and finally output the result.Assume the packet has N characters, the algorithm will create N threads in GPU if the device has this ability, and else they will create maximum threads which under the device’s ability, then each thread will loop many times to detecting the wholeThis method is very simple, because there is only one packet, and the state transition table which transferred to GPU also has one. So this method need not to find out which state transition table is corresponding to which packet. A drawback of this approach is that the input stream is very small and the DMA time occupied most of the time, so the GPU is not utilized effectively.3.2 Transferring Multi-packets to GPUIn this approach, we will mark the packets which we interfered to GPU as unique packetID, and give a unique tableID for each state transition table which finished creation process and transfer all the state transition tables to GPU. The whole process will be finished at the initialization phase of snort.Using this approach to detect packets, the way to creating threads is the same as method (1), and the difference is the packet must correspond to the state transition table. And this could be solved adding elements packetID and tableID to struct ACSM, and we will also transfer those elements to GPU. In the OpenCL algorithm, we must to judge the packet boundaries in order to get the correct results. The process flow is showed by Fig.6, and example of packets collecting process is showed by Fig.7. From Fig.7, each packet corresponds to a state transition table, so when we transfer packets to GPU, we must to determine the transition table’s address corresponding to each packet.Although this method is complicated comparing with method (1), the input stream transferring into GPU once time is muchindex n4 EvaluationPattern matching is the most critical operation in the snort system. Usually pattern matching algorithm can be classified into single pattern matching algorithm (such as KMP) and multi-patterns algorithm (such as AC).In this section, we explore the performance of our implementation. We realize the two approaches in Snort and compare the two methods with the original snort respectively. In processing multi-packets method, we change the parameter about the collecting packet number once time then get the average time about processing one packet.In our experiments we used an AMD A10-4600m computer, the CPU in this computer is 2.3GHz APU with Radeon™ HD Graphics 4 processor , 8G memory and GPU is AMD Radeon HD 7660G card, the operating system is Ubuntu12.04 64-bit. We get the packets data LLS DDOS 1.0-inside.dump from MIT Lincoln Laboratory [17] as the detected data, we also using snort to dump some small packets date set using the detected data LLS DDOS 1.0-inside.dump, such as contain 200 packets date set, 1000 packets date set, 10000 packets date set and 20000 packets date set, and we read the packets from disk rather than network in order to get the same speed of capture packet in different experiments. We also using the default rules file when using different version snort and this can ensure the correctness of the result.For all experiments, we disregard the time spent in the initialization phase of snort as well as the log of the alerts to the disk or terminal. Even though it only takes just a few seconds to load rule files and build its internal structures. And we used the full AC implementation to measure the performance in original snort.4.1 Performance Comparison between One Packet OpenCL snort and Original snortIn this experiment, input1, input2 and input3 are three different size detected packets and the packets size is 200, 1000 and 10000 respectively. We change the input packet numbers to get the performance data about one packet OpenCL snort and original snort and the performance data is showed by Fig.8. From Fig.8, (1) with the increase of input packet size, the throughput of two methods becomes large; (2)using one packet OpenCL snort, the throughput is not batter than the original snort’s throughput, because the local memory is not large enough, the state transition table is stored in Global memory, when judge the current character meet the conversion criteria or not each time, the algorithm must access the global memory once time; and most of threads are terminated at the beginning of the algorithm, and the GPU’s utilization is not high.Fig.8 Performance Comparison4.2 Performance Analysis about Multi-Packets OpenCL snortIn this experiment, we get the performance comparison about multi-packets OpenCL snort and one packet OpenCL snort. Before this comparison, first thing we must to ensure is when we transfer how many packets to GPU, the algorithm will get the best performance and maximum throughput. Fig.9 showed the algorithm’s performance comparison when transferring different number of packets to GPU. From Fig.9 we can see with the number’s difference, the throughput has some difference as well. When the number which transfers to GPU once time is 30, the throughput is 4.78Gbits/sec, when the number is 100, the throughput is up to 6.43Gbits/sec. And when the number changes from 150 to 200, the throughput grows slowly and then it has a downward trend. So we select 200 as the number which transfers to GPU once time.Fig.9 Performance Comparison of Multi-packets OpenCLSnortThe next experiment we are focus on is the performance comparison about the three version snort: original snort, one packet OpenCL snort and multi-packets OpenCL snort. And the result is showed by Fig.10. In this figure, input1, input2 and input3 are three different size detected packets as the same as Fig.9, the packets size is 150, 1200 and 10000 respectively. From the result, we can see the multi-packets OpenCL snort’s throughput is about two times faster than other two methods. And the GPU’s utilization in multi-packets OpenCL snort is much higher than the one packet OpenCL snort.Fig.10 Performance Comparison on Different Versions 5 ConclusionsIn this paper, we have proposed two OpenCL version snort, one packet OpenCL snort and multi-packets OpenCL snort in order to accelerate packet detecting by GPU. And the result showed that although one packet OpenCL snort’s throughput is about 20% slower than original snort, multi-packets OpenCL snort is about 2 times faster than original snort, and this system was able to achieve a maximum throughput of 6.758Gbit/s.AcknowledgementsThis work is supported by the National Natural Science Foundation of China under Grant No. 61402528, all support is gratefully acknowledged.References[1] Snort: : Home Page. /.[2] Application Layer Packet Classifier for Linux. http://17-/.[3] Clam AntiVirus. /.[4] S. Antonatos, K. Anagnostakis, and E. Markatos.Generating realistic workloads for network intrusion detection systems. In Proceedings of the 4th ACM Workshop on Software and Performance, (2004).[5] J. B. D. Cabrera, J. Gosar,W. Lee, and R. K. Mehra. Onthe statistical distribution of processing times in network intrusion detection. In 43rd IEEE Conference on Decision and Control, 75-80, (2004).[6] D. L. Cook, J. Ioannidis, A. D. Keromytis, and J. Luck.Cryptographics: Secret key cryptography using graphics cards. In Proceedings of RSA Conference, Cryptographer’s Track. 334-350, (2005).[7] G. G. R. I. Lodovico Marziale and V. Roussev. Massivethreading: Using GPUs to increase the performance of digital forensics tools. Digital Investigation. 73–81. [8] N. Jacob and C. Brodley. Offloading IDS computation tothe GPU. In Proceedings of the 22nd Annual Computer Security Applications Conference on Annual Computer Security Applications Conference, Washington, DC, USA, IEEE Computer Society. 371–380, (2006).[9] Lin CH, Tsai SY, Liu CH, Chang SC, Shyu. JMAccelerating string matching using multi-threaded algorithm on gpu. In: GLOBECOM, 1-5, (2010). [10] C. IOS. IPS deployment guide. /.。

高性能计算中的矩阵计算优化与并行算法研究

高性能计算中的矩阵计算优化与并行算法研究概述高性能计算是一项重要的领域,研究人员一直致力于提高计算机系统的运算速度和效率。

在高性能计算的应用中,矩阵计算是一项经常需要处理的任务。

矩阵计算涉及大规模的矩阵操作,如矩阵乘法、矩阵分解等,因此研究和优化矩阵计算算法具有重要的意义。

本文将探讨高性能计算中矩阵计算的优化与并行算法的研究。

矩阵计算优化的挑战在高性能计算中,矩阵计算往往需要处理大规模的矩阵,这就带来了一系列的挑战。

首先,矩阵计算的存储和计算需求非常高,在有限的存储和计算资源下,如何高效地利用这些资源成为了一个关键问题。

其次,大规模矩阵计算的计算复杂度较高,需要大量的计算时间,如何提高计算速度是另一个亟待解决的问题。

此外,矩阵计算涉及大量的数据传输和通信操作,如何降低通信开销,提高算法的并行性也是一个重要的研究方向。

矩阵计算优化策略为了解决上述挑战,研究人员提出了各种优化策略和算法。

下面将介绍一些常用的矩阵计算优化策略。

1. 内存优化内存优化是提高矩阵计算效率的关键一步。

在高性能计算中,借助数据局部性原理,研究人员提出了一系列的内存优化策略。

例如,使用分块矩阵存储方法可以减少数据访问带宽,提高矩阵乘法的计算效率。

此外,研究人员还探索了压缩存储和稀疏矩阵存储方法,以降低存储空间开销。

2. 并行计算并行计算是提高矩阵计算效率的重要手段。

通过将计算任务划分为多个子任务,并利用多个计算节点同时进行计算,可以显著提高计算速度。

在矩阵计算中,研究人员经常使用并行计算模型,如MPI和OpenMP等,以实现矩阵的并行计算。

例如,在矩阵乘法中,可以将矩阵划分成多个子矩阵,分布到不同的计算节点上进行并行计算。

3. 矩阵算法优化优化矩阵算法可以显著提高矩阵计算的效率。

研究人员提出了一系列的矩阵算法优化方法,如Strassen算法、Coppersmith-Winograd算法等。

这些算法利用了矩阵的特殊结构和性质,减少了计算的复杂度。

大规模生物序列比对算法及其并行化研究

大规模生物序列比对算法及其并行化研究一、引言生物学家需要比较大量的生物序列以研究它们之间的相似性和差异性。

在比较序列时,生物学家通常使用序列比对算法。

序列比对是计算两个或多个序列之间的相似性或差异。

序列比对在生物信息学、计算生物学和分子生物学等方面具有广泛的应用,如DNA序列比对、蛋白质序列比对和RNA序列比对等。

大规模生物序列比对算法具有一个基本的问题,即运行时间随着序列的长度增加而增加。

为了解决这个问题,生物信息学家正在通过使用并行计算和分布式计算来提高比对算法的效率。

在本文中,我们将讨论一些流行的序列比对算法以及它们的并行化实现。

二、算法概述序列比对算法通常使用一个矩阵来比较两个序列中的每个字符。

另一种方法是使用基于散列函数的方法来计算每个序列的哈希值。

然后,哈希值可以用于找到两个序列之间的相似性。

然而,这种方法不如矩阵方法精确。

序列比对算法可以分为局部比对和全局比对两类。

局部比对比较两个序列的一小部分,而全局比对比较两个序列的整个长度。

局部比对算法通常用于查找两个序列中的相似区域。

全局比对算法通常用于查找两个序列之间的相似性。

1、局部比对BLAST(基本局部序列比对工具)是一个在生物学领域中广泛使用的局部比对算法。

BLAST使用一种称为k-tuple的基于哈希表的散列函数来计算每个序列的哈希值。

然后,BLAST将这些哈希值与一个称为射线的预定义持久数据结构进行比较,以查找两个序列之间的相似性。

BLAST算法的并行化实现可以通过在多个处理器之间共享射线数据结构来提高效率。

每个处理器负责计算一个哈希表,并且结果可以在共享内存中组合以查找相似性。

2、全局比对Smith-Waterman算法是一种广泛使用的全局比对算法。

Smith-Waterman算法使用一种动态编程方法来计算两个序列的最佳匹配。

使用动态编程,序列比对可以分解为子问题,并使用前一个子问题的结果进行计算当前子问题的结果。

Smith-Waterman算法的主要缺点是它需要大量的计算时间,并且对于长序列来说,它的运行时间会呈指数级增长。

高性能计算中的数据并行算法设计与优化策略

高性能计算中的数据并行算法设计与优化策略在高性能计算领域,数据并行算法设计与优化是一项重要的任务。

数据并行是指将大规模数据划分为多个小数据块,然后在多个处理元素上并行处理这些小数据块。

本文将讨论数据并行算法的设计原则和优化策略。

1. 数据并行算法设计原则数据并行算法的设计原则可以总结为以下几点:1.1 分解数据首先,需要将计算任务的数据划分为多个小块,以便在多个处理元素上并行处理。

划分数据的方法有多种,包括块划分、循环划分和随机划分等。

在选择划分方法时,需要考虑数据之间的依赖关系、处理元素的数量和存储器的访问模式等因素。

1.2 指定任务根据划分的数据块,为每个处理元素指定相应的任务。

任务的指定可以通过任务分配的方式,将不同的数据块分配给不同的处理元素。

此外,还可以利用任务调度的方式,在运行时动态地指定任务。

1.3 执行并行计算在多个处理元素上执行并行计算。

并行计算可以采用多种方式,如SIMD(单指令流多数据流)、MIMD(多指令流多数据流)和SPMD(单程序多数据流)等。

根据任务的特点和处理元素的架构选择合适的并行计算方式。

1.4 合并结果将各个处理元素的计算结果合并为最终的结果。

合并结果时需要考虑数据之间的依赖关系,以确保最终结果的正确性和完整性。

2. 数据并行算法优化策略在设计数据并行算法时,还需要考虑优化策略以提高算法的性能。

以下是一些常用的优化策略:2.1 数据局部性优化数据局部性优化是指尽可能减少处理元素访问存储器的次数,提高数据访问效率。

可以通过数据重用、数据预取和数据对齐等方式来实现数据局部性优化。

2.2 计算与通信重叠优化计算与通信重叠优化是指在计算任务和通信任务之间进行重叠操作,以减少总体执行时间。

可以采用消息传递、流水线和缓存技术等方法来实现计算与通信的重叠。

2.3 负载均衡优化负载均衡优化是指将计算任务均匀地分配给多个处理元素,以确保各个处理元素的负载相等。

可以采用静态负载均衡和动态负载均衡两种方式来实现负载均衡优化。

多序列比对Clustal+w并行算法研究

1.2国内外研究概况

自从Fitch提出基于统计方法、利用计算机来自动地比较蛋白质序列以取代人眼的 观察比较以来,国际上对序列比对的研究已有几十年的历史了。序列比对的点阵图方法 (Gibbs&lIcIntyre)[6]发展较早的一种比对方法, 该方法属于一种图解法,将一条序列 横排在上首,另一个序列在左端。两个序列在任何位置出现相同值,就在两个序列对应 位置的交叉位置上标注一个点。在结果图上,排列成对角线的点列体现出两条序列具体 相同的字符串,从而形象的表明序列间的相似性。

of molecular structure and functions,SO its ealculalion method brings huge regards.Now the

most used method is called gradual sequence alignment algofthrrl,Clustal W program one of

the relative higher similarity.So if it has relatively high similarity among sequences,they are

supposed to have homology.Multiple sequence alignment has vast significance for the studying

calculation time is relatively long.In gradual multiple sequences Clus协l W,it takes the longest

并行优化算法研究

目录页

Contents Page

1. 并行优化算法简介 2. 并行计算基础知识 3. 并行优化算法分类 4. 经典并行优化算法 5. 并行优化算法应用领域 6. 并行优化算法挑战与未来发展 7. 并行优化算法实例分析 8. 总结与展望

并行优化算法研究

并行优化算法简介

并行优化算法简介

新型硬件和计算架构

1.随着新型硬件和计算架构的不断涌现,并行优化算法需要适应这些新的计算环境,以提高性能和 效率。 2.例如,利用GPU和TPU等加速器可以大幅提高并行优化算法的计算速度,而采用分布式存储和计 算架构可以扩展算法的处理能力。 3.在未来的研究中,需要关注新型硬件和计算架构的发展趋势,探索更为高效和稳定的并行优化算 法。

并行计算基础知识

▪ 并行计算应用领域

1.并行计算在科学计算、工程仿真、数据分析等领域得到广泛应用。 2.并行计算可以加速计算过程,提高计算效率,为应用领域提供更好的解决方案。 3.随着并行计算技术的发展,其应用领域也将不断扩大。

▪ 并行计算发展趋势

1.并行计算将继续向更高效、更可扩展的方向发展。 2.人工智能、量子计算等前沿技术将与并行计算相结合,推动其发展。 3.并行计算将成为未来计算机科学技术的重要组成部分,为各领域的发展提供支持。

▪ 遗传算法

1.遗传算法是一种基于生物进化原理的优化算法,它通过模拟自然选择和遗传机制来搜索问题 的最优解。 2.在并行环境中,可以将种群划分成多个子种群,每个子种群在一个处理节点上进行进化计算 ,然后定期交换信息,以加速搜索过程。 3.遗传算法的并行化需要考虑种群划分和交换策略,以及如何处理进化过程中的多样性问题。

1.粒子群优化算法是一种基于群体协作的优化算法,通过粒子间的相互作用搜索最优解。 2.并行化粒子群优化算法可利用多个计算节点同时更新粒子位置和速度,提高搜索效率。 3.针对非凸、多峰的优化问题,需要设计合适的粒子初始化和更新策略。

Blast工具的介绍和并行优化

Blast工具的介绍和并行优化摘要随着基因组计划的实施,分子生物信息迅速的增长。

以核酸序列数据库为代表的分子生物信息数据正以指数增加,而对于这些实验数据在计算机上的存储检索却远远跟不上这种发展。

因此我们需要对原来的生物学数据处理工具进行研究和改进。

本文介绍了当前最为流行的核酸序列数据库检索程序——Blast,分析了制约Blast性能的原因,最后实现了对串行Blast进行并行化,通过在曙光2000上的测试,证实了这种优化工作大大改进Blast的检索性能。

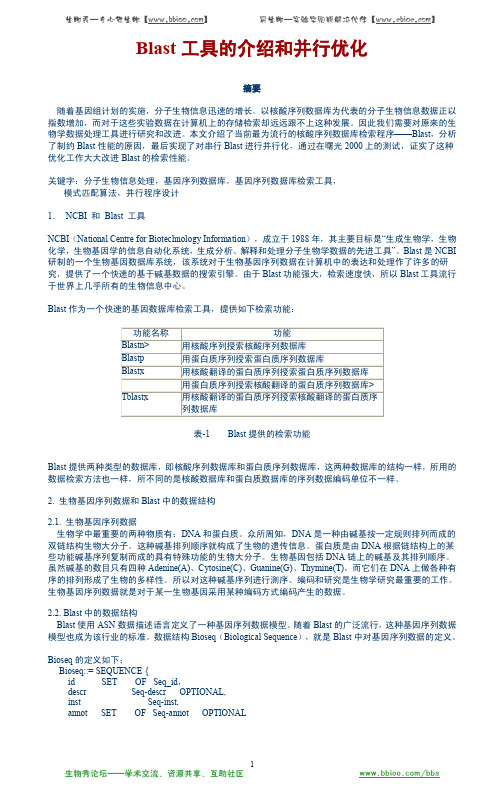

关键字:分子生物信息处理,基因序列数据库,基因序列数据库检索工具,模式匹配算法,并行程序设计1. NCBI 和Blast 工具NCBI(National Centre for Biotechnology Information),成立于1988年,其主要目标是“生成生物学,生物化学,生物基因学的信息自动化系统,生成分析、解释和处理分子生物学数据的先进工具”。

Blast是NCBI 研制的一个生物基因数据库系统,该系统对于生物基因序列数据在计算机中的表达和处理作了许多的研究,提供了一个快速的基于碱基数据的搜索引擎。

由于Blast功能强大,检索速度快,所以Blast工具流行于世界上几乎所有的生物信息中心。

Blast作为一个快速的基因数据库检索工具,提供如下检索功能:功能名称功能Blastn> 用核酸序列授索核酸序列数据库Blastp 用蛋白质序列授索蛋白质序列数据库Blastx 用核酸翻译的蛋白质序列授索蛋白质序列数据库用蛋白质序列授索核酸翻译的蛋白质序列数据库>Tblastx 用核酸翻译的蛋白质序列授索核酸翻译的蛋白质序列数据库表-1 Blast提供的检索功能Blast提供两种类型的数据库,即核酸序列数据库和蛋白质序列数据库,这两种数据库的结构一样,所用的数据检索方法也一样,所不同的是核酸数据库和蛋白质数据库的序列数据编码单位不一样。

2. 生物基因序列数据和Blast中的数据结构2.1. 生物基因序列数据生物学中最重要的两种物质有:DNA和蛋白质。

提高并行计算性能的方法与技术

提高并行计算性能的方法与技术在当今信息时代,计算机的运作速度已经成为了每一个人都很注重的事情。

并行计算技术是一种可以大幅度提升计算机运算速度的技术,而提高并行计算性能的方法与技术是实现这种技术的关键。

本文将会介绍几种提高并行计算性能的方法和技术,以便更加有效地利用计算机。

一、并行计算基础首先,我们需要了解什么是并行计算。

并行计算是指计算机在某一个任务上同一时间可以执行多个子任务,这些子任务之间是相互独立且可以并行执行的。

通俗地说,就是多个“小工人”同时做事,快速完成任务。

为了实现并行计算,目前主要有两种方式:并行硬件和并行软件。

并行硬件指的是电脑内部的多个计算机核心同时执行一个任务,且每个核心之间可以相互协作、通信和同步。

而并行软件是指利用编程语言或编程工具等软件技术方式,将程序分割成若干互相独立的子程序,在不同的核心上并行执行,最后再将结果进行合并。

二、提高并行计算性能的主要方法与技术1. 算法优化算法是计算机软件的基础,算法的优化可以极大地提高并行计算性能。

在实际应用中,算法的优化与并行计算的性能紧密相连。

通常,较为常见的优化方式包括以下几个方面:(1)位运算优化作为计算机的基础运算,位运算在很多场合都可以提高算法的效率。

位运算的优劣程度与算法的类型有关系,但总体来说,它比运用乘法、除法等基本运算要快很多。

(2)矩阵运算优化矩阵运算是计算机并行计算的基础之一,其性能的优化也是最为广泛的。

矩阵乘法是矩阵运算的核心,而且在很多科学计算中都经常出现。

这个问题的解决方式包括块状矩阵乘法、并行化的模拟退火和分布式算法等。

(3)分治优化分治法是一种算法,其基本思想是将一个较复杂的问题分割成若干个小规模的问题,再对小问题进行求解后,将子问题的解组合得到原问题的解。

在并行计算中,分治法的特点时可以提高计算的利用率,从而带来更高的性能。

2. 硬件优化硬件优化指的是通过硬件方式进一步提高并行计算的性能。

目前,最广为人知的硬件优化方式主要是采用更加高效的计算机架构。

使用BLAST算法和部分并行干扰抵消来减小干扰的方法[发明专利]

![使用BLAST算法和部分并行干扰抵消来减小干扰的方法[发明专利]](https://img.taocdn.com/s3/m/7325f2f552d380eb63946d32.png)

专利名称:使用BLAST算法和部分并行干扰抵消来减小干扰的方法

专利类型:发明专利

发明人:郑洪明,关皓

申请号:CN200680020355.0

申请日:20060602

公开号:CN101194433A

公开日:

20080604

专利内容由知识产权出版社提供

摘要:公开了一种用于在MIMO多码MC-CDMA系统中减小干扰的方法,其中在一块相关接收数据y以及该相关接收数据y的估计信道值H上执行BLAST算法,以产生一组临时判决符号C。

从临时判决值中选择具有最大SNR值的一个符号(I)。

将除了被选择的符号(I)之外的所述临时判决符号C与估计信道值H相组合,以恢复被选择的符号(I)上的一组临时干扰信号。

将干扰信号从相关接收信号向量y 中减去以产生修正的接收信号向量y,并且根据修正的接收信号向量y和原始估计信道值,识别更为准确的判决符号(II)。

针对其它符号(III)重复上述步骤。

申请人:诺基亚公司

地址:芬兰埃斯波

国籍:FI

代理机构:北京市金杜律师事务所

代理人:吴立明

更多信息请下载全文后查看。

组合优化问题算法的并行计算研究

组合优化问题算法的并行计算研究随着计算机科学和技术领域的不断发展和进步,人们能够解决的问题变得越来越复杂。

其中,组合优化问题一直是研究重点。

组合优化问题是求解最大或最小化问题的过程,它要求在一个给定的约束集合内找到一个最大值或最小值。

对于大规模的组合优化问题,串行计算是非常耗时的,而并行计算在解决这些问题上具有较好的优势。

一、组合优化问题简介组合优化问题是在一个有限集合内通过选择一个特定的子集或排列来解决问题的一类问题。

具体而言,这些问题被描述为:现有一组对象,如房屋、车辆或工作任务。

这些对象之间有一些限制或偏好条件,例如某些任务需要特定技能或者某些房屋不能够在同一个区域内出租。

组合优化问题的目标是找到最佳的子集或排列,以满足给定的条件。

组合优化问题可以分为两类:一个是独立决策问题,另一个是集合覆盖问题。

独立决策问题涉及到能够独立选择的对象或事项,而集合覆盖问题涉及到全部对象需要被至少一个特定的选择集合所覆盖。

具体而言,组合优化问题可以涉及到排课问题、航线计划问题、医院排班问题等。

二、组合优化问题的难点虽然组合优化问题看起来很简单,但实际上非常困难。

一个很小的问题就可能会有许多不同的解决方案。

一个更大的问题可能会有几百万、甚至数十亿个解决方案,从而使得计算非常困难或者不可行。

此外,组合优化问题还包含复杂性问题。

在计算复杂性理论中,组合优化问题属于 NP 难问题。

这意味着当前的最佳算法可能需要在有效执行时间内寻找可行的解决方案。

然而,这通常是不可能的。

因此,人们一直在寻找更好的算法来处理这些问题。

三、并行计算在组合优化问题中的应用并行计算是将一个大问题分解成多个小问题,并将它们分配到多个处理器上并行计算的过程。

在组合优化问题中,并行计算的应用已经变得越来越流行。

并行计算可以加快计算速度,从而节省时间和成本。

此外,它还允许大型数据集和处理规模变得可能。

在组合优化问题中,有许多方法可以实现并行计算,例如并行贪心算法、并行遗传算法、并行模拟退火算法等。

超级计算机架构和算法优化方法研究

超级计算机架构和算法优化方法研究超级计算机作为一种高性能计算工具,对于各种复杂的科学计算和工程问题的求解具有重要作用。

超级计算机架构和算法优化方法是其中两个关键的研究方向。

本文将从架构和算法两方面探讨超级计算机的设计与优化方法。

超级计算机架构是构建高性能计算的基础。

大规模并行计算是超级计算机的重要特点,应用了分布式计算的思想。

基于此,超级计算机中常采用多节点和多核心的设计,充分利用并行处理能力来提高计算性能。

此外,存储系统也是超级计算机的重要组成部分。

超级计算机中的存储系统既需要具备高容量和高速度的特性,又要兼顾可靠性和扩展性。

因此,超级计算机的架构设计需要考虑节点之间的通信和协同工作,以及存储系统和计算节点之间的数据传输和数据管理等问题。

在超级计算机的架构设计中,还需要关注功耗和散热等问题。

超级计算机的高性能计算需要消耗大量的能源,会产生大量的热量。

为了保证超级计算机的稳定运行,必须针对架构设计进行散热和能源管理的优化。

目前,一些新型的散热技术和能耗管理策略被广泛应用于超级计算机中,以提高其能效和可靠性。

除了架构设计,算法优化方法也是提高超级计算机性能的重要手段。

超级计算机中的算法优化主要包括并行算法和自适应算法两个方面。

并行算法通过将计算任务划分成多个子任务,并将这些子任务分配到不同的计算节点上并行执行,以充分发挥计算资源的并行处理能力。

自适应算法可根据具体的计算环境和任务特性,自动调整算法的参数和计算策略,以达到更好的性能和效果。

并行算法的设计和优化是超级计算机中的核心问题。

在设计并行算法时,需要考虑计算和通信之间的负载均衡,尽可能减少通信的延迟和开销,并提高并行算法的可扩展性。

此外,超级计算机中还需要面对大规模数据处理和复杂任务调度等挑战。

因此,如何设计高效的并行算法,是提高超级计算机性能的关键。

自适应算法的设计和优化是超级计算机中的另一个重要方向。

自适应算法的设计需要充分考虑计算任务的特性和目标,通过动态调整算法的参数和策略,以适应不同的计算场景和环境变化。

高性能计算中的并行处理芯片设计与优化

高性能计算中的并行处理芯片设计与优化在高性能计算领域中,为了提高计算效率和处理速度,广泛采用了并行处理芯片设计与优化。

本文将介绍并行处理芯片设计与优化的相关概念、方法和技术,并探讨其在高性能计算中的应用。

一、概述并行处理芯片设计与优化是指利用多个处理单元同时工作,以提高计算机系统的运算速度和处理能力。

这种设计与优化方法通过将计算任务分解为多个子任务,并由多个处理单元同时进行处理,从而实现并行计算。

并行处理芯片设计与优化在高性能计算中具有重要的意义,可以充分发挥计算机硬件的潜力,提升系统性能。

二、并行处理芯片设计在并行处理芯片设计中,需要考虑以下几个方面。

1. 处理单元设计:并行处理芯片通常由多个处理单元组成,处理单元之间需要高效的通信和协同工作。

因此,在设计过程中需要充分考虑处理单元之间的数据传输、同步机制等问题,以确保处理单元之间的协同效果。

2. 内存结构设计:高性能计算中大量数据的读取和存储是一个重要环节,因此内存结构的设计对系统性能具有决定性影响。

在并行处理芯片设计中,需要考虑内存的容量、访问速度、带宽等因素,以满足计算任务的需求。

3. 电源管理:对于大规模并行处理系统来说,能耗是一个重要问题。

在设计过程中需要考虑如何优化电源管理,以降低系统的能耗,提高能效。

三、并行处理芯片优化在并行处理芯片优化过程中,需要考虑以下几个方面。

1. 算法优化:高效的并行处理芯片设计需要与优化的算法相结合。

针对具体的计算任务,需选择合适的算法,并进行适当的优化,以充分发挥并行处理的优势。

2. 数据并行化:数据并行化是指将计算任务分解为多个子任务,每个子任务操作不同的数据集。

通过合理的数据并行化设计,可以减小并行处理单元之间的通信开销,提高计算效率。

3. 负载均衡:在并行处理系统中,各个处理单元的工作负载可能存在不均衡的情况。

为了提高系统的整体性能,需要采取负载均衡的策略,将任务合理地分配给各个处理单元,确保系统资源得到充分利用。

ICTCLAS的优化设计-PKU-北京大学

ICTCLAS的授权策略ICTCLAS的授权策略 (1)ICTCLAS介绍 (1)ICTCLAS大事记: (1)ICTCLAS授权策略 (2)ICTCLAS自由软件授权 (2)ICTCLAS商用API (2)ICTCLAS商用源代码 (3)ICTCLAS介绍词是最小的能够独立活动的有意义的语言成分,但汉语是以字为基本的书写单位,词语之间没有明显的区分标记,因此,中文词法分析是中文信息处理的基础与关键。

为此,我们中国科学院计算技术研究所在多年研究基础上,耗时两年研制出了基于多层隐马模型的汉语词法分析系统ICTCLAS(Institute of Computing Technology, Chinese Lexical Analysis System)。

该系统的功能有:中文分词;词性标注;命名实体识别;未登录词识别。

特色在于:C/C++编写,支持多种Linux及Windows系列操作系统;ICTCLAS有GB2312和BIG5版本,可分别处理目简繁体中文;支持当前广泛承认的分词和词类标准,包括计算所词类标注集ICTPOS3.0,北大标准、滨州大学标准、国家语委标准、台湾“中研院”、香港“城市大学”;用户可以直接自定义输出的词类标准,定义输出格式;可按需要输出多个最优结果;所有功能模块均可拆卸组装。

计算所汉语词法分析系统ICTCLAS同时还提供一套完整的API接口(包括:动态连接库,静态连接库,Linux下的库函数和COM组件)和相应的概率词典,开发者可以直接在自己的系统中调用ICTCLAS,在分词和词性标注的基础上继续上层开发。

欢迎相关领域的工程技术人员、研究人员使用,并提供宝贵意见。

联系人:张华平中国科学院计算技术研究所zhanghp@ 010-********ext. 838 刘群中国科学院计算技术研究所liuqun@010-********ext. 9607ICTCLAS大事记:1)2002年7月,在973项目"图像、语音、自然语言理解与知识挖掘"专家组的评测中,在所有参评的系统中,评测得分最高。

blast算法介绍

(Jonathan Pevsner, Bioinformatics and Functional Genomics)

BLOSUM62

BLOSUM80

当数据库较大,查询序列较多或 较长时,时间消耗太大 eg. 142*192206270*1μs≈7.5hrs HBA_HUMAN SwissProt氨基酸数

对于相邻或距离较近的HSP,可以把它们合并 当需要比较这些结合区域之间分值高低时,有以下两 种方法: 1. Poisson法则(Poisson method)(old) 2. 总分法则(sum-of scores method)

Eg.(65, 40)和(52, 45) Poisson法则:(52, 45) →45>40 总分法则:(65, 40) → 65+40(105)>52+45(97)

数据库中某些蛋白相关性较小,搜索效果差 PSI-BLAST比常规算法更敏感,主要用于搜索与我 们感兴趣蛋白远缘相关的蛋白。

用常规的 blastp 搜索数据 库 构建多序列比 对,为每个比 对建立一个专 门的序列谱 (profile) 检验比对后 每个匹配的 统计显著性

利用profile 搜索原来的 数据库

Qi– 残基i在该位点出 现的估计概率 Pi – 这个残基的背景概 率

Altschul, Basic Local Alignment Tool, J. Mol. Biol., 1990 Altschul, Gapped BLAST and PSI-BLAST,J. Mol. Biol.,1997 Jonathan Pevsner, Bioinformatics and Functional Genomics, 2006 Slides from Gao G

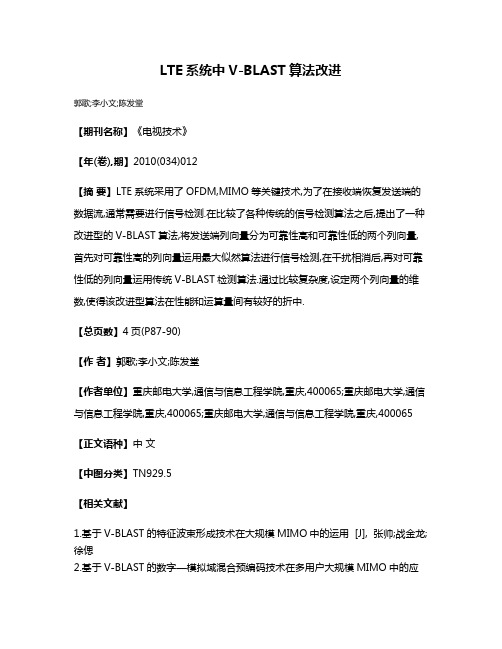

LTE系统中V-BLAST算法改进

LTE系统中V-BLAST算法改进

郭歌;李小文;陈发堂

【期刊名称】《电视技术》

【年(卷),期】2010(034)012

【摘要】LTE系统采用了OFDM,MIMO等关键技术,为了在接收端恢复发送端的数据流,通常需要进行信号检测.在比较了各种传统的信号检测算法之后,提出了一种改进型的V-BLAST算法,将发送端列向量分为可靠性高和可靠性低的两个列向量,首先对可靠性高的列向量运用最大似然算法进行信号检测,在干扰相消后,再对可靠性低的列向量运用传统V-BLAST检测算法.通过比较复杂度,设定两个列向量的维数,使得该改进型算法在性能和运算量间有较好的折中.

【总页数】4页(P87-90)

【作者】郭歌;李小文;陈发堂

【作者单位】重庆邮电大学,通信与信息工程学院,重庆,400065;重庆邮电大学,通信与信息工程学院,重庆,400065;重庆邮电大学,通信与信息工程学院,重庆,400065【正文语种】中文

【中图分类】TN929.5

【相关文献】

1.基于V-BLAST的特征波束形成技术在大规模MIMO中的运用 [J], 张帅;战金龙;徐偲

2.基于V-BLAST的数字—模拟域混合预编码技术在多用户大规模MIMO中的应

用 [J], 张帅;战金龙;王曼;李敏捷

3.异步V-BLAST中基于功率扩展的迭代并行干扰消除 [J], 莫韬甫;邵士海;刘田;唐友喜

4.LTE系统基于格基约减辅助V-BLAST算法 [J], 高明;刘金铸

5.MIMO无线通信系统中V-BLAST性能分析 [J], 屈正庚;牛少清

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

吲

F.1mproved∞nsitiv时of nuclcic孔id

databasc searches using appIication・

specmc scoring matircs METHODS:A Comp∞i∞to Methods in En巧mology.199l,3(1/8):66~70 Gusfield D.AJgorithms on Strings,Tfc峨锄d Sequcnces:Compute『Scjcnce锄d Computational Cambridge UniverSity Press

1导引

BLAST是广泛应用于生物学中序列相似性搜索工具。传统的BLAST主要适合于查询序列规模 较小的情况,但随着基因测序规模迅速增长,产生的新的查询序列达到了库序列的规模,使得 BLAST在搜索相似时效率很低.消耗大量的时间和内存资源。 BLAST算法具有计算和I/o密集的特征,为了解决BLAST在大规模处理中效率问题,提出了 许多并行算法。大多数的并行算法都是基于将数据库分割分布到各个计算节点的方法,这类算法 在查询序列的规模远远小于数据库序列规模的情况下表现出了较好的性能。我们引入了对查询序 列批处理并将查询序列分割分布到其他计算节点的方法,这样不需要主节点收集最后结果再排 序.大大减少了整个比对过程的时间和消耗的内存。在此基础上,提出了并行的ICT.BLAST算 法,结果表明,lCT.BLAST具有比NCBI.BLAST更好的性能。

BioIo舒.

川嘲旧研 嘲

Currcnt Tbpics in ComputationaI MoIecular BioIogy.Tsing}Iua xu,Mich醒l Q.zh鲫g University Press.The MIT P陀ss 2002 Gmma八Gupta D,et a1.Introduction t0 ParaJlel Computing,Second Edition.Addison Wesley,2003 K盯Iin S,AltschuI S F.Methods for弱辩ssing me s伍tistical significancc of moIecular sequence f醯tures by

if lUn弱singe dI—O t11en

发送消息COMPLETE给pi

eIse

else

发送消息FItAGMENT给pi if消息是请求片断t}len 从Un雏sigend中选择一个片断发送给pi

将pi从Un鹳signed中删除

end if end if endwhi{e

算法2

ict bl笛t

mpi从节点

见表1。

木奉义T作受到863项目(项日号:2002从104530)和固家自然科学荩金项目【项目号:60372040)的资助

88

表l时问和内存消耗对比

3

ICT.BLAST并行算法

ICT—BLAST并行算法主要有两个步骤,首先,主节点将整个数据库序列文件广播到其他计算

节点,保存在计算节点的本地存储设各上。然后把批处理的查询序列文件分割成大小大致相当的 片断,分别发送给惟一的计算节点并格式化.所有的计算节点并行进行相似性搜索,得到的结果 直接保存在本地,不需要主节点收集再排序输出。算法描述如下: 算法l

lP

翟

dP

8P

16P

她皇。个鼍

图I ICT.BU憾T并行算法和NCBI-BLAST比较

5结论

本文系统总结了ICT.BLAST主要关键技术,测试结果表明,本文提出的ICT-BLAST算法比目 前公开的BLAST算法更为优越.而且基于ICT.BLAST的MPI并行化比基于NCBI・BLAST的

mpiBLAS丁具有更好的可扩展性。

queries一从主节点接收到的库文件 currentStatc一从主节点接收的状态

while currentState!=COMPLETE do

subject=从主节点接收到的片断 lCT-BLAST(queries,subject) currentState一从主节,ii接收的状态

end whiIe

参考文献:

【ll

AIoschul S F,Gish w,MilIer w.et aI.Basic IocaI aIignment辩arch t001.J.MoI.BioI,1990,215:403~4lO

【2】

Dar“ng A E。Carey L,Wu Chunf.cng.T11e Design,Implementation,and EValuation of mpiBlast.CIusterWo rId Confercnce&Expo in coniunccion with the 4th ln协ma“onal Conf-efcnce on Ljnux Clusters:The HPC RevoIution.June 2003 States D J,Gish W,Altschul S

ICT.BLAST算法优化与并行算法设计研究水

谭光明.冯高峰.徐琳,冯圣中.孙凝晖 中国科学院计算技术研究所

{tgm,fg‘xulin,&,snh)@ncic.∞期

摘要:ICT.BLAsT对BLAST启发式算法的实现做了优化:引入批处理的概念、并对整个库文 件建立哈希表,实现了I/o延迟掩藏,提高了整个比对过程的速度,同时降低了内存消耗.优 化的算法更有利于并行化的实现:在并行系统中,将库文件广播到各个计算节点。由节点在 局部分别建立哈希表.然后将查询文件分割发送到各个计算节点并行比对,计算结果可以在 节点直接输出,不需要主节点收集,减少了通信开销.

2

BLAST算法和ICT.BLAST算法

BLAST主要流程如下:首先采用哈希法,对查询序列以碱基的位置为索引建立哈希表,然后

将查询序列和数据库中所有序列联配,找出精确匹配的种子,以种子为中心,应用动态规划法向 两边扩展成更长的联配,最后在一定精度范围内选取符合条件的联配按序输出。 上述的BLAST方法一次处理一条查询序列,当规模增大时速度太慢。ICT-BLAST对查询序列 批处理,同时为了减少内存的消耗,ICT-BLAST中对整个库序列建立哈希表.将它与一条查询序 列联配后可以立刻输出排序的联配结果。改进的算法结合了计算机体系结构上的特点,将CPU的 计算和I/o子系统的输入/输出并行,实现了计算和输出的时间重叠. 我们已经实现ICT.BLAST算法,和BLAST算法对比,时间和内存消耗都有很大的改进。我 们在AMD Opteron“.bitS SMP、内存4.5G、操作系统是SuSe Linux的系统上比较了两种算法。

Myrinet的GM—IP网互联。

测试的时问是主节点分割数据后发送到每个计算节点和每个计算节点在本地格式化再运行

IcT.BLAST进行序列相似性搜索的总时间。ICT-BLAST并行算法加速比接近线性,对开放源码的

mpiBLAST也进行了测试,测试了在lM的查询序列和10M的库序列联配时消耗的时间。ICT. BLAST并行算法消耗的时间远远低于mpiBLAST.主要来自两个方面的原因:每个计算节点都调 用优化的串行的ICT—BLAST进行序列联配,计算和联配结果输出到磁盘时间重叠i每个计算节点 得到的联配结果不需要再由主节点收集重新排序,减少通信时间。如表2和图l所示。

表2 ICT.BLAsT并行算法的运行时间(时间单位:秒)

箩鼍零;:≥予逋堑东孑≯了‘琴鬟霉霉凑 ≯:一/,1‘,.o∥。。4≥≮:叠∥、7溪

£ 茁

|!}.”,石州玉+:‘一。≯;;。矗曼o。,i:ij茗墨 ∥,砸迎一。尊1 0譬7≯:分j叠■_,尊;!麓

※z‘i_’≥,≯,艺≥_}罢≤.:耋i盏j:l∥,?,冀:+j‘篓I_!臻

Ji柚g Tao,Ying

A,K柳is

using窖cnemI Scoring schemes.In:Proc N龇I.Acad.Sci.USA.1 990,87:2264~2268 Galison F.111c FaSta柚d BIaSt prog髓ms

2000.hnp:∥bioweb.pastcur.倒scq狮aI,bl笛t,

resuIts

2

89

4

ICT.BLAST的性能

在单个节,I上运行时,优化的lCT—BLAST不但减少了序列相似性搜索的时问,而且降低了内

存消耗。我们对基于优化的ICT—BLAST的并行ICT.BLAST算法进行了测试,运行环境足曙光 4000A。其每个节点足4P Opteron“位处理器.8G内存。节点间分别由千兆的管理网和数据喇、

ict blaSt

mpi主节点

Q={ql,q2,...}是查询序列文件片断的Байду номын сангаас合 Un丛signed∈Q是未分配给计算节点的查询序列文件片断集合 P={Pl,P2,...)是计算的进程集合 IUnassingedl+一lFI

Un雒singed—F

把库序列文件广播给所有的计算节点

whiIe

IUn丛singedI I-O do 收到pi的消息 if消息是询问状态t11en