基于全连接条件随机场的道路场景语义分割方法

crf 条件随机场模型 语义分割

crf 条件随机场模型语义分割全文共四篇示例,供读者参考第一篇示例:条件随机场(Conditional Random Field, CRF)是一种统计学习模型,广泛应用于图像处理、自然语言处理等领域。

在语义分割任务中,CRF模型被用来提高像素级别的分类性能,从而实现对图像中不同物体的精确分割。

语义分割是计算机视觉领域的一个重要任务,其目的是将图像中的每个像素分配到一个特定的类别中,例如背景、道路、汽车等。

传统的像素级别分类方法往往有较高的误差率,无法很好地处理物体边界和细节。

引入CRF模型可以提高语义分割的精确度和鲁棒性。

CRF模型是一种有向图模型,用于描述随机变量之间的依赖关系。

在语义分割任务中,CRF模型将每个像素看作一个节点,并通过定义条件概率分布来学习像素之间的权重关系。

CRF模型考虑了局部和全局信息,并通过最大化条件概率来进行推理,从而实现对图像的语义分割。

CRF模型在语义分割中的应用主要包括两个方面:特征提取和后处理。

在特征提取方面,CRF模型可以学习像素间的空间相关性、颜色一致性等特征,有效提升图像分类性能。

在后处理方面,CRF模型可以对分割结果进行平滑处理,减少噪声和边缘混叠现象。

在实际应用中,CRF模型通常与深度学习模型结合使用,构建端到端的语义分割网络。

深度学习模型用于提取图像的高层语义特征,CRF 模型则用于优化像素级别的分类结果,相互补充、互相改进,实现更加精确的语义分割。

除了在图像处理领域,CRF模型还被广泛应用于自然语言处理、机器翻译等领域。

在自然语言处理中,CRF模型可以用于标注命名实体、识别句法结构等任务,提高文本处理的准确度和效率。

第二篇示例:条件随机场模型(CRF,Conditional Random Fields)是一种用于序列标注和结构化预测问题的概率图模型,经常用于自然语言处理和计算机视觉领域。

在语义分割任务中,CRF模型有着重要的应用价值,可以有效地提高图像分割的准确性和稳定性。

语义分割的分类

语义分割的分类语义分割是一种图像处理任务,其目标是将图像中的每个像素赋予其对应的语义标签。

简单来说,它就是通过对图像进行像素级别的分割,将图像中每个像素标记为属于哪个类别的过程。

在语义分割中,我们通常分为两类:基于全卷积神经网络(FCN)的语义分割和基于条件随机场(CRF)的语义分割。

基于全卷积神经网络(FCN)的语义分割是一种将卷积神经网络(CNN)应用于像素级别分类的方法。

在 FCN 中,我们通过将标准的卷积层进行修改和编排,使其可以处理任意大小的输入图片。

通过上采样和下采样层的加入,可以产生高分辨率的输出,这样可以更准确地描述每个像素点的标签,并为每个像素提供一个语义标签。

其训练方式为先训练分类器,再通过反向传播计算卷积神经网络的梯度,最大化 softmax 的输出标签概率。

基于条件随机场(CRF)的语义分割是一种基于概率图模型(Probabilistic Graphical Model)的方法。

该模型基于有向无环图模型,其中节点代表像素,边代表像素间的关系,即它们在空间上相邻。

该模型的训练主要涉及到两个方面:图像的全局特征和像素之间的邻居关系。

全局特征是指特定类别的像素在整幅图像中的常见形状和颜色分布。

邻居关系则是指具有相邻位置和其他类别之间的相互作用。

在语义分割任务中,我们通常使用像素的 RGB 值或更复杂的特征,如纹理、形状、原型、方向等,来对像素进行分类。

我们还使用 CRF 和其他技术来优化标签,并进一步提高精度。

语义分割对许多自然图像应用非常有用。

例如,语义分割可以极大地帮助道路标记、物体识别、场景分析等任务,其中图像分辨率不必过高,而只需要尽可能准确地描述不同区域之间的不同。

因此,在计算机视觉领域,语义分割是一项广泛应用的技术。

语义分割 车道线分割 实例分割

语义分割车道线分割实例分割全文共四篇示例,供读者参考第一篇示例:语义分割是计算机视觉领域中的一个重要技术,其研究目的是将图像中的每个像素分配至特定的类别中。

语义分割的应用非常广泛,包括自动驾驶、医学图像分析、地块识别等领域。

车道线分割和实例分割是语义分割的两个重要应用场景,本文将分别介绍这两个应用场景的原理和应用。

车道线分割是指在道路场景中将车道线与其他道路元素进行区分的任务。

自动驾驶是车道线分割的典型应用场景之一。

通过识别道路上的车道线,自动驾驶系统能够更准确地理解环境并做出相应的驾驶决策。

车道线分割通常会使用深度学习方法,如卷积神经网络(CNN),对道路图像进行像素级别的分类。

在训练阶段,系统需要收集大量的带有标注的道路图像,并通过反向传播算法来学习车道线的特征。

在测试阶段,系统可以实时地对道路图像进行分割,并输出每个像素所属的类别。

实例分割是指在图像中将不同对象进行分离的任务。

与语义分割不同,实例分割要求系统不仅能够将像素分配至特定类别,还需要对同一类别中的不同实例进行区分。

在一个室内场景中,实例分割能够将每个桌子、椅子和灯具识别为一个独立的实例。

实例分割通常会结合目标检测和语义分割的方法,首先对图像中的每个对象进行检测,然后进一步对每个对象进行像素级别的分类。

在实例分割的应用中,深度学习模型如Mask R-CNN等是常用的算法。

语义分割、车道线分割和实例分割在自动驾驶、智能监控、医学影像等领域具有重要的应用前景。

随着深度学习技术的不断发展,这些分割算法的性能和效果也在不断提升。

未来,我们可以期待这些技术在更多领域发挥更大的作用,为我们的生活和工作带来更多便利。

第二篇示例:语义分割是计算机视觉领域中一项重要的任务,旨在将图像中的每个像素分配到相应的语义类别中。

在语义分割中,最常见的应用之一就是车道线分割和实例分割。

车道线分割是指在道路的图像中,将车道线与道路背景区分开来。

这对于自动驾驶汽车等智能交通应用至关重要。

deeplabv3+语义分割算法

Deeplabv3+语义分割算法1. 引言在当今人工智能和计算机视觉技术日新月异的发展中,语义分割算法作为一种重要的图像处理技术,对于自动驾驶、医学影像分析、智能视频监控等领域具有重要意义。

而Deeplabv3+作为一种先进的语义分割算法,在图像分割领域具有重要的应用前景。

2. Deeplabv3+算法原理Deeplabv3+算法是由Google团队提出的,它是对Deeplabv3算法的改进版本,采用了编码器-解码器结构和空洞卷积来提高图像分割的精度和效率。

在编码器部分,Deeplabv3+采用了Xception模型作为主干网络,来提取图像的高级语义特征。

在解码器部分,引入了全连接条件随机场(CRF)和多尺度融合策略,以提高分割边界的准确性和图像细节的保留。

这种结构的创新性使得Deeplabv3+在语义分割任务上取得了显著的性能提升。

3. 深度评估要全面评估Deeplabv3+算法的优劣,首先需要考虑其在图像语义分割任务上的性能表现。

通过对比实验和模型测试,我们可以发现,在使用PASCAL VOC 2012和Cityscapes等数据集进行语义分割任务时,Deeplabv3+算法能够取得较高的分割精度和准确性。

其对细小物体和复杂场景的分割效果也较为突出,证明了其在真实场景中的适用性。

从算法的计算效率和速度上来看,Deeplabv3+也相对高效。

其采用了空洞卷积和多尺度处理策略,在提高分割精度的也保持了较快的推理速度和较小的计算资源消耗。

这对于在实际应用中对算法的实时性和效率提出了重要的要求的场景中,Deeplabv3+算法具有明显的优势。

综合以上评估,可以得出结论,Deeplabv3+算法在图像语义分割任务上具有较高的精度和效率,能够胜任复杂场景下的分割需求,具有较为广泛的应用前景。

4. 个人观点对于Deeplabv3+算法,我认为其结合了先进的深度学习模型和优秀的图像处理技术,具有较为显著的优势。

语义分割方法

语义分割方法

语义分割是一种计算机视觉领域的技术,它的目标是将图像中的每个像素分配到特定的语义类别中。

这种技术在许多应用程序中都有重要的用途,例如自动驾驶、医学图像分析和无人机监控等领域。

以下是一些常见的语义分割方法:

1. 基于全卷积网络(FCN)的方法

全卷积网络是一种特殊类型的卷积神经网络,它可以对整个图像进行端到端的处理,并输出每个像素点所属的类别。

这种方法通常需要一个预训练好的模型来提取特征,并使用反卷积操作将结果恢复到原始图像大小。

2. 基于编码器-解码器(Encoder-Decoder)结构的方法

编码器-解码器结构通常由两部分组成:编码器和解码器。

编码器将输入图像转换为低维度特征向量,而解码器则将该向量转换回原始图像大小,并输出每个像素点所属的类别。

这种方法通常需要在训练过程中进行迭代优化。

3. 基于条件随机场(CRF)的方法

条件随机场是一种概率图模型,它可以对图像中的像素进行联合建模,并考虑它们之间的相互作用。

这种方法通常需要在预测过程中使用迭

代算法来优化结果。

4. 基于图卷积网络(GCN)的方法

图卷积网络是一种专门用于处理图形数据的神经网络结构,它可以对

每个像素点进行局部感知,并考虑其周围像素点之间的关系。

这种方

法通常需要在训练过程中进行迭代优化。

总之,语义分割是一项复杂而重要的技术,在实际应用中需要根据具

体情况选择适合的方法,并进行适当的调整和优化。

一种基于卷积神经网络的道路场景语义分割方法[发明专利]

![一种基于卷积神经网络的道路场景语义分割方法[发明专利]](https://img.taocdn.com/s3/m/018d22d45a8102d277a22fd7.png)

专利名称:一种基于卷积神经网络的道路场景语义分割方法专利类型:发明专利

发明人:周武杰,刘劲夫,钱小鸿,雷景生,万健,杨胜英,强芳芳申请号:CN202011224151.7

申请日:20201105

公开号:CN112508956A

公开日:

20210316

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于卷积神经网络的道路场景语义分割方法。

本发明在训练阶段,构建卷积神经网络,其隐层包括十个神经网络块、三个卷积块、两个联合金字塔上采样模块、可分离上采样块;使用原始的道路场景图像输入到卷积神经网络中进行训练,得到对应的9幅语义分割预测图;再通过计算原始的道路场景图像对应的9幅语义分割预测图构成的集合与对应的语义分割标签图集之间的损失函数值,获得卷积神经网络分类训练模型的最优权值矢量和偏置项;在测试阶段,将待语义分割的道路场景图像输入到卷积神经网络分类训练模型中,得到预测语义分割图像;本发明提高了道路场景图像的语义分割效率,并且提升了准确度。

申请人:浙江科技学院

地址:310023 浙江省杭州市西湖区留和路318号

国籍:CN

代理机构:杭州求是专利事务所有限公司

代理人:林超

更多信息请下载全文后查看。

双通道特征融合的真实场景点云语义分割方法

2023-11-06•引言•双通道特征融合模型•点云数据预处理目录•真实场景点云语义分割实验•结论与展望•参考文献01引言背景点云语义分割是实现自动驾驶的关键技术之一,对于感知和理解车辆周围环境具有重要意义。

意义通过准确地对真实场景点云进行语义分割,可以提升自动驾驶系统的感知和理解能力,提高行车安全性。

研究背景与意义现状现有的点云语义分割方法主要基于单通道特征提取和分类,但单通道方法难以同时获取丰富的空间信息和上下文信息。

问题如何有效融合双通道特征,以提升点云语义分割的性能和准确性,是当前亟待解决的问题。

研究现状与问题研究内容与方法研究内容本研究提出了一种双通道特征融合的点云语义分割方法,旨在融合点云的空间信息和上下文信息,提升语义分割的性能和准确性。

方法采用深度学习技术,设计了一种双通道特征融合网络,该网络由两个独立的特征提取网络和一个融合网络组成。

两个特征提取网络分别提取点云的空间信息和上下文信息,融合网络将两种信息进行融合,得到最终的语义分割结果。

02双通道特征融合模型使用点云局部特征提取方法,如FPSF(Fast Point-set Feature Histograms)等,获取点云的局部几何属性和纹理信息。

局部特征提取利用深度神经网络对点云数据进行特征提取,如使用PointNet、PointNet等,从点云数据中学习更加有效的特征表示。

深度特征提取特征提取特征融合通道间融合将不同通道的特征进行融合,如采用串联、拼接等方式将局部特征和深度特征进行融合,以获得更加丰富的特征表示。

通道内融合对同一通道内的特征进行融合,如使用注意力机制(Attention Mechanism)对局部特征和深度特征进行加权融合,以实现更加有效的特征融合。

模型优化模型结构优化01采用更加有效的网络结构,如使用ResNet(残差网络)、DenseNet等,以提高模型的表达能力。

损失函数优化02设计更加合理的损失函数,如使用交叉熵损失函数(Cross-EntropyLoss)或者对比损失函数(Contrastive Loss)等,以提高模型的分割精度。

语义分割算法分类

语义分割算法分类

语义分割算法可以分为以下几类:

1. 基于全卷积网络(FCN)的语义分割算法:这是最早的语义分割算法之一,它将卷积神经网络(CNN)和像素级别的分类任务相结合,通过上采样操

作来获取像素级别的分类结果。

2. 基于条件随机场(CRF)的语义分割算法:条件随机场是一种用于标注序列的模型,可以将像素级别的分类结果进行后处理,进一步提高分割精度。

3. 基于深度学习的语义分割算法:随着深度学习技术的发展,出现了许多基于深度学习的语义分割算法,如DeepLab、RefineNet等。

这些算法利用

了深度学习技术中的卷积、池化、上采样等操作,提高了像素级别的分类精度。

4. 基于图卷积神经网络(GCN)的语义分割算法:图卷积神经网络是一种

处理图结构数据的神经网络,可以利用其节点分类的能力来进行像素级别的分类任务。

5. 基于Transformer的语义分割算法:随着Transformer结构的出现,也出现了基于Transformer的语义分割算法,如TransUNet等。

这些算法利用了Transformer中的自注意力机制和卷积操作,提高了像素级别的分类

精度。

总之,不同类型的语义分割算法各有其优缺点,在实际应用中需要根据具体需求选择合适的算法。

道路分割方法-概述说明以及解释

道路分割方法-概述说明以及解释1.引言概述部分的内容可以按以下方式撰写:1.1 概述道路分割是计算机视觉领域中的一个重要任务,其目标是将图像中的道路部分与其他环境进行有效地分割。

道路分割方法的发展对于实现自动驾驶、交通监控以及地图构建等应用具有重要意义。

本文将就几种常见的道路分割方法进行深入研究和分析。

近年来,随着深度学习技术的迅速发展,基于深度学习的道路分割方法成为主流。

这些方法通过构建卷积神经网络(Convolutional Neural Network, CNN)来学习图像特征,并将其应用于道路分割任务中。

相较于传统的基于特征工程的方法,基于深度学习的方法在道路分割的准确度和鲁棒性上取得了显著的提升。

然而,尽管基于深度学习的方法在道路分割任务中具有较高的精度,但其训练和推理的计算量较大,且对大量标注数据的依赖程度较高。

为了解决这些问题,一些研究者提出了基于传统计算机视觉方法和深度学习方法相结合的道路分割方法,通过充分利用两者的优势来提高分割准确度和效率。

本文将首先介绍道路分割任务的背景和意义,然后详细介绍几种常见的道路分割方法,包括基于深度学习的方法和深度学习与传统方法相结合的方法。

对于每种方法,将重点介绍其核心思想、关键技术和实验结果,并进行对比分析。

最后,从实际应用的角度出发,总结已有方法的优缺点,并展望未来道路分割方法的发展方向。

通过本文的研究,将能够更全面地了解道路分割方法的技术原理、应用现状和挑战,并为相关研究和应用提供参考和借鉴。

1.2 文章结构文章结构部分的内容可以是以下内容之一:文章结构部分旨在介绍本文的整体结构和各个部分的内容安排。

本文主要分为引言、正文和结论三个部分。

引言部分旨在介绍本文的背景和意义。

首先,道路分割问题在计算机视觉领域中具有广泛的应用,例如交通场景分析、自动驾驶等。

然后,介绍了本文所讨论的道路分割方法的重要性和挑战性。

最后,明确了本文的目的和结构。

正文部分是本文的核心部分,主要介绍了两种道路分割方法A和B。

路面语义分割数据集

路面语义分割数据集哎呀,说到路面语义分割数据集,这可真是个有趣的话题。

想象一下,城市里来来往往的车辆,行人和那些五花八门的交通标志,都是我们生活的一部分。

可是谁说这些都不能被“看见”呢?路面语义分割就像一双慧眼,把这些繁杂的元素分门别类,告诉我们每一个物体的身份。

你知道吗,做这个事情可真不简单,需要把各种图像数据整理得清清楚楚,像是给每个人贴上了标签,谁是谁,在哪里,干嘛呢,全都一目了然。

先说说这些数据集吧。

那些图片看起来普通,但每一张背后都有故事。

街头巷尾的照片,白天的阳光洒在路面上,夕阳西下的余晖映射着一切,哇,真是美得让人心醉。

不过,这些图片可不仅仅是为了好看,里面有车、有行人、还有各种标志,都在静静等待着被分析。

想想看,一张路面的图片上,红绿灯、斑马线、还有停在路边的汽车,它们各自都在说自己的话。

路面语义分割就是让这些“声音”变得清晰可见,分开、辨认,让我们一目了然。

再聊聊这数据集的构建。

想要制作一个好的路面语义分割数据集,得费不少心思。

这可不是随便拍几张照片就能凑合的活。

需要专门的团队去拍摄这些图像,挑选各种不同的天气和时间段,白天、晚上、晴天、阴天,每一种都不能少。

然后,最关键的就是标注,嘿,像是在给每张图片上的每一个物体涂上颜色,哪个是车,哪个是行人,哪个是狗狗,统统都要清楚。

想象一下,一个人坐在电脑前,眼睛盯着屏幕,逐一识别,真是需要耐心得像和尚念经。

说到这里,难免会想,为什么要做这些呢?嘿,答案简单得不能再简单。

想要让自动驾驶的汽车安全行驶,想要让智能交通系统变得更聪明,路面语义分割数据集可是个不可或缺的部分。

想想看,如果汽车能精准识别路面上的每一个元素,避免事故,那多好啊,司机都可以松一口气,自动驾驶可比人开车稳多了。

更别提未来的智慧城市,交通流畅,人人安全,想想都让人兴奋。

这一路走来可不是一帆风顺。

数据的质量、数量都是挑战。

拍到的图像可能模糊不清,或是光线太差。

标注员大哥大姐们有时候也会分神,结果把行人标成了汽车,这一笔可得多费一番功夫去修正。

高速场景的路面分割 python

高速场景的路面分割 python

路面分割是自动驾驶中的一个重要步骤,它能够将路面与周围环境进行区分,从而帮助车辆更好地规划行驶路线。

本文介绍了一种利用Python实现高速场景路面分割的方法。

首先,我们需要准备一些训练数据,包括高速公路的图像和对应的标注数据。

接着,使用OpenCV库中的图像处理函数对图像进行预处理,消除光照和阴影的影响,使图像更加清晰。

然后,我们使用深度学习算法进行路面分割。

本文使用的是Unet 模型,该模型具有较好的分割效果。

我们将训练数据分为训练集和验证集,使用训练数据对模型进行训练,并对验证集进行测试,调整模型的参数,以得到最佳的分割效果。

最后,我们将训练好的模型应用到实际场景中,对高速公路的图像进行路面分割,从而为自动驾驶提供更加准确的路线规划。

总的来说,本文介绍了一种利用Python实现高速场景路面分割的方法,该方法具有较好的分割效果,有望为自动驾驶的发展提供帮助。

- 1 -。

基于DeepLabv3+算法的城市街景语义分割算法研究

基于DeepLabv3+算法的城市街景语义分割算法研究作者:陈文艺苗宗成来源:《无线互联科技》2024年第09期摘要:在自动驾驶领域,城市街道场景的语义分割对于提升系统的安全性和效率至关重要。

针对传统语义分割模型参数过多、泛化性能较差以及分割效果有限等问题,文章提出了一种基于改进DeepLabv3+的解决方案。

此改进模型融合了轻量级MobileNetv2主干网络和SE注意力机制,优化了空洞金字塔池化(Atrous Spatial Pyramid Pooling, ASPP)模块,将其从并行结构改进成串行结构,采用深度可分离卷积结构。

在Cityscapes数据集上,文章的方法取得了75.90%的平均交并比(Mean Intersection over Union, MIoU),显著提升了分割精度与计算效率。

关键词:深度学习;语义分割;ASPP中图分类号:TP389.1文献标志码:A0 引言城市街景的图像分割一直是研究的热点,该技术主要分为以下3种:基于传统的分割方法、混合了传统技术和深度学习的方法以及单一依靠深度学习的策略。

传统分割技术通常涉及阈值设定、边缘检测、聚类和图论方法[1],这些技术主要依赖于颜色、纹理等简单的低层次特征来执行分割;结合了传统方法和深度学习的分割方法则更为多样,这种分割方法主要包括基于候选区域的分析、概率图模型和分割掩模的应用[2];深度学习驱动的图像语义分割则成为当前领域内的主导技术,特别是以卷积神经网络,如全卷积网络(Fully Convolutional Networks, FCN)[3]、循环神经网络(例如ReSeg[4])和生成对抗网络(如DA[5])为基础的方法。

虽然DeepLabv3+[6]在PASCAL VOC 2012和Cityscapes等知名数据集上展现了出色的分割能力,但仍有一些局限性。

首先,DeepLabv3+的编码器在提取特征的过程中逐渐减小图像尺寸,这可能导致关键信息的损失,使得在解码阶段难以恢复图像细节。

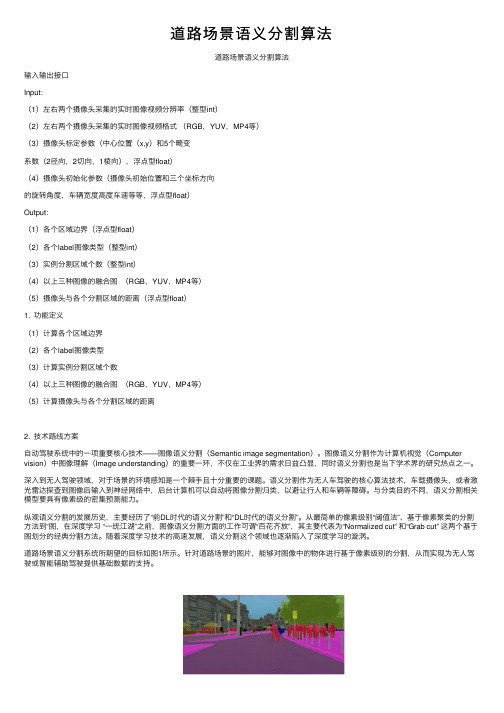

道路场景语义分割算法

道路场景语义分割算法道路场景语义分割算法输⼊输出接⼝Input:(1)左右两个摄像头采集的实时图像视频分辨率(整型int)(2)左右两个摄像头采集的实时图像视频格式(RGB,YUV,MP4等)(3)摄像头标定参数(中⼼位置(x,y)和5个畸变系数(2径向,2切向,1棱向),浮点型float)(4)摄像头初始化参数(摄像头初始位置和三个坐标⽅向的旋转⾓度,车辆宽度⾼度车速等等,浮点型float)Output:(1)各个区域边界(浮点型float)(2)各个label图像类型(整型int)(3)实例分割区域个数(整型int)(4)以上三种图像的融合图(RGB,YUV,MP4等)(5)摄像头与各个分割区域的距离(浮点型float)1. 功能定义(1)计算各个区域边界(2)各个label图像类型(3)计算实例分割区域个数(4)以上三种图像的融合图(RGB,YUV,MP4等)(5)计算摄像头与各个分割区域的距离2. 技术路线⽅案⾃动驾驶系统中的⼀项重要核⼼技术——图像语义分割(Semantic image segmentation)。

图像语义分割作为计算机视觉(Computer vision)中图像理解(Image understanding)的重要⼀环,不仅在⼯业界的需求⽇益凸显,同时语义分割也是当下学术界的研究热点之⼀。

深⼊到⽆⼈驾驶领域,对于场景的环境感知是⼀个棘⼿且⼗分重要的课题。

语义分割作为⽆⼈车驾驶的核⼼算法技术,车载摄像头,或者激光雷达探查到图像后输⼊到神经⽹络中,后台计算机可以⾃动将图像分割归类,以避让⾏⼈和车辆等障碍。

与分类⽬的不同,语义分割相关模型要具有像素级的密集预测能⼒。

纵观语义分割的发展历史,主要经历了“前DL时代的语义分割”和“DL时代的语义分割”。

从最简单的像素级别“阈值法”、基于像素聚类的分割⽅法到“图,在深度学习 “⼀统江湖”之前,图像语义分割⽅⾯的⼯作可谓“百花齐放”,其主要代表为“Normalized cut” 和“Grab cut” 这两个基于图划分的经典分割⽅法。

一种基于全连接CRF的前景-背景分割方法

一种基于全连接CRF的前景-背景分割方法

吴冠辰;詹煜;邓捷

【期刊名称】《四川理工学院学报(自然科学版)》

【年(卷),期】2018(031)004

【摘要】像素级的前景-背景分割通常被当做一个基于条件随机场的能量最小化问题,但是基于的只是局部连接的条件随机场,全连接的条件随机场因为复杂度高而不被采用.通过使用均值场近似技术将邻居节点间的约束转换成低通滤波操作,虽然简化了全连接条件随机场的计算,但也丢失了大量的相关性信息.为了克服这种信息丢失,对临近的像素间的二元约束进行保持,只将空间距离较远的像素间的二元约束转换成低通滤波,并添加了局部的光滑项进行分割边缘约束,然后使用图割算法对最后的能量函数进行优化.实验结果显示,算法由于充分利用了全局约束信息,对具有复杂边缘、细小枝状边缘、凹陷边缘的物体具有较好的分割效果.

【总页数】7页(P49-55)

【作者】吴冠辰;詹煜;邓捷

【作者单位】贵州交通职业技术学院信息工程系,贵阳 550008;贵州交通职业技术学院信息工程系,贵阳 550008;贵州交通职业技术学院信息工程系,贵阳 550008【正文语种】中文

【中图分类】TP391

【相关文献】

1.一种基于笔画特征的车牌前景背景分割新方法 [J], 丛露微;沈星星

2.基于全连接条件随机场的道路场景语义分割方法 [J], 王瑶;冯峰

3.基于深度CRF模型的图像语义分割方法 [J], 胡涛;李卫华;秦先祥;邱浪波;李小春

4.一种融合FC-CRF的密集网络语义分割方法 [J], 刘卫铭;辛月兰;姜星宇

5.基于图像边缘特征的前景背景分割方法 [J], 楚瀛;田淞;张桂林;张熠

因版权原因,仅展示原文概要,查看原文内容请购买。

基于Dense ASPP的道路图像语义分割方法

基于Dense ASPP的道路图像语义分割方法刘平;刘国清;郑伟【期刊名称】《自动化应用》【年(卷),期】2022()10【摘要】伴随着车辆智能化程度的持续提高,对道路场景的感知技术提升的需求也在持续增长,而道路场景感知技术的核心要素正是图像视觉。

纵观智能驾驶体系,图形视觉最具普遍性的使用场景正是道路图像语义分割。

立足于Deeplab V3+网络,以及全连接条件随机场于图像处理领域的特点,面向道路场景语义分割过程之中常见的小范围像素细节出现干扰、空间上下文特征信息缺失、图像分割边缘过程之中出现的模糊等现象,使用图像语义的性能对主、子网络模式展开划分,同时对网络模型展开优化。

在Deeplab V3+网络的解码单元之中引入注意力机制,将解码中浅层信息进行跨层融合操作,提升保存图像空间相关数据,从而设置基于改进的Dense ASPP道路图像语义分割模型,并在道路场景数据集Cityscapes上,对DeeplabV3+等算法展开对比实验。

从实验数据来看,提出的算法不单单能够完成对道路场景的语义分割,同时还能够高质量地对图像细节数据以及空间信息展开处置,有效提升了图像语义分割的质量。

【总页数】4页(P91-94)【作者】刘平;刘国清;郑伟【作者单位】深圳佑驾创新科技有限公司【正文语种】中文【中图分类】TP391.4【相关文献】1.基于分割块的图像语义分割方法2.基于Dense U-net方法的眼底彩色照片图像血管分割研究3.图像语义分割辅助的车载激光点云道路提取方法4.基于深度学习的轻量级道路图像语义分割算法5.结合ASPP与改进HRNet的多尺度图像语义分割方法研究因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于全连接条件随机场的道路场景语义分割方法作者:王瑶冯峰来源:《电脑知识与技术》2019年第18期摘要:道路场景图像的准确分割是对道路场景进一步分析与理解的前提条件。

针对基于点对条件随机场(Conditional Random Field,CRF)的道路场景语义分割方法仅考虑了局部邻域关系,无法表达像素点之间的相互依赖关系,易产生误分割现象的问题,本文提出基于全连接CRF模型的道路场景图像语义分割方法。

首先,通过像素点间的相互依赖关系获取空间全局信息,利用Textonboost分类器提取图像的基本结构特征建立模型的一元势能项,利用高斯核函数的线性组合构建模型的二元势能项;之后,采用平均场近似算法实现模型的优化推理;最后,采用道路场景数据库Sowerby-7进行实验分析,验证所提模型的可行性和有效性。

实验结果表明,与基于点对条件随机场模型相比,该模型能够得到较好的语义分割结果。

关键词:全连接CRF;道路场景;图像语义分割中图分类号:TP391; ; ; ; 文献标识码:A文章编号:1009-3044(2019)18-0212-03道路场景图像语义分割主要是提取车辆前方可通行的道路区域,为智能驾驶系统的路径规划和车辆控制提供道路信息,是实现自动驾驶、辅助驾驶和自主导航等机器视觉应用中的关键技术之一[1-4]。

现有的道路场景图像语义分割方法主要利用颜色、纹理以及道路几何形状等图像基本结构特征进行分割。

Sirmacek等人[5]总结了基于颜色的道路检测分割算法,包含K-means聚类、最近邻法等,此类算法往往对路面阴影、积水等干扰敏感,分割性能易衰减且需要对图像进行复杂的预处理操作;Hou等人[6]提出了基于纹理的道路边缘分割法,该方法适用于边缘清晰的直线道路,对于边缘模糊场景复杂的道路无法得到较好的分割结果;肖红光等人[7]基于道路几何形状的算法,提出一种新的高分辨率SAR图像道路提取算法,要求道路边缘轮廓清晰以便于控制点的选取,但该方法过分依赖控制点,建模条件复杂且对边缘不清晰的路面没有很好的分割能力。

上述这些方法提取到的像素特征往往是图像的局部特征,而且分类器对像素分类只考虑了当前点信息,像素之间互相独立无法获取上下文信息,因而无法获得更好的语义分割结果。

近年来,条件随机场(Conditional Random Field,CRF)模型由于能够充分融合图像多特征和表达空间上下文信息,可以很好地解决上述方法存在的问题。

Costea等人[8]基于点对CRF的基本理论,提出了一种快速的交通场景语义分割方法,该方法利用相邻像素点构建点对势能函数,引入多范围分类功能来捕捉局部结构和上下文信息,实现了快速的交通场景语义分割,但该方法不能描述相邻较远的连接关系;Geng等人[9]利用点对CRF模型引入邻域像素间空间信息,并实现了动态地将颜色、纹理、空间及边缘等多种特征融合,有效提高了图像分割的精度,但对于图像中边缘细小的区域,分割结果仍不理想。

这是由于点对CRF模型只考虑了局部邻域关系,仅能描述简单的邻域平滑等先验知识,无法描述更远距离的空间关系。

全连接CRF模型则进一步考虑了单个像素和其他所有像素的关系,在图像中的所有像素对上建立依赖关系,因此,本文利用全连接CRF模型对道路场景图像进行语义分割,通过像素点间的相互依赖关系获取空间全局信息,利用Textonboost分类器提取图像的基本特征建立模型的一元势能项,利用高斯核函数的线性组合构建模型的二元势能项,并采用平均场近似算法实现模型的推理。

实验结果表明,与基于点对条件随机场模型相比,本文模型能够得到较好的语义分割结果。

1 点对CRF模型给定图像的观察场[Y={y1,y2,...,yN}i∈N],其中yi为图像中第i个像素的像素值,N 为该图像中的像素总数;定义图像的标号场[X={x1,x2,...,xN}i∈N],其中[xi={1,2,...,L}]为该图像的类别标签,L为语义类别标签个数。

图像中的每一个像素值yi对应一个类别标签xi,这样每个像素点作为一个结点,结点间的关系作为边,从而构成一个条件随机场(X,Y)。

点对CRF模型就是通过观察变量yi来推测像素i对应的类别标签xi。

那么,在该模型中,求解满足最大后验概率的X*即为最优的类别标签分配结果:2 全连接CRF模型针对基于点对CRF模型的道路场景语义分割方法仅考虑了局部邻域关系,无法表达像素点之间的相互依赖关系,容易产生误分割现象,本文提出基于全连接CRF模型的道路场景图像语义分割方法。

该方法进一步考虑了单个像素和其他所有像素的关系,在图像中的所有像素对上建立依赖关系,利用邻域像素之间的相互作用引入空间全局信息,获得更准确的道路场景分割结果。

3 模型推理全连接CRF模型具有成千上万的边连接,因而对能量函数的计算和推理过程非常复杂。

平均场近似(Mean Field Approximation,MFA)算法[12]是一种高效的推理优化算法,其优点在于当有很多边连接存在时,依然可以快速推理达到收敛,效率极高。

因此,本文采用MFA 算法对全连接CRF模型进行优化推理。

4 实验结果与分析为了验证所提模型和推理算法的可行性和有效性,以道路场景数据库Sowerby-7[10]为实验对象,在实验环境为Intel(R) Core(TM) i5-8300H CPU @ 2.30GHz 8.00G的台式机上,通过VS2010平台采用C++语言编程实现,并结合Opencv基本算法库提高算法开发效率。

4.1 定性分析现从道路场景数据库Sowerby-7中选取3张图进行分割实验,并将全连接CRF模型的语义分割结果与点对CRF模型的进行对比,如图1所示。

从室外道路场景语义分割结果可以看出,使用點对CRF模型的分割结果在图像的局部区域存在缺失、模糊或者出现明显的边缘带现象,这是因为点对CRF只考虑了局部邻域关系,无法表达像素点之间的高级依赖关系;相对于点对CRF模型来说,全连接CRF模型对室外道路场景图像的分割结果有了明显提高,不仅能够有效地描述图像区域一致性,而且分割的边缘细节也较为清晰,因此基于全连接CRF模型的图像语义分割方法在室外道路场景上能够得到较好的语义分割结果。

4.2 定量分析为了进一步量化点对CRF模型和全连接CRF模型对室外道路场景图像的语义分割结果,采用PRI指标[13]进行评估。

从表1不同模型分割结果的PRI值对比可以看出,第1、2、3幅图在基于全连接CRF模型下的PRI值比基于点对CRF模型下的依次增长了2.51%、19.6%、17.1%。

5 结论本文针对基于点对CRF模型的道路场景语义分割方法仅考虑了局部邻域关系,无法表达像素点之间的相互依赖关系,容易产生误分割现象的问题,提出基于全连接CRF模型的道路场景图像语义分割方法,利用邻域像素之间的相互作用引入空间全局信息,获得更准确的道路场景语义分割结果。

同时采用道路场景数据库Sowerby-7中的图像进行实验对比分析,验证了所提模型的可行性和有效性。

实验结果表明,与基于点对CRF模型相比,全连接CRF模型在室外道路场景语义分割和标注的准确率方面都能够得到较好的实验效果。

参考文献:[1] PASSANI M, YEBES J J, BERGASA L M. Fast pixelwise road inference based on Uniformly Reweighted Belief Propagation[C]//.Intelligent Vehicles Symposium.2015.[2] ZHOU H, KONG H, WEI L, et al. Efficient Road Detection and Tracking for Unmanned Aerial Vehicle[J]. IEEE Transactions on Intelligent Transportation Systems, 2015, 16(1): 297-309.[3] SHIN B S, XU Z, KLETTE R. Visual lane analysis and higher-order tasks: a concise review[J]. 2014, 25(6): 1519-47.[4] HILLEL A B, LERNER R, DAN L, et al. Recent progress in road and lane detection:a survey[J]. Machine Vision & Applications, 2014, 25(3): 727-45.[5] SIRMACEK B, UNSALAN C. Road detection from remotely sensed images using color features[C]//.International Conference on Recent Advances in Space Technologies.2011.[6] HOU X, ZHANG T, XIONG G, et al. Image resampling detection based on texture classification[J]. Multimedia Tools & Applications, 2014, 72(2): 1681-708.[7] 肖紅光,文俊,陈立福,等. 一种新的高分辨率SAR图像道路提取算法[J]. 计算机工程与应用, 2016, 52(15): 198-202.[8] COSTEA A D, NEDEVSCHI S. Fast traffic scene segmentation using multi-range features from multi-resolution filtered and spatial context channels[C]//.Intelligent Vehicles Symposium.2016.[9] GENG X, ZHAO J. Interactive Image Segmentation with Conditional Random Fields[M]. IEEE Computer Society, 2008.[10] SHOTTON J, WINN J, ROTHER C, et al. TextonBoost for Image Understanding:Multi-Class Object Recognition and Segmentation by Jointly Modeling Texture, Layout, and Context[J]. International Journal of Computer Vision, 2009, 81(1): 2-23.[11] 李瀚,杨晓峰,邓红霞,等. 基于网格搜索算法的PCNN模型参数自适应[J]. 计算机工程与设计, 2017, 38(1): 192-7.[12] KRäHENBüHL P, KOLTUN V. Efficient Inference in Fully Connected CRFs with Gaussian Edge Potentials[J]. 2012,[13] MIGNOTTE M. A Label Field Fusion Bayesian Model and Its Penalized Maximum Rand Estimator for Image Segmentation[M]. 2010.【通联编辑:唐一东】。