细粒度并行计算编程模型研究

计算机体系结构与并行处理

计算机体系结构与并行处理计算机体系结构与并行处理是计算机科学领域中的重要概念。

本文将介绍计算机体系结构的基本原理、并行处理的概念及其应用,并附带题库类型的相关问题及解析。

一、计算机体系结构基本原理计算机体系结构是指计算机系统中各个硬件组件之间的结构关系和工作原理。

它包括计算机的各个层次结构,以及指令系统设计、存储器层次结构和总线结构等内容。

1. 数据通路与控制单元计算机体系结构中,数据通路用于处理和传输数据,控制单元则负责指导和协调各个硬件组件的工作。

数据通路包括算术逻辑单元(ALU)、寄存器、数据缓冲器等,而控制单元则由指令寄存器(IR)、程序计数器(PC)和控制逻辑组成。

2. 存储器层次结构存储器层次结构包括寄存器、高速缓存、主存和辅助存储器等。

其中,寄存器是CPU内部用于保存数据和指令的最快速的存储器。

高速缓存则位于CPU与主存之间,用于加速数据的读写。

主存是计算机中用于存储程序和数据的主要存储设备。

而辅助存储器则用于长期存储数据和程序。

3. 指令系统设计指令系统是计算机体系结构的核心部分,它规定了计算机所能执行的指令集和执行方式。

指令集包括数据传输指令、算术逻辑指令、控制转移指令等。

指令系统设计的关键是平衡指令的功能和数量,以满足计算机的多样化需求。

4. 总线结构总线是计算机中用于数据传输的公共通道。

总线结构包括数据总线、地址总线和控制总线等。

数据总线用于传输数据,地址总线用于定位数据在存储器中的位置,而控制总线则用于传输控制信号。

二、并行处理的概念及应用并行处理是指多个处理器同时执行多个任务或同一任务的不同部分,以提高计算机系统的性能和效率。

它可以分为粗粒度并行和细粒度并行。

1. 粗粒度并行粗粒度并行是指将一个任务分成多个子任务,由多个处理器分别执行。

每个处理器独立地处理自己的子任务,最后将结果合并。

粗粒度并行适用于需要处理的数据量大、计算复杂度高的任务,如科学计算和大规模数据处理。

2. 细粒度并行细粒度并行是指将一个任务分成多个子任务,并行执行它们的不同部分。

高性能计算中的并行计算模型使用技巧

高性能计算中的并行计算模型使用技巧在高性能计算领域,计算模型是实现并行计算的关键。

并行计算模型允许将计算任务分割成多个较小的部分,并且在多个处理器上同时执行这些部分。

在本文中,我们将探讨一些高性能计算中常用的并行计算模型以及使用技巧。

1. SIMD(单指令多数据)模型单指令多数据(SIMD)是一种并行计算模型,其中多个处理器同时执行相同的指令,但操作不同的数据。

这种模型适用于一些科学计算和图像处理等需要对大量数据进行相同类型操作的应用。

使用SIMD 模型时,可以通过向量化操作来提高计算速度。

向量化指令将多个数据元素打包在一起,以便可以一次执行多个相同的操作。

同时,使用SIMD指令集可以利用现代处理器的向量单元,并充分发挥硬件的并行能力。

2. MIMD(多指令多数据)模型在多指令多数据(MIMD)模型中,多个处理器可以同时执行不同的指令,操作不同的数据。

这种模型适用于一些需要并行执行不同算法或任务的应用。

MIMD模型可以通过分解计算任务为几个并行的子任务,并在不同的处理器上执行这些子任务来提高计算效率。

在MIMD模型中,处理器之间通常通过消息传递机制进行通信和数据交换。

一些常用的MIMD并行计算模型包括MPI(消息传递接口)和PVM(并行虚拟机)等。

3. 数据并行模型数据并行模型是一种特殊的并行计算模型,其中计算任务按数据划分为多个部分,并在不同的处理器上同时执行这些部分。

每个处理器负责处理自己的数据片段,并将结果传递给其他处理器。

数据并行模型广泛应用于一些大规模的数值计算和科学计算领域,例如矩阵乘法和数据挖掘等。

使用数据并行模型时,需要合理划分数据,并设计有效的数据通信机制,以充分利用处理器之间的并行处理能力。

4. 任务并行模型与数据并行模型不同,任务并行模型将计算任务划分为多个较小的、独立的子任务,并在不同的处理器上同时执行这些子任务。

每个处理器负责执行自己的子任务,并将结果传递给其他处理器。

高性能计算导论:并行计算性能评价

如流水线技术、分治算法等,通过将任务划分为多个子任 务,分配给不同的处理单元并行执行,从而实现任务的快 速完成。

消息传递并行算法

如MPI(Message Passing Interface)算法,通过进程 间通信来协调不同处理单元上的任务执行,适用于分布式 内存系统。

算法优化策略与方法探讨

结果分析和改进建议

结果分析

对实验结果进行深入分析,找出性能 瓶颈和影响性能的关键因素。

改进建议

根据分析结果提出针对性的改进建议,如优 化算法、改进系统结构、提高硬件性能等。 同时,也可以对实验方法和流程进行反思和 改进,以提高评估的准确性和有效性。

05 案例分析:并行计算性能 评价实践

案例背景和目标设定

加速比

并行算法相对于串行算法 的执行速度提升倍数。

效率

用于衡量并行系统中处理 器利用率的指标,通常表 示为加速比与处理器数量 的比值。

可扩展性与规模性指标

1 2

等效性

在增加处理器数量时,保持问题规模和计算复杂 度不变的情况下,系统性能的提升能力。

弱可扩展性

在增加处理器数量的同时,增加问题规模,保持 每个处理器的负载不变,系统性能的提升能力。

功耗与能效比指标

功耗

01

并行计算系统在运行过程中的总功率消耗。

能效比

02

用于衡量并行计算系统每消耗一单位能量所能完成的计算量或

任务量的指标。

节能技术

03

采用低功耗处理器、动态电压频率调整、节能算法等技术降低

并行计算系统的功耗。

03 并行算法设计与优化策略

典型并行算法介绍及原理剖析

数据并行算法

如数组运算、矩阵乘法等,通过将数据划分为多个部分, 在多个处理单元上并行执行相同的操作来提高性能。

并行遗传算法研究综述

GA0 i— u n。H E Gu— i Jaq a ixa

( h in o l e Z ei g Unv ri f e h oo y Z ia gC l g , h j n i s y o c n l ,Ha g h u3 0 2 ,C ia j e a e t T g n z o 1 0 4 hn )

题 . 过 模 型 比 较 发 现 粗 粒 度 模 型 以其 较 小 的 通 信 开 销 和 对 种 群 多 样 化 , 得 了 最 广 泛 的 应 用. 通 获 最

后介 绍 了 目前 并行 遗传 算法 的主要 评价模 型 , 并指 出了并行 遗传 算法 的今后 主要研 究 方向 , 向理 将

论化 、 型化 、 模 异步化 及混 合化 等 方向发展 .

关键 词 : 并行遗 传 算法 ; 并行计 算 ; 并行模 型

中图分 类 号 : 1 TP 8 文 献标识 码 : A 文 章编 号 :0 64 0 (0 7 0 —0 60 1 0 —3 3 2 0 ) 10 5 —4

A e i w fp r le e e i l o ih s r v e o a a l lg n tc a g r t m

0

引 目

遗传 算 法 ( n t g r h ,GAs 是 美 国 Ge ei Aloi ms c t )

并 以概 率 1收敛 到 全局 最 优解 [ . 1 这种 良好 的特 性 3

pr blm swhih ne d b ol e o mpr v ng is a lc to r u e t d Th o gh c mpa i g o e c e e s v d f ri o i t pp ia i n a e s gg s e . r u o rn t s he e mod l e s,i ss wn t tc a s — a n d m o e s mo ewi e y a ple o t itec mm u — ti ho ha o r egr i e d li r d l p i d f rislt l o ni

高性能计算中的并行计算模型与算法

高性能计算中的并行计算模型与算法前言在当今信息时代,高性能计算已经成为各个领域研究与应用的重要工具。

而在高性能计算中,实现并行计算是提高计算效率的重要手段之一。

本文将探讨高性能计算中的并行计算模型与算法,以期对该领域的研究与应用有一定的了解与启发。

一、并行计算模型1.1 SPMD模型(Single Program Multiple Data)SPMD模型是一种常用的并行计算模型,它将计算任务划分为多个子任务,每个子任务独立执行相同的程序代码,但操作不同的数据。

这种模型适用于问题的规模较大,而且子任务之间不需要进行过多的通信与同步的场景。

1.2 SIMD模型(Single Instruction Multiple Data)SIMD模型是一种特殊的并行计算模型,它同样将计算任务划分为多个子任务,但是每个子任务执行的是相同的指令,且操作相同的数据。

这种模型适用于需要大量重复计算的场景,如图像处理和视频编码等。

1.3 MIMD模型(Multiple Instruction Multiple Data)MIMD模型是一种更加灵活的并行计算模型,它将计算任务划分为多个子任务,每个子任务可以执行不同的指令,操作不同的数据。

这种模型适用于需要更细粒度的任务划分和复杂的并行计算场景,如科学计算和大规模数据分析等。

二、并行计算算法2.1 分而治之算法分而治之算法(Divide and Conquer)是一种常用的并行计算算法。

它将原始问题划分为多个子问题,并通过递归地解决子问题来得到最终的结果。

在并行计算中,每个子问题可以由一个独立的处理器来处理,从而加快问题的求解速度。

2.2 并行排序算法并行排序算法是一类重要的并行计算算法,它通过将原始数据划分为多个子集,每个子集在独立的处理器上进行排序,最后通过合并操作来得到全局有序的结果。

这种算法适用于需要对大规模数据进行排序的场景,如数据挖掘和搜索引擎等。

2.3 并行搜索算法并行搜索算法是一种解决搜索问题的并行计算算法。

物理计算中的并行计算与算法复杂度分析

物理计算中的并行计算与算法复杂度分析随着科技的不断进步,计算机在物理学研究中的应用越来越广泛。

物理计算涉及到大量的数据处理和复杂的计算任务,因此并行计算成为了物理计算中的重要技术之一。

本文将探讨物理计算中的并行计算以及算法复杂度分析的相关问题。

一、并行计算的概念与应用并行计算是指将一个大型计算任务分解成多个小任务,然后通过多个处理单元同时进行计算,以提高计算速度和效率的一种计算方式。

在物理计算中,由于涉及到大量的数据处理和复杂的计算任务,采用并行计算可以显著缩短计算时间,提高计算效率。

并行计算在物理计算中的应用非常广泛。

例如,在高能物理实验中,需要对海量的数据进行处理和分析,通过并行计算可以加快数据处理的速度,提高实验效率。

此外,在量子力学模拟和天体物理学研究等领域,也需要进行大规模的数值计算,采用并行计算可以大大缩短计算时间,加快研究进展。

二、并行计算的模型与算法在并行计算中,有两种常见的并行计算模型:共享内存模型和消息传递模型。

共享内存模型是指多个处理单元共享同一块内存空间,通过读写共享内存来进行通信和协调。

在共享内存模型中,可以使用多线程或多进程来实现并行计算。

多线程是指在同一进程中创建多个线程,每个线程独立执行任务;而多进程是指创建多个独立的进程,每个进程独立执行任务。

共享内存模型的优点是通信和协调相对简单,但由于多个处理单元共享同一块内存,可能会出现数据竞争和同步问题。

消息传递模型是指多个处理单元通过消息传递来进行通信和协调。

在消息传递模型中,每个处理单元拥有独立的内存空间,通过发送和接收消息来进行通信。

消息传递模型的优点是避免了数据竞争和同步问题,但相对而言通信和协调的开销较大。

在并行计算中,算法的设计和选择对于计算效率和性能至关重要。

算法复杂度分析是评估算法性能的一种方法。

算法复杂度分析主要涉及到时间复杂度和空间复杂度两个方面。

时间复杂度是指算法执行所需的时间,通常用大O记法表示。

超级计算技术中的并行编程模型介绍

超级计算技术中的并行编程模型介绍超级计算机被设计用于解决复杂问题,大规模数据处理和模拟计算等高性能计算任务。

为了充分利用超级计算机的计算能力和处理大规模数据的需求,高效的并行编程模型至关重要。

本文将介绍超级计算技术中常见的并行编程模型,以帮助读者更好地理解并应用这些模型。

1. SIMD(单指令多数据)模型SIMD模型是一种将一个操作应用于多个数据元素的并行编程模型。

在该模型中,计算任务被分为多个数据并行的操作,每个操作都被应用于大量的数据元素。

这样可以通过向量化指令集或并行处理器来加速计算。

SIMD模型适用于需要对大规模数据进行相同操作的计算任务,如图像处理和数值模拟。

2. MIMD(多指令多数据)模型MIMD模型是一种将多个独立的指令应用于不同的数据元素的并行编程模型。

在该模型中,计算任务被分为多个并行的子任务,每个子任务都是独立执行的,可以分配给不同的处理器或计算节点。

MIMD模型可以同时处理不同的计算任务,适用于解决大规模、复杂的问题,如分布式计算和并行算法。

3. SPMD(单指令多线程)模型SPMD模型是一种将相同指令应用于多个并行线程的并行编程模型。

在该模型中,计算任务被分为多个线程,每个线程都执行相同的指令序列,但可能处理不同的数据。

SPMD模型适用于数据密集型计算任务,其中每个线程可以独立执行不同的计算操作,例如在图像和视频处理中的像素级操作。

4. 数据并行模型数据并行模型是一种将计算任务分为多个数据部分并以数据为中心进行并行处理的编程模型。

在该模型中,数据被分为不同的分块、分配给不同的处理器或计算节点,然后进行并行计算。

数据并行模型适用于某些科学和工程应用中的数组操作和矩阵运算。

5. 任务并行模型任务并行模型是一种将计算任务划分为不同的子任务并以任务为中心进行并行处理的编程模型。

在该模型中,每个子任务独立执行,可以分配给不同的处理器或计算节点,之后通过消息传递或共享内存进行通信和同步。

编程语言中的并行计算模型介绍

编程语言中的并行计算模型介绍并行计算是指在多个处理器、多个核心或者多个计算机上同时进行计算任务的方法。

它是通过将一个大问题分解成多个小问题,然后并行地解决这些小问题,最后将结果合并得到最终结果。

在编程语言中,有几种常见的并行计算模型。

下面将介绍一些常见的并行计算模型,包括共享内存模型、消息传递模型和数据并行模型。

1. 共享内存模型共享内存模型是指在多个处理器或者多个核心之间共享同一块内存。

这些处理器可以通过读写这个共享内存来实现彼此之间的通信和数据交换。

共享内存模型常用的编程语言有OpenMP和Pthreads(POSIX threads)等。

在共享内存模型中,通常通过使用锁(Mutex)来保护共享数据的完整性。

锁可以在访问共享数据之前加锁,在访问完成后释放锁。

这样可以确保同一时间只有一个线程可以访问共享数据,避免并发访问导致的数据混乱。

2. 消息传递模型消息传递模型是指通过消息的发送和接收来实现不同处理器或者计算机之间的通信。

每个处理器有自己独立的地址空间,彼此之间无法直接访问对方的内存。

消息传递模型常用的编程语言有MPI(Message Passing Interface)和OpenMPI等。

在消息传递模型中,通常需要明确指定消息的发送和接收方。

发送方将消息发送到指定接收方的地址,接收方则通过接收指定地址的消息来获取数据。

消息传递模型可以实现点对点通信,也可以实现广播和集合等通信操作。

3. 数据并行模型数据并行模型是指将数据划分成多个块,然后同时对这些数据块进行计算的模型。

每个处理器或者核心负责计算其中的一个数据块,最后将结果合并得到最终结果。

数据并行模型常用的编程语言有CUDA和OpenCL等。

在数据并行模型中,数据划分的方式需要根据具体的问题来设计。

通常可以使用数据循环(Data Loop)来将数据块分配给不同的处理器或者核心。

数据并行模型可以充分利用硬件的并行性,提高计算任务的执行效率。

面向多线程编程的并行计算模型研究与实现

面向多线程编程的并行计算模型研究与实现引言随着计算机科学和技术的不断发展,人们对并行计算的需求越来越大。

并行计算在加快计算速度、提高系统性能和解决复杂问题等方面发挥着重要作用。

而多线程编程作为一种常见的并行计算模型,在高性能计算、数据处理和分布式计算等领域都得到广泛应用。

本文将围绕面向多线程编程的并行计算模型展开研究与实现。

一、并行计算模型的基本概念和分类1.1 并行计算模型的定义并行计算模型是指在多个处理器或线程之间进行任务划分和协同工作的一种方式。

它可以将一个任务分解成若干个子任务,并利用不同的多线程或处理器同时进行计算,以提高整个系统的计算速度和性能。

1.2 并行计算模型的分类常见的并行计算模型主要包括共享内存模型和消息传递模型。

共享内存模型是指多个线程或处理器之间通过读写共享内存的方式进行通信和数据交换,例如OpenMP;消息传递模型则是通过消息传递的方式在不同线程或处理器之间进行通信和数据交换,例如MPI。

二、面向多线程编程的并行计算模型研究2.1 共享内存模型共享内存模型是一种基于共享内存机制的并行计算模型,它主要通过读写共享内存的方式来进行线程之间的通信和数据交换。

该模型具有编程简单、易于理解和易于调试的特点,适用于对共享数据频繁访问的并行计算任务。

常用的共享内存编程接口包括OpenMP和POSIX线程库等。

2.2 消息传递模型消息传递模型是基于消息传递机制的并行计算模型,它通过消息的发送和接收来实现线程之间的通信和数据交换。

该模型适用于分布式环境下的并行计算任务,可以充分利用分布式计算资源,并进行高效的通信和数据传输。

常用的消息传递编程接口包括MPI和PVM等。

三、面向多线程编程的并行计算模型实现3.1 共享内存编程实现共享内存编程实现是通过对共享内存区域的读写操作来实现线程之间的通信和数据交换。

在实现过程中,首先需要定义共享内存区域,并在不同线程之间进行数据同步和互斥访问的控制。

细粒度计算机组成原理Proteus仿真实验设计

细粒度计算机组成原理Proteus仿真实验设计【摘要】本文介绍了细粒度计算机组成原理在Proteus仿真实验设计中的应用。

对Proteus软件进行了简要介绍,然后概述了细粒度计算机组成原理的基本概念。

接着详细阐述了Proteus仿真实验设计的步骤,包括硬件配置和软件调试过程。

在实验结果分析部分,讨论了仿真实验的效果和优化空间。

提出了性能优化策略,总结了细粒度计算机组成原理在Proteus仿真实验设计中的重要性,展望了未来研究方向。

通过本文的阐述,读者可以了解细粒度计算机组成原理在Proteus仿真实验设计中的具体应用及其潜在的发展前景。

【关键词】细粒度计算机组成原理,Proteus仿真,实验设计,软件简介,概述,步骤,实验结果分析,性能优化策略,总结,展望1. 引言1.1 细粒度计算机组成原理Proteus仿真实验设计细粒度计算机组成原理是计算机科学领域中一个重要的研究方向,它主要关注计算机系统中的各种组件如何相互作用,以实现高效的计算功能。

Proteus是一款广泛应用于电子工程领域的仿真软件,它提供了一种方便快捷的方式来设计和测试电路。

在计算机组成原理中,细粒度计算机组成原理是一种细致划分计算机结构的方法,通过将计算机系统的各个部分分解为更小的单元,以实现更高效的计算功能和更好的性能。

Proteus软件是一种强大的仿真工具,能够模拟各种电路和系统的行为,包括计算机系统。

在设计细粒度计算机组成原理的实验时,Proteus能够帮助我们快速验证系统设计的正确性,并进行性能评估。

在实验设计过程中,我们首先需要了解细粒度计算机组成原理的基本概念和原理,然后根据具体要求和目标设计相应的实验方案。

通过Proteus软件的仿真模拟,我们可以模拟系统的运行情况,分析实验结果并提出性能优化策略。

细粒度计算机组成原理Proteus仿真实验设计是一个复杂而又具有挑战性的任务,但通过合理的设计和分析,我们可以探索出更加高效的计算机系统结构和设计方案。

并行计算的模型

并行计算的模型随着科技的飞速发展和计算机性能的不断提升,人们对计算能力的要求也越来越高。

在计算机领域中,并行计算成为了一个备受研究和探讨的热门话题。

与串行计算相比,它能够在更短的时间内完成更多的计算任务,因此在大数据处理、科学计算和人工智能等应用领域发挥着至关重要的作用。

并行计算的模型是实现高效并行计算的关键,本文将介绍三种常见的并行计算模型,并对其优缺点进行分析。

一、SPMD模型SPMD模型是Single Program Multiple Data的缩写,即在所有处理器上执行同一个程序,对不同的数据进行操作。

SPMD是目前最为常用的并行计算模型之一。

在SPMD模型中,所有处理器执行同一个程序,但是数据的处理在不同的处理器上进行。

处理器之间通过消息传递来实现数据的交换和同步。

SPMD模型的优点在于实现简单,易于编写程序,同时能够发挥出多处理器的并行计算能力。

然而,由于SPMD模型的所有处理器都需要执行相同的指令,所以会浪费大量的处理器资源,并且在处理器数量较多时容易出现死锁等问题。

二、MPI模型MPI(Message Passing Interface)模型是一种消息传递接口,它在并行计算中广泛使用。

MPI模型允许处理器之间通过消息传递进行通信和同步,从而实现并行计算。

MPI模型的优点在于能够对不同处理器之间进行更加灵活的通信和同步,因此在处理器数量较多和计算规模较大的情况下,能够发挥出更高的性能。

同时,MPI模型也具有较好的可移植性,能够在不同的平台上进行移植。

但是,MPI模型的实现较为复杂,需要编写大量的通信代码,并且不同的MPI实现之间性能存在较大差异。

三、OpenMP模型OpenMP(Open Multi-Processing)模型是一种面向共享内存的并行计算模型,它是针对多核处理器的一种解决方案。

OpenMP模型允许程序员通过增加一些指令和注释来实现并行化,从而让程序在多处理器上并行执行。

并行计算综述

什么是并行计算并行计算(parallel computing)是指,在并行机上,将一个应用分解成多个子任务,分配给不同的处理器,各个处理器之间相互协同,并行地执行子任务,从而达到加速求解速度,或者增大求解应用问题规模的目的。

由此,为了成功开展并行计算,必须具备三个基本条件:(1) 并行机。

并行机至少包含两台或两台以上处理机,这些处理机通过互连网络相互连接,相互通信。

(2) 应用问题必须具有并行度。

也就是说,应用可以分解为多个子任务,这些子任务可以并行地执行。

将一个应用分解为多个子任务的过程,称为并行算法的设计。

(3) 并行编程。

在并行机提供的并行编程环境上,具体实现并行算法,编制并行程序,并运行该程序,从而达到并行求解应用问题的目的。

并行计算的主要研究目标和内容对于具体的应用问题,采用并行计算技术的主要目的在于两个方面:(1) 加速求解问题的速度。

(2) 提高求解问题的规模。

组成并行机的三个要素为:•结点(node)。

每个结点由多个处理器构成,可以直接输入输出(I/O)。

•互联网络(interconnect network)。

所有结点通过互联网络相互连接相互通信。

•内存(memory)。

内存由多个存储模块组成,这些模块可以与结点对称地分布在互联网络的两侧,或者位于各个结点的内部。

并行编程模型1.共享内存模型a)在共享编程模型中,任务间共享统一的可以异步读写的地址空间。

b)共享内存的访问控制机制可能使用锁或信号量。

c)这个模型的优点是对于程序员来说数据没有身份的区分,不需要特别清楚任务间的单数据通信。

程序开发也相应的得以简化。

d)在性能上有个很突出的缺点是很难理解和管理数据的本地性问题。

2.线程模型在并行编程的线程模型中,单个处理器可以有多个并行的执行路径。

3.消息传递模型消息传递模型有以下三个特征:1)计算时任务集可以用他们自己的内存。

多任务可以在相同的物理处理器上,同时可以访问任意数量的处理器。

基于细粒度并行化的大规模数据处理技术

基于细粒度并行化的大规模数据处理技术一、细粒度并行化技术概述随着大数据时代的来临,数据的规模和复杂度越来越高,传统的数据处理方案已经无法满足实时性和处理效率的需求,因此需要一种新的数据处理技术。

细粒度并行化技术是一种基于计算机集成化思想和并行化技术的数据处理方案。

该技术通过将数据分成若干个小块,然后通过并发计算和并行处理的方式将其进行处理,从而提高数据处理的效率。

二、细粒度并行化的特点1.精细划分数据:通过细粒度并行化技术,可以根据数据的特点和处理要求,将数据进行精细的划分,这样可以使得每一块数据的处理时间更加短暂,从而加快数据处理的速度。

2.高效率并行处理:在细粒度并行化技术中,由于数据被分成小块,可以同时处理多个数据块,这样可以充分利用计算机的多核心特性,从而提高数据处理的效率。

3.实时处理:细粒度并行化技术可以实时处理大量数据,可以用于实时数据处理、数据挖掘、插值和模拟等应用。

这也是大规模数据处理中所需要的一个重要特点。

4.高可扩展性:细粒度并行化技术还具有高度可扩展性,当数据规模越来越大时,可以通过增加计算节点和并发计算集群的数量来实现更好的处理效率。

三、细粒度并行化技术的应用场景1.互联网数据分析:互联网数据源源不断地产生,如何进行高效率的数据处理,已经成为一个亟待解决的问题。

细粒度并行化技术可以大量节省计算资源,加速数据处理时间,使得互联网数据分析变得更加高效。

2.商业智能:商业智能需要大量的数据处理和分析,而细粒度并行化技术正是商业智能的理想选择。

商业智能使用细粒度并行化技术处理数据,可以加速报表生成,提高分析效率,为企业提供决策支持。

3.科学计算:科学计算需要高效率的计算能力来处理大规模的数据,而细粒度并行化技术不仅可以加速计算速度,还可以实现更高的计算精度,从而提高计算效率。

因此,在检测、模拟和仿真中使用细粒度并行化技术有着广泛的应用。

四、细粒度并行化技术的实现方法1.分布式计算:分布式计算可以使得数据分散在多个节点上,同时在每个节点上进行并行计算,然后将计算结果进行分析和整合,从而实现高效率的数据处理。

基于CUDA的细粒度并行计算模型研究

分表 明基 于 GP U进行高性能并行计算 , 是适应 目前大规模计算需求的一个 重要 发展途径 。 关键词 图形处理器 ;图形处理器 的通用计算 ;统一计算设备架构 ;细粒度并 行计算 ; 单指令多数据

中 图分 类 号 T P 3 9 1

Fi ne — Gr a i ne d Par al l e l Co m pu t i ng Mo de l Bas e d o n CUDA

总第 2 8 3 期 2 0 1 3 年第 5 期

计算 机与数字 工程

C o mp u t e r& Di g i t a l En g i n e e r i n g

Vo 1 . 4 1 No . 5

8 O1

基于 C U DA 的 细 粒 度 并 行 计 算 模 型 研 究

( 2 .S c h o o l o f I nf o r ma t i o n Sc i e nc e a nd Te c h n o l o g y,Z he n g z ho u No r ma l Uni v e r s i t y,Z he n g z ho u 4 5 00 4 4)

( 3 . Zh e n g z h o u No .2 Mi d d l e Байду номын сангаасc h o o l ,Z he n g z h o u 4 5 0 0 0 2 ) ( 4 . Zh e n gz h o u Ar c h i v e s ,Z he n g z h o u 45 0 0 07 )

图形处 理器( GP U) 进入主流市场 , 与之 相适应 的编程 模型发 展却相 对滞后 。Nv i d i a在 Ge F o r c e 8系列 显卡 上推 出 的统 一计 算设 备架 构

并行计算模型

·在BSP模型上,曾直接实现了一些重要的算法(如矩阵乘、并行前序运算、FFT和排序等),他们均避免 了自动存储管理的额外开销;

· BSP模型可以有效的在超立方体络和光交叉开关互连技术上实现,显示出,该模型与特定的技术实现无关, 只要路由器有一定的通信吞吐率;

LogP模型的特点

(1)抓住了络与处理机之间的性能瓶颈。g反映了通信带宽,单位时间内最多有L/g个消息能进行处理机间传 送。

(2)处理机之间异步工作,并通过处理机间的消息传送来完成同步。 (3)对多线程技术有一定反映。每个物理处理机可以模拟多个虚拟处理机(VP),当某个VP有访问请求时,计 算不会终止,但VP的个数受限于通信带宽和上下文交换的开销。VP受限于络容量,至多有L/g个VP。 (4)消息延迟不确定,但延迟不大于L。消息经历的等待时间是不可预测的,但在没有阻塞的情况下,最大不 超过L。 (5)LogP模型鼓励编程人员采用一些好的策略,如作业分配,计算与通信重叠以及平衡的通信模式等。 (6)可以预估算法的实际运行时间。

LogP模型的不足之处

(1)对络中的通信模式描述的不够深入。如重发消息可能占满带宽、中间路由器缓存饱和等未加描述。 (2)LogP模型主要适用于消息传递算法设计,对于共享存储模式,则简单地认为远地读操作相当于两次消 息传递,未考虑流水线预取技术、Cache引起的数据不一致性以及Cache命中率对计算的影响。 (3)未考虑多线程技术的上下文开销。 (4)LogP模型假设用点对点消息路由器进行通信,这增加了编程者考虑路由器上相关通信操作的负担。

PRAM模型的缺点

并行计算模型研究及其应用

并行计算模型研究及其应用一、并行计算模型的概述随着科技的不断发展,计算机的性能得到了显著提升。

然而,单个计算机的计算能力仍然存在瓶颈,无法满足大规模的数据处理需求。

并行计算模型应运而生,其核心思想是将任务分配给多个计算单元,并行地执行任务。

并行计算模型可以明显提高计算效率,缩短计算时间。

并行计算模型一般分为两大类:共享内存模型和分布式内存模型。

其中,共享内存模型指的是许多处理器共享一块内存,每个处理器可以访问同一块内存,实现多个处理器之间的通讯。

而分布式内存模型则是每个处理器都有自己的内存,通过网络进行通信。

二、共享内存模型共享内存模型的主要思想是将内存分为若干个区域,每个处理器都可以访问同一块内存。

共享内存模型的特点是通讯速度较快,但是需要一个高速的内存总线来提供共享空间。

常见的共享内存模型有以下三种:1. 对称多处理器模型(SMP)SMP模型通常由多个处理器、共享内存以及一个总线组成。

每个处理器都可以访问同一块内存,并且可以通过总线进行通讯。

SMP模型的主要优点是处理器之间的通讯速度快,但是需要高速的硬件支持,因此价格也比较高。

2. 非一致存储访问模型(NUMA)NUMA模型把系统内存分为多个区域,每个区域分别和一个或多个处理器相连。

每个处理器都可以访问同一块内存,但是访问速度并不相同。

NUMA模型可以提供不同处理器之间的通讯,并且可以增加处理器的数量,但是需要更复杂的硬件支持。

3. 多线程模型多线程模型是在共享内存模型的基础上,通过线程的方式实现多个任务并行执行。

多线程模型通常需要采用锁机制来避免多个线程访问同一块内存,保证数据的一致性。

多线程可以提高计算效率,但是同时也会增加代码的复杂性。

三、分布式内存模型分布式内存模型的主要思想是每个处理器都有自己独立的内存,通过网络进行通讯。

分布式内存模型的特点是通讯速度较慢,但是能够支持非常大的计算量。

常见的分布式内存模型有以下两种:1. MPI模型MPI(Message Passing Interface,消息传递接口)模型是一个通用的消息传递库,可以用于编写并行程序。

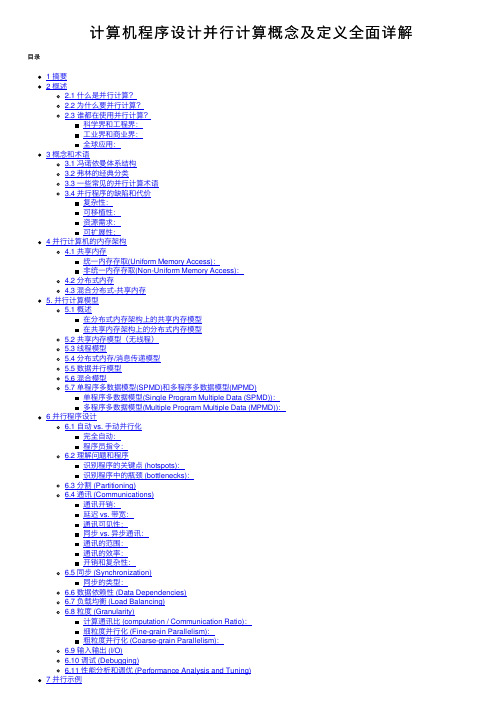

计算机程序设计并行计算概念及定义全面详解

计算机程序设计并⾏计算概念及定义全⾯详解⽬录1 摘要2 概述2.1 什么是并⾏计算?2.2 为什么要并⾏计算?2.3 谁都在使⽤并⾏计算?科学界和⼯程界:⼯业界和商业界:全球应⽤:3 概念和术语3.1 冯诺依曼体系结构3.2 弗林的经典分类3.3 ⼀些常见的并⾏计算术语3.4 并⾏程序的缺陷和代价复杂性:可移植性:资源需求:可扩展性:4 并⾏计算机的内存架构4.1 共享内存统⼀内存存取(Uniform Memory Access):⾮统⼀内存存取(Non-Uniform Memory Access):4.2 分布式内存4.3 混合分布式-共享内存5. 并⾏计算模型5.1 概述在分布式内存架构上的共享内存模型在共享内存架构上的分布式内存模型5.2 共享内存模型(⽆线程)5.3 线程模型5.4 分布式内存/消息传递模型5.5 数据并⾏模型5.6 混合模型5.7 单程序多数据模型(SPMD)和多程序多数据模型(MPMD)单程序多数据模型(Single Program Multiple Data (SPMD)):多程序多数据模型(Multiple Program Multiple Data (MPMD)):6 并⾏程序设计6.1 ⾃动 vs. ⼿动并⾏化完全⾃动:程序员指令:6.2 理解问题和程序识别程序的关键点 (hotspots):识别程序中的瓶颈 (bottlenecks):6.3 分割 (Partitioning)6.4 通讯 (Communications)通讯开销:延迟 vs. 带宽:通讯可见性:同步 vs. 异步通讯:通讯的范围:通讯的效率:开销和复杂性:6.5 同步 (Synchronization)同步的类型:6.6 数据依赖性 (Data Dependencies)6.7 负载均衡 (Load Balancing)6.8 粒度 (Granularity)计算通讯⽐ (computation / Communication Ratio):细粒度并⾏化 (Fine-grain Parallelism):粗粒度并⾏化 (Coarse-grain Parallelism):6.9 输⼊输出 (I/O)6.10 调试 (Debugging)6.11 性能分析和调优 (Performance Analysis and Tuning)7 并⾏⽰例7.1 数组处理7.2 圆周率计算7.3 简单热⽅程7.4 ⼀维波动⽅程8 参考⽂献和更多信息(本⼈刚刚完成这篇长⽂章的翻译,尚未认真校对。

细粒度多线程和粗粒度多线程

细粒度多线程和粗粒度多线程

《细粒度多线程与粗粒度多线程的比较》

在并行计算领域,细粒度多线程和粗粒度多线程是两种常见的并行计算模型。

它们分别以不同的粒度来管理并发任务,各自有着不同的优点和缺点。

细粒度多线程是指将并发任务划分得非常细致,每个线程只负责很小的任务。

这样的模型可以更充分地利用计算资源,提高系统的吞吐量和并发度。

然而,细粒度多线程也带来了更高的线程管理开销,可能导致线程切换和同步的代价较高。

粗粒度多线程则是将并发任务划分得相对粗略,每个线程负责更大的任务单元。

这样的模型可以减少线程管理开销,降低同步和通信的成本。

但由于任务单元较大,可能会导致任务分配不均衡,以及资源利用率不高的问题。

在实际应用中,选择合适的并行计算模型要根据具体问题的特点和计算环境来进行权衡。

对于计算密集型的任务,细粒度多线程可能更适合,可以充分利用多核处理器和并行计算资源;而对于通信密集型的任务,粗粒度多线程可能更合适,可以减少同步和通信的开销。

总的来说,细粒度多线程和粗粒度多线程各有其优势和局限性,需要根据具体情况来选择合适的并行计算模型,以达到最佳的性能和效率。

基于FPGA的细粒度并行CYK算法加速器设计与实现

基于FPGA的细粒度并行CYK算法加速器设计与实现夏飞;窦勇;宋健;雷国庆【期刊名称】《计算机学报》【年(卷),期】2010(033)005【摘要】基于随机上下文无关文法(SCFG)理论模型进行RNA二级结构预测是目前采用计算方法研究RNA二级结构的一种重要途径.由于基于SCFG模型的标准结构预测算法(Coche-Younger-Kasami,CYK)巨大的时空复杂度,对CYK算法进行加速成为计算生物学领域一个极具挑战性的热点问题.CYK的并行性能受限于算法多维度、非一致性的数据依赖关系和较低的计算/通信比,现有的基于通用微处理器结构的大规模并行处理方案不能获得令人满意的加速效果,并且大规模并行计算机系统硬件设备的购置、使用、日常维护的成本高昂,其适用性受到诸多限制.文中在深入分析CYK算法计算特征的基础上,基于FPGA平台提出并实现了一种细粒度的并行CYK算法.设计采用了对三维动态规划矩阵"按区域分割"和"逐层按列并行处理"的计算策略实现了多个处理单元间的负载均衡;采用数据预取、滑动窗口和数据传递流水线实现处理单元间的数据重用,有效解决了计算和通信间的平衡问题;设计了一种类似脉动阵列(systolic-like array)结构的主从多PE并行计算阵列,并在目前最大规模的FPGA芯片(Xilinx XC5VLX330)上成功集成了16个处理单元(processing elements),实验结果表明作者提出的CYK算法加速器结构具备良好的可扩展性.当RNA序列长度为959bps,CM模型状态数为3145时,与运行在Intel双核E5200 2.5GHzCPU、2.0GB主存通用计算上的Infernal-1.0软件相比,可获得超过14倍的加速效果.配置一个FP-GA算法加速器的通用计算平台的综合处理性能与包含20个Intel-Xeon CPU的PC集群相当,而硬件成本仅为后者的20%,系统功耗不到后者的10%.【总页数】16页(P797-812)【作者】夏飞;窦勇;宋健;雷国庆【作者单位】国防科学技术大学计算机学院,长沙,410073;国防科学技术大学计算机学院,长沙,410073;中国人民解放军61785部队,北京,100075;国防科学技术大学计算机学院,长沙,410073【正文语种】中文【中图分类】TP302【相关文献】1.基于FPGA的并行蒙特卡洛计算加速器的设计与实现 [J], 石琳琦;赵辛宇;吴望尘2.基于FPGA的并行蒙特卡洛计算加速器的设计与实现 [J], 石琳琦;赵辛宇;吴望尘;3.基于FPGA的细粒度并行K-means算法加速器的设计与实现 [J], 倪时策;窦勇;雷元武;赵建勋4.基于FPGA的存储优化的细粒度并行Zuker算法加速器研究 [J], 夏飞;窦勇;徐佳庆;张阳5.基于通道自适应动态网络剪枝算法的FPGA加速器设计与实现 [J], 龚赛君;曹红因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

25卷 第10期2008年10月微电子学与计算机M ICROEL ECTRON ICS &COMPU TERVol.25 No.10October 2008收稿日期:2008-06-13细粒度并行计算编程模型研究刘伟峰1,王智广2(1中国石油化工股份有限公司石油勘探开发研究院信息技术研究所,北京100083;2中国石油大学(北京)计算机科学与技术系,北京102249)摘 要:作为应用软件模型和计算机硬件之间的桥梁,编程模型在计算机领域的重要性不言而喻.但随着具备细粒度并行计算能力的多核心微处理器进入主流市场,与之相适应的编程模型发展却相对滞后.对细粒度的并行计算编程模型进行研究.首先,介绍3种典型的多核心微处理器体系结构;其次,介绍3个已有的细粒度并行计算编程模型;最后,探讨并行计算编程模型的必备条件.关键词:细粒度并行计算;图形处理器;图形处理器的通用计算;Cell ;统一计算设备架构中图分类号:TP312 文献标识码:A 文章编号:1000-7180(2008)10-0103-04Fine 2grained Parallel Computing Programming Model R esearchL IU Wei 2feng 1,WAN G Zhi 2guang 2(1Information and Technology Research Institute ,SINOPEC Exploration &ProductionResearch Institute ,Beijing 100083,China ;2Department of Computer Science and Technology ,China University of Petroleum 2Beijing ,Beijing 102249,China )Abstract :As a bridge between natural model of an application and hardware model of computer ,programming model is important in computer industry.Nevertheless ,evolution of programming model could not suit already boosted multi 2core microprocessors which have fine 2grained parallel computing ability.This paper focus on fine 2grained parallel computing programming model.Above all ,we introduce 3typical multi 2core microprocessor architectures ;secondly ,we introduce 3already exist fine 2grained parallel computing programming models ;finally ,we research the future of fine 2grained parallel computing programming model.K ey w ords :fine 2grained parallel computing ;GPU ;GPGPU ;cell ;CUDA1 引言随着一系列单芯片多处理器进入主流市场,并行程序设计所依赖的硬件土壤已经成熟.但就编程模型来讲,以往MPI 模型的粗粒度结构和OpenMP 的编译器优化已经不能满足单芯片上核与核之间的细粒度通信.所以,目前迫切需要研究可以适应多种单芯片多处理器体系结构的统一细粒度并行计算编程模型.文中在介绍已有的典型多核心微处理器体系结构和并行编程模型的基础上,对细粒度并行计算编程模型的必备条件进行研究.2 细粒度并行计算硬件体系结构目前典型的单芯片多处理器包括:(1)多核(Multi 2core )CPU ;(2)许多核(Many 2core )图形处理器(Graphics Processing Unit ,GPU );(3)异构(het 2erogeneous )多核Cell 微处理器.这三种单芯片多核微处理器的共同特点是都在单个芯片上集成多个核心以提高计算能力.相对于传统的单核心微处理器,在一个芯片上放置多个低频率低复杂度的核更能够提高计算能力,也能利用摩尔定律带来的每24个月翻番的大量晶体管.图1[1]很好地显示了这种性能上的改观,3.0GHz 的Intel双核CPU的浮点运算能力是同频率单核CPU 的5倍.而包含8个计算核心的异构Cell芯片的浮点运算能力是Intel四核CPU的2倍多.包含128个轻量级核心的Tesla GPU的浮点运算能力更达到后者的5倍以上.图1 CPU,GPU和Cell的单精度FLOPS理论峰值2.1 多核CPU体系结构模型2005年,Intel和AMD正式向主流消费级市场推出了双核心的CPU产品,2007年推出了4核心的CPU,预计今后大约每2年单CPU上的核心数将翻番.多核CPU中的核是真正的CPU核,每个核都使用了原来单核心CPU的技术.其好处是在提高计算能力的同时,对虚拟化技术也有很好的支持.多核CPU体系结构简图如图2所示.图2 多核CPU体系结构简图2.2 许多核GPU体系结构模型2006年,显卡厂商nVidia推出了其划时代的G80核心GPU.不同于传统GPU的SIMD模型和向量计算单元,G80核心采用了标量计算单元,包含128个流处理器(SP),每8个流处理器组成1个多处理器(SM).每个SM上的16kB共享内存(shared memory)用于多个SP间的数据交换.8192个32-bit寄存器可以同时保存768个活动线程的上下文,即包含16个多处理器的GPU可同时保存12288个活动线程.显示内存带宽103.7G B/s.与多核CPU的同时多线程复杂核心不同的是, GPU上的核心是轻量级的,每个核心同时只能执行1个线程.另外,相对于同样晶体管数量的CPU, GPU在芯片上仅包含很小的Cache和很少的控制单元,而把大量的晶体管用于AL U.这也是GPU的计算能力远超过同价位的CPU的原因之一.图3为许多核GPU体系结构简图.图3 nVidia G80核心许多核GPU体系结构简图2.3 异构多核Cell微处理器体系结构模型与多核CPU或许多核GPU的同构(homoge2 neous)多核不同,由IBM、SON Y和TOSHIBA共同研发的Cell微处理器上的多核心是异构的.Cell微处理器由1个基于PowerPC架构的控制核心PPU 和8个轻量级的SPU组成,多个处理单元通过环形数据总线EIB相连.其中PPU端同时执行2线程,可以运行Linux操作系统,负责对SPU进行调度,其功能类似于CPU.SPU端仅负责计算任务,每个SPE同时执行1线程,配备256kB Local Store存储器负责SPU间交换数据,类似于GPU上的SP.图4为异构多核Cell微处理器体系结构简图.3 细粒度并行计算编程模型随着各类多核微处理器进入主流市场并日渐成熟.从Web应用的服务器端程序设计到桌面级的图像浏览软件都有必要利用多核硬件带来的计算能力提高应用效果.但目前的情况是,与之配套的并行计算编程模型相对滞后,没有相应的标准,一定程度上导致并行程序设计思想还远没被主流程序设计人员所接受.然而,不改变编程习惯,仅指望编译器来完成串行代码到并行代码的转化是不现实的[2],研究并行计算编程模型势在必行.401图4 异构多核Cell 体系结构简图虽然目前没有统一的并行计算编程标准,但很多研究人员已经搭建了一些细粒度并行计算编程模型.具有代表性的如下:(1)支持GPU 的Brook/Brook +;(2)支持CPU/GPU 的CUDA ;(3)支持CPU/GPU/Cell 混合环境的Rapid 2Mind.3.1 Brook/Brook +过去的几年中,研究人员利用GPU 的计算能力进行了很多非图形的通用计算,并在天体物理、流体力学、分子动力学等很多计算密集型应用中取得了好的效果,从而诞生了GPU 的通用计算(general purpose computing on graphics processing units ,GP GPU )这门新兴学科.但由于GPU 是为图形处理而设计,导致GPU 上的通用计算在相当长一段时间里需要通过图形API (Open G L 或Direct X )编写程序.而图形编程的学习曲线相对较长,导致GP GPU 的普及受限[3].基于此,2004年Stanford 大学的研究人员编写了Brook 并行计算编程模型[4].Brook 包含在C 语言语法上进行了扩展的一套通用计算函数库,隐藏了传统GP GPU 编程中需要在图形API 上实现的显性技巧,提供了易于操作的GPU 通用计算编程模型,很好地利用了GPU 上数目众多的计算单元进行并行计算.后来,AMD 在Brook 的基础上进行了改进,形成了Brook +[5].3.2 CUDA2007年,基于Brook 思想,nVidia 推出了Com 2pute Unified Device Architecture ,统一计算设备架构(CUDA )编程模型.与Brook 利用C 语言直接调用GPU 资源且易于使用的特点相同,CUDA 也基于C语言进行了扩展.CUDA 在诞生初期仅兼容nVidiaG 80核心的GPU ,利用G 80核心GPU 的新特性在计算速度方面远超Brook ,灵活度方面也有提升.使得CUDA 在很短的时间内就被众多研究者们接受,产生了大量的科学计算应用.2008年,University of Illinois at Urbana 2Cham 2paign 的研究人员利用源2源的解决方案设计了MCUDA (Multicore 2CUDA )[6],使CUDA 程序也可以运行在多核CPU 上,且运行效率要高于多数原生的CPU 优化方法.此外,来自 的研究人员也将CUDA 移植到了AMD 的GPU 上.这一系列工作进一步扩展了CUDA 的适用范围.3.3 RapidMind与许多核GPU 上的并行计算编程模型的快速发展相比,适应多核CPU 的细粒度编程模型却进展缓慢.2007年,RapidMind 公司推出了支持x86指令集多核CPU的RapidMind 并行计算编程模型,并在其后续版本中开始支持许多核GPU 和异构多核Cell.虽然使用RapidMind 开发的并行应用还不多,但这种统一的细粒度并行计算编程模型是未来发展的趋势.4 细粒度并行计算编程模型的必备条件作为应用软件模型和微处理器体系结构之间的桥梁,编程模型,尤其是并行计算编程模型必须提高程序性能、减低程序实现复杂度.为了让这两者达到平衡,编程模型必须满足2个条件:(1)隐藏硬件细节.编程模型应该对底层硬件细节进行抽象,避免让掌握复杂底层硬件细节成为提高程序设计性能的必要条件;(2)关键参数显示化.编程模型应该暴露部分底层硬件的关键参数,比如共享内存调用、线程边界和线程通讯等.以便程序设计人员能够利用这些关键参数提高程序性能.除此之外,对于细粒度的并行计算编程模型,还必须满足下述4个条件.4.1 处理器核心数量无关经典的粗粒度并行编程模型MPI 采用了显示映射任务和分解数据的方法,把任务分解并映射到不同的处理器上.在程序设计人员对任务分析透彻的基础上,这种方式易于达到高性能.但在单芯片上的核心越来越多的情况下,这种方式会给程序设计人员带来很大的麻烦.当单芯片上的核心超过1000核的情况下,显示映射任务的方式就更加不可行.实际上,CUDA 编程模型已经解决了这个问题.目前不同层次GPU 上的SP 从16 第10期刘伟峰,等个到128个不等,CUDA编程模型只需要程序设计人员指定每个任务需要使用的线程块数量和每块上的线程数量,最终由多少个SP去处理这些线程块不需要程序设计人员关心.4.2 支持全数据类型对于相同的应用程序模型,可以有多种实现算法,但对于同样的实现算法,也存在不同的数据类型实现.比如国际通用处理器测试程序包SPEC[7]就仅使用32-bit和64-bit浮点数以及长整数实现测试算法.随着应用程序模型的需求不断复杂化,编程模型应该至少支持布尔数、定点数、多种长度整数、长整数、双精度和四精度等浮点数类型.另外,对混合精度浮点算数[8]等灵活数据结构的支持也是必要的.但目前,数据类型瓶颈主要在硬件上.比如第一代Cell的单精度浮点数运算能力是256GFLOPS,但双精度浮点数运算能力仅能达到25GFLOPS.第二代Cell改进了SPU的硬件实现,才将双精度浮点数运算能力提升到125GFLOPS.也就是说,编程模型对数据类型的支持必须以硬件的支持为前提,否则是没有意义的.4.3 支持多种并行算法模型随着多年来对并行计算研究的深入,已经证明,没有任何一种并行算法模型是适用所有应用程序模型的.即细粒度的并行计算编程模型必须支持有各自适用范围的多种并行算法模型.典型的并行算法模型包括[9]:任务级并行、分治模式并行、几何模式并行、流水线模式并行和波峰模式并行.目前已有的细粒度并行计算编程模型都不包括多种并行算法模型的支持.对非任务级并行的程序设计还要通过程序设计人员完成.未来随着并行计算编程模型的改进,这个条件不难满足.4.4 支持各类硬件目前的多数编程模型都是由生产硬件的厂家提供,且仅支持自家的硬件产品.形成这种现象的原因是目前除了兼容x86指令集的多核CPU以外的多核硬件在底层实现上各不相同甚至差别很大.即使是声称支持目前所有的多核微处理器的RapidMind 模型也没有实现与多类GPU和Cell指令集层面的兼容.而对于程序设计人员来说,统一环境下的并行计算编程模型是亟待解决的问题.5 结束语在介绍目前主流多核心微处理器体系结构和目前已经存在的并行计算编程模型的基础上,分析了细粒度并行计算编程模型的4项必备条件.随着摩尔定律的延续,单芯片上的核心数目会越来越多,带来的并行计算能力十分可观.而与之配合的细粒度并行计算编程模型却相对滞后,至今也没有出现支持全数据类型且支持多种并行算法模型和各类硬件的统一细粒度并行计算编程模型.目前,有必要从两个方面解决细粒度并行计算编程模型问题:(1)由各家硬件厂商合作,在底层硬件的实现细节上尽量解决指令集架构不兼容性;(2)让主流程序设计人员接受并行计算的思想,提高细粒度并行计算编程模型的应用基础.参考文献:[1]Green S.GPU Physics[R].San Diego,SIGGRAPHGPGPU Course,2007.[2]Sutter H.The free lunch is over:a fundamental turn to2ward concurrency in software[J].Dr.Dobb’s Journal, 2005,30(3):21-29.[3]吴恩华.图形处理器用于通用计算的技术、现状及其挑战[J].软件学报,2004,15(10):1493-1504.[4]Buck I,Foley T,Horn D,et al.Brook for GPUs:streamcomputing on graphics hardware[J].ACM Trans.on Graphics,2004,23(3):777-786.[5]AMD.Brook+[R].Reno:BOF Session of supercom2puting,2007.[6]Stratton J,Stone S,Hwu Wen-mei.MCUDA:an effi2cient implementation of CUDA kernels on multi-cores [R].USA:IMPACT Technical Report,2008.[7]Henning J.SPEC CPU2000:measuring CPU performancein the new millennium[J].Computer,2000,33(7):28 -35.[8]Demmel J,Bailey D,Henry G,et al.Design,implemen2tation and testing of extended and mixed precision BLAS [J].ACM Transations on Mathematical S oftware,2002, 28(2):152-205.[9]Wilkinson B,Allen M.Parallel programming[M].2nd ed.Boston:Prentince Hall.2005.作者简介:刘伟峰 男,(1981-),硕士,工程师,CCF会员.研究方向为图形处理器架构、高性能计算可视化.王智广 男,(1964-),博士,教授,CCF高级会员.研究方向为分布式计算和并行计算.。